使用Rancher在CentOS 环境上部署和管理多Kubernetes集群

引言

随着容器技术的迅猛发展,Kubernetes已成为容器编排领域的事实标准。然而,随着企业应用规模的扩大,多集群管理逐渐成为企业IT架构中的重要需求。 Rancher作为一个开源的企业级多集群Kubernetes管理平台,以其友好的用户界面和强大的功能,为企业提供了集中管理多个Kubernetes集群的能力。本技术文档将详细介绍如何在CentOS 8环境中安装、配置和管理多个Kubernetes集群,同时深入探讨Rancher作为多集群管理平台的使用方法和最佳实践。

本文档的目的是为IT技术人员、DevOps工程师和系统管理员提供一个全面的指南,帮助他们理解并实施基于Rancher的多Kubernetes集群管理解决方案。通过本文档,读者将能够掌握从基础设施准备到集群管理的全过程,构建一个稳定、高效、安全的容器化应用运行环境。

环境准备

在开始部署Kubernetes集群和安装Rancher之前,我们需要准备好相应的硬件和软件环境。本节将详细介绍环境准备的各个步骤,确保后续的部署工作能够顺利进行。

硬件要求

在构建Kubernetes集群和Rancher管理平台之前,我们需要确保硬件环境满足基本要求。根据Rancher官方文档,以下是推荐的硬件配置:

- CPU:至少2核处理器

- 内存:至少4GB RAM

- 存储:至少20GB可用存储空间

- 网络:稳定的网络连接,建议使用1Gbps网络接口

这些配置适用于大多数生产环境。如果您的应用对性能有更高要求,建议相应增加硬件配置。对于开发和测试环境,可以适当降低配置要求。

操作系统选择

本文档选择CentOS 8作为基础操作系统,这是由于CentOS在企业级应用中的广泛使用以及对Kubernetes和容器技术的良好支持。CentOS 8提供了稳定且长期支持的环境,适合部署生产级Kubernetes集群。

在选择操作系统版本时,请确保选择的版本得到Kubernetes和Rancher官方支持。根据搜索结果,Rancher支持在CentOS 8上安装运行,但需要注意SELinux配置可能需要额外步骤。

网络规划

网络规划是构建Kubernetes集群的重要环节。一个良好的网络架构能够确保集群内各节点之间的通信畅通,同时提供必要的安全性和可管理性。

主机名与IP地址规划

在部署Kubernetes集群之前,建议为每个节点规划唯一的主机名和静态IP地址。这样可以避免在后续的集群管理中出现网络配置问题。

例如,可以为Kubernetes主节点设置主机名为"k8s-master",IP地址为"192.168.199.100";为工作节点设置主机名为"k8s-node1",IP地址为"192.168.199.234"。

确保每台服务器的主机名设置正确,并在每台机的/etc/hosts文件中添加相应的配置,以确保节点之间能够通过主机名正确通信。

端口规划

Kubernetes集群和Rancher管理平台需要开放多个端口以实现正常通信。以下是主要需要开放的端口:

- Kubernetes API Server:默认6443端口

- 节点端口:30000-32767范围内的端口

- kubelet:10250端口(可选,根据安全策略配置)

- etcd:2379和2380端口(用于集群内部通信)

- Rancher服务:默认80和443端口

根据实际安全需求,建议采用最小化开放策略,并配置防火墙规则以限制访问源。出于演示目的,可以在安装过程中直接关闭firewalld服务[1]:

systemctl disable firewalld systemctl stop firewalld

依赖包安装

在CentOS 8上安装Kubernetes和Rancher之前,需要安装一些必要的依赖包。这些包包括系统工具、容器运行时环境和Kubernetes组件等。

安装系统工具和依赖包

执行以下命令安装系统工具和依赖包:

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

这些工具是安装Docker和其他容器运行时环境所必需的。lvm2提供逻辑卷管理功能,有助于存储资源的灵活配置。

配置Docker YUM源

为了安装最新版本的Docker,需要配置Docker的YUM源。以下是一个使用阿里云镜像源的配置示例:

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

配置完成后,更新YUM缓存:

sudo yum makecache fast

安装Docker

安装Docker是部署Kubernetes的前提条件。执行以下命令安装Docker:

sudo yum install docker-ce docker-ce-cli containerd.io

安装完成后,启用并启动Docker服务:

sudo systemctl enable docker sudo systemctl start docker

验证Docker安装是否成功:

docker --version

如果输出显示了Docker版本信息,则表示安装成功。

安装Kubernetes依赖包

Kubernetes在CentOS 8上依赖于一些特定的软件包。执行以下命令安装这些依赖包:

sudo yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

这些包包括Kubernetes的核心组件:kubelet(节点代理)、kubeadm(集群初始化工具)和kubectl(命令行工具)。

配置Kubernetes YUM源

为了获取最新版本的Kubernetes组件,建议配置Kubernetes的YUM源。以下是一个使用阿里云镜像源的配置示例:

cat <<EOF > /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/ enabled=1 gpgcheck=1 repo_gpgcheck=1 gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg EOF

配置完成后,更新YUM缓存:

sudo yum makecache fast

SELinux配置

SELinux(Security Enhanced Linux)是Linux系统上的一个安全模块,可以提供更细粒度的访问控制。然而,默认情况下SELinux可能会影响容器运行时环境和Kubernetes组件的运行。

关闭SELinux

为了简化配置,建议在安装和配置Kubernetes和Rancher的过程中临时关闭SELinux。修改文件/etc/sysconfig/selinux,将SELINUX=enforcing修改为SELINUX=disabled[1]。

配置SELinux策略

如果您希望保持SELinux启用状态,可以应用一个允许容器运行时环境与主机文件系统交互的策略。执行以下命令:

setsebool -P container_manage_cgroup 1

这将允许容器管理cgroup,这是Kubernetes正常运行所必需的。

对于在SELinux enforcing模式下的CentOS 8或RHEL 8节点,安装RancherD可能需要额外的步骤。因此,在安装Rancher之前,请确保了解并配置好SELinux设置。

时区和NTP配置

确保所有节点的时钟同步是Kubernetes集群健康运行的重要条件。配置NTP服务以保持时间同步:

sudo yum install -y chrony sudo systemctl enable chronyd sudo systemctl start chronyd

验证NTP同步状态:

chronyc sources

如果输出显示同步状态为"OK",则表示配置成功。

禁用swap分区

Kubernetes要求禁用swap分区以确保容器运行的一致性和稳定性。执行以下命令禁用swap:

swapoff -a

为了确保在系统重启后swap仍然禁用,注释掉或删除/etc/fstab文件中swap分区的条目:

sudo sed -i '/swap/d' /etc/fstab

安装Rancher依赖包

Rancher是一个基于Kubernetes的应用,因此在安装Rancher之前,需要确保Kubernetes环境已经正确配置。此外,Rancher还依赖于一些特定的包和配置。

对于CentOS 8系统,安装RancherD之前,需要确保系统已经更新到最新状态:

sudo yum update -y

如果计划使用RancherD作为Kubernetes引擎,还需要安装以下包:

sudo yum install -y containerd.io

网络配置

Kubernetes集群的网络配置对于容器之间的通信至关重要。默认情况下,Kubernetes使用kube-proxy管理服务发现和网络流量路由。

配置CNI网络插件

Kubernetes支持多种CNI(Container Network Interface)网络插件,如Flannel、Calico、Weave等。根据实际需求选择合适的网络插件。

例如,使用Flannel配置网络:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

确保网络插件配置正确后,验证网络是否正常工作:

kubectl get pods -n kube-system

如果输出显示所有系统组件都处于"Running"状态,则表示网络配置成功。

用户和权限配置

为了安全起见,建议为管理Kubernetes集群创建专用用户账户,并配置适当的权限。

创建管理用户

创建一个名为"kubernetes"的专用用户:

sudo useradd -m kubernetes sudo passwd kubernetes

切换到新用户:

su - kubernetes

配置sudo权限

允许"kubernetes"用户以sudo权限执行命令:

sudo usermod -aG wheel kubernetes

编辑sudo配置文件:

sudo visudo

在文件中添加以下行:

%wheel ALL=(ALL) NOPASSWD: ALL

保存并退出。

配置SSH密钥

为了方便管理和自动化操作,建议在所有节点之间配置SSH密钥认证。

生成SSH密钥对:

ssh-keygen -t rsa

将公钥复制到所有其他节点:

ssh-copy-id -i ~/.ssh/id_rsa.pub user@remote_host

验证无密码登录是否成功:

ssh user@remote_host

如果能够直接登录而无需输入密码,则表示配置成功。

总结

环境准备是成功部署Kubernetes集群和Rancher管理平台的基础。在这一阶段,我们需要确保硬件和软件环境满足要求,网络配置正确,依赖包安装齐全,并且基本的安全措施已经到位。

通过仔细规划和配置这些基础元素,我们可以为后续的Kubernetes集群部署和Rancher安装奠定坚实的基础,确保整个系统的稳定性和可靠性。

Kubernetes集群部署

在完成环境准备工作后,我们接下来将详细讲解如何在CentOS 8环境中使用kubeadm工具部署Kubernetes集群。本节将覆盖从单节点集群初始化到多节点集群扩展的全过程,并介绍网络配置和验证方法。

使用kubeadm初始化Kubernetes集群

kubeadm是Kubernetes官方提供的集群初始化工具,能够快速简便地创建一个符合生产环境标准的Kubernetes集群。以下步骤将指导您完成集群初始化过程。

配置kubeadm

在初始化集群之前,建议创建一个kubeadm配置文件,以便自定义集群参数。以下是一个基本的配置示例:

apiVersion: kubeadm.k8s.io/v1beta3 kind: InitConfiguration bootstrapTokens: - token: "your-bootstrap-token"ttl: "24h"usages:- signing- authentication --- apiVersion: kubeadm.k8s.io/v1beta3 kind: ClusterConfiguration networking:podSubnet: "10.244.0.0/16"serviceSubnet: "10.96.0.0/12" controllerManager:clusterCidr: "10.244.0.0/16"

在上述配置中,我们定义了以下参数:

- podSubnet:Pod网络子网,使用Flannel时默认为"10.244.0.0/16"

- serviceSubnet:Service网络子网,Kubernetes默认为"10.96.0.0/12"

- clusterCidr:控制器管理器使用的集群CIDR

根据实际需求调整这些参数,然后保存配置文件为"kubeadm-config.yaml"。

初始化主节点

在主节点上执行以下命令初始化Kubernetes集群:

sudo kubeadm init --config kubeadm-config.yaml

初始化过程可能需要几分钟时间。完成后,kubeadm会输出一个加入命令,用于将工作节点加入集群。请记录该命令,稍后将在添加工作节点时使用。

初始化完成后,设置kubectl配置文件:

mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config

部署网络组件

为了使Pod之间能够相互通信,需要部署网络组件。以下是一个使用Flannel的配置示例:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

验证网络组件是否正常运行:

kubectl get pods -n kube-system

如果输出显示所有系统组件都处于"Running"状态,则表示网络配置成功。

添加工作节点

在完成主节点初始化后,下一步是将工作节点加入集群。这将扩展集群的计算能力,并提高系统的整体性能和可用性。

准备工作节点

在每个工作节点上,执行以下命令安装必要的软件包:

sudo yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

启动并启用kubelet服务:

sudo systemctl enable kubelet sudo systemctl start kubelet

加入集群

使用kubeadm join命令将工作节点加入集群。在主节点初始化完成后,kubeadm会输出一个类似以下的命令:

kubeadm join 192.168.199.100:6443 --token your-token-here --discovery-token-ca-cert-hash sha256:your-hash-here

在每个工作节点上执行此命令,将它们加入Kubernetes集群。根据集群规模和配置,可能需要多次执行此命令以添加多个工作节点。

验证集群状态

在完成集群部署后,需要验证各个组件的状态,确保集群正常运行。

检查系统组件

使用以下命令检查Kubernetes系统组件的状态:

kubectl get componentstatuses

输出应该显示所有组件都处于"Healthy"状态。

检查节点状态

列出所有集群节点:

kubectl get nodes

输出应该显示所有节点都处于"Ready"状态。

检查Pod状态

列出kube-system命名空间中的所有Pod:

kubectl get pods -n kube-system

输出应该显示所有系统Pod都处于"Running"状态。

高可用性配置

为了提高Kubernetes集群的可靠性,建议配置高可用性(HA)组件。这包括多主节点配置、etcd集群和网络冗余等。

配置多主节点

默认情况下,kubeadm创建的集群只有一个主节点。为了提高控制平面的可靠性,可以添加多个主节点。

在每个额外的主节点上执行kubeadm join命令时,指定其角色为控制平面节点:

kubeadm join 192.168.199.100:6443 --token your-token-here --discovery-token-ca-cert-hash sha256:your-hash-here --control-plane

加入完成后,验证新主节点是否已正确配置:

kubectl get nodes -l node-role.kubernetes.io/master

输出应该显示所有主节点都已正确标记。

配置etcd集群

默认情况下,kubeadm创建的集群使用单节点etcd。为了提高数据存储的可靠性,可以创建一个etcd集群。

首先,在每个etcd节点上安装etcd:

sudo yum install -y etcd

创建etcd配置文件(/etc/etcd/etcd.conf):

[Member] ETCD_NAME="etcd-1" ETCD_DATA_DIR="/var/lib/etcd/default.etcd" ETCD_LISTEN_PEER_URLS="http://192.168.199.100:2380" ETCD_LISTEN_CLIENT_URLS="http://192.168.199.100:2379"[Cluster] ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.199.100:2380" ETCD_INITIAL_CLUSTER="etcd-1=http://192.168.199.100:2380,etcd-2=http://192.168.199.101:2380,etcd-3=http://192.168.199.102:2380" ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster-token" ETCD_INITIAL_CLUSTER_STATE="new"[Security] ETCD_PEER_KEY_FILE="/etc/etcd/ssl/peer.key" ETCD_PEER_CERT_FILE="/etc/etcd/ssl/peer.crt" ETCD_PEER_TRUSTED_CA_FILE="/etc/etcd/ssl/ca.crt" ETCD_CLIENT_KEY_FILE="/etc/etcd/ssl/client.key" ETCD_CLIENT_CERT_FILE="/etc/etcd/ssl/client.crt" ETCD_CLIENT_TRUSTED_CA_FILE="/etc/etcd/ssl/ca.crt"

根据实际配置调整IP地址和证书路径,然后启动etcd服务:

sudo systemctl enable etcd sudo systemctl start etcd

在kubeadm初始化或加入命令中指定etcd集群:

kubeadm init --config kubeadm-config.yaml --etcd-servers "https://192.168.199.100:2379,https://192.168.199.101:2379,https://192.168.199.102:2379"

配置网络冗余

为了提高网络的可靠性,可以配置网络冗余。这包括多网络接口绑定、网络负载均衡和网络监控等。

例如,使用keepalived实现Kubernetes API Server的高可用性:

sudo yum install -y keepalived

创建keepalived配置文件(/etc/keepalived/keepalived.conf):

global_defs {router_id k8s_api

}vrrp_instance VI_1 {state MASTERinterface eth0virtual_router_id 51priority 100advert_int 1virtual_ipaddress {192.168.199.200}track_process {k8s_api 10000 /usr/bin/kubectl get node k8s-master -o jsonpath='{.status.conditions[?(@.type=="Ready")].status}' 2>/dev/null | grep -q 'True'}

}

根据实际配置调整虚拟IP地址和跟踪脚本,然后启动keepalived服务:

sudo systemctl enable keepalived sudo systemctl start keepalived

在所有主节点上执行相同配置,但将状态设置为BACKUP,并降低优先级:

global_defs {router_id k8s_api_backup

}vrrp_instance VI_1 {state BACKUPinterface eth0virtual_router_id 51priority 90advert_int 1virtual_ipaddress {192.168.199.200}track_process {k8s_api 10000 /usr/bin/kubectl get node k8s-master -o jsonpath='{.status.conditions[?(@.type=="Ready")].status}' 2>/dev/null | grep -q 'True'}

}

集群扩展和维护

随着业务需求的变化,可能需要扩展或修改Kubernetes集群的配置。以下是一些常见的集群管理任务。

扩展计算能力

为了满足不断增长的工作负载需求,可以随时添加新的工作节点。

在新节点上安装必要的软件包:

sudo yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

然后使用kubeadm join命令将节点加入集群:

kubeadm join 192.168.199.100:6443 --token your-token-here --discovery-token-ca-cert-hash sha256:your-hash-here

更新组件版本

为了获取新功能和安全修复,定期更新Kubernetes组件是必要的。

首先,更新kubelet和kube-proxy:

sudo yum update -y kubelet kubeadm kubectl

然后,更新控制平面组件:

kubeadm upgrade plan kubeadm upgrade apply v1.25.0

根据kubeadm upgrade plan命令的输出,选择合适的版本进行升级。

备份和恢复

为了防止数据丢失,定期备份Kubernetes集群的数据是必要的。

备份etcd数据:

etcdctl backup --data-dir=/var/lib/etcd/default.etcd --backup-dir=/backup/etcd

备份Kubernetes配置:

kubectl get --all-namespaces -o yaml > kubernetes-resources.yml

在需要恢复时,执行以下命令:

etcdctl restore --data-dir=/var/lib/etcd/default.etcd --backup-dir=/backup/etcd kubectl apply -f kubernetes-resources.yml

集群监控和日志收集

为了确保集群的健康运行,需要实施监控和日志收集系统。

部署监控系统

使用Prometheus和Grafana部署监控系统:

kubectl apply -f https://raw.githubusercontent.com/kubernetes-monitoring/kubernetes-mixin/master/prometheus-operator/manifests/

访问Grafana仪表板,监控集群状态。

部署日志收集系统

使用ELK(Elasticsearch, Logstash, Kibana)或EFK(Elasticsearch, Fluentd, Kibana)部署日志收集系统:

kubectl apply -f https://raw.githubusercontent.com/elastic/k8s-prometheus-stack/v0.6.0/deploy/manifests/elasticsearch.yaml

访问Kibana界面,搜索和分析日志。

总结

在本节中,我们详细介绍了如何在CentOS 8环境中使用kubeadm部署Kubernetes集群。从单节点集群初始化到多节点集群扩展,从网络配置到高可用性设置,我们提供了全面的指导。

通过遵循这些步骤,您可以构建一个稳定、高效、安全的Kubernetes集群,为各种容器化应用提供运行环境。在下一节中,我们将介绍如何在CentOS 8上安装和配置Rancher,实现对多个Kubernetes集群的集中管理。

Rancher安装与配置

Rancher是一个开源的企业级多集群Kubernetes管理平台,提供了友好的用户界面和强大的功能,使管理多个Kubernetes集群变得简单高效。本节将详细介绍如何在CentOS 8环境中安装和配置Rancher,并设置其基本功能。

安装Rancher

Rancher可以通过多种方式安装,包括Kubernetes部署、独立二进制文件安装和使用RancherD。根据实际需求和环境特点,我们可以选择合适的安装方法。

安装Docker

Rancher依赖于Docker或containerd作为容器运行时环境。在安装Rancher之前,需要确保Docker已经正确安装并运行。

执行以下命令安装Docker:

sudo yum install -y docker-ce docker-ce-cli containerd.io sudo systemctl enable docker sudo systemctl start docker

验证Docker安装是否成功:

docker --version

如果输出显示了Docker版本信息,则表示安装成功。

安装Rancher Server

Rancher Server是Rancher的核心组件,提供用户界面和API接口。Rancher Server可以通过Helm Chart安装在Kubernetes集群上。

首先,添加Rancher Helm仓库:

helm repo add rancher-stable https://releases.rancher.com/stable-charts

更新仓库索引:

helm repo update

安装Rancher Server:

helm install rancher rancher-stable/rancher --namespace cattle-system --create-namespace

等待安装完成后,访问Rancher Server的Web界面。默认情况下,它运行在80和443端口上。

安装Rancher Agent

Rancher Agent是运行在每个被管理集群上的组件,负责与Rancher Server通信并执行命令。Rancher Agent可以通过以下命令安装:

curl -sfL https://releases.rancher.com/rancherd/latest/download | sh -

安装完成后,启动Rancher Agent服务:

sudo systemctl enable rancherd sudo systemctl start rancherd

验证Rancher Agent是否已连接到Rancher Server:

systemctl status rancherd

如果输出显示"Connected to Rancher Server",则表示连接成功。

安装Rancher CLI

Rancher CLI是命令行工具,提供了对Rancher Server的命令行访问。Rancher CLI可以通过以下命令安装:

curl -sfL https://releases.rancher.com/cli/latest/download | sh -

安装完成后,配置Rancher CLI以连接到Rancher Server:

rancher config set --url https://your-rancher-server-url

验证配置是否正确:

rancher context ls

如果输出显示了可用的上下文,则表示配置成功。

配置Rancher

安装完成后,需要进行一些基本配置,以确保Rancher能够有效地管理Kubernetes集群。

用户界面配置

登录到Rancher Web界面,设置管理员密码并创建用户账户。

在"Settings"页面,配置以下选项:

- Global Settings:设置全局参数,如默认项目和资源配额

- LDAP/AD Settings:配置与企业目录服务的集成

- Notification Settings:设置通知机制,如电子邮件和Slack

- Audit Log Settings:配置审计日志的存储和保留策略

集群管理

在Rancher中,可以管理两种类型的集群:Rancher创建的集群和导入的现有集群。

对于Rancher创建的集群,使用Rancher Kubernetes Engine (RKE) 配置集群。创建一个名为"rancher-cluster.yml"的配置文件:

nodes: - address: 192.168.199.100role: [controlplane, worker, etcd]sshPort: 22sshKeyPath: /path/to/ssh/keyuser: rancher

使用RKE命令设置集群:

rke up --config rancher-cluster.yml

对于导入的现有集群,需要提供kubeconfig文件或集群访问凭证。在Rancher界面中选择"Import Existing Cluster"选项,然后按照提示提供必要的信息。

项目和命名空间

Rancher使用项目和命名空间组织和隔离资源。项目是更高层次的容器,可以包含多个命名空间。

创建新项目:

rancher project create --name my-project

在项目中创建命名空间:

kubectl create namespace my-namespace

设置项目和命名空间的访问控制策略,确保资源的隔离和安全。

监控和日志

Rancher集成了监控和日志收集功能,便于用户跟踪集群和应用的状态。

启用监控功能:

rancher app enable monitoring

启用日志收集功能:

rancher app enable logging

配置监控和日志收集的参数,如数据保留期和告警阈值。

访问控制

Rancher提供了基于角色的访问控制(RBAC)功能,可以根据用户角色和职责分配不同的权限。

创建新用户:

rancher user create --name my-user --email my-user@example.com

创建新角色:

rancher role create --name my-role

将用户添加到角色中:

rancher user add-to-role --user my-user --role my-role

设置角色的权限,指定其可以访问的资源和操作。

高可用性配置

为了提高Rancher的可靠性,建议配置高可用性(HA)组件。这包括多节点配置、数据库冗余和网络负载均衡等。

多节点配置

默认情况下,Rancher Server运行在单个节点上。为了提高可用性,可以部署多个Rancher Server节点。

在每个额外的Rancher Server节点上执行以下命令:

helm install rancher rancher-stable/rancher --namespace cattle-system --set replicas=3

设置replicas参数为3,创建一个包含3个节点的Rancher Server集群。

数据库冗余

默认情况下,Rancher使用嵌入式数据库。为了提高数据的可靠性,可以配置外部数据库。

在Helm安装命令中指定数据库参数:

helm install rancher rancher-stable/rancher --namespace cattle-system --set mongodb.persistence.enabled=true --set mongodb.persistence.size=10Gi

设置persistence.enabled为true,启用数据库持久化;设置persistence.size为10Gi,指定数据库存储大小。

网络负载均衡

为了提高网络的可靠性,可以配置网络负载均衡器,将流量分发到多个Rancher Server节点。

使用Nginx配置负载均衡:

sudo yum install -y nginx

创建Nginx配置文件(/etc/nginx/conf.d/rancher.conf):

upstream rancher_servers {server rancher1:80;server rancher2:80;server rancher3:80;

}server {listen 80;server_name rancher.example.com;location / {proxy_pass http://rancher_servers;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;proxy_set_header X-Forwarded-Proto $scheme;}

}

根据实际配置调整服务器IP地址和域名,然后启动Nginx服务:

sudo systemctl enable nginx sudo systemctl start nginx

集成和扩展

Rancher提供了多种集成选项,可以与企业现有的工具和流程无缝衔接。

与CI/CD工具集成

Rancher可以与Jenkins、GitLab CI/CD等CI/CD工具集成,实现应用的自动化构建和部署。

配置Jenkins pipeline:

pipeline {agent anystages {stage('Build') {steps {sh 'mvn clean package'}}stage('Deploy') {steps {sh 'kubectl apply -f deployment.yml'}}}

}

与监控工具集成

Rancher可以与Prometheus、Grafana等监控工具集成,提供更全面的集群和应用监控。

配置Prometheus抓取Rancher指标:

- job_name: 'rancher'scrape_interval: 5sstatic_configs:- targets: ['rancher1:9100', 'rancher2:9100', 'rancher3:9100']

与日志收集工具集成

Rancher可以与ELK、EFK等日志收集工具集成,集中收集和分析日志数据。

配置Filebeat收集Rancher日志:

filebeat.inputs:

- type: logpaths: ['/var/log/rancher/*.log']fields:cluster_name: 'my-cluster'output.elasticsearch:hosts: ['elasticsearch:9200']index: 'rancher-logs-%{+YYYY.MM.dd}'

安全配置

为了保护Rancher和管理的集群免受安全威胁,需要实施适当的安全措施。

认证和授权

启用Rancher的认证和授权功能,确保只有授权用户可以访问特定资源。

配置LDAP/AD集成:

rancher setting set --name auth.ldap.enabled --value true rancher setting set --name auth.ldap.url --value 'ldap://your-ldap-server:389' rancher setting set --name auth.ldap.binddn --value 'cn=admin,dc=example,dc=com' rancher setting set --name auth.ldap.bindpass --value 'your-ldap-password'

配置RBAC策略:

rancher role create --name my-role rancher user add-to-role --user my-user --role my-role rancher role add-to-resource --role my-role --resource-type cluster --resource-id my-cluster --access-type read-write

加密

启用Rancher的加密功能,保护敏感数据,如密码和证书。

配置Kubernetes Secrets加密:

kubectl create secret generic my-secret --from-literal=password='my-password'

配置Rancher的TLS设置:

rancher setting set --name tls.certificate --value '/path/to/certificate.pem' rancher setting set --name tls.key --value '/path/to/key.pem'

审计日志

启用Rancher的审计日志功能,记录所有用户操作和API调用。

配置审计日志设置:

rancher setting set --name audit.log.enabled --value true rancher setting set --name audit.log.retention --value '7 days'

总结

在本节中,我们详细介绍了如何在CentOS 8环境中安装和配置Rancher。从Rancher Server的安装到高可用性设置,从访问控制到安全配置,我们提供了全面的指导。

通过遵循这些步骤,您可以构建一个强大、安全的多集群管理平台,实现对多个Kubernetes集群的集中管理和监控。在下一节中,我们将深入探讨如何使用Rancher管理多个Kubernetes集群,包括集群的添加、配置和维护。

多集群管理

随着企业应用规模的扩大,多集群管理逐渐成为企业IT架构中的重要需求。Rancher作为一个强大的多集群管理平台,提供了集中管理多个Kubernetes集群的能力。本节将详细介绍如何使用Rancher管理多个Kubernetes集群,包括集群的添加、配置、监控和维护等。

集群添加和导入

Rancher支持管理两种类型的集群:Rancher创建的集群和导入的现有集群。无论哪种类型,Rancher都提供了直观的界面和简化的流程。

使用Rancher创建新集群

Rancher提供了Rancher Kubernetes Engine (RKE) 作为创建新集群的工具。RKE是一个轻量级的Kubernetes安装程序,由Rancher自己开发。

创建一个名为"rancher-cluster.yml"的Kubernetes集群配置文件:

nodes: - address: 192.168.199.100role: [controlplane, worker, etcd]sshPort: 22sshKeyPath: /path/to/ssh/keyuser: rancher

使用RKE命令设置集群:

rke up --config rancher-cluster.yml

配置文件中定义了集群的节点信息,包括IP地址、角色、SSH端口、SSH密钥路径和用户。根据实际需求调整这些参数,然后保存配置文件为"rancher-cluster.yml"。

执行rke up命令创建集群。这将自动在指定的节点上安装和配置Kubernetes组件。

导入现有集群

Rancher也支持导入现有的Kubernetes集群。以下是导入现有集群的步骤:

- 准备好现有集群的kubeconfig文件

- 在Rancher界面中选择"Import Existing Cluster"选项

- 提供kubeconfig文件或集群访问凭证

- 完成导入过程

Rancher支持管理已有集群,以下是管理已有集群的步骤:

- 导入集群:通过Rancher界面导入已有集群

- 配置集群:更新集群配置,添加节点

在导入过程中,Rancher会检查集群的兼容性和健康状态,并提示您解决任何问题。

集群配置和管理

在将硬件资源虚拟化之后,我们将虚拟机上传至云中。其后,我们将软件包装在容器里,通过Docker进行部署,再通过Kubernetes进行容器的生命周期管理。在这一过程中,每一环节均将其之前各个层级的复杂性抽象化。

Rancher将Kubernetes作为一种商品:服务来源于何处并不重要,关键的是它是否可行。Kubernetes是全新的云,Rancher帮助您对接Kubernetes的每一个提供商、任意种类的云服务,如AWS、Azure、Google Cloud等,以及本地机房的服务器。

在Rancher中配置集群后,您可以开始使用强大的Kubernetes功能在开发、测试或生产环境中部署和扩展容器化应用。

集群设置

在Rancher中,可以配置各种集群设置,包括:

- 网络设置:配置容器网络接口(CNI)插件,如Flannel、Calico、Weave等

- 存储设置:配置持久化存储,如NFS、GlusterFS、Ceph等

- 计算资源:配置CPU和内存配额,确保应用的资源分配

- 安全策略:配置网络策略,限制Pod之间的通信

Rancher创造性地引入了用于管理多个集群的中央控制平面,帮助企业解决集群配置、升级、用户管理和安全策略的实施等运营难题。

节点管理

Rancher提供了全面的节点管理功能,包括:

- 节点监控:监控节点的健康状态、资源使用情况和性能指标

- 节点升级:管理节点的操作系统和Kubernetes组件升级

- 节点标签:为节点添加标签,便于应用调度和资源分配

- 节点驱逐:在必要时驱逐节点,确保集群的稳定运行

在Rancher中,可以为每个节点指定角色,如控制平面节点、工作节点和etcd节点。根据实际需求调整节点配置,然后保存配置文件。

集群升级

随着Kubernetes版本的不断更新,定期升级集群以获取新功能和安全修复是必要的。

Rancher提供了简化升级流程的工具,包括:

- 版本检查:自动检查可用的Kubernetes版本

- 升级计划:生成详细的升级计划,包括潜在的风险和解决方案

- 分阶段升级:支持分阶段升级,先升级控制平面,再升级工作节点

- 回滚机制:在升级失败时,可以快速回滚到之前的稳定版本

在Rancher中,可以使用以下命令升级Kubernetes组件:

kubeadm upgrade plan kubeadm upgrade apply v1.25.0

根据kubeadm upgrade plan命令的输出,选择合适的版本进行升级。

多集群应用部署

在多集群环境中,Rancher提供了多种部署应用的方法,包括:

- 单集群部署:将应用部署到单个集群

- 多集群部署:将应用同时部署到多个集群

- 分阶段部署:按阶段将应用部署到不同集群,便于测试和回滚

- 蓝绿部署:通过并行运行新旧版本应用,减少停机时间

所有者:此访问类型可以管理多集群应用的任何配置部分,包括模板版本,多集群应用特定的配置选项,应用的配置选项,可以与多集群应用交互的成员和指定针对项目 …

应用模板

Rancher提供了丰富的应用模板,涵盖了各种常见应用,如WordPress、Jenkins、Prometheus等。这些模板经过了优化和测试,确保在Kubernetes环境中的稳定运行。

使用应用模板部署应用:

rancher app create --template wordpress --project my-project

根据提示提供必要的参数,完成应用部署。

自定义应用

除了预定义的应用模板,Rancher也支持部署用户自定义的应用。用户可以上传自己的YAML文件或从GitHub等代码仓库拉取应用定义。

部署自定义应用:

rancher app create --file my-app.yml --project my-project

根据实际需求调整应用定义,然后保存文件。

集群监控和日志收集

为了确保多集群环境的健康运行,需要实施监控和日志收集系统。

集群监控

Rancher集成了Prometheus和Grafana,提供了全面的集群监控功能。默认情况下,Rancher会自动部署Prometheus和Grafana,监控Kubernetes集群的各种指标。

启用监控功能:

rancher app enable monitoring

配置监控参数,如数据保留期和告警阈值:

rancher setting set --name monitoring.retention --value '7 days' rancher setting set --name monitoring.alert.enabled --value true

访问Grafana仪表板,监控集群状态:

rancher app access monitoring/grafana

日志收集

Rancher也集成了ELK(Elasticsearch, Logstash, Kibana)或EFK(Elasticsearch, Fluentd, Kibana),提供了集中收集和分析日志的能力。

启用日志收集功能:

rancher app enable logging

配置日志收集参数,如数据保留期和日志类型:

rancher setting set --name logging.retention --value '7 days' rancher setting set --name logging.types --value 'container,host'

访问Kibana界面,搜索和分析日志:

rancher app access logging/kibana

集群安全和访问控制

在多集群环境中,安全性和访问控制变得尤为重要。Rancher提供了全面的安全功能,确保只有授权用户可以访问特定资源。

用户和角色管理

Rancher支持基于角色的访问控制(RBAC),可以根据用户角色和职责分配不同的权限。

创建新用户:

rancher user create --name my-user --email my-user@example.com

创建新角色:

rancher role create --name my-role

将用户添加到角色中:

rancher user add-to-role --user my-user --role my-role

设置角色的权限,指定其可以访问的资源和操作:

rancher role add-to-resource --role my-role --resource-type cluster --resource-id my-cluster --access-type read-write

认证和授权

Rancher支持多种认证方式,包括本地认证、LDAP/AD和SAML。根据企业安全策略选择合适的认证方式。

配置LDAP/AD集成:

rancher setting set --name auth.ldap.enabled --value true rancher setting set --name auth.ldap.url --value 'ldap://your-ldap-server:389' rancher setting set --name auth.ldap.binddn --value 'cn=admin,dc=example,dc=com' rancher setting set --name auth.ldap.bindpass --value 'your-ldap-password'

配置SAML集成:

rancher setting set --name auth.saml.enabled --value true rancher setting set --name auth.saml.idp.cert --value 'your-idp-cert' rancher setting set --name auth.saml.idp.url --value 'https://your-idp-url'

加密和签名

为了保护敏感数据,Rancher支持加密和签名功能。默认情况下,Rancher会自动加密存储在Etcd中的敏感信息。

配置Kubernetes Secrets加密:

kubectl create secret generic my-secret --from-literal=password='my-password'

配置Rancher的TLS设置:

rancher setting set --name tls.certificate --value '/path/to/certificate.pem' rancher setting set --name tls.key --value '/path/to/key.pem'

集群备份和恢复

为了防止数据丢失,定期备份Kubernetes集群的数据是必要的。Rancher提供了多种备份和恢复选项,确保在发生故障时可以快速恢复集群。

集群备份

Rancher支持使用多种工具进行集群备份,包括Velero、Kasten和原生Kubernetes备份工具。

使用Velero备份集群:

velero create backup my-backup --include-resources=namespaces,secrets,configmaps

根据实际需求调整备份参数,然后执行备份命令。

集群恢复

在需要恢复时,可以使用备份文件恢复集群。Rancher提供了直观的恢复界面,简化了恢复过程。

使用Velero恢复集群:

velero restore create --from-backup my-backup

根据提示提供必要的参数,完成集群恢复。

总结

在本节中,我们详细介绍了如何使用Rancher管理多个Kubernetes集群。从集群的添加和导入到配置和管理,从应用部署到监控和日志收集,从安全和访问控制到备份和恢复,我们提供了全面的指导。

通过使用Rancher,企业可以轻松管理多个Kubernetes集群,实现资源的集中管理和高效利用。在下一节中,我们将探讨多集群环境中的高级配置和最佳实践,帮助您进一步优化和管理复杂的Kubernetes环境。

高级配置与最佳实践

在构建和管理Kubernetes集群和Rancher平台时,了解高级配置选项和遵循最佳实践对于确保系统的稳定性和可靠性至关重要。本节将深入探讨如何优化Kubernetes集群和Rancher平台的配置,同时提供一些通用的最佳实践,帮助您构建一个安全、高效、可扩展的容器化应用环境。

集群高可用性配置

高可用性(HA)是企业级Kubernetes集群的关键特性,它通过冗余组件和自动故障转移机制,确保系统在部分组件故障时仍然能够正常运行。

多主节点配置

默认情况下,kubeadm创建的集群只有一个主节点。为了提高控制平面的可靠性,可以添加多个主节点。

在每个额外的主节点上执行kubeadm join命令时,指定其角色为控制平面节点:

kubeadm join 192.168.199.100:6443 --token your-token-here --discovery-token-ca-cert-hash sha256:your-hash-here --control-plane

加入完成后,验证新主节点是否已正确配置:

kubectl get nodes -l node-role.kubernetes.io/master

输出应该显示所有主节点都已正确标记。

etcd集群配置

默认情况下,kubeadm创建的集群使用单节点etcd。为了提高数据存储的可靠性,可以创建一个etcd集群。

首先,在每个etcd节点上安装etcd:

sudo yum install -y etcd

创建etcd配置文件(/etc/etcd/etcd.conf):

[Member] ETCD_NAME="etcd-1" ETCD_DATA_DIR="/var/lib/etcd/default.etcd" ETCD_LISTEN_PEER_URLS="http://192.168.199.100:2380" ETCD_LISTEN_CLIENT_URLS="http://192.168.199.100:2379"[Cluster] ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.199.100:2380" ETCD_INITIAL_CLUSTER="etcd-1=http://192.168.199.100:2380,etcd-2=http://192.168.199.101:2380,etcd-3=http://192.168.199.102:2380" ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster-token" ETCD_INITIAL_CLUSTER_STATE="new"[Security] ETCD_PEER_KEY_FILE="/etc/etcd/ssl/peer.key" ETCD_PEER_CERT_FILE="/etc/etcd/ssl/peer.crt" ETCD_PEER_TRUSTED_CA_FILE="/etc/etcd/ssl/ca.crt" ETCD_CLIENT_KEY_FILE="/etc/etcd/ssl/client.key" ETCD_CLIENT_CERT_FILE="/etc/etcd/ssl/client.crt" ETCD_CLIENT_TRUSTED_CA_FILE="/etc/etcd/ssl/ca.crt"

根据实际配置调整IP地址和证书路径,然后启动etcd服务:

sudo systemctl enable etcd sudo systemctl start etcd

在kubeadm初始化或加入命令中指定etcd集群:

kubeadm init --config kubeadm-config.yaml --etcd-servers "https://192.168.199.100:2379,https://192.168.199.101:2379,https://192.168.199.102:2379"

API Server负载均衡

为了提高API Server的可靠性,可以配置网络负载均衡器,将流量分发到多个API Server实例。

使用Nginx配置负载均衡:

sudo yum install -y nginx

创建Nginx配置文件(/etc/nginx/conf.d/k8s-api.conf):

upstream k8s_api {server 192.168.199.100:6443;server 192.168.199.101:6443;server 192.168.199.102:6443;

}server {listen 6443;server_name k8s-api.example.com;location / {proxy_pass http://k8s_api;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;proxy_set_header X-Forwarded-Proto $scheme;}

}

根据实际配置调整服务器IP地址和域名,然后启动Nginx服务:

sudo systemctl enable nginx sudo systemctl start nginx

网络配置优化

网络是Kubernetes集群的关键组成部分,优化网络配置可以显著提高集群的性能和可靠性。

CNI网络插件选择

Kubernetes支持多种CNI(Container Network Interface)网络插件,如Flannel、Calico、Weave等。根据实际需求选择合适的网络插件。

例如,使用Flannel配置网络:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

使用Calico配置网络:

kubectl apply -f https://docs.projectcalico.org/manifests/calico.yaml

根据实际需求选择合适的网络插件,并配置相应的参数。

网络策略配置

网络策略(Network Policy)是Kubernetes的一种资源,用于定义Pod之间的网络通信规则。通过网络策略,可以限制Pod之间的通信,提高系统的安全性。

创建网络策略:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata:name: my-network-policy spec:podSelector:matchLabels:app: my-appingress:- from:- podSelector:matchLabels:app: my-other-appports:- protocol: TCPport: 80

根据实际需求调整标签和端口配置,然后应用网络策略:

kubectl apply -f my-network-policy.yml

网络性能优化

为了提高网络性能,可以配置以下参数:

- kube-proxy:配置kube-proxy的模式,如userspace、iptables或IPVS。对于高流量场景,推荐使用IPVS模式。

kubectl edit cm kube-proxy -n kube-system

在配置文件中设置mode为"ipvs"。

- 网络接口:配置网络接口的MTU(最大传输单元)和RSS(Receive Side Scaling)参数,提高网络吞吐量。

ethtool -s eth0 rx-buffer-size 4096 ethtool -s eth0 tx-buffer-size 4096 ethtool -s eth0 rx-queues 4 ethtool -s eth0 tx-queues 4

- TCP参数:调整TCP参数,如tcp_tw_reuse、tcp_tw_recycle和tcp_fin_timeout,提高TCP连接的效率。

echo 1 > /proc/sys/net.ipv4.tcp_tw_reuse echo 1 > /proc/sys/net.ipv4.tcp_tw_recycle echo 30 > /proc/sys/net.ipv4.tcp_fin_timeout

存储配置优化

存储是Kubernetes集群的另一个关键组成部分,优化存储配置可以提高应用的数据访问效率和可靠性。

持久化存储配置

Kubernetes支持多种持久化存储选项,如NFS、GlusterFS、Ceph等。根据实际需求选择合适的存储解决方案。

配置NFS存储:

apiVersion: storage.k8s.io/v1 kind: StorageClass metadata:name: nfs-sc provisioner: nfs parameters:server: nfs-server.example.compath: /exports/data

创建持久化卷声明:

apiVersion: v1 kind: PersistentVolumeClaim metadata:name: my-pvc spec:accessModes:- ReadWriteOnceresources:requests:storage: 10GistorageClassName: nfs-sc

根据实际需求调整存储参数,然后应用配置。

存储性能优化

为了提高存储性能,可以配置以下参数:

- 文件系统:选择合适的文件系统,如ext4、XFS或btrfs。对于高吞吐量场景,推荐使用XFS文件系统。

mkfs.xfs /dev/sdb1

- 挂载选项:配置文件系统的挂载选项,如noatime、nodiratime和barrier=0,提高文件系统性能。

echo "/dev/sdb1 /data xfs defaults,noatime,nodiratime,barrier=0 0" >> /etc/fstab

- 缓存策略:配置缓存策略,如缓存模式和缓存大小,提高数据访问速度。

echo 1024 > /sys/block/sdb/queue/read_ahead_kb

安全配置优化

安全性是企业级Kubernetes集群的关键考虑因素。通过实施适当的安全措施,可以保护集群免受各种安全威胁。

隔离策略

Kubernetes提供了多种隔离机制,如Namespace、Security Context和Pod Security Policy,用于隔离不同应用和用户。

创建Namespace:

kubectl create namespace my-namespace

设置Namespace的配额和限制:

apiVersion: v1 kind: ResourceQuota metadata:name: my-quotanamespace: my-namespace spec:hard:requests.cpu: "2"requests.memory: "4Gi"limits.cpu: "4"limits.memory: "8Gi"

应用配额和限制:

kubectl apply -f my-quota.yml -n my-namespace

安全上下文

安全上下文(Security Context)是Pod规范的一部分,用于配置容器的运行环境,如用户ID、组ID和文件系统权限。

配置安全上下文:

apiVersion: v1

kind: Pod

metadata:name: my-pod

spec:securityContext:runAsUser: 1000runAsGroup: 1000fsGroup: 1000containers:- name: my-containerimage: my-imagevolumeMounts:- mountPath: /dataname: my-volumevolumes:- name: my-volumeemptyDir: {}

根据实际需求调整用户ID、组ID和文件系统权限,然后应用配置。

网络策略

网络策略(Network Policy)是Kubernetes的一种资源,用于定义Pod之间的网络通信规则。通过网络策略,可以限制Pod之间的通信,提高系统的安全性。

创建网络策略:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata:name: my-network-policy spec:podSelector:matchLabels:app: my-appingress:- from:- podSelector:matchLabels:app: my-other-appports:- protocol: TCPport: 80

根据实际需求调整标签和端口配置,然后应用网络策略:

kubectl apply -f my-network-policy.yml

日志和监控优化

日志和监控是Kubernetes集群管理和故障排除的关键工具。优化日志和监控配置可以提高系统的可见性和可控性。

日志收集优化

Kubernetes提供了多种日志收集选项,如ELK(Elasticsearch, Logstash, Kibana)和EFK(Elasticsearch, Fluentd, Kibana)。根据实际需求选择合适的日志收集解决方案。

配置Fluentd收集日志:

apiVersion: v1 kind: ConfigMap metadata:name: fluentd-confignamespace: kube-system data:fluent.conf: |<source>@type tailpath /var/log/containers/*.logpos_file /var/log/fluentd-containers.log.postag kubernetes.*<parse>@type json</parse></source><match kubernetes.*>@type elasticsearchhost elasticsearchport 9200logstash_format trueflush_interval 5</match>

应用Fluentd配置:

kubectl apply -f fluentd-config.yml

根据实际需求调整日志收集配置,然后应用配置。

监控优化

Kubernetes提供了多种监控选项,如Prometheus和Grafana。根据实际需求选择合适的监控解决方案。

配置Prometheus抓取Kubernetes指标:

- job_name: 'kubernetes'scrape_interval: 5skubernetes_sd_configs:- role: node- role: endpointsfilter_metric_name: kubernetes_io_rolefilter_metric_value: mastermetrics_path: /metricsscheme: http

应用Prometheus配置:

kubectl apply -f prometheus.yml

根据实际需求调整监控配置,然后应用配置。

备份和恢复优化

备份和恢复是Kubernetes集群灾难恢复的关键步骤。优化备份和恢复配置可以确保在发生故障时可以快速恢复集群。

集群备份优化

Kubernetes提供了多种备份选项,如Velero和Kasten。根据实际需求选择合适的备份解决方案。

配置Velero备份:

velero create backup my-backup --include-resources=namespaces,secrets,configmaps

根据实际需求调整备份参数,然后执行备份命令。

集群恢复优化

在需要恢复时,可以使用备份文件恢复集群。Velero提供了多种恢复选项,如完整恢复、部分恢复和时间点恢复。

恢复完整集群:

velero restore create --from-backup my-backup

恢复部分资源:

velero restore create --from-backup my-backup --resources=namespaces,secrets,configmaps

根据实际需求选择合适的恢复选项,然后执行恢复命令。

总结

在本节中,我们详细介绍了如何优化Kubernetes集群和Rancher平台的配置,同时提供了一些通用的最佳实践。从高可用性配置到网络优化,从存储配置到安全措施,从日志和监控到备份和恢复,我们提供了全面的指导。

通过遵循这些高级配置和最佳实践,您可以构建一个安全、高效、可扩展的容器化应用环境,为企业的数字化转型提供坚实的基础。

相关文章:

使用Rancher在CentOS 环境上部署和管理多Kubernetes集群

引言 随着容器技术的迅猛发展,Kubernetes已成为容器编排领域的事实标准。然而,随着企业应用规模的扩大,多集群管理逐渐成为企业IT架构中的重要需求。 Rancher作为一个开源的企业级多集群Kubernetes管理平台,以其友好的用户界面和…...

Java常用数据结构底层实现原理及应用场景

一、线性结构 1. ArrayList 底层实现:动态数组(Object[] elementData)。 核心特性: 默认初始容量为 10,扩容时容量增长为原来的 1.5 倍(int newCapacity oldCapacity (oldCapacity >> 1)…...

利用朴素贝叶斯对UCI 的 mushroom 数据集进行分类

朴素贝叶斯(Naive Bayes)是一种基于贝叶斯定理的简单而有效的分类算法,特别适合处理文本分类和多类别分类问题。UCI的Mushroom数据集是一个经典的分类数据集,包含蘑菇的特征和类别(可食用或有毒)。 1. 数据…...

Linux火墙管理及优化

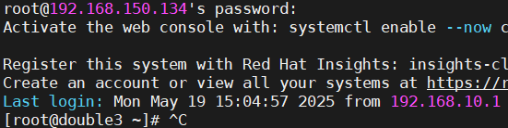

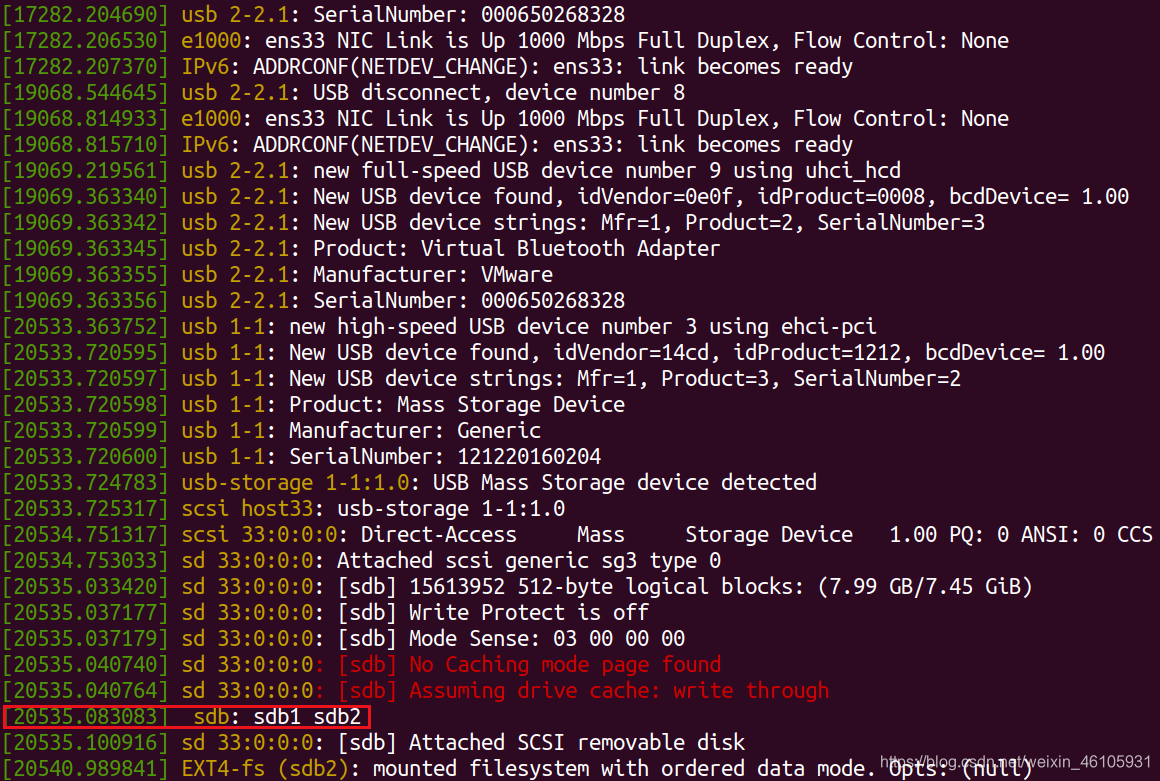

网络环境配置 使用3个新的虚拟机【配置好软件仓库和网络的】 F1 192.168.150.133 NAT F2 192.168.150.134 192.168.10.20 NAT HOST-ONLY 网络适配仅主机 F3 192.168.10.30 HOST-ONLY 网络适配仅主机 1 ~]# hostnamectl hostname double1.timinglee.org 【更…...

Visual Studio 制作msi文件环境搭建

一、插件安装 a. 插件寻找 在 Visual Studio 2017 中,如果你希望安装用于创建 MSI 安装包的插件,第一步是:打开 Visual Studio 后,点击顶部菜单栏中的 “工具”(Tools),然后选择下拉菜单中的 “…...

Java中常见的几种设计模式详解)

(Java基础笔记vlog)Java中常见的几种设计模式详解

前言: 在 Java 编程里,设计模式是被反复使用、多数人知晓、经过分类编目的代码设计经验总结。他能帮助开发者更高效地解决常见问题,提升代码的可维护性、可扩展性和复用性。下面介绍Java 中几种常见的设计模式。 单例模式(Singlet…...

C++ vector 深度解析:从原理到实战的全方位指南

一、引言 在 C 编程中,我们经常需要处理一组数据。比如,你想存储一个班级所有学生的成绩,或者保存用户输入的一组数字。最容易想到的方法是使用数组: int scores[100]; // 定义一个能存储100个成绩的数组但数组有两个明显的缺点…...

鸿蒙进阶——Framework之Want 隐式匹配机制概述

文章大纲 引言一、Want概述二、Want的类型1、显式Want2、隐式Want3、隐式Want的匹配 三、隐式启动Want 源码概述1、有且仅有一个Ability匹配2、有多个Ability 匹配需要弹出选择对话框3、ImplicitStartProcessor::ImplicitStartAbility3.1、GenerateAbilityRequestByAction3.1.1…...

antv/g6 图谱封装配置(二)

继上次实现图谱后,后续发现如果要继续加入不同样式的图谱实现起来太过麻烦,因此考虑将配置项全部提取封装到js文件中,图谱组件只专注于实现各种不同的组件,其中主要封装的点就是各个节点的横坐标(x),纵坐标…...

OpenCV CUDA模块图像过滤------用于创建一个最小值盒式滤波器(Minimum Box Filter)函数createBoxMinFilter()

操作系统:ubuntu22.04 OpenCV版本:OpenCV4.9 IDE:Visual Studio Code 编程语言:C11 算法描述 该函数创建的是一个 最小值滤波器(Minimum Filter),它对图像中每个像素邻域内的像素值取最小值。常用于&…...

网络抓包命令tcpdump及分析工具wireshark使用

文章目录 环境文档用途详细信息 环境 系统平台:Linux x86-64 Red Hat Enterprise Linux 8,Linux x86-64 Red Hat Enterprise Linux 7,Linux x86-64 SLES 12,银河麒麟 (鲲鹏),银河麒麟 (X86_64),银河麒麟(龙…...

linux strace调式定位系统问题

strace 的基本功能 strace 的主要功能包括: 跟踪系统调用:显示进程执行时调用的系统函数及其参数和返回值。监控信号:记录进程接收到的信号。性能分析:统计系统调用的执行时间和次数。调试支持:帮助定位程序崩溃、性…...

femap许可与云计算集成

随着云计算技术的迅猛发展,越来越多的企业开始将关键应用和服务迁移到云端,以享受其带来的弹性扩展、高效管理和成本优化等优势。Femap作为一款强大的电磁仿真工具,通过与云计算的集成,将为企业带来前所未有的许可管理和仿真分析体…...

车载诊断架构 --- 车载诊断有那些内容(上)

我是穿拖鞋的汉子,魔都中坚持长期主义的汽车电子工程师。 老规矩,分享一段喜欢的文字,避免自己成为高知识低文化的工程师: 钝感力的“钝”,不是木讷、迟钝,而是直面困境的韧劲和耐力,是面对外界噪音的通透淡然。 生活中有两种人,一种人格外在意别人的眼光;另一种人无论…...

【Hadoop】大数据技术之 HDFS

目录 一、HDFS 概述 1.1 HDFS 产出背景及定义 1.2 HDFS 优缺点 1.3 HDFS 组成架构 1.4 HDFS 文件块大小 二、HDFS 的Shell 操作 三、HDFS 的读写流程(面试重点) 3.1 HDFS 写数据流程 3.2 HDFS 读数据流程 四、DataNode 4.1 DataNode 的工作机制…...

聊一下CSS中的标准流,浮动流,文本流,文档流

在网络上关于CSS的文章中,有时候能听到“标准流”,“浮动流”,“定位流”等等词语,还有像“文档流”,“文本流”等词,这些流是什么意思?它们是CSS中的一些布局方案和特性。今天我们就来聊一下CS…...

ATGM332D-F8N22单北斗多频定位导航模块

ATGM332D-F8N 系列模块是 12.216mm 尺寸的高性能单北斗多频定位导航模块。该系列模块产品基于中科微新一代 SOC 单北斗多频芯片 AT9880B,支持北斗二号和北斗三号的 B1I、B1C、B2I、B3I、B2a 和 B2b 频点信号。 主要特征 多频点单北斗接收机 支持北斗二号、北斗三号…...

2024年热门AI趋势及回顾

人工智能的崛起 2024 年可能会被铭记为人工智能不再是一种技术新奇事物,而是成为现实的一年。微软、Salesforce 和 Intuit 等巨头将人工智能融入主流企业解决方案;从文案写作到数据分析,专门的人工智能应用程序和服务如雨后春笋般涌现&#…...

【信息系统项目管理师】第20章:高级项目管理 - 28个经典题目及详解

更多内容请见: 备考信息系统项目管理师-专栏介绍和目录 文章目录 【第1题】【第2题】【第3题】【第4题】【第5题】【第6题】【第7题】【第8题】【第9题】【第10题】【第11题】【第12题】【第13题】【第14题】【第15题】【第16题】【第17题】【第18题】【第19题】【第20题】【第…...

3. OpenManus-RL中使用AgentGym建立强化学习环境

AgentGym概述 AgentGym是为评估和开发大模型agent而设计的支持多环境和多任务的框架。该框架统一采用ReAct格式,提供多样化的交互环境和任务,支持实时反馈和并发操作。 What is Ai Agent(基于大模型的智能体)? 首先是人造实体&…...

C++性能测试工具——sysprof的使用

一、sysprof sysprof相对于前面的一些性能测试工具来说,要简单不少。特别是其图形界面的操作,非常容易上手,它还支持分析文件的保存和导入功能,这是一个非常不错的功能。做为一款系统性能测试工具,它支持多种硬件平台…...

:性能测试与持续优化)

JavaScript性能优化实战(13):性能测试与持续优化

在前面的系列文章中,我们探讨了各种JavaScript性能优化的方法和实战案例。然而,优化工作不应仅是一次性的努力,而应当成为开发流程中的常态。本篇将聚焦于如何建立系统化的性能测试体系,并实现持续的性能优化机制,确保应用长期保持出色的性能表现。 前端性能测试体系构建…...

questions and answers_1

TCP 长连接和短连接有什么区别? TCP 短连接是指客户端与服务端连接后只进行一次读写就关闭连接,一般是客户端关闭。 而长连接则是指在进行完一次读写后不关闭连接,直到服务端压力过大则选择关闭一些长时间为进行读写的连接。 TCP 短连接的优…...

树莓派内核源码的下载,配置,编译和替换

共享文件夹的创建 ubuntu创建共享文件夹可以实现和本地windows跨系统文件共享 下面是创建步骤 先在windows准备一个文件夹来当做共享文件夹 树莓派内核源码下载 1.在树莓派终端输入以下指令查看内核版本 uname -r我这里是已经编译替换过后的版本 2.选择树莓派对应的版本号下…...

CentOS停止维护了,解决yum不能安装软件的问题

最近在使用CentOS的yum命令安装软件时,出现了如下错误: 原因: 这是因为CentOS在2024 年 6 月 30 日停止维护了,同时也移除了相关的软件镜像仓库,导致网站地址访问不了,从而下载不了软件。 解决方法…...

过压保护电路设计和计算

设备供电电压因各种原因变得过高会烧坏设备,因此可以在前级加过压保护电路。 稳压二极管+PMOS 电路分析 1、当输入电压 Vin < 5.1V 时:(下图以输入电压 Vin = 5V 举例) D1是5.1V稳压管,此时输入电压Vin才5V,小于5.1V,所以稳压管D1未进入稳压状态,不导通。 5.1V稳…...

20250523-BUG:无法加载“GameLib/Framework.h“头文件(已解决)

BUG:无法加载"GameLib/Framework.h"头文件(已解决) 最近在打开新的C项目时报了这个错,我是按照以下步骤来排除的BUG,希望对您有所帮助~ 检查【C/C】-【附加包含目录】中的路径有无问题,一般需要加…...

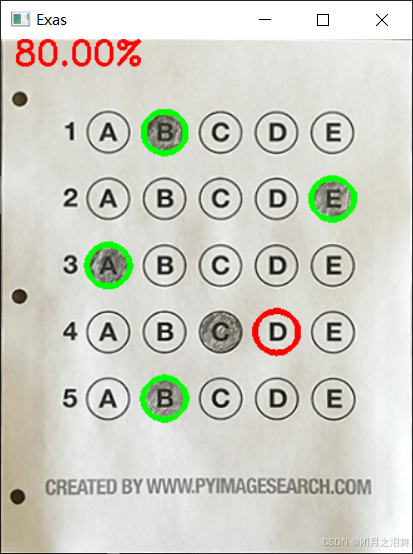

OpenCv高阶(8.0)——答题卡识别自动判分

文章目录 前言一、代码分析及流程讲解(一)初始化模块正确答案映射字典(题目序号: 正确选项索引)图像显示工具函数 (二)轮廓处理工具模块(三)几何变换核心模块 二、主处理流程图像读取…...

Python语法特点与编码规范

注释 单行注释 把#号当做注释符号 多行注释 python中并没有规定多行注释标记,通常使用单引号作为多行注释 中文注释 规定文件所用编码,当时是为解决python2不支持中文的问题 #codingutf-8代码缩进 python采用代码缩进和冒号区分代码层次,…...

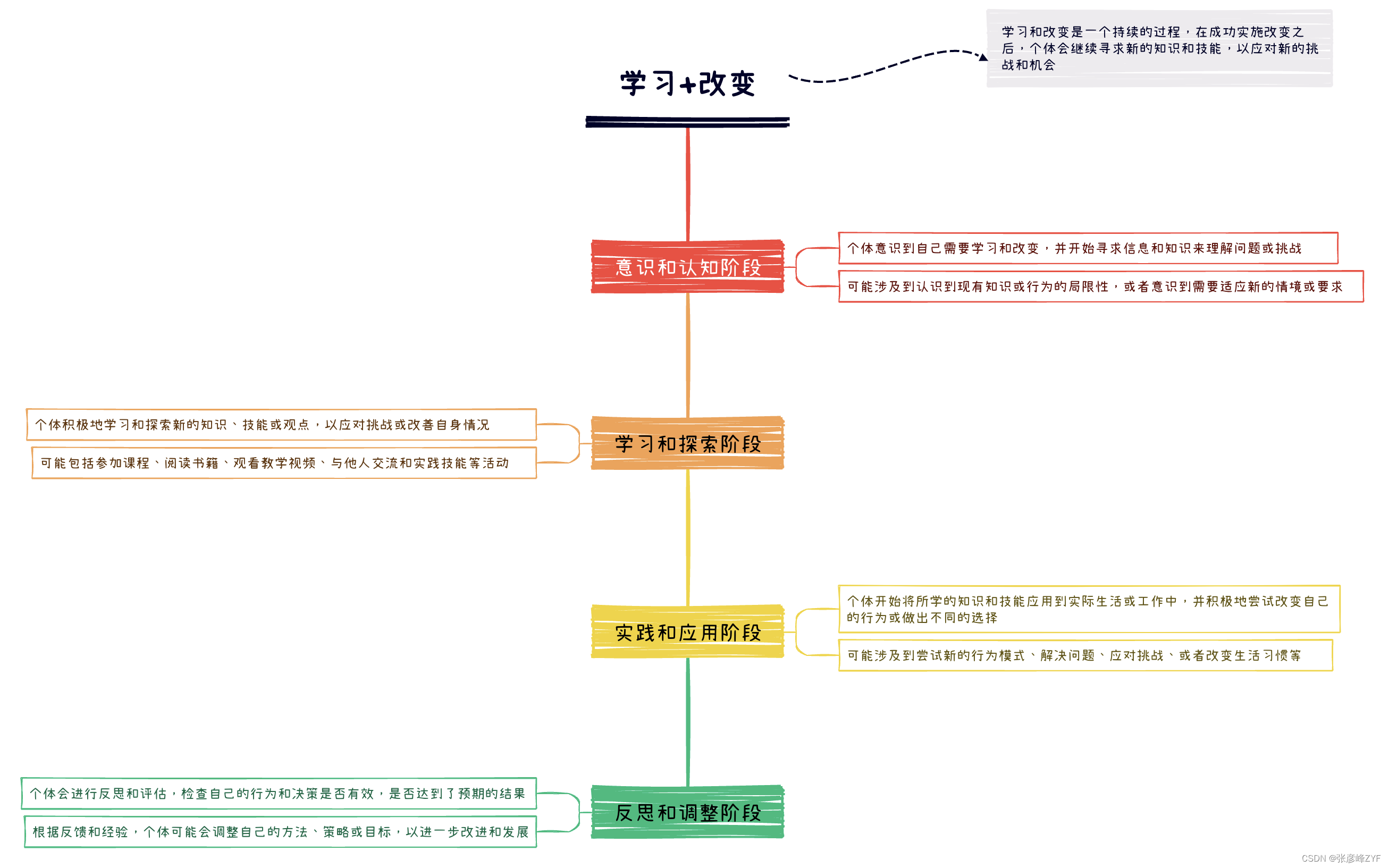

反本能---如何对抗你的习以为常

目录 一、概述 二、自我提升 (一)我们为什么总想拖延 (二)如何有效应对拖延 (三)如何更好的自我控制 (四)为啥付出了没有回报 (五)如何提高学习效率 三…...