Transformer架构详解:从Attention到ChatGPT

Transformer架构详解:从Attention到ChatGPT

系统化学习人工智能网站(收藏):https://www.captainbed.cn/flu

文章目录

- Transformer架构详解:从Attention到ChatGPT

- 摘要

- 引言

- 一、Attention机制:Transformer的数学基石

- 1.1 原始Attention公式推导

- 1.2 多头注意力(Multi-Head Attention)

- 二、Transformer架构详解

- 2.1 原始Encoder-Decoder结构

- 2.2 GPT系列的架构演进

- 三、ChatGPT的技术实现分析

- 3.1 预训练阶段

- 3.2 指令微调与对齐

- 四、Transformer的挑战与未来方向

- 4.1 核心挑战

- 4.2 未来趋势

- 结论

摘要

Transformer架构自2017年提出以来,已成为自然语言处理(NLP)领域的核心范式,并逐步向计算机视觉、语音识别等多模态领域渗透。本文从Attention机制出发,系统解析Transformer架构的演进路径、技术细节及其在GPT系列模型中的工程化实践。通过对比原始论文《Attention Is All You Need》与ChatGPT的技术实现,揭示预训练语言模型(PLM)的核心挑战与突破方向,为AI从业者提供从理论到落地的完整知识图谱。

引言

2017年,Google团队在论文《Attention Is All You Need》中提出Transformer架构,彻底颠覆了传统RNN/LSTM的序列建模范式。其核心创新在于:

- 并行化能力:通过自注意力机制(Self-Attention)消除时序依赖,支持GPU并行计算;

- 长程依赖建模:Attention权重矩阵直接捕获全局信息,克服RNN的梯度消失问题;

- 多头注意力:通过并行化注意力头提升特征提取维度。

随后五年间,Transformer架构经历了三次技术跃迁:

- BERT时代(2018-2020):双向编码器架构统治NLP预训练;

- GPT时代(2020-2022):自回归解码器架构实现生成式AI突破;

- 多模态时代(2022-至今):ViT、Swin Transformer等变体推动跨模态融合。

本文将从数学原理、工程实现、应用场景三个维度,深度剖析Transformer架构的技术内核与ChatGPT的实现逻辑。

一、Attention机制:Transformer的数学基石

1.1 原始Attention公式推导

import torch

import torch.nn as nn

import mathclass ScaledDotProductAttention(nn.Module):def __init__(self):super().__init__()self.scale = math.sqrt(512) # 假设d_k=512def forward(self, Q, K, V):# Q,K,V形状: (batch_size, seq_len, d_model)scores = torch.matmul(Q, K.transpose(-2, -1)) / self.scale # (batch, seq_len, seq_len)attn_weights = nn.functional.softmax(scores, dim=-1) # 注意力权重output = torch.matmul(attn_weights, V) # 加权求和return output, attn_weights

核心公式:

[

\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V

]

- Q/K/V:查询(Query)、键(Key)、值(Value)向量,通过线性变换从输入序列生成;

- 缩放因子:(\sqrt{d_k})防止点积结果进入softmax的梯度饱和区;

- 复杂度:(O(n^2 \cdot d))(n为序列长度,d为特征维度)。

1.2 多头注意力(Multi-Head Attention)

class MultiHeadAttention(nn.Module):def __init__(self, d_model=512, num_heads=8):super().__init__()self.d_k = d_model // num_headsself.num_heads = num_headsself.linear_q = nn.Linear(d_model, d_model)self.linear_k = nn.Linear(d_model, d_model)self.linear_v = nn.Linear(d_model, d_model)self.linear_out = nn.Linear(d_model, d_model)self.attn = ScaledDotProductAttention()def forward(self, Q, K, V):batch_size = Q.size(0)# 线性变换Q = self.linear_q(Q).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)K = self.linear_k(K).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)V = self.linear_v(V).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)# 并行计算多头注意力attn_output, _ = self.attn(Q, K, V) # (batch, num_heads, seq_len, d_k)# 拼接多头结果attn_output = attn_output.transpose(1, 2).contiguous().view(batch_size, -1, self.num_heads * self.d_k)return self.linear_out(attn_output)

关键设计:

- 并行化:将Q/K/V拆分为多个头(如8头),每个头独立计算注意力;

- 维度保持:通过线性变换保证输出维度与输入一致;

- 工程意义:提升模型对不同子空间的特征提取能力。

二、Transformer架构详解

2.1 原始Encoder-Decoder结构

核心组件:

-

位置编码(Positional Encoding):

[

PE_{(pos, 2i)} = \sin\left(\frac{pos}{10000^{2i/d_{model}}}\right)

]

[

PE_{(pos, 2i+1)} = \cos\left(\frac{pos}{10000^{2i/d_{model}}}\right)

]

将绝对位置信息注入模型,解决自注意力机制的排列不变性问题。 -

残差连接与LayerNorm:

- 缓解深层网络梯度消失;

- 加速收敛并稳定训练。

-

掩码自注意力(Masked Self-Attention):

- 在Decoder中防止信息泄露,确保生成过程的自回归性。

2.2 GPT系列的架构演进

| 模型 | 发布时间 | 参数规模 | 训练数据量 | 架构特点 |

|---|---|---|---|---|

| GPT-1 | 2018.6 | 1.17亿 | 5GB文本 | 12层Decoder-Only |

| GPT-2 | 2019.2 | 15亿 | 40GB文本 | 48层Decoder-Only,上下文学习 |

| GPT-3 | 2020.5 | 1750亿 | 45TB文本 | 96层Decoder-Only,稀疏注意力 |

| GPT-4 | 2023.3 | 1.8万亿 | 13万亿Token | 多模态混合专家架构 |

关键突破:

- 规模定律(Scaling Law):OpenAI发现模型性能与参数规模、数据量、计算量呈幂律关系;

- 上下文学习(In-Context Learning):通过提示词(Prompt)引导模型生成,无需微调;

- 指令微调(Instruction Tuning):使用人类反馈强化学习(RLHF)对齐模型输出。

三、ChatGPT的技术实现分析

3.1 预训练阶段

-

数据工程:

- 数据来源:Common Crawl、书籍、维基百科、代码库等;

- 去重清洗:使用MinHash算法过滤重复文本;

- 质量过滤:基于语言模型打分剔除低质量数据。

-

模型训练:

- 硬件配置:1万个A100 GPU,训练时间约1个月;

- 优化策略:

- 混合精度训练(FP16+FP32);

- ZeRO优化器减少显存占用;

- 梯度检查点(Gradient Checkpointing)平衡计算与显存。

3.2 指令微调与对齐

# 伪代码:RLHF训练流程

def rlhf_training(model, reward_model, ppo_optimizer):for step in range(num_steps):# 1. 生成候选回复prompt = get_random_prompt()candidates = model.generate(prompt, num_beams=4)# 2. 奖励模型打分scores = reward_model.predict(prompt, candidates)# 3. PPO优化advantages = scores - baseline # 计算优势函数loss = ppo_optimizer.step(model, prompt, candidates, advantages)# 4. 更新基线baseline = update_baseline(scores)

关键技术:

- 监督微调(SFT):使用人类标注的对话数据调整模型输出风格;

- 奖励建模(RM):训练一个打分模型评估回复质量;

- 近端策略优化(PPO):在保持模型生成能力的同时优化奖励目标。

四、Transformer的挑战与未来方向

4.1 核心挑战

-

计算效率:

- 自注意力复杂度:(O(n^2))导致长文本处理成本高昂;

- 解决方案:稀疏注意力(如BigBird)、局部敏感哈希(LSH)。

-

能源消耗:

- GPT-3训练耗电约1287兆瓦时,相当于120个美国家庭年用电量;

- 研究方向:模型蒸馏、量化压缩、硬件协同优化。

-

伦理风险:

- 虚假信息生成、数据隐私泄露、算法偏见等问题;

- 应对措施:可解释性研究(如LIME、SHAP)、水印技术。

4.2 未来趋势

-

多模态融合:

- CLIP/Flamingo:联合训练文本与图像Transformer;

- Gato:单模型处理604种不同任务。

-

硬件加速:

- TPU v4:支持16384个芯片互联,提供1 exaFLOPS算力;

- 光计算芯片:突破冯·诺依曼瓶颈,降低数据搬运能耗。

-

认知架构:

- 神经符号系统:结合Transformer的感知能力与符号推理;

- 世界模型:通过自监督学习构建环境动态模型。

结论

Transformer架构的崛起标志着AI进入"大数据+大模型"时代。从Attention机制的数学优雅,到ChatGPT的工程奇迹,其发展历程印证了"简单原理+规模效应"的技术哲学。然而,当前模型仍面临计算效率、能源消耗、伦理风险等瓶颈。未来五年,随着稀疏计算、多模态融合、神经符号系统等技术的突破,Transformer有望从"语言专家"进化为"通用智能体",最终实现人类水平的认知能力。

相关文章:

Transformer架构详解:从Attention到ChatGPT

Transformer架构详解:从Attention到ChatGPT 系统化学习人工智能网站(收藏):https://www.captainbed.cn/flu 文章目录 Transformer架构详解:从Attention到ChatGPT摘要引言一、Attention机制:Transformer的…...

数据中台(大数据平台)之数据安全管理

数据安全管理是结合大数据技术和行业特性,数据中台产品应具备数据分类分级、敏感数据智能识别的功能,并结合敏感数据管理、数据脱敏、数据加密等安全管控方式,保障数据安全可用。 1.安全分级分类:数据分级分类是一种将不同数据按…...

github双重验证密码忘记或者获取不了了怎么办

背景 近期由于换了新手机,之前配置好的Authenticator这个App无法使用,导致获取不到二次验证的Authenticator code,登陆不上GitHub,不知道有没有人和我遇到同样的问题? 当我们配置2FA双重验证后,每次登陆gi…...

告别复杂操作!电脑极简风格计时使用

无论是工作、学习还是日常生活,这款小巧实用的计时工具都能成为你掌控时间的好帮手。特别适合需要频繁切换正计时、倒计时和查看当前时间的场景。界面简洁,操作便捷,助你高效管理每一刻。 这是一款免安装的工具,下载后可直接打开…...

stm32cube ide如何将工具链替换成arm-none-eabi-gcc

在 STM32Cube IDE 中替换工具链为GNU Arm Embedded Toolchain (arm-none-eabi-gcc),可按以下步骤操作: 1. 检查是否已安装工具链 首先确认系统中是否已安装 arm-none-eabi-gcc: Windows:检查环境变量 PATH 中是否包含工具链路径…...

[STM32问题解决(2)]STM32通过串口与PC通信,打开串口助手后无法在打开状态下下载程序和复位STM32

问题回顾 最近学习STM32单片机,经常使用STM32通过USART1串口与PC的串口助手进行通信。为了简单便捷,通常在打开串口的状态下下载程序。这样子下载程序后,STM32发出的信号,PC马上可以收到。 但是,突然出现了一个问题&a…...

)

RabbitMQ 与其他 MQ 的对比分析:Kafka/RocketMQ 选型指南(二)

四、三者性能大比拼 4.1 吞吐量 吞吐量是衡量消息队列处理能力的重要指标,它反映了在单位时间内消息队列能够处理的消息数量。在这方面,Kafka 表现最为出色,其独特的设计使其能够轻松处理每秒数百万条消息 。Kafka 采用分布式架构和分区机制…...

OpenHarmony定制系统组合按键(一)

一、开发环境 系统版本:OpenHarmony 4.0.10.13 设备平台:rk3568 SDK版本:fullSDK 4.0.10.13 DevEco Studio版本:4.1.0.400 二、需求背景 定制OpenHarmony 系统组合按键功能,例如仿Android Power VOL_Up组合键实现截…...

ORDER BY子句在一个 SQL 查询中只能出现一次

order by A.create_time,A.update_time desc和 order by A.create_time desc,A.update_time desc有区别吗? 关键区别 第一个排序中 create_time 是升序(默认是ASC),第二个是降序(DESC) 只有在 DESC 关键字紧跟在列名后面时,该列才会按降序排…...

Spring Boot 3 整合 MQ 构建聊天消息存储系统

引子 在构建实时聊天服务时,我们既要保证消息的即时传递,又需要对消息进行持久化存储以便查询历史记录。然而,直接同步写入数据库在高并发场景下容易成为性能瓶颈,影响消息的实时性。秉承"没有什么问题是加一层解决不了的&q…...

DeepSeek实战:打造智能数据分析与可视化系统

DeepSeek实战:打造智能数据分析与可视化系统 1. 数据智能时代:DeepSeek数据分析系统入门 在数据驱动的决策时代,智能数据分析系统正成为企业核心竞争力。本节将使用DeepSeek构建一个从数据清洗到可视化分析的全流程智能系统。 1.1 系统核心功能架构 class DataAnalysisS…...

非线性声学计算与强化学习融合框架:突破复杂环境人机交互的新技术

随着人工智能的快速发展,尤其是在深度学习和强化学习领域,声学计算和人机交互进入前所未有的扩展和创新阶段。尽管传统声学方法取得了显著成功,但这些线性或准线性方法在实际环境中往往存在关键的不足,尤其在动态、复杂或混响环境…...

C++ - STL #什么是STL #STL的版本 #闭源开源 #STL的六大组件

文章目录 前言 一、什么是STL 二、STL的版本 1、原始版本 2、P.J.版本 3、RW版本 4、SGI版本 三、闭源、开源 四、STL的六大组件 总结 前言 路漫漫其修远兮,吾将上下而求索; 一、什么是STL STL(standard template libaray 标准模板库)&#…...

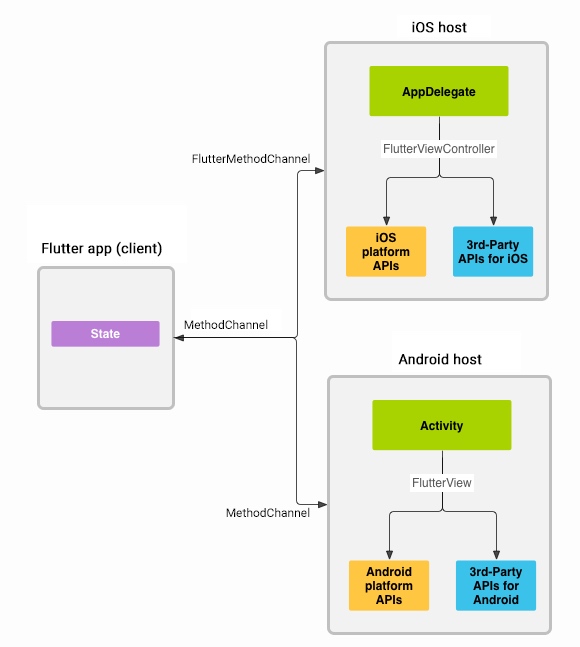

Flutter - 原生交互 - 相机Camera - 01

环境 Flutter 3.29 macOS Sequoia 15.4.1 Xcode 16.3 集成 Flutter提供了camera插件来拍照和录视频,它提供了一系列可用的相机,并使用特定的相机展示相机预览、拍照、录视频。 添加依赖 camera: 提供使用设备相机模块的工具path_provider: 寻找存储图…...

湖北理元理律师事务所:个人债务管理的温度与精度

湖北理元理律师事务所:个人债务管理的温度与精度 面对信用卡、网贷、医疗债等多重债务压力,普通人常陷入“拆东墙补西墙”的恶性循环。湖北理元理律师事务所通过计划集团公司服务平台,推出“有温度的债务优化计划”,其人性化设计…...

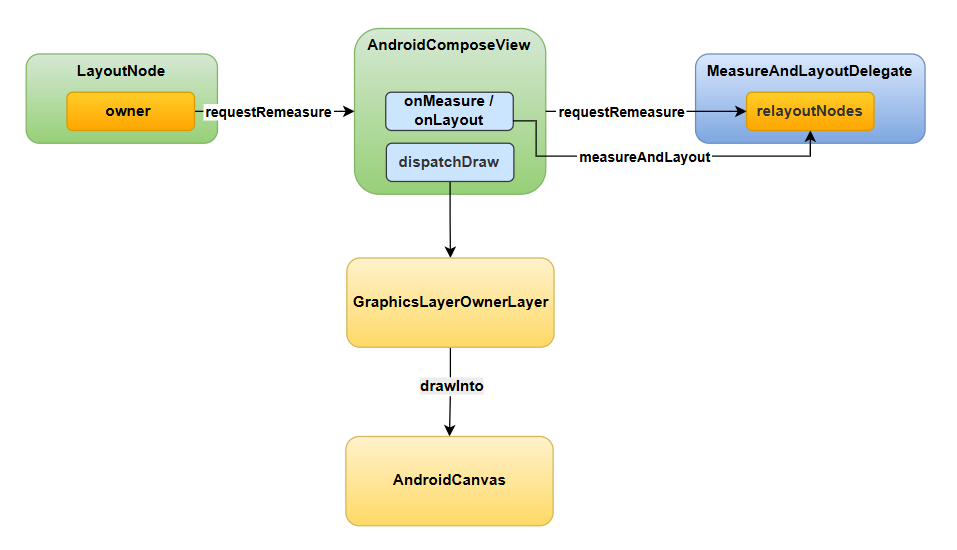

Compose原理 - 整体架构与主流程

一、整体架构 在官方文档中(Jetpack Compose 架构层 | Android Developers),对Compose的分层有所阐述: 其中 Runtime:提供Compose的基础运行能力,包括State、Side-effects、CompositionLocal、Compositio…...

从0开始学vue:实现一个简单页面

Vue.js 是一个渐进式JavaScript框架,用于构建用户界面。下面我将带你从零开始学习Vue.js并创建一个简单的可运行页面。 1. 准备工作 首先,你需要了解几种学习Vue.js的方式: 方式一:使用CDN引入(最简单的方式&#x…...

在机器视觉测量和机器视觉定位中,棋盘格标定如何影响精度

棋盘格标定是机器视觉(尤其是基于相机的系统)中进行相机内参(焦距、主点、畸变系数)和外参(相机相对于世界坐标系的位置和姿态)标定的经典且广泛应用的方法。它的质量直接、显著且多方面地影响最终的视觉测量和定位精度。 以下是棋盘格标定如何影响精度的详细分析: 标定…...

CppCon 2014 学习: C++ Test-driven Development

“Elephant in the Room”这个比喻常用来形容那些大家都知道但没人愿意讨论的重大问题。 这段内容讲的是软件质量管理的经典做法和潜在的问题: 经典做法:开发完成后才进行人工测试(manual testing after creation)。隐喻“Cape o…...

RAGflow详解及实战指南

目录 前言 一、RAGflow核心技术解析 1. 技术原理:检索与生成的协同进化 2. 架构设计:分层模块化与高扩展性 3. 核心优势:精准、高效、安全 二、RAGflow实战应用场景 1. 企业知识库搭建 2. 智能客服系统 3. 投资分析报告生成 4. 制造…...

JWT 不对外,Session ID 对外:构建安全可控的微服务认证架构

以下是一篇围绕“JWT不对外,Session ID对外”的专业架构设计文章,适用于技术团队评审、技术博客发布或系统设计文档引用: JWT 不对外,Session ID 对外:构建安全可控的微服务认证架构 在构建分布式微服务系统时&#x…...

[Godot] 如何导出安卓 APK 并在手机上调试

在之前的文章中,我们已经详细介绍了如何配置 Godot 的安卓应用开发环境,包括安装 Android SDK、配置 Java 环境、设置 Godot 的 Android 导出模板等。本篇文章将进一步讲解如何将 Godot 项目导出为安卓 APK 文件,并实现在手机上进行调试运行。…...

React 路由管理与动态路由配置实战

React 路由管理与动态路由配置实战 前言 在现代单页应用(SPA)开发中,路由管理已经成为前端架构的核心部分。随着React应用规模的扩大,静态路由配置往往难以满足复杂业务场景的需求,尤其是当应用需要处理权限控制、动态菜单和按需加载等高级…...

ZYNQ sdk lwip配置UDP组播收发数据

🚀 一、颠覆认知:组播 vs 单播 vs 广播 通信方式目标设备网络负载典型应用场景单播1对1O(n)SSH远程登录广播1对全网O(1)ARP地址解析组播1对N组O(1)视频会议/物联网群控创新价值:在智能工厂中,ZYNQ通过组播同时控制100台AGV小车,比传统单播方案降低92%网络流量! 🔧 二、…...

11.21 LangGraph多轮对话系统实战:三步构建高效信息整理引擎,效率提升300%!

关键词:LangGraph 工作流设计, 信息整理助理, 多轮对话系统, 状态管理, 条件分支控制 信息整理助理工作流设计 信息整理助理需要完成 多源数据收集 → 信息分类 → 深度分析 → 结构化输出 的完整流程。通过 LangGraph 的图结构工作流,可实现复杂逻辑的模块化编排: #mermai…...

高光谱成像相机:基于高光谱成像技术的玉米种子纯度检测研究

种子纯度是衡量种子质量的核心指标之一,直接影响农作物产量与品质。传统检测方法(如形态学观察、生化分析)存在耗时长、破坏样本、依赖人工等缺陷。近年来,高光谱成像技术因其融合光谱与图像信息的优势,成为无损检测领…...

Linux《文件系统》

在之前的系统IO当中已经了解了“内存”级别的文件操作,了解了文件描述符、重定向、缓冲区等概念,在了解了这些的知识之后还封装出了我们自己的libc库。接下来在本篇当中将会将视角从内存转向磁盘,研究文件在内存当中是如何进行存储的…...

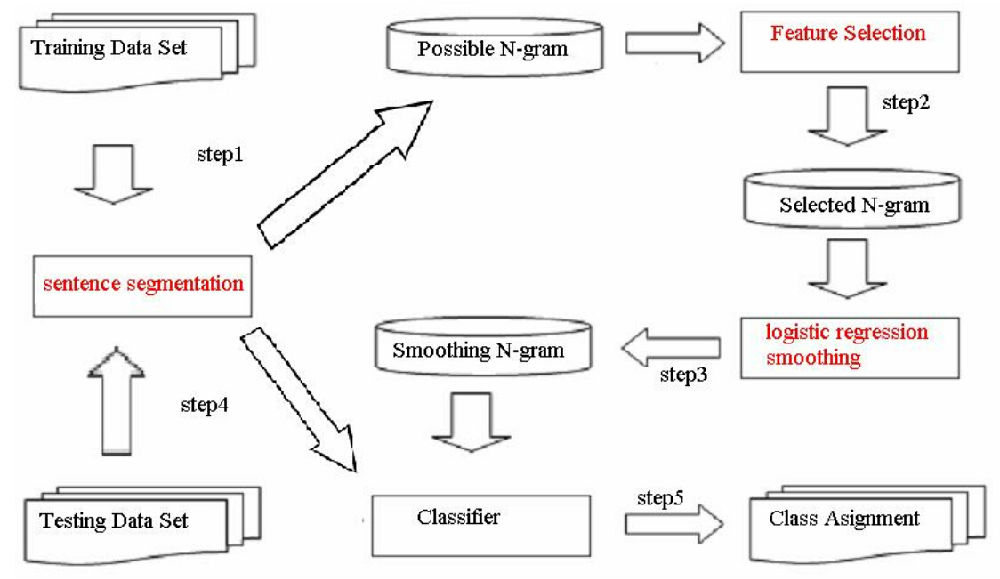

NLP学习路线图(十六):N-gram模型

一、为何需要语言模型?概率视角下的语言本质 自然语言处理的核心挑战在于让机器“理解”人类语言。这种理解的一个关键方面是处理语言的歧义性、创造性和结构性。语言模型(Language Model, LM)为此提供了一种强大的数学框架:它赋…...

数据-可自定义key和value)

【Python办公】将Excel表格转json(字典)数据-可自定义key和value

目录 专栏导读背景介绍库的安装数据源准备代码1:key1列,value所有列代码1:key多列,value所有列代码3:key自选,value自选总结专栏导读 🌸 欢迎来到Python办公自动化专栏—Python处理办公问题,解放您的双手 🏳️🌈 博客主页:请点击——> 一晌小贪欢的博客主页求关…...

Java内存区域与内存溢出异常分析与解决

在 Java 开发中,内存管理和内存溢出异常( OutOfMemoryError)是一个至关重要的主题。Java 虚拟机(JVM)的内存区域分为多个部分,每个区域都有其特定的用途和限制。当这些区域的内存耗尽时,就会触发…...