二 根据用户行为数据创建ALS模型并召回商品

二 根据用户行为数据创建ALS模型并召回商品

2.0 用户行为数据拆分

-

方便练习可以对数据做拆分处理

- pandas的数据分批读取 chunk 厚厚的一块 相当大的数量或部分

import pandas as pd reader = pd.read_csv('behavior_log.csv',chunksize=100,iterator=True) count = 0; for chunk in reader:count += 1if count ==1:chunk.to_csv('test4.csv',index = False)elif count>1 and count<1000:chunk.to_csv('test4.csv',index = False, mode = 'a',header = False)else:break pd.read_csv('test4.csv')

2.1 预处理behavior_log数据集

- 创建spark session

import os

# 配置spark driver和pyspark运行时,所使用的python解释器路径

PYSPARK_PYTHON = "/home/hadoop/miniconda3/envs/datapy365spark23/bin/python"

JAVA_HOME='/home/hadoop/app/jdk1.8.0_191'

# 当存在多个版本时,不指定很可能会导致出错

os.environ["PYSPARK_PYTHON"] = PYSPARK_PYTHON

os.environ["PYSPARK_DRIVER_PYTHON"] = PYSPARK_PYTHON

os.environ['JAVA_HOME']=JAVA_HOME

# spark配置信息

from pyspark import SparkConf

from pyspark.sql import SparkSessionSPARK_APP_NAME = "preprocessingBehaviorLog"

SPARK_URL = "spark://192.168.199.188:7077"conf = SparkConf() # 创建spark config对象

config = (("spark.app.name", SPARK_APP_NAME), # 设置启动的spark的app名称,没有提供,将随机产生一个名称("spark.executor.memory", "6g"), # 设置该app启动时占用的内存用量,默认1g("spark.master", SPARK_URL), # spark master的地址("spark.executor.cores", "4"), # 设置spark executor使用的CPU核心数# 以下三项配置,可以控制执行器数量

# ("spark.dynamicAllocation.enabled", True),

# ("spark.dynamicAllocation.initialExecutors", 1), # 1个执行器

# ("spark.shuffle.service.enabled", True)

# ('spark.sql.pivotMaxValues', '99999'), # 当需要pivot DF,且值很多时,需要修改,默认是10000

)

# 查看更详细配置及说明:https://spark.apache.org/docs/latest/configuration.htmlconf.setAll(config)# 利用config对象,创建spark session

spark = SparkSession.builder.config(conf=conf).getOrCreate()

- 从hdfs中加载csv文件为DataFrame

# 从hdfs加载CSV文件为DataFrame

df = spark.read.csv("hdfs://localhost:9000/datasets/behavior_log.csv", header=True)

df.show() # 查看dataframe,默认显示前20条

# 大致查看一下数据类型

df.printSchema() # 打印当前dataframe的结构

显示结果:

+------+----------+----+-----+------+

| user|time_stamp|btag| cate| brand|

+------+----------+----+-----+------+

|558157|1493741625| pv| 6250| 91286|

|558157|1493741626| pv| 6250| 91286|

|558157|1493741627| pv| 6250| 91286|

|728690|1493776998| pv|11800| 62353|

|332634|1493809895| pv| 1101|365477|

|857237|1493816945| pv| 1043|110616|

|619381|1493774638| pv| 385|428950|

|467042|1493772641| pv| 8237|301299|

|467042|1493772644| pv| 8237|301299|

|991528|1493780710| pv| 7270|274795|

|991528|1493780712| pv| 7270|274795|

|991528|1493780712| pv| 7270|274795|

|991528|1493780712| pv| 7270|274795|

|991528|1493780714| pv| 7270|274795|

|991528|1493780765| pv| 7270|274795|

|991528|1493780714| pv| 7270|274795|

|991528|1493780765| pv| 7270|274795|

|991528|1493780764| pv| 7270|274795|

|991528|1493780633| pv| 7270|274795|

|991528|1493780764| pv| 7270|274795|

+------+----------+----+-----+------+

only showing top 20 rowsroot|-- user: string (nullable = true)|-- time_stamp: string (nullable = true)|-- btag: string (nullable = true)|-- cate: string (nullable = true)|-- brand: string (nullable = true)

- 从hdfs加载数据为dataframe,并设置结构

from pyspark.sql.types import StructType, StructField, StringType, IntegerType, LongType

# 构建结构对象

schema = StructType([StructField("userId", IntegerType()),StructField("timestamp", LongType()),StructField("btag", StringType()),StructField("cateId", IntegerType()),StructField("brandId", IntegerType())

])

# 从hdfs加载数据为dataframe,并设置结构

behavior_log_df = spark.read.csv("hdfs://localhost:8020/datasets/behavior_log.csv", header=True, schema=schema)

behavior_log_df.show()

behavior_log_df.count()

显示结果:

+------+----------+----+------+-------+

|userId| timestamp|btag|cateId|brandId|

+------+----------+----+------+-------+

|558157|1493741625| pv| 6250| 91286|

|558157|1493741626| pv| 6250| 91286|

|558157|1493741627| pv| 6250| 91286|

|728690|1493776998| pv| 11800| 62353|

|332634|1493809895| pv| 1101| 365477|

|857237|1493816945| pv| 1043| 110616|

|619381|1493774638| pv| 385| 428950|

|467042|1493772641| pv| 8237| 301299|

|467042|1493772644| pv| 8237| 301299|

|991528|1493780710| pv| 7270| 274795|

|991528|1493780712| pv| 7270| 274795|

|991528|1493780712| pv| 7270| 274795|

|991528|1493780712| pv| 7270| 274795|

|991528|1493780714| pv| 7270| 274795|

|991528|1493780765| pv| 7270| 274795|

|991528|1493780714| pv| 7270| 274795|

|991528|1493780765| pv| 7270| 274795|

|991528|1493780764| pv| 7270| 274795|

|991528|1493780633| pv| 7270| 274795|

|991528|1493780764| pv| 7270| 274795|

+------+----------+----+------+-------+

only showing top 20 rowsroot|-- userId: integer (nullable = true)|-- timestamp: long (nullable = true)|-- btag: string (nullable = true)|-- cateId: integer (nullable = true)|-- brandId: integer (nullable = true)

- 分析数据集字段的类型和格式

- 查看是否有空值

- 查看每列数据的类型

- 查看每列数据的类别情况

print("查看userId的数据情况:", behavior_log_df.groupBy("userId").count().count())

# 约113w用户

#注意:behavior_log_df.groupBy("userId").count() 返回的是一个dataframe,这里的count计算的是每一个分组的个数,但当前还没有进行计算

# 当调用df.count()时才开始进行计算,这里的count计算的是dataframe的条目数,也就是共有多少个分组

查看user的数据情况: 1136340

print("查看btag的数据情况:", behavior_log_df.groupBy("btag").count().collect()) # collect会把计算结果全部加载到内存,谨慎使用

# 只有四种类型数据:pv、fav、cart、buy

# 这里由于类型只有四个,所以直接使用collect,把数据全部加载出来

查看btag的数据情况: [Row(btag='buy', count=9115919), Row(btag='fav', count=9301837), Row(btag='cart', count=15946033), Row(btag='pv', count=688904345)]

print("查看cateId的数据情况:", behavior_log_df.groupBy("cateId").count().count())

# 约12968类别id

查看cateId的数据情况: 12968

print("查看brandId的数据情况:", behavior_log_df.groupBy("brandId").count().count())

# 约460561品牌id

查看brandId的数据情况: 460561

print("判断数据是否有空值:", behavior_log_df.count(), behavior_log_df.dropna().count())

# 约7亿条目723268134 723268134

# 本数据集无空值条目,可放心处理

判断数据是否有空值: 723268134 723268134

- pivot透视操作,把某列里的字段值转换成行并进行聚合运算(pyspark.sql.GroupedData.pivot)

- 如果透视的字段中的不同属性值超过10000个,则需要设置spark.sql.pivotMaxValues,否则计算过程中会出现错误。文档介绍。

# 统计每个用户对各类商品的pv、fav、cart、buy数量

cate_count_df = behavior_log_df.groupBy(behavior_log_df.userId, behavior_log_df.cateId).pivot("btag",["pv","fav","cart","buy"]).count()

cate_count_df.printSchema() # 此时还没有开始计算

显示效果:

root|-- userId: integer (nullable = true)|-- cateId: integer (nullable = true)|-- pv: long (nullable = true)|-- fav: long (nullable = true)|-- cart: long (nullable = true)|-- buy: long (nullable = true)

- 统计每个用户对各个品牌的pv、fav、cart、buy数量并保存结果

# 统计每个用户对各个品牌的pv、fav、cart、buy数量

brand_count_df = behavior_log_df.groupBy(behavior_log_df.userId, behavior_log_df.brandId).pivot("btag",["pv","fav","cart","buy"]).count()

# brand_count_df.show() # 同上

# 113w * 46w

# 由于运算时间比较长,所以这里先将结果存储起来,供后续其他操作使用

# 写入数据时才开始计算

cate_count_df.write.csv("hdfs://localhost:9000/preprocessing_dataset/cate_count.csv", header=True)

brand_count_df.write.csv("hdfs://localhost:9000/preprocessing_dataset/brand_count.csv", header=True)

2.2 根据用户对类目偏好打分训练ALS模型

- 根据您统计的次数 + 打分规则 ==> 偏好打分数据集 ==> ALS模型

# spark ml的模型训练是基于内存的,如果数据过大,内存空间小,迭代次数过多的化,可能会造成内存溢出,报错

# 设置Checkpoint的话,会把所有数据落盘,这样如果异常退出,下次重启后,可以接着上次的训练节点继续运行

# 但该方法其实指标不治本,因为无法防止内存溢出,所以还是会报错

# 如果数据量大,应考虑的是增加内存、或限制迭代次数和训练数据量级等

spark.sparkContext.setCheckpointDir("hdfs://localhost:8020/checkPoint/")

from pyspark.sql.types import StructType, StructField, StringType, IntegerType, LongType, FloatType# 构建结构对象

schema = StructType([StructField("userId", IntegerType()),StructField("cateId", IntegerType()),StructField("pv", IntegerType()),StructField("fav", IntegerType()),StructField("cart", IntegerType()),StructField("buy", IntegerType())

])# 从hdfs加载CSV文件

cate_count_df = spark.read.csv("hdfs://localhost:9000/preprocessing_dataset/cate_count.csv", header=True, schema=schema)

cate_count_df.printSchema()

cate_count_df.first() # 第一行数据

显示结果:

root|-- userId: integer (nullable = true)|-- cateId: integer (nullable = true)|-- pv: integer (nullable = true)|-- fav: integer (nullable = true)|-- cart: integer (nullable = true)|-- buy: integer (nullable = true)Row(userId=1061650, cateId=4520, pv=2326, fav=None, cart=53, buy=None)

- 处理每一行数据:r表示row对象

def process_row(r):# 处理每一行数据:r表示row对象# 偏好评分规则:# m: 用户对应的行为次数# 该偏好权重比例,次数上限仅供参考,具体数值应根据产品业务场景权衡# pv: if m<=20: score=0.2*m; else score=4# fav: if m<=20: score=0.4*m; else score=8# cart: if m<=20: score=0.6*m; else score=12# buy: if m<=20: score=1*m; else score=20# 注意这里要全部设为浮点数,spark运算时对类型比较敏感,要保持数据类型都一致pv_count = r.pv if r.pv else 0.0fav_count = r.fav if r.fav else 0.0cart_count = r.cart if r.cart else 0.0buy_count = r.buy if r.buy else 0.0pv_score = 0.2*pv_count if pv_count<=20 else 4.0fav_score = 0.4*fav_count if fav_count<=20 else 8.0cart_score = 0.6*cart_count if cart_count<=20 else 12.0buy_score = 1.0*buy_count if buy_count<=20 else 20.0rating = pv_score + fav_score + cart_score + buy_score# 返回用户ID、分类ID、用户对分类的偏好打分return r.userId, r.cateId, rating

- 返回一个PythonRDD类型

# 返回一个PythonRDD类型,此时还没开始计算

cate_count_df.rdd.map(process_row).toDF(["userId", "cateId", "rating"])

显示结果:

DataFrame[userId: bigint, cateId: bigint, rating: double]

- 用户对商品类别的打分数据

# 用户对商品类别的打分数据

# map返回的结果是rdd类型,需要调用toDF方法转换为Dataframe

cate_rating_df = cate_count_df.rdd.map(process_row).toDF(["userId", "cateId", "rating"])

# 注意:toDF不是每个rdd都有的方法,仅局限于此处的rdd

# 可通过该方法获得 user-cate-matrix

# 但由于cateId字段过多,这里运算量比很大,机器内存要求很高才能执行,否则无法完成任务

# 请谨慎使用# 但好在我们训练ALS模型时,不需要转换为user-cate-matrix,所以这里可以不用运行

# cate_rating_df.groupBy("userId").povit("cateId").min("rating")

# 用户对类别的偏好打分数据

cate_rating_df

显示结果:

DataFrame[userId: bigint, cateId: bigint, rating: double]

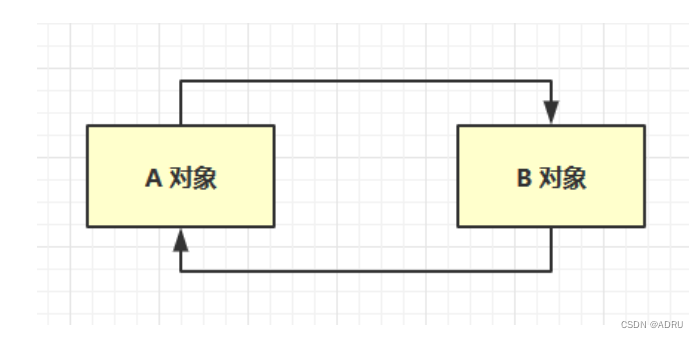

- 通常如果USER-ITEM打分数据应该是通过一下方式进行处理转换为USER-ITEM-MATRIX

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-bYZwXB3C-1691901742059)(/img/CF%E4%BB%8B%E7%BB%8D.png)]

但这里我们将使用的Spark的ALS模型进行CF推荐,因此注意这里数据输入不需要提前转换为矩阵,直接是 USER-ITEM-RATE的数据

-

基于Spark的ALS隐因子模型进行CF评分预测

-

ALS的意思是交替最小二乘法(Alternating Least Squares),是Spark2.*中加入的进行基于模型的协同过滤(model-based CF)的推荐系统算法。

同SVD,它也是一种矩阵分解技术,对数据进行降维处理。

-

详细使用方法:pyspark.ml.recommendation.ALS

-

注意:由于数据量巨大,因此这里也不考虑基于内存的CF算法

参考:为什么Spark中只有ALS

-

# 使用pyspark中的ALS矩阵分解方法实现CF评分预测

# 文档地址:https://spark.apache.org/docs/2.2.2/api/python/pyspark.ml.html?highlight=vectors#module-pyspark.ml.recommendation

from pyspark.ml.recommendation import ALS # ml:dataframe, mllib:rdd# 利用打分数据,训练ALS模型

als = ALS(userCol='userId', itemCol='cateId', ratingCol='rating', checkpointInterval=5)# 此处训练时间较长

model = als.fit(cate_rating_df)

- 模型训练好后,调用方法进行使用,具体API查看

# model.recommendForAllUsers(N) 给所有用户推荐TOP-N个物品

ret = model.recommendForAllUsers(3)

# 由于是给所有用户进行推荐,此处运算时间也较长

ret.show()

# 推荐结果存放在recommendations列中,

ret.select("recommendations").show()

显示结果:

+------+--------------------+

|userId| recommendations|

+------+--------------------+

| 148|[[3347, 12.547271...|

| 463|[[1610, 9.250818]...|

| 471|[[1610, 10.246621...|

| 496|[[1610, 5.162216]...|

| 833|[[5607, 9.065482]...|

| 1088|[[104, 6.886987],...|

| 1238|[[5631, 14.51981]...|

| 1342|[[5720, 10.89842]...|

| 1580|[[5731, 8.466453]...|

| 1591|[[1610, 12.835257...|

| 1645|[[1610, 11.968531...|

| 1829|[[1610, 17.576496...|

| 1959|[[1610, 8.353473]...|

| 2122|[[1610, 12.652732...|

| 2142|[[1610, 12.48068]...|

| 2366|[[1610, 11.904813...|

| 2659|[[5607, 11.699315...|

| 2866|[[1610, 7.752719]...|

| 3175|[[3347, 2.3429515...|

| 3749|[[1610, 3.641833]...|

+------+--------------------+

only showing top 20 rows+--------------------+

| recommendations|

+--------------------+

|[[3347, 12.547271...|

|[[1610, 9.250818]...|

|[[1610, 10.246621...|

|[[1610, 5.162216]...|

|[[5607, 9.065482]...|

|[[104, 6.886987],...|

|[[5631, 14.51981]...|

|[[5720, 10.89842]...|

|[[5731, 8.466453]...|

|[[1610, 12.835257...|

|[[1610, 11.968531...|

|[[1610, 17.576496...|

|[[1610, 8.353473]...|

|[[1610, 12.652732...|

|[[1610, 12.48068]...|

|[[1610, 11.904813...|

|[[5607, 11.699315...|

|[[1610, 7.752719]...|

|[[3347, 2.3429515...|

|[[1610, 3.641833]...|

+--------------------+

only showing top 20 rows

- model.recommendForUserSubset 给部分用户推荐TOP-N个物品

# 注意:recommendForUserSubset API,2.2.2版本中无法使用

dataset = spark.createDataFrame([[1],[2],[3]])

dataset = dataset.withColumnRenamed("_1", "userId")

ret = model.recommendForUserSubset(dataset, 3)# 只给部分用推荐,运算时间短

ret.show()

ret.collect() # 注意: collect会将所有数据加载到内存,慎用

显示结果:

+------+--------------------+

|userId| recommendations|

+------+--------------------+

| 1|[[1610, 25.4989],...|

| 3|[[5607, 13.665942...|

| 2|[[5579, 5.9051886...|

+------+--------------------+[Row(userId=1, recommendations=[Row(cateId=1610, rating=25.498899459838867), Row(cateId=5737, rating=24.901548385620117), Row(cateId=3347, rating=20.736785888671875)]),Row(userId=3, recommendations=[Row(cateId=5607, rating=13.665942192077637), Row(cateId=1610, rating=11.770171165466309), Row(cateId=3347, rating=10.35690689086914)]),Row(userId=2, recommendations=[Row(cateId=5579, rating=5.90518856048584), Row(cateId=2447, rating=5.624575138092041), Row(cateId=5690, rating=5.2555742263793945)])]

- transform中提供userId和cateId可以对打分进行预测,利用打分结果排序后

# transform中提供userId和cateId可以对打分进行预测,利用打分结果排序后,同样可以实现TOP-N的推荐

model.transform

# 将模型进行存储

model.save("hdfs://localhost:8020/models/userCateRatingALSModel.obj")

# 测试存储的模型

from pyspark.ml.recommendation import ALSModel

# 从hdfs加载之前存储的模型

als_model = ALSModel.load("hdfs://localhost:8020/models/userCateRatingALSModel.obj")

# model.recommendForAllUsers(N) 给用户推荐TOP-N个物品

result = als_model.recommendForAllUsers(3)

result.show()

显示结果:

+------+--------------------+

|userId| recommendations|

+------+--------------------+

| 148|[[3347, 12.547271...|

| 463|[[1610, 9.250818]...|

| 471|[[1610, 10.246621...|

| 496|[[1610, 5.162216]...|

| 833|[[5607, 9.065482]...|

| 1088|[[104, 6.886987],...|

| 1238|[[5631, 14.51981]...|

| 1342|[[5720, 10.89842]...|

| 1580|[[5731, 8.466453]...|

| 1591|[[1610, 12.835257...|

| 1645|[[1610, 11.968531...|

| 1829|[[1610, 17.576496...|

| 1959|[[1610, 8.353473]...|

| 2122|[[1610, 12.652732...|

| 2142|[[1610, 12.48068]...|

| 2366|[[1610, 11.904813...|

| 2659|[[5607, 11.699315...|

| 2866|[[1610, 7.752719]...|

| 3175|[[3347, 2.3429515...|

| 3749|[[1610, 3.641833]...|

+------+--------------------+

only showing top 20 rows

- 召回到redis

import redis

host = "192.168.19.8"

port = 6379

# 召回到redis

def recall_cate_by_cf(partition):# 建立redis 连接池pool = redis.ConnectionPool(host=host, port=port)# 建立redis客户端client = redis.Redis(connection_pool=pool)for row in partition:client.hset("recall_cate", row.userId, [i.cateId for i in row.recommendations])

# 对每个分片的数据进行处理 #mapPartition Transformation map

# foreachPartition Action操作 foreachRDD

result.foreachPartition(recall_cate_by_cf)# 注意:这里这是召回的是用户最感兴趣的n个类别

# 总的条目数,查看redis中总的条目数是否一致

result.count()

显示结果:

1136340

2.3 根据用户对品牌偏好打分训练ALS模型

from pyspark.sql.types import StructType, StructField, StringType, IntegerTypeschema = StructType([StructField("userId", IntegerType()),StructField("brandId", IntegerType()),StructField("pv", IntegerType()),StructField("fav", IntegerType()),StructField("cart", IntegerType()),StructField("buy", IntegerType())

])

# 从hdfs加载预处理好的品牌的统计数据

brand_count_df = spark.read.csv("hdfs://localhost:8020/preprocessing_dataset/brand_count.csv", header=True, schema=schema)

# brand_count_df.show()

def process_row(r):# 处理每一行数据:r表示row对象# 偏好评分规则:# m: 用户对应的行为次数# 该偏好权重比例,次数上限仅供参考,具体数值应根据产品业务场景权衡# pv: if m<=20: score=0.2*m; else score=4# fav: if m<=20: score=0.4*m; else score=8# cart: if m<=20: score=0.6*m; else score=12# buy: if m<=20: score=1*m; else score=20# 注意这里要全部设为浮点数,spark运算时对类型比较敏感,要保持数据类型都一致pv_count = r.pv if r.pv else 0.0fav_count = r.fav if r.fav else 0.0cart_count = r.cart if r.cart else 0.0buy_count = r.buy if r.buy else 0.0pv_score = 0.2*pv_count if pv_count<=20 else 4.0fav_score = 0.4*fav_count if fav_count<=20 else 8.0cart_score = 0.6*cart_count if cart_count<=20 else 12.0buy_score = 1.0*buy_count if buy_count<=20 else 20.0rating = pv_score + fav_score + cart_score + buy_score# 返回用户ID、品牌ID、用户对品牌的偏好打分return r.userId, r.brandId, rating

# 用户对品牌的打分数据

brand_rating_df = brand_count_df.rdd.map(process_row).toDF(["userId", "brandId", "rating"])

# brand_rating_df.show()

-

基于Spark的ALS隐因子模型进行CF评分预测

-

ALS的意思是交替最小二乘法(Alternating Least Squares),是Spark中进行基于模型的协同过滤(model-based CF)的推荐系统算法,也是目前Spark内唯一一个推荐算法。

同SVD,它也是一种矩阵分解技术,但理论上,ALS在海量数据的处理上要优于SVD。

更多了解:pyspark.ml.recommendation.ALS

注意:由于数据量巨大,因此这里不考虑基于内存的CF算法

参考:为什么Spark中只有ALS

-

-

使用pyspark中的ALS矩阵分解方法实现CF评分预测

# 使用pyspark中的ALS矩阵分解方法实现CF评分预测

# 文档地址:https://spark.apache.org/docs/latest/api/python/pyspark.ml.html?highlight=vectors#module-pyspark.ml.recommendation

from pyspark.ml.recommendation import ALSals = ALS(userCol='userId', itemCol='brandId', ratingCol='rating', checkpointInterval=2)

# 利用打分数据,训练ALS模型

# 此处训练时间较长

model = als.fit(brand_rating_df)

# model.recommendForAllUsers(N) 给用户推荐TOP-N个物品

model.recommendForAllUsers(3).show()

# 将模型进行存储

model.save("hdfs://localhost:9000/models/userBrandRatingModel.obj")

# 测试存储的模型

from pyspark.ml.recommendation import ALSModel

# 从hdfs加载模型

my_model = ALSModel.load("hdfs://localhost:9000/models/userBrandRatingModel.obj")

my_model

# model.recommendForAllUsers(N) 给用户推荐TOP-N个物品

my_model.recommendForAllUsers(3).first()

相关文章:

二 根据用户行为数据创建ALS模型并召回商品

二 根据用户行为数据创建ALS模型并召回商品 2.0 用户行为数据拆分 方便练习可以对数据做拆分处理 pandas的数据分批读取 chunk 厚厚的一块 相当大的数量或部分 import pandas as pd reader pd.read_csv(behavior_log.csv,chunksize100,iteratorTrue) count 0; for chunk in …...

SpringBoot ⽇志⽂件

日志 1. 作用2. 日志的使用3. 日志的级别4. 日志的持久化 1. 作用 日志最主要的⽤途就是排除和定位问题。 除了发现和定位问题之外,我们还可以通过⽇志实现以下功能: 记录⽤户登录⽇志,⽅便分析⽤户是正常登录还是恶意破解⽤户。记录系统的…...

SpringBoot案例-部门管理-查询

查看页面原型,明确需求需求 页面原型 需求分析 阅读接口文档 接口文档链接如下: https://docs.qq.com/doc/DUkRiTWVaUmFVck9N 思路分析 用户发送请求,交由对应的Controller类进行处理,Controller类调用service实现查询部门功…...

Java中处理表格

大家好 , 我是苏麟 , 也是很久没有更新了 , 今天带来一个很好使用的一个库 easyexcel. JAVA后端开发中可能会遇到一个问题 , 就是处理Execel表格 , 当然不一定非要用Java 我们在这里只说在Java里怎么去处理表格 . Easy Excel 我们今天要说到就是 Easy Excel , 这个是阿里的项…...

代码(包含7个数据集))

指静脉开集测试(OpenSet-test)代码(包含7个数据集)

七个数据集:sdu、mmc、hkpu、scut、utfvp、vera、nupt 一、SDU 80%用于训练,20%用于作为开集测试 1.数据集分割代码 ①先把636个类别提取出来 func: 创建temp_sdu,将636个类划分出来。下一个代码块将进行openset_sdu的分割import os from shutil import copy, rmtre…...

okcc对接ASR平台,okcc客户投诉的安全问题

客户投诉: 客户为什么要投诉?实际上分为两种情况,一是客户被冒犯到不能容忍导致的投诉,二是恶意投诉。降低客户被冒犯投诉的概率,无非就是选择客户、规范用语、降低频度;减少恶意投诉,回避是实践证明最有效…...

JVM中判定对象是否回收的的方法

引用计数法 引用计数法是一种垃圾回收(Garbage Collection)算法,用于自动管理内存中的对象。在引用计数法中,每个对象都有一个关联的引用计数器,用于记录对该对象的引用数量。 当一个新的引用指向对象时,…...

)

macos 使用vscode 开发python 爬虫(开发二)

以下是一个示例,用于爬取一个公开的示例网站(http://books.toscrape.com),并提取书籍的标题和价格: import requests from bs4 import BeautifulSoup# 发起请求并获取网页内容 url 可以用上面的链接🔗 re…...

redis.get报错com.alibaba.fastjson.JSONException: autoType is not support)

(已解决)redis.get报错com.alibaba.fastjson.JSONException: autoType is not support

redis存取值问题,存自定义实体对象; 第一次取的时候报错:com.alibaba.fastjson.JSONException: autoType is not support。 GenericFastJsonRedisSerializer序列化和反序列化redis的value值,需要bean对象含有无参构造方法。 解决…...

控价可以这样做

品牌为什么要做控价,因为渠道中的低价、假货、窜货链接不仅会影响品牌价值和发展,还会影响经销商的合作,长期销售受阻的经销商,会选择低价更价,或者不合作,这无疑是在使品牌渠道走向更为混乱的局面。同时低…...

Spring学习笔记之Spring IoC注解式开发

文章目录 声明Bean的注解Component注解Controller注解Service注解Repository Spring注解的使用选择性实例化Bean负责注入的注解ValueAutowired与QuaifierResource 全注解式开发 注解的存在主要是为了简化XML的配置。Spring6倡导全注解开发 注解怎么定义,注解中的属性…...

C语言入门教程,C语言学习教程(非常详细)第二章 c语言初探

第一个C语言程序 我们有两种方式从计算机获得信息:一是看屏幕上的文字、图片、视频等,二是听从喇叭发出来的声音。让喇叭发出声音目前还比较麻烦,我们先来看看如何在屏幕上显示一些文字吧。 在屏幕上显示文字非常简单,只需要一个…...

HOT99-下一个排列

leetcode原题链接:下一个排列 题目描述 整数数组的一个 排列 就是将其所有成员以序列或线性顺序排列。 例如,arr [1,2,3] ,以下这些都可以视作 arr 的排列:[1,2,3]、[1,3,2]、[3,1,2]、[2,3,1] 。整数数组的 下一个排列 是指其…...

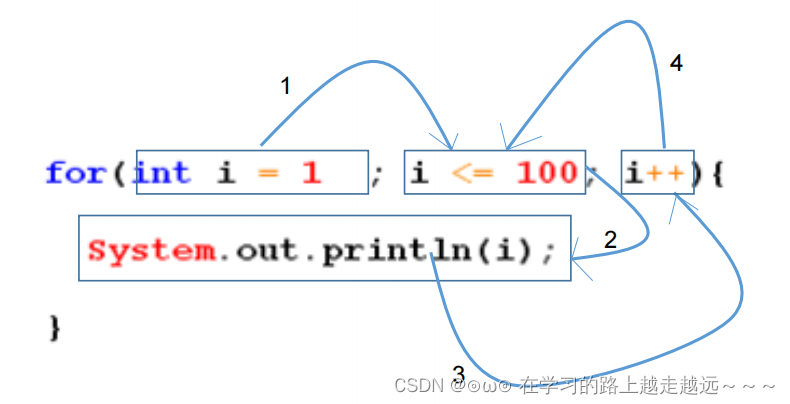

JAVA基础知识(二)——程序流程控制

程序流程控制 一、程序流程控制1.1 程序流程控制1.2 顺序结构1.3 分支结构1.4 循环结构1.5 嵌套循环1.6 return的使用 一、程序流程控制 1.1 程序流程控制 流程控制语句是用来控制程序中各语句执行顺序的语句,可以把语句组合成能完成一定功能的小逻辑模块。 其流程…...

mysql知识点+面试总结

目录 1 mysql介绍 2 数据库常见语法 3 数据库表的常见语法 4 其他常见语法(日期,查询表字段) 5 JDBC开发步骤 6 索引 6.1 索引常见语法 7 常见面试总结 8 java代码搭建监控页面 1 mysql介绍 数据库:存储在硬盘上的文件系统…...

前端大屏常用的适配方案

假设我们正在开发一个可视化拖拽的搭建平台,可以拖拽生成工作台或可视化大屏,或者直接就是开发一个大屏,首先必须要考虑的一个问题就是页面如何适应屏幕,因为我们在搭建或开发时一般都会基于一个固定的宽高,但是实际的…...

技术债 笔记

目录 1. 技术债 笔记1.1. 什么是技术债1.2. 讨论1.3. 国内技术从业者怎么看? 1. 技术债 笔记 1.1. 什么是技术债 1992 年, Ward Cunningham 在敏捷宣言中首次提出了"技术债"概念, 主要指有意或无意地做了错误的或不理想的技术决策所累积的债务。随后, 《重构》一书…...

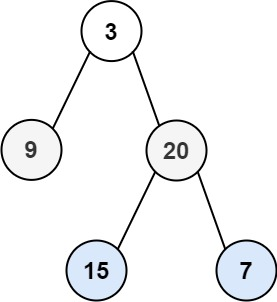

【Leetcode】102.二叉树的层序遍历

一、题目 1、题目描述 给你二叉树的根节点 root ,返回其节点值的 层序遍历 。 (即逐层地,从左到右访问所有节点)。 示例1: 输入:root = [3,9,20,null,null,15,7] 输出:[[3],[9,20],[15,7]]示例2: 输入:root = [1] 输出:[[1]]示例3: 输入:root = [] 输出:[]…...

上传文件报413Request EntityToo Large错误解决办法

产生这种原因是因为服务器限制了上传大小 1、nginx服务器的解决办法 修改nginx.conf的值就可以解决了 将以下代码粘贴到nginx.conf内 client_max_body_size 20M 可以选择在http{ }中设置:client_max_body_size 20m; 也可以选择在server{ }中设置:cli…...

Neo4j之MERGE基础

在 Neo4j 中,MERGE 语句用于根据指定的模式进行创建或匹配节点和关系。它可以在节点或关系不存在时创建它们,并在已存在时进行匹配。 创建或匹配节点: MERGE (p:Person {name: John});这个查询会检查是否已经存在一个具有 "Person&quo…...

k8s从入门到放弃之Ingress七层负载

k8s从入门到放弃之Ingress七层负载 在Kubernetes(简称K8s)中,Ingress是一个API对象,它允许你定义如何从集群外部访问集群内部的服务。Ingress可以提供负载均衡、SSL终结和基于名称的虚拟主机等功能。通过Ingress,你可…...

STM32+rt-thread判断是否联网

一、根据NETDEV_FLAG_INTERNET_UP位判断 static bool is_conncected(void) {struct netdev *dev RT_NULL;dev netdev_get_first_by_flags(NETDEV_FLAG_INTERNET_UP);if (dev RT_NULL){printf("wait netdev internet up...");return false;}else{printf("loc…...

)

postgresql|数据库|只读用户的创建和删除(备忘)

CREATE USER read_only WITH PASSWORD 密码 -- 连接到xxx数据库 \c xxx -- 授予对xxx数据库的只读权限 GRANT CONNECT ON DATABASE xxx TO read_only; GRANT USAGE ON SCHEMA public TO read_only; GRANT SELECT ON ALL TABLES IN SCHEMA public TO read_only; GRANT EXECUTE O…...

论文浅尝 | 基于判别指令微调生成式大语言模型的知识图谱补全方法(ISWC2024)

笔记整理:刘治强,浙江大学硕士生,研究方向为知识图谱表示学习,大语言模型 论文链接:http://arxiv.org/abs/2407.16127 发表会议:ISWC 2024 1. 动机 传统的知识图谱补全(KGC)模型通过…...

JDK 17 新特性

#JDK 17 新特性 /**************** 文本块 *****************/ python/scala中早就支持,不稀奇 String json “”" { “name”: “Java”, “version”: 17 } “”"; /**************** Switch 语句 -> 表达式 *****************/ 挺好的ÿ…...

Android 之 kotlin 语言学习笔记三(Kotlin-Java 互操作)

参考官方文档:https://developer.android.google.cn/kotlin/interop?hlzh-cn 一、Java(供 Kotlin 使用) 1、不得使用硬关键字 不要使用 Kotlin 的任何硬关键字作为方法的名称 或字段。允许使用 Kotlin 的软关键字、修饰符关键字和特殊标识…...

蓝桥杯 冶炼金属

原题目链接 🔧 冶炼金属转换率推测题解 📜 原题描述 小蓝有一个神奇的炉子用于将普通金属 O O O 冶炼成为一种特殊金属 X X X。这个炉子有一个属性叫转换率 V V V,是一个正整数,表示每 V V V 个普通金属 O O O 可以冶炼出 …...

【从零学习JVM|第三篇】类的生命周期(高频面试题)

前言: 在Java编程中,类的生命周期是指类从被加载到内存中开始,到被卸载出内存为止的整个过程。了解类的生命周期对于理解Java程序的运行机制以及性能优化非常重要。本文会深入探寻类的生命周期,让读者对此有深刻印象。 目录 …...

vulnyx Blogger writeup

信息收集 arp-scan nmap 获取userFlag 上web看看 一个默认的页面,gobuster扫一下目录 可以看到扫出的目录中得到了一个有价值的目录/wordpress,说明目标所使用的cms是wordpress,访问http://192.168.43.213/wordpress/然后查看源码能看到 这…...

Spring AI Chat Memory 实战指南:Local 与 JDBC 存储集成

一个面向 Java 开发者的 Sring-Ai 示例工程项目,该项目是一个 Spring AI 快速入门的样例工程项目,旨在通过一些小的案例展示 Spring AI 框架的核心功能和使用方法。 项目采用模块化设计,每个模块都专注于特定的功能领域,便于学习和…...