基于PaddlePaddle实现的声纹识别系统

前言

本项目使用了EcapaTdnn、ResNetSE、ERes2Net、CAM++等多种先进的声纹识别模型,不排除以后会支持更多模型,同时本项目也支持了MelSpectrogram、Spectrogram、MFCC、Fbank等多种数据预处理方法,使用了ArcFace Loss,ArcFace loss:Additive Angular Margin Loss(加性角度间隔损失函数),对应项目中的AAMLoss,对特征向量和权重归一化,对θ加上角度间隔m,角度间隔比余弦间隔在对角度的影响更加直接,除此之外,还支持AMLoss、ARMLoss、CELoss等多种损失函数。

源码地址:VoiceprintRecognition-PaddlePaddle

使用环境:

- Anaconda 3

- Python 3.8

- PaddlePaddle 2.4.1

- Windows 10 or Ubuntu 18.04

项目特性

- 支持模型:EcapaTdnn、TDNN、Res2Net、ResNetSE、ERes2Net、CAM++

- 支持池化层:AttentiveStatsPool(ASP)、SelfAttentivePooling(SAP)、TemporalStatisticsPooling(TSP)、TemporalAveragePooling(TAP)、TemporalStatsPool(TSTP)

- 支持损失函数:AAMLoss、AMLoss、ARMLoss、CELoss

- 支持预处理方法:MelSpectrogram、Spectrogram、MFCC、Fbank

模型论文:

- EcapaTdnn:ECAPA-TDNN: Emphasized Channel Attention, Propagation and Aggregation in TDNN Based Speaker Verification

- TDNN:Prediction of speech intelligibility with DNN-based performance measures

- Res2Net:Res2Net: A New Multi-scale Backbone Architecture

- ResNetSE:Squeeze-and-Excitation Networks

- CAMPPlus:CAM++: A Fast and Efficient Network for Speaker Verification Using Context-Aware Masking

- ERes2Net:An Enhanced Res2Net with Local and Global Feature Fusion for Speaker Verification

模型下载

| 模型 | Params(M) | 预处理方法 | 数据集 | train speakers | threshold | EER | MinDCF |

|---|---|---|---|---|---|---|---|

| CAM++ | 7.5 | Fbank | CN-Celeb | 2796 | 0.25 | 0.09485 | 0.56214 |

| ERes2Net | 8.2 | Fbank | CN-Celeb | 2796 | 0.22 | 0.09637 | 0.52627 |

| ResNetSE | 10.7 | Fbank | CN-Celeb | 2796 | |||

| EcapaTdnn | 6.7 | Fbank | CN-Celeb | 2796 | 0.25 | 0.10465 | 0.58521 |

| TDNN | 3.2 | Fbank | CN-Celeb | 2796 | 0.23 | 0.11804 | 0.61070 |

| Res2Net | 7.2 | Fbank | CN-Celeb | 2796 | 0.18 | 0.14126 | 0.68511 |

| ERes2Net | 8.2 | Fbank | 其他数据集 | 20W | 0.36 | 0.02939 | 0.18355 |

| CAM++ | 7.5 | Flank | 其他数据集 | 20W | 0.29 | 0.04768 | 0.31429 |

说明:

- 评估的测试集为CN-Celeb的测试集,包含196个说话人。

安装环境

- 首先安装的是PaddlePaddle的GPU版本,如果已经安装过了,请跳过。

conda install paddlepaddle-gpu==2.4.1 cudatoolkit=10.2 --channel https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/Paddle/

- 安装ppvector库。

使用pip安装,命令如下:

python -m pip install ppvector -U -i https://pypi.tuna.tsinghua.edu.cn/simple

建议源码安装,源码安装能保证使用最新代码。

git clone https://github.com/yeyupiaoling/VoiceprintRecognition_PaddlePaddle.git

cd VoiceprintRecognition_PaddlePaddle/

python setup.py install

修改预处理方法

配置文件中默认使用的是Fbank预处理方法,如果要使用其他预处理方法,可以修改配置文件中的安装下面方式修改,具体的值可以根据自己情况修改。如果不清楚如何设置参数,可以直接删除该部分,直接使用默认值。

# 数据预处理参数

preprocess_conf:# 音频预处理方法,支持:LogMelSpectrogram、MelSpectrogram、Spectrogram、MFCC、Fbankfeature_method: 'Fbank'# 设置API参数,更参数查看对应API,不清楚的可以直接删除该部分,直接使用默认值method_args:sr: 16000n_mels: 80

训练模型

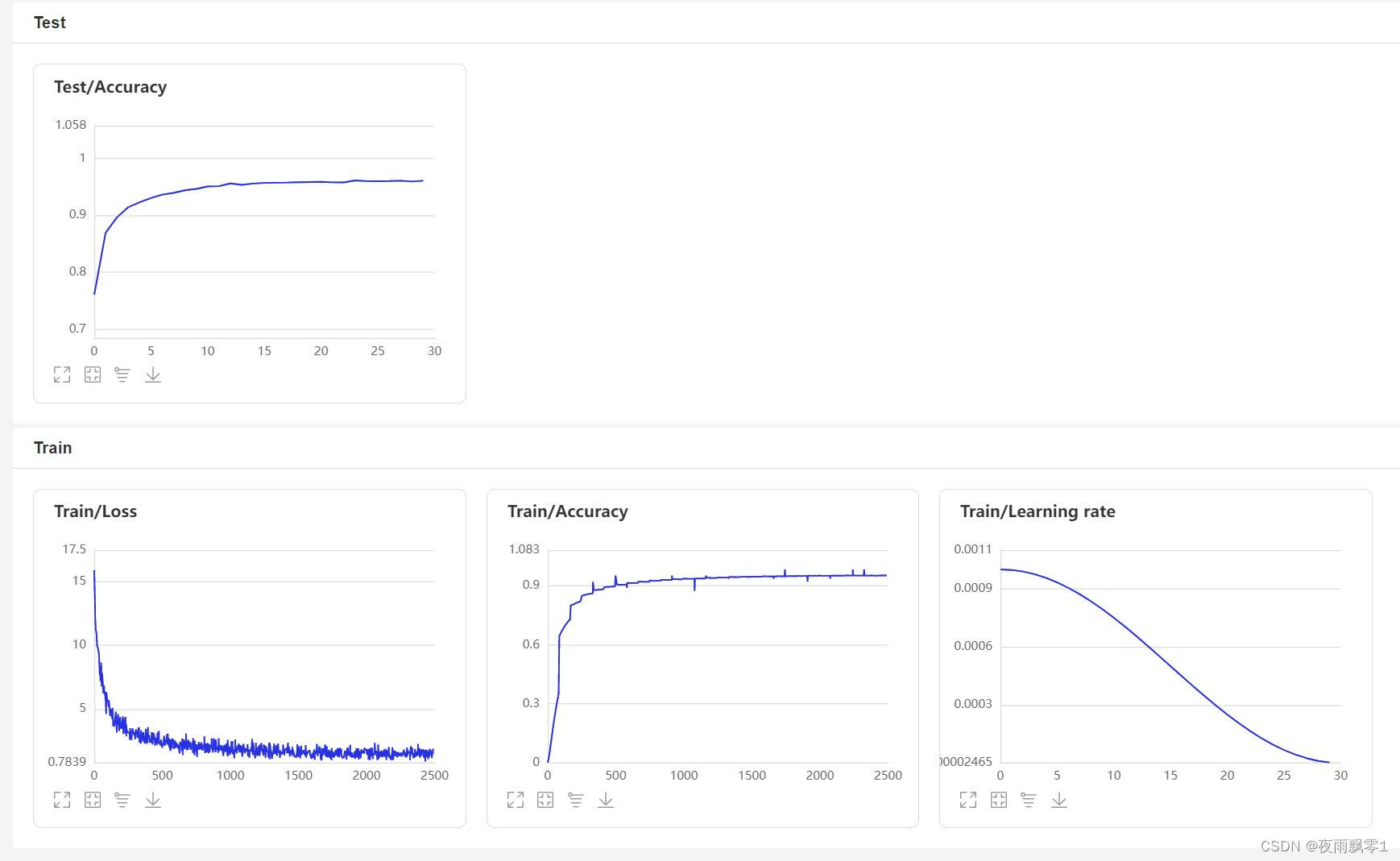

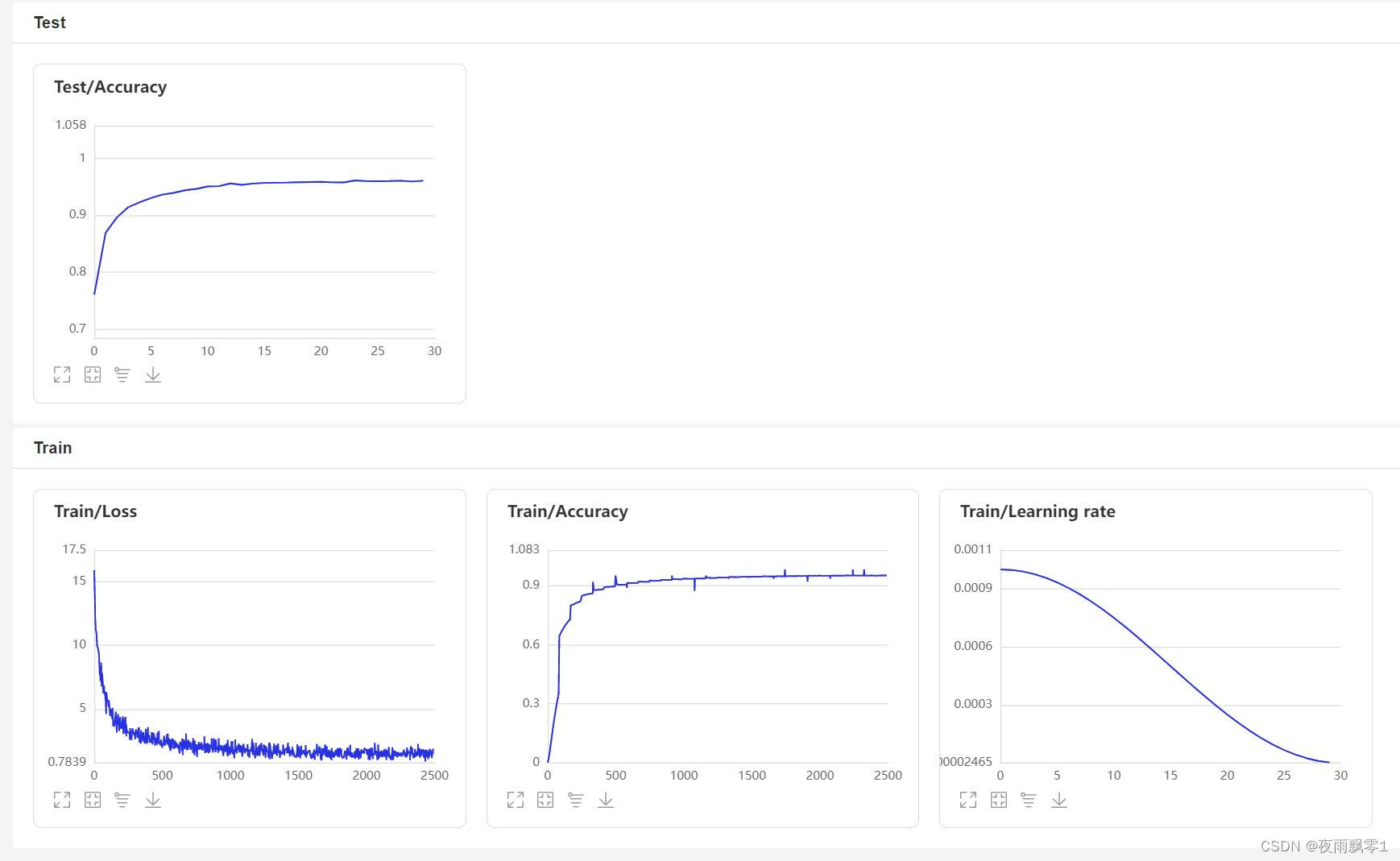

使用train.py训练模型,本项目支持多个音频预处理方式,通过configs/ecapa_tdnn.yml配置文件的参数preprocess_conf.feature_method可以指定,MelSpectrogram为梅尔频谱,Spectrogram为语谱图,MFCC梅尔频谱倒谱系数。通过参数augment_conf_path可以指定数据增强方式。训练过程中,会使用VisualDL保存训练日志,通过启动VisualDL可以随时查看训练结果,启动命令visualdl --logdir=log --host 0.0.0.0

# 单卡训练

CUDA_VISIBLE_DEVICES=0 python train.py

# 多卡训练

python -m paddle.distributed.launch --gpus '0,1' train.py

训练输出日志:

[2023-08-05 09:52:06.497988 INFO ] utils:print_arguments:13 - ----------- 额外配置参数 -----------

[2023-08-05 09:52:06.498094 INFO ] utils:print_arguments:15 - configs: configs/ecapa_tdnn.yml

[2023-08-05 09:52:06.498149 INFO ] utils:print_arguments:15 - do_eval: True

[2023-08-05 09:52:06.498191 INFO ] utils:print_arguments:15 - local_rank: 0

[2023-08-05 09:52:06.498230 INFO ] utils:print_arguments:15 - pretrained_model: None

[2023-08-05 09:52:06.498269 INFO ] utils:print_arguments:15 - resume_model: None

[2023-08-05 09:52:06.498306 INFO ] utils:print_arguments:15 - save_model_path: models/

[2023-08-05 09:52:06.498342 INFO ] utils:print_arguments:15 - use_gpu: True

[2023-08-05 09:52:06.498378 INFO ] utils:print_arguments:16 - ------------------------------------------------

[2023-08-05 09:52:06.513761 INFO ] utils:print_arguments:18 - ----------- 配置文件参数 -----------

[2023-08-05 09:52:06.513906 INFO ] utils:print_arguments:21 - dataset_conf:

[2023-08-05 09:52:06.513957 INFO ] utils:print_arguments:24 - dataLoader:

[2023-08-05 09:52:06.513995 INFO ] utils:print_arguments:26 - batch_size: 64

[2023-08-05 09:52:06.514031 INFO ] utils:print_arguments:26 - num_workers: 4

[2023-08-05 09:52:06.514066 INFO ] utils:print_arguments:28 - do_vad: False

[2023-08-05 09:52:06.514101 INFO ] utils:print_arguments:28 - enroll_list: dataset/enroll_list.txt

[2023-08-05 09:52:06.514135 INFO ] utils:print_arguments:24 - eval_conf:

[2023-08-05 09:52:06.514169 INFO ] utils:print_arguments:26 - batch_size: 1

[2023-08-05 09:52:06.514203 INFO ] utils:print_arguments:26 - max_duration: 20

[2023-08-05 09:52:06.514237 INFO ] utils:print_arguments:28 - max_duration: 3

[2023-08-05 09:52:06.514274 INFO ] utils:print_arguments:28 - min_duration: 0.5

[2023-08-05 09:52:06.514308 INFO ] utils:print_arguments:28 - noise_aug_prob: 0.2

[2023-08-05 09:52:06.514342 INFO ] utils:print_arguments:28 - noise_dir: dataset/noise

[2023-08-05 09:52:06.514374 INFO ] utils:print_arguments:28 - num_speakers: 3242

[2023-08-05 09:52:06.514408 INFO ] utils:print_arguments:28 - sample_rate: 16000

[2023-08-05 09:52:06.514441 INFO ] utils:print_arguments:28 - speed_perturb: True

[2023-08-05 09:52:06.514475 INFO ] utils:print_arguments:28 - target_dB: -20

[2023-08-05 09:52:06.514508 INFO ] utils:print_arguments:28 - train_list: dataset/train_list.txt

[2023-08-05 09:52:06.514542 INFO ] utils:print_arguments:28 - trials_list: dataset/trials_list.txt

[2023-08-05 09:52:06.514575 INFO ] utils:print_arguments:28 - use_dB_normalization: True

[2023-08-05 09:52:06.514609 INFO ] utils:print_arguments:21 - loss_conf:

[2023-08-05 09:52:06.514643 INFO ] utils:print_arguments:24 - args:

[2023-08-05 09:52:06.514678 INFO ] utils:print_arguments:26 - easy_margin: False

[2023-08-05 09:52:06.514713 INFO ] utils:print_arguments:26 - margin: 0.2

[2023-08-05 09:52:06.514746 INFO ] utils:print_arguments:26 - scale: 32

[2023-08-05 09:52:06.514779 INFO ] utils:print_arguments:24 - margin_scheduler_args:

[2023-08-05 09:52:06.514814 INFO ] utils:print_arguments:26 - final_margin: 0.3

[2023-08-05 09:52:06.514848 INFO ] utils:print_arguments:28 - use_loss: AAMLoss

[2023-08-05 09:52:06.514882 INFO ] utils:print_arguments:28 - use_margin_scheduler: True

[2023-08-05 09:52:06.514915 INFO ] utils:print_arguments:21 - model_conf:

[2023-08-05 09:52:06.514950 INFO ] utils:print_arguments:24 - backbone:

[2023-08-05 09:52:06.514984 INFO ] utils:print_arguments:26 - embd_dim: 192

[2023-08-05 09:52:06.515017 INFO ] utils:print_arguments:26 - pooling_type: ASP

[2023-08-05 09:52:06.515050 INFO ] utils:print_arguments:24 - classifier:

[2023-08-05 09:52:06.515084 INFO ] utils:print_arguments:26 - num_blocks: 0

[2023-08-05 09:52:06.515118 INFO ] utils:print_arguments:21 - optimizer_conf:

[2023-08-05 09:52:06.515154 INFO ] utils:print_arguments:28 - learning_rate: 0.001

[2023-08-05 09:52:06.515188 INFO ] utils:print_arguments:28 - optimizer: Adam

[2023-08-05 09:52:06.515221 INFO ] utils:print_arguments:28 - scheduler: CosineAnnealingLR

[2023-08-05 09:52:06.515254 INFO ] utils:print_arguments:28 - scheduler_args: None

[2023-08-05 09:52:06.515289 INFO ] utils:print_arguments:28 - weight_decay: 1e-06

[2023-08-05 09:52:06.515323 INFO ] utils:print_arguments:21 - preprocess_conf:

[2023-08-05 09:52:06.515357 INFO ] utils:print_arguments:28 - feature_method: MelSpectrogram

[2023-08-05 09:52:06.515390 INFO ] utils:print_arguments:24 - method_args:

[2023-08-05 09:52:06.515426 INFO ] utils:print_arguments:26 - f_max: 14000.0

[2023-08-05 09:52:06.515460 INFO ] utils:print_arguments:26 - f_min: 50.0

[2023-08-05 09:52:06.515493 INFO ] utils:print_arguments:26 - hop_length: 320

[2023-08-05 09:52:06.515527 INFO ] utils:print_arguments:26 - n_fft: 1024

[2023-08-05 09:52:06.515560 INFO ] utils:print_arguments:26 - n_mels: 64

[2023-08-05 09:52:06.515593 INFO ] utils:print_arguments:26 - sample_rate: 16000

[2023-08-05 09:52:06.515626 INFO ] utils:print_arguments:26 - win_length: 1024

[2023-08-05 09:52:06.515660 INFO ] utils:print_arguments:21 - train_conf:

[2023-08-05 09:52:06.515694 INFO ] utils:print_arguments:28 - log_interval: 100

[2023-08-05 09:52:06.515728 INFO ] utils:print_arguments:28 - max_epoch: 30

[2023-08-05 09:52:06.515761 INFO ] utils:print_arguments:30 - use_model: EcapaTdnn

[2023-08-05 09:52:06.515794 INFO ] utils:print_arguments:31 - ------------------------------------------------

----------------------------------------------------------------------------------------Layer (type) Input Shape Output Shape Param #

========================================================================================Conv1D-2 [[1, 64, 102]] [1, 512, 98] 164,352 Conv1d-1 [[1, 64, 98]] [1, 512, 98] 0 ReLU-1 [[1, 512, 98]] [1, 512, 98] 0 BatchNorm1D-2 [[1, 512, 98]] [1, 512, 98] 2,048 BatchNorm1d-1 [[1, 512, 98]] [1, 512, 98] 0 TDNNBlock-1 [[1, 64, 98]] [1, 512, 98] 0 Conv1D-4 [[1, 512, 98]] [1, 512, 98] 262,656 Conv1d-3 [[1, 512, 98]] [1, 512, 98] 0 ReLU-2 [[1, 512, 98]] [1, 512, 98] 0 BatchNorm1D-4 [[1, 512, 98]] [1, 512, 98] 2,048 BatchNorm1d-3 [[1, 512, 98]] [1, 512, 98] 0 TDNNBlock-2 [[1, 512, 98]] [1, 512, 98] 0

··········································SEBlock-3 [[1, 512, 98], None] [1, 512, 98] 0 SERes2NetBlock-3 [[1, 512, 98]] [1, 512, 98] 0 Conv1D-70 [[1, 1536, 98]] [1, 1536, 98] 2,360,832 Conv1d-69 [[1, 1536, 98]] [1, 1536, 98] 0 ReLU-32 [[1, 1536, 98]] [1, 1536, 98] 0 BatchNorm1D-58 [[1, 1536, 98]] [1, 1536, 98] 6,144 BatchNorm1d-57 [[1, 1536, 98]] [1, 1536, 98] 0 TDNNBlock-29 [[1, 1536, 98]] [1, 1536, 98] 0 Conv1D-72 [[1, 4608, 98]] [1, 128, 98] 589,952 Conv1d-71 [[1, 4608, 98]] [1, 128, 98] 0 ReLU-33 [[1, 128, 98]] [1, 128, 98] 0 BatchNorm1D-60 [[1, 128, 98]] [1, 128, 98] 512 BatchNorm1d-59 [[1, 128, 98]] [1, 128, 98] 0 TDNNBlock-30 [[1, 4608, 98]] [1, 128, 98] 0 Tanh-1 [[1, 128, 98]] [1, 128, 98] 0 Conv1D-74 [[1, 128, 98]] [1, 1536, 98] 198,144 Conv1d-73 [[1, 128, 98]] [1, 1536, 98] 0

AttentiveStatisticsPooling-1 [[1, 1536, 98]] [1, 3072, 1] 0 BatchNorm1D-62 [[1, 3072, 1]] [1, 3072, 1] 12,288 BatchNorm1d-61 [[1, 3072, 1]] [1, 3072, 1] 0 Conv1D-76 [[1, 3072, 1]] [1, 192, 1] 590,016 Conv1d-75 [[1, 3072, 1]] [1, 192, 1] 0 EcapaTdnn-1 [[1, 98, 64]] [1, 192] 0 SpeakerIdentification-1 [[1, 192]] [1, 9726] 1,867,392

========================================================================================

Total params: 8,039,808

Trainable params: 8,020,480

Non-trainable params: 19,328

----------------------------------------------------------------------------------------

Input size (MB): 0.02

Forward/backward pass size (MB): 35.60

Params size (MB): 30.67

Estimated Total Size (MB): 66.30

----------------------------------------------------------------------------------------

[2023-08-05 09:52:08.084231 INFO ] trainer:train:388 - 训练数据:874175

[2023-08-05 09:52:09.186542 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [0/13659], loss: 11.95824, accuracy: 0.00000, learning rate: 0.00100000, speed: 58.09 data/sec, eta: 5 days, 5:24:08

[2023-08-05 09:52:22.477905 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [100/13659], loss: 10.35675, accuracy: 0.00278, learning rate: 0.00100000, speed: 481.65 data/sec, eta: 15:07:15

[2023-08-05 09:52:35.948581 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [200/13659], loss: 10.22089, accuracy: 0.00505, learning rate: 0.00100000, speed: 475.27 data/sec, eta: 15:19:12

[2023-08-05 09:52:49.249098 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [300/13659], loss: 10.00268, accuracy: 0.00706, learning rate: 0.00100000, speed: 481.45 data/sec, eta: 15:07:11

[2023-08-05 09:53:03.716015 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [400/13659], loss: 9.76052, accuracy: 0.00830, learning rate: 0.00100000, speed: 442.74 data/sec, eta: 16:26:16

[2023-08-05 09:53:18.258807 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [500/13659], loss: 9.50189, accuracy: 0.01060, learning rate: 0.00100000, speed: 440.46 data/sec, eta: 16:31:08

[2023-08-05 09:53:31.618354 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [600/13659], loss: 9.26083, accuracy: 0.01256, learning rate: 0.00100000, speed: 479.50 data/sec, eta: 15:10:12

[2023-08-05 09:53:45.439642 INFO ] trainer:__train_epoch:334 - Train epoch: [1/30], batch: [700/13659], loss: 9.03548, accuracy: 0.01449, learning rate: 0.00099999, speed: 463.63 data/sec, eta: 15:41:08

VisualDL页面:

评估模型

训练结束之后会保存预测模型,我们用预测模型来预测测试集中的音频特征,然后使用音频特征进行两两对比,计算EER和MinDCF。

python eval.py

输出类似如下:

······

------------------------------------------------

W0425 08:27:32.057426 17654 device_context.cc:447] Please NOTE: device: 0, GPU Compute Capability: 7.5, Driver API Version: 11.6, Runtime API Version: 10.2

W0425 08:27:32.065165 17654 device_context.cc:465] device: 0, cuDNN Version: 7.6.

[2023-03-16 20:20:47.195908 INFO ] trainer:evaluate:341 - 成功加载模型:models/EcapaTdnn_Fbank/best_model/model.pth

100%|███████████████████████████| 84/84 [00:28<00:00, 2.95it/s]

开始两两对比音频特征...

100%|███████████████████████████| 5332/5332 [00:05<00:00, 1027.83it/s]

评估消耗时间:65s,threshold:0.26,EER: 0.14739, MinDCF: 0.41999

声纹对比

下面开始实现声纹对比,创建infer_contrast.py程序,编写infer()函数,在编写模型的时候,模型是有两个输出的,第一个是模型的分类输出,第二个是音频特征输出。所以在这里要输出的是音频的特征值,有了音频的特征值就可以做声纹识别了。我们输入两个语音,通过预测函数获取他们的特征数据,使用这个特征数据可以求他们的对角余弦值,得到的结果可以作为他们相识度。对于这个相识度的阈值threshold,读者可以根据自己项目的准确度要求进行修改。

python infer_contrast.py --audio_path1=audio/a_1.wav --audio_path2=audio/b_2.wav

输出类似如下:

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:13 - ----------- 额外配置参数 -----------

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - audio_path1: dataset/a_1.wav

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - audio_path2: dataset/b_2.wav

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - configs: configs/ecapa_tdnn.yml

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - model_path: models/EcapaTdnn_Fbank/best_model/

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - threshold: 0.6

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:15 - use_gpu: True

[2023-04-02 18:30:48.009149 INFO ] utils:print_arguments:16 - ------------------------------------------------

······································································

W0425 08:29:10.006249 21121 device_context.cc:447] Please NOTE: device: 0, GPU Compute Capability: 7.5, Driver API Version: 11.6, Runtime API Version: 10.2

W0425 08:29:10.008555 21121 device_context.cc:465] device: 0, cuDNN Version: 7.6.

成功加载模型参数和优化方法参数:models/ecapa_tdnn/model.pdparams

audio/a_1.wav 和 audio/b_2.wav 不是同一个人,相似度为:-0.09565544128417969

声纹识别

在上面的声纹对比的基础上,我们创建infer_recognition.py实现声纹识别。同样是使用上面声纹对比的infer()预测函数,通过这两个同样获取语音的特征数据。 不同的是笔者增加了load_audio_db()和register(),以及recognition(),第一个函数是加载声纹库中的语音数据,这些音频就是相当于已经注册的用户,他们注册的语音数据会存放在这里,如果有用户需要通过声纹登录,就需要拿到用户的语音和语音库中的语音进行声纹对比,如果对比成功,那就相当于登录成功并且获取用户注册时的信息数据。第二个函数register()其实就是把录音保存在声纹库中,同时获取该音频的特征添加到待对比的数据特征中。最后recognition()函数中,这个函数就是将输入的语音和语音库中的语音一一对比。

有了上面的声纹识别的函数,读者可以根据自己项目的需求完成声纹识别的方式,例如笔者下面提供的是通过录音来完成声纹识别。首先必须要加载语音库中的语音,语音库文件夹为audio_db,然后用户回车后录音3秒钟,然后程序会自动录音,并使用录音到的音频进行声纹识别,去匹配语音库中的语音,获取用户的信息。通过这样方式,读者也可以修改成通过服务请求的方式完成声纹识别,例如提供一个API供APP调用,用户在APP上通过声纹登录时,把录音到的语音发送到后端完成声纹识别,再把结果返回给APP,前提是用户已经使用语音注册,并成功把语音数据存放在audio_db文件夹中。

python infer_recognition.py

输出类似如下:

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:13 - ----------- 额外配置参数 -----------

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - audio_db_path: audio_db/

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - configs: configs/ecapa_tdnn.yml

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - model_path: models/EcapaTdnn_Fbank/best_model/

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - record_seconds: 3

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - threshold: 0.6

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:15 - use_gpu: True

[2023-04-02 18:31:20.521040 INFO ] utils:print_arguments:16 - ------------------------------------------------

······································································

W0425 08:30:13.257884 23889 device_context.cc:447] Please NOTE: device: 0, GPU Compute Capability: 7.5, Driver API Version: 11.6, Runtime API Version: 10.2

W0425 08:30:13.260191 23889 device_context.cc:465] device: 0, cuDNN Version: 7.6.

成功加载模型参数和优化方法参数:models/ecapa_tdnn/model.pdparams

Loaded 沙瑞金 audio.

Loaded 李达康 audio.

请选择功能,0为注册音频到声纹库,1为执行声纹识别:0

按下回车键开机录音,录音3秒中:

开始录音......

录音已结束!

请输入该音频用户的名称:夜雨飘零

请选择功能,0为注册音频到声纹库,1为执行声纹识别:1

按下回车键开机录音,录音3秒中:

开始录音......

录音已结束!

识别说话的为:夜雨飘零,相似度为:0.920434

其他版本

- Tensorflow:VoiceprintRecognition-Tensorflow

- Pytorch:VoiceprintRecognition-Pytorch

- Keras:VoiceprintRecognition-Keras

参考资料

- https://github.com/PaddlePaddle/PaddleSpeech

- https://github.com/yeyupiaoling/PaddlePaddle-MobileFaceNets

- https://github.com/yeyupiaoling/PPASR

相关文章:

基于PaddlePaddle实现的声纹识别系统

前言 本项目使用了EcapaTdnn、ResNetSE、ERes2Net、CAM等多种先进的声纹识别模型,不排除以后会支持更多模型,同时本项目也支持了MelSpectrogram、Spectrogram、MFCC、Fbank等多种数据预处理方法,使用了ArcFace Loss,ArcFace loss…...

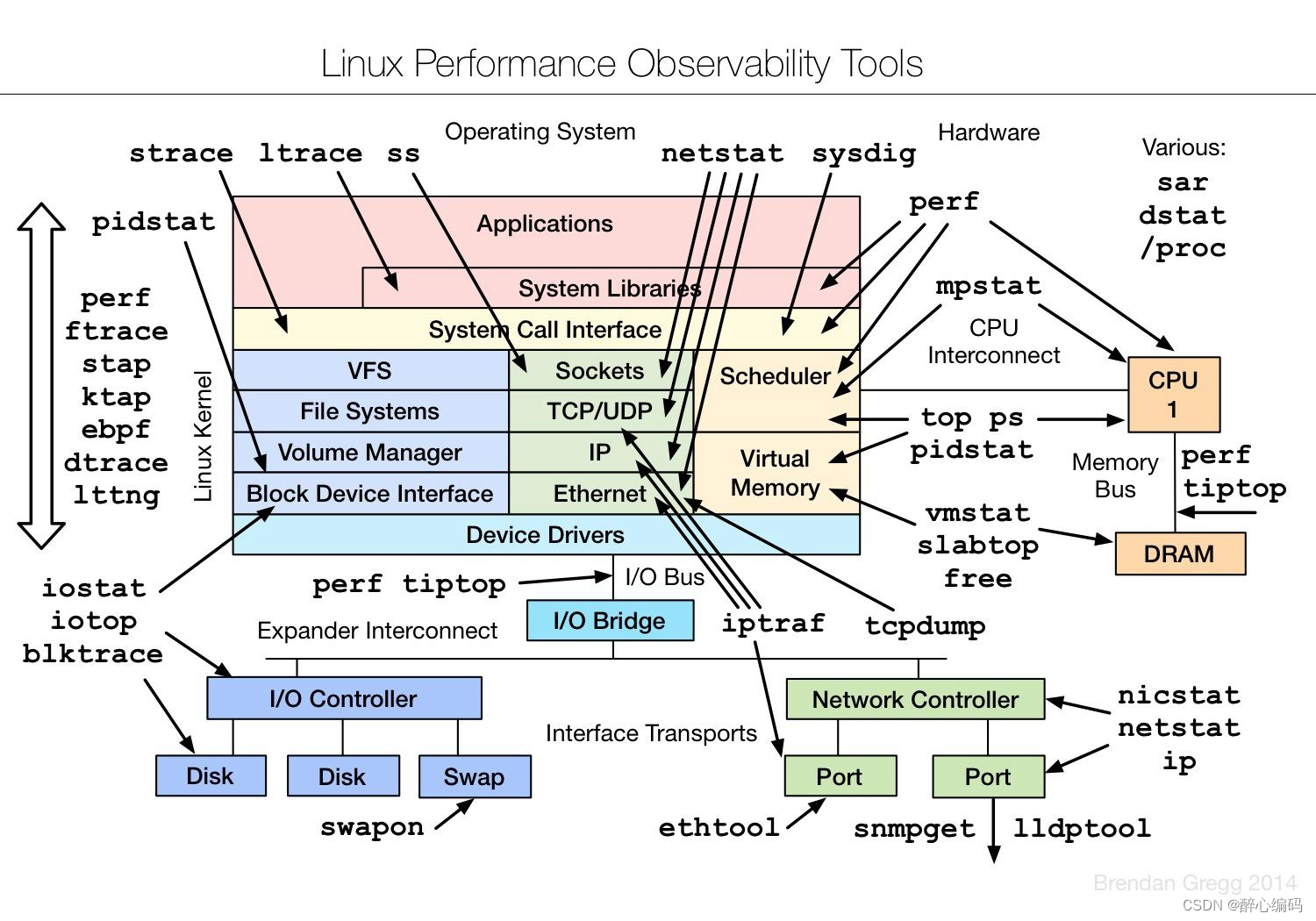

使用GDB工具分析core文件的方法

引言: 在软件开发过程中,我们经常会遇到程序崩溃或异常退出的情况。这时,一个非常有用的工具就是GDB(GNU调试器),它可以帮助我们分析core文件并找出导致程序崩溃的原因。本文将介绍如何使用GDB工具来分析c…...

Maven - 统一构建规范:Maven 插件管理最佳实践

文章目录 Available Plugins开源项目中的使用插件介绍maven-jar-pluginmaven-assembly-pluginmaven-shade-pluginShade 插件 - 标签artifactSetrelocationsfilters 完整配置 Available Plugins https://maven.apache.org/plugins/index.html Maven 是一个开源的软件构建工具&…...

对接海康明眸门禁设备-删除人员信息

对接海康明眸门禁设备-删除人员信息 文中登录 退出登录 长连接和海康hCNetSDK等接口 见文章 初始SDK和登录 /*** 删除人脸 IotCommDataResult 自定义类 收集结果*/Overridepublic List<IotCommDataResult> deleteFace(IotCameraParam camera, Collection<Long> us…...

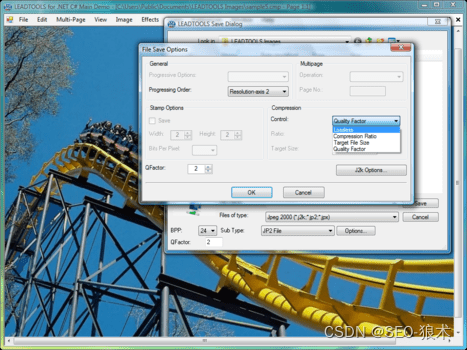

LEADTOOLS Imaging SDK Crack

LEADTOOLS Imaging SDK Crack 高级开发人员工具包包括ActiveX和WPF/XAML控件。 LEADTOOLS Imaging SDK为文件格式导入/导出、图像压缩、图像显示和效果、颜色转换、图像处理、TWAIN扫描、图像通用对话框、数据库集成、打印和互联网提供了基本和高级的彩色图像功能。 LEADTOOLS …...

2023并发之八股文——面试题

基础知识 并发编程的优缺点为什么要使用并发编程(并发编程的优点) 充分利用多核CPU的计算能力:通过并发编程的形式可以将多核CPU 的计算能力发挥到极致,性能得到提升方便进行业务拆分,提升系统并发能力和性能&#x…...

操作记录日志保存设计实现

定义一个切面类 @Aspect @Slf4j @Component @RequiredArgsConstructor public class OperateLogAopConfig {private final ISysOperateLogService sysOperateLogService;@Around("@annotation(operateLog)")public Object operateLog(ProceedingJoinPoint point, Op…...

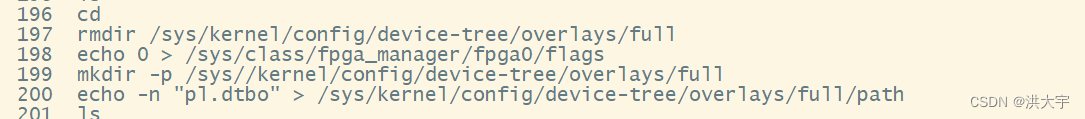

PL 侧驱动和fpga 重加载的方法

可以解决很多的问题 时钟稳定后加载特定fpga ip (要不内核崩的一塌糊涂)fpga 稳定复位软件决定fpga ip 加载的时序 dluash load /usr/local/scripts/si5512_setup.lua usleep 30 mkdir -p /lib/firmware cp -rf /usr/local/firmare/{*.bit.bin,*.dtbo} …...

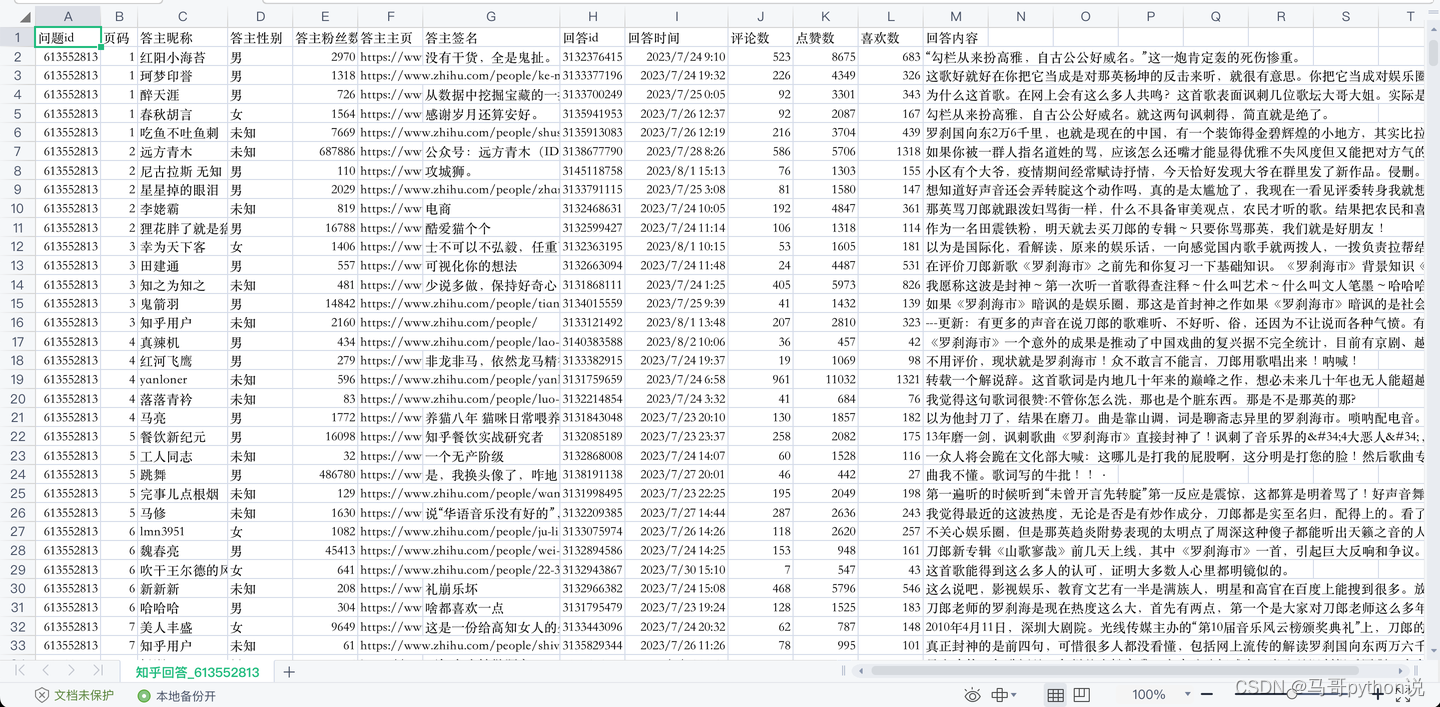

【2023最新爬虫】用python爬取知乎任意问题下的全部回答

老规矩,先上结果: 爬取了前200多页,每页5条数据,共1000多条回答。(程序设置的自动判断结束页,我是手动break的) 共爬到13个字段,包含: 问题id,页码,答主昵称,答主性别,…...

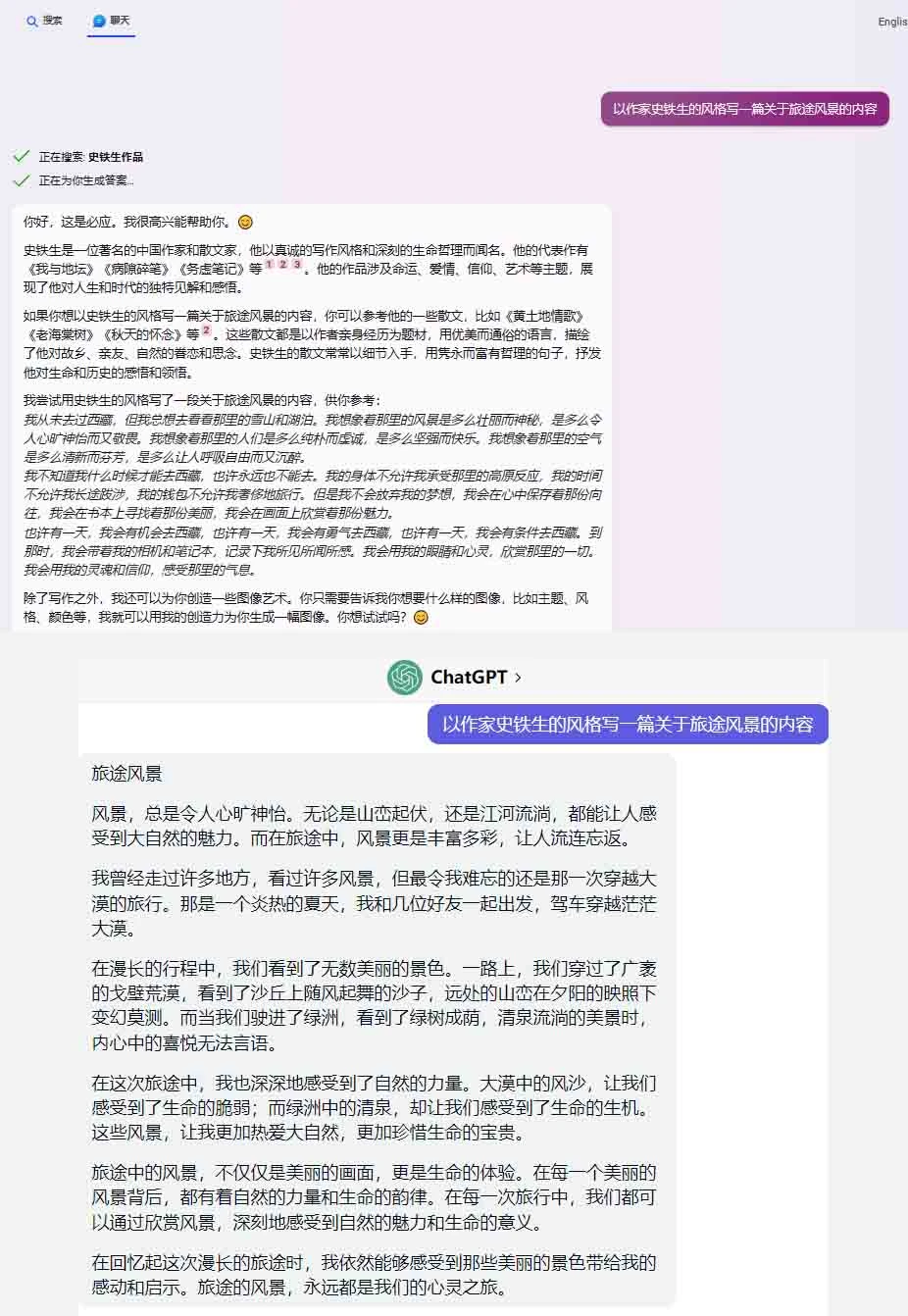

Bingchat和ChatGPT主要区别

Bing Chat由chatgpt GPT-4技术提供支持,这是流行的ChatGPT的最新语言模型。Bing Chat通过更具交互性和上下文联动的响应来优化搜索引擎。它允许用户提出问题并获得更人性化、精确化或创造力的答案。用户还可以在答案末尾查看的参考来源。该工具可以充当个人研究、计…...

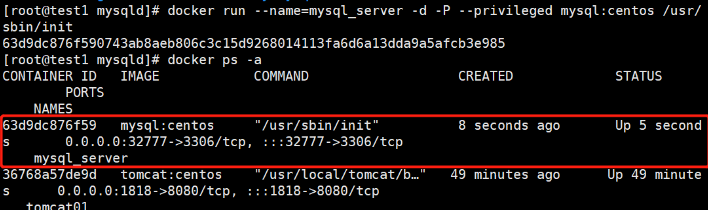

Docker容器:docker镜像的创建及dockerfile

Docker容器:docker镜像的创建及dockerfile案例 一.docker镜像的三种创建方法 创建镜像有三种方法:基于现有镜像创建、基于本地模板创建及基于dockerfile创建 1.基于现有镜像创建 1.1 启动镜像 #首先启动一个镜像,在容器里做修改 docker …...

Vue3 父子组件数据传递

1、父组件向子组件传递数据 1.1、传递多个简单变量给到子组件 父组件使用 <TitleView title"标题" :name"name" :isCollect"isCollect" collect-event"collectEvent" /><script setup>const name ref(名字)const isCol…...

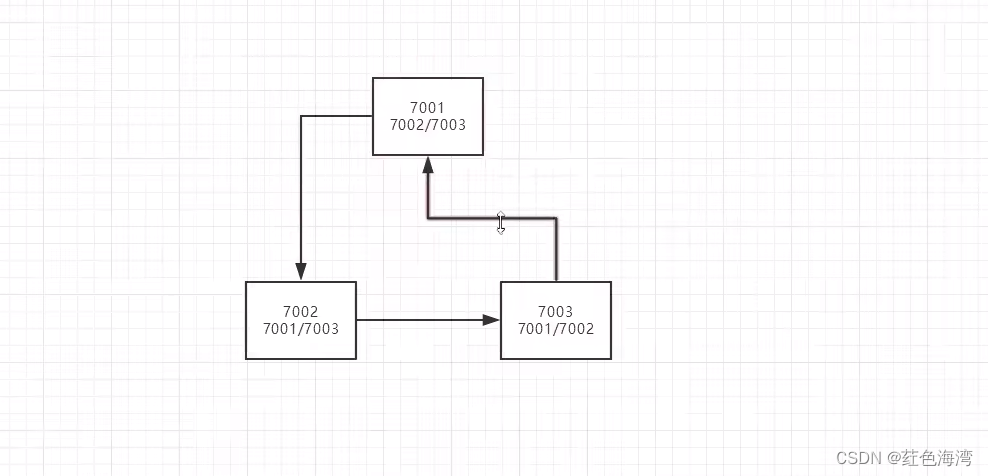

Eureka:集群环境配置

创建三个集群 导包 <!-- 导包--><dependencies><!-- Eureka -server --><dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-eureka-server</artifactId><version>1.…...

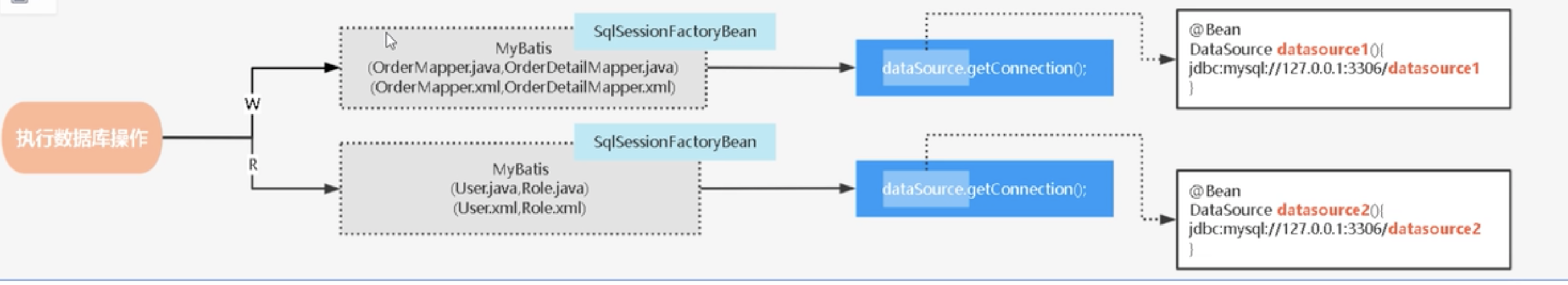

springboot之多数据源配置

文章目录 一、多数据源的典型使用场景1 业务复杂(数据量大)2 读写分离 二、如何实现多数据源通过AbstractRoutingDataSource动态指定数据源多数据源切换方式AOPMyBatis插件 三、spring集成多个Mybatis框架 实现多数据源控制四、dynamic-datasource 多数据…...

无涯教程-PHP - 静态变量函数

静态变量 静态变量在函数退出时值不会丢失,您只需将关键字STATIC放在变量名称的前面,即可将变量声明为静态变量。 <?phpfunction keep_track() {STATIC $count0;$count;print $count;print "<br />";}keep_track();keep_track();keep_track(); ?> 这…...

2023-08-20力扣今日二题

链接: 1312. 让字符串成为回文串的最少插入次数 题意: 如题 解: 动态规划,枚举回文串中点并递增回文串长度 初始状态若LR则单个字符为中点,需要添加0个字符成为回文串;若L1R则如果S[L]S[R]则需要添加…...

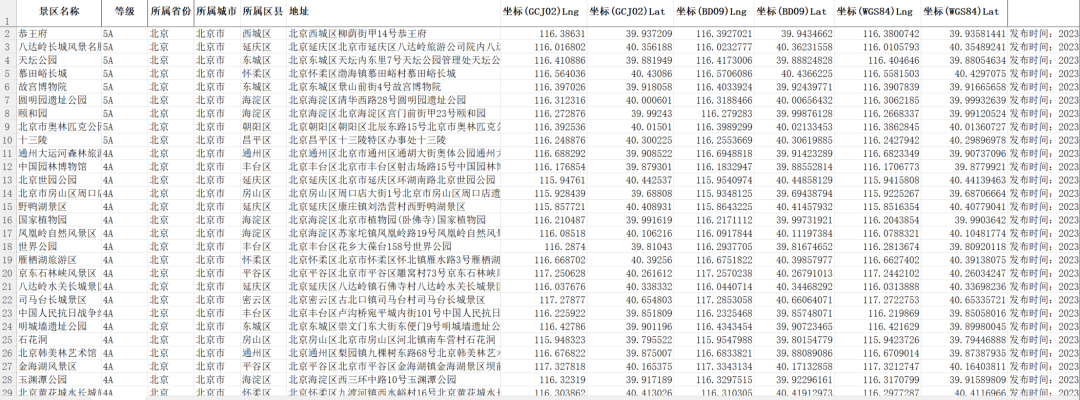

【地理专题】2023年最新全国A级景区数

数据来源:中国文化和旅游部时间跨度:2023年区域范围:全国范围数据字段: 景区名称;地址;等级;城市;经度;纬度 该图基于自然资源部地图技术审查中心标准地图服务网站下载…...

:Springboot实现Elasticsearch统一检索功能)

Elasticsearch实战(一):Springboot实现Elasticsearch统一检索功能

文章目录 系列文章索引一、准备工作1、搭建docker环境2、安装eskibana3、es安装ik分词器(1)下载安装(2)测试 4、Springboot(1)引包(2)客户端公共方法(3)公共实…...

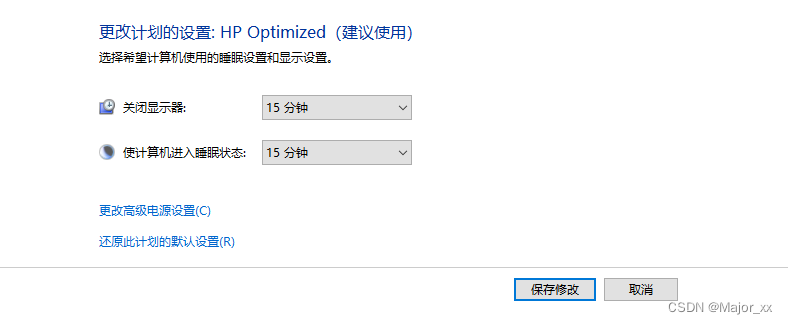

更改计算机睡眠时间

控制面板–>系统和安全–>电源选项下的更改计算机睡眠时间 如果关闭显示器时间小于使计算机进入睡眠状态时间,时间先到达关闭显示器时间,显示器关闭,这时电脑还在正常工作状态。如果此时敲击键盘显示器出现画面,无需输入密…...

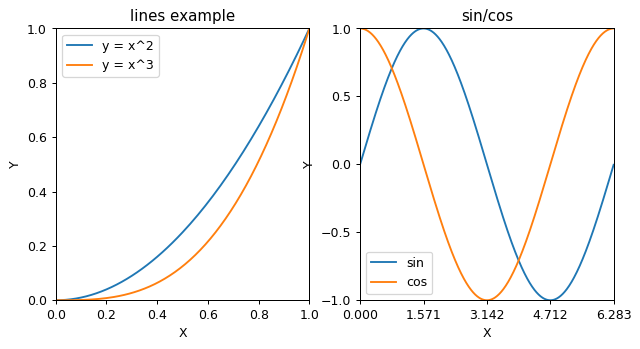

Matplotlib数据可视化(一)

目录 1.Matplotlib简介 2.Matplotlib绘图基础 2.1 创建画布与子图 2.2 添加画布属性 2.3 绘图的保存与显示 1.Matplotlib简介 Matplotlib是一个用于绘制数据可视化图表的Python库。它提供了广泛的功能和灵活性,可以创建各种类型的图表,包括折线图、…...

设计模式和设计原则回顾

设计模式和设计原则回顾 23种设计模式是设计原则的完美体现,设计原则设计原则是设计模式的理论基石, 设计模式 在经典的设计模式分类中(如《设计模式:可复用面向对象软件的基础》一书中),总共有23种设计模式,分为三大类: 一、创建型模式(5种) 1. 单例模式(Sing…...

golang循环变量捕获问题

在 Go 语言中,当在循环中启动协程(goroutine)时,如果在协程闭包中直接引用循环变量,可能会遇到一个常见的陷阱 - 循环变量捕获问题。让我详细解释一下: 问题背景 看这个代码片段: fo…...

蓝牙 BLE 扫描面试题大全(2):进阶面试题与实战演练

前文覆盖了 BLE 扫描的基础概念与经典问题蓝牙 BLE 扫描面试题大全(1):从基础到实战的深度解析-CSDN博客,但实际面试中,企业更关注候选人对复杂场景的应对能力(如多设备并发扫描、低功耗与高发现率的平衡)和前沿技术的…...

鸿蒙中用HarmonyOS SDK应用服务 HarmonyOS5开发一个医院挂号小程序

一、开发准备 环境搭建: 安装DevEco Studio 3.0或更高版本配置HarmonyOS SDK申请开发者账号 项目创建: File > New > Create Project > Application (选择"Empty Ability") 二、核心功能实现 1. 医院科室展示 /…...

如何在网页里填写 PDF 表格?

有时候,你可能希望用户能在你的网站上填写 PDF 表单。然而,这件事并不简单,因为 PDF 并不是一种原生的网页格式。虽然浏览器可以显示 PDF 文件,但原生并不支持编辑或填写它们。更糟的是,如果你想收集表单数据ÿ…...

在QWebEngineView上实现鼠标、触摸等事件捕获的解决方案

这个问题我看其他博主也写了,要么要会员、要么写的乱七八糟。这里我整理一下,把问题说清楚并且给出代码,拿去用就行,照着葫芦画瓢。 问题 在继承QWebEngineView后,重写mousePressEvent或event函数无法捕获鼠标按下事…...

基于 TAPD 进行项目管理

起因 自己写了个小工具,仓库用的Github。之前在用markdown进行需求管理,现在随着功能的增加,感觉有点难以管理了,所以用TAPD这个工具进行需求、Bug管理。 操作流程 注册 TAPD,需要提供一个企业名新建一个项目&#…...

虚幻基础:角色旋转

能帮到你的话,就给个赞吧 😘 文章目录 移动组件使用控制器所需旋转:组件 使用 控制器旋转将旋转朝向运动:组件 使用 移动方向旋转 控制器旋转和移动旋转 缺点移动旋转:必须移动才能旋转,不移动不旋转控制器…...

深度解析云存储:概念、架构与应用实践

在数据爆炸式增长的时代,传统本地存储因容量限制、管理复杂等问题,已难以满足企业和个人的需求。云存储凭借灵活扩展、便捷访问等特性,成为数据存储领域的主流解决方案。从个人照片备份到企业核心数据管理,云存储正重塑数据存储与…...

多模态大语言模型arxiv论文略读(112)

Assessing Modality Bias in Video Question Answering Benchmarks with Multimodal Large Language Models ➡️ 论文标题:Assessing Modality Bias in Video Question Answering Benchmarks with Multimodal Large Language Models ➡️ 论文作者:Jea…...