python爬虫涨姿势板块

Python有许多用于网络爬虫和数据采集的库和框架。这些库和框架使爬取网页内容、抓取数据、进行数据清洗和分析等任务变得更加容易。以下是一些常见的Python爬虫库和框架:

-

Beautiful Soup: Beautiful Soup是一个HTML和XML解析库,用于从网页中提取数据。它提供了许多方法来导航和搜索文档树,从而轻松提取所需的信息。

-

Requests: Requests是一个HTTP库,用于向网站发送HTTP请求。它使得下载网页内容变得非常容易,可以与其他库(如Beautiful Soup)结合使用来处理和解析页面内容。

-

Scrapy: Scrapy是一个强大的Web爬虫框架,用于爬取网站和抓取数据。它提供了一整套工具和功能,包括页面爬取、数据存储、数据清洗和导出。

-

Selenium: Selenium是一个自动化测试工具,但也可用于Web爬虫。它模拟浏览器行为,允许爬取JavaScript生成的内容,执行交互操作,以及处理需要用户输入的网站。

-

Scrapy-Redis: 这是Scrapy框架的一个扩展,用于支持分布式爬取,将数据存储在Redis数据库中。

-

PyQuery: 类似于Beautiful Soup,PyQuery是一个库,用于解析HTML和XML文档,但它使用jQuery选择器语法。

-

Gevent: Gevent是一个用于异步网络编程的库,可用于构建高性能的网络爬虫。它可以轻松处理数千个并发请求。

-

Apache Nutch: Nutch是一个开源的网络搜索引擎,也可以用作爬虫框架。它支持大规模爬取和数据处理。

-

Splash: Splash是一个JavaScript渲染服务,可用于爬取需要JavaScript渲染的页面。它可以与Scrapy等框架一起使用。

-

Tornado: Tornado是一个网络框架,也可用于构建高性能的异步爬虫。

Beautiful Soup

下面是一个使用Beautiful Soup进行简单网页爬取的Python示例。在此示例中,我们将使用Beautiful Soup来提取并显示指定网页的标题和所有链接的文本和URL。

首先,确保您已经安装了Beautiful Soup,您可以使用pip install beautifulsoup4来安装它。

import requests

from bs4 import BeautifulSoup# 指定要爬取的网页URL

url = "https://www.sina.com.cn/" # 请将网址替换为您要爬取的网页# 发送HTTP GET请求并获取页面内容

response = requests.get(url)

response.encoding = 'utf-8' # 指定字符编码为 UTF-8

# 使用Beautiful Soup解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')# 提取页面标题

title = soup.title.string

print("网页标题:", title)# 提取并显示所有链接的文本和URL

links = soup.find_all('a') # 查找所有<a>标签for link in links:link_text = link.textlink_url = link.get('href') # 获取链接的URLprint(f"链接文本: {link_text}\n链接URL: {link_url}\n")# 关闭HTTP连接

response.close()

首先使用requests.get(url)发送HTTP GET请求来获取指定网页的内容。然后,我们使用Beautiful Soup来解析HTML内容。我们提取了页面标题,并找到了所有的链接,然后逐个提取链接的文本和URL。最后,我们关闭了HTTP连接。

通常,您会使用Beautiful Soup来更深入地分析页面内容,找到特定元素,例如表格、列表或段落,以提取所需的数据。根据要爬取的网页的结构和需求,您可以使用Beautiful Soup来自定义更复杂的爬虫。

结合XPath

import requests

from bs4 import BeautifulSoup

from lxml import html# 发送HTTP请求,获取页面内容

url = "https://www.sina.com.cn/"

response = requests.get(url)

if response.status_code == 200:# 解析页面内容soup = BeautifulSoup(response.text, 'html.parser')# 转换Beautiful Soup对象为lxml对象root = html.fromstring(str(soup))# 使用XPath查询来获取所有链接links = root.xpath('//a')# 打印所有链接for link in links:href = link.get('href')if href:print(href)

else:print("Failed to retrieve the page. Status code:", response.status_code)lxml 是一个强大且高性能的Python库,用于处理XML和HTML文档。它提供了方便的API来解析、操作和构建XML文档。lxml 基于 C 语言的 libxml2 和 libxslt 库,因此它具有出色的性能和稳定性。

以下是 lxml 的一些主要特点和用法:1. 解析XML和HTML文档:lxml 可以用于解析标准的XML和HTML文档,包括处理各种复杂的文档结构和标签嵌套。2. XPath 支持:lxml 支持XPath,允许你使用XPath表达式来定位和选择文档中的元素。这使得数据提取和文档导航变得非常方便。3. ElementTree API:lxml 提供了 ElementTree API 的实现,这使得文档的处理更加易于理解和操作。4. HTML 清理和解析:lxml 提供了功能强大的 HTML 清理工具,允许你将不规范的 HTML 转换为规范的 XML,以便进一步处理。5. HTML 生成:lxml 也可以用于创建和生成 XML 和 HTML 文档,包括添加元素、属性和文本。6. 高性能:lxml 的 C 语言底层库使其具有出色的性能,适用于处理大型文档和高吞吐量的应用。7. 验证和模式检查:lxml 允许你验证 XML 文档是否符合给定的模式或 DTD(文档类型定义)。

Scrapy

Scrapy 是一个功能强大的Python网络爬虫框架,用于抓取和提取网站上的数据。下面是一个简单的 Scrapy 实例,用于爬取特定网站上的文章标题和链接。首先,确保你已安装 Scrapy。

- 首先,确保你已经安装了 Scrapy。如果没有安装,你可以使用以下命令安装 Scrapy:

pip install scrapy

然后,创建一个 Scrapy 项目。在命令行中执行以下命令:

scrapy startproject myproject

这将创建一个名为 “myproject” 的 Scrapy 项目目录。

- 进入项目目录:

cd myproject

- 创建一个爬虫。在命令行中执行以下命令,其中 “example_spider” 是爬虫的名称:

scrapy genspider example_spider example.com

这将创建一个名为 “example_spider” 的爬虫,并指定要爬取的网站域名为 “example.com”。

- 打开 “myproject/spiders/example_spider.py” 文件,编辑爬虫的规则和抓取逻辑。下面是一个简单的示例,用于爬取 “example.com” 网站上的标题和链接:

import scrapyclass ExampleSpider(scrapy.Spider):name = 'example_spider'start_urls = ['http://www.example.com']def parse(self, response):for entry in response.xpath('//h2/a'):yield {'title': entry.xpath('text()').get(),'link': entry.xpath('@href').get()}

- 运行爬虫。在项目目录中执行以下命令:

scrapy crawl example_spider

这将启动爬虫并开始抓取 “example.com” 网站上的信息。抓取的结果将显示在终端上。

Scrapy 具有丰富的功能和配置选项,可根据你的需求进行进一步定制。你还可以配置数据的存储、数据处理、请求头、中间件等。请查阅 Scrapy 文档以获取更多信息和示例:https://docs.scrapy.org/en/latest/index.html

相关文章:

python爬虫涨姿势板块

Python有许多用于网络爬虫和数据采集的库和框架。这些库和框架使爬取网页内容、抓取数据、进行数据清洗和分析等任务变得更加容易。以下是一些常见的Python爬虫库和框架: Beautiful Soup: Beautiful Soup是一个HTML和XML解析库,用于从网页中提取数据。它…...

软件设计原则-里氏替换原则讲解以及代码示例

里氏替换原则 一,介绍 1.前言 里氏替换原则(Liskov Substitution Principle,LSP)是面向对象设计中的一条重要原则,它由Barbara Liskov在1987年提出。 里氏替换原则的核心思想是:父类的对象可以被子类的…...

Sui提供dApp Kit 助力快速构建React Apps和dApps

近日,Mysten Labs推出了dApp Kit,这是一个全新的解决方案,可用于在Sui上开发React应用程序和去中心化应用程序(dApps)。mysten/dapp-kit是专门为React定制的全新SDK,旨在简化诸如连接钱包、签署交易和从RPC…...

2023年系统设计面试如何破解?进入 FAANG 面试的实战指南

如果您正在准备编码面试,但想知道如何准备关键的系统设计主题,并寻找正确方法、技巧和问题的分步指导,那么您来对地方了。在本文中,我将分享 2023 年系统设计面试的完整指南。 在软件开发领域,如果您正在申请高级工程…...

vite项目中的路径别名的配置)

(react+ts)vite项目中的路径别名的配置

简单两个步骤 找到vite.config.ts,这里会现实报错,需要安装一下 npm i -D types/node 这个库的ts声明配置 import path from path // https://vitejs.dev/config/ export default defineConfig({plugins: [react()],resolve:{alias:{"":path.resolve(__…...

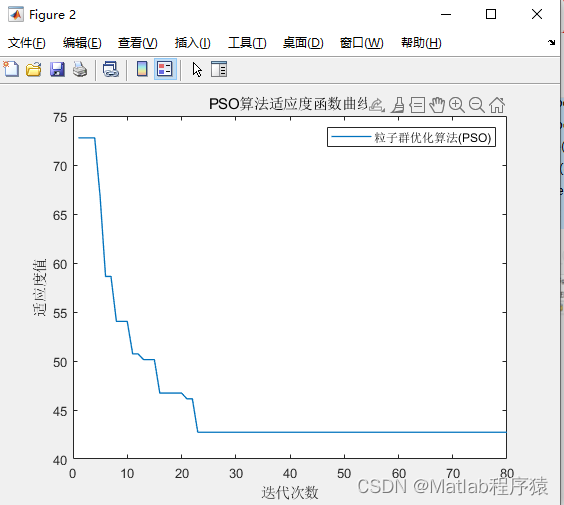

【MATLAB源码-第51期】基于matlab的粒子群算法(PSO)的栅格地图路径规划。

操作环境: MATLAB 2022a 1、算法描述 粒子群算法(Particle Swarm Optimization,简称PSO)是一种模拟鸟群觅食行为的启发式优化方法。以下是其详细描述: 基本思想: 鸟群在寻找食物时,每只鸟都会…...

React之render

一、原理 首先,render函数在react中有两种形式: 在类组件中,指的是render方法: class Foo extends React.Component {render() {return <h1> Foo </h1>;} }在函数组件中,指的是函数组件本身:…...

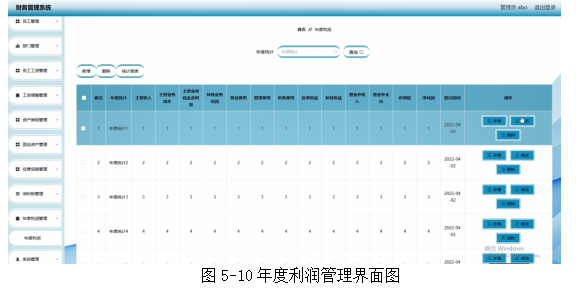

基于springboot实现财务管理系统项目【项目源码+论文说明】计算机毕业设计

基于springboot实现财务管理系统演示 摘要 随着信息技术和网络技术的飞速发展,人类已进入全新信息化时代,传统管理技术已无法高效,便捷地管理信息。为了迎合时代需求,优化管理效率,各种各样的管理系统应运而生&#x…...

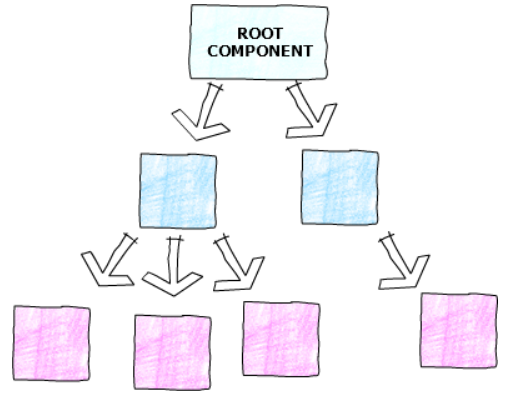

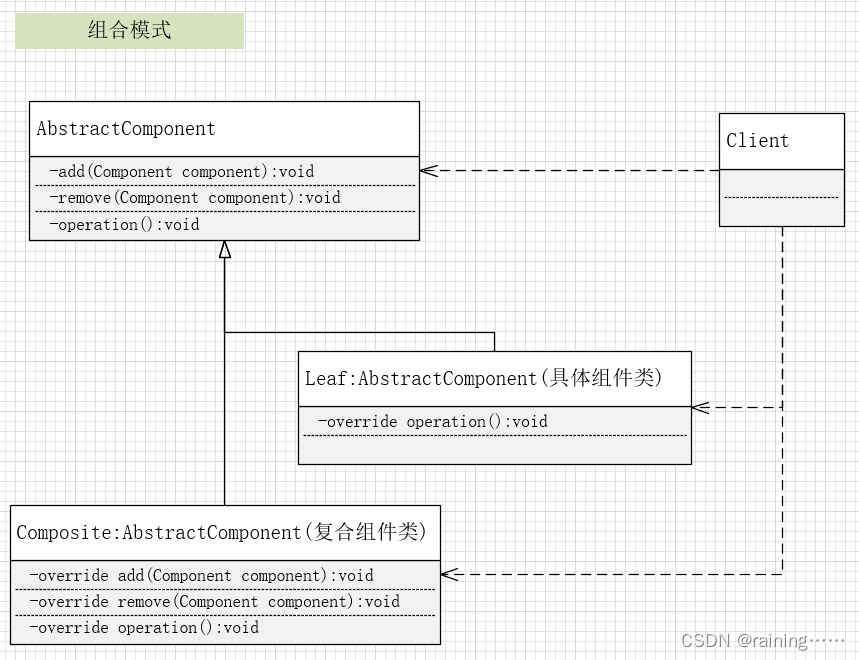

设计模式:组合模式(C#、JAVA、JavaScript、C++、Python、Go、PHP)

上一篇《模板模式》 下一篇《代理模式》 简介: 组合模式,它是一种用于处理树形结构、表示“部分-整体”层次结构的设计模式。它允许你将对象组合成树形结构,以表示部分…...

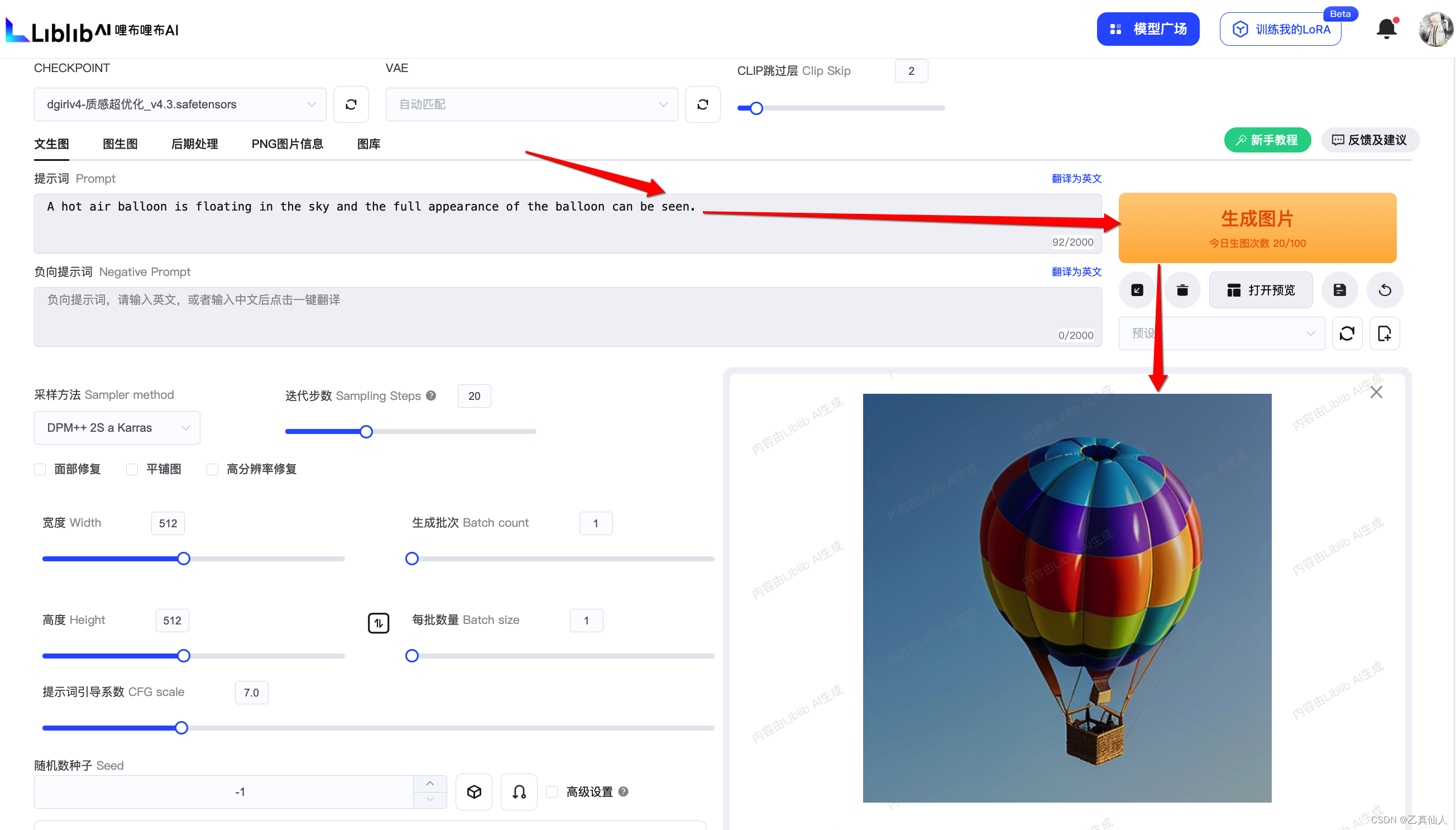

超强满血不收费的AI绘图教程来了(在线Stable Diffusion一键即用)

超强满血不收费的AI绘图教程来了(在线Stable Diffusion一键即用) 一、简介1.1 AI绘图1.2 Stable Diffusion1.2.1 原理简述1.2.2 应用流程 二、AI绘图工具2.1 吐司TusiArt2.2 哩布哩布LibLibAI2.3 原生部署 三、一键即用3.1 开箱尝鲜3.2 模型关联3.3 Cont…...

【蓝桥每日一题]-动态规划 (保姆级教程 篇12)#照相排列

这次是动态规划最后一期了,感谢大家一直以来的观看,以后就进入新的篇章了 目录 题目:照相排列 思路: 题目:照相排列 思路: 首先记录状态f[a][b][c][d][e]表示每排如此人数下对应的方案数,然…...

纺织工厂数字孪生3D可视化管理平台,推动纺织产业数字化转型

近年来,我国加快数字化发展战略部署,全面推进制造业数字化转型,促进数字经济与实体经济深度融合。以数字孪生、物联网、云计算、人工智能为代表的数字技术发挥重要作用。聚焦数字孪生智能工厂可视化平台,推动纺织制造业数字化转型…...

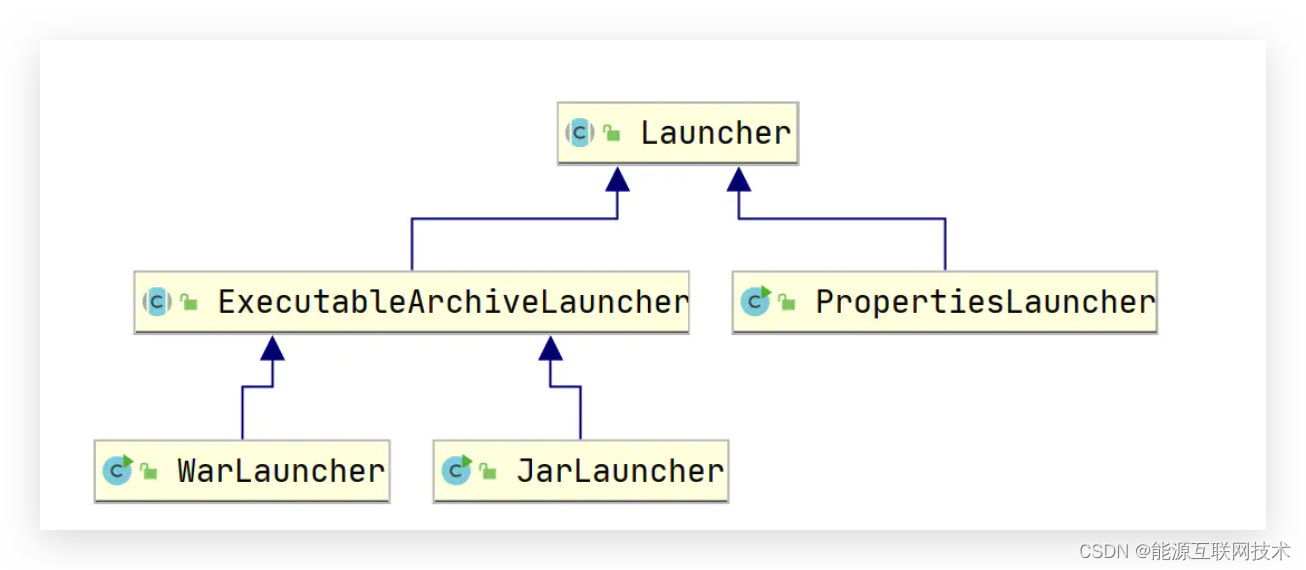

【七】SpringBoot为什么可以打成 jar包启动

SpringBoot为什么可以打成 jar包启动 简介:庆幸的是夜跑的习惯一直都在坚持,正如现在坚持写博客一样。最开始刚接触springboot的时候就觉得很神奇,当时也去研究了一番,今晚夜跑又想起来了这茬事,于是想着应该可以记录一…...

031-第三代软件开发-屏幕保护

第三代软件开发-屏幕保护 文章目录 第三代软件开发-屏幕保护项目介绍屏幕保护 关键字: Qt、 Qml、 MediaPlayer、 VideoOutput、 function 项目介绍 欢迎来到我们的 QML & C 项目!这个项目结合了 QML(Qt Meta-Object Language&#…...

Ubuntu 22.04 更新完内核重启卡在 grub 命令行解决办法

倒霉伊始 升级内核过程中出现如下警告,然后重启引导失败: Warning: os-prober will not be executed to detect other bootable partitions 屏幕内容如下: GNU GRUB version 2.06Minimal BASH-like line editing is supported. For the fir…...

Stream流式处理

Stream流式处理: 建立在Lambda表达式基础上的多数据处理技术。 可以对集合进行迭代、去重、筛选、排序、聚合等处理,极大的简化了代码量。 Stream常用方法 Stream流对象的五种创建方式 //基于数组 String[] arr {"a","b","c…...

ROG STRIX GS-AX5400 使用笔记

1. 技术支持 咨询京东(因为是在京东购买的) 2. 增强信号设置 Note:关于设置的具体步骤,请参考教程《华硕路由器地区如何改成澳大利亚》。 操作路径:打开主页<192.168.50.1> ⇒ 输入用户名和密码后选择登录 ⇒ …...

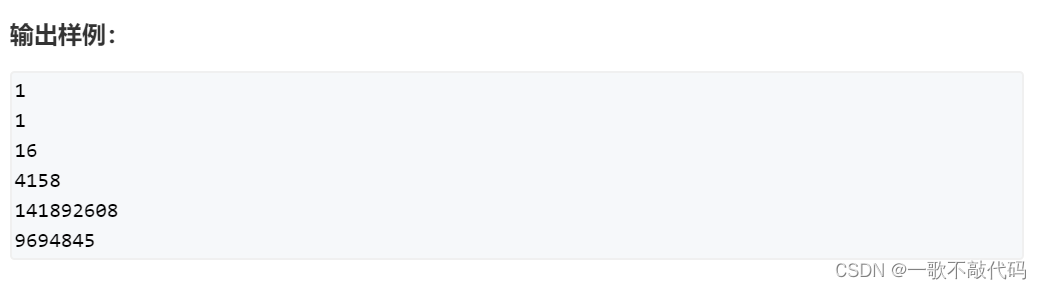

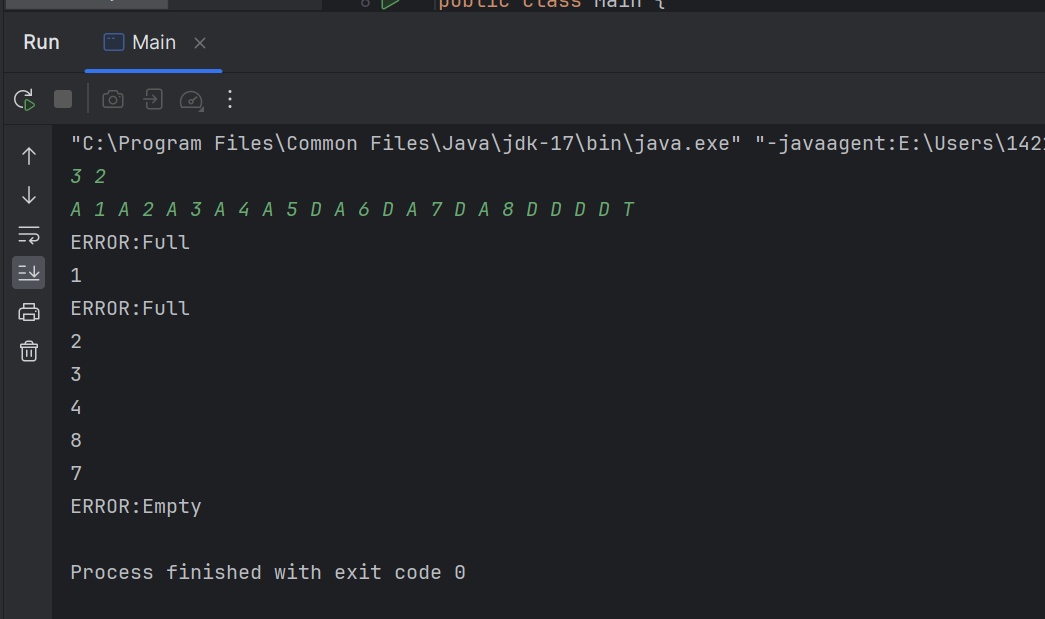

【刷题-PTA】堆栈模拟队列(代码+动态图解)

【刷题-PTA】堆栈模拟队列(代码动态图解) 文章目录 【刷题-PTA】堆栈模拟队列(代码动态图解)题目输入格式:输出格式:输入样例:输出样例: 分析题目区分两栈解题思路伪代码动图演示代码测试 题目 题目描述 : 设已知有两个堆栈S1和S2,请用这两个堆栈模拟出一个队列Q。 …...

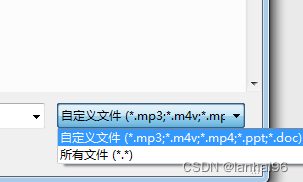

FileUpload控件上传文件时出现 不支持给定路径的格式.的解决方法

正常代码,部署到server 2012时,在上传音频mp3文件时,显示错误“不支持给定路径的格式”,上传控件使用FileUpload控件: 因为程序之前是正常的,因此应该不是程序的问题。 上传时,发现在选择文件时…...

这两天的一些碎碎念

一直以来我都不算是一个非常热爱运维岗位的一个人,其实本行工作对于我来说只是一个工作。运维的广度很大,说什么工作了7年了,可最终总感觉还曾是一窍不通。 什么shell啊,什么python啊,什么大数据啊,7年里&a…...

Lombok 的 @Data 注解失效,未生成 getter/setter 方法引发的HTTP 406 错误

HTTP 状态码 406 (Not Acceptable) 和 500 (Internal Server Error) 是两类完全不同的错误,它们的含义、原因和解决方法都有显著区别。以下是详细对比: 1. HTTP 406 (Not Acceptable) 含义: 客户端请求的内容类型与服务器支持的内容类型不匹…...

docker详细操作--未完待续

docker介绍 docker官网: Docker:加速容器应用程序开发 harbor官网:Harbor - Harbor 中文 使用docker加速器: Docker镜像极速下载服务 - 毫秒镜像 是什么 Docker 是一种开源的容器化平台,用于将应用程序及其依赖项(如库、运行时环…...

centos 7 部署awstats 网站访问检测

一、基础环境准备(两种安装方式都要做) bash # 安装必要依赖 yum install -y httpd perl mod_perl perl-Time-HiRes perl-DateTime systemctl enable httpd # 设置 Apache 开机自启 systemctl start httpd # 启动 Apache二、安装 AWStats࿰…...

WordPress插件:AI多语言写作与智能配图、免费AI模型、SEO文章生成

厌倦手动写WordPress文章?AI自动生成,效率提升10倍! 支持多语言、自动配图、定时发布,让内容创作更轻松! AI内容生成 → 不想每天写文章?AI一键生成高质量内容!多语言支持 → 跨境电商必备&am…...

)

【服务器压力测试】本地PC电脑作为服务器运行时出现卡顿和资源紧张(Windows/Linux)

要让本地PC电脑作为服务器运行时出现卡顿和资源紧张的情况,可以通过以下几种方式模拟或触发: 1. 增加CPU负载 运行大量计算密集型任务,例如: 使用多线程循环执行复杂计算(如数学运算、加密解密等)。运行图…...

智能分布式爬虫的数据处理流水线优化:基于深度强化学习的数据质量控制

在数字化浪潮席卷全球的今天,数据已成为企业和研究机构的核心资产。智能分布式爬虫作为高效的数据采集工具,在大规模数据获取中发挥着关键作用。然而,传统的数据处理流水线在面对复杂多变的网络环境和海量异构数据时,常出现数据质…...

dify打造数据可视化图表

一、概述 在日常工作和学习中,我们经常需要和数据打交道。无论是分析报告、项目展示,还是简单的数据洞察,一个清晰直观的图表,往往能胜过千言万语。 一款能让数据可视化变得超级简单的 MCP Server,由蚂蚁集团 AntV 团队…...

回溯算法学习

一、电话号码的字母组合 import java.util.ArrayList; import java.util.List;import javax.management.loading.PrivateClassLoader;public class letterCombinations {private static final String[] KEYPAD {"", //0"", //1"abc", //2"…...

Redis:现代应用开发的高效内存数据存储利器

一、Redis的起源与发展 Redis最初由意大利程序员Salvatore Sanfilippo在2009年开发,其初衷是为了满足他自己的一个项目需求,即需要一个高性能的键值存储系统来解决传统数据库在高并发场景下的性能瓶颈。随着项目的开源,Redis凭借其简单易用、…...

MacOS下Homebrew国内镜像加速指南(2025最新国内镜像加速)

macos brew国内镜像加速方法 brew install 加速formula.jws.json下载慢加速 🍺 最新版brew安装慢到怀疑人生?别怕,教你轻松起飞! 最近Homebrew更新至最新版,每次执行 brew 命令时都会自动从官方地址 https://formulae.…...