2.10、自定义量化优化过程

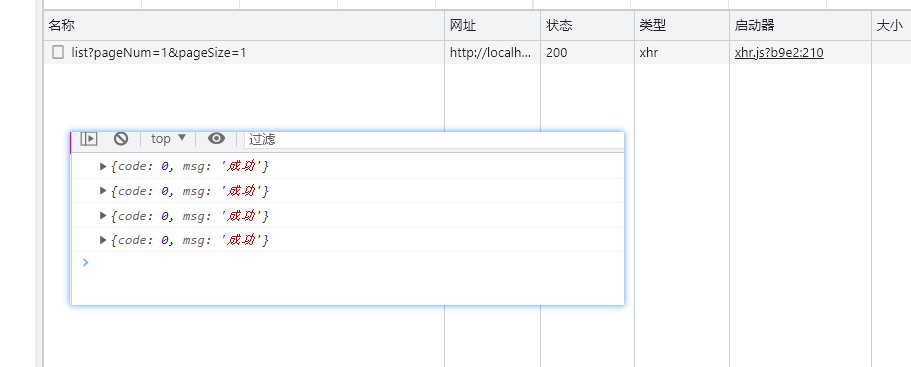

introduction

如何自定义量化优化过程,以及如何手动调用优化过程

code

from typing import Callable, Iterableimport torch

import torchvision

from ppq import QuantizationSettingFactory, TargetPlatform

from ppq.api import (ENABLE_CUDA_KERNEL, QuantizationSettingFactory,quantize_torch_model)

from ppq.core import QuantizationStates

from ppq.executor.torch import TorchExecutor

from ppq.IR.quantize import QuantableOperation# ------------------------------------------------------------

# 在这个例子中,我们将向你介绍如何自定义量化优化过程,以及如何手动调用优化过程

# ------------------------------------------------------------BATCHSIZE = 32

INPUT_SHAPE = [BATCHSIZE, 3, 224, 224]

DEVICE = 'cuda'

PLATFORM = TargetPlatform.TRT_INT8# ------------------------------------------------------------

# 和往常一样,我们要创建 calibration 数据,以及加载模型

# ------------------------------------------------------------

def load_calibration_dataset() -> Iterable:return [torch.rand(size=INPUT_SHAPE) for _ in range(32)]

CALIBRATION = load_calibration_dataset()def collate_fn(batch: torch.Tensor) -> torch.Tensor:return batch.to(DEVICE)model = torchvision.models.mobilenet.mobilenet_v2(pretrained=True)

model = model.to(DEVICE)# ------------------------------------------------------------

# 下面,我们将向你展示如何不借助 QSetting 来自定义优化过程

# QSetting 中包含了 PPQ 官方量化过程的配置参数,你可以借助它来调用所有系统内置优化过程

# 但如果你设计了新的优化过程,你将必须在合适的时机手动启动他们

# ------------------------------------------------------------

QSetting = QuantizationSettingFactory.default_setting()

# 不要进行 Parameter Baking 操作,一旦 Parameter 完成 Baking,后续任何对于参数的修改都是不被允许的

# 你可以设置 baking_parameter = True 并再次执行这个脚本,PPQ 系统会拒绝后续修改 scale 的请求

QSetting.quantize_parameter_setting.baking_parameter = False# ------------------------------------------------------------

# 定义我们自己的优化过程,继承 QuantizationOptimizationPass 基类,实现 optimize 接口

# 在 optimize 接口函数中,你可以修改图的属性从而实现特定目的

# 在这个例子中,我们将图中所有卷积的输入 scale 变换为原来的两倍

# 同时,我们解除最后一个 Gemm 的输入量化

# ------------------------------------------------------------

from ppq import BaseGraph, QuantizationOptimizationPass, TorchExecutor

class MyOptim(QuantizationOptimizationPass):def optimize(self, graph: BaseGraph, dataloader: Iterable, collate_fn: Callable, executor: TorchExecutor, **kwargs) -> None:# graph.operations 是一个包含了图中所有 op 的字典for name, op in graph.operations.items():# 从图中找出所有已经量化的卷积算子# 对于你的网络而言,并非所有算子最终都会被量化,他们会受到 调度策略 和 Quantizer策略 的双重限制# 因此我们要使用 isinstance(op, QuantableOperation) 来判断它是否是一个量化的算子if op.type == 'Conv' and isinstance(op, QuantableOperation):# 对于卷积算子,它可能有 2-3 个输入,其中第二个输入为权重,第三个输入为 bias# 我们修改权重量化信息的 scaleop.input_quant_config[1].scale *= 2 print(f'Input scale of Op {name} has been enlarged.')# 我们接下来解除 Gemm 的量化,在这里 mobilenet_v2 网络只有一个 Gemm 层# 所以我们将所有遇到的 Gemm 的层全部解除量化if op.type == 'Gemm' and isinstance(op, QuantableOperation):# config_with_variable 接口将返回量化算子的所有量化信息————包括输入与输出for cfg, _ in op.config_with_variable:# 在 PPQ 中有许多方法可以切换算子的量化状态# 将量化状态直接设置为 FP32,即解除了算子的量化cfg.state = QuantizationStates.FP32# 也可以直接调用算子的 dequantize 方法# op.dequantize()# ------------------------------------------------------------

# 如果你使用 ENABLE_CUDA_KERNEL 方法

# PPQ 将会尝试编译自定义的高性能量化算子,这一过程需要编译环境的支持

# 如果你在编译过程中发生错误,你可以删除此处对于 ENABLE_CUDA_KERNEL 方法的调用

# 这将显著降低 PPQ 的运算速度;但即使你无法编译这些算子,你仍然可以使用 pytorch 的 gpu 算子完成量化

# ------------------------------------------------------------

with ENABLE_CUDA_KERNEL():quantized = quantize_torch_model(model=model, calib_dataloader=CALIBRATION,calib_steps=32, input_shape=INPUT_SHAPE,setting=QSetting, collate_fn=collate_fn, platform=PLATFORM,onnx_export_file='./model.onnx', device=DEVICE, verbose=0)# ------------------------------------------------------------# 在完成量化流程之后,我们调用我们自定义的量化优化过程从而修改量化参数# ------------------------------------------------------------optim = MyOptim(name='My Optimization Procedure')optim.optimize(graph=quantized, dataloader=CALIBRATION, collate_fn=INPUT_SHAPE, executor=TorchExecutor(quantized, device=DEVICE))

result

____ ____ __ ____ __ __/ __ \/ __ \/ / / __ \__ ______ _____ / /_____ ____ / // /_/ / /_/ / / / / / / / / / __ `/ __ \/ __/ __ \/ __ \/ // ____/ ____/ /__/ /_/ / /_/ / /_/ / / / / /_/ /_/ / /_/ / //_/ /_/ /_____\___\_\__,_/\__,_/_/ /_/\__/\____/\____/_/[31m[Warning] Compling Kernels... Please wait (It will take a few minutes).[0m

[07:08:25] PPQ Quantization Config Refine Pass Running ... Finished.

[07:08:25] PPQ Quantization Fusion Pass Running ... Finished.

[07:08:25] PPQ Quantize Simplify Pass Running ... Finished.

[07:08:25] PPQ Parameter Quantization Pass Running ... Finished.

[07:08:25] PPQ Runtime Calibration Pass Running ...

Calibration Progress(Phase 1): 0%| | 0/32 [00:00<?, ?it/s]

Calibration Progress(Phase 1): 3%|▎ | 1/32 [00:00<00:11, 2.74it/s]

Calibration Progress(Phase 1): 6%|▋ | 2/32 [00:00<00:10, 2.86it/s]

Calibration Progress(Phase 1): 9%|▉ | 3/32 [00:01<00:09, 2.97it/s]

Calibration Progress(Phase 1): 12%|█▎ | 4/32 [00:01<00:09, 3.09it/s]

Calibration Progress(Phase 1): 16%|█▌ | 5/32 [00:01<00:08, 3.08it/s]

Calibration Progress(Phase 1): 19%|█▉ | 6/32 [00:01<00:08, 3.13it/s]

Calibration Progress(Phase 1): 22%|██▏ | 7/32 [00:02<00:08, 3.04it/s]

Calibration Progress(Phase 1): 25%|██▌ | 8/32 [00:02<00:07, 3.07it/s]

Calibration Progress(Phase 1): 28%|██▊ | 9/32 [00:02<00:07, 3.01it/s]

Calibration Progress(Phase 1): 31%|███▏ | 10/32 [00:03<00:06, 3.38it/s]

Calibration Progress(Phase 1): 34%|███▍ | 11/32 [00:03<00:06, 3.08it/s]

Calibration Progress(Phase 1): 38%|███▊ | 12/32 [00:03<00:06, 3.13it/s]

Calibration Progress(Phase 1): 41%|████ | 13/32 [00:04<00:06, 3.04it/s]

Calibration Progress(Phase 1): 44%|████▍ | 14/32 [00:04<00:06, 2.88it/s]

Calibration Progress(Phase 1): 47%|████▋ | 15/32 [00:04<00:05, 3.03it/s]

Calibration Progress(Phase 1): 50%|█████ | 16/32 [00:05<00:05, 2.93it/s]

Calibration Progress(Phase 1): 53%|█████▎ | 17/32 [00:05<00:04, 3.22it/s]

Calibration Progress(Phase 1): 56%|█████▋ | 18/32 [00:05<00:04, 3.15it/s]

Calibration Progress(Phase 1): 59%|█████▉ | 19/32 [00:06<00:03, 3.35it/s]

Calibration Progress(Phase 1): 62%|██████▎ | 20/32 [00:06<00:03, 3.07it/s]

Calibration Progress(Phase 1): 66%|██████▌ | 21/32 [00:06<00:03, 3.21it/s]

Calibration Progress(Phase 1): 69%|██████▉ | 22/32 [00:07<00:03, 3.19it/s]

Calibration Progress(Phase 1): 72%|███████▏ | 23/32 [00:07<00:02, 3.16it/s]

Calibration Progress(Phase 1): 75%|███████▌ | 24/32 [00:07<00:02, 3.10it/s]

Calibration Progress(Phase 1): 78%|███████▊ | 25/32 [00:08<00:02, 3.12it/s]

Calibration Progress(Phase 1): 81%|████████▏ | 26/32 [00:08<00:01, 3.10it/s]

Calibration Progress(Phase 1): 84%|████████▍ | 27/32 [00:08<00:01, 3.00it/s]

Calibration Progress(Phase 1): 88%|████████▊ | 28/32 [00:09<00:01, 3.12it/s]

Calibration Progress(Phase 1): 91%|█████████ | 29/32 [00:09<00:01, 2.98it/s]

Calibration Progress(Phase 1): 94%|█████████▍| 30/32 [00:09<00:00, 3.07it/s]

Calibration Progress(Phase 1): 97%|█████████▋| 31/32 [00:10<00:00, 2.89it/s]

Calibration Progress(Phase 1): 100%|██████████| 32/32 [00:10<00:00, 3.02it/s]

Calibration Progress(Phase 1): 100%|██████████| 32/32 [00:10<00:00, 3.07it/s]

Finished.

[07:08:36] PPQ Quantization Alignment Pass Running ... Finished.

[07:08:36] PPQ Passive Parameter Quantization Running ... Finished.

--------- Network Snapshot ---------

Num of Op: [100]

Num of Quantized Op: [54]

Num of Variable: [277]

Num of Quantized Var: [207]

------- Quantization Snapshot ------

Num of Quant Config: [214]

ACTIVATED: [108]

FP32: [106]

Network Quantization Finished.

Input scale of Op Conv_0 has been enlarged.

Input scale of Op Conv_4 has been enlarged.

Input scale of Op Conv_8 has been enlarged.

Input scale of Op Conv_9 has been enlarged.

Input scale of Op Conv_13 has been enlarged.

Input scale of Op Conv_17 has been enlarged.

Input scale of Op Conv_18 has been enlarged.

Input scale of Op Conv_22 has been enlarged.

Input scale of Op Conv_26 has been enlarged.

Input scale of Op Conv_28 has been enlarged.

Input scale of Op Conv_32 has been enlarged.

Input scale of Op Conv_36 has been enlarged.

Input scale of Op Conv_37 has been enlarged.

Input scale of Op Conv_41 has been enlarged.

Input scale of Op Conv_45 has been enlarged.

Input scale of Op Conv_47 has been enlarged.

Input scale of Op Conv_51 has been enlarged.

Input scale of Op Conv_55 has been enlarged.

Input scale of Op Conv_57 has been enlarged.

Input scale of Op Conv_61 has been enlarged.

Input scale of Op Conv_65 has been enlarged.

Input scale of Op Conv_66 has been enlarged.

Input scale of Op Conv_70 has been enlarged.

Input scale of Op Conv_74 has been enlarged.

Input scale of Op Conv_76 has been enlarged.

Input scale of Op Conv_80 has been enlarged.

Input scale of Op Conv_84 has been enlarged.

Input scale of Op Conv_86 has been enlarged.

Input scale of Op Conv_90 has been enlarged.

Input scale of Op Conv_94 has been enlarged.

Input scale of Op Conv_96 has been enlarged.

Input scale of Op Conv_100 has been enlarged.

Input scale of Op Conv_104 has been enlarged.

Input scale of Op Conv_105 has been enlarged.

Input scale of Op Conv_109 has been enlarged.

Input scale of Op Conv_113 has been enlarged.

Input scale of Op Conv_115 has been enlarged.

Input scale of Op Conv_119 has been enlarged.

Input scale of Op Conv_123 has been enlarged.

Input scale of Op Conv_125 has been enlarged.

Input scale of Op Conv_129 has been enlarged.

Input scale of Op Conv_133 has been enlarged.

Input scale of Op Conv_134 has been enlarged.

Input scale of Op Conv_138 has been enlarged.

Input scale of Op Conv_142 has been enlarged.

Input scale of Op Conv_144 has been enlarged.

Input scale of Op Conv_148 has been enlarged.

Input scale of Op Conv_152 has been enlarged.

Input scale of Op Conv_154 has been enlarged.

Input scale of Op Conv_158 has been enlarged.

Input scale of Op Conv_162 has been enlarged.

Input scale of Op Conv_163 has been enlarged.相关文章:

2.10、自定义量化优化过程

introduction 如何自定义量化优化过程,以及如何手动调用优化过程 code from typing import Callable, Iterableimport torch import torchvision from ppq import QuantizationSettingFactory, TargetPlatform from ppq.api import (ENABLE_CUDA_KERNEL, Quantiz…...

MySQL如何添加自定义函数

深入MySQL:学习如何添加自定义函数 MySQL 是一种流行的开源关系型数据库管理系统,它支持很多内置函数来完成各种操作。不过有时候这些内置函数无法满足我们的需求,这时候就需要自定义函数了。在 MySQL 中,可以通过编写自定义函数…...

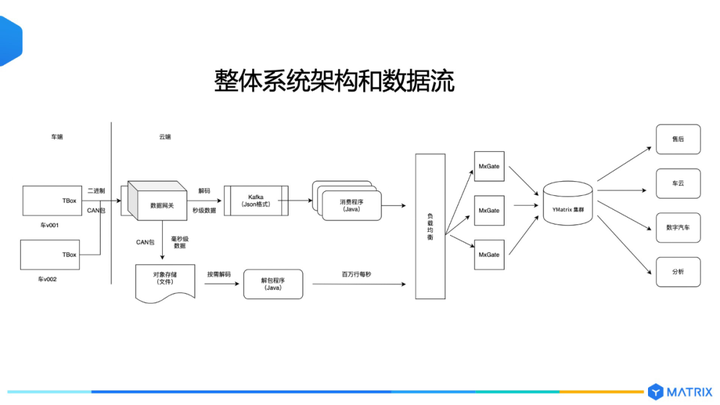

超融合数据库:解锁全场景数据价值的钥匙

前言 近日,四维纵横对外官宣已完成上亿元 B 轮融资。作为超融合数据库理念的提出者,三年来 YMatrix 持续在超融合数据库领域中保持精进与迭代,对于超融合数据库在行业、场景中的应用和理解也更为深刻。 本篇文章,我们将基于 YMa…...

Pap.er for Mac:高清壁纸应用打造你的专属视觉盛宴

在浩瀚的互联网海洋中,你是否曾为寻找一张心仪的高清壁纸而烦恼?或者是在大量的壁纸应用中感到困扰,不知道哪一个能满足你的需求?今天,我要向你介绍的,是一款独特的5K高清壁纸应用——Pap.er for Mac。 Pa…...

AI:46-基于深度学习的垃圾邮件识别

🚀 本文选自专栏:AI领域专栏 从基础到实践,深入了解算法、案例和最新趋势。无论你是初学者还是经验丰富的数据科学家,通过案例和项目实践,掌握核心概念和实用技能。每篇案例都包含代码实例,详细讲解供大家学习。 📌📌📌本专栏包含以下学习方向: 机器学习、深度学…...

【骑行贝丘渔场】一场与海的邂逅,一段难忘的旅程

在这个渐凉的秋日,我们校长骑行队一行人骑着自行车,从大观公园门口出发,开始了一段别开生面的海滩之旅。沿途穿越草海隧道湿地公园、迎海路、海埂公园西门(第二集合点)、宝丰湿地公园、斗南湿地公园、蓝光城࿰…...

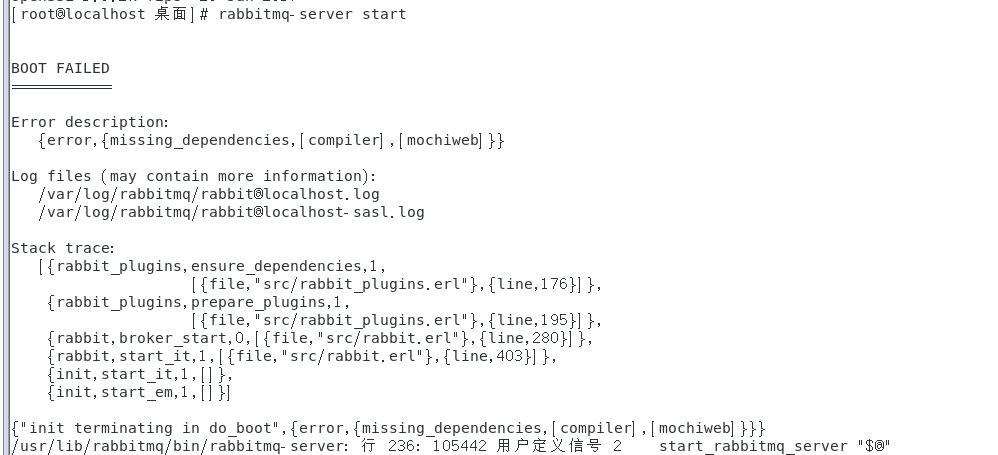

消息中间件——RabbitMQ(一)Windows/Linux环境搭建(完整版)

前言 最近在学习消息中间件——RabbitMQ,打算把这个学习过程记录下来。此章主要介绍环境搭建。此次主要是单机搭建(条件有限),包括在Windows、Linux环境下的搭建,以及RabbitMQ的监控平台搭建。 环境准备 在搭建Rabb…...

Mysql 表读锁与表写锁

表读锁 加锁:lock table table_name read 释放锁:unlock tables 当事务一用表读锁锁住某张表后, 1.事务一必须释放表读锁才能访问其他表 2.期间事务2可以访问该表,但是修改事会遇到阻塞等待,只有等到事务一释放锁后…...

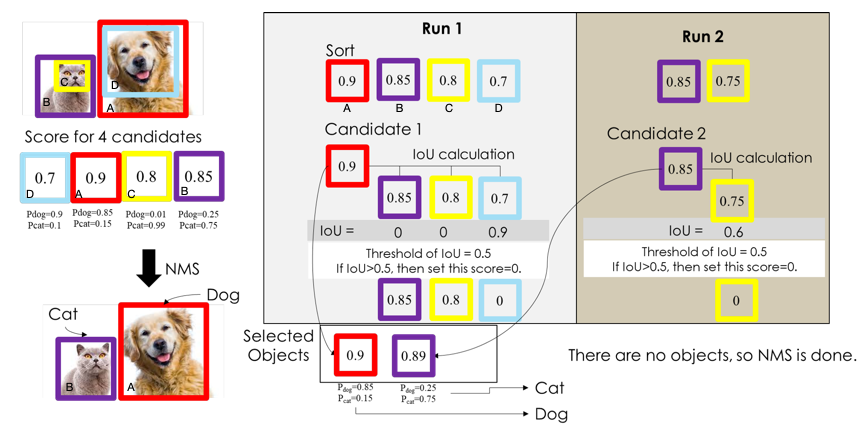

目标检测概述

1.是什么? 目标检测是计算机视觉领域的核心问题之一,其任务就是找出图像中所有感兴趣的目标,确定他们的类别和位置。由于各类不同物体有不同的外观,姿态,以及不同程度的遮挡,加上成像是光照等因素的干扰&a…...

10月31日星期二今日早报简报微语报早读

10月31日星期二,农历九月十七,早报微语早读分享。 1、广西官宣:做试管婴儿费用可报销; 2、港媒:4名港大学生承认“煽惑他人蓄意伤人罪”,被判监禁2年; 3、331名中国维和官兵全部获联合国勋章…...

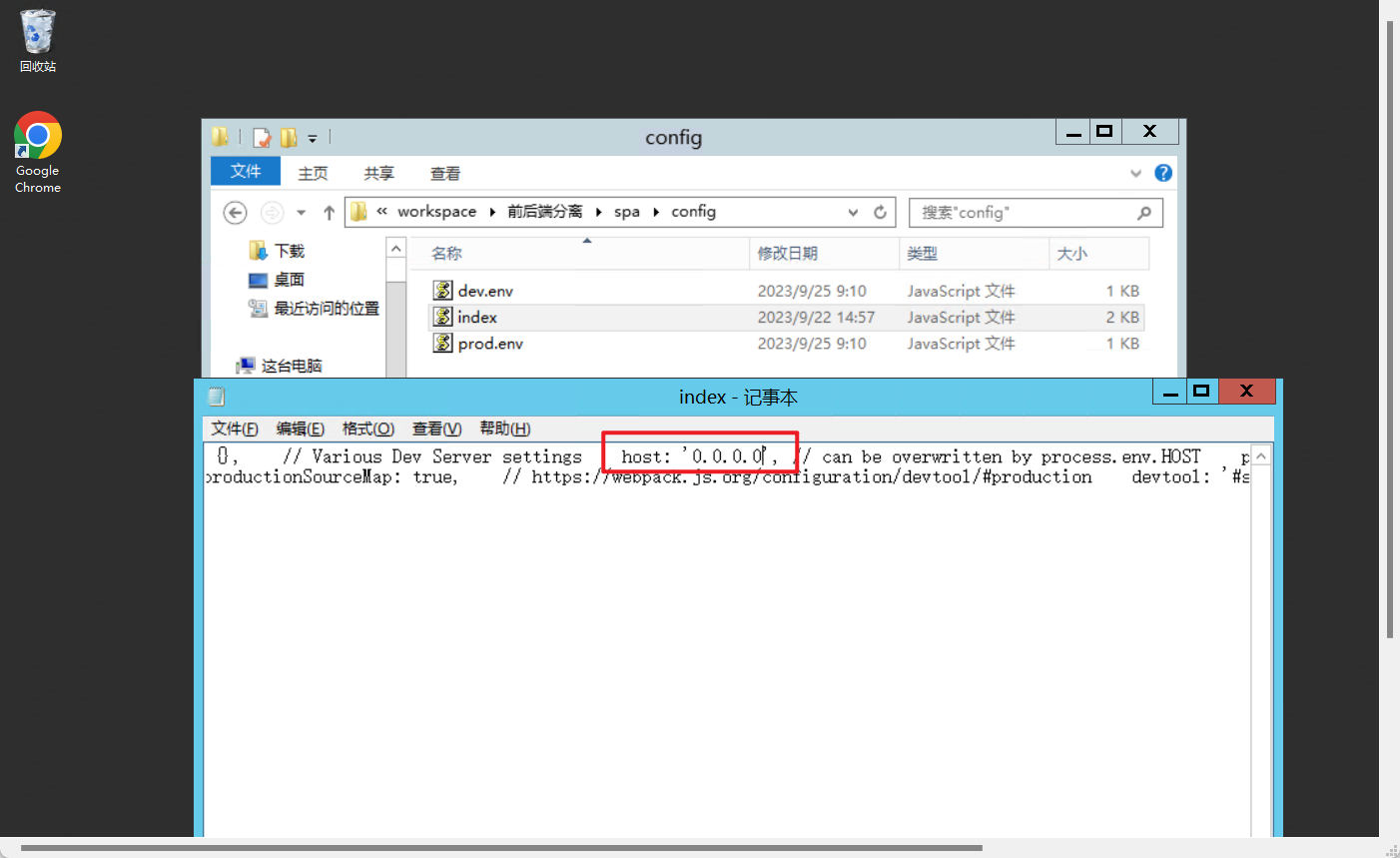

【Linux】虚拟机项目部署与发布

目录 一、Linux部署单机项目 1.1 优缺点 1.2 将项目共享到虚拟机 1.3 解压后将war包放入tomcat 1.4 数据库导入脚本 1.5 Tomcat启动项目 二、部署前后端分离项目 2.1 准备工作 2.2 部署SPA项目 2.2.1 nginx反向代理 2.2.2 SPA项目宿主机访问 一、Linux部署单机项目…...

边缘计算技术的崭新篇章:赋能未来智能系统

边缘计算是近年来云计算和物联网技术发展的重要趋势。通过将数据处理和分析从云端迁移到设备边缘,边缘计算能够实现更低的延迟和更高的数据安全。本文将探索边缘计算技术的最新进展及其在不同行业中的应用场景。 1. 实时数据处理与决策 在需要快速响应的场景中&…...

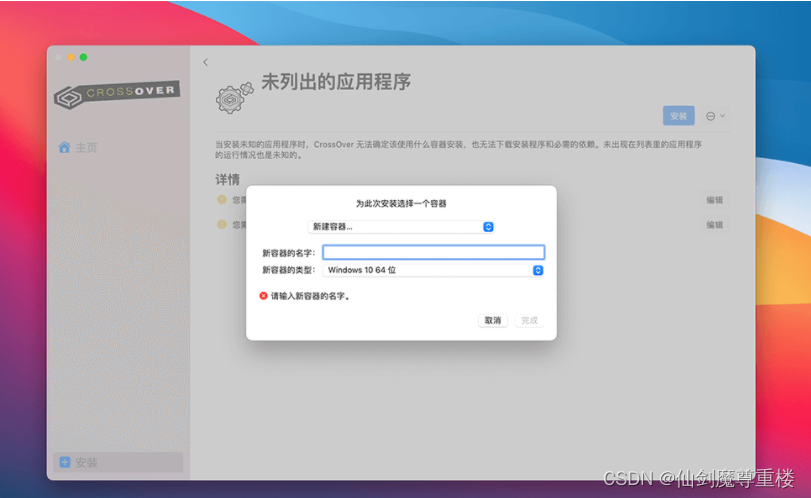

Mac/Linux类虚拟机_CrossOver虚拟机CrossOver 23.6正式发布2024全新功能解析

CodeWeivers 公司于今年 10 月发布了 CrossOver 23.6 测试版,重点添加了对 DirectX 12 支持,从而在 Mac 上更好地模拟运行 Windows 游戏。 该公司今天发布新闻稿,表示正式发布 CrossOver 23 稳定版,在诸多新增功能中,最…...

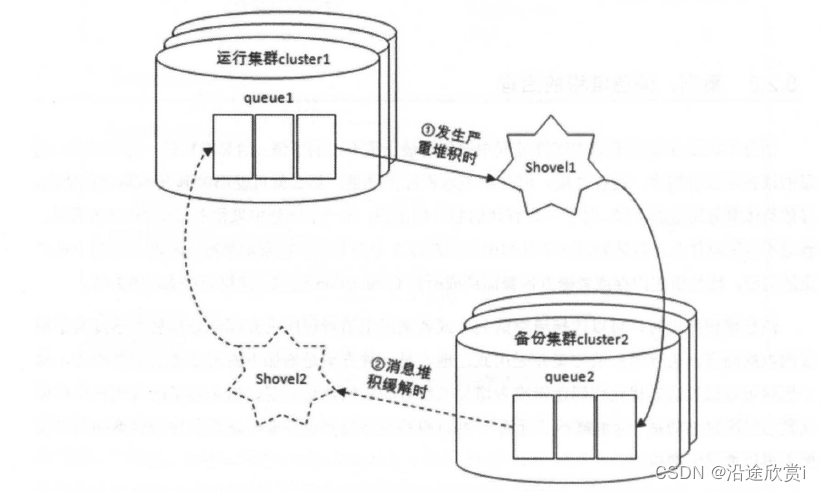

RabbitMQ 运维 扩展

1、集群管理与配置 1.1、集群搭建 关于Rabbitmq 集群的搭建,详见以下文章。简单说来就是将多个单机rabbitmq服务,通过给到一致的密钥(.erlang.cookie)并且开放rabbitmq服务的 25672 端口,允许多节点间进行互相通讯&am…...

[量化投资-学习笔记003]Python+TDengine从零开始搭建量化分析平台-Grafana画K线图

在前面两个笔记: PythonTDengine从零开始搭建量化分析平台-数据存储 PythonTDengine从零开始搭建量化分析平台-MA均线的多种实现方式 中有提到使用 Grafana 画图,不过画的都是均线。除了均线,Grafana 非常人性的提供了 K线图模块 搭配 TDeng…...

前端接口请求支持内容缓存和过期时间

前端接口请求支持内容缓存和过期时间 支持用户自定义缓存时间,在规则时间内读取缓存内容,超出时间后重新请求接口 首先封装一下 axios,这一步可做可不做。但是在实际开发场景中都会对 axios 做二次封装,我们在二次封装的 axios …...

【计算机网络】数据链路层——以太网

文章目录 前言什么是以太网以太网帧格式6位目的地址和源地址2位类型数据长度CRC 校验和 数据在数据链路层是如何转发的 前言 前面我们学习了关于应用层——自定义协议、传输层——UDP、TCP协议、网络层——IP协议,今天我将为大家分享关于数据链路层——以太网方面的…...

【Spring】Spring MVC请求响应

文章目录 1. 请求1.1 传递单个参数1.2 传递多个参数1.3 传递对象1.4 后端参数重命名1.5 传递数组1.6 传递集合1.7 传递JSON对象1.8 获取URL中参数1.9 上传⽂件1.10 获得Cookie1.11 获得Session1.12 获得Header 2. 响应2.1 返回静态界面2.2 返回数据2.3 返回HTML代码片段2.4 返回…...

算法基础(北京大学MOOC))

程序设计与算法(二)算法基础(北京大学MOOC)

一、枚举 1、完美立方 /* 完美立方a^3b^3c^3d^3// a大于b c d// b<c<d*/ #include <iostream> int main() {int a,b,c,d; int N 24;//scanf("%d", &N );for(a2; a<N; a ) //a的范围 [2,N]{for(b2; b<a; b){ //b的范围[2…...

【MedusaSTears】正则表达式搜索心得

文章目录 心得体会1.懒惰匹配最少字符 .?2.前瞻: 字符串后边 包括/不包括 某个单词/字母2-1.包含某单词: start(?.?hello)2-2.不包含某单词: start(?!.?hello) 心得体会 前情回顾: 【MedusaSTears】正则?不要太简单!—正则表达式个人学习心得总结: 正则说白了是对字符串…...

蓝桥杯 2024 15届国赛 A组 儿童节快乐

P10576 [蓝桥杯 2024 国 A] 儿童节快乐 题目描述 五彩斑斓的气球在蓝天下悠然飘荡,轻快的音乐在耳边持续回荡,小朋友们手牵着手一同畅快欢笑。在这样一片安乐祥和的氛围下,六一来了。 今天是六一儿童节,小蓝老师为了让大家在节…...

OkHttp 中实现断点续传 demo

在 OkHttp 中实现断点续传主要通过以下步骤完成,核心是利用 HTTP 协议的 Range 请求头指定下载范围: 实现原理 Range 请求头:向服务器请求文件的特定字节范围(如 Range: bytes1024-) 本地文件记录:保存已…...

ip子接口配置及删除

配置永久生效的子接口,2个IP 都可以登录你这一台服务器。重启不失效。 永久的 [应用] vi /etc/sysconfig/network-scripts/ifcfg-eth0修改文件内内容 TYPE"Ethernet" BOOTPROTO"none" NAME"eth0" DEVICE"eth0" ONBOOT&q…...

音视频——I2S 协议详解

I2S 协议详解 I2S (Inter-IC Sound) 协议是一种串行总线协议,专门用于在数字音频设备之间传输数字音频数据。它由飞利浦(Philips)公司开发,以其简单、高效和广泛的兼容性而闻名。 1. 信号线 I2S 协议通常使用三根或四根信号线&a…...

云原生安全实战:API网关Kong的鉴权与限流详解

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 一、基础概念 1. API网关(API Gateway) API网关是微服务架构中的核心组件,负责统一管理所有API的流量入口。它像一座…...

掌握 HTTP 请求:理解 cURL GET 语法

cURL 是一个强大的命令行工具,用于发送 HTTP 请求和与 Web 服务器交互。在 Web 开发和测试中,cURL 经常用于发送 GET 请求来获取服务器资源。本文将详细介绍 cURL GET 请求的语法和使用方法。 一、cURL 基本概念 cURL 是 "Client URL" 的缩写…...

破解路内监管盲区:免布线低位视频桩重塑停车管理新标准

城市路内停车管理常因行道树遮挡、高位设备盲区等问题,导致车牌识别率低、逃费率高,传统模式在复杂路段束手无策。免布线低位视频桩凭借超低视角部署与智能算法,正成为破局关键。该设备安装于车位侧方0.5-0.7米高度,直接规避树枝遮…...

Python 训练营打卡 Day 47

注意力热力图可视化 在day 46代码的基础上,对比不同卷积层热力图可视化的结果 import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader import matplotlib.pypl…...

通过MicroSip配置自己的freeswitch服务器进行调试记录

之前用docker安装的freeswitch的,启动是正常的, 但用下面的Microsip连接不上 主要原因有可能一下几个 1、通过下面命令可以看 [rootlocalhost default]# docker exec -it freeswitch fs_cli -x "sofia status profile internal"Name …...

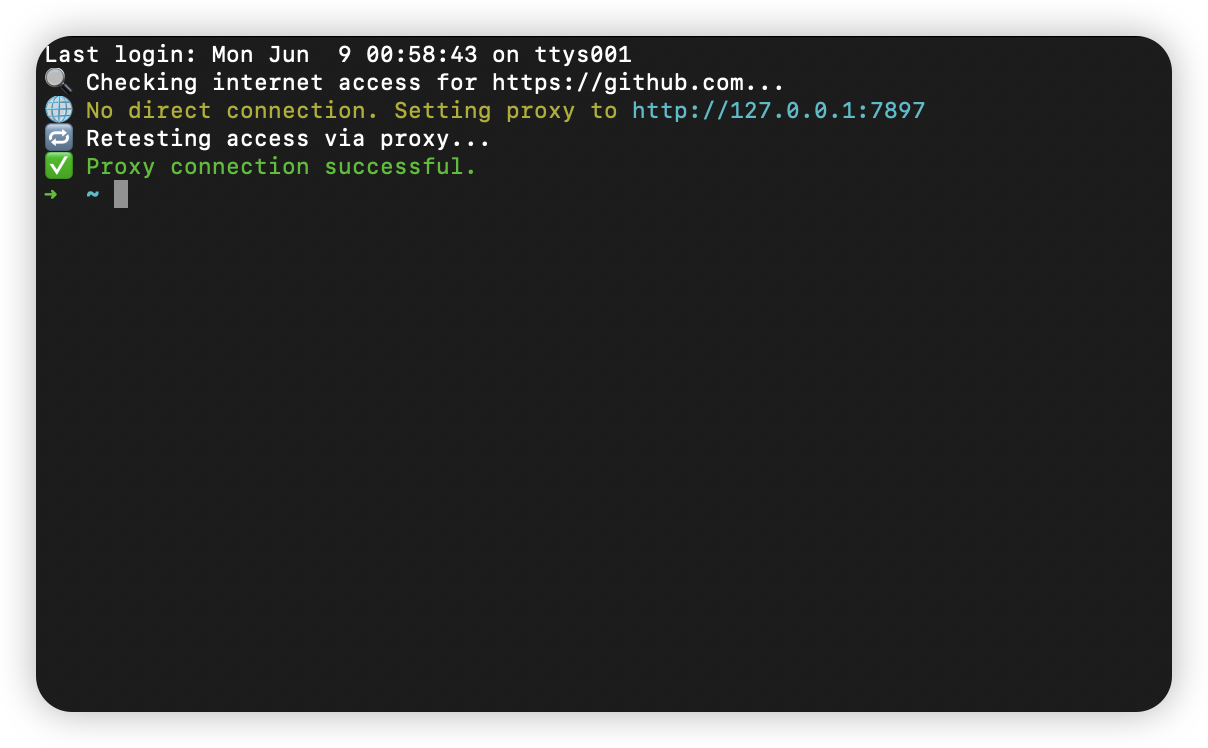

macOS 终端智能代理检测

🧠 终端智能代理检测:自动判断是否需要设置代理访问 GitHub 在开发中,使用 GitHub 是非常常见的需求。但有时候我们会发现某些命令失败、插件无法更新,例如: fatal: unable to access https://github.com/ohmyzsh/oh…...