kubernetes-PV与PVC、存储卷

一、PV和PVC详解

当前,存储的方式和种类有很多,并且各种存储的参数也需要非常专业的技术人员才能够了解。在Kubernetes集群中,放了方便我们的使用和管理,Kubernetes提出了PV和PVC的概念,这样Kubernetes集群的管理人员就可以将注意力集中到Kubernetes集群中来,而无需操心后端的存储设备。

pv : 相当于磁盘分区

pvc: 相当于磁盘请求

PersistentVolumeClaim(PVC)是用户存储的请求

PVC的使用逻辑:在pod中定义一个存储卷(该存储卷类型为PVC),

定义的时候直接指定大小,pvc必须与对应的pv建立关系,

pvc会根据定义去pv申请,而pv是由存储空间创建出来的。

pv和pvc是kubernetes抽象出来的一种存储资源。

- PV : 持久化卷的意思,是对底层的共享存储的一种抽象

- PVC(Persistent Volume Claim)是持久卷请求于存储需求的一种声明(PVC其实就是用户向kubernetes系统发出的一种资源需求申请。)

从上图可以看出,底层的存储可以使各种类型,包括NFS、Ceph、CIFS等等,而Kubernetes会把这些存储统一抽象为PV。PV,即Persistent Volume,是集群中配置的存储资源。PVC,即Persistent Volume Claim,是用户存储的请求,通常我们在一个Pod中定义一个存储卷,定义的时候会指定该存储卷的相关信息,比如空间大小、可读可写等属性。但是PVC并不是真正的存储空间,Pod的PVC和PV之间必须建立某种联系,这样才能使得Pod可以调用实际存储空间。

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv2

spec:

nfs: # 存储类型,与底层真正存储对应

capacity: # 存储能力,目前只支持存储空间的设置

storage: 2Gi

accessModes: # 访问模式

storageClassName: # 存储类别

persistentVolumeReclaimPolicy: # 回收策略

使用了PV和PVC之后,工作可以得到进一步的细分:

存储:存储工程师维护

PV: kubernetes管理员维护

PVC:kubernetes用户维护

二、PV和PVC生命周期

实际上,不管是PV,还是PVC,都遵循以下生命周期:

Provisioning(配置)---> Binding(绑定)---> Using(使用)---> Releasing(释放) ---> Recycling(回收)

2.1 Provisioning 配置

Provisioning,即配置阶段。一般而言,PV的提供方式有两种——静态和动态。

所谓静态提供,就是Kubernetes管理员创建多个PV,这些PV的存储空间等属性已经确定,并且已经和真实的存储设备进行了关联。Pod中的PVC可以根据需要请求这些PV。

所谓动态提供,需要依托与StorageClass的支持,这时Kubernetes会尝试为PVC来动态的创建PV。这样做的好处是避免出现这种情况:部分PVC被分配给了远远超出其资源需求的PV、或者说系统存在很多资源较少的PV,但是一个资源需求很高的PVC缺无法被满足的情况。

2.2 Binding 结合

在动态配置的情况下,用户创建或者已经创建了具有特定数量的PVC后,PVC与PV绑定的过程。

如果没有满足PVC请求需求的PV,那么PVC将无法被创建,因此造成的结果就是相应的Pod也不会被创建。

2.3 Using 使用

即PVC与PC绑定后,Pod对存储空间的使用过程。

2.4 Releasing 释放

当Pod被删除或者对该PV的资源使用结束后,Kubernetes就会删除该PVC对象,相应的也会回收PV资源,这时的PV就会处于这种状态。但是此时的PV还需要处理完毕之前的Pod在该存储卷上存储信息后才能够被使用。

2.5 Reclaiming 处理中

PV的回收策略对被释放的PV的处理过程。

2.6 Recycling 循环

根据配置,有时PV会被执行擦除操作,删除掉该存储空间上的所有信息,并且该存储资源也可以被再次使用。

三、访问模式

3.1 PV的访问模式(accessmodes)

| 模式 | 翻译 |

| ReadWriteOnce (RWO) | 可读可写,但只支持被单个节点挂载。 |

| ReadOnlyMany (ROX) | 只读,可以被多个节点挂载。 |

| ReadWriteMany (RWX) | 多路可读可写。这种存储可以以读写的方式被多个节点共享。不是每一种存储都支持这三种方式,像共享方式,目前支持的还比较少,比较常用的是 NFS。在PVC绑定PV时通常根据两个条件来绑定,一个是存储的大小,另一个就是访问模式。 |

3.2 PV的回收策略(persistentVolumeReclaimPolicy)

| 策略 | 解释 |

| retain | 不清理,保留Volume (需要手动清理) |

| Recycle | 删除数据,即rm -rf /thevolumel*(只有NFS和HostPath支持) |

| Delete | 删除存储资源,比如删除AWS EBS卷(只有AWS EBS,GCE PD,Azure Disk和Cinder支持) |

3.3 pv的状态

| 状态 | 解释 |

| Available | 可用 |

| Bound | 已经分配给PVC |

| Released | PVC解绑但还未执行回收策略 |

| Failed | 发生错误 |

四、实验验证

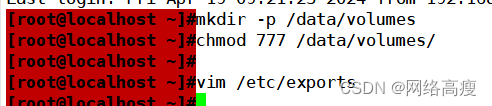

4.1 安装nfs

# 1、创建目录

[root@k8s ~]# mkdir /root/data/{pv1,pv2,pv3} -pv

chmod 777 /data/volumes

# 2、暴露服务

[root@k8s ~]# vim /etc/exports

/root/data/pv1 192.168.223.0/24(rw,sync,no_root_squash)

/root/data/pv2 192.168.223.0/24(rw,sync,no_root_squash)

/root/data/pv3 192.168.223.0/24(rw,sync,no_root_squash)

# 3、重启服务

[root@k8s ~]# systemctl restart nfs

//master节点操作

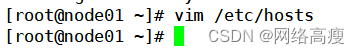

vim pod-nfs-vol.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-vol-nfs

namespace: default

spec:

containers:

- name: myapp

image: ikubernetes/myapp:v1

volumeMounts:

- name: html

mountPath: /usr/share/nginx/html

volumes:

- name: html

nfs:

path: /data/volumes

server: stor01(主机名)

4.2 验证nfs持久化存储

//在nfs服务器上创建index.html

cd /data/volumes

vim index.html

<h1> nfs stor01</h1>//master节点操作

curl 10.244.2.38

<h1> nfs stor01</h1>kubectl delete -f pod-nfs-vol.yaml #删除nfs相关pod,再重新创建,可以得到数据的持久化存储

kubectl apply -f pod-nfs-vol.yaml

nas gfs ceph san

可以实现持久化存储,使用nfs将存储设别空间挂载到容器中,pod可以跨node节点共享数据

4.3 NFS使用PV和PVC

PVC是资源的申请,用来声明对存储空间、访问模式、存储类别需求信息。下面是资源清单文件

4.3.1、配置nfs存储

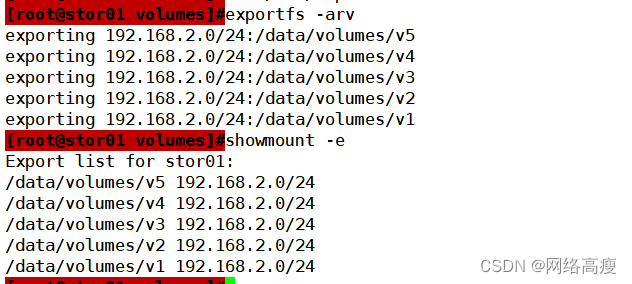

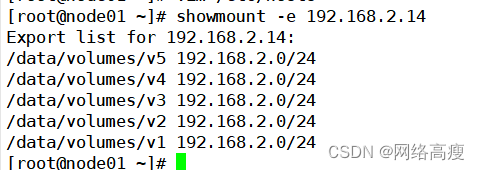

//NFS使用PV和PVC

1、配置nfs存储

mkdir v{1,2,3,4,5}vim /etc/exports

/data/volumes/v1 192.168.10.0/24(rw,no_root_squash)

/data/volumes/v2 192.168.10.0/24(rw,no_root_squash)

/data/volumes/v3 192.168.10.0/24(rw,no_root_squash)

/data/volumes/v4 192.168.10.0/24(rw,no_root_squash)

/data/volumes/v5 192.168.10.0/24(rw,no_root_squash)exportfs -arv

showmount -e

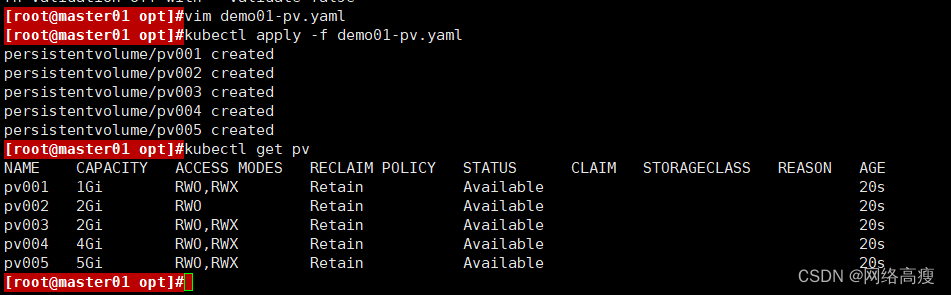

4.3.2 定义PV

//这里定义5个PV,并且定义挂载的路径以及访问模式,还有PV划分的大小。

vim pv-demo.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv001

labels:

name: pv001

spec:

nfs:

path: /data/volumes/v1server: stor01

accessModes: ["ReadWriteMany","ReadWriteOnce"]

capacity:

storage: 1Gi

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv002

labels:

name: pv002

spec:

nfs:

path: /data/volumes/v2

server: stor01

accessModes: ["ReadWriteOnce"]

capacity:

storage: 2Gi

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv003

labels:

name: pv003

spec:

nfs:

path: /data/volumes/v3

server: stor01

accessModes: ["ReadWriteMany","ReadWriteOnce"]

capacity:

storage: 2Gi

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv004

labels:

name: pv004

spec:

nfs:

path: /data/volumes/v4

server: stor01

accessModes: ["ReadWriteMany","ReadWriteOnce"]

capacity:

storage: 4Gi

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv005

labels:

name: pv005

spec:

nfs:

path: /data/volumes/v5

server: stor01

accessModes: ["ReadWriteMany","ReadWriteOnce"]

capacity:

storage: 5Gikubectl apply -f pv-demo.yaml

kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pv001 1Gi RWO,RWX Retain Available 7s

pv002 2Gi RWO Retain Available 7s

pv003 2Gi RWO,RWX Retain Available 7s

pv004 4Gi RWO,RWX Retain Available 7s

pv005 5Gi RWO,RWX Retain Available 7s

4.3.3 定义PVC

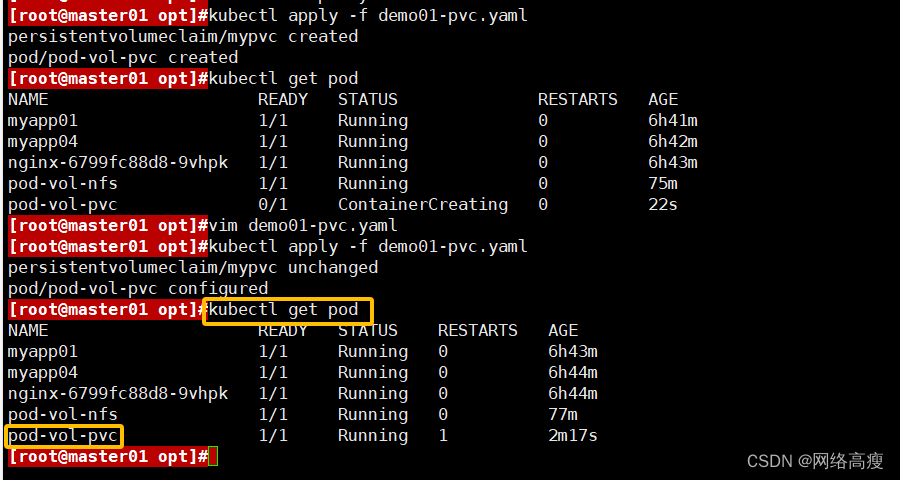

//这里定义了pvc的访问模式为多路读写,该访问模式必须在前面pv定义的访问模式之中。定义PVC申请的大小为2Gi,此时PVC会自动去匹配多路读写且大小为2Gi的PV,匹配成功获取PVC的状态即为Bound

vim pod-vol-pvc.yaml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: mypvc

namespace: default

spec:

accessModes: ["ReadWriteMany"]

resources:

requests:

storage: 2Gi

---

apiVersion: v1

kind: Pod

metadata:

name: pod-vol-pvc

namespace: default

spec:

containers:

- name: myapp

image: soscscs/myapp:v1

volumeMounts:

- name: html

mountPath: /usr/share/nginx/html

volumes:

- name: html

persistentVolumeClaim:

claimName: mypvc

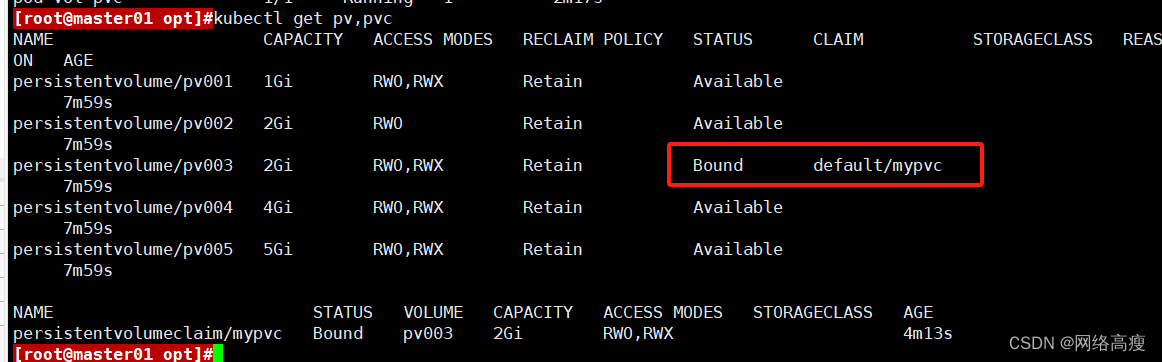

kubectl apply -f pod-vol-pvc.yamlkubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pv001 1Gi RWO,RWX Retain Available 19m

pv002 2Gi RWO Retain Available 19m

pv003 2Gi RWO,RWX Retain Bound default/mypvc 19m

pv004 4Gi RWO,RWX Retain Available 19m

pv005 5Gi RWO,RWX Retain Available 19mkubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

mypvc Bound pv003 2Gi RWO,RWX 22s

4.3.4 测试访问

//在存储服务器上创建index.html,并写入数据,通过访问Pod进行查看,可以获取到相应的页面。

cd /data/volumes/v3/

echo "welcome to use pv3" > index.htmlkubectl get pods -o wide

pod-vol-pvc 1/1 Running 0 3m 10.244.2.39 k8s-node02curl 10.244.2.39

welcome to use pv3

4.4 搭建 StorageClass + NFS,实现 NFS 的动态 PV 创建

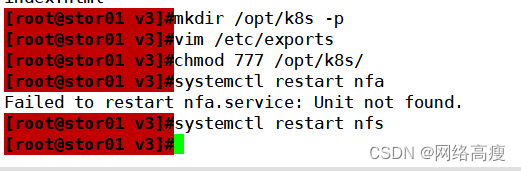

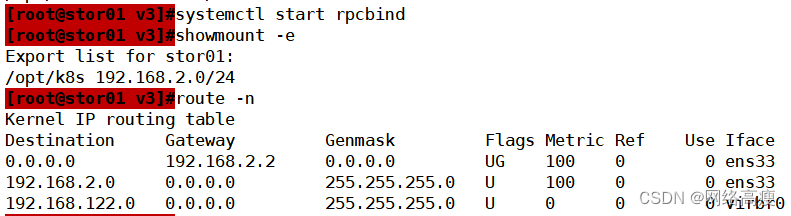

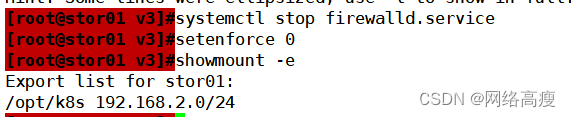

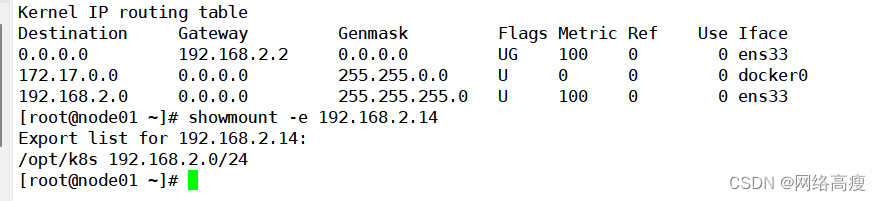

4.4.1 在stor01节点上安装nfs,并配置nfs服务

关闭防火墙

mkdir /opt/k8s

chmod 777 /opt/k8s/vim /etc/exports

/opt/k8s 192.168.10.0/24(rw,no_root_squash,sync)systemctl restart nfs

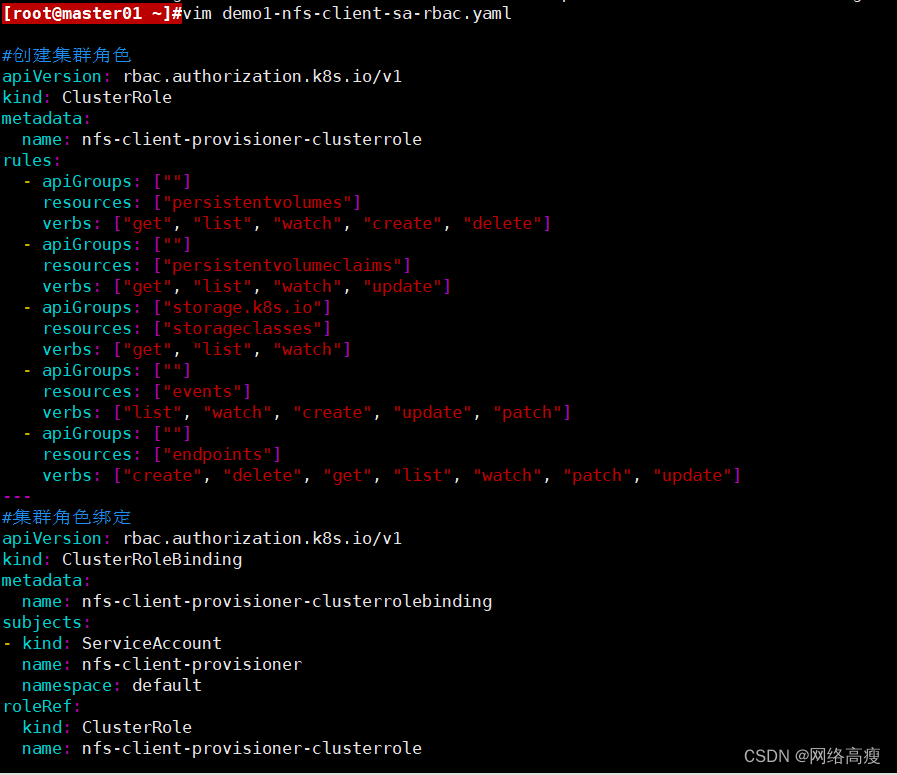

4.4.2 创建 Service Account,用来管理 NFS Provisioner 在 k8s 集群中运行的权限,设置 nfs-client 对 PV,PVC,StorageClass 等的规则

vim nfs-client-rbac.yaml

#创建 Service Account 账户,用来管理 NFS Provisioner 在 k8s 集群中运行的权限

apiVersion: v1

kind: ServiceAccount

metadata:

name: nfs-client-provisioner

---

#创建集群角色

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: nfs-client-provisioner-clusterrole

rules:

- apiGroups: [""]

resources: ["persistentvolumes"]

verbs: ["get", "list", "watch", "create", "delete"]

- apiGroups: [""]

resources: ["persistentvolumeclaims"]

verbs: ["get", "list", "watch", "update"]

- apiGroups: ["storage.k8s.io"]

resources: ["storageclasses"]

verbs: ["get", "list", "watch"]

- apiGroups: [""]

resources: ["events"]

verbs: ["list", "watch", "create", "update", "patch"]

- apiGroups: [""]

resources: ["endpoints"]

verbs: ["create", "delete", "get", "list", "watch", "patch", "update"]

---

#集群角色绑定

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: nfs-client-provisioner-clusterrolebinding

subjects:

- kind: ServiceAccount

name: nfs-client-provisioner

namespace: default

roleRef:

kind: ClusterRole

name: nfs-client-provisioner-clusterrole

apiGroup: rbac.authorization.k8s.io

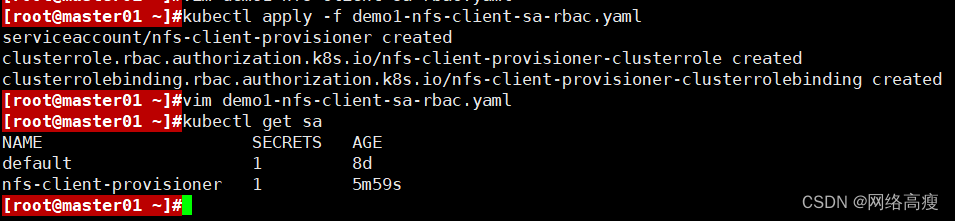

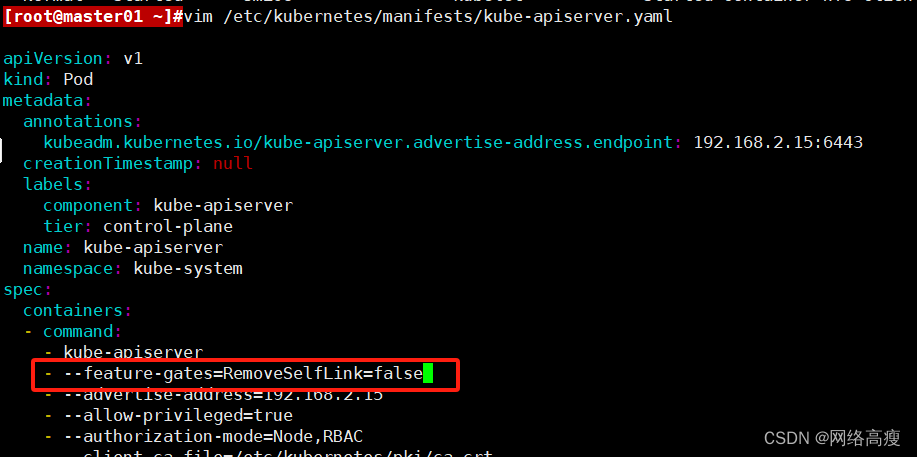

kubectl apply -f nfs-client-rbac.yaml

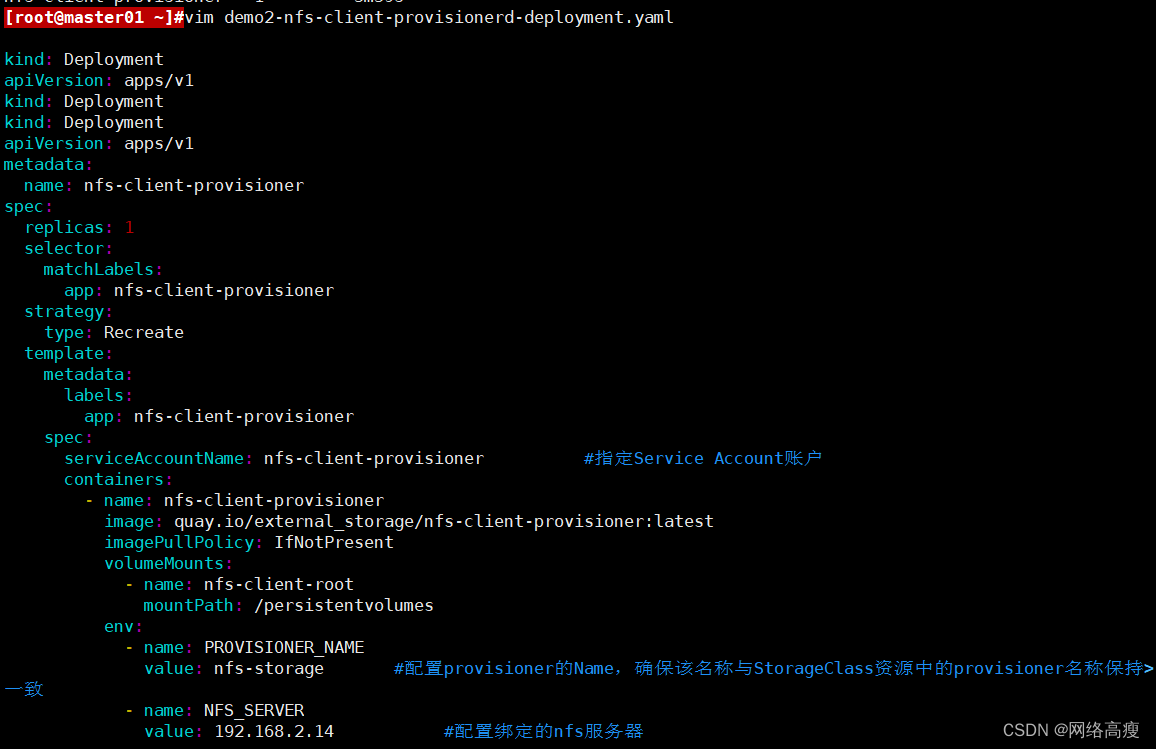

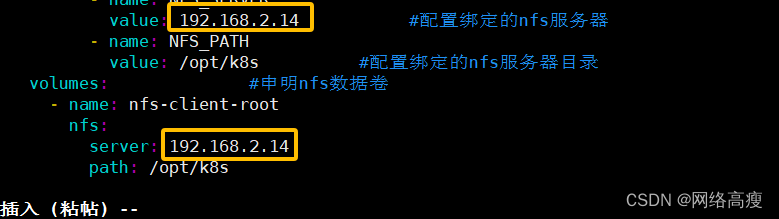

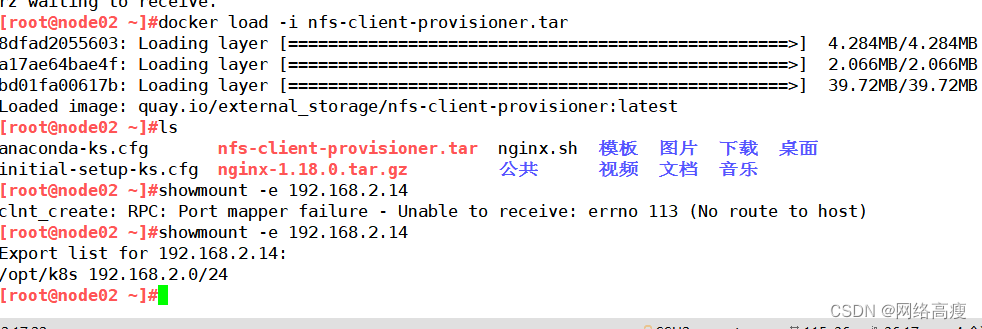

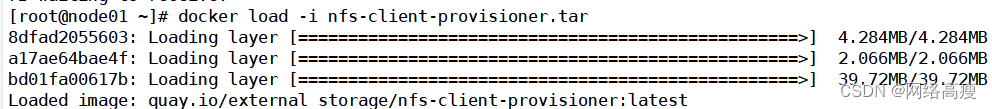

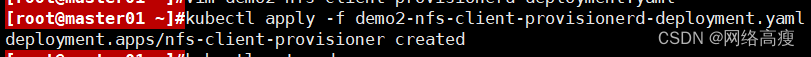

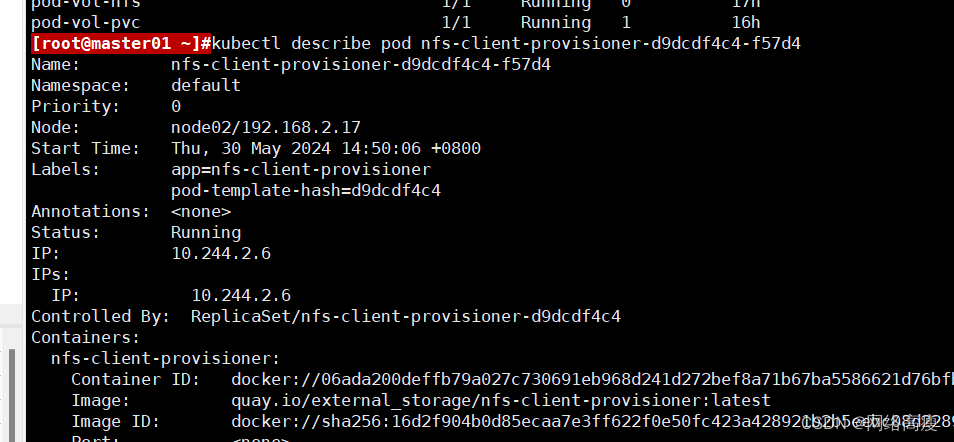

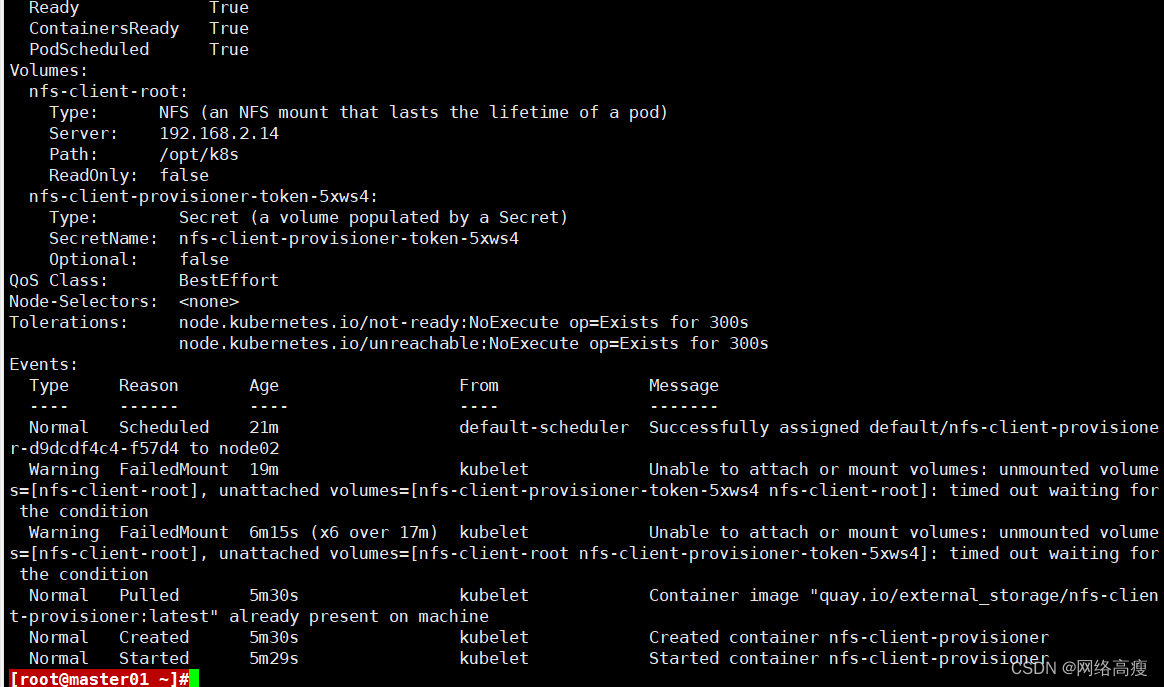

4.4.3 3、使用 Deployment 来创建 NFS Provisioner

NFS Provisione(即 nfs-client),有两个功能:一个是在 NFS 共享目录下创建挂载点(volume),另一个则是将 PV 与 NFS 的挂载点建立关联。

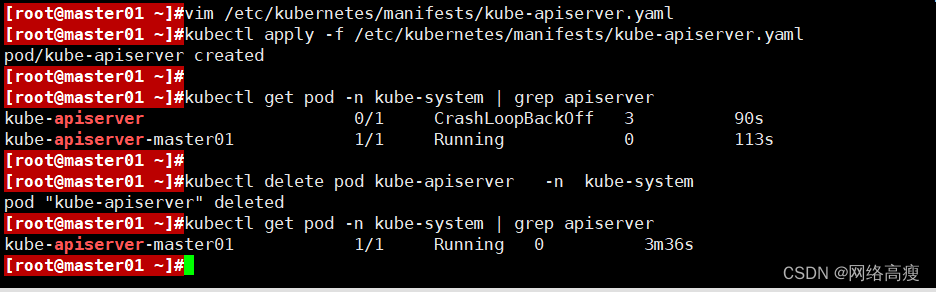

#由于 1.20 版本启用了 selfLink,所以 k8s 1.20+ 版本通过 nfs provisioner 动态生成pv会报错,解决方法如下:

vim /etc/kubernetes/manifests/kube-apiserver.yaml

spec:

containers:

- command:

- kube-apiserver

- --feature-gates=RemoveSelfLink=false #添加这一行

- --advertise-address=192.168.10.19

......kubectl apply -f /etc/kubernetes/manifests/kube-apiserver.yaml

kubectl delete pods kube-apiserver -n kube-system

kubectl get pods -n kube-system | grep apiserver#创建 NFS Provisioner

vim nfs-client-provisioner.yaml

kind: Deployment

apiVersion: apps/v1

metadata:

name: nfs-client-provisioner

spec:

replicas: 1

selector:

matchLabels:

app: nfs-client-provisioner

strategy:

type: Recreate

template:

metadata:

labels:

app: nfs-client-provisioner

spec:

serviceAccountName: nfs-client-provisioner #指定Service Account账户

containers:

- name: nfs-client-provisioner

image: quay.io/external_storage/nfs-client-provisioner:latest

imagePullPolicy: IfNotPresent

volumeMounts:

- name: nfs-client-root

mountPath: /persistentvolumes

env:

- name: PROVISIONER_NAME

value: nfs-storage #配置provisioner的Name,确保该名称与StorageClass资源中的provisioner名称保持一致

- name: NFS_SERVER

value: stor01 #配置绑定的nfs服务器

- name: NFS_PATH

value: /opt/k8s #配置绑定的nfs服务器目录

volumes: #申明nfs数据卷

- name: nfs-client-root

nfs:

server: stor01

path: /opt/k8s

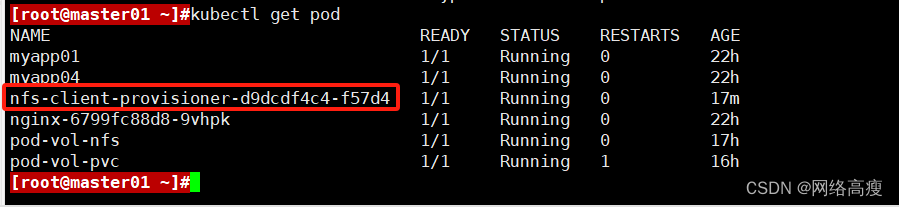

kubectl apply -f nfs-client-provisioner.yamlkubectl get pod

NAME READY STATUS RESTARTS AGE

nfs-client-provisioner-cd6ff67-sp8qd 1/1 Running 0 14s

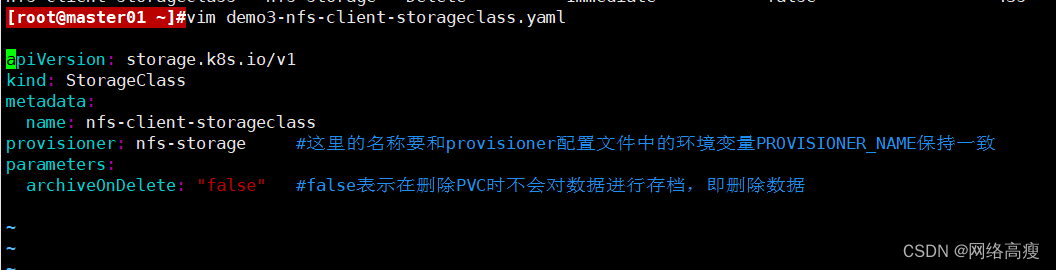

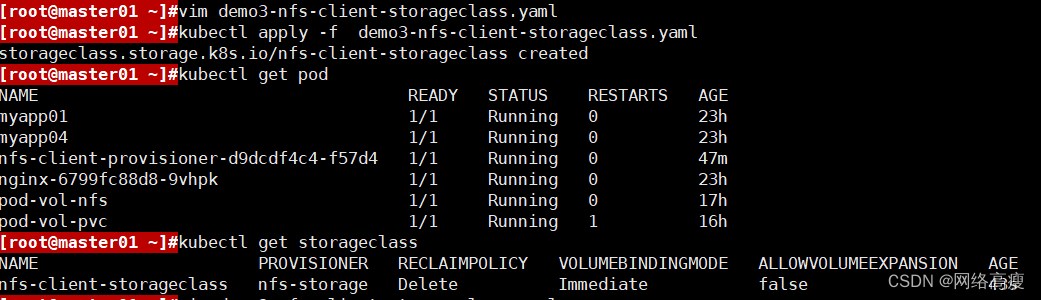

4.4.4 创建 StorageClass,负责建立 PVC 并调用 NFS provisioner 进行预定的工作,并让 PV 与 PVC 建立关联

vim nfs-client-storageclass.yaml

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: nfs-client-storageclass

provisioner: nfs-storage #这里的名称要和provisioner配置文件中的环境变量PROVISIONER_NAME保持一致

parameters:

archiveOnDelete: "false" #false表示在删除PVC时不会对数据进行存档,即删除数据

kubectl apply -f nfs-client-storageclass.yamlkubectl get storageclass

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

nfs-client-storageclass nfs-storage Delete Immediate false 43s

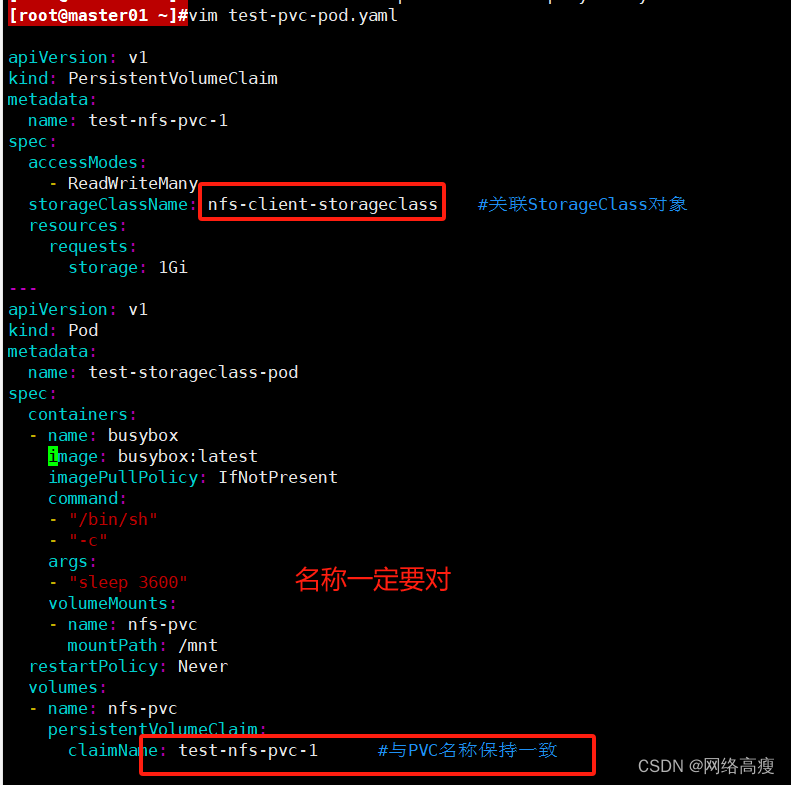

4.4.5 创建 PVC 和 Pod 测试

vim test-pvc-pod.yaml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: test-nfs-pvc-1

spec:

accessModes:

- ReadWriteMany

storageClassName: nfs-client-storageclass #关联StorageClass对象

resources:

requests:

storage: 1Gi

---

apiVersion: v1

kind: Pod

metadata:

name: test-storageclass-pod

spec:

containers:

- name: busybox

image: busybox:latest

imagePullPolicy: IfNotPresent

command:

- "/bin/sh"

- "-c"

args:

- "sleep 3600"

volumeMounts:

- name: nfs-pvc

mountPath: /mnt

restartPolicy: Never

volumes:

- name: nfs-pvc

persistentVolumeClaim:

claimName: test-nfs-pvc-1 #与PVC名称保持一致

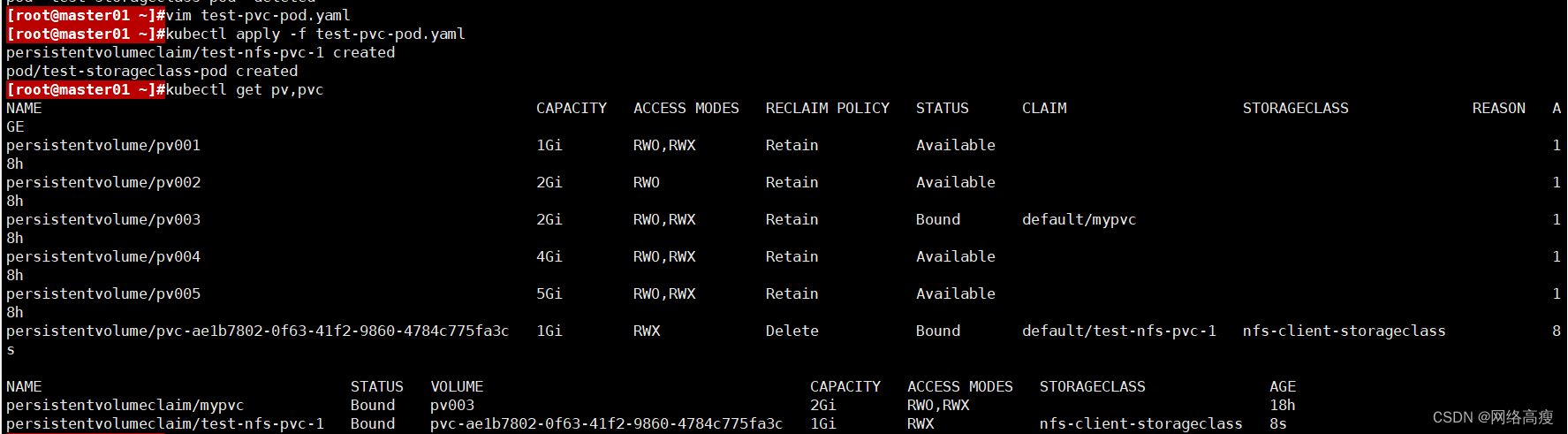

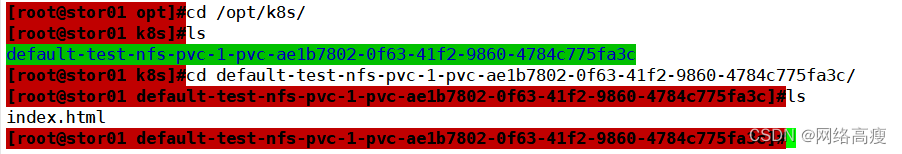

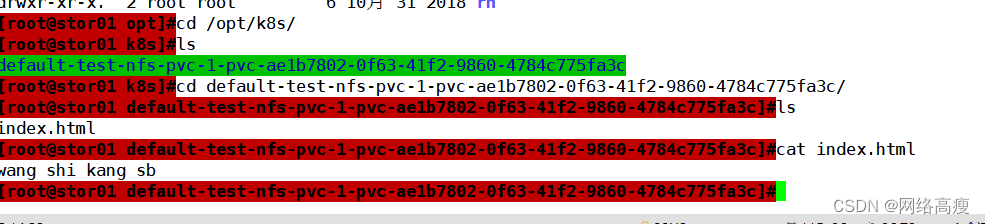

4.4.6 验证结果

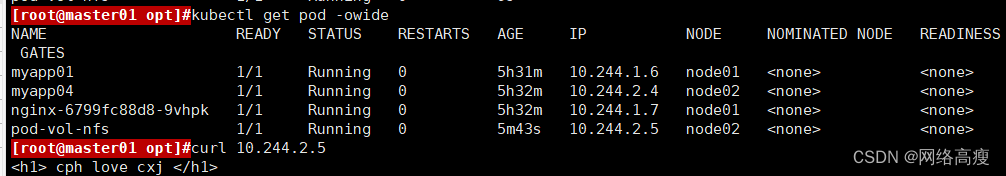

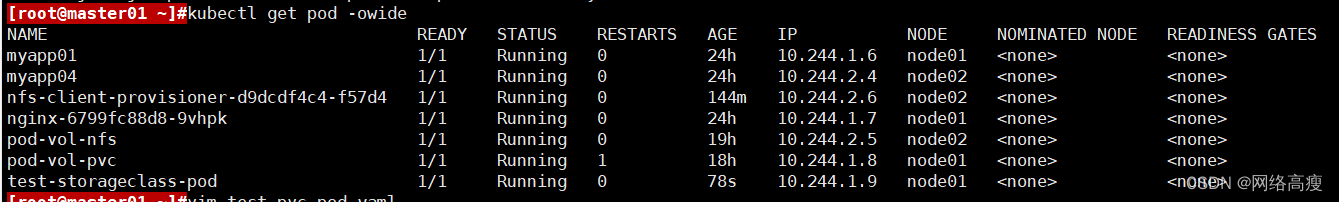

kubectl get pod -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

myapp01 1/1 Running 0 24h 10.244.1.6 node01 <none>

myapp04 1/1 Running 0 24h 10.244.2.4 node02 <none>

nfs-client-provisioner-d9dcdf4c4-f57d4 1/1 Running 0 144m 10.244.2.6 node02 <none>

nginx-6799fc88d8-9vhpk 1/1 Running 0 24h 10.244.1.7 node01 <none>

pod-vol-nfs 1/1 Running 0 19h 10.244.2.5 node02 <none>

pod-vol-pvc 1/1 Running 1 18h 10.244.1.8 node01 <none>

test-storageclass-pod 1/1 Running 0 78s 10.244.1.9 node01 <none>

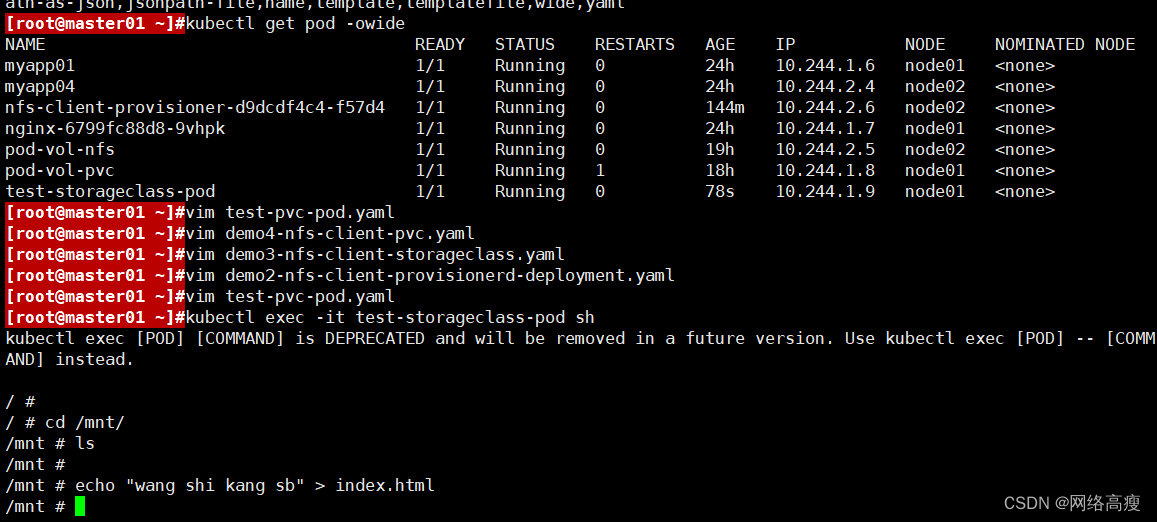

kubectl exec -it test-storageclass-pod sh

kubectl exec [POD] [COMMAND] is DEPRECATED and will be removed in a future version. Use kubectl exec [POD] -- [COMMAND] instead./ #

/ # cd /mnt/

/mnt # ls

/mnt #

/mnt # echo "wang shi kang sb" > index.html

/mnt #

五、总结

5.1 Volume

①emptyDir:可以实现Pod中的容器之间共享数据,但是存储卷不能持久化数据,且会随着Pod生命周期结束而一起删除

②hostpath:可以实现持久化存储,使用node节点的目录或文件挂载到容器,但是存储空间会收到node节点单机限制,node节点故障数据会丢失,Pod会跨节点不能共享数据

③NFS:可以实现持久化存储,使用NFS将存储设备空间挂载到容器中,Pod可以跨Node节点共享数据

5.2 PV和PVC

①PV 持久卷(Persistent Volumes)是集群中的一块存储资源,由管理员事先创建或由动态供应机制(如StorageClass)自动创建。

②PVC持久卷声明(Persistent Volume Claims)是用户对存储的请求或声明,Pod通过挂载PVC来使用PV。这种方式提供了存储的抽象和解耦,使得应用无需关心具体的存储细节。

③当Pod销毁或重建时,与之关联的PVC仍然保留,保证了数据的持久性。

5.3 StorageClass——动态存储

①存储类定义了存储的“类”,用于动态供应PV。管理员可以根据不同的需求(如性能、成本)定义多个存储类。

②用户在创建PVC时可以选择一个存储类,Kubernetes会自动匹配并创建合适的PV。

③对于存储资源,虽然不像CPU和内存那样频繁地设置请求和限制,但在使用PV/PVC时,可以通过设置存储容量的大小来间接限制使用量。

④在Pod的YAML定义中,可以通过volumeMounts来指定容器如何挂载卷,以及是否需要设置读写权限等。

⑤Pod中的存储卷可以配置访问模式(如只读、读写)来确保数据的安全性。

对于敏感数据,推荐使用Secrets或ConfigMaps,并注意权限控制。

六、存储卷

容器磁盘上的文件的生命周期是短暂的,这就使得在容器中运行重要应用时会出现一些问题。首先,当容器崩溃时,kubelet 会重启它,但是容器中的文件将丢失——容器以干净的状态(镜像最初的状态)重新启动。其次,在Pod中同时运行多个容器时,这些容器之间通常需要共享文件。Kubernetes 中的Volume抽象就很好的解决了这些问题。Pod中的容器通过Pause容器共享Volume。

6.1 emptyDir存储卷

当Pod被分配给节点时,首先创建emptyDir卷,并且只要该Pod在该节点上运行,该卷就会存在。正如卷的名字所述,它最初是空的。Pod 中的容器可以读取和写入emptyDir卷中的相同文件,尽管该卷可以挂载到每个容器中的相同或不同路径上。当出于任何原因从节点中删除 Pod 时,emptyDir中的数据将被永久删除。

mkdir /opt/volumes

cd /opt/volumes

vim pod-emptydir.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-emptydir

namespace: default

labels:

app: myapp

tier: frontend

spec:

containers:

- name: myapp

image: ikubernetes/myapp:v1

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

#定义容器挂载内容

volumeMounts:

#使用的存储卷名称,如果跟下面volume字段name值相同,则表示使用volume的这个存储卷

- name: html

#挂载至容器中哪个目录

mountPath: /usr/share/nginx/html/

- name: busybox

image: busybox:latest

imagePullPolicy: IfNotPresent

volumeMounts:

- name: html

#在容器内定义挂载存储名称和挂载路径

mountPath: /data/

command: ['/bin/sh','-c','while true;do echo $(date) >> /data/index.html;sleep 2;done']

#定义存储卷

volumes:

#定义存储卷名称

- name: html

#定义存储卷类型

emptyDir: {}

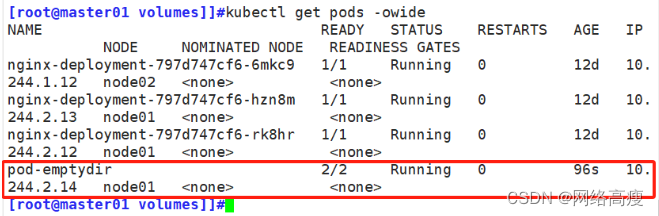

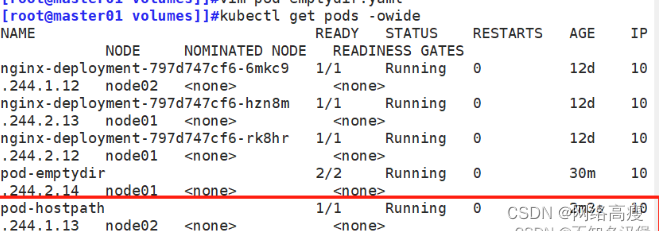

[root@master01 volumes]]#kubectl get pods -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

nginx-deployment-797d747cf6-6mkc9 1/1 Running 0 12d 10.244.1.12 node02 <none> <none>

nginx-deployment-797d747cf6-hzn8m 1/1 Running 0 12d 10.244.2.13 node01 <none> <none>

nginx-deployment-797d747cf6-rk8hr 1/1 Running 0 12d 10.244.2.12 node01 <none> <none>

pod-emptydir 2/2 Running 0 96s 10.244.2.14 node01 <none> <none>

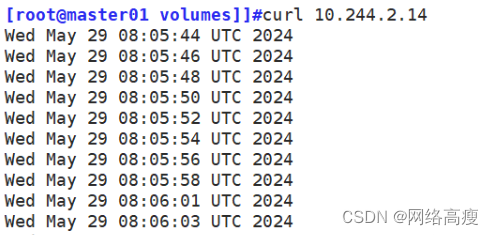

在上面定义了2个容器,其中一个容器是输入日期到index.html中,然后验证访问nginx的html是否可以获取日期。以验证两个容器之间挂载的emptyDir实现共享。

6.2 hastPath存储卷

hostPath卷将 node 节点的文件系统中的文件或目录挂载到集群中。

hostPath可以实现持久存储,但是在node节点故障时,也会导致数据的丢失。

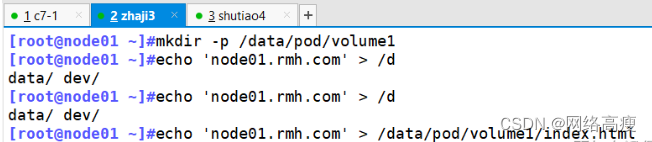

//在 node01 节点上创建挂载目录

mkdir -p /data/pod/volume1

echo 'node01.kgc.com' > /data/pod/volume1/index.html

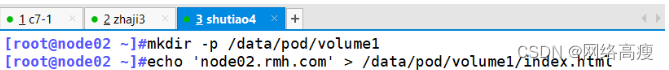

//在 node02 节点上创建挂载目录

mkdir -p /data/pod/volume1

echo 'node02.kgc.com' > /data/pod/volume1/index.html

//创建 Pod 资源

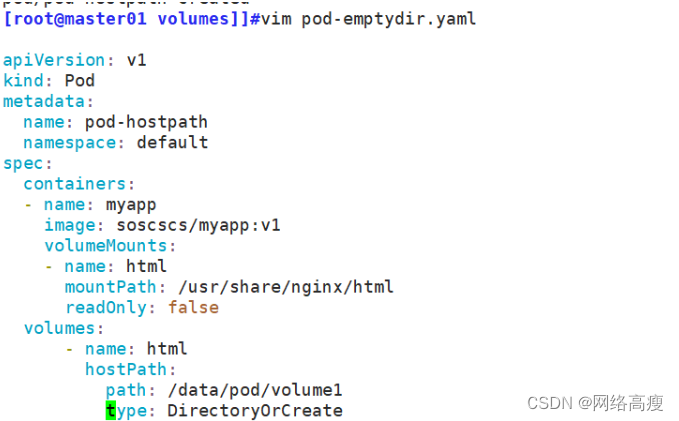

vim pod-hostpath.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-hostpath

namespace: default

spec:

containers:

- name: myapp

image: soscscs/myapp:v1

#定义容器挂载内容

volumeMounts:

#使用的存储卷名称,如果跟下面volume字段name值相同,则表示使用volume的这个存储卷

- name: html

#挂载至容器中哪个目录

mountPath: /usr/share/nginx/html

#读写挂载方式,默认为读写模式false

readOnly: false

#volumes字段定义了paues容器关联的宿主机或分布式文件系统存储卷

volumes:

#存储卷名称

- name: html

#路径,为宿主机存储路径

hostPath:

#在宿主机上目录的路径

path: /data/pod/volume1

#定义类型,这表示如果宿主机没有此目录则会自动创建

type: DirectoryOrCreate

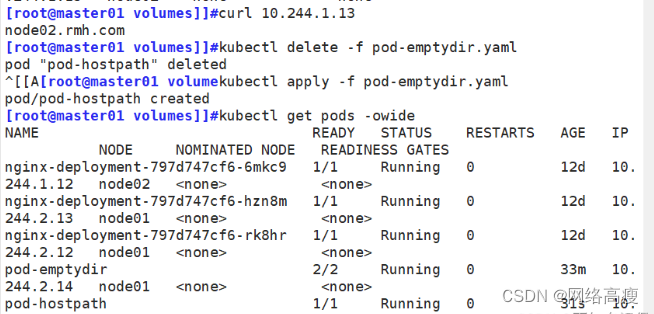

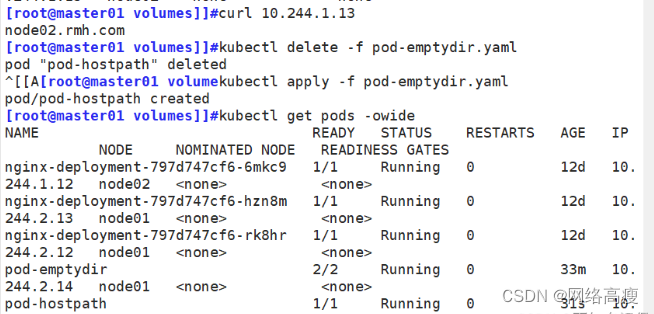

kubectl apply -f pod-hostpath.yaml

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

nginx-deployment-797d747cf6-6mkc9 1/1 Running 0 12d 10.244.1.12 node02 <none> <none>

nginx-deployment-797d747cf6-hzn8m 1/1 Running 0 12d 10.244.2.13 node01 <none> <none>

nginx-deployment-797d747cf6-rk8hr 1/1 Running 0 12d 10.244.2.12 node01 <none> <none>

pod-emptydir 2/2 Running 0 30m 10.244.2.14 node01 <none> <none>

pod-hostpath 1/1 Running 0 2m3s 10.244.1.13 node02 <none> <none>

[root@master01 volumes]]#curl 10.244.1.13

node02.rmh.com

相关文章:

kubernetes-PV与PVC、存储卷

一、PV和PVC详解 当前,存储的方式和种类有很多,并且各种存储的参数也需要非常专业的技术人员才能够了解。在Kubernetes集群中,放了方便我们的使用和管理,Kubernetes提出了PV和PVC的概念,这样Kubernetes集群的管理人员就…...

643. 子数组最大平均数 I

给你一个由 n 个元素组成的整数数组 nums 和一个整数 k 。 请你找出平均数最大且 长度为 k 的连续子数组,并输出该最大平均数。 任何误差小于 10-5 的答案都将被视为正确答案。 示例 1: 输入:nums [1,12,-5,-6,50,3], k 4 输出ÿ…...

Node性能如何进行监控以及优化?

一、 是什么 Node作为一门服务端语言,性能方面尤为重要,其衡量指标一般有如下: CPU内存I/O网络 CPU 主要分成了两部分: CPU负载:在某个时间段内,占用以及等待CPU的进程总数CPU使用率:CPU时…...

和ToArray()的区别)

ToList()和ToArray()的区别

以下是具体分析: 1. 返回类型 ToList():返回一个泛型列表 List<T>,其中 T 是列表中元素的类型。 ToArray():返回一个 Object 类型的数组。如果需要特定类型的数组,必须使用重载的 ToArray(T[] a) 方法&#x…...

11.RedHat认证-Linux文件系统(中)

11.RedHat认证-Linux文件系统(中) Linux的文件系统 格式化分区(1道题) #对于Linux分区来说,只有格式化之后才能使用,不格式化是无法使用的。 #Linux分区格式化之后就会变成文件系统,格式化的过程相当于对分区做了一个文件系统。 #Linux常见…...

windows系统电脑外插键盘驱动出现感叹号或者显示未知设备,键盘无法输入的解决办法

笔记本外插的键盘不能用,鼠标可以使用。 查找故障,结果打开设备管理器看到键盘那项里是一个的黄色惊叹号显示未知设备![图片]如下图所示 其实解决办法很简单,不要相信网上的一些博主说删除什么注册表,我开始跟着他们操…...

【开源项目】Excel数据表自动生成工具v1.0版

一、介绍 Excel数据表自动生成工具是Go语言编写的一款小型工具软件,用于将特定的Excel表格内容导出为多种编程语言的代码或可以直接读取的数据内容。 开源Github地址:https://github.com/SkyCreator/goproj 二、版本v1.0功能概览 1.编程语言支持 目前…...

Docker-一文详解容器通信的基础网络模式及衍生的自定义网络模式

启动容器时,通过-p 宿主机端口:容器端口,就可以通过访问宿主机端口访问到容器,这种原理机制是啥,有没有其它方式可以让宿主机和容器通信,以及容器与容器之间如何通信。带着这几个问题开始学习Docker的网络知识。 文章…...

Convolutional Occupancy Networks【ECCV】

论文:https://arxiv.org/pdf/2003.04618 代码:GitHub - autonomousvision/convolutional_occupancy_networks: [ECCV20] Convolutional Occupancy Networks 图 1:卷积占据网络。传统的隐式模型 (a) 由于其全连接网络结构,表现能力…...

Android Studio 问题集锦

报 Plugin [id: ‘com.android.application’, version: ‘8.1.3’, apply: false] was not found in any of the following sources: 场景:在一个Android 11的项目中添加一个Android 9的项目作为其Module,结果导致原项目无法正常运行,且原项…...

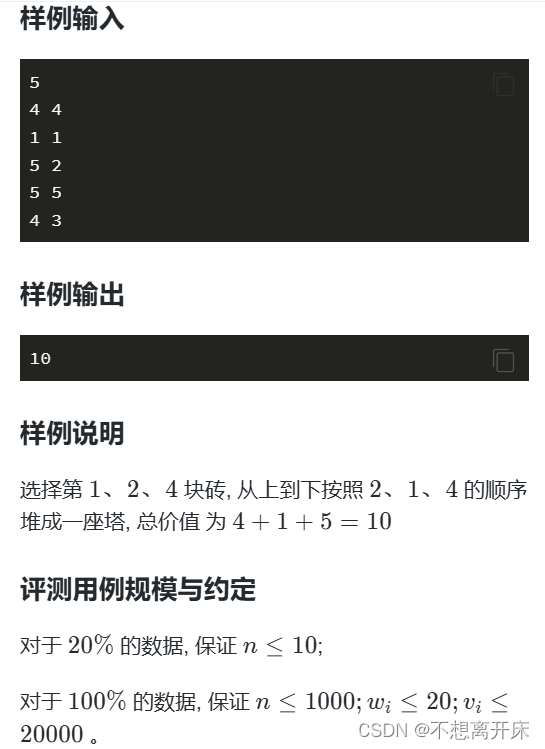

J.搬砖【蓝桥杯】/01背包+贪心

搬砖 01背包贪心 思路:要让重量更小的在更前面,价值更大的在更后面,vi−wj>vj−wi viwi>vjwj 第 i 个箱子放在第 j 个箱子下面就显然更优。所以进行排序再用01背包即可。 #include<iostream> #include<algorithm> #defi…...

拥塞控制的微观行为与力学解释

本文以 tcptrace 图为基,描述传输的微观行为,并给出一个初中几何描述的压水井模型。 统计复用网络的拥塞控制,宏观看 inflight,微观看 pacing rate,宏观大方向不对,微观再正确也不行。 而网络的统计动力学…...

)

每日一读: 硬件网卡tx支持哪些功能特性offload(ixgbe驱动为例)

ixgbe驱动 rte_eth_dev_info_get -> ixgbe_dev_info_get -> ixgbe_get_tx_port_offloads uint64_t ixgbe_get_tx_port_offloads(struct rte_eth_dev *dev) {uint64_t tx_offload_capa;struct ixgbe_hw *hw IXGBE_DEV_PRIVATE_TO_HW(dev->data->dev_private);tx_…...

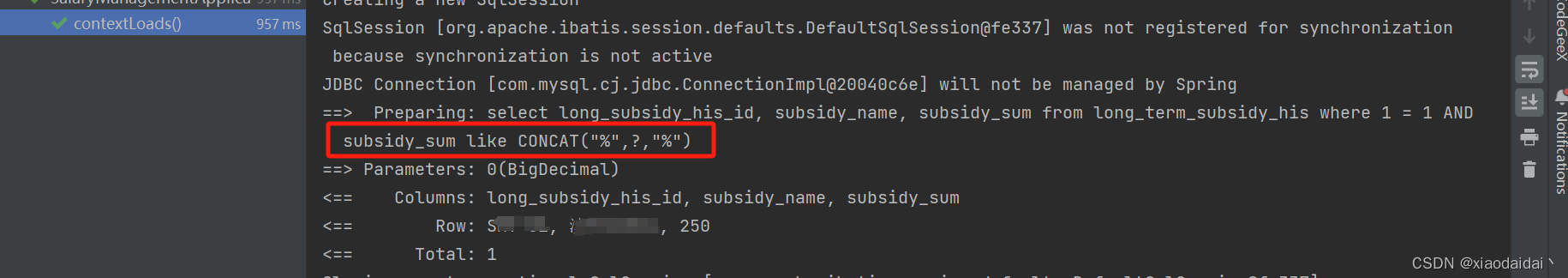

MyBatis的坑(动态SQL会把0和空串比较相等为true)

文章目录 前言一、场景如下二、原因分析1. 源码分析2. 写代码验证 三、解决办法代码及执行结果如下 总结 前言 在开发过程中遇到MyBatis的动态SQL的if条件不生效的情况,但经过debuger发现并不是参数问题,已经拿到了参数并传给了MyBatis,且从表…...

Springboot事务控制中A方法调用B方法@Transactional生效与不生效情况实战总结

介绍 本篇对Springboot事务控制中A方法调用B方法Transactional生效与不生效情况进行实战总结,让容易忘记或者困扰初学者甚至老鸟的开发者,只需要看这一篇文章即可立马找到解决方案,这就是干货的价值。喜欢的朋友别忘记来个一键三连哈&#x…...

python -【三】循环语句

一、while 循环 while 语法 while 条件: 条件满足时,做事情 a 0 while a < 100:print(i like python ...)a 1求 1-100 的总和 i 1 sum 0 while i < 100:sum ii 1 print(f1-100 的和是 {sum})""" 1-100 的和是 5050 ""&…...

类的内存对齐位段位图布隆过滤器哈希切割一致性哈希

文章目录 一、类的内存对齐1.1规则1.2原因 二、位段2.1介绍2.2内存分配问题2.3跨平台问题2.4使用的注意事项 三、位图的应用3.1 给40亿个不重复的无符号整数,找给定的一个数。(int的范围可以到达42亿多)3.2 给定100亿个整数,设计算…...

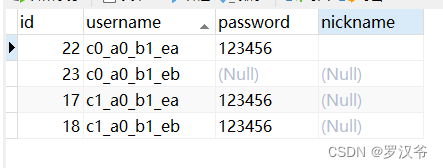

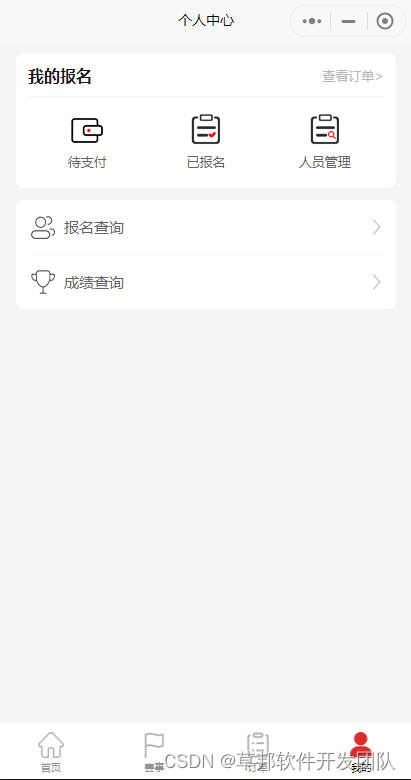

于ThinkPHP开发的赛事报名小程序

基于ThinkPHP开发的赛事报名微信小程序 功能包括 1、参赛公告 2、会员中心(会员注册、登录、成绩查询、资料管理、参赛记录管理) 3、个人报名和企业报名 (身份证验证防止重复报名) 4、培训报名 5、查询是否在库人员,根…...

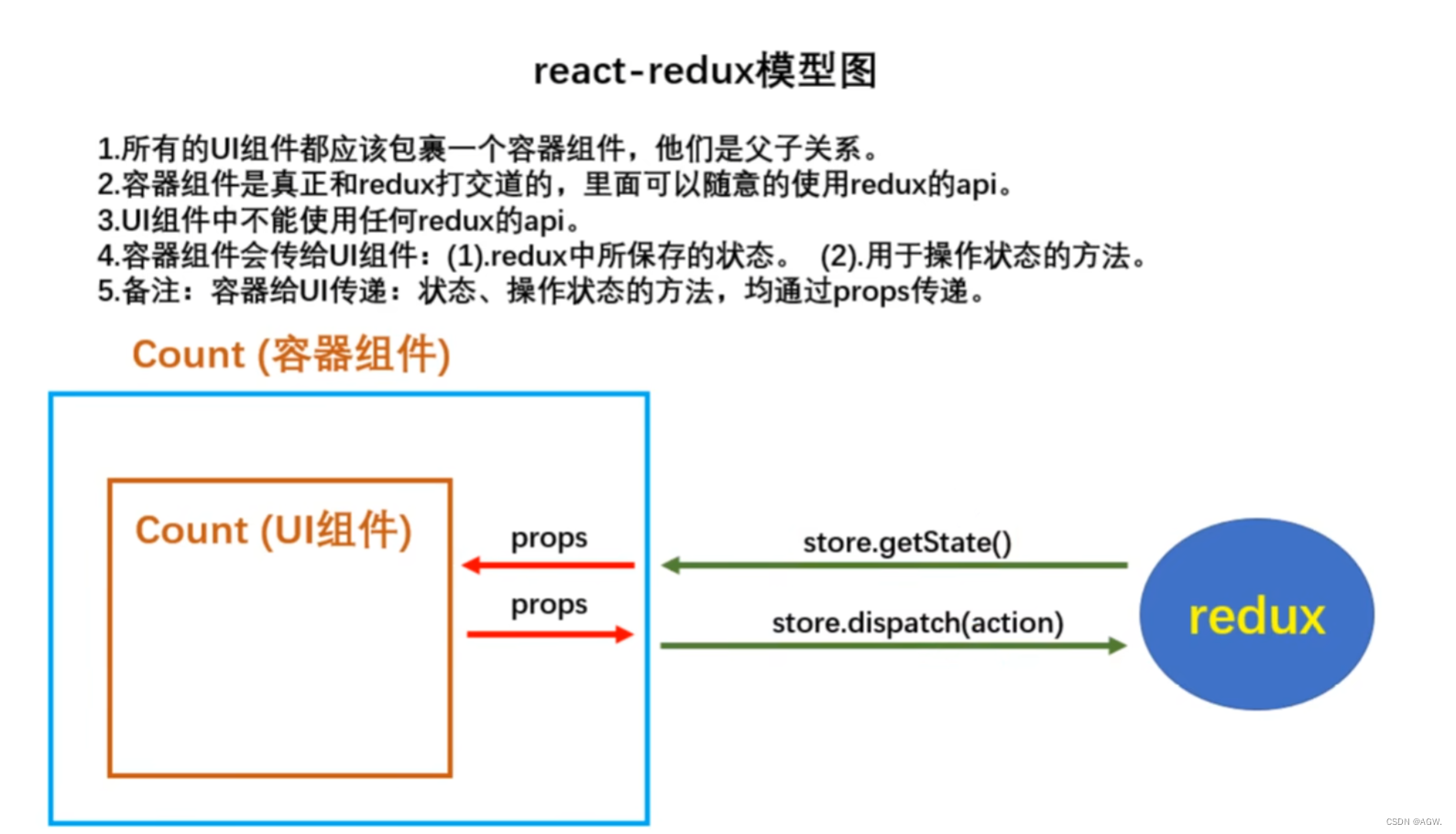

前端学习--React部分

文章目录 前端学习--React部分前言1.React简介1.1React的特点1.2引入文件1.3JSX🍉JSX简介与使用🍉JSX语法规则 1.4模块与组件🍉模块🍉组件 1.5安装开发者工具 2.React面向组件编程2.1创建组件🍉函数式组件🍉…...

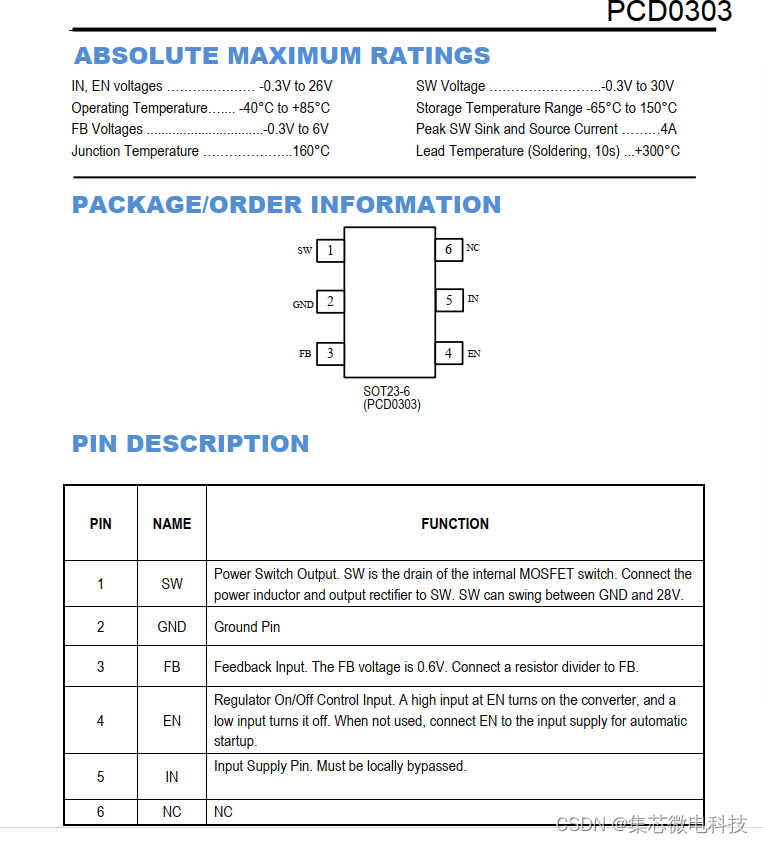

24V_2A_1.2MHZ|PCD0303升压恒频LCD背光源专用电路超小体积封装

概述 PCD0303是一个恒定频率,6针SOT23电流模式升压转换器用于小型低功耗应用。PCD0303 以1.2MHz切换,并且允许使用微小的,低成本电容器和电感器2mm或更小,内部软启动会产生较小的涌入电流延长电池寿命。PCD0303具有自动切换至轻负载下的脉冲…...

第19节 Node.js Express 框架

Express 是一个为Node.js设计的web开发框架,它基于nodejs平台。 Express 简介 Express是一个简洁而灵活的node.js Web应用框架, 提供了一系列强大特性帮助你创建各种Web应用,和丰富的HTTP工具。 使用Express可以快速地搭建一个完整功能的网站。 Expre…...

多模态2025:技术路线“神仙打架”,视频生成冲上云霄

文|魏琳华 编|王一粟 一场大会,聚集了中国多模态大模型的“半壁江山”。 智源大会2025为期两天的论坛中,汇集了学界、创业公司和大厂等三方的热门选手,关于多模态的集中讨论达到了前所未有的热度。其中,…...

k8s从入门到放弃之Ingress七层负载

k8s从入门到放弃之Ingress七层负载 在Kubernetes(简称K8s)中,Ingress是一个API对象,它允许你定义如何从集群外部访问集群内部的服务。Ingress可以提供负载均衡、SSL终结和基于名称的虚拟主机等功能。通过Ingress,你可…...

力扣-35.搜索插入位置

题目描述 给定一个排序数组和一个目标值,在数组中找到目标值,并返回其索引。如果目标值不存在于数组中,返回它将会被按顺序插入的位置。 请必须使用时间复杂度为 O(log n) 的算法。 class Solution {public int searchInsert(int[] nums, …...

Mobile ALOHA全身模仿学习

一、题目 Mobile ALOHA:通过低成本全身远程操作学习双手移动操作 传统模仿学习(Imitation Learning)缺点:聚焦与桌面操作,缺乏通用任务所需的移动性和灵活性 本论文优点:(1)在ALOHA…...

与常用工具深度洞察App瓶颈)

iOS性能调优实战:借助克魔(KeyMob)与常用工具深度洞察App瓶颈

在日常iOS开发过程中,性能问题往往是最令人头疼的一类Bug。尤其是在App上线前的压测阶段或是处理用户反馈的高发期,开发者往往需要面对卡顿、崩溃、能耗异常、日志混乱等一系列问题。这些问题表面上看似偶发,但背后往往隐藏着系统资源调度不当…...

return this;返回的是谁

一个审批系统的示例来演示责任链模式的实现。假设公司需要处理不同金额的采购申请,不同级别的经理有不同的审批权限: // 抽象处理者:审批者 abstract class Approver {protected Approver successor; // 下一个处理者// 设置下一个处理者pub…...

免费PDF转图片工具

免费PDF转图片工具 一款简单易用的PDF转图片工具,可以将PDF文件快速转换为高质量PNG图片。无需安装复杂的软件,也不需要在线上传文件,保护您的隐私。 工具截图 主要特点 🚀 快速转换:本地转换,无需等待上…...

力扣热题100 k个一组反转链表题解

题目: 代码: func reverseKGroup(head *ListNode, k int) *ListNode {cur : headfor i : 0; i < k; i {if cur nil {return head}cur cur.Next}newHead : reverse(head, cur)head.Next reverseKGroup(cur, k)return newHead }func reverse(start, end *ListNode) *ListN…...

Web中间件--tomcat学习

Web中间件–tomcat Java虚拟机详解 什么是JAVA虚拟机 Java虚拟机是一个抽象的计算机,它可以执行Java字节码。Java虚拟机是Java平台的一部分,Java平台由Java语言、Java API和Java虚拟机组成。Java虚拟机的主要作用是将Java字节码转换为机器代码&#x…...