Spark SQL【Java API】

前言

之前对 Spark SQL 的影响一直停留在 DSL 语法上面,感觉可以用 SQL 表达的,没有必要用 Java/Scala 去写,但是面试一段时间后,发现不少公司还是在用 SparkSQL 的,京东也在使用 Spark On Hive 而不是我以为的 Hive On Spark,经过一番了解之后发现,确实 Spark SQL 要比 HQL 灵活太多了。所以必须学学 SparkSQL(我喜欢用 Java 版本,和 Scala 执行速度一样,只不过代码复杂了点,对我来说也没多复杂),之后用 SparkSQL 对之前的离线项目实现一遍。

1、Spark SQL 介绍

Hive 是目前事实上离线数仓的标准,它的缺点是底层使用的 MR 引擎,所以执行稍微复杂点的 SQL 就非常慢,不过它支持更换执行引擎,换成 Spark/Tez 就会好很多,而我们实际开发中也几乎不会有人去用 MR 引擎的 Hive 去跑,一般都是 Hive on Spark 或者 Spark on Hive 的方式。

1.1、SparkSQL 的特点

正如官网描述:Spark SQL 是 Apache Spark 的一个用于处理结构化数据的模块。(而不是非结构化)

1.1.1、集成

Spark SQL 将 SQL 和 Spark 程序无缝衔接,它允许我们在 Spark 程序中使用 SQL 或者 DataFrame API 来查询结构化数据。

1.1.2、统一的数据访问

这也是 Spark SQL 优于 Hive 的一大原因,它支持很多的数据源(比如 hive、avro、parquet、orc、json、csv、jdbc 等),我们可以通过 API 去访问这些数据源并且可以将通过 API 或者 SQL 这些不同的数据源连接在一起。

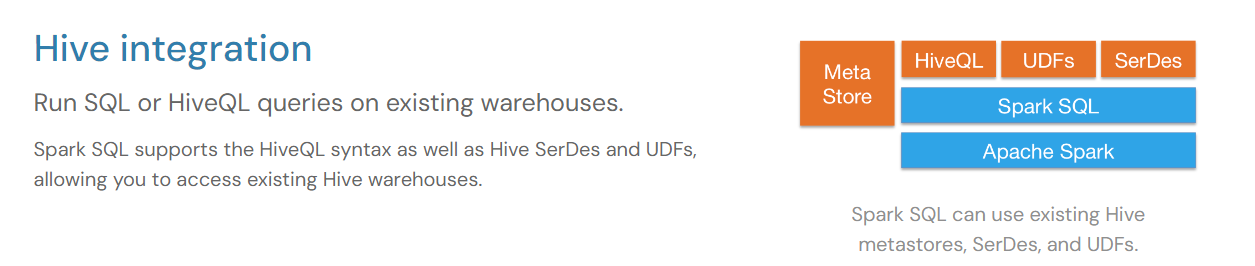

1.1.3、集成 Hive

Spark SQL 可以使用 Hive 的元数据库、SerDes 和 UDFs,我们可以在现有的数据仓库上运行 SQL 或 HiveQL 查询。

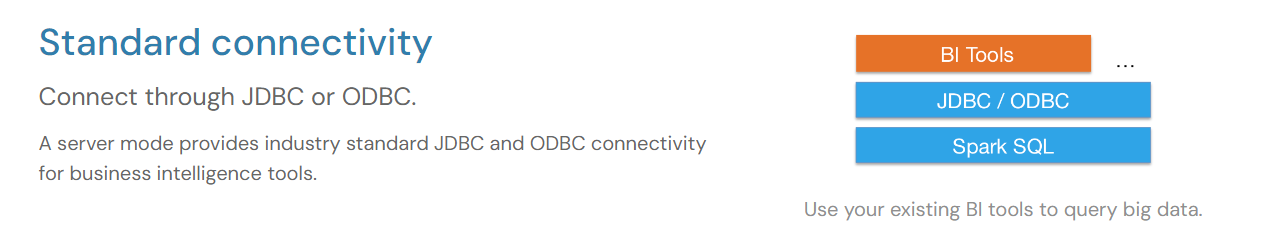

1.1.4、标准连接

这里说的是 Spark SQL 的服务器模式为商业智能工具(比如 BI 工具)提供了工业标准的 JDBC/ODBC。

1.2、不同 API 的执行速度

可以看到,Python 在操作 RDD 时的速度要比 Java/Scala 慢几乎两倍多。

1.3、数据抽象

Spark SQL提供了两个新的抽象,分别是 DataFrame 和 Dataset;

Dataset是数据的分布式集合。是Spark 1.6中添加的一个新接口,它提供了RDDs的优点(强类型、使用强大lambda函数的能力)以及Spark SQL优化的执行引擎的优点。可以从 JVM 对象构造数据集(使用 createDataFrame 方法,参数是Java对象集合),然后使用函数转换(map、flatMap、filter等)操作数据集。数据集API可以在Scala和Java中使用。Python 和 R 并不支持Dataset API。

DataFrame 是组织成命名列的 Dataset。它在概念上相当于关系数据库中的表或 R/Python中的DataFrame,但在底层有更丰富的优化(这也是为什么 R/Python 操作 DataFrame 的效率能和 SQL、Java/Scala 差不多的原因)。DataFrame 可以从各种各样的数据源构建,例如: 结构化或半结构化数据文件(json、csv)、Hive中的表、外部数据库或现有的 rdd。DataFrame API 可以在Scala、Java、Python和 R 中使用。在Scala API中,DataFrame 只是 Dataset[Row] 的类型别名。而在Java API中,使用 Dataset<Row> 来表示DataFrame。

在Spark支持的语言中,只有Scala和Java是强类型的。因此,Python和R只支持无类型的DataFrame API。

1.3.1、DataFrame

DataFrame 可以比作一个表格或电子表格,它有行和列,每一列都有一个名称和数据类型。它提供了一种结构化的方式来存储和处理数据。

使用场景:DataFrame 非常适合处理结构化数据,也就是具有明确定义的模式的数据。它支持各种数据源,如 CSV 文件、数据库、JSON 等。DataFrame 提供了丰富的操作,如筛选、聚合、连接等,使得数据处理变得简单高效。当我们需要执行 SQL 查询或进行统计分析时,DataFrame 是首选的数据结构。

1.3.2、DataSet

DataSet 可以比作一个带有标签的盒子。每个数据集都包含一组对象,这些对象具有相同的类型,并且每个对象都有一组属性或字段。与 DataFrame 不同,DataSet 是类型安全的,这意味着 JVM 可以在编译时捕获类型错误。

使用场景:DataSet 适用于需要类型安全和对象操作的情况。它提供了更强大的类型检查和编译时错误检查,以及更丰富的函数式编程接口。当我们需要处理复杂的数据结构、需要执行对象转换或利用 Lambda 表达式等高级功能时,DataSet 是更好的选择。但是需要注意的是,DataSet 在某些情况下可能比 DataFrame 更复杂,并且可能需要更多的内存和处理时间。

1.3.3、DataFrame 和 DataSet 的对比

类型安全性

- DataFrame 不是类型安全的。它的每一行是一个Row对象,字段的类型是在运行时解析的。因此,如果在处理数据时类型不匹配,可能会遇到运行时错误。

- 相比之下,DataSet 是强类型的分布式集合。当你定义一个 DataSet 时,你需要为其提供一个case class(使用 Scala API 时),这个 case class定义了数据的结构。由于DataSet的每个元素都由这个 case class 的实例表示,因此每个字段的类型在编译时就是已知的。这提供了更好的类型安全性,允许在编译时捕获许多类型错误。

数据源和兼容性

- DataFrame可以很容易地从各种数据源中创建,如CSV文件、JSON、数据库等,并且它提供了与这些数据源的直接兼容性。

- DataSet也可以从这些数据源创建,但通常需要通过DataFrame作为中间步骤,或者需要更多的代码来定义数据的结构。

优化和性能:

DataFrame 和 DataSet在处理大量数据时都非常快,但有时候,DataFrame可能会因为它的结构更简单而得到更多的优化,跑得更快一些。但是同样对于 DataSet ,因为提前知道了每一列的数据类型,所以在某些情况下,它也可以进行优化,让处理速度更快。

1.4、Spark on Hive / Hive on Spark

1.4.1、Spark on Hive

Spark on Hive是Hive只作为存储角色,Spark负责sql解析优化,执行。这里可以理解为Spark通过Spark SQL使用Hive语句操作Hive表,底层运行的还是Spark RDD。具体步骤如下:

- 通过SparkSQL,加载Hive的配置文件,获取到Hive的元数据信息;

- 获取到Hive的元数据信息之后可以拿到Hive表的数据;

- 通过SparkSQL来操作Hive表中的数据。

1.4.2、Hive on Spark

与Spark on Hive不同,Hive on Spark则是Hive既作为存储又负责sql的解析优化,Spark负责执行。这里Hive的执行引擎变成了Spark,不再是MR。实现这个模式比Spark on Hive要麻烦得多,需要重新编译Spark和导入jar包。

1.4.3、性能对比

相比之下,Spark on Hive 应该是要更好一些,毕竟 Spark on Hive 更加 "原生",底层就是 RDD 计算,只有元数据用了Hive,对SQL的解析,转换,优化等都是Spark完成(而且 Spark SQL 相比 Hive 在执行计划上做了更多的优化)。而 Hive on Spark 只有计算引擎是Spark,前期解析,转换,优化等步骤都是 Hive 完成。

2、Spark SQL 编程

导入依赖:

<dependency><groupId>org.apache.spark</groupId><artifactId>spark-sql_2.12</artifactId><version>3.3.1</version></dependency><dependency><groupId>org.projectlombok</groupId><artifactId>lombok</artifactId><version>1.18.22</version></dependency>

2.1、SparkSession

在 RDD 编程中,我们使用的是SparkContext 接口,但在 Spark SQL中,我们将使用SparkSession接口。Spark2.0 出现的 SparkSession 接口替代了 Spark 1.6 版本中的 SQLContext 和 HiveContext接口,来实现对数据的加载、转换、处理等功能。

SparkSession内部封装了SparkContext,所以计算实际上是由SparkContext完成的

2.2、Spark SQL 语法

先创建一个 json 文件作为数据源:

{"name": "李大喜", "age": 20, "dept": "农民"}

{"name": "燕双鹰", "age": 20, "dept": "保安"}

{"name": "狄仁杰", "age": 40, "dept": "保安"}

{"name": "李元芳", "age": 40, "dept": "保安"}

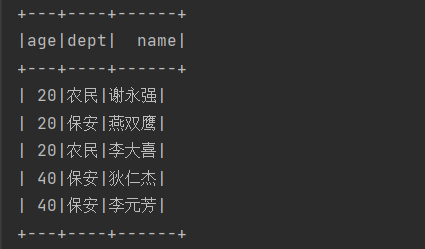

{"name": "谢永强", "age": 20, "dept": "农民"}2.2.1、SQL 语法

package com.lyh;import com.lyh.domain.User;

import org.apache.spark.SparkConf;

import org.apache.spark.sql.*;import java.util.Arrays;public class Main {public static void main(String[] args) {// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("test1");// 2. 创建 SparkSessionSparkSession spark = SparkSession.builder().config(conf).getOrCreate();spark.sparkContext().setLogLevel("WARN"); // 只在 Spark Application 运行时有效// 通过 json 文件创建 DataFrame// 在 Java 的 API 中并没有 DataFrame 这种数据类型, DataSer<Row> 指的就是 DataFrame Dataset<Row> lineDF = spark.read().json("src/main/resources/json/user.json");lineDF.createOrReplaceTempView("users"); // 支持所有的hive sql语法,并且会使用spark的优化器spark.sql("select * from users order by age").show();// 关闭 SparkSessionspark.close();}

}

运行结果:

2.2.2、DSL 语法

lineDF.select("*").orderBy("age").show();效果和上面是一样的,但是一般能用 SQL 就不用 DSL 。

2.3、自定义函数

2.3.1、UDF

一进一出(传一个参数进去,返回一个结果)

import org.apache.spark.SparkConf;

import org.apache.spark.sql.Dataset;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.SparkSession;

import org.apache.spark.sql.api.java.UDF1;

import org.apache.spark.sql.expressions.UserDefinedFunction;

import org.apache.spark.sql.types.DataTypes;import java.util.Locale;import static org.apache.spark.sql.functions.udf;public class MyUdf {public static void main(String[] args) {SparkConf conf = new SparkConf().setAppName("udf").setMaster("local[*]");SparkSession spark = SparkSession.builder().config(conf).getOrCreate();Dataset<Row> df = spark.read().json("src/main/resources/json/user.json");df.createOrReplaceTempView("users");UserDefinedFunction up = udf((UDF1<String, String>) str -> str.toUpperCase(Locale.ROOT), DataTypes.StringType);spark.udf().register("up",up);spark.sql("SELECT up(name),age FROM users").show();spark.close();}}上面,我们定义了一个函数,实现把英文全部大写,测试:

2.3.2、UDAF

输入多行,返回一行,一般和 groupBy 配合使用,其实就是自定义聚合函数。

- Spark3.x推荐使用extends Aggregator自定义UDAF,属于强类型的Dataset方式。

- Spark2.x使用extends UserDefinedAggregateFunction,属于弱类型的DataFrame

package com.lyh.udf;import lombok.Data;

import org.apache.spark.SparkConf;

import org.apache.spark.sql.*;

import org.apache.spark.sql.api.java.UDF1;

import org.apache.spark.sql.expressions.Aggregator;

import org.apache.spark.sql.expressions.UserDefinedFunction;

import org.apache.spark.sql.types.DataTypes;import java.io.Serializable;

import java.util.Locale;import static org.apache.spark.sql.functions.udaf;

import static org.apache.spark.sql.functions.udf;public class MyUdf {public static void main(String[] args) {SparkConf conf = new SparkConf().setAppName("udaf").setMaster("local[*]");SparkSession spark = SparkSession.builder().config(conf).getOrCreate();Dataset<Row> df = spark.read().json("src/main/resources/json/user.json");df.createOrReplaceTempView("users");spark.udf().register("myavg",udaf(new MyAvg(),Encoders.LONG()));spark.sql("SELECT dept,myavg(age) FROM users group by dept").show();spark.close();}@Datapublic static class Buffer implements Serializable{private Long sum;private Long count;public Buffer(){}public Buffer(Long sum,Long count){this.sum = sum;this.count = count;}}public static class MyAvg extends Aggregator<Long,Buffer,Double> {@Overridepublic Buffer zero() {return new Buffer(0L,0L);}@Overridepublic Buffer reduce(Buffer buffer, Long num) {buffer.setSum(buffer.getSum() + num);buffer.setCount(buffer.getCount()+1);return buffer;}@Overridepublic Buffer merge(Buffer b1, Buffer b2) {b1.setSum(b1.getSum()+b2.getSum());b1.setCount(b1.getCount()+b2.getCount());return b1;}@Overridepublic Double finish(Buffer reduction) {return reduction.getSum().doubleValue()/reduction.getCount();}// 序列化缓冲区的数据@Overridepublic Encoder<Buffer> bufferEncoder() {// 用kryo进行优化return Encoders.kryo(Buffer.class);}@Overridepublic Encoder<Double> outputEncoder() {return Encoders.DOUBLE();}}}Aggregator 有三个泛型参数,分别是输入类型,缓存类型和输出类型,需要重写的方法很好理解,其中, bufferEncoder 和 outputEncoder 这两个方法是用来序列化缓冲区和输出端的数据,这对于分布式处理环境尤为重要,因为数据需要在网络中传输或存储到磁盘上。

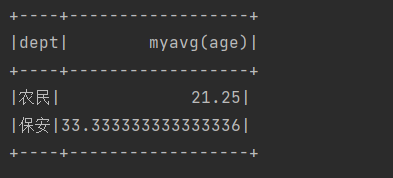

运行结果:

3、Spark SQL 数据的加载和保存

Spark SQL 会把读取进来的文件封装为一个 DataFrame 对象(DataSet<Row>),所以 Spark SQL 加载数据源的过程就是创建 DataFrame 的过程。

3.1、创建 DataFrame

这里省去公共的环境代码:

public class Main {public static void main(String[] args) {// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("Spark Application名称");// 2. 创建 SparkSessionSparkSession spark = SparkSession.builder().config(conf).getOrCreate();// 只在提交 Spark Application 时有效spark.sparkContext().setLogLevel("WARN");// 3. 业务代码// 4. 关闭 sparkSessionspark.close();}

}3.1.1、通过 JVM 对象创建

注意:Spark SQL 中用到的 Java Bean 必须提供 getter 和 setter 、无参构造,而且所有属性必须为 public 修饰的。

User user1 = new User("汤姆", 11L);User user2 = new User("李大喜", 18L);User user3 = new User("燕双鹰", 18L);User user4 = new User("狄仁杰", 11L);Dataset<Row> df = spark.createDataFrame(Arrays.asList(user1, user2, user3, user4), User.class);df.show();这里的 df.show 就相当于注册了一张临时表然后 select * from 这张表。

运行结果:

3.1.2、csv 文件

注意:Spark 读取 csv 文件时,读进来的字段都是 String 类型,所以如果有需求需要把 csv 中的数据封装转为 Bean 的时候,对于任何类型的数据都必须使用 getString 来读取,读取进来再做转换。比如下面,我们把读取进来的 csv 文件使用 map 函数转为 dataset 再做查询

注意:通过 csv 读取进来的 DataFrame 并没有 schema 信息,也不能通过 as 方法转为 DataSet 方法,因为 DataFrame 的列名和类型都是 _c0 string , _c1 string ... 和 User 的属性名根本匹配不上,所以只能通过 map 函数来把 DataFrame 转为 DataSet ,这样它才有了类型信息。

// 加载 csv 文件Dataset<Row> df = spark.read().option("sep", ",") // 使用 sep 或者 delimiter 效果一样.option("header", false).csv("src/main/resources/csv/user.csv");// 转为 dataset 展示df.map((MapFunction<Row, User>) row -> new User(row.getString(0),Long.parseLong(row.getString(1)),row.getString(2)),Encoders.bean(User.class) // 这个 Bean 必须提供 getter 和 setter 方法,否则报错).show();运行结果:

将结果写入到 csv 文件中:

写入到 csv 文件不能通过 DataFrame 直接写,因为现在它连 schema 都没有,sql 中的字段它都识别不了。所以必须先转为 DataSet 再去查询出结果写入到文件:

// 加载 csv 文件Dataset<Row> df = spark.read().option("seq", ",").option("header", false).csv("src/main/resources/csv/user.csv");df.printSchema();// 不能这么转 因为 DataFrame 没有模式信息 字段名默认是 _c0,_c1 ... 和 User 的属性名完全匹配不上 会报错!// Dataset<User> ds = df.as(Encoders.bean(User.class));Dataset<User> ds = df.map((MapFunction<Row, User>) row -> new User(row.getString(0), Long.parseLong(row.getString(1)), row.getString(2)),Encoders.bean(User.class));ds.printSchema();ds.createOrReplaceTempView("users");spark.sql("SELECT CONCAT(name,'大侠') name, age FROM users WHERE age > 18").write().option("header",true).option("seq","\t").csv("output");运行结果:

3.1.3、json 文件

注意:Spark 在读取 json 文件时,默认把 int 类型的值当做 bigint ,如果我们使用 row.getInt 去解析时就会直接报错(因为是小转大),所以我们的 Bean 的整型应该升级为长整型 Long 才不会报错。此外,Spark 读取 json 文件后封装成的 Row 对象是以 json 的字段作为索引的(是根据索引的 ASCII 码进行排序之后再从 0 开始排的),而不是按照 json 文件中的字段顺序,这也是一个坑点。

Dataset<Row> df = spark.read().json("src/main/resources/json/user.json");Dataset<User> ds = df.map((MapFunction<Row, User>) row -> new User(row.getString(2),row.getLong(0),row.getString(1)),Encoders.bean(User.class));ds.show();所以一般不会用上面的这种方式去读取 json,因为我们无法自己预估排序后的字段索引值。我们一般直接把 json 转为 DataFrame 之后立即转为 DataSet 进行操作,或者直接把 DataFrame 对象注册为临时表,然后使用 SQL 进行分析。

将结果写入到 json 文件:

下面我们把 json 读取进来解析为 DataFrame 之后直接注册为临时表——用户表,然后用 sql 进行分析(Spark SQL 支持 HQL 中的所有语法,所以这里试用一下窗口函数):

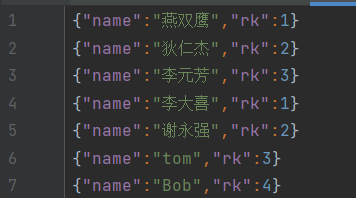

Dataset<Row> df = spark.read().json("src/main/resources/json/user.json");df.createOrReplaceTempView("users");spark.sql("SELECT name,ROW_NUMBER() OVER(PARTITION BY dept ORDER BY age) rk FROM users").write().json("users_rk");这里的 "user_rk" 是输出文件的目录名,最终会生成四个文件:两个 CRC 校验文件,一个 SUCCESS 和 生成的 json 文件。

运行结果:

我们这里直接用 DataFrame 来将分析出结果写入到 json 文件,但是上面的 csv 就不可以,因为 json 文件自带字段名,而字段类型 Spark 是可以识别的。

3.2、与 MySQL 交互

导入 MySQL 依赖:

<dependency><groupId>mysql</groupId><artifactId>mysql-connector-java</artifactId><version>8.0.31</version></dependency>public static void main(String[] args) {// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("read from mysql");// 2. 创建 SparkSessionSparkSession spark = SparkSession.builder().config(conf).getOrCreate();Dataset<Row> df = spark.read().format("jdbc").option("url", "jdbc:mysql://127.0.0.1:3306/spark").option("user", "root").option("password", "Yan1029.").option("dbtable", "student").load();df.select("*").show();spark.close();}3.3、与 Hive 交互

导入依赖:

<dependency><groupId>org.apache.spark</groupId><artifactId>spark-hive_2.12</artifactId><version>3.3.1</version></dependency>拷贝 hive-site.xml到resources目录(如果需要操作Hadoop,需要拷贝hdfs-site.xml、core-site.xml、yarn-site.xml),然后启动 Hadoop 和 Hive。

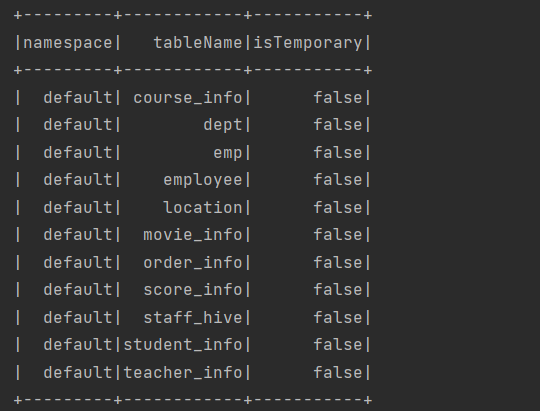

public static void main(String[] args) {System.setProperty("HADOOP_USER_NAME","lyh");// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("spark sql operate hive");// 2. 获取 SparkSessionSparkSession spark = SparkSession.builder().enableHiveSupport() // 添加 hive 支持.config(conf).getOrCreate();spark.sql("show tables").show();// 4. 关闭 SparkSessionspark.close();}运行结果:

4、Spark SQL 练习

4.1、统计每个商品的销量最高的日期

从订单明细表(order_detail)中统计出每种商品销售件数最多的日期及当日销量,如果有同一商品多日销量并列的情况,取其中的最小日期:

public static void main(String[] args) {System.setProperty("HADOOP_USER_NAME","lyh");// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("spark sql operate hive");// 2. 获取 SparkSessionSparkSession spark = SparkSession.builder().enableHiveSupport() // 添加 hive 支持.config(conf).getOrCreate();spark.sql("use db_hive2");// order_detail_id order_id sku_id create_date price sku_num// 每件商品的最高销量spark.sql("SELECT sku_id, create_date, sum_num FROM (SELECT sku_id, create_date, sum_num, ROW_NUMBER() OVER(PARTITION BY sku_id ORDER BY sum_num DESC,create_date ASC) rk FROM (SELECT sku_id, create_date, sum(sku_num) sum_num FROM order_detail GROUP BY sku_id,create_date)t1)t2 WHERE rk = 1").show();// 4. 关闭 SparkSessionspark.close();}上面个的代码就像在写 HQL 一样,我们可以把其中的子表提出来创建为临时表:

public static void main(String[] args) {System.setProperty("HADOOP_USER_NAME","lyh");// 1. 创建配置对象SparkConf conf = new SparkConf().setMaster("local[*]").setAppName("spark sql operate hive");// 2. 获取 SparkSessionSparkSession spark = SparkSession.builder().enableHiveSupport() // 添加 hive 支持.config(conf).getOrCreate();spark.sql("use db_hive2");// order_detail_id order_id sku_id create_date price sku_num// 每件商品的最高销量spark.sql("SELECT sku_id, create_date, sum(sku_num) sum_num FROM order_detail GROUP BY sku_id,create_date").createOrReplaceTempView("t1");spark.sql("SELECT sku_id, create_date, sum_num, ROW_NUMBER() OVER(PARTITION BY sku_id ORDER BY sum_num DESC,create_date ASC) rk FROM t1").createOrReplaceTempView("t2");spark.sql("SELECT sku_id, create_date, sum_num FROM t2 WHERE rk = 1").show();// 4. 关闭 SparkSessionspark.close();}没啥难度,这就是官网说的使用 Spark SQL 或者 HQL 来操作数仓中的数据,之后做个 Spark SQL 项目多练练手就行了。

运行结果:

相关文章:

Spark SQL【Java API】

前言 之前对 Spark SQL 的影响一直停留在 DSL 语法上面,感觉可以用 SQL 表达的,没有必要用 Java/Scala 去写,但是面试一段时间后,发现不少公司还是在用 SparkSQL 的,京东也在使用 Spark On Hive 而不是我以为的 Hive O…...

文心智能体平台丨创建你的四六级学习小助手

引言 在人工智能飞速发展的今天,我们迎来了文心智能体平台。该平台集成了最先进的人工智能技术,旨在为用户提供个性化、高效的学习辅助服务。今天,我们将向大家介绍如何利用文心智能体平台,创建一个专属于你的四六级学习小助手。…...

)

js全国省市区JSON数据(全)

AreaJson 就是全国省市区的具体数据信息,下面我自定义了一些方法,获取数据用的,不需要的可以删掉,只拿JSON内的数据即可 const AreaJson [{"name": "北京市","city": [{"name": "…...

轻量级 C Logger

目录 一、描述 二、实现效果 三、使用案例 四、内存检测 一、描述 最近实现一个 WS 服务器,内部需要一个日志打印记录服务器程序的运行过程,故自己实现了一个轻量级的 logger,主要包含如下特征: 可输出 debug、info、warn、er…...

哪里能下载到合适的衣柜3D模型素材?

室内设计师在进行家居设计时,衣柜3D模型素材是非常重要的工具。那么,哪里能下载到合适的衣柜3D模型素材呢? 一、建e网: ①建e网是一个专注于3D模型素材分享的平台,上面可以找到大量的衣柜3D模型。 ②该网站提供的模型种类丰富&am…...

计算机毕业设计 | SpringBoot+vue仓库管理系统(附源码)

1,绪论 1.1 项目背景 随着电子计算机技术和信息网络技术的发明和应用,使着人类社会从工业经济时代向知识经济时代发展。在这个知识经济时代里,仓库管理系统将会成为企业生产以及运作不可缺少的管理工具。这个仓库管理系统是由:一…...

【Python】解决Python报错:TypeError: can only concatenate str (not “int“) to str

🧑 博主简介:阿里巴巴嵌入式技术专家,深耕嵌入式人工智能领域,具备多年的嵌入式硬件产品研发管理经验。 📒 博客介绍:分享嵌入式开发领域的相关知识、经验、思考和感悟,欢迎关注。提供嵌入式方向…...

大数据技术分享 | Kylin入门系列:基础介绍篇

Kylin入门教程 在大数据时代,如何高效地处理和分析海量数据成为了企业面临的挑战之一。Apache Kylin作为一个开源的分布式分析引擎,提供了Hadoop之上的SQL查询接口及多维分析(OLAP)能力,使得对超大规模数据集的分析变…...

程序猿转型做项目经理一定要注意这 5 个坑

前言 国内的信息系统项目经理,很多都是从技术骨干转型的,我就是这样一路走过来的,这样有很多好处,比如技术过硬容易服众、熟悉开发流程更容易把控项目进度和质量、开发过程中碰到难题时更好组织攻坚等等,但是所谓成也…...

【Python爬虫】案例_github模拟登录

import requests import re from datetime import datetimedef login():sessionrequests.session()session.headers {User-Agent :XXXX #写自己的}url1 https://github.com/loginres_1 session.get(url1).content.decode()token re.findall(name"authenticity_token&q…...

小红书图文笔记怎么做?纯干货!

小红书图文笔记的制作是一门艺术,它需要结合精美的图片和有价值的内容,以吸引和留住用户的注意力。伯乐网络传媒给大家分享制作小红书图文笔记的干货指南,包括准备、制作、发布和优化的各个环节。 一、准备阶段 确定目标受众:找到…...

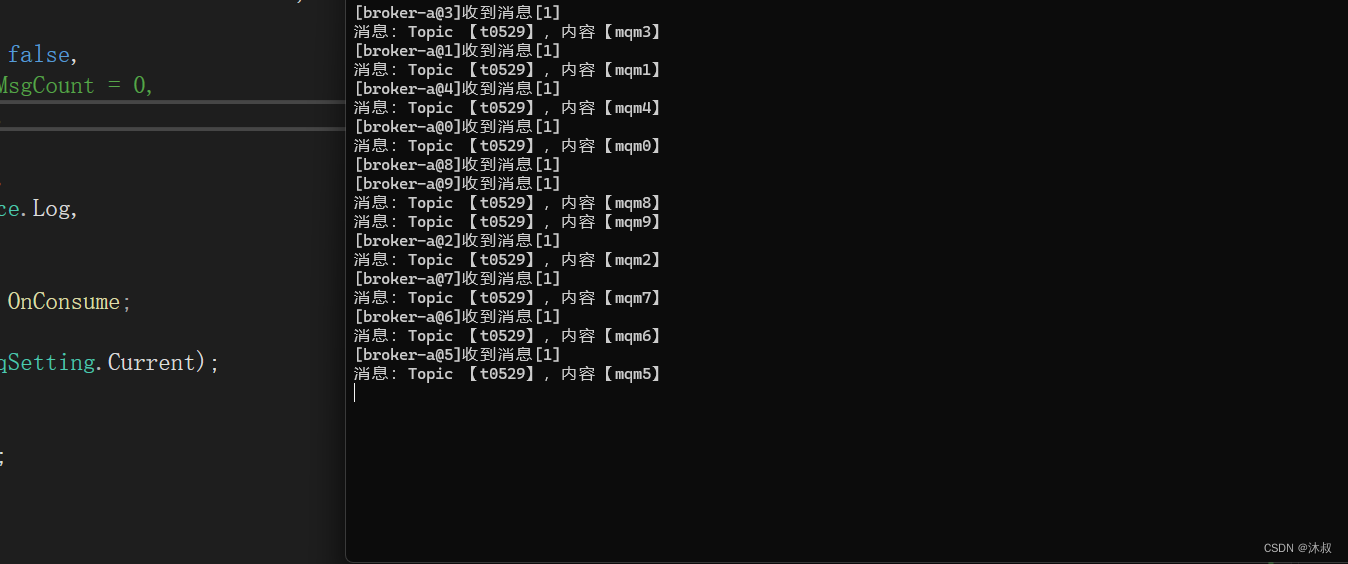

RocketMQ .NET

RocketMQ 是一款由阿里巴巴集团开发并开源给Apache软件基金会的分布式消息及流处理平台。以其高吞吐量、低延迟、高可用性等特点而广受欢迎。支持Java,C, Python, Go, .NET等。 异步解耦:可以实现上游和下游业务系统的松耦合设计,使得服务部…...

知攻善防应急响应靶机训练-Web2

前言: 本次应急响应靶机采用的是知攻善防实验室的Web-2应急响应靶机 靶机下载地址为: https://pan.quark.cn/s/4b6dffd0c51a 相关账户密码 用户:administrator 密码:Zgsfqq.com 解题过程: 一、攻击者的IP地址(两个)…...

opencv进阶 ——(七)图像处理之寸照换背景

寸照换背景,通常指的是将个人证件照片的背景色更换为另一种颜色,如白色、蓝色或红色等,以满足不同用途的要求。例如,护照照片通常要求白色背景,而身份证照片可能需要蓝色背景。这个过程通常涉及到图像处理技术…...

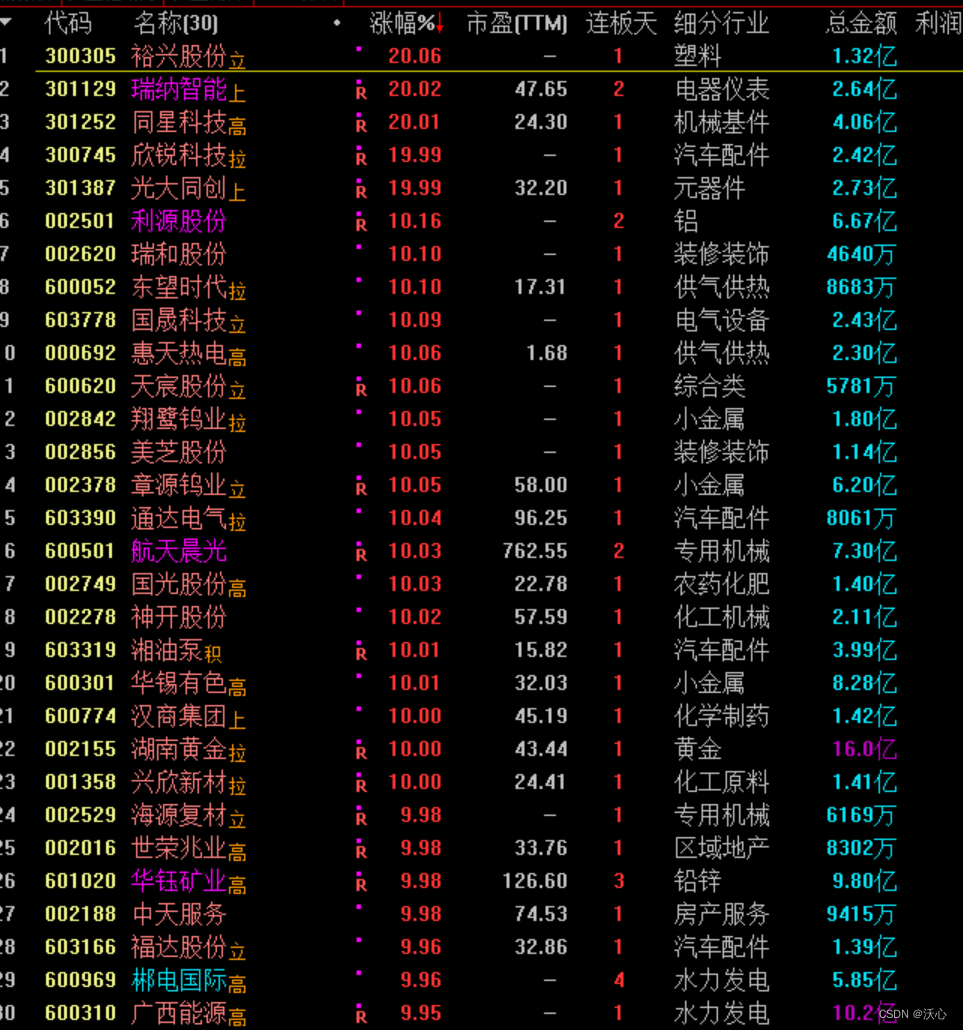

每日复盘-20240529

20240529 六日涨幅最大: ------1--------300956--------- 英力股份 五日涨幅最大: ------1--------301361--------- 众智科技 四日涨幅最大: ------1--------301361--------- 众智科技 三日涨幅最大: ------1--------300637--------- 扬帆新材 二日涨幅最大: ------1--------30…...

mybatis问题汇总

Mapped Statements collection does not contain value for mapper.xml中namespace存在问题 使用 ${}实现关键字(表名、列名)的可变 #{} 和 ${} 的区别...

Kafka SSL认证

证书生成 在kafka安装目录下/certificates生成keystore和trust文件,在其中一台机器声生成证书,然后将 生成的server.keystore.jks和server.truststore.jks文件拷贝其他broker节点上去即可 1.生成keystore [rootm1 certificates]# keytool -keystore se…...

【Spring】认识 Spring AOP

认识 Spring AOP 1.什么是 AOP2.AOP 中的概念3.用 AOP 方式管理日志3.1 编写 AOP 日志注解类3.2 编写控制器用于测试 1.什么是 AOP AOP(Aspect Oriented Program,面向切面编程)把业务功能分为核心、非核心两部分。 核心业务功能:…...

什么是访问控制漏洞

什么是AC Bugs? 实验室 Vertical privilege escalation 仅通过隐藏目录/判断参数来权限控制是不安全的(爆破url/爬虫/robots.txt/Fuzz/jsfinder) Unprotected functionality 访问robots.txt 得到隐藏目录,访问目录 ,…...

python基于百度,哈工大等停用表进行的中文分词

import os import pandas as pd import jieba# 加载停用词 def load_stopwords(filenames):stopwords set()for filename in filenames:with open(filename, r, encodingutf-8) as f:for line in f:stopwords.add(line.strip())return stopwords# 中文分词并去除停用词 def se…...

谷歌浏览器插件

项目中有时候会用到插件 sync-cookie-extension1.0.0:开发环境同步测试 cookie 至 localhost,便于本地请求服务携带 cookie 参考地址:https://juejin.cn/post/7139354571712757767 里面有源码下载下来,加在到扩展即可使用FeHelp…...

BCS 2025|百度副总裁陈洋:智能体在安全领域的应用实践

6月5日,2025全球数字经济大会数字安全主论坛暨北京网络安全大会在国家会议中心隆重开幕。百度副总裁陈洋受邀出席,并作《智能体在安全领域的应用实践》主题演讲,分享了在智能体在安全领域的突破性实践。他指出,百度通过将安全能力…...

自然语言处理——Transformer

自然语言处理——Transformer 自注意力机制多头注意力机制Transformer 虽然循环神经网络可以对具有序列特性的数据非常有效,它能挖掘数据中的时序信息以及语义信息,但是它有一个很大的缺陷——很难并行化。 我们可以考虑用CNN来替代RNN,但是…...

汇编常见指令

汇编常见指令 一、数据传送指令 指令功能示例说明MOV数据传送MOV EAX, 10将立即数 10 送入 EAXMOV [EBX], EAX将 EAX 值存入 EBX 指向的内存LEA加载有效地址LEA EAX, [EBX4]将 EBX4 的地址存入 EAX(不访问内存)XCHG交换数据XCHG EAX, EBX交换 EAX 和 EB…...

基于Java Swing的电子通讯录设计与实现:附系统托盘功能代码详解

JAVASQL电子通讯录带系统托盘 一、系统概述 本电子通讯录系统采用Java Swing开发桌面应用,结合SQLite数据库实现联系人管理功能,并集成系统托盘功能提升用户体验。系统支持联系人的增删改查、分组管理、搜索过滤等功能,同时可以最小化到系统…...

在Ubuntu24上采用Wine打开SourceInsight

1. 安装wine sudo apt install wine 2. 安装32位库支持,SourceInsight是32位程序 sudo dpkg --add-architecture i386 sudo apt update sudo apt install wine32:i386 3. 验证安装 wine --version 4. 安装必要的字体和库(解决显示问题) sudo apt install fonts-wqy…...

Java求职者面试指南:Spring、Spring Boot、MyBatis框架与计算机基础问题解析

Java求职者面试指南:Spring、Spring Boot、MyBatis框架与计算机基础问题解析 一、第一轮提问(基础概念问题) 1. 请解释Spring框架的核心容器是什么?它在Spring中起到什么作用? Spring框架的核心容器是IoC容器&#…...

PHP 8.5 即将发布:管道操作符、强力调试

前不久,PHP宣布了即将在 2025 年 11 月 20 日 正式发布的 PHP 8.5!作为 PHP 语言的又一次重要迭代,PHP 8.5 承诺带来一系列旨在提升代码可读性、健壮性以及开发者效率的改进。而更令人兴奋的是,借助强大的本地开发环境 ServBay&am…...

基于开源AI智能名片链动2 + 1模式S2B2C商城小程序的沉浸式体验营销研究

摘要:在消费市场竞争日益激烈的当下,传统体验营销方式存在诸多局限。本文聚焦开源AI智能名片链动2 1模式S2B2C商城小程序,探讨其在沉浸式体验营销中的应用。通过对比传统品鉴、工厂参观等初级体验方式,分析沉浸式体验的优势与价值…...

基于谷歌ADK的 智能产品推荐系统(2): 模块功能详解

在我的上一篇博客:基于谷歌ADK的 智能产品推荐系统(1): 功能简介-CSDN博客 中我们介绍了个性化购物 Agent 项目,该项目展示了一个强大的框架,旨在模拟和实现在线购物环境中的智能导购。它不仅仅是一个简单的聊天机器人,更是一个集…...