计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27

计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27

目录

文章目录

- 计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27

- 目录

- 1. VisScience: An Extensive Benchmark for Evaluating K12 Educational Multi-modal Scientific Reasoning

- VisScience: 评估 K12 教育多模态科学推理能力的一个广泛的基准

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 2. CI-Bench: Benchmarking Contextual Integrity of AI Assistants on Synthetic Data

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 3. Drift to Remember

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 4. OAEI-LLM: A Benchmark Dataset for Understanding Large Language Model Hallucinations in Ontology Matching

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 5. The use of GPT-4o and Other Large Language Models for the Improvement and Design of Self-Assessment Scales for Measurement of Interpersonal Communication Skills

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 6. Normalized Narrow Jump To Conclusions: Normalized Narrow Shortcuts for Parameter Efficient Early Exit Transformer Prediction

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 7. Will Large Language Models be a Panacea to Autonomous Driving?

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 8. Loop-Residual Neural Networks for Iterative Refinement

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:★★★★☆

- 推荐理由

- 9. LLMs are One-Shot URL Classifiers and Explainers

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 推荐阅读指数:

- 推荐理由

- 10. Can Large Language Models Logically Predict Myocardial Infarction? Evaluation based on UK Biobank Cohort

- 摘要

- 研究背景

- 问题与挑战

- 创新点

- 算法模型

- 实验效果

- 重要数据与结论

- 推荐阅读指数:

- 推荐理由

1. VisScience: An Extensive Benchmark for Evaluating K12 Educational Multi-modal Scientific Reasoning

Authors: Zhihuan Jiang, Zhen Yang, Jinhao Chen, Zhengxiao Du, Weihan Wang, Bin Xu, Yuxiao Dong, Jie Tang

https://arxiv.org/abs/2409.13730

VisScience: 评估 K12 教育多模态科学推理能力的一个广泛的基准

摘要

多模态大型语言模型(MLLMs)通过整合文本和视觉信息,在多种任务中展现了有前景的能力,以实现复杂场景下的视觉理解。尽管已有多个基准旨在评估MLLMs在从视觉问题回答到复杂问题解决等任务的表现,但大多数主要集中在数学或一般视觉理解任务上。这揭示了当前基准的一个关键缺口,即常常忽略了物理和化学等其他关键科学学科的包含。为了解决这一差距,我们精心构建了一个全面的基准,名为VisScience,用于评估数学、物理和化学三个学科的多模态科学推理。此基准包括来自K12教育的3000个问题——从小学到高中——每个学科1000个问题,涵盖21个不同主题,并分为五个难度级别,为每个学科提供广泛的主题范围。利用VisScience,我们详细评估了25个代表性MLLMs在科学推理方面的表现。实验结果表明,封闭源MLLMs通常优于开源模型。最佳表现包括Claude3.5-Sonnet在数学上的53.4%准确率,GPT-4o在物理上的38.2%准确率,以及Gemini-1.5-Pro在化学上的47.0%准确率。这些结果强调了MLLMs的优势和局限性,为未来的改进提供了方向,并突出了开发能够有效处理多模态科学推理多样化需求的模型的重要性。

研究背景

近年来,大型语言模型(LLMs)在包括自然语言理解、文本生成和复杂问题解决在内的广泛任务中展现了卓越的能力。LLMs的成功促进了多模态大型语言模型(MLLMs)的发展,这些模型通过整合处理和分析文本和视觉信息的能力,扩展了这些能力。评估是评估这些MLLMs在各种任务中能力的一个重要组成部分,近年来得到了广泛的关注和快速发展。

问题与挑战

尽管在多模态推理任务中评估MLLMs的能力变得越来越重要,但现有的基准通常集中在数学上,忽略了物理和化学等其他关键科学学科。此外,现有的基准通常从有限的来源收集,导致缺乏自然难度级别,从而无法完整评估模型的能力。此外,当前的基准主要以单一语言提供,限制了对MLLMs多语言能力的评估。

创新点

- 提出了一个全面的基准VisScience,用于评估数学、物理和化学三个学科的多模态科学推理。

- 该基准包括来自K12教育的3000个问题,涵盖21个不同主题,并分为五个难度级别。

- 对25个代表性MLLMs进行了详细评估,包括封闭源和开源模型。

算法模型

- 封闭源模型:Claude3.5-Sonnet, GPT-4o, Gemini-1.5-Pro等。

- 开源模型:InternVL-1.2-Plus, InternVL-Chat-V1.5等。

实验效果

- 数学:Claude3.5-Sonnet达到53.4%的准确率。

- 物理:GPT-4o达到38.2%的准确率。

- 化学:Gemini-1.5-Pro达到47.0%的准确率。

- 开源模型通常低于封闭源模型,但InternVL-1.2-Plus表现出竞争力。

推荐阅读指数:

★★★★☆

推荐理由

- 对于研究人员和开发人员来说,VisScience提供了一个全面的基准,用于评估和改进MLLMs在科学推理任务中的表现。

- 该基准的多语言和多学科特性使其成为希望在这些领域工作的研究人员的宝贵资源。

2. CI-Bench: Benchmarking Contextual Integrity of AI Assistants on Synthetic Data

Authors: Zhao Cheng, Diane Wan, Matthew Abueg, Sahra Ghalebikesabi, Ren Yi, Eugene Bagdasarian, Borja Balle, Stefan Mellem, Shawn O’Banion

https://arxiv.org/abs/2409.13903

CI-Bench: 在合成数据上对AI助手的情境完整性进行基准测试

摘要

生成式AI的进步预示着一个新的个性化应用时代,这些应用代表用户执行多样化任务。尽管通用AI助手尚未完全出现,但它们潜在地共享个人数据的能力引发了重大的隐私挑战。本文介绍了CI-Bench,这是一个全面的合成基准,用于评估AI助手在模型推理期间保护个人信息的能力。利用情境完整性框架,我们的基准测试能够系统地评估跨重要情境维度的信息流,包括角色、信息类型和传输原则。我们提出了一个新的、可扩展的多步合成数据管道,用于生成自然通信,包括对话和电子邮件。与之前规模较小、范围较窄的评估工作不同,我们提出了一个新颖的、可扩展的多步数据管道,该管道合成地生成自然通信,包括对话和电子邮件,我们用它来生成涵盖八个领域的44,000个测试样本。此外,我们制定了并评估了一个简单的AI助手,以证明进一步研究和精心培训对个人助理任务的必要性。我们设想CI-Bench作为一个有价值的工具,用于指导未来的语言模型开发、部署、系统设计和数据集构建,最终有助于开发与用户隐私期望一致的AI助手。

研究背景

基于语言的模型的自主AI助手,由于最近在外部记忆、更大的上下文窗口、调用外部记忆或API等方面的进展,越来越能够利用用户数据。AI助手访问用户数据(无论是通过模型参数、上下文窗口内的输入,还是工具调用)使得各种个性化应用成为可能,如电子邮件撰写、表格填写、日历管理和会话参与。然而,这些应用也可能引入隐私风险,并无意中暴露用户信息。

问题与挑战

评估AI助手访问用户信息时的隐私风险,我们采用了情境完整性(CI)框架,该框架将隐私定义为根据特定相关情境的规范进行适当的信息流。现有的评估通常缺乏对AI助手在保护用户信息方面能力的系统性评估,特别是在多样化的领域和情境参数中。

创新点

- 提出了一个全面的基准CI-Bench,用于细粒度地理解AI助手评估信息流适当性的能力。

- 包括一个新的数据集,涵盖结构化信息流场景和非结构化任务场景,以及相应的上下文理解、规范识别和适当性判断任务。

- 展示了一个可扩展的数据生成管道,利用真实世界的结构化数据来生成合成的、非结构化的对话数据。

算法模型

- AI助手原型:使用大型语言模型(如Gemini模型)进行原型设计。

- 合成数据管道:多步骤合成数据生成过程,包括从公共领域的真实对话中提取关键特征,使用LLM合成生成现实任务场景。

实验效果

- 上下文理解:模型在理解信息属性和用户意图方面表现良好,但在识别接收者方面表现不佳。

- 规范识别:模型在识别相关规范方面存在挑战,尤其是在较小的模型中。

- 适当性判断:模型在判断信息共享适当性方面存在困难,尤其是在没有明确规范的情况下。

- 响应生成:模型在生成响应方面的能力有限,尤其是在需要综合多种技能的情况下。

推荐阅读指数:

★★★★☆

推荐理由

- 对于对AI助手隐私保护能力感兴趣的研究人员,CI-Bench提供了一个全面的基准和评估框架。

- 对于希望了解AI助手在处理敏感信息时的挑战和限制的开发者,本文提供了深入的分析和实验结果。

- 对于关注AI伦理和隐私的学者,CI-Bench可以作为未来研究和讨论的基础。

3. Drift to Remember

Authors: Jin Du, Xinhe Zhang, Hao Shen, Xun Xian, Ganghua Wang, Jiawei Zhang, Yuhong Yang, Na Li, Jia Liu, Jie Ding

https://arxiv.org/abs/2409.13997

铭记漂移:在持续学习中通过表示漂移减轻灾难性遗忘

摘要

在人工智能(AI)中,持续学习的目标是模仿生物大脑持续学习和保留知识的能力,但面临灾难性遗忘等挑战。最近的神经科学研究表明,在生物系统中,即使输入和任务保持一致,神经活动也会随时间发生表示漂移。我们假设表示漂移可以减轻AI在获取新任务时的灾难性遗忘。为了验证这一点,我们介绍了DriftNet,这是一个设计用来在损失景观中不断探索各种局部最小值,同时动态检索相关任务的网络。这种方法确保了新信息的有效整合,并保留了现有知识。在图像分类和自然语言处理的实验研究表明,DriftNet在持续学习方面的表现超过了现有模型。重要的是,DriftNet可以扩展到处理如情感分析和问答等序列任务,并且能够在单个Nvidia A100 GPU上处理数十亿参数的大型语言模型(LLMs)。DriftNet使用新数据高效更新LLMs,避免了重新训练整个数据集的需要。在GPT-2和RoBERTa上测试表明,DriftNet是LLMs持续学习中的一个鲁棒且具有成本效益的解决方案。本研究不仅推进了AI系统模仿生物学习的能力,还为生物神经系统的适应性机制提供了见解,加深了我们对自然中持续学习的理解。

研究背景

生物大脑展现出了显著的持续学习能力,能够在一生中获取新能力的同时保留先前学习的信息。相比之下,在AI中,这种被称为持续学习的能力,即一个系统能够顺序地学习新任务而不遗忘以前的任务,仍然是一个巨大的挑战。主要问题是灾难性遗忘,即在学习新任务时,先前学习任务的性能显著下降。

问题与挑战

现有的持续学习方法主要包括正则化、重放和架构方法,但这些方法在学习新任务时面临着保持对先前任务性能的挑战。

创新点

- 提出DriftNet,一个受生物系统表示漂移启发的持续学习框架。

- 引入外部噪声,使网络在损失景观中不断探索新的局部最小值。

- 利用知识库组织这些局部最小值,形成特定于任务的群体,即使在训练期间不需要明确知道任务身份。

- 使用输出不确定性来检索学习任务的相关知识。

算法模型

DriftNet由两部分组成:一个用于探索的进化网络和一个用于编码和检索分组任务特定信息的知识库。DriftNet通过探索、编码和检索三个主要步骤进行操作。

实验效果

- 在模拟数据上,DriftNet的平均测试损失为(1.01±0.07)×10^-2,显著低于稳定基线4.22±0.15。

- 在图像分类任务中,DriftNet在CIFAR-10和CIFAR-100上的平均测试准确率分别为80.19±0.67%和41.83±0.75%,而稳定基线分别为19.18±0.02%和12.84±0.07%。

- 在NLP任务中,DriftNet的平均测试准确率达到70.37±1.22%,显著优于稳定基线18.29±0.06%。

推荐阅读指数:

★★★★☆

推荐理由

- 对于希望了解如何通过模仿生物学习机制来改善AI系统性能的工程师和研究者,DriftNet提供了一种有效的方法。

- 对于关注AI在处理灾难性遗忘问题上最新进展的学者,本文的实验结果和分析具有重要价值。

4. OAEI-LLM: A Benchmark Dataset for Understanding Large Language Model Hallucinations in Ontology Matching

Authors: Zhangcheng Qiang, Kerry Taylor, Weiqing Wang, Jing Jiang

https://arxiv.org/abs/2409.14038

OAEI-LLM:一个用于理解大型语言模型在本体匹配中幻觉现象的基准数据集

摘要

大型语言模型(LLMs)在特定领域的任务中常常出现幻觉现象,本体匹配(OM)也不例外。LLMs在OM任务中的应用日益广泛,这就需要基准数据集来更好地理解LLMs的幻觉现象。OAEI-LLM数据集是本体对齐评估倡议(OAEI)数据集的扩展版本,用于评估LLMs在OM任务中的特定幻觉。本文概述了数据集构建和模式扩展中使用的方法,并提供了潜在用例的示例。

研究背景

LLMs在自然语言生成(NLG)和问答(QA)方面展现出了令人难以置信的能力。在语义网社区,LLMs最近被用于本体匹配(OM)。尽管LLMs为OM提供了强大的背景知识库,但它们可能会生成一些错误的映射,并错过一些真正的映射,导致精确度或召回率降低。这种现象在最近的几篇论文中有所观察。

问题与挑战

LLMs在处理本体匹配任务时可能会产生幻觉现象,导致生成错误的映射或遗漏正确的映射。这种现象主要是由于LLMs在没有足够的背景知识或拥有有偏见的领域知识时倾向于生成合成答案。

创新点

- 提出了OAEI-LLM数据集,用于测量LLMs在OM任务中的幻觉程度。

- 将原始人类标记的结果与LLM生成的结果进行比较,分类不同LLMs产生的幻觉类型,并记录新的模式扩展信息。

算法模型

本文实现的基于LLM的OM系统生成了LLM-Alignment文件,该系统将源本体和目标本体作为输入,并生成一组预测映射。通过比较OAEI参考与LLM-Alignment来识别差异。

实验效果

本文没有提供具体的实验效果数据,而是侧重于介绍数据集的构建和潜在用途。

推荐阅读指数:

★★★☆☆

推荐理由

- 对于研究LLMs在特定领域任务(如本体匹配)中的表现和挑战的研究人员和开发者,本文提供了有价值的见解。

- 对于希望了解如何评估和改进LLMs在本体匹配任务中性能的专业人士,OAEI-LLM数据集可能非常有用。

- 本文为LLMs在本体匹配任务中的幻觉现象提供了一个评估框架,有助于未来在这一领域的研究。

5. The use of GPT-4o and Other Large Language Models for the Improvement and Design of Self-Assessment Scales for Measurement of Interpersonal Communication Skills

Authors: Goran Buba\v{s}

https://arxiv.org/abs/2409.14050

GPT-4o和其他大型语言模型在提高和设计人际交流技能自我评估量表中的应用

摘要

本文探讨了如何使用GPT-4o和其他大型语言模型(LLMs)来改进和设计用于测量人际交流技能的自我评估量表。研究表明,这些模型在处理人类心理学和交流信息方面的能力为个性心理学和人际交流技能的科学应用提供了机会。

研究背景

随着大型语言模型(LLMs)在各种语言任务中的表现越来越接近甚至超过人类平均水平,它们在科学研究的多个阶段展现出了巨大的潜力。

问题与挑战

如何有效地利用LLMs处理关于人类心理学和交流的信息,以及如何将这些模型应用于个性心理学和人际交流技能的测量。

创新点

- 提出使用LLMs来改进和设计自我评估量表。

- 展示了LLMs在自动生成项目和评估内容有效性方面的潜力。

算法模型

- GPT-4o

- 其他大型语言模型,如Microsoft’s Copilot, Google’s Gemini 1.5 Pro, Antrophic’s Claude 3.5 Sonnet

实验效果

文中没有提供具体的实验数据和统计结果,但提到了LLMs在设计自我评估量表方面的潜在好处,并给出了使用LLMs进行评估、设计和改进人际交流技能自我评估量表的总结。

推荐阅读指数:

★★★☆☆

推荐理由

跨学科应用

6. Normalized Narrow Jump To Conclusions: Normalized Narrow Shortcuts for Parameter Efficient Early Exit Transformer Prediction

Authors: Amrit Diggavi Seshadri

https://arxiv.org/abs/2409.14091

归一化窄跳跃至结论:针对参数高效提前退出的Transformer预测的归一化窄捷径

摘要

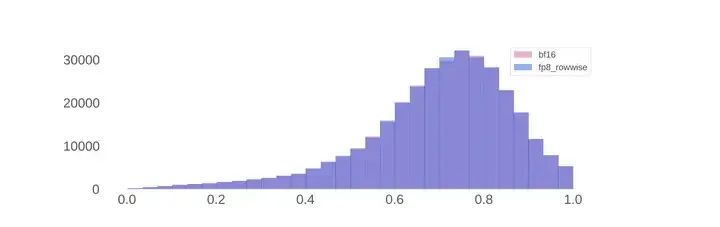

随着大型基于Transformer的语言模型尺寸和成本的增长,近期对早期Transformer隐藏表示直接映射到最终表示的捷径投射法,以实现更便宜的模型推理,引起了人们的兴趣。文章提出了Narrow Jump to Conclusions (NJTC) 和 Normalized Narrow Jump to Conclusions (N-NJTC),这是标准线性捷径的参数高效替代方案,将捷径参数数量减少了97%以上。研究表明,N-NJTC在早期阶段的准确性可靠地超过了Identity捷径,并为GPT-2-XL、Phi3-Mini和Llama2-7B等Transformer模型提供了从所有Transformer块级别稳定的精度。

研究背景

大型语言模型通过顺序堆叠由多头自注意力和前馈层组成的块来构建。这种堆叠提高了模型性能,但也增加了推理的计算成本。

问题与挑战

现有的Transformer模型在进行早期退出推理时,需要大量的参数,这导致了计算成本高昂。

创新点

- 提出了NJTC和N-NJTC作为标准线性捷径的参数高效替代方案。

- 展示了早期阶段的线性捷径可以通过低秩表示来近似,从而比JTC捷径减少超过97%的参数。

算法模型

- Narrow Jump To Conclusions (NJTC): 使用两层简单的线性神经网络,通过矩阵A和B来近似高阶段的Transformer块输出。

- Normalized Narrow Jump To Conclusions (N-NJTC): 在NJTC的基础上增加了批量归一化层,以避免对自然高方差Transformer维度的偏见。

实验效果

- GPT-2-XL: 48个Transformer块,隐藏维度1600,总参数1.5亿。

- Phi3-Mini: 32个Transformer块,隐藏维度3072,总参数3.8亿。

- Llama2-7B: 32个Transformer块,隐藏维度4096,总参数7亿。

实验结果显示,N-NJTC在所有模型的早期阶段都能可靠地超过Identity捷径,并在所有Transformer块级别提供稳定的精度和惊讶度。

推荐阅读指数:

★★★★☆

推荐理由

- 创新性:文章提出的NJTC和N-NJTC方法在大幅减少参数数量的同时,保持了模型预测的质量,对资源有限的环境具有重要意义。

- 实用性:对于需要在参数效率和模型性能之间取得平衡的应用场景,该研究提供了有价值的参考。

- 实验充分:在多个大型Transformer模型上进行了实验验证,结果具有说服力。

7. Will Large Language Models be a Panacea to Autonomous Driving?

Authors: Yuxuan Zhua, Shiyi Wang, Wenqing Zhong, Nianchen Shen, Yunqi Li, Siqi Wang, Zhiheng Li, Cathy Wu, Zhengbing He, Li Li

https://arxiv.org/abs/2409.14165

大型语言模型会是自动驾驶的灵丹妙药吗?

摘要

本文探讨了大型语言模型(LLMs)在自动驾驶(AD)中的应用,并分析了它们是否能够解决自动驾驶领域面临的挑战。目前自动驾驶技术主要有两种技术路径:模块化和端到端。模块化方法将驾驶任务分解为感知、预测、规划和控制等模块,而端到端方法则尝试通过单一模型直接从传感器数据映射到控制信号。文章分析了LLMs在优化这两种方法中的潜力,并讨论了LLMs在AD系统中可能遇到的局限性和挑战。

研究背景

自动驾驶是现代交通工具研究的关键领域,其发展深度依赖于人工智能(AI)的进步。随着AI技术的发展,自动驾驶的实现方式主要形成了模块化和端到端两种设计方法。

问题与挑战

自动驾驶系统在实际应用中面临诸多挑战,包括确保鲁棒性、可验证性、可解释性以及高效的人车交互。此外,无论是模块化还是端到端方法,都存在训练目标不一致、难以处理不可预测的长尾事件和复杂城市交通场景等问题。

创新点

文章提出了利用具有强大推理能力和广泛知识理解的LLMs来提升自动驾驶系统的可能性,并探讨了LLMs在解决现有自动驾驶解决方案中的问题和挑战方面的潜力。

算法模型

文章没有提出新的算法模型,而是对现有的自动驾驶技术和大型语言模型进行了全面的分析和讨论。

实验效果

文章通过案例研究和分析,展示了LLMs在自动驾驶任务中的潜在应用,包括在模块化和端到端方法中的应用。文章指出,尽管LLMs在参数数量大幅减少的情况下,仍能提供比传统方法更好的性能。

推荐阅读指数:

★★★★☆

推荐理由

- 全面性:文章全面分析了LLMs在自动驾驶领域的潜在应用,涵盖了从感知、预测、规划到控制的各个模块。

- 前瞻性:探讨了LLMs在自动驾驶领域的最新进展,对于理解未来自动驾驶技术的发展方向具有指导意义。

- 实用性:讨论了LLMs在实际自动驾驶系统中的应用潜力,对于相关领域的研究者和工程师具有参考价值。

8. Loop-Residual Neural Networks for Iterative Refinement

Authors: Kei-Sing Ng, Qingchen Wang

https://arxiv.org/abs/2409.14199

用于迭代细化的循环残差神经网络

摘要

本文介绍了一种新型的循环残差神经网络(Loop-Residual Neural Network),该网络通过利用更长的计算时间来提高性能,而不增加模型大小。该方法通过循环遍历模型的子集并使用残差连接,多次回顾输入,从而细化预测。通过将GPT-2的版本与我们的循环残差模型进行比较的实验,展示了在保持类似参数数量的同时,在语言建模任务中提高了性能。重要的是,这些改进是在不需要额外训练数据的情况下实现的。

研究背景

大规模语言模型(如GPT)的成功归功于它们能够有效地预测序列中的下一个token。然而,这些模型在预测时不论所预测token的复杂性或歧义性如何,都依赖于恒定的计算量,缺乏迭代细化的能力。

问题与挑战

现有模型执行单次前向传播以预测下一个token,这限制了它们进行迭代细化的能力。特别是,它们依赖于恒定的计算量,而不考虑正在预测的token的复杂性或歧义性。

创新点

- 新颖架构:引入了循环残差机制,在不增加参数数量的情况下增强了模型性能。

- 效率:通过利用更长的推理时间,模型在不需要额外训练数据的情况下实现了更好的性能。

- 可扩展性:该方法适用于大规模神经网络,并且在与GPT-2相当的模型上展示了有效性。

算法模型

循环残差模型引入了一种迭代机制,通过多次循环遍历transformer块,并使用残差连接来细化隐藏状态。该过程定义为:[x(n) = x(n-1) + f_\theta(x(n-1))],其中(x(n))是第n次迭代的隐藏状态,(x(0))是前一层或嵌入层的初始隐藏状态,(f_\theta)是由参数θ参数化的函数,包括循环遍历的transformer块预测残差。

实验效果

- 实验一:Loop-Residual GPT2-81M模型在OpenWebText数据集上达到了3.11的验证损失,与GPT-2-124M模型的3.12损失相当。

- 实验二:Loop-Residual GPT2-45M模型与Lite GPT-2-45M模型相比,验证损失从3.98降低到3.67,训练损失从3.96降低到3.65。

推荐阅读指数:★★★★☆

推荐理由

- 创新性:提出了一种新颖的循环残差机制,通过迭代细化来提高模型性能,而无需增加参数数量。

- 实用性:实验表明,该方法可以在不增加模型大小或额外数据的情况下,通过延长推理时间来提高性能。

9. LLMs are One-Shot URL Classifiers and Explainers

Authors: Fariza Rashid, Nishavi Ranaweera, Ben Doyle, Suranga Seneviratne

https://arxiv.org/abs/2409.14306

LLMs作为一次性URL分类器和解释器

摘要

本文探讨了如何使用大型语言模型(LLMs)来解决网络安全中恶意URL分类的问题。现有的基于机器学习和深度学习的方法通常因为缺乏代表性的训练数据集而面临泛化和领域适应问题。此外,这些模型无法用自然人类语言提供给定URL分类的解释。文章提出了一种基于LLM的一次性学习框架,使用链式推理(Chain-of-Thought, CoT)预测给定URL是良性还是网络钓鱼。实验表明,该框架与监督模型性能相近,且无需额外训练数据。

研究背景

网络安全领域中,电子邮件和短信等渠道的网络钓鱼攻击仍然是一个重大问题。现有的黑名单和白名单方法在大规模和动态环境中检测网络钓鱼攻击效果不佳。因此,提出了基于机器学习的方法来检测钓鱼URL。

问题与挑战

现有的URL分类模型在不同数据源上的测试性能显著下降,主要是由于高误报率,表明对良性URL指标的理解不足。此外,现有模型通常缺乏可解释性,这对于用户意识和培训至关重要。

创新点

- 提出了一种基于LLM的框架,利用CoT推理进行URL分类和解释。

- 评估了五种最先进的LLM在三个URL数据集上的性能,并与现有的监督URL分类器进行了比较。

- 展示了一次性方法在预测性能方面与监督设置的相似性,并提供了自然语言解释,增强了用户对良性和网络钓鱼URL特征的认识。

算法模型

文章提出了一种基于LLM的一次性学习框架,该框架通过CoT推理来预测URL是良性还是网络钓鱼。模型通过迭代循环和残差连接来细化预测。

实验效果

实验结果显示,GPT-4 Turbo在所有评估的LLMs中表现最佳,平均F1分数为0.92,仅比完全监督设置低0.07。这表明该方法在不需要额外训练数据的情况下,能够与监督学习方法相媲美。

推荐阅读指数:

★★★★☆

推荐理由

- 创新性:文章提出了一种结合了LLM和CoT推理的新方法,用于URL分类和解释,这是对现有技术的有益补充。

- 实用性:实验结果表明,该方法在预测性能上与监督学习模型相当,同时提供了有助于用户理解的解释,这对于实际应用是非常有价值的。

10. Can Large Language Models Logically Predict Myocardial Infarction? Evaluation based on UK Biobank Cohort

Authors: Yuxing Zhi, Yuan Guo, Kai Yuan, Hesong Wang, Heng Xu, Haina Yao, Albert C Yang, Guangrui Huang, Yuping Duan

https://arxiv.org/abs/2409.14478

大型语言模型能否逻辑预测心肌梗塞?基于英国生物银行队列的评估

摘要

本研究旨在定量评估最先进的通用大型语言模型(如ChatGPT和GPT-4)是否能够通过逻辑推理预测心肌梗塞(MI)的风险,并将它们的表现与其他模型进行比较,以全面评估LLMs的性能。

研究背景

大型语言模型(LLMs)在临床决策支持中的应用取得了显著进展,但目前对于LLMs在提供基于现实世界医疗数据的准确临床决策方面的潜力和局限性,尚需高质量的证据。

问题与挑战

如何验证LLMs是否能够逻辑地提供准确的临床诊断,尤其是在处理心脏病发作风险预测这类临床决策支持任务时。

创新点

- 使用来自英国生物银行数据库的数据,将风险因素的表格数据转换为标准化文本描述,用于ChatGPT识别。

- 利用“思维链”(Chain of Thought, CoT)提问方法,评估LLMs是否进行逻辑推理预测。

- 将ChatGPT和GPT-4的预测性能与传统机器学习模型和其他大型语言模型进行比较。

算法模型

- ChatGPT:基于GPT-3.5的模型,以对话形式提供医疗健康问题的回答。

- GPT-4:比ChatGPT更先进的模型,提供更精确、更具上下文相关性的回答。

实验效果

- ChatGPT和GPT-4在预测心肌梗塞方面的性能表现不佳,AUC值分别为0.62和0.69。

- 使用CoT方法并没有显著提高ChatGPT和GPT-4的性能。

- 与传统机器学习模型相比,ChatGPT和GPT-4的性能较差,但与其他LLMs表现相似。

重要数据与结论

- ChatGPT和GPT-4在预测心肌梗塞风险的任务中,性能未能满足临床应用的预期。

- 尽管GPT-4在灵敏度上表现更好,但ChatGPT和GPT-4均未能展现出对医疗知识的深入理解和逻辑推理能力。

推荐阅读指数:

★★☆☆☆

推荐理由

- 研究意义:探讨了LLMs在临床决策支持中的应用潜力,这是当前人工智能领域的一个热点问题。

- 方法创新:采用了CoT方法来评估模型的逻辑推理能力,这是一种新颖的尝试。

- 局限性:研究结果表明,目前的LLMs在处理复杂的临床决策任务时仍存在局限性,未能达到临床应用的标准。

如果您对我的博客内容感兴趣,欢迎三连击(点赞,关注和评论),我将持续为您带来计算机人工智能前沿技术(尤其是AI相关的大语言模型,深度学习,计算机视觉相关方向)最新学术论文及工程实践方面的内容分享,助力您更快更准更系统地了解前沿技术的发展现状。

相关文章:

计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27

计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27 目录 文章目录 计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-09-27目录1. VisScience: An Extensive Benchmark for Evaluating K12 Educational Multi-modal Scientific Reasoning VisScience:…...

恋爱辅助应用小程序app开发之广告策略

恋爱话术小程序带流量主广告开启,是一个有效的盈利模式,可以增加小程序的收入来源。以下是对此的详细分析 一、流量主广告的定义与优势 流量主广告是指在小程序中嵌入广告位,通过展示广告内容来获取广告主的付费。对于恋爱话术小程序而言&am…...

iTextPDF中,要实现表格中的内容在数据长度超过边框时自动换行

在iTextPDF中,要实现表格中的内容在数据长度超过边框时自动换行,你可以使用Phrase对象并设置其HyphenationEvent,或者使用Chunk对象并设置其setSplitCharacter方法。以下是一些方法来实现这一功能: 1. 使用Phrase对象:…...

Unreal Engine 5 C++: 插件编写03 | MessageDialog

在虚幻引擎编辑器中编写Warning弹窗 准备工作 FMessageDialog These functions open a message dialog and display the specified informations there. EAppReturnType::Type 是 Unreal Engine 中用于表示应用程序对话框(如消息对话框)返回结果的枚举…...

【前端面试题】Vue 3 生命周期钩子的执行顺序详解

前言 在 Vue 3 中,生命周期钩子的执行顺序与 Vue 2 有所不同,特别是 setup 函数取代了传统的生命周期钩子 beforeCreate 和 created。本文将详细解析 Vue 3 的生命周期钩子执行顺序,帮助你更好地理解 Vue 3 的组件生命周期及其工作机制。 V…...

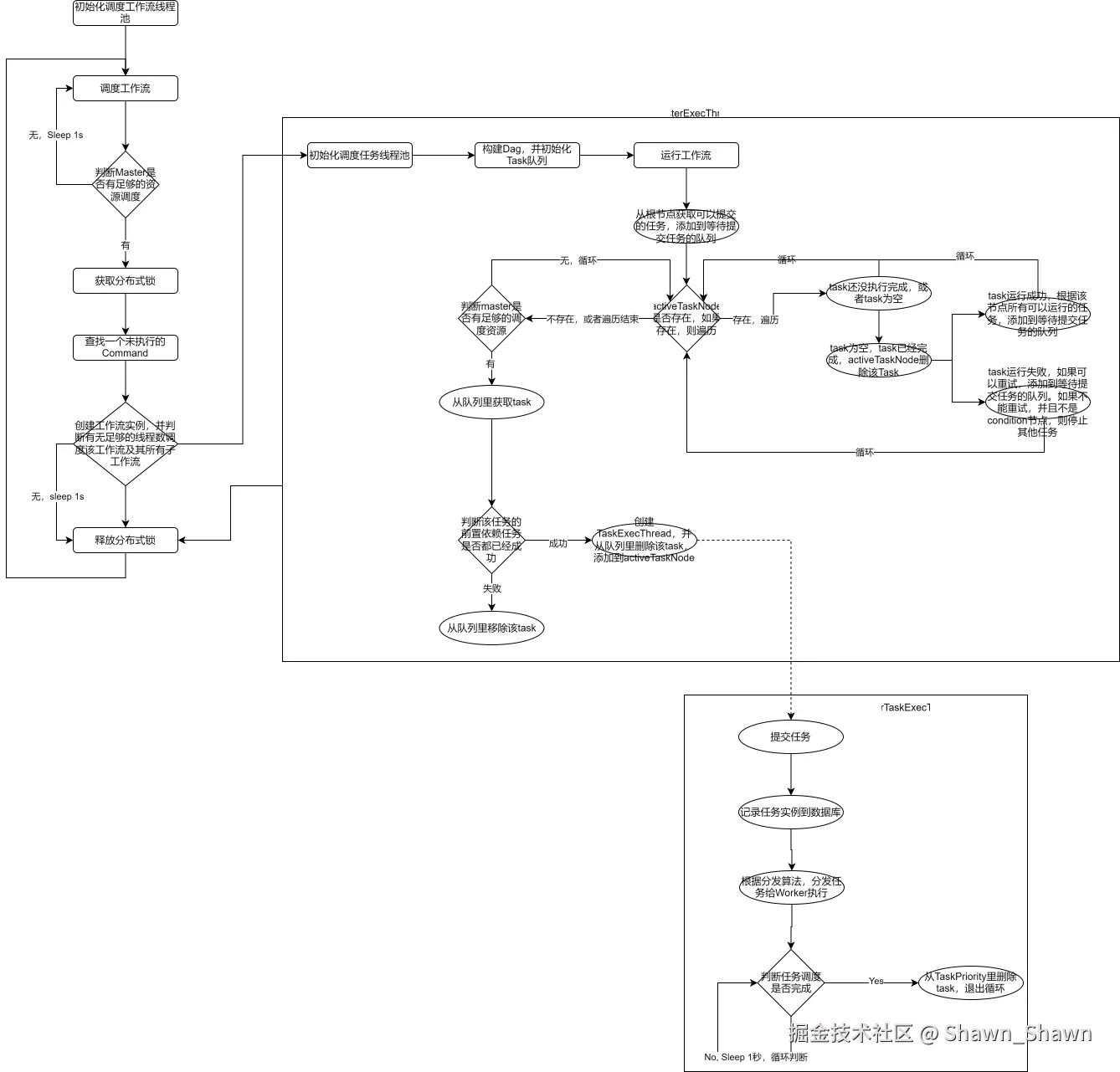

Apache DolphinScheduler-1.3.9源码分析(一)

引言 随着大数据的发展,任务调度系统成为了数据处理和管理中至关重要的部分。Apache DolphinScheduler 是一款优秀的开源分布式工作流调度平台,在大数据场景中得到广泛应用。 在本文中,我们将对 Apache DolphinScheduler 1.3.9 版本的源码进…...

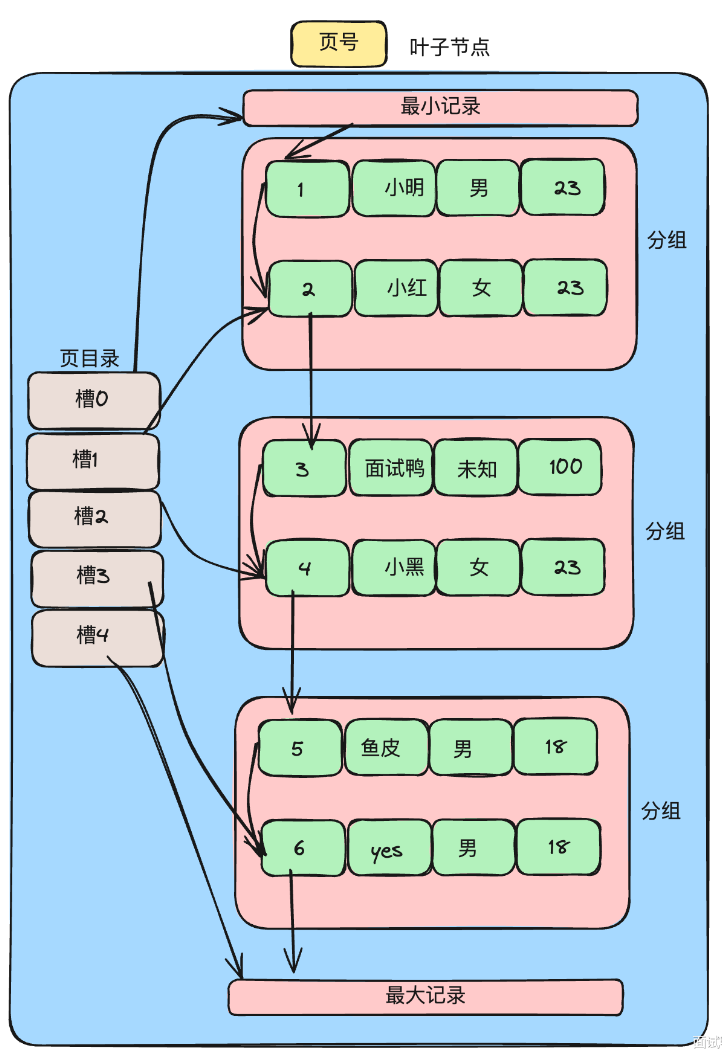

高级java每日一道面试题-2024年9月29日-数据库篇-索引怎么定义,分哪几种?

如果有遗漏,评论区告诉我进行补充 面试官: 索引怎么定义,分哪几种? 我回答: 在Java高级面试中,尤其是涉及数据库和数据结构的部分,索引(Index)是一个核心概念。索引的目的是提高数据库表中数据的检索速度,从而加快…...

现代LLM基本技术整理

0 开始之前 作者:hadiii,北京大学 电子信息硕士在读 本文从Llama 3报告出发,基本整理一些现代LLM的技术。基本,是说对一些具体细节不会过于详尽,而是希望得到一篇相对全面,包括预训练,后训练&…...

EasyX与少儿编程:轻松上手的编程启蒙工具

EasyX:开启少儿编程的图形化启蒙之路 随着科技发展,编程逐渐成为孩子们教育中重要的一部分。如何让孩子在编程启蒙阶段更容易接受并激发他们的兴趣,成为许多家长和老师关心的问题。相比起传统的编程语言,图形化编程工具显得更直观…...

【C语言指南】数据类型详解(上)——内置类型

💓 博客主页:倔强的石头的CSDN主页 📝Gitee主页:倔强的石头的gitee主页 ⏩ 文章专栏:《C语言指南》 期待您的关注 目录 引言 1. 整型(Integer Types) 2. 浮点型(Floating-Point …...

视频汇聚/视频存储/安防视频监控EasyCVR平台RTMP推流显示离线是什么原因?

视频汇聚/视频存储/安防视频监控EasyCVR视频汇聚平台兼容性强、支持灵活拓展,平台可提供视频远程监控、录像、存储与回放、视频转码、视频快照、告警、云台控制、语音对讲、平台级联等视频能力。 EasyCVR安防监控视频综合管理平台采用先进的网络传输技术࿰…...

联想电脑怎么开启vt_联想电脑开启vt虚拟化教程(附intel和amd主板开启方法)

最近使用联想电脑的小伙伴们问我,联想电脑怎么开启vt虚拟。大多数可以在Bios中开启vt虚拟化技术,当CPU支持VT-x虚拟化技术,有些电脑会自动开启VT-x虚拟化技术功能。而大部分的电脑则需要在Bios Setup界面中,手动进行设置ÿ…...

手把手教你使用YOLOv11训练自己数据集(含环境搭建 、数据集查找、模型训练)

一、前言 本文内含YOLOv11网络结构图 训练教程 推理教程 数据集获取等有关YOLOv11的内容! 官方代码地址:https://github.com/ultralytics/ultralytics/tree/main/ultralytics/cfg/models/11 二、整体网络结构图 三、环境搭建 项目环境如下…...

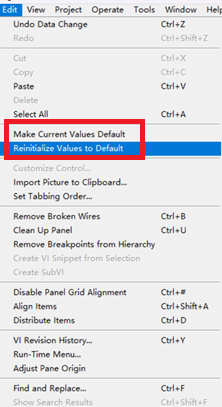

LabVIEW界面输入值设为默认值

在LabVIEW中,将前面板上所有控件的当前输入值设为默认值,可以通过以下步骤实现: 使用控件属性节点:你可以创建一个属性节点来获取所有控件的引用。 右键点击控件,选择“创建” > “属性节点”。 设置属性节点为“D…...

【Android 14源码分析】Activity启动流程-1

忽然有一天,我想要做一件事:去代码中去验证那些曾经被“灌输”的理论。 – 服装…...

Java 中 synchronized 和 Thread 的使用场合介绍

在 Java 编程中,synchronized 和 Thread 是处理并发与多线程编程的关键工具。多线程编程是为了在单一程序中并行执行多个任务,Java 提供了丰富的 API 和关键字以实现这一目标,而其中 synchronized 和 Thread 是非常基础和重要的部分。 synch…...

爬虫库是什么?是ip吗

爬虫库通常指的是用于网页爬虫(Web Scraping)开发的代码库或框架,它不是IP地址。以下是关于爬虫库的详细解释: 爬虫库的定义 爬虫库是一些用于简化网络数据抓取过程的工具和框架,通常提供了一系列函数和类࿰…...

【MySQL】查询原理 —— B+树查询数据全过程

使用B树作为索引结构的原因: 一种自平衡树: B树在插入和删除的时候节点会进行分裂和合并操作,以保持树的平衡,存在冗余节点,使得删除的时候树结构变化小,更高效。 高度不会增长过快,查询磁盘I…...

系统设置 WIFI输入框被挡住解决方案

文章目录 问题点复现的场景机器横屏可复现,竖屏不存在跟density 相关的。 解决问题方案设置输入模式路径 部分源码跟踪方法 延伸思考设置输入模式设置主题 问题点 进入系统设置-网络和互联网-WLAN-点击WIFI item ,密码输入框被遮挡,输入的密码不可见.如…...

SpringCloud无法注册Nacos和配置中心

今天升级SpringCloud版本,导致服务无法注册到nacos,使用nacos作为配置中心也无法刷新配置信息,后来发现是因为只更新了SpringCloud版本,SpringCloud-Alibaba没有更新导致的问题。 升级出现问题的版本是: <dependen…...

铭豹扩展坞 USB转网口 突然无法识别解决方法

当 USB 转网口扩展坞在一台笔记本上无法识别,但在其他电脑上正常工作时,问题通常出在笔记本自身或其与扩展坞的兼容性上。以下是系统化的定位思路和排查步骤,帮助你快速找到故障原因: 背景: 一个M-pard(铭豹)扩展坞的网卡突然无法识别了,扩展出来的三个USB接口正常。…...

Vue2 第一节_Vue2上手_插值表达式{{}}_访问数据和修改数据_Vue开发者工具

文章目录 1.Vue2上手-如何创建一个Vue实例,进行初始化渲染2. 插值表达式{{}}3. 访问数据和修改数据4. vue响应式5. Vue开发者工具--方便调试 1.Vue2上手-如何创建一个Vue实例,进行初始化渲染 准备容器引包创建Vue实例 new Vue()指定配置项 ->渲染数据 准备一个容器,例如: …...

土地利用/土地覆盖遥感解译与基于CLUE模型未来变化情景预测;从基础到高级,涵盖ArcGIS数据处理、ENVI遥感解译与CLUE模型情景模拟等

🔍 土地利用/土地覆盖数据是生态、环境和气象等诸多领域模型的关键输入参数。通过遥感影像解译技术,可以精准获取历史或当前任何一个区域的土地利用/土地覆盖情况。这些数据不仅能够用于评估区域生态环境的变化趋势,还能有效评价重大生态工程…...

前端开发面试题总结-JavaScript篇(一)

文章目录 JavaScript高频问答一、作用域与闭包1.什么是闭包(Closure)?闭包有什么应用场景和潜在问题?2.解释 JavaScript 的作用域链(Scope Chain) 二、原型与继承3.原型链是什么?如何实现继承&a…...

JDK 17 新特性

#JDK 17 新特性 /**************** 文本块 *****************/ python/scala中早就支持,不稀奇 String json “”" { “name”: “Java”, “version”: 17 } “”"; /**************** Switch 语句 -> 表达式 *****************/ 挺好的ÿ…...

Android 之 kotlin 语言学习笔记三(Kotlin-Java 互操作)

参考官方文档:https://developer.android.google.cn/kotlin/interop?hlzh-cn 一、Java(供 Kotlin 使用) 1、不得使用硬关键字 不要使用 Kotlin 的任何硬关键字作为方法的名称 或字段。允许使用 Kotlin 的软关键字、修饰符关键字和特殊标识…...

相比,优缺点是什么?适用于哪些场景?)

Redis的发布订阅模式与专业的 MQ(如 Kafka, RabbitMQ)相比,优缺点是什么?适用于哪些场景?

Redis 的发布订阅(Pub/Sub)模式与专业的 MQ(Message Queue)如 Kafka、RabbitMQ 进行比较,核心的权衡点在于:简单与速度 vs. 可靠与功能。 下面我们详细展开对比。 Redis Pub/Sub 的核心特点 它是一个发后…...

推荐 github 项目:GeminiImageApp(图片生成方向,可以做一定的素材)

推荐 github 项目:GeminiImageApp(图片生成方向,可以做一定的素材) 这个项目能干嘛? 使用 gemini 2.0 的 api 和 google 其他的 api 来做衍生处理 简化和优化了文生图和图生图的行为(我的最主要) 并且有一些目标检测和切割(我用不到) 视频和 imagefx 因为没 a…...

GruntJS-前端自动化任务运行器从入门到实战

Grunt 完全指南:从入门到实战 一、Grunt 是什么? Grunt是一个基于 Node.js 的前端自动化任务运行器,主要用于自动化执行项目开发中重复性高的任务,例如文件压缩、代码编译、语法检查、单元测试、文件合并等。通过配置简洁的任务…...

从“安全密码”到测试体系:Gitee Test 赋能关键领域软件质量保障

关键领域软件测试的"安全密码":Gitee Test如何破解行业痛点 在数字化浪潮席卷全球的今天,软件系统已成为国家关键领域的"神经中枢"。从国防军工到能源电力,从金融交易到交通管控,这些关乎国计民生的关键领域…...