LangChain4j系列—OpenAI开发实例

一、引入Maven依赖

1、纯Java

<dependency><groupId>dev.langchain4j</groupId><artifactId>langchain4j-open-ai</artifactId><version>0.35.0</version>

</dependency>2、Spring boot

<dependency><groupId>dev.langchain4j</groupId><artifactId>langchain4j-open-ai-spring-boot-starter</artifactId><version>0.35.0</version>

</dependency>二、API Key

要使用OpenAI模型,您需要一个API密钥。你可以在这里创建一个。

如果您没有自己的OpenAI API密钥,不要担心。您可以暂时使用演示密钥,我们为演示目的免费提供:

String apiKey = "demo";三、创建 OpenAiChatModel

1、纯Java

ChatLanguageModel model = OpenAiChatModel.builder().apiKey(System.getenv("OPENAI_API_KEY"))....build();这将使用默认模型参数(例如gpt-3.5-turbo模型名称、0.7温度等)创建OpenAiChatModel的实例。通过在生成器中提供值,可以自定义默认模型参数。

2、Spring Boot

配置application.properties:

langchain4j.open-ai.chat-model.api-key=${OPENAI_API_KEY}

langchain4j.open-ai.chat-model.base-url=...

langchain4j.open-ai.chat-model.custom-headers=...

langchain4j.open-ai.chat-model.frequency-penalty=...

langchain4j.open-ai.chat-model.log-requests=...

langchain4j.open-ai.chat-model.log-responses=...

langchain4j.open-ai.chat-model.logit-bias=...

langchain4j.open-ai.chat-model.max-retries=...

langchain4j.open-ai.chat-model.max-completion-tokens=...

langchain4j.open-ai.chat-model.max-tokens=...

langchain4j.open-ai.chat-model.model-name=...

langchain4j.open-ai.chat-model.organization-id=...

langchain4j.open-ai.chat-model.parallel-tool-calls=...

langchain4j.open-ai.chat-model.presence-penalty=...

langchain4j.open-ai.chat-model.proxy.host=...

langchain4j.open-ai.chat-model.proxy.port=...

langchain4j.open-ai.chat-model.proxy.type=...

langchain4j.open-ai.chat-model.response-format=...

langchain4j.open-ai.chat-model.seed=...

langchain4j.open-ai.chat-model.stop=...

langchain4j.open-ai.chat-model.strict-schema=...

langchain4j.open-ai.chat-model.strict-tools=...

langchain4j.open-ai.chat-model.temperature=...

langchain4j.open-ai.chat-model.timeout=...

langchain4j.open-ai.chat-model.top-p=

langchain4j.open-ai.chat-model.user=...请参阅上面的一些参数的描述。

此配置将创建OpenAiChatModel bean,它可以由AI服务使用,也可以在需要时自动连接,例如:

@RestController

class ChatLanguageModelController {ChatLanguageModel chatLanguageModel;ChatLanguageModelController(ChatLanguageModel chatLanguageModel) {this.chatLanguageModel = chatLanguageModel;}@GetMapping("/model")public String model(@RequestParam(value = "message", defaultValue = "Hello") String message) {return chatLanguageModel.generate(message);}

}四、结构化输出

工具和JSON模式都支持结构化输出功能。

1、工具的结构化输出

要为工具启用结构化输出功能,请在构建模型时设置.strictTools(true):

OpenAiChatModel.builder()....strictTools(true).build(),请注意,这将自动使所有工具参数都是必需的(在json模式中是必需的),并为json模式的每个对象设置additionalProperties=false。这是由于当前OpenAI的限制。

2、JSON模式的结构化输出

要为JSON模式启用结构化输出功能,请在构建模型时设置.responseFormat(“JSON_schema”)和.strictJsonSchema(true):

OpenAiChatModel.builder()....responseFormat("json_schema").strictJsonSchema(true).build(),在这种情况下,AiServices不会在最后一条UserMessage的末尾追加“You must answer strictly In the following JSON format:…”字符串,而是将从给定的POJO创建JSON模式,并将其传递给LLM。请注意,这仅在方法返回类型为POJO时有效。如果返回类型是其他类型(如枚举或List<String>),则应用旧的行为(“You must answer strictly…”)。在不久的将来,将支持所有返回类型。

五、创建OpenAiStreamingChatModel

1、纯Java

OpenAiStreamingChatModel model = OpenAiStreamingChatModel.builder().apiKey(System.getenv("OPENAI_API_KEY"))....build();2、Spring Boot

添加配置文件:

langchain4j.open-ai.streaming-chat-model.api-key=${OPENAI_API_KEY}

langchain4j.open-ai.streaming-chat-model.base-url=...

langchain4j.open-ai.streaming-chat-model.custom-headers=...

langchain4j.open-ai.streaming-chat-model.frequency-penalty=...

langchain4j.open-ai.streaming-chat-model.log-requests=...

langchain4j.open-ai.streaming-chat-model.log-responses=...

langchain4j.open-ai.streaming-chat-model.logit-bias=...

langchain4j.open-ai.streaming-chat-model.max-retries=...

langchain4j.open-ai.streaming-chat-model.max-completion-tokens=...

langchain4j.open-ai.streaming-chat-model.max-tokens=...

langchain4j.open-ai.streaming-chat-model.model-name=...

langchain4j.open-ai.streaming-chat-model.organization-id=...

langchain4j.open-ai.streaming-chat-model.parallel-tool-calls=...

langchain4j.open-ai.streaming-chat-model.presence-penalty=...

langchain4j.open-ai.streaming-chat-model.proxy.host=...

langchain4j.open-ai.streaming-chat-model.proxy.port=...

langchain4j.open-ai.streaming-chat-model.proxy.type=...

langchain4j.open-ai.streaming-chat-model.response-format=...

langchain4j.open-ai.streaming-chat-model.seed=...

langchain4j.open-ai.streaming-chat-model.stop=...

langchain4j.open-ai.streaming-chat-model.strict-schema=...

langchain4j.open-ai.streaming-chat-model.strict-tools=...

langchain4j.open-ai.streaming-chat-model.temperature=...

langchain4j.open-ai.streaming-chat-model.timeout=...

langchain4j.open-ai.streaming-chat-model.top-p=...

langchain4j.open-ai.streaming-chat-model.user=...六、创建OpenAiModerationModel

1、纯Java

ModerationModel model = OpenAiModerationModel.builder().apiKey(System.getenv("OPENAI_API_KEY"))....build();2、Spring Boot

langchain4j.open-ai.moderation-model.api-key=${OPENAI_API_KEY}

langchain4j.open-ai.moderation-model.base-url=...

langchain4j.open-ai.moderation-model.custom-headers=...

langchain4j.open-ai.moderation-model.log-requests=...

langchain4j.open-ai.moderation-model.log-responses=...

langchain4j.open-ai.moderation-model.max-retries=...

langchain4j.open-ai.moderation-model.model-name=...

langchain4j.open-ai.moderation-model.organization-id=...

langchain4j.open-ai.moderation-model.proxy.host=...

langchain4j.open-ai.moderation-model.proxy.port=...

langchain4j.open-ai.moderation-model.proxy.type=...

langchain4j.open-ai.moderation-model.timeout=...七、创建OpenAiTokenizer

1、纯Java

Tokenizer tokenizer = new OpenAiTokenizer();

// or

Tokenizer tokenizer = new OpenAiTokenizer("gpt-4o");2、Spring Boot

OpenAiTokenizer bean由Spring Boot启动器自动创建。

相关文章:

LangChain4j系列—OpenAI开发实例

一、引入Maven依赖 1、纯Java <dependency><groupId>dev.langchain4j</groupId><artifactId>langchain4j-open-ai</artifactId><version>0.35.0</version> </dependency> 2、Spring boot <dependency><groupId&g…...

Java 中简化操作集合的方法

在日常 Java 开发中,我们经常需要操作集合,如 List、Set 和 Map。虽然 Java 提供了丰富的集合框架供开发者使用,但在实际编写业务逻辑时,如何简化集合操作、提高代码可读性和效率,依然是一个经常遇到的问题。特别是随着…...

宗地结构)

ArcGIS Pro SDK (十七)宗地结构

ArcGIS Pro SDK (十七)宗地结构 环境:Visual Studio 2022 + .NET6 + ArcGIS Pro SDK 3.0 宗地结构 1 获取活动记录 string errorMessage = await QueuedTask.Run(() => {...

D. Co-growing Sequence

传送门:Problem - 1547D - Codeforces 题意:给定一个 数组 a , 构造一个数组 b ,使得 ( a[i] ^ b[i] ) & ( a[i 1] ^ b[ i 1] ) a[i] ^ b[i] 思路:(二进制题目) 设 a[i] ^ b[i] t 我们要让…...

docker配置加速器

阿里云 控制台》容器镜像服务》镜像工具》镜像加速器 复制地址:https://ywtoq7bz.mirror.aliyuncs.com 到:etc/docker下:vi daemon.json 格式: { "registry-mirrors": ["加速器地址"] } 注࿱…...

JS事件和DOM

1. DOM 1.1 基本概念 DOM,全称 Document Object Model,即文档对象模型。它是 Web 上最常用的 API 之一,是加载在浏览器中的文档模型,可以将文档表示为节点树(或称 DOM 树),其中每个节点代表文…...

CAS 详解

目录 Java 中 CAS 是如何实现的? CAS 算法存在哪些问题? ABA 问题 循环时间长开销大 只能保证一个共享变量的原子操作 Java 中 CAS 是如何实现的? 在 Java 中,实现 CAS(Compare-And-Swap, 比较并交换)操作的一个关键类是Unsafe。 Un…...

AI大模型那么火,教你一键Modelarts玩转开源LlaMA(羊驼)大模型

近日, LlaMA(羊驼) 这个大模型再次冲上热搜! LLaMA(Large Language Model Meta AI),由 Meta AI 发布的一个开放且高效的大型基础语言模型,共有 7B、13B、33B、65B(650 亿)四种版本。…...

Spring AI Alibaba: 支持国产大模型的Spring ai框架

Spring AI :java做ai应用的最好选择 过去,Java在AI应用开发方面缺乏一个高效且易于集成的框架,这限制了开发者快速构建和部署智能应用程序的能力。 Spring AI正是为解决这一问题而生,它提供了一套统一的接口,使得AI功…...

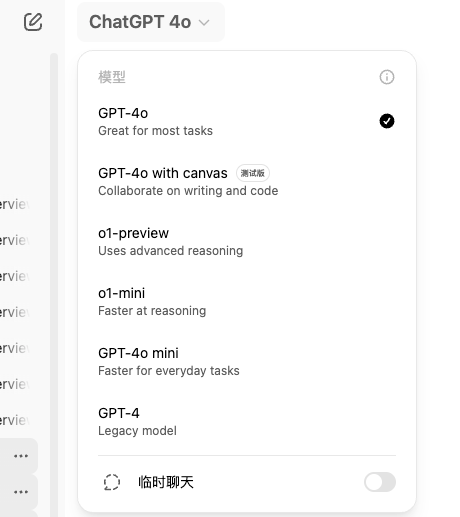

ChatGPT4o、o1 谁才是最佳大模型?

如何选择合适的 ChatGPT 模型?OpenAI 更新细节与 GPTs 的深入解析 随着人工智能的发展,ChatGPT 已成为众多用户的强大助手,广泛应用于写作、编程、学习和商业等多个领域。然而,面对 OpenAI 提供的众多模型(如 GPT-4、…...

[笔记] 关于CreateProcessWithLogonW函数创建进程

函数介绍 https://learn.microsoft.com/zh-cn/windows/win32/api/winbase/nf-winbase-createprocesswithlogonw BOOL CreateProcessWithLogonW([in] LPCWSTR lpUsername,[in, optional] LPCWSTR lpDomain,[in] …...

Ubuntu的Qt编译环境配置

1、找不到C和C编译器 利用run文件安装QT6.8.0和QT5.12.2版本后,打开QtCreator时,找不到编译器。 可在终端中查找gcc和g版本,如果没有就安装。 gcc --version g --version 如果没有就安装: sudo apt-get install gcc sudo apt-…...

12 django管理系统 - 注册与登录 - 登录

为了演示方便,我就直接使用models里的Admin来演示,不再创建用户模型了。 ok,先做基础配置 首先是在base.html中,新增登录和注册的入口 <ul class"nav navbar-nav navbar-right"><li><a href"/ac…...

2020年计算机网络408真题解析

第一题: 解析:OSI参考模型网络协议的三要素 网络协议的三要素:语法 ,语义,同步(时序) 语法:定义收发双方所交换信息的格式 语法:定义收发双方所要完成的操作 网页的加载 …...

速盾:cdn高防服务器防火墙的特性是什么?

CDN高防服务器防火墙是一种专门为互联网应用提供安全防护的网络安全设备。它采用先进的技术和算法,通过对网络流量进行过滤和检测,以防止恶意攻击和非法访问,保障网络服务的可用性和安全性。CDN高防服务器防火墙的特性主要包括以下几个方面&a…...

小程序分包和预加载

一、目的 分包的目的: 提升小程序的首屏加载速度,其原理和PC端网页的路由懒加载非常类似。即当我们第一个打开一个小程序的时候,只加载主包以及一些公共的资源,当调到某个页面的时候,在加载该页面所在的分包…...

【MATLAB 串口调试+虚拟串口测试】

文章目录 前言一、matlab 串口二、测试串口1.从系统中获取串口号2.避免串口打开被占用3. 安装虚拟串口4. 打开串口助手和MATALB 进行测试 总结 前言 提示:这里可以添加本文要记录的大概内容: 项目需要: 提示:以下是本篇文章正文…...

mac 安装最新版nginx

1. clone最新版本源代码: git clone https://github.com/nginx/nginx.git 2. 下载PCRE 没有PCRE那我们就下,下载地址:https://sourceforge.net/projects/pcre/files/pcre/,笔者下载的pcre-8.45.zip,下载之后解压到ngi…...

极氪汽车困局:营销频繁车、产品力不足

“ 极氪汽车的“车上吃火锅”营销活动虽登上热搜,但因频繁忽视老用户和产品力不足的争议,并未赢得消费者好感,反而加剧负面印象。 ” 科技新知 原创 作者丨颜瞾 编辑丨蕨影 近日,背靠吉利集团的极氪…...

Icecream 与 Python 日志库及性能分析整合指南

简介 Icecream 是一个用于简化 Python 调试过程的库,它允许开发者轻松打印变量名和它们的值。Python 的 logging 库则提供了一个强大的日志记录系统,用于跟踪应用程序的运行情况。而性能分析则是评估代码执行效率的重要手段。本指南将介绍如何将 Icecre…...

SkyWalking 10.2.0 SWCK 配置过程

SkyWalking 10.2.0 & SWCK 配置过程 skywalking oap-server & ui 使用Docker安装在K8S集群以外,K8S集群中的微服务使用initContainer按命名空间将skywalking-java-agent注入到业务容器中。 SWCK有整套的解决方案,全安装在K8S群集中。 具体可参…...

循环冗余码校验CRC码 算法步骤+详细实例计算

通信过程:(白话解释) 我们将原始待发送的消息称为 M M M,依据发送接收消息双方约定的生成多项式 G ( x ) G(x) G(x)(意思就是 G ( x ) G(x) G(x) 是已知的)࿰…...

MMaDA: Multimodal Large Diffusion Language Models

CODE : https://github.com/Gen-Verse/MMaDA Abstract 我们介绍了一种新型的多模态扩散基础模型MMaDA,它被设计用于在文本推理、多模态理解和文本到图像生成等不同领域实现卓越的性能。该方法的特点是三个关键创新:(i) MMaDA采用统一的扩散架构…...

指令的指南)

在Ubuntu中设置开机自动运行(sudo)指令的指南

在Ubuntu系统中,有时需要在系统启动时自动执行某些命令,特别是需要 sudo权限的指令。为了实现这一功能,可以使用多种方法,包括编写Systemd服务、配置 rc.local文件或使用 cron任务计划。本文将详细介绍这些方法,并提供…...

Module Federation 和 Native Federation 的比较

前言 Module Federation 是 Webpack 5 引入的微前端架构方案,允许不同独立构建的应用在运行时动态共享模块。 Native Federation 是 Angular 官方基于 Module Federation 理念实现的专为 Angular 优化的微前端方案。 概念解析 Module Federation (模块联邦) Modul…...

土地利用/土地覆盖遥感解译与基于CLUE模型未来变化情景预测;从基础到高级,涵盖ArcGIS数据处理、ENVI遥感解译与CLUE模型情景模拟等

🔍 土地利用/土地覆盖数据是生态、环境和气象等诸多领域模型的关键输入参数。通过遥感影像解译技术,可以精准获取历史或当前任何一个区域的土地利用/土地覆盖情况。这些数据不仅能够用于评估区域生态环境的变化趋势,还能有效评价重大生态工程…...

成都鼎讯硬核科技!雷达目标与干扰模拟器,以卓越性能制胜电磁频谱战

在现代战争中,电磁频谱已成为继陆、海、空、天之后的 “第五维战场”,雷达作为电磁频谱领域的关键装备,其干扰与抗干扰能力的较量,直接影响着战争的胜负走向。由成都鼎讯科技匠心打造的雷达目标与干扰模拟器,凭借数字射…...

)

Angular微前端架构:Module Federation + ngx-build-plus (Webpack)

以下是一个完整的 Angular 微前端示例,其中使用的是 Module Federation 和 npx-build-plus 实现了主应用(Shell)与子应用(Remote)的集成。 🛠️ 项目结构 angular-mf/ ├── shell-app/ # 主应用&…...

基于TurtleBot3在Gazebo地图实现机器人远程控制

1. TurtleBot3环境配置 # 下载TurtleBot3核心包 mkdir -p ~/catkin_ws/src cd ~/catkin_ws/src git clone -b noetic-devel https://github.com/ROBOTIS-GIT/turtlebot3.git git clone -b noetic https://github.com/ROBOTIS-GIT/turtlebot3_msgs.git git clone -b noetic-dev…...

安宝特案例丨Vuzix AR智能眼镜集成专业软件,助力卢森堡医院药房转型,赢得辉瑞创新奖

在Vuzix M400 AR智能眼镜的助力下,卢森堡罗伯特舒曼医院(the Robert Schuman Hospitals, HRS)凭借在无菌制剂生产流程中引入增强现实技术(AR)创新项目,荣获了2024年6月7日由卢森堡医院药剂师协会࿰…...