GPT(Generative Pre-trained Transformer) 和 Transformer的比较

GPT(Generative Pre-trained Transformer) 和 Transformer 的比较

flyfish

1. Transformer 是一种模型架构

Transformer 是一种通用的神经网络架构,由 Vaswani 等人在论文 “Attention Is All You Need”(2017)中提出。其核心特点是完全基于注意力机制(Self-Attention)进行信息建模,去除了传统的 RNN/CNN 结构。

Transformer 的关键特点

- 结构分为两部分:

- 编码器(Encoder):将输入序列映射为上下文相关的隐藏表示。

- 解码器(Decoder):根据编码器输出和先前的目标序列生成新的序列(如翻译、文本生成)。

- 核心模块:

- 多头自注意力机制(Multi-Head Self-Attention):捕捉输入序列中不同部分的关系。

- 位置编码(Positional Encoding):补偿 Transformer 缺乏序列信息的短板。

- 前馈神经网络(Feed-Forward Networks, FFN):对注意力输出进一步处理。

- 层归一化和残差连接(Layer Normalization & Residual Connections):缓解深层网络训练难题。

Transformer 的用途

- 通用框架:Transformer 可以用于任意需要序列到序列建模的任务,比如机器翻译、文本分类、问答系统等。

2. GPT 是一种基于 Transformer 的特化模型

GPT 是 OpenAI 在 Transformer 架构基础上进行设计和优化的一种特化模型,用于生成任务(如语言建模和文本生成)。

GPT 的特点

-

仅使用 Transformer 的解码器部分

- GPT 舍弃了完整 Transformer 的编码器-解码器结构,仅保留了解码器。

- 解码器适用于自回归任务(Autoregressive Tasks),即依赖之前的上下文生成下一步输出。

-

自回归生成方式

- GPT 是通过自回归语言建模(Autoregressive Language Modeling)训练的,预测下一个单词的概率:

P ( x 1 , x 2 , … , x T ) = ∏ t = 1 T P ( x t ∣ x 1 , x 2 , … , x t − 1 ) P(x_1, x_2, \dots, x_T) = \prod_{t=1}^{T} P(x_t | x_1, x_2, \dots, x_{t-1}) P(x1,x2,…,xT)=t=1∏TP(xt∣x1,x2,…,xt−1)

- GPT 是通过自回归语言建模(Autoregressive Language Modeling)训练的,预测下一个单词的概率:

-

预训练和微调

- 预训练(Pretraining):在大规模无监督文本语料上进行语言建模训练,捕捉通用语言知识。

- 微调(Fine-tuning):在具体任务上使用监督数据进行调整,使模型适应特定任务。

-

改进的训练技巧

- GPT 引入了一些针对解码器的优化,比如改进的初始化、梯度截断、动态批量大小调整等。

3. 核心区别

| 方面 | Transformer | GPT |

|---|---|---|

| 结构 | 编码器 + 解码器 | 仅使用解码器 |

| 训练目标 | 通用,适配不同任务 | 自回归语言建模(预测下一个词) |

| 适用任务 | 序列到序列任务(翻译、分类、问答等) | 文本生成、对话、补全 |

| 输入依赖 | 输入序列可以双向(编码器)或单向(解码器) | 输入序列只能是单向(自回归) |

| 位置编码方式 | 标准位置编码 | 类似,但可以调整为适配任务的变体 |

| 应用扩展 | 通用框架,用于 NLP、CV 等领域 | 专注于语言生成,适配特定的下游任务 |

4. GPT 和 Transformer 的关系

- GPT 是 Transformer 的子集:GPT 基于 Transformer 的解码器部分设计,是一种专注于生成任务的特化模型。

- 架构优化:虽然 GPT 继承了 Transformer 的基本架构,但针对生成任务和大规模预训练场景进行了优化。

- 功能聚焦:Transformer 是通用的序列建模工具,而 GPT 是针对语言生成任务的具体实现。

解释GPT 只有解码器的原因

1. Transformer 的全貌:编码器和解码器

Transformer 是一种深度学习架构,由 编码器(Encoder) 和 解码器(Decoder) 组成。这种架构最初由 Vaswani 等人在 2017 年提出,专门为序列到序列(Seq2Seq)任务设计,如机器翻译。我们先来看这两个部分的功能:

1.1 编码器(Encoder)

编码器的任务是将输入序列(如原文句子)转换为一组上下文相关的表示(高维向量),捕捉输入序列的语义。

- 输入:输入序列 ( X = (x_1, x_2, …, x_n) )。

- 处理:

- 利用注意力机制(Self-Attention)计算输入序列中不同位置的关联关系。

- 输出一组高维向量,代表输入序列的上下文语义。

- 输出:编码后的表示(Contextual Representation)。

1.2 解码器(Decoder)

解码器的任务是根据编码器的输出和已生成的部分序列,逐步生成目标序列。

- 输入:

- 编码器的输出(从输入序列提取的语义)。

- 当前已生成的目标序列(作为解码器的上下文)。

- 处理:

- 结合编码器输出和解码器内部的自注意力(Self-Attention),捕捉上下文关系。

- Masking 机制确保生成是因果性的:当前生成位置不能访问未来位置。

- 输出:目标序列(如翻译后的句子)。

2. Transformer 的典型任务:机器翻译

Transformer 最初设计是为了解决机器翻译问题,比如将一个法语句子翻译成英语。这需要两个关键步骤:

- 编码器提取原句的语义表示。

- 解码器利用这些语义信息,生成目标语言的句子。

举例:

- 输入(法语):

Je mange une pomme. - 编码器输出:句子的语义表示(向量)。

- 解码器生成(英语):

I am eating an apple.

因此,编码器负责理解,解码器负责生成。

3. GPT 的目标任务:语言生成

GPT 的目标并不是像机器翻译那样,需要对输入语句进行“理解”后生成目标语句。GPT 是一个语言生成模型,其任务是根据已给定的上下文生成下一步的输出。

3.1 任务特点

- GPT 只需要一个输入序列(上下文),然后从头到尾生成输出序列。

- 生成是逐步进行的,比如:

- 输入:

Once upon a time, there was a king who - 输出:

Once upon a time, there was a king who ruled a prosperous kingdom.

- 输入:

3.2 自回归建模

GPT 使用自回归语言建模(Autoregressive Language Modeling),它的核心是逐步预测下一个单词 (x_t),只依赖前面的单词:

P ( x 1 , x 2 , … , x T ) = ∏ t = 1 T P ( x t ∣ x 1 , x 2 , … , x t − 1 ) P(x_1, x_2, \dots, x_T) = \prod_{t=1}^T P(x_t | x_1, x_2, \dots, x_{t-1}) P(x1,x2,…,xT)=t=1∏TP(xt∣x1,x2,…,xt−1)

这种逐步预测的方法是一个典型的生成过程。

4. 为什么只保留解码器?

GPT 将 Transformer 的架构调整为仅保留了解码器,这是因为它的任务特点决定了编码器是冗余的,解码器已经完全能满足需求。以下分几个方面详细展开:

4.1 编码器的角色对 GPT 的任务无用

编码器的主要作用是压缩输入序列,提取全局语义信息。这对于翻译、文本分类等任务至关重要,但对于语言生成来说:

- 输入序列就是生成序列的上下文,它直接参与生成过程。

- GPT 不需要“理解”或“压缩”输入,只需在每一步基于已有上下文生成下一个单词。

- 解码器通过自注意力机制(Self-Attention)已经能够捕捉输入的上下文信息,无需编码器额外的处理。

4.2 解码器的 Masked Attention

解码器内置的 Masked Attention 机制确保生成过程是因果一致的,即预测当前单词时只依赖于之前的单词。这种设计让解码器能够单独完成生成任务,而不需要编码器的辅助。

4.3 简化架构,提高效率

- 如果保留编码器,模型需要处理输入的编码以及解码器与编码器的交互,增加计算复杂度。

- 去掉编码器后,模型的参数更少,训练和推理更高效。

4.4 专注生成任务

GPT 的设计目标是生成自然语言,而不是在输入和输出之间建立映射(如翻译任务)。解码器专注于生成,符合语言建模任务的特点。

5. 解码器如何完成任务?

只保留解码器的 GPT 通过以下机制完成语言生成:

5.1 自注意力(Self-Attention)

- 让解码器能够动态捕捉输入序列中各单词之间的关联关系。

- 对于生成任务,自注意力允许模型根据上下文生成连贯的文本。

5.2 Masked Self-Attention

- 屏蔽掉当前位置之后的单词,确保生成符合因果性。

- 每一步生成只依赖于之前生成的部分。

5.3 多层解码器堆叠

- 解码器的多层结构让模型能够捕捉更深层次的语言模式,如句法结构、语义关联等。

5.4 Softmax 输出与下一个单词的采样

- 解码器最后通过 Softmax 生成下一个单词的概率分布。

- 根据概率采样(或选择最大概率)生成最终的输出。

相关文章:

和 Transformer的比较)

GPT(Generative Pre-trained Transformer) 和 Transformer的比较

GPT(Generative Pre-trained Transformer) 和 Transformer 的比较 flyfish 1. Transformer 是一种模型架构 Transformer 是一种通用的神经网络架构,由 Vaswani 等人在论文 “Attention Is All You Need”(2017)中提…...

软件无线电(SDR)的架构及相关术语

今天简要介绍实现无线电系统调制和解调的主要方法,这在软件定义无线电(SDR)的背景下很重要。 外差和超外差 无线电发射机有两种主要架构——一种是从基带频率直接调制到射频频率(称为外差),而第二种超外差是通过两个调制阶段来实…...

Python将Excel文件转换为JSON文件

工作过程中,需要从 Excel 文件中读取数据,然后交给 Python 程序处理数据,中间需要把 Excel 文件读取出来转为 json 格式,再进行下一步数据处理。 这里我们使用pandas库,这是一个强大的数据分析工具,能够方便地读取和处理各种数据格式。需要注意的是还需要引入openpyxl库,…...

排序算法之选择排序篇

思想: 每次从未排序的部分找出最小的元素,将其放到已排序部分的末尾 从数据结构中找到最小值,放到第一位,放到最前面,之后再从剩下的元素中找出第二小的值放到第二位,以此类推。 实现思路: 遍…...

sizeof和strlen区分,(好多例子)

sizeof算字节大小 带\0 strlen算字符串长度 \0之前...

A050-基于spring boot物流管理系统设计与实现

🙊作者简介:在校研究生,拥有计算机专业的研究生开发团队,分享技术代码帮助学生学习,独立完成自己的网站项目。 代码可以查看文章末尾⬇️联系方式获取,记得注明来意哦~🌹 赠送计算机毕业设计600…...

[自然语言处理] NLP-RNN及其变体-干货

一、认识RNN模型 1 什么是RNN模型 RNN(Recurrent Neural Network), 中文称作循环神经网络, 它一般以序列数据为输入, 通过网络内部的结构设计有效捕捉序列之间的关系特征, 一般也是以序列形式进行输出. 一般单层神经网络结构: RNN单层网络结构: 以时间步对RNN进行展开后的单层…...

Elasticsearch ILM 索引生命周期管理讲解与实战

ES ILM 索引生命周期管理讲解与实战 Elasticsearch ILM索引生命周期管理:深度解析与实战演练1. 引言1.1 背景介绍1.2 研究意义2. ILM核心概念2.1 ILM的四个阶段2.1.1 Hot阶段2.1.2 Warm阶段2.1.3 Cold阶段2.1.4 Delete阶段3. ILM实战指南3.1 定义ILM策略3.1.1 创建ILM策略3.1.…...

重塑视频新语言,让每一帧都焕发新生——Video-Retalking,开启数字人沉浸式交流新纪元!

模型简介 Video-Retalking 模型是一种基于深度学习的视频再谈话技术,它通过分析视频中的音频和图像信息,实现视频角色口型、表情乃至肢体动作的精准控制与合成。这一技术的实现依赖于强大的技术架构和核心算法,特别是生成对抗网络࿰…...

联想Lenovo SR650服务器硬件监控指标解读

随着企业IT架构的复杂性和业务需求的增长,服务器的稳定运行变得至关重要。联想Lenovo SR650服务器以其高性能和稳定性,在各类应用场景中发挥着关键作用。为了保障服务器的稳定运行,监控易作为一款专业的IT基础设施监控软件,为联想…...

二十一、QT C++

1.1QT介绍 1.1.1 QT简介 Qt 是一个跨平台的应用程序和用户界面框架,用于开发图形用户界面(GUI)应用程序以及命令行工具。它最初由挪威的 Trolltech (奇趣科技)公司开发,现在由 Qt Company 维护ÿ…...

微服务上下线动态感知实现的技术解析

序言 随着微服务架构的广泛应用,服务的动态管理和监控变得尤为重要。在微服务架构中,服务的上下线是一个常见的操作,如何实时感知这些变化,确保系统的稳定性和可靠性,成为了一个关键技术挑战。本文将深入探讨微服务上…...

指针与引用错题汇总

int *p[3]; // 定义一个包含 3 个指向 int 的指针的数组int a 10, b 20, c 30; p[0] &a; // p[0] 指向 a p[1] &b; // p[1] 指向 b p[2] &c; // p[2] 指向 c // 访问指针所指向的值 printf("%d %d %d\n", *p[0], *p[1], *p[2]); // 输出: 10 20 30…...

短视频账号矩阵系统源码--独立saas技术部署

短视频矩阵系统通过多账号在多个平台上发布内容,形成一种网络效应。对于抖音平台而言,技术公司需具备特定接口权限方能进行开发工作。然而,视频发布及企业号评论与回复等功能的接口权限往往难以获取。通过构建抖音账号矩阵,利用多…...

leaflet 介绍

目录 一、leaflet 官网 二、leaflet 在项目中的引用 1、在head中引入 2、在main.js中引入 leaflet目前版本是1.9.4,在leaflet插件库中,很多插件因长时间未更新,适配的是1.7版本的,在选用插件的时候要查看版本适配。 leaflet详…...

总结贴:Servlet过滤器、MVC拦截器

一:Servlet过滤器 1.1解析 Filter 即为过滤,用于请求到达Servlet之前(Request),以及再Servlet方法执行完之后返回客户端进行后处理(HttpServletResponse)。简单说就是对请求进行预处理,对响应进行后处理 在请求到达Servlet之前,可以经过多个Filt…...

鸿蒙开发:自定义一个任意位置弹出的Dialog

前言 鸿蒙开发中,一直有个问题困扰着自己,想必也困扰着大多数开发者,那就是,系统提供的dialog自定义弹窗,无法实现在任意位置进行弹出,仅限于CustomDialog和Component struct的成员变量,这就导致…...

在Windows下编译支持https的wsdl2h

下载源码 在官网下载源码 安装Openssl 下载OpenSSL并安装,安装完成后需要将OpenSSL的路径添加到环境变量中 配置VS 1、打开工程 2、因为前面安装的OpenSLL是64位的,因此需要创建一个X64的配置 打开配置管理器,然后选择新建࿰…...

PHP和GD库如何根据像素绘制图形

使用PHP和GD库,你可以根据像素绘制各种图形,比如点、线、矩形、圆形等。GD库是PHP的一个扩展,它提供了一系列用于创建和处理图像的函数。以下是一个简单的示例,展示如何使用GD库根据像素绘制图形。 安装GD库 首先,确…...

webpack(react)基本构建

文章目录 概要整体架构流程技术名词解释技术细节小结 概要 Webpack 是一个现代 JavaScript 应用程序的静态模块打包工具。它的主要功能是将各种资源(如 JavaScript、CSS、图片等)视为模块,并将它们打包成一个或多个输出文件,以便…...

基于距离变化能量开销动态调整的WSN低功耗拓扑控制开销算法matlab仿真

目录 1.程序功能描述 2.测试软件版本以及运行结果展示 3.核心程序 4.算法仿真参数 5.算法理论概述 6.参考文献 7.完整程序 1.程序功能描述 通过动态调整节点通信的能量开销,平衡网络负载,延长WSN生命周期。具体通过建立基于距离的能量消耗模型&am…...

以下是对华为 HarmonyOS NETX 5属性动画(ArkTS)文档的结构化整理,通过层级标题、表格和代码块提升可读性:

一、属性动画概述NETX 作用:实现组件通用属性的渐变过渡效果,提升用户体验。支持属性:width、height、backgroundColor、opacity、scale、rotate、translate等。注意事项: 布局类属性(如宽高)变化时&#…...

解决Ubuntu22.04 VMware失败的问题 ubuntu入门之二十八

现象1 打开VMware失败 Ubuntu升级之后打开VMware上报需要安装vmmon和vmnet,点击确认后如下提示 最终上报fail 解决方法 内核升级导致,需要在新内核下重新下载编译安装 查看版本 $ vmware -v VMware Workstation 17.5.1 build-23298084$ lsb_release…...

关于iview组件中使用 table , 绑定序号分页后序号从1开始的解决方案

问题描述:iview使用table 中type: "index",分页之后 ,索引还是从1开始,试过绑定后台返回数据的id, 这种方法可行,就是后台返回数据的每个页面id都不完全是按照从1开始的升序,因此百度了下,找到了…...

令牌桶 滑动窗口->限流 分布式信号量->限并发的原理 lua脚本分析介绍

文章目录 前言限流限制并发的实际理解限流令牌桶代码实现结果分析令牌桶lua的模拟实现原理总结: 滑动窗口代码实现结果分析lua脚本原理解析 限并发分布式信号量代码实现结果分析lua脚本实现原理 双注解去实现限流 并发结果分析: 实际业务去理解体会统一注…...

vulnyx Blogger writeup

信息收集 arp-scan nmap 获取userFlag 上web看看 一个默认的页面,gobuster扫一下目录 可以看到扫出的目录中得到了一个有价值的目录/wordpress,说明目标所使用的cms是wordpress,访问http://192.168.43.213/wordpress/然后查看源码能看到 这…...

PHP 8.5 即将发布:管道操作符、强力调试

前不久,PHP宣布了即将在 2025 年 11 月 20 日 正式发布的 PHP 8.5!作为 PHP 语言的又一次重要迭代,PHP 8.5 承诺带来一系列旨在提升代码可读性、健壮性以及开发者效率的改进。而更令人兴奋的是,借助强大的本地开发环境 ServBay&am…...

淘宝扭蛋机小程序系统开发:打造互动性强的购物平台

淘宝扭蛋机小程序系统的开发,旨在打造一个互动性强的购物平台,让用户在购物的同时,能够享受到更多的乐趣和惊喜。 淘宝扭蛋机小程序系统拥有丰富的互动功能。用户可以通过虚拟摇杆操作扭蛋机,实现旋转、抽拉等动作,增…...

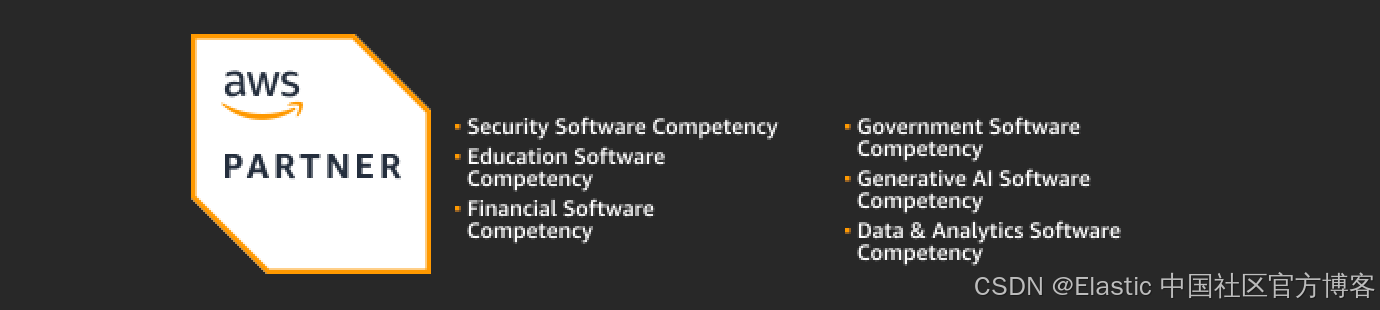

Elastic 获得 AWS 教育 ISV 合作伙伴资质,进一步增强教育解决方案产品组合

作者:来自 Elastic Udayasimha Theepireddy (Uday), Brian Bergholm, Marianna Jonsdottir 通过搜索 AI 和云创新推动教育领域的数字化转型。 我们非常高兴地宣布,Elastic 已获得 AWS 教育 ISV 合作伙伴资质。这一重要认证表明,Elastic 作为 …...

FFmpeg avformat_open_input函数分析

函数内部的总体流程如下: avformat_open_input 精简后的代码如下: int avformat_open_input(AVFormatContext **ps, const char *filename,ff_const59 AVInputFormat *fmt, AVDictionary **options) {AVFormatContext *s *ps;int i, ret 0;AVDictio…...