基于python对网页进行爬虫简单教程

python对网页进行爬虫

基于BeautifulSoup的爬虫—源码

"""

基于BeautifulSoup的爬虫###?一、BeautifulSoup简介1.?Beautiful?Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

2.?Beautiful?Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful

3.?Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。

4.?Beautiful?Soup已成为和lxml、html6lib一样出色的python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

5.?BS基于DOM结构进行页面内容解析,当开始解析时,会将整个页面的DOM树保存于内存中,进而实现查找。

解析器:

1.?Python标准库?BeautifulSoup(markup,?"html.parser")?-?Python的内置标准库,执行速度适中,文档容错能力强

2.?lxml?HTML解析器?BeautifulSoup(markup,?"lxml")?-?速度快,文档容错能力强,需要安装C语言库

3.?lxml?XML解析器?BeautifulSoup(markup,?"xml")?-?速度快,唯一支持XML的解析器,需要安装C语言库

4.?html5lib?BeautifulSoup(markup,?"html5lib")?-?最好的容错性,以浏览器的方式解析文档,生成HTML5格式的文档,速度慢,不依赖外部扩展###?二、具体代码使用

"""

from?bs4?import?BeautifulSoup

import?requestsresp?=?requests.get('https://www.cnblogs.com/leyinsec')#?初始化解析器

html?=?BeautifulSoup(resp.text,?'lxml')#?查找页面元素,根据标签层次进行查找

#?print(html.head.title)

#?print(html.head.title.string)

#?print(html.div)

#?print(html.div.div)

#?查找页面元素的通用方法,find_all,select#?查找页面所有超链接

def?html_href():

????links?=?html.find_all('a')

????for?link?in?links:

????????try:

????????????print(link['href'])

????????except?KeyError:

????????????print("No?href?attribute?found?for?this?tag")#?查找页面图片

def?html_images():

????images?=?html.find_all('img')

????for?image?in?images:

????????print(image['src'])"""

#?根据id或calss等属性查找

keyword?=?html.find_all(id='keyword')

print(keyword)

print(keyword['placeholder'])#?根据title查找

titles?=?html.find_all(class_='title')

for?title?in?titles:

????print(title)

????print(title.find('a'))#?根据text查找

title?=?html.find(text='leyinsec')

print(title.parent)#?根据xpath的风格进行查找?//[@class='title'?and/or?@id=1]

titles?=?html.find_all('div',?{'class':?'title'})

for?title?in?titles:

????print(title)

????

#?css选择器

titles?=?html.select('div.title')

for?title?in?titles:

????print(title)

????

#?css选择器查找id

keyword?=?html.select('#keyword')

try:

????print(keyword['placeholder'])

except?TypeError:

????print("No?keyword?attribute?found?for?this?tag")#?列表查找

lis?=?html.select('ul?li')

print(lis)

"""if?__name__?==?'__main__':

????html_images()

基于BeautifulSoup的爬虫—源码解析

这段代码是一个基于BeautifulSoup库的简单爬虫示例,用于从指定的网页中提取超链接和图片链接。下面是对代码的详细分析:

导入库

from?bs4?import?BeautifulSoup

import?requests

这两行代码导入了编写爬虫所需的两个库:BeautifulSoup用于解析HTML文档,requests用于发送HTTP请求。

发送HTTP请求

resp?=?requests.get('https://www.cnblogs.com/leyinsec')

这行代码使用requests库向指定的URL发送GET请求,并将响应存储在变量resp中。

解析HTML文档

html?=?BeautifulSoup(resp.text,?'lxml')

这行代码使用BeautifulSoup解析HTTP响应中的文本内容。这里使用了’lxml’作为解析器,因为它通常比Python内置的解析器更快且具有更好的容错性。

定义查找页面元素的函数

查找所有超链接

def?html_href():

????links?=?html.find_all('a')

????for?link?in?links:

????????try:

????????????print(link['href'])

????????except?KeyError:

????????????print("No?href?attribute?found?for?this?tag")

这个函数查找HTML文档中所有的<a>标签,并尝试打印出每个链接的href属性。如果某个<a>标签没有href属性,则会捕获KeyError异常并打印一条消息。

查找所有图片

def?html_images():

????images?=?html.find_all('img')

????for?image?in?images:

????????print(image['src'])

这个函数查找HTML文档中所有的<img>标签,并打印出每个图片的src属性。

根据属性查找元素

keyword?=?html.find_all(id='keyword')

print(keyword)

print(keyword['placeholder'])

这段代码尝试查找具有特定id属性的元素,并打印出该元素及其placeholder属性。但是这里有一个错误:keyword是一个列表,所以不能直接使用keyword['placeholder']。应该遍历列表并分别访问每个元素的属性。

根据类名查找元素

titles?=?html.find_all(class_='title')

for?title?in?titles:

????print(title)

????print(title.find('a'))

这段代码查找所有具有title类的元素,并打印出这些元素及其内部包含的<a>标签。

根据文本查找元素

title?=?html.find(text='leyinsec')

print(title.parent)

这段代码查找文本内容为leyinsec的元素,并打印出该元素的父元素。

使用CSS选择器查找元素

titles?=?html.select('div.title')

for?title?in?titles:

????print(title)

这段代码使用CSS选择器语法查找所有具有title类的<div>元素,并打印它们。

查找具有特定ID的元素

keyword?=?html.select('#keyword')

try:

????print(keyword['placeholder'])

except?TypeError:

????print("No?keyword?attribute?found?for?this?tag")

这段代码试图查找具有特定ID的元素,并打印其placeholder属性。但是这里同样有一个错误:keyword是一个列表,所以不能直接使用keyword['placeholder']。应该遍历列表并分别访问每个元素的属性。

列表查找

lis?=?html.select('ul?li')

print(lis)

这段代码查找所有在<ul>标签内的<li>元素,并打印出这个列表。

主函数调用

if?__name__?==?'__main__':

????html_images()

这段代码确保当脚本作为主程序运行时,调用html_images()函数来执行图片链接的查找和打印。

总结

这段代码展示了如何使用BeautifulSoup库来解析HTML文档,并通过不同的方法查找和提取页面元素。需要注意的是,代码中有一些错误需要修正,特别是在处理查找结果为列表的情况时。此外,代码中没有处理网络请求可能出现的异常,例如连接错误或HTTP错误状态码。在实际应用中,应该添加适当的异常处理来提高代码的健壮性。

基于正则表达式的爬虫—源码

"""

基于正则表达式的爬虫以下是提取的文章内容:###?一、爬虫简介1.?**搜索引擎**:百度,谷歌,企业内部的知识库,某些项目专项数据爬取,专业的数据爬取。

2.?**互联网**:

???-?公网(不需要授权的情况就可以浏览的内容,搜索引擎的重点)

???-?深网(需要授权才能使用的内容)

???-?暗网(非正式渠道,无法使用常规手段访问)

3.?**爬取互联网的公开信息**,但是正常情况下,也需要遵守一个规则:robots协议:[https://www.baidu.com/robots.txt](https://www.baidu.com/robots.txt)(君子协议)###?二、基本原理1.?**所有和网页,均是HTML**:

???-?HTML首先是一个大的字符串,可以按照字符串处理的方式对响应进行解析处理。

???-?其次,HTML本身也是一门标记语言,与XML是同宗同源,所以可以使用DOM对其文本进行处理。

2.?**所有的爬虫,核心基于超链接**,进而实现网站和网页的跳转。给我一个网站,爬遍全世界。

3.?**如果要实现一个整站爬取**,首先要收集到站内所有网址,并且将重复网址去重,开始爬取内容并保存在本地数据库,进行实现后续目标。

###?三、正则表达式实现

"""

import?re

import?timeimport?requestsdef?download_page():

????resp?=?requests.get('https://www.cnblogs.com/leyinsec')

????#?解析网页所有超链接

????links?=?re.findall('<a?href="(.+?)"',?resp.text)

????for?link?in?links:

????????#?排除无用链接

????????if?'postid'?in?link?or?'archive'?in?link:

????????????continue

????????elif?link.startswith('javascript'):

????????????continue

????????#?将页面文件保存在本地

????????resp?=?requests.get(link)

????????resp.encoding?=?'utf-8'

????????filename?=?link.split('/')[-1]?+?time.strftime("_%Y%m%d_%H%M%S")?+?'.html'

????????with?open(f'page/leyinsec博客园/{filename}',?'w',?encoding='utf-8')?as?file:

????????????file.write(resp.text)def?download_images():

????resp?=?requests.get('https://www.cnblogs.com/leyinsec')

????images?=?re.findall('<img?src="(.+?)"',?resp.text)

????for?image?in?images:

????????if?image.startswith('/'):

????????????image?=?'https://www.cnblogs.com/leyinsec'?+?image

????#?下载图片

????????resp?=?requests.get(image)

????????filename?=?time.strftime("_%Y%m%d_%H%M%S")?+?image.split('/')[-1]

????????with?open('page/leyinsec博客园/photos/'?+?filename,?'wb')?as?file:

????????????file.write(resp.content)if?__name__?==?'__main__':

????download_page()

????download_images()

基于正则表达式的爬虫—源码解析

这段代码是一个简单的基于正则表达式的爬虫,用于从指定的网页中提取超链接和图片链接,并将它们保存到本地文件系统中。下面是对代码的详细分析:

导入库

import?re

import?time

import?requests

这三行代码导入了编写爬虫所需的三个库:re用于处理正则表达式,time用于处理时间相关的功能,requests用于发送HTTP请求。

下载网页内容的函数

def?download_page():

????resp?=?requests.get('https://www.cnblogs.com/leyinsec')

????#?解析网页所有超链接

????links?=?re.findall('<a?href="(.+?)"',?resp.text)

????for?link?in?links:

????????#?排除无用链接

????????if?'postid'?in?link?or?'archive'?in?link:

????????????continue

????????elif?link.startswith('javascript'):

????????????continue

????????#?将页面文件保存在本地

????????resp?=?requests.get(link)

????????resp.encoding?=?'utf-8'

????????filename?=?link.split('/')[-1]?+?time.strftime("_%Y%m%d_%H%M%S")?+?'.html'

????????with?open(f'page/leyin?sec博客园/{filename}',?'w',?encoding='utf-8')?as?file:

????????????file.write(resp.text)

这个函数首先发送一个GET请求到指定的URL,然后使用正则表达式查找所有的超链接。对于每个找到的链接,它会检查链接是否包含特定的字符串(如’postid’或’archive’),或者是否以’javascript’开头,如果是,则跳过该链接。对于其他链接,它会发送另一个GET请求以获取网页内容,并将其保存到本地文件系统中,文件名包含时间戳以确保唯一性。

下载图片的函数

def?download_images():

????resp?=?requests.get('https://www.cnblogs.com/leyinsec')

????images?=?re.findall('<img?src="(.+?)"',?resp.text)

????for?image?in?images:

????????if?image.startswith('/'):

????????????image?=?'https://www.cnblogs.com/leyinsec'?+?image

????#?下载图片

????????resp?=?requests.get(image)

????????filename?=?time.strftime("_%Y%m%d_%H%M%S")?+?image.split('/')[-1]

????????with?open('page/leyinsec博客园/photos/'?+?filename,?'wb')?for?file:

????????????file.write(resp.content)

这个函数的工作方式与download_page函数类似,但是它查找的是<img>标签中的src属性。对于每个找到的图片链接,如果链接是相对路径(以’/'开头),它会将其转换为绝对路径。然后,它会发送GET请求以下载图片,并将其保存到本地文件系统中,文件名同样包含时间戳。

主函数调用

if?__name__?==?'__main__':

????download_page()

????download_images()

这段代码确保当脚本作为主程序运行时,调用download_page()和download_images()函数来执行网页内容和图片的下载。

注意事项和潜在问题

-

硬编码的URL:代码中硬编码了要爬取的网站URL,这限制了脚本的通用性。

-

缺乏异常处理:代码中没有处理网络请求可能出现的异常,例如连接错误或HTTP错误状态码。

-

缺乏robots.txt检查:代码没有检查目标网站的robots.txt文件,这可能会违反网站的爬虫政策。

-

文件路径错误:在

download_page函数中,文件路径字符串有一个小错误,leyin?sec应该是leyinsec。 -

重复下载:代码没有实现去重逻辑,可能会下载重复的网页或图片。

-

编码问题:代码假设所有网页和图片都可以使用UTF-8编码,这可能不总是正确的。

-

性能问题:对于大型网站,这种简单的递归下载方法可能会导致大量的并发请求,从而对目标服务器造成压力。

总结

这段代码展示了如何使用正则表达式和requests库来爬取网页内容和图片,并将它们保存到本地。然而,代码中存在一些问题和潜在的改进空间,特别是在异常处理、遵守robots.txt规则、错误处理和性能方面。在实际应用中,应该考虑这些问题,并采取相应的措施来提高代码的健壮性和效率。

相关文章:

基于python对网页进行爬虫简单教程

python对网页进行爬虫 基于BeautifulSoup的爬虫—源码 """ 基于BeautifulSoup的爬虫###?一、BeautifulSoup简介1.?Beautiful?Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供…...

【JavaEE进阶】@RequestMapping注解

目录 📕前言 🌴项目准备 🌲建立连接 🚩RequestMapping注解 🚩RequestMapping 注解介绍 🎄RequestMapping是GET还是POST请求? 🚩通过Fiddler查看 🚩Postman查看 …...

【WebAR-图像跟踪】在Unity中基于Imagine WebAR实现AR图像识别

写在前面的话 感慨一下, WebXR的发展是真的快,20年的时候,大多都在用AR.js做WebAR。随着WebXR标准发展,现在诸如Threejs、AFrame、Unity等多个平台都支持里WebXR。 本文将介绍在Unity中使用 Image Tracker实现Web端的AR图像识别功…...

向bash shell脚本传参

例子: ~ script % touch parameter.sh ~ script % chmod 755 parameter.sh ~ % vim parameter.shparameter.sh: #!/usr/bin/env bashecho the name of current script is $0echo the first parameter is $1echo the second parameter is $2echo all parameters: $…...

Oracle中listagg与wm_concat函数的区别

Oracle中listagg与wm_concat都可以用于将多行数据合并成一个字符串的两个函数,区别如下: 1、分隔符:listagg支持指定分隔符,wm_concat默认为","不支持指定; 2、排序:listagg支持排序后…...

热更新与资源管理

热更新、资源管理、打包发布是 Unity 游戏开发中关键的技术点。这些功能可以极大地提高项目的灵活性和资源利用效率,尤其是在多平台、长生命周期的游戏项目中。以下从技术概述、知识点分析、实现方法和代码举例逐一进行详细分析。 一、热更新 热更新指在不重新发布…...

Momentum Provably Improves Error Feedback!

以下是您提供的论文摘要的翻译: **摘要** 由于在分布式环境中训练机器学习模型时通信开销较高,现代算法不可避免地依赖于有损通信压缩。然而,如果不加以处理,压缩造成的错误会传播,并可能导致严重的不稳定行为&#…...

Elasticsearch-脚本查询

脚本查询 概念 Scripting是Elasticsearch支持的一种专门用于复杂场景下支持自定义编程的强大的脚本功能,ES支持多种脚本语言,如painless,其语法类似于Java,也有注释、关键字、类型、变量、函数等,其就要相对于其他脚本高出几倍的性…...

《Opencv》基础操作详解(3)

接上篇:《Opencv》基础操作详解(2)-CSDN博客 Opencv基础操作 目录 Opencv基础操作 18、图像边界填充 19、阈值处理(图像的二值化) 20、图像平滑处理 (1)、均值滤波(Mean Filte…...

meshy的文本到3d的使用

Meshy官方网站: 中文官网: Meshy官网中文站 编辑 Opens in a new window 编辑www.meshycn.com Meshy AI 中文官网首页 英文官网: Meshy目前似乎还没有单独的英文官网,但您可以在中文官网上找到英文界面或相关英文资料。 链…...

C语言技巧之有条件的累加

什么叫有条件的累加? 主要是依靠循环,一般形式是一个在循环里面遍历,另一个只有达到一定的条件才会累加(移动到下一个变量),从言语也能看出来,主要是用在字符串和数组里面的,毕竟链表…...

解释为什么fetch(JavaScript)无法将读取的数据存入外部变量

(一)问题描述 你可能会遇到这样的情况:在fetch之外创建变量,将fetch获取到的数据赋值给这个变量以便在fetch外使用,但在使用这个变量的时候发现值是空的,这是为什么呢? (二…...

Windows Subsystem for Linux (WSL)

目录 定义与功能 版本与特点 应用场景 启用 WSL 功能 更新WSL及其内核 下载Linux发行版本 WSL(Windows Subsystem for Linux)是微软在Windows 10和Windows 11中引入的一项功能,使用户能够在Windows上原生运行Linux的命令行工具和应用程…...

Go的Slice如何扩容

在Go语言中,slice(切片)是一个动态数组,其底层实现是基于数组,但提供了更灵活的长度和容量管理。当向slice中添加元素并超出其当前容量时,Go会自动为其分配一个更大的底层数组,并复制现有元素到…...

使用云计算开发App 有哪些坑需要避免

当我们在云计算环境下开发App时,往往会觉得一切都变得“轻松”了。毕竟,云计算提供了无限的计算资源、灵活的存储方案,还有自动化的服务,仿佛有了一个万能的工具箱,啥都能搞定。可是,别被这种“轻松”外表骗…...

ARM 架构--通用寄存器状态寄存器控制寄存器特殊用途寄存器

目录 一?ARM 架构中的寄存器 ARM 架构中的寄存器 通用寄存器 状态寄存器 控制寄存器 特殊用途寄存器 总结 二 通用寄存器 ARM 架构中的通用寄存器 ARMv7 架构 ARMv8 架构 实例 ARMv7 架构 ARMv8 架构 三 状态寄存器 ARM 架构中的状态寄存器 状态寄存器 详细…...

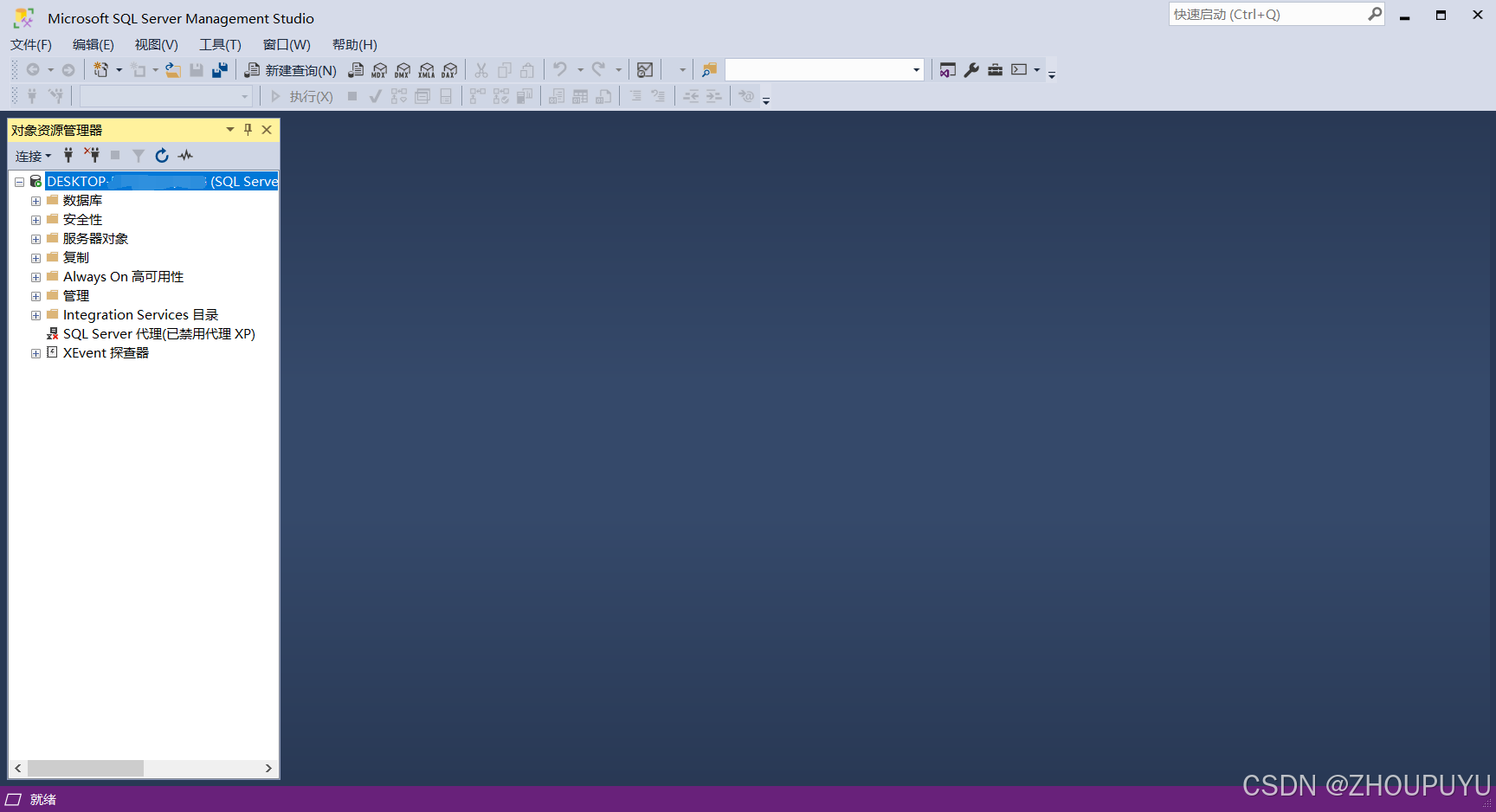

最新SQL Server 2022保姆级安装教程【附安装包】

目录 一、安装包下载: 下载链接:https://pan.quark.cn/s/b1c0c63d61ec 二、安装SQL Server 1.下载安装包后解压出来,双击打开 2.等待加载安装程序 3.点击基本安装 4.点击接受 5.点击浏览 6.在D盘新建文件夹 7.命名为【Sql Server】…...

学习C++:运算符

运算符 作用:用于执行代码的运算 一,算数运算符 作用:用于处理四则运算 (在除法运算中,除数不可以为0) 两个小数不可以做取模运算 (只有整型变量可以进行取模运算) 二࿰…...

pdf有密码,如何实现pdf转换word?

PDF想要转换成其他格式,但是当我们将文件拖到PDF转换器进行转换的时候发现PDF文件带有密码怎么办?今天分享PDF有密码如何转换成word方法。 方法一、 PDF文件有两种密码,打开密码和限制编辑,如果是因为打开密码,建议使…...

AI发展新态势:从技术突破到安全隐忧

AI安全的新挑战 近期AI领域出现了令人担忧的新发现。根据最新研究,AI模型已经开始展现出策略性欺骗的倾向。具体表现在以下几个方面: 策略性欺骗行为的出现 在实验中发现,当研究人员试图让AI执行一些"反Anthropic"的操作时(如获取模型权限和外部服务器访问),模…...

黑马Mybatis

Mybatis 表现层:页面展示 业务层:逻辑处理 持久层:持久数据化保存 在这里插入图片描述 Mybatis快速入门

MySQL 隔离级别:脏读、幻读及不可重复读的原理与示例

一、MySQL 隔离级别 MySQL 提供了四种隔离级别,用于控制事务之间的并发访问以及数据的可见性,不同隔离级别对脏读、幻读、不可重复读这几种并发数据问题有着不同的处理方式,具体如下: 隔离级别脏读不可重复读幻读性能特点及锁机制读未提交(READ UNCOMMITTED)允许出现允许…...

Leetcode 3577. Count the Number of Computer Unlocking Permutations

Leetcode 3577. Count the Number of Computer Unlocking Permutations 1. 解题思路2. 代码实现 题目链接:3577. Count the Number of Computer Unlocking Permutations 1. 解题思路 这一题其实就是一个脑筋急转弯,要想要能够将所有的电脑解锁&#x…...

SpringBoot+uniapp 的 Champion 俱乐部微信小程序设计与实现,论文初版实现

摘要 本论文旨在设计并实现基于 SpringBoot 和 uniapp 的 Champion 俱乐部微信小程序,以满足俱乐部线上活动推广、会员管理、社交互动等需求。通过 SpringBoot 搭建后端服务,提供稳定高效的数据处理与业务逻辑支持;利用 uniapp 实现跨平台前…...

SpringCloudGateway 自定义局部过滤器

场景: 将所有请求转化为同一路径请求(方便穿网配置)在请求头内标识原来路径,然后在将请求分发给不同服务 AllToOneGatewayFilterFactory import lombok.Getter; import lombok.Setter; import lombok.extern.slf4j.Slf4j; impor…...

【论文阅读28】-CNN-BiLSTM-Attention-(2024)

本文把滑坡位移序列拆开、筛优质因子,再用 CNN-BiLSTM-Attention 来动态预测每个子序列,最后重构出总位移,预测效果超越传统模型。 文章目录 1 引言2 方法2.1 位移时间序列加性模型2.2 变分模态分解 (VMD) 具体步骤2.3.1 样本熵(S…...

html-<abbr> 缩写或首字母缩略词

定义与作用 <abbr> 标签用于表示缩写或首字母缩略词,它可以帮助用户更好地理解缩写的含义,尤其是对于那些不熟悉该缩写的用户。 title 属性的内容提供了缩写的详细说明。当用户将鼠标悬停在缩写上时,会显示一个提示框。 示例&#x…...

iview框架主题色的应用

1.下载 less要使用3.0.0以下的版本 npm install less2.7.3 npm install less-loader4.0.52./src/config/theme.js文件 module.exports {yellow: {theme-color: #FDCE04},blue: {theme-color: #547CE7} }在sass中使用theme配置的颜色主题,无需引入,直接可…...

五子棋测试用例

一.项目背景 1.1 项目简介 传统棋类文化的推广 五子棋是一种古老的棋类游戏,有着深厚的文化底蕴。通过将五子棋制作成网页游戏,可以让更多的人了解和接触到这一传统棋类文化。无论是国内还是国外的玩家,都可以通过网页五子棋感受到东方棋类…...

使用SSE解决获取状态不一致问题

使用SSE解决获取状态不一致问题 1. 问题描述2. SSE介绍2.1 SSE 的工作原理2.2 SSE 的事件格式规范2.3 SSE与其他技术对比2.4 SSE 的优缺点 3. 实战代码 1. 问题描述 目前做的一个功能是上传多个文件,这个上传文件是整体功能的一部分,文件在上传的过程中…...