FFmpeg命令行解析

目录标题

- 一、引言(Introduction)

- 1.1 FFmpeg简介(Overview of FFmpeg)

- 1.2 FFmpeg命令行的应用场景(Application Scenarios of FFmpeg Command Line)

- 二、FFmpeg命令行基础(FFmpeg Command Line Basics)

- 2.1 常用命令概览(Overview of Common Commands)

- 2.2 命令行参数解析(Command Line Parameter Parsing)

- 三、视频处理命令(Video Processing Commands)

- 3.1 视频转码(Video Transcoding)

- 3.2 视频剪辑(Video Editing)

- 3.3 视频合并(Video Merging)

- 四、音频处理命令(Audio Processing Commands)

- 4.1 音频转码(Audio Transcoding)

- 4.2 音频剪辑(Audio Editing)

- 4.3 音频合并(Audio Merging)

- 五、字幕处理命令(Subtitle Processing Commands)

- 5.1 字幕提取(Subtitle Extraction)

- 5.2 字幕合并(Subtitle Merging)

- 5.3 字幕编辑(Subtitle Editing)

- 六、滤镜与效果(Filters and Effects)

- 6.1 滤镜简介(Introduction to Filters)

- 6.2 常用滤镜与实现原理(Common Filters and Their Implementation Principles)

- 6.3 滤镜链的应用(Application of Filterchains)

- 6.4 FFmpeg滤镜框架(FFmpeg Filter Framework)

- 6.5 FFmpeg库之间的关系(Relationship between FFmpeg Libraries)

- 七、FFmpeg库解析(FFmpeg Library Analysis)

- 7.1 源码结构与编译(Source Code Structure and Compilation)

- 7.2 核心组件及其功能(Core Components and Their Functions)

- 7.3 跟踪命令行到源码的流程(Tracing the Process from Command Line to Source Code)

- 八、自定义开发与接口应用(Custom Development and Interface Application)

- 8.1 FFmpeg库概述(Overview of FFmpeg Libraries)

- 8.2 编写自定义应用程序(Writing Custom Applications)

- 8.3 使用FFmpeg API实现命令功能(Implementing Command Functions with FFmpeg API)

- 8.4 FFmpeg的实时音视频处理(Real-Time Processing in FFmpeg)

- 九、优化与性能调整(Optimization and Performance Tuning)

- 9.1 硬件加速(Hardware Acceleration)

- 9.2 多线程与并发处理(Multithreading and Concurrent Processing)

- 9.3 调优技巧与建议(Tuning Tips and Suggestions)

- 9.4 FFmpeg的封装格式处理(Container Formats in FFmpeg)

- 十、音视频同步

- 10.1 FFmpeg中的音视频同步原理(Audio-Video Synchronization in FFmpeg)

- 10.2 音视频同步问题的诊断与调试(Diagnosing and Debugging Audio-Video Synchronization Issues)

- 10.3 FFmpeg中的实时音视频处理(Real-time Audio-Video Processing in FFmpeg)

- 十一、图像技术

- 11.1 FFmpeg中的图像处理技术(Image Processing Techniques in FFmpeg)

- 11.2 FFmpeg与OpenCV的结合应用(Combining FFmpeg and OpenCV)

- 11.3 FFmpeg与深度学习模型的结合(Integrating FFmpeg with Deep Learning Models)

- 十二、总结与展望(Conclusion and Outlook)

- 12.1 学到的知识与技能(Learned Knowledge and Skills)

- 12.2 FFmpeg未来的发展趋势(Future Development Trends of FFmpeg)

一、引言(Introduction)

1.1 FFmpeg简介(Overview of FFmpeg)

FFmpeg是一个广泛应用于多媒体处理领域的开源项目,它提供了一套强大的、灵活的工具和库,使得开发者能够方便地进行视频、音频以及字幕的处理与转换。FFmpeg项目由三个核心组件组成:命令行工具(fftools)、多媒体处理库(libav)以及开发者文档(doc)。

FFmpeg的主要特点如下:

- 支持多种媒体格式:FFmpeg支持众多的视频、音频和字幕格式,包括流行的MP4、AVI、MOV、MKV等视频格式,以及MP3、AAC、FLAC等音频格式,还有SRT、ASS等字幕格式。

- 高度可定制:FFmpeg具有丰富的编解码器、滤镜和输出格式选项,可以满足不同场景和需求的处理任务。通过命令行参数,用户可以对输入和输出媒体进行精确控制。

- 跨平台兼容性:FFmpeg可以在多种操作系统上运行,包括Windows、macOS和Linux等,这使得它在不同平台上的应用具有很高的灵活性。

- 高性能:FFmpeg针对多核处理器和硬件加速技术进行了优化,使其在执行多媒体任务时具备高效的性能表现。

- 活跃的社区:FFmpeg拥有一个活跃的开发者社区,定期更新并修复问题,保持项目的持续改进和发展。

正因为具备这些优点,FFmpeg成为了多媒体处理领域的事实标准,被广泛应用于各种场景,如在线视频平台、实时流媒体服务器、视频编辑软件等。接下来的章节,我们将详细探讨FFmpeg命令行的使用方法,以及对应的源码实现原理。

1.2 FFmpeg命令行的应用场景(Application Scenarios of FFmpeg Command Line)

FFmpeg命令行工具在多媒体处理领域有着广泛的应用,可以轻松地完成各种音视频处理任务。以下列举了一些常见的应用场景:

- 媒体格式转换:FFmpeg可以将视频和音频文件从一种格式转换成另一种格式,例如从AVI转换为MP4,从MP3转换为AAC等。这使得用户可以在不同的设备和平台上播放媒体文件。

- 视频剪辑与合并:通过FFmpeg命令行工具,用户可以轻松地对视频进行剪辑,例如截取视频的一部分、去除片头片尾等。此外,FFmpeg还可以将多个视频文件合并成一个文件,便于连续播放。

- 音频编辑与处理:FFmpeg可以提取视频中的音频轨道,对音频进行剪辑、合并、降噪等操作。这对于制作音乐剪辑、语音识别等应用非常有用。

- 字幕处理:FFmpeg支持对字幕文件的处理,如提取嵌入式字幕、合并外挂字幕等。这使得用户可以轻松地为视频添加或修改字幕。

- 调整视频参数:FFmpeg可以对视频进行各种参数的调整,如分辨率、码率、帧率等。这对于优化视频质量、降低文件大小以及适配不同设备的播放需求非常有帮助。

- 添加滤镜和特效:FFmpeg内置了丰富的滤镜和特效,用户可以通过命令行为视频添加各种视觉效果,如旋转、缩放、翻转、水印等。这对于美化视频、创建特效场景等有很大的应用价值。

- 实时流媒体处理:FFmpeg可以处理实时流媒体,如网络摄像头、直播推流等。这使得FFmpeg在直播、监控等领域具有广泛的应用潜力。

- 批量处理任务:FFmpeg命令行工具支持批量处理多个媒体文件,用户可以一次性完成大量文件的转换、剪辑等任务,提高工作效率。

总之,FFmpeg命令行工具具有强大的多媒体处理能力,可以满足各种场景和需求。在接下来的章节中,我们将逐一探讨这些应用场景所涉及的命令和操作。

二、FFmpeg命令行基础(FFmpeg Command Line Basics)

2.1 常用命令概览(Overview of Common Commands)

FFmpeg命令行工具提供了丰富的功能,下面我们将列举一些常用的命令和参数,以便于快速了解FFmpeg的基本功能。

- 转换媒体格式:

ffmpeg -i input.avi output.mp4

这条命令将输入的AVI文件转换为MP4格式。

- 提取音频:

ffmpeg -i input.mp4 -vn -c:a copy output.aac

这条命令从输入的MP4文件中提取音频并保存为AAC格式。

- 提取视频:

ffmpeg -i input.mp4 -an -c:v copy output.h264

这条命令从输入的MP4文件中提取视频并保存为H.264格式。

- 截取视频:

ffmpeg -i input.mp4 -ss 00:01:00 -t 00:02:00 -c copy output.mp4

这条命令截取输入的MP4文件中从第1分钟开始的2分钟视频片段。

- 合并视频:

ffmpeg -f concat -i filelist.txt -c copy output.mp4

这条命令根据filelist.txt文件中的列表合并多个视频文件。

- 改变分辨率:

ffmpeg -i input.mp4 -vf "scale=1280:720" output.mp4

这条命令将输入的MP4文件分辨率调整为1280x720。

- 添加水印:

ffmpeg -i input.mp4 -i watermark.png -filter_complex "overlay=10:10" output.mp4

这条命令将watermark.png图片作为水印添加到输入的MP4文件上。

- 调整音量:

ffmpeg -i input.mp3 -af "volume=1.5" output.mp3

这条命令将输入的MP3文件的音量提高50%。

- 视频旋转:

ffmpeg -i input.mp4 -vf "transpose=1" output.mp4

这条命令将输入的MP4文件顺时针旋转90度。

- 转换字幕格式:

ffmpeg -i input.srt output.ass

这条命令将输入的SRT字幕文件转换为ASS格式。

以上仅为FFmpeg命令行工具常用命令的简要概览,更多的功能和参数可以通过查阅FFmpeg官方文档或在线教程获得。在后续章节中,我们将详细介绍这些命令的用法和原理。

2.2 命令行参数解析(Command Line Parameter Parsing)

FFmpeg命令行工具的参数解析是通过一系列的选项(options)和参数(parameters)来实现的。选项和参数可以控制FFmpeg的行为,例如指定输入文件、选择编码器、设置滤镜等。理解命令行参数的解析规则和各种选项的含义是学习FFmpeg的重要基础。

以下是FFmpeg命令行参数解析的一般规则:

- 选项(option)通常由一个短横线(-)和一个字母组成,例如

-i表示输入文件。部分选项还有长格式,如-codec,这种选项可以用两个短横线(–)表示,如--codec。 - 选项后面通常跟着一个或多个参数(parameter),用于指定选项的具体值。例如,

-i input.mp4中的input.mp4就是-i选项的参数。 - 选项和参数之间可以用空格分隔,也可以用等号(=)连接。例如,

-vf scale=1280:720等同于-vf "scale 1280:720"。 - 有些选项可以出现多次,以对应多个输入文件、输出文件或滤镜等。例如,

-i input1.mp4 -i input2.mp4表示有两个输入文件。 - 选项的顺序通常很重要,因为FFmpeg会按照选项出现的顺序来处理输入文件和应用设置。例如,

-vf "scale=1280:720"应该出现在输入文件选项-i之后,以便应用于指定的输入文件。 - 部分选项具有全局作用范围,它们会影响FFmpeg的整体行为。例如,

-y选项表示自动覆盖已存在的输出文件。

为了更好地理解FFmpeg命令行参数解析,我们可以通过一个示例来说明:

ffmpeg -i input.mp4 -vf "scale=1280:720" -c:v libx264 -crf 20 -c:a aac -b:a 128k output.mp4

在这个示例中,我们可以看到以下选项及其参数:

-i input.mp4:指定输入文件为input.mp4。-vf "scale=1280:720":应用缩放滤镜,将视频分辨率调整为1280x720。-c:v libx264:设置视频编码器为libx264(H.264编码器)。-crf 20:设置视频质量为CRF(Constant Rate Factor)模式,数值越小质量越好,通常取值范围为18-28。-c:a aac:设置音频编码器为AAC。-b:a 128k:设置音频比特率为128kbps。output.mp4:指定输出文件名为output.mp4。

通过这个示例,我们可以看到FFmpeg命令行参数的组织结构以及各个选项和参数的功能。在实际使用中,FFmpeg提供了更多的选项和参数,可以实现更复杂的多媒体处理任务。

需要注意的是,FFmpeg的命令行参数解析过程在源码中的主要实现位于ffmpeg.c文件的main()函数中。这个函数首先对命令行参数进行解析,然后根据解析得到的选项和参数设置各种参数,最后执行实际的多媒体处理任务。如果希望深入了解FFmpeg命令行参数解析的实现原理,可以从main()函数开始阅读源码。

三、视频处理命令(Video Processing Commands)

3.1 视频转码(Video Transcoding)

视频转码是指将一种编码格式的视频转换为另一种编码格式。在实际应用中,视频转码的需求很常见,例如在不同设备上播放视频时需要转换为适应设备的编码格式。FFmpeg作为一个强大的视频处理工具,支持多种编码格式的转码。

以下是一个使用FFmpeg命令行进行视频转码的示例:

ffmpeg -i input.mp4 -c:v libx264 -preset slow -crf 22 -c:a aac -b:a 128k output.mkv

这个命令的作用是将输入文件input.mp4转换为输出文件output.mkv,视频编码使用libx264,音频编码使用aac。在转码过程中,可以通过一些参数来调整输出视频的质量,如-preset slow用于控制编码速度,-crf 22用于控制视频质量,-b:a 128k用于控制音频比特率。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与编解码器相关的组件。在FFmpeg源码中,libavcodec库负责编解码器的实现,而libavformat库负责封装格式的处理。在执行转码任务时,FFmpeg首先使用libavformat解封装输入文件,然后使用libavcodec对音视频流进行解码、编码,最后使用libavformat封装输出文件。

为了自定义转码功能,可以使用FFmpeg提供的编程接口。例如,使用avcodec_open2()打开编解码器,使用av_read_frame()读取输入文件的帧,使用avcodec_send_packet()和avcodec_receive_frame()进行解码,使用avcodec_send_frame()和avcodec_receive_packet()进行编码,最后使用av_write_frame()将编码后的数据写入输出文件。通过编写C或C++代码,可以实现与命令行相同的转码功能,并根据需求进行更复杂的定制。

3.2 视频剪辑(Video Editing)

视频剪辑是指对视频进行截取、拼接等操作,以得到所需的片段或组合。使用FFmpeg命令行,我们可以轻松地完成视频剪辑任务。以下是一些常见的视频剪辑操作示例:

- 截取视频片段:

ffmpeg -i input.mp4 -ss 00:01:00 -t 00:00:30 -c copy output.mp4

这个命令将从input.mp4的第1分钟开始,截取30秒的视频片段,并保存为output.mp4。参数-ss表示开始时间,-t表示持续时间。在这个例子中,我们使用-c copy参数来直接复制音视频流,而不对其进行重新编码,从而加快处理速度。

- 拼接视频:

要使用FFmpeg拼接多个视频文件,首先需要创建一个包含所有输入文件路径的文本文件,例如input_files.txt:

file 'input1.mp4'

file 'input2.mp4'

file 'input3.mp4'

然后,使用以下命令进行拼接:

ffmpeg -f concat -i input_files.txt -c copy output.mp4

这个命令使用concat协议将input_files.txt中列出的视频文件拼接成一个输出文件output.mp4。类似地,我们使用-c copy参数来避免重新编码。

FFmpeg源码中与视频剪辑相关的部分主要集中在libavfilter库。该库提供了一系列滤镜,用于对音视频数据进行处理。例如,trim滤镜用于截取视频片段,concat滤镜用于拼接视频。要在自定义程序中实现视频剪辑功能,可以使用avfilter库提供的API。例如,使用avfilter_graph_create_filter()创建滤镜,使用avfilter_link()连接滤镜,使用av_buffersrc_add_frame()和av_buffersink_get_frame()将数据传递给滤镜并获取处理后的数据。

通过学习FFmpeg源码中的滤镜实现,我们可以更深入地理解视频剪辑功能的原理,并根据需求进行定制。

3.3 视频合并(Video Merging)

视频合并是指将多个视频文件的音频和视频流进行组合,以生成一个新的视频文件。使用FFmpeg命令行,我们可以方便地完成视频合并任务。以下是一个将两个视频文件进行合并的示例:

ffmpeg -i input1.mp4 -i input2.mp4 -filter_complex "[0:v][0:a][1:v][1:a]concat=n=2:v=1:a=1[outv][outa]" -map "[outv]" -map "[outa]" output.mp4

这个命令将input1.mp4和input2.mp4两个视频文件合并成一个新的视频文件output.mp4。-filter_complex参数用于定义一个复杂的滤镜图,其中[0:v][0:a][1:v][1:a]表示输入文件的视频和音频流,concat=n=2:v=1:a=1[outv][outa]表示将这些流进行合并,并将结果命名为[outv]和[outa]。-map参数用于将合并后的流映射到输出文件。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与滤镜图相关的部分。在FFmpeg源码中,libavfilter库负责实现滤镜图。在执行合并任务时,FFmpeg首先使用avfilter_graph_parse2()解析-filter_complex参数,然后使用avfilter_graph_config()配置滤镜图。处理过程中,FFmpeg使用av_buffersrc_add_frame()将数据传递给滤镜图,并使用av_buffersink_get_frame()获取处理后的数据。

为了自定义合并功能,可以使用FFmpeg提供的编程接口。例如,使用avfilter_graph_create_filter()创建滤镜,使用avfilter_link()连接滤镜,然后使用av_buffersrc_add_frame()和av_buffersink_get_frame()将数据传递给滤镜并获取处理后的数据。通过编写C或C++代码,可以实现与命令行相同的合并功能,并根据需求进行更复杂的定制。

四、音频处理命令(Audio Processing Commands)

4.1 音频转码(Audio Transcoding)

音频转码是将一种编码格式的音频转换为另一种编码格式。在实际应用中,音频转码的需求很常见,例如在不同设备上播放音频时需要转换为适应设备的编码格式。FFmpeg作为一个强大的音视频处理工具,支持多种编码格式的音频转码。

以下是一个使用FFmpeg命令行进行音频转码的示例:

ffmpeg -i input.mp3 -c:a aac -b:a 128k output.m4a

这个命令的作用是将输入文件input.mp3转换为输出文件output.m4a,音频编码使用aac。在转码过程中,可以通过一些参数来调整输出音频的质量,如-b:a 128k用于控制音频比特率。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与编解码器相关的组件。在FFmpeg源码中,libavcodec库负责编解码器的实现,而libavformat库负责封装格式的处理。在执行音频转码任务时,FFmpeg首先使用libavformat解封装输入文件,然后使用libavcodec对音频流进行解码、编码,最后使用libavformat封装输出文件。

为了自定义音频转码功能,可以使用FFmpeg提供的编程接口。例如,使用avcodec_open2()打开编解码器,使用av_read_frame()读取输入文件的帧,使用avcodec_send_packet()和avcodec_receive_frame()进行解码,使用avcodec_send_frame()和avcodec_receive_packet()进行编码,最后使用av_write_frame()将编码后的数据写入输出文件。通过编写C或C++代码,可以实现与命令行相同的音频转码功能,并根据需求进行更复杂的定制。

4.2 音频剪辑(Audio Editing)

音频剪辑是指对音频进行截取、拼接等操作,以得到所需的片段或组合。使用FFmpeg命令行,我们可以轻松地完成音频剪辑任务。以下是一些常见的音频剪辑操作示例:

- 截取音频片段:

ffmpeg -i input.mp3 -ss 00:01:00 -t 00:00:30 -c:a copy output.mp3

这个命令将从input.mp3的第1分钟开始,截取30秒的音频片段,并保存为output.mp3。参数-ss表示开始时间,-t表示持续时间。在这个例子中,我们使用-c:a copy参数来直接复制音频流,而不对其进行重新编码,从而加快处理速度。

- 拼接音频:

要使用FFmpeg拼接多个音频文件,首先需要创建一个包含所有输入文件路径的文本文件,例如input_files.txt:

file 'input1.mp3'

file 'input2.mp3'

file 'input3.mp3'

然后,使用以下命令进行拼接:

ffmpeg -f concat -i input_files.txt -c copy output.mp3

这个命令使用concat协议将input_files.txt中列出的音频文件拼接成一个输出文件output.mp3。类似地,我们使用-c copy参数来避免重新编码。

FFmpeg源码中与音频剪辑相关的部分主要集中在libavfilter库。该库提供了一系列滤镜,用于对音频数据进行处理。例如,atrim滤镜用于截取音频片段,concat滤镜用于拼接音频。要在自定义程序中实现音频剪辑功能,可以使用avfilter库提供的API。例如,使用avfilter_graph_create_filter()创建滤镜,使用avfilter_link()连接滤镜,使用av_buffersrc_add_frame()和av_buffersink_get_frame()将数据传递给滤镜并获取处理后的数据。

通过学习FFmpeg源码中的滤镜实现,我们可以更深入地理解音频剪辑功能的原理,并根据需求进行定制。

4.3 音频合并(Audio Merging)

音频合并是指将多个音频文件按照时间轴进行组合,以生成一个新的音频文件。使用FFmpeg命令行,我们可以轻松地完成音频合并任务。以下是一个将两个音频文件进行合并的示例:

ffmpeg -i input1.mp3 -i input2.mp3 -filter_complex "[0:a][1:a]amerge=inputs=2[outa]" -map "[outa]" -c:a libmp3lame -ac 2 -q:a 4 output.mp3

这个命令将input1.mp3和input2.mp3两个音频文件合并成一个新的音频文件output.mp3。-filter_complex参数用于定义一个复杂的滤镜图,其中[0:a][1:a]表示输入文件的音频流,amerge=inputs=2[outa]表示将这些流进行合并,并将结果命名为[outa]。-map参数用于将合并后的流映射到输出文件。-c:a libmp3lame -ac 2 -q:a 4用于指定输出音频的编码器、声道数量和质量。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与滤镜图相关的部分。在FFmpeg源码中,libavfilter库负责实现滤镜图。在执行音频合并任务时,FFmpeg首先使用avfilter_graph_parse2()解析-filter_complex参数,然后使用avfilter_graph_config()配置滤镜图。处理过程中,FFmpeg使用av_buffersrc_add_frame()将数据传递给滤镜图,并使用av_buffersink_get_frame()获取处理后的数据。

为了自定义音频合并功能,可以使用FFmpeg提供的编程接口。例如,使用avfilter_graph_create_filter()创建滤镜,使用avfilter_link()连接滤镜,然后使用av_buffersrc_add_frame()和av_buffersink_get_frame()将数据传递给滤镜并获取处理后的数据。通过编写C或C++代码,可以实现与命令行相同的音频合并功能,并根据需求进行更复杂的定制。

五、字幕处理命令(Subtitle Processing Commands)

5.1 字幕提取(Subtitle Extraction)

字幕提取是指从一个视频文件中提取字幕流,然后将其保存为一个独立的字幕文件。FFmpeg支持从多种封装格式中提取字幕,并将其转换为常见的字幕文件格式,如SRT、ASS等。以下是一个使用FFmpeg命令行提取字幕的示例:

ffmpeg -i input.mkv -map 0:s:0 -c:s srt output.srt

这个命令从input.mkv文件中提取字幕流,并将其保存为SRT格式的output.srt文件。-map 0:s:0参数用于选择第一个字幕流,-c:s srt用于指定输出字幕的格式。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与封装格式和字幕编解码器相关的组件。在FFmpeg源码中,libavformat库负责处理封装格式,libavcodec库负责实现字幕编解码器。在执行字幕提取任务时,FFmpeg首先使用libavformat解封装输入文件,然后使用libavcodec对字幕流进行解码,并将解码后的字幕数据转换为指定的输出格式。

为了自定义字幕提取功能,可以使用FFmpeg提供的编程接口。例如,使用avformat_open_input()打开输入文件,使用av_read_frame()读取输入文件的帧,使用avcodec_send_packet()和avcodec_receive_frame()进行解码,最后将解码后的字幕数据保存为指定的文件格式。通过编写C或C++代码,可以实现与命令行相同的字幕提取功能,并根据需求进行更复杂的定制。

5.2 字幕合并(Subtitle Merging)

字幕合并是指将一个独立的字幕文件嵌入到一个视频文件中,从而在播放视频时同时显示字幕。FFmpeg支持将多种字幕文件格式(如SRT、ASS等)合并到多种视频封装格式中。以下是一个使用FFmpeg命令行合并字幕的示例:

ffmpeg -i input.mp4 -i input.srt -c:v copy -c:a copy -c:s mov_text -metadata:s:s:0 language=eng output.mp4

这个命令将input.srt字幕文件合并到input.mp4视频文件中,并将结果保存为output.mp4。-c:v copy和-c:a copy参数用于复制视频和音频流,而不重新编码。-c:s mov_text参数用于指定输出字幕的编码格式。-metadata:s:s:0 language=eng参数用于设置字幕流的语言元数据。

要理解这个命令背后的源码实现,我们需要关注FFmpeg源码中与封装格式和字幕编解码器相关的组件。在FFmpeg源码中,libavformat库负责处理封装格式,libavcodec库负责实现字幕编解码器。在执行字幕合并任务时,FFmpeg首先使用libavformat打开输入文件,然后使用libavcodec对字幕数据进行编码,并将编码后的字幕数据封装到输出文件中。

为了自定义字幕合并功能,可以使用FFmpeg提供的编程接口。例如,使用avformat_open_input()打开输入文件,使用avformat_new_stream()创建新的字幕流,使用avcodec_send_frame()和avcodec_receive_packet()进行编码,最后使用av_interleaved_write_frame()将编码后的字幕数据写入输出文件。通过编写C或C++代码,可以实现与命令行相同的字幕合并功能,并根据需求进行更复杂的定制。

5.3 字幕编辑(Subtitle Editing)

字幕编辑是指修改或调整字幕文件的内容,例如调整字幕的显示时间、修改字幕样式或对字幕进行翻译等。FFmpeg命令行工具本身不直接支持字幕编辑功能,但可以通过其他开源工具(如Subtitle Edit、Aegisub等)或FFmpeg的编程接口来实现字幕编辑。

以下是一个使用FFmpeg命令行调整字幕显示时间的示例:

ffmpeg -itsoffset 3 -i input.srt -c:s srt output.srt

这个命令将input.srt文件中的所有字幕时间轴向后偏移3秒,并将结果保存为output.srt。-itsoffset 3参数用于设置时间偏移量。

要实现更复杂的字幕编辑功能,可以使用FFmpeg提供的编程接口。例如,可以读取字幕文件的内容,对时间轴、样式或文本进行修改,然后将修改后的内容保存为新的字幕文件。这种方法需要对字幕文件格式(如SRT、ASS等)的结构有一定了解,并可能涉及到一定的文本处理和格式转换。

六、滤镜与效果(Filters and Effects)

6.1 滤镜简介(Introduction to Filters)

FFmpeg中的滤镜是一种处理多媒体数据(如视频、音频或字幕)的工具,可以对数据进行转换、调整或增强。滤镜可以独立使用,也可以按顺序或并行组合成滤镜链。FFmpeg提供了丰富的滤镜库(libavfilter),包括用于视频处理、音频处理和字幕处理的滤镜。

以下是一些常见的FFmpeg滤镜示例:

- 视频滤镜:

- scale:缩放视频尺寸

- crop:裁剪视频画面

- rotate:旋转视频画面

- overlay:叠加多个视频画面

- 音频滤镜:

- volume:调整音量

- aresample:重采样音频

- equalizer:调整音频的均衡器设置

- afade:音频淡入淡出效果

要在FFmpeg命令行中使用滤镜,需要使用-vf(视频滤镜)或-af(音频滤镜)参数,后面跟上相应的滤镜表达式。例如,以下命令将输入视频的尺寸缩放到1280x720:

ffmpeg -i input.mp4 -vf "scale=1280:720" output.mp4

在FFmpeg源码中,滤镜的实现位于libavfilter库。每个滤镜都有一个对应的滤镜描述结构体(AVFilter),包含滤镜的名称、类型、输入/输出参数等信息。滤镜处理函数负责对输入数据进行处理,并将处理结果传递给下一个滤镜或输出。

通过学习FFmpeg的滤镜库和编程接口,可以实现自定义滤镜功能,满足特定需求。

6.2 常用滤镜与实现原理(Common Filters and Their Implementation Principles)

在本节中,我们将介绍一些常用的FFmpeg滤镜及其实现原理。

- scale(缩放):scale滤镜用于调整视频帧的尺寸。它的实现原理是通过图像重采样算法(如最近邻、双线性、双三次等)对图像像素进行插值。在FFmpeg源码中,scale滤镜位于

libavfilter/vf_scale.c文件。使用sws_scale()函数进行实际的缩放操作。 - crop(裁剪):crop滤镜用于裁剪视频帧的一部分。它的实现原理是将输入帧的指定矩形区域复制到输出帧。在FFmpeg源码中,crop滤镜位于

libavfilter/vf_crop.c文件。使用av_frame_copy_props()和av_frame_copy()函数进行实际的裁剪操作。 - volume(音量调整):volume滤镜用于调整音频的音量。它的实现原理是对音频采样数据进行放大或缩小。在FFmpeg源码中,volume滤镜位于

libavfilter/af_volume.c文件。使用音频采样格式(如PCM)相关的函数进行实际的音量调整操作。 - overlay(叠加):overlay滤镜用于将两个视频帧叠加在一起。它的实现原理是将一个视频帧的像素值与另一个视频帧的像素值进行合成,得到输出帧的像素值。在FFmpeg源码中,overlay滤镜位于

libavfilter/vf_overlay.c文件。使用av_image_copy_plane()函数进行实际的叠加操作。

6.3 滤镜链的应用(Application of Filterchains)

在FFmpeg中,滤镜链(Filterchains)是一种强大的功能,可以将多个滤镜按照特定顺序链接在一起,以实现更加复杂的音视频处理效果。滤镜链的应用可以让我们在一个命令中同时应用多个滤镜,从而实现音视频的串行处理。

以下是一个简单的滤镜链应用示例:

ffmpeg -i input.mp4 -vf "scale=1280:720,transpose=1" output.mp4

在这个示例中,我们使用了两个滤镜:scale和transpose。首先,scale滤镜将视频尺寸调整为1280x720,然后transpose滤镜将视频顺时针旋转90度。这两个滤镜以逗号分隔,形成一个滤镜链。

在编程接口中,可以使用AVFilterGraph结构体创建滤镜图,并使用相关函数连接滤镜。以下是一个简单的C++示例,演示如何创建一个视频滤镜链,将输入视频缩放并旋转:

#include <libavfilter/avfilter.h>

#include <libavfilter/buffersink.h>

#include <libavfilter/buffersrc.h>// 创建滤镜图

AVFilterGraph* filter_graph = avfilter_graph_alloc();// 创建缩放滤镜实例

AVFilterContext* scale_filter;

avfilter_graph_create_filter(&scale_filter, avfilter_get_by_name("scale"), "scale","1280:720", nullptr, filter_graph);// 创建旋转滤镜实例

AVFilterContext* transpose_filter;

avfilter_graph_create_filter(&transpose_filter, avfilter_get_by_name("transpose"), "transpose","1", nullptr, filter_graph);// 连接滤镜

avfilter_link(scale_filter, 0, transpose_filter, 0);

6.4 FFmpeg滤镜框架(FFmpeg Filter Framework)

FFmpeg滤镜框架是一套用于处理音视频数据的模块化系统,它允许用户通过简单地链接滤镜来实现复杂的音视频处理任务。滤镜框架的核心组件是滤镜(Filter),每个滤镜都可以执行特定的音视频处理操作,如缩放、裁剪、旋转等。在本节中,我们将简要介绍FFmpeg滤镜框架的工作原理和实现。

-

滤镜图(Filtergraph)

滤镜图是FFmpeg滤镜框架的基本组织结构,它由滤镜节点(Filter Nodes)和滤镜边(Filter Edges)组成。滤镜节点代表具体的滤镜实例,而滤镜边代表滤镜之间的数据流。通过在滤镜图中连接不同的滤镜节点,用户可以实现各种音视频处理功能。

-

滤镜节点(Filter Nodes)

滤镜节点是滤镜图中的基本元素,每个滤镜节点都包含一个滤镜实例和相应的输入输出端口。滤镜实例负责执行具体的音视频处理操作,如缩放、裁剪、旋转等。输入输出端口则用于接收和发送音视频数据。

-

滤镜边(Filter Edges)

滤镜边是滤镜图中连接滤镜节点的数据通道,它负责在滤镜之间传递音视频数据。通过滤镜边,滤镜图可以实现复杂的音视频处理任务,如混流、拼接、转码等。

-

FFmpeg中的滤镜框架实现

FFmpeg滤镜框架的实现主要位于

libavfilter库中。这个库包含了大量的滤镜实现,如视频滤镜(vf_开头)、音频滤镜(af_开头)等。这些滤镜通过统一的接口(如AVFilter结构体)进行管理和调用。在使用FFmpeg命令行工具时,用户可以通过

-vf和-af选项来指定滤镜图。例如,以下命令将输入视频文件input.mp4缩放为1280x720分辨率,并保存为output.mp4:ffmpeg -i input.mp4 -vf "scale=1280:720" output.mp4在阅读FFmpeg源码时,可以从

libavfilter库中的滤镜实现入手,深入了解各种滤镜的工作原理和实现细节。同时,也可以学习FFmpeg如何通过滤镜框架来实现灵活的音视频处理功能。 -

自定义滤镜

FFmpeg滤镜框架提供了丰富的音视频处理功能,但在某些情况下,用户可能需要实现自定义滤镜来满足特定需求。为了实现自定义滤镜,用户需要遵循以下步骤:

- 定义滤镜结构:首先,用户需要定义一个滤镜结构(如

AVFilter),并为其指定滤镜的名称、类型、初始化函数、处理函数等信息。这个结构将作为滤镜实例的基本描述信息。 - 实现滤镜函数:接下来,用户需要实现滤镜的初始化函数、处理函数等。这些函数将负责执行具体的音视频处理操作,如图像缩放、音频滤波等。

- 注册滤镜:最后,用户需要将自定义滤镜注册到FFmpeg滤镜框架中,以便在滤镜图中使用。用户可以通过调用

avfilter_register()函数来实现这一点。

- 定义滤镜结构:首先,用户需要定义一个滤镜结构(如

在实现自定义滤镜时,用户可以参考FFmpeg源码中已有的滤镜实现,如libavfilter/vf_scale.c(视频缩放滤镜)和libavfilter/af_volume.c(音频音量滤镜)等。通过学习这些源码,用户可以更深入地了解FFmpeg滤镜框架的工作原理和实现细节。

6.5 FFmpeg库之间的关系(Relationship between FFmpeg Libraries)

FFmpeg的核心功能由一系列库(libav *)组成,这些库之间存在相互依赖和协作关系。了解这些库之间的关系有助于我们更深入地理解FFmpeg的工作原理。以下简要介绍FFmpeg主要库及其关系:

- libavcodec:这是FFmpeg的编解码库,包含了大量音视频编解码器。它负责对音视频数据进行编码和解码,以实现媒体文件的压缩和解压缩。

- libavformat:这是FFmpeg的容器格式库,负责处理多媒体文件的封装和解封装。它支持多种常见的音视频文件格式,如MP4、AVI、MKV等。libavformat库依赖于libavcodec库来实现音视频数据的编解码。

- libavfilter:这是FFmpeg的滤镜库,包含了丰富的音视频滤镜,如缩放、裁剪、旋转等。它可以对音视频数据进行各种处理和转换,以实现特效、调整参数等功能。libavfilter库依赖于libavcodec库来获取解码后的音视频帧。

- libavutil:这是FFmpeg的工具库,提供了许多底层的功能和数据结构,如内存管理、数学运算、字符串处理等。其他FFmpeg库(如libavcodec、libavformat、libavfilter等)均依赖于libavutil库。

- libavdevice:这是FFmpeg的设备库,负责处理音视频设备的输入和输出,如摄像头、麦克风、屏幕捕获等。它依赖于libavcodec和libavformat库来实现音视频数据的编解码和封装。

- libswscale:这是FFmpeg的图像缩放库,负责对图像进行缩放、色彩空间转换等操作。它通常与libavfilter库一起使用,以实现图像处理功能。libswscale库依赖于libavutil库。

- libswresample:这是FFmpeg的音频重采样库,负责对音频数据进行重采样、格式转换等操作。它通常与libavfilter库一起使用,以实现音频处理功能。libswresample库依赖于libavutil库。

通过以上介绍,我们可以看出FFmpeg各库之间的依赖和协作关系。在实际应用中,这些库通常共同工作,以实现丰富的多媒体处理功能。在阅读FFmpeg源码时,可以从这些库的关系入手,逐步深入了解各个库的具体实现。

七、FFmpeg库解析(FFmpeg Library Analysis)

7.1 源码结构与编译(Source Code Structure and Compilation)

为了更好地理解FFmpeg命令行工具的原理,我们需要熟悉其源码结构。FFmpeg项目的源码结构相对清晰,主要分为以下几个部分:

命令行工具(ff*tools):包括ffmpeg、ffplay和ffprobe等命令行工具的源码。这些工具分别用于多媒体处理、播放和分析。主要源码文件位于项目根目录下的fftools文件夹中。FFmpeg命令行工具提供对各种音频、视频和字幕处理功能的命令行接口。

库(libav *):包括libavcodec、libavformat、libavfilter、libavutil、libavdevice、libswscale、libswresample等库的源码。这些库为FFmpeg提供了丰富的多媒体处理功能。

- libavcodec:编解码器库,包含各种音频、视频和字幕的编解码器实现。

- libavformat:多媒体容器格式库,包含各种音频、视频和字幕的封装和解封装实现。

- libavfilter:滤镜库,包含多种音频、视频和字幕的滤镜实现。

- libavutil:公共工具库,包含基本数据结构、数学函数、字符串操作等通用功能。

- libavdevice:设备输入输出库,包含对各种设备(如摄像头、麦克风、屏幕等)的访问支持。

- libswscale:视频缩放库,包含视频尺寸、像素格式转换等功能。

- libswresample:音频重采样库,包含音频采样率、格式、声道布局转换等功能。

主要源码文件位于项目根目录下的libav*文件夹中。

文档(doc):包括开发者文档、用户手册和示例代码等。这些文档有助于用户和开发者学习和使用FFmpeg。主要源码文件位于项目根目录下的doc文件夹中。

测试(tests):包括各种测试用例和测试工具。这些测试用于确保FFmpeg的正确性和稳定性。主要源码文件位于项目根目录下的tests文件夹中。

配置和构建(configure and build):包括配置脚本、Makefile等。这些文件用于配置和构建FFmpeg项目。主要源码文件位于项目根目录下。

在阅读FFmpeg源码时,可以根据自己的需求和兴趣选择合适的部分进行学习。例如,如果关注FFmpeg命令行工具的实现原理,可以重点阅读fftools文件夹下的源码;如果关注编解码器、滤镜等多媒体处理功能,可以重点阅读libav*文件夹下的源码。

为了更深入地理解FFmpeg的原理和实现,你可以从以下几个方面入手:

- 学习基础知识:在深入研究源码之前,了解音视频处理、编解码原理、多媒体容器格式等基础知识是非常必要的。这将帮助你更好地理解FFmpeg源码中各种概念和实现细节。

- 阅读文档:FFmpeg项目提供了丰富的文档,包括开发者文档、用户手册和示例代码等。通过阅读这些文档,你可以更好地了解FFmpeg的功能、使用方法和开发流程。

- 学习代码示例:FFmpeg项目中包含了许多代码示例,它们展示了如何使用FFmpeg库完成各种音视频处理任务。通过阅读和分析这些示例代码,你可以学习到FFmpeg库的使用方法和技巧。

- 深入源码:在掌握了基础知识和使用方法后,可以逐步深入到FFmpeg的源码中。可以从命令行工具(如ffmpeg、ffplay、ffprobe)的实现开始,然后逐步深入到各个库的实现。在这个过程中,你可以关注自己感兴趣的功能模块,如编解码器、滤镜等。

- 跟踪调试:为了更好地理解FFmpeg的工作原理,可以使用调试工具(如gdb)跟踪和调试FFmpeg的执行过程。通过实际运行和调试FFmpeg,你可以更深入地了解其内部结构和实现细节。

- 参与社区:FFmpeg有一个活跃的开源社区,通过参与邮件列表、讨论组和代码审查等活动,你可以了解到项目的最新动态,与其他开发者交流经验,甚至为FFmpeg项目贡献代码。

通过以上几个方面的学习和实践,你将逐步掌握FFmpeg的原理和实现,为你在音视频处理领域的工作和研究打下坚实的基础。

为了编译FFmpeg源码,可以使用以下步骤:

- 下载FFmpeg源码:

git clone https://github.com/FFmpeg/FFmpeg.git cd FFmpeg - 安装依赖库(根据需要):

sudo apt-get install yasm pkg-config libx264-dev libx265-dev libvpx-dev libfdk-aac-dev libmp3lame-dev libopus-dev - 配置编译选项:

./configure --enable-gpl --enable-nonfree --enable-libx264 --enable-libx265 --enable-libvpx --enable-libfdk-aac --enable-libmp3lame --enable-libopus - 编译FFmpeg:

make - 安装FFmpeg:

sudo make install

编译完成后,可以使用ffmpeg命令行工具进行各种多媒体任务。同时,可以通过阅读FFmpeg源码,了解其内部实现原理和编程接口。

7.2 核心组件及其功能(Core Components and Their Functions)

FFmpeg源码中包含多个核心组件,用于实现不同的多媒体处理功能。以下是一些主要的核心组件及其功能介绍:

- AVCodec:编解码器组件。它封装了音频、视频和字幕的编解码器实现。libavcodec库提供了统一的编解码器接口,用于注册、查找和操作编解码器。在FFmpeg源码中,编解码器的实现位于

libavcodec目录下的各个源文件。 - AVFormat:多媒体容器格式组件。它封装了音频、视频和字幕的封装和解封装实现。libavformat库提供了统一的容器格式接口,用于注册、查找和操作容器格式。在FFmpeg源码中,容器格式的实现位于

libavformat目录下的各个源文件。 - AVFilter:滤镜组件。它封装了多种音频、视频和字幕的滤镜实现。libavfilter库提供了统一的滤镜接口,用于注册、查找和操作滤镜。在FFmpeg源码中,滤镜的实现位于

libavfilter目录下的各个源文件。 - AVDevice:设备输入输出组件。它封装了对各种设备(如摄像头、麦克风、屏幕等)的访问支持。libavdevice库提供了统一的设备接口,用于注册、查找和操作设备。在FFmpeg源码中,设备支持的实现位于

libavdevice目录下的各个源文件。 - Swscale:视频缩放组件。它封装了视频尺寸、像素格式转换等功能。libswscale库提供了统一的缩放接口,用于对图像进行缩放和格式转换。在FFmpeg源码中,视频缩放的实现位于

libswscale目录下的各个源文件。 - Swresample:音频重采样组件。它封装了音频采样率、格式、声道布局转换等功能。libswresample库提供了统一的重采样接口,用于对音频进行重采样和格式转换。在FFmpeg源码中,音频重采样的实现位于

libswresample目录下的各个源文件。

通过阅读和分析这些核心组件的源码,可以了解FFmpeg的内部实现原理。同时,可以学习如何使用这些组件的编程接口,实现自定义的多媒体处理功能。

7.3 跟踪命令行到源码的流程(Tracing the Process from Command Line to Source Code)

了解FFmpeg源码的结构和核心组件后,我们可以从命令行到源码的角度去跟踪和理解FFmpeg的工作流程。以一个常见的视频转码任务为例,让我们分析这个过程:

命令行示例:ffmpeg -i input.mp4 -c:v libx264 -c:a aac output.mp4

以下是从命令行到源码的主要步骤:

- 参数解析:当我们执行ffmpeg命令时,首先进入到

ffmpeg.c文件的main函数。这里会解析命令行参数,包括输入文件、输出文件和各种转码选项。 - 输入文件处理:在解析完命令行参数后,FFmpeg会根据输入文件的路径和格式,调用

libavformat库打开输入文件。这个过程会解析文件的元数据,如音频轨、视频轨、字幕轨等,并将这些信息存储在AVFormatContext结构体中。 - 编解码器配置:接下来,FFmpeg会根据输入文件的编码格式,查找合适的解码器(AVCodec)。然后,根据用户指定的输出编码格式,查找合适的编码器。这些查找过程会涉及到

libavcodec库中的编解码器注册和查找接口。 - 滤镜与效果处理:如果用户指定了滤镜或效果选项,FFmpeg会调用

libavfilter库来处理这些选项。这个过程会创建滤镜图(Filtergraph),并将输入文件的音频、视频轨分别连接到相应的滤镜链。 - 编码输出:经过滤镜处理后,FFmpeg会将处理后的音频、视频轨分别编码成用户指定的编码格式。这个过程会调用

libavcodec库中的编码器接口。 - 输出文件封装:最后,FFmpeg会将编码后的音频、视频轨封装成用户指定的输出文件格式。这个过程会调用

libavformat库中的封装接口。

八、自定义开发与接口应用(Custom Development and Interface Application)

8.1 FFmpeg库概述(Overview of FFmpeg Libraries)

FFmpeg是一个强大且灵活的多媒体处理框架,它提供了一系列库来支持多种音视频处理任务。通过使用FFmpeg的库和接口,我们可以在自己的应用程序中实现各种多媒体处理功能。以下是FFmpeg主要库的概述:

- libavcodec:编解码库,提供音频、视频和字幕的编解码功能。这个库包含了大量的编解码器,支持各种主流的编码格式。

- libavformat:封装/解封装库,提供音频、视频和字幕的封装和解封装功能。这个库支持多种多媒体容器格式,如MP4、MKV、AVI等。

- libavfilter:滤镜库,提供音频、视频和字幕的滤镜处理功能。这个库包含了大量的滤镜效果,如缩放、裁剪、旋转、水印等。

- libavdevice:设备输入输出库,提供对各种设备的访问支持,如摄像头、麦克风、屏幕等。这个库可以帮助开发者更方便地访问和处理设备相关的多媒体数据。

- libswscale:视频缩放库,提供视频的尺寸和像素格式转换功能。这个库可以帮助开发者在不同的视频格式之间进行快速、高效的转换。

- libswresample:音频重采样库,提供音频的采样率、格式和声道布局转换功能。这个库可以帮助开发者在不同的音频格式之间进行高质量的转换。

通过学习和使用这些库,我们可以为自己的应用程序添加多媒体处理功能,实现自定义的音视频处理任务。同时,这也有助于更深入地了解FFmpeg的内部实现原理。

8.2 编写自定义应用程序(Writing Custom Applications)

利用FFmpeg库来编写自定义应用程序,可以帮助我们实现特定的音视频处理任务。在编写自定义应用程序时,需要遵循以下基本步骤:

- 初始化库:在使用FFmpeg库之前,需要先进行一些初始化操作,如注册编解码器、封装格式、滤镜等。这些初始化操作通常可以通过调用相应库的

av_register_all()函数完成。 - 打开输入文件:使用

libavformat库的avformat_open_input()函数打开输入文件,并解析文件的元数据信息。这个过程会将文件的音频轨、视频轨、字幕轨等信息存储在AVFormatContext结构体中。 - 查找并配置编解码器:根据输入文件的编码格式,使用

libavcodec库的接口查找并配置相应的解码器。此外,还需要根据输出文件的编码格式查找并配置相应的编码器。 - 处理滤镜与效果:如果需要对音频或视频应用滤镜或效果,可以使用

libavfilter库创建滤镜图(Filtergraph),并将输入文件的音频、视频轨分别连接到相应的滤镜链。 - 解码、处理与编码:将输入文件的音频、视频轨分别解码成原始数据,然后进行滤镜处理或其他自定义处理。处理完成后,将原始数据编码成输出文件的编码格式。

- 输出文件封装:使用

libavformat库的接口将编码后的音频、视频轨封装成指定的输出文件格式,最后将封装好的文件写入磁盘。 - 释放资源:在处理完成后,需要正确释放所有分配的资源,如

AVFormatContext、AVCodecContext、AVFrame等。这可以通过调用相应库的av_free()或av_close()等函数完成。

通过遵循以上步骤,我们可以利用FFmpeg库编写自定义的音视频处理应用程序。这些程序可以满足特定的需求,例如批量转码、实时音视频处理、多媒体文件合并等。同时,这也有助于更深入地了解FFmpeg的内部实现原理。

8.3 使用FFmpeg API实现命令功能(Implementing Command Functions with FFmpeg API)

FFmpeg提供了丰富的API,使得开发者可以使用这些接口实现各种音视频处理任务。通过使用这些API,我们可以将FFmpeg命令行工具中的功能直接嵌入到我们的应用程序中。以下是一些实现FFmpeg命令行功能的API示例:

- 视频转码:要将视频从一种编码格式转换为另一种编码格式,我们可以使用libavcodec库中的解码器和编码器接口。例如,使用

avcodec_decode_video2()函数解码输入视频,然后使用avcodec_encode_video2()函数将解码后的数据编码为目标格式。 - 视频剪辑:要实现视频剪辑功能,我们需要先解码输入视频,然后根据剪辑的开始时间和结束时间选择需要保留的帧。接下来,将保留的帧编码并封装到输出文件中。这个过程可以通过使用libavcodec和libavformat库中的相关接口来实现。

- 视频合并:要实现视频合并功能,我们需要先打开多个输入文件,并将每个输入文件的视频轨解码成原始数据。接下来,将所有解码后的数据连接在一起,然后编码成目标格式。最后,将编码后的数据封装到输出文件中。这个过程可以通过使用libavcodec和libavformat库中的相关接口来实现。

- 音频转码:类似于视频转码,我们可以使用libavcodec库中的解码器和编码器接口来实现音频转码功能。例如,使用

avcodec_decode_audio4()函数解码输入音频,然后使用avcodec_encode_audio2()函数将解码后的数据编码为目标格式。 - 字幕处理:要实现字幕提取、合并或编辑功能,我们需要使用libavcodec和libavformat库中的相关接口。例如,使用

avcodec_decode_subtitle2()函数解码输入字幕,然后根据需要进行提取、合并或编辑操作。最后,使用avcodec_encode_subtitle()函数将处理后的字幕编码为目标格式。 - 滤镜处理:要实现滤镜处理功能,我们需要使用libavfilter库中的相关接口。例如,使用

avfilter_graph_create_filter()函数创建滤镜实例,然后使用avfilter_link()函数将滤镜连接到滤镜链上。最后,将解码后的音视频数据传递给滤镜链,并将处理后的数据编码为目标格式。

8.4 FFmpeg的实时音视频处理(Real-Time Processing in FFmpeg)

实时音视频处理是一种在有限的时间内对音视频数据进行处理和传输的技术,广泛应用于直播、视频会议、远程教育等场景。实时音视频处理需要满足低延迟、高质量、稳定性等要求。FFmpeg提供了一套强大的实时音视频处理功能,支持多种网络协议和实时编码技术。在本节中,我们将简要介绍FFmpeg的实时音视频处理原理和实现。

-

实时音视频处理原理

实时音视频处理通常包括以下几个步骤:

- 采集:从音视频设备(如摄像头、麦克风等)获取音视频数据。

- 编码:将原始音视频数据压缩为较小的数据包,以便传输和存储。

- 传输:通过网络协议(如RTMP、RTP、SRT等)将编码后的音视频数据发送到服务器或客户端。

- 解码:将接收到的音视频数据解压缩为原始格式,以便播放和处理。

- 渲染:将解码后的音视频数据显示在屏幕上或输出到音响设备。

实时音视频处理的关键挑战是在有限的时间内实现高质量的音视频编码、传输和解码,以满足用户的实时交互需求。

-

FFmpeg中的实时音视频处理实现

FFmpeg提供了一套完整的实时音视频处理解决方案,支持多种采集设备、编解码器、网络协议和封装格式。以下是一些典型的实时音视频处理功能:

- 设备采集:FFmpeg支持从摄像头、麦克风等设备采集音视频数据,如

-f v4l2(Linux摄像头采集)和-f dshow(Windows摄像头采集)等。 - 实时编解码:FFmpeg提供了多种实时编解码器,如

libx264(H.264实时编码器)和libfdk_aac(AAC实时音频编码器)等。这些编解码器可以通过-c:v和-c:a选项在命令行中指定。 - 网络传输:FFmpeg支持多种网络协议,如RTMP、RTP、SRT等。这些协议可以用于实时音视频数据的发送和接收,如

-f rtp(RTP协议发送)和-i rtmp://server/app/stream(RTMP协议接收)等。 - 封装格式:FFmpeg支持多种实时封装格式,如MPEG-TS、FLV等。

这些封装格式可以用于实时音视频数据的打包和解包,如-f mpegts(MPEG-TS封装)和-f flv(FLV封装)等。

在使用FFmpeg进行实时音视频处理时,用户可以通过命令行选项组合不同的功能,以实现定制化的实时音视频解决方案。例如,以下命令将从摄像头采集视频数据,使用H.264编码,通过RTP协议发送到指定地址:

ffmpeg -f v4l2 -i /dev/video0 -c:v libx264 -f rtp rtp://192.168.1.100:1234在阅读FFmpeg源码时,可以从

libavdevice库(设备采集)、libavcodec库(编解码器)、libavformat库(网络协议和封装格式)等入手,深入了解实时音视频处理的原理和实现细节。同时,也可以学习FFmpeg如何通过统一的接口和框架来组织和调用这些功能,以实现高效的实时音视频处理。 - 设备采集:FFmpeg支持从摄像头、麦克风等设备采集音视频数据,如

-

自定义实时音视频处理

在某些情况下,用户可能需要实现自定义的实时音视频处理功能,以满足特定需求。为了实现自定义实时音视频处理,用户可以基于FFmpeg提供的API和框架进行开发。以下是一些可能的自定义实现:

- 设备采集:用户可以开发自定义的设备采集模块,以支持特定的硬件设备或采集方式。这可以通过实现

AVInputFormat结构和相关函数来完成。 - 编解码器:用户可以开发自定义的编解码器,以支持特定的编码格式或优化算法。这可以通过实现

AVCodec结构和相关函数来完成。 - 网络协议:用户可以开发自定义的网络协议,以支持特定的传输方式或优化策略。这可以通过实现

URLProtocol结构和相关函数来完成。 - 封装格式:用户可以开发自定义的封装格式,以支持特定的容器格式或优化策略。这可以通过实现

AVOutputFormat和AVInputFormat结构和相关函数来完成。

- 设备采集:用户可以开发自定义的设备采集模块,以支持特定的硬件设备或采集方式。这可以通过实现

在实现自定义实时音视频处理时,用户可以参考FFmpeg源码中已有的实现,如libavdevice/v4l2.c(摄像头采集)、libavcodec/libx264.c(H.264编码器)、libavformat/rtpproto.c(RTP协议)等。通过学习这些源码,用户可以更深入地了解实时音视频处理的原理和实现细节,以及FFmpeg如何通过统一的接口和框架来组织和调用这些功能。

九、优化与性能调整(Optimization and Performance Tuning)

9.1 硬件加速(Hardware Acceleration)

在处理高清音视频数据时,硬件加速技术可以显著提高编解码和滤镜处理的性能,降低CPU占用率。FFmpeg支持多种硬件加速技术,如NVIDIA的NVENC/NVDEC、Intel的QSV(Quick Sync Video)和AMD的AMF(Advanced Media Framework)等。在本节中,我们将简要介绍FFmpeg中的硬件加速原理和实现。

- 硬件加速原理

硬件加速技术通常利用专用的音视频处理器(如GPU、DSP等)来实现编解码和滤镜处理等任务,从而减轻CPU的负担。不同的硬件厂商提供了不同的硬件加速技术和接口,如NVIDIA的CUDA、Intel的Media SDK和AMD的OpenVideo等。这些技术和接口通常与特定的硬件平台(如显卡、处理器等)紧密相关。

- FFmpeg中的硬件加速实现

FFmpeg通过统一的硬件加速框架(如AVHWDeviceContext和AVHWFramesContext)来支持不同的硬件加速技术。这个框架提供了一套抽象的接口,用于管理硬件设备和硬件帧缓冲区。通过这些接口,FFmpeg可以在不同的硬件平台上实现高效的音视频处理。

FFmpeg支持的硬件加速技术主要包括以下几类:

- 编解码加速:FFmpeg提供了基于硬件加速的编解码器实现,如h264_nvenc(基于NVIDIA NVENC的H.264编码器)、hevc_qsv(基于Intel QSV的H.265编码器)和h264_amf(基于AMD AMF的H.264编码器)等。这些编解码器可以通过

-c:v和-c:a选项在命令行中指定。 - 滤镜加速:FFmpeg提供了基于硬件加速的滤镜实现,如scale_npp(基于NVIDIA CUDA的视频缩放滤镜)、scale_qsv(基于Intel QSV的视频缩放滤镜)和scale_opencl(基于OpenCL的视频缩放滤镜)等。这些滤镜可以通过

-vf和-af选项在命令行中指定。 - 格式转换加速:FFmpeg支持基于硬件加速的格式转换(如YUV到RGB、RGB到YUV等),以实现更高效的色彩空间和像素格式处理。用户可以通过

-pix_fmt选项在命令行中指定目标像素格式。

在使用FFmpeg命令行工具时,用户可以通过-hwaccel选项来启用硬件加速功能。例如,以下命令将使用NVIDIA NVDEC进行H.264视频解码,并将解码后的视频保存为output.yuv文件:

ffmpeg -hwaccel nvdec -i input.mp4 -c:v rawvideo -pix_fmt yuv420p output.yuv

在阅读FFmpeg源码时,可以从libavutil/hwcontext.h(硬件加速框架)和libavcodec/nvenc.c(NVIDIA NVENC编解码器实现)等文件入手,深入了解FFmpeg中的硬件加速原理和实现细节。

- 自定义硬件加速实现

在某些情况下,用户可能需要实现自定义的硬件加速功能,以满足特定需求。为了实现自定义硬件加速,用户需要遵循以下步骤:

- 定义硬件加速结构:首先,用户需要定义一个硬件加速结构(如

AVHWDeviceContext和AVHWFramesContext),并为其指定硬件设备和硬件帧缓冲区的信息。这个结构将作为硬件加速实例的基本描述信息。 - 实现硬件加速函数:接下来,用户需要实现硬件加速的初始化函数、处理函数等。这些函数将负责执行具体的音视频处理操作,如编解码、滤镜处理等。

- 注册硬件加速:最后,用户需要将自定义硬件加速注册到FFmpeg硬件加速框架中,以便在编解码器和滤镜中使用。用户可以通过调用

av_hwdevice_register()和av_hwframe_register()函数来实现这一点。

在实现自定义硬件加速时,用户可以参考FFmpeg源码中已有的硬件加速实现,如libavutil/hwcontext_cuda.c(NVIDIA CUDA硬件加速)和libavutil/hwcontext_qsv.c(Intel QSV硬件加速)等。通过学习这些源码,用户可以更深入地了解FFmpeg中的硬件加速原理和实现细节。

9.2 多线程与并发处理(Multithreading and Concurrent Processing)

多线程和并发处理是另一种提高FFmpeg性能的方法。FFmpeg支持多线程处理,可以充分利用多核处理器的计算能力。要启用多线程处理,需要在运行时指定线程数(例如,通过-threads参数)。此外,还可以使用并发处理技术,如异步I/O、线程池等,进一步提高处理速度。

9.3 调优技巧与建议(Tuning Tips and Suggestions)

在使用FFmpeg进行音视频处理时,可以通过一些调优技巧和建议来提高性能。以下是一些建议:

- 选择合适的编解码器:不同编解码器的性能和压缩效果可能有很大差别。选择合适的编解码器,可以根据实际需求平衡处理速度和输出质量。

- 调整编码参数:可以通过调整编码参数,如比特率、GOP大小、帧率等,来优化输出文件的大小和质量。这些参数需要根据实际需求进行权衡。

- 使用预设选项:许多编解码器提供了预设选项,如x264的

-preset参数。这些预设选项可以帮助快速选择一组性能和质量之间的平衡参数。 - 利用缓存和磁盘I/O优化:通过使用内存缓存和磁盘I/O优化技术,可以减少读写磁盘的次数,从而提高处理速度。

9.4 FFmpeg的封装格式处理(Container Formats in FFmpeg)

封装格式(也称为容器格式)是一种用于存储和传输多媒体数据的文件格式,如MP4、MKV、MOV、FLV等。封装格式通常包含多种音视频流、字幕流和元数据等信息,并为这些信息提供了同步和索引等功能。FFmpeg支持大量的封装格式,并提供了一套抽象的接口来处理这些格式。在本节中,我们将简要介绍FFmpeg的封装格式处理原理和实现。

- 封装格式原理

封装格式通常由以下几部分组成:

- 文件头(File Header):存储文件的基本信息,如文件类型、版本等。

- 元数据(Metadata):存储音视频流的描述信息,如编码格式、分辨率、码率等。

- 数据流(Streams):存储实际的音视频数据,如编码后的帧数据、字幕数据等。

- 索引(Index):存储音视频数据的位置信息,以便快速定位和播放。

封装格式的主要任务是对音视频数据进行组织和存储,以实现多媒体数据的高效传输和播放。

- FFmpeg中的封装格式实现

FFmpeg通过统一的封装格式框架(如AVFormatContext和AVStream)来支持不同的封装格式。这个框架提供了一套抽象的接口,用于管理封装格式的信息和数据流。通过这些接口,FFmpeg可以实现各种封装格式的读取、写入、转换等操作。

FFmpeg支持的封装格式主要包括以下几类:

- 标准封装格式:如MP4、MKV、MOV、FLV等。

- 音频封装格式:如MP3、AAC、WAV、FLAC等。

- 网络封装格式:如HTTP Live Streaming(HLS)、Dynamic Adaptive Streaming over HTTP(DASH)、Real-Time Messaging Protocol(RTMP)等。

在使用FFmpeg命令行工具时,用户可以通过-f选项来指定封装格式。例如,以下命令将输入视频文件input.mp4转换为MKV格式,并保存为output.mkv:

ffmpeg -i input.mp4 -f matroska output.mkv

在阅读FFmpeg源码时,可以从libavformat库中的封装格式实现入手,深入了解各种封装格式的工作原理和实现细节。同时,也可以学习FFmpeg如何通过统一的接口来管理和调用这些封装格式,以实现灵活的多媒体处理功能。

- 自定义封装格式

在某些情况下,用户可能需要实现自定义的封装格式,以满足特定需求。为了实现自定义封装格式,用户需要遵循以下步骤:

- 定义封装格式结构:首先,用户需要定义一个封装格式结构(如

AVOutputFormat和AVInputFormat),并为其指定封装格式的名称、扩展名、MIME类型等信息。这个结构将作为封装格式实例的基本描述信息。 - 实现封装格式函数:接下来,用户需要实现封装格式的读取函数、写入函数、探测函数等。这些函数将负责执行具体的封装格式处理操作,如读取文件头、写入元数据、解析数据流等。

- 注册封装格式:最后,用户需要将自定义封装格式注册到FFmpeg封装格式框架中,以便在命令行工具和API中使用。用户可以通过调用

av_register_output_format()和av_register_input_format()函数来实现这一点。

在实现自定义封装格式时,用户可以参考FFmpeg源码中已有的封装格式实现,如libavformat/movenc.c(MP4/MOV封装格式)和libavformat/matroskaenc.c(MKV封装格式)等。通过学习这些源码,用户可以更深入地了解封装格式的工作原理和实现细节,以及FFmpeg如何通过统一的接口来管理和调用这些封装格式。

十、音视频同步

10.1 FFmpeg中的音视频同步原理(Audio-Video Synchronization in FFmpeg)

音视频同步是指保持音频和视频帧之间的时间关系,以确保音画同步播放。在处理音视频流时,音视频同步是一个关键的技术挑战。FFmpeg作为一个强大的音视频处理工具,提供了一套音视频同步的原理和实现。在本节中,我们将简要介绍FFmpeg中的音视频同步原理。

-

时间基(Time Base)

在FFmpeg中,音视频同步的基础概念是时间基(Time Base)。时间基是一个时间单位,用于表示音视频帧的时间戳(Timestamp)。通常,时间基与音视频流的帧率或采样率成反比,如视频流的时间基可以是1/30秒(30fps),音频流的时间基可以是1/48000秒(48kHz)。

时间基的作用是将音视频帧的时间戳转换为实际时间。例如,一个视频帧的时间戳是900(时间基为1/30秒),则该帧的实际播放时间是900 *(1/30)秒=30秒。

-

音视频同步算法

FFmpeg采用一种基于PTS(Presentation Timestamp)的音视频同步算法。PTS是音视频帧的显示时间,用于指示该帧应该在什么时候播放。在FFmpeg中,音视频同步的关键是计算和维护正确的PTS。

以下是FFmpeg中的音视频同步算法的主要步骤:

- 解码:在解码音视频帧时,FFmpeg会从输入流中提取PTS,并根据时间基将其转换为实际时间。

- 同步:在播放音视频时,FFmpeg会根据音频时钟(Audio Clock)和视频时钟(Video Clock)来调整音视频帧的播放顺序和速度。音频时钟和视频时钟是指当前已经播放的音频和视频的时间。

- 调整:根据音频时钟和视频时钟的差值,FFmpeg会采取一定的策略来调整音视频同步,如丢弃视频帧、插入音频静音、延迟音频播放等。

-

FFmpeg中的音视频同步实现

FFmpeg中的音视频同步实现主要位于

libavformat库(音视频流处理)、libavcodec库(音视频解码)、libavfilter库(音视频滤镜)等部分。在阅读FFmpeg源码时,可以从这些部分入手,深入了解音视频同步的原理和实现细节。同时,也可以学习FFmpeg如何通过统一的接口和框架来组织和调用这些功能,以实现高效的音视频同步处理。

10.2 音视频同步问题的诊断与调试(Diagnosing and Debugging Audio-Video Synchronization Issues)

音视频同步问题可能会导致音画不同步、播放卡顿等现象,给用户带来不良的观看体验。因此,诊断和调试音视频同步问题是音视频处理过程中的重要任务。在本节中,我们将介绍如何使用FFmpeg诊断和调试音视频同步问题。

-

诊断音视频同步问题

诊断音视频同步问题的第一步是确认是否存在同步问题。用户可以通过以下方法来诊断音视频同步问题:

- 观察播放现象:观察音视频播放时是否存在音画不同步、播放卡顿等现象。

- 检查音视频流信息:使用

ffprobe命令查看音视频流的信息,如帧率、采样率、时间基等。例如:ffprobe input.mp4 - 分析音视频帧的PTS:使用

ffprobe命令查看音视频帧的PTS,以分析音视频同步关系。例如:ffprobe -select_streams v -show_frames -print_format csv input.mp4

-

调试音视频同步问题

调试音视频同步问题的关键是找到导致同步问题的原因,并采取相应的处理策略。以下是一些建议和方法:

- 调整音视频同步阈值:FFmpeg允许用户通过

-async和-vsync选项来调整音视频同步阈值,以解决轻微的同步问题。例如:ffmpeg -i input.mp4 -async 1 -vsync 1 output.mp4 - 重新计算音视频帧的PTS:使用

-itsoffset选项来调整音视频流的初始PTS,以解决因为时间戳错误导致的同步问题。例如:ffmpeg -i input.mp4 -itsoffset 1.0 -i input.mp4 -c copy output.mp4 - 使用滤镜处理音视频同步问题:FFmpeg提供了

asetpts和setpts滤镜来重新计算音频和视频帧的PTS。例如:ffmpeg -i input.mp4 -af "asetpts=PTS+1.0/TB" -vf "setpts=PTS+1.0/TB" output.mp4

- 调整音视频同步阈值:FFmpeg允许用户通过

-

阅读FFmpeg源码以深入了解音视频同步原理

为了更深入地了解音视频同步的原理和实现细节,用户可以阅读FFmpeg源码中与音视频同步相关的部分,如

libavformat库(音视频流处理)、libavcodec库(音视频解码)、libavfilter库(音视频滤镜)等。通过学习这些源码,用户可以更好地理解音视频同步问题的成因和解决方案,并为调试音视频同步问题提供有力的支持。 -

使用第三方工具辅助调试

除了FFmpeg本身的功能外,还有一些第三方工具可以帮助用户调试音视频同步问题,如:

- 视频播放器:一些高级的视频播放器,如VLC、PotPlayer等,提供了音视频同步调整功能。用户可以在播放过程中实时调整音视频同步,以找到合适的同步参数。

- 音视频分析工具:一些专业的音视频分析工具,如Elecard StreamEye、Inlet Rant、Telestream Vidchecker等,可以帮助用户分析音视频流的详细信息,以发现潜在的同步问题。

通过使用这些工具,用户可以更方便地诊断和调试音视频同步问题,以确保音视频播放的质量和稳定性。

总之,音视频同步问题的诊断和调试是音视频处理过程中的一个重要环节。用户需要掌握一定的音视频同步原理和技巧,以解决实际工作中遇到的同步问题。通过使用FFmpeg和其他辅助工具,用户可以有效地发现和解决音视频同步问题,提高音视频处理的质量和效率。

10.3 FFmpeg中的实时音视频处理(Real-time Audio-Video Processing in FFmpeg)

实时音视频处理是指在音视频数据传输和播放过程中,实时对音视频数据进行处理,以满足特定的质量、性能和应用需求。在本节中,我们将介绍FFmpeg如何支持实时音视频处理,以及如何利用FFmpeg进行实时音视频处理的实现和优化。

-

FFmpeg的实时音视频处理支持

FFmpeg作为一个强大的音视频处理工具,提供了一系列功能来支持实时音视频处理,包括:

- 实时输入输出:FFmpeg支持实时音视频流的输入和输出,如RTSP、RTP、HTTP等协议。用户可以使用FFmpeg捕获、传输和接收实时音视频流。

- 音视频编解码:FFmpeg支持多种音视频编解码格式,如H.264、HEVC、AAC等。用户可以使用FFmpeg实时编解码音视频流,以满足特定的质量和性能需求。

- 音视频滤镜:FFmpeg提供了丰富的音视频滤镜,如缩放、裁剪、调色等。用户可以使用FFmpeg实时处理音视频流,以实现特定的效果和优化。

-

实现实时音视频处理的方法

以下是一些使用FFmpeg实现实时音视频处理的方法和技巧:

- 实时音视频流输入:使用

-i选项指定实时音视频流的地址,如:ffmpeg -i rtsp://example.com/stream.sdp - 实时音视频流输出:使用

-f选项指定实时音视频流的格式,如:ffmpeg -i input.mp4 -f rtsp rtsp://example.com/stream.sdp - 实时音视频编解码:使用

-c:v和-c:a选项指定音视频编解码器,如:ffmpeg -i input.mp4 -c:v libx264 -c:a aac output.mp4 - 实时音视频滤镜:使用

-vf和-af选项指定音视频滤镜,如:ffmpeg -i input.mp4 -vf "scale=1280:720" -af "volume=0.5" output.mp4

- 实时音视频流输入:使用

-

优化实时音视频处理的性能

为了提高实时音视频处理的性能,用户可以采取以下措施:

- 使用硬件加速:FFmpeg支持多种硬件加速技术,如NVIDIA CUDA、Intel QSV、AMD AMF等。用户可以使用硬件加速来提高实时音视频编解码的性能。

- 调整编解码参数:用户可以调整音视频编解码器的参数,如码率、GOP大小、预设等,以平衡质量和性能。

- 使用多线程:FFmpeg支持多线程和异步处理。用户可以通过调整

-threads选项来提高实时音视频处理的性能。ffmpeg -i input.mp4 -c:v libx264 -threads 4 output.mp4 - 调整缓冲区大小和延迟:为了减少实时音视频处理过程中的延迟和卡顿,用户可以调整输入输出缓冲区的大小和最大延迟。例如,使用

-bufsize和-max_delay选项:ffmpeg -i input.mp4 -f rtsp -bufsize 1M -max_delay 100 rtsp://example.com/stream.sdp

-

实时音视频处理的应用场景

实时音视频处理在许多应用场景中具有重要价值,如:

- 直播:实时音视频处理可以用于实现直播编码、转码和分发,以支持多种设备和网络环境。

- 视频会议:实时音视频处理可以用于视频会议中的音视频采集、编解码和传输,以保证通话质量和稳定性。

- 监控:实时音视频处理可以用于监控系统中的视频捕获、分析和存储,以满足安全和管理需求。

通过掌握FFmpeg的实时音视频处理功能和技巧,用户可以在实际工作和项目中灵活地应用实时音视频处理技术,以解决各种音视频处理问题和需求。

总之,FFmpeg为实时音视频处理提供了强大的支持和灵活性。用户可以通过学习和掌握FFmpeg的实时音视频处理方法和优化技巧,以应对各种实时音视频处理场景和挑战。同时,用户还可以通过阅读FFmpeg源码,深入了解实时音视频处理的原理和实现细节,以提高自己的音视频处理能力和技术水平。

十一、图像技术

11.1 FFmpeg中的图像处理技术(Image Processing Techniques in FFmpeg)

FFmpeg不仅仅局限于音视频处理,还具有强大的图像处理能力。本节将介绍FFmpeg中的图像处理技术,如图像格式转换、图像滤镜和图像动画等功能。

-

图像格式转换

FFmpeg支持众多图像格式,包括JPEG、PNG、BMP、GIF等。用户可以使用FFmpeg轻松地在不同图像格式之间进行转换。例如,将JPEG图像转换为PNG格式:

ffmpeg -i input.jpg output.png -

图像滤镜

FFmpeg提供了一系列图像滤镜,可以对图像进行缩放、裁剪、旋转、翻转等操作。以下是一些常见的图像滤镜示例:

- 缩放图像:

ffmpeg -i input.jpg -vf "scale=800:600" output.jpg - 裁剪图像:

ffmpeg -i input.jpg -vf "crop=400:300:100:50" output.jpg - 旋转图像:

ffmpeg -i input.jpg -vf "transpose=1" output.jpg - 翻转图像:

ffmpeg -i input.jpg -vf "hflip" output.jpg

- 缩放图像:

-

图像动画

FFmpeg还可以用于创建和处理图像动画,如GIF动画。以下是一些与图像动画相关的操作示例:

- 从视频中提取帧并创建GIF动画:

ffmpeg -i input.mp4 -vf "fps=10,scale=320:-1:flags=lanczos" output.gif - 将多张图像合成为GIF动画:

ffmpeg -framerate 5 -i image%d.jpg output.gif - 调整GIF动画的播放速度:

ffmpeg -i input.gif -filter:v "setpts=0.5*PTS" output.gif

通过学习和掌握FFmpeg中的图像处理技术,用户可以轻松地完成各种图像处理任务,提高图像处理的效率和质量。同时,用户还可以通过阅读FFmpeg源码,深入了解图像处理的原理和实现细节,以提高自己的图像处理能力和技术水平。

- 从视频中提取帧并创建GIF动画:

11.2 FFmpeg与OpenCV的结合应用(Combining FFmpeg and OpenCV)

OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉库,提供了许多图像和视频处理功能。FFmpeg与OpenCV相结合,可以实现更强大、灵活的音视频和图像处理功能。在本节中,我们将介绍如何结合FFmpeg和OpenCV进行音视频处理。

-

FFmpeg与OpenCV的交互

FFmpeg可以用于音视频数据的输入输出,而OpenCV则可以用于图像和视频的处理。为了结合两者的功能,用户需要实现FFmpeg与OpenCV之间的数据交互。

以下是使用C++结合FFmpeg与OpenCV进行实时人脸检测的示例:

#include <iostream> #include <opencv2/opencv.hpp> #include <opencv2/objdetect.hpp>extern "C" { #include <libavcodec/avcodec.h> #include <libavformat/avformat.h> #include <libavutil/imgutils.h> #include <libswscale/swscale.h> }int main() {// 初始化FFmpegav_register_all();avformat_network_init();AVFormatContext *formatContext = nullptr;AVCodecContext *codecContext = nullptr;AVCodec *codec = nullptr;// 打开摄像头设备if (avformat_open_input(&formatContext, "/dev/video0", nullptr, nullptr) != 0) {std::cerr << "Failed to open video device" << std::endl;return -1;}avformat_find_stream_info(formatContext, nullptr);int videoStreamIndex = av_find_best_stream(formatContext, AVMEDIA_TYPE_VIDEO, -1, -1, &codec, 0);codecContext = avcodec_alloc_context3(codec);avcodec_parameters_to_context(codecContext, formatContext->streams[videoStreamIndex]->codecpar);avcodec_open2(codecContext, codec, nullptr);// 初始化OpenCV的人脸检测器cv::CascadeClassifier face_cascade;face_cascade.load("haarcascade_frontalface_default.xml");AVFrame *frame = av_frame_alloc();AVPacket packet;cv::Mat img;while (true) {// 从FFmpeg输出中读取图像数据av_read_frame(formatContext, &packet);if (packet.stream_index == videoStreamIndex) {int ret = avcodec_send_packet(codecContext, &packet);if (ret < 0) {std::cerr << "Failed to send packet" << std::endl;break;}ret = avcodec_receive_frame(codecContext, frame);if (ret < 0) {std::cerr << "Failed to receive frame" << std::endl;break;}// 使用OpenCV进行人脸检测img = cv::Mat(codecContext->height, codecContext->width, CV_8UC3, frame->data[0], frame->linesize[0]);cv::cvtColor(img, img, cv::COLOR_YUV2BGR);std::vector<cv::Rect> faces;cv::Mat gray;cv::cvtColor(img, gray, cv::COLOR_BGR2GRAY);face_cascade.detectMultiScale(gray, faces);// 在检测到的人脸周围绘制矩形框for (const auto &face : faces) {cv::rectangle(img, face, cv::Scalar(255, 0, 0), 2);}// 显示处理后的图像cv::imshow("Face Detection", img);cv::waitKey(1);}av_packet_unref(&packet);}av_frame_free(&frame);avcodec_free_context(&codecContext);avformat_close_input(&formatContext);return 0; }请注意,您需要在C++环境中安装FFmpeg库和OpenCV库才能编译和运行上述代码。此示例展示了如何使用C++结合FFmpeg与OpenCV进行实时人脸检测。

-

实时视频处理与分析

结合FFmpeg和OpenCV,可以对实时视频进行处理和分析。例如,用户可以对实时视频流进行目标检测、跟踪和识别等操作。以下是一个使用FFmpeg读取实时视频流,然后使用OpenCV进行目标检测的例子:

#include <iostream> #include <opencv2/opencv.hpp> #include <opencv2/objdetect.hpp>extern "C" { #include <libavcodec/avcodec.h> #include <libavformat/avformat.h> #include <libavutil/imgutils.h> #include <libswscale/swscale.h> }int main() {// 初始化FFmpegav_register_all();avformat_network_init();AVFormatContext *formatContext = nullptr;AVCodecContext *codecContext = nullptr;AVCodec *codec = nullptr;// 打开实时视频流地址if (avformat_open_input(&formatContext, "rtsp://example.com/stream.sdp", nullptr, nullptr) != 0) {std::cerr << "Failed to open video stream" << std::endl;return -1;}avformat_find_stream_info(formatContext, nullptr);int videoStreamIndex = av_find_best_stream(formatContext, AVMEDIA_TYPE_VIDEO, -1, -1, &codec, 0);codecContext = avcodec_alloc_context3(codec);avcodec_parameters_to_context(codecContext, formatContext->streams[videoStreamIndex]->codecpar);avcodec_open2(codecContext, codec, nullptr);// 初始化OpenCV的目标检测器cv::HOGDescriptor hog;hog.setSVMDetector(cv::HOGDescriptor::getDefaultPeopleDetector());AVFrame *frame = av_frame_alloc();AVPacket packet;cv::Mat img;while (true) {// 从FFmpeg输出中读取图像数据av_read_frame(formatContext, &packet);if (packet.stream_index == videoStreamIndex) {int ret = avcodec_send_packet(codecContext, &packet);if (ret < 0) {std::cerr << "Failed to send packet" << std::endl;break;}ret = avcodec_receive_frame(codecContext, frame);if (ret < 0) {std::cerr << "Failed to receive frame" << std::endl;break;}// 使用OpenCV进行目标检测img = cv::Mat(codecContext->height, codecContext->width, CV_8UC3, frame->data[0], frame->linesize[0]);cv::cvtColor(img, img, cv::COLOR_YUV2BGR);std::vector<cv::Rect> found;hog.detectMultiScale(img, found, 0, cv::Size(8, 8), cv::Size(32, 32), 1.05, 2);// 在检测到的目标周围绘制矩形框for (const auto &rect : found) {cv::rectangle(img, rect, cv::Scalar(0, 255, 0), 2);}// 显示处理后的图像cv::imshow("Object Detection", img);cv::waitKey(1);}av_packet_unref(&packet);}av_frame_free(&frame);avcodec_free_context(&codecContext);avformat_close_input(&formatContext);return 0; }请注意,您需要在C++环境中安装FFmpeg库和OpenCV库才能编译和运行上述代码。此示例展示了如何使用C++结合FFmpeg与OpenCV进行实时目标检测。

您可以根据需要使用不同的目标检测算法替换HOGDescriptor,以适应各种应用场景。结合FFmpeg与OpenCV,您可以实现各种实时音视频处理与分析功能。

11.3 FFmpeg与深度学习模型的结合(Integrating FFmpeg with Deep Learning Models)

深度学习技术在图像和视频处理方面取得了显著的成功。结合FFmpeg与深度学习模型,可以实现各种复杂的音视频处理任务,例如实时物体检测、人脸识别和姿态估计等。在本节中,我们将介绍如何将FFmpeg与深度学习模型结合使用。

-

使用FFmpeg读取图像和视频数据

为了将FFmpeg与深度学习模型结合使用,首先需要使用FFmpeg从图像或视频中读取数据。这可以通过调用FFmpeg库的API来实现。参考前面章节的示例,使用FFmpeg读取视频帧并将其转换为OpenCV的Mat格式。之后,可以将Mat格式的数据输入到深度学习模型中。

-

预处理图像数据

在将图像数据输入到深度学习模型之前,通常需要对图像进行预处理,以满足模型的输入要求。预处理操作可能包括缩放、裁剪、归一化等。这些操作可以使用OpenCV库完成。

例如,假设我们需要将图像缩放到指定大小并进行归一化:

cv::Mat img; // 读取图像数据...// 缩放图像 cv::resize(img, img, cv::Size(224, 224));// 归一化图像数据 img.convertTo(img, CV_32F, 1.0 / 255.0); -

将图像数据输入到深度学习模型

完成图像数据的预处理后,可以将其输入到深度学习模型中。这可以使用深度学习框架(如TensorFlow、PyTorch或OpenCV的DNN模块)实现。以下是一个使用OpenCV的DNN模块加载并运行深度学习模型的示例:

#include <opencv2/opencv.hpp> #include <opencv2/dnn.hpp>int main() {cv::Mat img;// 读取并预处理图像数据...// 加载深度学习模型cv::dnn::Net net = cv::dnn::readNetFromONNX("model.onnx");// 将图像数据输入到模型中cv::Mat inputBlob = cv::dnn::blobFromImage(img);net.setInput(inputBlob);// 运行模型cv::Mat output = net.forward();// 处理模型输出...return 0; }

结合FFmpeg、OpenCV与深度学习模型,可以实现各种复杂的音视频处理任务。不同的任务可能需要不同的深度学习模型和预处理方法,因此需要根据具体需求进行调整。

十二、总结与展望(Conclusion and Outlook)

12.1 学到的知识与技能(Learned Knowledge and Skills)

通过本文的学习,我们了解了FFmpeg命令行的基本使用方法、实现原理以及如何利用FFmpeg库编写自定义应用程序。这些知识和技能可以帮助我们在实际工作中更有效地处理音视频任务,同时也为我们提供了深入了解FFmpeg内部实现的基础。

12.2 FFmpeg未来的发展趋势(Future Development Trends of FFmpeg)

随着多媒体技术的不断发展,FFmpeg也在持续更新和完善。在未来,FFmpeg可能会继续关注以下方面的发展:

- 支持更多的编解码器和格式:随着新的编解码器和格式的出现,FFmpeg将继续扩展其支持范围,以满足各种音视频处理需求。

- 提高性能和兼容性:FFmpeg将继续优化内部实现,提高处理性能,并增强对各种硬件和操作系统的兼容性。

- 更加强大的滤镜和效果:随着视觉处理技术的进步,FFmpeg将引入更多高级的滤镜和效果,使得音视频处理更加丰富多样。

- 提升易用性和文档完善:FFmpeg将努力提高命令行工具和API的易用性,同时完善相关文档,降低开发者和用户的学习成本。

通过对FFmpeg的深入了解,我们可以更好地应对各种音视频处理挑战,充分发挥FFmpeg的强大功能。同时,我们也期待FFmpeg在未来能够不断发展,为我们提供更加高效、灵活的音视频处理工具。

尽管FFmpeg命令行提供了丰富的功能,但有些特定任务可能无法直接通过命令行实现。这时,可以使用FFmpeg库和API来编写自定义代码,以实现这些特定功能。以下是一些可能需要使用FFmpeg库和API实现的功能:

- 复杂的音视频处理逻辑:例如,根据输入视频的特定内容(如场景变换、动作检测等)实现自适应的处理逻辑。

- 实时音视频处理:使用FFmpeg库进行实时音视频处理,如实时视频转码、实时图像识别等。

- 集成到现有程序中:如果需要将FFmpeg的功能集成到现有的应用程序或系统中,可以使用FFmpeg库和API来实现。

- 定制化的滤镜和效果:尽管FFmpeg提供了很多内置滤镜,但在某些情况下,可能需要开发自定义滤镜或效果以满足特定需求。

- 定制编解码器:如果需要对现有编解码器进行定制或开发新的编解码器,可以使用FFmpeg库和API来实现。

- 多媒体文件的深度分析:通过FFmpeg库和API,可以更深入地分析多媒体文件的元数据、编解码器信息等,以实现一些高级分析功能。

- 高级的同步和混合功能:在某些场景下,可能需要实现复杂的音视频同步和混合功能,例如将多个音频轨道按照指定规则混合到一个视频文件中。

- 基于事件的回调:通过FFmpeg库,可以实现基于事件的回调机制,例如在音视频处理过程中的某个阶段触发自定义函数。

- 分布式处理和云服务集成:使用FFmpeg库,可以将音视频处理任务分布到多台服务器上执行,或者将处理任务集成到云服务中。

使用FFmpeg库和API,我们可以实现更为灵活和定制化的音视频处理功能,满足各种特殊需求和场景。

相关文章:

FFmpeg命令行解析

目录标题 一、引言(Introduction)1.1 FFmpeg简介(Overview of FFmpeg)1.2 FFmpeg命令行的应用场景(Application Scenarios of FFmpeg Command Line) 二、FFmpeg命令行基础(FFmpeg Command Line …...

机器学习——为什么逻辑斯特回归(logistic regression)是线性模型

问:逻辑斯蒂回归是一种典型的线性回归模型。 答:正确。逻辑斯蒂回归是一种典型的线性回归模型。它通过将线性回归模型的输出结果映射到[0,1]区间内,表示某个事物发生的概率,从而适用于二分类问题。具体地说,它使用sig…...

从输入URL到页面展示到底发生了什么

刚开始写这篇文章还是挺纠结的,因为网上搜索“从输入url到页面展示到底发生了什么”,你可以搜到一大堆的资料。而且面试这道题基本是必考题,二月份面试的时候,虽然知道这个过程发生了什么,不过当面试官一步步追问下去的…...

Qt connect传参方式及lambda函数传参方式详解

Qt connect传参方式及lambda函数传参方式详解 Qt是一种流行的跨平台C应用程序框架,它提供了许多有用的工具和函数来帮助开发人员构建高效的图形用户界面和其他应用程序。其中,Qt Connect函数是用于连接信号和槽的重要函数之一,它可以在Qt应用…...

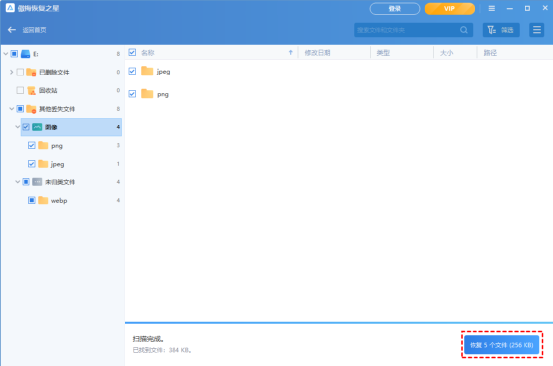

如何在硬盘上恢复已经删除的照片?

可以从硬盘恢复删除的照片吗? 旅行后,许多人倾向于将照片保存到另一个储存设备作为副本或备份。例如,将它们存储在外部硬盘上或将图片传输到电脑。但是在整理照片的时候,很可能不小心把照片删掉了,尤其是使用外接硬…...

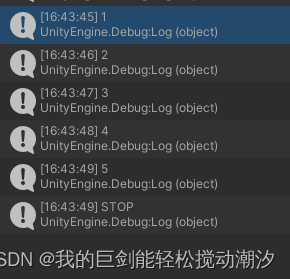

Unity日记22(携程概念)

目录 学习视频 携程 1异步 2调用方法 3优点 4停止方法 5返回值 实例:每过一秒打印当前运行时间 实例:停止数字打印携程 错误方法:(携程只能开一个) 参考方法 学习视频 https://www.bilibili.com/video/BV1eu…...

01-Linux-磁盘分区与目录配置

1. 主引导纪录和磁盘分区表 1.1 MBR分区表 启动引导程序记录区与分区表都放在磁盘的第一个扇区(512B) 由于分区表仅占 64B,因此最多能有四组记录区,每组记录区记录了该区段的起始与结束的柱面号码。 缺点如下: 操作…...

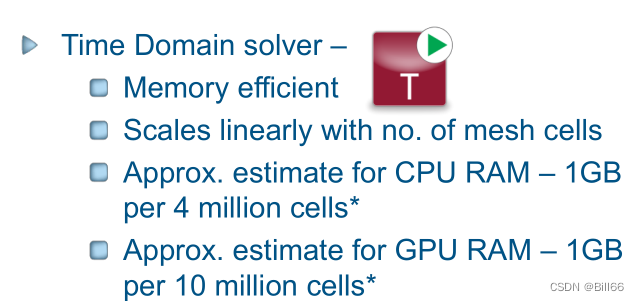

连接器信号完整性仿真教程 二

在连接器信号完整性仿真教程一中Step by Step演示了如何进行连接器信号完整性仿真,看完这片博文后应该可以做类似产品的仿真。如果说,看了这篇博文就学会了连接器信号完整性仿真,那就有点过了。有人也许会说信号完整性仿真难学,不…...

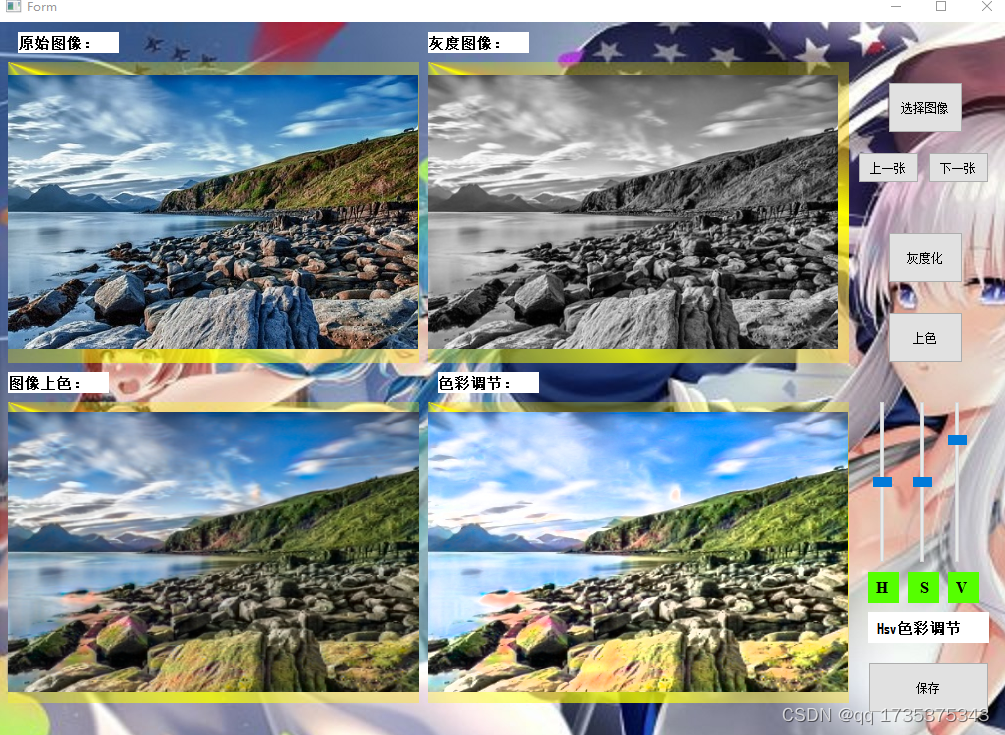

基于深度学习的图片上色(Opencv,Pytorch,CNN)

文章目录 1. 前言2.图像格式(RGB,HSV,Lab)2.1 RGB2.2 hsv2.3 Lab 3. 生成对抗网络(GAN)3.1 生成网络(Unet)3.2 判别网络(resnet18) 4. 数据集5. 模型训练与预…...

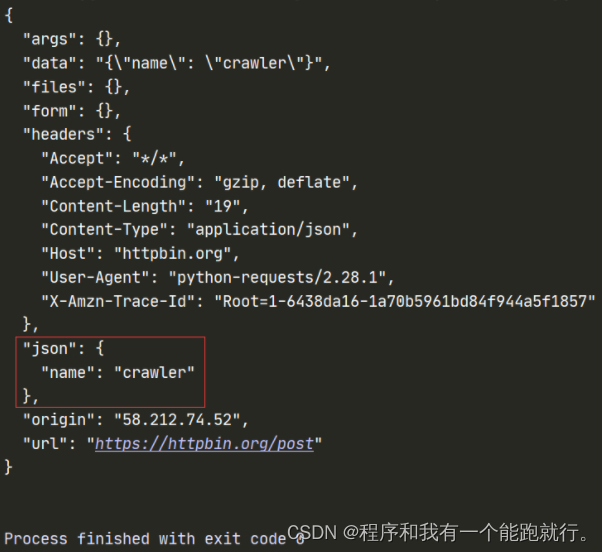

Python爬虫

目录 爬虫总览 准备工作 一、爬虫基础 1、爬虫前导 1.1、爬虫介绍 1.2、HTTP与HTTPS 1.3、URL 1.4、开发工具 1.5、爬虫流程 2、requests模块 2.1、简介 2.2、安装 2.3、发送请求 二、爬虫 爬虫总览 准备工作 一、爬虫基础 1、爬虫前导 1.1、爬虫介绍 概念&…...

python基础案例题:进制转换、字符串加密的实现、猜拳游戏、多种方法计算π

目录 前言1.进制转换2.字符串加密的实现3.猜拳游戏4.多种方法计算π尾语 💝 前言 嗨喽~大家好呀,这里是魔王呐 ❤ ~! 1.进制转换 功能: 获取十进制整数的二进制串,相当于内置函数bin。 算法分析: 对2辗转相除&…...

Spring Boot入门与进阶

本文将为您详细讲解Spring Boot的入门与进阶知识,包括Spring Boot的简介、环境搭建、基本功能以及高级特性,并配以丰富的代码示例,帮助大家快速掌握Spring Boot。 一、Spring Boot简介 Spring Boot是基于Spring框架的一种轻量级、快速开发的…...

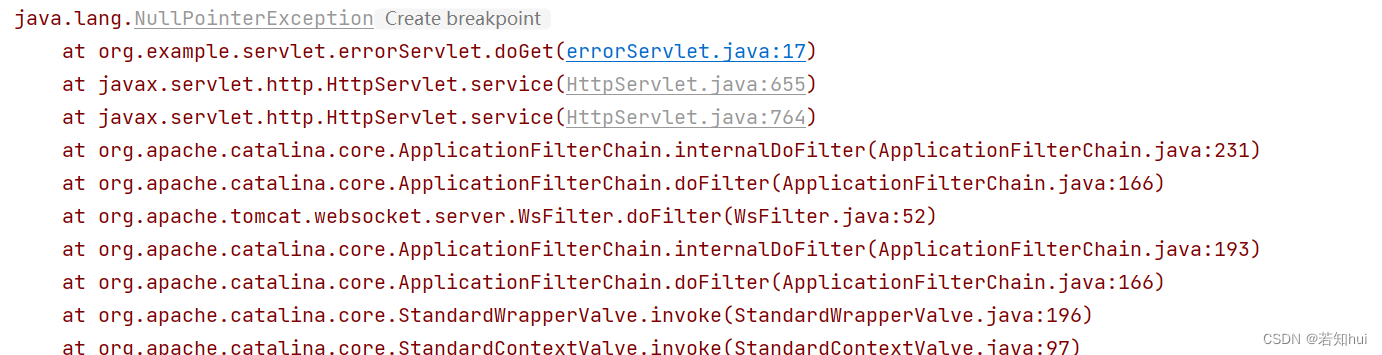

servlet(1)—javaEE

文章目录 1.认识servlet2.使用servlet2.1创建项目2.2引入依赖2.3创建目录2.4编写代码2.5打包2.6部署2.7运行2.8验证 3.开发步骤4.部署方式4.1打包4.2安装插件 5.访问出错的情况5.1 4045.2 4055.3其他 6.servlet的三大生命周期方法7.servlet api7.1HttpServlet7.2HttpServletReq…...

定制 Jenkins 镜像说明

Dockerfile模板示例 FROM jenkins/jenkins:2.332.4-jdk8 MAINTAINER jason USER root RUN sed -i ‘s/deb.debian.org/mirrors.aliyun.com/g’ /etc/apt/sources.list && apt update && apt install ca-certificates tzdata -y && rm -rf /var/cach…...

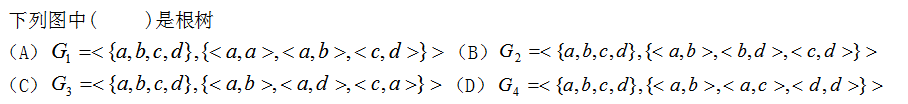

【离散数学】测试五 图论

1. n层正则m叉树一共有()片树叶。 A. nm B. mn C. mn 正确答案: B 2. 下图是一棵最优二叉树 A. 对 B. 错 正确答案: B 3. 要构造权为1,4,9,16,25,36,49,64,81,100一棵最优二叉树,则必须先构造权为5,9,16,25,36,49,64,81,100一棵最优二叉树. A. 对 B. 错 …...

根据cadence设计图学习硬件知识 day03 了解 一些芯片 和 数据手册下载的地方

1. MT53D512M32D2DS 芯片(动态随机存取存储器)的技术指标 1.1 16n Prefetch (预加载) (n --芯片位宽) DDR 体系 链接:DDR扫盲—-关于Prefetch(预取)与Burst(突发)的深入讨论_ddr prefetch_qq_25814297-npl的博客-CSDN博客 1.2 每个通…...

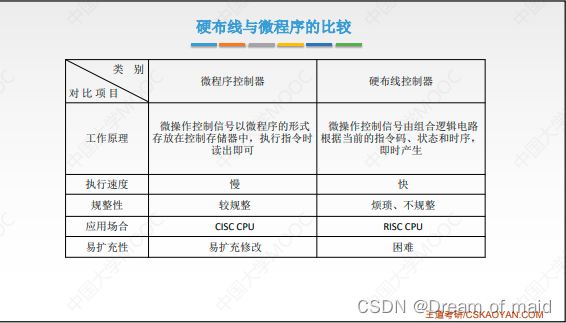

计算机组成原理——第五章中央处理器(中)

辞别再无相见月,终是一人度春秋 文章目录 前言5.4.1 硬布线控制器的设计5.4.2 微程序控制器的基本原理5.4.3 微指令的设计5.4.4 微程序控制单元的设计 前言 本文主要写的是控制器的设计,控制器的设计分为硬部件控制器(就是用纯硬件的方式来实现的一种控…...

)

ImageJ 用户手册——第三部分(ImageJ扩展)

ImageJ 用户手册-第三部分 ImageJ扩展14. 宏指令(Macros)宏程序设计 15. 脚本( Scripts)JavaScript编程 16. 插件( Plugins)开发ImageJ插件 17. 用其他语言编写脚本Fiji脚本编辑器 18. 从命令行运行ImageJ …...

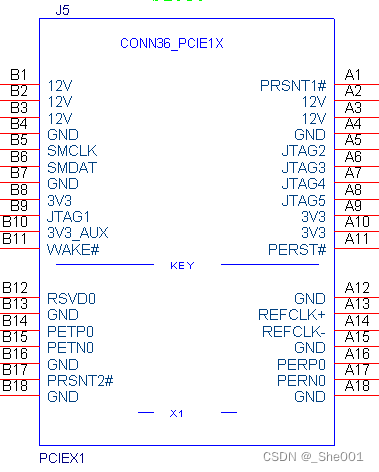

RK3399平台开发系列讲解(PCI/PCI-E)PCIE相关配置说明

🚀返回专栏总目录 文章目录 一、DTS 配置二、menuconfig 配置三、cmdline 配置沉淀、分享、成长,让自己和他人都能有所收获!😄 📢 本篇将介绍在使用 RK3399 平台 PCIE 时候的配置。 一、DTS 配置 ep-gpios = <&gpio3 13 GPIO_ACTIVE_HIGH>; 此项是设置 PCIe…...

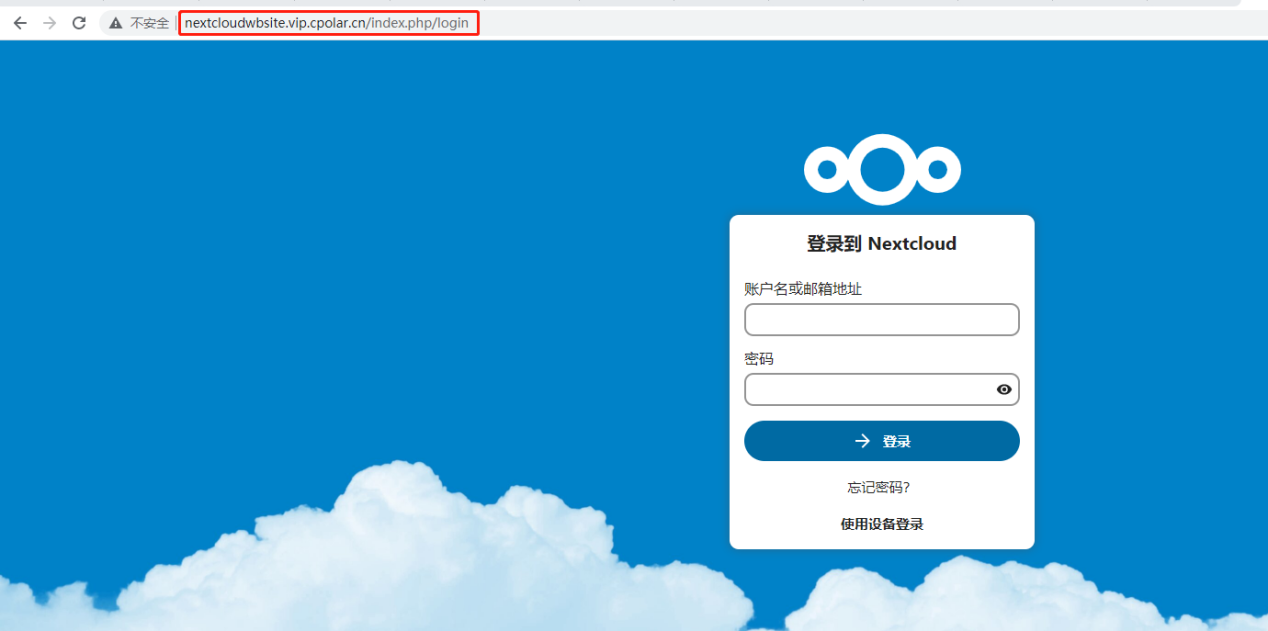

NAS私有云存储 - 搭建Nextcloud私有云盘并公网远程访问

文章目录 摘要视频教程1. 环境搭建2. 测试局域网访问3. 内网穿透3.1 ubuntu本地安装cpolar3.2 创建隧道3.3 测试公网访问 4 配置固定http公网地址4.1 保留一个二级子域名4.1 配置固定二级子域名4.3 测试访问公网固定二级子域名 转载自内网穿透工具的文章:使用Nextcl…...

19c补丁后oracle属主变化,导致不能识别磁盘组

补丁后服务器重启,数据库再次无法启动 ORA01017: invalid username/password; logon denied Oracle 19c 在打上 19.23 或以上补丁版本后,存在与用户组权限相关的问题。具体表现为,Oracle 实例的运行用户(oracle)和集…...

:爬虫完整流程)

Python爬虫(二):爬虫完整流程

爬虫完整流程详解(7大核心步骤实战技巧) 一、爬虫完整工作流程 以下是爬虫开发的完整流程,我将结合具体技术点和实战经验展开说明: 1. 目标分析与前期准备 网站技术分析: 使用浏览器开发者工具(F12&…...

Ascend NPU上适配Step-Audio模型

1 概述 1.1 简述 Step-Audio 是业界首个集语音理解与生成控制一体化的产品级开源实时语音对话系统,支持多语言对话(如 中文,英文,日语),语音情感(如 开心,悲伤)&#x…...

关于 WASM:1. WASM 基础原理

一、WASM 简介 1.1 WebAssembly 是什么? WebAssembly(WASM) 是一种能在现代浏览器中高效运行的二进制指令格式,它不是传统的编程语言,而是一种 低级字节码格式,可由高级语言(如 C、C、Rust&am…...

服务器--宝塔命令

一、宝塔面板安装命令 ⚠️ 必须使用 root 用户 或 sudo 权限执行! sudo su - 1. CentOS 系统: yum install -y wget && wget -O install.sh http://download.bt.cn/install/install_6.0.sh && sh install.sh2. Ubuntu / Debian 系统…...

使用Spring AI和MCP协议构建图片搜索服务

目录 使用Spring AI和MCP协议构建图片搜索服务 引言 技术栈概览 项目架构设计 架构图 服务端开发 1. 创建Spring Boot项目 2. 实现图片搜索工具 3. 配置传输模式 Stdio模式(本地调用) SSE模式(远程调用) 4. 注册工具提…...

: 一刀斩断视频片头广告)

快刀集(1): 一刀斩断视频片头广告

一刀流:用一个简单脚本,秒杀视频片头广告,还你清爽观影体验。 1. 引子 作为一个爱生活、爱学习、爱收藏高清资源的老码农,平时写代码之余看看电影、补补片,是再正常不过的事。 电影嘛,要沉浸,…...

Linux nano命令的基本使用

参考资料 GNU nanoを使いこなすnano基础 目录 一. 简介二. 文件打开2.1 普通方式打开文件2.2 只读方式打开文件 三. 文件查看3.1 打开文件时,显示行号3.2 翻页查看 四. 文件编辑4.1 Ctrl K 复制 和 Ctrl U 粘贴4.2 Alt/Esc U 撤回 五. 文件保存与退出5.1 Ctrl …...

libfmt: 现代C++的格式化工具库介绍与酷炫功能

libfmt: 现代C的格式化工具库介绍与酷炫功能 libfmt 是一个开源的C格式化库,提供了高效、安全的文本格式化功能,是C20中引入的std::format的基础实现。它比传统的printf和iostream更安全、更灵活、性能更好。 基本介绍 主要特点 类型安全:…...

什么是VR全景技术

VR全景技术,全称为虚拟现实全景技术,是通过计算机图像模拟生成三维空间中的虚拟世界,使用户能够在该虚拟世界中进行全方位、无死角的观察和交互的技术。VR全景技术模拟人在真实空间中的视觉体验,结合图文、3D、音视频等多媒体元素…...