Kubernetes 集群搭建(二):搭建k8s集群 (1.28版本)

(一)虚拟环境准备

| 名称 | ip | 备注 |

|---|---|---|

| m1 | 192.168.101.131 | master |

| n1 | 192.168.101.132 | worker |

| n2 | 192.168.101.133 | worker |

(二)所有主机统一配置

2.1 关闭防火墙和selinux

systemctl stop firewalld

systemctl disable firewalld

sed -i 's/enforcing/disabled/' /etc/selinux/config

setenforce 02.2 关闭swap 分区

swapoff -ased -i '/\bswap\b/s/^/#/' /etc/fstab

2.3 修改hosts文件

echo '''

192.168.101.131 m1

192.168.101.132 n1

192.168.101.133 n2

''' >> /etc/hosts2.4 配置内核参数

cat <<EOF | tee /etc/modules-load.d/k8s.conf

overlay

br_netfilter

EOFmodprobe overlay

modprobe br_netfilter# 设置所需的 sysctl 参数,参数在重新启动后保持不变

cat <<EOF | tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-ip6tables = 1

net.ipv4.ip_forward = 1

EOF# 应用 sysctl 参数而不重新启动

sysctl --system# 检查是否被加载

lsmod | grep br_netfilter

lsmod | grep overlay2.5 使用ipvs转发

yum install -y ipvsadm

cat > /etc/sysconfig/modules/ipvs.modules << EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack

EOFchmod 755 /etc/sysconfig/modules/ipvs.modules

bash /etc/sysconfig/modules/ipvs.modules

lsmod | grep -e ip_vs -e nf_conntrack

2.5 安装containerd

在 Kubernetes 的早期版本中,鉴于 Docker 的广泛流行,Kubernetes 选择了直接调用 Docker API 来管理容器。为此,Kubernetes 专门开发了一个名为 dockershim 的组件,它充当了 kubelet 与 Docker 之间的桥梁,实现了两者之间的无缝交互。

然而,随着 Kubernetes 生态系统的不断发展和壮大,越来越多的底层容器运行时技术如 containerd、CRI-O、rkt 等涌现出来。为了支持这些多样化的容器运行时,Kubernetes 引入了容器运行时接口(CRI)标准。这一标准使得第三方容器运行时只需与 CRI 对接,即可与 Kubernetes 进行集成。

后来,在 Kubernetes 1.20 版本中,官方宣布将在后续的 1.24 版本中正式移除 dockershim。当时,Docker 尚未直接支持 CRI 标准,为了应对这一变化,Docker 官方与 Mirantis 公司携手合作,共同开发了一个名为 “cri-dockerd” 的代理程序。

containerd 最初是 Docker 引擎的一部分,用于处理容器的生命周期管理,包括创建、启动、停止和删除容器等操作。

在 Docker 1.11 版本之后,containerd 被从 Docker 引擎中分离出来,成为一个独立的开源项目。

这里使用containerd作为容器。

- 安装containerd.io

yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo# 对于欧拉系统,需要

sed -i 's#$releasever#8#' /etc/yum.repos.d/docker-ce.repoyum install -y containerd.io

- 配置 containerd

# 生成containerd的配置文件

mkdir /etc/containerd -p

# 生成配置文件

containerd config default > /etc/containerd/config.toml# 修改配置

sed -i 's#SystemdCgroup = false#SystemdCgroup = true#' /etc/containerd/config.tomlsed -i 's#sandbox.*#sandbox_image = "registry.aliyuncs.com/google_containers/pause:3.9"#' /etc/containerd/config.toml systemctl enable containerd --now

2.6 安装k8s

确保每个节点上 MAC 地址和 product_uuid 的唯一性

使用命令 ip link 或 ifconfig -a 来获取网络接口的 MAC 地址

使用 sudo cat /sys/class/dmi/id/product_uuid 命令对 product_uuid 校验

一般来讲,硬件设备会拥有唯一的地址,但是有些虚拟机的地址可能会重复。 Kubernetes 使用这些值来唯一确定集群中的节点。 如果这些值在每个节点上不唯一,可能会导致安装失败。

- 添加kubernets的yum源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF安装kubernets

yum install -y kubectl-1.28.2 kubelet-1.28.2 kubeadm-1.28.2systemctl enable kubelet --now

2.7 containerd容器部署 (具体的容器根据kubernets版本决定)

拉取(国内源):

ctr -n k8s.io i pull -k docker.m.daocloud.io/calico/cni:v3.25.0

ctr -n k8s.io i pull -k docker.m.daocloud.io/calico/node:v3.25.0

ctr -n k8s.io i pull -k docker.m.daocloud.io/calico/kube-controllers:v3.25.0

重新标记“视为”原始镜像

ctr -n k8s.io images tag docker.m.daocloud.io/calico/cni:v3.25.0 docker.io/calico/cni:v3.25.0

ctr -n k8s.io images tag docker.m.daocloud.io/calico/node:v3.25.0 docker.io/calico/node:v3.25.0

ctr -n k8s.io images tag docker.m.daocloud.io/calico/kube-controllers:v3.25.0 docker.io/calico/kube-controllers:v3.25.0

导出(作为本地备份):

ctr -n k8s.io i export cni.tar.gz docker.io/calico/cni:v3.25.0

ctr -n k8s.io i export kube-controllers.tar.gz docker.io/calico/kube-controllers:v3.25.0

ctr -n k8s.io i export node.tar.gz docker.io/calico/node:v3.25.0

导入(恢复本地备份):

ctr -n k8s.io i import cni.tar.gz

ctr -n k8s.io i import kube-controllers.tar.gz

ctr -n k8s.io i import node.tar.gz

检查:

ctr -n k8s.io i ls -q

(三)master节点配置

3.1 配置主机名,主机名是节点与集群通信的重要标识之一,尤其是在日志、监控和调度中,分别在各个节点中配置它的主机名

hostnamectl set-hostname m1

3.2 重置(可选)

kubeadm reset

- 手动清理残留文件

# /var/lib/etcd/ 是 etcd 数据库的存储目录,用于保存 Kubernetes 集群中的关键元数据和配置信息

rm -rf /etc/kubernetes/manifests/*

rm -rf /var/lib/etcd/*

rm -rf $HOME/.kube/config

3.3 配置kubeadm-config.yaml文件

- 确保 serviceSubnet 和 podSubnet 不与现有的网络配置冲突。

apiVersion: kubeadm.k8s.io/v1beta3

kind: InitConfiguration

localAPIEndpoint:advertiseAddress: "192.168.101.131"bindPort: 6443

---

apiVersion: kubeadm.k8s.io/v1beta3

kind: ClusterConfiguration

kubernetesVersion: v1.28.2

controlPlaneEndpoint: "" # 如果需要高可用控制平面,可以指定负载均衡器的地址

apiServer:certSANs:- "192.168.101.131" # 添加额外的 SAN(Subject Alternative Name)

networking:serviceSubnet: "192.140.0.0/16"podSubnet: "192.240.0.0/16"

imageRepository: "registry.aliyuncs.com/google_containers"

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: "ipvs"

3.4 初始化集群

kubeadm init --config=kubeadm-config.yaml

完成后会显示如下的信息

Your Kubernetes control-plane has initialized successfully!To start using your cluster, you need to run the following as a regular user:mkdir -p $HOME/.kubesudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configsudo chown $(id -u):$(id -g) $HOME/.kube/configAlternatively, if you are the root user, you can run:export KUBECONFIG=/etc/kubernetes/admin.confYou should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:https://kubernetes.io/docs/concepts/cluster-administration/addons/Then you can join any number of worker nodes by running the following on each as root:kubeadm join 192.168.101.131:6443 --token 0mhdu0.eoctqrfvamju7z97 \--discovery-token-ca-cert-hash sha256:e46a3d35352dadf3d79358e50f61cf58fc95c6129676578867cf05aad7a12f97

- 复制初始化集群后终端显示的命令

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config3.5 安装CNI插件,此处选择calico

-

官方文档地址

https://archive-os-3-26.netlify.app/calico/3.26/getting-started/kubernetes/requirements

里面可以查到k8s 1.28 对应的calico版本为3.25 -

下载官方yaml文件

wget https://docs.projectcalico.org/archive/v3.25/manifests/calico.yaml -

更改其中cidr地址,与podsubnet一致

sed -i 's@# - name: CALICO_IPV4POOL_CIDR@- name: CALICO_IPV4POOL_CIDR@' calico.yaml

sed -i 's@# value: "192.168.0.0/16"@ value: "192.240.0.0/16"@' calico.yaml -

启动

kubectl apply -f calico.yaml

结果如下

poddisruptionbudget.policy/calico-kube-controllers created

serviceaccount/calico-kube-controllers created

serviceaccount/calico-node created

configmap/calico-config created

customresourcedefinition.apiextensions.k8s.io/bgpconfigurations.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/bgppeers.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/blockaffinities.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/caliconodestatuses.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/clusterinformations.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/felixconfigurations.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/globalnetworkpolicies.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/globalnetworksets.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/hostendpoints.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/ipamblocks.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/ipamconfigs.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/ipamhandles.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/ippools.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/ipreservations.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/kubecontrollersconfigurations.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/networkpolicies.crd.projectcalico.org created

customresourcedefinition.apiextensions.k8s.io/networksets.crd.projectcalico.org created

clusterrole.rbac.authorization.k8s.io/calico-kube-controllers created

clusterrole.rbac.authorization.k8s.io/calico-node created

clusterrolebinding.rbac.authorization.k8s.io/calico-kube-controllers created

clusterrolebinding.rbac.authorization.k8s.io/calico-node created

daemonset.apps/calico-node created

deployment.apps/calico-kube-controllers created

(四)Node 节点配置

4.1 Node节点主机名更改

每个节点的主机名应不同

hostnamectl set-hostname n1

4.2 Node节点加入集群

复制在master节点里显示的命令

kubeadm join 192.168.101.131:6443 --token 0mhdu0.eoctqrfvamju7z97 --discovery-token-ca-cert-hash sha256:e46a3d35352dadf3d79358e50f61cf58fc95c6129676578867cf05aad7a12f97

(五)测试

kubectl get nodeskubectl get pods -ANAMESPACE NAME READY STATUS RESTARTS AGE

kube-system calico-kube-controllers-658d97c59c-bx9mx 1/1 Running 0 9m49s

kube-system calico-node-k8wpd 1/1 Running 0 9m49s

kube-system calico-node-lchjc 0/1 Running 0 9m49s

kube-system calico-node-vdpqf 1/1 Running 0 9m49s

kube-system coredns-66f779496c-qhp6p 1/1 Running 0 157m

kube-system coredns-66f779496c-txxql 1/1 Running 0 157m

kube-system etcd-m1 1/1 Running 0 157m

kube-system kube-apiserver-m1 1/1 Running 0 157m

kube-system kube-controller-manager-m1 1/1 Running 0 157m

kube-system kube-proxy-5gg2p 1/1 Running 0 118m

kube-system kube-proxy-ctw2r 1/1 Running 0 114m

kube-system kube-proxy-zlbb7 1/1 Running 0 157m

kube-system kube-scheduler-m1 1/1 Running 0 157m

所有pod 为running则正常

相关文章:

:搭建k8s集群 (1.28版本))

Kubernetes 集群搭建(二):搭建k8s集群 (1.28版本)

(一)虚拟环境准备 名称ip备注m1192.168.101.131mastern1192.168.101.132workern2192.168.101.133worker (二)所有主机统一配置 2.1 关闭防火墙和selinux systemctl stop firewalld systemctl disable firewalld sed -i s/enfo…...

一文详解OpenCV环境搭建:Windows使用CLion配置OpenCV开发环境

在计算机视觉和图像处理领域,OpenCV 是一个不可或缺的工具。其为开发者提供了一系列广泛的算法和实用工具,支持多种编程语言,并且可以在多个平台上运行。对于希望在其项目中集成先进视觉功能的开发者来说,掌握如何配置和使用OpenC…...

)

Python爬取数据(二)

一.example2包下的 1.re模块的compile函数使用 import repatternre.compile(r\d) print(pattern) 2.match的方法使用 import re patternre.compile(r\d) # m1pattern.match(one123twothree345four) #参数2:指定起始位置(包含),参数3:终止位置(包含),…...

前端用用jsonp的方式解决跨域问题

前端用用jsonp的方式解决跨域问题 前端用用jsonp的方式解决跨域问题 前端用用jsonp的方式解决跨域问题限制与缺点:前端后端测试使用示例 限制与缺点: 不安全、只能使用get方式、后台需要相应jsonp方式的传参 前端 function jsonp(obj) {// 动态生成唯…...

计算机网络 3-2 数据链路层(流量控制与可靠传输机制)

3.4 流量控制与可靠传输机制 流量控制:指由接收方控制发送方的发送速率,使接收方有足够的缓冲空间来接收每个帧 滑动窗口流量控制:一种更高效的流量控制方法。 在任意时刻,发送方都维持一组连续的允许发送帧的序号,称为发送窗口…...

科普:原始数据是特征向量么?

一、输入向量 x \mathbf{x} x是特征向量 机器学习算法公式中的输入向量 x \mathbf{x} x通常要求是特征向量。原因如下: 从算法原理角度:机器学习算法旨在通过对输入数据的学习来建立模型,以实现对未知数据的预测或分类等任务。特征向量是对…...

Jenkins配置的JDK,Maven和Git

1. 前置 在配置前,我们需要先把JDK,Maven和Git安装到Jenkins的服务器上。 (1)需要进入容器内部,执行命令:docker exec -u root -it 容器号/容器名称(2选1) bash -- 容器名称 dock…...

有效压缩 Hyper-v linux Centos 的虚拟磁盘 VHDX

参考: http://www.360doc.com/content/22/0505/16/67252277_1029878535.shtml VHDX 有个不好的问题就是,如果在里面存放过文件再删除,那么已经使用过的空间不会压缩,导致空间一直被占用。那么就需要想办法压缩空间。 还有一点&a…...

网络空间安全(53)XSS

一、定义与原理 XSS(Cross Site Scripting),全称为跨站脚本攻击,是一种网站应用中的安全漏洞攻击。其原理是攻击者利用网站对用户输入内容校验不严格等漏洞,将恶意脚本(通常是JavaScript,也可以…...

(Go语言版))

【LeetCode 热题100】45:跳跃游戏 II(详细解析)(Go语言版)

🚀 力扣 45:跳跃游戏 II(全解法详解) 📌 题目描述 给你一个非负整数数组 nums,表示你最初位于数组的第一个位置。 数组中的每个元素表示你在该位置可以跳跃的最大长度。 你的目标是使用 最少的跳跃次数 到…...

Spring MVC 框架 的核心概念、组件关系及流程的详细说明,并附表格总结

以下是 Spring MVC 框架 的核心概念、组件关系及流程的详细说明,并附表格总结: 1. 核心理念 Spring MVC 是基于 MVC(Model-View-Controller)设计模式 的 Web 框架,其核心思想是 解耦: Model:数…...

使用 redis 实现消息队列

方案1: 使用list做消息队列问题1: 如何保证消息不丢失问题 2: 重复消费/幂等 方案 2: zset实现消息队列方案 3: 发布/订阅(pub/sub)问题1: 如何保证消息不丢失问题 2: 重复消费/幂等 方案 4: Stream 实现消息队列问题1: 如何保证消息不丢失问题 2: 重复消费/幂等 方案1: 使用li…...

金融数据分析(Python)个人学习笔记(6):安装相关软件

python环境的安装请查看Python个人学习笔记(1):Python软件的介绍与安装 一、pip 在windows系统中检查是否安装了pip 打开命令提示符的快捷键:winR,然后输入cmd 在命令提示符中执行如下命令 python -m pip --version…...

Android Material Design 3 主题配色终极指南:XML 与 Compose 全解析

最小必要颜色配置 <!-- res/values/themes.xml --> <style name"Theme.MyApp" parent"Theme.Material3.DayNight"><!-- 基础三原色 --><item name"colorPrimary">color/purple_500</item><item name"col…...

PyTorch参数管理详解:从访问到初始化与共享

本文通过实例代码讲解如何在PyTorch中管理神经网络参数,包括参数访问、多种初始化方法、自定义初始化以及参数绑定技术。所有代码可直接运行,适合深度学习初学者进阶学习。 1. 定义网络与参数访问 1.1 定义单隐藏层多层感知机 import torch from torch…...

页面简单传参

#简单的情景:你需要在帖子主页传递参数给帖子详情页面,携带在主页获得的帖子ID。你有以下几种传递方法# #使用Vue3 TS# 1. 通过 URL 参数传递(Query 参数) 这是最简单、最常用的方法,ID 会显示在 URL 中的 ? 后面…...

nginx路径匹配的优先级

在 Nginx 配置中,当请求 /portal/agent/sse 时,会匹配 location ~* /sse$ 规则,而不是 location /portal。原因如下: 匹配规则解析 location ~* /sse$ ~* 表示 不区分大小写的正则匹配/sse$ 表示以 /sse 结尾的路径匹配结果&#…...

一周学会Pandas2 Python数据处理与分析-Pandas2一维数据结构-Series

锋哥原创的Pandas2 Python数据处理与分析 视频教程: 2025版 Pandas2 Python数据处理与分析 视频教程(无废话版) 玩命更新中~_哔哩哔哩_bilibili Pandas提供Series和DataFrame作为数组数据的存储框架。 Series(系列、数列、序列)是一个带有…...

DApp实战篇:前端技术栈一览

前言 在前面一系列内容中,我们由浅入深地了解了DApp的组成,从本小节开始我将带领大家如何完成一个完整的DApp。 本小节则先从前端开始。 前端技术栈 在前端开发者速入:DApp中的前端要干些什么?文中我说过,即便是在…...

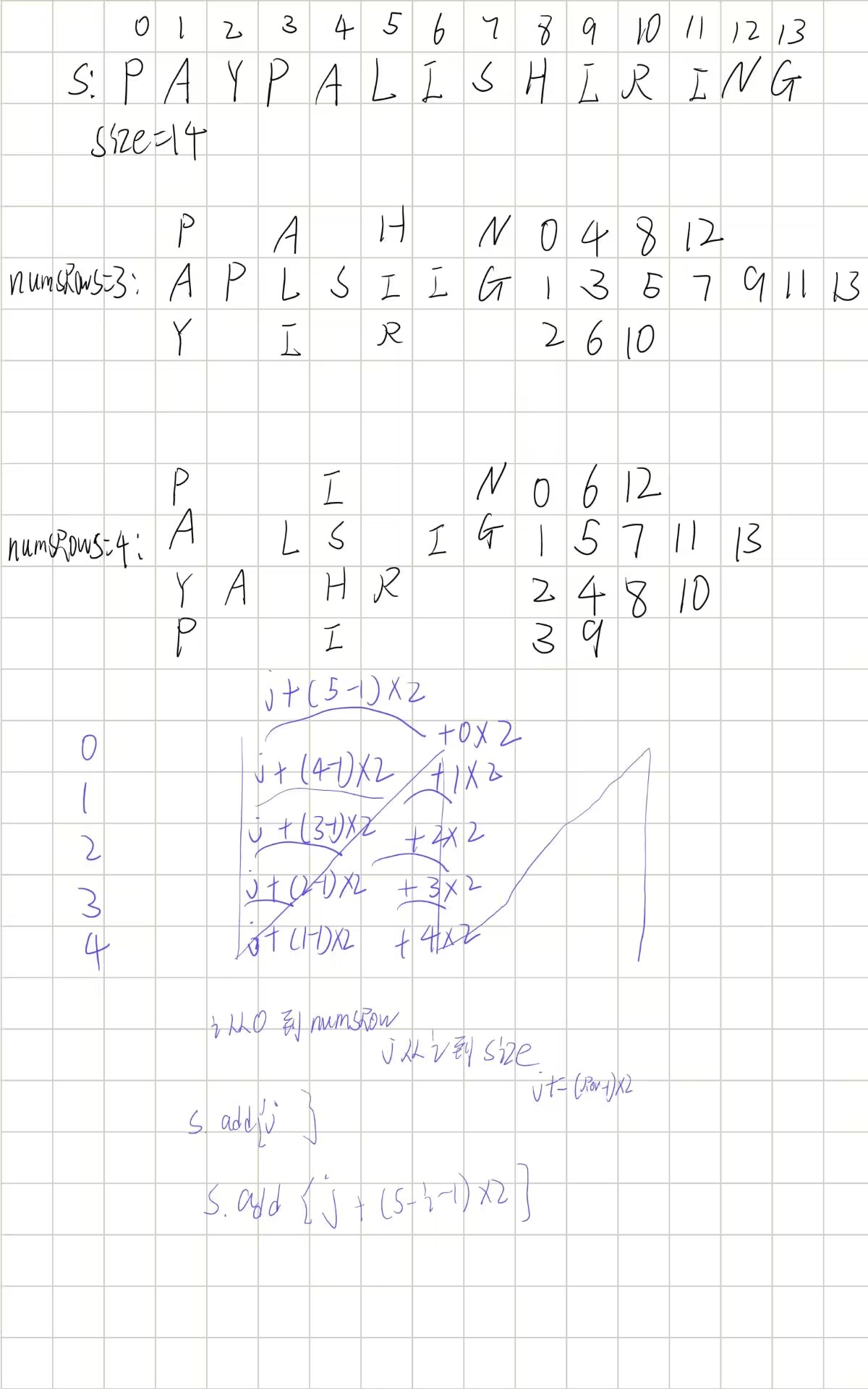

leetcode6.Z字形变换

题目说是z字形变化,但其实模拟更像n字形变化,找到字符下标规律就逐个拼接就能得到答案 class Solution {public String convert(String s, int numRows) {if(numRows1)return s;StringBuilder stringBuilder new StringBuilder();for (int i 0; i <…...

HarmonyOS应用开发者高级-编程题-001

题目一:跨设备分布式数据同步 需求描述 开发一个分布式待办事项应用,要求: 手机与平板登录同一华为账号时,自动同步任务列表任一设备修改任务状态(完成/删除),另一设备实时更新任务数据在设备离线时能本地存储,联网后自动同步实现方案 // 1. 定义分布式数据模型 imp…...

鸿蒙开发者高级认证编程题库

题目一:跨设备分布式数据同步 需求描述 开发一个分布式待办事项应用,要求: 手机与平板登录同一华为账号时,自动同步任务列表任一设备修改任务状态(完成/删除),另一设备实时更新任务数据在设备离线时能本地存储,联网后自动同步实现方案 // 1. 定义分布式数据模型 imp…...

快速进入深度学习pytorch环境)

Ubuntu(CentOS、Rockylinux等)快速进入深度学习pytorch环境

这里写自定义目录标题 安装进入系统(如Ubuntu22.04)安装anacondapip、conda换源pip换源conda换源 安装nvidia安装pytorch环境针对于wsl的优化 安装进入系统(如Ubuntu22.04) docker 、 wsl 、 双系统 、服务器系统 推荐 Ubuntu 20…...

[实战] 天线阵列波束成形原理详解与仿真实战(完整代码)

天线阵列波束成形原理详解与仿真实战 1. 引言 在无线通信、雷达和声学系统中,波束成形(Beamforming)是一种通过调整天线阵列中各个阵元的信号相位和幅度,将电磁波能量集中在特定方向的技术。其核心目标是通过空间滤波增强目标方…...

Android开发okhttp添加头部参数

Android开发okhttp添加头部参数或者是头文件 private static class RequestHeaderInterceptor implements Interceptor {Overridepublic Response intercept(Chain chain) throws IOException {Request original chain.request();//添加头部信息Request request original.new…...

Halcon图像采集

Halcon是一款强大的机器视觉软件,结合C#可以开发出功能完善的视觉应用程序。 基本设置 确保已经安装了Halcon和Halcon的.NET库(HalconDotNet)。 1. 添加引用 在C#项目中,需要添加对HalconDotNet.dll的引用: 右键点…...

自动提取pdf公式 ➕ 输出 LaTeX

# 创建打包脚本的主内容 script_content """ from doc2x.extract_formula import extract_formula_imgs from pix2text import Pix2Text from PIL import Image import osdef main():pdf_path "your_file.pdf" # 将你的PDF命名为 your_file.pdf 并…...

安卓开发中的Activity之间的通信使用详解)

(十)安卓开发中的Activity之间的通信使用详解

在 Android 开发中,Activity 之间的通信是非常常见且核心的功能之一,常见的方式包括: 使用显式 Intent 传递数据使用隐式 Intent 实现跨组件调用使用 startActivityForResult(或新版 Activity Result API)回传数据传递…...

python 浅拷贝copy与深拷贝deepcopy 理解

一 浅拷贝与深拷贝 1. 浅拷贝 浅拷贝只复制了对象本身(即c中的引用)。 2. 深拷贝 深拷贝创建一个新的对象,同时也会创建所有子对象的副本,因此新对象与原对象之间完全独立。 二 代码理解 1. 案例一 a 10 b a b 20 print…...

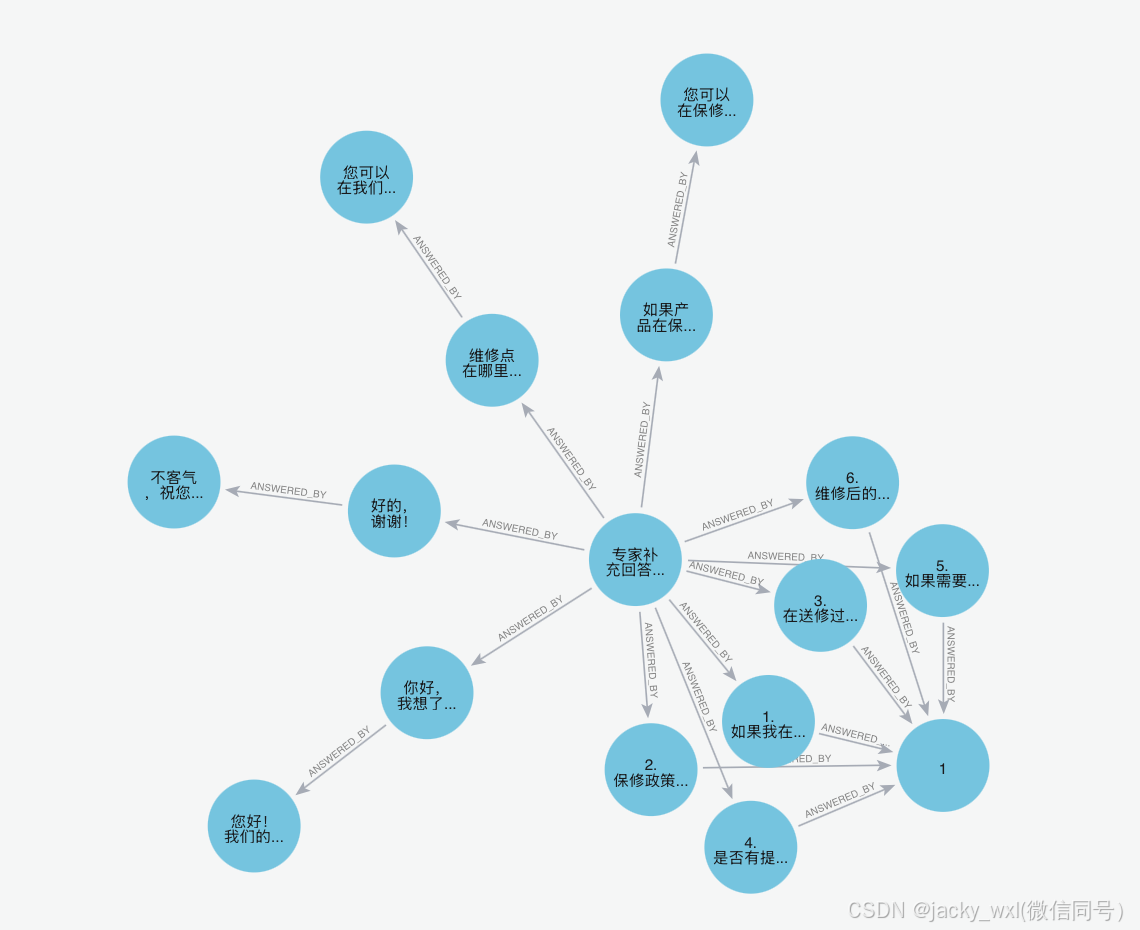

基于neo4j存储知识树-mac

1、安装jdk21 for mac(jdk-21_macos-aarch64_bin.dmg) 2、安装neo4j for mac(neo4j-community-5.26.0-unix.tar.gz) 3、使用默认neo4j/neo4j登录http://localhost:7474 修改登录密码,可以使用生成按钮生成密码,连接数据库,默认设置为neo4j…...