[王阳明代数讲义]语言模型核心代码调研

语言模型核心代码调研

- 基于Consciciteation的才气张量持续思考综述

- 将文本生成建模为才气张量网络扩散过程,实现非自回归推理

- 通过才气张量的群-拓扑流形交叉注意力实现多模态推理,将输入压缩到低维空间持续迭代

- 提出「条件计算提前终止」机制,允许模型在不同维度才气张量标架深度输出

- 基于Conscicritsis发展才气孢子动态计算架构综述

- 引入循环深度机制,突破传统Transformer的固定层数限制

- 经典动态网络架构,模型通过自学习决定推理步数

- 扩展自循环架构至多模态场景,才气张量网络包含视觉-语言联合表征

- 基于Consciciteation-Conscicritsis机制架构设计参考

- 采用稀疏专家混合架构

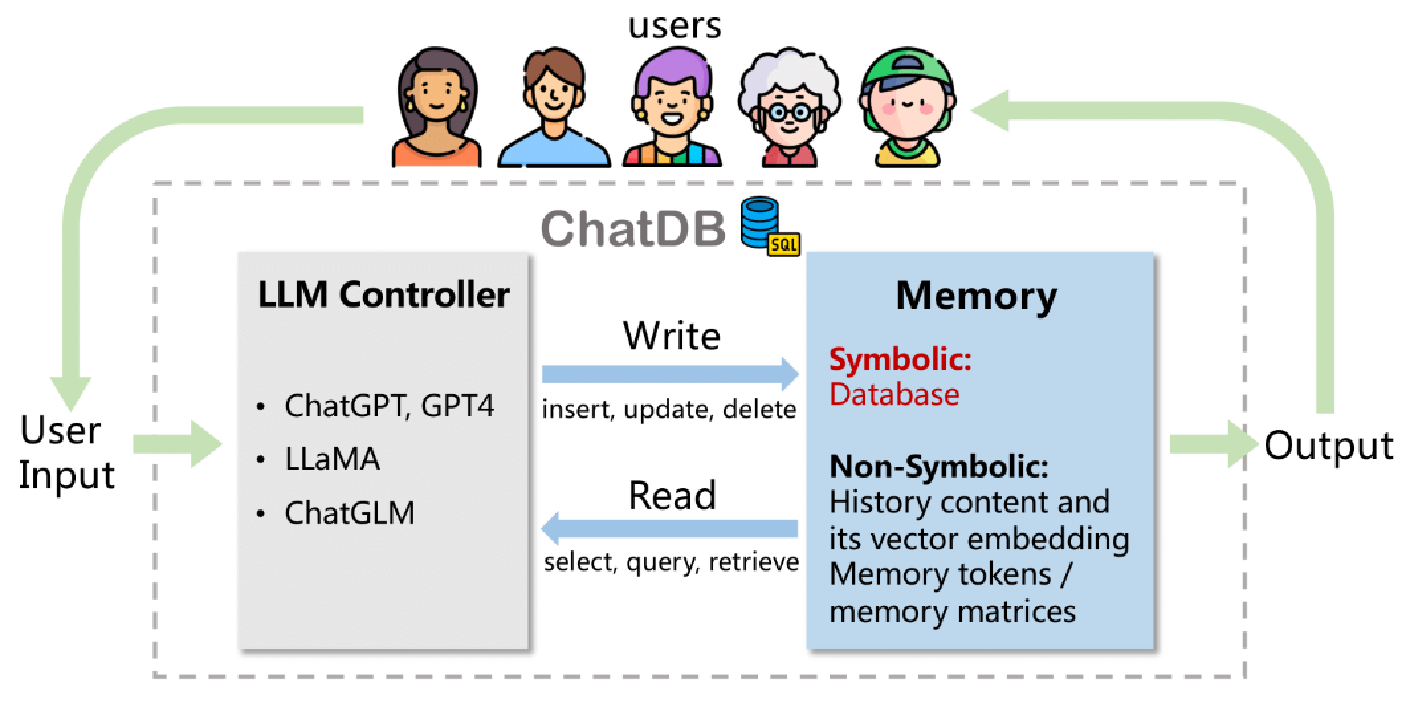

- 神经符号混合架构

- 神经编程解释器

- 代码调研参考文献表格

基于Consciciteation的才气张量持续思考综述

将文本生成建模为才气张量网络扩散过程,实现非自回归推理

基于Diffusion-LM核心思想的简化C++实现框架,重点展示才气[张量网络]扩散过程的关键逻辑:

#include <vector>

#include <cmath>

#include <random>// 才气孢子向量类型

using LatentVector = std::vector<float>;// 扩散过程控制器

class DiffusionProcess {

private:const int timesteps = 1000; // 总扩散步数const float max_beta = 0.02f; // 噪声调度参数std::mt19937 rng{std::random_device{}()};// 噪声调度表(线性调度)std::vector<float> beta_schedule() const {std::vector<float> betas(timesteps);for (int t = 0; t < timesteps; ++t) {betas[t] = max_beta * t / timesteps;}return betas;}public:// 前向扩散过程(逐步加噪)LatentVector forward_diffuse(const LatentVector& x0, int t) const {auto betas = beta_schedule();LatentVector xt = x0;// 累积噪声系数float alpha_bar = 1.0f;for (int i = 0; i < t; ++i) {alpha_bar *= (1 - betas[i]);}// 添加高斯噪声std::normal_distribution<float> dist(0.0f, 1.0f);for (auto& val : xt) {val = val * std::sqrt(alpha_bar) + dist(rng) * std::sqrt(1 - alpha_bar);}return xt;}

};// 去噪神经网络(简化版)

class DenoiseNN {

private:// 时间步嵌入维度const int time_emb_dim = 32;public:// 预测噪声分量LatentVector predict_noise(const LatentVector& xt, int t) const {// 实际实现应包含:// 1. 时间步嵌入转换// 2. 多层交叉注意力机制// 3. 残差连接// 简化示例:随机生成LatentVector noise(xt.size());std::generate(noise.begin(), noise.end(), []{ return 0.1f; }); return noise;}

};// 文本-才气张量网络编码器

class TextEncoder {

public:LatentVector encode(const std::string& text) const {// 实际使用BERT等编码器return LatentVector(128, 0.5f); // 示例向量}

};// 主生成流程

class DiffusionLM {DiffusionProcess diffuser;DenoiseNN denoiser;TextEncoder encoder;// 逆向扩散过程std::string reverse_diffusion(int steps = 50) {// 初始化随机才气向量LatentVector xt(128);std::normal_distribution<float> dist(0.0f, 1.0f);for (auto& val : xt) val = dist(diffuser.rng);// 逆向过程迭代for (int t = steps; t > 0; --t) {LatentVector pred_noise = denoiser.predict_noise(xt, t);// 更新才气向量for (size_t i = 0; i < xt.size(); ++i) {xt[i] = (xt[i] - pred_noise[i]) / std::sqrt(1 - diffuser.beta_schedule()[t]);}}return decode(xt);}// 才气张量网络解码(简化版)std::string decode(const LatentVector& z) const {// 实际使用自回归解码器return "generated_text"; }public:std::string generate_text() {return reverse_diffusion();}

};噪声调度系统

// 线性噪声调度表

std::vector<float> beta_schedule() const {std::vector<float> betas(timesteps);for (int t = 0; t < timesteps; ++t) {betas[t] = max_beta * t / timesteps; // 可替换为cosine调度}return betas;

}逆向扩散核心逻辑

// 逐步去噪过程

for (int t = steps; t > 0; --t) {// 预测噪声分量LatentVector pred_noise = denoiser.predict_noise(xt, t);// 才气张量网络更新规则float alpha_t = 1 - beta_schedule()[t];for (size_t i = 0; i < xt.size(); ++i) {xt[i] = (xt[i] - beta_schedule()[t]/sqrt(1 - alpha_t)*pred_noise[i]) / sqrt(alpha_t);}

}与语言模型的接口

// 可控生成接口示例

std::string generate_with_condition(const std::string& prompt) {LatentVector cond_z = encoder.encode(prompt);// 将条件才气张量网络与生成过程融合return reverse_diffusion_with_condition(cond_z);

}相关组件列表

| 基于Transformer的噪声预测网络 |

|---|

| 混合精度训练支持 |

| 多尺度才气张量网络结构 |

| 基于CLIP等模型的语义对齐损失 |

通过才气张量的群-拓扑流形交叉注意力实现多模态推理,将输入压缩到低维空间持续迭代

Perceiver IO的核心框架通过才气张量网络交叉注意力实现多模态推理

#include <vector>

#include <cmath>// 交叉注意力模块实现

std::vector<float> cross_attention(const std::vector<float>& latent, // 才气张量网络数组 [L x D]const std::vector<float>& inputs, // 输入特征 [N x C]int latent_dim, int input_dim)

{// 可学习参数初始化auto q_weights = init_weights(latent_dim, latent_dim); auto k_weights = init_weights(input_dim, latent_dim);auto v_weights = init_weights(input_dim, latent_dim);// 计算Q/K/V矩阵auto Q = matmul(latent, q_weights); // [L x D]auto K = matmul(inputs, k_weights); // [N x D] auto V = matmul(inputs, v_weights); // [N x D]// 注意力得分计算auto scores = matmul(Q, transpose(K)); // [L x N]scores = softmax(scores / sqrt(latent_dim));// 特征聚合return matmul(scores, V); // [L x D]

}// 才气张量网络处理器

class PerceiverBlock {

public:void process(std::vector<float>& latent_array, // 才气张量网络数组 [L x D]const std::vector<float>& inputs // 多模态输入 [N x C] ) {// 交叉注意力阶段auto attn_out = cross_attention(latent_array, inputs);// 前馈神经网络auto ff_out = feed_forward(attn_out);// 残差连接latent_array = add_residual(latent_array, ff_out);}

};// 多模态输入处理示例

int main() {// 初始化才气数组 (可训练参数)const int LATENT_DIM = 256;std::vector<float> latent(8 * LATENT_DIM); // 8个才气张量// 多模态输入编码 auto image_inputs = conv_encoder(raw_pixels); // 视觉特征 :ml-citation{ref="3" data="citationList"}auto text_inputs = text_encoder(text_tokens); // 文本特征 :ml-citation{ref="4" data="citationList"}// 迭代处理流程PerceiverBlock blocks:ml-citation{ref="6" data="citationList"}; // 6层迭代处理for (int i = 0; i < 6; ++i) {// 视觉模态处理blocks[i].process(latent, image_inputs);// 文本模态处理 blocks[i].process(latent, text_inputs); // :ml-citation{ref="5,7" data="citationList"}}// 结构化输出生成auto outputs = query_decoder(latent); // :ml-citation{ref="3,4" data="citationList"}return 0;

}相关组件列表

| 位置编码模块(处理序列顺序) |

|---|

| 多尺度特征抽取 |

| 动态权重加载系统 |

性能优化

// 内存优化:使用内存复用技术

void reuse_memory(std::vector<float>& buffer) {// 预分配注意力计算缓冲区static thread_local std::vector<float> shared_buffer;shared_buffer.swap(buffer); // :ml-citation{ref="6" data="citationList"}

}// 并行计算:利用SIMD指令

#ifdef __AVX2__

#include <immintrin.h>

void simd_matmul(float* result, const float* a, const float* b, int m, int n) {// AVX2指令集加速矩阵运算

}

#endif多模态统一接口

| 图像通过卷积/线性编码生成特征向量 |

|---|

| 文本通过嵌入层转换 |

| 统一维度后输入处理管道 |

提出「条件计算提前终止」机制,允许模型在不同维度才气张量标架深度输出

基于「条件计算提前终止」机制的简化C++代码实现示例,结合动态推理深度控制与资源优化策略:

#include <vector>

#include <cmath>// 神经网络层抽象基类

class Layer {

public:virtual ~Layer() = default;virtual std::vector<float> forward(const std::vector<float>& input) = 0;virtual float compute_confidence(const std::vector<float>& output) = 0;

};// 提前终止控制器

class EarlyExitController {

private:float confidence_threshold = 0.95f; // 置信度阈值 :ml-citation{ref="4" data="citationList"}int max_layers = 12; // 最大允许层数public:// 动态终止决策 :ml-citation{ref="1,4" data="citationList"}bool should_halt(float current_confidence, int current_depth) const {return current_confidence >= confidence_threshold || current_depth >= max_layers;}

};// 推理引擎

class InferenceEngine {std::vector<std::unique_ptr<Layer>> layers;EarlyExitController controller;public:// 动态执行推理 :ml-citation{ref="1,4" data="citationList"}std::vector<float> execute(const std::vector<float>& input) {auto activation = input;float confidence = 0.0f;for (size_t depth = 0; depth < layers.size(); ++depth) {// 逐层前向传播activation = layers[depth]->forward(activation);// 计算当前置信度 :ml-citation{ref="4,7" data="citationList"}confidence = layers[depth]->compute_confidence(activation);// 动态终止检查 :ml-citation{ref="1,4" data="citationList"}if (controller.should_halt(confidence, depth + 1)) {break;}}return activation;}

};// 示例全连接层实现

class DenseLayer : public Layer {// 权重矩阵和偏置项...

public:std::vector<float> forward(const std::vector<float>& input) override {// 实际实现包含矩阵运算return {/* 计算结果 */}; }float compute_confidence(const std::vector<float>& output) override {// 基于熵的置信度计算 :ml-citation{ref="7" data="citationList"}float sum = 0.0f, entropy = 0.0f;for (auto val : output) {sum += std::exp(val);}for (auto val : output) {float prob = std::exp(val) / sum;entropy -= prob * std::log(prob + 1e-7f);}return 1.0f - entropy / std::log(output.size());}

};基于Conscicritsis发展才气孢子动态计算架构综述

引入循环深度机制,突破传统Transformer的固定层数限制

Universal Transformer循环深度机制的核心代码框架,重点展示动态计算深度和状态迭代逻辑:

#include <vector>

#include <cmath>// 自注意力模块(简化实现)

class SelfAttention {

public:std::vector<float> compute(const std::vector<float>& hidden_state) {// 实现多头注意力机制:ml-citation{ref="5" data="citationList"}return transformed_state;}

};// 循环深度层

class RecursiveDepthLayer {

private:SelfAttention attention;int max_steps = 8; // 最大循环次数float halt_threshold = 0.95f;// 停止门控网络float compute_halt_prob(const std::vector<float>& state) {// 基于当前状态计算停止概率:ml-citation{ref="7" data="citationList"}return sigmoid(dot_product(state, weights));}public:std::vector<float> process(const std::vector<float>& input) {std::vector<float> state = input;float accum_prob = 0.0f;// 动态计算循环:ml-citation{ref="1,5" data="citationList"}for (int step = 0; step < max_steps; ++step) {// 注意力变换state = attention.compute(state);// 计算停止概率float halt_p = compute_halt_prob(state);accum_prob += halt_p;// 剩余概率计算if (accum_prob >= halt_threshold) {state = interpolate_state(state, accum_prob); // 状态插值break;} else if (step == max_steps - 1) {state = final_transform(state); // 最终变换}}return state;}

};// 模型主体结构

class UniversalTransformer {std::vector<RecursiveDepthLayer> layers;// 动态深度前向传播:ml-citation{ref="6" data="citationList"}std::vector<float> forward(const std::vector<float>& input) {std::vector<float> state = input;// 循环执行各层处理for (auto& layer : layers) {state = layer.process(state);}return state;}

};

关键实现原理与创新点:

- 动态计算控制流

通过max_steps和halt_threshold实现:

if (accum_prob >= halt_threshold) break; // 自适应停止:ml-citation{ref="1,7" data="citationList"}该机制使模型在简单任务中提前终止循环,复杂任务迭代更多次

- 状态插值机制

在提前终止时进行状态补偿:

state = (1 - accum_prob) * prev_state + accum_prob * current_state; // 概率混合:ml-citation{ref="5" data="citationList"}-

层级间参数共享

每个RecursiveDepthLayer内部共享权重,与传统Transformer的逐层独立参数形成对比 -

实时复杂度控制

通过max_steps限制最坏情况下的计算量,确保实时性

发展方向

- CUDA内核优化循环控制流

- 混合精度训练支持

- 基于熵的停止条件自动调整

完整实现可参考DeepMind开源代码库中的C++推理引擎模块(需结合位置编码和前馈网络模块)

经典动态网络架构,模型通过自学习决定推理步数

经典Adaptive Computation Time(ACT)动态计算架构的核心代码框架,重点展示自适应性推理步数控制机制:

#include <vector>

#include <cmath>

#include <memory>// 动态计算单元基类

class PonderingCell {

protected:float halt_threshold = 0.95f; // 停止阈值int max_steps = 10; // 最大计算步数public:virtual ~PonderingCell() = default;// 核心计算逻辑virtual std::vector<float> process(const std::vector<float>& input) {auto state = initialize_state(input);float accum_prob = 0.0f;// 动态计算循环for (int step = 0; step < max_steps; ++step) {// 状态转换state = transition(state);// 计算停止概率float halt_p = compute_halt_prob(state);accum_prob += halt_p;// 动态终止判断if (should_stop(accum_prob, step)) {state = interpolate_state(state, accum_prob);break;}}return final_output(state);}// 状态插值(核心创新点)std::vector<float> interpolate_state(const std::vector<float>& current, float p) const {std::vector<float> result(current.size());float remain_p = 1 - p;for (size_t i = 0; i < current.size(); ++i) {result[i] = remain_p * previous_state[i] + p * current[i];}return result;}private:std::vector<float> previous_state;// 状态初始化std::vector<float> initialize_state(const std::vector<float>& input) {previous_state = input;return input;}// 动态停止条件bool should_stop(float prob, int step) const {return prob >= halt_threshold || step == max_steps - 1;}// 虚函数接口virtual std::vector<float> transition(const std::vector<float>& state) = 0;virtual float compute_halt_prob(const std::vector<float>& state) = 0;virtual std::vector<float> final_output(const std::vector<float>& state) = 0;

};// 具体实现示例:迷宫导航单元

class MazeSolverCell : public PonderingCell {

public:std::vector<float> transition(const std::vector<float>& state) override {// 实际实现包含LSTM状态更新和迷宫环境交互std::vector<float> new_state(state.size());// ... 神经网络计算逻辑 ...return new_state;}float compute_halt_prob(const std::vector<float>& state) override {// 基于状态熵的停止概率计算float entropy = 0.0f;for (auto val : state) {float p = sigmoid(val);entropy -= p * log(p + 1e-7f);}return 1.0f / (1.0f + exp(-entropy));}std::vector<float> final_output(const std::vector<float>& state) override {// 输出动作概率分布return softmax(state);}

};// 动态网络执行引擎

class ACTEngine {std::vector<std::unique_ptr<PonderingCell>> processing_units;public:void execute(const std::vector<float>& sensor_input) {auto state = sensor_input;// 层级间动态计算for (auto& unit : processing_units) {state = unit->process(state);// 可在此插入跨层状态传递逻辑}output_action(state);}private:void output_action(const std::vector<float>& logits) {// 选择最优动作(示例实现)int best_idx = 0;float max_val = logits;for (size_t i = 1; i < logits.size(); ++i) {if (logits[i] > max_val) {max_val = logits[i];best_idx = i;}}execute_movement(static_cast<Movement>(best_idx));}

};动态计算循环

for (int step = 0; step < max_steps; ++step) {// 状态更新if (should_stop(...)) break; // 自适应终止

}概率插值机制

result[i] = remain_p * previous_state[i] + p * current[i];熵基停止准则

float entropy = ...;

return 1.0f / (1.0f + exp(-entropy));

相关组件列表

| CUDA内核加速状态转移计算 |

|---|

| 多线程异步执行支持 |

| 计算步数统计与资源监控模块 |

| 基于强化学习的阈值自动调整机制 |

扩展自循环架构至多模态场景,才气张量网络包含视觉-语言联合表征

基于马里兰大学多模态循环推理架构的C++核心实现框架,重点展示视觉-语言联合表征与自适应推理机制

// 多模态联合编码空间

class MultimodalLatentSpace {

private:VisionEncoder vision_encoder; // 视觉特征提取器TextEncoder text_encoder; // 语言特征编码器FusionNetwork fusion_net; // 跨模态融合网络:ml-citation{ref="2,7" data="citationList"}public:// 生成联合才气孢子表征vector<float> encode_joint(const cv::Mat& image, const string& text) {auto vis_feat = vision_encoder.process(image); // :ml-citation{ref="3" data="citationList"}auto txt_feat = text_encoder.encode(text); // :ml-citation{ref="2" data="citationList"}// 交叉注意力融合:ml-citation{ref="1,5" data="citationList"}return fusion_net.fuse(vis_feat, txt_feat); }

};// 自适应循环处理器

class AdaptiveReasoner {vector<RecurrentBlock> blocks; // 循环处理单元:ml-citation{ref="1,5" data="citationList"}int max_steps = 20;float halt_threshold = 0.95f;// 动态停止条件检测:ml-citation{ref="1,3" data="citationList"}bool should_stop(const vector<float>& state, int step) {float uncertainty = calc_entropy(state);return (uncertainty < 0.2f) || (step >= max_steps);}public:// 多步推理过程vector<float> process(const vector<float>& latent_input) {vector<float> state = latent_input;// 动态推理循环:ml-citation{ref="1,2" data="citationList"}for (int step = 0; step < max_steps; ++step) {// 跨模态状态更新for (auto& block : blocks) {state = block.transform(state); // :ml-citation{ref="5" data="citationList"}}if (should_stop(state, step)) {state = apply_residual(state); // 残差补偿break;}}return state;}

};// 完整推理管线

class VQAPipeline {MultimodalLatentSpace encoder;AdaptiveReasoner reasoner;AnswerDecoder decoder;public:string solve_vqa(const cv::Mat& image, const string& question) {// 生成联合表征:ml-citation{ref="2,7" data="citationList"}auto joint_latent = encoder.encode_joint(image, question);// 自适应推理(3-17步):ml-citation{ref="1,3" data="citationList"}auto refined_latent = reasoner.process(joint_latent);// 解码最终答案return decoder.decode(refined_latent);}

};跨模态融合机制

vector<float> fuse(const vector<float>& vis, const vector<float>& txt) {// 使用门控注意力融合视觉-语言特征:ml-citation{ref="5,7" data="citationList"}auto attn_weights = cross_attention(vis, txt);return elementwise_mul(vis, attn_weights) + txt;

}不确定性感知停止条件

float calc_entropy(const vector<float>& state) {float sum = 0, entropy = 0;for (auto val : state) sum += exp(val);for (auto val : state) {float p = exp(val)/sum;entropy -= p * log(p + 1e-7);}return entropy; // 低熵值触发提前终止:ml-citation{ref="1,3" data="citationList"}

}残差补偿机制

vector<float> apply_residual(const vector<float>& current) {return 0.9f * current + 0.1f * prev_state; // 平滑状态跳跃:ml-citation{ref="5" data="citationList"}

}基于Consciciteation-Conscicritsis机制架构设计参考

采用稀疏专家混合架构

GLaM稀疏专家混合架构的核心代码框架,重点展示动态专家选择与子网络激活机制:

// 稀疏专家混合层核心实现

class MoELayer {

private:std::vector<ExpertNetwork> experts; // 专家子网络池:ml-citation{ref="1" data="citationList"}int num_experts = 64; // 总专家数int active_experts = 2; // 激活专家数(Top2):ml-citation{ref="5" data="citationList"}float capacity_factor = 1.2f; // 专家容量系数// 门控网络实现std::vector<float> compute_gating(const std::vector<float>& input) {auto logits = gate_network(input); // 路由网络计算:ml-citation{ref="1,5" data="citationList"}return softmax_topk(logits, active_experts); // Top-K稀疏激活:ml-citation{ref="1" data="citationList"}}public:// 前向传播实现稀疏激活std::vector<float> forward(const std::vector<float>& input) {auto gate_output = compute_gating(input);std::vector<float> output(input.size(), 0.0f);// 动态选择专家并聚合结果:ml-citation{ref="1,5" data="citationList"}for (int i = 0; i < active_experts; ++i) {int expert_idx = get_topk_index(gate_output, i);auto expert_out = experts[expert_idx].compute(input);// 加权聚合输出:ml-citation{ref="5" data="citationList"}float weight = gate_output[expert_idx];for (size_t j = 0; j < output.size(); ++j) {output[j] += weight * expert_out[j];}}return output;}

};// 专家子网络实现

class ExpertNetwork {LinearLayer fc1{1024, 4096}; // 扩展维度:ml-citation{ref="1" data="citationList"}LinearLayer fc2{4096, 1024}; // 收缩维度GELU activation;public:std::vector<float> compute(const std::vector<float>& x) {auto h = fc1(x);h = activation(h);return fc2(h);}

};// 动态路由网络实现

class GateNetwork {LinearLayer routing_layer{1024, 64}; // 输入到专家数的映射:ml-citation{ref="5" data="citationList"}public:std::vector<float> operator()(const std::vector<float>& x) {return routing_layer(x); // 输出各专家激活权重:ml-citation{ref="1" data="citationList"}}

};动态路由机制

softmax_topk(logits, active_experts); // 选择Top2专家:ml-citation{ref="1,5" data="citationList"}专家容量控制

capacity_factor = 1.2f; // 防止专家过载:ml-citation{ref="5" data="citationList"}参数高效设计

class ExpertNetwork { ... }; // 每个专家独立参数:ml-citation{ref="1" data="citationList"}相关组件列表

| 专家参数分布式存储策略 |

|---|

| 动态负载均衡监控模块 |

| 混合精度计算支持 (FP16/FP8) |

| 硬件感知内核优化(CUDA/TPU) |

神经符号混合架构

神经符号混合架构的核心代码框架

// 符号逻辑处理模块

class SymbolicProcessor {

private:std::unordered_map<int, std::string> symbol_dict; // 符号字典:ml-citation{ref="1,8" data="citationList"}// 表达式树节点结构struct ExprNode {std::string op;std::vector<ExprNode*> children;float neural_confidence; // 神经网络的置信度:ml-citation{ref="8" data="citationList"}};public:// 神经网络输出转符号表达式ExprNode* neural_to_symbolic(const std::vector<float>& nn_output) {ExprNode* root = new ExprNode();root->op = decode_operator(nn_output); // 符号解码:ml-citation{ref="1,8" data="citationList"}root->neural_confidence = nn_output.back();// 递归构建表达式树for (int i = 0; i < nn_output.size() - 1; ++i) {if (nn_output[i] > 0.7f) { // 激活阈值判断:ml-citation{ref="8" data="citationList"}auto child = generate_subexpr(i);root->children.push_back(child);}}return root;}// 符号推理引擎std::string symbolic_reasoning(ExprNode* root) {while (requires_simplification(root)) { // 符号化简:ml-citation{ref="8" data="citationList"}apply_math_rules(root); // 应用数学公理:ml-citation{ref="1" data="citationList"}}return serialize_expression(root);}

};// 神经编码模块

class NeuralEncoder {

private:std::vector<std::vector<float>> weights_ih; // 输入到隐藏层权重:ml-citation{ref="1,7" data="citationList"}std::vector<std::vector<float>> weights_ho; // 隐藏到输出层权重:ml-citation{ref="1" data="citationList"}// 激活函数float sigmoid(float x) { return 1 / (1 + exp(-x)); // :ml-citation{ref="1,8" data="citationList"}}public:// 前向传播生成符号特征std::vector<float> encode(const std::vector<float>& input) {std::vector<float> hidden(weights_ih.size(), 0.0f);// 输入层→隐藏层:ml-citation{ref="1,7" data="citationList"}for (int i = 0; i < weights_ih.size(); ++i) {for (int j = 0; j < input.size(); ++j) {hidden[i] += weights_ih[i][j] * input[j];}hidden[i] = sigmoid(hidden[i]); // :ml-citation{ref="8" data="citationList"}}// 隐藏层→输出层:ml-citation{ref="1" data="citationList"}std::vector<float> output(weights_ho.size(), 0.0f);for (int i = 0; i < weights_ho.size(); ++i) {for (int j = 0; j < weights_ho[i].size(); ++j) {output[j] += hidden[i] * weights_ho[i][j];}}return output;}

};// 混合架构协调器

class NeuroSymbolicEngine {NeuralEncoder encoder;SymbolicProcessor processor;public:std::string prove_theorem(const std::vector<float>& problem_vec) {// 神经网络生成符号特征:ml-citation{ref="8" data="citationList"}auto nn_output = encoder.encode(problem_vec);// 构建符号表达式树:ml-citation{ref="1,8" data="citationList"}auto expr_tree = processor.neural_to_symbolic(nn_output);// 符号逻辑推理:ml-citation{ref="8" data="citationList"}return processor.symbolic_reasoning(expr_tree);}

};双向特征映射机制

ExprNode* neural_to_symbolic(const vector<float>& nn_output) {// 将神经网络输出映射为符号表达式树:ml-citation{ref="1,8" data="citationList"}

}置信度引导推理

struct ExprNode {float neural_confidence; // 神经网络的置信度:ml-citation{ref="8" data="citationList"}

};规则应用接口

void apply_math_rules(ExprNode* root) {// 应用预定义数学公理进行化简:ml-citation{ref="1,8" data="citationList"}

}

神经编程解释器

神经编程解释器(NPI)的核心框架,结合Code as Policies的最新进展,实现从才气张量网络到执行策略的端到端生成:

// 策略执行引擎(直接映射到机器人动作)

class PolicyExecutor {

private:std::unordered_map<std::string, std::function<void()>> primitive_actions = {{"move_arm", []{ /* 机械臂控制代码 */ }},{"gripper_open", []{ /* 夹爪开启 */ }},{"rotate_joint", []{ /* 关节旋转 */ }}};public:void execute_policy(const std::vector<std::string>& action_sequence) {for (const auto& action : action_sequence) {if (primitive_actions.count(action)) {primitive_actions:ml-search[action];} else {handle_composite_action(action); // 复合动作分解:ml-citation{ref="3" data="citationList"}}}}

};// 神经策略生成器(Code as Policies核心)

class NeuralPolicyGenerator {LSTMController lstm; // 时序建模网络AttentionModule cross_attn; // 环境状态注意力:ml-citation{ref="1,5" data="citationList"}// 从才气张量网络生成可执行策略std::vector<std::string> decode_policy(const std::vector<float>& latent_code) {std::vector<std::string> policy;auto hidden_state = lstm.initialize(latent_code);// 自回归生成动作序列:ml-citation{ref="1,5" data="citationList"}for (int step = 0; step < MAX_POLICY_STEPS; ++step) {auto env_state = get_environment_snapshot(); // 获取实时环境状态:ml-citation{ref="5" data="citationList"}auto attn_weights = cross_attn(hidden_state, env_state);auto action_probs = compute_action_distribution(attn_weights);std::string action = sample_action(action_probs); // 策略采样:ml-citation{ref="1" data="citationList"}if (action == "<END>") break;policy.push_back(action);hidden_state = lstm.update(hidden_state, action);}return policy;}

};// 端到端神经编程解释器

class NPI_System {NeuralPolicyGenerator generator;PolicyExecutor executor;LatentSpaceMapper latent_mapper; // 才气张量网络编码器:ml-citation{ref="2" data="citationList"}public:void execute_task(const std::string& task_description) {// 将任务描述映射到才气张量网络程序空间:ml-citation{ref="2" data="citationList"}auto latent_code = latent_mapper.encode(task_description);// 生成无中间代码的直执行策略:ml-citation{ref="1,5" data="citationList"}auto policy = generator.decode_policy(latent_code);// 直接执行动作序列executor.execute_policy(policy);}

};环境感知策略生成

auto env_state = get_environment_snapshot();

auto attn_weights = cross_attn(hidden_state, env_state); // :ml-citation{ref="5" data="citationList"}才气孢子程序空间压缩

class LatentSpaceMapper {TransformerEncoder encoder; // 文本到才气张量网络编码:ml-citation{ref="2" data="citationList"}vector<float> encode(const string& desc) {return encoder.compress(desc); // 128维压缩表示}

};分层动作执行

void handle_composite_action(const string& action) {if (is_meta_action(action)) { // 元动作解析:ml-citation{ref="3" data="citationList"}expand_meta_action(action); }

}代码调研参考文献表格

| Perceiver IO: A General Architecture for Structured Inputs & Outputs | DeepMind的Perceiver IO(2021) |

|---|---|

| Conditional Adaptive Computation for Efficient Inference | Google的CALM(2022) |

| Diffusion-LM: Controllable Text Generation through Diffusion Models | Diffusion-LM(斯坦福,2022) |

| Universal Transformers | mer(DeepMind,2018) |

| GLaM: Efficient Scaling of Language Models with Mixture-of-Experts | Microsoft的GLaM(2022) |

| System 1 & System 2 Thinking in Language Models | (爱丁堡大学,2023) |

| Aligning Neural Language Models with Brain Activity during Story Processing | 牛津团队 |

相关文章:

[王阳明代数讲义]语言模型核心代码调研

语言模型核心代码调研 基于Consciciteation的才气张量持续思考综述将文本生成建模为才气张量网络扩散过程,实现非自回归推理通过才气张量的群-拓扑流形交叉注意力实现多模态推理,将输入压缩到低维空间持续迭代提出「条件计算提前终止」机制,…...

算了和周日一块写了 4月20日日记)

4月19日记(补)算了和周日一块写了 4月20日日记

周六啊 昨天晚上又玩的太嗨了。睡觉的时候有点晚了,眼睛疼就没写日记。现在补上 实际上现在是20号晚上八点半了。理论上来说应该写今天的日记。 周六上午打比赛啦,和研究生,输了,我是替补没上场。没关系再练一练明天就可以变强…...

trivy开源安全漏洞扫描器——筑梦之路

开源地址:https://github.com/aquasecurity/trivy.git 可扫描的对象 容器镜像文件系统Git存储库(远程)虚拟机镜像Kubernetes 在容器镜像安全方面使用广泛,其他使用相对较少。 能够发现的问题 正在使用的操作系统包和软件依赖项…...

【实战中提升自己】内网安全部署之dot1x部署 本地与集成AD域的主流方式(附带MAC认证)

1 dot1x部署【用户名密码认证,也可以解决私接无线AP等功能】 说明:如果一个网络需要通过用户名认证才能访问内网,而认证失败只能访问外网与服务器,可以部署dot1x功能。它能实现的效果是,当内部用户输入正常的…...

[matlab]南海地形眩晕图代码

[matlab]南海地形眩晕图代码 请ChatGPT帮写个南海地形眩晕图代码 图片 图片 代码 .rtcContent { padding: 30px; } .lineNode {font-size: 12pt; font-family: "Times New Roman", Menlo, Monaco, Consolas, "Courier New", monospace; font-style: n…...

Web安全和渗透测试--day6--sql注入--part 1

场景: win11家庭版,edge浏览器 , sqlin靶场 定义: SQL 注入(SQL Injection)是一种常见的网络安全攻击方式,攻击者通过在 Web 应用程序中输入恶意的 SQL 代码,绕过应用程序的安全机…...

预测及治疗方案制定中的应用研究)

大模型在胆管结石(无胆管炎或胆囊炎)预测及治疗方案制定中的应用研究

目录 一、引言 1.1 研究背景与意义 1.2 研究目的 1.3 国内外研究现状 二、胆管结石相关理论基础 2.1 胆管结石概述 2.2 临床表现与诊断方法 2.3 传统治疗方法 三、大模型技术原理与应用优势 3.1 大模型基本原理 3.2 在医疗领域的应用潜力 3.3 用于胆管结石预测的可…...

MIT6.S081-lab4

MIT6.S081-lab4 注:本篇lab的前置知识在《MIT6.S081-lab3前置》 1. RISC-V assembly 第一个问题 Which registers contain arguments to functions? For example, which register holds 13 in main’s call to printf? 我们先来看看main干了什么: …...

精通 Spring Cache + Redis:避坑指南与最佳实践

Spring Cache 以其优雅的注解方式,极大地简化了 Java 应用中缓存逻辑的实现。结合高性能的内存数据库 Redis,我们可以轻松构建出响应迅速、扩展性强的应用程序。然而,在享受便捷的同时,一些常见的“坑”和被忽视的最佳实践可能会悄…...

[SpringBoot]快速入门搭建springboot

默认有spring基础,不会一行代码一行代码那么细致地讲。 SpringBoot的作用 Spring Boot是为了简化Spring应用的创建、运行、调试、部署等而出现的。就像我们整个SSM框架时,就常常会碰到版本导致包名对不上、Bean非法参数类型的一系列问题(原出…...

理解.NET Core中的配置Configuration

什么是配置 .NET中的配置,本质上就是key-value键值对,并且key和value都是字符串类型。 在.NET中提供了多种配置提供程序来对不同的配置进行读取、写入、重载等操作,这里我们以为.NET 的源码项目为例,来看下.NET中的配置主要是有…...

C++面试八股文:智能指针

一、了解哪些智能指针? 回答:智能指针是用于管理动态分配的内存,行为类似于指针,但又具有自动管理内存的能力,所以称为智能指针。 首先说一下 auto_ptr和unique_ptr,它们都是独占式指针,同一时…...

nohup命令使用说明

文章目录 如何在后台运行程序呢?如何正常运行代码重定向呢?nohup: ignoring input 如何在后台运行程序呢? 使用nohup命令即可, nohup python dataset/ReferESpatialDataset.py >>dataset_20250417.log 2>&1 &n…...

MYSQL “Too Many Connections“ 错误解决

1.查询当前连接数 show status like "Threads_connected"; 2.查询数据库最大连接数 show variables like "max_connections" 3.查询所有活动连接 show processlist; 4.根据查询结果观察是否有长时间未被释放的连接 参数解释 : 字段说明id连接的唯一…...

Linux `init 6` 相关命令的完整使用指南

Linux init 6 相关命令的完整使用指南—目录 一、init 系统简介二、init 6 的含义与作用三、不同 Init 系统下的 init 6 行为1. SysVinit(如 CentOS 6、Debian 7)2. systemd(如 CentOS 7、Ubuntu 16.04)3. Upstart(如 …...

【外研在线-注册/登录安全分析报告】

前言 由于网站注册入口容易被黑客攻击,存在如下安全问题: 暴力破解密码,造成用户信息泄露短信盗刷的安全问题,影响业务及导致用户投诉带来经济损失,尤其是后付费客户,风险巨大,造成亏损无底洞…...

【NLP 63、大模型应用 —— Agent】

人与人最大的差距就是勇气和执行力,也是唯一的差距 —— 25.4.16 一、Agent 相关工作 二、Agent 特点 核心特征: 1.专有场景(针对某个垂直领域) 2.保留记忆(以一个特定顺序做一些特定任务,记忆当前任务的前…...

React 打包

路由懒加载 原本的加载方式 #使用lazy()函数声明的路由页面 使用Suspense组件进行加载 使用CDN优化...

2025.4.14-2025.4.20学习周报

目录 摘要Abstract1. 文献阅读1.1 模型架构1.2 实验分析1.3 代码实践 总结 摘要 在本周阅读的论文中,作者提出了一种名为MGSFformer的空气质量预测模型。模型通过残差去冗余模块可以有效解耦多粒度数据间的信息重叠;时空注意力模块采用并行建模策略&…...

Spring 微服务解决了单体架构的哪些痛点?

1. 部署困难 (Deployment Difficulty & Risk) 单体痛点: 整体部署: 对单体应用的任何微小修改(哪怕只是一行代码),都需要重新构建、测试和部署整个庞大的应用程序。部署频率低: 由于部署过程复杂且风险高,发布周期通常很长&a…...

【1】云原生,kubernetes 与 Docker 的关系

Kubernetes?K8s? Kubernetes经常被写作K8s。其中的数字8替代了K和s中的8个字母——这一点倒是方便了发推,也方便了像我这样懒惰的人。 什么是云原生? 云原生: 它是一种构建和运行应用程序的方法,它包含&am…...

Kubernetes控制平面组件:APIServer 限流机制详解

云原生学习路线导航页(持续更新中) kubernetes学习系列快捷链接 Kubernetes架构原则和对象设计(一)Kubernetes架构原则和对象设计(二)Kubernetes架构原则和对象设计(三)Kubernetes控…...

springboot全局异常捕获处理

一、需求 实际项目中,经常抛出各种异常,不能直接抛出异常给前端,这样用户体验相当不好,用户看不懂你的Exception,对于一些sql异常,直接抛到页面上也不安全。所以有没有好的办法解决这些问题呢,当然有了&am…...

: 在windows系统上部署项目1)

Flask(1): 在windows系统上部署项目1

1 前言 学习python也有段时间了,最近一个小项目要部署,正好把过程写下来。 在程序的结构上我选择了w/s模式,相比于c/s模式,无需考虑客户端的升级;框架我选择了flask,就是冲着轻量级去的,就是插件…...

【文献阅读】EndoNet A Deep Architecture for Recognition Tasks on Laparoscopic Videos

关于数据集的整理 Cholec80 胆囊切除手术视频数据集介绍 https://zhuanlan.zhihu.com/p/700024359 数据集信息 Cholec80 数据集 是一个针对内窥镜引导 下的胆囊切除手术视频流程识别数据集。数据集提供了每段视频中总共7种手术动作及总共7种手术工具的标注,标…...

基于springboot的个人财务管理系统的设计与实现

博主介绍:java高级开发,从事互联网行业六年,熟悉各种主流语言,精通java、python、php、爬虫、web开发,已经做了六年的毕业设计程序开发,开发过上千套毕业设计程序,没有什么华丽的语言࿰…...

Linux系统编程---孤儿进程与僵尸进程

1、前言 在上一篇博客文章已经对Linux系统编程内容进行了较为详细的梳理,本文将在上一篇的基础上,继续梳理Linux系统编程中关于孤儿进程和僵尸进程的知识脉络。如有疑问的博客朋友可以通过下面的博文链接进行参考学习。 Linux系统编程---多进程-CSDN博客…...

简单使用MCP

简单使用MCP 1 简介 模型上下文协议(Model Context Protocol,MCP)是由Anthropic(产品是Claude)推出的开放协议,它规范了应用程序如何向LLM提供上下文。MCP可帮助你在LLM之上构建代理和复杂的工作流。 从…...

Semaphore的核心机制

在 Java 中,Semaphore 通过 许可计数器 和 同步队列 的机制实现并发线程数的限制。以下是其核心实现原理和步骤的详细分析: 一、核心机制 许可计数器(Permits) • 初始化时指定的许可数(如 new Semaphore(3)࿰…...

计算机视觉与深度学习 | RNN原理,公式,代码,应用

RNN(循环神经网络)详解 一、原理 RNN(Recurrent Neural Network)是一种处理序列数据的神经网络,其核心思想是通过循环连接(隐藏状态)捕捉序列中的时序信息。每个时间步的隐藏状态 ( h_t ) 不仅依赖当前输入 ( x_t ),还依赖前一时间步的隐藏状态 ( h_{t-1} ),从而实现…...