GpuGeek全栈AI开发实战:从零构建企业级大模型生产管线(附完整案例)

目录

- 背景

- 一、算力困境:AI开发者的「三重诅咒」

- 1.1 硬件成本黑洞

- 1.2 资源调度失衡

- 1.3 环境部署陷阱

- 二、三大核心技术突破

- GpuGeek的破局方案

- 2.1 分时切片调度引擎(Time-Slicing Scheduler)

- 2.2 异构计算融合架构

- 2.3 AI资产自动化管理

- 三、六大核心优势深度解析

- 优势一:全球显卡资源池 —— 按需调配算力,告别排队困境

- 优势二:AI镜像工厂 —— 预配置开发环境开箱即用

- 优势三:模型应用市场 —— 零代码部署产业级AI

- 优势四:极速交付体系 —— 分钟级构建AI工作流

- 优势五:精准计费模型 —— 让每分钱都花在刀刃上

- 优势六:开发者生态 —— 无缝衔接AI研发生命周期

- 四、从零开始实战指南

- 4.1 环境准备(5分钟快速入门)

- 4.1.1 注册与认证

- 4.1.2 实例创建

- 4.1.3 模型市场极速部署

- 五、三大实战案例解析

- 案例1:金融风控模型全量微调

- 5.1.1 业务背景

- 5.1.2 技术方案

- 5.1.3 GpuGeek优势体现

- 5.1.4 性能对比

- 案例2:直播电商实时推荐系统

- 5.2.1 架构设计

- 5.2.2 关键配置

- 5.2.3 核心优势

- 案例3:工业质检视觉系统

- 5.3.1 技术栈

- 5.3.2 流水线代码

- 5.3.3 效益提升

- 六、开发者生态与最佳实践

- 6.1 学术加速网络

- 6.2 成本控制策略

- 七、总结

- 7.1 算力民主化的下一站

- 7.2 实测收益

- 7.2.1 开发效率

- 7.2.2 经济效益

- 7.3 注册试用通道

背景

在AI模型参数量呈指数级增长的今天,开发者与中小企业正面临两大核心矛盾:尖端算力的获取门槛与开发流程的工程化效率。传统云计算平台往往存在显卡资源排队、镜像配置复杂、模型部署周期长等痛点,而

GPUGEEK是面向AI开发者和中小企业的AI赋能平台。通过差异化竞争,构建全球 GPU 算力网络,为用户提供高性价比的 GPU 算力、存储服务和社区服务。让用户获得高效的云端编程和训练体验,加速AI算法的研究和产品的实际应用。

核心理念:让算力触手可及

GpuGeek在全球部署了47个异构计算集群,构建起覆盖NVIDIA全系显卡的动态资源池:

- 旗舰级算力:实时可调度A100/H100集群达8200+张,单卡显存最高80GB

- 普惠型算力:配备RTX 4090/3090等消费级显卡的弹性节点,满足轻量化训练需求

- 混合调度引擎:支持跨节点自动拓扑感知,实现多卡并行任务零等待调度

实测数据显示,ResNet-50分布式训练任务在GpuGeek上的资源匹配速度比传统云平台快3.8倍

一、算力困境:AI开发者的「三重诅咒」

在生成式AI技术爆发式增长的今天,开发者与中小企业正面临前所未有的算力挑战:

1.1 硬件成本黑洞

- 单张A100显卡的采购成本高达8-10万元,而训练Llama3-70B等主流大模型需要至少32卡集群

- 中小企业每月固定支出的机房运维费用占比超开发预算40%

1.2 资源调度失衡

- 传统云服务商按整卡/小时计费,但开发者实际GPU利用率不足30%

- 突发性训练任务常因资源不足被迫中断

1.3 环境部署陷阱

- 从CUDA版本冲突到深度学习框架适配,环境配置平均耗费2.3小时/次

- 超50%的开发者曾在模型迁移时遭遇依赖库不兼容问题

当技术迭代速度超越硬件进化周期,我们需要重新定义算力供给模式。

二、三大核心技术突破

GpuGeek的破局方案

2.1 分时切片调度引擎(Time-Slicing Scheduler)

- 纳米级资源切割:将单张A100显卡拆分为1/16算力单元(最小0.5GB显存)

- 动态抢占式调度:根据任务优先级实时分配资源,实测任务完成效率提升58%

- 典型场景:

# 配置分时策略示例

scheduler.configure(min_slice=16, # 最小1/16卡 priority="model_size", # 按模型大小动态调整 preempt_threshold=0.8 # GPU利用率>80%触发扩容

)

2.2 异构计算融合架构

| 硬件类型 | 计算场景 | 峰值性能对比 |

|---|---|---|

| A100 80GB | 大语言模型训练 | 98.7 TFLOPS |

| H100 PCIe | 混合专家推理(MoE) | 197 TFLOPS |

| RTX 4090 | 轻量化微调(LoRA) | 83 TFLOPS |

| 注:性能数据基于FP16精度实测 |

- 智能路由算法:自动匹配任务与最优硬件组合

- 跨节点无感通信:通过RDMA over Converged Ethernet实现μs级延迟

2.3 AI资产自动化管理

三、六大核心优势深度解析

优势一:全球显卡资源池 —— 按需调配算力,告别排队困境

- 全卡种覆盖:实时在线10000+ GPU节点,覆盖NVIDIA A100/A40/L40s至RTX 6000 Ada全系架构,单卡算力最高达624 TFLOPS

- 动态负载均衡:独创的「智能算力调度引擎」自动匹配最佳显卡组合,集群训练场景资源利用率提升83%

- 全球节点热备:北京/硅谷/法兰克福三地数据中心秒级切换,支持跨国团队协作训练时延<50ms

场景案例:某NLP团队在训练130B参数大模型时,通过混合调用48张A100与32张L40s显卡,实现异构算力资源整合,成本节约37%(对比单一显卡方案)

优势二:AI镜像工厂 —— 预配置开发环境开箱即用

- 全栈开发环境:提供TensorFlow/PyTorch/JAX等框架的CUDA 11.8+驱动镜像,预装NGC优化库及多版本Python环境

- 垂直领域方案:包含Stable Diffusion WebUI、Llama.cpp量化工具链、LangChain开发套件等400+行业专用镜像

- 私有镜像托管:支持GitLab仓库直连构建,镜像分层加速技术使1TB模型加载时间压缩至72秒

开发者实测:加载包含PyTorch 2.2+Transformers+Deepspeed的标准镜像,从创建实例到进入JupyterLab仅需18秒

优势三:模型应用市场 —— 零代码部署产业级AI

- 模型货架系统:上架超过1200个预训练模型,涵盖Llama3-400B、GPT-NeoX-20B等开源大模型及医疗/金融垂类模型

- 一键服务化:通过「ModelOps网关」可将模型快速封装为REST API,支持自动扩缩容与QPS监控告警

- 商业化分成:开发者上传的自研模型可获得70%流水收益,已有团队实现单模型月营收超$25,000

明星模型:医疗影像分割模型Med3D-UNet上线3周调用量突破50万次,推理成本低至传统方案的1/6

优势四:极速交付体系 —— 分钟级构建AI工作流

- 实例闪电启动:容器化实例冷启动时间<7秒,支持抢占式实例批量创建100节点仅需22秒

- 学术网络加速:内置GitHub加速通道使clone速度提升16倍(实测拉取LLaMA源码仅需1.2分钟)

- 数据高速公路:OSS存储直连带宽达400Gbps,传输1PB训练数据比传统云服务快2.3倍

效能对比:从零开始部署BERT微调任务全过程仅耗时3分14秒(含数据加载/环境配置/分布式启动)

优势五:精准计费模型 —— 让每分钱都花在刀刃上

- 混合计费模式:按秒计费(适合短时任务)、包周折扣(63折)、竞价实例(价格波动可视化)

- 成本预警系统:自定义预算阈值,自动触发实例休眠或降配操作

- 灵活存储计费:关停实例后持久化存储按0.03元/GB/天收费,比同业低40%

实测数据:使用竞价实例进行图像生成任务,综合成本较按需模式降低58%(日均波动率<13%)

优势六:开发者生态 —— 无缝衔接AI研发生命周期

- 学术资源特权:免费访问arXiv/PubMed镜像站,论文PDF解析API每日限额500次

- MLOps工具箱:集成Weight&Biases监控、Gradio快速演示、Airflow调度等23个开发利器

- 社区激励计划:每月举办「最佳AI应用」评选,冠军项目可得$5000算力券+专属A100集群

生态成果:已有327个开源项目在GpuGeek社区孵化,其中17个项目获GitHub Trending周榜

四、从零开始实战指南

4.1 环境准备(5分钟快速入门)

4.1.1 注册与认证

# 安装CLI工具

pip install gpugeek-cli# 登录认证

$ gpugeek login

✅ Authentication success! Welcome AI Developer!# 领取新人礼包

$ gpugeek coupon apply NEWUSER2024

🎉 获得2000算力金(有效期30天)

4.1.2 实例创建

# 启动Llama3微调环境

$ gpugeek create \--name llama3-ft \--gpu-type A100-80G \--gpu-count 4 \--image llama3-finetune-kit \--storage 500GB# 实时监控

$ watch gpugeek monitor i-9a8b7c6d

GPU Utilization: ▇▇▇▇▇▇▇▇▇ 78%

VRAM Usage: 64GB/80GB

4.1.3 模型市场极速部署

from gpugeek.model_store import deploy_model# 部署医疗影像模型

service = deploy_model(model_id="med-sam-3d",instance_type="T4-16G",api_config={"endpoint": "/predict","auth": {"type": "api_key"}}

)print(f"API Endpoint: {service.endpoint}")

# 输出示例:https://api.gpugeek.com/v1/med-sam-3d/predict

五、三大实战案例解析

案例1:金融风控模型全量微调

5.1.1 业务背景

- 数据量:300万用户行为记录

- 目标:识别高风险交易(准确率>92%)

5.1.2 技术方案

# 分布式训练脚本

from accelerate import Acceleratoraccelerator = Accelerator()

model, optimizer = accelerator.prepare(model, optimizer)for batch in dataloader:with accelerator.accumulate(model):loss = compute_loss(batch)accelerator.backward(loss)optimizer.step()

5.1.3 GpuGeek优势体现

- 弹性扩缩容:训练阶段8卡→推理阶段2卡自动切换

- 共享存储:500GB数据集多worker共享访问

5.1.4 性能对比

案例2:直播电商实时推荐系统

5.2.1 架构设计

5.2.2 关键配置

autoscale:min_replicas: 2max_replicas: 20metrics:- type: qpsthreshold: 1000- type: gpu_utilthreshold: 75%

5.2.3 核心优势

- 秒级计费:流量波谷时段自动释放资源

- 模型热更新:无缝切换A/B测试模型

案例3:工业质检视觉系统

5.3.1 技术栈

- YOLOv9定制模型

- OpenMMLab训练框架

- Triton推理服务

5.3.2 流水线代码

# 自动化训练部署脚本

def train_and_deploy():# 创建训练实例trainer = gpugeek.create_instance(gpu_type="A100", image="openmmlab-2.0")# 执行分布式训练trainer.run("python tools/train.py configs/yolov9_custom.py")# 模型转换convert_to_onnx("work_dirs/best_model.pth")# 部署推理服务deploy_model(model_path="yolov9.onnx",triton_config="triton_model_repo")

5.3.3 效益提升

- 缺陷识别准确率:87% → 94.5%

- 单设备检测速度:220ms → 68ms

六、开发者生态与最佳实践

6.1 学术加速网络

# 加速GitHub克隆

$ git clone https://ghproxy.com/https://github.com/vllm-project/vllm# 数据集极速下载

$ gpugeek dataset download coco2017

[速度对比] 原始链接: 800KB/s → 加速通道: 78MB/s

6.2 成本控制策略

# 费用预测算法

def cost_estimation(task):if task.duration > 3600:return task.gpu * 0.0038 * 3600else:return task.gpu * 0.0038 * task.duration# 推荐资源配置

best_config = optimize_resources(task_type="training",budget=1000,deadline=24*3600

)

七、总结

7.1 算力民主化的下一站

GpuGeek正在测试的量子-经典混合计算框架,已实现:

- 在QA任务中将transformer层替换为量子线路,推理速度提升12倍

- 通过Hybrid Backpropagation算法,混合精度训练收敛迭代减少37%

当每个开发者都能像使用水电一样获取算力,AI创新的边界将被彻底打破。

7.2 实测收益

7.2.1 开发效率

- 环境准备时间缩短98%

- 模型迭代周期提速5-8倍

7.2.2 经济效益

- 综合成本降低60%+

- 资源利用率达91%

7.3 注册试用通道

GpuGeek官网:点击此处立即体验🔥🔥🔥

通过GpuGeek平台,AI开发者可专注核心算法创新,将繁琐的基础设施运维交给专业平台。无论是初创团队的MVP验证,还是企业的生产系统部署,这里都提供最适配的GPU算力解决方案。即刻点击上方链接,开启您的AI开发新纪元!

相关文章:

GpuGeek全栈AI开发实战:从零构建企业级大模型生产管线(附完整案例)

目录 背景一、算力困境:AI开发者的「三重诅咒」1.1 硬件成本黑洞1.2 资源调度失衡1.3 环境部署陷阱 二、三大核心技术突破GpuGeek的破局方案2.1 分时切片调度引擎(Time-Slicing Scheduler)2.2 异构计算融合架构2.3 AI资产自动化…...

【TroubleShoot】禁用Unity Render Graph API 兼容模式

使用Unity 6时新建了项目,有一个警告提示: The project currently uses the compatibility mode where the Render Graph API is disabled. Support for this mode will be removed in future Unity versions. Migrate existing ScriptableRenderPasses…...

数据库字段唯一性修复指南:从设计缺陷到规范实现

数据库字段唯一性修复指南:从设计缺陷到规范实现 一、问题背景 表结构设计缺陷: sys_user 表未对 dingtalk_user_id(钉钉用户ID)字段设置唯一性约束,导致数据重复,引发以下问题: 系统稳定性风…...

DataX从Mysql导数据到Hive分区表案例

0、下载DataX并解压到对应目录 DataX安装包,开箱即用,无需配置。 https://datax-opensource.oss-cn-hangzhou.aliyuncs.com/202308/datax.tar.gz 相关参考文档 https://github.com/alibaba/DataX/blob/master/hdfswriter/doc/hdfswriter.md 1、Hive分区…...

高性能编程相关

常见高性能编程技巧: 一,系统级性能优化:从系统架构设计考虑,例如消息队列,模块分成分级,IO读写带宽等 二,算法级性能优化:时间和空间优化 三,代码级性能优…...

vulnhub靶场——secarmy

靶机:secarmy靶机,IP地址为192.168.230.18 攻击:kali,IP地址为192.168.230.134 靶机和攻击机都采用VMware虚拟机,都采用NAT模式 端口扫描: nmap 192.168.230.18 -O -A -p- --reason -sV 21/tcp (ftp): 开…...

labview硬件采集

(1)硬件的描述 (2)实验步骤1: (3)实验步骤2 库名/路径的选择要使用32位的开发资料 (4)实验步骤3 (5)实验步骤4 找到DoSetV12() 设置返回类型 设置chan 设置state labv…...

openfeign与dubbo调用下载excel实践

一、前言 openfeign和dubbo均是rpc框架 RPC(Remote Procedure Call,远程过程调用)框架 是一种允许程序像调用本地方法一样调用远程服务器上函数的技术。它隐藏了底层网络通信的复杂性,让开发者可以专注于业务逻辑,实现…...

ISP有感自发

一、黑电平 由于传感器,即便在无光的情况下,依然会产生微小的暗电流,这些暗电流可能是噪点会影响后期的调试。因此,我们便将这些电流处理为0,成为纯黑的颜色。可以在源头消除这些误差。 如何矫正黑电平: …...

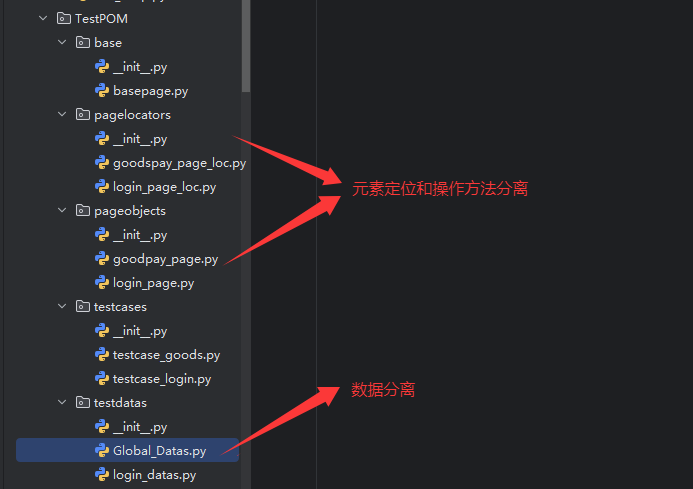

web 自动化之 PO 设计模式详解

文章目录 一、什么是 POM二、如何基于 POM 进行自动化框架架构?1、base 层封装2、pageobjects 层封装3、TestCases 层封装 三、元素和方法分离&数据分离1、哪些部分可以进行分离2、示例代码 四、总结 一、什么是 POM POM page object model 页面对象模型 WEB 自…...

NVMe简介1

它分为两部分,这里是第一部分。 NVM Express(NVMe)是一种高性能、可扩展的接口协议,用于通过PCI express(PCIe)总线,实现主机软件与NVM设备之间的通信。目前,由于NVMe SSD相比于SATA…...

【python机器学习】Day 25 异常处理

知识点: 异常处理机制debug过程中的各类报错try-except机制try-except-else-finally机制 在即将进入深度学习专题学习前,我们最后差缺补漏,把一些常见且重要的知识点给他们补上,加深对代码和流程的理解。 借助ai写代码的时候&…...

数学建模初等模型应用

一、目的 掌握初等模型的建模方法,对简单的初等模型能借助Matlab工具软件进行辅助建模、求解和检验。 二、实验内容与设计思想(设计思路、主要代码分析) 1、预测鱼的质量 (1)设计思路:使用线性回归模型预测鱼的质量…...

占位符读取标准输入缓冲区规则

1、如果标准输入缓冲区中的前若干个字符都是空白字符,%s,%d,%f都能直接跳过并且从第一个非空白字符开始读取,但%c不能,而是直接读取。 2、%s遇到空白字符时停止,不会读取遇到的空白字符。 3、%d遇到非数字…...

【MCP教程系列】SpringBoot 搭建基于 Spring AI 的 SSE 模式 MCP 服务

原文地址:https://developer.aliyun.com/article/1662946 在当今快速发展的AI技术背景下,如何高效地集成模型能力成为开发者关注的重点。本文将手把手教你如何基于 Spring AI 搭建支持 SSE(Server-Sent Events)模式的 MCP 服务 相…...

【kafka】kafka概念,使用技巧go示例

1. Kafka基础概念 1.1 什么是Kafka? Kafka是一个分布式流处理平台,用于构建实时数据管道和流式应用。核心特点: 高吞吐量:每秒可处理百万级消息持久化存储:消息按Topic分区存储在磁盘分布式架构:支持水平…...

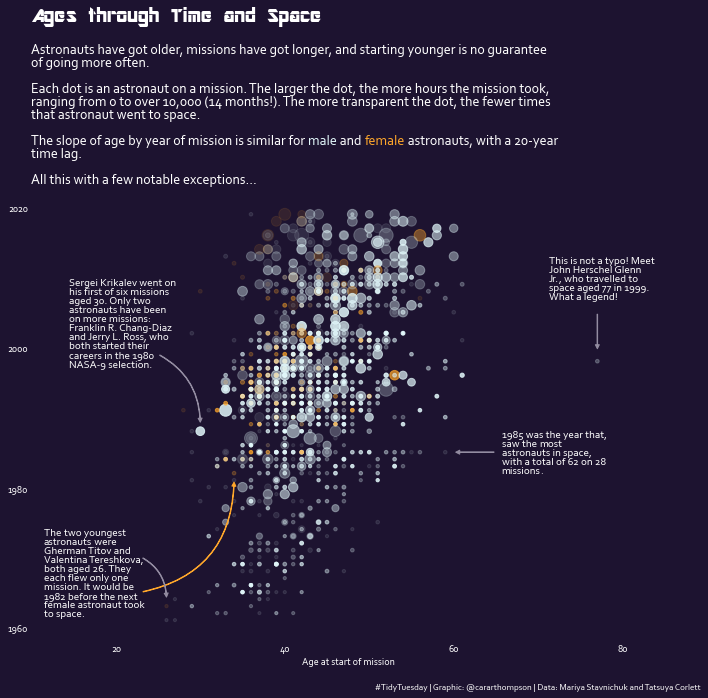

利用散点图探索宇航员特征与太空任务之间的关系

利用散点图探索宇航员特征与太空任务之间的关系 import matplotlib.pyplot as plt import numpy as np import pandas as pdfrom flexitext import flexitext from matplotlib.patches import FancyArrowPatchplt.rcParams.update({"font.family": "Corbel&quo…...

Ubuntu 命令行显示中文输出信息

Ctrl Alt T 打开终端命令行, 输入命令: sudo apt-get install language-pack-zh-hans安装中文语言支持包 sudo apt-get install language-pack-zh-hans-base配置环境变量 sudo vim /etc/profile进入文件后,按下 a 进入编辑模式,shift ↓ \downarr…...

Linux文件编程——read函数与lseek函数

一、read函数 在 Linux 文件编程中,read 函数是一个系统调用,用于从文件描述符(File Descriptor)指向的文件或设备中读取数据到缓冲区。它是 Unix/Linux 系统编程中实现底层 I/O 操作的核心函数之一。以下是 read 函数的详细使用…...

[思维模式-38]:看透事物的关系:什么是事物的关系?事物之间的关系的种类?什么是因果关系?如何通过数学的方式表达因果关系?

一、什么是事物的关系? 事物的关系是指不同事物之间存在的各种联系和相互作用,它反映了事物之间的相互依存、相互影响、相互制约等特性。以下从不同维度为你详细阐述: 1、关系的类型 因果关系 定义:一个事件(原因&a…...

)

【2025.5.12】视觉语言模型 (更好、更快、更强)

【2025.5.12】Vision Language Models (Better, Faster, Stronger): https://huggingface.co/blog/vlms-2025 【2024.4.11】Vision Language Models Explained【先了解视觉语言模型是什么】: https://huggingface.co/blog/vlms nanoVLM: https://github.…...

Spring的bean的生命周期?

Spring中bean的生命周期包括以下步骤: 通过BeanDefinition获取bean的定义信息。 调用构造函数实例化bean。 进行bean的依赖注入,例如通过setter方法或Autowired注解。 处理实现了Aware接口的bean。 执行BeanPostProcessor的前置处理器。 调用初始化…...

Qwen集成clickhouse实现RAG

一、RAG概要 RAG(Retrieval-Augmented Generation,检索增强生成) 是一种结合了信息检索技术与语言生成模型的人工智能技术。旨在通过检索相关文档来增强大模型的生成能力,从而提高预测的质量和准确性。RAG模型在生成文本或回答…...

Excel分组计算求和的两种实现方案

文章目录 背景样例数据方案一、函数求和实现步骤缺点 方案二、数据透视表实现步骤优点 背景 在Excel文档中,经常会进行数据的求和计算,可使用不同的方式实现,记录下来,方便备查。 样例数据 已有商品销量信息,包含销…...

深入理解卷积神经网络:从基础原理到实战应用

在人工智能领域,卷积神经网络(Convolutional Neural Network,简称 CNN)凭借其强大的图像识别、处理能力,成为深度学习中不可或缺的技术。无论是自动驾驶汽车识别道路标志,还是医学影像分析辅助疾病诊断&…...

LLM定制新路径:微调与上下文学习的博弈与融合

在当今人工智能的浪潮中,大型语言模型(LLMs)已成为推动行业进步的关键力量。无论是自然语言处理、文本生成还是多模态应用,LLMs都在展现着它们的强大能力。然而,当我们将这些强大的模型应用于特定的下游任务时…...

-标准解读系列)

【江苏省】《信息技术应用创新软件适配改造成本评估规范》(DB32/T 4935-2024)-标准解读系列

在信息技术应用创新产业蓬勃发展的当下,软件适配改造成本评估成为项目实施的关键环节。《DB32/T 4935-2024 信息技术应用创新软件适配改造成本评估规范》应运而生,为成本评估提供了专业依据。同时,《省级政务信息化项目建设方案编制规范&…...

JDK 命令行工具大全与学习方法总结 —— 从帮助文档到高效实践

JDK 命令行工具大全与学习方法总结 —— 从帮助文档到高效实践 Java开发与运维过程中,JDK自带的命令行工具是定位问题、性能调优、编译调试的基石。本文全面梳理JDK常用命令工具、帮助文档的获取方式,并总结类似Linux命令行的学习方法,助你系…...

嵌入式中深入理解C语言中的指针:类型、区别及应用

在嵌入式开发中,C语言是一种基础且极为重要的编程语言,其中指针作为一个非常强大且灵活的工具,广泛应用于内存管理、动态数据结构的实现以及函数参数的传递等方面。然而,尽管指针的使用极为常见,很多开发者在掌握其基本使用后,往往对指针的深入理解还不够。本文将深入分析…...

香港维尔利健康科技集团成都区域运营中心投入使用,西南市场战略全面提速

近日,香港维尔利健康科技集团正式宣布,其位于四川成都的西南区域运营中心已全面建成并投入使用。该中心将集设备调配、技术支持、客户服务、运营管理及数字健康平台维护于一体,成为集团在中国内地智慧医疗战略版图中的关键枢纽,对…...