Kafka 核心架构与消息模型深度解析(二)

案例实战:Kafka 在实际场景中的应用

(一)案例背景与需求介绍

假设我们正在为一个大型电商平台构建数据处理系统。该电商平台拥有庞大的用户群体,每天会产生海量的订单数据、用户行为数据(如浏览、点击、收藏等)以及商品信息变更数据。这些数据分散在各个业务系统中,需要进行集中收集、处理和分析,以便为平台的运营决策、用户个性化推荐、商品管理等提供数据支持。

在这个场景下,我们面临着以下几个关键问题:一是数据量巨大且产生速度快,传统的数据传输方式难以满足实时性要求;二是不同业务系统的数据格式和结构各异,需要进行统一的规范化处理;三是数据处理流程复杂,涉及多个环节和系统,需要一种可靠的消息传递机制来解耦各个组件,确保系统的高可用性和扩展性。为了解决这些问题,我们引入 Kafka 作为数据传输和消息队列的核心组件。Kafka 的高吞吐量、低延迟特性能够满足海量数据的实时传输需求;其分布式架构和分区机制可以有效地处理大规模数据,并实现水平扩展;同时,Kafka 的消息模型能够很好地解耦数据生产者和消费者,使得各个业务系统可以独立地进行数据生产和消费,提高系统的灵活性和可维护性。

(二)Kafka 架构与消息模型的应用实践

- 搭建 Kafka 集群:我们在三台高性能服务器上搭建了 Kafka 集群,每台服务器都运行一个 Kafka Broker。通过修改 Kafka 的配置文件server.properties,设置不同的broker.id来区分各个 Broker 节点。例如,第一台服务器的broker.id=1,第二台broker.id=2,第三台broker.id=3。同时,配置zookeeper.connect参数,指定 Zookeeper 集群的地址,让 Kafka 集群能够通过 Zookeeper 进行元数据管理和协调。在网络配置方面,设置listeners参数为服务器的内网 IP 和端口,如listeners=PLAINTEXT://192.168.1.101:9092,并根据实际情况配置advertised.listeners参数,确保外部系统能够正确访问 Kafka Broker。

- 配置 Producer:在订单系统中,我们使用 Kafka 的 Java 客户端来配置 Producer。首先,创建一个Properties对象,设置 Producer 的相关参数。例如,设置bootstrap.servers为 Kafka 集群的地址,如bootstrap.servers=192.168.1.101:9092,192.168.1.102:9092,192.168.1.103:9092;设置acks参数为all,表示 Producer 需要等待所有副本都确认收到消息后才认为消息发送成功,确保消息的可靠性;设置key.serializer和value.serializer为 Kafka 提供的序列化器,将消息的键和值转换为字节数组,以便在网络中传输。示例代码如下:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class OrderProducer {

public static void main(String[] args) {

Properties props = new Properties();

props.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "192.168.1.101:9092,192.168.1.102:9092,192.168.1.103:9092");

props.put(ProducerConfig.ACKS_CONFIG, "all");

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

try {

// 模拟订单数据

String orderData = "{\"orderId\":\"12345\",\"userId\":\"67890\",\"productId\":\"1001\",\"quantity\":2,\"price\":99.99}";

ProducerRecord<String, String> record = new ProducerRecord<>("orders", orderData);

producer.send(record);

System.out.println("Sent message: " + record);

} catch (Exception e) {

e.printStackTrace();

} finally {

producer.close();

}

}

}

- 配置 Consumer:在数据分析系统中,我们配置 Consumer 来订阅orders主题,消费订单数据进行分析处理。同样使用 Kafka 的 Java 客户端,创建Properties对象并设置相关参数。设置bootstrap.servers为 Kafka 集群地址;设置group.id为消费者组 ID,确保同一个消费者组内的消费者能够协调消费消息;设置key.deserializer和value.deserializer为反序列化器,将接收到的字节数组转换为消息的键和值。示例代码如下:

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Collections;

import java.util.Properties;

public class OrderConsumer {

public static void main(String[] args) {

Properties props = new Properties();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "192.168.1.101:9092,192.168.1.102:9092,192.168.1.103:9092");

props.put(ConsumerConfig.GROUP_ID_CONFIG, "order-analysis-group");

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList("orders"));

try {

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

System.out.println("Received message: " + record.value());

// 在这里进行订单数据分析处理

}

}

} catch (Exception e) {

e.printStackTrace();

} finally {

consumer.close();

}

}

}

- 利用消息模型实现业务需求:通过 Kafka 的消息模型,订单系统作为 Producer 将订单消息发送到orders主题,数据分析系统作为 Consumer 从orders主题中消费订单消息进行分析处理。由于 Kafka 的分区机制,订单消息会被分散存储到多个分区中,提高了数据存储和处理的并行性。同时,消费者组的概念使得多个数据分析系统实例可以组成一个消费者组,共同消费orders主题的消息,实现负载均衡。例如,当业务量增加时,可以添加更多的消费者实例到消费者组中,Kafka 会自动进行分区重新分配,确保每个消费者都能高效地处理消息。

(三)案例总结与经验分享

在这个案例中,我们深刻体会到了合理设计 Kafka 架构和消息模型的重要性。在架构设计方面,选择合适的服务器配置和 Kafka 参数调优对于系统的性能和稳定性至关重要。例如,合理设置log.dirs参数,将 Kafka 的数据存储在高性能的磁盘阵列上,可以提高数据读写速度;根据业务量和数据增长趋势,合理规划分区数量和副本数量,既能满足系统的扩展性需求,又能保证数据的可靠性。在消息模型设计方面,准确理解和应用 Producer 的分区策略、Consumer 的拉取模式以及消费者组的分区分配策略,是实现高效、可靠消息传递和处理的关键。例如,根据订单 ID 作为消息的键,使用 hash 分区策略,确保同一个订单的所有消息都发送到同一个分区,方便后续的订单状态跟踪和处理;在消费者组中,根据业务场景选择合适的分区分配策略,如 Sticky 策略,减少分区重分配带来的开销,提高系统的稳定性。

在实际应用过程中,我们也遇到了一些问题并总结了相应的解决方案。例如,在高并发场景下,Producer 可能会出现消息发送超时的问题。通过适当增加linger.ms参数的值,让 Producer 在发送消息前等待一段时间,积累更多的消息形成批次发送,既可以提高发送效率,又能减少网络开销,从而解决消息发送超时的问题。另外,Consumer 在消费消息时,可能会因为处理逻辑复杂导致消费速度跟不上生产速度,造成消息堆积。通过优化消费逻辑,采用异步处理、多线程等技术,提高消费速度;或者增加消费者实例的数量,实现水平扩展,分担消费压力,解决消息堆积的问题。

通过这个案例,我们更加深入地理解了 Kafka 的核心架构和消息模型,也为今后在其他项目中应用 Kafka 积累了宝贵的经验。

总结与展望:Kafka 的未来之路

(一)Kafka 核心架构与消息模型总结

Kafka 以其独特而精妙的设计,在分布式系统领域占据了重要的一席之地。其核心架构中的 Producer、Consumer、Broker、Topic、Partition 和 Zookeeper 等组件相互协作,构建了一个高效、可靠的分布式消息处理平台。Producer 负责将消息发送到 Kafka 集群,通过灵活的分区策略,能够将消息准确地路由到指定的分区,为后续的处理和分析提供了基础。Consumer 从 Kafka 集群中读取消息,采用拉取模式,能够根据自身的处理能力自主控制消费速率,并且通过消费者组的机制,实现了负载均衡和高可用性,使得多个消费者可以协同工作,高效地处理海量消息。

Broker 作为 Kafka 集群的核心节点,承担着消息存储和管理的重任。它通过将消息持久化到磁盘,并采用分段存储和索引机制,大大提高了消息的读写性能和存储效率。同时,Broker 通过副本机制,确保了数据的高可用性和一致性,即使在部分节点出现故障的情况下,也能保证服务的连续性和数据的完整性。Topic 作为消息的逻辑分类,将不同类型的消息进行区分,方便了消息的管理和处理。Partition 则是 Topic 的物理分区,通过分区,Kafka 实现了消息的并行处理和分布式存储,提高了系统的扩展性和吞吐量。Zookeeper 作为分布式协调服务,为 Kafka 集群提供了元数据管理、节点状态监控和控制器选举等重要功能,是 Kafka 集群稳定运行的关键支撑。

Kafka 的消息模型同样具有诸多亮点。消息由键和值组成,键不仅用于决定消息的分区,还为消息的处理和查询提供了便利。偏移量作为消息在分区中的唯一标识,确保了消费者能够准确地跟踪自己的消费进度,实现了消息的精确消费。消费者组的概念则为消息的广播和单播提供了灵活的实现方式,满足了不同业务场景的需求。在消息生产与消费过程中,Producer 的分区策略和消息发送方式,以及 Consumer 的拉取模式和分区分配策略,都经过了精心设计,以实现高效、可靠的消息传递。在消息存储与持久化方面,Kafka 的分区日志结构、Segment 文件管理、数据持久化策略和副本机制,共同保证了消息的可靠存储和高可用性。

(二)Kafka 的发展趋势与展望

展望未来,Kafka 有望在多个方面实现进一步的突破和发展。在流处理能力方面,KSQL 和 Kafka Streams 作为 Kafka 提供的流处理框架,将不断演进,具备更强大的功能和更高的性能。KSQL 可能会支持更多复杂的 SQL 特性,使得用户能够更方便地进行实时数据分析和处理,满足企业日益增长的对实时数据洞察的需求。

随着云原生技术的普及,Kafka 在云原生环境中的部署和管理将变得更加便捷。Kafka 与 Kubernetes 等容器编排工具的集成将不断深化,实现更简单的部署方式、更高效的资源利用和更强的弹性扩展能力。这将使得企业能够更轻松地在云端构建和管理 Kafka 集群,降低运维成本,提高系统的灵活性和可扩展性。

为了满足多租户环境下的应用需求,Kafka 将持续增强其安全性和隔离性。通过引入更细粒度的访问控制和配额管理机制,Kafka 可以确保不同租户之间的数据和资源隔离,防止数据泄露和资源滥用。同时,提供更完善的审计和监控功能,帮助管理员及时发现和解决潜在的安全问题,保障系统的稳定运行。

运维和监控对于 Kafka 的稳定运行至关重要。未来,Kafka 将不断优化其运维和监控工具,增强 Kafka Manager、Confluent Control Center 等工具的功能,并与 Prometheus、Grafana 等主流监控系统进行更紧密的集成,提供更全面、实时的监控和报警机制。这将使管理员能够实时了解 Kafka 集群的运行状态,及时发现和解决性能瓶颈、故障等问题,提高系统的可靠性和可用性。

在存储引擎方面,分层存储(Tiered Storage)技术的应用将成为趋势。通过将数据分层存储到不同的存储介质上,如本地磁盘和云存储,Kafka 可以在降低存储成本的同时提高存储效率,更好地满足企业对大规模数据存储的需求。

Kafka 社区也在考虑引入 Raft 协议来替代目前的 ZooKeeper 协议,以进一步提高性能和可靠性。Raft 协议的引入将简化 Kafka 的部署和管理,减少对外部协调服务的依赖,提供更高的可用性和一致性保障,为 Kafka 在关键业务场景中的应用提供更坚实的基础。

随着人工智能和机器学习技术的发展,Kafka 可能会引入智能数据路由和处理功能。通过利用机器学习算法,Kafka 可以根据数据的特征和业务需求,动态调整数据路由策略,实现更高效的数据分发和处理,提升系统的智能化水平和性能表现。

Kafka 作为分布式系统中的重要组件,其核心架构和消息模型为其在海量数据处理和消息传递领域的广泛应用奠定了坚实基础。而未来的发展趋势将使其在功能、性能、可用性等方面更上一层楼,继续在分布式系统领域发光发热,为企业的数字化转型和创新发展提供强大的技术支持。作为开发者和技术爱好者,我们应持续关注 Kafka 的发展动态,不断探索其在更多场景下的应用,共同推动技术的进步和创新。

相关文章:

)

Kafka 核心架构与消息模型深度解析(二)

案例实战:Kafka 在实际场景中的应用 (一)案例背景与需求介绍 假设我们正在为一个大型电商平台构建数据处理系统。该电商平台拥有庞大的用户群体,每天会产生海量的订单数据、用户行为数据(如浏览、点击、收藏等&#…...

4G网络中频段的分配

国内三大运营商使用的4G网络频段及对应关系如下: 📶 一、中国移动(以TD-LTE为主) 主力频段 Band 38(2570-2620MHz):室内覆盖Band 39(1880-1920MHz):广覆盖&am…...

SQL进阶之旅 Day 19:统计信息与优化器提示

【SQL进阶之旅 Day 19】统计信息与优化器提示 文章简述 在数据库性能调优中,统计信息和优化器提示是两个至关重要的工具。统计信息帮助数据库优化器评估查询成本并选择最佳执行计划,而优化器提示则允许开发人员对优化器的行为进行微调。本文深入探讨了…...

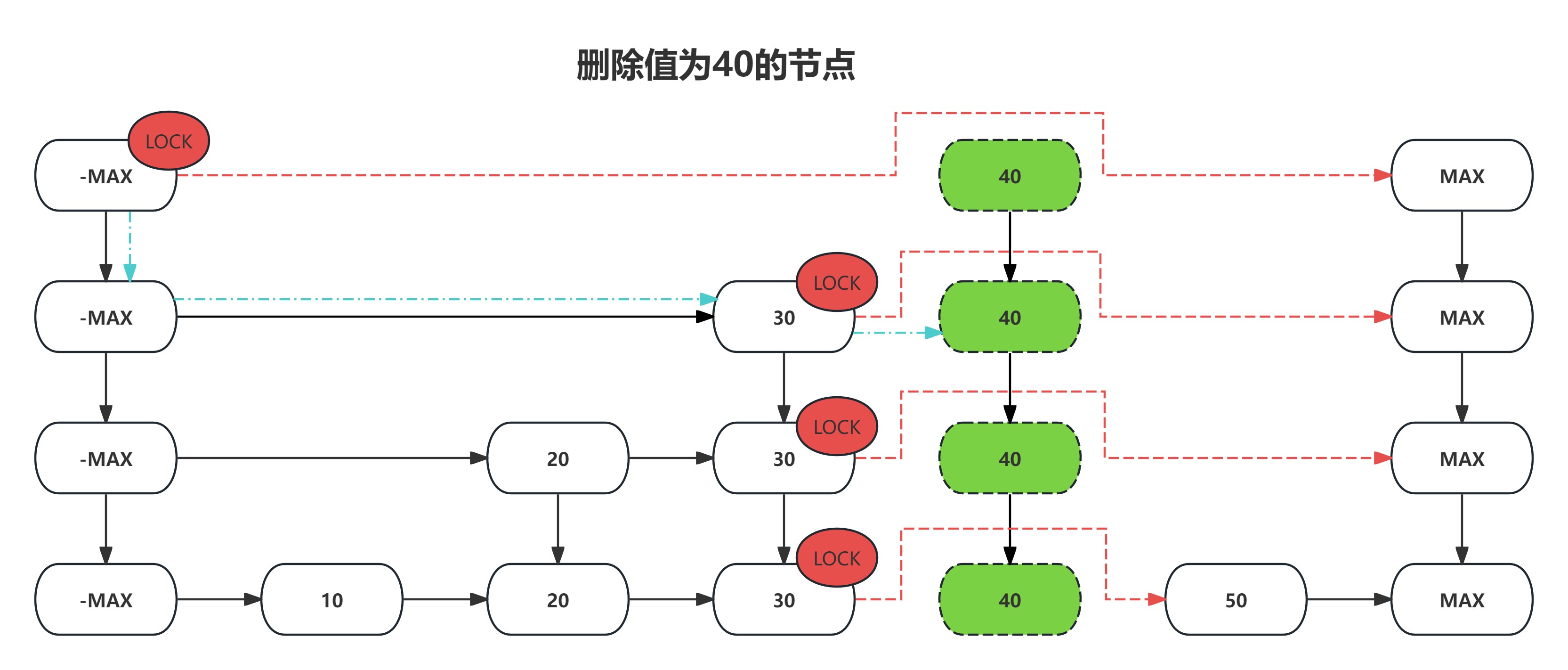

数据结构之LinkedList

系列文章目录 数据结构之ArrayList-CSDN博客 目录 系列文章目录 前言 一、模拟实现链表 1. 遍历链表 2. 插入节点 3. 删除节点 4. 清空链表 二、链表的常见操作 1. 反转链表 2. 返回链表的中间节点 3. 链表倒数第 k 个节点 4. 合并两个有序链表 5. 分割链表 6. 判…...

摆脱硬件依赖:SkyEye在轨道交通中的仿真应用

在城市轨道交通系统中,信号系统承担着确保列车安全、高效运行的关键任务。从排列进路、信号开放,到终点折返与接发车,几乎每一个调度动作背后都依赖于信号系统的精密控制与实时响应。作为信号系统的重要组成部分,目标控制器&#…...

使用变异系数增强 CFD 收敛标准

将描述性统计整合到 CFD 中,以评估可变性和收敛性。 挑战 在工程设计中,尤其是在进行仿真时,我们经常处理描述流体、温度、应力或浓度行为的大型数据集。以有意义的方式解释这些值需要的不仅仅是原始数字;它需要对统计的理解。 统计学在工程…...

解决获取视频第一帧黑屏问题

文章目录 解决获取视频第一帧黑屏问题核心代码 解决获取视频第一帧黑屏问题 废话不多说,直接上代码: <script setup> const status ref(请点击“添加视频”按钮添加视频) const videoElement ref(document.createElement(video)) const curren…...

物联网通信技术全景指南(2025)之如何挑选合适的物联网模块

物联网通信技术全景指南(2025)之 如何挑选合适的物联网模块 物联网通信技术全景指南(2025)一、技术代际演进与退网背景二、5G 物联网技术体系(Sub-6 GHz 核心)1. 技术分层架构2. 蜂窝技术性能矩阵3. Sub-6 …...

影楼精修-AI衣服祛褶皱算法解析

注:为避免侵权,本文所用图像均为AIGC生成或无版权网站提供; 衣服祛褶皱功能,目前在像素蛋糕、美图云修、百度网盘AI修图、阿里云都有相关的功能支持,它的价值就是将不平整的衣服图像,变得整齐平整…...

Day46 Python打卡训练营

知识点回顾: 1. 不同CNN层的特征图:不同通道的特征图 2. 什么是注意力:注意力家族,类似于动物园,都是不同的模块,好不好试了才知道。 3. 通道注意力:模型的定义和插入的位置 4. 通道注意力后…...

信号电压高,传输稳定性变强,但是传输速率下降?

信号电压高,传输稳定性变强,但是传输速率下降? 一、信号电压升高,传输稳定性变强 1.信号幅度更大,抗噪声能力增强 2.噪声,比如干扰电磁波,串扰等相对于信号幅度比例变小,误码率降低 …...

linux安全加固(非常详细)

安全加固方案原则 1.版本升级 对于系统和应用在使用过程中暴露的安全缺陷,系统或应用厂商会及时发布解决问题的升级补丁包。升级系统或应用版本,可有效解决旧版本存在的安全风险。2.关闭端口服务 在不影响业务系统正常运行情况下,停止或禁用承…...

关于事务的简介

一、引言 在数据处理与存储的领域中,事务(Transaction)是确保数据完整性和一致性的关键概念。无论是金融系统的资金转账、电商平台的订单处理,还是企业资源规划(ERP)系统的业务流程操作,事务都…...

qt控制台程序与qt窗口程序在读取数据库中文字段的差异!!巨坑

问题:最近在自己编写一个类,这个类需要对mysql数据库进行插入和查询。因为最后是以一个类文件的形式拿来单独使用,所以在创建项目的时候就创建了一个qt的控制台程序。但是在对数据库的内容进行查询时,出现了中文乱码。参考了之前的…...

动手学深度学习12.7. 参数服务器-笔记练习(PyTorch)

以下内容为结合李沐老师的课程和教材补充的学习笔记,以及对课后练习的一些思考,自留回顾,也供同学之人交流参考。 本节课程地址:35 分布式训练【动手学深度学习v2】_哔哩哔哩_bilibili 本节教材地址:12.7. 参数服务器…...

告别数据泥沼,拥抱智能中枢:King’s四位一体重塑科研生产力

在现代科研的战场上,数据堪称科研人员手中的“弹药”。然而,许多实验室却深陷数据管理的泥沼:硬盘里堆满了不同年份的实验记录,U盘里塞着各种格式的谱图,Excel表格里还留着手动计算的痕迹……,当科研人员想…...

智绅科技 —— 智慧养老 + 数字健康,构筑银发时代安全防护网

在老龄化率突破 21.3% 的当下,智绅科技以 "科技适老" 为核心理念,构建 "监测 - 预警 - 干预 - 照护" 的智慧养老闭环。 其自主研发的七彩喜智慧康养平台,通过物联网、AI 和边缘计算技术,实现对老年人健康与安…...

Code Composer Studio CCS 工程设置,如何设置h文件查找路径?

右键工程,选Properties,在Build>MSP430 Compiler>Optinizution Include Options 设置头文件的搜索路径。 比如我设置了这些: ${CCS_BASE_ROOT}/msp430/include ${PROJECT_ROOT} ${CG_TOOL_ROOT}/include "${workspace_loc:/${ProjName}/F5xx_F6xx_Core_Lib}&quo…...

Qt生成日志与以及捕获崩溃文件(mingw64位,winDbg)————附带详细解说

文章目录 Qt生成日志与以及报错文件(mingw64位,winDbg)0 背景与结果0.1 背景0.2 结果1 WinDbg1.1 安装1.2 使用 2 编写代码2.1 ccrashstack类2.2 编写输出捕获异常的dmp文件2.2 编写输出日志文件2.3 调用生成日志和dmp文件 参考 Qt生成日志与以及报错文件(mingw64位…...

web前端开发如何适配各分辨率

在开发Web应用时,适配不同的显示器分辨率是确保用户体验一致性的关键。以下是一些常见的显示器分辨率。 常见的显示器分辨率 PC屏幕分辨率 1366 x 768:普通液晶显示器 1920 x 1080:高清液晶显示器 2560 x 1440:2K高清显示器 4096…...

本机无法远程别的计算机的方法

在本地计算机上修改组策略 按下 Win R 组合键打开运行窗口,输入 gpedit.msc 并回车,打开组策略编辑器。依次展开路径:计算机配置 > 管理模板 > 系统 > 凭据分配。在右侧找到并双击 加密 Oracle 修正 策略。选择 已启用,…...

智能手表健康监测系统的PSRAM存储芯片CSS6404LS-LI—高带宽、耐高温、微尺寸的三重突破

一、直击智能手表三大核心痛点 痛点场景风险传统方案缺陷连续生物数据流存储100Hz PPG信号产生82MB/s数据洪峰SPI NOR Flash带宽不足(≤50MB/s)高温环境稳定性腕表表面温度达50℃(烈日/运动场景)商用级存储器件(85℃)易触发数据错误极限空间约束PCB面积…...

蓝桥杯国赛题2022

首先这个题应该是一个01背包,背包容量为2022,有2022个物品,第i个物品的体积为i,只不过这里有两个限制条件,一个限制条件是和为2022,另一个限制条件为10个数,两个限制条件那就把加一维࿰…...

)

Pycharm中添加不了新建的Conda环境(此篇专门给Daidai写的)

安装好了Conda之后,在系统终端也创建好Conda环境,一切显示正常,但在Pycharm中添加不了新建的Conda环境,显示“Conda executable is not found” 解决“Conda executable is not found” conda环境新建如下 D:/Programs/anacond…...

如何选择专业数据可视化开发工具?为您拆解捷码全功能和落地指南!

分享大纲: 1、捷码核心功能:4维能力支撑大屏开发 2、3步上手:可视化大屏开发操作路径 3、适配场景:8大行业已验证方案 在各行各业要求数字化转型时代,数据可视化大屏已成为众多企业数据驱动的核心工具。面对市场上繁杂…...

关于如何使用VScode编译下载keil工程的步骤演示

1、vscode的插件市场下载keil Assistant 2 、点设置 3、复制keil的地址 4、粘贴到第…...

微信小程序动态效果实战指南:从悬浮云朵到丝滑列表加载

小红书爆款交互设计解析,附完整代码! 🔥 一、为什么动态效果是小程序的关键竞争力? 用户留存提升:数据显示,86.3%的微商从业者依赖微信小程序,而动态效果能显著降低跳出率。技术赋能体验&#…...

Redis底层数据结构之深入理解跳表(2)

上一篇文章中我们详细讲述了跳表的增添、查找和修改的操作,这篇文章我们来讲解一下跳表在多线程并发时的安全问题。在Redis中,除了网络IO部分和大文件的后台复制涉及到多线程外,其余任务执行时全部都是单线程,这也就意味着在Redis…...

大模型编程助手-Cline

官网: https://cline.bot/ Cline 是一款深度集成在 Visual Studio Code(VSCode) 中的开源 AI 编程助手插件,旨在通过结合大语言模型(如 Claude 3.5 Sonnet、DeepSeek V3、Google Gemini 等)和工具链&#…...

[蓝桥杯]兰顿蚂蚁

兰顿蚂蚁 题目描述 兰顿蚂蚁,是于 1986 年,由克里斯兰顿提出来的,属于细胞自动机的一种。 平面上的正方形格子被填上黑色或白色。在其中一格正方形内有一只"蚂蚁"。 蚂蚁的头部朝向为:上下左右其中一方。 蚂蚁的移…...