部署K8S集群

目录

一、环境搭建

1、准备环境

2、安装master节点

3、安装k8s-master上的node

4、安装配置k8s-node1节点

5、安装k8s-node2节点

6、为所有node节点配置flannel网络

7、配置docker开启加载防火墙规则允许转发数据

二、k8s常用资源管理

1、创建一个pod

2、pod管理

一、环境搭建

1、准备环境

- 计算机说明,建议系统版本7.4或者7.6

| 主机名 | IP地址 | 角色 | 硬件 |

| k8s-master | 192.168.2.116 | Master,node | Etcd、apiserver、controlor-manager、scheduler、kube-proxy、docker、registry |

| K8s-node1 | 192.168.2.117 | Node | Kubletel、kube-proxy、docker |

| K8s-node2 | 192.168.2.118 | Node | Kubletel、kube-proxy、docker |

- 修改master主机的计算机名设置host文件

[root@centos01 ~]# hostnamectl set-hostname k8s-master[root@centos01 ~]# bash[root@k8s-master ~]# vim /etc/hosts192.168.2.116 k8s-master192.168.2.117 k8s-node1192.168.2.118 k8s-node2- 修改节点一主机名设置host文件

[root@centos02 ~]# hostnamectl set-hostname k8s-node1[root@centos02 ~]# bash[root@k8s-node1 ~]# scp 192.168.2.117:/etc/hosts /etc/4)修改节点二主机名字设置host文件

[root@centos03 ~]# hostnamectl set-hostname k8s-node2[root@centos03 ~]# bash[root@k8s-node2 ~]# scp 192.168.2.118:/etc/hosts /etc/2、安装master节点

1)安装etcd配置etcd

[root@k8s-master ~]# yum -y install etcd[root@k8s-master ~]# cp /etc/etcd/etcd.conf /etc/etcd/etcd.conf.bak[root@k8s-master ~]# vim /etc/etcd/etcd.conf6 ETCD_LISTEN_CLIENT_URLS=http://0.0.0.0:2379

21 ETCD_ADVERTISE_CLIENT_URLS=http://192.168.2.116:2379[root@k8s-master ~]# systemctl start etcd[root@k8s-master ~]# systemctl enable etcdCreated symlink from /etc/systemd/system/multi-user.target.wants/etcd.service to /usr/lib/systemd/system/etcd.service.2)安装k8s-master节点

[root@k8s-master ~]#yum install kubernetes-master.x86_64 -y3)配置apiserver

[root@k8s-master ~]# vim /etc/kubernetes/apiserver8 KUBE_API_ADDRESS="--insecure-bind-address=0.0.0.0" //修改监听IP地址

12 KUBE_API_PORT="--port=8080" //监听端口

16 KUBELET_PORT="--kubelet-port=10250" //kubelet监听端口

19 KUBE_ETCD_SERVERS="--etcd-servers=http://192.168.2.116:2379" //连接etcd

24 KUBE_ADMISSION_CONTROL="--admission-control=NamespaceLifecycle,NamespaceExists,LimitRanger,SecurityContextDeny,ResourceQuota"4)配置controller和scheduler

[root@k8s-master ~]# vim /etc/kubernetes/config22 KUBE_MASTER="--master=http://192.168.2.116:8080"5)启动k8s服务

[root@k8s-master ~]# systemctl start kube-apiserver.service[root@k8s-master ~]# systemctl start kube-controller-manager.service[root@k8s-master ~]# systemctl start kube-scheduler.service[root@k8s-master ~]# systemctl enable kube-apiserver.serviceCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-apiserver.service to /usr/lib/systemd/system/kube-apiserver.service.[root@k8s-master ~]# systemctl enable kube-controller-manager.serviceCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-controller-manager.service to /usr/lib/systemd/system/kube-controller-manager.service.[root@k8s-master ~]# systemctl enable kube-scheduler.serviceCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-scheduler.service to /usr/lib/systemd/system/kube-scheduler.service.

6)检查节点安装都是健康的

[root@k8s-master ~]# kubectl get componentstatus NAME STATUS MESSAGE ERROR

etcd-0 Healthy {"health":"true"}

controller-manager Healthy ok

scheduler Healthy ok

3、安装k8s-master上的node

1)安装node

[root@k8s-master ~]# yum install kubernetes node.x86_64

2)配置kubelet

[root@k8s-master ~]# vim /etc/kubernetes/kubelet

5 KUBELET_ADDRESS="--address=192.168.2.116" //监听IP地址

11 KUBELET_HOSTNAME="--hostname-override=k8s-master" //监听计算机名

14 KUBELET_API_SERVER="--api-servers=http://192.168.2.116:8080" //监听apiserver端口3)启动kubelet启动自动启动docker服务

[root@k8s-master ~]# systemctl start kubelet

[root@k8s-master ~]# systemctl enable kubeletCreated symlink from /etc/systemd/system/multi-user.target.wants/kubelet.service to /usr/lib/systemd/system/kubelet.service.

4)启动kubelet-proxy

[root@k8s-master ~]# systemctl start kube-proxy

[root@k8s-master ~]# systemctl enable kube-proxyCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-proxy.service to /usr/lib/systemd/system/kube-proxy.service.

5)检查node节点

[root@k8s-master ~]# kubectl get nodesNAME STATUS AGE

k8s-master Ready 51s

4、安装配置k8s-node1节点

1)安装node

[root@k8s-node1 ~]# yum install kubernetes-node.x86_642)node1连接k8s-master

[root@k8s-node1 ~]# vim /etc/kubernetes/config

22 KUBE_MASTER="--master=http://192.168.2.116:8080"3)配置kubelet

[root@k8s-node1 ~]# vim /etc/kubernetes/kubelet

5 KUBELET_ADDRESS="--address=192.168.2.117"

11 KUBELET_HOSTNAME="--hostname-override=k8s-node1"

15 KUBELET_API_SERVER="--api-servers=http://192.168.2.116:8080"4)启动服务

[root@k8s-node1 yum.repos.d]# systemctl start kubelet

[root@k8s-node1 yum.repos.d]# systemctl start kube-proxy

[root@k8s-node1 yum.repos.d]# systemctl enable kubeletCreated symlink from /etc/systemd/system/multi-user.target.wants/kubelet.service to /usr/lib/systemd/system/kubelet.service.[root@k8s-node1 yum.repos.d]# systemctl enable kube-proxyCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-proxy.service to /usr/lib/systemd/system/kube-proxy.service.

5)在master节点检测node节点状态

[root@k8s-master ~]# kubectl get nodesNAME STATUS AGE

k8s-master Ready 27m

k8s-node1 Ready 12m

5、安装k8s-node2节点

1)安装node

[root@k8s-node2 ~]# yum install kubernetes-node.x86_642)node2连接k8s-master

[root@k8s-node2 ~]# vim /etc/kubernetes/config

22 KUBE_MASTER="--master=http://192.168.2.116:8080"3)配置kubelet

[root@k8s-node2 ~]# vim /etc/kubernetes/kubelet

5 KUBELET_ADDRESS="--address=192.168.2.118"

11 KUBELET_HOSTNAME="--hostname-override=k8s-node1"

15 KUBELET_API_SERVER="--api-servers=http://192.168.2.116:8080"4)启动服务

[root@k8s-node2 yum.repos.d]# systemctl start kubelet

[root@k8s-node2 yum.repos.d]# systemctl start kube-proxy

[root@k8s-node2 yum.repos.d]# systemctl enable kube-proxyCreated symlink from /etc/systemd/system/multi-user.target.wants/kube-proxy.service to /usr/lib/systemd/system/kube-proxy.service.[root@k8s-node2 yum.repos.d]# systemctl enable kubeletCreated symlink from /etc/systemd/system/multi-user.target.wants/kubelet.service to

/usr/lib/systemd/system/kubelet.service.

5)在master节点检测node节点状态

[root@k8s-master ~]# kubectl get nodesNAME STATUS AGE

k8s-master Ready 31m

k8s-node1 Ready 16m

k8s-node2 Ready 33s

6、为所有node节点配置flannel网络

1)在k8s-master节点安装flannel

[root@k8s-master ~]# yum install flannel -y

[root@k8s-master ~]# vim /etc/sysconfig/flanneld

4 FLANNEL_ETCD_ENDPOINTS=http://192.168.200.112:2379[root@k8s-master ~]# etcdctl set /atomic.io/network/config '{ "Network": "172.16.0.0/16" }' //配置网络

{ "Network": "172.16.0.0/16" }[root@k8s-master ~]# systemctl start flanneld

[root@k8s-master ~]# systemctl enable flanneld

Created symlink from /etc/systemd/system/multi-user.target.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.

Created symlink from /etc/systemd/system/docker.service.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.[root@k8s-master ~]# ifconfigflannel0: flags=4305<UP,POINTOPOINT,RUNNING,NOARP,MULTICAST> mtu 1472inet 172.16.35.0 netmask 255.255.0.0 destination 172.16.35.0inet6 fe80::db5b:30ce:83c4:c67b prefixlen 64 scopeid 0x20<link>unspec 00-00-00-00-00-00-00-00-00-00-00-00-00-00-00-00 txqueuelen 500 (UNSPEC)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 3 bytes 144 (144.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0[root@k8s-master ~]# systemctl restart docker

[root@k8s-master ~]# systemctl enable docker

Created symlink from /etc/systemd/system/multi-user.target.wants/docker.service to /usr/lib/systemd/system/docker.service.[root@k8s-master ~]# ifconfig

docker0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500inet 172.16.35.1 netmask 255.255.255.0 broadcast 0.0.0.0ether 02:42:02:36:e4:15 txqueuelen 0 (Ethernet)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 0 bytes 0 (0.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 02)配置node1节点flannel网络

[root@k8s-node1 ~]# yum install flannel -y

[root@k8s-node1 ~]# vim /etc/sysconfig/flanneld4 FLANNEL_ETCD_ENDPOINTS=http://192.168.2.116:2379[root@k8s-node1 ~]# systemctl start flanneld

[root@k8s-node1 ~]# systemctl enable flanneldCreated symlink from /etc/systemd/system/multi-user.target.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.

Created symlink from /etc/systemd/system/docker.service.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.[root@k8s-node1 ~]# systemctl restart docker

[root@k8s-node1 ~]# systemctl enable dockerCreated symlink from /etc/systemd/system/multi-user.target.wants/docker.service to /usr/lib/systemd/system/docker.service.

3)安装node2节点flannel网络

[root@k8s-node2 ~]# yum install flannel -y[root@k8s-node2 ~]# vim /etc/sysconfig/flanneld4 FLANNEL_ETCD_ENDPOINTS=http://192.168.2.116:2379[root@k8s-node2 ~]# systemctl start flanneld

[root@k8s-node2 ~]# systemctl enable flanneldCreated symlink from /etc/systemd/system/multi-user.target.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.

Created symlink from /etc/systemd/system/docker.service.wants/flanneld.service to /usr/lib/systemd/system/flanneld.service.[root@k8s-node2 ~]# systemctl restart docker

[root@k8s-node2 ~]# systemctl enable dockerCreated symlink from /etc/systemd/system/multi-user.target.wants/docker.service to /usr/lib/systemd/system/docker.service.[root@k8s-master ~]# kubectl get nodesNAME STATUS AGE

k8s-master Ready 47m

k8s-node1 Ready 32m

k8s-node2 Ready 16m

4)测试docker容器跨宿主机通信

[root@k8s-master ~]# docker run -it busybox //下载镜像

Unable to find image 'busybox:latest' locally

Trying to pull repository docker.io/library/busybox ...

latest: Pulling from docker.io/library/busybox

3f4d90098f5b: Pull complete

Digest: sha256:3fbc632167424a6d997e74f52b878d7cc478225cffac6bc977eedfe51c7f4e79

Status: Downloaded newer image for docker.io/busybox:latest

/ #

/ # ping 172.16.71.1 //测试和其他docker宿主机之间通信

PING 172.16.71.1 (172.16.71.1): 56 data bytes

64 bytes from 172.16.71.1: seq=0 ttl=61 time=1.730 ms

64 bytes from 172.16.71.1: seq=1 ttl=61 time=0.443 ms

64 bytes from 172.16.71.1: seq=2 ttl=61 time=0.867 ms

^C

--- 172.16.71.1 ping statistics ---

3 packets transmitted, 3 packets received, 0% packet loss

round-trip min/avg/max = 0.443/1.013/1.730 ms

/ # ping 172.16.10.1 //测试和其他docker宿主机之间通信

PING 172.16.10.1 (172.16.10.1): 56 data bytes

64 bytes from 172.16.10.1: seq=0 ttl=61 time=1.424 ms

64 bytes from 172.16.10.1: seq=1 ttl=61 time=0.485 ms

^C

--- 172.16.10.1 ping statistics ---

2 packets transmitted, 2 packets received, 0% packet loss

round-trip min/avg/max = 0.485/0.954/1.424 ms

7、配置docker开启加载防火墙规则允许转发数据

1)配置k8s-master节点

[root@k8s-master ~]# vim /usr/lib/systemd/system/docker.service

18 ExecStartPort=/usr/sbin/iptables -P FORWARD ACCEPT #添加[root@k8s-master ~]# systemctl daemon-reload

[root@k8s-master ~]# systemctl restart docker2)配置k8s-node1节点

[root@k8s-node1 ~]# vim /usr/lib/systemd/system/docker.service18 ExecStartPort=/usr/sbin/iptables -P FORWARD ACCEPT #添加[root@k8s-node1 ~]# systemctl daemon-reload

[root@k8s-node1 ~]# systemctl restart docker3)配置k8s-node2节点

[root@k8s-node2 ~]# vim /usr/lib/systemd/system/docker.service18 ExecStartPort=/usr/sbin/iptables -P FORWARD ACCEPT #添加[root@k8s-node2 ~]# systemctl daemon-reload

[root@k8s-node2 ~]# systemctl restart docker二、k8s常用资源管理

1、创建一个pod

1)创建yuml文件

[root@k8s-master ~]# mkdir k8s

[root@k8s-master ~]# vim ./k8s/nginx.yaml

apiVersion: v1

kind: Pod

metadata:name: nginxlabels:app: web

spec:containers:- name: nginximage: nginx:1.13ports:- containerPort: 802)创建容器

方法一. yum安装[root@k8s-master ~]#yum install *rhsm*方法二 (我是用这方法解决的)执行命令:[root@k8s-master ~]#wget http://mirror.centos.org/centos/7/os/x86_64/Packages/python-rhsm-certificates-1.19.10-1.el7_4.x86_64.rpm[root@k8s-master ~]#rpm2cpio python-rhsm-certificates-1.19.10-1.el7_4.x86_64.rpm | cpio -iv --to-stdout ./etc/rhsm/ca/redhat-uep.pem | tee /etc/rhsm/ca/redhat-uep.pem

前两个命令会生成/etc/rhsm/ca/redhat-uep.pem文件. [root@k8s-master ~]#docker pull registry.access.redhat.com/rhel7/pod-infrastructure:latest

[root@k8s-master ~]# kubectl create -f ./k8s/nginx.yaml3)查看所有pod创建运行状态

[root@k8s-master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

nginx 0/1 ContainerCreating 0 5m

4)查看指定pod资源

[root@k8s-master ~]# kubectl get pod nginx

NAME READY STATUS RESTARTS AGE

nginx 0/1 ContainerCreating 0 6m

5)查看pod运行的详细信息

[root@k8s-master ~]# kubectl describe pod nginx

Name: nginx

Namespace: default

Node: k8s-node2/192.168.2.118

Start Time: Fri, 11 Aug 2023 15:34:10 +0800

Labels: app=web

Status: Pending

IP:

Controllers: <none>

Containers:nginx:Container ID: Image: nginx:1.13Image ID: Port: 80/TCPState: WaitingReason: ContainerCreatingReady: FalseRestart Count: 0Volume Mounts: <none>Environment Variables: <none>

Conditions:Type StatusInitialized True Ready False PodScheduled True

No volumes.

QoS Class: BestEffort

Tolerations: <none>

Events:FirstSeen LastSeen Count From SubObjectPath Type Reason Message--------- -------- ----- ---- ------------- -------- ------ -------7m 7m 1 {default-scheduler } NormalScheduled Successfully assigned nginx to k8s-node27m 1m 6 {kubelet k8s-node2} WarninFailedSync Error syncing pod, skipping: failed to "StartContainer" for "POD" with ErrImagePull: "image pull failed for registry.access.redhat.com/rhel7/pod-infrastructure:latest, this may be because there are no credentials on this request. details: (open /etc/docker/certs.d/registry.access.redhat.com/redhat-ca.crt: no such file or directory)"6m 9s 25 {kubelet k8s-node2} Warning FailedSync Error syncing pod, skipping: failed to "StartContainer" for "POD" with ImagePullBackOff: "Back-off pulling image \"registry.access.redhat.com/rhel7/pod-infrastructure:latest\""6)验证运行的pod

[root@k8s-master ~]# kubectl get pod nginx -o wide

NAME READY STATUS RESTARTS AGE IP NODE

nginx 0/1 ContainerCreating 0 8m <none> k8s-node2

2、pod管理

1)删除pod

[root@k8s-master ~]# kubectl delete pod nginx

pod "nginx" deleted

2)查看删除pod无法找到

[root@k8s-master ~]# kubectl get pod nginx -o wide

Error from server (NotFound): pods "nginx" not found

3)创建pod

[root@k8s-master ~]# kubectl create -f ./k8s/nginx.yaml

pod "nginx" created

4)发现最先创建的pod运行在k8s-master节点上,下载镜像速度太慢没法运行

[root@k8s-master ~]# kubectl get pod nginx -o wide

NAME READY STATUS RESTARTS AGE IP NODE

nginx 0/1 ContainerCreating 0 8s <none> k8s-node1

相关文章:

部署K8S集群

目录 一、环境搭建 1、准备环境 2、安装master节点 3、安装k8s-master上的node 4、安装配置k8s-node1节点 5、安装k8s-node2节点 6、为所有node节点配置flannel网络 7、配置docker开启加载防火墙规则允许转发数据 二、k8s常用资源管理 1、创建一个pod 2、pod管理 一、…...

在时间和频率域中准确地测量太阳黑子活动及使用信号处理工具箱(TM)生成广泛的波形,如正弦波、方波等研究(Matlab代码实现)

💥💥💞💞欢迎来到本博客❤️❤️💥💥 🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。 ⛳️座右铭&a…...

一百五十四、Kettle——Linux上安装Kettle9.3(踩坑,亲测有效,附截图)

一、目的 由于kettle8.2在Linux上安装后,共享资源库创建遇到一系列问题,所以就换成kettle9.3 二、kettle版本以及安装包网盘链接 kettle9.3.0安装包网盘链接 链接:https://pan.baidu.com/s/1MS8QBhv9ukpqlVQKEMMHQA?pwddqm0 提取码&…...

PackageNotFoundError: No package metadata was found for bitsandbytes解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…...

uni-app和springboot完成前端后端对称加密解密流程

概述 使用对称加密的方式实现。前端基于crypto-js。uni-app框架中是在uni.request的基础上,在拦截器中处理的。springboot在Filter中完成解密工作。 uni-app 项目中引入crypto-js。 npm install crypto-js加密方法 const SECRET_KEY CryptoJS.enc.Utf8.parse(…...

【Unity造轮子】制作一个简单的2d抓勾效果(类似蜘蛛侠的技能)

前言 欢迎阅读本文,本文将向您介绍如何使用Unity游戏引擎来实现一个简单而有趣的2D抓勾效果,类似于蜘蛛侠的独特能力。抓勾效果是许多动作游戏和平台游戏中的常见元素,给玩家带来了无限的想象和挑战。 不需要担心,即使您是一…...

)

Unity 人物连招(三段连击)

一: 连招思路 首先人物角色上有三个攻击实例对象 Damage,每一个damage定义了攻击的伤害值,攻击距离,触发器名称,伤害的发起者,攻击持续时间,攻击重置时间,伤害的碰撞框大小等字段: …...

关于WSL以及docker连接adb的坑

结论 WSL可以连接到adb,需要和主机保持一致的adb型号。主机是windows还是macOS的docker没法直接连接到adb设备,只有主机为Linux才可以。其他平台只能通过TCP网络协议。 具体过程 关于WSL连接adb设备 windows安装adb工具(安装可以去官网下…...

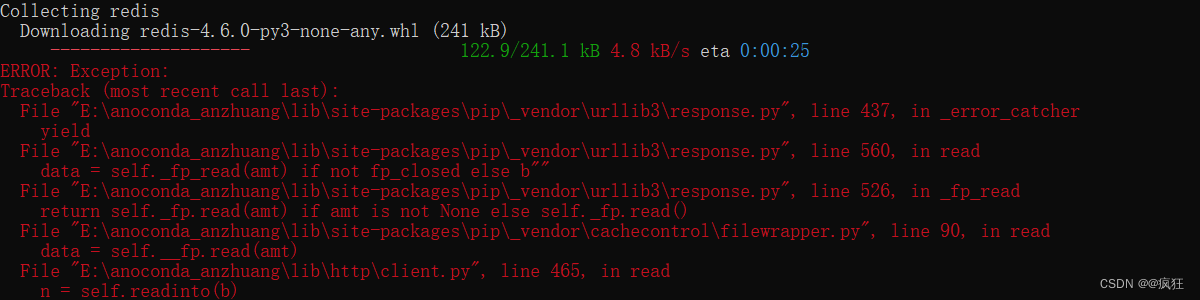

python安装第三方包时报错:...\lib\site-packages\pip\_vendor\urllib3\response.py...

安装redis第三方包: pip install redis报错现象: 解决方法:使用以下命令可成功安装 pip install redis -i http://pypi.douban.com/simple --trusted-host pypi.douban.com...

腾讯云从业者认证考试考点——云存储产品

文章目录 存储产品功能云存储产品概述存储产品存储网关存储服务 存储分类按存储方式分按存储频率分 云存储与传统存储的区别功能需求性能需求容量扩展数据共享 云硬盘CBS产品概述归档存储和文件存储归档存储CAS文件存储CFS 对象存储存储网关存储网关的分类 云数据迁移CDM日志服…...

猿辅导Motiff与IXDC达成战略合作,将在UI设计领域推动AI革新更多可能性

近日,“IXDC 2023国际体验设计大会”在北京国家会议中心拉开序幕,3000设计师、1000企业、200全球商业领袖,共襄为期5天的用户体验创新盛会。据了解,此次大会是以“设计领导力”为主题,分享全球设计、科技、商业的前沿趋…...

条件操作符(三目操作符)

比如之前我们想写一个条件判断表达式是这样写的: 用操作符就可以这样写: 应用,比如求两个数的最大值...

Unity开发Vision Pro——FAQ)

(五)Unity开发Vision Pro——FAQ

常见问题 (FAQ) 1.问:我看到在visionOS 模拟器中运行的结果与在硬件上运行的结果不同 请注意,在模拟器中运行时,某些特定于硬件的功能不可用 - 最明显的是 AR 数据。这可能意味着 VisionOS 模拟器中的模拟结果可能与 Vision Pro 耳机上的模…...

GitOps 与 DevOps:了解关键差异,为企业做出最佳选择

在软件开发领域,GitOps 和 DevOps 是加强协作和实现软件交付流程自动化的重要技术。虽然这两种模式都旨在提高软件开发生命周期的效率,但它们的核心原则和实施方式却各不相同。 本篇文章将帮助您了解 GitOps 和 DevOps 之间的差异、它们的工作流程&am…...

Java实现Word文档转PDF,PDF转Word,PDF转Excel,PDF转换工具

前言 java实现word文档转PDF,PDF转word 解决只能转换4页问题 解决每页头部存在水印问题 实现 引入依赖 <dependency><groupId>com.documents4j</groupId><artifactId>documents4j-local</artifactId><version>1.0.3</ve…...

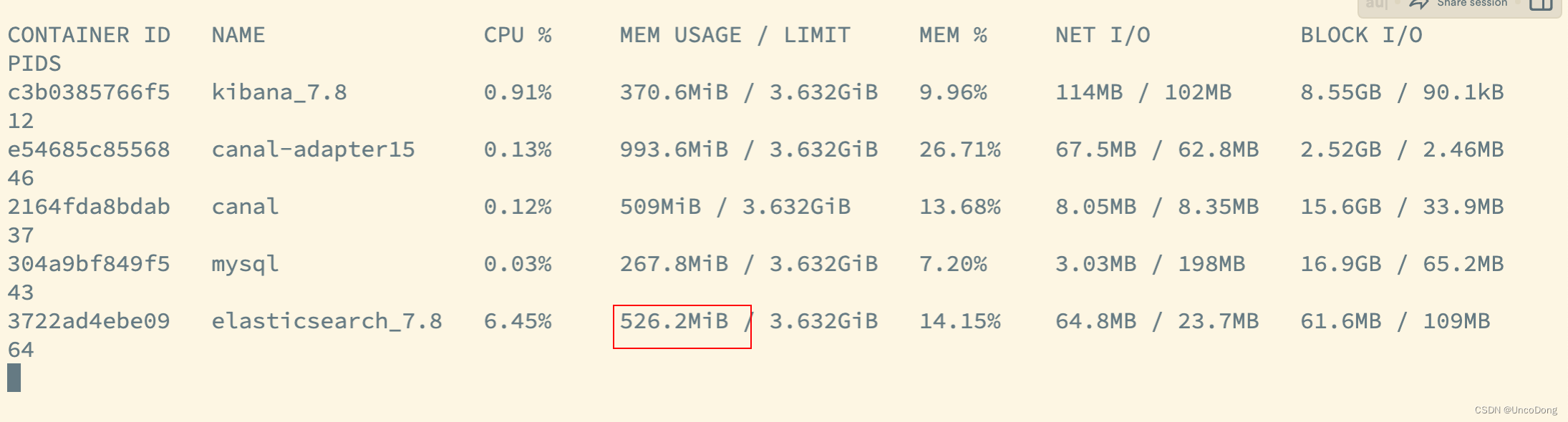

Docker部署ES服务,全量同步的时候内存爆炸,ES自动关闭,CPU100%

问题 使用canal-adapter全量同步(参考Canal Adapter1.1.5版本API操作服务,手动同步数据(4))的时候 小批量数据可以正常运行(几千条)只要数据量一大(上万条),…...

Python——添加照片边框

原图: 添加边框后: 添加边框会读取照片的exif信息如时间、相机型号、品牌以及快门焦段等信息,将他们显示在下面的边框中。 获取当前py文件路径 import os #get path that py file located def Get_Currentpath():file_path os.path.abspa…...

《高性能MySQL》——查询性能优化(笔记)

文章目录 六、查询性能优化6.1 查询为什么会慢6.2 慢查询基础:优化数据访问6.2.1 是否向数据库请求了不需要的数据查询不需要的记录多表关联时返回全部列总是取出全部列重复查询相同的数据 6.2.2 MySQL 是否在扫描额外的记录响应时间扫描的行数与返回的行数扫描的行…...

【Linux操作系统】编译过程中遇到的问题-为什么加-c?执行文件提示无法执行二进制文件?main函数参数argc和*argv[]的作用和理解?

在使用GCC编译器进行程序开发时,我们经常会遇到一些编译过程中的问题, 比如为什么要加上"-c"选项,以及为什么生成的可执行文件无法执行等问题。 本篇博客将详细介绍这些问题,并给出相应的代码和解释,帮助读者…...

【数据结构与算法——TypeScript】图结构(Graph)

【数据结构与算法——TypeScript】 图结构(Graph) 认识图结构以及特性 什么是图? 在计算机程序设计中,图结构 也是一种非常常见的数据结构。 但是,图论其实是一个非常大的话题 认识一下关于图的一些内容 图的抽象数据类型一些算法实现。 什么是图?…...

)

uniapp 对接腾讯云IM群组成员管理(增删改查)

UniApp 实战:腾讯云IM群组成员管理(增删改查) 一、前言 在社交类App开发中,群组成员管理是核心功能之一。本文将基于UniApp框架,结合腾讯云IM SDK,详细讲解如何实现群组成员的增删改查全流程。 权限校验…...

:にする)

日语学习-日语知识点小记-构建基础-JLPT-N4阶段(33):にする

日语学习-日语知识点小记-构建基础-JLPT-N4阶段(33):にする 1、前言(1)情况说明(2)工程师的信仰2、知识点(1) にする1,接续:名词+にする2,接续:疑问词+にする3,(A)は(B)にする。(2)復習:(1)复习句子(2)ために & ように(3)そう(4)にする3、…...

【2025年】解决Burpsuite抓不到https包的问题

环境:windows11 burpsuite:2025.5 在抓取https网站时,burpsuite抓取不到https数据包,只显示: 解决该问题只需如下三个步骤: 1、浏览器中访问 http://burp 2、下载 CA certificate 证书 3、在设置--隐私与安全--…...

相机从app启动流程

一、流程框架图 二、具体流程分析 1、得到cameralist和对应的静态信息 目录如下: 重点代码分析: 启动相机前,先要通过getCameraIdList获取camera的个数以及id,然后可以通过getCameraCharacteristics获取对应id camera的capabilities(静态信息)进行一些openCamera前的…...

全面解析各类VPN技术:GRE、IPsec、L2TP、SSL与MPLS VPN对比

目录 引言 VPN技术概述 GRE VPN 3.1 GRE封装结构 3.2 GRE的应用场景 GRE over IPsec 4.1 GRE over IPsec封装结构 4.2 为什么使用GRE over IPsec? IPsec VPN 5.1 IPsec传输模式(Transport Mode) 5.2 IPsec隧道模式(Tunne…...

A2A JS SDK 完整教程:快速入门指南

目录 什么是 A2A JS SDK?A2A JS 安装与设置A2A JS 核心概念创建你的第一个 A2A JS 代理A2A JS 服务端开发A2A JS 客户端使用A2A JS 高级特性A2A JS 最佳实践A2A JS 故障排除 什么是 A2A JS SDK? A2A JS SDK 是一个专为 JavaScript/TypeScript 开发者设计的强大库ÿ…...

免费PDF转图片工具

免费PDF转图片工具 一款简单易用的PDF转图片工具,可以将PDF文件快速转换为高质量PNG图片。无需安装复杂的软件,也不需要在线上传文件,保护您的隐私。 工具截图 主要特点 🚀 快速转换:本地转换,无需等待上…...

)

C#学习第29天:表达式树(Expression Trees)

目录 什么是表达式树? 核心概念 1.表达式树的构建 2. 表达式树与Lambda表达式 3.解析和访问表达式树 4.动态条件查询 表达式树的优势 1.动态构建查询 2.LINQ 提供程序支持: 3.性能优化 4.元数据处理 5.代码转换和重写 适用场景 代码复杂性…...

逻辑回归暴力训练预测金融欺诈

简述 「使用逻辑回归暴力预测金融欺诈,并不断增加特征维度持续测试」的做法,体现了一种逐步建模与迭代验证的实验思路,在金融欺诈检测中非常有价值,本文作为一篇回顾性记录了早年间公司给某行做反欺诈预测用到的技术和思路。百度…...

从面试角度回答Android中ContentProvider启动原理

Android中ContentProvider原理的面试角度解析,分为已启动和未启动两种场景: 一、ContentProvider已启动的情况 1. 核心流程 触发条件:当其他组件(如Activity、Service)通过ContentR…...