NLP:从头开始的文本矢量化方法

一、说明

NLP 项目使用文本,但机器学习算法不能使用文本,除非将其转换为数字表示。这种表示通常称为向量,它可以应用于文本的任何合理单位:单个标记、n-gram、句子、段落,甚至整个文档。

在整个语料库的统计 NLP 中,应用了不同的向量化技术,例如 one-hot、计数或频率编码。在神经 NLP 中,词向量(也称为词嵌入)占主导地位。可以使用预先训练的向量以及复杂神经网络中学习的向量表示。

本文解释并展示了所有提到的向量化技术的 Python 实现:one-hot 编码、计数器编码(词袋)、词频以及最后的词向量。

本文的技术背景是和几个Python v3.11附加库:gensim v4.3.1、pandas v2.0.1、numpy v1.26.1和nltk v3.8.1。scikit-learn v1.2.2所有示例也应该适用于较新的库版本。

本文最初出现在我的博客admantium.com上。

二、要求和使用的 Python 库

请务必阅读并运行我上一篇文章的要求,以便拥有 Jupyter Notebook 来运行所有代码示例。

对于本文,需要以下库:

Collections

Counter用于计算文档中标记数量的对象

Gensim

- 该

downloader对象允许加载多个预先训练的词向量

Pandas

DataFrame用于存储文本、标记和向量的对象

Numpy

- 创建和使用的几种方法

arrays

NLTK

PlaintextCorpusReader用于提供对文档的访问、提供标记化方法并计算有关所有文件的统计信息的可遍历对象sent_tokenizer并word_tokenizer用于生成令牌stopwords代币减持清单

SciKitLearn

Pipeline对象来实现处理步骤链BaseEstimator并TransformerMixin构建代表管道步骤的自定义类

所有示例都需要这些导入和基类:

import numpy as np

import re

from copy import deepcopy

from collections import Counter

from gensim import downloader

from nltk.corpus import stopwords

from nltk.corpus.reader.plaintext import PlaintextCorpusReader

from nltk.tokenize import sent_tokenize, word_tokenize

from sklearn.base import BaseEstimator, TransformerMixin

from time import timeclass SciKitTransformer(BaseEstimator, TransformerMixin):def fit(self, X=None, y=None):return selfdef transform(self, X=None):return self三、基本示例

根据之前的文章,NLTK PlaintextCorpusReader 将被重用。

这是该类的更新版本,WikipediaCorpus带有一个附加filter()方法 - 它将词汇表减少为仅文本,没有任何停用词。

class WikipediaCorpus(PlaintextCorpusReader):def __init__(self, root_path):PlaintextCorpusReader.__init__(self, root_path, r'.*[0-9].txt')def filter(self, word):#only keep letters, numbers, and sentence delimiterword = re.sub('[\(\)\.,;:+\--"]', '', word)#remove multiple whitespaceword = re.sub(r'\s+', '', word)if not word in stopwords.words("english"):return word.lower()return ''def vocab(self):return sorted(set([self.filter(word) for word in corpus.words()]))def max_words(self):max = 0for doc in self.fileids():l = len(self.words(doc))max = l if l > max else maxreturn maxdef describe(self, fileids=None, categories=None):started = time()return {'files': len(self.fileids()),'paras': len(self.paras()),'sents': len(self.sents()),'words': len(self.words()),'vocab': len(self.vocab()),'max_words': self.max_words(),'time': time()-started}为了使本文中的示例向量简短易懂,该语料库由维基百科有关机器学习的文章的前三个句子组成。

_Source: [Wikipedia](https://en.wikipedia.org/wiki/Artificial_intelligence)_Artificial intelligence (AI) is intelligence-perceiving, synthesizing, and inferring information-demonstrated by machines, as opposed to intelligence displayed by humans or by other animals.

Example tasks in which this is done include speech recognition, computer vision, translation between (natural) languages, as well as other mappings of inputs.

As machines become increasingly capable, tasks considered to require "intelligence" are often removed from the definition of AI, a phenomenon known as the AI effect. For instance, optical character recognition is frequently excluded from things considered to be AI, having become a routine technology.使用语料库类来解析这些句子,得到以下统计数据: 词汇量为 49 个单词,总单词数为 113 个。它的大小足以让下面的解释保持简短。

corpus = WikipediaCorpus('ai_sentences')print(corpus.fileids())

# ['sent1.txt', 'sent2.txt', 'sent3.txt']print(corpus.describe())

# {'files': 3, 'paras': 3, 'sents': 3, 'words': 91, 'vocab': 40, 'max_words': 32, 'time': 0.01642608642578125}print(corpus.vocab())

# ['', 'ai', 'animals', 'artificial', 'as', 'become', 'capable', 'computer', 'considered', ..., 'well']四、一次性编码

one-hot 编码基于所有文档的总词汇量来表示单词在特定文档中出现的关系。因此,实施需要以下步骤:

- 计算所有文档的总有序词汇表

- 迭代每个文档并标记出现的单词

以下实现构建一个vocab_dict填充有默认浮点值的对象0.0,然后将这些值设置1.0为出现在句子中的每个标记。

class OneHotEncoder(SciKitTransformer):def __init__(self, vocab):self.vocab_dict = dict.fromkeys(vocab, 0.0)def one_hot_vector(self, tokens):vec_dict = deepcopy(self.vocab_dict)for token in tokens:if token in self.vocab_dict:vec_dict[token] = 1.0vec = [v for v in vec_dict.values()]return np.array(vec)以下是前两个句子的 one-hot 向量:

encoder = OneHotEncoder(corpus.vocab())sent1 = [word for word in word_tokenize(corpus.raw('sent1.txt'))]

vec1 = encoder.one_hot_vector(sent1)print(vec1)

# [0. 0. 1. 0. 1. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 1. 0. 0. 1. 0. 0. 1. 0. 0.

# 1. 0. 0. 0. 1. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 0.]print(vec1.shape)

# (40,)sent2 = [word for word in word_tokenize(corpus.raw('sent2.txt'))]

vec2 = encoder.one_hot_vector(sent2)print(vec2)

# [0. 0. 0. 0. 1. 0. 0. 1. 0. 0. 0. 0. 1. 0. 0. 0. 1. 0. 0. 0. 1. 0. 0. 1.

# 0. 1. 1. 0. 0. 0. 0. 1. 0. 0. 1. 0. 1. 1. 1. 1.]print(vec2.shape)

# (40,)五、计数器编码

计数器编码是创建向量的中间形式。基于所有文档的完整有序词汇表,确定文档中所有单词的数量和出现次数。该数字通常按比例缩放,例如按文档的长度。

这是 Python 中的计数器编码实现。和以前一样,它构建一个vocab_dict填充有默认浮点值 的对象0.0,并为每个文档设置一个值number(word)/len(document)。

from collections import Counterclass CountEncoder(SciKitTransformer):def __init__(self, vocab):self.vocab = dict.fromkeys(vocab, 0.0)def count_vector(self, tokens):vec_dict = deepcopy(self.vocab)token_vec = Counter(tokens)doc_length = len(tokens)for token, count in token_vec.items():if token in self.vocab:vec_dict[token] = count/doc_lengthvec = [v for v in vec_dict.values()]return np.array(vec)使用计数器编码会产生以下结果:

encoder = CountEncoder(corpus.vocab())sent1 = [word for word in word_tokenize(corpus.raw('sent1.txt'))]

vec1 = encoder.count_vector(sent1)print(vec1)

# [0. 0. 0.03571429 0. 0.03571429 0.

# 0. 0. 0. 0. 0. 0.03571429

# 0. 0. 0. 0.03571429 0. 0.

# 0.03571429 0. 0. 0.07142857 0. 0.

# 0.03571429 0. 0. 0. 0.03571429 0.

# 0. 0. 0. 0. 0. 0.03571429

# 0. 0. 0. 0. ]print(vec1.shape)

# (40,)

sent2 = [word for word in word_tokenize(corpus.raw('sent2.txt'))]

vec2 = encoder.count_vector(sent2)print(vec2)

# [0. 0. 0. 0. 0.06896552 0.

# 0. 0.03448276 0. 0. 0. 0.

# 0.03448276 0. 0. 0. 0.03448276 0.

# 0. 0. 0.03448276 0. 0. 0.03448276

# 0. 0.03448276 0.03448276 0. 0. 0.

# 0. 0.03448276 0. 0. 0.03448276 0.

# 0.03448276 0.03448276 0.03448276 0.03448276]print(vec2.shape)

# (40,)六、词频编码

前两种编码导致的问题是,当与机器学习算法一起使用时,非常罕见的术语没有足够的权重来发挥重要作用。特别是为了解决这个问题,术语频率、术语间接频率指标平衡了大型文档语料库中的罕见术语。详细的数学可以在TfIdf 维基百科文章中研究- 以下是基本摘要:

- TF,术语频率,是术语在文档中出现的次数除以文档的总长度,以伪代码表示

word_occurences_in_doc/doc_len - IDF,间接文档频率,是包含某个单词的文档数除以语料库中文档总数的对数,以伪代码表示

log(number_of_docs/number_of_docs_containing_word)

实现非常复杂,根据以下考虑因素构建:

- 编码器以列表形式接收语料库词汇,并接收以下形式的字典对象

{document_name: [tokens]}(否则此实现将与语料库对象耦合得太紧) - 在初始化过程中,会创建一个

word_frequency字典,其中包含某个术语在所有文档中出现的频率总数 - TfIdf 方法确定文档总数为

number_of_docs,文档长度为doc_len。Counter然后,它为文档中的所有单词创建一个 TfIdf值,然后为词汇表中包含的每个单词计算 TfIdf 值 - 所有值都转换为 Numpy 数组并返回

这是实现:

class TfIdfEncoder(SciKitTransformer):def __init__(self, doc_arr, vocab):self.doc_arr = doc_arrself.vocab = vocabself.word_frequency = self._word_frequency()def _word_frequency(self):word_frequency = dict.fromkeys(self.vocab, 0.0)for doc_name in self.doc_arr:doc_words = Counter([word for word in self.doc_arr[doc_name]])for word, _ in doc_words.items():if word in self.vocab:word_frequency[word] += 1.0return word_frequencydef TfIdf_vector(self, doc_name):if not doc_name in self.doc_arr:print(f'Document "{doc_name}" not found.')returnnumber_of_docs = len(self.doc_arr)doc_len = len(self.doc_arr[doc_name])doc_words = Counter([word for word in self.doc_arr[doc_name]])TfIdf_vec = dict.fromkeys(self.vocab, 0.0)for word, word_count in doc_words.items():if word in self.vocab:tf = word_count/doc_lenidf = np.log(number_of_docs/self.word_frequency[word])idf = 1 if idf == 0 else idfTfIdf_vec[word] = tf * idfvec = [v for v in TfIdf_vec.values()]return np.array(vec)对于我们只有三个句子的示例,向量足以表示文档,但它们的全部潜力只有在大型校园中才能实现。

doc_list = [doc for doc in corpus.fileids()]

words_list = [corpus.words(doc) for doc in [doc for doc in corpus.fileids()]]

doc_arr = dict(zip(doc_list, words_list))encoder = TfIdfEncoder(doc_arr, corpus.vocab())

vec1 = encoder.TfIdf_vector('sent1.txt')print(vec1)

# [0. 0. 0.03433163 0. 0.03125 0.

# 0. 0. 0. 0. 0.03433163 0.03433163

# 0. 0. 0. 0.03433163 0. 0.

# 0.03433163 0.03433163 0. 0.03801235 0. 0.

# 0.01267078 0. 0. 0. 0.03433163 0.03433163

# 0. 0. 0. 0. 0. 0.03433163

# 0. 0. 0. 0. ]print(vec1.shape)

# (40,)

vec2 = encoder.TfIdf_vector('sent2.txt')print(vec2)

# [0. 0. 0. 0. 0.06896552 0.

# 0. 0.03788318 0. 0. 0. 0.

# 0.03788318 0. 0. 0. 0.03788318 0.

# 0. 0. 0.03788318 0. 0. 0.03788318

# 0. 0.03788318 0.03788318 0. 0. 0.

# 0. 0.03788318 0. 0. 0.03788318 0.

# 0.01398156 0.03788318 0.03788318 0.03788318]print(vec2.shape)

# (40,)七、词向量

最终的编码类型是词向量。本质上,每个单词都用一个 n 维向量表示。该向量表示单词之间的细粒度关系,并且它使向量算术能够进行向量的比较和组合,例如满足 的向量代数king + women = queen。

词向量为大规模自然语言处理任务提供了巨大且令人惊讶的价值。三个主要的词向量实现是原始的 Word2Vec、FastText 和 Glove。

Word2Vec是第一个模型,根据新闻文章进行训练,并使用不同的 n-gram 大小来捕获周围上下文中单词的含义。FastText使用类似的连续 n 元语法方法,但它不仅考虑训练数据中单词的实际上下文,还考虑其他上下文。这改善了稀疏单词的表示并处理训练期间不存在的未知单词。Glove考虑整个语料库,根据训练数据计算词与词的共现矩阵,并构建一个关于采样数据中任何词出现的可能性的概率模型。

词向量表示训练数据中出现的结构。如果该数据足够大并且接近语料库的文本,则可以使用预训练的向量。否则,他们需要在校园内接受培训。

在下面的实现中,Gensim库将用于加载预训练的Word2Vec向量并将其应用到语料库中。要使用预训练模型之一,您需要使用 Gensim 助手下载其模型。请注意,模型可能非常大。例如,word2vec-google-news-300模型为 1.6GB,为每个单词提供 300 维向量。

>>> wv = downloader.load('word2vec-google-news-300')

# [=======-------------------------------------------] 15.5% 258.5/1662.8MB downloaded矢量化器实现使用与其他结构相同的已知结构。它的实现非常简单:它将处理文档标记列表并输出一个向量,其中包含存在向量表示的每个单词的数值。

class Word2VecEncoder(SciKitTransformer):def __init__(self, vocab):self.vocab = vocabself.vector_lookup = downloader.load('word2vec-google-news-300')def word_vector(self, tokens):vec = np.array([])for token in tokens:if token in self.vocab:if token in self.vector_lookup:print(f'Add {token}')vec = np.append(self.vector_lookup[token], vec)return vec这是一个示例输出。

encoder = Word2VecEncoder(corpus.vocab())sent1 = [word for word in word_tokenize(corpus.raw('sent1.txt'))]

vec1 = encoder.word_vector(sent1)print(vec1)

# [ 0.01989746 0.24707031 -0.23632812 ... -0.24707031 0.05249023

# 0.19824219]print(vec1.shape)

# (3000,)sent2 = [word for word in word_tokenize(corpus.raw('sent2.txt'))]

vec2 = encoder.word_vector(sent2)print(vec2)

# [-0.11767578 -0.13769531 -0.140625 ... -0.03295898 -0.01733398

# 0.13476562]print(vec2.shape)

# (4500,)正如您所看到的,两个句子的向量分别为 3000 和 4500 个值。结果是特定于文档的矩阵,其中每列代表按原样出现的文档标记,列数是列中包含的单词数。

八、结论

本文展示了如何从头开始实现文本矢量化方法。它展示了 one-hot 编码、计数器编码、TfIdf 频率编码以及 Word2Vec 词向量的实现。它还展示了将所得向量应用于维基百科有关人工智能的文章中的句子时的具体示例。

参考资料:

NLP: Text Vectorization Methods from Scratch | by Sebastian | Oct, 2023 | Medium

相关文章:

NLP:从头开始的文本矢量化方法

一、说明 NLP 项目使用文本,但机器学习算法不能使用文本,除非将其转换为数字表示。这种表示通常称为向量,它可以应用于文本的任何合理单位:单个标记、n-gram、句子、段落,甚至整个文档。 在整个语料库的统计 NLP 中&am…...

Kotlin 中 apply、let、also、run的区别

apply apply 函数接收一个目标并回来该目标自身。它答应您在目标上履行一些操作,同时仍然回来原始目标。 fun <T> T.apply(block: T.() -> Unit): TT 是目标的类型,block 是一个 lambda 表达式,能够在该目标上履行一些操作。在这个…...

Android JKS MD5 SHA1 公钥生成 私钥生成 APP备案 内容获取

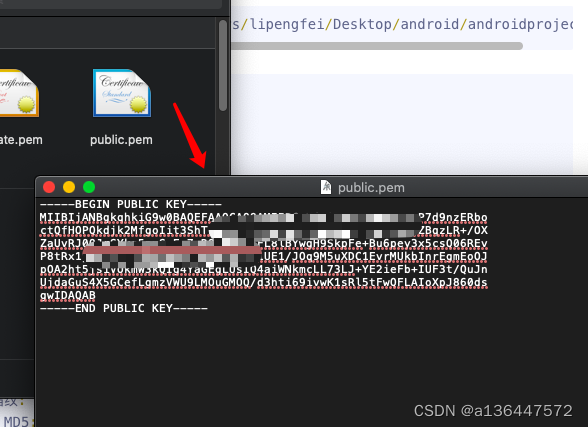

1 查看 jks keytool -list -v -keystore /Users/lipengfei/Desktop/android/androidproject.jks密钥库类型: jks 密钥库提供方: SUN您的密钥库包含 1 个条目别名: ddgj 创建日期: 2018-11-16 条目类型: PrivateKeyEntry 证书链长度: 1 证书[1]: 所有者: CNcn, OUcn, Ocn, Lcn,…...

)

常用linux的命令(持续更新)

1.防火墙相关 centos7 防火墙 查状态:systemctl status firewalld.service 关闭:systemctl disable firewalld.service 重启生效 关闭:systemctl stop firewalld.service 马上生效 systemctl stop firewalld 临时关闭防火墙 systemctl disabl…...

《动手学深度学习 Pytorch版》 8.7 通过时间反向传播

8.7.1 循环神经网络的梯度分析 本节主要探讨梯度相关问题,因此对模型及其表达式进行了简化,进行如下表示: h t f ( x t , h t − 1 , w h ) o t g ( h t , w o ) \begin{align} h_t&f(x_t,h_{t-1},w_h)\\ o_t&g(h_t,w_o) \end{ali…...

2023-10-20 游戏开发-cocos旧版本2.0.6-下载地址-记录

官方下载地址: Cocos Creator 下载 - 轻量高效的开发引擎 Tags cocos/cocos-engine GitHub cocos creater 旧版本: Tool/Package/REAMDE.md adofsauron/CocosCreatorFAQ - Gitee.com v2.0.6版本: Mac版:http://cocos2d-x.org/filedown/CocosStudioForMac-v2.0.…...

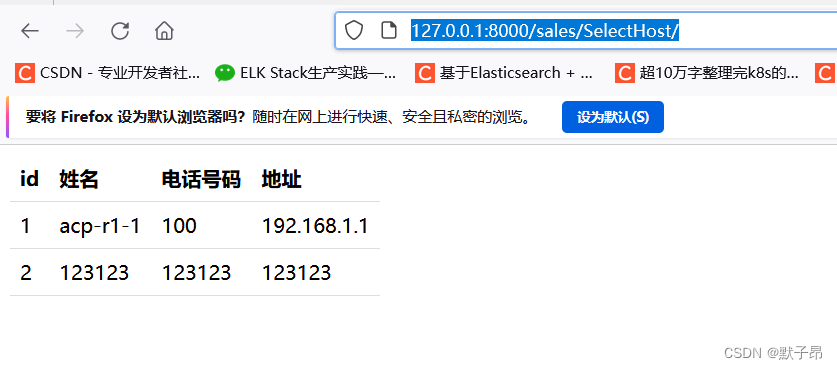

Python 框架学习 Django篇 (三) 链接数据库

只要你是做后端开发的,那么就离不开各种数据库,Django框架对各种数据库都非常友好,比如常见的PostgreSQL、MySQL、SQLite、Oracle,django都对他们提供了统一调用api,我们这里主要使用mysql数据库作为演示 一、ORM机制 …...

【debug】安装diffusion的bug解决合集

环境问题 ImportError: cannot import name ‘CLIPImageProcessor’ from ‘transformers’ (D:\Python\lib\site-packages\transformers_init_.py) https://github.com/huggingface/transformers/issues/23340 解决:查看更详细信息,安装环境 transfor…...

面试题 01.02. 判定是否互为字符重排

题目来源: leetcode题目,网址:面试题 01.02. 判定是否互为字符重排 - 力扣(LeetCode) 解题思路: 遍历计数即可。 解题代码: class Solution { public:bool CheckPermutation(string s1, …...

笔记39:在Pycharm中为项目添加新解释器

很久不用pycharm都生疏了 a a a 第一步:创建虚拟环境 略 a a a 第二步:将虚拟环境应用到项目中去 【File】----【Settings】----【Project:~~~】-----【Project Interpreter】----【选择合适的解释器】 因为我们要用新的解释…...

C#—VB.NET的相同点与不同点

目录 前言 一、相同之处 二、不同之处 三、总结 前言 VB.NET 和C#是两种由微软公司开发的面向对象编程语言。它们在语法上有很多相似之处,但也有一些不同之处。本文将讨论 VB.NET 和C#之间的相同之处和不同之处。 一、相同之处 1.面向对象编程语言:…...

【Edabit 算法 ★☆☆☆☆☆】【返回数组第一个元素】 Return the First Element in an Array

【Edabit 算法 ★☆☆☆☆☆】【返回数组第一个元素】 Return the First Element in an Array arrays language_fundamentals Instructions Create a function that takes an array containing only numbers and return the first element. Examples getFirstValue([1, 2, 3…...

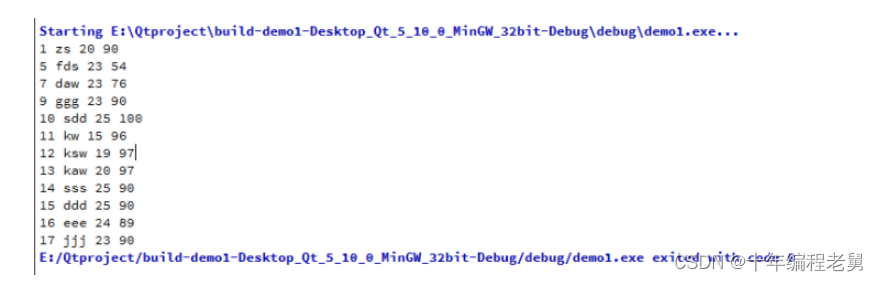

在Qt中怎么操作MySQL数据库

一、安装驱动 (1)安装 在Qt中操作MySQL数据库首先要安装mysql的驱动文件,将MySQL下的libmusql.dll文件复制到Qt的安装路径下的bin文件夹下即可。 本文福利,莬费领取Qt开发学习资料包、技术视频,内容包括(…...

)

C/C++网络编程基础知识超详细讲解上部分(系统性学习day11)

目录 前言 一、网络的含义与构成 含义: 构成: 二、网络的体系结构 1>OSI七层模型 2>TCP/IP协议体系结构 3>数据经过体系结构,怎么封装? 4>端口号 5>大小端序 6>TCP/UDP传输层的协议 三、系统函数API学习框…...

chrome Driver 使用教程

ChromeDriver是一款实用的chrome浏览器驱动工具,能够用于自动化测试、网络爬虫和操作浏览器,其主要作用是模拟浏览器操作。 ## 下载地址 [Chrome for Testing availability](Chrome for Testing availability)...

目标检测YOLO实战应用案例100讲-面向恶劣环境下的多模态 行人识别

目录 前言 国内外研究现状 可见光行人目标识别 红外行人目标识别...

react-router-dom v6版本实现Tabs路由缓存切换

目录 文章目录 概要 效果 完整代码 概要 摆了半年摊,好久没写代码了,今天有人问我怎么实现React-Router-dom类似标签页缓存。后面看了一下router的官网。很久以前用的是react-router v5那个比较容易实现。v6变化挺大,但了解react的机制和rea…...

ArcGIS笔记9_数据源缺少空间参考信息?如何定义坐标系?

本文目录 前言Step 1 确定好要赋予给目标文件的恰当坐标系Step 2 定义坐标系 前言 有时从其他软件转换得到了shp文件,拖到ArcGIS后却出现“未知的空间参考:添加的数据源缺少空间参考信息 不能投影”的提示,如下图所示: 这种情况就…...

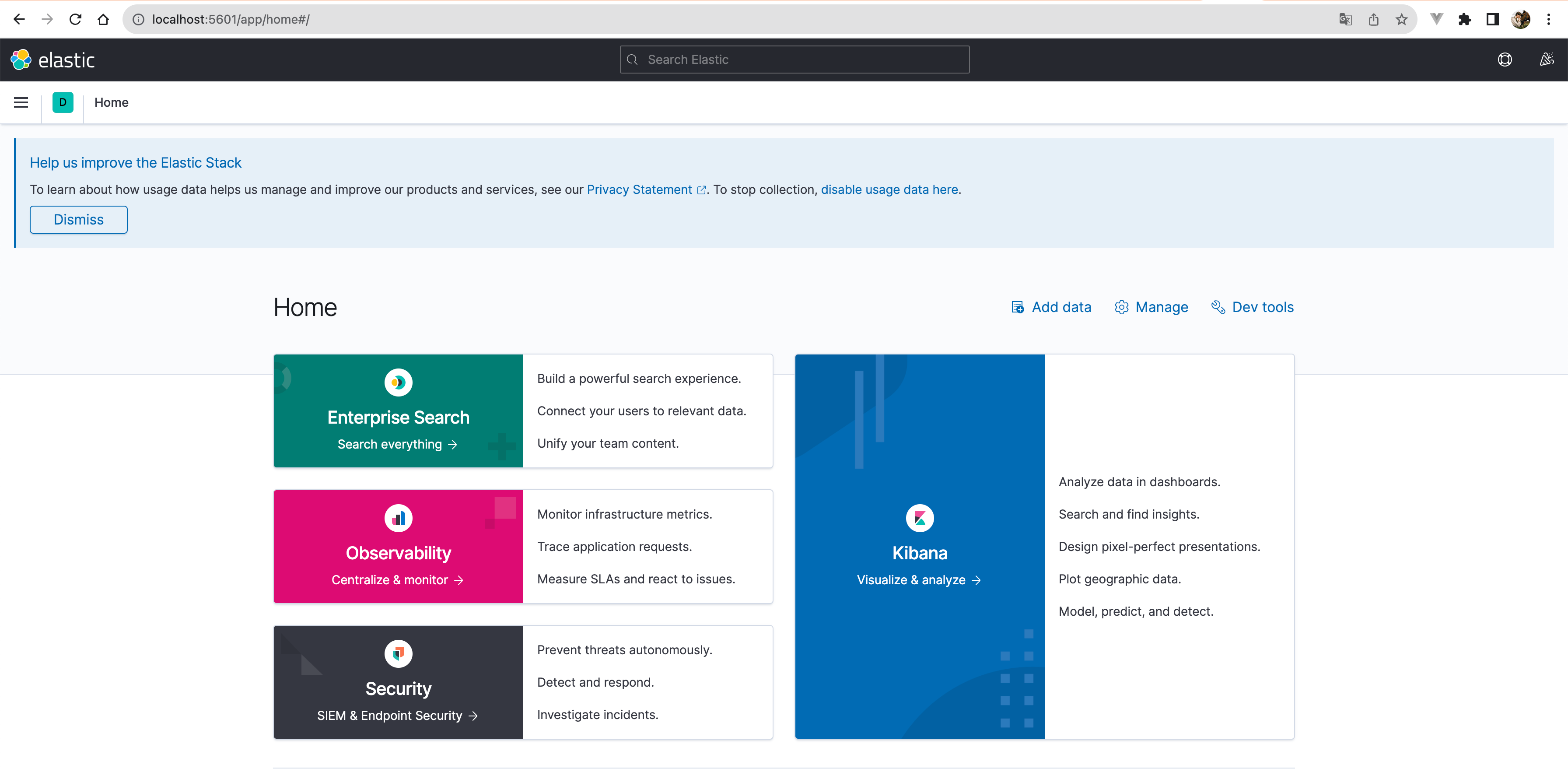

Elasticsearch实践:ELK+Kafka+Beats对日志收集平台的实现

可以在短时间内搜索和分析大量数据。 Elasticsearch 不仅仅是一个全文搜索引擎,它还提供了分布式的多用户能力,实时的分析,以及对复杂搜索语句的处理能力,使其在众多场景下,如企业搜索,日志和事件数据分析等…...

离线语音与IoT结合:智能家居发展新增长点

离线语音控制和物联网(IoT)相结合在家居中具有广泛的应用和许多优势。离线语音控制是指在设备在本地进行语音识别和处理,而不需要依赖云服务器进行处理。IoT是指借助网络,通过手机APP、小程序远程控制家居设备。 启英泰伦基于AI语…...

智慧医疗能源事业线深度画像分析(上)

引言 医疗行业作为现代社会的关键基础设施,其能源消耗与环境影响正日益受到关注。随着全球"双碳"目标的推进和可持续发展理念的深入,智慧医疗能源事业线应运而生,致力于通过创新技术与管理方案,重构医疗领域的能源使用模式。这一事业线融合了能源管理、可持续发…...

连锁超市冷库节能解决方案:如何实现超市降本增效

在连锁超市冷库运营中,高能耗、设备损耗快、人工管理低效等问题长期困扰企业。御控冷库节能解决方案通过智能控制化霜、按需化霜、实时监控、故障诊断、自动预警、远程控制开关六大核心技术,实现年省电费15%-60%,且不改动原有装备、安装快捷、…...

【项目实战】通过多模态+LangGraph实现PPT生成助手

PPT自动生成系统 基于LangGraph的PPT自动生成系统,可以将Markdown文档自动转换为PPT演示文稿。 功能特点 Markdown解析:自动解析Markdown文档结构PPT模板分析:分析PPT模板的布局和风格智能布局决策:匹配内容与合适的PPT布局自动…...

Frozen-Flask :将 Flask 应用“冻结”为静态文件

Frozen-Flask 是一个用于将 Flask 应用“冻结”为静态文件的 Python 扩展。它的核心用途是:将一个 Flask Web 应用生成成纯静态 HTML 文件,从而可以部署到静态网站托管服务上,如 GitHub Pages、Netlify 或任何支持静态文件的网站服务器。 &am…...

:爬虫完整流程)

Python爬虫(二):爬虫完整流程

爬虫完整流程详解(7大核心步骤实战技巧) 一、爬虫完整工作流程 以下是爬虫开发的完整流程,我将结合具体技术点和实战经验展开说明: 1. 目标分析与前期准备 网站技术分析: 使用浏览器开发者工具(F12&…...

UR 协作机器人「三剑客」:精密轻量担当(UR7e)、全能协作主力(UR12e)、重型任务专家(UR15)

UR协作机器人正以其卓越性能在现代制造业自动化中扮演重要角色。UR7e、UR12e和UR15通过创新技术和精准设计满足了不同行业的多样化需求。其中,UR15以其速度、精度及人工智能准备能力成为自动化领域的重要突破。UR7e和UR12e则在负载规格和市场定位上不断优化…...

自用)

css3笔记 (1) 自用

outline: none 用于移除元素获得焦点时默认的轮廓线 broder:0 用于移除边框 font-size:0 用于设置字体不显示 list-style: none 消除<li> 标签默认样式 margin: xx auto 版心居中 width:100% 通栏 vertical-align 作用于行内元素 / 表格单元格ÿ…...

MySQL用户和授权

开放MySQL白名单 可以通过iptables-save命令确认对应客户端ip是否可以访问MySQL服务: test: # iptables-save | grep 3306 -A mp_srv_whitelist -s 172.16.14.102/32 -p tcp -m tcp --dport 3306 -j ACCEPT -A mp_srv_whitelist -s 172.16.4.16/32 -p tcp -m tcp -…...

基于matlab策略迭代和值迭代法的动态规划

经典的基于策略迭代和值迭代法的动态规划matlab代码,实现机器人的最优运输 Dynamic-Programming-master/Environment.pdf , 104724 Dynamic-Programming-master/README.md , 506 Dynamic-Programming-master/generalizedPolicyIteration.m , 1970 Dynamic-Programm…...

Hive 存储格式深度解析:从 TextFile 到 ORC,如何选对数据存储方案?

在大数据处理领域,Hive 作为 Hadoop 生态中重要的数据仓库工具,其存储格式的选择直接影响数据存储成本、查询效率和计算资源消耗。面对 TextFile、SequenceFile、Parquet、RCFile、ORC 等多种存储格式,很多开发者常常陷入选择困境。本文将从底…...