【Python大数据笔记_day06_Hive】

hive内外表操作

建表语法

create [external] table [if not exists] 表名(字段名 字段类型 , 字段名 字段类型 , ... )

[partitioned by (分区字段名 分区字段类型)] # 分区表固定格式

[clustered by (分桶字段名) into 桶个数 buckets] # 分桶表固定格式 注意: 可以排序[sorted by (排序字段名 asc|desc)]

[row format delimited fields terminated by '字段分隔符'] # 自定义字段分隔符固定格式

[stored as textfile] # 默认即可

[location 'hdfs://域名:8020/user/hive/warehouse/库名.db/表名'] # 默认即可

; # 注意: 最后一定加分号结尾注意: 关键字顺序是从上到下从左到右,否则报错

default默认库存储路径: /user/hive/warehouse

自定义库在HDFS的默认存储路径: /user/hive/warehouse/库名.db

自定义表在HDFS的默认存储路径: /user/hive/warehouse/库名.db/表名

业务数据文件在HDFS的默认存储路径: /user/hive/warehouse/库名.db/表名/数据文件

数据类型

基本数据类型: 整数: int 小数: float double 字符串: string varchar(长度) 日期: date timestamp

复杂数据类型: 集合: array 映射: map 结构体: struct 联合体: union

表分类

Hive中可以创建的表有好几种类型, 分别是:

内部表:又叫管理表或者托管表

分区表(分区分桶表)

分桶表

外部表:又叫非管理表或者非托管表

分区表(分区分桶表)

分桶表

内部表和外部表区别?

内部表: 未被external关键字修饰的即是内部表, 即普通表。 内部表又称管理表,还可以叫托管表

删除内部表:直接删除元数据(metadata)和存储数据本身

外部表: 被external关键字修饰的即是外部表, 即关联表。 还可以叫非管理表或非托管表

删除外部表:仅仅是删除元数据(metadata),不会删除存储数据本身

查看表格式化信息: desc formatted 表名;

-- 内部表类型: MANAGED_TABLE

-- 外部表类型: EXTERNAL_TABLE

-- 内部表(又叫管理表或者托管表)

create table stu1(id int,name string

);

-- 外部表(又叫非管理表,非托管表)

create external table stu2(id int,name string

);

-- 查看表结构

desc stu1;

desc stu2;

-- 查看表格式化信息

desc formatted stu1; -- 内部表类型: managed_table

desc formatted stu2; -- 外部表类型: external_table-- 演示内外部表的重点区别

-- 删除内部表(管理表/托管表),会删除表相关的所有数据

insert into stu1 values(1,'张三');

drop table stu1;

-- 删除外部表,只删除了元数据,hdfs中业务数据保留

insert into stu2 values(1,'张三');

drop table stu2;

-- 再次建表后,可以使用location重新关联原来hdfs保留的业务数据

create external table stu22(id int,name string

)location '/user/hive/warehouse/hive1.db/stu2';

-- 验证数据

select * from stu22 limit 10;内部表基本操作

创建内部表: create table [if not exists] 内部表名(字段名 字段类型 , 字段名 字段类型 , ... )[row format delimited fields terminated by '字段分隔符'] ;

复制内部表: 方式1: like方式复制表结构 方式2: as 方式复制表结构和数据

删除内部表: drop table 内部表名;

注意: 删除内部表效果是mysql中表相关元数据被删除,同时存储在hdfs中的业务数据本身也被删除查看表格式化信息: desc formatted 表名; -- 内部表类型: MANAGED_TABLE

注意: 还可以使用truncate清空内部表数据 格式: truncate table 内部表名;

-- 操作表的前提:先有库并使用它

create database hive2;

use hive2;

-- 一.内部表的创建和删除

-- 1.演示创建内部表

-- 建表方式1

create table inner_stu1(id int,name string

);

-- 插入数据

insert into inner_stu1 values(1,'张三');-- 建表方式2: 复制表结构

create table inner_stu2 like inner_stu1;

-- 插入数据

insert into inner_stu2 values(1,'张三');-- 建表方式3: 复制表结构和数据

create table inner_stu3 as

select * from inner_stu1;-- 2.演示查看内部表结构详细信息

-- 内部表类型: MANAGED_TABLE

desc formatted inner_stu1;

desc formatted inner_stu2;

desc formatted inner_stu3;-- 3.演示内部表的删除

-- 删除内部表

drop table inner_stu3;-- 元数据和业务数据均被删除

-- 清空内部数据

truncate table inner_stu2;

-- 注意: delete和update不能使用

delete from inner_stu1;-- 报错

update inner_stu1 set name = '李四'; -- 报错外部表基本操作

创建外部表: create external table [if not exists] 外部表名(字段名 字段类型 , 字段名 字段类型 , ... )[row format delimited fields terminated by '字段分隔符'] ;

复制表: 方式1: like方式复制表结构 注意: as方式不可以使用

删除外部表: drop table 外部表名;

注意: 删除外部表效果是mysql中元数据被删除,但是存储在hdfs中的业务数据本身被保留

查看表格式化信息: desc formatted 表名; -- 外部表类型: EXTERNAL_TABLE注意: 外部表不能使用truncate清空数据本身

-- 二.外部表的创建和删除

-- 1.外部的表创建

-- 建表方式1

create external table outer_stu1(id int,name string

);

-- 插入数据

insert into outer_stu1 values(1,'张三');-- 建表方式2

create external table outer_stu2 like outer_stu1;

-- 插入数据

insert into outer_stu2 values(1,'张三');-- 注意: 外部表不能使用create ... as 方式复制表

create external table outer_stu3 asselect * from outer_stu1; -- 报错-- 2.演示查看外部表结构详细信息

-- 外部表类型: EXTERNAL_TABLE

desc formatted outer_stu1;

desc formatted outer_stu2;-- 3.演示外部表的删除

-- 删除表

drop table outer_stu2;

-- 注意: 外部表不能使用truncate关键字清空数据

truncate table outer_stu1; -- 报错

-- 注意: delete和update不能使用

delete from outer_stu1; -- 报错

update outer_stu1 set name = '李四'; -- 报错查看/修改表

查看所有表: show tables;

查看建表语句: show create table 表名;

查看表信息: desc 表名;

查看表结构信息: desc 表名;

查看表格式化信息: desc formatted 表名; 注意: formatted能够展示详细信息修改表名: alter table 旧表名 rename to 新表名

字段的添加: alter table 表名 add columns (字段名 字段类型);

字段的替换: alter table 表名 replace columns (字段名 字段类型 , ...);

字段名和字段类型同时修改: alter table 表名 change 旧字段名 新字段名 新字段类型;

注意: 字符串类型不能直接改数值类型

修改表路径: alter table 表名 set location 'hdfs中存储路径'; 注意: 建议使用默认路径

location: 建表的时候不写有默认路径/user/hive/warehouse/库名.db/表名,当然建表的时候也可以直接指定路径修改表属性: alter table 表名 set tblproperties ('属性名'='属性值'); 注意: 经常用于内外部表切换

内外部表类型切换: 外部表属性: 'EXTERNAL'='TRUE' 内部表属性: 'EXTERNAL'='FALSE'

-- 三.表的查看/修改操作

-- 验证之前的内外部表是否存在以及是否有数据,如果没有自己创建,如果有直接使用

select * from inner_stu1 limit 1;

select * from outer_stu1 limit 1;

-- 1.表的查看操作

-- 查看所有的表

show tables;

-- 查看建表语句

show create table inner_stu1;

show create table outer_stu1;

-- 查看表基本机构

desc inner_stu1;

desc outer_stu1;

-- 查看表格式化详细信息

desc formatted inner_stu1;

desc formatted outer_stu1;-- 2.表的修改操作

-- 修改表名

-- 注意: 外部表只会修改元数据表名,hdfs中表目录名不会改变

alter table inner_stu1 rename to inner_stu;

alter table outer_stu1 rename to outer_stu;

-- 修改表中字段

-- 添加字段

alter table inner_stu add columns(age int);

alter table outer_stu add columns(age int);

-- 替换字段

alter table inner_stu replace columns(id int,name string);

alter table outer_stu replace columns(id int,name string);

-- 修改字段

alter table inner_stu change name sname varchar(100);

alter table outer_stu change name sname varchar(100);-- 修改表路径(实际不建议修改)

-- 注意: 修改完路径后,如果该路径不存在,不会立刻创建,以后插入数据的时候自动生成目录

alter table inner_stu set location '/inner_stu';

alter table outer_stu set location '/outer_stu';-- 修改表属性

-- 先查看类型

desc formatted inner_stu; -- MANAGED_TABLE

desc formatted outer_stu; -- EXTERNAL_TABLE

-- 内部表改为外部表

alter table inner_stu set tblproperties ('EXTERNAL'='TRUE');

-- 外部表改为内部表

alter table outer_stu set tblproperties ('EXTERNAL'='FALSE');

-- 最后再查看类型

desc formatted inner_stu; -- EXTERNAL_TABLE

desc formatted outer_stu; -- MANAGED_TABLE默认分隔符

创建表的时候,如果不指定分隔符,以后表只能识别默认的分隔符,键盘不好打印,展示形式一般为:\0001,SOH,^A,□

-- 默认分隔符: 创建表的时候不指定就代表使用默认分隔符

-- 1.创建表

create table stu(id int,name string

);

-- insert方式插入数据,会自动使用默认分隔符把数据连接起来

-- 2.插入数据

insert into stu values(1,'zhangsan');

-- 3.验证数据

select * from stu limit 1;

-- 当然也可以通过在hdfs中查看,默认分隔符是\0001,其他工具中也会展示为SOH,^A,□快速映射表

创建表的时候指定分隔符: create [external] table 表名(字段名 字段类型)row format delimited fields terminated by 符号;

加载数据: load data [local] inpath '结构化数据文件' into table 表名;

-- 创建表

create table products(id int,name string,price double,cid string

)row format delimited

fields terminated by ',';

-- 加载数据

-- 注意: 如果从hdfs中加载文件,本质就是移动文件到对应表路径下

load data inpath '/source/products.txt' into table products;

-- 验证数据

select * from products limit 1;数据导入和导出

文件数据加载导入

1.直接上传文件

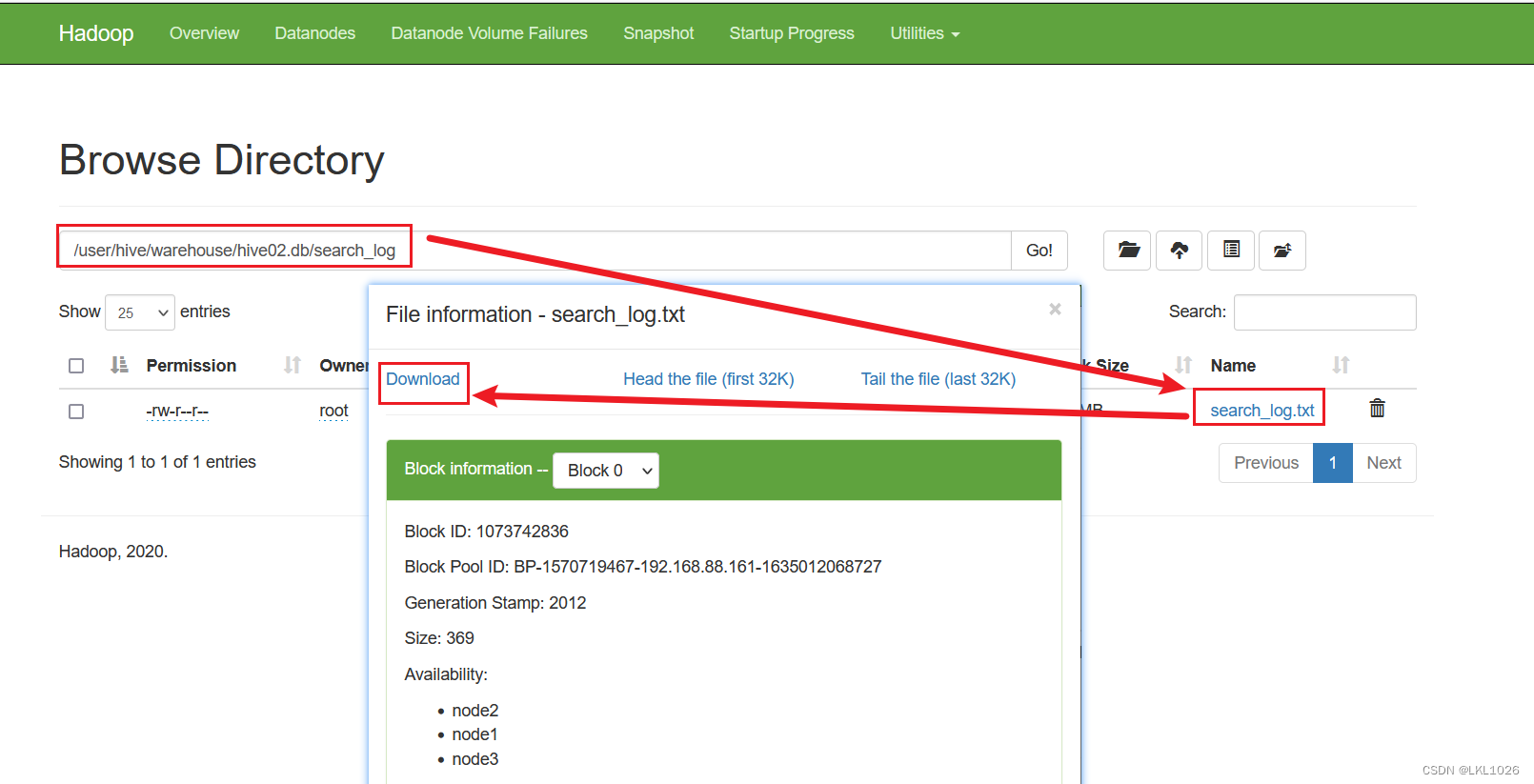

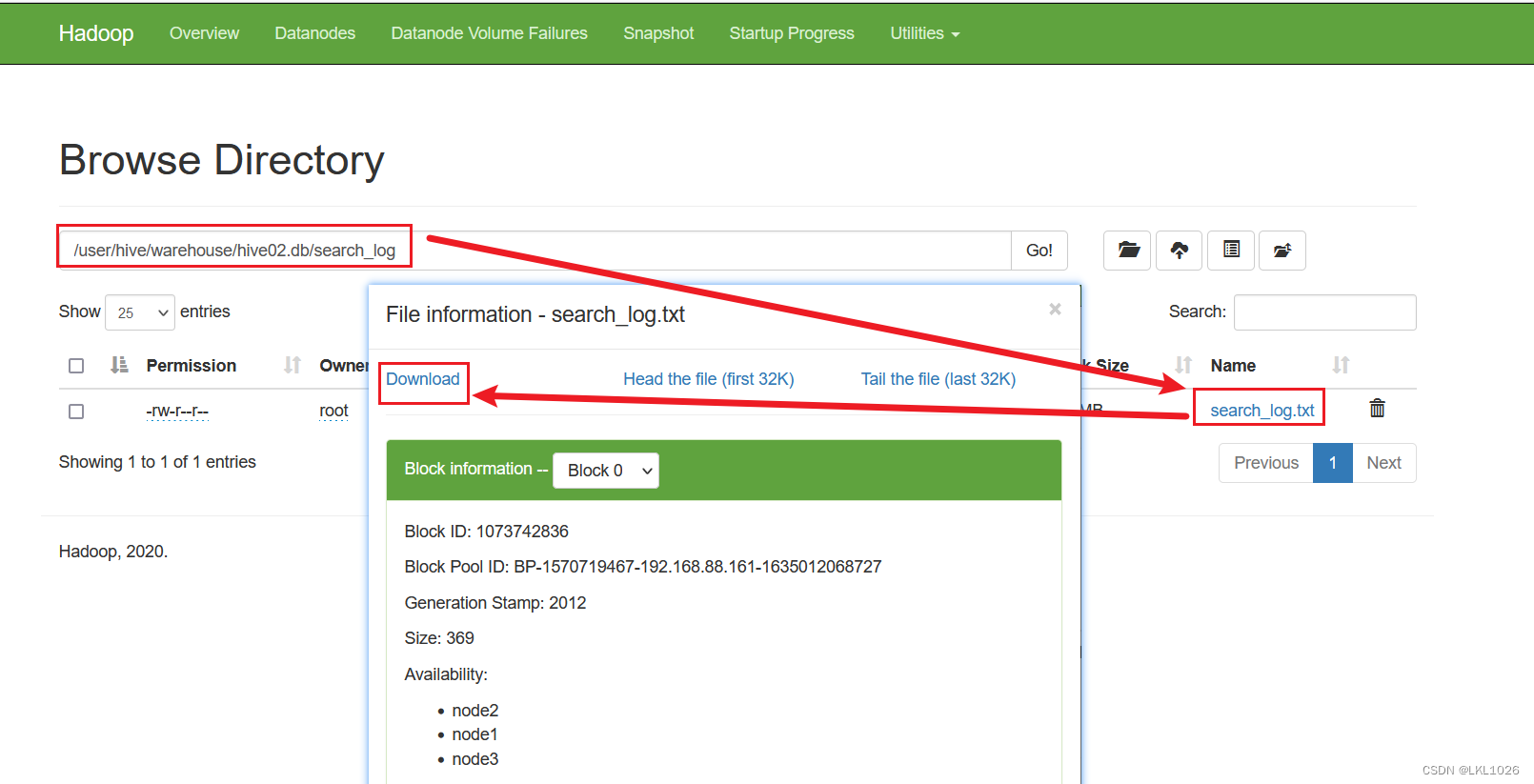

Windows页面上传

需求: 已知emp1.txt文件在windows/mac系统,要求使用hdfs保存此文件 并且使用hivesql建表关联数据

-- 1.先在hive上根据数据建表,然后在window/mac上传文件到hdfs表路径中

create table emp1(id int,name string,sal double,dept string

)row format delimited

fields terminated by ',';-- windows使用hdfs页面上传文件

-- node1:9870访问页面把emp1.txt上传到/user/hive/warehouse/hive02.db/emp1路径下

-- 查询数据

select * from emp1;Linux本地put上传

需求: 已知emp2.txt文件在linux系统,要求使用hdfs保存此文件 并且使用hivesql建表关联数据

-- 2.先在hive上根据数据建表,然后在linux上传文件到hdfs表路径中

create table emp2(id int,name string,sal double,dept string

)row format delimited

fields terminated by ',';-- linux使用hdfs命令上传文件

-- [root@node1 ~]# hdfs dfs -put emp2.txt /user/hive/warehouse/hive02.db/emp2-- 查看数据

select * from emp2;2.load加载文件

从hdfs路径把文件移动到表对应存储路径中: load data inpath 'HDFS文件路径' [overwrite] into table 表名;

从linux本地把文件上传到表对应存储路径中: load data local inpath 'Linux文件路径' [overwrite] into table 表名;

load移动HDFS文件

-- 数据导入

-- 需求1: load加载hdfs中文件到表路径中

-- 1.根据资料中search_log.txt数据创建表

create table search_log(dt string,uid string,name string,url string

)row format delimited fields terminated by '\t';

-- 2.把windows中search_log.txt文件上传hdfs其他路径,例如:/src中

-- 3.使用load把hdfs的/src中的文件移动到search_log对应hdfs表存储路径中

load data inpath '/src/search_log.txt' into table search_log;

-- 4.查询数据

select * from search_log;load上传Linux文件

-- 需求2: 直接把linux中最新的search_log.txt文件上传到search表对应hdfs路径中

-- 先把资料中search_log.txt文件传到linux中,例如:/root

-- load命令上传文件

load data local inpath '/root/search_log.txt' overwrite into table search_log;-- 查看最终数据

select * from search_log;3.insert插入数据

从其他表查询数据'追加'插入到当前表中: insert into [table] 表名 select 语句;

从其他表查询数据'覆盖'插入到当前表中: insert overwrite table 表名 select 语句;

insert追加数据

-- 需求1:创建一个search_log_copy表,然后从search_log查询数据插入到新表中

create table search_log_copy(dt string,uid string,word string,url string

)row format delimited

fields terminated by '\t';-- 从search_log表中查所有数据,直接插入到search_log_copy表

insert into table search_log_copy select * from search_log;

-- 查看数据

select * from search_log_copy;insert覆盖数据

-- 需求2: 假设search_log表中数据改变了,要求把最新的数据更新到search_log_copy表中

insert overwrite table search_log_copy select * from search_log;

-- 查看数据

select * from search_log_copy;文件数据导出

1.直接下载文件

web页面下载

需求: 已知search_log.txt文件在HFDS的/user/hive/warehouse/hive02.db/search_log路径下,要下载到window系统

get命令下载文件

需求: 已知search_log.txt文件在HFDS的/user/hive/warehouse/hive02.db/search_log路径下,要下载到linux系统

[root@node1 binzi]# hdfs dfs -get /user/hive/warehouse/hive02.db/search_log/search_log.txt /binzi2.insert导出数据

查询数据导出到hdfs其他路径: insert overwrite directory 'hfds存储该数据路径' select语句;

查询数据导出到linux本地中: insert overwrite local directory 'linux存储该数据路径' select语句;

注意: overwrite默认是覆盖重写,所以在指定存储该数据路径的时候尽量指定一个空的目录

注意: 导出数据的时候不指定分隔符采用默认分隔符SOH,0001,?...

导出数据指定分隔符添加: row format delimited fields terminated by '分隔符'

insert导出到hdfs

-- 演示insert overwrite导出数据到文件

-- 语法: insert overwrite [local] directory 文件存储路径 [指定分隔符] select语句;

-- 导出数据到hfds

-- 注意: 如果是根目录/,会自动创建-ext-10000目录存储生成的000000_0文件

-- 但是其他目录,会自动清空所有内容,再生成一个000000_0文件,所以注意导出目录尽量是一个新的空目录

-- 默认分隔符

insert overwrite directory '/source' select * from search_log1;

-- 指定分隔符

insert overwrite directory '/output'row format delimited fields terminated by ','

select * from search_log1;insert导出Linux

-- 2.2导出到linux

-- [root@node1 ~]# mkdir /output

-- 导出到linux的/output目录下,自动生成000000_0文件存储查询结果

-- 默认分隔符

insert overwrite local directory '/output' select * from search_log1;

-- 指定分隔符

insert overwrite local directory '/output'row format delimited fields terminated by ','

select * from search_log1;3.hive_shell命令

hive命令执行sql语句: hive -e "sql语句" > 存储该结果数据的文件路径

hive命令执行sql脚本: hive -f sql脚本文件 > 存储该结果数据的文件路径

hql语句导出

# 以下命令都是在linux的shell命令行执行

# 3.1使用hive -e sql语句方式导出数据

[root@node1 ~]# hive -e 'select * from hive02.search_log;' > /home/hs1.txt

[root@node1 ~]# cat hs1.txthql脚本导出

# 3.2使用hive -f 脚本文件方式导出数据

[root@node1 ~]# echo 'select * from hive02.search_log;' > /home/export.sql

[root@node1 ~]# hive -f export.sql > /home/hs2.txt

[root@node1 ~]# cat hs2.txt相关文章:

【Python大数据笔记_day06_Hive】

hive内外表操作 建表语法 create [external] table [if not exists] 表名(字段名 字段类型 , 字段名 字段类型 , ... ) [partitioned by (分区字段名 分区字段类型)] # 分区表固定格式 [clustered by (分桶字段名) into 桶个数 buckets] # 分桶表固定格式 注意: 可以排序[so…...

Netty--文件编程

3. 文件编程 3.1 FileChannel ⚠️ FileChannel 工作模式 FileChannel 只能工作在阻塞模式下 获取 不能直接打开 FileChannel,必须通过 FileInputStream、FileOutputStream 或者 RandomAccessFile 来获取 FileChannel,它们都有 getChannel 方法 通过…...

SVN 服务器建立

1.建立SVN库 svnadmin create cat svndir/conf/passwd 修改SVN用户密码 chenht 123456 2.建立目录权限 [aliases] # joe /CXZ/STDessert/LSnake City/OSnake Oil, Ltd./OUResearch Institute/CNJoe Average [groups] # harry_and_sally harry,sally # harry_sally_…...

iPhone或在2024开放第三方应用商店。

iPhone或开放第三方应用商店,可以说这是一个老生常谈的话题。对于像是iOS这样封闭的系统来说,此前传出苹果可能开放侧载消息的时候,又有谁能信,谁会信? 如果是按照苹果自身的意愿,这种事情自然是不可能发生…...

《C和指针》笔记36:动态内存分配

1. malloc和free C函数库提供了两个函数,malloc和free,分别用于执行动态内存分配和释放。这些函数维护一个可用内存池。当一个程序另外需要一些内存时,它就调用malloc函数,malloc从内存池中提取一块合适的内存,并向该…...

)

C/S架构学习之基于UDP的本地通信(服务器)

基于UDP的本地通信(服务器):创建流程:一、创建数据报式套接字(socket函数): int sock_fd socket(AF_UNIX,SOCK_DGRAM,0);if(-1 sock_fd){perror("socket error");exit(-1);}二、创建…...

excel如何加密(excel加密的三种方法)

Excel是一款广泛使用的办公软件,有时候我们需要对一些重要的Excel文件进行加密,以保证文件的安全性。下面将介绍3种常用的Excel加密方法。 方法一:通过路径文件-另存为-工具-常规选项-设置打开或修改权限密码(密码只可以使数字、字…...

玩了个锤子游戏小程序搭建流程:探索深度与逻辑的结合

随着移动互联网的普及,小程序已经成为了越来越多用户的选择。在这个背景下,玩了个锤子游戏小程序应运而生,它为用户提供了一个全新的游戏体验。那么,如何搭建这样一个小程序呢?本文将为大家详细介绍玩了个锤子游戏小程…...

召回率计算及影响因素

召回率是指在所有正样本中,被成功预测为正样本的样本数占比。在机器学习领域,召回率是评估模型预测性能的重要指标之一。在本文中,我们将从多个方面深入探讨召回率的概念和应用。 阈值越高,精准率越高,召回率越低&…...

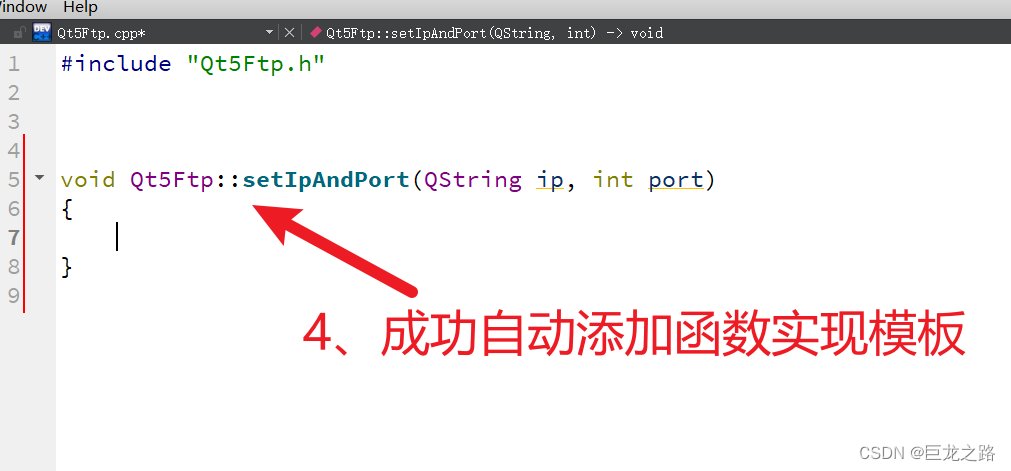

在Qt中怎么由函数定义自动创建函数实现模板

2023年11月12日,周日凌晨...

【算法】算法题-20231112

算法题 一、459. 重复的子字符串二、414. 第三大的数三、520. 检测大写字母四、680. 验证回文串 II五、283. 移动零 一、459. 重复的子字符串 简单 给定一个非空的字符串 s ,检查是否可以通过由它的一个子串重复多次构成。 示例 1: 输入: s “abab” 输出: true…...

)

目标检测YOLO实战应用案例100讲-基于多目标追踪的交通场景异常检测(续)

目录 3.5特征融合网络改进:小目标检测层 3.5.1小目标检测层 3.6实验结果与讨论...

最新支付宝转卡码生成之转账源代码(隐藏部分卡号)

一、需要准备好自己的卡号、名称、以及对应的姓名 二、然后将自己的信息填入下面的代码中 三、然后将拼接好的代码,利用转码技术生产对应的二维码 四、这样一个跳转银行卡二维码的转账码就做好了 效果演示:如下 支付宝扫码、跳转码、转卡码、隐藏卡号…...

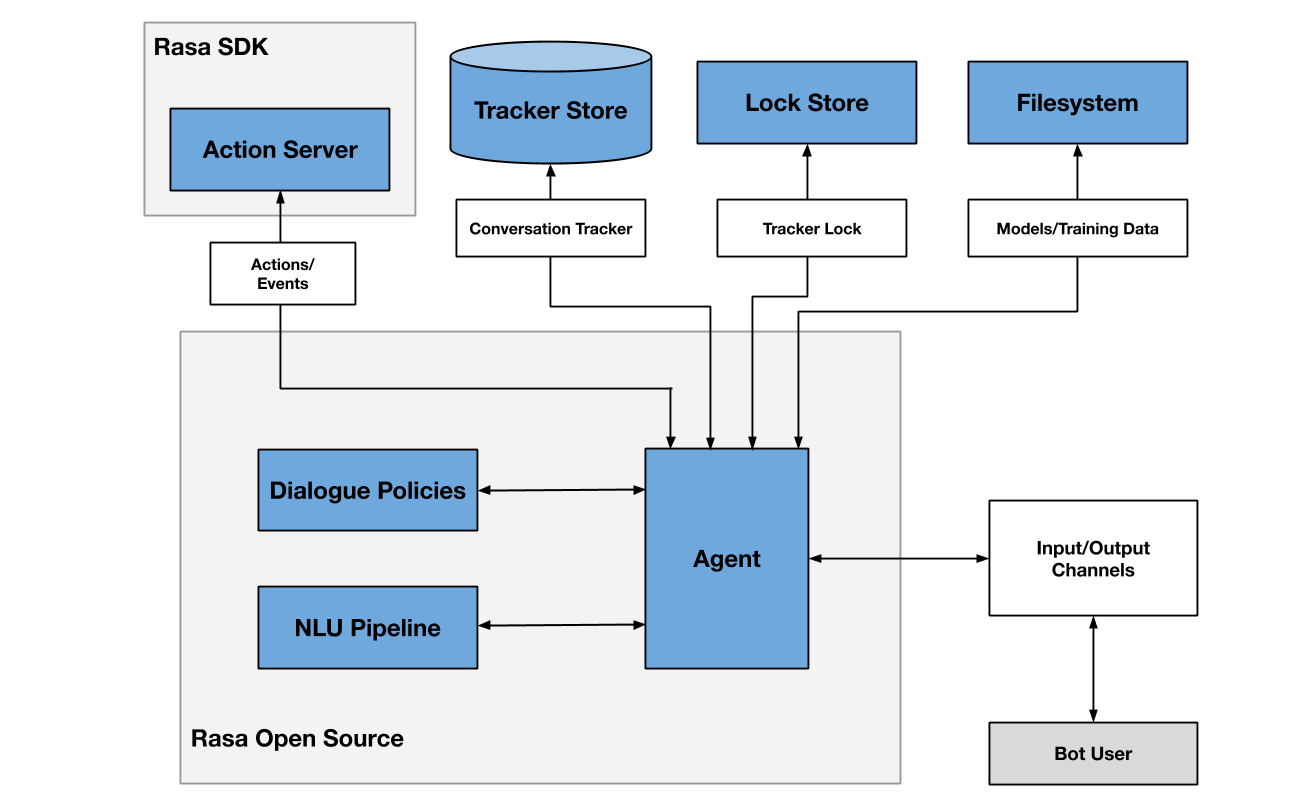

聊天机器人框架Rasa资源整理

Rasa是一个主流的构建对话机器人的开源框架,它的优点是几乎覆盖了对话系统的所有功能,并且每个模块都有很好的可扩展性。参考文献收集了一些Rasa相关的开源项目和优质文章。 一.Rasa介绍 1.Rasa本地安装 直接Rasa本地安装一个不好的地方就是容易把本地…...

魔搭社区LLM模型部署实践, 以ChatGLM3为例(一)

魔搭社区LLM模型部署实践, 以ChatGLM3为 例 本文以ChatGLM3-6B为例, 主要介绍在魔搭社区如何部署LLM, 主要包括如下内容: ● SwingDeploy - 云端部署, 实现零代码一键部署 ● 多端部署 - MAC个人笔记本,…...

、226.翻转二叉树 、101.对称二叉树 2)

25期代码随想录算法训练营第十四天 | 二叉树 | 层序遍历(10道题)、226.翻转二叉树 、101.对称二叉树 2

目录 层序遍历 10226.翻转二叉树101.对称二叉树 2 层序遍历 10 链接 # Definition for a binary tree node. # class TreeNode: # def __init__(self, val0, leftNone, rightNone): # self.val val # self.left left # self.right right clas…...

驱动安装教程)

ubuntu cp210x(USB转串口)驱动安装教程

ubuntu cp210x(USB转串口)驱动安装 前言1. 驱动下载2. 驱动编译和安装3. 可能遇到的问题及解决办法3.1 第一种解决方案:检查当前是否已有CP210x.ko驱动3.2 第二种解决方案:修改驱动文件,编译 前言 CP2108 是一款高度集…...

Spring-SpringAOP的实现

对Spring AOP的理解 OOP表示面向对象编程,是一种编程思想,AOP表示面向切面编程,也是一种编程思想 Spring AOP:Spring为了让程序员更加方便的做到面向切面编程所提供的技术支持 Spring提供的一套机制,让我们更容易的…...

js:Browserslist用特定语句查询浏览器列表的工具与Babel和Postcss配置使用

目录 BrowserslistBabel 和 BrowserslistPostcss 和 Browserslist推荐配置参考文章 Browserslist Browserslist 是一个用特定语句查询浏览器列表的工具 文档 https://www.npmjs.com/package/browserslisthttps://github.com/browserslist/browserslist#full-list 安装 pnp…...

odoo16前端框架源码阅读——boot.js

odoo16前端框架源码阅读——boot.js 从名字就能看出来,这个文件是一个启动文件。 odoo前端将所有的js打包成了两个文件,一个是common.js,另一个是backend.js, 而common.js 是最先加载的 在common.js打包的js文件中最先加载的是下面的文件,看…...

java调用dll出现unsatisfiedLinkError以及JNA和JNI的区别

UnsatisfiedLinkError 在对接硬件设备中,我们会遇到使用 java 调用 dll文件 的情况,此时大概率出现UnsatisfiedLinkError链接错误,原因可能有如下几种 类名错误包名错误方法名参数错误使用 JNI 协议调用,结果 dll 未实现 JNI 协…...

定时器任务——若依源码分析

分析util包下面的工具类schedule utils: ScheduleUtils 是若依中用于与 Quartz 框架交互的工具类,封装了定时任务的 创建、更新、暂停、删除等核心逻辑。 createScheduleJob createScheduleJob 用于将任务注册到 Quartz,先构建任务的 JobD…...

DIY|Mac 搭建 ESP-IDF 开发环境及编译小智 AI

前一阵子在百度 AI 开发者大会上,看到基于小智 AI DIY 玩具的演示,感觉有点意思,想着自己也来试试。 如果只是想烧录现成的固件,乐鑫官方除了提供了 Windows 版本的 Flash 下载工具 之外,还提供了基于网页版的 ESP LA…...

sipsak:SIP瑞士军刀!全参数详细教程!Kali Linux教程!

简介 sipsak 是一个面向会话初始协议 (SIP) 应用程序开发人员和管理员的小型命令行工具。它可以用于对 SIP 应用程序和设备进行一些简单的测试。 sipsak 是一款 SIP 压力和诊断实用程序。它通过 sip-uri 向服务器发送 SIP 请求,并检查收到的响应。它以以下模式之一…...

保姆级教程:在无网络无显卡的Windows电脑的vscode本地部署deepseek

文章目录 1 前言2 部署流程2.1 准备工作2.2 Ollama2.2.1 使用有网络的电脑下载Ollama2.2.2 安装Ollama(有网络的电脑)2.2.3 安装Ollama(无网络的电脑)2.2.4 安装验证2.2.5 修改大模型安装位置2.2.6 下载Deepseek模型 2.3 将deepse…...

C++:多态机制详解

目录 一. 多态的概念 1.静态多态(编译时多态) 二.动态多态的定义及实现 1.多态的构成条件 2.虚函数 3.虚函数的重写/覆盖 4.虚函数重写的一些其他问题 1).协变 2).析构函数的重写 5.override 和 final关键字 1&#…...

OD 算法题 B卷【正整数到Excel编号之间的转换】

文章目录 正整数到Excel编号之间的转换 正整数到Excel编号之间的转换 excel的列编号是这样的:a b c … z aa ab ac… az ba bb bc…yz za zb zc …zz aaa aab aac…; 分别代表以下的编号1 2 3 … 26 27 28 29… 52 53 54 55… 676 677 678 679 … 702 703 704 705;…...

【p2p、分布式,区块链笔记 MESH】Bluetooth蓝牙通信 BLE Mesh协议的拓扑结构 定向转发机制

目录 节点的功能承载层(GATT/Adv)局限性: 拓扑关系定向转发机制定向转发意义 CG 节点的功能 节点的功能由节点支持的特性和功能决定。所有节点都能够发送和接收网格消息。节点还可以选择支持一个或多个附加功能,如 Configuration …...

嵌入式常见 CPU 架构

架构类型架构厂商芯片厂商典型芯片特点与应用场景PICRISC (8/16 位)MicrochipMicrochipPIC16F877A、PIC18F4550简化指令集,单周期执行;低功耗、CIP 独立外设;用于家电、小电机控制、安防面板等嵌入式场景8051CISC (8 位)Intel(原始…...

【堆垛策略】设计方法

堆垛策略的设计是积木堆叠系统的核心,直接影响堆叠的稳定性、效率和容错能力。以下是分层次的堆垛策略设计方法,涵盖基础规则、优化算法和容错机制: 1. 基础堆垛规则 (1) 物理稳定性优先 重心原则: 大尺寸/重量积木在下…...