Python开发运维:Celery连接Redis

目录

一、理论

1.Celery

二、实验

1.Windows11安装Redis

2.Python3.8环境中配置Celery

3.celery的多目录结构异步执行

4.celery简单结构下的定时任务

三、问题

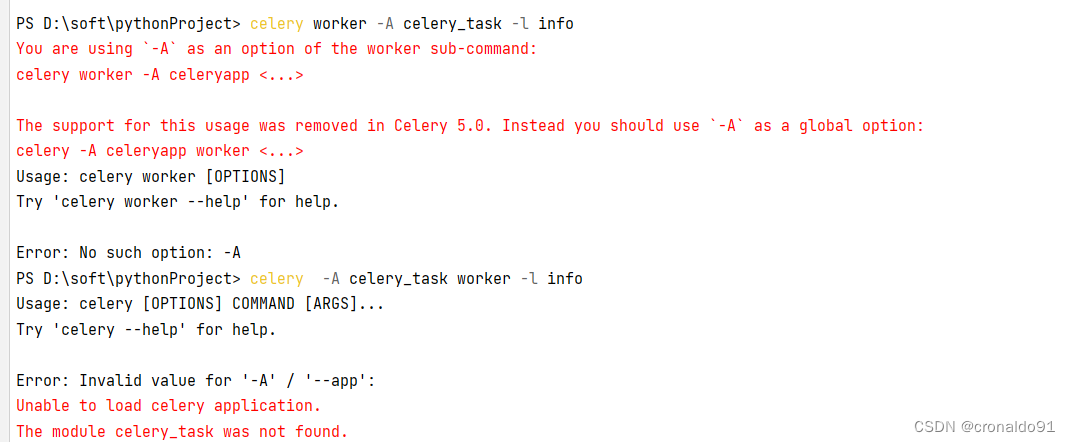

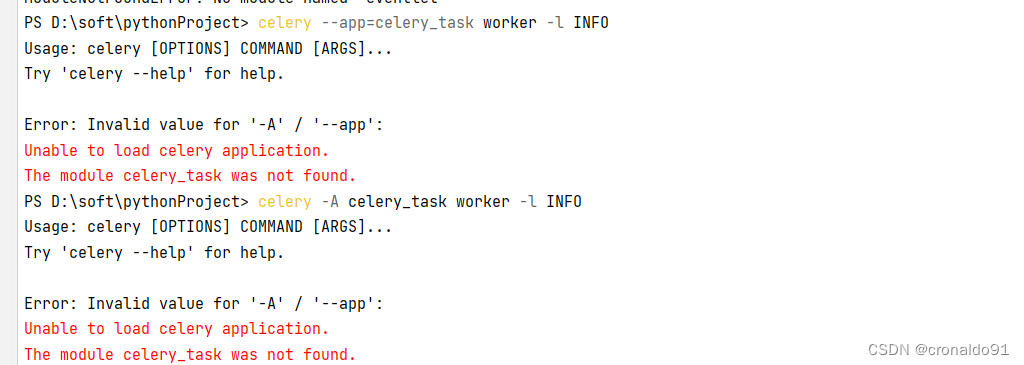

1.Celery命令报错

2.执行Celery命令报错

3.Win11启动Celery报ValueErro错误

4.Pycharm 无法 import 同目录下的 .py 文件或自定义模块

一、理论

1.Celery

(1) 概念

Celery是一个基于python开发的分布式系统,它是简单、灵活且可靠的,处理大量消息,专注于实时处理的异步任务队列,同时也支持任务调度。

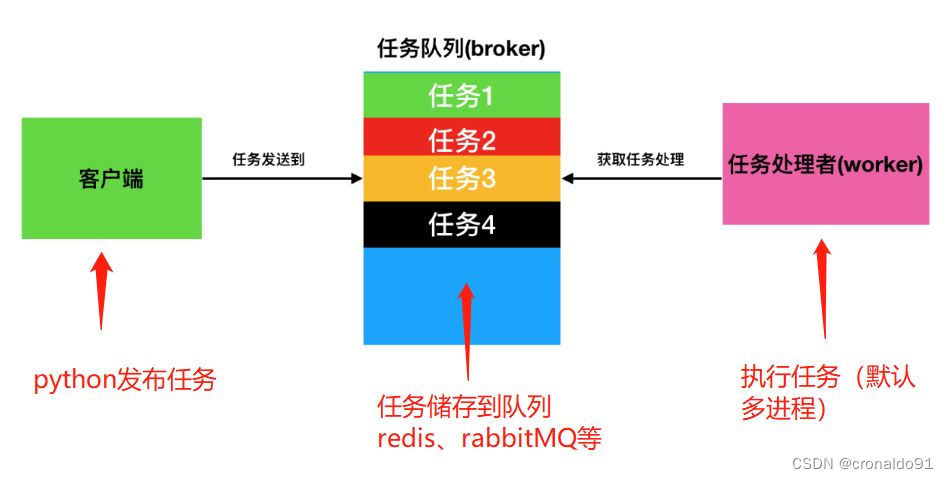

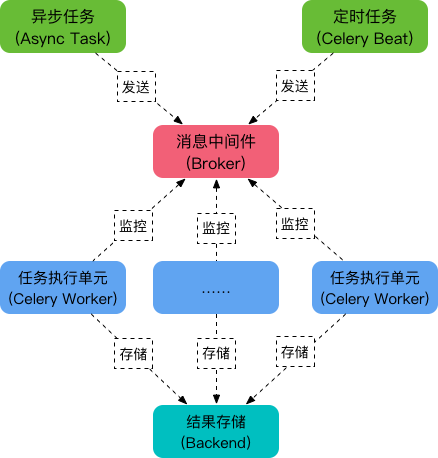

(2) 架构

Celery的架构由三部分组成,消息中间件(message broker),任务执行单元(worker)和任务执行结果存储(task result store)组成。

1)消息中间件

Celery本身不提供消息服务,但是可以方便的和第三方提供的消息中间件集成。包括,RabbitMQ, Redis等等2)任务执行单元

Worker是Celery提供的任务执行的单元,worker并发的运行在分布式的系统节点中。3)任务结果存储

Task result store用来存储Worker执行的任务的结果,Celery支持以不同方式存储任务的结果,包括AMQP, redis等

(3) 特点

1)简单

Celery易于使用和维护,并且它不需要配置文件并且配置和使用是比较简单的2)高可用

当任务执行失败或执行过程中发生连接中断,celery会自动尝试重新执行任务3)快速

单个 Celery 进程每分钟可处理数以百万计的任务,而保持往返延迟在亚毫秒级4)灵活

Celery几乎所有部分都可以扩展或单独使用,各个部分可以自定义。(4)场景

Celery是一个强大的 分布式任务队列的异步处理框架,它可以让任务的执行完全脱离主程序,甚至可以被分配到其他主机上运行。通常使用它来实现异步任务(async task)和定时任务(crontab)。

1)异步任务

将耗时操作任务提交给Celery去异步执行,比如发送短信/邮件、消息推送、音视频处理等等2)定时任务

定时执行某件事情,比如每天数据统计二、实验

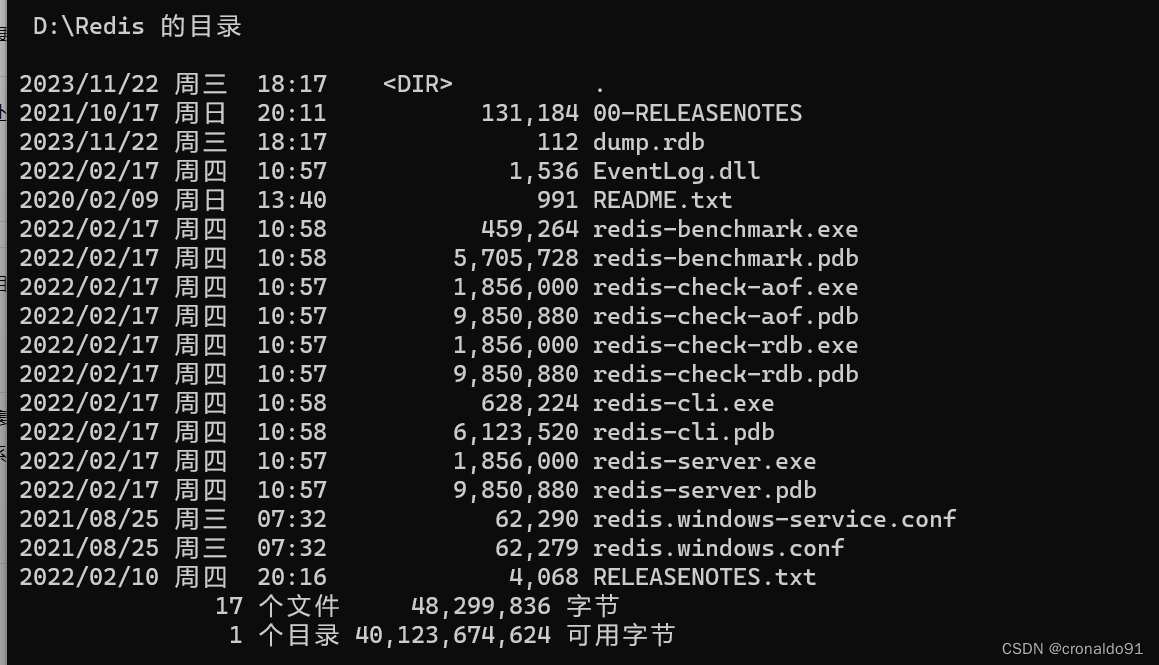

1.Windows11安装Redis

(1)下载最新版Redis

Redis-x64-xxx.zip压缩包到D盘,解压后,将文件夹重新命名为 Redis(2)查看目录

D:\Redis>dir

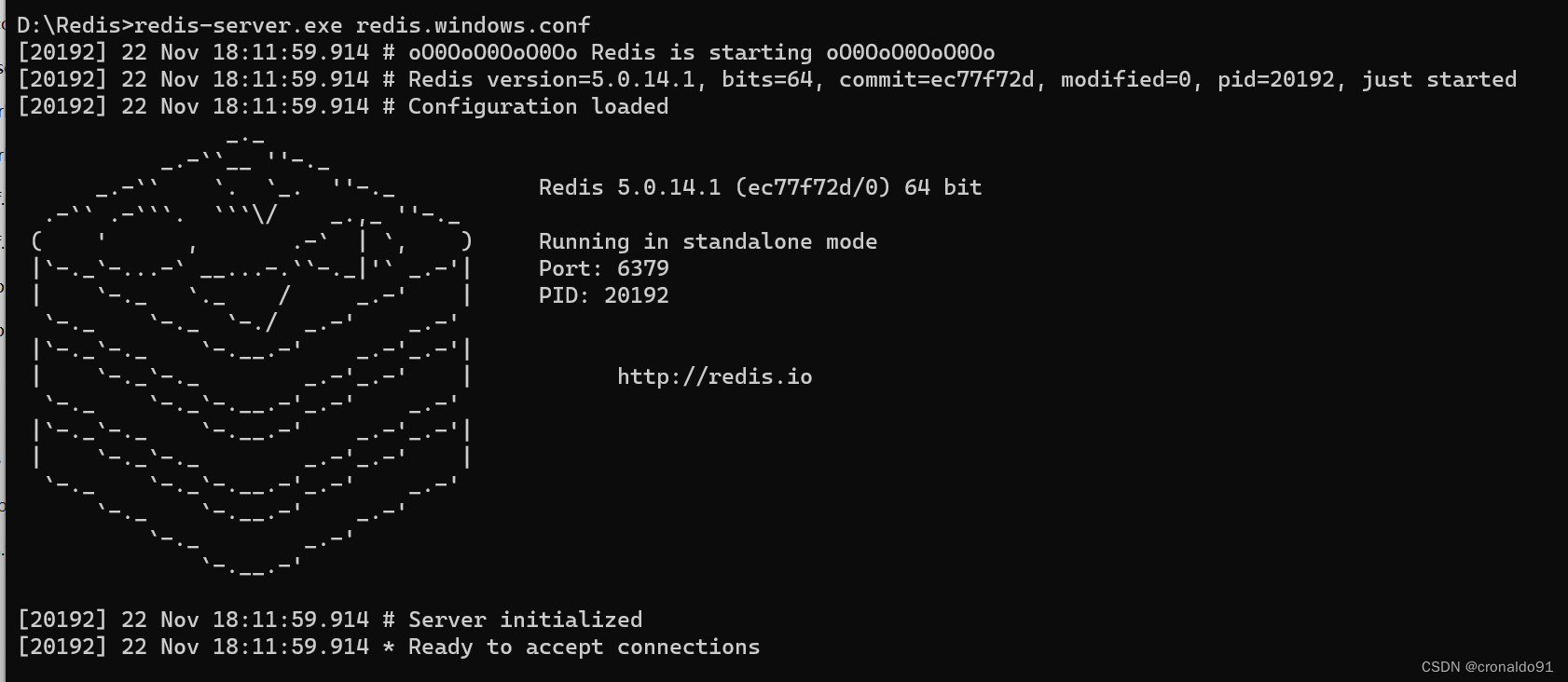

(3)打开一个 cmd 窗口 使用 cd 命令切换目录到 D:\Redis 运行

redis-server.exe redis.windows.conf

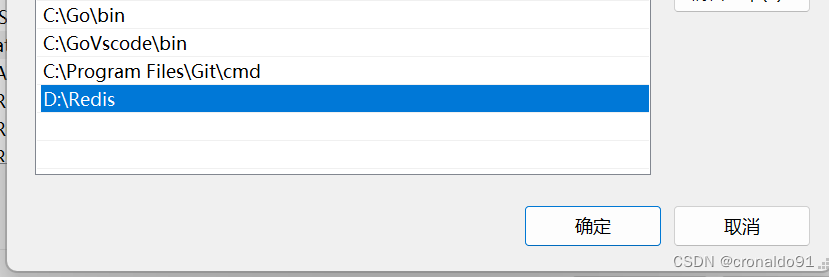

(4)把 redis 的路径加到系统的环境变量

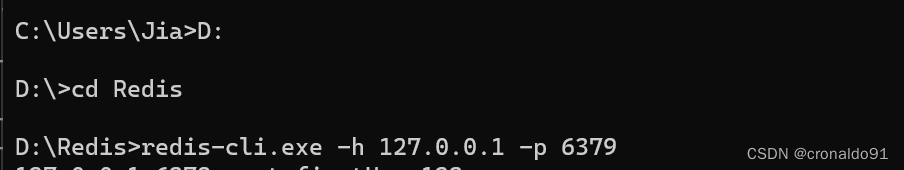

(5)另外开启一个 cmd 窗口,原来的不要关闭,因为先前打开的是redis服务端

#切换到 redis 目录下运行

redis-cli.exe -h 127.0.0.1 -p 6379

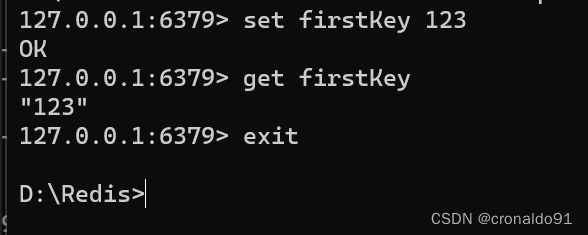

(6)检测连接是否成功

#设置键值对

set firstKey 123#取出键值对

get firstKey#退出

exit

Redis数据库已显示

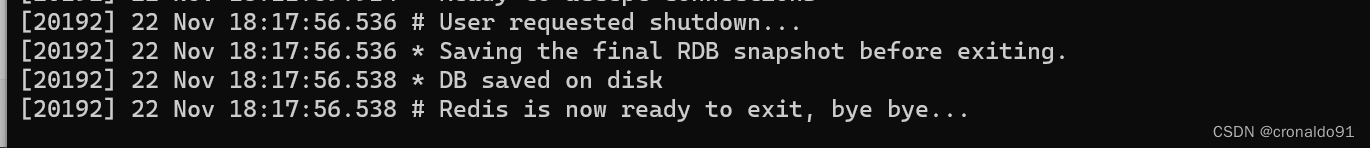

(7)ctrl+c 退出先前打开的服务端

(8)注册Redis服务

#通过 cmd 命令行工具进入 Redis 安装目录,将 Redis 服务注册到 Windows 服务中,执行以下命令

redis-server.exe --service-install redis.windows.conf --loglevel verbose

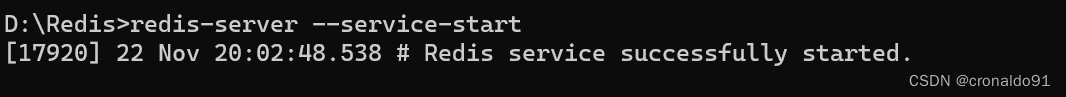

(9)启动Redis服务

#执行以下命令启动 Redis 服务

redis-server --service-start

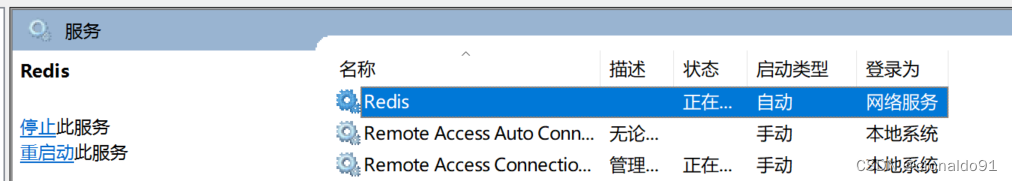

(10)Redis 已经被添加到 Windows 服务中

(11)打开Redis服务,将启动类型设置为自动,即可实现开机自启动

2.Python3.8环境中配置Celery

(1) PyCharm安装celery+redis

#celery是典型的生产者+消费者的模式,生产者生产任务并加入队列中,消费者取出任务消费。多用于处理异步任务或者定时任务。#第一种方式

pip install celery

pip install redis#第二种方式

pip install -i https://pypi.douban.com/simple celery

pip install -i https://pypi.douban.com/simple redis

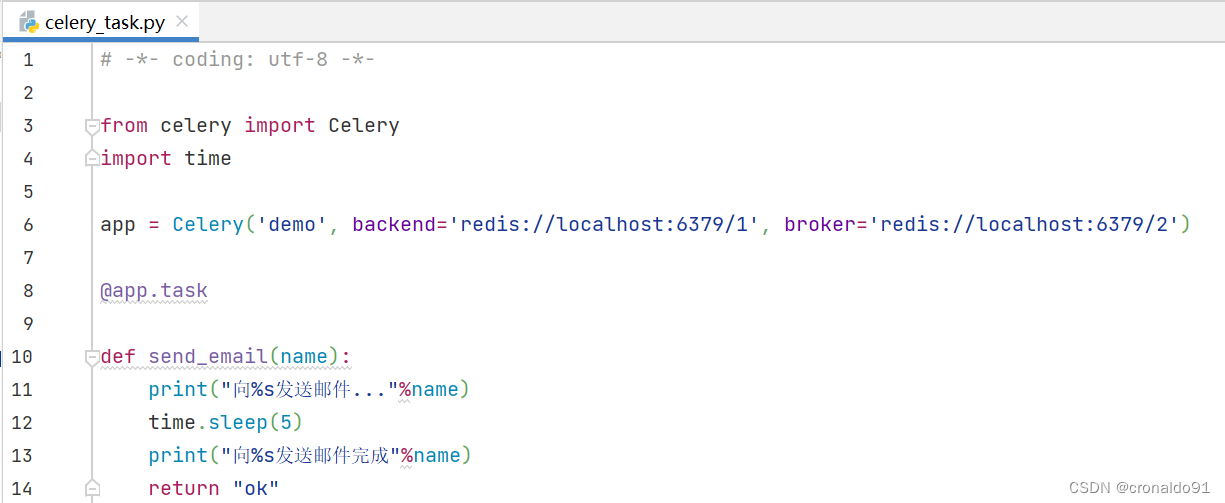

(2)新建异步任务执行文件celery_task.py.相当于注册了celery app

# -*- coding: utf-8 -*-

from celery import Celery

import time

app = Celery('demo', backend='redis://localhost:6379/1', broker='redis://localhost:6379/2')

@app.task

def send_email(name):print("向%s发送邮件..."%name)time.sleep(5)print("向%s发送邮件完成"%name)return "ok"

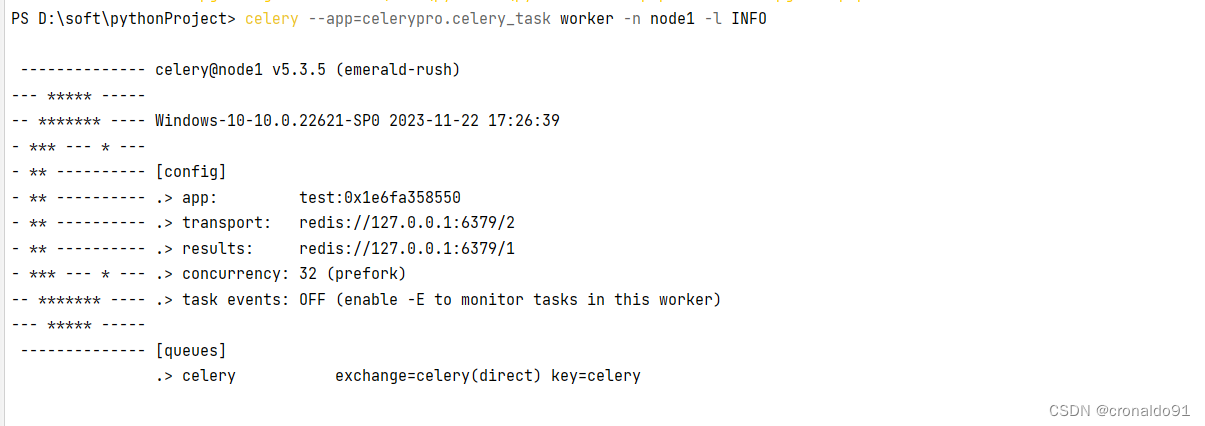

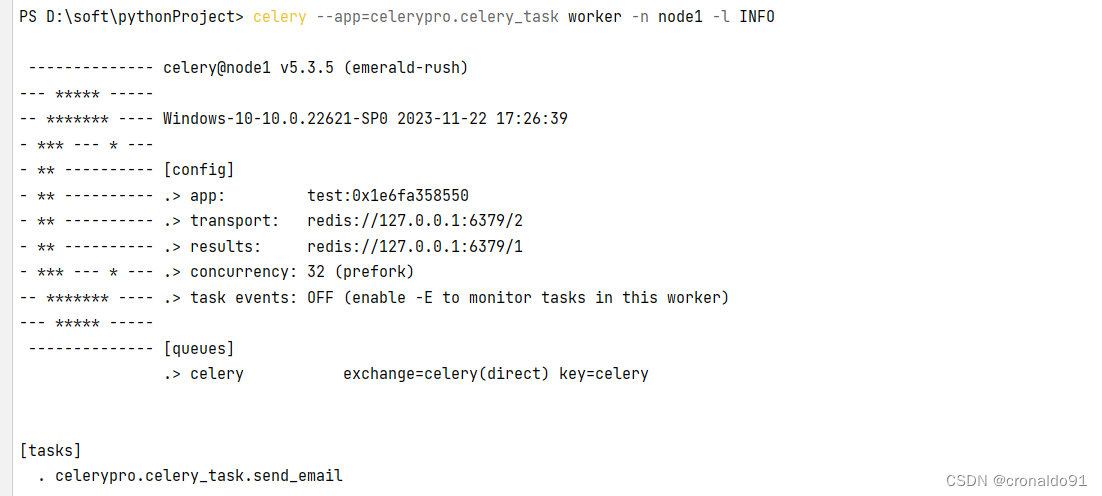

(3) 在项目文件目录下创建worker消费任务

PS D:\soft\pythonProject> celery --app=celerypro.celery_task worker -n node1 -l INFO-------------- celery@node1 v5.3.5 (emerald-rush)

--- ***** -----

-- ******* ---- Windows-10-10.0.22621-SP0 2023-11-22 17:26:39

- *** --- * ---

- ** ---------- [config]

- ** ---------- .> app: test:0x1e6fa358550

- ** ---------- .> transport: redis://127.0.0.1:6379/2

- ** ---------- .> results: redis://127.0.0.1:6379/1

- *** --- * --- .> concurrency: 32 (prefork)

-- ******* ---- .> task events: OFF (enable -E to monitor tasks in this worker)

--- ***** ------------------- [queues].> celery exchange=celery(direct) key=celery[tasks]. celerypro.celery_task.send_email[2023-11-22 17:26:39,265: WARNING/MainProcess] d:\soft\python38\lib\site-packages\celery\worker\consumer\consumer.py:507: CPendingDeprecationWarning: The broker_connection_retry configuration setting will no longer determine

[2023-11-22 20:30:08,249: INFO/MainProcess] mingle: searching for neighbors

[2023-11-22 20:30:15,379: INFO/MainProcess] mingle: all alone

[2023-11-22 20:30:25,608: INFO/MainProcess] celery@node1 ready.

(4)ctrl+c 退出

(5)修改celery_task.py文件,增加一个task

# -*- coding: utf-8 -*-

from celery import Celery

import time

app = Celery('demo', backend='redis://localhost:6379/1', broker='redis://localhost:6379/2')

@app.task

def send_email(name):print("向%s发送邮件..."%name)time.sleep(5)print("向%s发送邮件完成"%name)return "ok"

@app.task

def send_msg(name):print("向%s发送短信..."%name)time.sleep(5)print("向%s发送邮件完成"%name)return "ok"

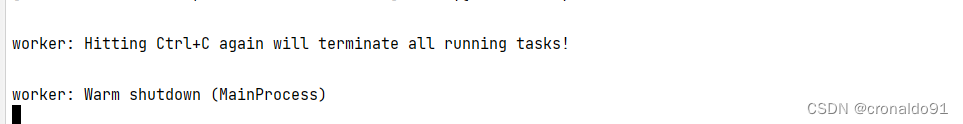

(6)再次在项目文件目录下创建worker消费任务

PS D:\soft\pythonProject> celery --app=celerypro.celery_task worker -n node1 -l INFO-------------- celery@node1 v5.3.5 (emerald-rush)

--- ***** -----

-- ******* ---- Windows-10-10.0.22621-SP0 2023-11-22 21:01:43

- *** --- * ---

- ** ---------- [config]

- ** ---------- .> app: demo:0x29cea446250

- ** ---------- .> transport: redis://localhost:6379/2

- ** ---------- .> results: redis://localhost:6379/1

- *** --- * --- .> concurrency: 32 (prefork)

-- ******* ---- .> task events: OFF (enable -E to monitor tasks in this worker)

--- ***** ----- -------------- [queues].> celery exchange=celery(direct) key=celery[tasks]. celerypro.celery_task.send_email. celerypro.celery_task.send_msg[2023-11-22 21:01:43,381: WARNING/MainProcess] d:\soft\python38\lib\site-packages\celery\worker\consumer\consumer.py:507: CPendingDeprecationWarning: The broker_connection_retry configuration setting will no longer determine

[2023-11-22 21:01:43,612: INFO/SpawnPoolWorker-23] child process 23988 calling self.run()

[2023-11-22 21:01:43,612: INFO/SpawnPoolWorker-17] child process 16184 calling self.run()

[2023-11-22 21:01:43,612: INFO/SpawnPoolWorker-21] child process 22444 calling self.run()

[2023-11-22 21:01:43,612: INFO/SpawnPoolWorker-27] child process 29480 calling self.run()

[2023-11-22 21:01:43,612: INFO/SpawnPoolWorker-24] child process 5844 calling self.run()

[2023-11-22 21:01:43,631: INFO/SpawnPoolWorker-25] child process 8896 calling self.run()

[2023-11-22 21:01:43,634: INFO/SpawnPoolWorker-29] child process 28068 calling self.run()

[2023-11-22 21:01:43,634: INFO/SpawnPoolWorker-28] child process 18952 calling self.run()

[2023-11-22 21:01:43,636: INFO/SpawnPoolWorker-26] child process 13680 calling self.run()

[2023-11-22 21:01:43,638: INFO/SpawnPoolWorker-31] child process 25472 calling self.run()

[2023-11-22 21:01:43,638: INFO/SpawnPoolWorker-30] child process 28688 calling self.run()

[2023-11-22 21:01:43,638: INFO/SpawnPoolWorker-32] child process 10072 calling self.run()

[2023-11-22 21:01:45,401: INFO/MainProcess] Connected to redis://localhost:6379/2

[2023-11-22 21:01:45,401: WARNING/MainProcess] d:\soft\python38\lib\site-packages\celery\worker\consumer\consumer.py:507: CPendingDeprecationWarning: The broker_connection_retry configuration setting will no longer determine

whether broker connection retries are made during startup in Celery 6.0 and above.

If you wish to retain the existing behavior for retrying connections on startup,

you should set broker_connection_retry_on_startup to True.warnings.warn([2023-11-22 21:01:49,477: INFO/MainProcess] mingle: searching for neighbors

[2023-11-22 21:01:56,607: INFO/MainProcess] mingle: all alone

[2023-11-22 21:02:04,753: INFO/MainProcess] celery@node1 ready.

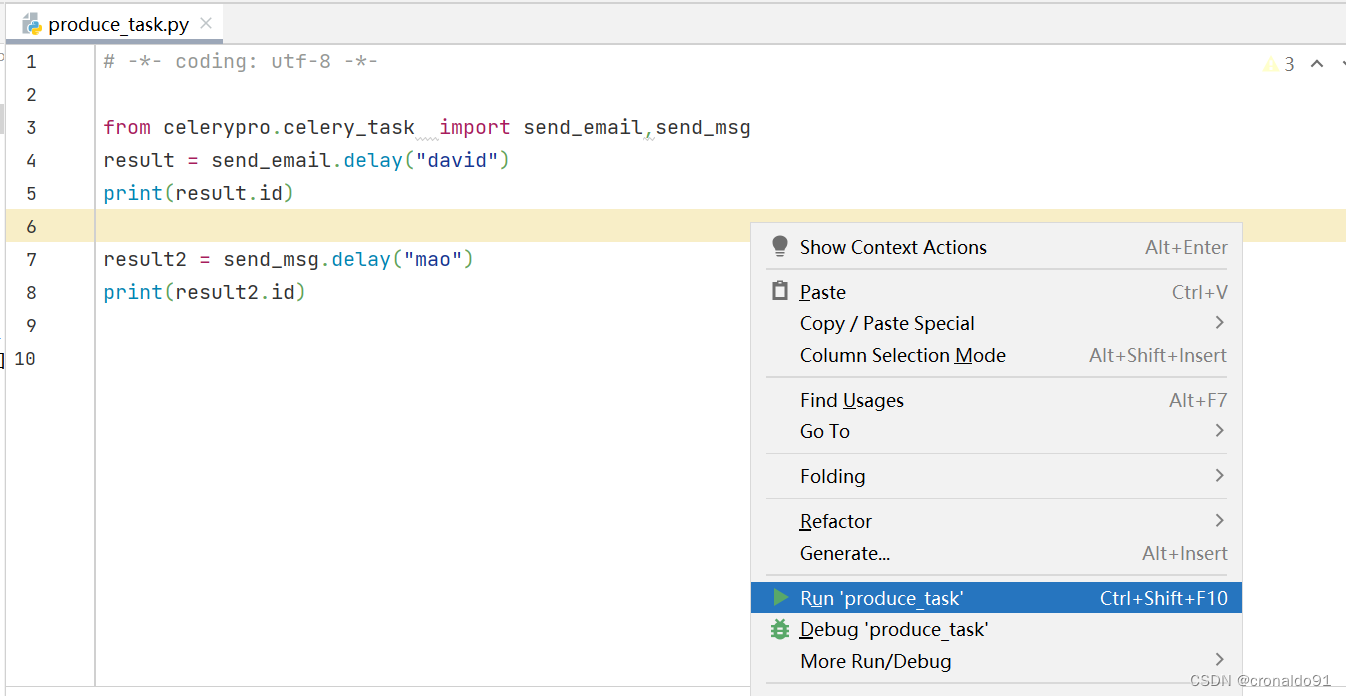

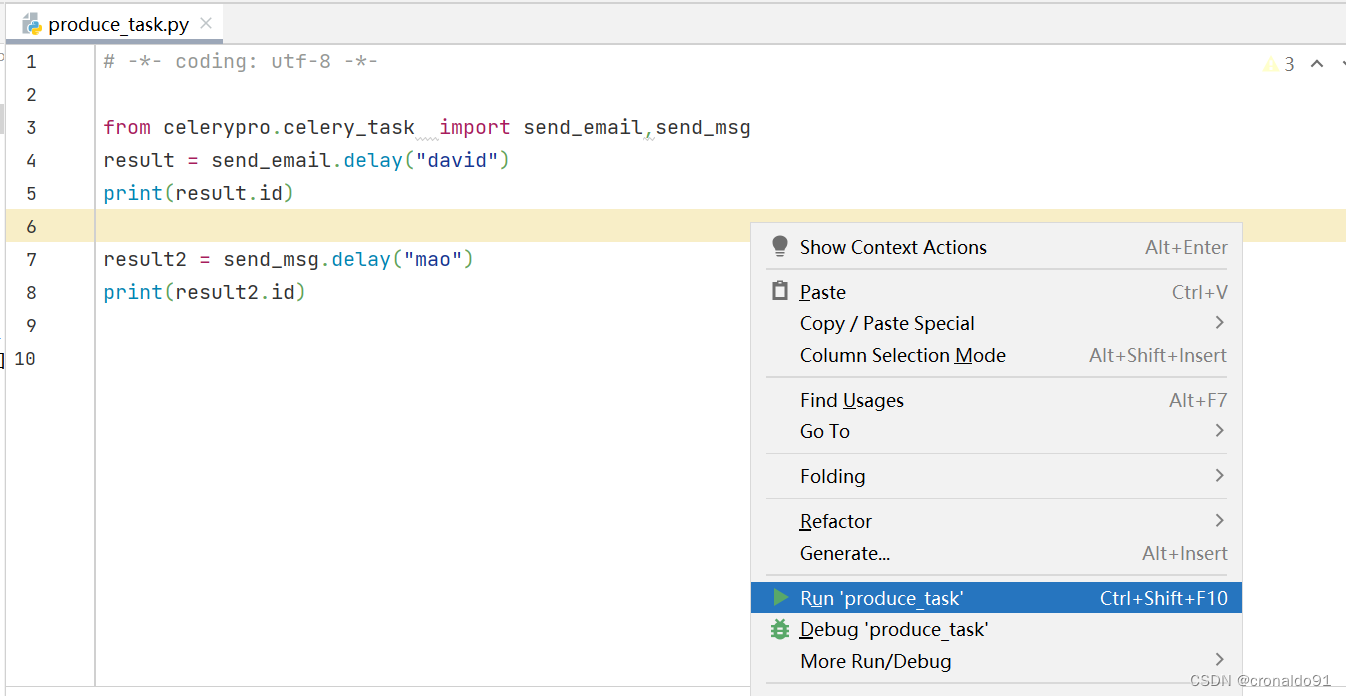

(6)ctrl+c 退出创建执行任务文件produce_task.py

# -*- coding: utf-8 -*-

from celerypro.celery_task import send_email,send_msg

result = send_email.delay("david")

print(result.id)

result2 = send_msg.delay("mao")

print(result2.id)

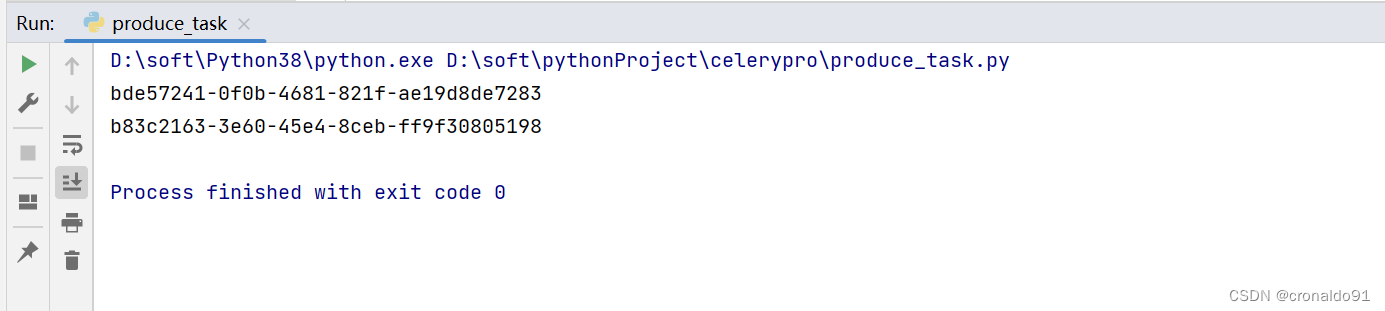

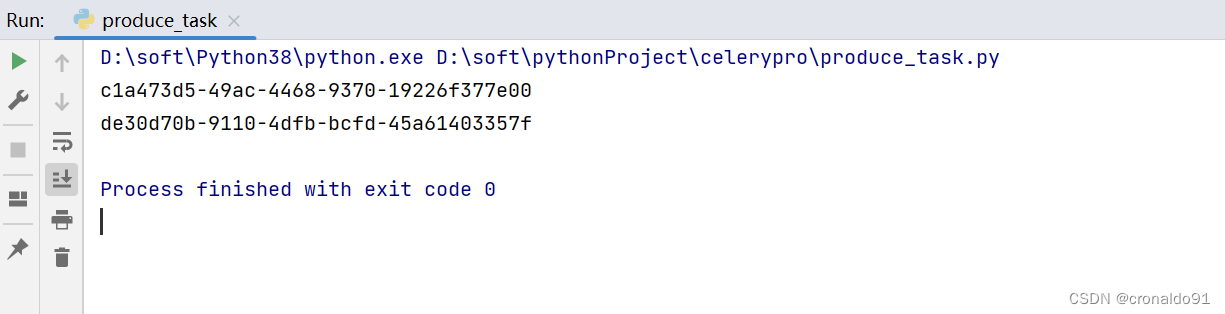

(7)运行produce_task.py

(8)同时取到id值

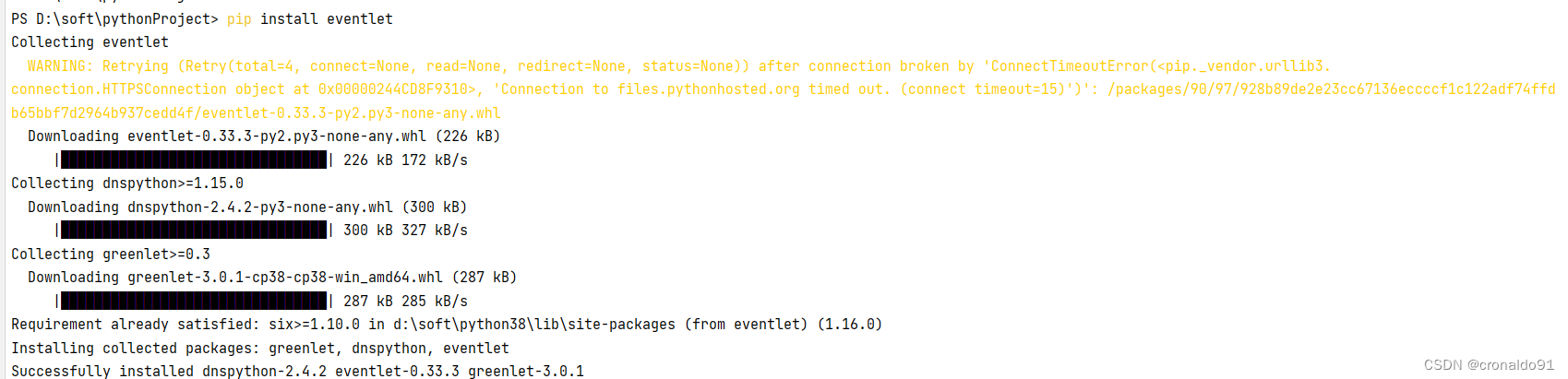

(9)如遇到报错需要安装包 eventlet

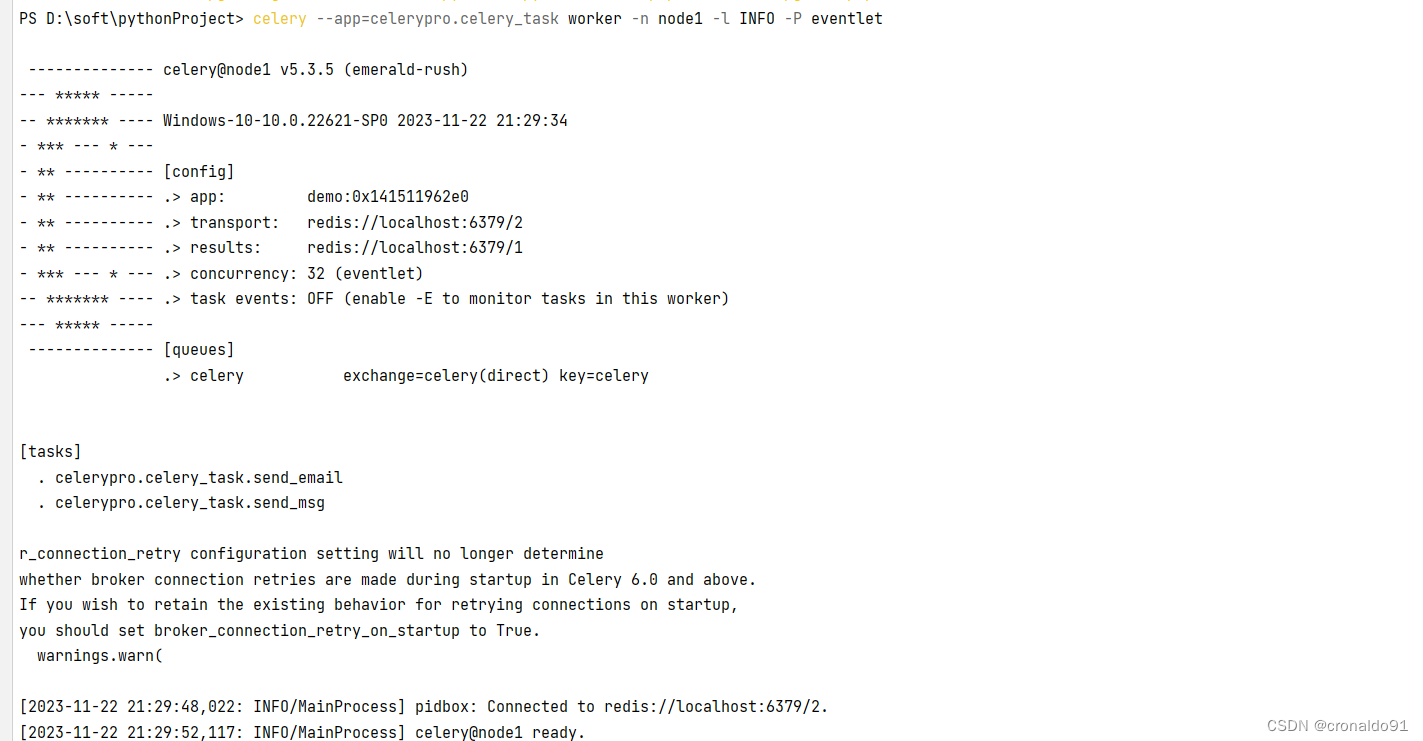

PS D:\soft\pythonProject> pip install eventlet

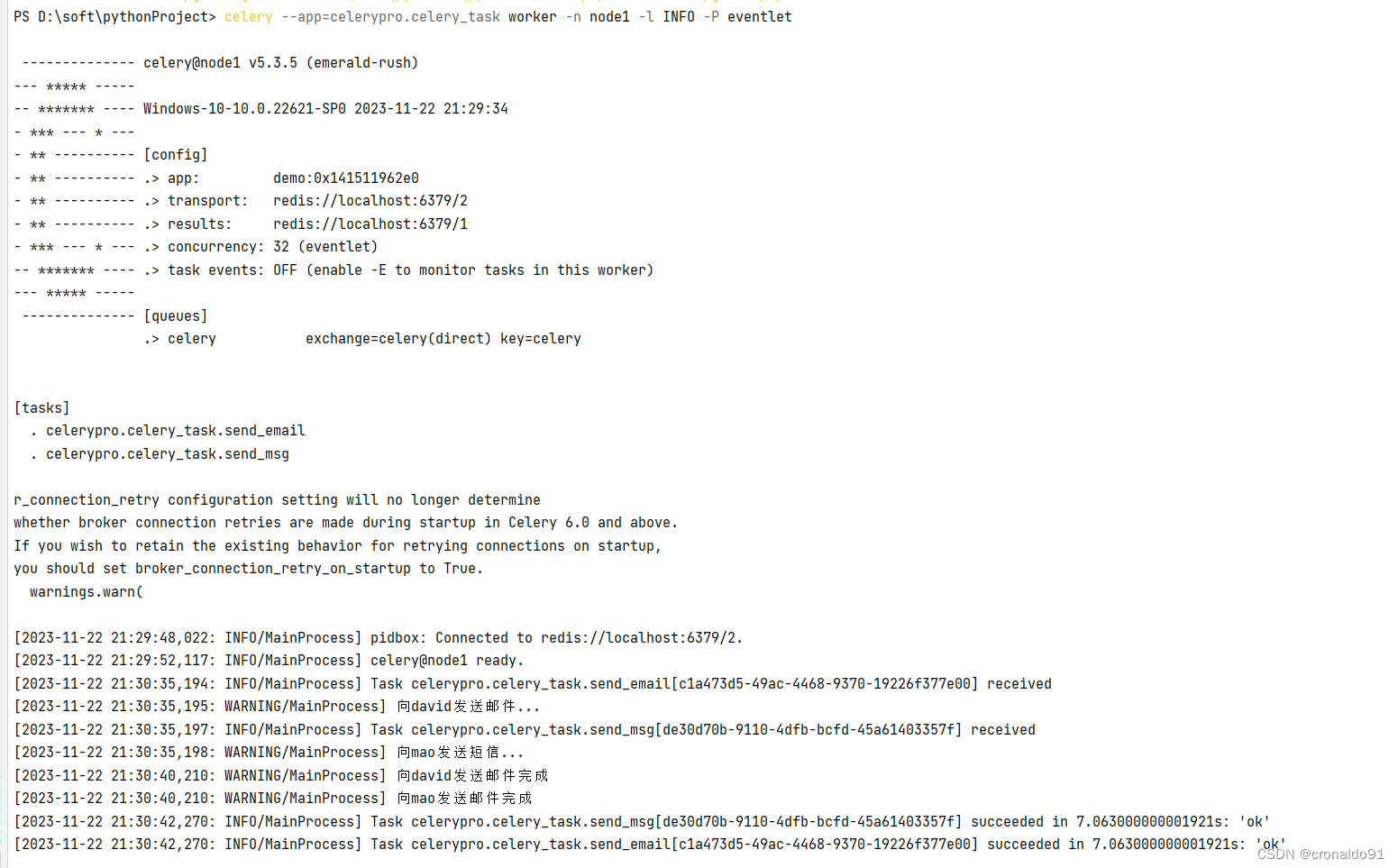

(10)重新在项目文件目录下创建worker消费任务

PS D:\soft\pythonProject> celery --app=celerypro.celery_task worker -n node1 -l INFO -P eventlet-------------- celery@node1 v5.3.5 (emerald-rush)

--- ***** -----

-- ******* ---- Windows-10-10.0.22621-SP0 2023-11-22 21:29:34

- *** --- * ---

- ** ---------- [config]

- ** ---------- .> app: demo:0x141511962e0

- ** ---------- .> transport: redis://localhost:6379/2

- ** ---------- .> results: redis://localhost:6379/1

- *** --- * --- .> concurrency: 32 (eventlet)

-- ******* ---- .> task events: OFF (enable -E to monitor tasks in this worker)

--- ***** ------------------- [queues].> celery exchange=celery(direct) key=celery[tasks]. celerypro.celery_task.send_email. celerypro.celery_task.send_msgr_connection_retry configuration setting will no longer determine

whether broker connection retries are made during startup in Celery 6.0 and above.

If you wish to retain the existing behavior for retrying connections on startup,

you should set broker_connection_retry_on_startup to True.warnings.warn([2023-11-22 21:29:48,022: INFO/MainProcess] pidbox: Connected to redis://localhost:6379/2.

[2023-11-22 21:29:52,117: INFO/MainProcess] celery@node1 ready.

(11) 运行produce_task.py

(12)生成id

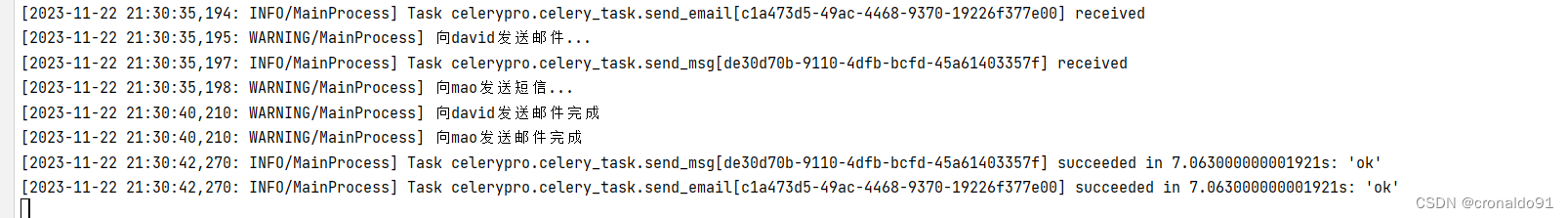

(13)查看任务消息

[2023-11-22 21:30:35,194: INFO/MainProcess] Task celerypro.celery_task.send_email[c1a473d5-49ac-4468-9370-19226f377e00] received

[2023-11-22 21:30:35,195: WARNING/MainProcess] 向david发送邮件...

[2023-11-22 21:30:35,197: INFO/MainProcess] Task celerypro.celery_task.send_msg[de30d70b-9110-4dfb-bcfd-45a61403357f] received

[2023-11-22 21:30:35,198: WARNING/MainProcess] 向mao发送短信...

[2023-11-22 21:30:40,210: WARNING/MainProcess] 向david发送邮件完成

[2023-11-22 21:30:40,210: WARNING/MainProcess] 向mao发送邮件完成

[2023-11-22 21:30:42,270: INFO/MainProcess] Task celerypro.celery_task.send_msg[de30d70b-9110-4dfb-bcfd-45a61403357f] succeeded in 7.063000000001921s: 'ok'

[2023-11-22 21:30:42,270: INFO/MainProcess] Task celerypro.celery_task.send_email[c1a473d5-49ac-4468-9370-19226f377e00] succeeded in 7.063000000001921s: 'ok'

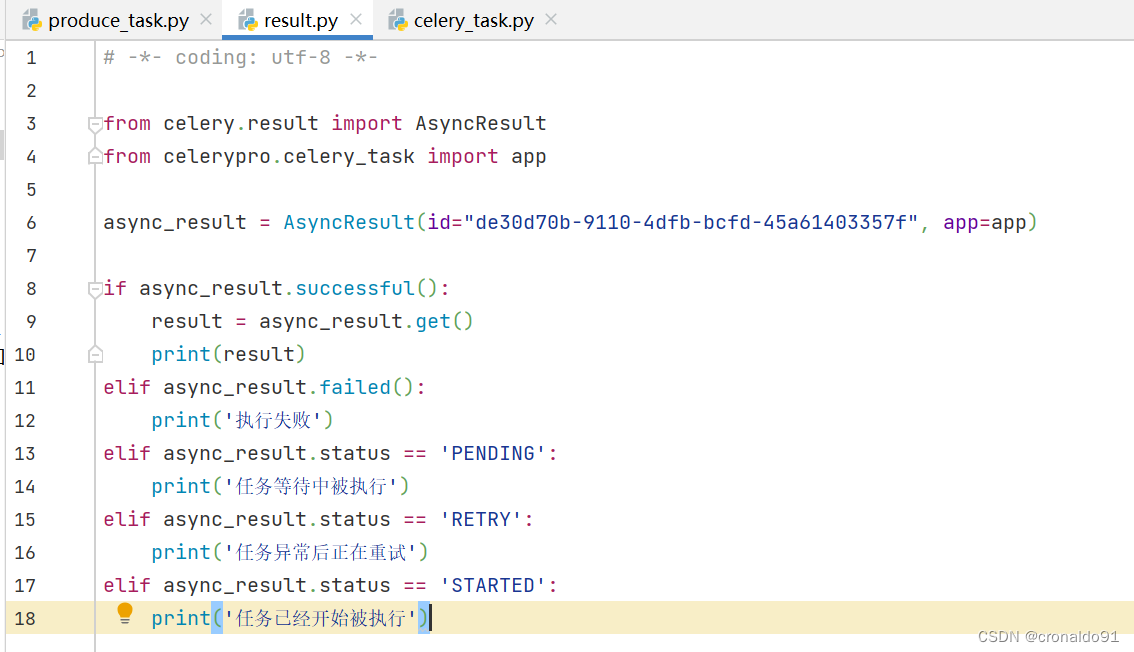

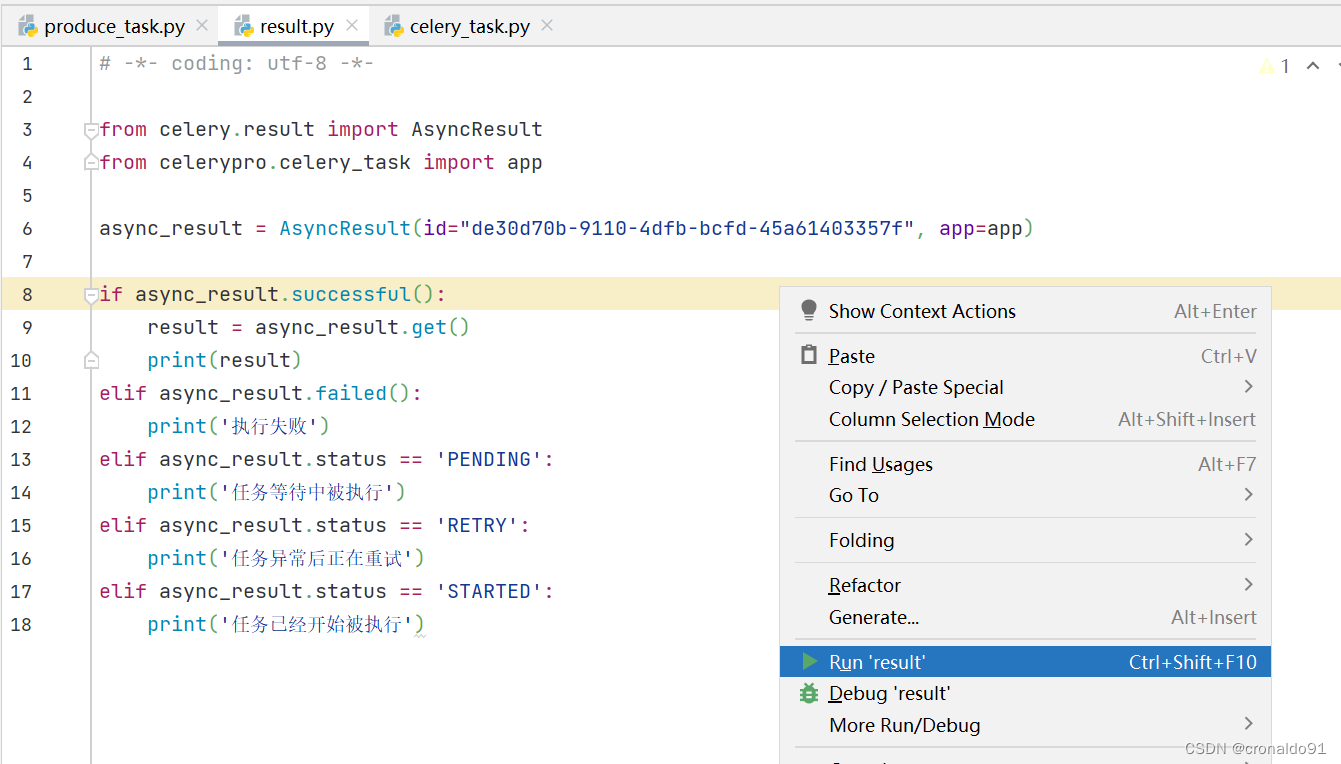

(14)创建py文件:result.py,查看任务执行结果

取第2个id:de30d70b-9110-4dfb-bcfd-45a61403357f

# -*- coding: utf-8 -*-

from celery.result import AsyncResult

from celerypro.celery_task import app

async_result = AsyncResult(id="de30d70b-9110-4dfb-bcfd-45a61403357f", app=app)

if async_result.successful():result = async_result.get()print(result)

elif async_result.failed():print('执行失败')

elif async_result.status == 'PENDING':print('任务等待中被执行')

elif async_result.status == 'RETRY':print('任务异常后正在重试')

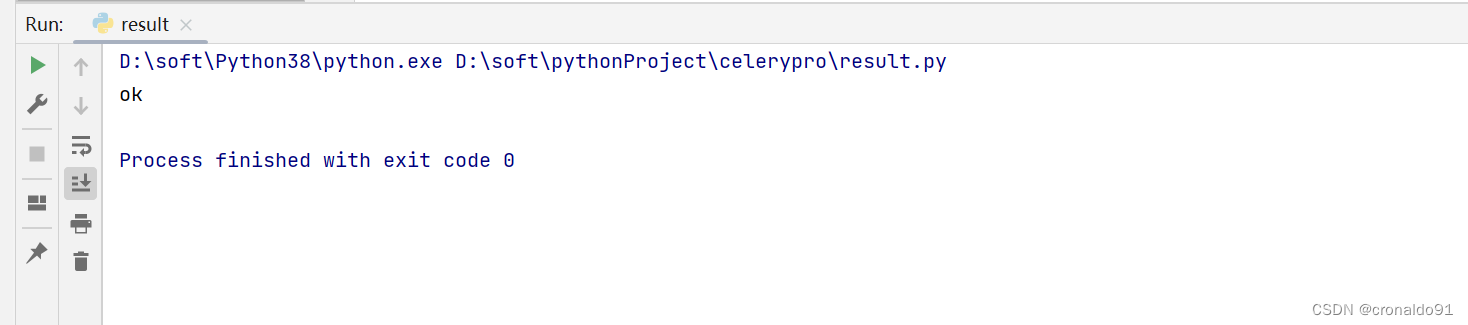

elif async_result.status == 'STARTED':print('任务已经开始被执行')(15) 运行result.py文件

(16)输出ok

(17)Redis可视化界面查看最后2次的task

3.celery的多目录结构异步执行

(1)原目录结构

(2)优化目录结构

(3)消费者celery_main.py

# -*- coding: utf-8 -*-

#消费者

from celery import Celery

app = Celery('celery_demo',backend='redis://localhost:6379/1',broker='redis://localhost:6379/2',include=['celery_tasks.task01','celery_tasks.task02'])

# 时区

app.conf.timezone = 'Asia/Shanghai'

# 是否使用UTC

app.conf.enable_utc = False

(2) 任务一task01.py

# -*- coding: utf-8 -*-

#task01

import time

from celery_tasks.celery_main import app

@app.task

def send_email(res):print("完成向%s发送邮件任务"%res)time.sleep(5)return "邮件完成!"

(3) 任务二task02.py

# -*- coding: utf-8 -*-

#task02

import time

from celery_tasks.celery_main import app

@app.task

def send_msg(name):print("完成向%s发送短信任务"%name)time.sleep(5)return "短信完成!"

(4) 在项目文件目录下创建worker消费任务

PS D:\soft\pythonProject\CeleryMTask> celery --app=celery_tasks.celery worker -n node1 -l INFO -P eventlet

(5)生产者produce_task.py

# -*- coding: utf-8 -*-

# 生产者

from CeleryMTask import celery_tasks

from celery_tasks.task01 import send_email

from celery_tasks.task02 import send_msg

result = send_email.delay("jack")

print(result.id)

result2 = send_msg.delay("alice")

print(result2.id)(5)运行生产者生产者produce_task.py

(6) 异步结果检查check_result

# -*- coding: utf-8 -*-

# 异步结果检查

from celery.result import AsyncResult

from celery_tasks.celery_main import app

async_result = AsyncResult(id="bb906153-822a-4bd5-aacd-2f2172d3003a", app=app)

if async_result.successful():result = async_result.get()print(result)

elif async_result.failed():print('执行失败')

elif async_result.status == 'PENDING':print('任务等待中被执行')

elif async_result.status == 'RETRY':print('任务异常后正在重试')

elif async_result.status == 'STARTED':print('任务已经开始被执行')

(7) 运行异步结果检查check_result

(8)查看运行结果

(8)查看Terminal输出

4.celery简单结构下的定时任务

(1)基于celerypro简单结构,源目录结构如下

(2) 设定时间让celery执行一个定时任务,新建time.py

# -*- coding: utf-8 -*-

from celerypro.celery_task import send_email

from datetime import datetime

v1 = datetime(2023, 11, 24, 20, 7, 00)

print(v1)

# 时间戳timestamp,国标时间方法utcfromtimestamp,

v2 = datetime.utcfromtimestamp(v1.timestamp())

print(v2)

#调异步任务建议用delay方法,掉定时任务建议用apply_async方法来接纳更多参数,

#参数放列表,eta接收时间对象

result = send_email.apply_async(args=["leon",], eta=v2)

print(result.id)

(3)在项目文件目录下创建worker消费任务

PS D:\soft\pythonProject> celery --app=celerypro.celery_task worker -n node1 -l INFO -P eventlet

(4)运行time.py文件

(5)查看RUN运行结果

(6)等待指定时间,查看Terminal

(7) 利用时差方式让celery执行一个定时任务,修改time.py

# -*- coding: utf-8 -*-

from celerypro.celery_task import send_email

from datetime import datetime

from datetime import timedelta

#当前时间

ctime = datetime.now()

# 默认用utc时间

# 时间戳timestamp,国标时间方法utcfromtimestamp,

utc_ctime = datetime.utcfromtimestamp(ctime.timestamp())

#时差

time_delay = timedelta(seconds=10)

task_time = utc_ctime + time_delay

# 使用apply_async并设定时间

result = send_email.apply_async(args=["bale"], eta=task_time)

print(result.id)

(8)运行time.py文件

(9)查看RUN运行结果

(10)等待10秒,查看Terminal

(11)Redis可视化界面查看最后2次的task

三、问题

1.Celery命令报错

(1)报错

(2)原因分析

celery版本不同命令不同。

查看帮助命令

PS D:\soft\pythonProject> celery --help

Usage: celery [OPTIONS] COMMAND [ARGS]...Celery command entrypoint.Options:-A, --app APPLICATION-b, --broker TEXT--result-backend TEXT--loader TEXT--config TEXT--workdir PATH-C, --no-color-q, --quiet--version--skip-checks Skip Django core checks on startup. Setting theSKIP_CHECKS environment variable to any non-emptystring will have the same effect.--help Show this message and exit.Commands:amqp AMQP Administration Shell.beat Start the beat periodic task scheduler.call Call a task by name.control Workers remote control.events Event-stream utilities.graph The ``celery graph`` command.inspect Inspect the worker at runtime.list Get info from broker.logtool The ``celery logtool`` command.migrate Migrate tasks from one broker to another.multi Start multiple worker instances.purge Erase all messages from all known task queues.report Shows information useful to include in bug-reports.result Print the return value for a given task id.shell Start shell session with convenient access to celery symbols.status Show list of workers that are online.upgrade Perform upgrade between versions.worker Start worker instance.

PS D:\soft\pythonProject> celery worker --help

Usage: celery worker [OPTIONS]Start worker instance.Examples--------$ celery --app=proj worker -l INFO$ celery -A proj worker -l INFO -Q hipri,lopri$ celery -A proj worker --concurrency=4$ celery -A proj worker --concurrency=1000 -P eventlet$ celery worker --autoscale=10,0Worker Options:-n, --hostname HOSTNAME Set custom hostname (e.g., 'w1@%%h').Expands: %%h (hostname), %%n (name) and %%d,(domain).-D, --detach Start worker as a background process.-S, --statedb PATH Path to the state database. The extension'.db' may be appended to the filename.-l, --loglevel [DEBUG|INFO|WARNING|ERROR|CRITICAL|FATAL]Logging level.-O, --optimization [default|fair]Apply optimization profile.--prefetch-multiplier <prefetch multiplier>Set custom prefetch multiplier value forthis worker instance.Pool Options:-c, --concurrency <concurrency>Number of child processes processing thequeue. The default is the number of CPUsavailable on your system.-P, --pool [prefork|eventlet|gevent|solo|processes|threads|custom]Pool implementation.-E, --task-events, --events Send task-related events that can becaptured by monitors like celery events,celerymon, and others.--time-limit FLOAT Enables a hard time limit (in secondsint/float) for tasks.--soft-time-limit FLOAT Enables a soft time limit (in secondsint/float) for tasks.--max-tasks-per-child INTEGER Maximum number of tasks a pool worker canexecute before it's terminated and replacedby a new worker.--max-memory-per-child INTEGER Maximum amount of resident memory, in KiB,that may be consumed by a child processbefore it will be replaced by a new one. Ifa single task causes a child process toexceed this limit, the task will becompleted and the child process will bereplaced afterwards. Default: no limit.--scheduler TEXTDaemonization Options:-f, --logfile TEXT Log destination; defaults to stderr--pidfile TEXT--uid TEXT--gid TEXT--umask TEXT--executable TEXTOptions:--help Show this message and exit.

(3)解决方法

修改命令

PS D:\soft\pythonProject> celery --app=celerypro.celery_task worker -n node1 -l INFO

成功

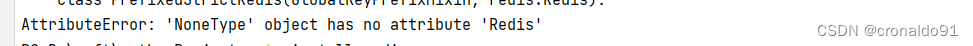

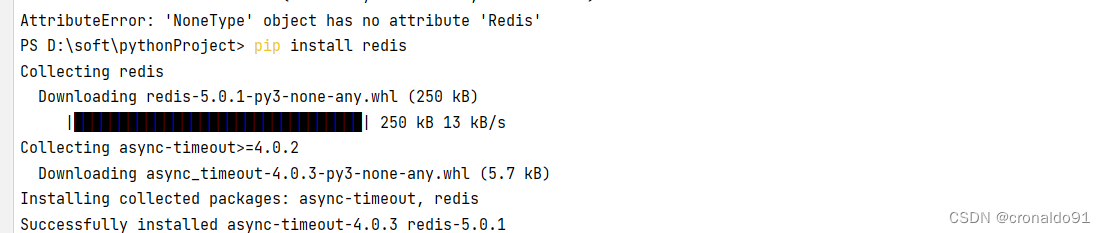

2.执行Celery命令报错

(1)报错

AttributeError: 'NoneType' object has no attribute 'Redis'

(2)原因分析

PyCharm未安装redis插件。

(3)解决方法

安装redis插件

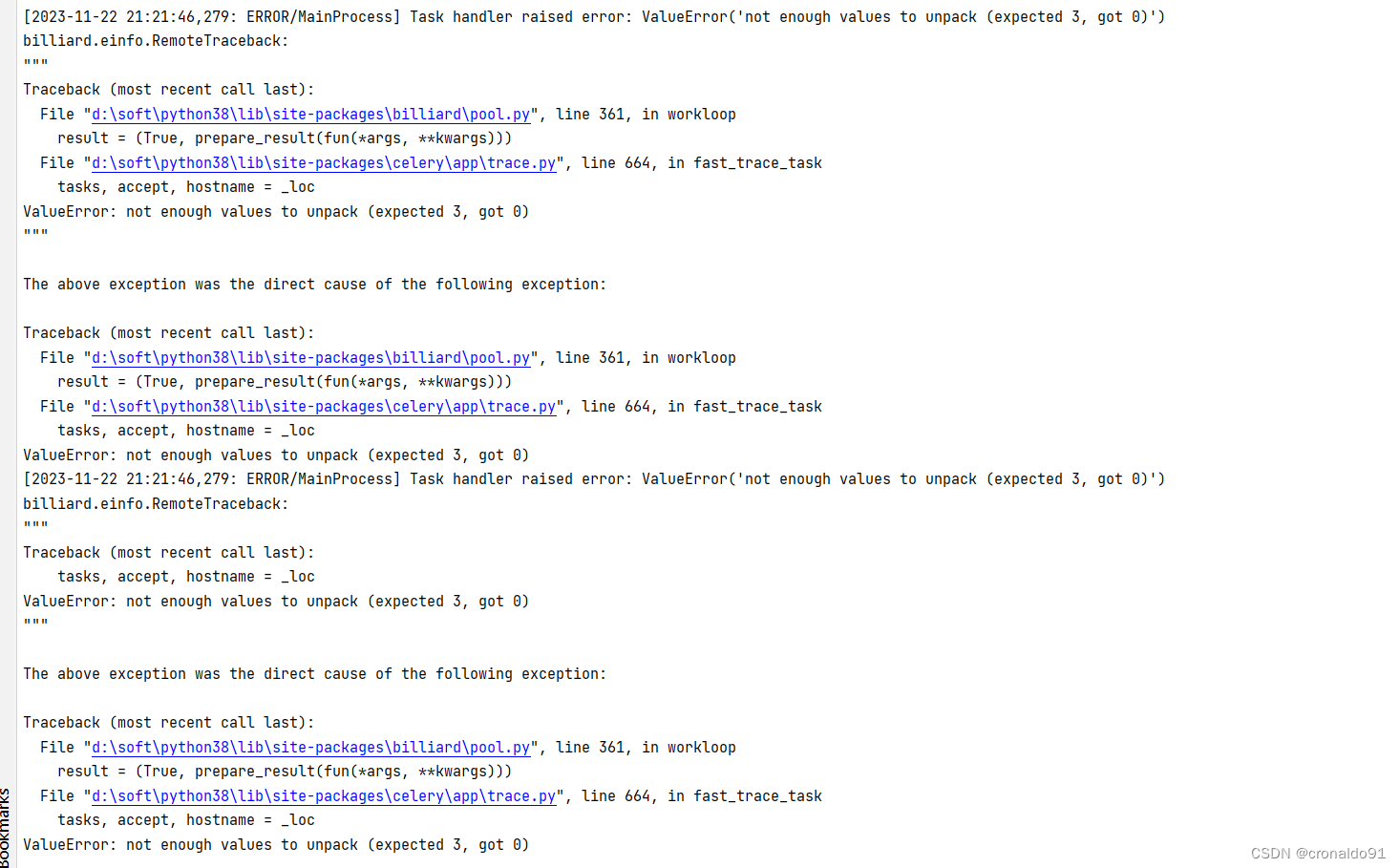

3.Win11启动Celery报ValueErro错误

(1)报错

Windows 在开发 Celery 异步任务,通过命令 celery --app=celerypro.celery_task worker -n node1 -l INFO 启动 Celery 服务后正常;

但在使用 delay() 调用任务时会出现以下报错信息:

Task handler raised error: ValueError('not enough values to unpack (expected 3, got 0)')

(2)原因分析

PyCharm未安装eventlet

(3)解决方法

安装包 eventlet

pip install eventlet

通过以下命令启动服务

celery --app=celerypro.celery_task worker -n node1 -l INFO -P eventlet

4.Pycharm 无法 import 同目录下的 .py 文件或自定义模块

(1)报错

(2)原因分析

pycharm 默认情况下只检索项目根目录下的py文件,当引用的py文件不在项目根目录时,,会出现错误。

(3)解决方法

需将要引用的py文件所在的文件夹添加到默认搜索搜索文件夹即可:

方法一

右键py文件所在的文件夹,依次点击:MarkDircetory as -> Sources Root

方法二

将py文件所在文件夹作为一个package,在py文件所在文件夹下新建__init__.py文件,在__init__.py中添加如下语句:

from [py文件所在文件夹名].[py文件名] import 模块名相关文章:

Python开发运维:Celery连接Redis

目录 一、理论 1.Celery 二、实验 1.Windows11安装Redis 2.Python3.8环境中配置Celery 3.celery的多目录结构异步执行 4.celery简单结构下的定时任务 三、问题 1.Celery命令报错 2.执行Celery命令报错 3.Win11启动Celery报ValueErro错误 4.Pycharm 无法 import 同目…...

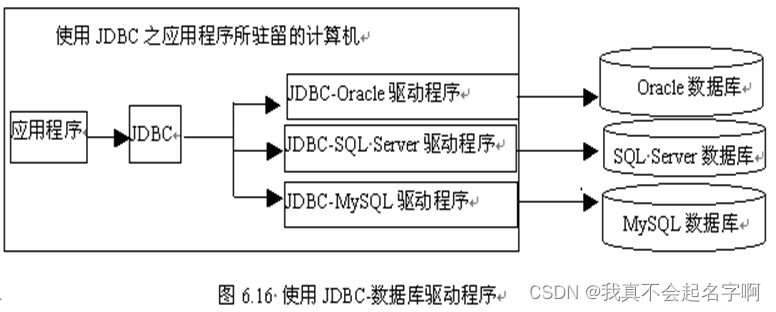

JSP:JDBC

JDBC(Java Data Base Connectivity的缩写)是Java程序操作数据库的API,也是Java程序与数据库相交互的一门技术。 JDBC是Java操作数据库的规范,由一组用Java语言编写的类和接口组成,它对数据库的操作提供基本方法&#…...

能否在一台电脑上安全地登录多个Facebook账号?

Facebook是一个流量大、用户多的平台,许多人可能需要在一台设备上管理多个Facebook账号,无论是出于个人或职业需求,都能带来极大地便利。然而,保持每个账号的安全性和隐私性却是一个挑战。本文将介绍如何在一台电脑上安全地登录多…...

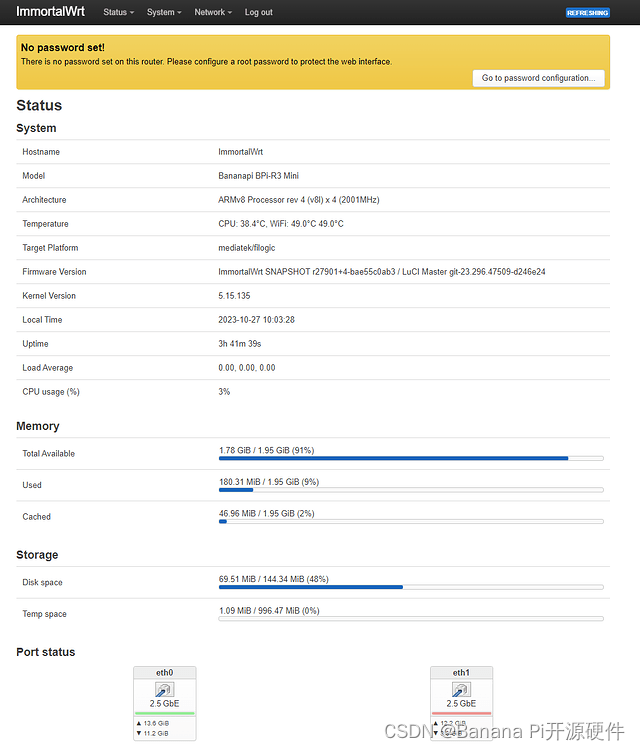

Banana Pi [BPi-R3-Mini] 回顾和主线 ImmortalWrt 固件支持

BananaPi BPi-R3 Mini 采用 MediaTek 830(4 个 A53,最高 2.0 GHz),具有 2 个 2.5 GbE、AX4200 2.4G/5G 无线和 USB 2.0 端口。它还具有两个 M.2 连接器,可用于 NVMe SSD 和 5G 模块(板上包含 Nano SIM 插槽…...

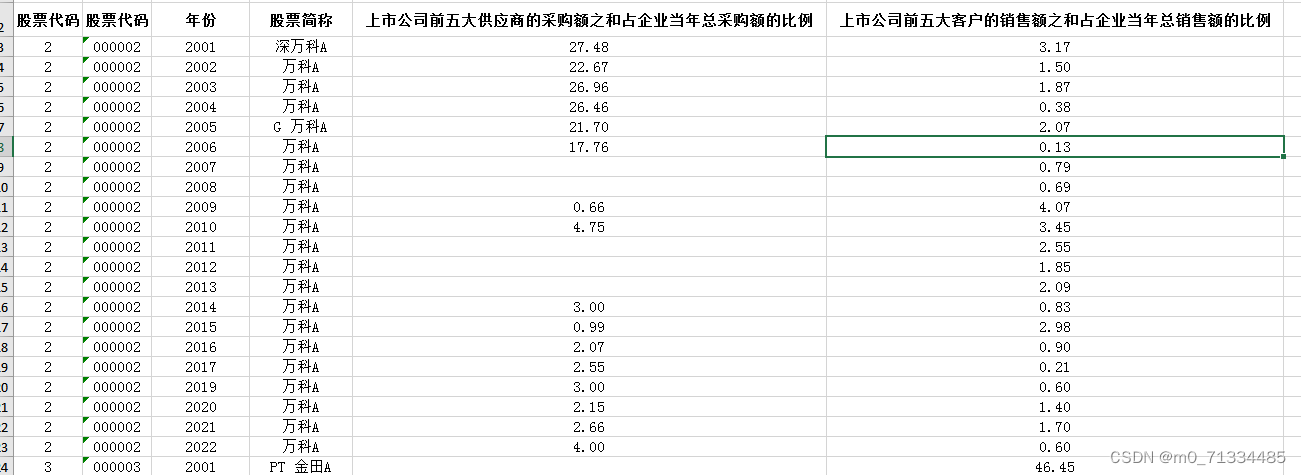

2001-2022年上市公-供应链话语权测算数据(原始数据+处理代码Stata do文档+结果)

2001-2022年上市公-供应链话语权测算数据(原始数据处理代码Stata do文档结果) 1、时间:2001-2022年 2、指标:企业代码、股票代码、年份、股票简称、上市公司前五大供应商的采购额之和占企业当年总采购额的比例、上市公司前五大客…...

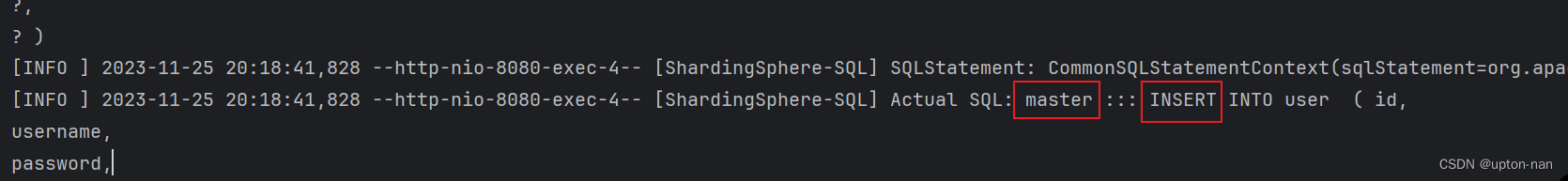

如何通过ShardingJDBC进行读写分离

背景信息: 面对日益增加的系统访问量,数据库的吞吐量面临着巨大瓶颈。 对于同一时刻有大量并发读操作和较少写操作类型的应用系统来说,将数据库拆分为主库和从库。其中主库负责处理事务性的增删改操作,从库负责处理查询操作&#…...

【uniapp】部分图标点击事件无反应

比如:点击这个图标在h5都正常,在小程序上无反应 css:也设置z-index,padding 页面上也试过click.native.stop.prevent"changePassword()" 时而可以时而不行, 最后发现是手机里输入键盘的原因,输…...

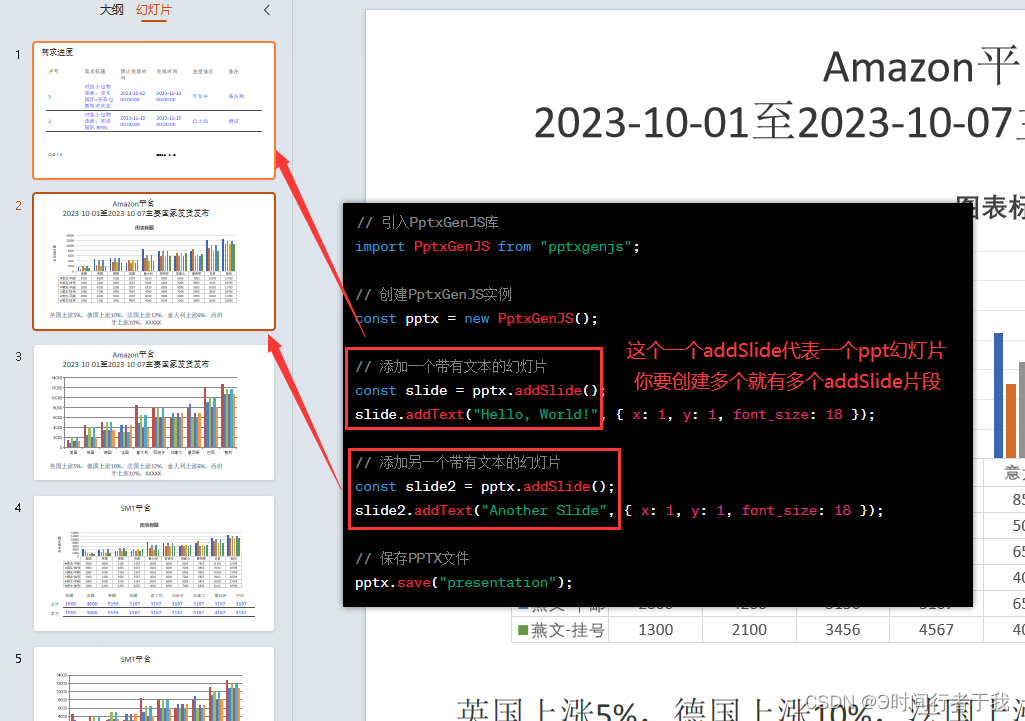

前端vue导出PPT,使用pptxgen.js

前言 公司新需求需要导出ppt给业务用,查阅资料后发现也挺简单的,记录一下。 如有不懂的可以留言!!! 1.安装包 npm install pptxgenjs --save2.引入包 在需要使用的文件中引入 import Pptxgenfrom "pptxgenjs&…...

JSP过滤器和监听器

什么是过滤器 Servlet过滤器与Servlet十分相似,但它具有拦截客户端(浏览器)请求的功能,Servlet过滤器可以改变请求中的内容,来满足实际开发中的需要。 对于程序开发人员而言,过滤器实质就是在Web应用服务…...

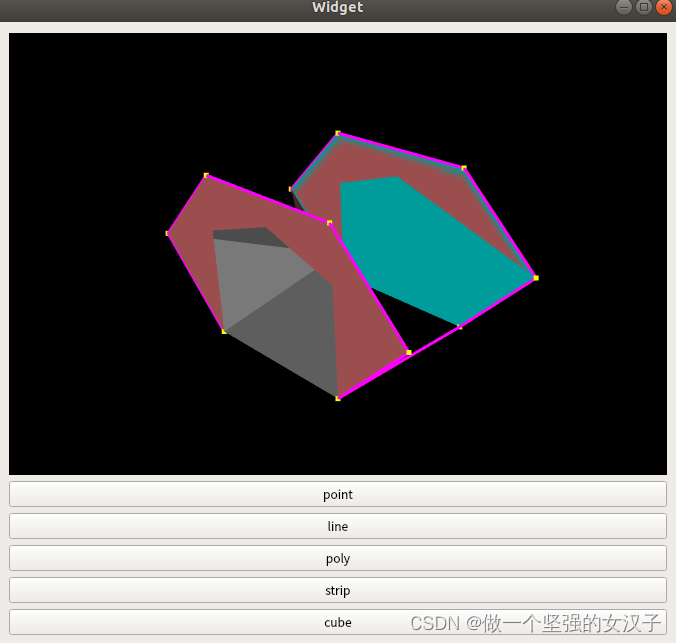

pcl+vtk(十二)使用vtkPolyData创建点、线、面(不规则面)、三角带

一、前言 vtkPlaneSource创建平面,只可以创建平行四边形的平面,根据一个起点和两个终点创建法向量创建平面。但是当有创建多个点围成不规则平面的需求时,该怎么创建显示呢? 在网上查了资料,可以使用vtkPolyData拓扑结…...

51单片机的智能浇花系统【含proteus仿真+程序+报告+原理图】

1、主要功能 该系统由AT89C51单片机LCD1602显示模块DHT11温湿度模块DS1302时间模块继电器驱动水泵模块光敏传感器等模块构成。适用于智能浇花、自动浇花、智能盆栽等相似项目。 可实现基本功能: 1、LCD1602实时显示北京时间、土壤温湿度、光照强度等信息 2、DHT11采集温湿度信…...

为什么 MQTT 对于构建联网汽车至关重要

汽车行业正在接受构建联网汽车的想法。他们看到了利用车辆遥测数据创造新收入机会并打造更好用户体验的机会。然而,实施可扩展以支持数百万辆汽车的联网汽车服务可能会带来一些挑战。 对于大多数联网汽车服务,汽车和云之间需要进行双向通信。汽车将遥测…...

CSIT883系统分析与项目管理——Lecture2重点概念

一、前言 这个是本人的学习笔记,如果大家喜欢可以多多关注吧! 二、重点概念 1.项目经理及其团队必须认识到任何项目对整个系统或组织的利益和需求的影响,而不是关注项目的直接问题。 2.系统愿景文件的目的是什么? 系统愿景文档是描述问题、解决方案、系统目标等的简短声…...

【linux】基本指令(中篇)

echo指令 将引号内容打印到显示屏上 输出的重定向 追加的重定向 输出的重定向 我们学习c语言的时候当以写的方式创建一个文件,就会覆盖掉该文件之前的内容 当我们以追加的方式打开文件的时候,原文件内容不会被覆盖而是追加 more指令 10.more指令…...

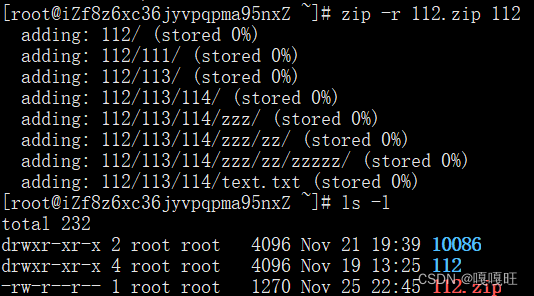

Centos Download

前言 CentOS Linux 是一个社区支持的发行版,源自 CentOS git for Red Hat Enterprise Linux (RHEL) 上免费提供给公众的源代码。因此,CentOS Linux 的目标是在功能上与 RHEL 兼容。CentOS 计划主要更改组件以删除上游供应商的品牌…...

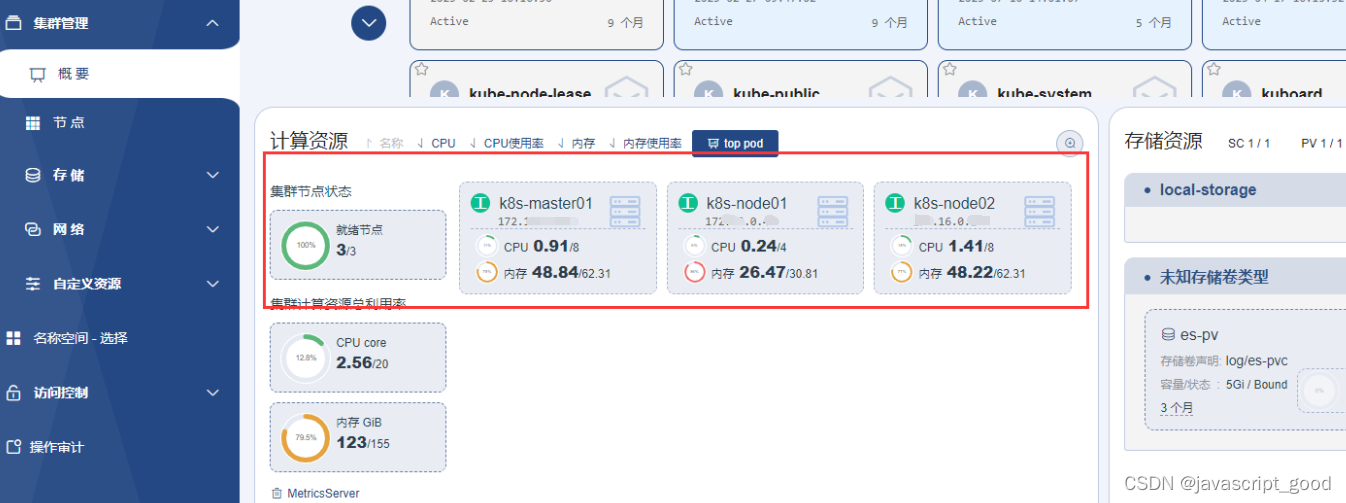

k8s集群资源监控工具metrics-server安装

1、下载镜像 docker pull swr.cn-east-2.myhuaweicloud.com/kuboard-dependency/metrics-server:v0.6.22、在任一一个主节点上创建角色,执行下面语句 kubectl create clusterrolebinding kube-proxy-cluster-admin --clusterrolecluster-admin --usersystem:kube-…...

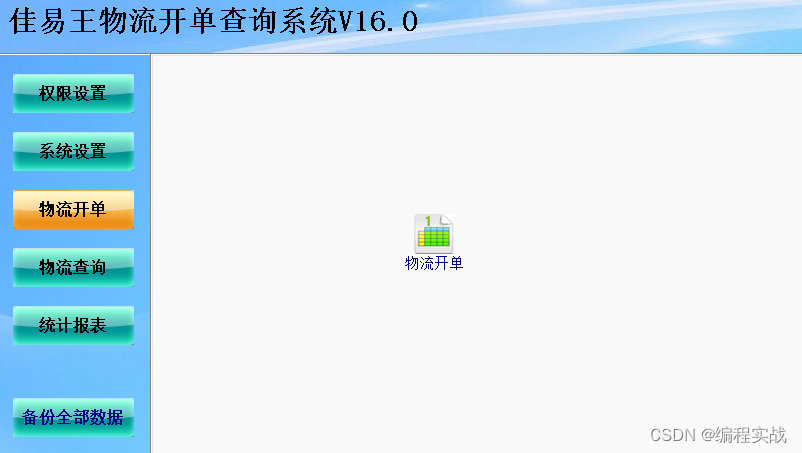

物流单打印模板下载,佳易王物流托运单打印软件

物流单打印模板下载,佳易王物流托运单打印软件 上图是常用的物流单打印模板,佳易王物流单打印软件打印格式可以根据需要定制更改。 软件特色: 1、功能实用,操作简单,不会电脑也会操作,软件免安装ÿ…...

TrustAsia亮相Matter开发者大会,荣获Matter优秀赋能者奖

11月22日,由CSA(连接标准联盟)中国成员组主办,CSHIA承办的“Matter中国区开发者大会2023” 于杭州举行。 会上,连接标准联盟中国成员组主席宿为民博士、连接标准联盟亚洲区架构师杨莉女士、CSHIA秘书长|中智盟投资创始…...

)

java 事务提交(批量处理数据,单个批次执行完成后直接提交事务)

方法一:接口REQUIRES_NEW 实现单个事务提交 方式1: for (TIrBuPBom buPBom : batchList) {// 查询待处理的批次数据List<TIrBuPBom> pBomList pBomMapperBase.list(new LambdaQueryWrapper<TIrBuPBom>().eq(TIrBuPBom::getBatchNo, buPBom.getBatchNo…...

logging.config 日志模块

logging 日志模块 简单应用: import logging logging.warning(警告!) # 输出结果: WARNING:root:警告!1. 日志等级 - debug 调试 10 最详细的日志信息,典型应用场景是 问题诊断 - info 普通信息 20 信息详细…...

龙虎榜——20250610

上证指数放量收阴线,个股多数下跌,盘中受消息影响大幅波动。 深证指数放量收阴线形成顶分型,指数短线有调整的需求,大概需要一两天。 2025年6月10日龙虎榜行业方向分析 1. 金融科技 代表标的:御银股份、雄帝科技 驱动…...

eNSP-Cloud(实现本地电脑与eNSP内设备之间通信)

说明: 想象一下,你正在用eNSP搭建一个虚拟的网络世界,里面有虚拟的路由器、交换机、电脑(PC)等等。这些设备都在你的电脑里面“运行”,它们之间可以互相通信,就像一个封闭的小王国。 但是&#…...

[2025CVPR]DeepVideo-R1:基于难度感知回归GRPO的视频强化微调框架详解

突破视频大语言模型推理瓶颈,在多个视频基准上实现SOTA性能 一、核心问题与创新亮点 1.1 GRPO在视频任务中的两大挑战 安全措施依赖问题 GRPO使用min和clip函数限制策略更新幅度,导致: 梯度抑制:当新旧策略差异过大时梯度消失收敛困难:策略无法充分优化# 传统GRPO的梯…...

conda相比python好处

Conda 作为 Python 的环境和包管理工具,相比原生 Python 生态(如 pip 虚拟环境)有许多独特优势,尤其在多项目管理、依赖处理和跨平台兼容性等方面表现更优。以下是 Conda 的核心好处: 一、一站式环境管理:…...

Vue记事本应用实现教程

文章目录 1. 项目介绍2. 开发环境准备3. 设计应用界面4. 创建Vue实例和数据模型5. 实现记事本功能5.1 添加新记事项5.2 删除记事项5.3 清空所有记事 6. 添加样式7. 功能扩展:显示创建时间8. 功能扩展:记事项搜索9. 完整代码10. Vue知识点解析10.1 数据绑…...

Go 语言接口详解

Go 语言接口详解 核心概念 接口定义 在 Go 语言中,接口是一种抽象类型,它定义了一组方法的集合: // 定义接口 type Shape interface {Area() float64Perimeter() float64 } 接口实现 Go 接口的实现是隐式的: // 矩形结构体…...

【Go】3、Go语言进阶与依赖管理

前言 本系列文章参考自稀土掘金上的 【字节内部课】公开课,做自我学习总结整理。 Go语言并发编程 Go语言原生支持并发编程,它的核心机制是 Goroutine 协程、Channel 通道,并基于CSP(Communicating Sequential Processes࿰…...

Spring Boot面试题精选汇总

🤟致敬读者 🟩感谢阅读🟦笑口常开🟪生日快乐⬛早点睡觉 📘博主相关 🟧博主信息🟨博客首页🟫专栏推荐🟥活动信息 文章目录 Spring Boot面试题精选汇总⚙️ **一、核心概…...

Spring AI 入门:Java 开发者的生成式 AI 实践之路

一、Spring AI 简介 在人工智能技术快速迭代的今天,Spring AI 作为 Spring 生态系统的新生力量,正在成为 Java 开发者拥抱生成式 AI 的最佳选择。该框架通过模块化设计实现了与主流 AI 服务(如 OpenAI、Anthropic)的无缝对接&…...

大学生职业发展与就业创业指导教学评价

这里是引用 作为软工2203/2204班的学生,我们非常感谢您在《大学生职业发展与就业创业指导》课程中的悉心教导。这门课程对我们即将面临实习和就业的工科学生来说至关重要,而您认真负责的教学态度,让课程的每一部分都充满了实用价值。 尤其让我…...