HiDataPlus 3.3.2-005 搭建(个人的一点心得体会 x86 平台)

HDP 集群搭建

前置安装

yum -y install createrepo

yum install -y lrzsz

yum install -y wget

yum install -y vim修改当前集群机器的主机名

hostnamectl set-hostname XXX

这里的 XXX 就是要设置的当前机器的主机名称。主机名称是集群唯一的,一定不要重复!

安装基础环境

rpm -qa | grep java rpm -e --nodeps 旧包mkdir /opt/download /opt/software

echo 'export JAVA_HOME=/opt/software/jdk1.8.0_311' >> /etc/profile

echo 'export PATH=$JAVA_HOME/bin:$PATH:' >> /etc/profile

配置主机间的映射 - 3

echo '192.168.3.126 hdp3.node1' >> /etc/hosts

echo '192.168.3.127 hdp3.node2' >> /etc/hosts

echo '192.168.3.128 hdp3.node3' >> /etc/hosts关闭防火墙及selinux - 3

systemctl stop firewalld.service | systemctl disable firewalld.service | systemctl status firewalld.service | setenforce 0 | sed -i 's/SELINUX=enforcing/SELINUX=disabled/' /etc/selinux/config

重启3台机器后进行验证是否修改成功

# sestatus -v

SELinux status: disabled

配置ssh互信 - 3

ssh-keygen -t rsa

ssh-copy-id hdp3.node1

ssh-copy-id hdp3.node2

ssh-copy-id hdp3.node3

配置ntp时钟同步 - 3台

卸载系统原装的chrony

yum -y remove chronyd

所有节点安装NTP服务

yum -y install ntp

systemctl restart ntpd

systemctl enable ntpd.servicerpm包检查关闭

sed -i 's/gpgcheck=1/gpgcheck=0/' /etc/yum.conf

安装http服务 - 本服务仅安装在解压了安装包的机器上

yum -y install httpd

systemctl start httpd

systemctl enable httpd.service安装Ambari&HDP - 主

cd /opt/download/HDP3.3.2.0-005/

mkdir /var/www/html/ambari

mkdir /var/www/html/HDP

mkdir /var/www/html/HDP-UTILS

mkdir /var/www/html/HDP-GPL

tar -zxvf ambari-2.7.6.0-25-redhat7-x86_64.tar.gz -C /var/www/html/ambari

tar -zxvf HDP-3.3.2.0-005-redhat789-x86_64-2.tar.gz -C /var/www/html/HDP

tar -zxvf HDP-UTILS-1.1.0.22-centos7_8-x86_64.tar.gz -C /var/www/html/HDP-UTILS/

tar -zxvf HDP-GPL-3.3.2.0-005-redhat789-x86_64.tar.gz -C /var/www/html/HDP-GPL/

cd /var/www/html/

chown -R root:root HDP

chown -R root:root HDP-GPL

chown -R root:root HDP-UTILS

chmod -R 755 HDP

chmod -R 755 HDP-GPL

chmod -R 755 HDP-UTILScreaterepo /var/www/html/ambari/2.7.6.0-25/安装mariadb - 主

rpm -qa |grep -i mysql

rpm -qa |grep -i mariadb

rpm -e --nodeps 旧包

yum install mariadb-server -ysystemctl enable mariadb

systemctl start mariadb# 初始化 mariadb

/usr/bin/mysql_secure_installation按照以下过程进行 mariadb 的初始化操作

[...]

Enter current password for root (enter for none):

OK, successfully used password, moving on...

[...]

Set root password? [Y/n] Y

New password:123456

Re-enter new password:123456

[...]

Remove anonymous users? [Y/n] Y

[...]

Disallow root login remotely? [Y/n] N

[...]

Remove test database and access to it [Y/n] Y

[...]

Reload privilege tables now? [Y/n] Y

[...]

All done! If you've completed all of the above steps, your MariaDB 18 installation should now be secure.

Thanks for using MariaDB!初始化完成后开始准备 mariadb 连接器

mkdir /usr/share/java/

# 上传mysql连接器

cp mysql-connector-java-5.1.40-bin.jar /usr/share/java/mysql-connector-java.jar

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%'WITH GRANT OPTION;

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123456';FLUSH PRIVILEGES;# 如果需要ranger,编辑以下⽂件: vi /etc/my.cnf 并添加以下⾏:

# vi /etc/my.cnfecho "log_bin_trust_function_creators = 1" >> /etc/my.cnf# 重启并登陆

systemctl restart mariadb

mysql -uroot -p123456制作本地源 - 3台机器

这里需要注意,baseurl 属性所对应的 http 地址就是之前我们安装 http 服务的机器。路径就是将 /var/www/http/ 替换为 http://hostname/ 后续路径不变。

touch /etc/yum.repos.d/ambari.repoecho "[Ambari]" >> /etc/yum.repos.d/ambari.repo

echo "name=ambari" >> /etc/yum.repos.d/ambari.repo

echo "baseurl=http://hdp3.node1/ambari/2.7.6.0-25/" >> /etc/yum.repos.d/ambari.repo# 重新创建 Yum 源

yum clean all

yum makecatch

yum repolist安装和配置ambari-server - 主

mkdir -p /var/lib/ambari-server/resources/

yum install -y ambari-server --nogpgcheckcp /usr/share/java/mysql-connector-java.jar /var/lib/ambari-server/resources/# --------------------------------- 添加

# vim /etc/ambari-server/conf/ambari.properties

echo "server.jdbc.driver.path=/usr/share/java/mysql-connector-java.jar" >> /etc/ambari-server/conf/ambari.propertiesambari-server setup --jdbc-db=mysql --jdbc-driver=/usr/share/java/mysql-connector-java.jar初始化ambari-server - 主

登录mariadb创建ambari安装所需要的库

mysql -uroot -pRhein.2023

CREATE DATABASE ambari;

use ambari; set global validate_password_policy=0;

set global validate_password_length=1;CREATE USER 'ambari'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'ambari'@'%';

CREATE USER 'ambari'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'ambari'@'localhost';

CREATE USER 'ambari'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'ambari'@'hdp3.node1'; source /var/lib/ambari-server/resources/Ambari-DDL-MySQL-CREATE.sqlshow tables;

use mysql;

select host,user from user where user='ambari';

CREATE DATABASE hive;

use hive;

CREATE USER 'hive'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hive'@'%';

CREATE USER 'hive'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hive'@'localhost';

CREATE USER 'hive'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hive'@'hdp3.node1'; CREATE DATABASE oozie;

use oozie;

CREATE USER 'oozie'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'oozie'@'%';

CREATE USER 'oozie'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'oozie'@'localhost';

CREATE USER 'oozie'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'oozie'@'hdp3.node1'; CREATE DATABASE hue;

use hue;

CREATE USER 'hue'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hue'@'%';

CREATE USER 'hue'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hue'@'localhost';

CREATE USER 'hue'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'hue'@'hdp3.node1'; CREATE DATABASE dolphinscheduler;

use dolphinscheduler;

CREATE USER 'dolphinscheduler'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'dolphinscheduler'@'%';

CREATE USER 'dolphinscheduler'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'dolphinscheduler'@'localhost';

CREATE USER 'dolphinscheduler'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'dolphinscheduler'@'hdp3.node1'; CREATE DATABASE druid;

use druid;

CREATE USER 'druid'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'druid'@'%';

CREATE USER 'druid'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'druid'@'localhost';

CREATE USER 'druid'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'druid'@'hdp3.node1'; CREATE DATABASE superset;

use superset;

CREATE USER 'superset'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'superset'@'%';

CREATE USER 'superset'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'superset'@'localhost';

CREATE USER 'superset'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'superset'@'hdp3.node1'; CREATE DATABASE ranger;

use ranger;

CREATE USER 'rangeradmin'@'%' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'rangeradmin'@'%';

CREATE USER 'rangeradmin'@'localhost' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'rangeradmin'@'localhost';

CREATE USER 'rangeradmin'@'hdp3.node1' IDENTIFIED BY '123456';

GRANT ALL PRIVILEGES ON *.* TO 'rangeradmin'@'hdp3.node1'; FLUSH PRIVILEGES;service mysqld restart

ambari-server setup

# (1) 提示是否自定义设置。输入:y

Customize user account for ambari-server daemon [y/n] (n)? y

#(2)ambari-server 守护进程账号。如果直接回车就是默认选择root用户

Enter user account for ambari-server daemon (root):

Adjusting ambari-server permissions and ownership...

#(3)检查防火墙是否关闭

Adjusting ambari-server permissions and ownership...

Checking firewall...

WARNING: iptables is running. Confirm the necessary Ambari ports are accessible. Refer to the Ambari documentation for more details on ports.

OK to continue [y/n] (y)?

# 直接回车

Checking JDK...

Do you want to change Oracle JDK [y/n] (n)? y

[1] Oracle JDK 1.8 + Java Cryptography Extension (JCE) Policy Files 8

[2] Custom JDK

#==============================================================================

#(4)设置JDK。输入:2

Enter choice (1): 2

WARNING: JDK must be installed on all hosts and JAVA_HOME must be valid on all hosts.

WARNING: JCE Policy files are required for configuring Kerberos security. If you plan to use Kerberos,please make sure JCE Unlimited Strength Jurisdiction Policy Files are valid on all hosts.

# 如果上面选择 2 自定义JDK,则需要设置JAVA_HOME。输入:/opt/software/jdk1.8.0_311

Path to JAVA_HOME: /apps/software/jdk1.8.0_311

Validating JDK on Ambari Server...done.GPL License for LZO: https://www.gnu.org/licenses/old-licenses/gpl-2.0.en.html

# 是否安装 GPL

Enable Ambari Server to download and install GPL Licensed LZO packages [y/n] (n)? yCompleting setup...

Configuring database...

#(5)数据库配置。选择:y

Enter advanced database configuration [y/n] (n)? y

Configuring database...

#==============================================================================

Choose one of the following options:

[1] - PostgreSQL (Embedded)

[2] - Oracle

[3] - MySQL/ MariaDB

[4] - PostgreSQL

[5] - Microsoft SQL Server (Tech Preview)

[6] - SQL Anywhere

#==============================================================================

#(6)选择数据库类型。输入:3

Enter choice (3): 3

#(7)设置数据库的具体配置信息,根据实际情况输入,如果和括号内相同,则可以直接回车。如果想重命名,就输入。

Hostname (localhost):node1

Port (3306): 3306

Database name (ambari): ambari

Username (ambari): ambari

Enter Database Password (bigdata):123456

Re-Enter password: 123456

#(8)将Ambari数据库脚本导入到数据库

WARNING: Before starting Ambari Server, you must run the following DDL against the database to create the schema: /var/lib/ambari-server/resources/Ambari-DDL-MySQL-CREATE.sql 这个sql后面会用到,导入数据库

Proceed with configuring remote database connection properties [y/n] (y)? y启动ambari服务 - 主节点

systemctl start ambari-server安装ambari-agent - 3台机器

yum -y install ambari-agent --nogpgcheck

systemctl start ambari-agentsed -i 's/hostname=localhost/hostname=hdp3.node1/' /etc/ambari-agent/conf/ambari-agent.ini

安装 libtirpc-devel - 3

yum -y install libtirpc-devel

WEB端集群部署

登录界面:http://hdp3.node1:8080

默认管理员账户登录, 账户:admin 密码:admin

开始创建相应的集群

在标签 1 的位置输入要创建的集群的名称,名称可以任意。

输入完成后点击标签 2 的 next 继续下一步的安装。

1 - 选择版本,配置yum源

2 - 选择版本并修改本地源地址

3 - 选HDP-3.1(Default Version Definition);

4 - 选Use Local Repository;

5 - 选redhat7(这里因为当前选择的系统是Centos7所以选择 Redhat7 ,如果此处是安装在其他系统上的就要选择对应的系统):

HDP-3.1: http://hdp3.node4/HDP/3.3.2.0-005/

HDP-3.1-GPL: http://hdp3.node4/HDP-GPL/gpl-3.3.2.0-005/

HDP-UTILS-1.1.0.22: http://hdp3.node4/HDP-UTILS/HDP-UTILS/centos7/1.1.0.22/

配置节点和密钥

在主节点执行以下命令:

cat /root/.ssh/id_rsa

将执行的内容放置到web页面指定位置即可

这里继续点击 CONTINUE 即可

之后就可以看到集群正在安装,等待安装成功后点击 NEXT 即可

安装成功后页面如下所示:

点击 Next 后出现如下页面:

Sqoop

Sqoop访问Hive异常:

error:

INFO hive.HiveImport: Connecting to jdbc:hive2://hdp3.node1:2181,hdp3.node2:2181,hdp3.node3:2181/default;serviceDiscoveryMode=zooKeeper;zooKeeperNamespace=hiveserver2

ERROR tool.ImportTool: Import failed: java.io.IOException: Hive exited with status 2at org.apache.sqoop.hive.HiveImport.executeExternalHiveScript(HiveImport.java:253)

解决方案:

1-在 hive 的 conf 目录下创建 beeline-hs2-connection.xml 文件:

hdp 的 conf 目录:/usr/hdp/3.3.2.0-005/hive/conf

vim /usr/hdp/3.3.2.0-005/hive/conf/beeline-hs2-connection.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property><name>beeline.hs2.connection.user</name><value>hive</value>

</property>

<property><name>beeline.hs2.connection.password</name><value>hive</value>

</property>

</configuration>2-新建一个存储格式为textfile的临时表

create table hive_db.hive_01( id string comment 'Id')

row format delimited fields terminated by '\001'

stored as textFile;

3-将数据导入临时表中(Sqoop执行的Import写入到临时表中)

4-通过查询插入的方式将临时表数据导入目标表

insert overwrite table hive_db.news_detail_hive select * from hive_db.news_detail_hive_01;

HDFS 权限检查属性设置

dfs.permissions.enabled

yarn 资源只能使用 50%

增加以下属性的值大小(默认0.2,调整0.3-0.5)

yarn.scheduler.capacity.maximum-am-resource-percent

Hue

默认使用的pg数据库,在安装的时候替换成 mysql 及相关的参数即可。

SeaTunnel

需要前置安装 Hue

Dolphin Scheduler

默认登陆用户密码:

admin

dolphinscheduler123

phoenix连接HBase

/usr/hdp/3.3.2.0-005/phoenix/bin/sqlline.py hdp3.node1:2181

API删除服务

curl -u admin:admin -H "X-Requested-By: ambari" -X PUT -d '{"RequestInfo": {"context":"Stop Service"},"Body":{"ServiceInfo":{"state":"INSTALLED"}}}' http://hdp3.node4:8080/api/v1/clusters/cluster/services/RANGERhdp3.node1 是 ambari 安装机器cluster 是集群名称RANGER 是服务名称curl -u admin:admin -H "X-Requested-By: ambari" -X DELETE http://hdp3.node4:8080/api/v1/clusters/cluster/services/RANGER

Yarn 任务 kill

yarn application -kill application_1704037136405_0001

相关文章:

HiDataPlus 3.3.2-005 搭建(个人的一点心得体会 x86 平台)

HDP 集群搭建 前置安装 yum -y install createrepo yum install -y lrzsz yum install -y wget yum install -y vim修改当前集群机器的主机名 hostnamectl set-hostname XXX 这里的 XXX 就是要设置的当前机器的主机名称。主机名称是集群唯一的,一定不要重复&am…...

【PHP】PHP实现与硬件串口交互,接收硬件发送的实时数据

一、前言 目的:借助虚拟串口软件(VSPD)模拟硬件串口发送数据,使用PHP语言实现接收硬件发送的数据。 我这里的需求是连接天平,把天平的称量数据实时的传送到PHP使用。 使用工具:vspd串口调试工具 使用语…...

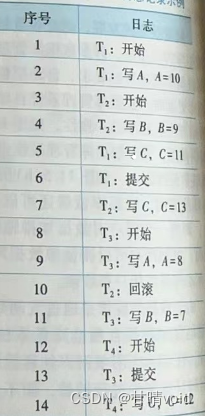

HNU-数据库系统-作业

数据库系统-作业 计科210X 甘晴void 202108010XXX 第一章作业 10.09 1.(名词解释)试述数据、数据库、数据库管理系统、数据库系统的概念。 数据,是描述事物的符号记录。 数据库(DB),是长期存储在计算机内、有组织、可共享的大量…...

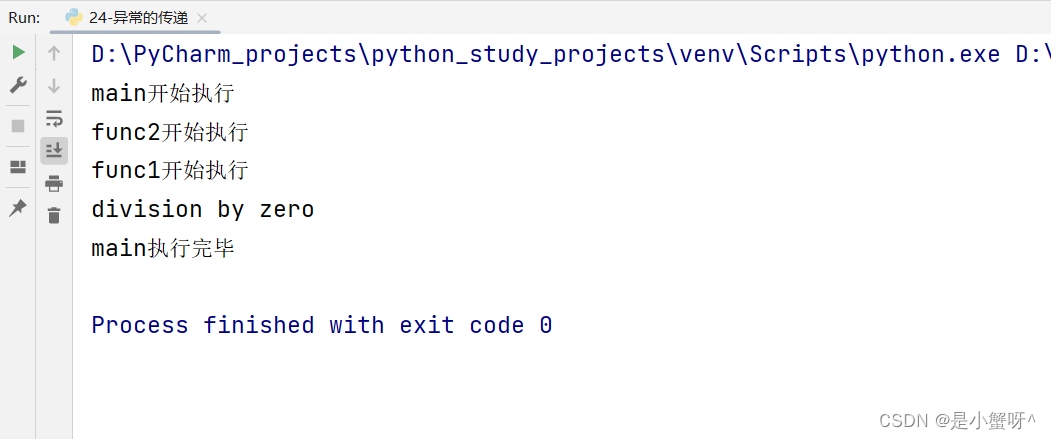

Python基础知识:整理10 异常相关知识

1 异常的捕获 1.1 基础写法 """基本语法:try:可能发生错误的代码except:如果出现异常,将执行的代码""" try:fr open("D:/abc.txt", "r", encoding"utf-8") except:print("出现异常…...

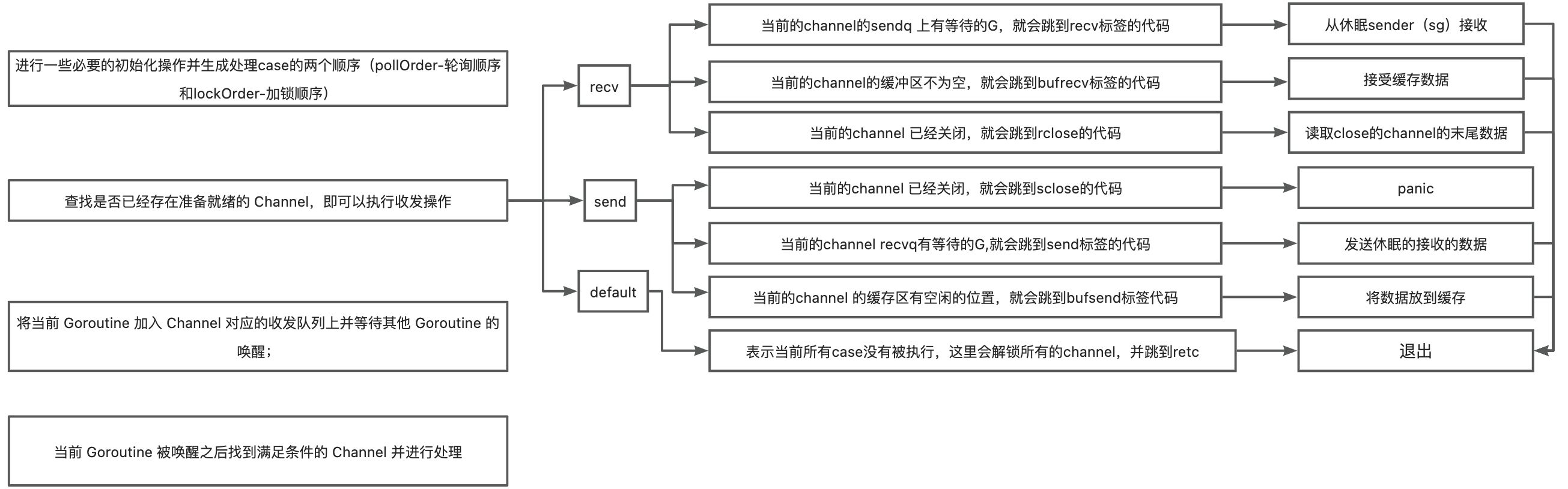

golang并发安全-select

前面说了golang的channel, 今天我们看看golang select 是怎么实现的。 数据结构 type scase struct {c *hchan // chanelem unsafe.Pointer // 数据 } select 非默认的case 中都是处理channel 的 接受和发送,所有scase 结构体中c是用来存储…...

微软Visual Studio产品之Visual C++编程进阶——一维数组(画画版)

我是荔园微风,作为一名在IT界整整25年的老兵,看到不少初学者在学习编程语言的过程中如此的痛苦,我决定做点什么,我小时候喜欢看小人书(连环画),在那个没有电视、没有手机的年代,这是…...

Moonbeam生态项目分析 — — 下一代DeFi协议HydraDX

作者:David 概览 HydraDX是一个基于Substrate区块链框架构建的DeFi协议,旨在为波卡带来大量流动性。HydraDX的特色服务,HydraDX Omnipool,是一种创新的自动化做市商(AMM),通过将所有资产组合在…...

Spark九:Spark调优之Shuffle调优

Spark shuffle调优方法 map端和reduce端缓存大小设置,reduce端重试次数和等待时间间隔,以及bypass设置 学习资料:https://mp.weixin.qq.com/s/caCk3mM5iXy0FaXCLkDwYQ 一、map和reduce端缓冲区大小 1.1 map端 在Spark任务运行过程中&…...

linux c多线程优先级

在 Linux 系统中,可以使用 pthread_setschedparam 函数来设置线程的优先级。该函数需要传入一个指向 pthread_t 类型的线程 ID,以及一个指向 struct sched_param 类型的结构体对象。struct sched_param 结构体包含了线程的优先级信息。 下面是一个示例代…...

Redis在项目开发中的应用

Spring Boot集成Redis构建博客应用 在这个示例中,我们将展示如何使用Spring Boot和Redis构建一个简单的博客应用,包括文章发布、点赞和评论功能。 1. 添加依赖 首先,我们需要在pom.xml文件中添加Spring Boot和Redis的依赖项。 <!-- Sp…...

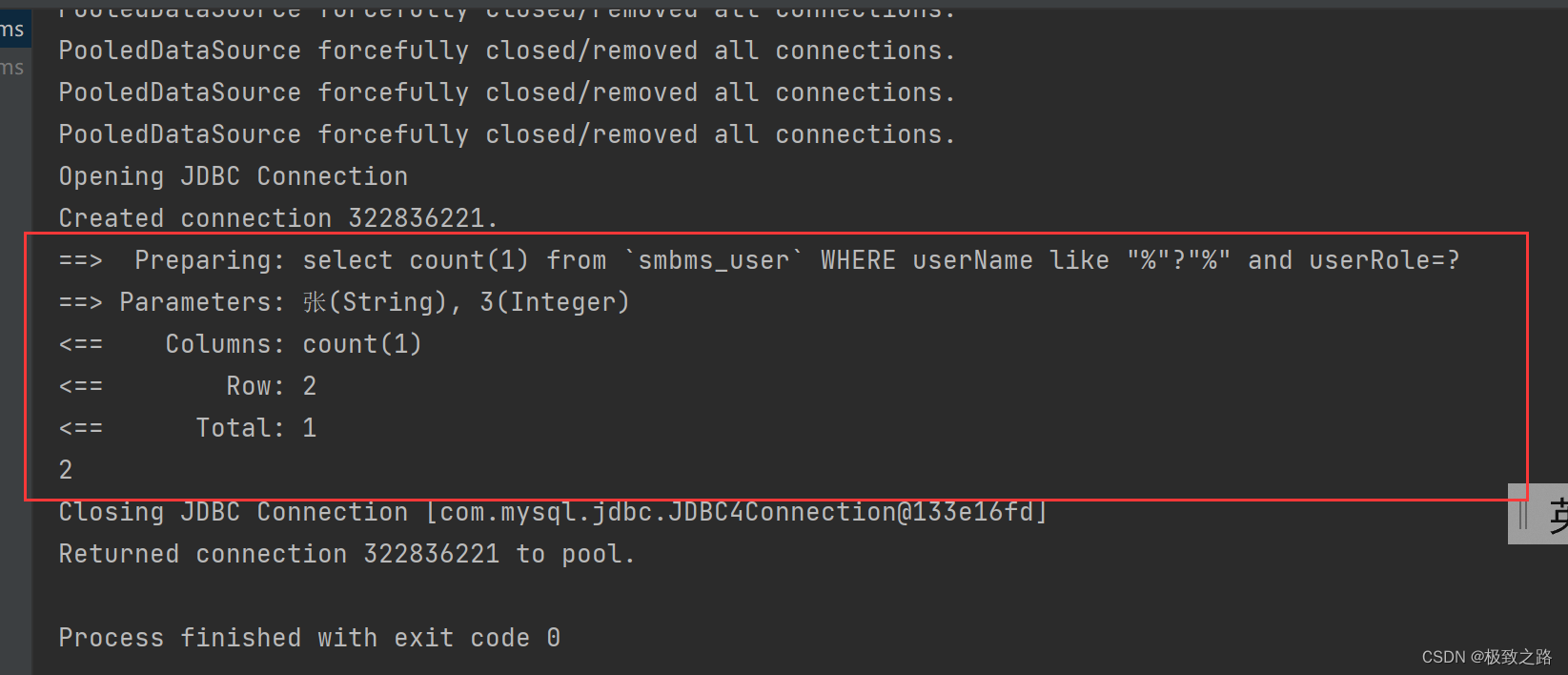

mapper向mapper.xml传参中文时的乱码问题

1.起因: 在idea中进行模糊查询传参时,发现在idea中查中文查不出记录,在navicate中可以查出来。 2.猜测: 1.idea中的编码问题导致的乱码。 2.idea和navicate的编码一致性导致的乱码。 3.mapper向mapper.xml传参后出现乱码。 3.解…...

基于Docker官方php:7.1.33-fpm镜像构建支持67个常见模组的php7.1.33镜像

实践说明:基于RHEL7(CentOS7.9)部署docker环境(23.0.1、24.0.2),所构建的php7.1.33镜像应用于RHEL7-9(如AlmaLinux9.1),但因为docker的特性,适用场景是不限于此的。 文档形成时期:2017-2023年 因系统或软件版本不同&am…...

Type-C PD充电器受电端sink诱骗取电汇总:小家电应用5V9V12V15V20V28V

小家电产品、美容产品、电动产品等升级采用Type-C接口,在Type-C接口上使用Type-C取电芯片,即可使用快速充电器的5V、9V、12V、15V、20V供电,无需再配充电器,各类品牌的充电器都可以支持。目前充电器常见的USB-PD功率为:…...

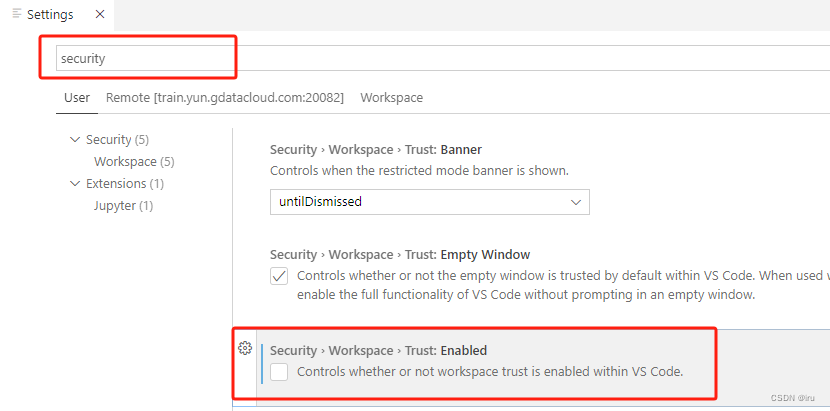

禁用code server docker容器中的工作区信任提示

VSCode 添加受限模式,主要是防止自动运行代码的,比如在vscode配置的task和launch参数是可以运行自定义代码的。如果用VScode打开未知的工程文件就有可能直接运行恶意代码。 但是当我们的实验基础模板文件可控的情况下,要想禁用code server do…...

JSON格式插件-VUE

JsonEditor 安装: npm i bin-code-editor -S引入: import Vue from vue; import CodeEditor from bin-code-editor; import bin-code-editor/lib/style/index.css; import App from ./App.vue; Vue.use(CodeEditor); new Vue({el: #app,render: h > …...

dubbo的springboot集成

1.什么是dubbo? Apache Dubbo 是一款 RPC 服务开发框架,用于解决微服务架构下的服务治理与通信问题,官方提供了 Java、Golang 等多语言 SDK 实现。使用 Dubbo 开发的微服务原生具备相互之间的远程地址发现与通信能力, 利用 Dubbo …...

【人工智能】智能电网:未来能源的革命

未来能源的革命 智能电网革命的意义在于将电力行业从传统的集中式发电和集中式输配电模式转变为智能化、分布式、互动式的能源网络。 现在我们从以下方面详细认真的了解一下智能电网: 智能变电站,智能配电网,智能电能表,智能交互…...

【AIGC】一组精美动物AI智能画法秘诀

如何使用AI绘画,从以下角度,依据表格内容梳理,表格如下: 外貌特征物种姿势特征描述场景风格技术描述小巧可爱幼小浣熊倚在桌子上具有人形特征中世纪酒馆电影风格照明8k分辨率细节精致毛茸茸手持咖啡杯Jean-Baptiste Monge的风格蓝…...

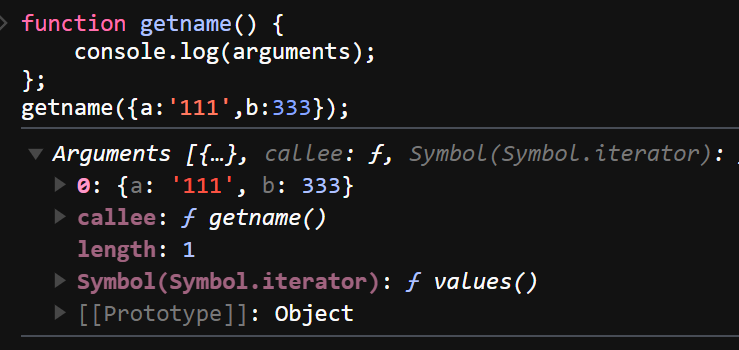

JS 高频面试题

JS 的数据类型有哪些,有什么区别 基本数据类型(Undefined、Null、Boolean、Number、String、Symbol) 引用数据类型(对象、数组和函数) 区别: 原始数据类型直接存储在栈(stack)中的简…...

linux—多服务免密登录

文档结构 概念简介配置操作 概念简介 配置操作 场景:在部署gp集群时,希望 master 节点可以使用gpadmin用户可以实现免密登录 slave1和 slave2 节点; step_1: IP映射 xx.xx.xx.101 server-slave1 xx.xx.xx.102 server-slave2说明&#x…...

深度学习在微纳光子学中的应用

深度学习在微纳光子学中的主要应用方向 深度学习与微纳光子学的结合主要集中在以下几个方向: 逆向设计 通过神经网络快速预测微纳结构的光学响应,替代传统耗时的数值模拟方法。例如设计超表面、光子晶体等结构。 特征提取与优化 从复杂的光学数据中自…...

React Native在HarmonyOS 5.0阅读类应用开发中的实践

一、技术选型背景 随着HarmonyOS 5.0对Web兼容层的增强,React Native作为跨平台框架可通过重新编译ArkTS组件实现85%以上的代码复用率。阅读类应用具有UI复杂度低、数据流清晰的特点。 二、核心实现方案 1. 环境配置 (1)使用React Native…...

自用)

css3笔记 (1) 自用

outline: none 用于移除元素获得焦点时默认的轮廓线 broder:0 用于移除边框 font-size:0 用于设置字体不显示 list-style: none 消除<li> 标签默认样式 margin: xx auto 版心居中 width:100% 通栏 vertical-align 作用于行内元素 / 表格单元格ÿ…...

使用LangGraph和LangSmith构建多智能体人工智能系统

现在,通过组合几个较小的子智能体来创建一个强大的人工智能智能体正成为一种趋势。但这也带来了一些挑战,比如减少幻觉、管理对话流程、在测试期间留意智能体的工作方式、允许人工介入以及评估其性能。你需要进行大量的反复试验。 在这篇博客〔原作者&a…...

scikit-learn机器学习

# 同时添加如下代码, 这样每次环境(kernel)启动的时候只要运行下方代码即可: # Also add the following code, # so that every time the environment (kernel) starts, # just run the following code: import sys sys.path.append(/home/aistudio/external-libraries)机…...

Windows安装Miniconda

一、下载 https://www.anaconda.com/download/success 二、安装 三、配置镜像源 Anaconda/Miniconda pip 配置清华镜像源_anaconda配置清华源-CSDN博客 四、常用操作命令 Anaconda/Miniconda 基本操作命令_miniconda创建环境命令-CSDN博客...

【网络安全】开源系统getshell漏洞挖掘

审计过程: 在入口文件admin/index.php中: 用户可以通过m,c,a等参数控制加载的文件和方法,在app/system/entrance.php中存在重点代码: 当M_TYPE system并且M_MODULE include时,会设置常量PATH_OWN_FILE为PATH_APP.M_T…...

)

【LeetCode】3309. 连接二进制表示可形成的最大数值(递归|回溯|位运算)

LeetCode 3309. 连接二进制表示可形成的最大数值(中等) 题目描述解题思路Java代码 题目描述 题目链接:LeetCode 3309. 连接二进制表示可形成的最大数值(中等) 给你一个长度为 3 的整数数组 nums。 现以某种顺序 连接…...

libfmt: 现代C++的格式化工具库介绍与酷炫功能

libfmt: 现代C的格式化工具库介绍与酷炫功能 libfmt 是一个开源的C格式化库,提供了高效、安全的文本格式化功能,是C20中引入的std::format的基础实现。它比传统的printf和iostream更安全、更灵活、性能更好。 基本介绍 主要特点 类型安全:…...

如何在Windows本机安装Python并确保与Python.NET兼容

✅作者简介:2022年博客新星 第八。热爱国学的Java后端开发者,修心和技术同步精进。 🍎个人主页:Java Fans的博客 🍊个人信条:不迁怒,不贰过。小知识,大智慧。 💞当前专栏…...