【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型

1,关于 fastllm 项目

https://www.bilibili.com/video/BV1fx421k7Mz/?vd_source=4b290247452adda4e56d84b659b0c8a2

【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型

https://github.com/ztxz16/fastllm

🚀 纯c++实现,便于跨平台移植,可以在安卓上直接编译

🚀 ARM平台支持NEON指令集加速,X86平台支持AVX指令集加速,NVIDIA平台支持CUDA加速,各个平台速度都很快就是了

🚀 支持浮点模型(FP32), 半精度模型(FP16), 量化模型(INT8, INT4) 加速

🚀 支持多卡部署,支持GPU + CPU混合部署

🚀 支持Batch速度优化

🚀 支持并发计算时动态拼Batch

🚀 支持流式输出,很方便实现打字机效果

🚀 支持python调用

🚀 前后端分离设计,便于支持新的计算设备

🚀 目前支持ChatGLM系列模型,各种LLAMA模型(ALPACA, VICUNA等),BAICHUAN模型,QWEN模型,MOSS模型,MINICPM模型等

2,本地CPU编译也非常方便

git clone https://github.com/ztxz16/fastllm.gitcd fastllm

mkdir build

cd build

cmake .. -DUSE_CUDA=OFF

make -j

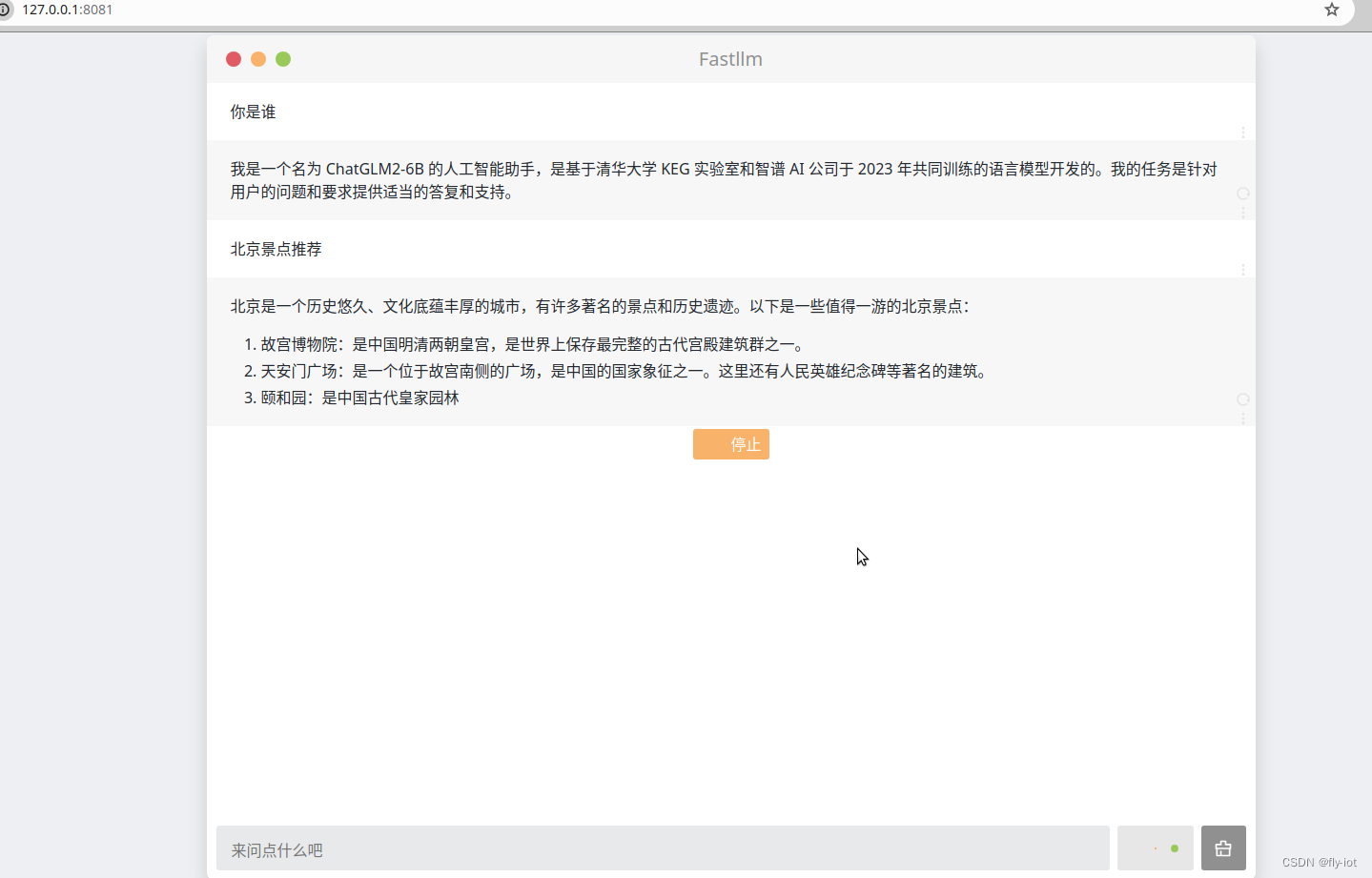

3,运行webui 可以进行交互问答

文件下载:

https://hf-mirror.com/huangyuyang/chatglm2-6b-int4.flm

./webui -p /data/home/test/hf_cache/chatglm2-6b-int4.flm

Load (200 / 200)

Warmup…

finish.

please open http://127.0.0.1:8081

也有打字效果,不知道是咋实现的。好像不是stream 方式的。

3,速度还可以,同时也支持其他的模型

文档地址:

https://github.com/ztxz16/fastllm/blob/master/docs/llama_cookbook.md

LLaMA 类模型转换参考

这个文档提供了了转换LLaMA同结构模型的方法。

LLaMA类模型有着基本相同的结构,但权重和prompt构造有差异。在fastllm中,通过转转模型时修改部分配置,实现对这些变体模型的支持、

声明

以下配置方案根据模型的源代码整理,不保证模型推理结果与原版完全一致。

修改方式

目前,转换脚本和两行加速方式均可用于llama类模型。但无论采用哪一种方式,都需要预留足够的内存(可以用swap空间)。

在float16模式下,转换时约需要4×参数量+1GB的空闲内存。

转换脚本

这里以支持推理各类Llama结构的基座模型为例,介绍如何应用本文档。

- 方案一:修改转换脚本

以alpaca2flm.py为模板修改。在创建model之后添加:

model = LlamaForCausalLM.from_pretrained(model_name).float()# config.json中定义了自己的model_type的需要添加conf = model.config.__dict__conf["model_type"] = "llama"# 接下来的部分各个Chat模型有差别,Base模型有的需要添加pre_prompt。torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "", user_role = "", bot_role = "", history_sep = "", dtype = dtype)

其中,pre_prompt 、user_role 、bot_role 、history_sep分别为“开始的系统提示词(第一轮对话之前)”,“用户角色标志”,“用户话语结束标志及模型回复开始标志”,“两轮对话之间的分隔符”。

- 方案二:修改config.json

在下载的模型目录下,修改配置文件config.json中,修改"model_type"为llama,并增加下面的键-值对:

"pre_prompt": "","user_role": "","bot_role": "","history_sep": "",

如需添加Token ID而非字符串(类似baichuan-chat模型),可以使用“<FLM_FIX_TOKEN_{ID}>”的格式添加。

- 执行脚本

python3 tools/alpaca2flm.py [输出文件名] [精度] [原始模型名称或路径]

对齐tokenizer

如果想使fastllm模型和原版transformers模型基本一致,最主要的操作是对齐tokenizer。

如果模型使用了huggingface 加速版本的Tokenizers(即模型目录中包含tokenizer.json并优先使用),目前的转换脚本仅在从本地文件转换时,能够对齐tokenizer。

注意检查原始tokenizer的encode()方法返回的结果前面是否会加空格。如果原始tokenizer没有加空格,则需要设置:

conf["tokenizer_add_dummy_prefix"] = False

Base Model

一部分模型需要制定bos_token_id,假设bos_token_id为1则可以配置如下:

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "<FLM_FIX_TOKEN_1>", user_role = "", bot_role = "", history_sep = "", dtype = dtype)

Chat Model

对Chat Model,同样是修改转换脚本,或修改模型的config.json,以下是目前常见的chat model的配置:

InternLM(书生)

- internlm/internlm-chat-7b

- internlm/internlm-chat-7b v1.1

- internlm/internlm-chat-20b

conf = model.config.__dict__conf["model_type"] = "llama"torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "<s><s>", user_role = "<|User|>:", bot_role = "<eoh>\n<|Bot|>:", history_sep = "<eoa>\n<s>", dtype = dtype)

可以直接使用llamalike2flm.py脚本转换:

cd build

python3 tools/llamalike2flm.py internlm-7b-fp16.flm float16 internlm/internlm-chat-20b #导出float16模型

python3 tools/llamalike2flm.py internlm-7b-int8.flm int8 internlm/internlm-chat-20b #导出int8模型

python3 tools/llamalike2flm.py internlm-7b-int4.flm int4 internlm/internlm-chat-20b #导出int4模型

python3 tools/llamalike2flm.py internlm-7b-int4.flm float16 internlm/internlm-chat-7b #导出internlm-chat-7b float16模型

XVERSE

- xverse/XVERSE-13B-Chat

- xverse/XVERSE-7B-Chat

conf = model.config.__dict__conf["model_type"] = "llama"conf["tokenizer_add_dummy_prefix"] = Falsetorch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "", user_role = "Human: ", bot_role = "\n\nAssistant: ", history_sep = "<FLM_FIX_TOKEN_3>", dtype = dtype)

XVERSE-13B-Chat V1 版本需要对输入做NFKC规范化,fastllm暂不支持,因此需要使用原始tokenizer.

- xverse/XVERSE-13B-256K

该模型没有将RoPE外推参数放到config中,因此需要手工指定:

conf = model.config.__dict__conf["model_type"] = "llama"conf["rope_theta"] = 500000conf["rope_scaling.type"] = "dynamic"conf["rope_scaling.factor"] = 2.0conf["tokenizer_add_dummy_prefix"] = Falsetorch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "", user_role = "Human: ", bot_role = "\n\nAssistant: ", history_sep = "<FLM_FIX_TOKEN_3>", dtype = dtype)

其他 llama1 系列

- Vicuna v1.1 v1.3

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt="A chat between a curious user and an artificial intelligence assistant. ""The assistant gives helpful, detailed, and polite answers to the user's questions. "user_role="USER: ", bot_role=" ASSISTANT:", history_sep="<s>", dtype=dtype)

- BiLLa

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "\n", user_role = "Human: ", bot_role = "\nAssistant: ", history_sep = "\n", dtype = dtype)

llama2-chat

- meta-llama/Llama-2-chat

| Model | Llama2-chat | Llama2-chat-hf |

|---|---|---|

| 7B | meta-llama/Llama-2-7b-chat | meta-llama/Llama-2-7b-chat-hf |

| 13B | meta-llama/Llama-2-13b-chat | meta-llama/Llama-2-13b-chat-hf |

| Model | CodeLlama-Instruct |

|---|---|

| 7B | codellama/CodeLlama-7b-Instruct-hf |

| 13B | codellama/CodeLlama-13b-Instruct-hf |

官方示例代码中,可以不用系统提示语:

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "<FLM_FIX_TOKEN_1>", user_role = "[INST] ", bot_role = " [/INST]", history_sep = " <FLM_FIX_TOKEN_2><FLM_FIX_TOKEN_1>", dtype = dtype)

Llama-2系列支持系统提示语需要修改代码,单轮可以使用以下带有系统提示语的版本:

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "<FLM_FIX_TOKEN_1>[INST] <<SYS>>\nYou are a helpful, respectful and honest assistant. Always answer as helpfully as possible, " \"while being safe. Your answers should not include any harmful, unethical, racist, sexist, toxic, dangerous, or illegal content. " \"Please ensure that your responses are socially unbiased and positive in nature.\n\nIf a question does not make any sense, " \"or is not factually coherent, explain why instead of answering something not correct. If you don't know the answer to a question, " \"please don't share false information.\n<</SYS>>\n\n", user_role = " ", bot_role = " [/INST]", history_sep = " <FLM_FIX_TOKEN_2><FLM_FIX_TOKEN_1>", dtype = dtype)

- ymcui/Chinese-Alpaca-2

| Model | Chinese-Alpaca-2 | Chinese-Alpaca-2-16K |

|---|---|---|

| 7B | ziqingyang/chinese-alpaca-2-7b | ziqingyang/chinese-alpaca-2-7b-16k |

| 13B | ziqingyang/chinese-alpaca-2-13b | ziqingyang/chinese-alpaca-2-13b-16k |

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt = "<FLM_FIX_TOKEN_1>[INST] <<SYS>>\nYou are a helpful assistant. 你是一个乐于助人的助手。\n<</SYS>>\n\n"user_role = " ", bot_role = " [/INST]", history_sep = " <FLM_FIX_TOKEN_2><FLM_FIX_TOKEN_1>", dtype = dtype)

RUC-GSAI/YuLan-Chat

- Full

- YuLan-Chat-2-13B

- Delta (需要原始LLaMA)

- YuLan-Chat-1-65B-v2

- YuLan-Chat-1-65B-v1

- YuLan-Chat-1-13B-v1

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt="The following is a conversation between a human and an AI assistant namely YuLan, developed by GSAI, Renmin University of China. " \"The AI assistant gives helpful, detailed, and polite answers to the user's questions.\n",user_role="[|Human|]:", bot_role="\n[|AI|]:", history_sep="\n", dtype=dtype)

WizardCoder

- WizardCoder-Python-7B-V1.0

- WizardCoder-Python-13B-V1.0

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt="Below is an instruction that describes a task. " \"Write a response that appropriately completes the request.\n\n",user_role="### Instruction:\n", bot_role="\n\n### Response:", history_sep="\n", dtype=dtype)

Deepseek Coder

- Deepseek-Coder-1.3B-Instruct

- Deepseek-Coder-6.7B-Instruct

- Deepseek-Coder-7B-Instruct v1.5

torch2flm.tofile(exportPath, model, tokenizer, pre_prompt="<FLM_FIX_TOKEN_32013> You are an AI programming assistant, utilizing the Deepseek Coder model, developed by Deepseek Company, " \"and you only answer questions related to computer science. For politically sensitive questions, security and privacy issues, " \"and other non-computer science questions, you will refuse to answer.\n",user_role="### Instruction:\n", bot_role="\n### Response:\n", history_sep="\n<|EOT|>\n", dtype=dtype)

相关文章:

【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型

1,关于 fastllm 项目 https://www.bilibili.com/video/BV1fx421k7Mz/?vd_source4b290247452adda4e56d84b659b0c8a2 【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型 https://github.com/ztxz16/fastllm &am…...

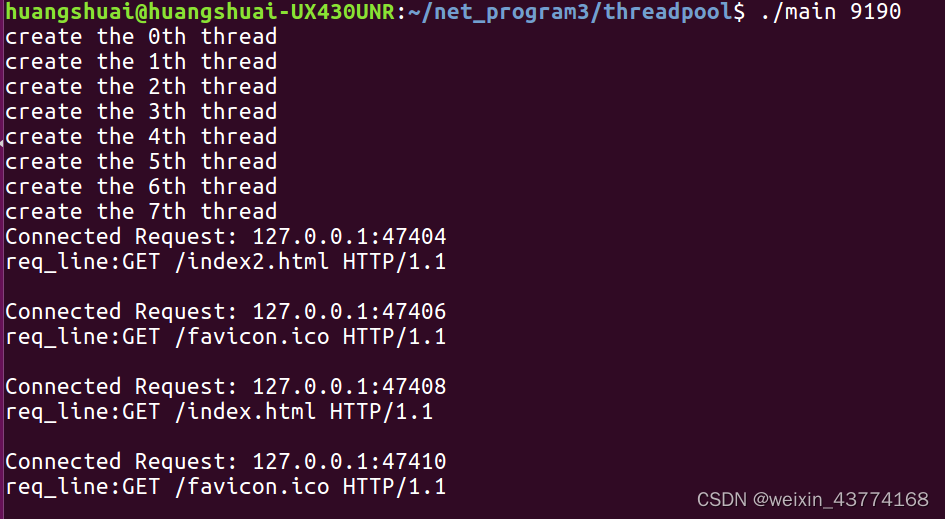

《TCP/IP网络编程》中多线程HTTP服务器实现代码,线程池改编

文章目录 最初代码线程池代码locker.hthreadpool.htask.hmain.cppindex.html编译 执行结果 最初代码 #include <stdio.h> #include <stdlib.h> #include <string.h> #include <unistd.h> #include <arpa/inet.h> #include <sys/socket.h>…...

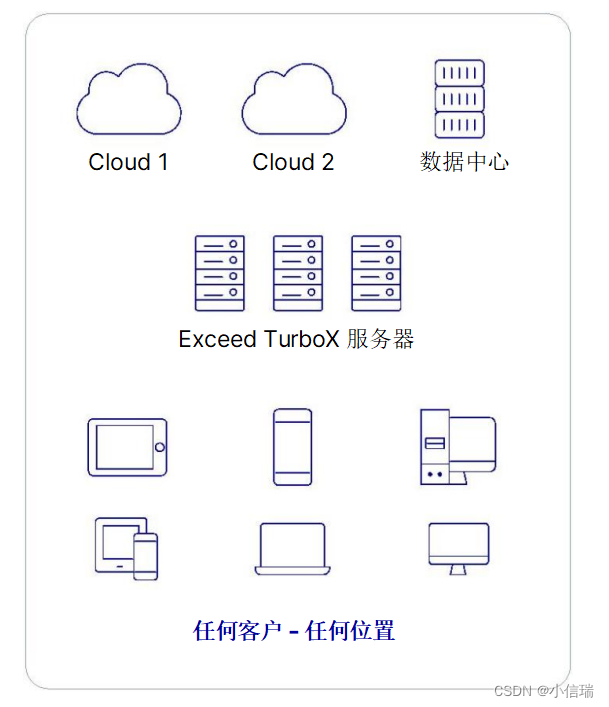

Windows®、Linux® 和 UNIX® 系统都适用的远程桌面工具 OpenText ETX

Windows、Linux 和 UNIX 系统都适用的远程桌面工具 OpenText ETX 为 Windows、Linux 和 UNIX 实施精益、经济高效的虚拟化;提供完整的远程 Windows 可用性;以类似本地的性能远程工作;安全地保护系统和知识产权(IP)&am…...

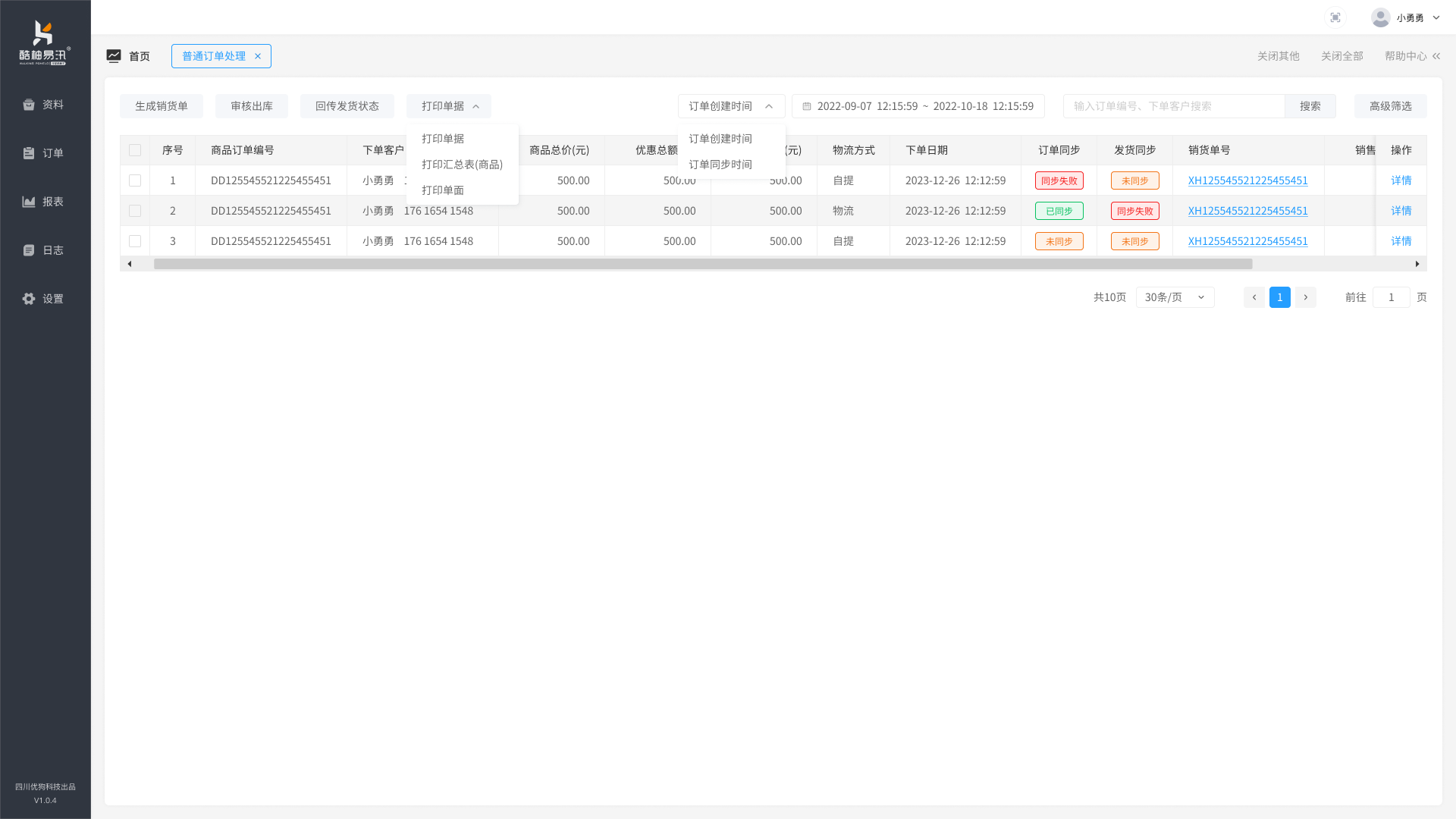

酷柚易汛ERP - 榜店商城对接说明

榜店商城与酷柚易汛ERP对接,需要先在榜店系统中安装对应插件,配置对应的密钥 榜店商城与酷柚易汛ERP的商品进行关联操作,同时订单也会同步,关联不正确会导致订单出库错误 可查看对应的日志...

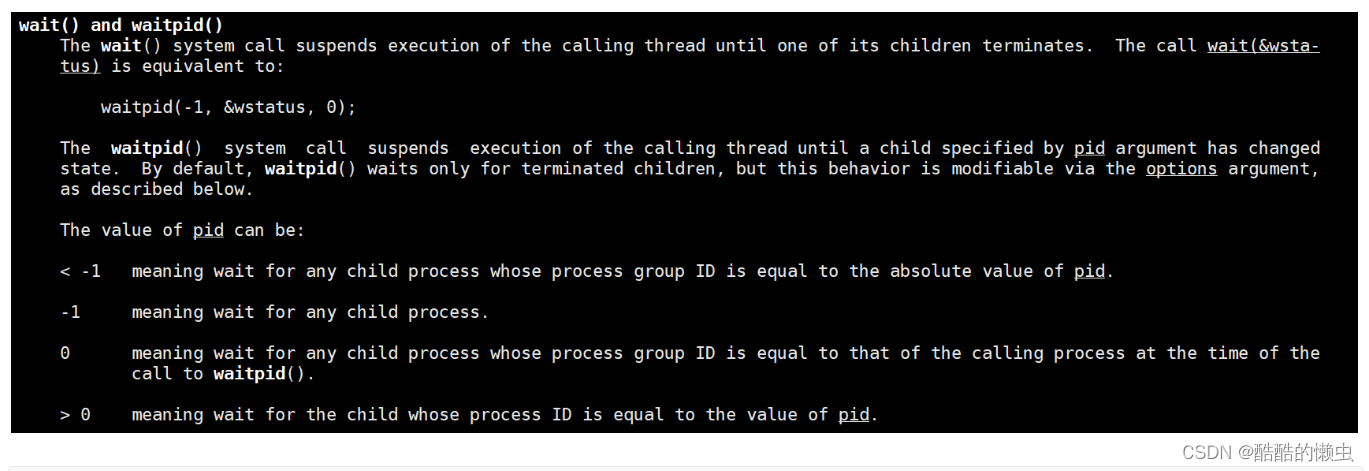

Linux 多进程开发(上)

第二章 Linux 多进程开发 2.1 进程概述2.2 进程状态转换2.3 进程创建2.4 exec 函数族2.5 进程控制 网络编程系列文章: 第1章 Linux系统编程入门(上) 第1章 Linux系统编程入门(下) 第2章 Linux多进程开发(…...

【DataWhale学习】用免费GPU线上跑StableDiffusion项目实践

用免费GPU线上跑SD项目实践 DataWhale组织了一个线上白嫖GPU跑chatGLM与SD的项目活动,我很感兴趣就参加啦。之前就对chatGLM有所耳闻,是去年清华联合发布的开源大语言模型,可以用来打造个人知识库什么的,一直没有尝试。而SD我…...

基于YOLOv8/YOLOv7/YOLOv6/YOLOv5的铁轨缺陷检测系统(Python+PySide6界面+训练代码)

摘要:开发铁轨缺陷检测系统对于物流行业、制造业具有重要作用。本篇博客详细介绍了如何运用深度学习构建一个铁轨缺陷检测系统,并提供了完整的实现代码。该系统基于强大的YOLOv8算法,并对比了YOLOv7、YOLOv6、YOLOv5,展示了不同模…...

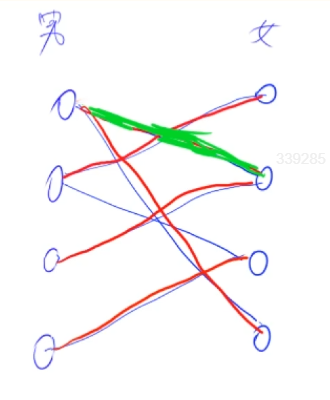

3.基础算法之搜索与图论

1.深度优先搜索 深度优先搜索(DFS,Depth First Search)是一种用于遍历或搜索树或图的算法。它将当前状态按照一定的规则顺序,先拓展一步得到一个新状态,再对这个新状态递归拓展下去。如果无法拓展,则退回…...

Java模板方法模式源码剖析及使用场景

一、原理与通俗理解 模板方法模式定义了一个算法的骨架,将某些步骤推迟到子类中实现。模板方法定义一个算法的骨架,将一些步骤的实现延迟到子类中完成。这样做的目的是确保算法的结构保持不变,同时又可以为不同的子类提供特定步骤的实现。 比如去餐馆吃饭,餐馆有固定的流程(下…...

c++ 新的函数声明语法

右值引用(&&) 右值引用(&&)允许我们定义接受临时对象或移动语义的函数。 void foo(int&& x); // 右值引用参数默认参数 允许在函数声明中指定参数的默认值。 void bar(int x, double y 3.14); // 带有默认参数的函数声明noexcept关键字 指示函数…...

一款好用的AI工具——边界AICHAT

目录 一、简介二、注册及登录三、主要功能介绍3.1、模型介绍3.2、对话模型历史记录3.3、创作中心3.4、AI绘画SD3.5、文生图3.6、图生图3.7、线稿生图3.8、艺术二维码3.9、秀图广场3.10、AI绘画创作人像辅助器 一、简介 人工智能(AI)是一门研究、开发用于…...

谷歌承认“窃取”OpenAI模型关键信息

什么?谷歌成功偷家OpenAI,还窃取到了gpt-3.5-turbo关键信息??? 是的,你没看错。 根据谷歌自己的说法,它不仅还原了OpenAI大模型的整个投影矩阵(projection matrix)&…...

)

蓝桥杯(3.10)

1219. 移动距离 import java.util.Scanner; public class Main{public static void main(String[] args) {Scanner sc new Scanner(System.in);int w sc.nextInt();int m sc.nextInt();int n sc.nextInt();m--;n--;//由从1开始变为从0开始//求行号int x1 m/w, x2 n/w;//…...

Hololens 2应用开发系列(3)——MRTK基础知识及配置文件配置(中)

Hololens 2应用开发系列(3)——MRTK基础知识及配置文件配置(中) 一、前言二、输入系统2.1 MRTK输入系统介绍2.2 输入数据提供者(Input Data Providers)2.3 输入动作(Input Actions)2…...

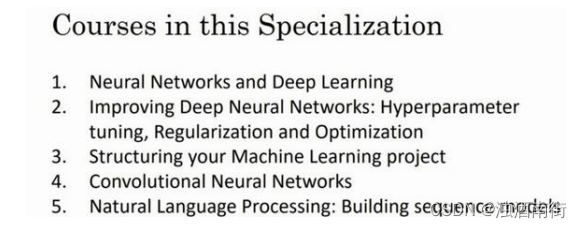

吴恩达深度学习笔记:深度学习引言1.1-1.5

目录 第一门课:神经网络和深度学习 (Neural Networks and Deep Learning)第一周:深度学习引言(Introduction to Deep Learning)1.1 欢迎(Welcome)1.2 什么是神经网络?(What is a Neural Network)1.3 神经网络的监督学习(Supervised Learning …...

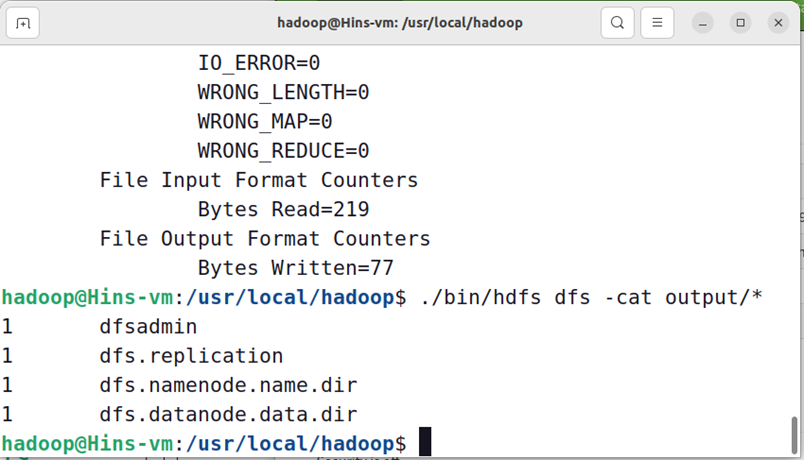

【Hadoop大数据技术】——Hadoop概述与搭建环境(学习笔记)

📖 前言:随着大数据时代的到来,大数据已经在金融、交通、物流等各个行业领域得到广泛应用。而Hadoop就是一个用于处理海量数据的框架,它既可以为海量数据提供可靠的存储;也可以为海量数据提供高效的处理。 目录 &#…...

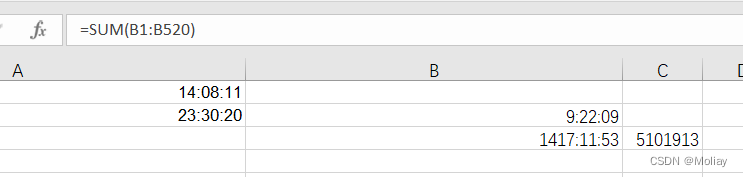

蓝桥杯2023年第十四届省赛真题-工作时长

文件数据 把数据复制到excel中 数据按照增序排序 选中列数据,设置单元格格式,选择下述格式。注意,因为求和之后总小时数可能会超过24小时,所以不要选择最前面是hh的 设置B2 A2 - A1, B4 A4 - A3;然后选中已经算出…...

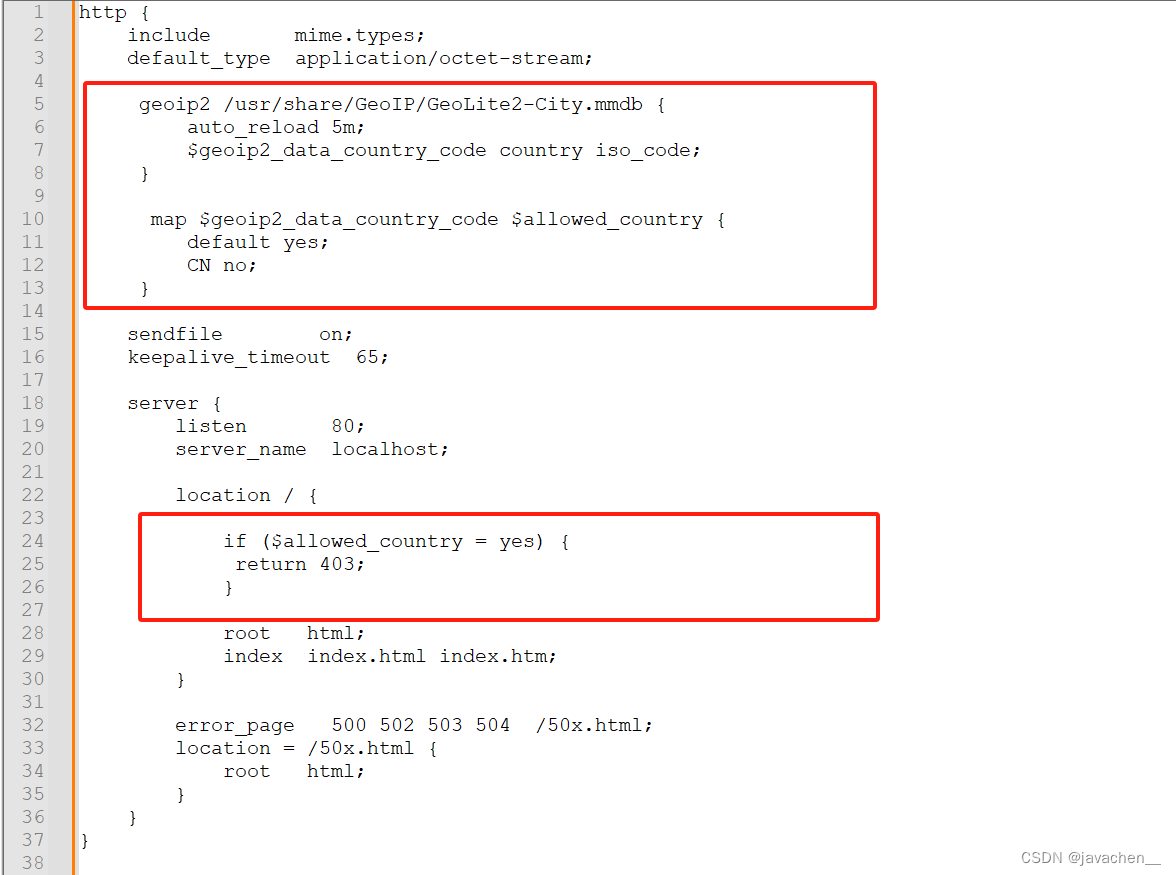

nginx禁止国外ip访问

1.安装geoip2扩展依赖 yum install libmaxminddb-devel -y 2.下载ngx_http_geoip2_module模块 https://github.com/leev/ngx_http_geoip2_module.git 3.编译安装 ./configure --add-module/datasdb/ngx_http_geoip2_module-3.4 4.下载最新数据库文件 模块安装成功后,还要…...

《腾讯音乐》24校招Java后端一面面经

1.手写LRU 2.项目拷打 3.Https客户端校验证书的细节? 4.对称加密和非对称加密的区别?你分别了解哪些算法? 5.在信息传输过程中,Https用的是对称加密还是非对称加密? 6.怎么防止下载的文件被劫持和篡改? 7.H…...

JavaScript:ES至今发展史简说

ECMAScript(简称ES)是JavaScript的标准,它的发展史经历了多个版本的迭代,以下是主要里程碑: ES1 (1997年6月):首个正式发布的ECMAScript标准,基于当时的JavaScript(由Netscape公司开…...

idea大量爆红问题解决

问题描述 在学习和工作中,idea是程序员不可缺少的一个工具,但是突然在有些时候就会出现大量爆红的问题,发现无法跳转,无论是关机重启或者是替换root都无法解决 就是如上所展示的问题,但是程序依然可以启动。 问题解决…...

解锁数据库简洁之道:FastAPI与SQLModel实战指南

在构建现代Web应用程序时,与数据库的交互无疑是核心环节。虽然传统的数据库操作方式(如直接编写SQL语句与psycopg2交互)赋予了我们精细的控制权,但在面对日益复杂的业务逻辑和快速迭代的需求时,这种方式的开发效率和可…...

Python爬虫(一):爬虫伪装

一、网站防爬机制概述 在当今互联网环境中,具有一定规模或盈利性质的网站几乎都实施了各种防爬措施。这些措施主要分为两大类: 身份验证机制:直接将未经授权的爬虫阻挡在外反爬技术体系:通过各种技术手段增加爬虫获取数据的难度…...

【决胜公务员考试】求职OMG——见面课测验1

2025最新版!!!6.8截至答题,大家注意呀! 博主码字不易点个关注吧,祝期末顺利~~ 1.单选题(2分) 下列说法错误的是:( B ) A.选调生属于公务员系统 B.公务员属于事业编 C.选调生有基层锻炼的要求 D…...

04-初识css

一、css样式引入 1.1.内部样式 <div style"width: 100px;"></div>1.2.外部样式 1.2.1.外部样式1 <style>.aa {width: 100px;} </style> <div class"aa"></div>1.2.2.外部样式2 <!-- rel内表面引入的是style样…...

鸿蒙中用HarmonyOS SDK应用服务 HarmonyOS5开发一个生活电费的缴纳和查询小程序

一、项目初始化与配置 1. 创建项目 ohpm init harmony/utility-payment-app 2. 配置权限 // module.json5 {"requestPermissions": [{"name": "ohos.permission.INTERNET"},{"name": "ohos.permission.GET_NETWORK_INFO"…...

3403. 从盒子中找出字典序最大的字符串 I

3403. 从盒子中找出字典序最大的字符串 I 题目链接:3403. 从盒子中找出字典序最大的字符串 I 代码如下: class Solution { public:string answerString(string word, int numFriends) {if (numFriends 1) {return word;}string res;for (int i 0;i &…...

的原因分类及对应排查方案)

JVM暂停(Stop-The-World,STW)的原因分类及对应排查方案

JVM暂停(Stop-The-World,STW)的完整原因分类及对应排查方案,结合JVM运行机制和常见故障场景整理而成: 一、GC相关暂停 1. 安全点(Safepoint)阻塞 现象:JVM暂停但无GC日志,日志显示No GCs detected。原因:JVM等待所有线程进入安全点(如…...

重启Eureka集群中的节点,对已经注册的服务有什么影响

先看答案,如果正确地操作,重启Eureka集群中的节点,对已经注册的服务影响非常小,甚至可以做到无感知。 但如果操作不当,可能会引发短暂的服务发现问题。 下面我们从Eureka的核心工作原理来详细分析这个问题。 Eureka的…...

安装docker)

Linux离线(zip方式)安装docker

目录 基础信息操作系统信息docker信息 安装实例安装步骤示例 遇到的问题问题1:修改默认工作路径启动失败问题2 找不到对应组 基础信息 操作系统信息 OS版本:CentOS 7 64位 内核版本:3.10.0 相关命令: uname -rcat /etc/os-rele…...