视频降噪算法 hqdn3d 原理分析

视频降噪

视频降噪是一种处理技术,旨在减少视频中的噪声,提高画面质量。噪声可能来自多种源头,包括摄像机的传感器、压缩算法、传输过程中的干扰等。降噪处理对于视频监控、视频会议、电影后期制作以及任何需要高画质输出的应用场景都非常重要。

视频降噪技术通常包括以下几个关键点:

-

时域降噪:利用连续视频帧之间的时间冗余,通过分析连续帧中相同位置像素的变化来识别噪声,并进行相应的处理。

-

空域降噪:在单帧视频内,通过分析像素邻域内的亮度和色度信息来识别并减少噪声。

-

3D降噪:结合时域和空域信息,同时考虑视频帧的当前帧和相邻帧,进行更加复杂的降噪处理。

-

非线性降噪:某些算法采用非线性处理方法,如中值滤波或维纳滤波,来减少噪声,这些方法对某些类型的噪声特别有效。

-

自适应降噪:根据视频内容的复杂性和噪声水平动态调整降噪强度。

-

基于模型的降噪:使用统计模型或机器学习技术来识别噪声模式,并进行相应的降噪处理。

-

运动补偿:在视频中,运动物体的噪声处理需要特别考虑,以避免在运动补偿过程中引入伪影。

-

硬件加速:某些降噪算法可以在GPU或其他专用硬件上执行,以提高处理速度。

-

用户控制:许多降噪工具提供用户界面,允许用户根据需要调整降噪参数。

关于视频降噪的算法综述可以参考:视频降噪综述。

hqdn3d

hqdn3d(High Quality 3D Denoise)是一种高质量的三维视频降噪算法,主要用于去除视频中的噪声。hqdn3d算法能够有效地去除视频中的高频率噪声,同时尽量减少图像的失真和模糊,保持视频质量。

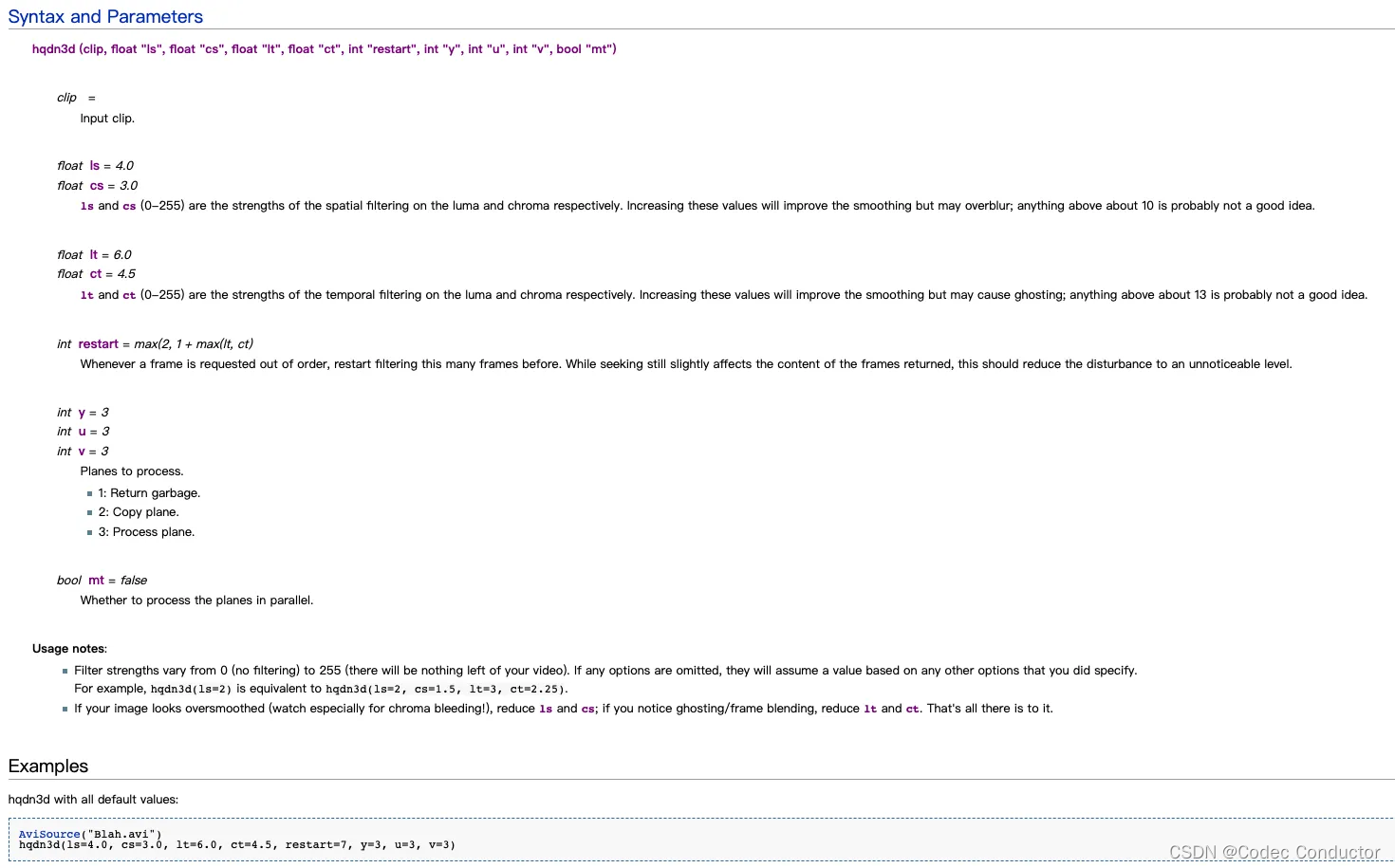

hqdn3d算法已经被实现为AviSynth插件,并且可以在FFmpeg中作为滤镜使用,例如通过命令 ffmpeg -i input.avi -vf hqdn3d output.mp4 来应用。高质量去噪3D是一个AviSynth端口的同名MPlayer过滤器。采用3路低通滤波,在完全去除高频噪声的同时最大限度地减少混合伪影。

-

在AviSynth中使用 hqdn3d 方法如下:有对应的空域滤波、时域滤波的亮度和色度强度设置参数。

-

AviSynth官网:http://www.avisynth.org/

-

FFmpeg 官网:https://ffmpeg.org/

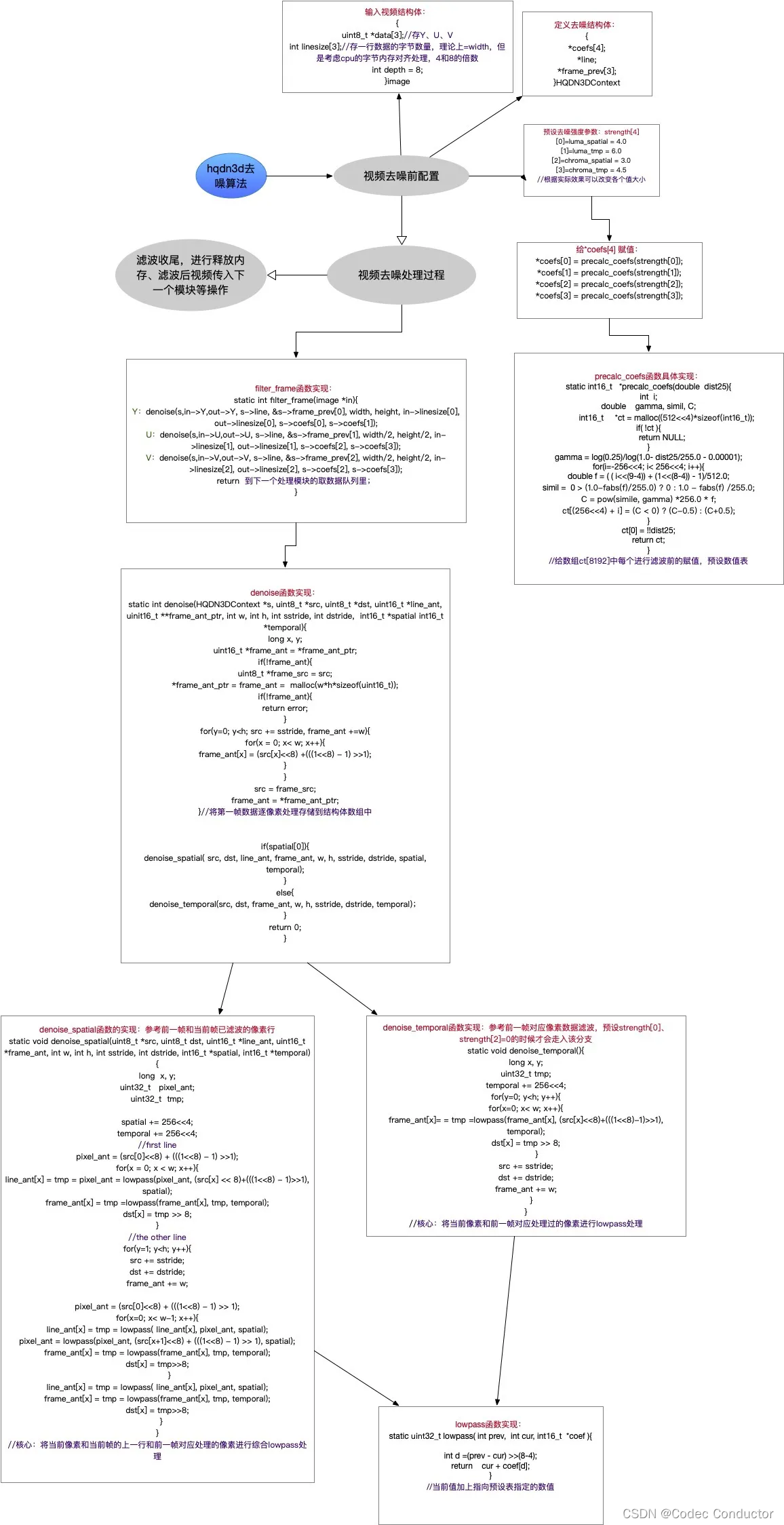

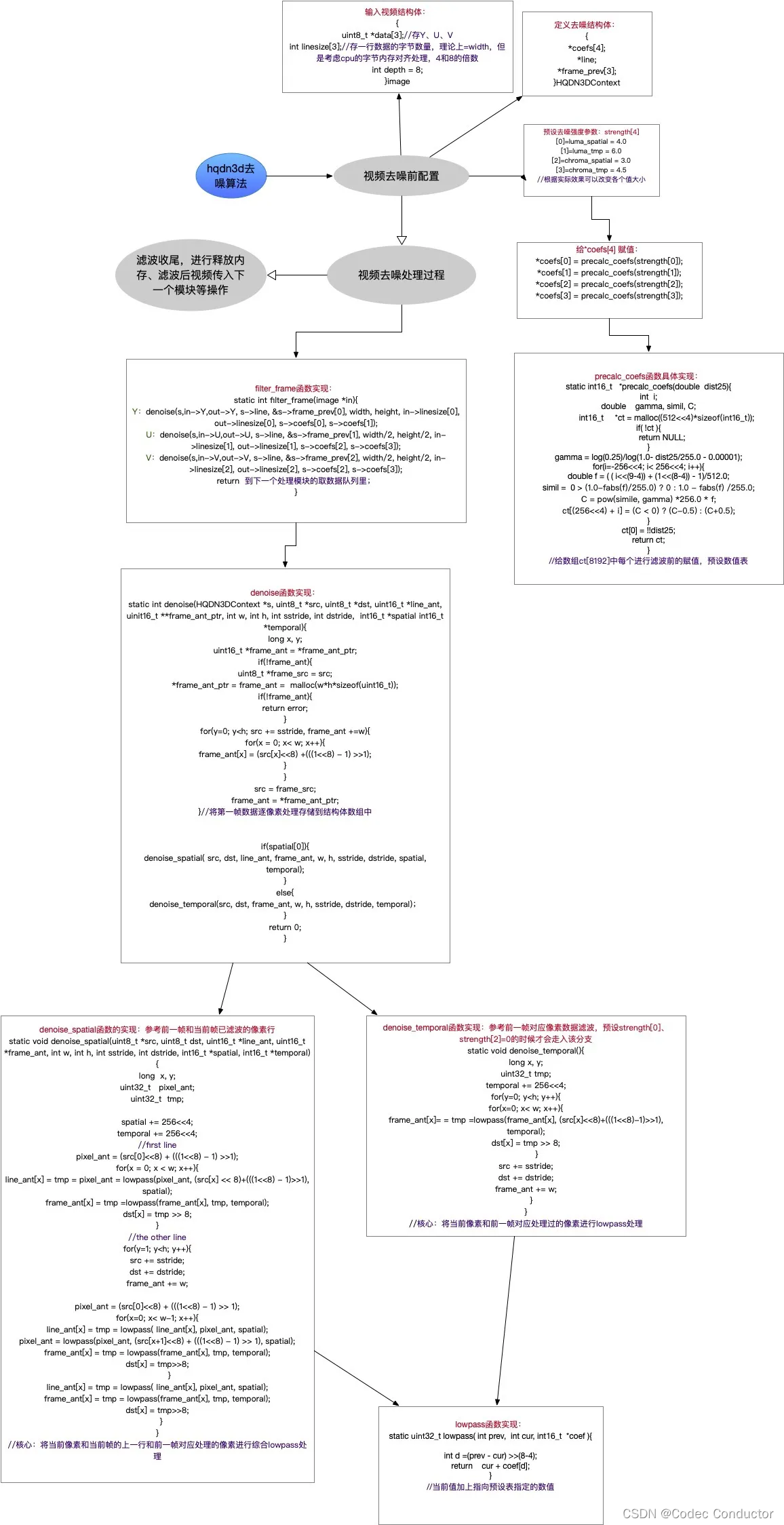

原理

hqdn3d 算法的原理相对比较容易理解,总结其原理,如下:

- 该算法是像素处理,不涉及频域和运动搜索;

- 空域去噪时,当前像素参考当前帧左邻、上邻和前一帧同一位置的像素,对每个像素多次应用低通滤波器;

- 时域去噪时,参考前一帧同一位置的像素,对每个像素应用一个低通滤波器;

- 根据相邻像素的差,确定偏移量,将相邻像素颜色值“拉近”,即对像素做加减法,以达到降噪目的;

- 对于较小的像素差异,hqdn3d会拉近距离,若差异较大,降低偏置系数,达到保边效果;

- 可以通过外部设置滤波强度,调整峰值位置;

- 分析 FFmpeg 中 hqdn3d 算法,算法实现流程如下:

源码

- FFmpeg 中 filter 滤镜对应的 hqdn3d 算法实现

/** Copyright (c) 2003 Daniel Moreno <comac AT comac DOT darktech DOT org>* Copyright (c) 2010 Baptiste Coudurier* Copyright (c) 2012 Loren Merritt** This file is part of FFmpeg, ported from MPlayer.** FFmpeg is free software; you can redistribute it and/or modify* it under the terms of the GNU General Public License as published by* the Free Software Foundation; either version 2 of the License, or* (at your option) any later version.** FFmpeg is distributed in the hope that it will be useful,* but WITHOUT ANY WARRANTY; without even the implied warranty of* MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE. See the* GNU General Public License for more details.** You should have received a copy of the GNU General Public License along* with FFmpeg; if not, write to the Free Software Foundation, Inc.,* 51 Franklin Street, Fifth Floor, Boston, MA 02110-1301 USA.*//*** @file* high quality 3d video denoiser, ported from MPlayer* libmpcodecs/vf_hqdn3d.c.*/#include <float.h>#include "config.h"

#include "libavutil/attributes.h"

#include "libavutil/common.h"

#include "libavutil/pixdesc.h"

#include "libavutil/intreadwrite.h"

#include "libavutil/opt.h"#include "avfilter.h"

#include "formats.h"

#include "internal.h"

#include "video.h"

#include "vf_hqdn3d.h"#define LUT_BITS (depth==16 ? 8 : 4)

#define LOAD(x) (((depth == 8 ? src[x] : AV_RN16A(src + (x) * 2)) << (16 - depth))\+ (((1 << (16 - depth)) - 1) >> 1))

#define STORE(x,val) (depth == 8 ? dst[x] = (val) >> (16 - depth) : \AV_WN16A(dst + (x) * 2, (val) >> (16 - depth)))av_always_inline

static uint32_t lowpass(int prev, int cur, int16_t *coef, int depth)

{int d = (prev - cur) >> (8 - LUT_BITS);return cur + coef[d];

}av_always_inline

static void denoise_temporal(uint8_t *src, uint8_t *dst,uint16_t *frame_ant,int w, int h, int sstride, int dstride,int16_t *temporal, int depth)

{long x, y;uint32_t tmp;temporal += 256 << LUT_BITS;for (y = 0; y < h; y++) {for (x = 0; x < w; x++) {frame_ant[x] = tmp = lowpass(frame_ant[x], LOAD(x), temporal, depth);STORE(x, tmp);}src += sstride;dst += dstride;frame_ant += w;}

}av_always_inline

static void denoise_spatial(HQDN3DContext *s,uint8_t *src, uint8_t *dst,uint16_t *line_ant, uint16_t *frame_ant,int w, int h, int sstride, int dstride,int16_t *spatial, int16_t *temporal, int depth)

{long x, y;uint32_t pixel_ant;uint32_t tmp;spatial += 256 << LUT_BITS;temporal += 256 << LUT_BITS;/* First line has no top neighbor. Only left one for each tmp and* last frame */pixel_ant = LOAD(0);for (x = 0; x < w; x++) {line_ant[x] = tmp = pixel_ant = lowpass(pixel_ant, LOAD(x), spatial, depth);frame_ant[x] = tmp = lowpass(frame_ant[x], tmp, temporal, depth);STORE(x, tmp);}for (y = 1; y < h; y++) {src += sstride;dst += dstride;frame_ant += w;if (s->denoise_row[depth]) {s->denoise_row[depth](src, dst, line_ant, frame_ant, w, spatial, temporal);continue;}pixel_ant = LOAD(0);for (x = 0; x < w-1; x++) {line_ant[x] = tmp = lowpass(line_ant[x], pixel_ant, spatial, depth);pixel_ant = lowpass(pixel_ant, LOAD(x+1), spatial, depth);frame_ant[x] = tmp = lowpass(frame_ant[x], tmp, temporal, depth);STORE(x, tmp);}line_ant[x] = tmp = lowpass(line_ant[x], pixel_ant, spatial, depth);frame_ant[x] = tmp = lowpass(frame_ant[x], tmp, temporal, depth);STORE(x, tmp);}

}av_always_inline

static int denoise_depth(HQDN3DContext *s,uint8_t *src, uint8_t *dst,uint16_t *line_ant, uint16_t **frame_ant_ptr,int w, int h, int sstride, int dstride,int16_t *spatial, int16_t *temporal, int depth)

{// FIXME: For 16-bit depth, frame_ant could be a pointer to the previous// filtered frame rather than a separate buffer.long x, y;uint16_t *frame_ant = *frame_ant_ptr;if (!frame_ant) {uint8_t *frame_src = src;*frame_ant_ptr = frame_ant = av_malloc_array(w, h*sizeof(uint16_t));if (!frame_ant)return AVERROR(ENOMEM);for (y = 0; y < h; y++, src += sstride, frame_ant += w)for (x = 0; x < w; x++)frame_ant[x] = LOAD(x);src = frame_src;frame_ant = *frame_ant_ptr;}if (spatial[0])denoise_spatial(s, src, dst, line_ant, frame_ant,w, h, sstride, dstride, spatial, temporal, depth);elsedenoise_temporal(src, dst, frame_ant,w, h, sstride, dstride, temporal, depth);emms_c();return 0;

}#define denoise(...) \do { \int ret = AVERROR_BUG; \switch (s->depth) { \case 8: ret = denoise_depth(__VA_ARGS__, 8); break; \case 9: ret = denoise_depth(__VA_ARGS__, 9); break; \case 10: ret = denoise_depth(__VA_ARGS__, 10); break; \case 12: ret = denoise_depth(__VA_ARGS__, 12); break; \case 14: ret = denoise_depth(__VA_ARGS__, 14); break; \case 16: ret = denoise_depth(__VA_ARGS__, 16); break; \} \if (ret < 0) { \av_frame_free(&out); \if (!direct) \av_frame_free(&in); \return ret; \} \} while (0)static void precalc_coefs(double dist25, int depth, int16_t *ct)

{int i;double gamma, simil, C;gamma = log(0.25) / log(1.0 - FFMIN(dist25,252.0)/255.0 - 0.00001);for (i = -256<<LUT_BITS; i < 256<<LUT_BITS; i++) {double f = ((i<<(9-LUT_BITS)) + (1<<(8-LUT_BITS)) - 1) / 512.0; // midpoint of the binsimil = FFMAX(0, 1.0 - fabs(f) / 255.0);C = pow(simil, gamma) * 256.0 * f;ct[(256<<LUT_BITS)+i] = lrint(C);}ct[0] = !!dist25;

}#define PARAM1_DEFAULT 4.0

#define PARAM2_DEFAULT 3.0

#define PARAM3_DEFAULT 6.0static av_cold int init(AVFilterContext *ctx)

{HQDN3DContext *s = ctx->priv;if (!s->strength[LUMA_SPATIAL])s->strength[LUMA_SPATIAL] = PARAM1_DEFAULT;if (!s->strength[CHROMA_SPATIAL])s->strength[CHROMA_SPATIAL] = PARAM2_DEFAULT * s->strength[LUMA_SPATIAL] / PARAM1_DEFAULT;if (!s->strength[LUMA_TMP])s->strength[LUMA_TMP] = PARAM3_DEFAULT * s->strength[LUMA_SPATIAL] / PARAM1_DEFAULT;if (!s->strength[CHROMA_TMP])s->strength[CHROMA_TMP] = s->strength[LUMA_TMP] * s->strength[CHROMA_SPATIAL] / s->strength[LUMA_SPATIAL];av_log(ctx, AV_LOG_VERBOSE, "ls:%f cs:%f lt:%f ct:%f\n",s->strength[LUMA_SPATIAL], s->strength[CHROMA_SPATIAL],s->strength[LUMA_TMP], s->strength[CHROMA_TMP]);return 0;

}static av_cold void uninit(AVFilterContext *ctx)

{HQDN3DContext *s = ctx->priv;av_freep(&s->coefs[0]);av_freep(&s->coefs[1]);av_freep(&s->coefs[2]);av_freep(&s->coefs[3]);av_freep(&s->line[0]);av_freep(&s->line[1]);av_freep(&s->line[2]);av_freep(&s->frame_prev[0]);av_freep(&s->frame_prev[1]);av_freep(&s->frame_prev[2]);

}static int query_formats(AVFilterContext *ctx)

{static const enum AVPixelFormat pix_fmts[] = {AV_PIX_FMT_YUV420P, AV_PIX_FMT_YUV422P, AV_PIX_FMT_YUV444P,AV_PIX_FMT_YUV410P, AV_PIX_FMT_YUV411P, AV_PIX_FMT_YUV440P,AV_PIX_FMT_YUVJ420P, AV_PIX_FMT_YUVJ422P, AV_PIX_FMT_YUVJ444P, AV_PIX_FMT_YUVJ440P,AV_PIX_FMT_YUV420P9, AV_PIX_FMT_YUV422P9, AV_PIX_FMT_YUV444P9,AV_PIX_FMT_YUV420P10, AV_PIX_FMT_YUV422P10, AV_PIX_FMT_YUV444P10,AV_PIX_FMT_YUV440P10,AV_PIX_FMT_YUV444P12, AV_PIX_FMT_YUV422P12, AV_PIX_FMT_YUV420P12,AV_PIX_FMT_YUV440P12,AV_PIX_FMT_YUV444P14, AV_PIX_FMT_YUV422P14, AV_PIX_FMT_YUV420P14,AV_PIX_FMT_YUV420P16, AV_PIX_FMT_YUV422P16, AV_PIX_FMT_YUV444P16,AV_PIX_FMT_NONE};AVFilterFormats *fmts_list = ff_make_format_list(pix_fmts);if (!fmts_list)return AVERROR(ENOMEM);return ff_set_common_formats(ctx, fmts_list);

}static void calc_coefs(AVFilterContext *ctx)

{HQDN3DContext *s = ctx->priv;for (int i = 0; i < 4; i++)precalc_coefs(s->strength[i], s->depth, s->coefs[i]);

}static int config_input(AVFilterLink *inlink)

{AVFilterContext *ctx = inlink->dst;HQDN3DContext *s = inlink->dst->priv;const AVPixFmtDescriptor *desc = av_pix_fmt_desc_get(inlink->format);int i, depth;uninit(inlink->dst);s->hsub = desc->log2_chroma_w;s->vsub = desc->log2_chroma_h;s->depth = depth = desc->comp[0].depth;for (i = 0; i < 3; i++) {s->line[i] = av_malloc_array(inlink->w, sizeof(*s->line[i]));if (!s->line[i])return AVERROR(ENOMEM);}for (i = 0; i < 4; i++) {s->coefs[i] = av_malloc((512<<LUT_BITS) * sizeof(int16_t));if (!s->coefs[i])return AVERROR(ENOMEM);}calc_coefs(ctx);if (ARCH_X86)ff_hqdn3d_init_x86(s);return 0;

}typedef struct ThreadData {AVFrame *in, *out;int direct;

} ThreadData;static int do_denoise(AVFilterContext *ctx, void *data, int job_nr, int n_jobs)

{HQDN3DContext *s = ctx->priv;const ThreadData *td = data;AVFrame *out = td->out;AVFrame *in = td->in;int direct = td->direct;denoise(s, in->data[job_nr], out->data[job_nr],s->line[job_nr], &s->frame_prev[job_nr],AV_CEIL_RSHIFT(in->width, (!!job_nr * s->hsub)),AV_CEIL_RSHIFT(in->height, (!!job_nr * s->vsub)),in->linesize[job_nr], out->linesize[job_nr],s->coefs[job_nr ? CHROMA_SPATIAL : LUMA_SPATIAL],s->coefs[job_nr ? CHROMA_TMP : LUMA_TMP]);return 0;

}static int filter_frame(AVFilterLink *inlink, AVFrame *in)

{AVFilterContext *ctx = inlink->dst;AVFilterLink *outlink = ctx->outputs[0];AVFrame *out;int direct = av_frame_is_writable(in) && !ctx->is_disabled;ThreadData td;if (direct) {out = in;} else {out = ff_get_video_buffer(outlink, outlink->w, outlink->h);if (!out) {av_frame_free(&in);return AVERROR(ENOMEM);}av_frame_copy_props(out, in);}td.in = in;td.out = out;td.direct = direct;/* one thread per plane */ctx->internal->execute(ctx, do_denoise, &td, NULL, 3);if (ctx->is_disabled) {av_frame_free(&out);return ff_filter_frame(outlink, in);}if (!direct)av_frame_free(&in);return ff_filter_frame(outlink, out);

}static int process_command(AVFilterContext *ctx, const char *cmd, const char *args,char *res, int res_len, int flags)

{int ret;ret = ff_filter_process_command(ctx, cmd, args, res, res_len, flags);if (ret < 0)return ret;calc_coefs(ctx);return 0;

}#define OFFSET(x) offsetof(HQDN3DContext, x)

#define FLAGS AV_OPT_FLAG_VIDEO_PARAM | AV_OPT_FLAG_FILTERING_PARAM | AV_OPT_FLAG_RUNTIME_PARAM

static const AVOption hqdn3d_options[] = {{ "luma_spatial", "spatial luma strength", OFFSET(strength[LUMA_SPATIAL]), AV_OPT_TYPE_DOUBLE, { .dbl = 0.0 }, 0, DBL_MAX, FLAGS },{ "chroma_spatial", "spatial chroma strength", OFFSET(strength[CHROMA_SPATIAL]), AV_OPT_TYPE_DOUBLE, { .dbl = 0.0 }, 0, DBL_MAX, FLAGS },{ "luma_tmp", "temporal luma strength", OFFSET(strength[LUMA_TMP]), AV_OPT_TYPE_DOUBLE, { .dbl = 0.0 }, 0, DBL_MAX, FLAGS },{ "chroma_tmp", "temporal chroma strength", OFFSET(strength[CHROMA_TMP]), AV_OPT_TYPE_DOUBLE, { .dbl = 0.0 }, 0, DBL_MAX, FLAGS },{ NULL }

};AVFILTER_DEFINE_CLASS(hqdn3d);static const AVFilterPad avfilter_vf_hqdn3d_inputs[] = {{.name = "default",.type = AVMEDIA_TYPE_VIDEO,.config_props = config_input,.filter_frame = filter_frame,},{ NULL }

};static const AVFilterPad avfilter_vf_hqdn3d_outputs[] = {{.name = "default",.type = AVMEDIA_TYPE_VIDEO},{ NULL }

};AVFilter ff_vf_hqdn3d = {.name = "hqdn3d",.description = NULL_IF_CONFIG_SMALL("Apply a High Quality 3D Denoiser."),.priv_size = sizeof(HQDN3DContext),.priv_class = &hqdn3d_class,.init = init,.uninit = uninit,.query_formats = query_formats,.inputs = avfilter_vf_hqdn3d_inputs,.outputs = avfilter_vf_hqdn3d_outputs,.flags = AVFILTER_FLAG_SUPPORT_TIMELINE_INTERNAL | AVFILTER_FLAG_SLICE_THREADS,.process_command = process_command,

};相关文章:

视频降噪算法 hqdn3d 原理分析

视频降噪 视频降噪是一种处理技术,旨在减少视频中的噪声,提高画面质量。噪声可能来自多种源头,包括摄像机的传感器、压缩算法、传输过程中的干扰等。降噪处理对于视频监控、视频会议、电影后期制作以及任何需要高画质输出的应用场景都非常重…...

Ansys Mechanical|屈曲分析技术

屈曲分析的基本概念 当受拉杆件的应力达到屈服极限或强度极限时,将引起塑性变形或断裂。这些是由于强度不足所引起的失效。 在工程中,我们会注意到当细长杆件受压时,表现出与强度失效完全不同的性质。当杆件受压超过某一临界值时࿰…...

【大模型微调】一文掌握7种大模型微调的方法

本篇文章深入分析了大型模型微调的基本理念和多样化技术,细致介绍了LoRA、适配器调整(Adapter Tuning)、前缀调整(Prefix Tuning)等多个微调方法。详细讨论了每一种策略的基本原则、主要优点以及适宜应用场景,使得读者可以依据特定的应用要求和计算资源限…...

MySQL表突然卡死,删、查操作加载不停解决办法

今天遇到了MySQL删表的时候卡死情况。然后通过网上查阅资料和项目组沟通,了解到了有多人同时对同一张表进行了操作。我和另一个同事同时进行了删除操作,然后另两位同时进行了查询操作,然后还有一位同事用dolphin调度,用datax采集数…...

Rust 标准库的结构及其模块路径

在 Rust 中,标准库提供了一组核心功能,以帮助开发者执行常见的编程任务。当使用这些功能时,我们需要通过特定的模块路径来引用它们。下面,我们将详细介绍 Rust 标准库的结构,并提供相应的 use 路径。 Rust 标准库模块…...

003_PyCharm的安装与使用

如果你正在学习PyQt,本系列教程完全可以带你入门直至入土。 所谓从零开始,就是从软件安装、环境配置开始。 不跳过一个细节,不漏掉一行代码,不省略一个例图。 IDE 开始学习一个编程语言,我们肯定是首先得安装好它&…...

事件传递机制

IOS面试题(UIView) ----- 事件传递机制 - 简书 面试题: 在以下场景中,父视图 ParentView 上有三个子视图 ViewA、ViewB 和 ViewC。ViewA 完全位于 ParentView 的范围内,ViewB 有一半在 ParentView 的范围内,而 ViewC 完全位于 Par…...

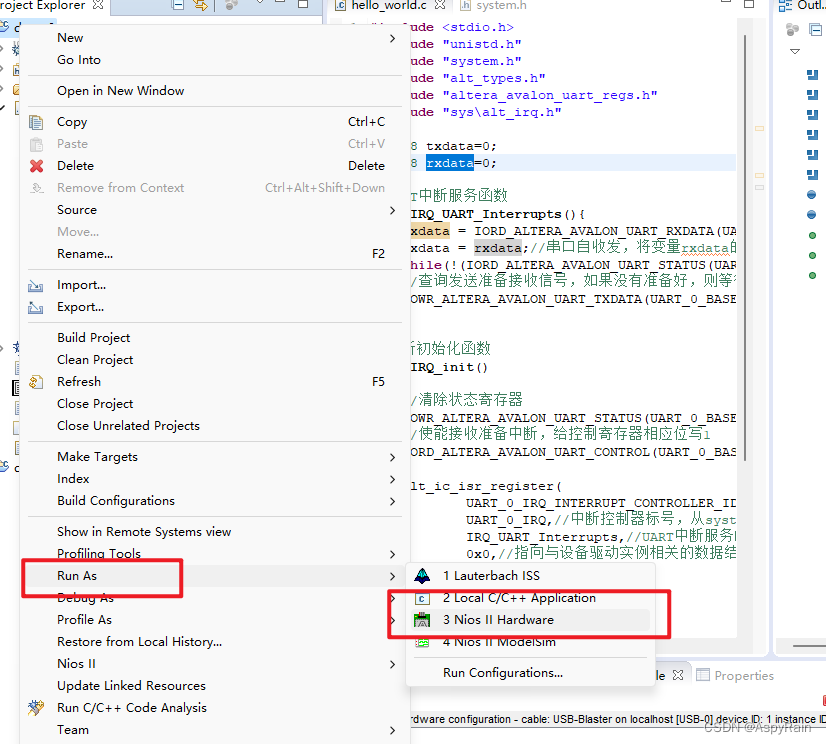

DE2-115串口通信

目录 一、 内容概要二、 Hello Nios-II2.1 Nios-II编程2.1.1 硬件Ⅰ 搭建环境Ⅱ 编写代码 2.1.2 软件2.1.3 烧录Ⅰ硬件Ⅱ 软件 2.2 verilog编程 三、 心得体会 一、 内容概要 分别用Verilog和Nios软件编程, 实现DE2-115开发板串口输出“Hello Nios-II”字符到笔记本电脑串口助…...

Danfoss丹佛斯S90泵比例放大器

S90R042、S90R055、S90R075、S90R100、S90R130、S90R180、S90R250电气排量控制变量泵比例阀放大器,电气排量控制为高增益控制方式:通过微小变化的输入电流控制信号即可推动伺服阀主阀芯至全开口位置,进而将最大流量的控制油引入到伺服油缸。伺…...

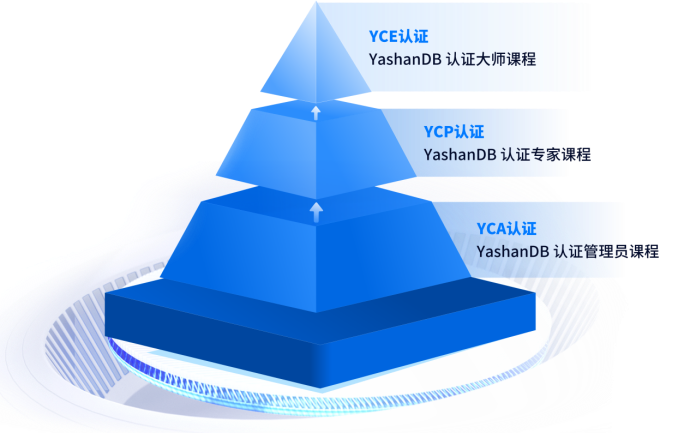

对话YashanDB CTO陈志标:如何推动国产数据库长远发展

深圳计算科学研究院(以下简称“深算院”)是深圳市人民政府2018年11月批准建设的“十大基础研究机构”之一,由深圳市科技创新委员会主管、深圳大学举办、深圳市龙华区人民政府共建的二类事业法人单位。 崖山数据库系统YashanDB是深算院完全自主…...

ip显示地址和实际地址不一样:原因解析与应对策略

在数字化时代,IP地址作为我们在互联网上的身份标识,其重要性不言而喻。然而,有时我们会遇到ip显示地址和实际地址不一样的情况,这不仅可能影响到我们的网络体验,还可能引发一系列安全和隐私问题。那么,造成…...

visual studio snippet常用注释片段

Visual Studio 2022 添加自定义代码片段_vs2022 代码片段-CSDN博客 dclass.snippet: <?xml version"1.0" encoding"utf-8"?> <CodeSnippets xmlns"http://schemas.microsoft.com/VisualStudio/2005/CodeSnippet"> …...

ubuntu下不生成core dumped

1、先用ulimit -c,如果看到0,说明没有开core dump。 所以我们输入ulimit -c unlimited,打开core dump。 再次用ulimit -c,看到unlimited了,说明core dump打开了。 注意这句ulimit -c unlimited只对当前会话有效。要永…...

python开发的学习路线

I. 基础知识学习 A. Python基础语法 变量和数据类型 学习如何定义变量,理解并使用不同的数据类型(整数、浮点数、字符串、布尔值等)。 掌握数字类型的转换和操作。 熟悉字符串的基本操作,如拼接、切片、替换和查找。 …...

vite+vue3 部署后,总是需要清除缓存的问题

1.每次部署后,需要清除缓存,才能看到最新代码,给打包文件加上hash就可以解决此问题。 vite.config.ts文件中加以下代码 build: {rollupOptions: {output: {entryFileNames: assets/[name].[hash].js,chunkFileNames: assets/[name].[hash].j…...

多态:解锁面向对象编程的无限可能

1. 概述 多态(Polymorphism)是面向对象编程的三大核心特性之一(另两个是封装和继承)。多态意味着不同的对象对同一消息做出不同的响应。简单来说,多态允许你使用父类引用指向子类对象,并且当调用方法时&am…...

:记录的增删改查)

学习MySQL(四):记录的增删改查

记录的增、删、改 增 -- 插入一条数据 INSERT INTO 表名(字段 1,字段2,字段3) VALUES(值 1,值2,值3) INSERT INTO 表名 VALUES(值 1,值2,值3&am…...

如何使用Python进行网页爬取

Python爬虫案例可以有很多种,但我会为你提供一个简单的案例,该案例使用Python的requests库来爬取一个网页的内容,并使用BeautifulSoup库来解析HTML并提取特定的信息。 假设我们要从某个新闻网站(例如:示例网站&#x…...

设计模式)

Spring的IOC(Inversion of Control)设计模式

Spring的IOC(Inversion of Control)是一种设计模式,它通过控制反转的思想来降低组件之间的耦合度。在Spring框架中,IOC容器负责管理应用程序中的对象,使得对象之间的依赖关系由容器来维护和注入。 以下是Spring IOC的…...

深度学习知识点总结

深度学习是机器学习领域中的一个重要研究方向,它致力于模拟人脑的学习过程,使机器能够像人一样具有分析学习能力,识别文字、图像和声音等数据。以下是深度学习的一些关键知识点总结: 定义与目标: 深度学习是学习样本数…...

边缘计算医疗风险自查APP开发方案

核心目标:在便携设备(智能手表/家用检测仪)部署轻量化疾病预测模型,实现低延迟、隐私安全的实时健康风险评估。 一、技术架构设计 #mermaid-svg-iuNaeeLK2YoFKfao {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg…...

使用分级同态加密防御梯度泄漏

抽象 联邦学习 (FL) 支持跨分布式客户端进行协作模型训练,而无需共享原始数据,这使其成为在互联和自动驾驶汽车 (CAV) 等领域保护隐私的机器学习的一种很有前途的方法。然而,最近的研究表明&…...

CentOS下的分布式内存计算Spark环境部署

一、Spark 核心架构与应用场景 1.1 分布式计算引擎的核心优势 Spark 是基于内存的分布式计算框架,相比 MapReduce 具有以下核心优势: 内存计算:数据可常驻内存,迭代计算性能提升 10-100 倍(文档段落:3-79…...

如何在看板中有效管理突发紧急任务

在看板中有效管理突发紧急任务需要:设立专门的紧急任务通道、重新调整任务优先级、保持适度的WIP(Work-in-Progress)弹性、优化任务处理流程、提高团队应对突发情况的敏捷性。其中,设立专门的紧急任务通道尤为重要,这能…...

现代密码学 | 椭圆曲线密码学—附py代码

Elliptic Curve Cryptography 椭圆曲线密码学(ECC)是一种基于有限域上椭圆曲线数学特性的公钥加密技术。其核心原理涉及椭圆曲线的代数性质、离散对数问题以及有限域上的运算。 椭圆曲线密码学是多种数字签名算法的基础,例如椭圆曲线数字签…...

CMake 从 GitHub 下载第三方库并使用

有时我们希望直接使用 GitHub 上的开源库,而不想手动下载、编译和安装。 可以利用 CMake 提供的 FetchContent 模块来实现自动下载、构建和链接第三方库。 FetchContent 命令官方文档✅ 示例代码 我们将以 fmt 这个流行的格式化库为例,演示如何: 使用 FetchContent 从 GitH…...

实现弹窗随键盘上移居中

实现弹窗随键盘上移的核心思路 在Android中,可以通过监听键盘的显示和隐藏事件,动态调整弹窗的位置。关键点在于获取键盘高度,并计算剩余屏幕空间以重新定位弹窗。 // 在Activity或Fragment中设置键盘监听 val rootView findViewById<V…...

【C++从零实现Json-Rpc框架】第六弹 —— 服务端模块划分

一、项目背景回顾 前五弹完成了Json-Rpc协议解析、请求处理、客户端调用等基础模块搭建。 本弹重点聚焦于服务端的模块划分与架构设计,提升代码结构的可维护性与扩展性。 二、服务端模块设计目标 高内聚低耦合:各模块职责清晰,便于独立开发…...

有限自动机到正规文法转换器v1.0

1 项目简介 这是一个功能强大的有限自动机(Finite Automaton, FA)到正规文法(Regular Grammar)转换器,它配备了一个直观且完整的图形用户界面,使用户能够轻松地进行操作和观察。该程序基于编译原理中的经典…...

[ACTF2020 新生赛]Include 1(php://filter伪协议)

题目 做法 启动靶机,点进去 点进去 查看URL,有 ?fileflag.php说明存在文件包含,原理是php://filter 协议 当它与包含函数结合时,php://filter流会被当作php文件执行。 用php://filter加编码,能让PHP把文件内容…...