openEuler搭建hadoop Standalone 模式

Standalone

- 升级软件

- 安装常用软件

- 关闭防火墙

- 修改主机名和IP地址

- 修改hosts配置文件

- 下载jdk和hadoop并配置环境变量

- 配置ssh免密钥登录

- 修改配置文件

- 初始化集群

- windows修改hosts文件

- 测试

1、升级软件

yum -y update

2、安装常用软件

yum -y install gcc gcc-c++ autoconf automake cmake make \zlib zlib-devel openssl openssl-devel pcre-devel \rsync openssh-server vim man zip unzip net-tools tcpdump lrzsz tar wget

3、关闭防火墙

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

setenforce 0

systemctl stop firewalld

systemctl disable firewalld

4、修改主机名和IP地址

hostnamectl set-hostname hadoop

vim /etc/sysconfig/network-scripts/ifcfg-ens32

参考如下:

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=eui64

NAME=ens32

UUID=55e7ac28-39d7-4f24-b6bf-0f9fb40b7595

DEVICE=ens32

ONBOOT=yes

IPADDR=192.168.10.24

PREFIX=24

GATEWAY=192.168.10.2

DNS1=192.168.10.2

5、修改hosts配置文件

vim /etc/hosts

修改内容如下:

192.168.10.24 hadoop

重启系统

reboot

6、下载jdk和hadoop并配置环境变量

创建软件目录

mkdir -p /opt/soft

进入软件目录

cd /opt/soft

下载 JDK

下载 hadoop

wget https://dlcdn.apache.org/hadoop/common/hadoop-3.3.6/hadoop-3.3.6.tar.gz

解压 JDK 修改名称

tar -zxvf jdk-8u411-linux-x64.tar.gz

mv jdk1.8.0_411 jdk-8

解压 hadoop 修改名称

tar -zxvf hadoop-3.3.6.tar.gz

mv hadoop-3.3.6 hadoop-3

配置环境变量

vim /etc/profile.d/my_env.sh

编写以下内容:

export JAVA_HOME=/opt/soft/jdk-8export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_ZKFC_USER=root

export HDFS_JOURNALNODE_USER=root

export HADOOP_SHELL_EXECNAME=rootexport YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=rootexport HADOOP_HOME=/opt/soft/hadoop-3

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/nativeexport PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin生成新的环境变量

source /etc/profile

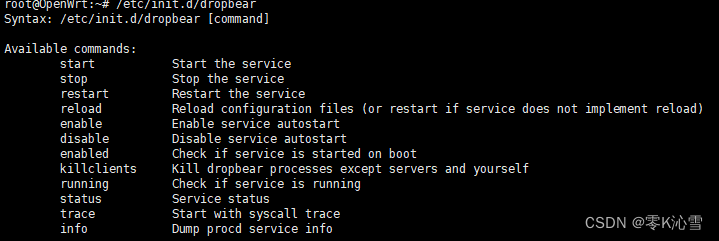

7、配置ssh免密钥登录

创建本地秘钥并将公共秘钥写入认证文件

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

ssh-copy-id root@hadoop

8、修改配置文件

hadoop-env.sh

core-site.xml

hdfs-site.xml

workers

mapred-site.xml

yarn-site.xml

hadoop-env.sh

文档末尾追加以下内容:

export JAVA_HOME=/opt/soft/jdk-8export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_ZKFC_USER=root

export HDFS_JOURNALNODE_USER=root

export HADOOP_SHELL_EXECNAME=rootexport YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=rootexport JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/nativecore-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>fs.defaultFS</name><value>hdfs://hadoop:9000</value></property><property><name>hadoop.tmp.dir</name><value>/home/hadoop_data</value></property><property><name>hadoop.http.staticuser.user</name><value>root</value></property><property><name>dfs.permissions.enabled</name><value>false</value></property><property><name>hadoop.proxyuser.root.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.root.groups</name><value>*</value></property>

</configuration>

hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.namenode.secondary.http-address</name><value>hadoop:9868</value></property>

</configuration>

workers

注意:

hadoop2.x中该文件名为slaves

hadoop3.x中该文件名为workers

hadoop

mapred-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>mapreduce.framework.name</name><value>yarn</value></property><property><name>mapreduce.application.classpath</name><value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value></property>

</configuration>yarn-site.xml

<?xml version="1.0"?>

<configuration><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.env-whitelist</name><value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ,HADOOP_MAPRED_HOME</value></property>

</configuration>9、初始化集群

# 格式化文件系统

hdfs namenode -format

# 启动 NameNode SecondaryNameNode DataNode

start-dfs.sh

# 查看启动进程

jps

# 看到 DataNode SecondaryNameNode NameNode 三个进程代表启动成功

# 启动 ResourceManager daemon 和 NodeManager

start-yarn.sh

# 看到 DataNode NodeManager SecondaryNameNode NameNode ResourceManager 五个进程代表启动成功

重点提示:

# 关机之前 依关闭服务

stop-yarn.sh

stop-dfs.sh

# 开机后 依次开启服务

start-dfs.sh

start-yarn.sh

或者

# 关机之前关闭服务

stop-all.sh

# 开机后开启服务

start-all.sh

#jps 检查进程正常后开启胡哦关闭在再做其它操作

10、修改windows下hosts文件

C:\Windows\System32\drivers\etc\hosts

追加以下内容:

192.168.171.10 hadoop

Windows11 注意 修改权限

-

开始搜索 cmd

找到命令头提示符 以管理身份运行

-

进入 C:\Windows\System32\drivers\etc 目录

cd drivers/etc

-

打开 hosts 配置文件

start hosts

-

追加以下内容后保存

192.168.10.24 hadoop

11、测试

11.1 浏览器访问hadoop

浏览器访问: http://hadoop:9870

浏览器访问:http://hadoop:9868/

浏览器访问:http://hadoop:8088

11.2 测试 hdfs

本地文件系统创建 测试文件 wcdata.txt

vim wcdata.txt

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

在 HDFS 上创建目录 /wordcount/input

hdfs dfs -mkdir -p /wordcount/input

查看 HDFS 目录结构

hdfs dfs -ls /

hdfs dfs -ls /wordcount

hdfs dfs -ls /wordcount/input

上传本地测试文件 wcdata.txt 到 HDFS 上 /wordcount/input

hdfs dfs -put wcdata.txt /wordcount/input

检查文件是否上传成功

hdfs dfs -ls /wordcount/input

hdfs dfs -cat /wordcount/input/wcdata.txt

11.3 测试 mapreduce

计算 PI 的值

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar pi 10 10

单词统计

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar wordcount /wordcount/input/wcdata.txt /wordcount/result

hdfs dfs -ls /wordcount/result

hdfs dfs -cat /wordcount/result/part-r-00000

dcount

```bash

hdfs dfs -ls /wordcount/input

上传本地测试文件 wcdata.txt 到 HDFS 上 /wordcount/input

hdfs dfs -put wcdata.txt /wordcount/input

检查文件是否上传成功

hdfs dfs -ls /wordcount/input

hdfs dfs -cat /wordcount/input/wcdata.txt

11.3 测试 mapreduce

计算 PI 的值

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar pi 10 10

单词统计

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar wordcount /wordcount/input/wcdata.txt /wordcount/result

hdfs dfs -ls /wordcount/result

hdfs dfs -cat /wordcount/result/part-r-00000

相关文章:

openEuler搭建hadoop Standalone 模式

Standalone 升级软件安装常用软件关闭防火墙修改主机名和IP地址修改hosts配置文件下载jdk和hadoop并配置环境变量配置ssh免密钥登录修改配置文件初始化集群windows修改hosts文件测试 1、升级软件 yum -y update2、安装常用软件 yum -y install gcc gcc-c autoconf automake…...

nginx更新https/ssl证书的步骤

一、上传nginx证书到服务器 上传步骤略。。。 二、更新证书 (一)确认nginx的安装目录 我这里的环境是/etc/nginx/ (二)确认nginx的证书目录 查看/etc/nginx/nginx.conf,证书目录就在/etc/nginx目录下 将新的证书tes…...

【Android面试八股文】说一说Handler的sendMessage和postDelay的区别?

文章目录 一、`sendMessage` 方法1.1 主要用法1.2 适用场景二、`postDelayed` 方法2.1 主要用法2.2 适用场景三、 区别总结3.1 区别3.2 本质上有差别吗?四、实例对比4.1 使用`sendMessage`4.2 使用`postDelayed`五、结论Handler类在Android中用于消息传递和任务调度。 sendMe…...

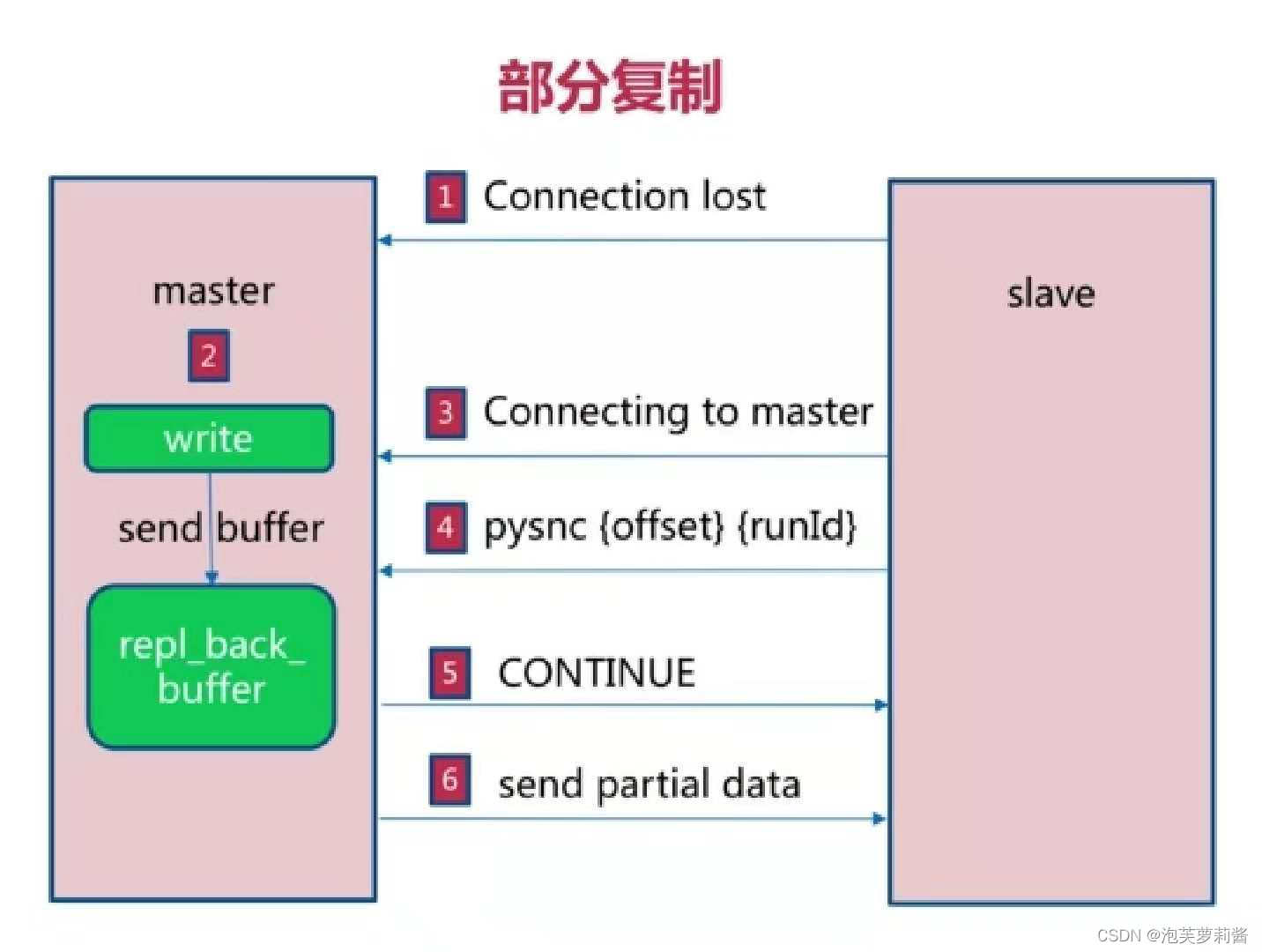

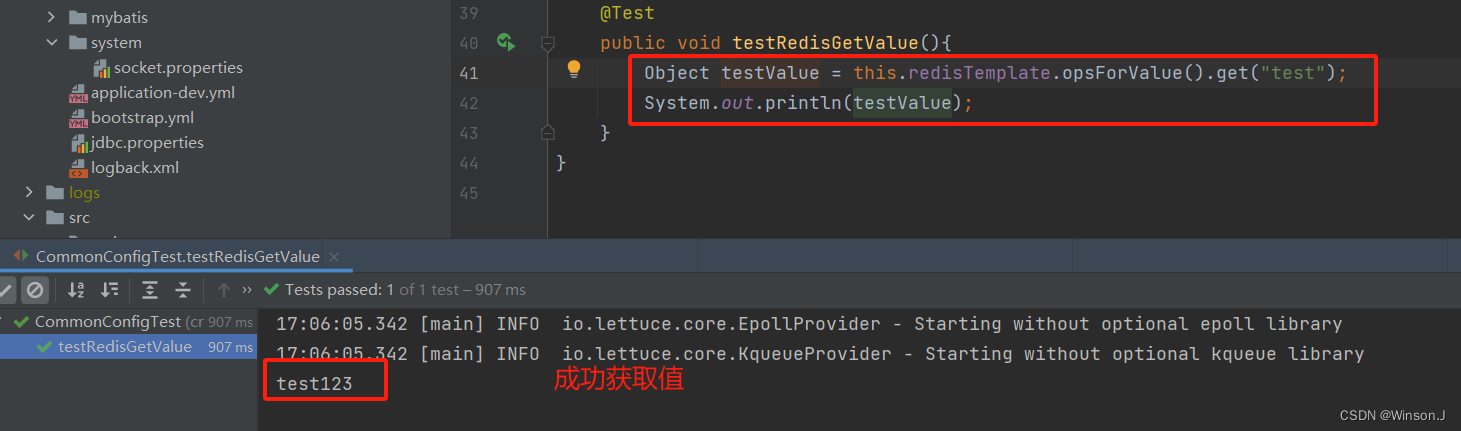

Java学习 - Redis主从复制

主从复制是什么 用于建立一个和主数据库完全一样的数据库环境,称为从数据库 主从复制的作用 数据备份读写分离 主从复制使用方式 通过slaveof命令 创建从节点 redis-slave> slaveof 127.0.0.1 6379取消从节点 redis-slave> slaveof no one通过配置 配置…...

图的拓扑排序

图的拓扑排序(Topological Sorting)是一种线性排序,用于有向无环图(Directed Acyclic Graph,DAG)。拓扑排序将图中的顶点排成一个线性序列,使得对于每一条有向边 (u, v),顶点 u 都排…...

windows USB 设备驱动开发-总章

通用串行总线 (USB) 提供可扩展的即插即用串行接口,确保外围设备的标准、低成本的连接。 USB 设备包括键盘、鼠标、游戏杆、打印机、扫描仪、存储设备、调制解调器、视频会议摄像头等。USB-IF 是一个特别兴趣组 (SIG),负责维护官方 USB 规范、测试规范和…...

springboot解析自定义yml文件

背景 公司产品微服务架构下有十几个模块,几乎大部分模块都要连接redis。每次在客户那里部署应用,都要改十几遍配置,太痛苦了。当然可以用nacos配置中心的功能,配置公共参数。不过我是喜欢在应用级别上解决问题,因为并不…...

【C/C++】静态函数调用类中成员函数方法 -- 最快捷之一

背景 注册回调函数中,回调函数是一个静态函数。需要调用类对象中的一个成员函数进行后续通知逻辑。 方案 定义全局指针,用于指向类对象this指针 static void *s_this_obj;类构造函数中,将全局指针指向所需类的this指针 s_this_obj this…...

佣金的定义和类型

1. 佣金的定义 基本定义:佣金是指在商业交易中,代理人或中介机构为促成交易所获得的报酬。它通常是按交易金额的一定比例计算和支付的。支付方式:佣金可以是固定金额,也可以是交易金额的百分比。 2. 佣金的类型 销售佣金&#…...

)

python数据分析实训任务二(‘风力风向’)

import numpy as np import matplotlib.pyplot as plt # 数据 labelsnp.array([东风, 东北风, 北风, 西北风, 西风, 西南风, 南风, 东南风]) statsnp.array([2.1, 2, 0, 3, 1.5, 3, 6, 4]) # 将角度转换为弧度 anglesnp.linspace(0, 2*np.pi, len(labels), endpointFalse).toli…...

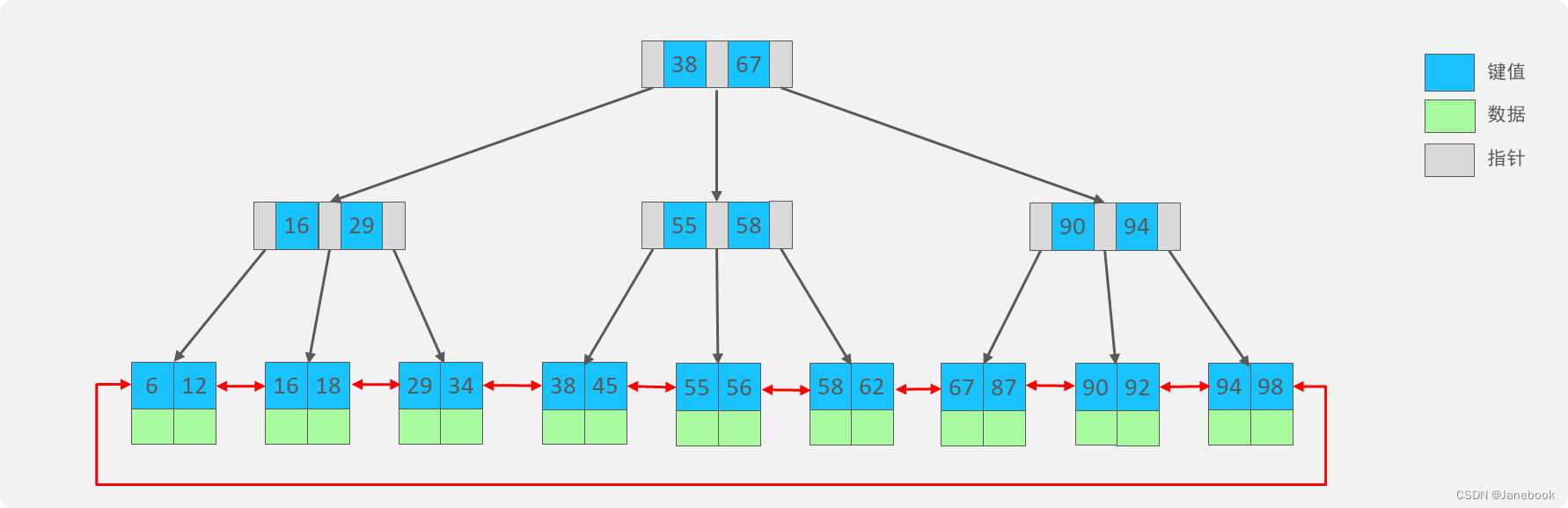

Java技术栈总结:数据库MySQL篇

一、慢查询 1、常见情形 聚合查询 多表查询 表数据量过大查询 深度分页查询 2、定位慢查询 方案一、开源工具 调试工具:Arthas运维工具:Prometheus、Skywalking 方案二、MySQL自带慢日志 在MySQL配置文件 /etc/my.conf 中配置: # …...

vue-cli 项目打包优化-基础篇

1、项目打包完运行空白 引用资源路径问题,打包完的【index.html】文件引用其他文件的引用地址不对 参考配置:https://cli.vuejs.org/zh/config 修改vue.config.js ,根据与 后端 或 运维 沟通修改 module.export {// 默认 publicPath: //…...

24/06/26(1.1129)动态内存

strtok 字符串分割函数 #include<stdio.h> int main(){ char str[] "this,a sample string."; char* sep ","; char* pch strtok(str, sep); printf("%s\n", pch); while (pch ! NULL){ printf("%s\…...

基于 elementUI / elementUI plus,实现 主要色(主题色)的一件换色(换肤)

一、效果图 二、方法 改变elementUI 的主要色 --el-color-primary 为自己选择的颜色,核心代码如下: // 处理主题样式 export function handleThemeStyle(theme) {document.documentElement.style.setProperty(--el-color-primary, theme) } 三、全部代…...

js 计算某个日期加月份最后月份不会增加或者跳变

/** * * param {*} dateString 原来日期 2023-12-31 * param {*} months 加月份 2 * returns 2024-02-29 */ export function getDateByMonth(dateString, months0) { console.log(1); let oldMonths dateString.substring(0,7); let day dateString.substring(8); let …...

Git简介与详细教程

一、简介 什么是Git? Git是一款分布式版本控制系统,由Linux之父Linus Torvalds于2005年开发。它旨在快速、高效地处理从小型到大型项目的所有内容。Git与传统的版本控制系统相比,具备显著的优势,主要体现在其分布式架构、强大的…...

创建OpenWRT虚拟机

环境:Ubuntu 2204,VM VirtualBox 7.0.18 安装必备软件包: sudo apt update sudo apt install subversion automake make cmake uuid-dev gcc vim build-essential clang flex bison g gawk gcc-multilib g-multilib gettext git libncurses…...

智慧安防新篇章:如何科学设定可燃气体报警器校准检测周期

随着科技的快速发展,智慧安防系统已成为现代社会不可或缺的一部分。在各类安全监测设备中,可燃气体报警器因其对潜在危险的及时预警功能而备受关注。 接下来,佰德将围绕可燃气体报警器的校准检测周期进行深入探讨,以确保其在智慧…...

如何优化Spring Boot应用的启动时间

如何优化Spring Boot应用的启动时间 大家好,我是免费搭建查券返利机器人省钱赚佣金就用微赚淘客系统3.0的小编,也是冬天不穿秋裤,天冷也要风度的程序猿!今天我们将讨论如何优化Spring Boot应用的启动时间,提升应用的性…...

(Effective C) 2.3 作用域

(Effective C) 2.3 作用域 文章目录 (Effective C) 2.3 作用域前言🔢4大作用域1️⃣文件作用域2️⃣块作用域3️⃣函数原型作用域4️⃣函数作用域 ⭐作用域性质📖实例CodeEND关注我 前言 作用域应用于标识符的某个特定声明。 标识符包含对象࿰…...

iPhone密码忘记了办?iPhoneUnlocker,iPhone解锁工具Aiseesoft iPhone Unlocker 高级注册版分享

平时用 iPhone 的时候,难免会碰到解锁的麻烦事。比如密码忘了、人脸识别 / 指纹识别突然不灵,或者买了二手 iPhone 却被原来的 iCloud 账号锁住,这时候就需要靠谱的解锁工具来帮忙了。Aiseesoft iPhone Unlocker 就是专门解决这些问题的软件&…...

AtCoder 第409场初级竞赛 A~E题解

A Conflict 【题目链接】 原题链接:A - Conflict 【考点】 枚举 【题目大意】 找到是否有两人都想要的物品。 【解析】 遍历两端字符串,只有在同时为 o 时输出 Yes 并结束程序,否则输出 No。 【难度】 GESP三级 【代码参考】 #i…...

江苏艾立泰跨国资源接力:废料变黄金的绿色供应链革命

在华东塑料包装行业面临限塑令深度调整的背景下,江苏艾立泰以一场跨国资源接力的创新实践,重新定义了绿色供应链的边界。 跨国回收网络:废料变黄金的全球棋局 艾立泰在欧洲、东南亚建立再生塑料回收点,将海外废弃包装箱通过标准…...

C# SqlSugar:依赖注入与仓储模式实践

C# SqlSugar:依赖注入与仓储模式实践 在 C# 的应用开发中,数据库操作是必不可少的环节。为了让数据访问层更加简洁、高效且易于维护,许多开发者会选择成熟的 ORM(对象关系映射)框架,SqlSugar 就是其中备受…...

c#开发AI模型对话

AI模型 前面已经介绍了一般AI模型本地部署,直接调用现成的模型数据。这里主要讲述讲接口集成到我们自己的程序中使用方式。 微软提供了ML.NET来开发和使用AI模型,但是目前国内可能使用不多,至少实践例子很少看见。开发训练模型就不介绍了&am…...

C++ Visual Studio 2017厂商给的源码没有.sln文件 易兆微芯片下载工具加开机动画下载。

1.先用Visual Studio 2017打开Yichip YC31xx loader.vcxproj,再用Visual Studio 2022打开。再保侟就有.sln文件了。 易兆微芯片下载工具加开机动画下载 ExtraDownloadFile1Info.\logo.bin|0|0|10D2000|0 MFC应用兼容CMD 在BOOL CYichipYC31xxloaderDlg::OnIni…...

HashMap中的put方法执行流程(流程图)

1 put操作整体流程 HashMap 的 put 操作是其最核心的功能之一。在 JDK 1.8 及以后版本中,其主要逻辑封装在 putVal 这个内部方法中。整个过程大致如下: 初始判断与哈希计算: 首先,putVal 方法会检查当前的 table(也就…...

基于Java Swing的电子通讯录设计与实现:附系统托盘功能代码详解

JAVASQL电子通讯录带系统托盘 一、系统概述 本电子通讯录系统采用Java Swing开发桌面应用,结合SQLite数据库实现联系人管理功能,并集成系统托盘功能提升用户体验。系统支持联系人的增删改查、分组管理、搜索过滤等功能,同时可以最小化到系统…...

)

C#学习第29天:表达式树(Expression Trees)

目录 什么是表达式树? 核心概念 1.表达式树的构建 2. 表达式树与Lambda表达式 3.解析和访问表达式树 4.动态条件查询 表达式树的优势 1.动态构建查询 2.LINQ 提供程序支持: 3.性能优化 4.元数据处理 5.代码转换和重写 适用场景 代码复杂性…...

c# 局部函数 定义、功能与示例

C# 局部函数:定义、功能与示例 1. 定义与功能 局部函数(Local Function)是嵌套在另一个方法内部的私有方法,仅在包含它的方法内可见。 • 作用:封装仅用于当前方法的逻辑,避免污染类作用域,提升…...