图书馆数据仓库

目录

1.数据仓库的数据来源为业务数据库(mysql)

初始化脚本

init_book_result.sql

2.通过sqoop将mysql中的业务数据导入到大数据平台(hive)

导入mysql数据到hive中

3.通过hive进行数据计算和数据分析 形成数据报表

4.再通过sqoop将数据报表导出到mysql

5.使用FineReport制作数据报表

1.数据仓库的数据来源为业务数据库(mysql)

包含 图书表 t_book_info,

借书表 t_borrow_info,

用户表 t_user_info 38条数据

图书类别表 dim_books_type 5条

初始化脚本

init_mysql.sql

-- 设置sql_mode

set sql_mode = 'NO_ENGINE_SUBSTITUTION,STRICT_TRANS_TABLES';-- 创建数据库library

create database library;-- 切换数据库

use library;-- 创建用户信息表

CREATE TABLE t_user_info(user_id varchar(100) not null,user_name varchar(100) not null,sex varchar(10) not null,age int not null

)DEFAULT CHARSET='utf8';-- 创建图书表

CREATE TABLE t_book_info(book_id varchar(100) not null,book_name varchar(100) not null,type_id varchar(100) not null

)DEFAULT CHARSET='utf8';-- 创建图书类别表

CREATE TABLE dim_books_type(type_id varchar(100) not null,type_name varchar(100) not null

)DEFAULT CHARSET='utf8';-- 创建借书表

CREATE TABLE t_borrow_order(user_id varchar(100) not null,book_id varchar(100) not null,create_time varchar(100) not null

)DEFAULT CHARSET='utf8';-- 用户信息表插入数据

insert into t_user_info values ('114', '王小名', '男', 22);

insert into t_user_info values ('115', '张美丽', '女', 27);

insert into t_user_info values ('116', '李华', '男', 30);

insert into t_user_info values ('117', '陈晓红', '女', 35);

insert into t_user_info values ('118', '赵伟', '男', 24);

insert into t_user_info values ('119', '周小燕', '女', 29);

insert into t_user_info values ('120', '吴强', '男', 33);

insert into t_user_info values ('121', '郑丽', '女', 26);

insert into t_user_info values ('122', '王刚', '男', 28);

insert into t_user_info values ('123', '黄芳', '女', 31);

insert into t_user_info values ('124', '刘涛', '男', 36);

insert into t_user_info values ('125', '杨静', '女', 25);

insert into t_user_info values ('126', '张杰', '男', 32);

insert into t_user_info values ('127', '陈莉', '女', 23);

insert into t_user_info values ('128', '赵勇', '男', 38);

insert into t_user_info values ('129', '周敏', '女', 30);

insert into t_user_info values ('130', '吴浩', '男', 29);

insert into t_user_info values ('131', '郑薇', '女', 34);

insert into t_user_info values ('132', '王林', '男', 27);

insert into t_user_info values ('133', '黄梅', '女', 26);

insert into t_user_info values ('134', '刘军', '男', 37);

insert into t_user_info values ('135', '杨慧', '女', 25);

insert into t_user_info values ('136', '张明', '男', 33);

insert into t_user_info values ('137', '陈霞', '女', 31);

insert into t_user_info values ('138', '赵海', '男', 28);

insert into t_user_info values ('139', '周兰', '女', 36);

insert into t_user_info values ('140', '吴飞', '男', 24);

insert into t_user_info values ('141', '郑敏', '女', 27);

insert into t_user_info values ('142', '王磊', '男', 35);

insert into t_user_info values ('143', '黄蓉', '女', 30);

insert into t_user_info values ('144', '刘丽', '女', 26);

insert into t_user_info values ('145', '杨勇', '男', 32);

insert into t_user_info values ('146', '张华', '男', 29);

insert into t_user_info values ('147', '陈敏', '女', 34);

insert into t_user_info values ('148', '赵丽', '女', 31);

insert into t_user_info values ('149', '周刚', '男', 25);

insert into t_user_info values ('150', '吴丽', '女', 37);

insert into t_user_info values ('151', '郑强', '男', 28);

insert into t_user_info values ('152', '王芳', '女', 33);

insert into t_user_info values ('153', '黄伟', '男', 27);

insert into t_user_info values ('154', '刘静', '女', 36);

insert into t_user_info values ('155', '杨华', '男', 24);

insert into t_user_info values ('156', '张敏', '女', 31);

insert into t_user_info values ('157', '陈军', '男', 30);

insert into t_user_info values ('158', '赵敏', '女', 26);

insert into t_user_info values ('159', '周强', '男', 35);

insert into t_user_info values ('160', '吴红', '女', 32);

insert into t_user_info values ('161', '郑丽', '女', 29);

insert into t_user_info values ('162', '王伟', '男', 34);

insert into t_user_info values ('163', '黄静', '女', 31);

insert into t_user_info values ('164', '刘涛', '男', 25);

insert into t_user_info values ('165', '杨敏', '女', 37);

insert into t_user_info values ('166', '张勇', '男', 28);

insert into t_user_info values ('167', '陈芳', '女', 33);

insert into t_user_info values ('168', '赵军', '男', 27);

insert into t_user_info values ('169', '周丽', '女', 36);

insert into t_user_info values ('170', '吴华', '男', 24);commit;-- 图书表插入数据

-- Book Type: 散文随笔 (a)

insert into t_book_info values ('a001', '珠江潮汐美', 'a');

insert into t_book_info values ('a002', '晨曦的低语', 'a');

insert into t_book_info values ('a003', '山间小路', 'a');

insert into t_book_info values ('a004', '秋叶之歌', 'a');

insert into t_book_info values ('a005', '夜色中的琴声', 'a');

insert into t_book_info values ('a006', '城市边缘的诗人', 'a');

insert into t_book_info values ('a007', '冬日里的暖阳', 'a');

insert into t_book_info values ('a008', '海边的沉思', 'a');

-- book type: 世界名著 (b)

insert into t_book_info values ('b001', '悲惨世界', 'b');

insert into t_book_info values ('b002', '百年孤独', 'b');

insert into t_book_info values ('b003', '双城记', 'b');

insert into t_book_info values ('b004', '战争与和平', 'b');

insert into t_book_info values ('b005', '简爱', 'b');

insert into t_book_info values ('b006', '飘', 'b');

insert into t_book_info values ('b007', '堂吉诃德', 'b');

insert into t_book_info values ('b008', '呼啸山庄', 'b');

-- book type: 少儿童书 (c)

insert into t_book_info values ('c001', '小王子的星球', 'c');

insert into t_book_info values ('c002', '魔法森林的秘密', 'c');

insert into t_book_info values ('c003', '海底两万里', 'c');

insert into t_book_info values ('c004', '勇敢的小火车头', 'c');

insert into t_book_info values ('c005', '神奇的种子', 'c');

insert into t_book_info values ('c006', '月亮上的兔子', 'c');

insert into t_book_info values ('c007', '彩虹桥下的秘密', 'c');

insert into t_book_info values ('c008', '会说话的石头', 'c');

-- book type: 历史小说 (d)

insert into t_book_info values ('d001', '三国演义', 'd');

insert into t_book_info values ('d002', '水浒传', 'd');

insert into t_book_info values ('d003', '大明王朝', 'd');

insert into t_book_info values ('d004', '清朝末年', 'd');

insert into t_book_info values ('d005', '大唐盛世', 'd');

insert into t_book_info values ('d006', '宋朝风云', 'd');

insert into t_book_info values ('d007', '明朝那些事儿', 'd');

insert into t_book_info values ('d008', '清朝宫廷秘史', 'd');

-- book type: 国学入门 (e)

insert into t_book_info values ('e001', '论语解读', 'e');

insert into t_book_info values ('e002', '道德经注释', 'e');

insert into t_book_info values ('e003', '易经初探', 'e');

insert into t_book_info values ('e004', '诗经选读', 'e');

insert into t_book_info values ('e005', '孟子精讲', 'e');

insert into t_book_info values ('e006', '庄子心解', 'e');

insert into t_book_info values ('e007', '大学中庸', 'e');

insert into t_book_info values ('e008', '孝经新解', 'e');commit;-- 图书类别表插入数据

insert into dim_books_type values('a','散文随笔');

insert into dim_books_type values('b','世界名著');

insert into dim_books_type values('c','少儿童书');

insert into dim_books_type values('d','历史小说');

insert into dim_books_type values('e','国学入门');commit;-- 借书表插入数据

insert into t_borrow_order values('114','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('115','e002','2022-11-08 09:23:54');

insert into t_borrow_order values('114','b003','2022-11-08 09:23:54');

insert into t_borrow_order values('116','d002','2022-11-08 09:23:54');

insert into t_borrow_order values('114','c001','2022-11-08 09:23:54');

insert into t_borrow_order values('115','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('117','b004','2022-11-08 09:23:54');

insert into t_borrow_order values('118','a007','2022-11-08 09:23:54');

insert into t_borrow_order values('118','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('119','e003','2022-11-08 09:23:54');

insert into t_borrow_order values('119','d001','2022-11-08 09:23:54');

insert into t_borrow_order values('120','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('120','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('121','d005','2022-11-08 09:23:54');

insert into t_borrow_order values('123','b006','2022-11-08 09:23:54');

insert into t_borrow_order values('124','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('125','e004','2022-11-08 09:23:54');

insert into t_borrow_order values('126','b002','2022-11-08 09:23:54');

insert into t_borrow_order values('127','a003','2022-11-08 09:23:54');

insert into t_borrow_order values('124','d002','2022-11-08 09:23:54');

insert into t_borrow_order values('122','b001','2022-11-08 09:23:54');

insert into t_borrow_order values('128','a001','2022-11-08 09:23:54');

insert into t_borrow_order values('129','a006','2022-11-08 09:23:54');

insert into t_borrow_order values('125','d008','2022-11-08 09:23:54');

insert into t_borrow_order values('123','e008','2022-11-08 09:23:54');

insert into t_borrow_order values('120','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('130','b007','2022-11-08 09:23:54');

insert into t_borrow_order values('131','a007','2022-11-08 09:23:54');

insert into t_borrow_order values('132','a008','2022-11-08 09:23:54');

insert into t_borrow_order values('133','e004','2022-11-08 09:23:54');

insert into t_borrow_order values('135','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('133','d003','2022-11-08 09:23:54');

insert into t_borrow_order values('136','a003','2022-11-08 09:23:54');

insert into t_borrow_order values('138','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('139','d001','2022-11-08 09:23:54');

insert into t_borrow_order values('133','e001','2022-11-08 09:23:54');

insert into t_borrow_order values('133','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('132','e002','2022-11-08 09:23:54');

insert into t_borrow_order values('131','a003','2022-11-08 09:23:54');

insert into t_borrow_order values('141','b003','2022-11-08 09:23:54');

insert into t_borrow_order values('140','e003','2022-11-08 09:23:54');

insert into t_borrow_order values('142','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('142','d005','2022-11-08 09:23:54');

insert into t_borrow_order values('146','b006','2022-11-08 09:23:54');

insert into t_borrow_order values('144','d006','2022-11-08 09:23:54');

insert into t_borrow_order values('148','d007','2022-11-08 09:23:54');

insert into t_borrow_order values('144','e003','2022-11-08 09:23:54');

insert into t_borrow_order values('142','a003','2022-11-08 09:23:54');

insert into t_borrow_order values('143','e003','2022-11-08 09:23:54');

insert into t_borrow_order values('149','d004','2022-11-08 09:23:54');

insert into t_borrow_order values('150','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('151','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('151','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('154','d003','2022-11-08 09:23:54');

insert into t_borrow_order values('153','d002','2022-11-08 09:23:54');

insert into t_borrow_order values('156','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('155','d003','2022-11-08 09:23:54');

insert into t_borrow_order values('157','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('158','d005','2022-11-08 09:23:54');

insert into t_borrow_order values('159','a005','2022-11-08 09:23:54');

insert into t_borrow_order values('154','c006','2022-11-08 09:23:54');

insert into t_borrow_order values('153','d007','2022-11-08 09:23:54');

insert into t_borrow_order values('152','c004','2022-11-08 09:23:54');

insert into t_borrow_order values('154','a004','2022-11-08 09:23:54');

insert into t_borrow_order values('151','d003','2022-11-08 09:23:54');

insert into t_borrow_order values('152','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('162','c003','2022-11-08 09:23:54');

insert into t_borrow_order values('161','a001','2022-11-08 09:23:54');

insert into t_borrow_order values('166','d002','2022-11-08 09:23:54');

insert into t_borrow_order values('163','a002','2022-11-08 09:23:54');

insert into t_borrow_order values('167','c003','2022-11-08 09:23:54');

insert into t_borrow_order values('169','a005','2022-11-08 09:23:54');

commit;init_book_result.sql

-- 设置sql_mode

set sql_mode = 'NO_ENGINE_SUBSTITUTION,STRICT_TRANS_TABLES';-- 创建数据库result,并进行切换

create database book_result;use book_result;-- 创建图书类别浏览量表

CREATE TABLE t_books_type_borrow_count(type_name varchar(100) not null,borrow_count int not null

)DEFAULT CHARSET='utf8';

2.通过sqoop将mysql中的业务数据导入到大数据平台(hive)

在hive中建立映射的数据库

init_hive.sql

create database library;

use library;-- 创建用户信息表create table t_user_info (user_id STRING comment "用户id", user_name STRING comment "用户姓名", sex STRING comment "用户姓名", age INT comment "用户性别"

)

comment "用户信息表"

row format delimited fields terminated by ','

stored as textfile;-- 创建图书表create table t_book_info (book_id STRING comment "图书id", book_name STRING comment "书名", type_id STRING comment "类别id"

)

comment "图书表"

row format delimited fields terminated by ','

stored as textfile;-- 创建图书类别表create table dim_books_type (type_id STRING comment "类别id", type_name STRING comment "类别名"

)

comment "图书类别表"

row format delimited fields terminated by ','

stored as textfile;-- 创建借书表create table t_borrow_order (user_id STRING comment "用户id", book_id STRING comment "图书id", create_time STRING comment "创建时间"

)

comment "借书表"

row format delimited fields terminated by ','

stored as textfile;source /opt/sql/library/init_hive.sql;

导入mysql数据到hive中

此次mysql与hive中的表名都相同

sqoop import \

虚拟机 端口号 mysql中的数据库名

--connect jdbc:mysql://bigdata004:3306/mall \

--username root \

--password root123 \

mysql中的表名

--table t_user_info \

--num-mappers 1 \

--hive-import \

--fields-terminated-by "," \

--hive-overwrite \

导入dim_books_type

sqoop import \

--connect jdbc:mysql://bigdata004:3306/library \

--username root \

--password root123 \

--table dim_books_type \

--num-mappers 1 \

--hive-import \

--fields-terminated-by "," \

--hive-overwrite \

--hive-table library.dim_books_type3.通过hive进行数据计算和数据分析 形成数据报表

--切换数据库

use library;--创建图书类别借阅表

--从借书表中获取图书id

--从图书表中获取图书id的类别id

--从类别表中获取类别名

--表中显示 类名 和 该类名的总数()create table if not exists library.dws_borrow_books_type_count

asselect t3.type_name,count(t2.type_id) as borrow_count from (select book_id from t_borrow_order) t1inner join t_book_info t2 on t1.book_id=t2.book_idinner join dim_books_type t3 on t2.type_id=t3.type_idgroup by t3.type_name;4.再通过sqoop将数据报表导出到mysql

-- sqoop导出数据到mysql

sqoop export \

主机名 数据库

--connect jdbc:mysql://bigdata004:3306/result \

--username root \

--password root123 \

mysql上的表名

--table t_city_sale_total \

--num-mappers 1 \

hdfs上的数据库位置

--export-dir /user/hive/warehouse/mall_bigdata.db/dws_sale_order_city_total \

--input-fields-terminated-by "\001"

-- sqoop导出数据到mysqlsqoop export \

--connect jdbc:mysql://bigdata004:3306/book_result \

--username root \

--password root123 \

--table t_books_type_borrow_count \

--num-mappers 1 \

--export-dir /user/hive/warehouse/library.db/dws_borrow_books_type_count \

--input-fields-terminated-by "\001"

5.使用FineReport制作数据报表

相关文章:

图书馆数据仓库

目录 1.数据仓库的数据来源为业务数据库(mysql) 初始化脚本 init_book_result.sql 2.通过sqoop将mysql中的业务数据导入到大数据平台(hive) 导入mysql数据到hive中 3.通过hive进行数据计算和数据分析 形成数据报表 4.再通过sq…...

基于uniapp(vue3)H5附件上传组件,可限制文件大小

代码: <template><view class"upload-file"><text>最多上传5份附件,需小于50M</text><view class"" click"selectFile">上传</view></view><view class"list" v…...

Phoenix Omid Timestamp Oracle 组件实现原理

Omid Timestamp Oracle 组件实现原理 作用 生成全局单调递增的时间戳,支持获取操作和崩溃恢复。 功能 1.生成全局单调递增的时间戳(支持崩溃恢复)apinext返回下一个时间戳getLast返回最后一个分配的时间戳(当前时间戳)实现方式TimestampOracleImpl单调递增的时间…...

Lex Fridman Podcast with Andrej Karpathy

我不太喜欢Lex Fridman的声音,总觉得那让人昏昏欲睡, 但无奈他采访的人都太大牌了,只能去听。但是听着听着,就会觉得有深度的采访这些人,似乎也只有他这种由研究员背景的人能干, 另,他提的问题确…...

力扣1895.最大的幻方

力扣1895.最大的幻方 求前缀和暴力枚举幻方边长 求行列前缀和 class Solution {public:int largestMagicSquare(vector<vector<int>>& grid) {int n grid.size() , m grid[0].size();vector<vector<int>> rowsum(n,vector<int>(m));for…...

【C++】 解决 C++ 语言报错:Segmentation Fault

文章目录 引言 段错误(Segmentation Fault)是 C 编程中常见且令人头疼的错误之一。段错误通常发生在程序试图访问未被允许的内存区域时,导致程序崩溃。本文将深入探讨段错误的产生原因、检测方法及其预防和解决方案,帮助开发者在…...

【linuxC语言】手撕Http协议之程序框架

文章目录 前言提示基本框架主函数一个小问题代码概况多线程版本单线程版本总结前言 在现代网络编程中,HTTP协议无疑是最常用的协议之一。它是互联网上应用最为广泛的一种网络协议。理解HTTP协议并能够手动实现它,对于深入理解网络编程和提高编程技能都有着重要的意义。本文将…...

溶解氧(DO)理论指南(1)

转载自梅特勒官网资料,仅用于学习交流,侵权则删! 溶解氧理论指南 1 溶解氧(DO)原理1.1 溶解氧和分压1.2 氧气在水中的溶解度1.3 溶解氧对生物的重要性1.4 溶解氧对工业的重要性 1 溶解氧(DO)原理 氧是宇宙中第三大常见元素,也是…...

Mysql中常用函数的使用示例

场景 基础知识回顾:mysql中常用函数的使用示例。 注: 博客:霸道流氓气质-CSDN博客 实现 数学函数 -- ABS(x)返回x的绝对值 SELECT ABS(-1),ABS(2); -- PI()返回圆周率 SELECT PI(); -- SQRT(x)返回非负数x的二次方根 SELECT SQRT(4); -…...

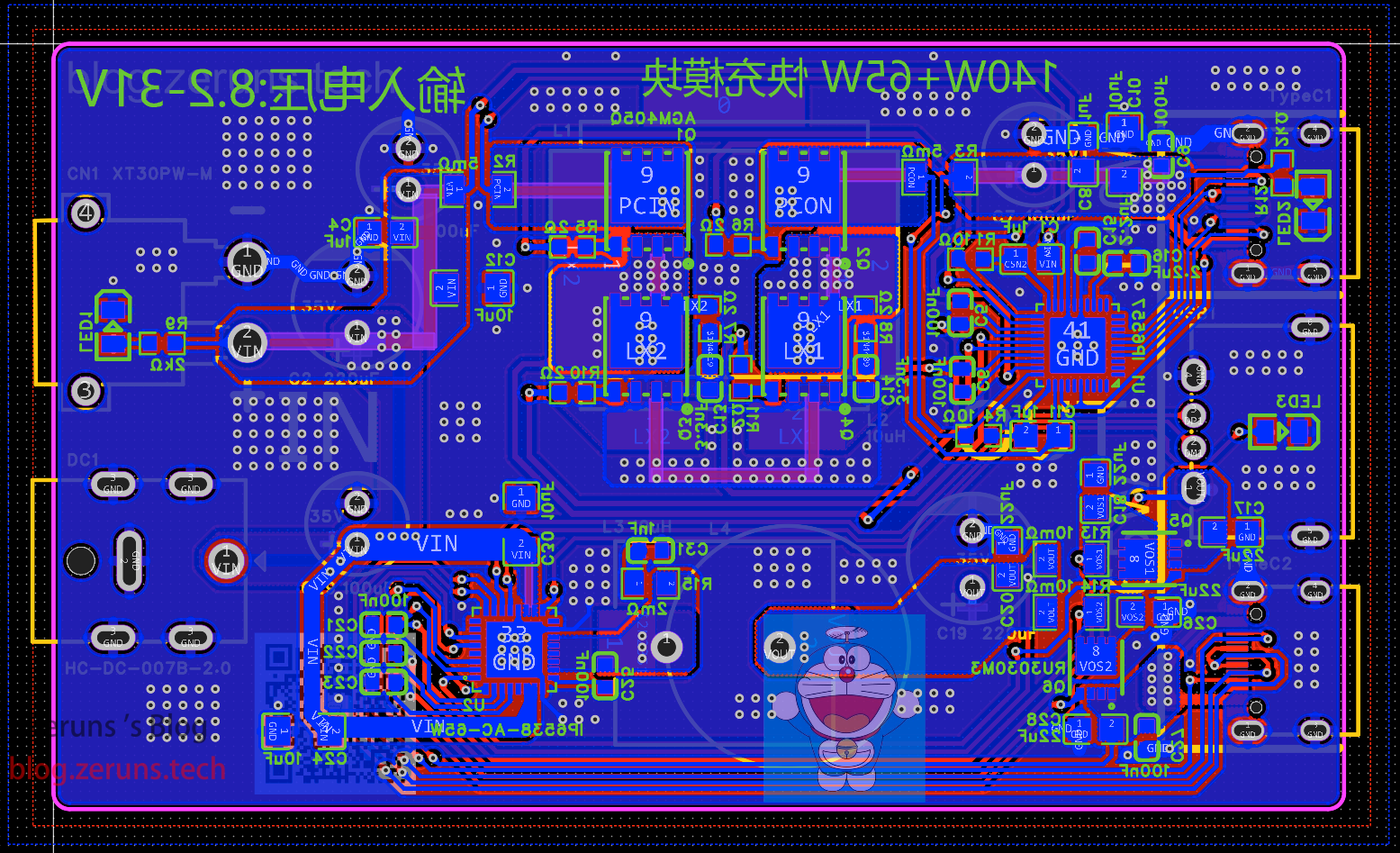

开源205W桌面充电器,140W+65W升降压PD3.1快充模块(2C+1A口),IP6557+IP6538

开源一个基于IP6557和IP6538芯片的205W升降压快充模块(140W65W),其中一路C口支持PD3.1协议,最高输出28V5A,另一路是A口C口,最高输出65W(20V3.25A),可搭配一个24V10A的开关…...

Java中的内存数据库与缓存技术

Java中的内存数据库与缓存技术 大家好,我是免费搭建查券返利机器人省钱赚佣金就用微赚淘客系统3.0的小编,也是冬天不穿秋裤,天冷也要风度的程序猿! 1. 内存数据库的概念与优势 1.1 什么是内存数据库? 内存数据库是…...

GUKE万能工具箱(附带源码)

GUKE万能工具箱(附带源码) 效果图部分源码领取完整源码下期更新 效果图 部分源码 <!DOCTYPE html> <html><head><meta charset"utf-8" name"viewport" content"widthdevice-width, initial-scale1"…...

使用ZLMediaKit开启SRT视频直播服务)

FFmpeg开发笔记(四十二)使用ZLMediaKit开启SRT视频直播服务

《FFmpeg开发实战:从零基础到短视频上线》一书在第10章介绍了轻量级流媒体服务器MediaMTX,通过该工具可以测试RTSP/RTMP等流媒体协议的推拉流。不过MediaMTX的功能实在是太简单了,无法应用于真实直播的生产环境,真正能用于生产环境…...

spring-boot-starter-data-redis是否支持reactive响应式编程

开源项目SDK:https://github.com/mingyang66/spring-parent 个人文档:https://mingyang66.github.io/raccoon-docs/#/ spring-boot-starter-data-redis: 使用传统的基于阻塞的I/O编程模型,这意味着当你调用Redis操作时࿰…...

Java后端每日面试题(day3)

目录 Spring中Bean的作用域有哪些?Spring中Bean的生命周期Bean 是线程安全的吗?了解Spring Boot中的日志组件吗? Spring中Bean的作用域有哪些? Bean的作用域: singleton:单例,Spring中的bean默…...

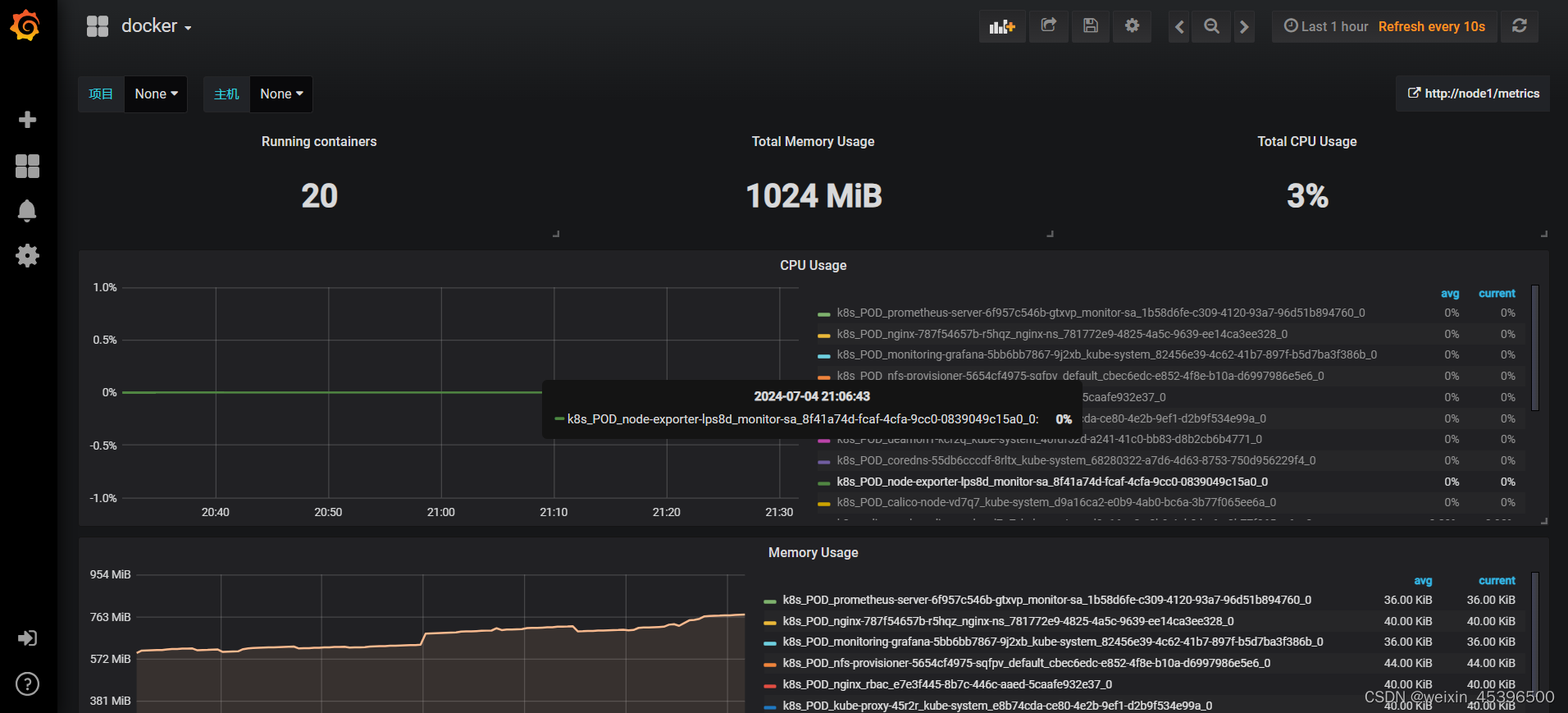

[单master节点k8s部署]18.监控系统构建(三)Grafana安装

Grafana是一个跨平台的开源的度量分析和可视化工具。支持多种数据源,比如OpenTSDB,Prometheus,ElasticResearch,Cloudwatch等。 Grafana安装 通过yaml配置grafana的pod和service,grafana工作在kube-system的命名空间…...

【JavaScript脚本宇宙】优化你的Web色彩:精选JavaScript颜色工具对比

万能色彩助手:详解最受欢迎的JavaScript颜色库 前言 在现代Web开发中,颜色处理和转换是一个不可忽视的环节。无论是网站设计、数据可视化还是用户界面开发,都离不开对颜色的精确控制和转换。为了满足这一需求,众多JavaScript库应…...

用html+css设计一个列表清单小卡片

目录 简介: 效果图: 源代码: 可能的问题: 简介: 这个HTML代码片段是一个简单的列表清单设计。它包含一个卡片元素(class为"card"),内部包含一个无序列表(ul),列表项(li)前面有一个特殊的符号(△)。整个卡片元素设计成300px宽,150px高,具有圆角边…...

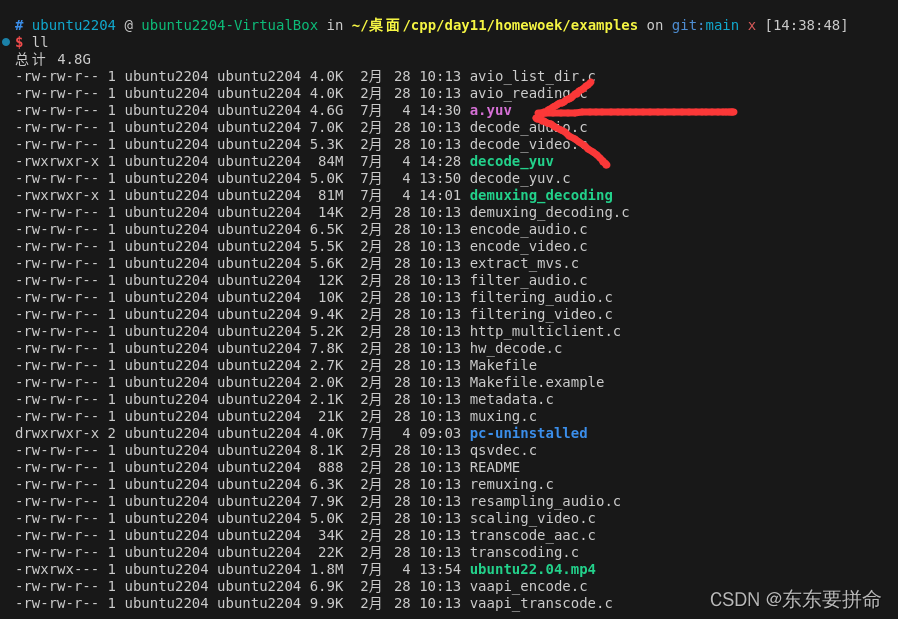

day11_homework_need2submit

Homework 编写—个将ts或mp4中视频文件解码到yuv的程序 yuv数据可以使用如下命令播放: ffplay -i output yuv-pix_fmt yuv420p-s 1024x436 要求: ffmpeg解析到avpacket并打印出pts和dts字段完成解码到avframe并打印任意字段完成yuv数据保存 // teminal orders on bash cd ex…...

昇思MindSpore学习总结九——FCN语义分割

1、语义分割 图像语义分割(semantic segmentation)是图像处理和机器视觉技术中关于图像理解的重要一环,AI领域中一个重要分支,常被应用于人脸识别、物体检测、医学影像、卫星图像分析、自动驾驶感知等领域。 语义分割的目的是对图…...

VB.net复制Ntag213卡写入UID

本示例使用的发卡器:https://item.taobao.com/item.htm?ftt&id615391857885 一、读取旧Ntag卡的UID和数据 Private Sub Button15_Click(sender As Object, e As EventArgs) Handles Button15.Click轻松读卡技术支持:网站:Dim i, j As IntegerDim cardidhex, …...

工业安全零事故的智能守护者:一体化AI智能安防平台

前言: 通过AI视觉技术,为船厂提供全面的安全监控解决方案,涵盖交通违规检测、起重机轨道安全、非法入侵检测、盗窃防范、安全规范执行监控等多个方面,能够实现对应负责人反馈机制,并最终实现数据的统计报表。提升船厂…...

《Qt C++ 与 OpenCV:解锁视频播放程序设计的奥秘》

引言:探索视频播放程序设计之旅 在当今数字化时代,多媒体应用已渗透到我们生活的方方面面,从日常的视频娱乐到专业的视频监控、视频会议系统,视频播放程序作为多媒体应用的核心组成部分,扮演着至关重要的角色。无论是在个人电脑、移动设备还是智能电视等平台上,用户都期望…...

2024年赣州旅游投资集团社会招聘笔试真

2024年赣州旅游投资集团社会招聘笔试真 题 ( 满 分 1 0 0 分 时 间 1 2 0 分 钟 ) 一、单选题(每题只有一个正确答案,答错、不答或多答均不得分) 1.纪要的特点不包括()。 A.概括重点 B.指导传达 C. 客观纪实 D.有言必录 【答案】: D 2.1864年,()预言了电磁波的存在,并指出…...

Psychopy音频的使用

Psychopy音频的使用 本文主要解决以下问题: 指定音频引擎与设备;播放音频文件 本文所使用的环境: Python3.10 numpy2.2.6 psychopy2025.1.1 psychtoolbox3.0.19.14 一、音频配置 Psychopy文档链接为Sound - for audio playback — Psy…...

k8s业务程序联调工具-KtConnect

概述 原理 工具作用是建立了一个从本地到集群的单向VPN,根据VPN原理,打通两个内网必然需要借助一个公共中继节点,ktconnect工具巧妙的利用k8s原生的portforward能力,简化了建立连接的过程,apiserver间接起到了中继节…...

什么是Ansible Jinja2

理解 Ansible Jinja2 模板 Ansible 是一款功能强大的开源自动化工具,可让您无缝地管理和配置系统。Ansible 的一大亮点是它使用 Jinja2 模板,允许您根据变量数据动态生成文件、配置设置和脚本。本文将向您介绍 Ansible 中的 Jinja2 模板,并通…...

PAN/FPN

import torch import torch.nn as nn import torch.nn.functional as F import mathclass LowResQueryHighResKVAttention(nn.Module):"""方案 1: 低分辨率特征 (Query) 查询高分辨率特征 (Key, Value).输出分辨率与低分辨率输入相同。"""def __…...

从“安全密码”到测试体系:Gitee Test 赋能关键领域软件质量保障

关键领域软件测试的"安全密码":Gitee Test如何破解行业痛点 在数字化浪潮席卷全球的今天,软件系统已成为国家关键领域的"神经中枢"。从国防军工到能源电力,从金融交易到交通管控,这些关乎国计民生的关键领域…...

【Linux手册】探秘系统世界:从用户交互到硬件底层的全链路工作之旅

目录 前言 操作系统与驱动程序 是什么,为什么 怎么做 system call 用户操作接口 总结 前言 日常生活中,我们在使用电子设备时,我们所输入执行的每一条指令最终大多都会作用到硬件上,比如下载一款软件最终会下载到硬盘上&am…...