第37讲:Cephfs文件系统的正确使用姿势

文章目录

- 1.Cephfs文件系统简介

- 2.Cephfs文件系统细节介绍

- 2.1.Cephfs文件系统多客户端隔离挂载

- 2.2.Ceph集群中多个Cephfs如何单独使用

- 3.挂载多个Cephfs文件系统

- 4.Cephfs文件系统多客户端隔离挂载实战

- 4.1.创建一个Cephfs文件系统

- 4.2.将Cephfs文件系统挂载到本地路径

- 4.3.在Cephfs文件文件系统中创建多个目录

- 4.4.查看Cephfs文件系统的状态

- 4.5.客户端分别挂载不同的Cephfs文件系统中的子目录

- 5.卸载MDS的方法

- 6.小插曲

1.Cephfs文件系统简介

Cephfs文件系统至少需要一个MDS(Metadata Server组件)来存储文件系统的元数据信息,因此在使用Cephfs文件存储之前,首先要在集群中部署MDS组件,我们希望Cephfs文件存储具备高可用性,所以MDS组件一般都会在集群中部署多个,大多数情况下都是三个MDS组件。

Cephfs支持用户级别和内核级别的挂载使用,可扩展性极高,并且可以同时让多个Client客户端进行读写。

一个Cephfs文件系统至少需要两个Librados存储池,也就是Pool资源池,一个为data,存储具体落盘的数据,一个为metadata,存储数据文件的元数据信息。

建议为metadata的Pool资源池设置较高级别的副本数,因为metadata资源池损坏就会导致整个文件系统不可用,另外metadata的资源池要使用低延时的存储,例如SSD类型的磁盘,metadata会直接影响客户端的响应速度。

Cephfs文件系统正确使用姿势:

首次创建完Cephfs文件系统后,将其挂载到本地的一个路径中,然后在路径中创建出多个子级目录,客户端使用时挂载特定的子级目录。

这样做的好处是:既可以看到所有客户端在Cephfs文件系统中存储的数据,又可以让多个客户端之间实现数据的隔离存储。

2.Cephfs文件系统细节介绍

2.1.Cephfs文件系统多客户端隔离挂载

在Ceph集群中创建的Cephfs文件系统,其实是一个Volume,也就是一个空盘,只有一个/路径,这也是大多数直接挂载/的一个原因。

如果集群中只有一个Cephfs文件系统,在使用mount挂载时,无需指定使用哪个Cephfs文件系统,直接就是将这个Cephfs文件系统的/目录挂载到指定的路径中,就可以使用这个Cephfs文件系统进行存储了。

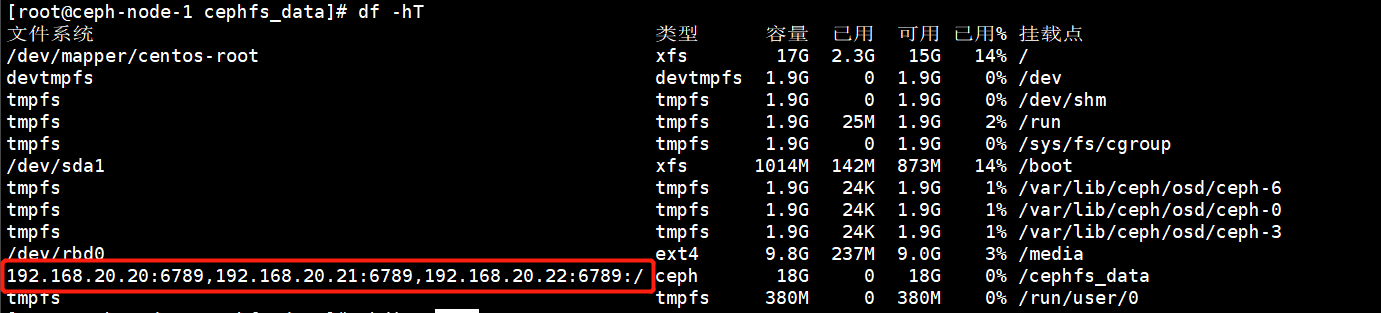

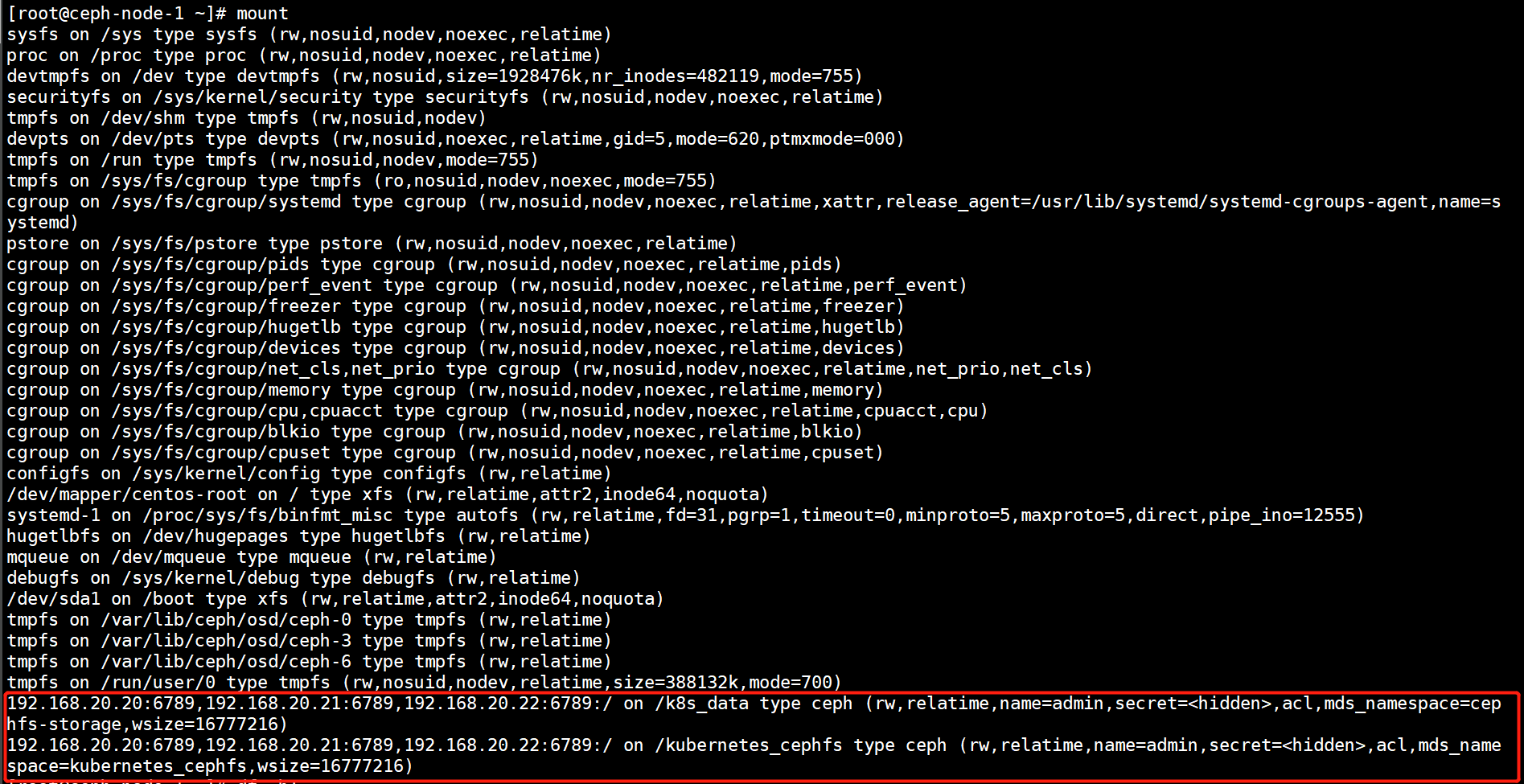

如下图所示:Ceph集群中只有一个Cephfs文件系统,也没有在文件系统中创建任何目录,因此直接挂载的/目录

我们可以把Cephfs文件系统理解成一个空的父级目录,一开始并没有任何的文件系统,在使用这个文件系统之前,先将Cephfs挂载到本地的一个路径中,在里面为不同的客户端创建出不同的目录,然后由客户端挂载时指定要挂载的目录,实现多客户端之间的数据隔离。

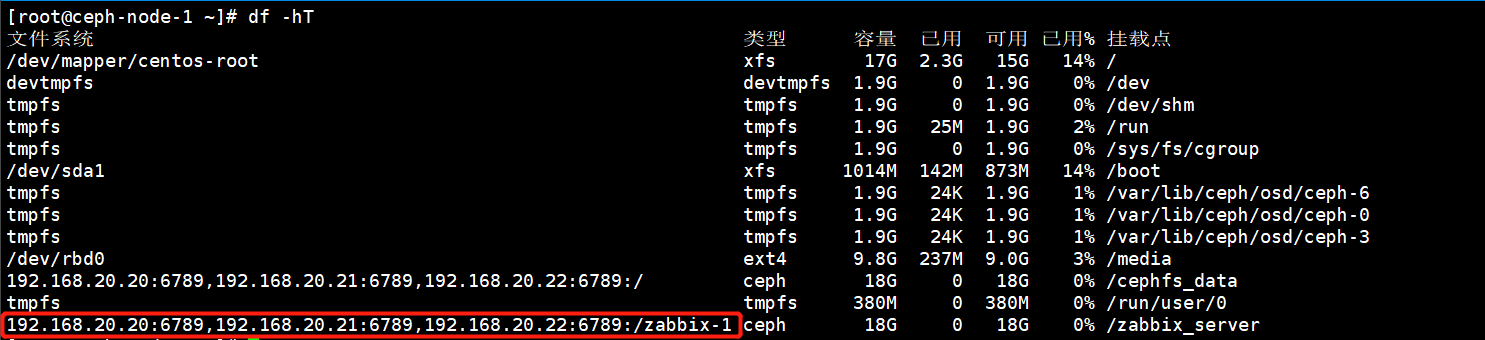

如下图所示:就是在Cephfs文件系统中为不同的客户端创建了不同的存储目录,然后由客户端进行挂载,实现数据上的逻辑隔离。

2.2.Ceph集群中多个Cephfs如何单独使用

一个Ceph集群中不可能只有一个Cephfs文件系统,那么如何指定客户端使用哪一个Cephfs呢?其实很简单,mount挂载命令中有个参数可以指定客户端使用哪一个Cephfs。

挂载非默认FS,以防集群有多个FS

mount -t ceph :/ /mnt/ mycephfs2 -o fs=mycephfs2或者mount -t ceph :/ /mnt/ mycephfs2 -o mds_namespace=mycephfs2 # 此选项名称已弃用。

官网是如上这么写的,但是我在使用的时候发现fs=这个参数是不支持的,只有mds_namespace=参数是支持的

3.挂载多个Cephfs文件系统

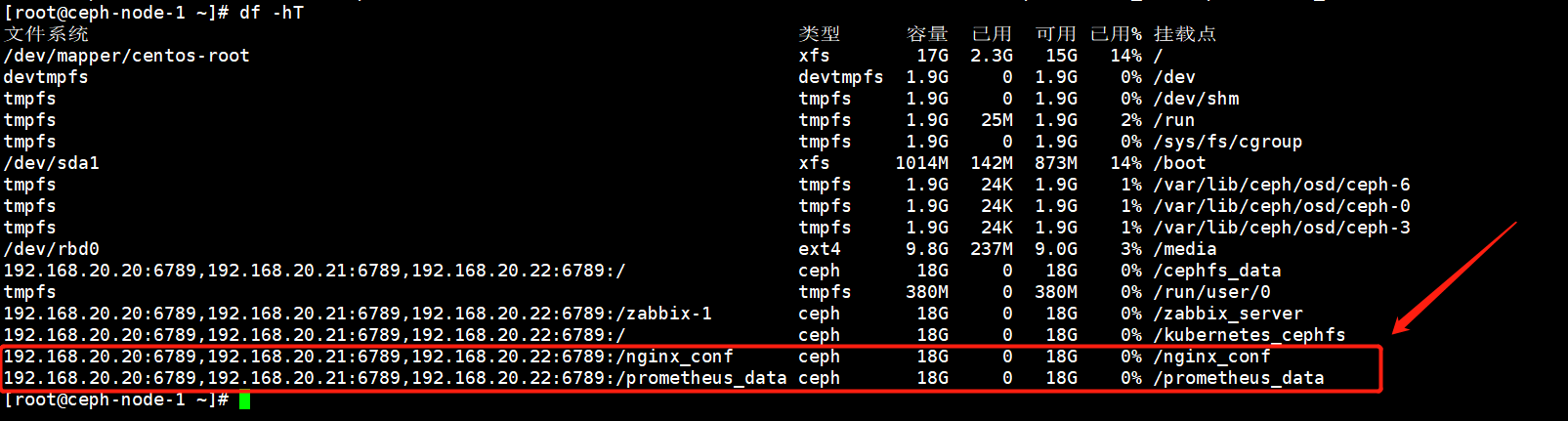

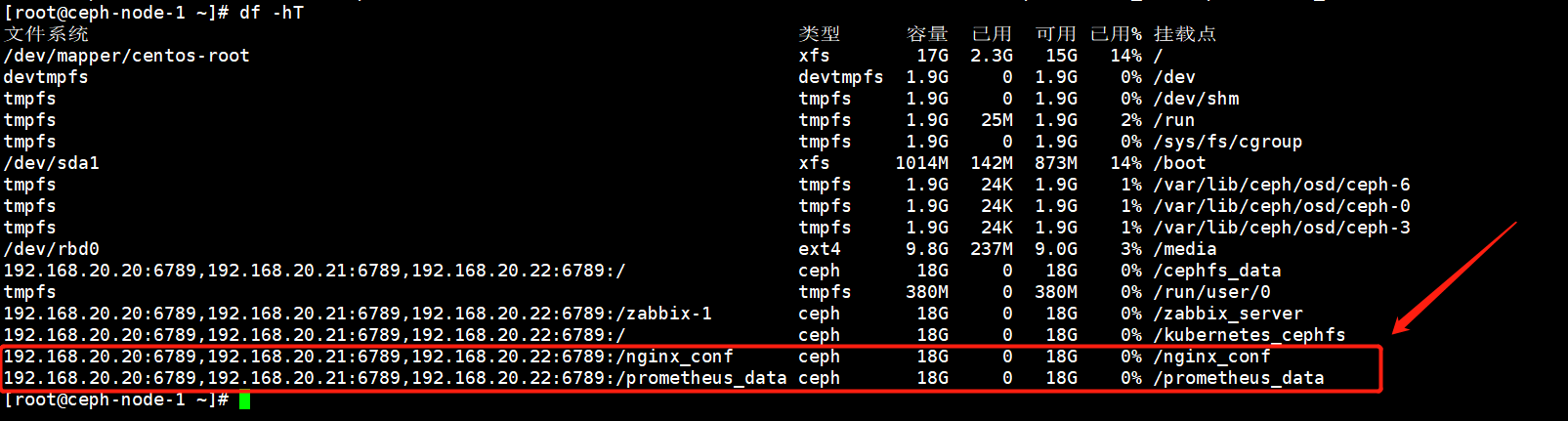

使用mount命令的mds_namespace参数就可以指定要挂载的Cephfs文件系统

[root@ceph-node-1 ~]# mount -t ceph 192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/nginx_conf /nginx_conf/ -o name=admin,mds_namespace=kubernetes_cephfs[root@ceph-node-1 ~]# mount -t ceph 192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/prometheus_data /prometheus_data/ -o name=admin,mds_namespace=kubernetes_cephfs

执行mount命令也可以看到挂载的详情。

192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/nginx_conf on /nginx_conf type ceph (rw,relatime,name=admin,secret=<hidden>,acl,mds_namespace=kubernetes_cephfs,wsize=16777216)

192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/prometheus_data on /prometheus_data type ceph (rw,relatime,name=admin,secret=<hidden>,acl,mds_namespace=kubernetes_cephfs,wsize=16777216)

4.Cephfs文件系统多客户端隔离挂载实战

创建一个Cephfs文件系统,然后将文件系统挂载到本地的一个路径上,

4.1.创建一个Cephfs文件系统

1)首先创建Cephfs依赖的数据池和元数据池

[root@ceph-node-1 ~]# ceph osd pool create kubernetes_cephfs_data 16 16

pool 'kubernetes_cephfs_data' created

[root@ceph-node-1 ~]# ceph osd pool create kubernetes_cephfs_metadata 16 16

pool 'kubernetes_cephfs_metadata' created

2)创建一个Cephfs文件系统

[root@ceph-node-1 ~]# ceph fs new kubernetes_cephfs kubernetes_cephfs_metadata kubernetes_cephfs_data

new fs with metadata pool 14 and data pool 13

3)查看创建的Cephfs文件系统

[root@ceph-node-1 ~]# ceph fs ls

name: kubernetes_cephfs, metadata pool: kubernetes_cephfs_metadata, data pools: [kubernetes_cephfs_data ]

4.2.将Cephfs文件系统挂载到本地路径

使用mount命令时,指定mds_namespace参数挂载特定的Cephfs文件系统。

[root@ceph-node-1 ~]# mount -t ceph 192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/ /kubernetes_cephfs/ -o name=admin,mds_namespace=kubernetes_cephfs

4.3.在Cephfs文件文件系统中创建多个目录

创建出多个目录为不同的客户端提供存储。

[root@ceph-node-1 ~]# mkdir /kubernetes_cephfs/{zabbix_data,prometheus_data,nginx_conf}

[root@ceph-node-1 ~]# ll /kubernetes_cephfs/

总用量 0

drwxr-xr-x 1 root root 0 4月 16 10:02 nginx_conf

drwxr-xr-x 1 root root 0 4月 16 10:02 prometheus_data

drwxr-xr-x 1 root root 0 4月 16 10:02 zabbix_data

4.4.查看Cephfs文件系统的状态

当前还没有任何数据写入。

[root@ceph-node-1 ~]# ceph fs status kubernetes_cephfs

kubernetes_cephfs - 0 clients

=================

+------+--------+-------------+---------------+-------+-------+

| Rank | State | MDS | Activity | dns | inos |

+------+--------+-------------+---------------+-------+-------+

| 0 | active | ceph-node-2 | Reqs: 0 /s | 0 | 0 |

+------+--------+-------------+---------------+-------+-------+

+----------------------------+----------+-------+-------+

| Pool | type | used | avail |

+----------------------------+----------+-------+-------+

| kubernetes_cephfs_metadata | metadata | 1728k | 17.9G |

| kubernetes_cephfs_data | data | 0 | 17.9G |

+----------------------------+----------+-------+-------+

+-------------+

| Standby MDS |

+-------------+

| ceph-node-1 |

+-------------+

+-----------------------------------------------------------------------------------+-------------+

| version | daemons |

+-----------------------------------------------------------------------------------+-------------+

| None | ceph-node-2 |

| ceph version 14.2.22 (ca74598065096e6fcbd8433c8779a2be0c889351) nautilus (stable) | ceph-node-1 |

+-----------------------------------------------------------------------------------+-------------+

4.5.客户端分别挂载不同的Cephfs文件系统中的子目录

1)客户端挂载文件系统中不同的目录

1.创建挂载点

[root@ceph-node-1 ~]# mkdir /nginx_conf

[root@ceph-node-1 ~]# mkdir /prometheus_data2.挂载Cephfs文件系统中不同的子目录

[root@ceph-node-1 ~]# mount -t ceph 192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/nginx_conf /nginx_conf/ -o name=admin,mds_namespace=kubernetes_cephfs

[root@ceph-node-1 ~]# mount -t ceph 192.168.20.20:6789,192.168.20.21:6789,192.168.20.22:6789:/prometheus_data /prometheus_data/ -o name=admin,mds_namespace=kubernetes_cephfs

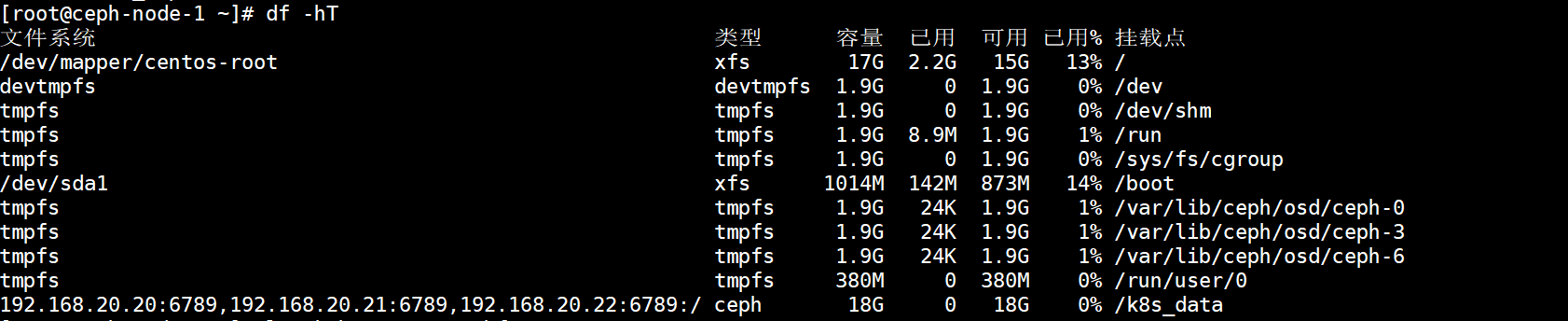

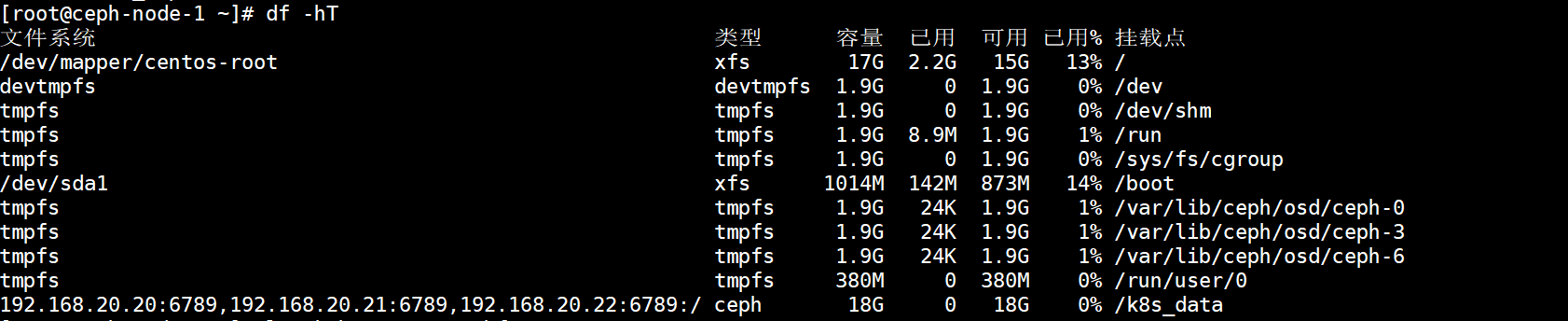

2)查看挂载的信息

不同的客户端挂载了Cephfs文件系统中不同的子目录,实现数据上的隔离存储。

3)写入数据验证数据的隔离性

每个客户端都在自己的挂载点写入数据。

#nginx客户端

[root@ceph-node-1 ~]# touch /nginx_conf/file{1..5}.txt#prometheus客户端

[root@ceph-node-1 ~]# cp rbd-storage.img /prometheus_data/

在总的Cephfs文件存储中查看子目录的数据。

[root@ceph-node-1 ~]# tree /kubernetes_cephfs/

/kubernetes_cephfs/

├── nginx_conf

│ ├── file1.txt

│ ├── file2.txt

│ ├── file3.txt

│ ├── file4.txt

│ └── file5.txt

├── prometheus_data

│ └── rbd-storage.img

└── zabbix_data3 directories, 6 files

查看Cephfs文件系统的状态,此时数据就有了变化。

[root@ceph-node-1 ~]# ceph fs status kubernetes_cephfs

kubernetes_cephfs - 0 clients

=================

+------+--------+-------------+---------------+-------+-------+

| Rank | State | MDS | Activity | dns | inos |

+------+--------+-------------+---------------+-------+-------+

| 0 | active | ceph-node-2 | Reqs: 0 /s | 0 | 0 |

+------+--------+-------------+---------------+-------+-------+

+----------------------------+----------+-------+-------+

| Pool | type | used | avail |

+----------------------------+----------+-------+-------+

| kubernetes_cephfs_metadata | metadata | 1920k | 17.8G |

| kubernetes_cephfs_data | data | 215M | 17.8G |

+----------------------------+----------+-------+-------+

+-------------+

| Standby MDS |

+-------------+

| ceph-node-1 |

+-------------+

+-----------------------------------------------------------------------------------+-------------+

| version | daemons |

+-----------------------------------------------------------------------------------+-------------+

| None | ceph-node-2 |

| ceph version 14.2.22 (ca74598065096e6fcbd8433c8779a2be0c889351) nautilus (stable) | ceph-node-1 |

+-----------------------------------------------------------------------------------+-------------+

5.卸载MDS的方法

1:(可选)创建一个新的MDS将要被移除的MDS,如果在删除MDS之后没有替代MDS可以接管,则文件系统将对客户端不可用,如果不希望这样做,请在删除要脱机的元数据服务器之前考虑添加元数据服务器

2:停止MDS服务

systemctl stop ceph-mds@${id}

MDS将自动通知mon它已关闭,这使mon能够将故障瞬间切换到可用的备用数据库(如果存在)。无需使用管理命令来实现此故障转移,例如通过使用ceph mds fail mds.${id}

3:删除/var/lib/ceph/mds/ceph-${id}目录

rm -rf /var/lib/ceph/mds/ceph-${id}

注意:卸载掉集群中所有的MDS后,Cephfs文件系统将不可用,再次部署完MDS后,需要将所有的cephfs以及对应的Pool资源池删掉,否则集群就会有问题。

6.小插曲

如果一台机器中挂载了两个Cephfs,虽然是两个不通的Cephfs文件系统,但是都挂载的是/目录。

此时使用df目录查看挂载信息时,只会显示第一个挂载的Cephfs文件系统。

相关文章:

第37讲:Cephfs文件系统的正确使用姿势

文章目录 1.Cephfs文件系统简介2.Cephfs文件系统细节介绍2.1.Cephfs文件系统多客户端隔离挂载2.2.Ceph集群中多个Cephfs如何单独使用 3.挂载多个Cephfs文件系统4.Cephfs文件系统多客户端隔离挂载实战4.1.创建一个Cephfs文件系统4.2.将Cephfs文件系统挂载到本地路径4.3.在Cephfs…...

单片机烧录

在设计芯片的时候,关于烧录的环节是一个不得不考虑的问题。 我们首先排除掉,由外部直接硬件操控FLASH 的方案,这个方案有很多缺点。 1、每个IC使用的FLASH型号是各不相同的,每种型号的FLASH的烧录命令和流程都有差别,这…...

mysql实现分布式锁

利用数据库的悲观锁实现分布式锁,实际应用中要考虑mysql的高可用。 DistributedLock.h #ifndef DistributedLock_H_ #define DistributedLock_H_// // DistributedLock.h: // #include "base/MySQLDriver.h" class CDistributedLock { public://// Construction/D…...

MySQL快速使用

关系型数据库(RDBMS):建立在关系模型基础上,由多张相互连接的二维表组成的数据库 特点:使用表存储数据,格式统一方便维护;使用SQL语言操作,标准统一使用方便 通用语法: …...

LeetCode41.缺失的第一个正数

1. 题目大意 给你一个未排序的整数数组 nums ,请你找出其中没有出现的最小的正整数。 请你实现时间复杂度为 O(n) 并且只使用常数级别额外空间的解决方案。 2. 思路分析 示例 1: 输入:nums [3,4,-1,1] 输出:2 解释࿱…...

ee trade:黄金投资与股票投资的区别

黄金和股票, 是金融市场中两种常见的投资工具, 它们拥有截然不同的特点和风险, 了解它们的差异, 可以帮助投资者制定更合理的投资策略。 一、 投资性质: 避险与成长, 两种投资方向 黄金: 被视…...

AI视频创作原理

重磅推荐专栏: 《大模型AIGC》 《课程大纲》 《知识星球》 本专栏致力于探索和讨论当今最前沿的技术趋势和应用领域,包括但不限于ChatGPT和Stable Diffusion等。我们将深入研究大型模型的开发和应用,以及与之相关的人工智能生成内容(AIGC)技术。通过深入的技术解析和实践经…...

idea vue项目删除node_modules时报文件损坏且无法读取,导致删除失败

解决办法,查看node_modules所在盘,右击点击属性-工具,点击检查驱动,查完后修复即可, 就能够成功删除损坏的文件了...

Linux下编译安装-单机模式

1.1 Linux下编译安装-单机模式 1.1.1 安装 (1).把安装包放在Linux文件系统下 (2).解压缩 tar -zxf redis-4.0.2.tar.gz (3).切换到解压后的目录 cd redis-4.0.2(4).编译 make(5).进入到src目录 cd src(6).执行安装 make install(7) .返回上级目录 cd .. (8) .修改配置&…...

RSSI定位算法

文章目录 一、定位算法简介1.1. 定位技术原理1.2. 定位算法二、RSSI测距原理2.1. 建模与测量终端到基站的距离三、定位3.1. 三边定位算法3.2. 加权三边定位算法3.3. 加权三角形质心定位算法3.4. 程序定位算法的执行流程一、定位算法简介 1.1. 定位技术原理 定位终端接收到iBe…...

布局管理(Layouts)-Qt-思维导图-学习笔记

布局管理(Layouts) Qt 提供了非常丰富的布局类,主要包括以下基本布局管理类 QBoxLayout 提供了水平和垂直的布局管理,可以将子部件按行或列排列。根据排列方向的不同,QBoxLayout 分为 QHBoxLayout(水平布局)和 QVBox…...

《区块链赋能游戏业:破解虚拟资产交易与确权难题》

在当今数字化的时代,游戏行业正以前所未有的速度发展,虚拟资产在游戏中的重要性日益凸显。然而,虚拟资产的交易和确权问题一直困扰着游戏开发者和玩家。随着区块链技术的引入,为解决这些问题带来了新的曙光。 首先,我…...

机器学习第十一章-特征选择与稀疏学习

11.1子集收集与评价 属性称为"特征" ,对当前学习任务有用的属性称为"相关特征" 、没什么用的属性称为"无关特 征" . 从给定的特征集合中选择出相关特征于集的过程,称为"特征选择"。 特征选择是一个重要的"…...

C#中客户端直接引用服务端Proto文件

gRPC 客户端是从 .proto 文件生成的具体客户端类型。 具体 gRPC 客户端具有转换为 .proto 文件中 gRPC 服务的方法。 下一步打开【服务引用】 控制面板 选择grpc选项,然后继续 到此配置完成,然后就和服务共用一份protocol文件...

SiLM5932SHO系列SiLM5932SHOCG-DG 12A/12A强劲驱动电流能力 支持主动短路保护功能(ASC)单通道隔离门极驱动器

SiLM5932SHO系列是一款单通道隔离驱动器,提供12A源电流和12A灌电流。主动保护功能包括退饱和过流检测、UVLO、隔离故障报警和 4A 米勒钳位。输入侧电源的工作电压为3V至5.5V,输出侧电源的工作电压范围为13V至30V。所有电源电压引脚都有欠压锁定 (UVLO) 保…...

本地项目上传github

一、先在github(GitHub: Let’s build from here GitHub)上创建仓库 1,登录github后,点击右上角头像,点击 Your repositories 2,点击new 3,填写仓库名,假设命名 testhub࿰…...

使用zip包来安装mysql

下载 下载地址mysql,使用5.7.23 配置环境变量 添加到系统变量中 C:\Users\Admin\Downloads\mysql-5.7.23-win32\bin 添加my.ini配置文件 在C:\Users\Admin\Downloads\mysql-5.7.23-win32目录下添加my.ini [mysqld] # 设置3306端口 port3306# 自定义设置mysql的安装目录 b…...

嵌入式面经篇十——驱动开发

文章目录 前言一、驱动开发1、Linux 驱动程序的功能是什么?2、内核程序中申请内存使用什么函数?3、内核程序中申请内存和应用程序时申请内存有什么区别?4、自旋锁和信号量在互斥使用时需要注意什么?在中断服务程序里面的互斥是使用…...

MySQL(四)——常用函数

文章目录 函数字符串函数数值函数日期函数流程函数 函数 函数,是指一段可以直接被另一段程序调用的程序或代码。 MySQL中内置了许多函数,我们只需在合适的场景下调用它们即可,调用函数查询结果直接使用SELECT即可,并且可以嵌套使…...

C++ //练习 17.38 扩展上一题中你的程序,将读入的每个单词打印到它所在的行。

C Primer(第5版) 练习 17.38 练习 17.38 扩展上一题中你的程序,将读入的每个单词打印到它所在的行。 环境:Linux Ubuntu(云服务器) 工具:vim 代码块 #include<iostream> #include<…...

Vim 调用外部命令学习笔记

Vim 外部命令集成完全指南 文章目录 Vim 外部命令集成完全指南核心概念理解命令语法解析语法对比 常用外部命令详解文本排序与去重文本筛选与搜索高级 grep 搜索技巧文本替换与编辑字符处理高级文本处理编程语言处理其他实用命令 范围操作示例指定行范围处理复合命令示例 实用技…...

(转)什么是DockerCompose?它有什么作用?

一、什么是DockerCompose? DockerCompose可以基于Compose文件帮我们快速的部署分布式应用,而无需手动一个个创建和运行容器。 Compose文件是一个文本文件,通过指令定义集群中的每个容器如何运行。 DockerCompose就是把DockerFile转换成指令去运行。 …...

今日学习:Spring线程池|并发修改异常|链路丢失|登录续期|VIP过期策略|数值类缓存

文章目录 优雅版线程池ThreadPoolTaskExecutor和ThreadPoolTaskExecutor的装饰器并发修改异常并发修改异常简介实现机制设计原因及意义 使用线程池造成的链路丢失问题线程池导致的链路丢失问题发生原因 常见解决方法更好的解决方法设计精妙之处 登录续期登录续期常见实现方式特…...

python执行测试用例,allure报乱码且未成功生成报告

allure执行测试用例时显示乱码:‘allure’ �����ڲ����ⲿ���Ҳ���ǿ�&am…...

微软PowerBI考试 PL300-在 Power BI 中清理、转换和加载数据

微软PowerBI考试 PL300-在 Power BI 中清理、转换和加载数据 Power Query 具有大量专门帮助您清理和准备数据以供分析的功能。 您将了解如何简化复杂模型、更改数据类型、重命名对象和透视数据。 您还将了解如何分析列,以便知晓哪些列包含有价值的数据,…...

Unsafe Fileupload篇补充-木马的详细教程与木马分享(中国蚁剑方式)

在之前的皮卡丘靶场第九期Unsafe Fileupload篇中我们学习了木马的原理并且学了一个简单的木马文件 本期内容是为了更好的为大家解释木马(服务器方面的)的原理,连接,以及各种木马及连接工具的分享 文件木马:https://w…...

如何更改默认 Crontab 编辑器 ?

在 Linux 领域中,crontab 是您可能经常遇到的一个术语。这个实用程序在类 unix 操作系统上可用,用于调度在预定义时间和间隔自动执行的任务。这对管理员和高级用户非常有益,允许他们自动执行各种系统任务。 编辑 Crontab 文件通常使用文本编…...

CSS | transition 和 transform的用处和区别

省流总结: transform用于变换/变形,transition是动画控制器 transform 用来对元素进行变形,常见的操作如下,它是立即生效的样式变形属性。 旋转 rotate(角度deg)、平移 translateX(像素px)、缩放 scale(倍数)、倾斜 skewX(角度…...

永磁同步电机无速度算法--基于卡尔曼滤波器的滑模观测器

一、原理介绍 传统滑模观测器采用如下结构: 传统SMO中LPF会带来相位延迟和幅值衰减,并且需要额外的相位补偿。 采用扩展卡尔曼滤波器代替常用低通滤波器(LPF),可以去除高次谐波,并且不用相位补偿就可以获得一个误差较小的转子位…...

HybridVLA——让单一LLM同时具备扩散和自回归动作预测能力:训练时既扩散也回归,但推理时则扩散

前言 如上一篇文章《dexcap升级版之DexWild》中的前言部分所说,在叠衣服的过程中,我会带着团队对比各种模型、方法、策略,毕竟针对各个场景始终寻找更优的解决方案,是我个人和我司「七月在线」的职责之一 且个人认为,…...