大语言模型量化方法GPTQ、GGUF、AWQ详细原理

大语言模型量化的目的是减少模型的计算资源需求和存储占用,同时尽量保持模型的性能。以下是几种常见的量化方法的原理;

1. GPTQ (Gradient-based Post-training Quantization)

GPTQ 是一种基于梯度的后训练量化方法,主要目的是在减少浮点计算时尽量保持模型的性能。这种方法对大语言模型的量化尤其有效,适用于 8-bit 或更低的量化需求。

原理:

- 后训练量化:模型已经训练完毕,不需要重新训练,只需在训练后对权重进行量化。

- 梯度校正:在进行量化的过程中,GPTQ 通过优化目标函数,对量化误差进行最小化。它通过梯度优化调整量化时的权重误差,使得量化后模型的表现与未量化模型尽可能接近。

- 误差补偿:由于量化不可避免地引入误差,GPTQ 采用了误差反馈机制,将量化过程中产生的误差传播到后续的层进行补偿,从而减少累积误差对模型输出结果的影响。

优点:

- 不需要额外的训练数据,只使用训练后的模型即可。

- 相较于传统的直接量化方法(如固定比特宽度量化),GPTQ 的精度损失较小,特别适合复杂模型。

假设量化 LLaMA 模型,以下是一个基本的示例代码::

# # 环境安装

# pip install transformers accelerate

# pip install git+https://github.com/qwopqwop200/GPTQ-for-LLaMa.gitimport torch

from transformers import AutoModelForCausalLM, AutoTokenizer

from gptq import GPTQ# 选择模型(你可以使用 LLaMA 或其他支持的模型)

model_name = "huggingface/llama"# 加载预训练模型和分词器

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16)# 初始化 GPTQ

quantizer = GPTQ(model)# 设置量化位数(比如8-bit量化)

W_BITS = 8# 开始量化模型

quantizer.quantize(w_bits=W_BITS, layer_types=["self_attn", "mlp"])# 生成量化后的模型

quantized_model = quantizer.finish()# 测试模型推理(生成文本)

input_text = "What is the capital of France?"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = quantized_model.generate(**inputs, max_new_tokens=20)# 解码输出

decoded_output = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(decoded_output)2. GGUF (Generalized Global Uniform Quantization Framework)

GGUF 是一种通用的全局统一量化框架,专门设计用于处理大规模神经网络。它通常采用全局统一量化策略,即对整个模型的权重或激活值采用相同的量化参数,保持模型的一致性。

原理:

- 全局量化:将整个模型中的所有参数统一映射到固定的范围,比如使用 8-bit 或 4-bit 表示所有的浮点数。它假设模型的所有层或某一类参数具有相似的分布,从而可以使用相同的量化范围。

- 均匀量化:所有的数值都被线性地映射到一个均匀的范围。这种方式计算效率高,尤其适合硬件加速器。

- 权重重定标:由于采用统一量化策略,GGUF 通常会引入一个缩放因子,用来在推理阶段重定标量化后的数值,以避免数值溢出或精度过低的问题。

优点:

- 简单且高效,适用于低延迟推理场景。

- 算法计算复杂度低,适合部署在资源有限的硬件上。

缺点:

- 由于全局采用统一的量化范围,对于模型某些权重分布极端的层来说,精度损失可能较大

演示如何对 Hugging Face 上的 GPT-2 模型进行 8-bit 全局统一量化

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel

from torch.quantization import QuantStub, DeQuantStub, quantize_dynamic# 加载 GPT2 模型和分词器

model_name = "gpt2"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)# 打印原始模型的大小

print(f"Original model size: {model.num_parameters()} parameters")# 模型准备:将全局所有层量化(使用动态量化)

quantized_model = quantize_dynamic(model, # 要量化的模型{torch.nn.Linear}, # 量化哪些层(这里是线性层)dtype=torch.qint8 # 量化数据类型,这里使用 8-bit 量化

)# 打印量化后的模型大小

print(f"Quantized model size: {sum(p.numel() for p in quantized_model.parameters())} parameters")# 测试量化后的模型生成文本

input_text = "Once upon a time"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = quantized_model.generate(**inputs, max_new_tokens=50)# 解码输出

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

print("Generated text:", generated_text)

3. AWQ (Activation-aware Quantization)

AWQ 是一种关注激活值的量化方法,主要在量化过程中考虑了激活值分布对模型性能的影响。这种方法通过分析激活值的分布特性,在量化过程中对激活值进行适应性处理,从而提高量化后模型的准确性。

原理:

- 激活值感知:在对权重进行量化的同时,AWQ 也会对每一层的激活值分布进行分析。在某些层,激活值可能呈现出不均匀或长尾分布,导致量化过程中精度下降。AWQ 对这些激活值分布进行感知并自适应调整量化策略。

- 非均匀量化:在量化激活值时,AWQ 并不采用线性均匀量化,而是针对不同的激活值范围选择不同的量化尺度。这样可以更好地捕捉激活值的细节,减少量化误差。

- 动态缩放:通过动态调整每层的量化缩放因子,使得量化后的激活值分布尽量保持和原始模型一致。

优点:

- 在模型的不同层次灵活调整量化策略,减少精度损失。

- 适合模型推理阶段需要高精度的场景。

缺点:

- 相比全局统一量化,计算复杂度略高,可能需要更多的计算资源。

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel

from torch.quantization import QuantStub, DeQuantStub, prepare_qat, convert# 加载 GPT-2 模型和分词器

model_name = "gpt2"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)# 定义量化模块

class QuantizedGPT2(torch.nn.Module):def __init__(self, model):super(QuantizedGPT2, self).__init__()self.quant = QuantStub() # 用于激活值的量化self.model = modelself.dequant = DeQuantStub() # 用于激活值的反量化def forward(self, input_ids):# 对输入的激活值进行量化quantized_inputs = self.quant(input_ids)outputs = self.model(input_ids=quantized_inputs)# 对输出进行反量化return self.dequant(outputs.logits)# 将模型包装在量化模块中

quantized_model = QuantizedGPT2(model)# 量化感知训练准备(QAT)

quantized_model.qconfig = torch.quantization.get_default_qat_qconfig('fbgemm')# 准备 QAT

quantized_model = prepare_qat(quantized_model, inplace=True)# 模拟训练(可以加载现有权重并继续训练)

# 这里使用了一些样本数据

input_text = "What is the capital of France?"

inputs = tokenizer(input_text, return_tensors="pt")['input_ids']

quantized_model.train()for _ in range(10): # 模拟训练步骤outputs = quantized_model(inputs)loss = torch.nn.functional.cross_entropy(outputs.view(-1, outputs.size(-1)), inputs.view(-1))loss.backward()# 完成量化

quantized_model.eval()

quantized_model = convert(quantized_model)# 测试量化后的模型

with torch.no_grad():outputs = quantized_model(inputs)generated_text = tokenizer.decode(outputs[0].argmax(dim=-1), skip_special_tokens=True)

print("Generated text:", generated_text)总结

- GPTQ 通过梯度优化对量化误差进行最小化,适用于后训练阶段的精细量化,精度较高。

- GGUF 采用全局统一的量化策略,具有简单高效的优点,适用于资源受限的部署场景,但可能导致某些模型层的精度损失。

- AWQ 关注激活值的量化,通过分析激活值的分布对量化策略进行自适应调整,精度更高但计算复杂度较大。

相关文章:

大语言模型量化方法GPTQ、GGUF、AWQ详细原理

大语言模型量化的目的是减少模型的计算资源需求和存储占用,同时尽量保持模型的性能。以下是几种常见的量化方法的原理; 1. GPTQ (Gradient-based Post-training Quantization) GPTQ 是一种基于梯度的后训练量化方法,主要目的是在减少浮点计…...

《 C++ 修炼全景指南:十 》自平衡的艺术:深入了解 AVL 树的核心原理与实现

摘要 本文深入探讨了 AVL 树(自平衡二叉搜索树)的概念、特点以及实现细节。我们首先介绍了 AVL 树的基本原理,并详细分析了其四种旋转操作,包括左旋、右旋、左右双旋和右左双旋,阐述了它们在保持树平衡中的重要作用。…...

SAP 特别总账标识[SGL]

1. 特别总账标识(SGL)概述 1.1 定义与目的 特别总账标识(Special General Ledger, SGL)在SAP系统中用于区分客户或供应商的不同业务类型,以便将特定的业务交易记录到非标准的总账科目中。 定义:SGL是一个用于标记特殊业务类型的…...

认知杂谈77《简单:通往高手的技巧》

内容摘要: 在信息爆炸、关系复杂的时代,简单是复杂背后的真谛。简单如“112”,是智慧的朴素呈现。简单有强大力量,像清泉般纯净,如“我爱你”简单却有力,基础财务知识也体现其在理财中的作…...

《SmartX ELF 虚拟化核心功能集》发布,详解 80+ 功能特性和 6 例金融实践

《SmartX ELF 虚拟化核心功能集》电子书现已发布!本书详细介绍了 SmartX ELF 虚拟化及云平台核心功能,包含虚机服务、容器服务、网络服务、存储服务、运维管理、工具服务、数据保护等各个方面。 即刻下载电子书,了解如何利用基于 SmartX ELF …...

9月23日

思维导图 作业 统计家目录下.c文件的个数 #!/bin/bashnum0for file in ~/*.c; doif [ -f "$file" ]; then((num))fi doneecho "家目录下.c文件的个数: $num"...

如何使用Jinja定义dbt宏

dbt宏在dbt框架内的工作方式与传统编程中的函数类似。它允许用户将特定的、通常是重复的SQL逻辑封装到可调用的命名单元中,就像在其他编程语言中用函数来避免重复代码一样;dbt宏定义特定业务的SQL逻辑,然后在dbt项目中需要的地方调用该宏函数…...

深入理解 JavaScript 三大作用域:全局作用域、函数作用域、块级作用域

一. 作用域 对于多数编程语言,最基本的功能就是能够存储变量当中的值、并且允许我们对这个变量的值进行访问和修改。那么有了变量之后,应该把它放在哪里、程序如何找到它们?是否需要提前约定好一套存储变量、访问变量的规则?答案…...

【门牌制作 / A】

题目 代码 #include <bits/stdc.h> using namespace std; int main() {int cnt 0;for (int i 1; i < 2020; i){string s;s to_string(i);cnt count(s.begin(), s.end(), 2);}cout << cnt; }...

Git+Jenkins 基本使用(Basic Usage of Git+Jenkins)

💝💝💝欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。 推荐:Linux运维老纪的首页…...

智谱清言:智能语音交互的引领者,解锁高效沟通新体验

哪个编程工具让你的工作效率翻倍? 在日益繁忙的工作环境中,选择合适的编程工具已成为提升开发者工作效率的关键。不同的工具能够帮助我们简化代码编写、自动化任务、提升调试速度,甚至让团队协作更加顺畅。那么,哪款编程工具让你…...

前端组件库

vant2现在的地址 Vant 2 - Mobile UI Components built on Vue...

后端常用的mybatis-plus方法以及配合querywapper使用

目录 一、插入数据 save方法 二、删除操作 removeById方法 三、更新操作 updateById方法 四、查询操作 selectById方法 五、条件构造器QueryWrapper的更多用法 1.比较操作符 2.逻辑操作符 3.模糊查询 4.空值判断 一、插入数据 save方法 save(T entity):向数据库中插入…...

【设计模式】万字详解:深入掌握五大基础行为模式

作者:后端小肥肠 🍇 我写过的文章中的相关代码放到了gitee,地址:xfc-fdw-cloud: 公共解决方案 🍊 有疑问可私信或评论区联系我。 🥑 创作不易未经允许严禁转载。 姊妹篇: 【设计模式】…...

C++ 9.19

练习:要求在堆区申请5个double类型的空间,用于存储5名学生的成绩。请自行封装函数完成 1> 空间的申请 2> 学生成绩的录入 3> 学生成绩的输出 4> 学生成绩进行降序排序 5> 释放申请的空间 主程序中用于测试上述函数 #include<ios…...

[Unity Demo]从零开始制作空洞骑士Hollow Knight第五集:再制作更多的敌人

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、制作敌人另个爬虫Crawler 1.公式化导入制作另个爬虫Crawler素材2.制作另个爬虫Crawler的Crawler.cs状态机3.制作敌人另个爬虫Crawler的playmaker状态机二、…...

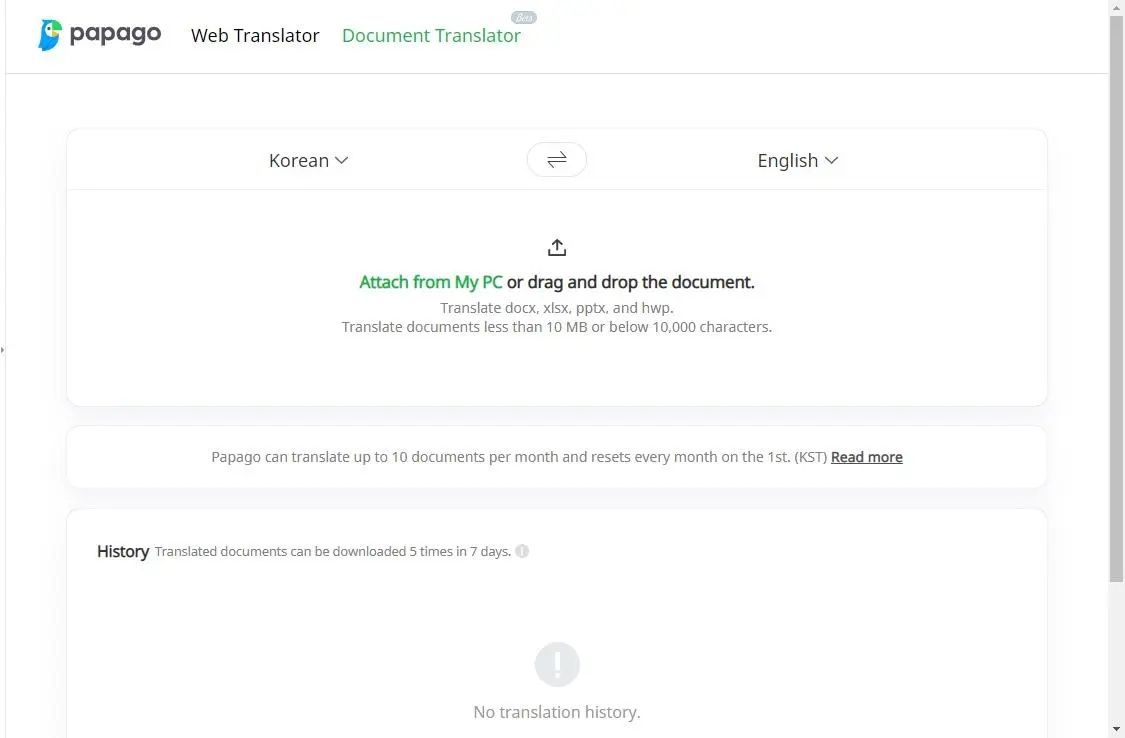

怎么把excel翻译成英文?这些翻译技巧记得收藏

在处理Excel数据时,我们常常会遇到多语言的数据集,这无疑给数据分析和整理带来了不小的挑战。 幸运的是,随着技术的发展,现在有多种工具可以帮助我们进行Excel中的批量翻译,这些工具以其强大的翻译功能和便捷的操作方…...

信息技术引领的智能化未来

信息技术引领的智能化未来 随着信息技术的飞速发展,社会各个领域正在加速迈入智能化的新时代。信息技术的广泛应用,尤其是人工智能、大数据、物联网等前沿技术的创新与融合,正在从根本上改变着人们的生产和生活方式。本文将探讨信息技术在智…...

【QT开发-Pyside】使用Pycharm与conda配置Pyside环境并新建工程

知识拓展 Pycharm 是一个由 JetBrains 开发的集成开发环境(IDE),它主要用于 Python 编程语言的开发。Pycharm 提供了代码编辑、调试、版本控制、测试等多种功能,以提高 Python 开发者的效率。 Pycharm 与 Python 的关系 Pycharm 是…...

)

vue选项式写法项目案例(购物车)

一、初始化项目结构 1.初始化vite项目 npm create vite cd vite-project npm install 2.清理项目结构 清空App.vue 删除components目录下的HelloWorld.vue组件 3.为组件的样式启用sacc或less组件 npm i sass4.初始化index.css全局样式 :root{font-size:12px } 二、封装…...

)

Java 语言特性(面试系列1)

一、面向对象编程 1. 封装(Encapsulation) 定义:将数据(属性)和操作数据的方法绑定在一起,通过访问控制符(private、protected、public)隐藏内部实现细节。示例: public …...

Go 语言接口详解

Go 语言接口详解 核心概念 接口定义 在 Go 语言中,接口是一种抽象类型,它定义了一组方法的集合: // 定义接口 type Shape interface {Area() float64Perimeter() float64 } 接口实现 Go 接口的实现是隐式的: // 矩形结构体…...

macOS多出来了:Google云端硬盘、YouTube、表格、幻灯片、Gmail、Google文档等应用

文章目录 问题现象问题原因解决办法 问题现象 macOS启动台(Launchpad)多出来了:Google云端硬盘、YouTube、表格、幻灯片、Gmail、Google文档等应用。 问题原因 很明显,都是Google家的办公全家桶。这些应用并不是通过独立安装的…...

【Go】3、Go语言进阶与依赖管理

前言 本系列文章参考自稀土掘金上的 【字节内部课】公开课,做自我学习总结整理。 Go语言并发编程 Go语言原生支持并发编程,它的核心机制是 Goroutine 协程、Channel 通道,并基于CSP(Communicating Sequential Processes࿰…...

Python爬虫(一):爬虫伪装

一、网站防爬机制概述 在当今互联网环境中,具有一定规模或盈利性质的网站几乎都实施了各种防爬措施。这些措施主要分为两大类: 身份验证机制:直接将未经授权的爬虫阻挡在外反爬技术体系:通过各种技术手段增加爬虫获取数据的难度…...

深入解析C++中的extern关键字:跨文件共享变量与函数的终极指南

🚀 C extern 关键字深度解析:跨文件编程的终极指南 📅 更新时间:2025年6月5日 🏷️ 标签:C | extern关键字 | 多文件编程 | 链接与声明 | 现代C 文章目录 前言🔥一、extern 是什么?&…...

ABAP设计模式之---“简单设计原则(Simple Design)”

“Simple Design”(简单设计)是软件开发中的一个重要理念,倡导以最简单的方式实现软件功能,以确保代码清晰易懂、易维护,并在项目需求变化时能够快速适应。 其核心目标是避免复杂和过度设计,遵循“让事情保…...

Python+ZeroMQ实战:智能车辆状态监控与模拟模式自动切换

目录 关键点 技术实现1 技术实现2 摘要: 本文将介绍如何利用Python和ZeroMQ消息队列构建一个智能车辆状态监控系统。系统能够根据时间策略自动切换驾驶模式(自动驾驶、人工驾驶、远程驾驶、主动安全),并通过实时消息推送更新车…...

MySQL 索引底层结构揭秘:B-Tree 与 B+Tree 的区别与应用

文章目录 一、背景知识:什么是 B-Tree 和 BTree? B-Tree(平衡多路查找树) BTree(B-Tree 的变种) 二、结构对比:一张图看懂 三、为什么 MySQL InnoDB 选择 BTree? 1. 范围查询更快 2…...

鸿蒙HarmonyOS 5军旗小游戏实现指南

1. 项目概述 本军旗小游戏基于鸿蒙HarmonyOS 5开发,采用DevEco Studio实现,包含完整的游戏逻辑和UI界面。 2. 项目结构 /src/main/java/com/example/militarychess/├── MainAbilitySlice.java // 主界面├── GameView.java // 游戏核…...