【AI大模型】《多模态持续学习》最新进展综述

摘要—持续学习(CL)旨在使机器学习模型能够从新数据中不断学习,同时在不遗忘已获得知识的基础上进行扩展。随着机器学习模型从小规模到大规模预训练架构的演变,以及从支持单一模态数据到支持多模态数据,多模态持续学习(MMCL)方法最近开始出现。MMCL的主要挑战在于,它超越了简单的单模态持续学习方法的叠加,因为这种直接的方法通常会产生不理想的效果。在本研究中,我们首次对MMCL进行了全面综述。我们提供了MMCL的基本背景知识和设定,并提出了结构化的MMCL方法分类法。我们将现有的MMCL方法分为四类,即基于正则化、基于架构、基于重放和基于提示的方法,阐述它们的方法论并强调其关键创新。此外,为了激发该领域的进一步研究,我们总结了开放的MMCL数据集和基准,并讨论了若干未来有前景的研究和发展方向。我们还创建了一个GitHub仓库,用于索引相关的MMCL论文和开放资源,网址为:https://github.com/LucyDYu/Awesome-Multimodal-Continual-Learning。

关键词—多模态持续学习,多模态数据,终身学习,增量学习

1 引言

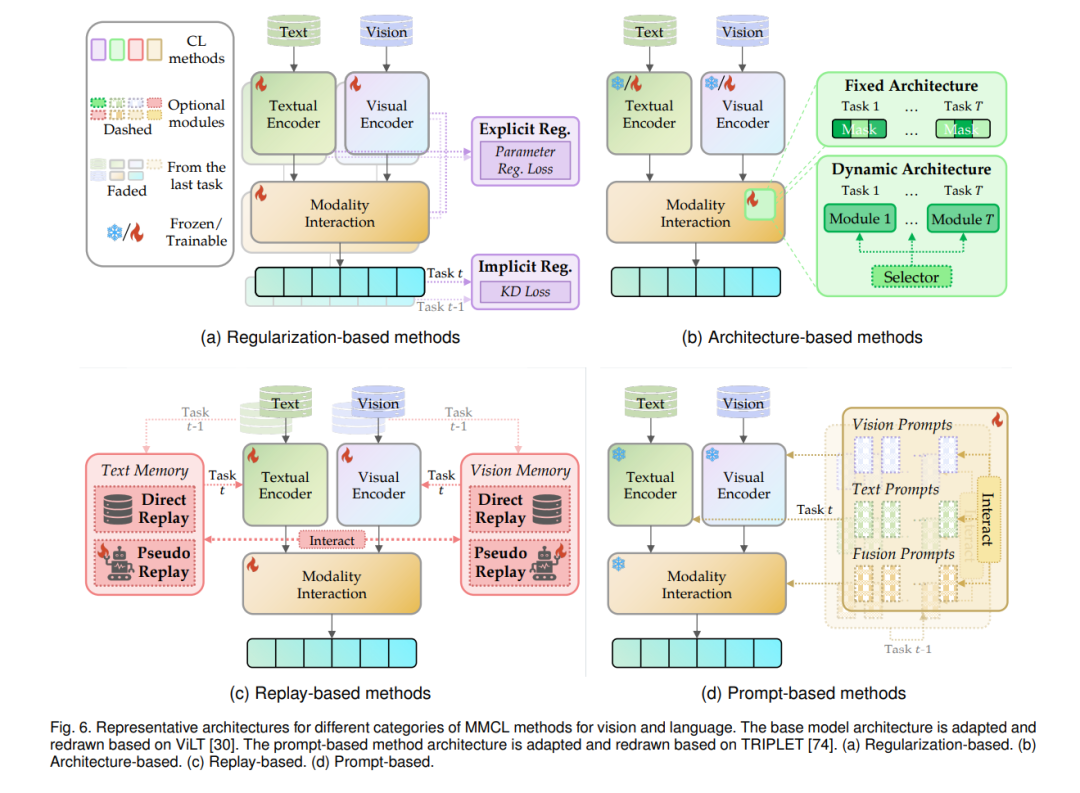

近年来,机器学习(ML)取得了显著的进展,为解决各种实际问题作出了重要贡献。在传统设置中,大多数ML模型在所谓的“单一阶段”范式下运行,即在静态和单一数据集上进行训练,并在独立同分布(i.i.d.)假设下进行评估【1】。然而,这种“单一阶段”范式无法赋予训练模型适应新数据或执行新任务的能力,因此难以满足开发能够应对动态变化环境的智能体的需求。为解决这一问题,ML社区致力于发展持续学习(CL),也称为终身学习或增量学习,它通过在新任务上逐步训练模型并保留早期知识,无需对完整数据进行重新训练【2-5】。

CL的主要挑战是灾难性遗忘:当任务按顺序进行训练时,针对新任务的训练会严重影响之前已学习任务的性能【6, 7】,这是因为不受约束的微调会使参数远离旧的最优状态【8】。CL的目标是开发能够持续获取知识并保留已学习信息的学习系统。这一过程本质上模仿了生物大脑的认知灵活性,生物大脑在整个生命过程中不断学习各种技能【9】。通过使模型能够在不遗忘的情况下适应新任务,CL在资源和时间效率方面相较于传统的模型全数据重新训练方法具有显著优势。此外,由于存储限制、隐私问题等原因,历史训练数据可能无法访问,这使得全数据训练变得不可行,进一步突显了CL在记忆旧知识并从动态环境中获取最新知识方面的效率和有效性。

尽管CL取得了显著进展,大多数研究仍集中在单一数据模态上,如视觉【10-13】、语言【14-16】、图【17, 18】或音频【19】。这种单模态的关注忽略了真实世界环境的多模态特性,这些环境本质上是复杂的,由多种数据模态组成而非单一模态。随着多模态数据的快速增长,例如Meta和TikTok等平台上图像、文本和视频数据的激增,开发能够从多模态源中持续学习的AI系统变得至关重要,因此出现了多模态持续学习(MMCL)设置。这些MMCL系统需要有效地整合和处理多模态数据流【20, 21】,同时还要能够保留先前获取的知识。更重要的是,这种MMCL设置更接近于人类生物系统在应对现实世界复杂性时跨模态学习和整合信息的过程【22, 23】。

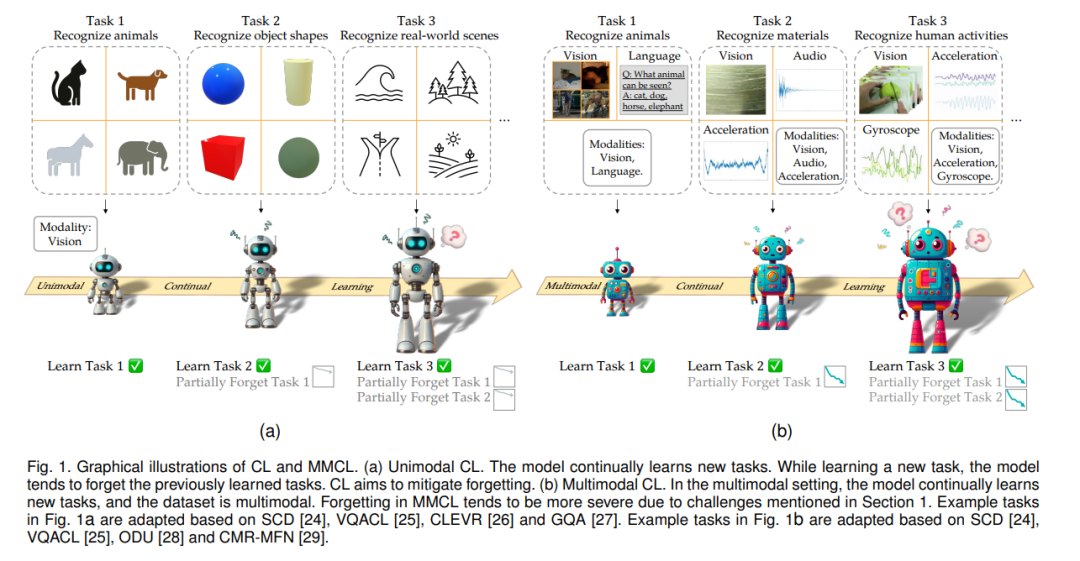

MMCL的挑战。尽管传统单模态CL与MMCL之间存在联系,MMCL的挑战远不止是简单地将CL方法叠加在多模态数据上。事实证明,这种直接的尝试通常会产生次优性能【31-33】。具体来说,如图2所示,除CL中已有的灾难性遗忘问题外,MMCL的多模态特性还引入了以下四个挑战。这些挑战不仅独立存在,还可能加剧灾难性遗忘问题:

-

挑战1(模态不平衡)。模态不平衡指的是在多模态系统中对不同模态进行不均衡处理或表示,这种不平衡在数据和参数层面上都有体现。在数据层面,不同模态的数据可用性在CL过程中可能显著不同,可能出现极端不平衡的情况,如某些模态的缺失【28】。在参数层面,不同模态特定组件的学习速率可能有所不同,导致跨所有模态的整体不平衡学习过程【34】。因此,MMCL模型可能会遭受性能下降,甚至在某些情况下其表现可能比单模态模型还要差【32, 36】。

-

挑战2(复杂模态交互)。模态交互发生在模型组件中,即多模态输入信息的表示之间进行显式交互。这一交互在MMCL中引入了独特的挑战,主要体现在两个交互过程中:模态对齐和模态融合【37】。在模态对齐中,不同模态的单一数据样本的特征在持续学习过程中往往会发生偏离,这种现象被称为MMCL中的空间紊乱【38】。在模态融合中,传统的多模态融合方法在非CL环境中效果良好,但在MMCL环境中可能表现较差,因为不同的融合技术对解决遗忘问题的影响各不相同【36, 39】。

-

挑战3(高计算成本)。MMCL中的多模态整合显著增加了模型和任务特定层面的计算成本。在模型层面,增加模态不可避免地增加了可训练参数的数量。许多MMCL方法利用预训练的多模态模型作为基础,但持续地微调这些大规模模型会导致沉重的计算负担【42, 43】。这些不断增加的计算需求对MMCL方法的实际部署提出了严格的可扩展性要求。

-

挑战4(预训练零样本能力的退化)。随着预训练模型的进步,MMCL方法可以借助这些强大的基础模型。预训练的多模态模型通常具有在未见过的任务上实现零样本能力的优势【44, 45】。然而,在MMCL的连续微调过程中,预训练基础模型的一些初始能力可能会下降,这种退化风险可能导致未来任务的性能严重下降【45】。

贡献。为了应对这些挑战,研究人员正日益关注MMCL方法。我们首次提供了MMCL的全面综述。我们总结了当前的数据集和基准测试,以促进研究和实验,并在快速发展的MMCL领域内讨论了未来的研究方向。总之,我们的综述有以下主要贡献:

-

我们提供了第一个全面的MMCL综述。我们详细介绍了MMCL的背景知识,包括基本的设定、不同的MMCL场景和常用评估指标。

-

在我们的MMCL方法分类体系中,我们将现有的MMCL工作分为四个类别,并提供了详细的子类别解释。

-

我们总结了当前的数据集和基准,并讨论了未来的研究方向,旨在激发创新性研究,从而促进更有效的MMCL方法的发展。

多模态持续学习

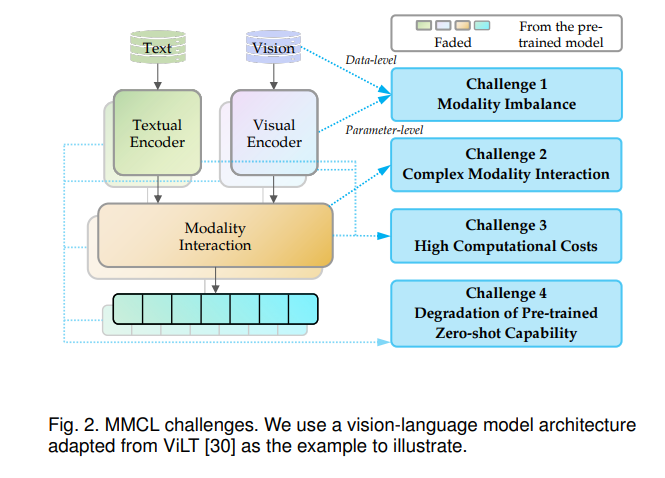

根据输入模态的不同,多模态持续学习可以分为五种主要场景:

-

类增量学习(Class-incremental Learning, CIL):不同任务间的数据分布和标签空间不同,且测试阶段不提供任务ID。模型需能在所有已学类别间进行分类。

-

领域增量学习(Domain-incremental Learning, DIL):不同任务间的数据分布不同,但共享相同的标签空间。测试阶段不需要任务ID。

-

任务增量学习(Task-incremental Learning, TIL):不同任务的数据分布和标签空间均不同,且测试阶段提供任务ID,模型知道执行的是哪个任务。

此外,为了适应多模态数据,定义了两种新的场景:

-

生成式领域增量学习(Generative Domain-incremental Learning, GDIL):此场景用于生成式任务,例如视觉问答。与CIL不同,GDIL中的模型输出来自一个较大的词汇集。

-

模态动态任务增量学习(Modality-dynamic Task-incremental Learning, MDTIL):任务序列中的模态可能变化,模型在测试阶段获得任务ID,并适应不同的模态组合。

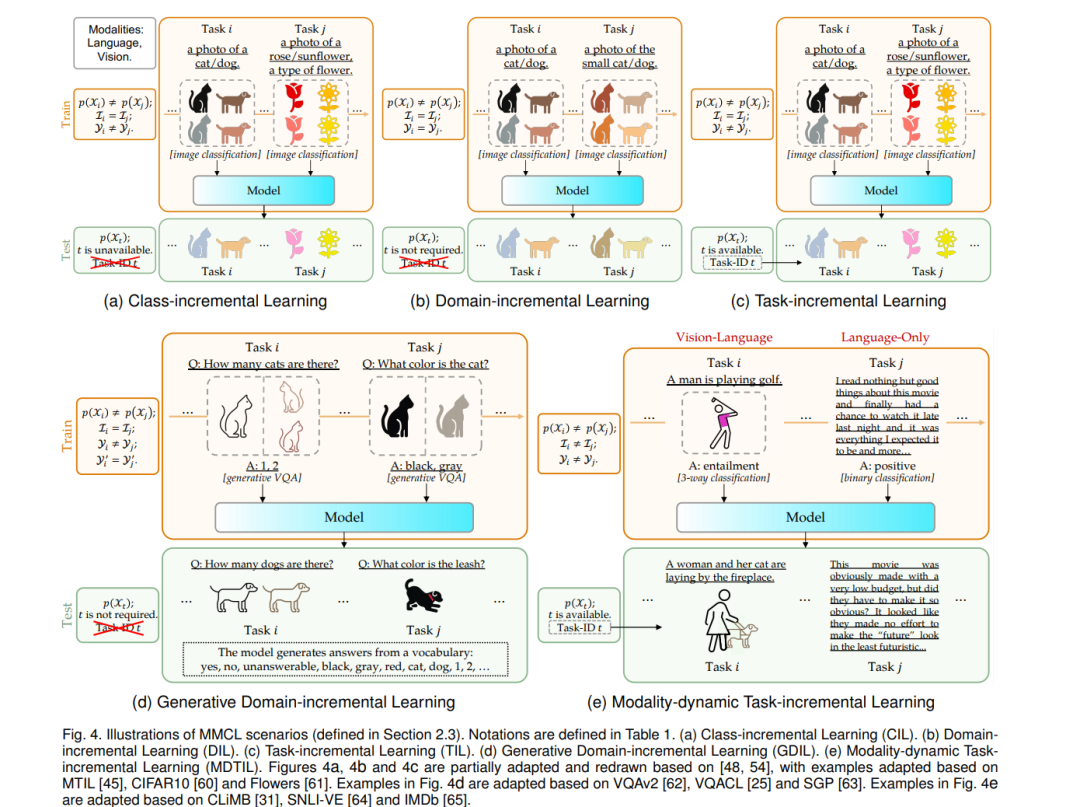

3 方法学

在多模态持续学习(MMCL)中,有多种方法学策略。本文将MMCL方法分为四大类:基于正则化、基于架构、基于重放以及基于提示的方法。图5对这些方法进行了分类,并在后续的小节中详细说明。表2总结了各类MMCL方法的具体特性,而图6展示了代表性架构,主要以视觉和语言模态为主。对于其他模态的方法,在表3中进行了汇总。在正式介绍MMCL方法之前,我们将首先介绍一些经典的单模态持续学习(CL)方法,因为它们既是MMCL方法的前身,也在MMCL研究中被广泛用作对比。

3.1 基于正则化的方法

基于正则化的方法旨在通过对参数施加约束来减少灾难性遗忘现象【8】。这类方法根据约束方式的不同,分为显式正则化和隐式正则化两种。下图(图6a)总结了显式和隐式正则化方法的代表性架构。

3.1.1 显式正则化

显式正则化方法通过直接为参数赋予重要性权重来抑制模型的参数变化。它通过惩罚那些偏离先前最优状态的参数,以减缓模型的遗忘。其关键思想是对模型的参数偏移施加显式约束,以保护模型在先前任务中的知识。

在这种方法中,常用的技术包括:

-

弹性权重保持(Elastic Weight Consolidation, EWC):通过利用Fisher信息矩阵对参数赋予权重,从而实现参数保护,避免重要参数发生显著改变。EWC的变种方法例如EWCH和在线EWC通过单一正则化项的方式进一步提高了效率。

-

任务相关性调节(Task Importance Regularization, TIR):这是MMCL中的一种方法,基于BLIP2等多模态模型。它通过计算新旧任务之间的相似性来动态调整正则化权重,以适应长期持续学习的需求。

3.1.2 隐式正则化

隐式正则化方法主要关注于在训练新任务时尽量保持模型对旧任务输出的一致性,从而减少遗忘风险。与显式正则化不同,隐式正则化方法仅在参数变化导致模型输出改变时才施加惩罚,因此允许参数更自由地调整。隐式正则化常见的方式是知识蒸馏(KD),通常包括以下几种策略:

-

基于logits的蒸馏(Logits-based KD):通过对比新模型和旧模型在最后一层输出的logits,尽量让新模型在训练新任务时保持与旧任务相似的输出分布。

-

基于特征的蒸馏(Feature-based KD):不仅关注最终输出,还在中间层的特征上进行对比,从而保留中间表征。

-

基于关系的蒸馏(Relation-based KD):使用样本间的关系信息进行对比,如在视觉-语言模型中,可以利用图像和文本之间的相似度来进行知识转移。

典型的单模态模型中,LwF(Learning without Forgetting)是一种经典的隐式正则化方法,它在训练新任务前使用当前数据生成旧任务的输出,并在训练时通过KD损失来最小化新任务下的输出变化。LwF因其无需显式存储旧任务数据的特性,被广泛应用于多模态和单模态CL模型中。

在多模态模型中,隐式正则化方法进一步扩展并改进了KD策略以适应不同的模态。例如,ZSCL(Zero-Shot Continual Learning)和Mod-X都使用CLIP作为基础模型,通过KD技术保留零样本能力。此外,Mod-X还关注空间无序(Spatial Disorder)问题,以解决视觉和语言表征在持续训练过程中逐渐偏离的问题。

3.2 基于架构的方法

架构方法通过引入任务特定组件来减少不同任务之间的干扰,通常分为固定架构和动态架构两种。

3.2.1 固定架构

固定架构方法在整个任务序列中保持相同的模型结构,通过任务掩码选择性地激活或抑制特定参数,从而使各个任务使用不同的参数组合。这种方式通过分配任务特定的参数部分来减轻遗忘现象。

单模态模型中,HAT(Hard Attention to the Task)通过学习接近于二值的注意力向量,在模型层次上选择性激活或抑制参数。它通过掩码来固定特定参数,以保留早期任务的知识。

在多模态模型中,RATT(Recurrent Attention Task Transformer)使用固定架构进行图像描述生成。它结合了卷积神经网络(CNN)和长短时记忆网络(LSTM),并通过注意力掩码实现特定任务的激活,以便针对不同任务分配不同的模型层激活状态。

3.2.2 动态架构

动态架构方法则允许模型结构随着任务的引入而动态扩展,通常通过添加新模块来增加模型容量。与固定架构不同,动态架构可以在新任务到来时扩展新的任务特定模块,因此性能不会受到初始容量的限制。

在单模态模型中,进步网络(Progressive Network)是一种早期的动态架构,它通过为每个新任务初始化一个新网络来避免遗忘。这种方法使用横向连接来支持特征共享和知识转移。

多模态模型中的动态架构方法则可以通过任务特定、模态特定等多种策略来决定如何扩展网络结构。例如,MoE-Adapters4CL在多模态模型CLIP的基础上为每个新任务添加模块,减少了新任务对已有知识的干扰。此外,ODU和CMR-MFN都设计了模态融合模块,以应对多模态数据中模态组合多变的特性。

3.3 基于重放的方法

重放方法使用一个记忆缓冲区来存储历史实例,以帮助在学习新任务时维护早期任务的知识。这些方法无需动态调整网络架构,也不需约束参数自由度。基于获取重放数据的不同方式,重放方法可以分为直接重放和伪重放两种。

3.3.1 直接重放

直接重放方法通过将旧任务中的少量样本存储在记忆缓冲区中,以在新任务训练时进行重放。此类方法的关键在于如何选择代表性样本以充分利用有限的记忆空间。

在多模态模型中,例如VQACL和SAMM采用随机选择策略直接重放多模态样本。实验表明,与单模态重放相比,多模态重放能显著提升模型的稳定性和灵活性。此外,KDR通过在跨模态相似度矩阵上引入KD,以确保模型更新前后的交互一致性,从而进一步巩固知识。

3.3.2 伪重放

伪重放方法利用生成模型学习旧任务的数据分布,从而在当前阶段生成伪造数据,避免了直接重放方法的存储需求和隐私问题。

例如,单模态模型中DGR(Deep Generative Replay)通过训练生成对抗网络(GAN)来生成数据样本以进行重放。后续研究扩展了伪重放策略,包括在特征层面进行伪重放,以强化特征表示,减少遗忘现象。

在多模态模型中,SGP通过保存场景图和语言模型生成伪造数据以进行伪重放。此外,AID通过伪原型重放策略处理模态不平衡问题,从而提升分类器的区分能力。这些方法解决了多模态学习环境中数据类型多样性和平衡性的问题。

3.4 基于提示的方法

基于提示的方法利用预训练大模型,通过修改输入而非调整模型结构来保留原始知识并学习新任务。此类方法减少了大规模微调的需求,并能够更好地保留预训练模型的零样本能力。

在多模态模型中,例如Fwd-Prompt和S-liPrompts分别采用共享提示和任务特定提示策略,增强了视觉-语言模型在跨模态信息融合中的表现。CPE-CLIP通过将视觉提示设计为语言提示的函数来连接多模态信息,使模型在新任务中具备更好的适应性。

4 数据集和基准

本节对当前多模态持续学习(MMCL)领域的主要数据集和基准进行了综述。MMCL中的大多数数据集都是从最初为非持续学习(CL)任务设计的知名数据集中改编而来,研究人员常常利用多个数据集或将单一数据集划分为多个子集,以便在MMCL设置中模拟任务【39】。此外,也存在一些专门为MMCL构建的数据集,例如P9D【68】和UESTC-MMEA-CL【39】。

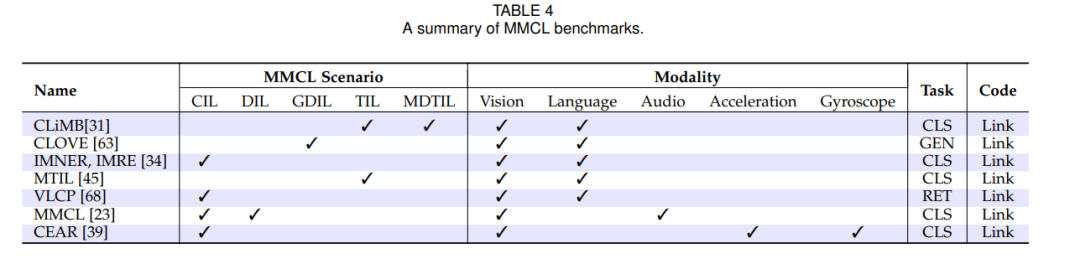

表4汇总了涵盖各种CL场景、模态和任务类型的MMCL基准。以下将具体介绍这些基准,若数据集和代码为公开可访问,将在相应位置标明。

4.1 基于原始数据集的基准

这一部分总结了两个专门为MMCL构建的数据集:

-

P9D:Zhu等人【68】利用电商数据构建了首个视觉-语言持续预训练数据集P9D,并建立了跨模态检索与多模态检索的VLCP基准。P9D包含超过一百万对真实产品的图像和文本数据,并根据行业类别划分为9个任务。该数据集旨在支持多模态任务中不同类别的持续学习。

-

UESTC-MMEA-CL:Xu等人【39】收集了来自佩戴智能眼镜的10位参与者的视频和传感器数据,构建了包含视觉、加速度和陀螺仪模态的UESTC-MMEA-CL数据集,这是第一个用于持续自我活动识别的多模态数据集。作者还建立了CEAR基准,并使用了三种基础CL方法:EWC【11】、LwF【10】和iCaRL【12】。研究结果显示,与其他方法相比,iCaRL在重放基础上能更有效地减轻遗忘问题。

这两个数据集通过与常用CL方法的结合验证了MMCL方法在不同模态组合上的有效性,也进一步揭示了多模态数据融合的挑战及潜在研究方向。

4.2 基于多个数据集的基准

除了专门的数据集外,也有一些基准通过使用多个数据集来模拟MMCL任务。以下是一些此类基准的简要介绍:

-

CLiMB【31】:该基准包括四个视觉-语言任务(VQAv2、NLVR2、SNLI-VE和VCR)、五个仅语言任务(IMDb、SST-2、HellaSwag、CommonsenseQA和PIQA)以及四个仅视觉任务(ImageNet-1000、iNaturalist2019、Places365和MS-COCO目标检测)。CLiMB采用分类任务来评估模型在不同模态任务中的表现。

-

CLOVE【63】:专注于生成任务,适用于不同模态的生成式任务,利用多个数据集进行评估。

-

MTIL【45】:该基准在视觉-语言领域内使用了多个数据集进行任务增量学习,验证模型在多任务设置中的表现。

-

CEAR【39】:基准测试多模态数据集(视频、加速度和陀螺仪)上的持续学习性能,评估模型对复杂运动数据的持续识别能力。

这些基准提供了多种任务和模态组合,用以验证模型在各种复杂多模态环境中的持续学习能力。通过这些基准,研究人员可以深入探讨MMCL方法在不同任务类型下的适用性和性能表现。

5 未来研究方向

随着多模态模型的快速发展,多模态持续学习(MMCL)已成为一个活跃且前景广阔的研究课题。在本节中,我们提出了几个值得进一步探索和研究的未来方向。

5.1 提升模态数量与质量

当前的MMCL研究中,多模态数据的数量和质量直接影响模型的性能。然而,由于不同模态的数据特性和收集难度,提升模态数量和质量仍面临诸多挑战:

-

丰富模态种类:许多现有研究主要集中在视觉、语言和音频模态上,但实际应用中往往需要结合更多模态,如生物信号、环境数据等。因此,未来研究可以探索如何将更多元的模态引入MMCL系统,以提高模型对复杂环境的适应性和泛化能力。

-

提高数据质量:不同模态数据的噪声和不完整性可能导致信息缺失或误导模型学习。提高数据采集和预处理的质量,以及开发具有鲁棒性的数据增强方法,将有助于改善模型对多模态数据的学习效果。

-

模态互补性研究:多模态数据之间的互补性在MMCL中发挥着重要作用。研究如何更好地利用不同模态之间的相互补充来增强学习效果,例如通过模态间对齐和融合方法,以更好地利用数据多样性,提升模型的整体性能。

5.2 更高效的计算资源利用

MMCL中的模型往往依赖大规模预训练模型,并在多个模态和任务上进行持续训练,这对计算资源提出了更高要求。为提高资源利用效率,未来可以在以下几个方面展开研究:

-

参数高效的微调方法:开发参数高效的微调策略(如适配器模块、低秩近似等),以减少训练过程中对计算资源的需求。这类方法能够使模型在进行任务增量学习时仅调整少量参数,从而减轻计算负担。

-

模型压缩和加速:探索模型压缩(如量化、剪枝)和加速(如蒸馏、混合精度训练)技术,以降低MMCL模型的内存和计算成本,使其更适合实际部署。

-

分布式与异构计算:结合分布式计算和异构计算设备(如GPU和TPU),分担大规模多模态数据的处理任务,以应对计算负载挑战。这可以使得MMCL模型在多任务和大数据量场景下保持较高的性能表现。

5.3 增强零样本能力和泛化性能

MMCL中的一个关键挑战是如何在不忘旧任务的同时提升对新任务的零样本适应能力及泛化性能:

-

保持预训练模型能力:随着持续微调的进行,MMCL模型可能逐渐丧失预训练模型的零样本能力。研究如何在保持先前知识的基础上,继续增强模型对新任务的适应性,将是未来的重要方向。

-

增强跨任务泛化:MMCL模型往往面对跨任务的知识迁移和适应性问题。如何设计有效的跨任务知识迁移机制,以增强模型在不同任务间的泛化能力,将有助于提高模型在多变环境下的实用性。

-

任务间关系学习:许多现实任务之间存在一定的关联性,未来可以探索如何利用任务间的关系信息(如标签关系、特征共现)来更好地指导模型学习,从而提升模型对新任务的预测准确性。

5.4 应对多模态数据中的模态失衡

在多模态环境下,模态数据的分布和数量可能存在不平衡,这会影响MMCL的表现。未来的研究可以关注以下方面:

-

模态优先级与加权机制:不同模态对任务完成的重要性可能不同,因此可以研究如何为不同模态分配合适的权重和优先级,以提高模型在模态不平衡情况下的鲁棒性。

-

动态模态选择与融合:设计动态的模态选择策略,使模型能够在缺少某些模态数据时,灵活地进行模态融合和任务处理。这种动态融合策略将提高模型在不同模态条件下的适应性。

-

模态数据重采样与合成:在模态不平衡的情况下,可以研究如何通过重采样或合成方法生成缺少的模态数据,以保持模态之间的平衡性,提高模型的整体学习效果。

5.5 提高模型对隐私与数据安全的适应性

随着隐私和数据安全需求的增加,未来MMCL研究需要更好地应对这些问题:

-

隐私保护技术:研究如何在MMCL模型中引入隐私保护技术,如联邦学习和差分隐私,以在多模态数据环境中保护用户隐私。

-

安全模型更新与迁移:开发安全的模型更新和迁移机制,以防止敏感数据泄露,同时保证模型在不同平台或设备上的适应性和性能。

-

数据合成与伪重放:为减轻隐私风险,可以利用数据合成与伪重放技术,在不依赖真实用户数据的情况下,重建训练数据分布,从而提高模型的隐私适应性。

结论

以上是未来研究方向的详尽讨论,为进一步发展多模态持续学习(MMCL)领域提供了切实可行的建议和探索路径。通过提升模态数量与质量、提高计算资源效率、增强零样本能力与泛化性能、应对模态失衡问题,以及加强隐私与数据安全的适应性,研究人员可以应对MMCL的挑战,推动模型更好地适应现实环境的需求。这些方向的研究不仅能解决当前的技术难题,还将推动更为广泛和深入的实际应用,从而实现更加智能化和多样化的学习系统。

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

相关文章:

【AI大模型】《多模态持续学习》最新进展综述

摘要—持续学习(CL)旨在使机器学习模型能够从新数据中不断学习,同时在不遗忘已获得知识的基础上进行扩展。随着机器学习模型从小规模到大规模预训练架构的演变,以及从支持单一模态数据到支持多模态数据,多模态持续学习…...

大厂面试真题-CPU飙升问题怎么定位

CPU使用率飙升是开发者和系统管理员常遇到的问题,定位CPU飙升问题通常涉及以下步骤: 一、使用系统监控工具 查看CPU使用图表:利用任务管理器(Windows系统)或top、htop(Linux系统)等工具&#…...

【每日刷题】Day137

【每日刷题】Day137 🥕个人主页:开敲🍉 🔥所属专栏:每日刷题🍍 🌼文章目录🌼 1. 1576. 替换所有的问号 - 力扣(LeetCode) 2. 495. 提莫攻击 - 力扣…...

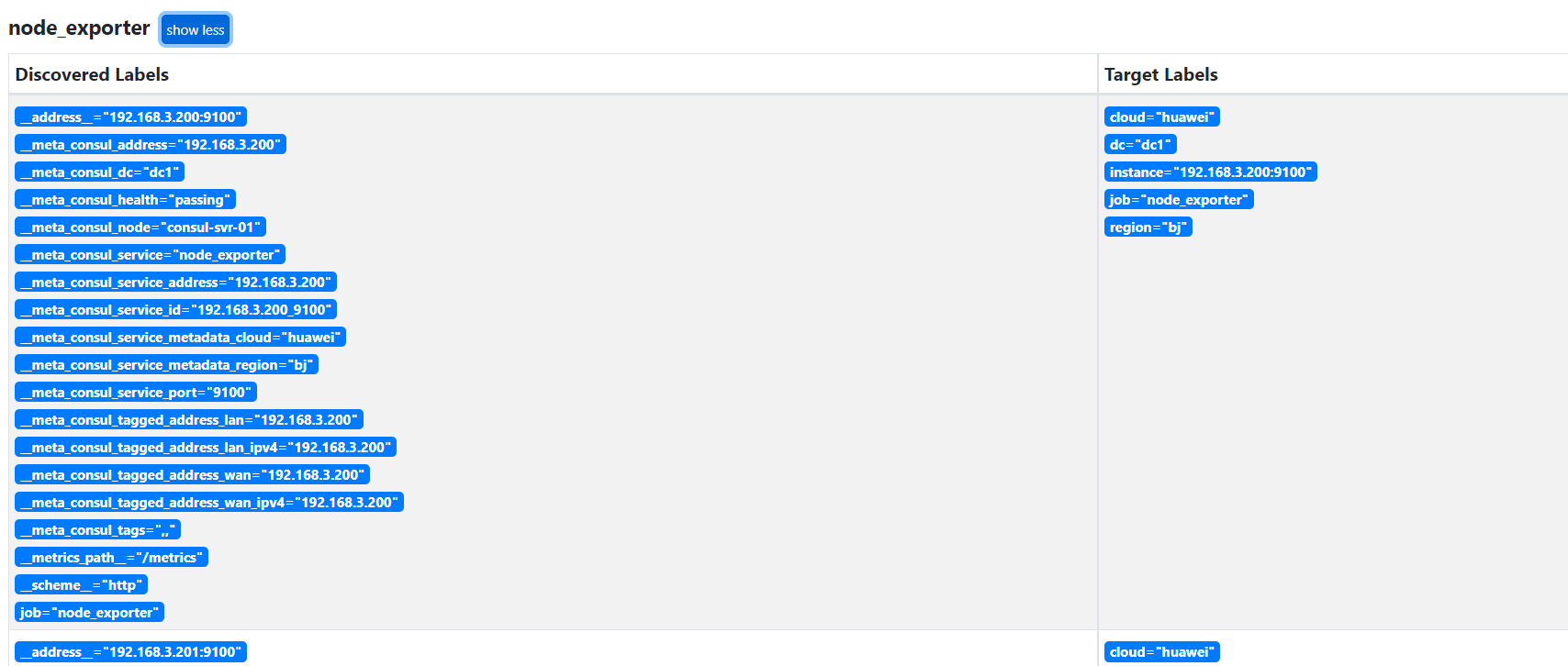

24.4 基于consul服务发现模式

本节重点介绍 : consul 安装consul go代码注册服务,注销服务,获取服务node_exporter改造为consul服务发现在数量比较大时,在注册服务的时候,关闭check,可以降低consul的压力 consul 安装 准备工作 # 下载consul wge…...

[红队apt]快捷方式病毒攻击流程

免责声明:本文整理攻击者操作,帮助了解攻击原理,提高防范能力 前言 欢迎来到我的博客 个人主页:北岭敲键盘的荒漠猫-CSDN博客 本文整理攻击者是如何用快捷方式进行攻击的流程 快捷方式攻击原理 快捷方式可以指向执行某个程序。 我们利用快捷方式攻击的…...

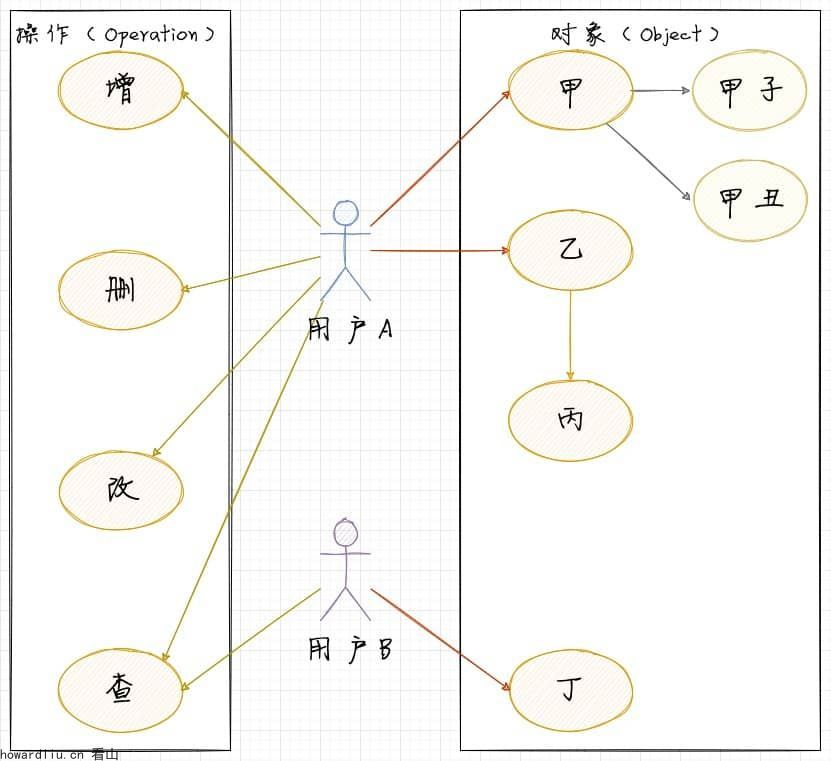

一个架构师的职业素养:四种常用的权限模型

你好,我是看山。 本文收录在《一个架构师的职业素养》专栏。日拱一卒,功不唐捐。 今天咱们一起聊聊权限系统。 以大家熟知的电商场景举例: 用户可以分为普通用户、VIP用户:我们需要控制不同角色用户的访问范围。比如,京东的PLUS会员,可以进入会员专区,而且能够使用礼金…...

说起来很简单,做起来很复杂:解密Chat GPT背后的原理与技术

你或许已经体验过ChatGPT,它能快速回答各种问题,生成文案、编写代码,甚至陪你聊些有趣的话题。看似简单易用,背后却隐藏着强大的技术支持。 输入几句话,ChatGPT仿佛“理解”了你的问题,立即给出准确的回答…...

tcpdump-arm平台移植

准备工作 下载并解压 972 mkdir tcpdump973 cd tcpdump/974 ls975 wget https://www.tcpdump.org/release/tcpdump-4.99.5.tar.xz976 wget https://www.tcpdump.org/release/libpcap-1.10.5.tar.xz977 tar -xvf libpcap-1.10.5.tar.xz978...

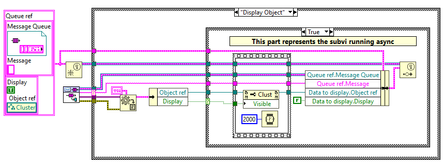

LabVIEW中的非阻塞定时器

在LabVIEW编程中,通常需要在某些任务执行过程中进行非阻塞的延时操作。例如,显示某条信息一段时间,同时继续执行其他任务,并在延时时间结束后停止显示该信息。这类需求通常用于处理优先级不同的信息显示,如错误信息需要…...

MIDIPLUS 50周年丨中国国际乐器展览会首日盛况

10月10日,由中国乐器协会、上海国展展览中心有限公司、法兰克福展览(上海)有限公司共同主办的中国(上海)国际乐器展览会在上海新国际博览中心(上海市浦东新区龙阳路2345号)盛大开幕。 2024上海…...

基于springboot的家政服务管理系统(含源码+sql+视频导入教程+文档+PPT)

👉文末查看项目功能视频演示获取源码sql脚本视频导入教程视频 1 、功能描述 基于springboot的家政服务管理系统1拥有三种角色 管理员:用户管理、服务管理、评价管理、预约管理、分配管理等 用户:登录注册、预约服务、取消服务、评价等 服…...

第十四届单片机嵌入式蓝桥杯

一、CubeMx配置 (1)LED配置 (1)LED灯里面用到了SN74HC573ADWR锁存器,这个锁存器有一个LE引脚,这个是我们芯片的锁存引脚(使能引脚),由PD2这个端口来控制的 (2ÿ…...

Zotero 如何实现数据同步 坚果云

如何在Zotero中设置webdav连接到坚果云? | 坚果云帮助中心...

基于Redis实现的延迟队列

1. 适用场景 日常开发中,我们经常遇到这样的需求,在某个事件发生后,过一段时间做一个额外的动作,比如 拼单,如果2小时未能成单,取消拼单下单,30分钟内未支付,取消订单 之前的我们的…...

LINUX——内核移植、内核编译教程

Linux内核编译是一个将内核源代码转换成可在特定硬件架构上运行的二进制文件的过程。以下是编译Linux内核的一般步骤: 1、准备工作: 确保安装了必要的编译工具,如gcc、make、ncurses库(用于make menuconfig)等。 2、…...

《OpenCV计算机视觉》—— 用于执行图像透视变换的两个关键函数

文章目录 cv2.getPerspectiveTransformcv2.warpPerspective注意事项 cv2.getPerspectiveTransform 和 cv2.warpPerspective 是 OpenCV 库中用于执行透视变换的两个关键函数。下面是对这两个函数的详细解释: cv2.getPerspectiveTransform 功能:计算从源…...

uniapp使用字体图标 ttf svg作为选项图标,还支持变色变图按

在staic目录下有一些ttf文件,如uni.ttf,iconfont.ttf 这些文件中保存这字体svg的源码们,我们也可以在网上找其他的。这些就是我们要显示的突图标的 显示来源。这样不用使用png图标,选中不选中还得用两个图片 我的具体使用如下 &q…...

<Project-6 pdf2tx> Python Flask 应用:图片PDF图书的中文翻译解决方案

重要更新! Modified on 8oct24. P6已经被 P8 替代,后着支持多任务,多翻译机。在速度与资源占用上,都好于这个P6。 新的 P8 文章链接: <Project-8 pdf2tx-MM> Python Flask应用:在…...

10.11Python数学基础-多维随机变量及其分布

多维随机变量及其分布 1.二维随机变量及其分布 假设E是随机试验,Ω是样本空间,X、Y是Ω的两个变量;(X,Y)就叫做二维随机变量或二维随机向量。X、Y来自同一个样本空间。 联合分布函数 F ( x , y ) P ( X ≤ x , Y ≤ y ) F(x,y)P(X≤x,Y≤…...

Mysql 数据库备份恢复全攻略)

(四)Mysql 数据库备份恢复全攻略

一、数据库备份 数据库备份目的和数据库故障类型 目的: 当发生故障时,将损失降到最低。保证能够快速从备份数据中恢复,确保数据稳定运行。故障类型: 程序错误:Mysql 服务器端程序故障无法使用。人为误操作:…...

生成xcframework

打包 XCFramework 的方法 XCFramework 是苹果推出的一种多平台二进制分发格式,可以包含多个架构和平台的代码。打包 XCFramework 通常用于分发库或框架。 使用 Xcode 命令行工具打包 通过 xcodebuild 命令可以打包 XCFramework。确保项目已经配置好需要支持的平台…...

大数据学习栈记——Neo4j的安装与使用

本文介绍图数据库Neofj的安装与使用,操作系统:Ubuntu24.04,Neofj版本:2025.04.0。 Apt安装 Neofj可以进行官网安装:Neo4j Deployment Center - Graph Database & Analytics 我这里安装是添加软件源的方法 最新版…...

设计模式和设计原则回顾

设计模式和设计原则回顾 23种设计模式是设计原则的完美体现,设计原则设计原则是设计模式的理论基石, 设计模式 在经典的设计模式分类中(如《设计模式:可复用面向对象软件的基础》一书中),总共有23种设计模式,分为三大类: 一、创建型模式(5种) 1. 单例模式(Sing…...

springboot 百货中心供应链管理系统小程序

一、前言 随着我国经济迅速发展,人们对手机的需求越来越大,各种手机软件也都在被广泛应用,但是对于手机进行数据信息管理,对于手机的各种软件也是备受用户的喜爱,百货中心供应链管理系统被用户普遍使用,为方…...

Spark 之 入门讲解详细版(1)

1、简介 1.1 Spark简介 Spark是加州大学伯克利分校AMP实验室(Algorithms, Machines, and People Lab)开发通用内存并行计算框架。Spark在2013年6月进入Apache成为孵化项目,8个月后成为Apache顶级项目,速度之快足见过人之处&…...

页面渲染流程与性能优化

页面渲染流程与性能优化详解(完整版) 一、现代浏览器渲染流程(详细说明) 1. 构建DOM树 浏览器接收到HTML文档后,会逐步解析并构建DOM(Document Object Model)树。具体过程如下: (…...

数据链路层的主要功能是什么

数据链路层(OSI模型第2层)的核心功能是在相邻网络节点(如交换机、主机)间提供可靠的数据帧传输服务,主要职责包括: 🔑 核心功能详解: 帧封装与解封装 封装: 将网络层下发…...

中的KV缓存压缩与动态稀疏注意力机制设计)

大语言模型(LLM)中的KV缓存压缩与动态稀疏注意力机制设计

随着大语言模型(LLM)参数规模的增长,推理阶段的内存占用和计算复杂度成为核心挑战。传统注意力机制的计算复杂度随序列长度呈二次方增长,而KV缓存的内存消耗可能高达数十GB(例如Llama2-7B处理100K token时需50GB内存&a…...

Java线上CPU飙高问题排查全指南

一、引言 在Java应用的线上运行环境中,CPU飙高是一个常见且棘手的性能问题。当系统出现CPU飙高时,通常会导致应用响应缓慢,甚至服务不可用,严重影响用户体验和业务运行。因此,掌握一套科学有效的CPU飙高问题排查方法&…...

)

安卓基础(aar)

重新设置java21的环境,临时设置 $env:JAVA_HOME "D:\Android Studio\jbr" 查看当前环境变量 JAVA_HOME 的值 echo $env:JAVA_HOME 构建ARR文件 ./gradlew :private-lib:assembleRelease 目录是这样的: MyApp/ ├── app/ …...