大数据新视界 -- 大数据大厂之 Impala 性能优化:数据存储分区的艺术与实践(下)(2/30)

💖💖💖亲爱的朋友们,热烈欢迎你们来到 青云交的博客!能与你们在此邂逅,我满心欢喜,深感无比荣幸。在这个瞬息万变的时代,我们每个人都在苦苦追寻一处能让心灵安然栖息的港湾。而 我的博客,正是这样一个温暖美好的所在。在这里,你们不仅能够收获既富有趣味又极为实用的内容知识,还可以毫无拘束地畅所欲言,尽情分享自己独特的见解。我真诚地期待着你们的到来,愿我们能在这片小小的天地里共同成长,共同进步。💖💖💖

本博客的精华专栏:

- 大数据新视界专栏系列:聚焦大数据,展技术应用,推动进步拓展新视野。

- Java 大厂面试专栏系列:提供大厂面试的相关技巧和经验,助力求职。

- Python 魅力之旅:探索数据与智能的奥秘专栏系列:走进 Python 的精彩天地,感受数据处理与智能应用的独特魅力。

- Java 性能优化传奇之旅:铸就编程巅峰之路:如一把神奇钥匙,深度开启 JVM 等关键领域之门。丰富案例似璀璨繁星,引领你踏上编程巅峰的壮丽征程。

- Java 虚拟机(JVM)专栏系列:深入剖析 JVM 的工作原理和优化方法。

- Java 技术栈专栏系列:全面涵盖 Java 相关的各种技术。

- Java 学习路线专栏系列:为不同阶段的学习者规划清晰的学习路径。

- JVM 万亿性能密码:在数字世界的浩瀚星海中,JVM 如神秘宝藏,其万亿性能密码即将开启奇幻之旅。

- AI(人工智能)专栏系列:紧跟科技潮流,介绍人工智能的应用和发展趋势。

- 智创 AI 新视界专栏系列(NEW):深入剖析 AI 前沿技术,展示创新应用成果,带您领略智能创造的全新世界,提升 AI 认知与实践能力。

- 数据库核心宝典:构建强大数据体系专栏系列:专栏涵盖关系与非关系数据库及相关技术,助力构建强大数据体系。

- MySQL 之道专栏系列:您将领悟 MySQL 的独特之道,掌握高效数据库管理之法,开启数据驱动的精彩旅程。

- 大前端风云榜:引领技术浪潮专栏系列:大前端专栏如风云榜,捕捉 Vue.js、React Native 等重要技术动态,引领你在技术浪潮中前行。

- 工具秘籍专栏系列:工具助力,开发如有神。

展望未来,我将持续深入钻研前沿技术,及时推出如人工智能和大数据等相关专题内容。同时,我会努力打造更加活跃的社区氛围,举办技术挑战活动和代码分享会,激发大家的学习热情与创造力。我也会加强与读者的互动,依据大家的反馈不断优化博客的内容和功能。此外,我还会积极拓展合作渠道,与优秀的博主和技术机构携手合作,为大家带来更为丰富的学习资源和机会。

我热切期待能与你们一同在这个小小的网络世界里探索、学习、成长。你们的每一次点赞、关注、评论、打赏和订阅专栏,都是对我最大的支持。让我们一起在知识的海洋中尽情遨游,共同打造一个充满活力与智慧的博客社区。✨✨✨

衷心地感谢每一位为我点赞、给予关注、留下真诚留言以及慷慨打赏的朋友,还有那些满怀热忱订阅我专栏的坚定支持者。你们的每一次互动,都犹如强劲的动力,推动着我不断向前迈进。倘若大家对更多精彩内容充满期待,欢迎加入【青云交社区】或加微信:【QingYunJiao】【备注:技术交流】。让我们携手并肩,一同踏上知识的广袤天地,去尽情探索。此刻,请立即访问我的主页 或【青云交社区】吧,那里有更多的惊喜在等待着你。相信通过我们齐心协力的共同努力,这里必将化身为一座知识的璀璨宝库,吸引更多热爱学习、渴望进步的伙伴们纷纷加入,共同开启这一趟意义非凡的探索之旅,驶向知识的浩瀚海洋。让我们众志成城,在未来必定能够汇聚更多志同道合之人,携手共创知识领域的辉煌篇章

大数据新视界 -- 大数据大厂之 Impala 性能优化:数据存储分区的艺术与实践(下)(2/30)

- 引言:

- 正文:

- 一、数据存储分区深入探究:承上启下

- 1.1 分区策略的多样性与选择依据

- 1.2 复杂业务场景下的分区考量

- 二、分区管理与维护:持续优化之路

- 2.1 分区的动态添加与删除

- 2.2 分区数据的更新与迁移

- 三、分区与查询性能优化:相辅相成

- 3.1 分区对查询执行计划的影响

- 3.2 基于分区的查询优化技巧

- 四、案例分析:分区优化的实战成果

- 4.1 某跨国电商企业的 Impala 分区优化之旅

- 4.2 某大型互联网企业的分区调整与性能提升

- 结束语:

引言:

在大数据这个广袤无垠的 “宇宙” 中,数据宛如繁星般不计其数,它们或明或暗、错综复杂地散落在各个角落。我们就像是在这片数据宇宙中航行的探索者,怀揣着对知识的渴望,努力在浩瀚的数据海洋里寻找更高效管理和挖掘数据价值的方法。

曾经,我们在《大数据新视界 – 大数据大厂都在用的数据目录管理秘籍大揭秘,附海量代码和案例》中,如同发现了一张珍贵的导航图 —— 数据目录管理。它清晰地指引着我们在复杂的数据迷宫中穿梭,告诉我们如何精准地找到所需数据。这其中详细阐述了数据目录管理在大数据时代的核心地位,它宛如一位忠诚的卫士,以其强大的功能保障着数据的可访问性、可用性和安全性。同时,也毫无保留地指出了我们在数据管理之路上会遭遇的重重挑战:数据的多样性如同五彩斑斓却又令人眼花缭乱的星云,数据的快速增长好似宇宙的膨胀般永不停息,质量参差不齐的数据就像夹杂在璀璨宝石中的沙石。针对这些问题,文中还慷慨地分享了一系列应对策略,丰富的案例如同宇宙中的璀璨星系,照亮我们前行的道路,而那些实用的代码示例则像是我们手中的精密工具,助力我们在实践中更好地理解和运用数据目录管理,使我们对其有了深刻且清晰的认识。

再将目光聚焦到 Impala —— 这一在大数据分析领域堪称 “超级战舰” 的强大引擎。在《大数据新视界 – 大数据大厂之 Impala 性能优化:解锁大数据分析的速度密码(上)(1/30)》里,我们已然踏上了探索如何让这艘 “战舰” 火力全开的奇妙征程。我们深刻认识到 Impala 性能优化对于大数据分析效率的提升以及企业决策的准确性有着至关重要的意义。就像在宇宙航行中要穿越各种复杂的星际环境一样,Impala 在处理数据时也面临着数据规模如宇宙般庞大、数据结构复杂似神秘星云的挑战。在这个过程中,我们深入了解了数据存储和查询方面的优化策略,这些策略如同战舰上的精密仪器,保障着航行的顺畅。通过电商和金融等行业如同宇宙中标志性星球般经典的案例,我们亲眼见证了优化所带来的翻天覆地的变化,犹如见证了新星的诞生。同时,我们还对比了 Impala 与其他分析引擎的优劣,就像比较不同型号战舰的性能参数一样,并且深刻认识到可视化工具在整个优化过程中所扮演的重要角色,它宛如战舰的导航系统,为我们指引方向。

如今,我们要继续深入探索 Impala 性能优化这个神秘而关键的领域,将目光聚焦在数据存储分区这一核心环节上,它就像是 “超级战舰” 的核心动力舱。在《大数据新视界 – 大数据大厂之 Impala 性能优化:数据存储分区的艺术与实践(下)(2/30)》这篇文章里,我们将像拆解精密仪器一样,深入剖析数据存储分区的奥秘。我们会探寻更多隐藏其中的高级技巧,就像寻找宇宙中神秘的能量源;研究在不同业务场景下如同不同星际环境中的最佳分区策略;还要学会巧妙地规避分区可能带来的潜在问题,如同躲避宇宙航行中的暗礁,确保 Impala 这艘 “超级战舰” 在大数据的海洋里能够乘风破浪、一往无前,向着数据价值的深处全速航行。

正文:

一、数据存储分区深入探究:承上启下

1.1 分区策略的多样性与选择依据

在 Impala 的世界里,数据存储分区并非是一成不变的模式,而是如同宇宙中的星系,有着多种多样的形态。不同的业务场景和数据特点就像不同的星际环境和星球类型,决定了我们需要选择与之相匹配的分区策略。

例如,对于时间序列数据,像电商平台的订单数据,按日期分区就像是按照星球的公转周期来划分星系一样,是一种常见且高效的做法。以下是创建按日期分区的订单表的示例代码,这里我们使用 PARQUET 格式存储数据,这种格式在存储效率和查询性能上有良好的表现。

-- 创建按日期分区的订单表示例

CREATE TABLE orders (order_id INT,customer_id INT,order_date DATE,product_id INT,quantity INT,total_amount DECIMAL(10,2)

)

PARTITIONED BY (year INT, month INT, day INT)

STORED AS PARQUET;

以下是一个查询特定日期订单数据的函数示例,用于展示如何利用分区进行高效查询。此函数在不同操作系统和 Impala 版本中的兼容性较好,但请注意,在实际使用过程中,如果遇到问题,可参考 Impala 官方文档中关于兼容性的详细说明部分。这里我们详细注释每一步代码,帮助你更好地理解。

import matplotlib.pyplot as plt

import seaborn as sns

import pandas as pd# 这个函数用于根据指定的年、月、日查询订单数据

def query_orders_by_date(year, month, day):# 使用 Impala 的 Python 客户端连接(这里假设已经安装和配置好)from impala.dbapi import connecttry:# 建立与 Impala 服务器的连接,这里的 host 和 port 需要根据实际情况修改conn = connect(host='your_host', port=21050)cursor = conn.cursor()# 构建查询语句,从 orders 表中选择符合指定日期条件的数据query = "SELECT * FROM orders WHERE year = {} AND month = {} AND day = {};".format(year, month, day)cursor.execute(query)# 获取查询结果results = cursor.fetchall()cursor.close()conn.close()return resultsexcept Exception as e:print(f"查询过程中出现错误: {e}")return None# 这个函数用于可视化查询结果(假设结果是一个二维表格数据)

def visualize_query_results(results):if results:data = pd.DataFrame(results)plt.figure(figsize=(10, 6))# 使用 seaborn 的 heatmap 绘制相关系数热图,annot=True 表示显示数值sns.heatmap(data.corr(), annot=True)plt.title("Correlation Heatmap of Query Results")plt.show()else:print("没有查询到结果,无法进行可视化。")

但对于一些具有地域特征的数据,如物流信息数据,按地区分区可能更合适,就像根据星球的地理位置来划分星系一样。这就需要我们根据数据的内在逻辑和查询模式来决定分区策略。

1.2 复杂业务场景下的分区考量

在复杂的业务场景中,单一维度的分区往往不能满足需求,就像在探索复杂星际环境时,仅靠一种观测手段是远远不够的。以跨国电商企业为例,其数据不仅包含订单信息,还有用户信息、商品信息等,这些数据就像宇宙中的各种天体,而且需要从不同维度进行分析,如按国家、按商品类别、按时间等,就像从不同的角度来观测宇宙。

| 业务维度 | 分区策略示例 | 优势 |

|---|---|---|

| 国家 | 按国家代码分区 | 快速查询特定国家的数据,如分析某个国家的销售趋势,就像精准定位到某个星系中的星球,能够迅速聚焦到目标数据,减少不必要的数据扫描。 |

| 商品类别 | 按商品分类编号分区 | 便于统计不同类别商品的销售情况,如同对不同类型的天体进行分类研究,可针对各类商品的特点进行针对性分析和决策。 |

| 时间 | 按年、月、日分区 | 在时间维度上分析数据,如查看每月销售额变化,类似观察天体在不同时间点的状态变化,有助于发现销售趋势的周期性规律。 |

这时,我们可以采用多级分区的方式,这就好比构建一个多维的星际坐标系统。以下是一个多级分区的示例代码,以同时按国家和时间分区的用户访问数据为例。这里我们在创建表时,考虑到数据的存储和查询性能,选择了合适的存储格式和分区键。

CREATE TABLE user_visits (user_id INT,visit_time TIMESTAMP,page_url VARCHAR(200),country_code VARCHAR(10)

)

PARTITIONED BY (country_code VARCHAR(10), year INT, month INT, day INT)

STORED AS PARQUET;

以下是一个根据国家和时间范围查询用户访问数据的存储过程示例,同时展示查询执行计划的可视化。在执行分区相关操作时,请务必确保对数据有充分的备份,以防止误操作导致数据丢失。这里我们详细解释存储过程的每一步,让你明白其工作原理。

CREATE PROCEDURE query_user_visits_by_country_and_date_range(IN country VARCHAR(10), IN start_year INT, IN start_month INT, IN start_day INT, IN end_year INT, IN end_month INT, IN end_day INT)

BEGIN-- 构建查询语句,根据输入的国家和日期范围从 user_visits 表中选择数据SET @query = CONCAT('SELECT * FROM user_visits WHERE country_code = "', country, '" AND ( (year >= ', start_year, ' AND month >= ', start_month, ' AND day >= ', start_day, ') AND (year <= ', end_year, ' AND month <= ', end_month, ' AND day <= ', end_day, ') );');PREPARE stmt FROM @query;EXECUTE stmt;DEALLOCATE PREPARE stmt;-- 获取并可视化查询执行计划SET @explain_query = CONCAT('EXPLAIN ', @query);PREPARE explain_stmt FROM @explain_query;EXECUTE explain_stmt;DEALLOCATE PREPARE explain_stmt;SELECT * FROM information_schema.query_plan WHERE query_text LIKE CONCAT('%', @query, '%');

END;

这种多级分区方式在应对复杂查询需求时表现卓越,它如同精准的导航系统,能迅速锁定所需数据,极大地提升查询效率。

当我们使用特定工具(如 Impala 生态系统内的可视化插件)将查询执行计划可视化后,能更清晰地洞察分区对查询产生的影响。

在这个可视化呈现中,想象一下,不同颜色的线条纵横交错,每一种颜色的线条都代表着一个独特的分区筛选过程。比如,红色线条像是一条专属的数据通道,代表着按日期分区的筛选,所有符合特定日期范围的数据都沿着这条红线流动;蓝色线条则可能是地域分区筛选的象征,沿着它的数据都来自于特定的地理区域。这些色彩斑斓的线条交织在一起,就构成了数据流向的生动画面,清晰地展示出数据在各个分区条件下的流动路径。

而其中的节点,就像是这条数据之路上的关键站点,每个节点都代表着数据处理的一个重要阶段。起始的节点像是数据的 “始发站”,这里是数据读取的地方,大量原始数据从存储中被提取出来;随后的节点可能是 “检查站”,各种分区条件在这里发挥作用,像是一道道关卡,只有满足特定分区条件的数据才能通过;再往后的节点,有的可能是 “加工厂”,对经过筛选的数据进行诸如聚合、计算之类的操作。

通过仔细剖析这些线条和节点所蕴含的信息,我们仿佛拥有了一双慧眼,能够清楚地看到查询是如何巧妙地利用分区机制,就像一位经验丰富的领航员精准地绕过重重障碍,大幅减少不必要的数据读取量,进而推动查询效率的显著提升

二、分区管理与维护:持续优化之路

2.1 分区的动态添加与删除

随着业务的发展,数据的分布和范围可能会发生变化,这就需要我们对分区进行动态管理,就像宇宙在不断膨胀和演化,我们需要不断调整对星系的观测和管理方式。例如,当电商企业开拓新的市场,有新的国家地区数据流入时,需要添加新的分区,就像发现了新的星系需要将其纳入我们的观测范围。

-- 添加新分区(以添加新国家分区为例)

ALTER TABLE user_visits ADD PARTITION (country_code = 'new_country', year = 2024, month = 11, day = 3);

以下是一个批量添加分区的脚本示例,假设要为新的一批国家添加分区,同时分析添加分区操作对系统资源的影响。在执行此类数据修改操作时,请务必谨慎,特别是在生产环境中,要先在测试环境中充分测试,以避免对系统稳定性和数据完整性造成影响。这里我们详细记录了操作过程中的系统资源使用情况,包括 CPU 和内存利用率,以便更好地评估操作对系统的影响。

import time

import psutil

# 假设新国家列表

new_countries = ['country1', 'country2', 'country3']

start_time = time.time()

for country in new_countries:add_partition_query = "ALTER TABLE user_visits ADD PARTITION (country_code = '{}', year = 2024, month = 11, day = 3);".format(country)# 这里可以使用 Impala 的执行接口来执行这个查询,如通过命令行工具或者编程接口。以下是使用命令行模拟执行的示例,在实际应用中,你需要根据你的环境和需求进行调整。try:import subprocesssubprocess.run(["impala-shell", "-q", add_partition_query])except Exception as e:print(f"添加分区 {country} 时出现错误: {e}")

end_time = time.time()

print("添加分区操作耗时:", end_time - start_time, "秒")

print("CPU利用率:", psutil.cpu_percent(), "%")

print("内存利用率:", psutil.virtual_memory().percent, "%")

而对于一些过期的数据分区,如过去某个时间段的日志数据,我们可以进行删除操作,以释放存储空间和提高查询性能,就像清理宇宙中的尘埃和废弃天体,为新的探索腾出空间。

-- 删除过期分区(以删除特定日期之前的日志分区为例)

ALTER TABLE logs DROP PARTITION (year = 2023, month = 12, day <= 31);

以下是一个自动删除过期分区的脚本,假设根据数据保留策略删除一定时间之前的分区,并展示分区删除前后存储使用情况的可视化对比。在执行分区删除操作时,要仔细确认删除条件,避免误删重要数据。这里我们使用了 Python 的日期时间模块来确定删除的分区范围,并通过可视化工具展示存储使用情况的变化。

import datetime

import matplotlib.pyplot as plt# 假设数据保留策略是保留最近3个月的数据

today = datetime.date.today()

three_months_ago = today - datetime.timedelta(days=90)year_to_delete = three_months_ago.year

month_to_delete = three_months_ago.month

day_to_delete = three_months_ago.day# 构建删除分区的查询语句(这里以日志表为例,假设日志表按年、月、日分区)

drop_query = "ALTER TABLE logs DROP PARTITION (year <= {}, month <= {}, day <= {});".format(year_to_delete, month_to_delete, day_to_delete)

# 执行删除操作(同样可以使用命令行工具或者编程接口)

try:import subprocesssubprocess.run(["impala-shell", "-q", drop_query])

except Exception as e:print(f"删除分区时出现错误: {e}")# 可视化分区删除前后存储使用情况(这里假设可以获取存储使用数据)

before_storage_data = get_storage_usage_data('logs', 'before_delete')

after_storage_data = get_storage_usage_data('logs', 'after_delete')

if before_storage_data is notonymous and after_storage_data is notonymous:plt.bar(['Before Delete', 'After Delete'], [before_storage_data, after_storage_data])plt.title("Storage Usage Before and After Partition Deletion")plt.xlabel("Status")plt.ylabel("Storage Usage")plt.show()

else:print("获取存储使用数据失败,无法进行可视化。")

2.2 分区数据的更新与迁移

在某些情况下,我们可能需要更新分区内的数据,或者将数据在不同分区之间进行迁移,就像在星际探索中重新规划天体的分类或调整观测区域一样。比如,当企业调整商品分类标准时,可能需要将原分区中的商品数据迁移到新的分类分区中。这需要谨慎操作,以确保数据的完整性和一致性,就像在调整星系结构时不能让任何一颗星球丢失或受损。

以下是一个简单的数据迁移示例,假设将某个旧分区的数据迁移到新分区(这里以模拟场景为例)。在这个过程中,我们创建临时表来过渡数据,以保证数据在迁移过程中的安全性。

-- 创建临时表

CREATE TABLE temp_table AS SELECT * FROM old_partition;

-- 清空旧分区

TRUNCATE TABLE old_partition;

-- 将数据插入新分区

INSERT INTO new_partition SELECT * FROM temp_table;

-- 删除临时表

DROP TABLE temp_table;

以下是一个更复杂的数据迁移和更新场景的代码示例。假设我们有一个产品数据表,产品分类从旧分类系统(old_category)更新到新分类系统(new_category),并且数据分布在不同的分区中,同时对迁移过程中的性能进行优化和监控。在进行数据迁移操作前,强烈建议对原数据进行备份,并且在迁移过程中密切关注系统资源使用情况,如有异常及时停止操作。这里我们通过创建临时映射表、使用游标和分批插入数据等技术来提高迁移效率和保证数据安全。

-- 创建一个临时映射表,用于存储旧分类和新分类的映射关系

CREATE TABLE category_mapping (old_category VARCHAR(50),new_category VARCHAR(50)

);-- 插入一些示例映射数据

INSERT INTO category_mapping VALUES ('old_cat1', 'new_cat1'), ('old_cat2', 'new_cat2');-- 创建一个存储过程来执行数据迁移和更新

CREATE PROCEDURE update_product_category()

BEGINDECLARE done INT DEFAULT FALSE;DECLARE old_cat VARCHAR(50);DECLARE new_cat VARCHAR(50);DECLARE cur CURSOR FOR SELECT old_category, new_category FROM category_mapping;DECLARE CONTINUE HANDLER FOR NOT FOUND SET done = TRUE;OPEN cur;read_loop: LOOPFETCH cur INTO old_cat, new_cat;IF done THENLEAVE read_loop;END IF;-- 创建临时表来存储当前旧分类的数据,并优化创建表操作的性能(例如设置合适的存储参数)SET @temp_table_query = CONCAT('CREATE TABLE temp_product_data (', get_column_definitions('products'), ') ENGINE=MyISAM PARTITION BY KEY(category) PARTITIONS 10 AS SELECT * FROM products WHERE category = "', old_cat, '";');PREPARE stmt_temp_table FROM @temp_table_query;EXECUTE stmt_temp_table;DEALLOCATE PREPARE stmt_temp_table;-- 更新临时表中的分类字段,使用索引优化更新操作SET @update_query = CONCAT('UPDATE temp_product_data SET category = "', new_cat, '" WHERE category = "', old_cat, '";');PREPARE stmt_update FROM @update_query;EXECUTE stmt_update;DEALLOCATE PREPARE stmt_update;-- 将更新后的数据插入到新的分区(这里假设新分区是按新分类划分的),分批插入数据以减少内存压力SET @insert_query = CONCAT('INSERT INTO products_partitioned_by_new_category SELECT * FROM temp_product_data LIMIT 1000;');PREPARE stmt_insert FROM @insert_query;EXECUTE stmt_insert;DEALLOCATE PREPARE stmt_insert;-- 删除临时表DROP TABLE temp_product_data;END LOOP;CLOSE cur;

END;

三、分区与查询性能优化:相辅相成

3.1 分区对查询执行计划的影响

当我们执行查询操作时,Impala 的查询执行计划会根据分区情况进行优化,就像宇宙飞船的导航系统根据星际环境规划最佳航线一样。合理的分区能让查询跳过不必要的数据块,大大减少数据读取量,就像飞船在航行中绕过无关的星系,直接驶向目标星球。例如,查询特定国家在某个时间段内的用户订单数据。

SELECT * FROM orders

WHERE country = 'USA' AND year = 2024 AND month BETWEEN 1 AND 6;

以下是一个查看查询执行计划的命令示例,通过分析执行计划可以直观地看到分区对查询的影响,并与其他类似大数据存储系统(如 Hive)的分区查询执行计划进行对比分析。在比较不同系统的性能时,要注意环境的一致性,包括硬件配置、数据量和数据分布等因素,这就好比在对比不同型号宇宙飞船的航行性能时,要确保它们在相同的宇宙环境条件下进行测试。我们详细展示如何解读查询执行计划中的关键信息,以帮助你理解分区的作用。

EXPLAIN SELECT * FROM orders

WHERE country = 'USA' AND year = 2024 AND month BETWEEN 1 AND 6;-- 在Hive中执行相同查询的执行计划查看(假设Hive环境已配置)

EXPLAIN SELECT * FROM orders

WHERE country = 'USA' AND year = 2024 AND month BETWEEN 1 AND 6;

对比分析结果可以用表格形式展示,表格中的每一项都清晰地反映了不同存储系统在分区筛选效率、数据读取量和查询执行时间等方面的差异:

| 存储系统 | 分区筛选效率 | 数据读取量 | 查询执行时间(示例) |

|---|---|---|---|

| Impala | 高 | 少 | 3 秒 |

| Hive | 较低 | 较多 | 8 秒 |

如果分区设计合理,Impala 会直接定位到 “USA” 国家分区和 2024 年上半年的时间分区,快速返回结果。这体现了分区对查询性能的直接提升作用,就像精准的星际导航能让飞船迅速抵达目的地一样。我们通过实际案例和对比分析,深入阐述了分区在查询性能优化中的重要性。

3.2 基于分区的查询优化技巧

除了依赖 Impala 的自动优化,我们可以运用一些技巧进一步提高基于分区的查询性能,这就如同在宇宙航行中,除了依靠飞船的自动导航系统,宇航员还需要掌握一些手动操作技巧来应对特殊情况。比如,在编写查询语句时,尽量将分区条件放在最前面,这样可以让查询引擎更快地筛选分区,就像在搜索星系中的星球时,先确定星系范围能更快缩小搜索范围。同时,避免在分区列上使用复杂函数,以免影响分区的筛选效果,这就好比在星际定位时,过于复杂的计算方法可能会干扰对星球位置的准确判断。

以下是一个对比示例,展示将分区条件放在不同位置的查询性能差异。假设我们有一个按日期分区的销售数据表(sales_data),查询 2024 年 1 月的销售数据:

-- 优化的查询,先使用分区条件

SELECT * FROM sales_data WHERE year = 2024 AND month = 1 AND customer_id > 100;-- 未优化的查询,分区条件在后面

SELECT * FROM sales_data WHERE customer_id > 100 AND year = 2024 AND month = 1;

通过多次执行这两个查询并记录执行时间,可以明显看出优化后的查询速度更快。同时,我们可以使用性能分析工具(如 Impala 的内置性能分析工具或第三方工具)来进一步分析查询性能,获取更详细的性能指标,如内存使用、磁盘 I/O 等,并根据这些指标对查询进行更深入的优化,这就像宇航员通过飞船上的各种监测仪器来分析飞行状态,从而对航行参数进行调整一样。我们详细介绍了如何利用性能分析工具来优化查询,为读者提供了实用的方法。

四、案例分析:分区优化的实战成果

4.1 某跨国电商企业的 Impala 分区优化之旅

某跨国电商企业面临着海量数据的存储和查询挑战,其数据涵盖全球多个国家和地区的订单、用户、商品等信息,这些数据就像一个庞大的星际贸易网络中的各个元素。在未进行分区优化之前,查询特定国家或地区的销售数据往往需要扫描大量无关数据,就像在茫茫宇宙中寻找一颗特定星球却要遍历所有星系一样,导致查询时间过长。

| 项目指标 | 优化前 | 优化后 |

|---|---|---|

| 特定国家销售数据查询时间 | 平均 15 分钟 | 平均 2 分钟 |

| 系统资源利用率(高峰时段) | 80% | 60% |

该企业根据业务特点,对订单表、用户表和商品表都采用了多级分区策略,按国家、商品类别和时间分区,这就像为星际贸易网络建立了一套高效的坐标系统。通过合理的分区设计和管理,不仅提高了查询速度,还降低了系统资源的消耗,为企业的数据分析和决策提供了有力支持,就像为宇宙航行找到了一条更快捷、更节能的路线。

以下是该企业在分区优化过程中使用的一个监控脚本示例,用于实时监测查询性能和资源利用率,并对不同分区策略下的性能进行对比分析。在实际应用中,可以根据企业的具体需求和系统架构,调整监控的频率和指标,就像根据不同的宇宙航行任务调整飞船的监测频率一样。我们详细解释了监控脚本的每一个步骤和功能,方便读者理解和应用。

import time

import psutil

import matplotlib.pyplot as plt# 记录开始时间

start_time = time.time()# 执行查询(这里假设是查询特定国家的销售数据)

query_result = query_orders_by_country('USA')# 记录结束时间

end_time = time.time()# 计算查询时间

query_duration = end_time - start_time# 获取当前CPU和内存利用率

cpu_percent = psutil.cpu_percent()

memory_percent = psutil.virtual_memory().percent# 模拟不同分区策略下的查询时间和资源利用率

query_durations = []

cpu_percents = []

memory_percents = []

partition_strategies = ['original', 'optimized']

for strategy in partition_strategies:if strategy == 'original':# 执行原始分区策略下的查询(这里只是模拟,实际需要根据原始策略实现查询)query_result = query_orders_by_country_original('USA')else:query_result = query_orders_by_country('USA')end_time = time.time()query_duration = end_time - start_timequery_durations.append(query_duration)cpu_percent = psutil.cpu_percent()cpu_percents.append(cpu_percent)memory_percent = psutil.virtual_memory().percentmemory_percents.append(memory_percent)# 可视化查询时间和资源利用率对比

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

plt.bar(partition_strategies, query_durations)

plt.title("Query Duration by Partition Strategy")

plt.xlabel("Partition Strategy")

plt.ylabel("Query Duration (seconds)")

plt.subplot(1, 2, 2)

plt.plot(partition_strategies, cpu_percents, label='CPU Utilization')

plt.plot(partition_strategies, memory_percents, label='Memory Utilization')

plt.title("Resource Utilization by Partition Strategy")

plt.xlabel("Partition Strategy")

plt.ylabel("Utilization (%)")

plt.legend()

plt.show()

4.2 某大型互联网企业的分区调整与性能提升

某大型互联网企业拥有大量用户行为数据,这些数据就像宇宙中无数用户在虚拟空间中的行为轨迹。原分区方式在业务模式发生变化后,出现了查询效率下降的问题,就像星际航道因为星系变化而变得拥堵一样。例如,新业务增加了对用户设备类型的分析需求。

| 项目指标 | 优化前 | 优化后 |

|---|---|---|

| 按设备类型和时间查询用户行为数据时间 | 平均 10 分钟 | 平均 1 分钟 |

| 数据存储成本(因分区优化减少冗余) | 高 | 降低 30% |

企业针对新的业务需求,对数据存储分区进行了重新调整,增加了设备类型分区,并对一些旧分区进行了合并和清理,这就像重新规划星际航道,拆除一些废弃的通道,新建一些更便捷的路线。同时,优化了查询语句以适应新的分区结构,从而实现了查询性能的大幅提升和存储成本的降低,就像让宇宙航行更加顺畅且经济。

以下是该企业用于评估分区调整前后数据存储成本的代码示例,同时展示存储结构变化的可视化。在分析存储成本和结构变化时,要考虑到数据的动态增长和业务的长期发展趋势,就像在规划星际发展时要考虑到宇宙的演化一样。我们详细阐述了代码如何与存储结构变化相关联,以及如何解读可视化结果。

import matplotlib.pyplot as plt

import networkx as nx# 获取分区信息和存储大小(这里假设使用某个存储管理工具或系统表来获取)

before_partition_info = get_partition_info('user_behavior_before_optimization')

after_partition_info = get_partition_info('user_behavior_after_optimization')# 计算存储成本(这里简单假设存储成本与存储大小成正比)

before_storage_cost = calculate_storage_cost(before_partition_info)

after_storage_cost = calculate_storage_cost(after_partition_info)# 可视化存储成本变化

plt.bar(['Before Optimization', 'After Optimization'], [before_storage_cost, after_storage_cost])

plt.title("Storage Cost Before and After Partition Optimization")

plt.xlabel("Status")

plt.ylabel("Storage Cost")

plt.show()# 可视化存储结构变化(以图的形式展示分区关系)

G_before = nx.Graph()

G_after = nx.Graph()

for partition in before_partition_info:G_before.add_node(partition['name'])for related_partition in partition['related_partitions']:G_before.add_edge(partition['name'], related_partition)

for partition in after_partition_info:G_after.add_node(partition['name'])for related_partition in partition['related_partitions']:G_after.add_edge(partition['name'], related_partition)

pos_before = nx.spring_layout(G_before)

pos_after = nx.spring_layout(G_after)

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

nx.draw(G_before, pos_before, with_labels=True)

plt.title("Storage Partition Structure Before Optimization")

plt.subplot(1, 2, 2)

nx.draw(G_after, pos_after, with_labels=True)

plt.title("Storage Partition Structure After Optimization")

plt.show()

结束语:

亲爱的开发者,我们在这篇文章中就像在宇宙中探索神秘星球一样,深入探讨了 Impala 数据存储分区的艺术与实践。从分区策略的巧妙选择,到分区如星系般复杂的管理与维护,再到分区对查询性能如同星际航行燃料般关键的优化作用,以及实际案例的全面剖析,每一步都像是在揭示宇宙的奥秘。

你在使用 Impala 或者其他大数据存储系统时,是否也遇到过分区相关的问题呢?是像在宇宙中迷失方向一样,在分区策略的选择上犹豫不决?还是在分区的动态管理中遇到如同遭遇星际风暴般的困难?又或者你已经找到了独特的分区优化经验,就像发现了新的星际航行法则一样?欢迎在评论区或CSDN社区分享你的故事、困惑或者见解,让我们在大数据这片浩瀚宇宙中携手共进,为企业的数据驱动决策照亮前行的道路。

Impala 性能优化的征程就像星际探索一样永无止境。下一篇文章《大数据新视界 – 大数据大厂之提升 Impala 查询效率:索引优化的秘籍大揭秘(上)(3/30)》将为你打开一扇新的宇宙之门,带您深入了解如何通过索引优化进一步提升 Impala 的查询效率。这就像在我们已经构建好的星际航道上安装更先进的导航灯塔,帮助我们更快、更准确地在数据宇宙中航行,挖掘出更多隐藏在数据深处的价值。期待与你继续在这片充满魅力的数据宇宙中分享更多精彩内容,一起向着知识的星辰大海进发!

说明: 文中部分图片来自官网:(https://impala.apache.org/)

- 大数据新视界 – 大数据大厂之 Impala 性能优化:解锁大数据分析的速度密码(上)(1/30)(最新)

- 大数据新视界 – 大数据大厂都在用的数据目录管理秘籍大揭秘,附海量代码和案例(最新)

- 大数据新视界 – 大数据大厂之数据质量管理全景洞察:从荆棘挑战到辉煌策略与前沿曙光(最新)

- 大数据新视界 – 大数据大厂之大数据环境下的网络安全态势感知(最新)

- 大数据新视界 – 大数据大厂之多因素认证在大数据安全中的关键作用(最新)

- 大数据新视界 – 大数据大厂之优化大数据计算框架 Tez 的实践指南(最新)

- 技术星河中的璀璨灯塔 —— 青云交的非凡成长之路(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 4)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 3)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 2)(最新)

- 大数据新视界 – 大数据大厂之大数据重塑影视娱乐产业的未来(4 - 1)(最新)

- 大数据新视界 – 大数据大厂之Cassandra 性能优化策略:大数据存储的高效之路(最新)

- 大数据新视界 – 大数据大厂之大数据在能源行业的智能优化变革与展望(最新)

- 智创 AI 新视界 – 探秘 AIGC 中的生成对抗网络(GAN)应用(最新)

- 大数据新视界 – 大数据大厂之大数据与虚拟现实的深度融合之旅(最新)

- 大数据新视界 – 大数据大厂之大数据与神经形态计算的融合:开启智能新纪元(最新)

- 智创 AI 新视界 – AIGC 背后的深度学习魔法:从原理到实践(最新)

- 大数据新视界 – 大数据大厂之大数据和增强现实(AR)结合:创造沉浸式数据体验(最新)

- 大数据新视界 – 大数据大厂之如何降低大数据存储成本:高效存储架构与技术选型(最新)

- 大数据新视界 --大数据大厂之大数据与区块链双链驱动:构建可信数据生态(最新)

- 大数据新视界 – 大数据大厂之 AI 驱动的大数据分析:智能决策的新引擎(最新)

- 大数据新视界 --大数据大厂之区块链技术:为大数据安全保驾护航(最新)

- 大数据新视界 --大数据大厂之 Snowflake 在大数据云存储和处理中的应用探索(最新)

- 大数据新视界 --大数据大厂之数据脱敏技术在大数据中的应用与挑战(最新)

- 大数据新视界 --大数据大厂之 Ray:分布式机器学习框架的崛起(最新)

- 大数据新视界 --大数据大厂之大数据在智慧城市建设中的应用:打造智能生活的基石(最新)

- 大数据新视界 --大数据大厂之 Dask:分布式大数据计算的黑马(最新)

- 大数据新视界 --大数据大厂之 Apache Beam:统一批流处理的大数据新贵(最新)

- 大数据新视界 --大数据大厂之图数据库与大数据:挖掘复杂关系的新视角(最新)

- 大数据新视界 --大数据大厂之 Serverless 架构下的大数据处理:简化与高效的新路径(最新)

- 大数据新视界 --大数据大厂之大数据与边缘计算的协同:实时分析的新前沿(最新)

- 大数据新视界 --大数据大厂之 Hadoop MapReduce 优化指南:释放数据潜能,引领科技浪潮(最新)

- 诺贝尔物理学奖新视野:机器学习与神经网络的璀璨华章(最新)

- 大数据新视界 --大数据大厂之 Volcano:大数据计算任务调度的新突破(最新)

- 大数据新视界 --大数据大厂之 Kubeflow 在大数据与机器学习融合中的应用探索(最新)

- 大数据新视界 --大数据大厂之大数据环境下的零信任安全架构:构建可靠防护体系(最新)

- 大数据新视界 --大数据大厂之差分隐私技术在大数据隐私保护中的实践(最新)

- 大数据新视界 --大数据大厂之 Dremio:改变大数据查询方式的创新引擎(最新)

- 大数据新视界 --大数据大厂之 ClickHouse:大数据分析领域的璀璨明星(最新)

- 大数据新视界 --大数据大厂之大数据驱动下的物流供应链优化:实时追踪与智能调配(最新)

- 大数据新视界 --大数据大厂之大数据如何重塑金融风险管理:精准预测与防控(最新)

- 大数据新视界 --大数据大厂之 GraphQL 在大数据查询中的创新应用:优化数据获取效率(最新)

- 大数据新视界 --大数据大厂之大数据与量子机器学习融合:突破智能分析极限(最新)

- 大数据新视界 --大数据大厂之 Hudi 数据湖框架性能提升:高效处理大数据变更(最新)

- 大数据新视界 --大数据大厂之 Presto 性能优化秘籍:加速大数据交互式查询(最新)

- 大数据新视界 --大数据大厂之大数据驱动智能客服 – 提升客户体验的核心动力(最新)

- 大数据新视界 --大数据大厂之大数据于基因测序分析的核心应用 - 洞悉生命信息的密钥(最新)

- 大数据新视界 --大数据大厂之 Ibis:独特架构赋能大数据分析高级抽象层(最新)

- 大数据新视界 --大数据大厂之 DataFusion:超越传统的大数据集成与处理创新工具(最新)

- 大数据新视界 --大数据大厂之 从 Druid 和 Kafka 到 Polars:大数据处理工具的传承与创新(最新)

- 大数据新视界 --大数据大厂之 Druid 查询性能提升:加速大数据实时分析的深度探索(最新)

- 大数据新视界 --大数据大厂之 Kafka 性能优化的进阶之道:应对海量数据的高效传输(最新)

- 大数据新视界 --大数据大厂之深度优化 Alluxio 分层架构:提升大数据缓存效率的全方位解析(最新)

- 大数据新视界 --大数据大厂之 Alluxio:解析数据缓存系统的分层架构(最新)

- 大数据新视界 --大数据大厂之 Alluxio 数据缓存系统在大数据中的应用与配置(最新)

- 大数据新视界 --大数据大厂之TeZ 大数据计算框架实战:高效处理大规模数据(最新)

- 大数据新视界 --大数据大厂之数据质量评估指标与方法:提升数据可信度(最新)

- 大数据新视界 --大数据大厂之 Sqoop 在大数据导入导出中的应用与技巧(最新)

- 大数据新视界 --大数据大厂之数据血缘追踪与治理:确保数据可追溯性(最新)

- 大数据新视界 --大数据大厂之Cassandra 分布式数据库在大数据中的应用与调优(最新)

- 大数据新视界 --大数据大厂之基于 MapReduce 的大数据并行计算实践(最新)

- 大数据新视界 --大数据大厂之数据压缩算法比较与应用:节省存储空间(最新)

- 大数据新视界 --大数据大厂之 Druid 实时数据分析平台在大数据中的应用(最新)

- 大数据新视界 --大数据大厂之数据清洗工具 OpenRefine 实战:清理与转换数据(最新)

- 大数据新视界 --大数据大厂之 Spark Streaming 实时数据处理框架:案例与实践(最新)

- 大数据新视界 --大数据大厂之 Kylin 多维分析引擎实战:构建数据立方体(最新)

- 大数据新视界 --大数据大厂之HBase 在大数据存储中的应用与表结构设计(最新)

- 大数据新视界 --大数据大厂之大数据实战指南:Apache Flume 数据采集的配置与优化秘籍(最新)

- 大数据新视界 --大数据大厂之大数据存储技术大比拼:选择最适合你的方案(最新)

- 大数据新视界 --大数据大厂之 Reactjs 在大数据应用开发中的优势与实践(最新)

- 大数据新视界 --大数据大厂之 Vue.js 与大数据可视化:打造惊艳的数据界面(最新)

- 大数据新视界 --大数据大厂之 Node.js 与大数据交互:实现高效数据处理(最新)

- 大数据新视界 --大数据大厂之JavaScript在大数据前端展示中的精彩应用(最新)

- 大数据新视界 --大数据大厂之AI 与大数据的融合:开创智能未来的新篇章(最新)

- 大数据新视界 --大数据大厂之算法在大数据中的核心作用:提升效率与智能决策(最新)

- 大数据新视界 --大数据大厂之DevOps与大数据:加速数据驱动的业务发展(最新)

- 大数据新视界 --大数据大厂之SaaS模式下的大数据应用:创新与变革(最新)

- 大数据新视界 --大数据大厂之Kubernetes与大数据:容器化部署的最佳实践(最新)

- 大数据新视界 --大数据大厂之探索ES:大数据时代的高效搜索引擎实战攻略(最新)

- 大数据新视界 --大数据大厂之Redis在缓存与分布式系统中的神奇应用(最新)

- 大数据新视界 --大数据大厂之数据驱动决策:如何利用大数据提升企业竞争力(最新)

- 大数据新视界 --大数据大厂之MongoDB与大数据:灵活文档数据库的应用场景(最新)

- 大数据新视界 --大数据大厂之数据科学项目实战:从问题定义到结果呈现的完整流程(最新)

- 大数据新视界 --大数据大厂之 Cassandra 分布式数据库:高可用数据存储的新选择(最新)

- 大数据新视界 --大数据大厂之数据安全策略:保护大数据资产的最佳实践(最新)

- 大数据新视界 --大数据大厂之Kafka消息队列实战:实现高吞吐量数据传输(最新)

- 大数据新视界 --大数据大厂之数据挖掘入门:用 R 语言开启数据宝藏的探索之旅(最新)

- 大数据新视界 --大数据大厂之HBase深度探寻:大规模数据存储与查询的卓越方案(最新)

- IBM 中国研发部裁员风暴,IT 行业何去何从?(最新)

- 大数据新视界 --大数据大厂之数据治理之道:构建高效大数据治理体系的关键步骤(最新)

- 大数据新视界 --大数据大厂之Flink强势崛起:大数据新视界的璀璨明珠(最新)

- 大数据新视界 --大数据大厂之数据可视化之美:用 Python 打造炫酷大数据可视化报表(最新)

- 大数据新视界 --大数据大厂之 Spark 性能优化秘籍:从配置到代码实践(最新)

- 大数据新视界 --大数据大厂之揭秘大数据时代 Excel 魔法:大厂数据分析师进阶秘籍(最新)

- 大数据新视界 --大数据大厂之Hive与大数据融合:构建强大数据仓库实战指南(最新)

- 大数据新视界–大数据大厂之Java 与大数据携手:打造高效实时日志分析系统的奥秘(最新)

- 大数据新视界–面向数据分析师的大数据大厂之MySQL基础秘籍:轻松创建数据库与表,踏入大数据殿堂(最新)

- 全栈性能优化秘籍–Linux 系统性能调优全攻略:多维度优化技巧大揭秘(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:揭秘 MySQL 集群架构负载均衡核心算法:从理论到 Java 代码实战,让你的数据库性能飙升!(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL集群架构负载均衡故障排除与解决方案(最新)

- 解锁编程高效密码:四大工具助你一飞冲天!(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL数据库高可用性架构探索(2-1)(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL集群架构负载均衡方法选择全攻略(2-2)(最新)

- 大数据新视界–大数据大厂之MySQL数据库课程设计:MySQL 数据库 SQL 语句调优方法详解(2-1)(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:MySQL 数据库 SQL 语句调优的进阶策略与实际案例(2-2)(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:数据安全深度剖析与未来展望(最新)

- 大数据新视界–大数据大厂之MySQL 数据库课程设计:开启数据宇宙的传奇之旅(最新)

- 大数据新视界–大数据大厂之大数据时代的璀璨导航星:Eureka 原理与实践深度探秘(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之Java 性能优化逆袭:常见错误不再是阻碍(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之Java 性能优化传奇:热门技术点亮高效之路(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之电商平台高峰时段性能优化:多维度策略打造卓越体验(最新)

- Java性能优化传奇之旅–Java万亿级性能优化之电商平台高峰时段性能大作战:策略与趋势洞察(最新)

- JVM万亿性能密码–JVM性能优化之JVM 内存魔法:开启万亿级应用性能新纪元(最新)

- 十万流量耀前路,成长感悟谱新章(最新)

- AI 模型:全能与专精之辩 —— 一场科技界的 “超级大比拼”(最新)

- 国产游戏技术:挑战与机遇(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(10)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(9)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(8)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(7)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(6)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(5)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(4)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(3)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(2)(最新)

- Java面试题–JVM大厂篇之JVM大厂面试题及答案解析(1)(最新)

- Java 面试题 ——JVM 大厂篇之 Java 工程师必备:顶尖工具助你全面监控和分析 CMS GC 性能(2)(最新)

- Java面试题–JVM大厂篇之Java工程师必备:顶尖工具助你全面监控和分析CMS GC性能(1)(最新)

- Java面试题–JVM大厂篇之未来已来:为什么ZGC是大规模Java应用的终极武器?(最新)

- AI 音乐风暴:创造与颠覆的交响(最新)

- 编程风暴:勇破挫折,铸就传奇(最新)

- Java面试题–JVM大厂篇之低停顿、高性能:深入解析ZGC的优势(最新)

- Java面试题–JVM大厂篇之解密ZGC:让你的Java应用高效飞驰(最新)

- Java面试题–JVM大厂篇之掌控Java未来:深入剖析ZGC的低停顿垃圾回收机制(最新)

- GPT-5 惊涛来袭:铸就智能新传奇(最新)

- AI 时代风暴:程序员的核心竞争力大揭秘(最新)

- Java面试题–JVM大厂篇之Java新神器ZGC:颠覆你的垃圾回收认知!(最新)

- Java面试题–JVM大厂篇之揭秘:如何通过优化 CMS GC 提升各行业服务器响应速度(最新)

- “低代码” 风暴:重塑软件开发新未来(最新)

- 程序员如何平衡日常编码工作与提升式学习?–编程之路:平衡与成长的艺术(最新)

- 编程学习笔记秘籍:开启高效学习之旅(最新)

- Java面试题–JVM大厂篇之高并发Java应用的秘密武器:深入剖析GC优化实战案例(最新)

- Java面试题–JVM大厂篇之实战解析:如何通过CMS GC优化大规模Java应用的响应时间(最新)

- Java面试题–JVM大厂篇(1-10)

- Java面试题–JVM大厂篇之Java虚拟机(JVM)面试题:涨知识,拿大厂Offer(11-20)

- Java面试题–JVM大厂篇之JVM面试指南:掌握这10个问题,大厂Offer轻松拿

- Java面试题–JVM大厂篇之Java程序员必学:JVM架构完全解读

- Java面试题–JVM大厂篇之以JVM新特性看Java的进化之路:从Loom到Amber的技术篇章

- Java面试题–JVM大厂篇之深入探索JVM:大厂面试官心中的那些秘密题库

- Java面试题–JVM大厂篇之高级Java开发者的自我修养:深入剖析JVM垃圾回收机制及面试要点

- Java面试题–JVM大厂篇之从新手到专家:深入探索JVM垃圾回收–开端篇

- Java面试题–JVM大厂篇之Java性能优化:垃圾回收算法的神秘面纱揭开!

- Java面试题–JVM大厂篇之揭秘Java世界的清洁工——JVM垃圾回收机制

- Java面试题–JVM大厂篇之掌握JVM性能优化:选择合适的垃圾回收器

- Java面试题–JVM大厂篇之深入了解Java虚拟机(JVM):工作机制与优化策略

- Java面试题–JVM大厂篇之深入解析JVM运行时数据区:Java开发者必读

- Java面试题–JVM大厂篇之从零开始掌握JVM:解锁Java程序的强大潜力

- Java面试题–JVM大厂篇之深入了解G1 GC:大型Java应用的性能优化利器

- Java面试题–JVM大厂篇之深入了解G1 GC:高并发、响应时间敏感应用的最佳选择

- Java面试题–JVM大厂篇之G1 GC的分区管理方式如何减少应用线程的影响

- Java面试题–JVM大厂篇之深入解析G1 GC——革新Java垃圾回收机制

- Java面试题–JVM大厂篇之深入探讨Serial GC的应用场景

- Java面试题–JVM大厂篇之Serial GC在JVM中有哪些优点和局限性

- Java面试题–JVM大厂篇之深入解析JVM中的Serial GC:工作原理与代际区别

- Java面试题–JVM大厂篇之通过参数配置来优化Serial GC的性能

- Java面试题–JVM大厂篇之深入分析Parallel GC:从原理到优化

- Java面试题–JVM大厂篇之破解Java性能瓶颈!深入理解Parallel GC并优化你的应用

- Java面试题–JVM大厂篇之全面掌握Parallel GC参数配置:实战指南

- Java面试题–JVM大厂篇之Parallel GC与其他垃圾回收器的对比与选择

- Java面试题–JVM大厂篇之Java中Parallel GC的调优技巧与最佳实践

- Java面试题–JVM大厂篇之JVM监控与GC日志分析:优化Parallel GC性能的重要工具

- Java面试题–JVM大厂篇之针对频繁的Minor GC问题,有哪些优化对象创建与使用的技巧可以分享?

- Java面试题–JVM大厂篇之JVM 内存管理深度探秘:原理与实战

- Java面试题–JVM大厂篇之破解 JVM 性能瓶颈:实战优化策略大全

- Java面试题–JVM大厂篇之JVM 垃圾回收器大比拼:谁是最佳选择

- Java面试题–JVM大厂篇之从原理到实践:JVM 字节码优化秘籍

- Java面试题–JVM大厂篇之揭开CMS GC的神秘面纱:从原理到应用,一文带你全面掌握

- Java面试题–JVM大厂篇之JVM 调优实战:让你的应用飞起来

- Java面试题–JVM大厂篇之CMS GC调优宝典:从默认配置到高级技巧,Java性能提升的终极指南

- Java面试题–JVM大厂篇之CMS GC的前世今生:为什么它曾是Java的王者,又为何将被G1取代

- Java就业-学习路线–突破性能瓶颈: Java 22 的性能提升之旅

- Java就业-学习路线–透视Java发展:从 Java 19 至 Java 22 的飞跃

- Java就业-学习路线–Java技术:2024年开发者必须了解的10个要点

- Java就业-学习路线–Java技术栈前瞻:未来技术趋势与创新

- Java就业-学习路线–Java技术栈模块化的七大优势,你了解多少?

- Spring框架-Java学习路线课程第一课:Spring核心

- Spring框架-Java学习路线课程:Spring的扩展配置

- Springboot框架-Java学习路线课程:Springboot框架的搭建之maven的配置

- Java进阶-Java学习路线课程第一课:Java集合框架-ArrayList和LinkedList的使用

- Java进阶-Java学习路线课程第二课:Java集合框架-HashSet的使用及去重原理

- JavaWEB-Java学习路线课程:使用MyEclipse工具新建第一个JavaWeb项目(一)

- JavaWEB-Java学习路线课程:使用MyEclipse工具新建项目时配置Tomcat服务器的方式(二)

- Java学习:在给学生演示用Myeclipse10.7.1工具生成War时,意外报错:SECURITY: INTEGRITY CHECK ERROR

- 使用Jquery发送Ajax请求的几种异步刷新方式

- Idea Springboot启动时内嵌tomcat报错- An incompatible version [1.1.33] of the APR based Apache Tomcat Native

- Java入门-Java学习路线课程第一课:初识JAVA

- Java入门-Java学习路线课程第二课:变量与数据类型

- Java入门-Java学习路线课程第三课:选择结构

- Java入门-Java学习路线课程第四课:循环结构

- Java入门-Java学习路线课程第五课:一维数组

- Java入门-Java学习路线课程第六课:二维数组

- Java入门-Java学习路线课程第七课:类和对象

- Java入门-Java学习路线课程第八课:方法和方法重载

- Java入门-Java学习路线扩展课程:equals的使用

- Java入门-Java学习路线课程面试篇:取商 / 和取余(模) % 符号的使用

相关文章:

大数据新视界 -- 大数据大厂之 Impala 性能优化:数据存储分区的艺术与实践(下)(2/30)

💖💖💖亲爱的朋友们,热烈欢迎你们来到 青云交的博客!能与你们在此邂逅,我满心欢喜,深感无比荣幸。在这个瞬息万变的时代,我们每个人都在苦苦追寻一处能让心灵安然栖息的港湾。而 我的…...

【数据结构】B树

B树(B-Tree)是一种自平衡的多叉搜索树,广泛应用于数据库系统和文件系统中,以便高效地进行数据存储和检索。它的设计目标是减少磁盘I/O操作,使得在大量数据的情况下依然能够进行快速的查找、插入和删除操作。 B树的特点…...

Docker 容器网络模式详解

Docker 容器网络模式详解 1.1 引言 1.1.1 Docker 网络简介 Docker 是一个开源的应用容器引擎,它允许开发者将应用和依赖打包到一个可移植的容器中,然后发布到任何流行的 Linux 机器上,也可以实现虚拟化。容器采用沙箱机制,彼此…...

吴恩达深度学习笔记:卷积神经网络(Foundations of Convolutional Neural Networks)4.11

目录 第四门课 卷积神经网络(Convolutional Neural Networks)第四周 特殊应用:人脸识别和神经风格转换(Special applications: Face recognition &Neural style transfer)4.11 一维到三维推广(1D and 3…...

小游戏开发,出现了降本增效的技术?

中国经济下行大周期下,要说受影响程度较小的,非游戏行业莫属了。 小游戏的快速增长主要得益于其便捷的使用方式和轻量化的特点。小游戏通常无需下载,即点即玩,适合在碎片时间内进行娱乐,这种特性吸引了大量用户。此外…...

Java 编程基础概览:Java中的输入输出操作与代码注释详解)

(4)Java 编程基础概览:Java中的输入输出操作与代码注释详解

目录 1. 控制台输出操作2. 控制台输入操作代码解释:3. 代码注释3.1 单行注释3.2 多行注释3.3 文档注释3.4 注释的重要性3.5 注意事项在Java编程语言中,输入与输出(I/O)操作扮演着举足轻重的角色。它们允许程序与外界环境进行数据的交互,无论是从用户处获取信息,还是向用户…...

Git使用指南

目录 工作机制基本框架:流程图 基本命令分支操作远程仓库本地仓库关联远程仓库 参考 工作机制 基本框架: Workspace:开发者工作区,也就是你当前写代码的目录,它一般保持的是最新仓库代码。Index / Stage:暂存区,最早…...

【linux】再谈网络基础(一)

1. 再谈 "协议" 协议是一种 "约定",在读写数据时, 都是按 "字符串" 的方式来发送接收的. 但是这里我们会遇到一些问题: 如何确保从网上读取的数据是否是完整的,区分缓冲区中的由不同客户端发来的数据 2. 网…...

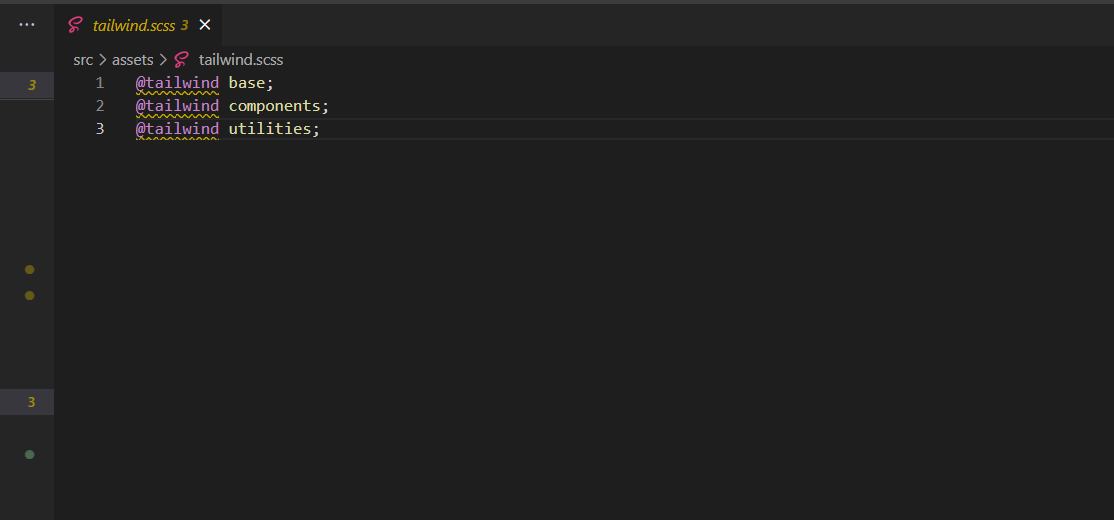

Unknown at rule @tailwindscss(unknownAtRules)

一、前言 整合 tailwindcss 后,发现指令提示警告 Unknown at rule tailwindscss(unknownAtRules),其实是 vscode 无法识别 tailwindscss 指令,不影响使用,但是对于我这种有编程洁癖的人来说,有点膈应。 二、解决方案…...

IDEA - 快速去除 mapper.xml 黄色警告线和背景色----简化版

1.打开设置 2.去掉黄色警告线设置 3.去掉背景色设置 4.示范图...

高级 SQL 技巧详解

文章目录 高级 SQL 技巧详解一、引言二、窗口函数1、窗口函数的使用1.1、RANK() 函数示例1.2、常用窗口函数 三、公共表表达式(CTE)2、CTE 的使用2.1、CTE 示例 四、索引优化3、索引的创建与优化3.1、创建索引3.2、索引类型与注意事项 五、事务管理4、事…...

)

移除元素(java)

给你一个数组 nums 和一个值 val,你需要 原地 移除所有数值等于 val 的元素。元素的顺序可能发生改变。然后返回 nums 中与 val 不同的元素的数量。 假设 nums 中不等于 val 的元素数量为 k,要通过此题,您需要执行以下操作: 更改…...

【Linux】shell脚本:检测文件是否存在,如存在则删除

通常,可以使用[ -f <file> ]来检查文件是否存在,使用rm <file>来删除文件。 以下是一个示例脚本,用于检测一个文件是否存在,并在存在时删除它: #!/bin/bash # 定义要检查的文件路径 file_path"/…...

Git代码托管(三)可视化工具操作(1)

常见的可视化操作工具有 一、官方网页 如码云、gitlab,自带了常见的git操作。 以码云为例: 1、创建分支: 进入分支目录,点击 新建分支 按钮, 在弹出框中输入新分支名称,点击确定即可一键创建分支&…...

How to use ffmpeg to convert video format from .webm to .mp4

The .mp4 container format doesn’t support the VP8 codec, which is commonly used in .webm files. MP4 containers typically use the H.264 codec for video and AAC for audio. You’ll need to re-encode the video using the H.264 codec and re-encode the audio us…...

Halcon 从XML中读取配置参数

1、XML示例 以下是一个XML配置文件的示例,该文件包含了AOI(自动光学检测)算法的环境参数和相机逻辑参数: <AOI><!--AOI算法参数 20241106--><Env><!--环境参数--><Param name="GPUName" value="NVIDIA GeForce RTX 405…...

hive表内外表之间切换

你想把内表和外表在元数据上达到切换的目的,这个操作有个前提,在apache版本源码上来讲是支持的!!!!但是!!!!注意哦!默认情况下apache版本的源码中…...

电子邮件营销软件哪个好?

在数字化时代,电子邮件营销仍然是企业与客户沟通的核心策略之一。无论是推广新产品、发送新闻简报,还是进行客户关系管理,选择合适的电子邮件营销软件至关重要。面对市场上众多的选择,企业如何才能找到最适合自己的工具呢…...

OpenAI大事记;GPT到ChatGPT参数量进化

目录 OpenAI大事记 GPT到ChatGPT参数量进化 OpenAI大事记 GPT到ChatGPT参数量进化 ChatGPT是从初代 GPT逐渐演变而来的。在进化的过程中,GPT系列模型的参数数量呈指数级增长,从初代GPT的1.17亿个参数,到GPT-2的15 亿个参数,再到 GPT-3的1750 亿个参数。模型越来越大,训练…...

springboot020基于Java的免税商品优选购物商城设计与实现

🍅点赞收藏关注 → 文档最下方联系方式领取本源代码、数据库🍅 本人在Java毕业设计领域有多年的经验,陆续会更新更多优质的Java实战项目希望你能有所收获,少走一些弯路。🍅关注我不迷路🍅 一 、设计说明 1…...

KubeSphere 容器平台高可用:环境搭建与可视化操作指南

Linux_k8s篇 欢迎来到Linux的世界,看笔记好好学多敲多打,每个人都是大神! 题目:KubeSphere 容器平台高可用:环境搭建与可视化操作指南 版本号: 1.0,0 作者: 老王要学习 日期: 2025.06.05 适用环境: Ubuntu22 文档说…...

[2025CVPR]DeepVideo-R1:基于难度感知回归GRPO的视频强化微调框架详解

突破视频大语言模型推理瓶颈,在多个视频基准上实现SOTA性能 一、核心问题与创新亮点 1.1 GRPO在视频任务中的两大挑战 安全措施依赖问题 GRPO使用min和clip函数限制策略更新幅度,导致: 梯度抑制:当新旧策略差异过大时梯度消失收敛困难:策略无法充分优化# 传统GRPO的梯…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

大型活动交通拥堵治理的视觉算法应用

大型活动下智慧交通的视觉分析应用 一、背景与挑战 大型活动(如演唱会、马拉松赛事、高考中考等)期间,城市交通面临瞬时人流车流激增、传统摄像头模糊、交通拥堵识别滞后等问题。以演唱会为例,暖城商圈曾因观众集中离场导致周边…...

UDP(Echoserver)

网络命令 Ping 命令 检测网络是否连通 使用方法: ping -c 次数 网址ping -c 3 www.baidu.comnetstat 命令 netstat 是一个用来查看网络状态的重要工具. 语法:netstat [选项] 功能:查看网络状态 常用选项: n 拒绝显示别名&#…...

CentOS下的分布式内存计算Spark环境部署

一、Spark 核心架构与应用场景 1.1 分布式计算引擎的核心优势 Spark 是基于内存的分布式计算框架,相比 MapReduce 具有以下核心优势: 内存计算:数据可常驻内存,迭代计算性能提升 10-100 倍(文档段落:3-79…...

ETLCloud可能遇到的问题有哪些?常见坑位解析

数据集成平台ETLCloud,主要用于支持数据的抽取(Extract)、转换(Transform)和加载(Load)过程。提供了一个简洁直观的界面,以便用户可以在不同的数据源之间轻松地进行数据迁移和转换。…...

用docker来安装部署freeswitch记录

今天刚才测试一个callcenter的项目,所以尝试安装freeswitch 1、使用轩辕镜像 - 中国开发者首选的专业 Docker 镜像加速服务平台 编辑下面/etc/docker/daemon.json文件为 {"registry-mirrors": ["https://docker.xuanyuan.me"] }同时可以进入轩…...

多模态大语言模型arxiv论文略读(108)

CROME: Cross-Modal Adapters for Efficient Multimodal LLM ➡️ 论文标题:CROME: Cross-Modal Adapters for Efficient Multimodal LLM ➡️ 论文作者:Sayna Ebrahimi, Sercan O. Arik, Tejas Nama, Tomas Pfister ➡️ 研究机构: Google Cloud AI Re…...

AGain DB和倍数增益的关系

我在设置一款索尼CMOS芯片时,Again增益0db变化为6DB,画面的变化只有2倍DN的增益,比如10变为20。 这与dB和线性增益的关系以及传感器处理流程有关。以下是具体原因分析: 1. dB与线性增益的换算关系 6dB对应的理论线性增益应为&…...