自然语言处理——Hugging Face 详解

Hugging Face 是一个以自然语言处理(NLP)为核心的人工智能平台和开源社区,提供了一系列非常流行的机器学习工具和预训练模型,尤其在文本生成、分类、翻译、情感分析等任务中表现出色。Hugging Face 旗下最为著名的项目是 Transformers 库,它为 NLP 任务提供了大量的预训练模型,并且支持多种主流深度学习框架,如 PyTorch 和 TensorFlow。

一、Hugging Face 的背景和目标

Hugging Face 旨在降低机器学习和自然语言处理的入门门槛,并使机器学习模型的训练、应用和共享更加简单、透明。其最著名的工具和平台包括:

- Transformers:提供了多种预训练的 NLP 模型,可以快速地将其应用于各种 NLP 任务,如文本生成、文本分类、情感分析、机器翻译等。

- Datasets:提供了大量公开的 NLP 数据集,可以方便地进行数据预处理和加载。

- Tokenizers:为文本处理提供了高效的分词工具,支持多种分词算法。

- Hugging Face Hub:这是一个模型存储库,用户可以上传、下载、分享模型。

Hugging Face 通过开源技术和社区支持,极大地促进了 NLP 领域的发展,尤其是在预训练模型的应用上,它推动了从机器学习到深度学习的转变。

二、Hugging Face 的核心技术——Transformers

1. Transformers 模型

Transformers 是由 Vaswani 等人在 2017 年提出的一种神经网络架构,特别适用于序列到序列(sequence-to-sequence)任务。其核心创新在于自注意力(self-attention)机制,它可以捕捉输入数据中的长程依赖关系,而不需要像传统的递归神经网络(RNN)和长短时记忆网络(LSTM)那样逐步处理输入。

Transformers 模型的主要结构包括以下几个部分:

- 自注意力机制(Self-Attention):通过计算每个单词与其他单词之间的注意力权重来建模输入序列中的依赖关系。

- 位置编码(Positional Encoding):由于 Transformer 不使用递归结构,它需要显式地引入位置编码,以便模型能够理解输入的顺序信息。

- 编码器(Encoder)和解码器(Decoder):标准的 Transformer 架构包含两个主要部分:编码器和解码器。编码器将输入序列转换为隐状态,解码器根据隐状态生成输出序列。

- 多头注意力(Multi-head Attention):为了使模型能够捕捉到不同的上下文信息,Transformer 引入了多头注意力机制。

2. 模型的微调

Hugging Face 提供的 Transformer 模型都是 预训练模型,这些模型经过大规模的文本数据训练,具有很强的迁移能力。预训练模型可以通过少量的样本进行 微调(fine-tuning),从而适应特定任务,如情感分析、命名实体识别(NER)等。

通过 Hugging Face,用户可以快速地加载预训练模型,并将其应用到自己的任务上。下面是一个基本的微调流程:

- 加载预训练模型:通过

transformers库加载预训练模型(例如 BERT、GPT、T5 等)。 - 准备数据:准备特定任务的数据集,并进行必要的预处理(例如分词)。

- 微调:通过迁移学习和梯度下降等方法,利用特定任务的数据对预训练模型进行微调。

- 评估和应用:微调后的模型可以进行评估,并用于实际的预测任务。

三、Hugging Face 源代码实现

1. 安装 transformers 库

要使用 Hugging Face 的工具,我们首先需要安装 transformers 和 datasets 库:

pip install transformers datasets2. 加载和使用预训练模型

在 Hugging Face 中加载一个预训练模型非常简单。例如,加载 BERT 模型并进行文本分类的代码如下:

from transformers import pipeline# 加载预训练的文本分类模型

classifier = pipeline("sentiment-analysis")# 进行预测

result = classifier("I love using Hugging Face!")

print(result)

在上面的代码中,pipeline 是一个高层接口,可以用来快速加载和应用各种 NLP 模型。通过 "sentiment-analysis" 任务,我们加载了一个用于情感分析的预训练模型,并使用它对输入的文本进行预测。

3. 微调模型

假设我们想对一个文本分类任务进行微调。下面是一个完整的流程,使用 transformers 和 datasets 库进行文本分类任务的微调。

from transformers import Trainer, TrainingArguments, BertForSequenceClassification, BertTokenizer

from datasets import load_dataset# 加载数据集

dataset = load_dataset("imdb")# 加载BERT tokenizer和模型

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

model = BertForSequenceClassification.from_pretrained("bert-base-uncased")# 数据预处理函数

def preprocess_function(examples):return tokenizer(examples["text"], truncation=True, padding="max_length")# 对数据集进行预处理

encoded_datasets = dataset.map(preprocess_function, batched=True)# 分割训练和验证数据集

train_dataset = encoded_datasets["train"]

eval_dataset = encoded_datasets["test"]# 设置训练参数

training_args = TrainingArguments(output_dir="./results",evaluation_strategy="epoch",learning_rate=2e-5,per_device_train_batch_size=16,per_device_eval_batch_size=64,num_train_epochs=3,weight_decay=0.01,

)# 使用Trainer API进行微调

trainer = Trainer(model=model,args=training_args,train_dataset=train_dataset,eval_dataset=eval_dataset,

)# 开始训练

trainer.train()# 保存模型

trainer.save_model("./finetuned_bert")

代码解释:

- 加载数据集:我们从 Hugging Face Datasets Hub 加载了

IMDB数据集,并对其进行预处理。 - 加载模型:我们加载了 BERT 模型(

bert-base-uncased),并使用其进行文本分类。 - 数据预处理:使用 BERT 的 tokenizer 对数据集进行分词,并将文本转换为模型可以理解的输入格式。

- 训练设置:使用

TrainingArguments来设置训练参数,如学习率、批量大小和训练周期数。 - Trainer:

Trainer是 Hugging Face 提供的一个高层接口,它封装了训练和评估的流程,简化了模型的训练过程。

4. 模型的保存与加载

训练完成后,我们可以保存微调后的模型,并在未来的应用中重新加载使用:

from transformers import pipeline# 加载预训练的文本分类模型

classifier = pipeline("sentiment-analysis")# 进行预测

result = classifier("I love using Hugging Face!")

print(result)

四、Hugging Face 的其他功能

除了预训练模型和微调工具外,Hugging Face 还提供了许多强大的功能:

-

Hugging Face Hub:用户可以上传自己的模型到 Hugging Face Hub,并与社区共享。模型上传后可以通过简单的 API 调用进行加载。

-

Datasets 库:Hugging Face 还提供了

datasets库,它支持从多种格式的数据集进行加载(CSV、JSON、Parquet 等),并且具备数据预处理和转换的功能。 -

Tokenizers:Hugging Face 提供了高效的 Tokenizer 库,专门用于文本数据的处理,包括分词、编码和解码等。

-

Accelerate:这是一个旨在简化多GPU和分布式训练的工具,用户可以通过几行代码快速使用多GPU进行训练。

-

Spaces:Hugging Face 还提供了一个名为 Spaces 的平台,允许用户构建和分享机器学习应用程序,并能方便地在 Web 界面上进行交互。

五、总结

Hugging Face 通过提供易用的 API、预训练模型和社区支持,极大地降低了 NLP 和深度学习的使用门槛。它的 Transformers 库让研究人员和开发者能够快速上手并在各种任务上获得很好的效果。通过微调、模型共享和高效的训练工具,Hugging Face 为 NLU(自然语言理解)任务和 NLP 研究提供了强大的支持,帮助推动了该领域的进步。

相关文章:

自然语言处理——Hugging Face 详解

Hugging Face 是一个以自然语言处理(NLP)为核心的人工智能平台和开源社区,提供了一系列非常流行的机器学习工具和预训练模型,尤其在文本生成、分类、翻译、情感分析等任务中表现出色。Hugging Face 旗下最为著名的项目是 Transfor…...

本地保存mysql凭据实现免密登录mysql

本地保存mysql凭据 mysql加密登录文件简介加密保存mysql用户的密码到本地凭据 mysql加密登录文件简介 要在 mysql客户端 上连接 MySQL 而无需在命令提示符上输入用户名和口令,下列三个位置可用于存储用户的mysql 凭证来满足此要求。 配置文件my.cnf或my.ini /etc…...

Ubuntu 22 安装 Apache Doris 3.0.3 笔记

Ubuntu 22 安装 Apache Doris 3.0.3 笔记 1. 环境准备 Doris 需要 Java 17 作为运行环境,所以首先需要安装 Java 17。 sudo apt-get install openjdk-17-jdk -y sudo update-alternatives --config java在安装 Java 17 后,可以通过 sudo update-alter…...

构建智能防线 灵途科技光电感知助力轨交全向安全防护

10月27日,在南京南站至紫金山东站间的高铁联络线上,一头野猪侵入轨道,与D5515次列车相撞,导致设备故障停车。 事故不仅造成南京南站部分列车晚点,还在故障排查过程中导致随车机械师因被邻线限速通过的列车碰撞而不幸身…...

【go从零单排】泛型(Generics)、链表

🌈Don’t worry , just coding! 内耗与overthinking只会削弱你的精力,虚度你的光阴,每天迈出一小步,回头时发现已经走了很远。 📗概念 在Go语言中,泛型(Generics)允许你编写可以处理…...

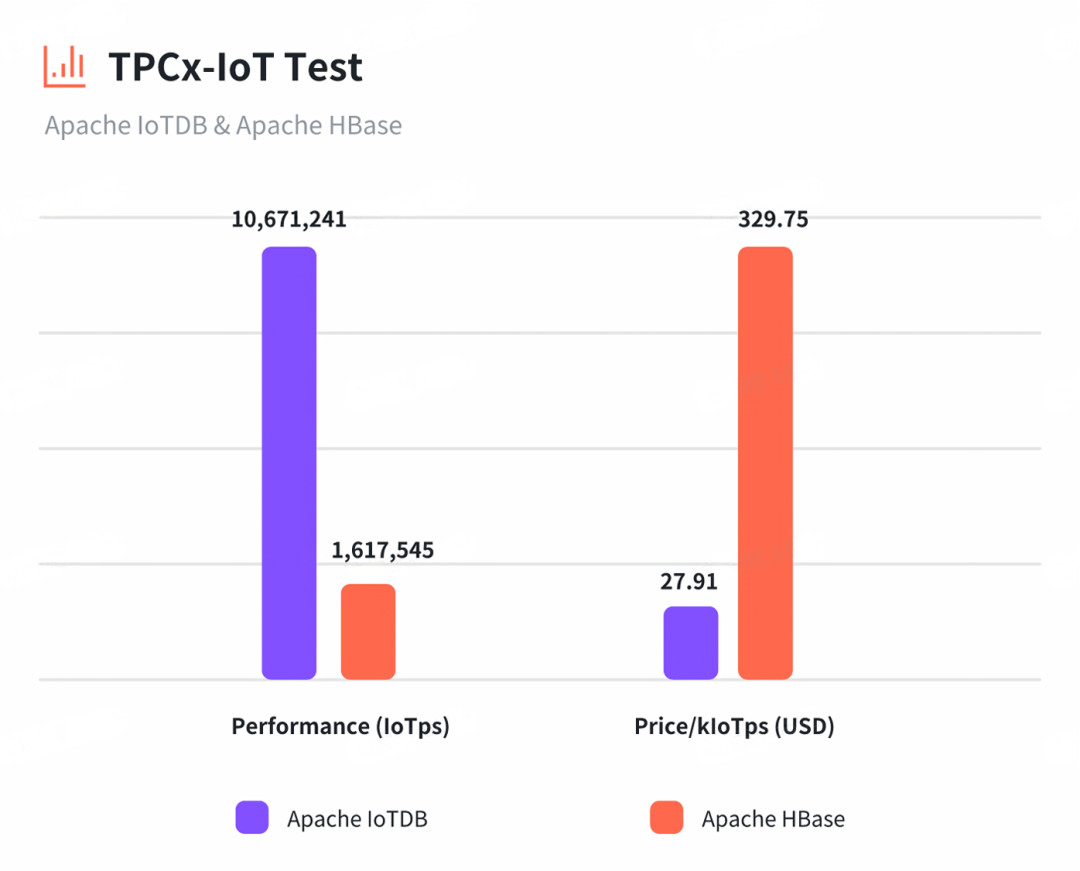

IoTDB 与 HBase 对比详解:架构、功能与性能

五大方向,洞悉 IoTDB 与 HBase 的详尽对比! 在物联网(IoT)领域,数据的采集、存储和分析是确保系统高效运行和决策准确的重要环节。随着物联网设备数量的增加和数据量的爆炸式增长,开发者和决策者们需要选择…...

推荐一款ETCD桌面客户端——Etcd Workbench

Etcd Workbench 我相信很多人在开始管理ETCD的时候都去搜了Etcd客户端工具,然后找到了官方的Etcd Manager,但用完之后发现它并不好用,还不支持多连接和代码格式化,并且已经好几年不更新了,于是市面上就有了好多其他客…...

01 Oracle 数据库存储结构深度解析:从数据文件到性能优化的全链路探究

文章目录 Oracle 数据库存储结构深度解析:从数据文件到性能优化的全链路探究一、Oracle存储结构的物理层次1.1 控制文件(Control File)1.2 联机重做日志文件(Online Redo Log File)1.3 数据文件(Data File&…...

AI教育革命:个性化学习的新篇章

内容概要 在 教育 领域,人工智能 的崭露头角带来了前所未有的变化。如今,个性化学习 已不再是一个遥不可及的梦想,而是通过 AI 技术真正实现的可能。借助先进的数据分析能力,教师可以实时跟踪和评估每位学生的学习进度࿰…...

【网络原理】万字详解 UDP 和 TCP

🥰🥰🥰来都来了,不妨点个关注叭! 👉博客主页:欢迎各位大佬!👈 文章目录 1. UDP1.1 UDP 报文格式1.1.1 源端口/目的端口1.1.2 报文长度1.1.3 校验和 2. TCP2.1 TCP 报文结构2.2 TCP 特…...

从零开始搭建Halo个人博客

前言 老话说得好,好记性不如烂笔头。对于程序员来说,学无止境,需要学习的东西很多,而如果不记录下来可能过不了多久就忘记了,而记录下来这一步也能很好地贯彻费曼学习法。 其实网上有很多博客平台,但是自…...

AMD显卡低负载看视频掉驱动(chrome edge浏览器) 高负载玩游戏却稳定 解决方法——关闭MPO

2024.11.9更新 开关mpo ulps 感觉有用但是还是掉驱动,现在确定是window顶驱动问题 按网上的改注册表和组策略会让自己也打不上驱动 目前感觉最好的办法就是,重置此电脑,然后你就摆着电脑挂个十分钟半小时别动,一开始他是不显示…...

数据结构——二叉树(续集)

♥♥♥~~~~~~欢迎光临知星小度博客空间~~~~~~♥♥♥ ♥♥♥零星地变得优秀~也能拼凑出星河~♥♥♥ ♥♥♥我们一起努力成为更好的自己~♥♥♥ ♥♥♥如果这一篇博客对你有帮助~别忘了点赞分享哦~♥♥♥ ♥♥♥如果有什么问题可以评论区留言或者私信我哦~♥♥♥ ✨✨✨✨✨✨个人…...

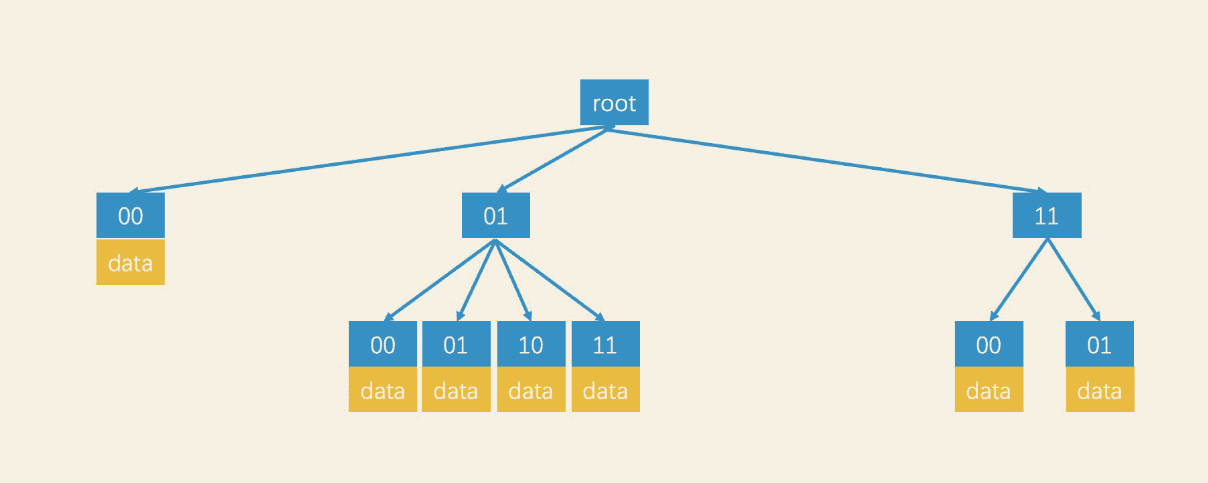

ElasticSearch学习篇16_《检索技术核心20讲》进阶篇之空间检索

背景 学习极客实践课程《检索技术核心20讲》https://time.geekbang.org/column/article/215243,文档形式记录笔记。 相关问题: 查询范围固定的需求 直接计算两点之间距离区域二进制编码GeoHash编码 查询范围不固定的需求 GeoHash编码索引结构设计 基于…...

uni-app跨域set-cookie

set-cookie的值是作为一个权限控制的 首先,无论什么接口都会返回一个set-cookie,但未登录时,set-cookie是没有任何权限的 其次,登录接口请求时会修改set-cookie,并且在后续其他接口发起请求时,会在请求头…...

移动应用开发:简易登录页

文章目录 简介一,创建新活动二,设计UI布局三,编写活动代码四,运行应用程序注意 简介 使用Android Studio编写的简单Android 登录应用程序,该应用程序包含一个登录界面,具有账号和密码两个文本框࿰…...

C++_ C++11的override和final

文章目录 1. override 关键字2. final 关键字在虚函数上使用 final在类上使用 final 1. override 关键字 用于明确表示派生类中的某个虚函数是用来重写基类中的虚函数的,这样编译器会检查基类,看看是否确实存在同样的虚函数,如果没有匹配&am…...

【MyBatis源码】SQL 语句构建器AbstractSQL

文章目录 介绍org.apache.ibatis.jdbc.SQLSQL类使用示例SelectProvider搭配动态SQLAbstractSQL类源码分析 介绍 当我们需要使用Statement对象执行SQL时,SQL语句会嵌入Java代码中。SQL语句比较复杂时,我们可能会在代码中对SQL语句进行拼接,查…...

C++OJ_二叉树的层序遍历

✨✨ 欢迎大家来到小伞的大讲堂✨✨ 🎈🎈养成好习惯,先赞后看哦~🎈🎈 所属专栏:C_OJ 小伞的主页:xiaosan_blog 二叉树的层序遍历 102. 二叉树的层序遍历 - 力扣(LeetCode࿰…...

什么是直方图算法

什么是直方图算法? 直方图算法是一种优化决策树分裂点搜索效率的算法,被广泛应用于像 LightGBM 和 XGBoost 这样的梯度提升决策树框架中。其核心思想是通过将连续特征的取值范围离散化为有限的区间(称为 bins),在这些…...

【网络】每天掌握一个Linux命令 - iftop

在Linux系统中,iftop是网络管理的得力助手,能实时监控网络流量、连接情况等,帮助排查网络异常。接下来从多方面详细介绍它。 目录 【网络】每天掌握一个Linux命令 - iftop工具概述安装方式核心功能基础用法进阶操作实战案例面试题场景生产场景…...

循环冗余码校验CRC码 算法步骤+详细实例计算

通信过程:(白话解释) 我们将原始待发送的消息称为 M M M,依据发送接收消息双方约定的生成多项式 G ( x ) G(x) G(x)(意思就是 G ( x ) G(x) G(x) 是已知的)࿰…...

:滤镜命令)

ffmpeg(四):滤镜命令

FFmpeg 的滤镜命令是用于音视频处理中的强大工具,可以完成剪裁、缩放、加水印、调色、合成、旋转、模糊、叠加字幕等复杂的操作。其核心语法格式一般如下: ffmpeg -i input.mp4 -vf "滤镜参数" output.mp4或者带音频滤镜: ffmpeg…...

DIY|Mac 搭建 ESP-IDF 开发环境及编译小智 AI

前一阵子在百度 AI 开发者大会上,看到基于小智 AI DIY 玩具的演示,感觉有点意思,想着自己也来试试。 如果只是想烧录现成的固件,乐鑫官方除了提供了 Windows 版本的 Flash 下载工具 之外,还提供了基于网页版的 ESP LA…...

)

相机Camera日志分析之三十一:高通Camx HAL十种流程基础分析关键字汇总(后续持续更新中)

【关注我,后续持续新增专题博文,谢谢!!!】 上一篇我们讲了:有对最普通的场景进行各个日志注释讲解,但相机场景太多,日志差异也巨大。后面将展示各种场景下的日志。 通过notepad++打开场景下的日志,通过下列分类关键字搜索,即可清晰的分析不同场景的相机运行流程差异…...

html css js网页制作成品——HTML+CSS榴莲商城网页设计(4页)附源码

目录 一、👨🎓网站题目 二、✍️网站描述 三、📚网站介绍 四、🌐网站效果 五、🪓 代码实现 🧱HTML 六、🥇 如何让学习不再盲目 七、🎁更多干货 一、👨…...

【Redis】笔记|第8节|大厂高并发缓存架构实战与优化

缓存架构 代码结构 代码详情 功能点: 多级缓存,先查本地缓存,再查Redis,最后才查数据库热点数据重建逻辑使用分布式锁,二次查询更新缓存采用读写锁提升性能采用Redis的发布订阅机制通知所有实例更新本地缓存适用读多…...

Java求职者面试指南:计算机基础与源码原理深度解析

Java求职者面试指南:计算机基础与源码原理深度解析 第一轮提问:基础概念问题 1. 请解释什么是进程和线程的区别? 面试官:进程是程序的一次执行过程,是系统进行资源分配和调度的基本单位;而线程是进程中的…...

【Android】Android 开发 ADB 常用指令

查看当前连接的设备 adb devices 连接设备 adb connect 设备IP 断开已连接的设备 adb disconnect 设备IP 安装应用 adb install 安装包的路径 卸载应用 adb uninstall 应用包名 查看已安装的应用包名 adb shell pm list packages 查看已安装的第三方应用包名 adb shell pm list…...

Linux系统部署KES

1、安装准备 1.版本说明V008R006C009B0014 V008:是version产品的大版本。 R006:是release产品特性版本。 C009:是通用版 B0014:是build开发过程中的构建版本2.硬件要求 #安全版和企业版 内存:1GB 以上 硬盘…...