ELK入门教程(超详细)

什么是ELK?

ELK是Elasticsearch、Logstash、Kibana三大开源框架首字母大写简称(后来出现的filebeat属于beats家族中的一员,可以用来替代logstash的数据收集功能,比较轻量级),也被称为Elastic Stack。

Filebeat

Filebeat是用于转发和集中日志数据的轻量级传送工具。Filebeat监视您指定的日志文件或位置,收集日志事件,并将它们转发到Elasticsearch或 Logstash进行索引。Filebeat的工作方式如下:启动Filebeat时,它将启动一个或多个输入,这些输入将在为日志数据指定的位置中查找。对于Filebeat所找到的每个日志,Filebeat都会启动收集器。每个收集器都读取单个日志以获取新内容,并将新日志数据发送到libbeat,libbeat将聚集事件,并将聚集的数据发送到为Filebeat配置的输出。

Logstash

Logstash是免费且开放的服务器端数据处理管道,能够从多个来源采集数据,转换数据,然后将数据发送到您最喜欢的“存储库”中。Logstash能够动态地采集、转换和传输数据,不受格式或复杂度的影响。利用Grok从非结构化数据中派生出结构,从IP地址解码出地理坐标,匿名化或排除敏感字段,并简化整体处理过程。

ElasticSearch

Elasticsearch是Elastic Stack核心的分布式搜索和分析引擎,是一个基于Lucene、分布式、通过Restful方式进行交互的近实时搜索平台框架。Elasticsearch为所有类型的数据提供近乎实时的搜索和分析。无论您是结构化文本还是非结构化文本,数字数据或地理空间数据,Elasticsearch都能以支持快速搜索的方式有效地对其进行存储和索引。

Kibana

Kibana是一个针对Elasticsearch的开源分析及可视化平台,用来搜索、查看交互存储在Elasticsearch索引中的数据。使用Kibana,可以通过各种图表进行高级数据分析及展示。并且可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以汇总、分析和搜索重要数据日志。还可以让海量数据更容易理解。它操作简单,基于浏览器的用户界面可以快速创建仪表板(dashboard)实时显示Elasticsearch查询动态。

Logstash入门

使用Docker-Compose启动Logstash服务,其中docker-compose.yml文件如下:

version: "3.1"

# 服务配置

services:

logstash:

container_name: logstash-7.17.0

image: docker.elastic.co/logstash/logstash:7.17.0

volumes:

- ./logstash/data:/usr/share/logstash/data

- ./logstash/pipeline:/usr/share/logstash/pipeline

networks:

- elk_net

# 网络配置

networks:

elk_net:

driver: bridge

示例配置1(标准输入、输出)

每隔10秒输出字符串:Hello from Logstash!

input {

heartbeat {

interval => 10

message => 'Hello from Logstash!'

}

}

output {

stdout {

codec => rubydebug

}

}

示例配置2(读取文件)

读取文件内容(文件的最后一行将不会读取),示例文件为test.log

hello world!

From Shanghai To Beijing

this is a log for test in logstash!

配置文件如下:

input {

file {

path => "/usr/share/logstash/data/test.log"

start_position => "beginning"

}

}

output {

stdout {

codec => rubydebug

}

}

读取结果如下(顺序已打乱)

示例配置3(Grok插件)

Grok为正则表达式,Logstash(v4.4.3)已内置120种表达式,参考网址为:https://github.com/logstash-plugins/logstash-patterns-core/tree/main/patterns.

读取Nginx日志文件,并使用Grok进行过滤。Nginx文件示例如下:

112.195.209.90 - - [20/Feb/2018:12:12:14 +0800] "GET / HTTP/1.1" 200 190 "-" "Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Mobile Safari/537.36" "-"

配置文件如下:

input {

file {

path => "/usr/share/logstash/data/test.log"

start_position => "beginning"

}

}

filter {

grok {

match => {

"message" => "%{COMBINEDAPACHELOG}"

}

}

}

output {

stdout {

codec => rubydebug

}

}

解析结果为:

Kibana在Dev Tools中内置了Grok Debugger(调试器):

示例解析配置4(多行读取插件 multiline)

对 multiline 插件来说,有三个设置比较重要:negate、pattern 和 what。

-

• pattern: 类型是string,要匹配的正则表达式

-

• negate: 类型是boolean,默认false,否定正则表达式

-

• what: 必须设置,可以为 previous 或 next, 如果正则表达式匹配了,那么该事件是属于下一个或是前一个事件

multiline插件可以多行读取。示例文件内容如下(注意最后一行为空行):

[Aug/08/08 14:54:03] hello world

[Aug/08/09 14:54:04] hello logstash

hello best practice

hello raochenlin

[Aug/08/10 14:54:05] the end

配置文件:

input {

file {

path => "/usr/share/logstash/data/test.log"

start_position => "beginning"

codec => multiline {

pattern => "^\["

negate => true

what => "previous"

}

}

}

output {

stdout {

codec => rubydebug

}

}

解析结果如下:

{

"message" => "[Aug/08/08 14:54:03] hello world",

"@timestamp" => 2023-12-23T10:41:20.884Z,

"path" => "/usr/share/logstash/data/test.log",

"host" => "b62820accf76",

"@version" => "1"

}

{

"message" => "[Aug/08/09 14:54:04] hello logstash\n hello best practice\n hello raochenlin",

"path" => "/usr/share/logstash/data/test.log",

"tags" => [

[0] "multiline"

],

"@timestamp" => 2023-12-23T10:44:24.846Z,

"host" => "b62820accf76",

"@version" => "1"

}

由于参数what设置为previous,因此只解析出两条数据。当what设置为next时,可解析出三条数据,但解析结果有变化,如下:

{

"message" => "[Aug/08/08 14:54:03] hello world",

"path" => "/usr/share/logstash/data/test.log",

"@timestamp" => 2023-12-23T10:49:23.395Z,

"host" => "492dfb254e78",

"@version" => "1"

}

{

"message" => " hello best practice\n hello raochenlin\n[Aug/08/10 14:54:05] the end",

"@timestamp" => 2023-12-23T10:49:23.415Z,

"path" => "/usr/share/logstash/data/test.log",

"host" => "492dfb254e78",

"@version" => "1",

"tags" => [

[0] "multiline"

]

}

{

"message" => "[Aug/08/09 14:54:04] hello logstash",

"path" => "/usr/share/logstash/data/test.log",

"@timestamp" => 2023-12-23T10:49:23.414Z,

"host" => "492dfb254e78",

"@version" => "1"

}

ELK搭建简单示例

结合Logstash, ElasticSearch与Kibana,将data文件夹中的以log结尾的文件,逐行导入至ElasticSearch中。

logstash.conf配置如下:

input {

file {

path => "/usr/share/logstash/data/*.log"

start_position => "beginning"

}

}

output {

stdout {

codec => rubydebug

}

elasticsearch {

hosts => ["http://elasticsearch:9200"]

index => "test_log"

action => "index"

}

}

docker-compose.yml文件如下:

version: "3.1"

# 服务配置

services:

logstash:

container_name: logstash-7.17.0

image: docker.elastic.co/logstash/logstash:7.17.0

volumes:

- ./logstash/config/logstash.yml:/usr/share/logstash/logstash.yml

- ./logstash/data:/usr/share/logstash/data

- ./logstash/pipeline:/usr/share/logstash/pipeline

networks:

- elk_net

depends_on:

- elasticsearch

elasticsearch:

container_name: elasticsearch-7.17.0

image: elasticsearch:7.17.0

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "http.host=0.0.0.0"

- "node.name=elastic01"

- "cluster.name=cluster_elasticsearch"

- "discovery.type=single-node"

ports:

- "9200:9200"

- "9300:9300"

volumes:

- ./es/plugins:/usr/share/elasticsearch/plugins

- ./es/data:/usr/share/elasticsearch/data

networks:

- elk_net

kibana:

container_name: kibana-7.17.0

image: kibana:7.17.0

ports:

- "5601:5601"

networks:

- elk_net

depends_on:

- elasticsearch

# 网络配置

networks:

elk_net:

driver: bridge

ELK日志系统实战

我们来设计这样一个日志系统,其中Logstash可将Flask运行过程中的日志进行收集,并导入至ElasticSearch中,再使用Kibana进行数据分析。

Flask服务

使用Flask构建简单的web服务,代码如下:

# -*- coding: utf-8 -*-

# @file: server.py

# @time: 2023/12/23 19:17

import time

import random

from flask import Flask, Response

import logginglogging.basicConfig(filename='../logstash/data/flask.log',level=logging.DEBUG,format='%(asctime)s-%(filename)s-%(funcName)s-%(levelname)s-%(message)s')

logger = logging.getLogger()app = Flask("elk_test")@app.route('/')

def index():t1 = time.time()logger.info(f"api_endpoint: /, status: 200, cost_time: {(time.time() - t1) * 1000}")return "Hello index", 200@app.route("/io_task")

def io_task():t1 = time.time()time.sleep(2)logger.info(f"api_endpoint: /io_task, status: 200, cost_time: {(time.time() - t1) * 1000}")return "IO bound task finish!", 200@app.route("/cpu_task")

def cpu_task():t1 = time.time()for i in range(10000):n = i*i*ilogger.info(f"api_endpoint: /cpu_task, status: 200, cost_time: {(time.time() - t1) * 1000}")return "CPU bound task finish!", 200@app.route("/random_sleep")

def random_sleep():t1 = time.time()time.sleep(random.randint(0, 5))logger.info(f"api_endpoint: /random_sleep, status: 200, cost_time: {(time.time() - t1) * 1000}")return "random sleep", 200@app.route("/random_status")

def random_status():t1 = time.time()status_code = random.choice([200] * 6 + [300, 400, 400, 500])logger.info(f"api_endpoint: /random_status, status: {status_code}, cost_time: {(time.time() - t1) * 1000}")return Response("random status", status=status_code)if __name__ == '__main__':app.run(host="0.0.0.0", port=5000, debug=True)使用下面的shell脚本进行HTTP请求模拟:

TIMES=5

for i in $(eval echo "{1..$TIMES}")

do

siege -c 1 -r 10 http://localhost:5000/

siege -c 1 -r 5 http://localhost:5000/io_task

siege -c 1 -r 5 http://localhost:5000/cpu_task

siege -c 1 -r 3 http://localhost:5000/random_sleep

siege -c 1 -r 10 http://localhost:5000/random_status

sleep 5

done

日志记录在flask.log文件中。

ELK搭建

对上述日志,搭建ELK,docker-compose.yml同上述ELK搭建简单示例,logstash.conf改动如下:

input {

file {

path => "/usr/share/logstash/data/flask.log"

start_position => "beginning"

}

}

filter {

# 只对cost_time所在列进行解析

if "cost_time" in [message] {

grok {

match => {

"message" => "%{TIMESTAMP_ISO8601:request_finish_time}-%{WORD:script}.py-%{WORD:module}-%{LOGLEVEL:loglevel}-api_endpoint: %{DATA:api_endpoint}, status: %{NUMBER:status:int}, cost_time: %{NUMBER:cost_time:float}"

}

}

# 使用mutate过滤器替换字符

mutate {

# 替换空格为T

gsub => [ "request_finish_time", " ", "T" ]

# 替换逗号为点

gsub => [ "request_finish_time", ",", "." ]

}

# 使用date过滤器解析和格式化日期

date {

match => [ "request_finish_time", "ISO8601" ]

}

}

else {

drop { }

}

}

output {

stdout {

codec => rubydebug

}

elasticsearch {

hosts => ["http://elasticsearch:9200"]

index => "flask_log"

action => "index"

}

}

只对有cost_time所在的行进行解析,其它行丢弃,导入至ElasticSearch中的flask_log这个索引中。

数据分析

对上述的五个API Endpoint进行请求占比分析,饼图如下:

同时,对cost_time进行数据分析,其平均值,90, 95, 99分位数如下表:

上述的日志记录方式还有待改进,比如记录程序报错信息,使用json字段解析而不是Grok表达式会更容易些。

相关文章:

ELK入门教程(超详细)

什么是ELK? ELK是Elasticsearch、Logstash、Kibana三大开源框架首字母大写简称(后来出现的filebeat属于beats家族中的一员,可以用来替代logstash的数据收集功能,比较轻量级),也被称为Elastic Stack。 Filebeat Filebeat是用于转…...

人工智能知识分享第六天-机器学习_逻辑回归(Logistic Regression)

简介 在机器学习中,分类问题是一种常见的任务,目标是根据输入特征将数据点分配到不同的类别中。为了实现分类,我们需要训练一个分类器,该分类器能够根据输入数据的特征进行预测。 逻辑回归(Logistic Regression&…...

基于Springboot + vue实现的校园周边美食探索及分享平台

🥂(❁◡❁)您的点赞👍➕评论📝➕收藏⭐是作者创作的最大动力🤞 💖📕🎉🔥 支持我:点赞👍收藏⭐️留言📝欢迎留言讨论 🔥🔥&…...

初学STM32 --- 外部SRAM

目录 SRAM简介 SRAM特性: XM8A51216 功能框图 8080并口读时序编辑 8080并口写时序 SRAM 读写操作步骤 FSMC介绍 FSMC时序介绍 FSMC控制器对内核地址映射编辑 FSMC HAL库相关驱动 SRAM驱动步骤 SRAM简介 静态随机存取存储器(Static Random-Access Memory&am…...

创龙3588——debian根文件系统制作

文章目录 build.sh debian 执行流程build.sh源码流程 30-rootfs.sh源码流程 mk-rootfs-bullseys.sh源码流程 mk-sysroot.sh源码流程 mk-image.sh源码流程 post-build.sh 大致流程系统制作步骤 build.sh debian 执行流程 build.sh 源码 run_hooks() {DIR"$1"shiftf…...

javacript中function (res) {}与箭头函数表达式(res) =>{}的区别

javacript中function (res) {}与(res) >{}的区别 function (res) {} 代码演示 let shape {name:长方形,say:function(){console.log(我是this.name)setTimeout(function(){console.log(3秒后输出我是: this.name); //this.name为undefined}, 3000)} }shape.sa…...

kylin安装docker

1. 前言 本文详细介绍如何在kylin v10上安装docker。系统环境如下: dockder: 20.10.7 linux os: kylinv 10 (GFB) linux kernel: 4.19.90-52.23.v2207.gfb01.ky10.aarch642. 安装docker 2.1. 下载docker二进制包 wget https://mirror.nju.edu.cn…...

【Yarn】通过JMX采集yarn相关指标的Flink任务核心逻辑

通过JMX采集yarn相关指标的Flink任务核心逻辑 文章目录 通过JMX采集yarn相关指标的Flink任务核心逻辑通过jmx接口查询Yarn队列指标请求JMX配置项核心处理流程输出到kafka格式通过jmx接口查询ResourceManager核心指标请求JMX读取配置yaml配置文件核心处理逻辑输出Kafka格式彩蛋 …...

鸿蒙HarmonyOS开发:基于Swiper组件和自定义指示器实现多图片进度条轮播功能

文章目录 一、概述1、场景介绍2、技术选型 二、实现方案1、图片区域实现2、底部导航点设计3、手动切换 三、所有代码1、设置沉浸式2、外层Tabs效果3、ImageSwiper组件 四、效果展示 一、概述 在短视频平台上,经常可以见到多图片合集。它的特点是:由多张…...

Excel 身份证号计算年龄

1. 设置身份证号列格式 复制身份证列值到记事本或其他地方重新设置身份证号列单元格格式为“文本”将复制出去的身份证号重新复制粘贴回来 2. 年龄列单元格中添加公式 DATEDIF(DATE(LEFT(MID(A2, 7, 8), 4), MID(MID(A2, 7, 8), 5, 2), RIGHT(MID(A2, 7, 8), 2)), TODAY(), …...

【2024年-6月-14日-开源社区openEuler实践记录】探索 test - tools:高效测试的开源宝库

开篇引言 大家好,我是 fzr123,在软件开发领域深耕多年,一直致力于探索各种提升效率的工具与技术。今天,我将为大家深入介绍一款在测试领域极具价值的开源项目——test - tools,它为开发者们提供了一系列强大的测试功能…...

2022浙江大学信号与系统笔记

原视频地址:2022浙江大学信号与系统(含配套课件和代码) - 胡浩基老师-哔哩哔哩 ⭐⭐⭐ 我的笔记:飞书链接 - 信号与系统 基于视频,记得笔记,加了点自己的补充(有的是问 ChatGPT 的)…...

DeepSeek-VL2

《DeepSeek-VL2: Mixture-of-Experts Vision-Language Models for Advanced Multimodal Understanding》是 DeepSeek-AI 团队发布的关于视觉语言模型 DeepSeek-VL2 的论文,以下是对该论文的详细介绍: 研究背景与动机 多模态理解的重要性:在当…...

前端⾯试⼋股⽂

1.http 和 https 的基本概念 - http: 是⼀个客⼾端和服务器端请求和应答的标准(TCP),⽤于从 WWW 服务器传输超⽂本到本地浏 览器的超⽂本传输协议。 - https:是以安全为⽬标的 HTTP 通道,即 HTTP 下 加⼊ SSL 层进⾏加密。其作⽤…...

【Rust自学】8.6. HashMap Pt.2:更新HashMap

8.6.0. 本章内容 第八章主要讲的是Rust中常见的集合。Rust中提供了很多集合类型的数据结构,这些集合可以包含很多值。但是第八章所讲的集合与数组和元组有所不同。 第八章中的集合是存储在堆内存上而非栈内存上的,这也意味着这些集合的数据大小无需在编…...

Python异常处理详解:概念、语法与实践

1. 异常的概念 在Python中,异常(Exception)是程序运行时出现的错误或不正常情况。异常通常表示程序在运行时遇到了无法继续执行的条件。Python通过 try/except 语句来捕获和处理异常。 异常可以分为两类: 内建异常:…...

Kotlin在医疗大健康域的应用实例探究与编程剖析(上)

一、引言 1.1 研究背景与意义 在当今数字化时代,医疗行业正经历着深刻的变革。随着信息技术的飞速发展,尤其是人工智能、大数据、物联网等新兴技术的广泛应用,医疗行业数字化转型已成为必然趋势。这种转型旨在提升医疗服务的效率和质量,优化医疗资源配置,为患者提供更加…...

QT----------QT Data Visualzation

实现思路: 配置项目:在 .pro 文件中添加 QT datavisualization 以引入 QT Data Visualization 模块。创建主窗口:使用 QMainWindow 作为主窗口,添加 Q3DScatter、Q3DBars 和 Q3DSurface 等三维视图组件。初始化和创建三维图表&a…...

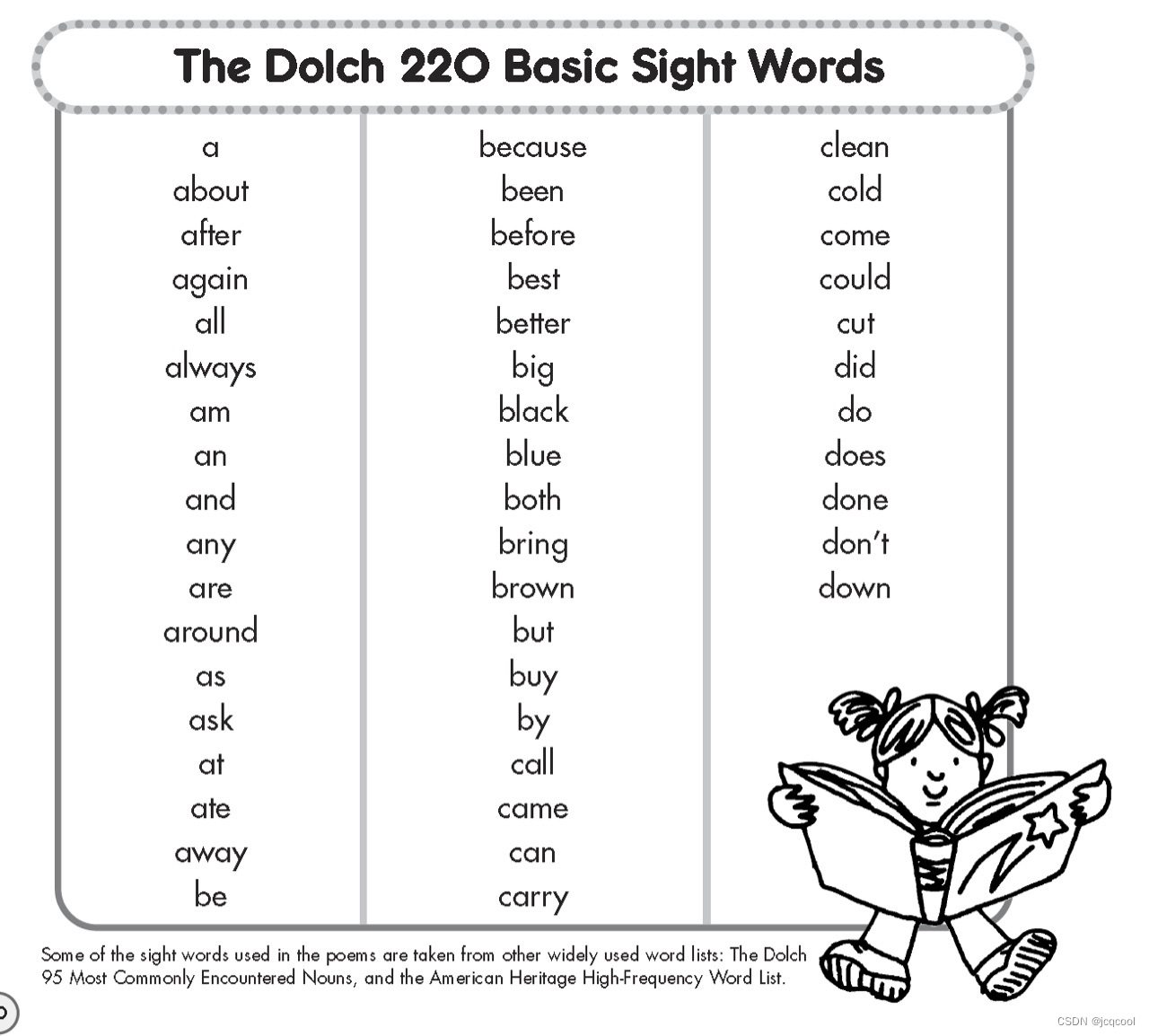

什么是Sight Words(信号词)

🧡什么是Sight Words(信号词) 简单来说,Sight Words就是我们在日常英语中常用的一些基本词汇。可以把它想象成是学练英语的“基础词汇”,这些词在各种考试中经常出现,也是在生活中必不可少的。 …...

SpringBoot日志快速集成详解-生产实战

SpringBoot日志快速集成详解 1. 添加依赖2. 创建 logback-spring.xml 配置文件示例 logback-spring.xml 配置: 3. 启用 Spring Boot 自动配置4. 配置 Spring Boot 启动日志级别5. 运行与验证 博文专注于最快速的实战,没有那么多逼逼叨叨的理论࿰…...

利用最小二乘法找圆心和半径

#include <iostream> #include <vector> #include <cmath> #include <Eigen/Dense> // 需安装Eigen库用于矩阵运算 // 定义点结构 struct Point { double x, y; Point(double x_, double y_) : x(x_), y(y_) {} }; // 最小二乘法求圆心和半径 …...

web vue 项目 Docker化部署

Web 项目 Docker 化部署详细教程 目录 Web 项目 Docker 化部署概述Dockerfile 详解 构建阶段生产阶段 构建和运行 Docker 镜像 1. Web 项目 Docker 化部署概述 Docker 化部署的主要步骤分为以下几个阶段: 构建阶段(Build Stage):…...

微信小程序之bind和catch

这两个呢,都是绑定事件用的,具体使用有些小区别。 官方文档: 事件冒泡处理不同 bind:绑定的事件会向上冒泡,即触发当前组件的事件后,还会继续触发父组件的相同事件。例如,有一个子视图绑定了b…...

从WWDC看苹果产品发展的规律

WWDC 是苹果公司一年一度面向全球开发者的盛会,其主题演讲展现了苹果在产品设计、技术路线、用户体验和生态系统构建上的核心理念与演进脉络。我们借助 ChatGPT Deep Research 工具,对过去十年 WWDC 主题演讲内容进行了系统化分析,形成了这份…...

云启出海,智联未来|阿里云网络「企业出海」系列客户沙龙上海站圆满落地

借阿里云中企出海大会的东风,以**「云启出海,智联未来|打造安全可靠的出海云网络引擎」为主题的阿里云企业出海客户沙龙云网络&安全专场于5.28日下午在上海顺利举办,现场吸引了来自携程、小红书、米哈游、哔哩哔哩、波克城市、…...

遍历 Map 类型集合的方法汇总

1 方法一 先用方法 keySet() 获取集合中的所有键。再通过 gey(key) 方法用对应键获取值 import java.util.HashMap; import java.util.Set;public class Test {public static void main(String[] args) {HashMap hashMap new HashMap();hashMap.put("语文",99);has…...

在四层代理中还原真实客户端ngx_stream_realip_module

一、模块原理与价值 PROXY Protocol 回溯 第三方负载均衡(如 HAProxy、AWS NLB、阿里 SLB)发起上游连接时,将真实客户端 IP/Port 写入 PROXY Protocol v1/v2 头。Stream 层接收到头部后,ngx_stream_realip_module 从中提取原始信息…...

【Zephyr 系列 10】实战项目:打造一个蓝牙传感器终端 + 网关系统(完整架构与全栈实现)

🧠关键词:Zephyr、BLE、终端、网关、广播、连接、传感器、数据采集、低功耗、系统集成 📌目标读者:希望基于 Zephyr 构建 BLE 系统架构、实现终端与网关协作、具备产品交付能力的开发者 📊篇幅字数:约 5200 字 ✨ 项目总览 在物联网实际项目中,**“终端 + 网关”**是…...

实现弹窗随键盘上移居中

实现弹窗随键盘上移的核心思路 在Android中,可以通过监听键盘的显示和隐藏事件,动态调整弹窗的位置。关键点在于获取键盘高度,并计算剩余屏幕空间以重新定位弹窗。 // 在Activity或Fragment中设置键盘监听 val rootView findViewById<V…...

智能分布式爬虫的数据处理流水线优化:基于深度强化学习的数据质量控制

在数字化浪潮席卷全球的今天,数据已成为企业和研究机构的核心资产。智能分布式爬虫作为高效的数据采集工具,在大规模数据获取中发挥着关键作用。然而,传统的数据处理流水线在面对复杂多变的网络环境和海量异构数据时,常出现数据质…...