使用MediaPipe Face Mesh 面部动作检测

一、技术选型

-

OpenCV(Open Source Computer Vision Library)

- 用于视频流捕捉、图像预处理和基本图像处理操作。

-

MediaPipe

- 提供高效的人脸检测与关键点提取功能(Face Mesh)。

-

Python

- 作为后端开发语言,整合上述库进行图像处理和动作识别。

-

Flask/Django(可选)

- 用于构建后端API服务,处理前端请求。

二、整体流程概述

-

视频流或图片获取

- 前端通过摄像头捕捉视频流或图片,并将数据发送至后端。

-

图像预处理

- 对接收到的图像数据进行解码、缩放和颜色空间转换。

-

人脸检测与关键点提取

- 使用 MediaPipe 提取面部关键点(Face Mesh)。

-

动作识别

- 根据关键点数据,分析用户的具体动作(如转头、眨眼、张嘴)。

-

结果返回

- 将识别结果以 JSON 格式返回前端。

三、详细实现步骤

1. 视频流或图片获取

前端(微信小程序)捕捉到视频帧或图片后,通过 API 将图像数据(通常为 Base64 编码或二进制数据)发送至后端。

前端发送图像数据示例(微信小程序):

wx.chooseImage({count: 1,success: function(res) {const tempFilePaths = res.tempFilePaths;wx.getFileSystemManager().readFile({filePath: tempFilePaths[0],encoding: 'base64',success: function(data) {wx.request({url: 'https://localhost/api/task/detect',method: 'POST',data: {user_id: 'unique_user_id',image_data: data.data},success: function(response) {// 处理后端返回的检测结果}});}});}

});

2. 图像预处理

后端接收到图像数据后,进行解码和预处理。

示例代码(Python):

import base64

import cv2

import numpy as npdef decode_image(image_base64):# 解码 Base64 图像数据img_data = base64.b64decode(image_base64)# 转换为 numpy 数组np_arr = np.frombuffer(img_data, np.uint8)# 使用 OpenCV 解码图像img = cv2.imdecode(np_arr, cv2.IMREAD_COLOR)return img

3. 人脸检测与关键点提取

使用 MediaPipe 的 Face Mesh 模型提取面部关键点。

安装 MediaPipe:

pip install mediapipe

示例代码(Python):

import mediapipe as mp# 初始化 MediaPipe Face Mesh

mp_face_mesh = mp.solutions.face_mesh

face_mesh = mp_face_mesh.FaceMesh(static_image_mode=False,max_num_faces=1,refine_landmarks=True,min_detection_confidence=0.5,min_tracking_confidence=0.5

)def get_face_landmarks(image):# 将图像从 BGR 转换为 RGBrgb_image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)# 获取关键点results = face_mesh.process(rgb_image)if results.multi_face_landmarks:# 返回第一个人脸的关键点return results.multi_face_landmarks[0]else:return None

4. 动作识别

基于提取的关键点数据,分析用户的具体动作。以下分别介绍左右转头、眨眼和张嘴的检测方法。

4.1 左右转头检测

通过分析左右眼和鼻子的关键点位置,计算头部的旋转角度。

关键点选择:

- 鼻尖(例如 MediaPipe Face Mesh 的 1 号关键点)

- 左眼外角(例如 33 号关键点)

- 右眼外角(例如 263 号关键点)

实现步骤:

- 计算左眼外角与鼻尖的连线向量。

- 计算右眼外角与鼻尖的连线向量。

- 通过向量之间的角度差,判断头部是否向左或向右转动。

示例代码:

import mathdef calculate_angle(p1, p2):# 计算两点连线的角度(相对于水平线)delta_y = p2.y - p1.ydelta_x = p2.x - p1.xangle = math.degrees(math.atan2(delta_y, delta_x))return angledef detect_head_turn(landmarks):# 关键点索引(根据 MediaPipe Face Mesh)nose_tip = landmarks.landmark[1]left_eye_outer = landmarks.landmark[33]right_eye_outer = landmarks.landmark[263]# 计算角度left_angle = calculate_angle(nose_tip, left_eye_outer)right_angle = calculate_angle(nose_tip, right_eye_outer)# 计算平均角度avg_angle = (left_angle + right_angle) / 2# 定义阈值(根据实际测试调整)TURN_LEFT_THRESHOLD = -15 # 向左转头TURN_RIGHT_THRESHOLD = 15 # 向右转头if avg_angle < TURN_LEFT_THRESHOLD:return 'left'elif avg_angle > TURN_RIGHT_THRESHOLD:return 'right'else:return 'straight'

4.2 眨眼检测

通过监测眼睛的纵横比(EAR, Eye Aspect Ratio)来检测眨眼次数。

关键点选择:

- 左眼:关键点 362, 385, 387, 263, 373, 380

- 右眼:关键点 33, 160, 158, 133, 153, 144

实现步骤:

- 计算每只眼睛的 EAR。

- 当 EAR 低于某个阈值时,判断为闭眼。

- 记录眨眼次数。

示例代码:

def eye_aspect_ratio(landmarks, eye_indices):# 计算 EAR# eye_indices 包含 6 个关键点的索引p1 = landmarks.landmark[eye_indices[1]]p2 = landmarks.landmark[eye_indices[5]]p3 = landmarks.landmark[eye_indices[2]]p4 = landmarks.landmark[eye_indices[4]]p5 = landmarks.landmark[eye_indices[0]]p6 = landmarks.landmark[eye_indices[3]]# 纵向距离vertical_1 = math.sqrt((p2.x - p4.x)**2 + (p2.y - p4.y)**2)vertical_2 = math.sqrt((p3.x - p5.x)**2 + (p3.y - p5.y)**2)# 横向距离horizontal = math.sqrt((p1.x - p6.x)**2 + (p1.y - p6.y)**2)ear = (vertical_1 + vertical_2) / (2.0 * horizontal)return eardef detect_blink(landmarks, blink_counter, total_blinks):LEFT_EYE = [362, 385, 387, 263, 373, 380]RIGHT_EYE = [33, 160, 158, 133, 153, 144]EAR_THRESHOLD = 0.21 # 根据实际测试调整CONSEC_FRAMES = 3 # 眨眼最少持续的帧数left_ear = eye_aspect_ratio(landmarks, LEFT_EYE)right_ear = eye_aspect_ratio(landmarks, RIGHT_EYE)ear = (left_ear + right_ear) / 2.0if ear < EAR_THRESHOLD:blink_counter += 1else:if blink_counter >= CONSEC_FRAMES:total_blinks += 1blink_counter = 0return blink_counter, total_blinks

4.3 张嘴检测

通过计算嘴部纵横比(MAR, Mouth Aspect Ratio)来检测张嘴动作。

关键点选择:

- 上唇上方(例如 13 号关键点)

- 下唇下方(例如 14 号关键点)

- 左嘴角(78 号关键点)

- 右嘴角(308 号关键点)

实现步骤:

- 计算嘴部的 MAR。

- 当 MAR 超过某个阈值时,判断为张嘴。

示例代码:

def mouth_aspect_ratio(landmarks):# 关键点索引(根据 MediaPipe Face Mesh)upper_lip = landmarks.landmark[13]lower_lip = landmarks.landmark[14]left_mouth = landmarks.landmark[78]right_mouth = landmarks.landmark[308]# 纵向距离vertical = math.sqrt((upper_lip.x - lower_lip.x)**2 + (upper_lip.y - lower_lip.y)**2)# 横向距离horizontal = math.sqrt((left_mouth.x - right_mouth.x)**2 + (left_mouth.y - right_mouth.y)**2)mar = vertical / horizontalreturn mardef detect_mouth_open(landmarks, mouth_opened):MAR_THRESHOLD = 0.6 # 根据实际测试调整mar = mouth_aspect_ratio(landmarks)if mar > MAR_THRESHOLD:mouth_opened = Trueelse:mouth_opened = Falsereturn mouth_opened

5. 综合动作识别

将上述各个动作的检测方法整合,形成综合的动作识别流程。

示例代码:

def recognize_actions(landmarks, state):# state 包含用于记录眨眼状态的变量,如 blink_counter, total_blinks, mouth_openedaction_results = {}# 检测左右转头head_direction = detect_head_turn(landmarks)action_results['head_turn'] = head_direction# 检测眨眼state['blink_counter'], state['total_blinks'] = detect_blink(landmarks, state['blink_counter'], state['total_blinks'])action_results['blink_count'] = state['total_blinks']# 检测张嘴state['mouth_opened'] = detect_mouth_open(landmarks, state['mouth_opened'])action_results['mouth_opened'] = state['mouth_opened']return action_results

6. 后端 API 实现

使用 Flask 构建后端 API,处理前端请求,执行上述图像处理和动作识别逻辑,并返回结果。

安装 Flask:

pip install Flask

示例代码(Flask 应用):

from flask import Flask, request, jsonify

import cv2

import base64

import numpy as npapp = Flask(__name__)# 初始化 MediaPipe Face Mesh

import mediapipe as mp

mp_face_mesh = mp.solutions.face_mesh

face_mesh = mp_face_mesh.FaceMesh(static_image_mode=False,max_num_faces=1,refine_landmarks=True,min_detection_confidence=0.5,min_tracking_confidence=0.5

)# 状态管理(简单示例,实际应用建议使用数据库或缓存)

user_states = {}@app.route('/api/task/detect', methods=['POST'])

def detect_task():data = request.jsonuser_id = data.get('user_id')image_base64 = data.get('image_data')if not user_id or not image_base64:return jsonify({'success': False, 'message': '缺少参数'}), 400# 解码图像try:img = decode_image(image_base64)except Exception as e:return jsonify({'success': False, 'message': '图像解码失败'}), 400# 获取关键点landmarks = get_face_landmarks(img)if not landmarks:return jsonify({'success': False, 'message': '未检测到人脸'}), 200# 初始化用户状态if user_id not in user_states:user_states[user_id] = {'current_step': 1,'blink_counter': 0,'total_blinks': 0,'mouth_opened': False}state = user_states[user_id]current_step = state['current_step']# 识别动作action_results = recognize_actions(landmarks, state)# 判断当前步骤success = Falsenext_task = ''if current_step == 1:if action_results['head_turn'] in ['left', 'right']:success = Truenext_task = '请眨眼'state['current_step'] += 1elif current_step == 2:if action_results['blink_count'] >= 1:success = Truenext_task = '请张嘴'state['current_step'] += 1elif current_step == 3:if action_results['mouth_opened']:success = Truenext_task = '所有任务完成'state['current_step'] += 1else:# 所有任务完成success = Truenext_task = '所有任务已完成'if success:if state['current_step'] > 3:return jsonify({'success': True,'message': '成功完成所有任务','next_task': '完成','current_step': state['current_step']}), 200else:return jsonify({'success': True,'message': '检测成功,进入下一步','next_task': next_task,'current_step': state['current_step']}), 200else:return jsonify({'success': False,'message': '检测失败,请重新开始','current_step': 1}), 200@app.route('/api/task/reset', methods=['POST'])

def reset_task():data = request.jsonuser_id = data.get('user_id')if not user_id:return jsonify({'success': False, 'message': '缺少 user_id'}), 400user_states[user_id] = {'current_step': 1,'blink_counter': 0,'total_blinks': 0,'mouth_opened': False}return jsonify({'success': True,'message': '任务已重置','current_step': 1}), 200def decode_image(image_base64):img_data = base64.b64decode(image_base64)np_arr = np.frombuffer(img_data, np.uint8)img = cv2.imdecode(np_arr, cv2.IMREAD_COLOR)return imgdef get_face_landmarks(image):rgb_image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)results = face_mesh.process(rgb_image)if results.multi_face_landmarks:return results.multi_face_landmarks[0]else:return None# 包含上述动作检测函数的 recognize_actions 等if __name__ == '__main__':app.run(host='0.0.0.0', port=5000)

四、示例说明

假设用户正在进行 “检测用户是否向左转头” 的第一步任务:

-

前端捕捉图像:

- 用户在小程序中启动任务,摄像头捕捉当前帧,并将图像数据发送至后端的

/api/task/detect接口。

- 用户在小程序中启动任务,摄像头捕捉当前帧,并将图像数据发送至后端的

-

后端处理:

- 解码图像数据,并使用 MediaPipe 提取面部关键点。

- 计算鼻尖与左右眼外角的角度差,判断用户是否向左或向右转头。

- 假设检测到用户向左转头,更新用户任务状态为第二步。

-

后端返回结果:

- 返回

success: true,提示用户进入下一步任务“请眨眼”。

- 返回

-

前端反馈:

- 小程序根据后端返回的结果,更新界面提示用户“请眨眼”,并更新进度条。

具体代码执行过程:

- 用户完成向左转头动作,前端发送图像数据。

- 后端解码图像,提取关键点,计算角度。

- 检测到头部向左转动,

detect_head_turn返回'left'。 - 后端判断当前步骤为 1,检测成功,更新步骤为 2,提示下一步任务。

- 前端接收到

success: true,显示“请眨眼”。

五、优化与注意事项

-

实时性与性能优化

- 后端:使用异步框架(如

FastAPI)提升并发处理能力;使用 GPU 加速(如 NVIDIA CUDA)提升 MediaPipe 的处理速度。 - 前端:优化图像上传频率,减少网络传输延迟;使用合适的图像分辨率,平衡识别精度与传输速度。

- 后端:使用异步框架(如

-

准确性提升

- 调整动作识别的阈值(如 EAR_THRESHOLD、MAR_THRESHOLD),根据实际测试数据进行优化。

- 使用更多关键点或更复杂的算法(如深度学习模型)提升动作识别的准确性。

-

错误处理与用户体验

- 后端:处理异常情况,如未检测到人脸,返回友好的错误信息。

- 前端:根据后端返回的错误信息,提供明确的用户指引,如“未检测到人脸,请调整位置并重试”。

-

安全性

- 使用 HTTPS 协议保护数据传输安全。

- 对上传的图像数据进行限制,防止恶意攻击(如限制图像大小、格式等)。

-

扩展性

- 设计模块化的代码结构,便于后续增加更多动作识别任务。

- 使用数据库或缓存系统(如 Redis)管理用户状态,支持大规模用户同时使用。

六、扩展示例:添加“微笑”检测

假设需要增加一个新任务,检测用户是否微笑。以下为实现步骤:

-

关键点选择:

- 上嘴唇中点(例如 13 号关键点)

- 下嘴唇中点(例如 14 号关键点)

- 左嘴角(78 号关键点)

- 右嘴角(308 号关键点)

-

微笑检测逻辑:

def smile_aspect_ratio(landmarks):# 关键点索引upper_lip = landmarks.landmark[13]lower_lip = landmarks.landmark[14]left_mouth = landmarks.landmark[78]right_mouth = landmarks.landmark[308]# 纵向距离vertical = math.sqrt((upper_lip.x - lower_lip.x)**2 + (upper_lip.y - lower_lip.y)**2)# 横向距离horizontal = math.sqrt((left_mouth.x - right_mouth.x)**2 + (left_mouth.y - right_mouth.y)**2)sar = vertical / horizontalreturn sardef detect_smile(landmarks):SAR_THRESHOLD = 0.5 # 根据实际测试调整sar = smile_aspect_ratio(landmarks)return sar > SAR_THRESHOLD -

集成到后端 API:

在

recognize_actions函数中添加微笑检测逻辑,并在任务流程中增加相应步骤。

后端实现对视频流或图片的人脸检测与动作识别功能,关键在于有效利用 MediaPipe 提供的高效人脸关键点提取功能,并基于这些关键点设计合理的动作识别算法。结合前端的摄像头捕捉和后端的高效处理,可以实现实时、准确的任务检测与反馈,提升用户体验。

附录: 关键点索引参考

MediaPipe Face Mesh 提供 468 个面部关键点,常用的一些关键点索引如下:

- 鼻尖:1

- 左眼外角:33

- 右眼外角:263

- 左眼上方:159

- 左眼下方:145

- 右眼上方:386

- 右眼下方:374

- 上唇上方:13

- 下唇下方:14

- 左嘴角:78

- 右嘴角:308

详细的关键点索引可以参考 MediaPipe Face Mesh 。

相关文章:

使用MediaPipe Face Mesh 面部动作检测

一、技术选型 OpenCV(Open Source Computer Vision Library) 用于视频流捕捉、图像预处理和基本图像处理操作。 MediaPipe 提供高效的人脸检测与关键点提取功能(Face Mesh)。 Python 作为后端开发语言,整合上述库进行…...

【Vue】<script setup>和 <script>区别是什么?在使用时的写法区别?

<script setup> 是 Vue 3 引入的一种新的脚本语法,它提供了一种更简洁和声明式的方式来编写组件逻辑。它是为了解决传统 <script> 标签在 Vue 单文件组件(SFC)中的一些局限性而设计的。 <script setup> 与 <script>…...

微服务框架,Http异步编程中,如何保证数据的最终一致性

一、背景 在微服务框架下,跨服务之间的调用,当遇到操作耗时或者量大的情况,我们一般会采用异步编程实现。 本文出现的问题是:异步回调过来时,却未查询到数据库中的任务,导致未能正常处理回调。 下面是当…...

vue3-dom-diff算法

vue3diff算法 什么是vue3diff算法 Vue3中的diff算法是一种用于比较虚拟DOM树之间差异的算法,其目的是为了高效地更新真实DOM,减少不必要的重渲染 主要过程 整个过程主要分为以下五步 前置预处理后置预处理仅处理新增仅处理后置处理包含新增、卸载、…...

年会抽奖Html

在这里插入图片描述 <!-- <video id"backgroundMusic" src"file:///D:/background.mp3" loop autoplay></video> --> <divstyle"width: 290px; height: 580px; margin-left: 20px; margin-top: 20px; background: url(D:/nianhu…...

ubuntu16 重启之后lvm信息丢失故障恢复

一、背景 1、问题背景 业务有一台物理开发服务器,文件系统有损坏;由于重启时没有检查,导致重启卡住。后面通过断电重新启动之后,无法进入系统;进入救援模式,注释数据盘挂载。重启之后进入系统,…...

】)

【华为OD-E卷 - 热点网站统计 100分(python、java、c++、js、c)】

【华为OD-E卷 - 热点网站统计 100分(python、java、c、js、c)】 题目 企业路由器的统计页面,有一个功能需要动态统计公司访问最多的网页URL top N。请设计一个算法,可以高效动态统计Top N的页面 输入描述 每一行都是一个URL或…...

Ubuntu下安装Android Sdk

下载android sdk命令行工具 https://developer.android.com/studio?hlzh-cn#command-tools mkdir android-sdk cd android-sdk unzip commandlinetools-linux-11076708_latest.zip 添加环境变量到~/.bashrc export ANDROID_HOME$HOME/android-sdk export PATH$PATH:$ANDRO…...

【JVM】总结篇-类的加载篇之 类的加载器 和ClassLoader分析

文章目录 类的加载器ClassLoader自定义类加载器双亲委派机制概念源码分析优势劣势如何打破Tomcat 沙箱安全机制JDK9 双亲委派机制变化 类的加载器 获得当前类的ClassLoader clazz.getClassLoader() 获得当前线程上下文的ClassLoader Thread.currentThread().getContextClassLoa…...

怎样修改el-table主题样式

起因:el-table有主题样式,部分需要单独设置 环境:ideanodejs插件谷歌浏览器 第一步:找到scss文件: 谷歌浏览器打开表格页面,ctrlshifti打开开发者工具,点击后鼠标移动到表格单元格上单击一下…...

MySQL(二)MySQL DDL数据库定义语言

1. MySQL DDL数据库定义语言 1.1. MySQL定义语言 进入MySQL mysql -u root -p(回车后输入密码,即可进入mysq1)1.1.1. 数据库操作 (1)查看数据库 mysql>show databases;注:MySQL语句分隔符为“;” mysql库很重要它里面有…...

Spring Boot 项目启动报 NoClassDefFoundError 异常的原因分析与解决方案 - jackson 版本不一致

目录 报错: 问题分析: 解决方案: 方案 1:对 Jackson 版本进行统一 方案 2:升级 Springfox 版本 方案 3:替换 Springfox 为 springdoc-openapi(推荐) 方案 4:排除冲突的 Jack…...

原型与原型链

什么是原型(对象) 在JavaScript中,每个对象都具有一个原型对象prototype,目的是:利用原型对象实现在同一原型链中的原型方法共享 在理解原型对象前,需要先了解什么是构造函数 构造函数 用来初始化对象的…...

【Linux】信号处理

一、Linux系统信号 1、常见的系统信号 常见的Linux系统信号 信号值描述1SIGHUP挂起(hang up)进程2SIGINT中断进(interrupt)程3SIGQUIT停止(stop)进程9SIGKILL无条件终止(terminate)…...

5个不同类型的mysql数据库安装

各种社区版本下载官方地址:MySQL :: MySQL Community Downloads 一、在线YUM仓库(Linux) 选择 MySQL Yum Repository 选择对应版本下载仓库安装包(No thanks, just start my download.) 下载方法1:下载到本…...

python学习笔记—12—布尔类型、if语句

1. 布尔类型 (1) 定义 (2) 比较运算符 (3) 代码演示 1. 手动定义 bool_1 True bool_2 False print(f"bool_1的内容是:{bool_1}, 类型是:{type(bool_1)}") print(f"bool_2的内容是:{bool_2}, 类型是:{type(bool…...

分数阶傅里叶变换代码 MATLAB实现

function Faf myfrft(f, a) %分数阶傅里叶变换函数 %输入参数: %f:原始信号 %a:阶数 %输出结果: %原始信号的a阶傅里叶变换N length(f);%总采样点数 shft rem((0:N-1)fix(N/2),N)1;%此项等同于fftshift(1:N),起到翻…...

《数据结构》期末考试测试题【中】

《数据结构》期末考试测试题【中】 21.循环队列队空的判断条件为?22. 单链表的存储密度比1?23.单链表的那些操作的效率受链表长度的影响?24.顺序表中某元素的地址为?25.m叉树第K层的结点数为?26. 在双向循环链表某节点…...

openwrt 清缓存命令行

一、查看缓存 : free -m 二、清缓存:echo 3 > /proc/sys/vm/drop_caches 三、详解。 释放物理页缓存 echo 1 > /proc/sys/vm/drop_caches 释放可回收的slab对象,包含inode and dentry echo 2 > /proc/sys/vm/drop_caches 同时…...

RP2K:一个面向细粒度图像的大规模零售商品数据集

这是一种用于细粒度图像分类的新的大规模零售产品数据集。与以往专注于相对较少产品的数据集不同,我们收集了2000多种不同零售产品的35万张图像,这些图像直接在真实的零售商店的货架上拍摄。我们的数据集旨在推进零售对象识别的研究,该研究具…...

Swagger和OpenApi的前世今生

Swagger与OpenAPI的关系演进是API标准化进程中的重要篇章,二者共同塑造了现代RESTful API的开发范式。 本期就扒一扒其技术演进的关键节点与核心逻辑: 🔄 一、起源与初创期:Swagger的诞生(2010-2014) 核心…...

AI书签管理工具开发全记录(十九):嵌入资源处理

1.前言 📝 在上一篇文章中,我们完成了书签的导入导出功能。本篇文章我们研究如何处理嵌入资源,方便后续将资源打包到一个可执行文件中。 2.embed介绍 🎯 Go 1.16 引入了革命性的 embed 包,彻底改变了静态资源管理的…...

Linux 中如何提取压缩文件 ?

Linux 是一种流行的开源操作系统,它提供了许多工具来管理、压缩和解压缩文件。压缩文件有助于节省存储空间,使数据传输更快。本指南将向您展示如何在 Linux 中提取不同类型的压缩文件。 1. Unpacking ZIP Files ZIP 文件是非常常见的,要在 …...

)

uniapp 集成腾讯云 IM 富媒体消息(地理位置/文件)

UniApp 集成腾讯云 IM 富媒体消息全攻略(地理位置/文件) 一、功能实现原理 腾讯云 IM 通过 消息扩展机制 支持富媒体类型,核心实现方式: 标准消息类型:直接使用 SDK 内置类型(文件、图片等)自…...

mac:大模型系列测试

0 MAC 前几天经过学生优惠以及国补17K入手了mac studio,然后这两天亲自测试其模型行运用能力如何,是否支持微调、推理速度等能力。下面进入正文。 1 mac 与 unsloth 按照下面的进行安装以及测试,是可以跑通文章里面的代码。训练速度也是很快的。 注意…...

Elastic 获得 AWS 教育 ISV 合作伙伴资质,进一步增强教育解决方案产品组合

作者:来自 Elastic Udayasimha Theepireddy (Uday), Brian Bergholm, Marianna Jonsdottir 通过搜索 AI 和云创新推动教育领域的数字化转型。 我们非常高兴地宣布,Elastic 已获得 AWS 教育 ISV 合作伙伴资质。这一重要认证表明,Elastic 作为 …...

小木的算法日记-多叉树的递归/层序遍历

🌲 从二叉树到森林:一文彻底搞懂多叉树遍历的艺术 🚀 引言 你好,未来的算法大神! 在数据结构的世界里,“树”无疑是最核心、最迷人的概念之一。我们中的大多数人都是从 二叉树 开始入门的,它…...

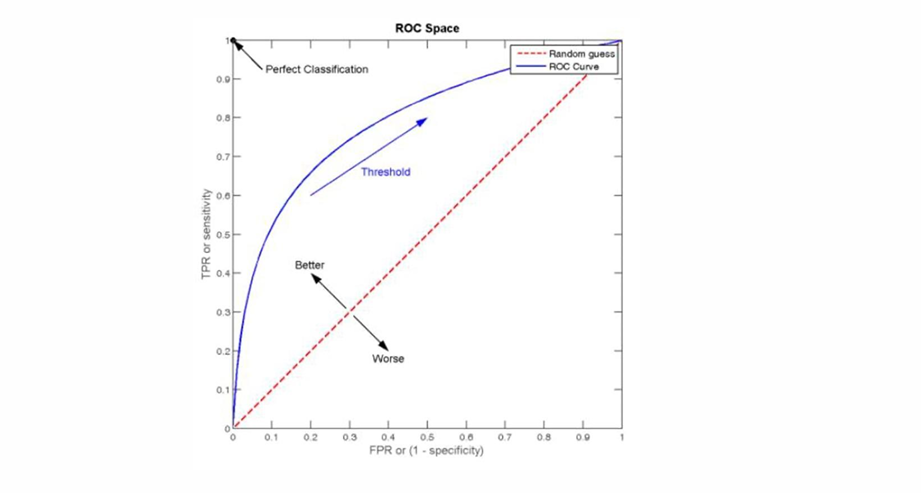

自然语言处理——文本分类

文本分类 传统机器学习方法文本表示向量空间模型 特征选择文档频率互信息信息增益(IG) 分类器设计贝叶斯理论:线性判别函数 文本分类性能评估P-R曲线ROC曲线 将文本文档或句子分类为预定义的类或类别, 有单标签多类别文本分类和多…...

之(六) ——通用对象池总结(核心))

怎么开发一个网络协议模块(C语言框架)之(六) ——通用对象池总结(核心)

+---------------------------+ | operEntryTbl[] | ← 操作对象池 (对象数组) +---------------------------+ | 0 | 1 | 2 | ... | N-1 | +---------------------------+↓ 初始化时全部加入 +------------------------+ +-------------------------+ | …...

数据库正常,但后端收不到数据原因及解决

从代码和日志来看,后端SQL查询确实返回了数据,但最终user对象却为null。这表明查询结果没有正确映射到User对象上。 在前后端分离,并且ai辅助开发的时候,很容易出现前后端变量名不一致情况,还不报错,只是单…...