Linux 环境(Ubuntu)部署 Hadoop 环境

前置准备

- 准备三台机器

cat /etc/hosts

192.168.1.7 hadoop-master

192.168.1.11 hadoop-slave01

192.168.1.12 hadoop-slave02

- Linux 环境

cat /etc/os-release

PRETTY_NAME="Ubuntu 24.10"

NAME="Ubuntu"

VERSION_ID="24.10"

VERSION="24.10 (Oracular Oriole)"

VERSION_CODENAME=oracular

ID=ubuntu

ID_LIKE=debian

HOME_URL="https://www.ubuntu.com/"

SUPPORT_URL="https://help.ubuntu.com/"

BUG_REPORT_URL="https://bugs.launchpad.net/ubuntu/"

PRIVACY_POLICY_URL="https://www.ubuntu.com/legal/terms-and-policies/privacy-policy"

UBUNTU_CODENAME=oracular

LOGO=ubuntu-logo

-

配置三台机器免密登录

参考https://blog.csdn.net/xchenhao/article/details/105005312 -

在三台机器配置 JDK 环境

参考https://blog.csdn.net/xchenhao/article/details/144866090 -

Hadoop

下载https://hadoop.apache.org/releases.html

规划

| hadoop-master | hadoop-slave01 | hadoop-slave02 | |

|---|---|---|---|

| HDFS | NameNode DataNode | DataNode | Secondary NameNode |

| YARN | NodeManager JobHistoryServer | ResourceManager NodeManager | NodeManager |

操作

在 hadoop-master 执行

# 下载 hadoop 压缩包

$ wget https://dlcdn.apache.org/hadoop/common/hadoop-3.4.1/hadoop-3.4.1.tar.gz$ mkdir /opt

$ tar xvf hadoop-3.4.1.tar.gz -C /opt$ cd /opt/hadoop-3.4.1# 配置 HADOOP_HOME 环境变量

$ echo 'export HADOOP_HOME=/opt/hadoop-3.4.1' >> /etc/profile

# 将 hadoop 相关命令添加至 PATH 中

$ echo 'export PATH=$HADOOP_HOME/bin:$PATH' >> /etc/profile

source /etc/profile# 查看 hadoop 版本

$ hadoop version

Hadoop 3.4.1

Source code repository https://github.com/apache/hadoop.git -r 4d7825309348956336b8f06a08322b78422849b1

Compiled by mthakur on 2024-10-09T14:57Z

Compiled on platform linux-x86_64

Compiled with protoc 3.23.4

From source with checksum 7292fe9dba5e2e44e3a9f763fce3e680

This command was run using /opt/hadoop-3.4.1/share/hadoop/common/hadoop-common-3.4.1.jar# 创建 hadoop 数据目录

$ mkdir $HADOOP_HOME/data

在 hadoop-master 调整配置

$HADOOP_HOME/etc/hadoop/hadoop-env.sh

在文件中添加

JAVA_HOME=/opt/jdk1.8.0_431

$HADOOP_HOME/etc/hadoop/core-site.xml

<configuration><!--hdfs 的 配置--><!-- 设置 namenode 节点 --><!-- 注意: hadoop1.x时代默认端⼝9000 hadoop2.x时代默认端⼝8020 hadoop3.x时 代默认端⼝ 9820 --><property><name>fs.defaultFS</name><value>hdfs://hadoop-master:9820</value></property> <!-- hdfs的基础路径,被其他属性所依赖的⼀个基础路径 --><property><name>hadoop.tmp.dir</name><value>/opt/hadoop-3.4.1/data</value></property><!--配置 HDFS 网页登录使用的静态用户为 xchenhao --><property><name>hadoop.http.staticuser.user</name><value>xchenhao</value></property>

</configuration>

$HADOOP_HOME/etc/hadoop/hdfs-site.xml

<configuration><!-- namenode 守护进程的http地址:主机名和端⼝号。参考守护进程布局 --><property><name>dfs.namenode.http-address</name><value>hadoop-master:9870</value></property><!--secondarynamenode 守护进程的 http 地址:主机名和端⼝号。参考守护进程布局 --><property><name>dfs.namenode.secondary.http-address</name><value>hadoop-slave02:9868</value></property>

</configuration>

$HADOOP_HOME/etc/hadoop/mapred-site.xml

<configuration><!--指定 MapReduce 程序运行在Yarn上--><property><name>mapreduce.framework.name</name><value>yarn</value></property><!--历史服务器端地址--><property><name>mapreduce.jobhistory.address</name><value>hadoop-master:10020</value></property><!--历史服务器 web 端地址--><property><name>mapreduce.jobhistory.webapp.address</name><value>hadoop-master:19888</value></property>

</configuration>

$HADOOP_HOME/etc/hadoop/workers

hadoop-master

hadoop-slave01

hadoop-slave02

$HADOOP_HOME/etc/hadoop/yarn-site.xml

<configuration><!--指定 MR 走 shuffle --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!--指定 ResourceManager 的地址--><property><name>yarn.resourcemanager.hostname</name><value>hadoop-slave01</value></property><!--环境变量的继承--><property><name>yarn.nodemanager.env-whitelist</name><value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value></property><!--开启日志聚集功能--><property><name>yarn.log-aggregation-enable</name><value>true</value></property><!--设置日志聚集服务器地址--><property><name>yarn.log.server.url</name><value>http://hadoop102:19888/jobhistory/logs</value></property><!--设置日志保留时间为7天--><property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value></property>

</configuration>

将 hadoop-master 相关文件分发至 hadoop-slave01、hadoop-slave02

| 文件或目录 |

|---|

| /opt/hadoop-3.4.1 |

| /etc/profile |

注:可用 rsync 命令进行文件分发 xrsync.sh /opt/hadoop-3.4.1

脚本如下:

#!/bin/bash#1. 判断参数个数

if [ $# -lt 1 ]

thenecho Not Enough Arguement!exit;

fi#2. 遍历集群所有机器

for host in hadoop-master hadoop-slave01 hadoop-slave02

doecho ==================== $host ====================#3. 遍历所有目录,挨个发送for file in $@do#4. 判断文件是否存在if [ -e $file ]then#5. 获取父目录pdir=$(cd -P $(dirname $file); pwd)#6. 获取当前文件的名称fname=$(basename $file)ssh $host "mkdir -p $pdir"rsync -av $pdir/$fname $host:$pdirelseecho $file does not exists!fidone

done

验证

(1)准备群集启/停脚本 xhadoop.sh

脚本如下:

#!/bin/bashif [ $# -lt 1 ]

thenecho "No Args Input..."exit ;

ficase $1 in

"start")echo " =================== 启动hadoop集群==================="echo " ---------------启动hdfs ---------------"ssh hadoop-master "source /etc/profile && $HADOOP_HOME/sbin/start-dfs.sh"echo " ---------------启动yarn ---------------"ssh hadoop-slave01 "source /etc/profile && $HADOOP_HOME/sbin/start-yarn.sh"echo " ---------------启动historyserver ---------------"ssh hadoop-master "source /etc/profile && $HADOOP_HOME/bin/mapred --daemon start historyserver"

;;

"stop")echo " =================== 关闭hadoop集群==================="echo " ---------------关闭historyserver ---------------"ssh hadoop-master "source /etc/profile && $HADOOP_HOME/bin/mapred --daemon stop historyserver"echo " ---------------关闭yarn ---------------"ssh hadoop-slave01 "source /etc/profile && $HADOOP_HOME/sbin/stop-yarn.sh"echo " ---------------关闭hdfs ---------------"ssh hadoop-master "source /etc/profile && $HADOOP_HOME/sbin/stop-dfs.sh"

;;

*)echo "Input Args Error..."

;;

esac

(2)启动集群

$ xhadoop.sh start=================== 启动hadoop集群===================---------------启动hdfs ---------------

Starting namenodes on [hadoop-master]

Starting datanodes

Starting secondary namenodes [hadoop-slave02]---------------启动yarn ---------------

Starting resourcemanager

Starting nodemanagers---------------启动historyserver ---------------

(3)查看各机器 hadoop 组件进程

$ jpsall.sh

=============== hadoop-master ===============

12245 DataNode

12549 NodeManager

12729 JobHistoryServer

12108 NameNode

12959 Jps

=============== hadoop-slave01 ===============

11584 DataNode

12368 Jps

11907 NodeManager

11775 ResourceManager

=============== hadoop-slave02 ===============

7446 SecondaryNameNode

7558 NodeManager

7309 DataNode

7791 Jps

脚本如下

#!/bin/shfor host in hadoop-master hadoop-slave01 hadoop-slave02

doecho =============== $host ===============ssh $host "source /etc/profile && $JAVA_HOME/bin/jps"

done

(4)相关后台

| NameNode 相关信息 Web 后台 | http://hadoop-master:9870 |

| Yarn Web 后台 | http://hadoop-slave01:8088 |

| HistoryServer 后台 | http://hadoop-master:19888 |

(5)停止集群

$ xhadoop.sh stop

$ jpsall.sh

参考

https://blog.csdn.net/huxili2020/article/details/117809913

相关文章:

部署 Hadoop 环境)

Linux 环境(Ubuntu)部署 Hadoop 环境

前置准备 准备三台机器 cat /etc/hosts 192.168.1.7 hadoop-master 192.168.1.11 hadoop-slave01 192.168.1.12 hadoop-slave02Linux 环境 cat /etc/os-release PRETTY_NAME"Ubuntu 24.10" NAME"Ubuntu" VERSION_ID"24.10" VERSION"24.…...

如何在Windows 11 WSL2 Ubuntu 环境下安装和配置perf性能分析工具?

在Windows 11 WSL2 Ubuntu 环境下完整安装和配置perf性能分析工具 一、背景二、准备工作三、获取并编译Linux内核源码四、安装和配置perf五、测试perf六、总结 一、背景 由于WSL2使用的是微软定制的内核,并非标准的Ubuntu内核,因此直接使用apt安装linux…...

Docker运维高级容器技术知识点总结

1、虚拟机部署和容器化部署的区别是什么? 1、技术基础: <1>.虚拟化技术在物理硬件上创建虚拟机,每台虚拟机运行自己完整的操作系统、从而实现资源隔离。 <2>.容器化技术:将应用程序打包在容器内,在进程空间…...

react-quill 富文本组件编写和应用

index.tsx文件 import React, { useRef, useState } from react; import { Modal, Button } from antd; import RichEditor from ./RichEditor;const AnchorTouchHistory: React.FC () > {const editorRef useRef<any>(null);const [isModalVisible, setIsModalVis…...

LabVIEW轴承性能测试系统

本文介绍了基于LabVIEW的高效轴承性能测试系统的设计与开发。系统通过双端驱动技术实现高精度同步控制,针对轴承性能进行全面的测试与分析,以提高轴承的可靠性和寿命。 项目背景 随着工业自动化程度的提高,对轴承的性能要求越来越高。传统的…...

【《游戏编程模式》实战04】状态模式实现敌人AI

目录 1、状态模式 2、使用工具 3、状态模式适用范围 4、实现内容 5、代码及思路 Enemy.cs EnemyState.cs 6、unity里的设置 7、运行效果展示 1、状态模式 “允许一个对象在其内部状态改变时改变自身的行为。对象看起来好像是在修改自身类。” 就是一个对象能随着自己…...

借助免费GIS工具箱轻松实现las点云格式到3dtiles格式的转换

在当今数字化浪潮下,地理信息系统(GIS)技术日新月异,广泛渗透到城市规划、地质勘探、文化遗产保护等诸多领域。而 GISBox 作为一款功能强大且易用的 GIS 工具箱,以轻量级、免费使用、操作便捷等诸多优势,为…...

科研绘图系列:R语言科研绘图之标记热图(heatmap)

禁止商业或二改转载,仅供自学使用,侵权必究,如需截取部分内容请后台联系作者! 文章目录 介绍加载R包数据下载导入数据数据预处理画图系统信息参考介绍 科研绘图系列:R语言科研绘图之标记热图(heatmap) 加载R包 library(tidyverse) library(ggplot2) library(reshape)…...

【轻松学C:编程小白的大冒险】--- C语言简介 02

在编程的艺术世界里,代码和灵感需要寻找到最佳的交融点,才能打造出令人为之惊叹的作品。而在这座秋知叶i博客的殿堂里,我们将共同追寻这种完美结合,为未来的世界留下属于我们的独特印记。 【轻松学C:编程小白的大冒险】…...

《HeadFirst设计模式》笔记(上)

设计模式的目录: 1 设计模式介绍 要不断去学习如何利用其它开发人员的智慧与经验。学习前人的正统思想。 我们认为《Head First》的读者是一位学习者。 一些Head First的学习原则: 使其可视化将文字放在相关图形内部或附近,而不是放在底部…...

数据结构:ArrayList与顺序表

目录 📖一、什么是List 📖二、线性表 📖三、顺序表 🐬1、display()方法 🐬2、add(int data)方法 🐬3、add(int pos, int data)方法 🐬4、contains(int toFind)方法 🐬5、inde…...

SpringBoot之核心配置

学习目标: 1.熟悉Spring Boot全局配置文件的使用 2.掌握Spring Boot配置文件属性值注入 3.熟悉Spring Boot自定义配置 4.掌握Profile多环境配置 5.了解随机值设置以及参数间引用 1.全局配置文件 Spring Boot使用 application.properties 或者application.yaml 的文…...

EasyExcel上传校验文件错误信息放到文件里以Base64 返回给前端

产品需求: 前端上传个csv 或 excel 文件,文件共4列,验证文件大小,类型,文件名长度,文件内容,如果某行某个单元格数据验证不通过,就把错误信息放到这行第五列,然后把带有…...

单片机软件定时器V4.0

单片机软件定时器V4.0 用于单片机定时执行任务等,比如LED GPIO等定时控制,内置前后台工作模式 头文件有使用例子 #ifndef __SORFTIME_APP_H #define __SORFTIME_APP_H#ifdef __cplusplus extern "C" { #endif#include <stdint.h>// #…...

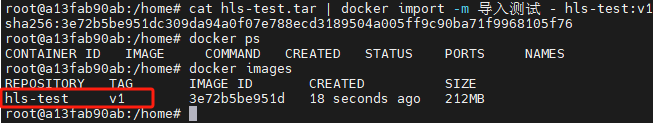

超完整Docker学习记录,Docker常用命令详解

前言 关于国内拉取不到docker镜像的问题,可以利用Github Action将需要的镜像转存到阿里云私有仓库,然后再通过阿里云私有仓库去拉取就可以了。 参考项目地址:使用Github Action将国外的Docker镜像转存到阿里云私有仓库 一、Docker简介 Do…...

C++ 入门第26天:文件与流操作基础

往期回顾: C 入门第23天:Lambda 表达式与标准库算法入门-CSDN博客 C 入门第24天:C11 多线程基础-CSDN博客 C 入门第25天:线程池(Thread Pool)基础-CSDN博客 C 入门第26天:文件与流操作基础 前言…...

使用python将多个Excel表合并成一个表

import pandas as pd# 定义要合并的Excel文件路径和名称 file_paths [file1.xlsx, file2.xlsx, file3.xlsx, file4.xlsx, file5.xlsx]# 创建一个空的DataFrame来存储合并后的数据 merged_data pd.DataFrame()# 循环遍历每个Excel文件,并读取其中的数据 for file_p…...

find_shape_model_3d_recompute_score)

halcon三维点云数据处理(七)find_shape_model_3d_recompute_score

目录 一、find_shape_model_3d_recompute_score例程代码二、set_object_model_3d_attrib_mod函数三、prepare_object_model_3d 函数四、create_cube_shape_model_3d函数五、获得CamPose六、project_cube_image函数七、find_shape_model_3d函数八、project_shape_model_3d函数 一…...

vue js实现时钟以及刻度效果

2025.01.08今天我学习如何用js实现时钟样式,效果如下: 一、html代码如下: <template><!--圆圈--><div class"notice_border"><div class"notice_position notice_name_class" v-for"item in …...

unity学习15:预制体prefab

目录 1 创建多个gameobject 2 创建prefab 2.1 创建prefab (类) 2.2 prefab 是一个文件 2.3 prefab可以导出 3 创建prefab variant (子类) 3.1 除了创建多个独立的prefab, 还可以创建 prefab variant 3.2 他…...

基于Flask实现的医疗保险欺诈识别监测模型

基于Flask实现的医疗保险欺诈识别监测模型 项目截图 项目简介 社会医疗保险是国家通过立法形式强制实施,由雇主和个人按一定比例缴纳保险费,建立社会医疗保险基金,支付雇员医疗费用的一种医疗保险制度, 它是促进社会文明和进步的…...

tree 树组件大数据卡顿问题优化

问题背景 项目中有用到树组件用来做文件目录,但是由于这个树组件的节点越来越多,导致页面在滚动这个树组件的时候浏览器就很容易卡死。这种问题基本上都是因为dom节点太多,导致的浏览器卡顿,这里很明显就需要用到虚拟列表的技术&…...

优选算法第十二讲:队列 + 宽搜 优先级队列

优选算法第十二讲:队列 宽搜 && 优先级队列 1.N叉树的层序遍历2.二叉树的锯齿型层序遍历3.二叉树最大宽度4.在每个树行中找最大值5.优先级队列 -- 最后一块石头的重量6.数据流中的第K大元素7.前K个高频单词8.数据流的中位数 1.N叉树的层序遍历 2.二叉树的锯…...

Python Ovito统计金刚石结构数量

大家好,我是小马老师。 本文介绍python ovito方法统计金刚石结构的方法。 Ovito Identify diamond structure命令可以识别和统计金刚石结构,但是无法直接输出结构的变化情况。 本文使用python调用ovito包的方法,可以持续统计各步的金刚石结构,具体代码如下: from ovito…...

)

C++课设:简易日历程序(支持传统节假日 + 二十四节气 + 个人纪念日管理)

名人说:路漫漫其修远兮,吾将上下而求索。—— 屈原《离骚》 创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊) 专栏介绍:《编程项目实战》 目录 一、为什么要开发一个日历程序?1. 深入理解时间算法2. 练习面向对象设计3. 学习数据结构应用二、核心算法深度解析…...

详细解析)

Caliper 负载(Workload)详细解析

Caliper 负载(Workload)详细解析 负载(Workload)是 Caliper 性能测试的核心部分,它定义了测试期间要执行的具体合约调用行为和交易模式。下面我将全面深入地讲解负载的各个方面。 一、负载模块基本结构 一个典型的负载模块(如 workload.js)包含以下基本结构: use strict;/…...

如何应对敏捷转型中的团队阻力

应对敏捷转型中的团队阻力需要明确沟通敏捷转型目的、提升团队参与感、提供充分的培训与支持、逐步推进敏捷实践、建立清晰的奖励和反馈机制。其中,明确沟通敏捷转型目的尤为关键,团队成员只有清晰理解转型背后的原因和利益,才能降低对变化的…...

)

安卓基础(Java 和 Gradle 版本)

1. 设置项目的 JDK 版本 方法1:通过 Project Structure File → Project Structure... (或按 CtrlAltShiftS) 左侧选择 SDK Location 在 Gradle Settings 部分,设置 Gradle JDK 方法2:通过 Settings File → Settings... (或 CtrlAltS)…...

elementUI点击浏览table所选行数据查看文档

项目场景: table按照要求特定的数据变成按钮可以点击 解决方案: <el-table-columnprop"mlname"label"名称"align"center"width"180"><template slot-scope"scope"><el-buttonv-if&qu…...

嵌入式常见 CPU 架构

架构类型架构厂商芯片厂商典型芯片特点与应用场景PICRISC (8/16 位)MicrochipMicrochipPIC16F877A、PIC18F4550简化指令集,单周期执行;低功耗、CIP 独立外设;用于家电、小电机控制、安防面板等嵌入式场景8051CISC (8 位)Intel(原始…...