【Python爬虫(29)】爬虫数据生命线:质量评估与监控全解

【Python爬虫】专栏简介:本专栏是 Python 爬虫领域的集大成之作,共 100 章节。从 Python 基础语法、爬虫入门知识讲起,深入探讨反爬虫、多线程、分布式等进阶技术。以大量实例为支撑,覆盖网页、图片、音频等各类数据爬取,还涉及数据处理与分析。无论是新手小白还是进阶开发者,都能从中汲取知识,助力掌握爬虫核心技能,开拓技术视野。

目录

- 一、数据质量评估指标体系搭建

- 1.1 准确性

- 1.2 完整性

- 1.3 一致性

- 1.4 时效性

- 二、工具助力数据质量监控

- 2.1 数据异常值检测工具与方法

- 2.2 重复值检查工具与实践

- 2.3 专业爬虫监控工具介绍

- 三、基于评估结果的数据优化与改进

- 3.1 数据清洗策略

- 3.2 爬虫策略调整

- 3.3 持续监控与优化

一、数据质量评估指标体系搭建

在 Python 爬虫的实际应用中,建立一套完善的数据质量评估指标体系是确保数据价值的关键。这一体系主要涵盖准确性、完整性、一致性和时效性四个重要方面。

1.1 准确性

数据准确性是指爬虫获取的数据与目标网站原始数据的匹配程度,确保数据的真实可靠 。在爬虫过程中,数据错误的产生原因多种多样。比如解析错误,当网页结构发生变化,而爬虫的解析规则未及时更新时,就可能导致数据提取错误。以使用 BeautifulSoup 库解析 HTML 页面为例,如果原本通过特定 class 属性提取数据,而网站将该 class 名称修改,爬虫就会提取到错误或无关的数据。

网站的反爬干扰也是重要因素。一些网站为了防止数据被恶意抓取,会采取反爬措施,如动态加载数据、验证码验证等。当爬虫未能有效处理这些反爬机制时,可能获取到不完整或错误的数据。比如在爬取某电商网站商品价格时,网站通过 JavaScript 动态加载价格信息,若爬虫无法执行 JavaScript 代码,就可能获取不到准确的价格数据。

1.2 完整性

完整性要求爬虫获取的数据应包含目标数据的全部字段和记录。在实际爬取中,数据缺失的情况并不少见。比如关键字段缺失,在爬取新闻网站时,可能出现文章标题、正文等关键信息缺失的情况,这会严重影响后续对新闻内容的分析。还有可能是部分页面数据未抓取,由于网络波动、请求超时等原因,爬虫可能跳过某些页面,导致数据不完整。

数据缺失对分析的影响巨大。若进行舆情分析时,缺失关键评论数据,可能会得出片面甚至错误的结论;在市场调研中,缺失部分产品的价格或销量数据,会影响对市场趋势的准确判断。

1.3 一致性

数据一致性强调数据在不同来源或不同时间的格式、定义和逻辑关系保持统一。在爬虫场景中,数据不一致的表现较为明显。不同页面相同字段格式不同,在爬取多个论坛的用户信息时,有的论坛用户注册时间格式为 “YYYY - MM - DD”,有的则为 “MM/DD/YYYY”,这会给数据整合和分析带来困难。

当进行用户行为分析时,不一致的时间格式会导致时间序列分析无法正常进行,难以准确把握用户行为的时间规律。在整合多源数据进行数据分析时,不一致的数据格式需要耗费大量时间和精力进行清洗和转换,降低了数据分析的效率。

1.4 时效性

数据时效性指数据能够反映当前最新情况的程度。在新闻、金融等领域,数据的时效性尤为重要。在新闻数据爬取中,及时获取最新的新闻资讯,才能让用户第一时间了解事件动态。若爬虫获取的数据滞后,新闻就失去了其及时性和价值。

金融数据更是如此,股票价格、汇率等金融数据瞬息万变。以股票市场为例,投资者需要实时获取股票价格数据来做出投资决策。若爬虫获取的数据延迟,投资者依据这些滞后数据进行交易,可能会遭受巨大的经济损失。

二、工具助力数据质量监控

在 Python 爬虫的数据质量监控中,借助专业工具和方法能够更高效地发现和解决数据问题。下面将详细介绍异常值检测、重复值检查以及专业爬虫监控工具的使用。

2.1 数据异常值检测工具与方法

异常值是指数据集中与其他数据点显著不同的数据,它们可能由数据录入错误、测量误差或真实的异常情况导致。在爬虫获取的数据中,异常值会对数据分析结果产生重大影响。

Z - Score 是一种常用的异常值检测方法,它基于数据的均值和标准差来判断数据点是否为异常值。具体来说,对于一个数据点x,其 Z - Score 的计算公式为: ,其中

,其中 是数据集的均值,

是数据集的均值, 是数据集的标准差。一般认为,当(|Z| > 3)时,数据点(x)可能是异常值。

是数据集的标准差。一般认为,当(|Z| > 3)时,数据点(x)可能是异常值。

在 Python 中,使用numpy库可以方便地实现 Z - Score 方法:

import numpy as npdef z_score_detection(data):mean = np.mean(data)std = np.std(data)z_scores = np.abs((data - mean) / std)outliers = data[z_scores > 3]return outliers

Z - Score 方法适用于数据近似服从正态分布的情况,其优点是计算简单、直观,能够快速识别出明显偏离均值的数据点。但它对数据分布有较强的假设,如果数据不服从正态分布,可能会误判或漏判异常值。

Isolation Forest(孤立森林)是一种基于树的异常值检测算法,特别适用于高维数据。它的核心思想是通过随机选择特征和切分点,构建多棵决策树,将数据点划分到不同的叶节点。由于异常点在数据集中是少数且与其他数据点不同,它们更容易被孤立,即在树中的路径长度较短。

使用sklearn库中的IsolationForest类可以实现该算法:

from sklearn.ensemble import IsolationForestdef isolation_forest_detection(data):model = IsolationForest(contamination=0.05)predictions = model.fit_predict(data)outliers = data[predictions == -1]return outliers

这里contamination参数表示数据集中异常值的比例,可根据实际情况调整。Isolation Forest 算法不需要对数据分布进行假设,能够处理高维数据,并且在大规模数据上表现良好。不过,它对参数设置较为敏感,不同的参数可能会导致不同的检测结果。

2.2 重复值检查工具与实践

在爬虫获取的数据中,重复值的出现会占用存储空间,降低数据分析效率,甚至可能导致错误的分析结果。因此,及时检查和删除重复值是数据质量监控的重要环节。

在 Python 中,pandas库提供了强大的重复值处理功能。duplicated()函数用于判断数据中是否存在重复行,drop_duplicates()函数则用于删除重复行。

例如,假设有一个爬虫获取的新闻数据DataFrame,包含title(标题)、content(内容)和published_time(发布时间)等字段,要检查并删除重复的新闻数据,可以这样操作:

import pandas as pd# 假设df是爬虫获取的新闻数据

df = pd.read_csv('news_data.csv')# 判断重复行

duplicate_rows = df.duplicated()

print("重复行数量:", duplicate_rows.sum())# 删除重复行,保留第一次出现的行

df = df.drop_duplicates(keep='first')

print("删除重复行后的数据行数:", len(df))

在实际应用中,还可以指定某些列进行重复值判断。比如,只根据title列判断新闻是否重复:

duplicate_by_title = df.duplicated(subset=['title'], keep='first')

df = df.drop_duplicates(subset=['title'], keep='first')

通过以上方法,可以有效地清理爬虫数据中的重复值,提高数据的质量和可用性。

2.3 专业爬虫监控工具介绍

除了上述针对数据异常值和重复值的检测工具,还有一些专业的爬虫监控工具,能够对爬虫的运行状态和数据质量进行全面监控。

Spidermon 是一款专为 Scrapy 爬虫框架设计的监控扩展工具,它提供了数据验证、统计监控和通知系统等功能。通过 Spidermon,可以设置自定义的数据验证规则,确保抓取的数据符合预期格式和内容要求。例如,在爬取电商网站商品信息时,可以验证商品价格是否为正数、商品名称是否为空等。

安装 Spidermon 非常简单,使用pip命令即可:

pip install spidermon

在 Scrapy 项目中集成 Spidermon 后,可以在配置文件中定义监控规则和通知方式。例如,通过邮件通知爬虫运行过程中的错误和异常:

# settings.py

SPIDERMON_ENABLED = True

SPIDERMON_SEND_NOTIFICATIONS = True

SPIDERMON_NOTIFICATION_BACKENDS = ('spidermon.contrib.notifications.mail.MailNotification',

)

SPIDERMON_MAIL_FROM = 'your_email@example.com'

SPIDERMON_MAIL_TO = ['recipient_email@example.com']

SPIDERMON_MAIL_HOST ='smtp.example.com'

SPIDERMON_MAIL_PORT = 587

SPIDERMON_MAIL_USER = 'your_email@example.com'

SPIDERMON_MAIL_PASSWORD = 'your_password'

CrawlerMonitor 是一个开源的网络爬虫监控系统,它基于 Python 开发,结合了 Flask、React、Elasticsearch 和 Kibana 等技术,提供了实时监控和管理网络爬虫访问行为的能力。通过 CrawlerMonitor,可以直观地查看爬虫的运行状态、请求频率、响应时间等指标,及时发现爬虫运行中的问题。

安装 CrawlerMonitor 需要先安装 Docker 和 Docker Compose,然后通过以下步骤启动:

# 克隆项目

git clone https://github.com/adrian9631/CrawlerMonitor.git

# 进入项目目录

cd CrawlerMonitor

# 启动服务

docker-compose up -d

启动后,通过浏览器访问http://localhost:指定端口即可打开 CrawlerMonitor 的监控界面,根据界面提示进行配置和使用。

这些专业爬虫监控工具能够帮助开发者更全面、更高效地监控爬虫的数据质量和运行状态,及时发现并解决问题,确保爬虫项目的稳定运行和数据的高质量获取。

三、基于评估结果的数据优化与改进

在完成数据质量评估与监控后,基于评估结果对数据和爬虫策略进行优化改进是确保数据价值和爬虫效率的关键环节。下面将从数据清洗策略、爬虫策略调整以及持续监控与优化三个方面进行详细阐述。

3.1 数据清洗策略

根据数据质量评估中发现的异常值、重复值和错误数据等问题,需要制定针对性的数据清洗策略。在 Python 中,利用pandas库可以高效地实现数据清洗操作。

对于异常值处理,若在爬取的商品价格数据中发现存在明显不合理的价格(如负数价格),可以使用pandas的条件筛选功能进行处理。假设数据存储在DataFrame对象df中,价格列名为price,则可以使用以下代码删除异常值:

import pandas as pd# 读取数据

df = pd.read_csv('product_data.csv')# 删除价格为负数的异常值

df = df[df['price'] > 0]

对于重复值,如前所述,可以使用duplicated()和drop_duplicates()函数进行检查和删除。如果要保留重复值中最新的数据(假设数据中有timestamp字段记录数据获取时间),可以按照以下方式操作:

# 按照timestamp降序排列

df = df.sort_values(by='timestamp', ascending=False)# 删除重复值,保留第一次出现的(即最新的)

df = df.drop_duplicates(subset=['product_id'], keep='first')

针对错误数据,例如在爬取的用户年龄数据中,出现了不符合常理的年龄值(如大于 120 岁),可以使用apply()函数结合自定义函数进行修正。假设年龄列名为age:

def correct_age(age):if age > 120:return None # 可以选择修正为合理值或设为缺失值return agedf['age'] = df['age'].apply(correct_age)

3.2 爬虫策略调整

数据质量问题往往与爬虫策略密切相关。例如,爬取频率过高可能导致被目标网站封禁,从而获取到不完整或错误的数据;爬取深度设置不当可能遗漏重要数据;并发设置不合理可能引发网络请求超时等问题。

如果在数据质量评估中发现大量数据缺失或请求超时的情况,可能是因为爬取频率过高,导致目标网站采取反制措施。此时,可以降低爬取频率,增加请求之间的时间间隔。在使用requests库进行网络请求时,可以通过time.sleep()函数实现:

import requests

import timeurl_list = ['http://example.com/page1', 'http://example.com/page2', 'http://example.com/page3']

for url in url_list:response = requests.get(url)# 处理响应数据time.sleep(5) # 每次请求后暂停5秒

若发现某些深层页面的数据无法获取,可能是爬取深度设置不足。以使用BeautifulSoup进行网页解析为例,在爬取多层链接时,可以增加递归深度:

from bs4 import BeautifulSoup

import requestsdef crawl(url, depth=0, max_depth=2):if depth > max_depth:returnresponse = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')# 处理当前页面数据for link in soup.find_all('a'):new_url = link.get('href')if new_url:crawl(new_url, depth + 1, max_depth)

3.3 持续监控与优化

数据质量监控是一个持续的过程,不能一蹴而就。建立定期数据质量评估机制至关重要,比如每周或每月对爬虫获取的数据进行一次全面的质量评估。通过长期监控数据质量指标的变化趋势,可以及时发现潜在问题,并针对性地改进爬虫和数据处理流程。

可以使用 Python 的schedule库来实现定期任务。例如,每周一凌晨 2 点执行数据质量评估任务:

import schedule

import timedef evaluate_data_quality():# 执行数据质量评估的代码passschedule.every().monday.at("02:00").do(evaluate_data_quality)while True:schedule.run_pending()time.sleep(1)

根据长期监控数据,若发现某个网站的数据质量一直不稳定,频繁出现异常值或数据缺失,可以对该网站单独制定爬虫策略,如调整请求头信息、更换代理 IP 等。同时,随着业务需求的变化和目标网站的更新,爬虫和数据处理流程也需要不断优化,以适应新的情况,确保数据质量始终满足要求。

相关文章:

【Python爬虫(29)】爬虫数据生命线:质量评估与监控全解

【Python爬虫】专栏简介:本专栏是 Python 爬虫领域的集大成之作,共 100 章节。从 Python 基础语法、爬虫入门知识讲起,深入探讨反爬虫、多线程、分布式等进阶技术。以大量实例为支撑,覆盖网页、图片、音频等各类数据爬取ÿ…...

VSCode AI提效工具,通义灵码前端开发体验

安装 安装依旧很简单,vs code拓展插件中搜索就出来了,记住下边这个图标。 亮点 新接入了deepseek-v3\deepseek-r1模型,不仅支持智能问答,而且增加了AI程序员,可以直接按照完成编码任务,修改优化代码&am…...

在实时大数据处理中如何平衡延迟和吞吐量

在实时大数据处理中,平衡延迟和吞吐量是一个至关重要的挑战。以下是一些实用的策略和技巧,有助于在这两者之间找到最佳平衡点: 一、技术层面的平衡策略 并行处理: 通过同时处理多个任务来提高吞吐量。在实时大数据处理环境中&am…...

一款开源可独立部署的知识管理工具!!

今天给大家介绍一款开源的知识管理工具——云策文档。 介绍 该系统通过独立的知识库空间,结构化地组织在线协作文档,实现知识的积累与沉淀,促进知识的复用与流通。同时支持多人协作文档。 云策文档设计了明确的权限管理,方便文档…...

罗德与施瓦茨SMB100A,一款卓越的中档模拟射频/微波信号源

罗德与施瓦茨R&S SMB100A 微波信号发生器 型 号:SMB100A 名 称:微波信号发生器 品 牌:罗德与施瓦茨(R&S) 分 类:射频测试设备 > 射频信号源 > 矢量信号源 产品属性:主机 简 述&…...

java毕业设计之医院门诊挂号系统(源码+文档)

风定落花生,歌声逐流水,大家好我是风歌,混迹在java圈的辛苦码农。今天要和大家聊的是一款基于ssm的医院门诊挂号系统。项目源码以及部署相关请联系风歌,文末附上联系信息 。 项目简介: 医院门诊挂号系统的主要使用者…...

【Scrapy】Scrapy教程7——存储数据

上一节我们对爬虫程序的默认回调函数parse做了改写,提取的数据可以在Scrapy的日志中打印出来了,光打印肯定是不行的,还需要把数据存储,数据可以存到文件,也可以存到数据库,我们一一来看。 存储数据到文件 首先我们看看如何将数据存储到文件,在讲[[【Scrapy】Scrapy教程…...

QILSTE H4-108TCG/5M高亮翠绿光LED灯珠 发光二极管LED

H4-108TCG/5M:高亮纯绿光LED的复杂特性与突发性挑战 在现代电子设备的复杂世界中,H4-108TCG/5M型号的高亮纯绿光LED以其独特的参数和复杂的特性脱颖而出。这款LED不仅在尺寸上做到了极致精巧,还在光电参数、可靠性测试和实际应用中展现出令人…...

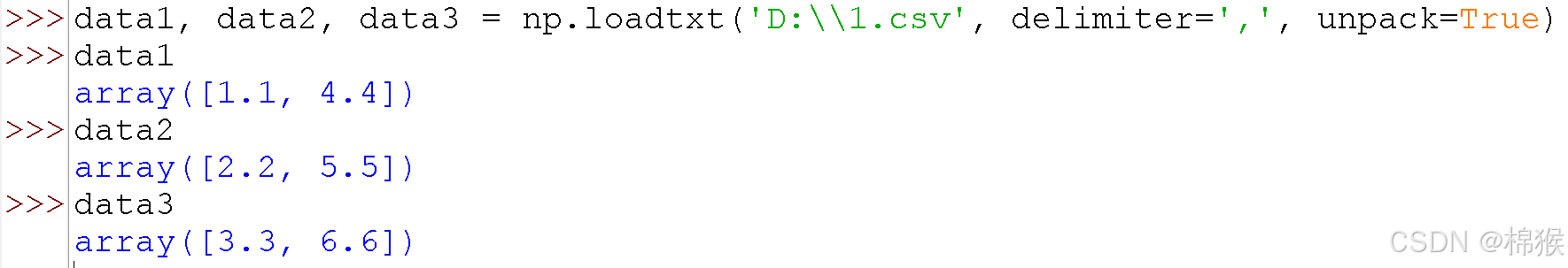

Python中numpy.loadtxt()函数的用法

numpy模块的loadtxt()函数用于快速读取简单格式文件的内容,常用于csv文件的读取。 1 loadtxt()函数的格式 loadtxt()函数的格式如图1所示,该函数的返回值是读取到的数据,其类型为numpy.ndarray。 图1 loadtxt()函数的格式 其中,…...

Windows系统安装GPU驱动/CUDA/cuDNN

1、驱动安装步骤 1.1下载驱动 通过浏览器访问Download The Official NVIDIA Drivers | NVIDIA 1.2安装驱动 1.3检查 打开【设备管理器】—【显示适配器】 2、CUDA安装步骤 2.1下载CUDA 官网链接CUDA Toolkit 12.4 Update 1 Downloads | NVIDIA 开发者 2.2安装CUDA 3、cuDN…...

nessus kali 卸载

安装请看这篇Nessus漏扫工具的安装与使用(Windows与Linux)_nessus license key-CSDN博客 Download Tenable Nessus | Tenable 离线安装 Tenable Nessus (Tenable Nessus 10.8) systemctl stop nessusd Remove Nessus Run the …...

使用Geotools读取DEM地形数据实战-以湖南省30米数据为例

目录 前言 一、DEM地形数据介绍 1、DEM数据简介 2、DEM应用领域 3、QGIS中读取DEM数据 二、GeoTools解析地形 1、Maven中依赖引用 2、获取数据基本信息 三、总结 前言 随着全球数字化进程的加速,各类地理空间数据呈爆炸式增长,DEM 数据作为其中的…...

基于WebGIS技术的校园地图导航系统架构与核心功能设计

本文专为IT技术人员、地理信息系统(GIS)开发者、智慧校园解决方案架构师及相关领域的专业人士撰写。本文提出了一套基于WebGIS技术的校园地图导航系统构建与优化方案,旨在为用户提供高效、智能、个性化的导航体验。如需获取校园地图导航系统技…...

)

《养生方法》(一)

一、基础生活习惯 饮食管理 均衡营养:每日摄入多彩蔬果(如胡萝卜、西兰花、柑橘类)补充维生素C/E及膳食纤维;搭配鱼类、豆制品等优质蛋白质,保障免疫系统正常运作 清淡规律:减少高油盐食物…...

Python常见面试题的详解9

1. 如何找出整数数组中第二大的数 要点 定义一个函数用于在整数数组里找出第二大的数。 若数组元素少于 2 个,则返回 None。 借助两个变量 first 和 second 来跟踪最大数和第二大数。 可以添加异常处理,以应对输入非整数数组的情况。 若数组包含重复…...

MAVSDK - Custom Mavlink处理

编译命令中开启 Custom Mavlink 编译 cmake -DCMAKE_BUILD_TYPERelease -DMAVLINK_DIALECTcustom -DBUILD_CUSTOM_MAVLINKON -DCUSTOM_MAVLINK_PATH"G:/Custom_Mavlink" -DBUILD_CUSTOM_PLUGINSON -DENABLED_CUSTOM_PLUGINS"speaker" -DENABLED_PLUGINS&qu…...

java每日精进 2.13 MySql迁移人大金仓

1.迁移数据库 1. 数据库创建语句 MySQL: CREATE DATABASE dbname; 人大金仓(Kingbase): 在人大金仓中,CREATE DATABASE 的语法通常相同,但可能需要特别注意字符集的指定(如果涉及到多语言支持…...

【R语言】回归分析与判别分析

一、线性回归分析 1、lm()函数 lm()函数是用于拟合线性模型(Linear Models)的主要函数。线性模型是一种统计方法,用于描述一个或多个自变量(预测变量、解释变量)与因变量(响应变量)之间的关系…...

ES6中Object.defineProperty 的详细用法和使用场景以及例子

ES6 Object.defineProperty() 用法总结 Object.defineProperty() 是 ES5 引入的一个方法,ES6 继续强化了该方法的使用,它允许我们为对象的属性定义或修改 属性描述符。它能够控制对象属性的行为,如读写权限、可枚举性和可配置性。 1. Objec…...

揭秘云计算 | 5、关于云计算效率的讨论

一、 公有云效率更高? 解:公有云具有更高的效率。首先我们需要知道效率到底指的是什么。这是个亟须澄清的概念。在这里效率是指云数据中心(我们将在后文中介绍其定义)中的IT设备资源利用率,其中最具有代表性的指标就是…...

VB.net复制Ntag213卡写入UID

本示例使用的发卡器:https://item.taobao.com/item.htm?ftt&id615391857885 一、读取旧Ntag卡的UID和数据 Private Sub Button15_Click(sender As Object, e As EventArgs) Handles Button15.Click轻松读卡技术支持:网站:Dim i, j As IntegerDim cardidhex, …...

模型参数、模型存储精度、参数与显存

模型参数量衡量单位 M:百万(Million) B:十亿(Billion) 1 B 1000 M 1B 1000M 1B1000M 参数存储精度 模型参数是固定的,但是一个参数所表示多少字节不一定,需要看这个参数以什么…...

在鸿蒙HarmonyOS 5中实现抖音风格的点赞功能

下面我将详细介绍如何使用HarmonyOS SDK在HarmonyOS 5中实现类似抖音的点赞功能,包括动画效果、数据同步和交互优化。 1. 基础点赞功能实现 1.1 创建数据模型 // VideoModel.ets export class VideoModel {id: string "";title: string ""…...

将对透视变换后的图像使用Otsu进行阈值化,来分离黑色和白色像素。这句话中的Otsu是什么意思?

Otsu 是一种自动阈值化方法,用于将图像分割为前景和背景。它通过最小化图像的类内方差或等价地最大化类间方差来选择最佳阈值。这种方法特别适用于图像的二值化处理,能够自动确定一个阈值,将图像中的像素分为黑色和白色两类。 Otsu 方法的原…...

uniapp中使用aixos 报错

问题: 在uniapp中使用aixos,运行后报如下错误: AxiosError: There is no suitable adapter to dispatch the request since : - adapter xhr is not supported by the environment - adapter http is not available in the build 解决方案&…...

C# 求圆面积的程序(Program to find area of a circle)

给定半径r,求圆的面积。圆的面积应精确到小数点后5位。 例子: 输入:r 5 输出:78.53982 解释:由于面积 PI * r * r 3.14159265358979323846 * 5 * 5 78.53982,因为我们只保留小数点后 5 位数字。 输…...

高效线程安全的单例模式:Python 中的懒加载与自定义初始化参数

高效线程安全的单例模式:Python 中的懒加载与自定义初始化参数 在软件开发中,单例模式(Singleton Pattern)是一种常见的设计模式,确保一个类仅有一个实例,并提供一个全局访问点。在多线程环境下,实现单例模式时需要注意线程安全问题,以防止多个线程同时创建实例,导致…...

MySQL 8.0 事务全面讲解

以下是一个结合两次回答的 MySQL 8.0 事务全面讲解,涵盖了事务的核心概念、操作示例、失败回滚、隔离级别、事务性 DDL 和 XA 事务等内容,并修正了查看隔离级别的命令。 MySQL 8.0 事务全面讲解 一、事务的核心概念(ACID) 事务是…...

破解路内监管盲区:免布线低位视频桩重塑停车管理新标准

城市路内停车管理常因行道树遮挡、高位设备盲区等问题,导致车牌识别率低、逃费率高,传统模式在复杂路段束手无策。免布线低位视频桩凭借超低视角部署与智能算法,正成为破局关键。该设备安装于车位侧方0.5-0.7米高度,直接规避树枝遮…...

ubuntu22.04有线网络无法连接,图标也没了

今天突然无法有线网络无法连接任何设备,并且图标都没了 错误案例 往上一顿搜索,试了很多博客都不行,比如 Ubuntu22.04右上角网络图标消失 最后解决的办法 下载网卡驱动,重新安装 操作步骤 查看自己网卡的型号 lspci | gre…...