《一文读懂Transformers库:开启自然语言处理新世界的大门》

《一文读懂Transformers库:开启自然语言处理新世界的大门》

GitHub - huggingface/transformers: 🤗 Transformers: State-of-the-art Machine Learning for Pytorch, TensorFlow, and JAX.

HF-Mirror

Hello! · Transformers快速入门

pip install transformers -i https://pypi.tuna.tsinghua.edu.cn/simple

import os

os.environ['HF_ENDPOINT'] = 'https://hf-mirror.com'

from datasets import load_dataset

dataset = load_dataset("数据集名称")import os os.environ["HF_ENDPOINT"] = "https://hf-mirror.com" from transformers import Trainer, TrainingArguments

一、引言:探索 NLP 领域的宝藏库

在自然语言处理(Natural Language Processing,NLP)这个充满无限可能与挑战的领域中,Transformers 库宛如一颗璀璨的明星,散发着独特的光芒。它为研究者和开发者们提供了一个强大且便捷的工具集,极大地推动了 NLP 技术的发展与应用。

从早期简单的文本分类任务,到如今复杂的机器翻译、文本生成、问答系统等,NLP 的应用场景不断拓展,对技术的要求也日益提高。而 Transformers 库的出现,如同一场及时雨,满足了人们在这些任务中对高效、准确模型的需求。

以机器翻译为例,在过去,传统的翻译模型往往难以准确捕捉语言之间复杂的语义和语法关系,翻译结果常常差强人意。但自从有了基于 Transformers 库构建的模型,机器翻译的质量得到了显著提升。它们能够更好地理解源语言的含义,并将其准确地转换为目标语言,使得跨国交流变得更加顺畅。

在文本生成领域,Transformers 库同样表现出色。无论是创作新闻报道、撰写故事,还是生成诗歌,基于该库的模型都能生成流畅、富有逻辑的文本。例如,一些智能写作助手利用 Transformers 库,能够根据用户输入的关键词和主题,快速生成高质量的文章大纲甚至完整内容,为创作者们节省了大量的时间和精力。

问答系统也是 NLP 的重要应用之一。Transformers 库使得问答系统能够理解复杂的问题,并从大量的文本中提取准确的答案。如今,智能客服、智能助手等应用广泛采用基于 Transformers 库的问答系统,为用户提供了更加智能、高效的服务。

可以说,Transformers 库已经成为 NLP 领域不可或缺的一部分,它为我们打开了一扇通往自然语言理解与生成的大门,让我们能够更加深入地探索语言的奥秘,实现更多令人惊叹的应用。在接下来的内容中,我们将深入探讨 Transformers 库的方方面面,揭开它神秘的面纱 。

二、Transformers 库初相识

(一)诞生背景与发展历程

在自然语言处理的早期发展阶段,研究人员主要依赖基于规则的系统和传统机器学习方法来处理文本。基于规则的系统需要人工编写大量的语法和语义规则,这是一个极其耗时且费力的过程,并且难以应对语言的多样性和复杂性。而传统机器学习方法,如朴素贝叶斯、支持向量机等,虽然在一定程度上提高了处理效率,但它们对于特征工程的要求较高,泛化能力也相对有限。

随着深度学习的兴起,神经网络开始在 NLP 领域崭露头角。循环神经网络(RNN)及其变体长短时记忆网络(LSTM)和门控循环单元(GRU),能够处理序列数据,捕捉文本中的长距离依赖关系,在语言建模、机器翻译等任务中取得了一定的成果。然而,RNN 存在梯度消失和梯度爆炸的问题,并且在处理长序列时计算效率较低,难以满足大规模数据处理的需求 。

在这样的背景下,2017 年,谷歌大脑团队在论文《Attention Is All You Need》中提出了 Transformer 模型。该模型摒弃了传统的 RNN 结构,完全基于自注意力(Self-Attention)机制,能够并行处理序列数据,大大提高了计算效率,同时在捕捉长距离依赖关系方面表现出色。Transformer 模型的提出,开启了 NLP 领域的新篇章,为后续一系列强大的预训练模型的诞生奠定了基础。

Hugging Face 团队敏锐地捕捉到了 Transformer 模型的巨大潜力,为了让研究人员和开发者更方便地使用这些先进的模型,他们开发了 Transformers 库。最初的 Transformers 库主要是对一些基本的 Transformer 模型进行了封装,提供了简单的 API 接口,使得用户可以快速加载和使用这些模型。随着时间的推移,越来越多基于 Transformer 架构的预训练模型被提出,如 BERT、GPT-2、RoBERTa 等,Transformers 库也不断更新迭代,将这些模型纳入其中,并持续优化库的性能和功能。

如今,Transformers 库已经成为 NLP 领域最受欢迎和广泛使用的工具之一,它不仅支持多种深度学习框架,如 PyTorch 和 TensorFlow,还涵盖了几乎所有主流的 NLP 任务,如文本分类、生成、摘要、问答等。同时,库中提供的预训练模型可以在不同的数据集上进行微调,以适应各种具体的应用场景,为 NLP 从业者节省了大量的时间和精力。

(二)Hugging Face 与 Transformers 库

Hugging Face 是一家专注于自然语言处理和人工智能的公司,成立于 2016 年,总部位于纽约市。起初,Hugging Face 以开发聊天机器人而闻名,但很快公司便将重心转向开发和发布 NLP 工具和资源,其中最具代表性的就是 Transformers 库。

Hugging Face 与 Transformers 库之间有着紧密且不可分割的联系。可以说,Hugging Face 是 Transformers 库的缔造者和主要推动者。公司的愿景是让 NLP 技术变得更加普及和易用,而 Transformers 库正是实现这一愿景的关键工具。Hugging Face 团队投入了大量的精力和资源,不断完善和扩展 Transformers 库的功能,使其成为一个强大而全面的 NLP 工具包。

作为一个开源库,Transformers 库的发展离不开社区的支持和贡献。Hugging Face 积极营造一个活跃的开源社区,吸引了全球各地的开发者和研究者参与其中。在这个社区中,用户可以分享自己的经验、代码和模型,共同探讨和解决问题。许多开发者基于 Transformers 库进行二次开发,提出了各种创新的应用和改进方案,进一步丰富了库的生态系统。

Hugging Face 还提供了 Model Hub,这是一个共享和下载预训练模型的平台。在 Model Hub 上,用户可以方便地找到各种基于 Transformer 架构的预训练模型,涵盖了不同的语言、任务和领域。这些模型可以直接下载使用,也可以根据自己的需求进行微调,极大地降低了使用 Transformer 模型的门槛。截至目前,Model Hub 上已经收录了数千个预训练模型,并且这个数量还在不断增长。

除了 Transformers 库和 Model Hub,Hugging Face 还开发了其他一些与 NLP 相关的工具和库,如 Datasets 库和 Tokenizers 库。Datasets 库提供了大量的 NLP 数据集,方便用户进行模型的训练和评估;Tokenizers 库则提供了高效的文本分词工具,支持 Transformer 模型的分词需求。这些工具和库相互配合,形成了一个完整的 NLP 开发工具链,为开发者提供了全方位的支持。

Hugging Face 通过开源 Transformers 库和构建活跃的社区,极大地推动了 Transformer 模型在 NLP 领域的应用和发展。它使得 Transformer 模型不再是少数研究机构和大型企业的专利,而是让更多的开发者和研究者能够轻松地使用这些先进的技术,为 NLP 领域的创新和发展注入了新的活力 。

三、核心原理:Transformer 模型架构解析

(一)Transformer 模型的起源

2017 年,谷歌大脑团队发表了一篇名为《Attention Is All You Need》的论文,在这篇具有开创性意义的论文中,Transformer 模型首次被提出。当时,自然语言处理领域主要依赖于循环神经网络(RNN)及其变体,如长短时记忆网络(LSTM)和门控循环单元(GRU)来处理序列数据 。

然而,RNN 存在着一些固有的缺陷。其一,RNN 在处理长序列时会面临梯度消失和梯度爆炸的问题。由于 RNN 的循环结构,梯度在反向传播过程中需要经过多次乘法运算,随着序列长度的增加,梯度可能会变得非常小(梯度消失),导致模型难以学习到长距离的依赖关系;或者梯度变得非常大(梯度爆炸),使得模型训练不稳定。其二,RNN 的计算过程是顺序进行的,难以并行化,这在处理大规模数据时效率较低,无法充分利用现代硬件的并行计算能力。

为了解决这些问题,Transformer 模型应运而生。它的最大创新之处在于摒弃了传统的 RNN 结构,完全基于自注意力(Self-Attention)机制来构建。自注意力机制允许模型在处理序列时,能够同时关注输入序列中的不同位置,直接计算序列中任意两个位置之间的关联,而不需要像 RNN 那样按顺序依次处理每个位置。这使得 Transformer 模型能够有效地捕捉长距离依赖关系,并且可以并行计算,大大提高了计算效率。

Transformer 模型的提出,打破了传统 NLP 模型的束缚,为后续的研究和发展开辟了新的道路。它不仅在自然语言处理领域取得了巨大的成功,还被广泛应用于计算机视觉、语音识别等其他领域,成为了现代深度学习中最重要的模型架构之一。许多基于 Transformer 的预训练模型,如 BERT、GPT 系列等,在各种 NLP 任务中取得了优异的成绩,推动了整个 NLP 领域的快速发展 。

(二)自注意力机制(Self - Attention)

自注意力机制是 Transformer 模型的核心,它的主要作用是计算输入序列中词汇之间的关联程度,从而让模型能够更好地捕捉上下文信息。在自然语言处理中,理解一个单词的含义往往需要考虑它周围的其他单词,自注意力机制就提供了这样一种方式,让模型在处理每个单词时,能够关注到整个输入序列中与该单词相关的其他单词。

自注意力机制的计算过程可以分为以下几个步骤。假设输入序列为\(X = [x_1, x_2, ..., x_n]\),其中\(x_i\)表示第\(i\)个单词的向量表示。首先,对于每个单词\(x_i\),模型会通过线性变换分别生成三个向量:查询向量(Query,记为\(q_i\))、键向量(Key,记为\(k_i\))和值向量(Value,记为\(v_i\))。具体来说,\(q_i = x_iW_Q\),\(k_i = x_iW_K\),\(v_i = x_iW_V\),这里\(W_Q\)、\(W_K\)和\(W_V\)是可学习的权重矩阵。

接下来,计算查询向量\(q_i\)与其他所有键向量\(k_j\)(\(j = 1, 2, ..., n\))的点积,得到一个表示它们之间关联程度的分数\(e_{ij}\),即\(e_{ij} = q_ik_j^T\)。这些分数表示了第\(i\)个单词对其他每个单词的关注度。为了使分数的范围更加稳定,通常会将分数除以一个缩放因子\(\sqrt{d_k}\),其中\(d_k\)是键向量\(k\)的维度。

然后,通过 Softmax 函数对这些分数进行归一化处理,得到注意力权重\(a_{ij}\),即\(a_{ij} = \frac{exp(e_{ij}/\sqrt{d_k})}{\sum_{j=1}^{n} exp(e_{ij}/\sqrt{d_k})}\)。注意力权重\(a_{ij}\)表示了第\(i\)个单词在关注第\(j\)个单词时的相对重要性,所有注意力权重之和为 1。

最后,根据注意力权重对值向量进行加权求和,得到第\(i\)个单词的自注意力输出\(z_i\),即\(z_i = \sum_{j=1}^{n} a_{ij}v_j\)。这个输出\(z_i\)综合了输入序列中所有单词的信息,并且重点关注了与第\(i\)个单词相关的单词。

例如,对于句子 “我 喜欢 吃 苹果”,当模型处理单词 “苹果” 时,通过自注意力机制,它会计算 “苹果” 与 “我”“喜欢”“吃” 这几个单词的关联程度。如果发现 “吃” 这个单词与 “苹果” 的关联度很高(比如注意力权重较大),那么在生成 “苹果” 的自注意力输出时,“吃” 这个单词的值向量就会对结果产生较大的影响,从而让模型更好地理解 “苹果” 在这个句子中的语义角色,即它是 “吃” 这个动作的对象 。

通过自注意力机制,模型可以在编码阶段将重要信息进行聚焦和提取,从而更好地理解输入序列的语义和结构。这种机制在很多自然语言处理任务中都取得了很好的效果,它使得模型能够更有效地处理长距离依赖关系,相比传统的 RNN 模型,大大提高了模型的性能和效率 。

(三)多头注意力(Multi - Head Attention)

多头注意力机制是对自注意力机制的进一步扩展和增强。它通过并行化多个自注意力机制,使得模型能够同时从不同的子空间捕捉输入序列的不同上下文关系,从而学习到更丰富的信息。

具体来说,多头注意力机制首先将输入的查询(Query)、键(Key)和值(Value)分别通过多个不同的线性变换,得到多个 “头” 的查询、键和值。假设有\(h\)个头,那么对于输入\(X\),会得到\(h\)组查询向量\(Q_1, Q_2, ..., Q_h\),\(h\)组键向量\(K_1, K_2, ..., K_h\)和\(h\)组值向量\(V_1, V_2, ..., V_h\)。

然后,每个头独立地进行自注意力计算,即对于第\(i\)个头,计算其注意力输出\(z_i\):\(z_i = Attention(Q_i, K_i, V_i) = softmax(\frac{Q_iK_i^T}{\sqrt{d_k}})V_i\) 。

最后,将这\(h\)个头的输出拼接起来,并通过一个线性变换,得到多头注意力的最终输出\(Z\)。公式表示为:\(Multi - Head Attention(Q, K, V) = Concat(head_1, head_2, ..., head_h)W^O\),其中\(head_i\)表示第\(i\)个头的注意力输出,\(W^O\)是用于最终线性变换的权重矩阵 。

以机器翻译任务为例,当翻译句子 “我 喜欢 中国 的 美食” 时,不同的注意力头可以关注到不同的语义关系。一个头可能主要关注 “我” 和 “喜欢” 之间的主谓关系,另一个头则可能更关注 “中国” 和 “美食” 之间的修饰关系。通过多头注意力机制,模型能够同时捕捉到这些不同的关系,从而更准确地进行翻译。

多头注意力机制的优势在于它可以让模型从多个角度去学习输入序列的特征和关系。不同的头可以关注到不同的上下文信息,有的头擅长捕捉局部信息,有的头则更善于捕捉长距离依赖关系。这种并行化和多样化的学习方式,大大提高了模型的表达能力和对复杂语义的理解能力 。

(四)位置编码(Positional Encoding)

在 Transformer 模型中,由于自注意力机制本身不考虑输入序列中元素的顺序信息,为了让模型能够捕捉到序列中词汇的位置信息,引入了位置编码(Positional Encoding)。

位置编码的作用是将每个词汇在序列中的位置信息编码成一个向量,并将其与词汇本身的词嵌入向量相加,从而使模型能够感知到词汇的位置。具体来说,位置编码使用正弦和余弦函数来生成位置向量。对于位置\(pos\)和维度\(i\),位置编码的计算公式如下:\(PE(pos, 2i) = sin(pos / 10000^{2i / d_{model}})\)

\(PE(pos, 2i + 1) = cos(pos / 10000^{2i / d_{model}})\)

其中,\(d_{model}\)是模型的维度。从公式中可以看出,位置编码在偶数维度上使用正弦函数,在奇数维度上使用余弦函数,通过不同的频率来编码不同的位置信息。

例如,对于一个简单的句子 “苹果 是 红色 的”,“苹果” 在句子中的位置是 1,“是” 的位置是 2。通过位置编码,会为 “苹果” 和 “是” 生成不同的位置向量,然后将这些位置向量分别与 “苹果” 和 “是” 的词嵌入向量相加,得到包含位置信息的新向量。这样,当模型处理这些向量时,就能够知道 “苹果” 和 “是” 在句子中的先后顺序,从而更好地理解句子的结构和语义。

位置编码的引入使得 Transformer 模型能够处理具有顺序性的自然语言数据,它在许多 NLP 任务中都发挥了重要作用。无论是文本分类、机器翻译还是文本生成,位置信息对于模型准确理解和处理文本都至关重要。通过位置编码,模型可以更好地捕捉到句子中词汇之间的依赖关系,提高模型在这些任务中的性能 。

(五)前馈神经网络(Feed - Forward Neural Network)

在前馈神经网络在 Transformer 模型中,它位于多头注意力机制之后,主要作用是对多头注意力输出的特征进行进一步的处理和变换,提取词汇的局部特征,增强模型的表达能力。

前馈神经网络的结构相对简单,它由两个全连接层组成,中间使用 ReLU 激活函数进行非线性变换。假设多头注意力的输出为\(Z\),其维度为\((batch\_size, seq\_length, d_{model})\),其中\(batch\_size\)是批量大小,\(seq\_length\)是序列长度,\(d_{model}\)是模型维度。前馈神经网络首先将\(Z\)通过第一个全连接层,将其维度从\(d_{model}\)变换到一个更高的维度\(d_{ff}\)(通常\(d_{ff}\) >> \(d_{model}\)),然后使用 ReLU 激活函数进行非线性变换:\(FFN_1(Z) = ReLU(Z W_1 + b_1)\),这里\(W_1\)是第一个全连接层的权重矩阵,\(b_1\)是偏置项。

接着,将经过 ReLU 激活后的结果通过第二个全连接层,将维度再变换回\(d_{model}\):\(FFN_2(FFN_1(Z)) = FFN_1(Z) W_2 + b_2\),其中\(W_2\)是第二个全连接层的权重矩阵,\(b_2\)是偏置项。最终得到前馈神经网络的输出,这个输出将继续参与后续的计算。

以文本分类任务为例,当模型通过多头注意力机制捕捉到文本中的各种语义关系后,前馈神经网络会对这些关系进行进一步的抽象和提炼。它可以从这些关系中提取出与文本类别相关的局部特征,比如特定的词汇组合、语义模式等。通过这种方式,模型能够更好地对文本进行分类,提高分类的准确性。

前馈神经网络的

相关文章:

《一文读懂Transformers库:开启自然语言处理新世界的大门》

《一文读懂Transformers库:开启自然语言处理新世界的大门》 GitHub - huggingface/transformers: 🤗 Transformers: State-of-the-art Machine Learning for Pytorch, TensorFlow, and JAX. HF-Mirror Hello! Transformers快速入门 pip install transformers -i https:/…...

2025年GPLT团体程序设计天梯赛L1-L2

目录 1.珍惜生命 2.偷感好重 3.高温补贴 4.零头就抹了吧 5.这是字符串题 6.这不是字符串题 7.大幂数编辑 8.现代战争编辑 9.算式拆解 10.三点共线 11.胖达的山头 12.被n整除的n位数 1.珍惜生命 【解析】直接输出即可 #include<bits/stdc.h> using namespace…...

【每天一个知识点】IPv4(互联网协议版本4)和IPv6(互联网协议版本6)

IPv4(互联网协议版本4)和IPv6(互联网协议版本6)是用于在互联网上标识和定位设备的两种主要协议。它们的主要区别在于地址空间、结构、以及一些附加功能。以下是两者的对比: 1. 地址长度 IPv4: 地址长度为32位…...

金仓数据库征文-政务领域国产化数据库更替:金仓 KingbaseES 应用实践

目录 一.金仓数据库介绍 二.政务领域数据库替换的时代需求 三.金仓数据库 KingbaseES 在政务领域的替换优势 1.强大的兼容性与迁移能力 2.高安全性与稳定性保障 3.良好的国产化适配性 四.金仓数据库 KingbaseES 在政务领域的典型应用实践 1.电子政务办公系…...

Mac 「brew」快速安装MySQL

安装MySQL 在 macOS 上安装 MySQL 环境可以通过Homebrew快速实现,以下是步骤指南: 方法 1:使用 Homebrew 安装 MySQL 1. 安装 Homebrew 如果尚未安装 Homebrew,可以通过以下命令安装: /bin/bash -c "$(curl -…...

Android Studio开发中Application和Activity生命周期详解

文章目录 Application生命周期Application生命周期概述Application关键回调方法onCreate()onConfigurationChanged()onLowMemory()onTrimMemory()onTerminate() Application生命周期管理最佳实践 Activity生命周期Activity生命周期概述Activity生命周期回调方法onCreate()onSta…...

【一次成功!】Ubuntu22.04 安装 Autoware、 cuda、 cudnn、 TensorRT

背景 新买的工控机,32GB NVIDIA GeForce RTX 4060,只装了 Ubuntu22.04、ROS2 Humble。 一.安装Autoware Source installation - Autoware Documentation 1. 基础环境 OS Ubuntu 22.04ROS ROS 2 Humble#小鱼ros一键安装 wget http://fishros.com/install -O fishros &…...

【金仓数据库征文】金仓数据库:开启未来技术脑洞,探索数据库无限可能

我的个人主页 我的专栏: 人工智能领域、java-数据结构、Javase、C语言,希望能帮助到大家!!! 点赞👍收藏❤ 目录 引言:数据库进化的下一站 —— 未来科技的无限可能金仓数据库简介:国…...

微信小程序根据图片生成背景颜色有效果图

效果图 取得是图片中间10个像素算出背景颜色 .wxml <canvas type"2d" id"imageCanvas" style"--w: {{w}}px;--h: {{h}}px;" /> <view style"background: {{backgroundColor}};"><image bind:tap"updateIndex&qu…...

Redis ⑥-string | hash | list

string类型基本介绍 Redis 中的字符串,是直接按照二进制的方式进行存储的。也就是说,在存取的过程中,是不会做任何编码转换的。存的是啥,取的时候就是啥。 Redis 的这个机制,就使得 Redis 非常适合用来存储各种各样的…...

深入理解C语言函数之模拟实现strcpy()strcat()

文章目录 前言一、strcpy的模拟实现二、strcat的模拟实现总结 前言 前面我们用三种方法模拟实现了一下strlen,所以这篇文章模拟实现以下strcpy()strcat() 一、strcpy的模拟实现 首先我们去官网找到strcpy的用法和原…...

大数据组件学习之--Kafka 安装搭建

一、前置环境 在搭建kafka之前,请确认自己的hadoop、zookeeper是否搭建完成且可正常运行 二、下载并上传安装包(链接为百度网盘) kafka安装包 tar -zxvf /opt/software/kafka_2.12-2.4.1.tgz -C /opt/module/ 进入解压后的目录更改文件名…...

BIOS主板(非UEFI)安装fedora42的方法

BIOS主板(非UEFI)安装fedora42的方法 现实困难:将Fedora-Workstation-Live-42-1.1.x86_64.iso写入U盘制作成可启动U盘启动fedora42,按照向导将fedora42安装到真机的sda7分区中得到报错如下内容: /boot/efi 必需的 /boot/efi必须位于格式化为e…...

[吾爱出品] 【键鼠自动化工具】支持识别窗口、识图、发送文本、按键组合等

键鼠自动化工具 链接:https://pan.xunlei.com/s/VOOhDZkj-E0mdDZCvo3jp6s4A1?pwdfufb# 1、增加的找图点击功能(不算增加,只能算缝补),各种的不完善,但是能运行。 2、因为受限于原程序的界面,…...

图解YOLO(You Only Look Once)目标检测(v1-v5)

1. YOLO系列整体介绍 YOLO属于深度学习经典检测方法中的单阶段(one - stage)类型,与两阶段(two - stage,如Faster - rcnn、Mask - Rcnn系列)方法相对。 不同模型性能 单阶段方法的最核心优势是速度非常快…...

基于AI应用创业IDEA:使用百度搜索开放平台的MCP广场智能推荐MCPServices服务

基于AI应用创业IDEA:使用百度搜索开放平台的MCP广场智能推荐MCPServices服务 在当今快速发展的技术时代,人工智能(AI)已经成为推动各行各业创新的关键力量。特别是在创业领域,AI技术不仅能够帮助提升产品性能…...

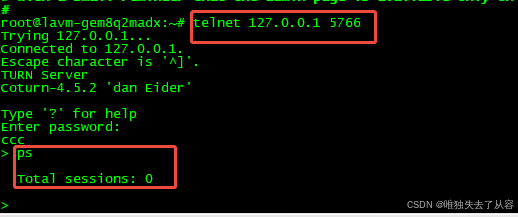

WebRTC服务器Coturn服务器的管理平台功能

1、概述 开源的webrtc服务器提供管理平台功能,用户可以通过web页面进行访问配置coturn服务器,主要包括管理平台功能和telnet的管理功能,coturn相当于telnet服务器,可能通过配置来开启这两个功能,方便查看coturn服务器…...

户外监控起雾终结者:PD3电解除湿器全方位解决方案

一、监控画面模糊?潮湿正在侵蚀您的安防系统! 清晨的浓雾中,监控画面逐渐模糊;暴雨过后,摄像头内部凝结水珠;冬季温差导致镜头起雾,关键画面完全丢失...这些场景每天都在全国各地的安防系统中上…...

[mysql]数据类型精讲

目录 数据类型精讲: 整数类型 浮点类型 日期和时间类型 文本字符串类型 数据类型精讲: 精度问题:不能损失数据 性能问题:表的设计,范式的讲解. 表设计的时候需要设置字段,我们现在要把字段类型讲完.,细节点一点点给大家拆解. Float和double是有精度的损失的,这边推荐使用…...

并发设计模式实战系列(7):Thread Local Storage (TLS)

🌟 大家好,我是摘星! 🌟 今天为大家带来的是并发设计模式实战系列,第七章Thread Local Storage (TLS),废话不多说直接开始~ 目录 一、核心原理深度拆解 1. TLS内存模型 2. 关键特性 二、生活化类比&a…...

跟我学C++中级篇——处理对象的复制

一、对象的传递 在应用程序中,经常会遇到不同线程或不同模块间需要进行对象的传递,本来传递不是什么多大的事。但问题是,如果对象的值大到一定的程度后,传递不是问题可对象值的处理反而成了问题了。举一个现实世界的例子…...

Tailwind CSS 实战:基于 Kooboo 构建企业官网页面(一)

目录 一、技术选型:为什么选择Tailwind Kooboo? 二、CDN方案 vs 传统安装 三、CDN方式实战步骤 一、技术选型:为什么选择Tailwind Kooboo? 1.1 黄金组合优势 Tailwind CSS:原子化CSS框架,提供&#x…...

Go语言实战:快速搭建完整的用户认证系统

前言 在本文中,我将介绍如何使用 Go 语言搭建一个包含用户注册、登录、登出功能的完整认证系统。该系统使用 SQLite 作为数据库,JWT 作为身份验证token,并实现了优雅关闭等特性。 技术栈 Go 语言 SQLite 数据库 JWT (JSON Web Token) G…...

Bolsig+超详细使用教程

文章目录 Bolsig介绍Bolsig的使用 Bolsig介绍 BOLSIG 是一款用于求解弱电离气体中电子玻尔兹曼方程的免费计算程序,适用于均匀电场条件下的群体实验、气体放电及碰撞型低温等离子体研究。在此类环境中,电子分布函数呈现非麦克斯韦特性,其形态…...

uni-app云开发总结

uni-app云开发总结 云开发无非就三个概念:云数据库、云函数、云存储 uni-app中新增了一个概念叫做云对象,它其实就是云函数的加强版,它是导出的一个对象,对象中可以包含多个操作数据库的函数,接下来咱们就详细对uni-…...

新闻速递丨Altair 与 Databricks 达成合作,加速数据驱动型创新

NEWS Altair 近日宣布与数据和人工智能公司 Databricks 达成战略合作,通过新一代数据统一化、图谱驱动智能和企业级人工智能(AI)技术赋能双方客户。 此次合作整合了两大平台的核心优势,将 Altair RapidMiner 平台的强大功能&…...

vscode和git 踩坑

git init经常 在 vscode push错误问题: 正确姿势:先 GitHub 上建仓库 → git clone 拉到本地 → 再用 VSCode 打开编辑 ❌ 不是:VSCode 里 git init → 再去 GitHub 选个仓库绑定 举个对比 操作流程是否推荐后果GitHub 创建仓库 → git clone → 用 VSC…...

《ATPL地面培训教材13:飞行原理》——第7章:失速

翻译:刘远贺;工具:Cursor & Cluade 3.7 第7章:失速 目录 引言失速的原因升力曲线失速恢复接近失速时的飞机行为接近失速时的飞行控制使用失速识别失速速度失速警告人工失速警告装置基本失速要求(EASA和FAR&…...

在html中如何创建vue自定义组件(以自定义文件上传组件为例,vue2+elementUI)

1、先上代码:vueUpload.js var dom <div class"upload-file"><el-upload :action"uploadFileUrl" :before-upload"handleBeforeUpload" :file-list"fileList" :limit"limit":on-error"handleUpl…...

《使用 Cesium 加载静态热力图显示的实现步骤》

Cesium——使用cesium 加载静态热力图显示 实现思路 要在 Cesium 中加载静态热力图,我们需要完成以下几个主要步骤: 1、计算热力图数据的四至范围和中心点。 2、初始化热力图并设置相关参数。 3、将数据添加到热力图中。 4、定位到热力图的位置并刷…...