ORA-48913: Writing into trace file failed, file size limit [50000000] reached

检查某环境的alert_orcl1.log时,发现有很多的ORA-48913报错,细节如下

Sat Jul 22 19:34:04 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_138010.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Sat Jul 22 20:08:08 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_151573.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Sun Jul 23 20:08:17 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_270006.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Mon Jul 24 20:08:01 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_388027.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Tue Jul 25 20:08:20 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_47733.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Wed Jul 26 20:08:12 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_165947.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Thu Aug 03 20:08:10 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_196174.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Fri Aug 04 20:08:05 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_314448.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

Sat Aug 05 20:08:11 2023

Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_432215.trc"

Error message: ORA-48913: Writing into trace file failed, file size limit [50000000] reached

Writing to the above trace file is disabled for now on...

查看其中一个trc文件,发现是有备份引起的问题

[root@db1 trace]# strings orcl1_dw00_432215.trc|more

Trace file /u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_432215.trc

Oracle Database 11g Enterprise Edition Release 11.2.0.4.0 - 64bit Production

With the Partitioning, Real Application Clusters, Automatic Storage Management, OLAP,

Data Mining and Real Application Testing options

ORACLE_HOME = /u01/app/oracle/product/11.2.0/db_1

System name: Linux

Node name: db1

Release: 4.1.12-124.16.4.el6uek.x86_64

Version: #2 SMP Thu Jun 14 18:55:52 PDT 2018

Machine: x86_64

Instance name: orcl1

Redo thread mounted by this instance: 1

Oracle process number: 131

Unix process pid: 432215, image: oracle@db1 (DW00)

*** 2023-08-05 20:05:04.951

*** SESSION ID:(433.37713) 2023-08-05 20:05:04.951

*** CLIENT ID:() 2023-08-05 20:05:04.951

*** SERVICE NAME:(SYS$BACKGROUND) 2023-08-05 20:05:04.951

*** MODULE NAME:() 2023-08-05 20:05:04.951

*** ACTION NAME:() 2023-08-05 20:05:04.951

KUPP:20:05:04.950: Current trace/debug flags: 00480300 = 4719360

*** MODULE NAME:(Data Pump Worker) 2023-08-05 20:05:04.952

*** ACTION NAME:(SYS_EXPORT_FULL_01) 2023-08-05 20:05:04.952

KUPW:20:05:04.952: 0: ALTER SESSION ENABLE PARALLEL DML called.

KUPW:20:05:04.952: 0: ALTER SESSION ENABLE PARALLEL DML returned.

KUPC:20:05:05.085: Setting remote flag for this process to FALSE

KUPW:20:05:05.189: 0: KUPP$PROC.WHATS_MY_ID called.

KUPW:20:05:05.189: 1: KUPP$PROC.WHATS_MY_ID returned.

KUPW:20:05:05.191: 1: worker max message number: 1000

KUPW:20:05:05.192: 1: Cluster access disabled - all workers and slaves local

KUPW:20:05:05.193: 1: Original job start time: 23-AUG-05 08:05:03 PM

KUPW:20:05:05.199: 1: Seqno 235 is DATABASE_EXPORT/SCHEMA/TABLE/TABLE_DATA

KUPW:20:05:05.199: 1: Seqno 434 is DATABASE_EXPORT/SCHEMA/TABLE/INDEX/DOMAIN_INDEX/SECONDARY_TABLE/INDEX/TABLE_DATA

KUPW:20:05:05.199: 1: KUPP$PROC.WHATS_MY_NAME called.

KUPW:20:05:05.199: 1: KUPP$PROC.WHATS_MY_NAME returned. Process name: DW00

KUPW:20:05:05.199: 1: KUPV$FT_INT.GET_INSTANCE_ID called.

KUPW:20:05:05.200: 1: KUPV$FT_INT.GET_INSTANCE_ID returned. Instance name: db1:orcl1

KUPW:20:05:05.201: 1: ALTER SESSION ENABLE RESUMABLE called.

KUPW:20:05:05.202: 1: ALTER SESSION ENABLE RESUMABLE returned.

KUPW:20:05:05.203: 1: KUPF$FILE.INIT called.

KUPW:20:05:05.216: 1: KUPF$FILE.INIT returned.

KUPW:20:05:05.216: 1: KUPF$FILE.GET_MAX_CSWIDTH called.

KUPW:20:05:05.217: 1: KUPF$FILE.GET_MAX_CSWIDTH returned.

KUPW:20:05:05.217: 1: Max character width: 4

KUPW:20:05:05.217: 1: Max clob fetch: 8181

KUPW:20:05:05.217: 1: Max varchar2a size: 8181

KUPW:20:05:05.217: 1: Max varchar2 size: 1990

KUPW:20:05:05.217: 1: In procedure GET_PARAMETERS

KUPW:20:05:05.217: 1: In procedure GET_METADATA_FILTERS

KUPW:20:05:05.218: 1: In procedure GET_METADATA_TRANSFORMS

KUPW:20:05:05.219: 1: In procedure GET_DATA_FILTERS

KUPW:20:05:05.219: 1: In procedure GET_DATA_REMAPS

KUPW:20:05:05.220: 1: In procedure CREATE_MSG

KUPW:20:05:05.220: 1: KUPV$FT.MESSAGE_TEXT called.

KUPW:20:05:05.220: 1: KUPV$FT.MESSAGE_TEXT returned.

KUPW:20:05:05.220: 1: In procedure PRINT_MT_PARAMS

KUPW:20:05:05.220: 1: Master table : "SYS"."SYS_EXPORT_FULL_01"

KUPW:20:05:05.220: 1: Metadata job mode : DATABASE_EXPORT

KUPW:20:05:05.220: 1: Debug enable : TRUE

KUPW:20:05:05.220: 1: Profile enable : FALSE

KUPW:20:05:05.220: 1: Transportable enable : FALSE

KUPW:20:05:05.220: 1: Metrics enable : TRUE

KUPW:20:05:05.220: 1: db version : 11.2.0.4.0

KUPW:20:05:05.220: 1: job version : 11.2.0.4.0

KUPW:20:05:05.220: 1: service name :

KUPW:20:05:05.220: 1: Current Edition : ORA$BASE

KUPW:20:05:05.220: 1: Job Edition :

KUPW:20:05:05.220: 1: Abort Step : 0

KUPW:20:05:05.220: 1: Access Method : AUTOMATIC

KUPW:20:05:05.220: 1: Data Options : 0

KUPW:20:05:05.220: 1: Dumper directory :

KUPW:20:05:05.220: 1: Master only : FALSE

KUPW:20:05:05.220: 1: Data Only : FALSE

KUPW:20:05:05.220: 1: Metadata Only : FALSE

处理办法

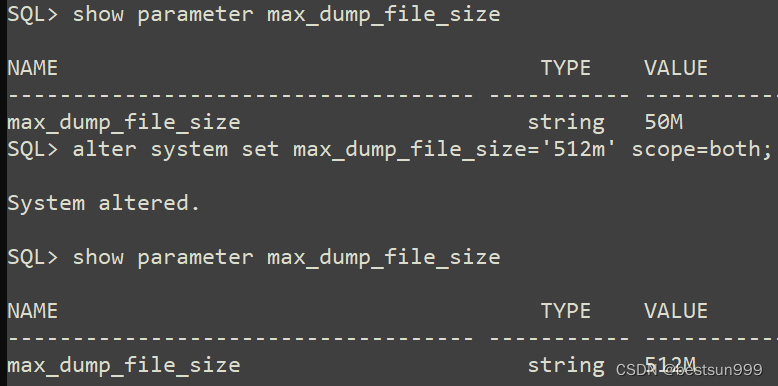

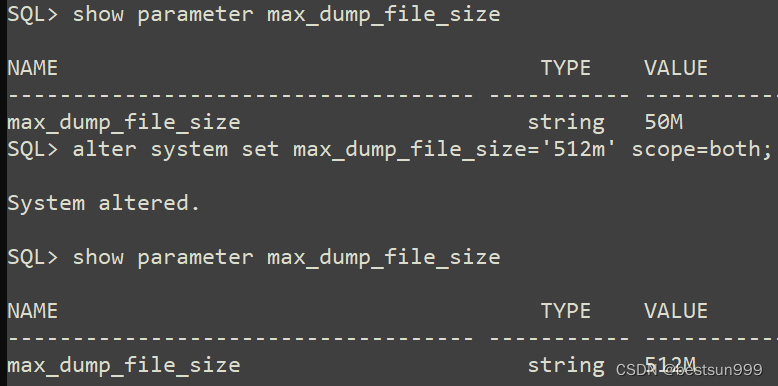

1、查看max_dump_file_size的值为50m,确实不够大,调整max_dump_file_size的值到512M

SQL> show parameter max_dump_file_size

NAME TYPE VALUE

------------------------------------ ----------- ------------------------------

max_dump_file_size string 50M

SQL> alter system set max_dump_file_size='512m' scope=both;

System altered.

SQL> show parameter max_dump_file_size

NAME TYPE VALUE

------------------------------------ ----------- ------------------------------

max_dump_file_size string 512M

-----------------------------------------

2、手动执行expdp备份不再报错,但trc文件有60M。打开备份脚本查看发现备份命令加了METRICS=Y TRACE=480300参数,删除参数后再次备份,trc很小了。

[root@db1 trace]# du -sh orcl1_dw00_286274.trc

60M orcl1_dw00_286274.trc

相关文章:

ORA-48913: Writing into trace file failed, file size limit [50000000] reached

检查某环境的alert_orcl1.log时,发现有很多的ORA-48913报错,细节如下 Sat Jul 22 19:34:04 2023 Non critical error ORA-48913 caught while writing to trace file "/u01/app/oracle/diag/rdbms/orcl/orcl1/trace/orcl1_dw00_138010.trc" E…...

线上Zookeeper问题解决记录

zookeeper问题: 日志目录: /home/cmccdata/app/zookeeper/logs dataDir/home/cmccdata/app/zookeeper/data/zoodata dataLogDir/home/cmccdata/app/zookeeper/data/zoolog 问题0: 2023-08-03 17:15:43,139 [myid:1] - WARN [NIOServerCxn.Factory:0.0.0.0/0.0.0.0:2181:…...

Docker极速安装Jenkins

安装 Jenkins 是一个常见的任务,使用 Docker 进行安装可以简化该过程并确保环境一致性。以下是在 Docker 中安装 Jenkins 的详细步骤: 安装 Docker: 首先,请确保您已在目标机器上安装了 Docker。根据您的操作系统,可以在 Docker 官…...

TransnormerLLM 中 FlashLinearAttention 的纯pytorch实现

Github 仓库:https://github.com/One-sixth/flash-linear-attention-pytorch flash-linear-attention-pytorch 纯 Pytorch 实现 TransnormerLLM 中快速线性注意力算子。 用于学习目的。 如果你希望用于训练模型,你可能要修改为 CUDA 或 Triton 的实现&…...

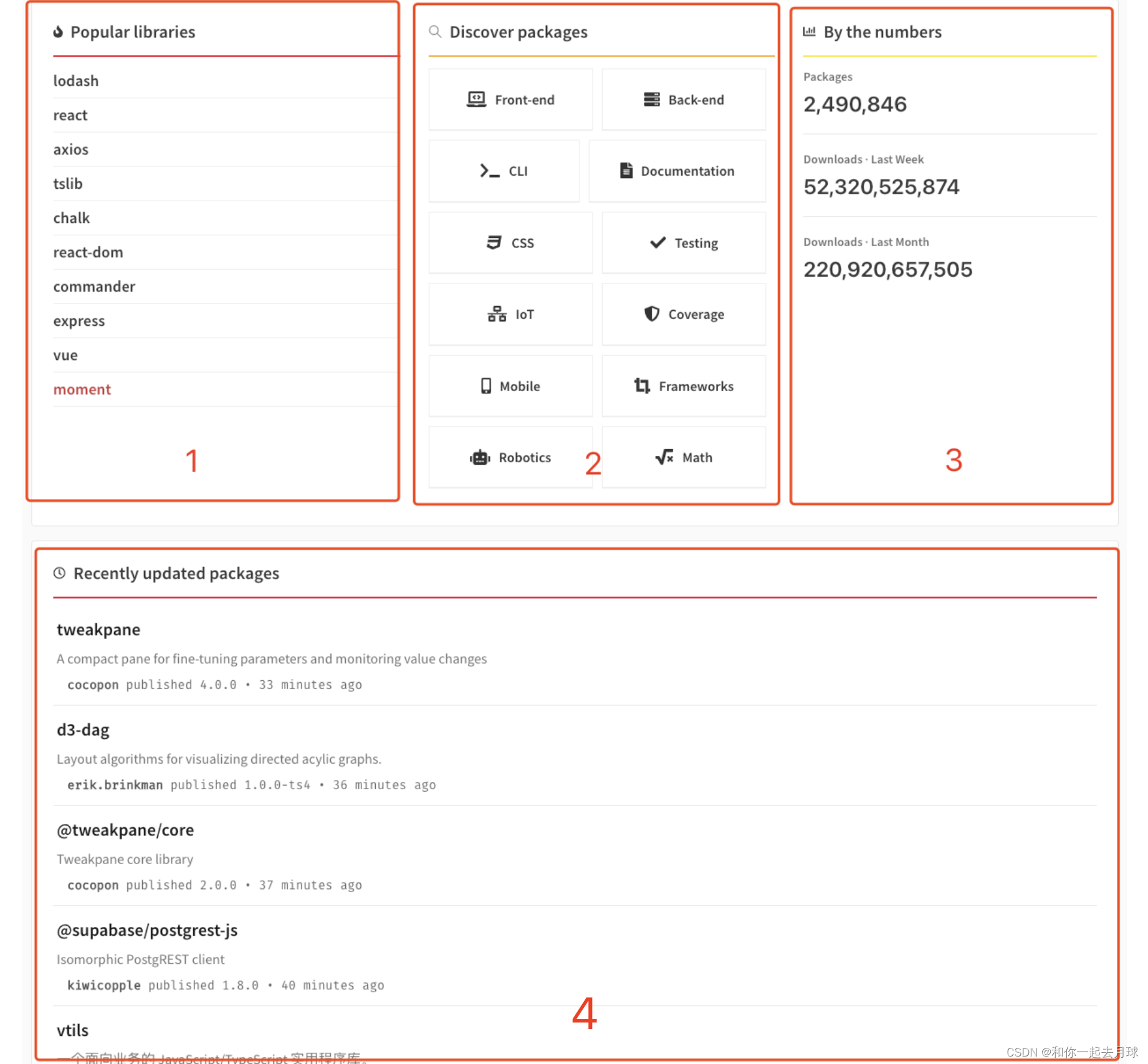

从NPM注册中心获取包

目录 1、搜索和选择要下载的包 1.1 为什么使用 1.2 工作原理 1、质量 2、维护 3、受欢迎程度 4、名气 1.1、开始搜索包 2、在本地安装下载和安装软件包 2.1 安装未限定作用域的包 2.2 安装有作用域的公共包 2.3 安装私有包 2.4 测试包安装 2.5 已安装的软件包版本…...

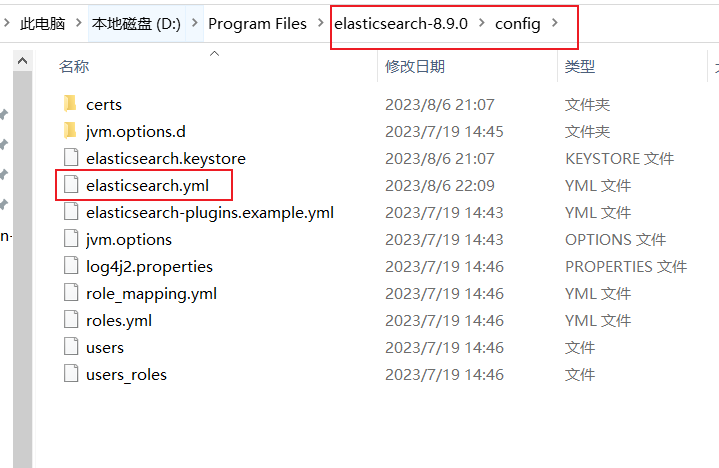

Elastic的下载

文章目录 ElasticSearch的下载扩展1(ElasticSearch 与 JDK 版本 适配)扩展2(访问 http://192.168.1.200:9200 没有显示信息)扩展3(免密登录) ElasticSearch的下载 官方下载网址:https://www.el…...

day52-Redis

Redis 1.Redis 1.1 RESP连接Redis 1.2 定义:是一个高性能的key-value数据库(非关系型数据库) 1.3 数据类型: key键的类型是字符串类型; 值的类型有五种:字符串String,哈希hash࿰…...

高效处理矢量大数据的高可用解决方案

高效处理矢量大数据的高可用解决方案 解决方案目标 存储海量矢量数据实时分析海量矢量数据实现海量矢量数据的可视化提供高可用、高性能和高可拓展性解决方案概述 海量数据查询与可视化 系统技术流程 方案一 数据存储: PostgreSQL+PostGIS(矢量数据存储和空间分析)数据服务…...

Docker Compose构建lnmp

目录 Compose的优点 编排和部署 Compose原理 Compose应用案例 安装docker-ce 阿里云镜像加速器 安装docker-compose docker-compose用法 Yaml简介 验证LNMP环境 Compose的优点 先来了解一下我们平时是怎么样使用docker的?把它进行拆分一下: 1…...

Flutter开发问题记录

1. Q:Mac电脑通过AndroidStudio运行软件到iphone报错 automatically assigning platform iOS with version 10.0 on target Runner because no platform was specified. A:项目中ios目录下,Podfile文件第2行 platform :ios, ‘11.0’,取消注释 2. Q:Mac电脑通过And…...

如何使用本地mock数据

当后端同事接口数据还未完成,我们前端开发需要使用数据时,怎么办呢?这里可以自己本地mock数据先用着啦!仅在开发时使用 1. 创建一个 xxx.js文件,对外暴露一个数组; 对新建js文件编写导出,返回数…...

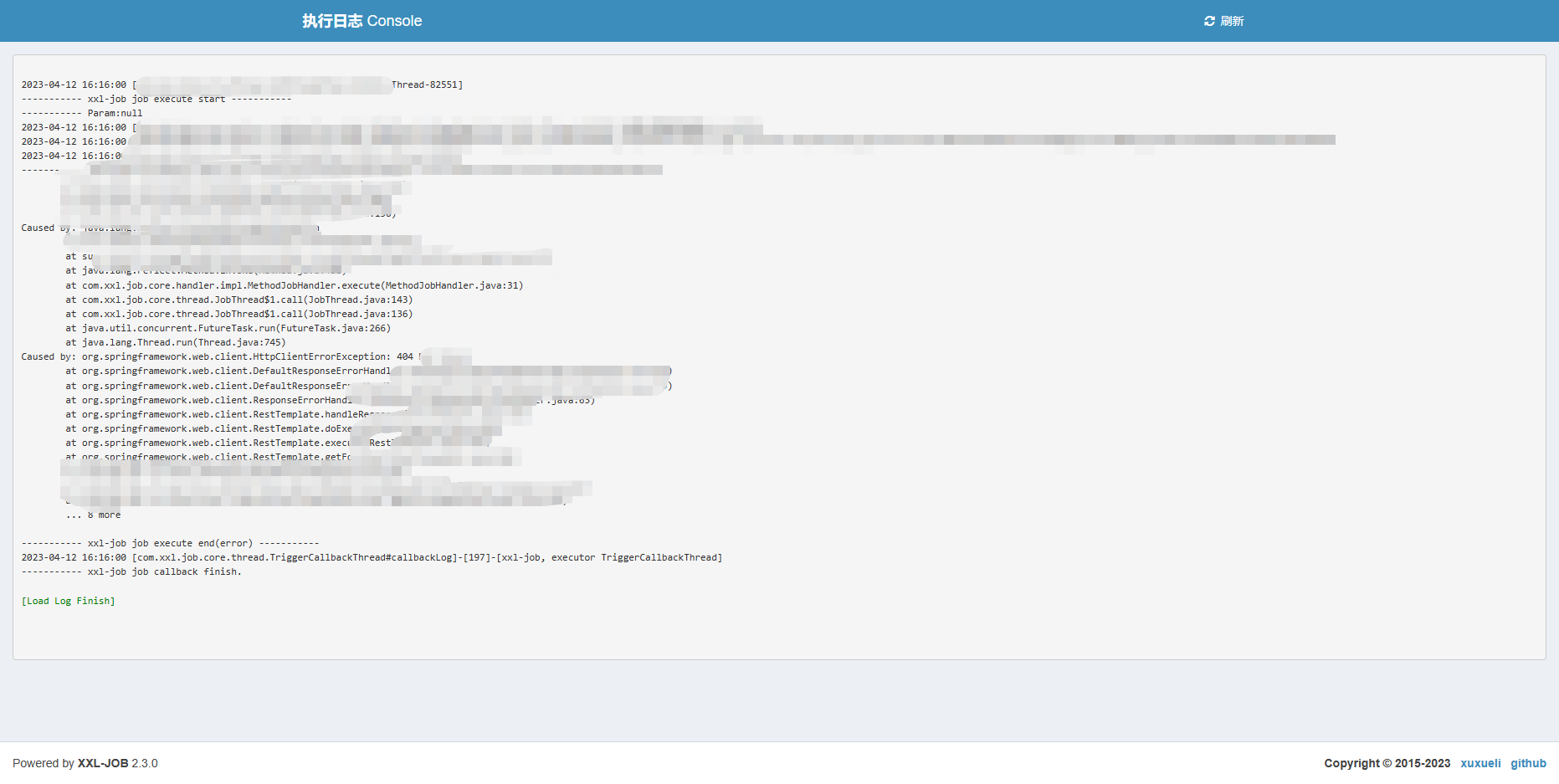

XXL-JOB定时任务框架(Oracle定制版)

特点 xxl-job是一个轻量级、易扩展的分布式任务调度平台,能够快速开发和简单学习。开放源代码并被多家公司线上产品使用,开箱即用。尽管其确实非常好用,但我在工作中使用的是Oracle数据库,因为xxl-job是针对MySQL设计的ÿ…...

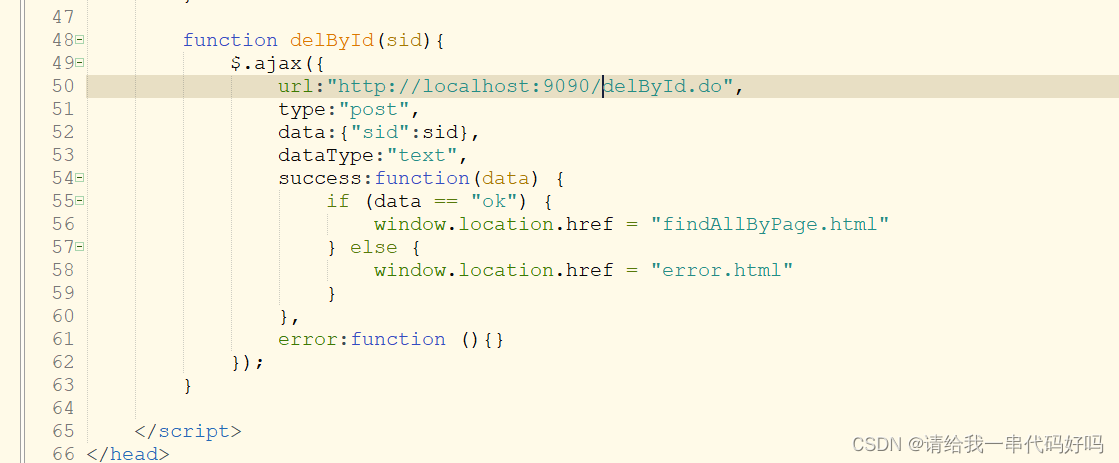

SpringBoot + ajax 实现分页和增删查改

0目录 1.SpringBoot 2.SpringBoot分页;增删改查 1.SpringBoot分页 创建数据库和表 创建SpringBoot工程,引入springboot下的分页依赖 配置application.yml 实体类 Mapper接口 Mapper.xml Service接口 Service实现类 控制层 测试 加…...

ProxyGenerator-代理类生成器

ProxyGenerator是JDK-sun包下提供的用于生成动态代理类信息的类,其唯一向外透出的是其静态方法-generateProxyClass(…)。 public class ProxyGenerator { ... }学习本篇文章,就是想学习ProxyGenerator如何生成代理类信息的过程。 一、唯一入口-公开静…...

ARM 内存屏障指令

ARM 内存屏障指令 1. dmb (Data Memory Barrier) 数据内存栅栏2. dsb (Data Synchronization Barrier) 数据同步栅栏3. isb (Instruction Synchronization Barrier) 指令同步栅栏4. ARM 内存屏障指令如何选择使用?5. 使用示例5.1. DMB指令示例:5.2. DSB指…...

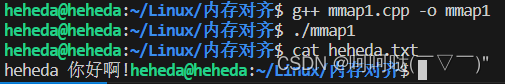

了解Linux 的 mmap --- 笔记

学习这篇博客,进行了一些归纳Linux下mmap_linux mmap_一个山里的少年的博客-CSDN博客https://blog.csdn.net/qq_56999918/article/details/127070280 >>读取文件 读取文件方法:由操作系统提供的两个方法,read和write来读写文件。 由…...

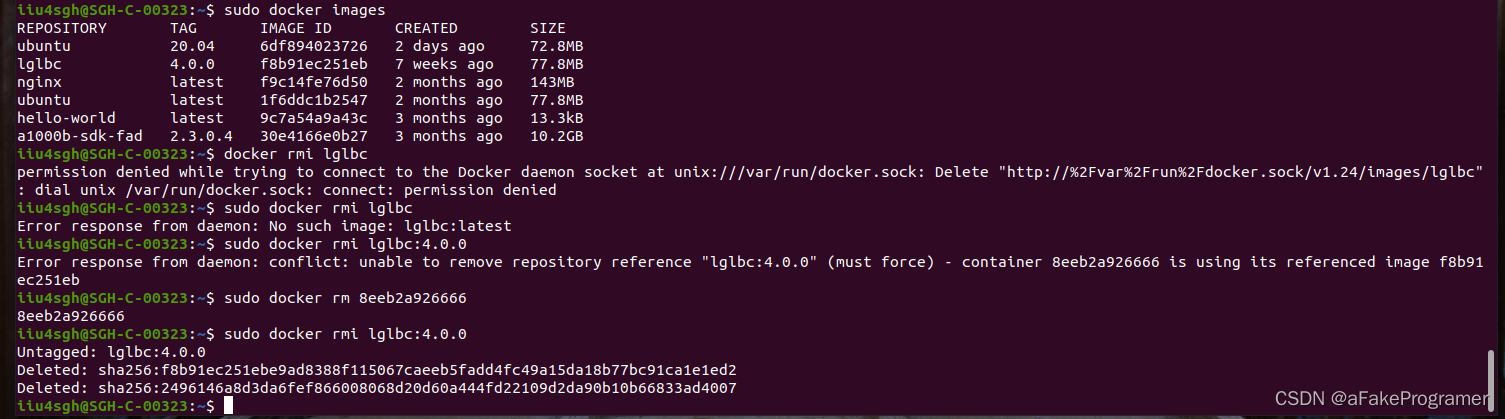

docker删除容器(步骤详解)

要在Docker中删除容器,需要使用命令docker rm。 下面是详细步骤: 1. 首先,使用docker ps命令查看当前正在运行的容器。这个命令会列出所有正在运行的容器的ID、名称、状态等信息。 如果没有正在运行的容器可以通过docker ps -a 查看当前所…...

boost beast http server 测试

boost beast http client boost http server boost beast 是一个非常好用的库,带上boost的协程,好很多东西是比较好用的,以下程序使用四个线程开启协程处理进入http协议处理。协议支持http get 和 http post #include <boost/beast/cor…...

Android 10.0 系统开启禁用adb push和adb pull传输文件功能

1.使用场景 在进行10.0的系统开发中,在一些产品中由于一些开发的功能比较重要,防止技术点外泄在出货产品中,禁用 adb pull 和adb push等命令 来获取系统system下的jar 和apk 等文件,所以需要禁用这些命令 2.系统开启禁用adb push和adb pull传输文件功能的分析 看了下系统…...

浙大数据结构第七周之07-图4 哈利·波特的考试

基础知识:(最短路的前提都是在图中两条边之间的权值非定值) (一)Dijkstra方法 算法实现: …...

线程与协程

1. 线程与协程 1.1. “函数调用级别”的切换、上下文切换 1. 函数调用级别的切换 “函数调用级别的切换”是指:像函数调用/返回一样轻量地完成任务切换。 举例说明: 当你在程序中写一个函数调用: funcA() 然后 funcA 执行完后返回&…...

服务器硬防的应用场景都有哪些?

服务器硬防是指一种通过硬件设备层面的安全措施来防御服务器系统受到网络攻击的方式,避免服务器受到各种恶意攻击和网络威胁,那么,服务器硬防通常都会应用在哪些场景当中呢? 硬防服务器中一般会配备入侵检测系统和预防系统&#x…...

电脑插入多块移动硬盘后经常出现卡顿和蓝屏

当电脑在插入多块移动硬盘后频繁出现卡顿和蓝屏问题时,可能涉及硬件资源冲突、驱动兼容性、供电不足或系统设置等多方面原因。以下是逐步排查和解决方案: 1. 检查电源供电问题 问题原因:多块移动硬盘同时运行可能导致USB接口供电不足&#x…...

C# 类和继承(抽象类)

抽象类 抽象类是指设计为被继承的类。抽象类只能被用作其他类的基类。 不能创建抽象类的实例。抽象类使用abstract修饰符声明。 抽象类可以包含抽象成员或普通的非抽象成员。抽象类的成员可以是抽象成员和普通带 实现的成员的任意组合。抽象类自己可以派生自另一个抽象类。例…...

多种风格导航菜单 HTML 实现(附源码)

下面我将为您展示 6 种不同风格的导航菜单实现,每种都包含完整 HTML、CSS 和 JavaScript 代码。 1. 简约水平导航栏 <!DOCTYPE html> <html lang"zh-CN"> <head><meta charset"UTF-8"><meta name"viewport&qu…...

【JVM面试篇】高频八股汇总——类加载和类加载器

目录 1. 讲一下类加载过程? 2. Java创建对象的过程? 3. 对象的生命周期? 4. 类加载器有哪些? 5. 双亲委派模型的作用(好处)? 6. 讲一下类的加载和双亲委派原则? 7. 双亲委派模…...

虚拟电厂发展三大趋势:市场化、技术主导、车网互联

市场化:从政策驱动到多元盈利 政策全面赋能 2025年4月,国家发改委、能源局发布《关于加快推进虚拟电厂发展的指导意见》,首次明确虚拟电厂为“独立市场主体”,提出硬性目标:2027年全国调节能力≥2000万千瓦࿰…...

MacOS下Homebrew国内镜像加速指南(2025最新国内镜像加速)

macos brew国内镜像加速方法 brew install 加速formula.jws.json下载慢加速 🍺 最新版brew安装慢到怀疑人生?别怕,教你轻松起飞! 最近Homebrew更新至最新版,每次执行 brew 命令时都会自动从官方地址 https://formulae.…...

Chrome 浏览器前端与客户端双向通信实战

Chrome 前端(即页面 JS / Web UI)与客户端(C 后端)的交互机制,是 Chromium 架构中非常核心的一环。下面我将按常见场景,从通道、流程、技术栈几个角度做一套完整的分析,特别适合你这种在分析和改…...

nnUNet V2修改网络——暴力替换网络为UNet++

更换前,要用nnUNet V2跑通所用数据集,证明nnUNet V2、数据集、运行环境等没有问题 阅读nnU-Net V2 的 U-Net结构,初步了解要修改的网络,知己知彼,修改起来才能游刃有余。 U-Net存在两个局限,一是网络的最佳深度因应用场景而异,这取决于任务的难度和可用于训练的标注数…...