基于 ceph-deploy 部署 Ceph 集群 超详细

Ceph part1

- 一、存储基础

- 1.1 单机存储设备

- 1.2 单机存储的问题

- 1.3 单机存储问题的解决方案

- 1.3.1 商业存储解决方案

- 1.3.2 分布式存储(软件定义的存储 SDS)

- 二、分布式存储

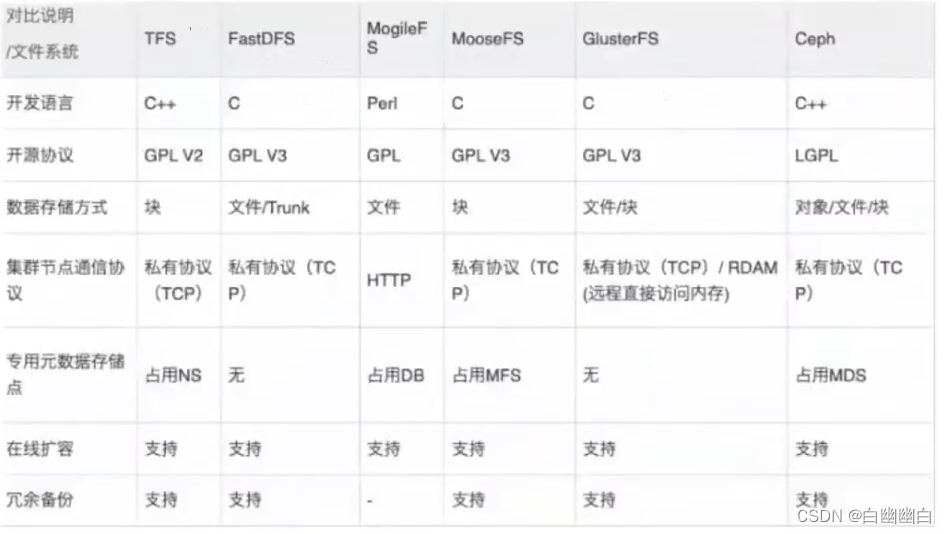

- 2.1 常见的分布式存储

- 2.2 分布式存储的类型

- 三、Ceph概述

- 3.1 Ceph简介

- 3.2 Ceph 优势

- 3.3 Ceph 架构

- 3.4 Ceph 核心组件

- 3.5 OSD 存储后端

- 3.5.1 方式一:Filestore

- 3.5.2 方式二:Bluestore

- BlueStore 的主要功能

- 3.6 Ceph 数据的存储过程(重点)

- 3.7 Ceph 版本发行生命周期

- 3.8 Ceph 集群部署

- 四、基于 ceph-deploy 部署 Ceph 集群

- 4.1 环境准备

- Step1 关闭 防火墙、selinux

- Step2 修改主机名,创建管理用户

- Step3 修改本地hosts文件,添加域名映射

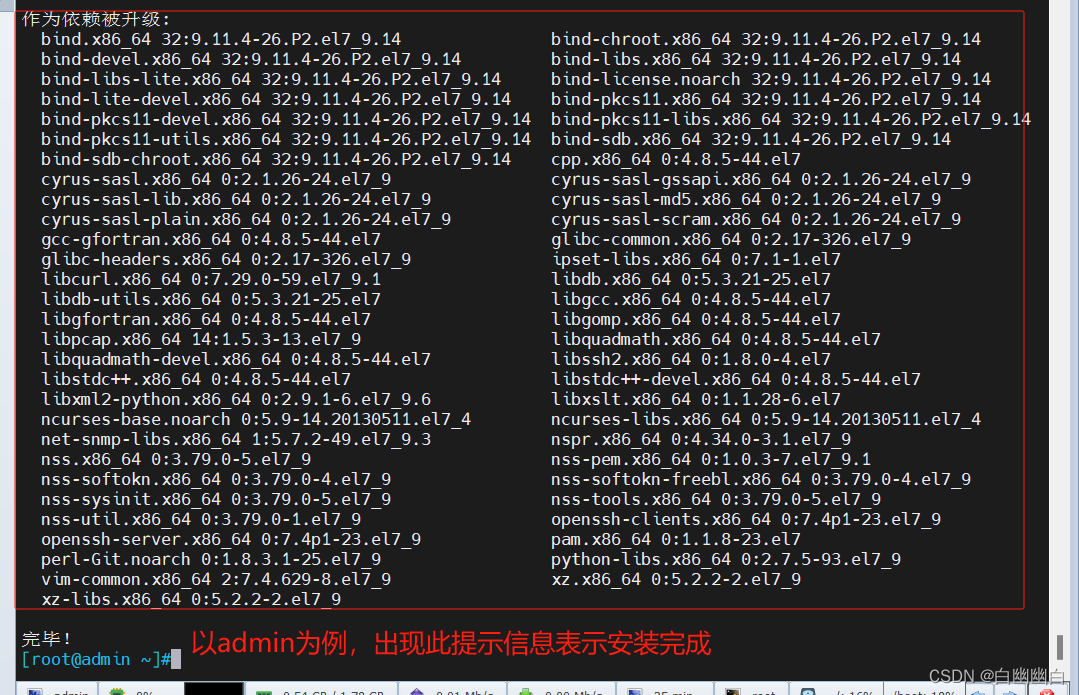

- Step4 安装常用软件和依赖包

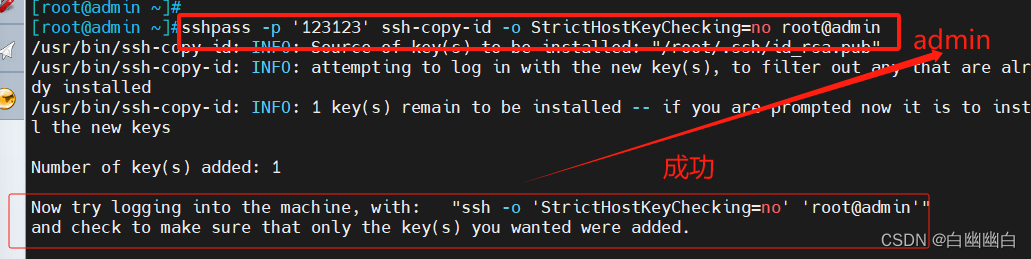

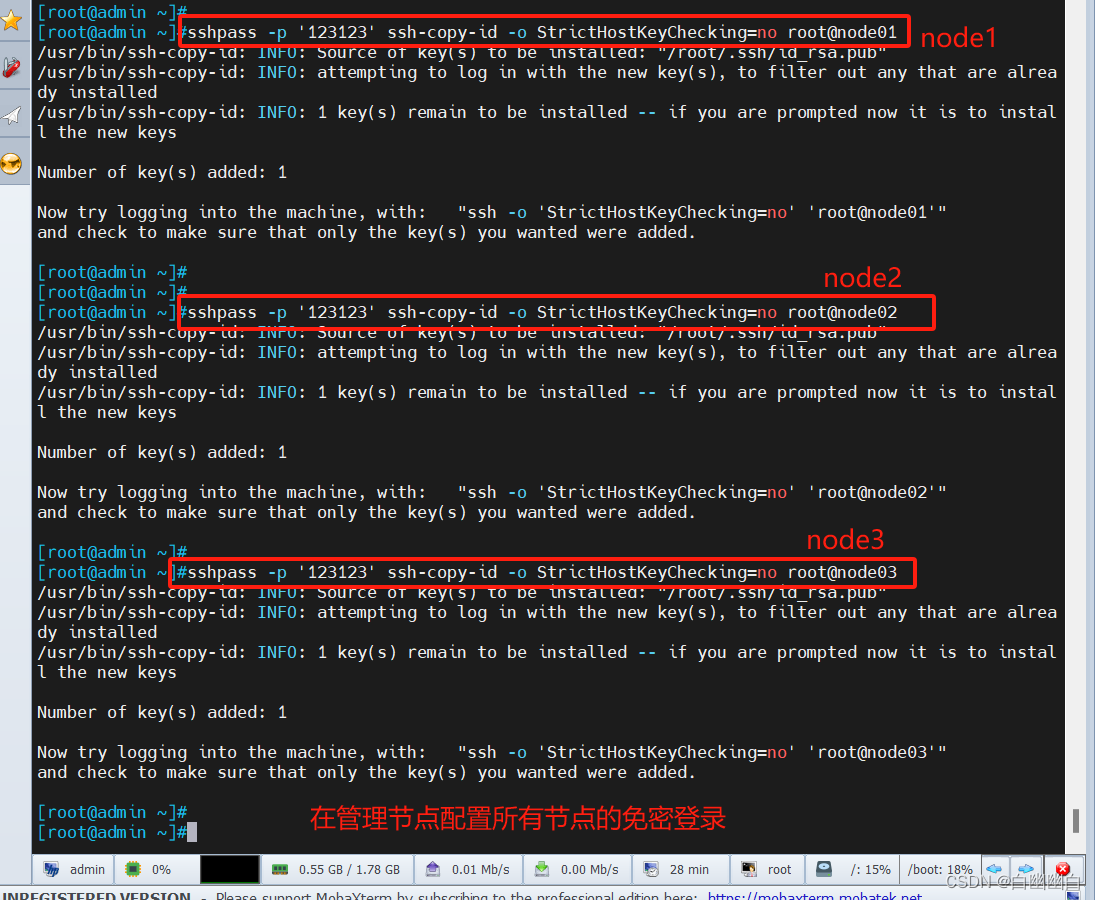

- Step5 在 admin 管理节点配置 ssh 免密登录所有节点

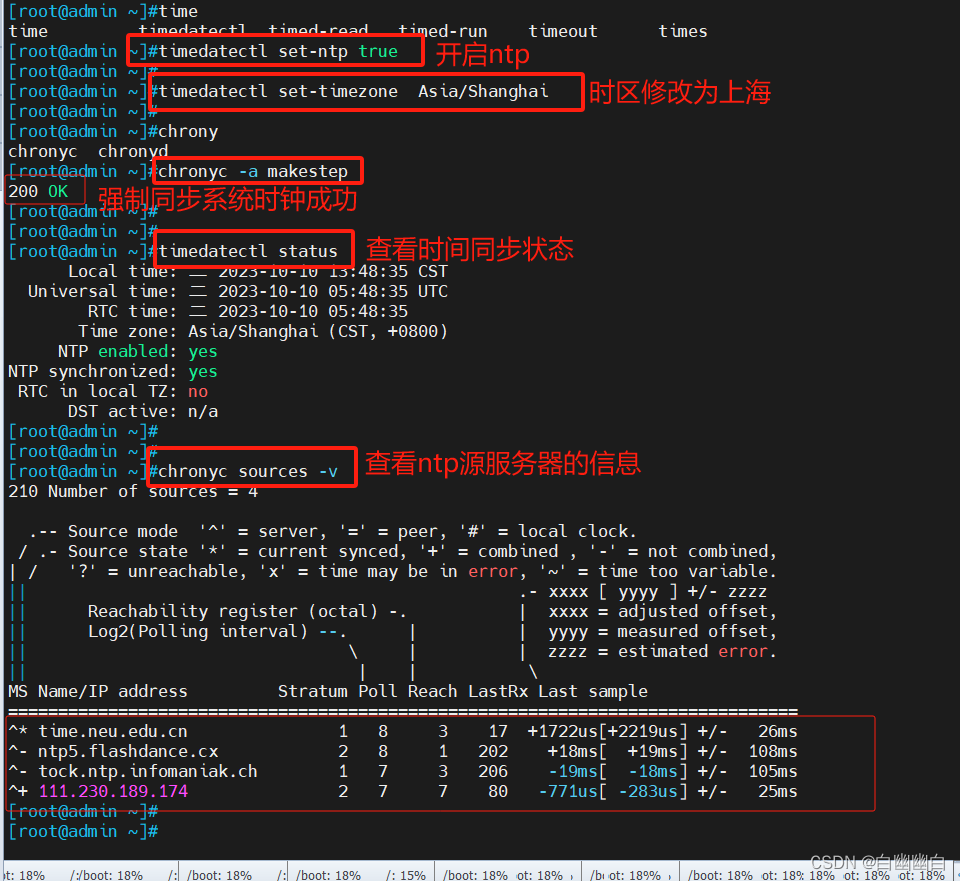

- Step6 配置时间同步(一定要做)

- Step7 配置 Ceph yum源

- Step8 组件节点配置双网卡

- Step9 重启所有主机(可选)

- 4.2 部署 Ceph 集群

- Step1 为所有节点创建 Ceph 工作目录

- Step2 安装 ceph-deploy 部署工具

- Step3 在管理节点为其它节点安装 Ceph 软件包

- Step4 生成初始配置

- Step5 在管理节点初始化 mon 节点

- Step6 部署能够管理 Ceph 集群的节点(可选)

- Step7 部署 osd 存储节点

- Step8 部署 mgr 节点

- Step9 开启监控模块

一、存储基础

1.1 单机存储设备

●DAS(直接附加存储,是直接接到计算机的主板总线上去的存储)

IDE、SATA、SCSI、SAS、USB 接口的磁盘

所谓接口就是一种存储设备驱动下的磁盘设备,提供块级别的存储

●NAS(网络附加存储,是通过网络附加到当前主机文件系统之上的存储)

NFS、CIFS、FTP

文件系统级别的存储,本身就是一个做好的文件系统,通过nfs接口在用户空间输出后,客户端基于内核模块与远程主机进行网络通信,把它转为好像本地文件系统一样来使用,这种存储服务是没办法对它再一次格式化创建文件系统块的

●SAN(存储区域网络)

SCSI协议(只是用来传输数据的存取操作,物理层使用SCSI线缆来传输)、FCSAN(物理层使用光纤来传输)、iSCSI(物理层使用以太网来传输)

也是一种网络存储,但不同之处在于SAN提供给客户端主机使用的接口是块级别的存储

1.2 单机存储的问题

●存储处理能力不足

传统的IDE的IO值是100次/秒,SATA固态磁盘500次/秒,固态硬盘达到2000-4000次/秒。即使磁盘的IO能力再大数十倍,也不够抗住网站访问高峰期数十万、数百万甚至上亿用户的同时访问,这同时还要受到主机网络IO能力的限制。

●存储空间能力不足

单块磁盘的容量再大,也无法满足用户的正常访问所需的数据容量限制。

●单点故障问题

单机存储数据存在单点故障问题

1.3 单机存储问题的解决方案

1.3.1 商业存储解决方案

EMC、NetAPP、IBM、DELL、华为、浪潮

1.3.2 分布式存储(软件定义的存储 SDS)

Ceph、TFS、FastDFS、MooseFS(MFS)、HDFS、GlusterFS(GFS)

存储机制会把数据分散存储到多个节点上,具有高扩展性、高性能、高可用性等优点。

二、分布式存储

2.1 常见的分布式存储

2.2 分布式存储的类型

1)块存储

就是一个裸设备,用于提供没有被组织过的存储空间,底层以分块的方式来存储数据;

例如硬盘,一般是一个存储被一个服务器挂载使用,适用于容器或虚拟机存储卷分配、日志存储、文件存储。

2)文件存储

是一种数据的组织存放接口,一般是建立在块级别的存储结构之上,以文件形式来存储数据,而文件的元数据和实际数据是分开存储的;

例如NFS,解决块存储无法共享问题,可以一个存储被多个服务器同时挂载,适用于目录结构的存储、日志存储。

3)对象存储

基于API接口提供的文件存储,每一个文件都是一个对象,且文件大小各不相同的,文件的元数据和实际数据是存放在一起的;

例如OSS,一个存储可以被多服务同时访问,具备块存储的高速读写能力,也具备文件存储共享的特性,适用图片存储、视频存储。

三、Ceph概述

3.1 Ceph简介

Ceph使用C++语言开发,是一个开放、自我修复和自我管理的开源分布式存储系统。

具有高扩展性、高性能、高可靠性的优点。

Ceph目前已得到众多云计算厂商的支持并被广泛应用。

RedHat及OpenStack,Kubernetes都可与Ceph整合以支持虚拟机镜像的后端存储。

3.2 Ceph 优势

●高扩展性

去中心化,支持使用普通X86服务器,支持上千个存储节点的规模,支持TB到EB级的扩展。

●高可靠性

没有单点故障,多数据副本,自动管理,自动修复。

●高性能

摒弃了传统的集中式存储元数据寻址的方案,采用 CRUSH 算法,数据分布均衡,并行度高。

●功能强大

Ceph是个大一统的存储系统,集块存储接口(RBD)、文件存储接口(CephFS)、对象存储接口(RadosGW)于一身,因而适用于不同的应用场景。

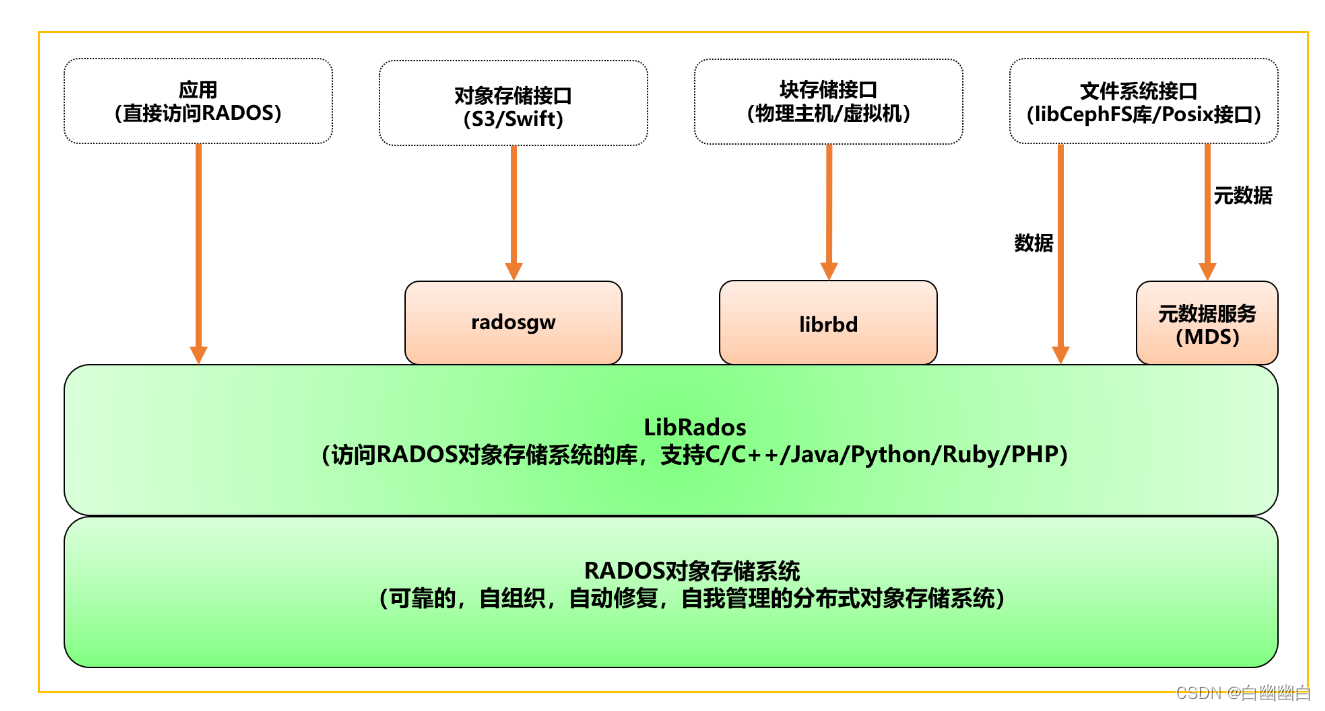

3.3 Ceph 架构

自下向上,可以将Ceph系统分为四个层次:

1)RADOS 基础存储系统

RADOS,(Reliab1e,Autonomic,Distributed object store),即可靠的、自动化的、分布式的对象存储。

RADOS是Ceph最底层的功能模块,是一个无限可扩容的对象存储服务,能将文件拆解成无数个对象(碎片)存放在硬盘中,大大提高了数据的稳定性。

它主要由OSD和Monitor两个组件组成,OSD和Monitor都可以部署在多台服务器中,这就是ceph分布式的由来,高扩展性的由来。

2)LIBRADOS 基础库

Librados提供了与RADOS进行交互的方式,并向上层应用提供Ceph服务的API接

口,因此上层的RBD、RGW和CephFS都是通过Librados访问的;

目前提供PHP、Ruby、Java、Python、Go、C和C++支持,以便直接基于RADOS(而不是整个Ceph)进行客户端应用开发。

3)高层应用接口

-

对象存储接口 RGW(RADOS Gateway)

网关接口,基于Librados开发的对象存储系统,提供S3和Swift兼容的RESTful API接口。 -

块存储接口 RBD(Reliable Block Device)

基于Librados提供块设备接口,主要用于Host/VM。 -

文件存储接口 CephFS(Ceph File System)

Ceph文件系统,提供了一个符合POSIX标准的文件系统,它使用Ceph存储集群在文件系统上存储用户数据。基于Librados提供的分布式文件系统接口。

4)应用层

基于高层接口或者基础库Librados开发出来的各种APP,或者Host、VM等诸多客户端

3.4 Ceph 核心组件

Ceph中,一切皆对象。

Ceph是一个对象式存储系统,它把每一个待管理的数据流(如文件等数据)切分为一到多个固定大小(默认4兆)的对象数据(Object),并以其为原子单元(原子是构成元素的最小单元)完成数据的读写。

●OSD(Object Storage Daemon,守护进程 ceph-osd)

负责存储数据,一般一个磁盘对应一个OSD,负责响应客户端的读写请求

主要功能是存储数据、复制数据、平衡数据、恢复数据,以及与其它OSD间进行心跳检查,负责响应客户端请求返回具体数据的进程等。

通常至少需要3个OSD来实现冗余和高可用性。

●PG(Placement Group 归置组)

PG 是一个虚拟的概念而已,物理上不真实存在。

它在数据寻址时类似于数据库中的索引:Ceph 先将每个对象数据通过HASH算法固定映射到一个 PG 中,然后将 PG 通过 CRUSH 算法映射到 OSD。

●Pool

Pool 是存储对象的逻辑分区,它起到 namespace 的作用。

每个 Pool 包含一定数量(可配置)的 PG。

Pool 可以做故障隔离域,根据不同的用户场景统一进行隔离。

#Pool中数据保存方式支持两种类型:

●多副本(replicated):类似 raid1,一个对象数据默认保存 3 个副本,放在不同的 OSD

●纠删码(Erasure Code):类似 raid5,对 CPU 消耗稍大,但是节约磁盘空间,对象数据保存只有 1 个副本。由于Ceph部分功能不支持纠删码池,此类型存储池使用不多

#Pool、PG 和 OSD 的关系:

一个Pool里有很多个PG;

一个PG里包含一堆对象,一个对象只能属于一个PG;

PG有主从之分,一个PG分布在不同的OSD上(针对多副本类型)

●Monitor(守护进程 ceph-mon)

负载保存OSD的元数据,维护展示集群状态的各种图表, 管理集群客户端认证与授权

负责维护集群状态的映射视图(Cluster Map:OSD Map、Monitor Map、PG Map 和 CRUSH Map),维护展示集群状态的各种图表, 管理集群客户端认证与授权。

一个Ceph集群通常至少需要 3 或 5 个(奇数个)Monitor 节点才能实现冗余和高可用性,它们通过 Paxos 协议实现节点间的同步数据。

●Manager(守护进程 ceph-mgr)

负责跟踪运行时指标和 Ceph 集群的当前状态,包括存储利用率、当前性能指标和系统负载。

为外部监视和管理系统提供额外的监视和接口,例如 zabbix、prometheus、 cephmetrics 等。

一个 Ceph 集群通常至少需要 2 个 mgr 节点实现高可用性,基于 raft 协议实现节点间的信息同步。

●MDS(Metadata Server,守护进程 ceph-mds)

是 CephFS 服务依赖的元数据服务。

负责保存文件系统的元数据,管理目录结构。

对象存储和块设备存储不需要元数据服务;如果不使用 CephFS 可以不安装。

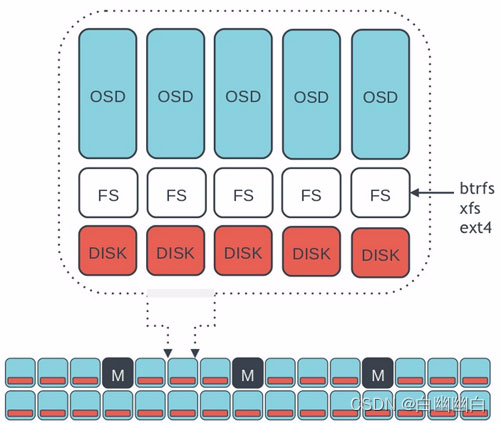

3.5 OSD 存储后端

OSD 有两种方式管理它们存储的数据。

在 Luminous 12.2.z 及以后的发行版中,默认(也是推荐的)后端是 BlueStore。

在 Luminous 发布之前, 默认是 FileStore, 也是唯一的选项。

3.5.1 方式一:Filestore

FileStore是在Ceph中存储对象的一个遗留方法。

它依赖于一个标准文件系统(只能是XFS),并结合一个键/值数据库(传统上是LevelDB,现在BlueStore是RocksDB),用于保存和管理元数据。

FileStore经过了良好的测试,在生产中得到了广泛的应用。

然而,由于它的总体设计和对传统文件系统的依赖,使得它在性能上存在许多不足。

3.5.2 方式二:Bluestore

BlueStore是一个特殊用途的存储后端,专门为OSD工作负载管理磁盘上的数据而设计。

BlueStore 的设计是基于十年来支持和管理 Filestore 的经验。

BlueStore 相较于 Filestore,具有更好的读写性能和安全性。

BlueStore 的主要功能

1)BlueStore直接管理存储设备,即直接使用原始块设备或分区管理磁盘上的数据。

这样就避免了抽象层的介入(例如本地文件系统,如XFS),因为抽象层会限制性能或增加复杂性。

2)BlueStore使用RocksDB进行元数据管理。

RocksDB的键/值数据库是嵌入式的,以便管理内部元数据,包括将对象名称映射到磁盘上的块位置。

3)写入BlueStore的所有数据和元数据都受一个或多个校验和的保护。

未经验证,不会从磁盘读取或返回给用户任何数据或元数据。

4)支持内联压缩。数据在写入磁盘之前可以选择性地进行压缩。

5)支持多设备元数据分层。

BlueStore允许将其内部日志(WAL预写日志)写入单独的高速设备(如SSD、NVMe或NVDIMM),以提高性能。

如果有大量更快的可用存储,则可以将内部元数据存储在更快的设备上。

6)支持高效的写时复制。

RBD和CephFS快照依赖于在BlueStore中有效实现的即写即复制克隆机制。

这将为常规快照和擦除编码池(依赖克隆实现高效的两阶段提交)带来高效的I/O。

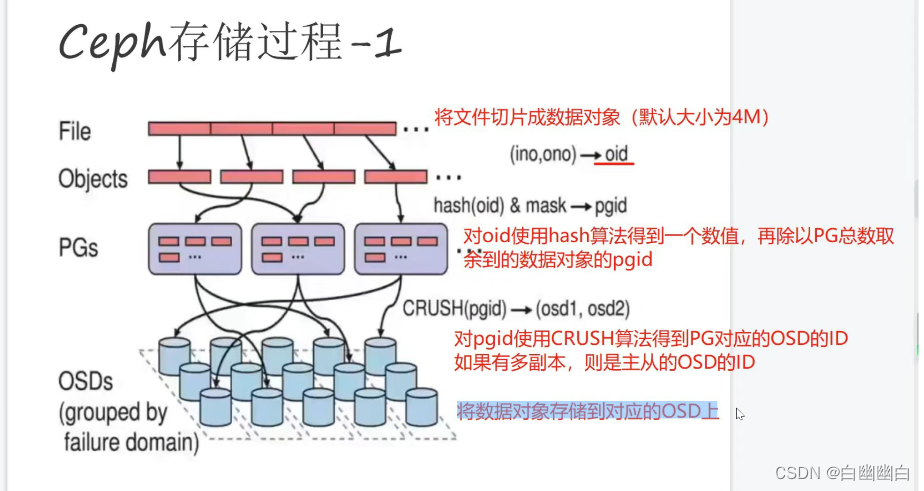

3.6 Ceph 数据的存储过程(重点)

1)文件默认会被按照4M大小进行分片成一个或者多个数据对象(object);

2)每个数据对象(object)都有一个oid(由文件ID(ino)和分片编号(non组成),通过对oid使用hash算法得到一个16进制的特征码,再除以Pool的PG总数取余,得到数据对象(object)的pgid(由Pool_id+pgid组成);

3)通过对pgid使用CRUSH算法得到PG对应的OSD的ID(如果是多副本,则是主从的OSD的ID);

4)将数据对象(object)的数据存储到对应的OSD上。

3.7 Ceph 版本发行生命周期

Ceph从Nautilus版本(14.2.0)开始,每年都会有一个新的稳定版发行,预计是每年的3月份发布,每年的新版本都会起一个新的名称(例如,“Mimic”)和一个主版本号(例如,13代表Mimic,因为“M”是字母表的第13个字母)。

版本号的格式为 x.y.z,x 表示发布周期(例如,13 代表 Mimic,17 代表 Quincy),y 表示发布版本类型,即

● x.0.z :y等于 0,表示开发版本

● x.1.z :y等于 1,表示发布候选版本(用于测试集群)

● x.2.z :y等于 2,表示稳定/错误修复版本(针对用户)

3.8 Ceph 集群部署

目前 Ceph 官方提供很多种部署 Ceph 集群的方法,常用的分别是 ceph-deploy,cephadm 和 二进制

●ceph-deploy :一个集群自动化部署工具,使用较久,成熟稳定,被很多自动化工具所集成,可用于生产部署。

●cephadm :从 Octopus 和较新的版本版本后使用 cephadm 来部署 ceph 集群,使用容器和 systemd 安装和管理 Ceph 集群。目前不建议用于生产环境。

●二进制:手动部署,一步步部署 Ceph 集群,支持较多定制化和了解部署细节,安装难度较大。

四、基于 ceph-deploy 部署 Ceph 集群

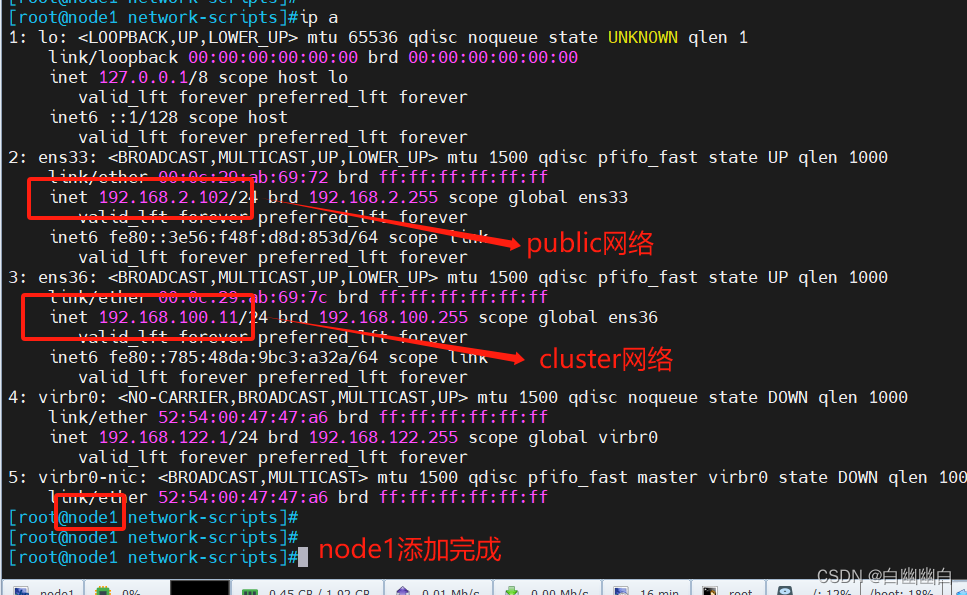

| 主机名 | Public网络 | Cluster网络 | Role |

|---|---|---|---|

| admin | 192.168.2.100 | admin(管理节点负责集群整体部署)、client | |

| node01 | 192.168.2.102 | 192.168.100.11 | mon、mgr、osd(/dev/sdb、/dev/sdc、/dev/sdd) |

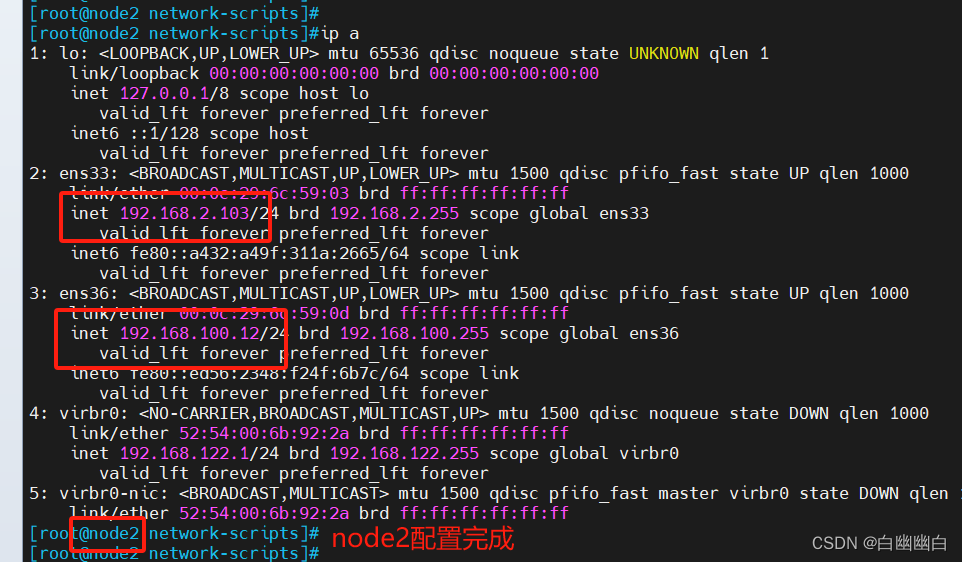

| node02 | 192.168.2.103 | 192.168.100.12 | mon、mgr、osd(/dev/sdb、/dev/sdc、/dev/sdd) |

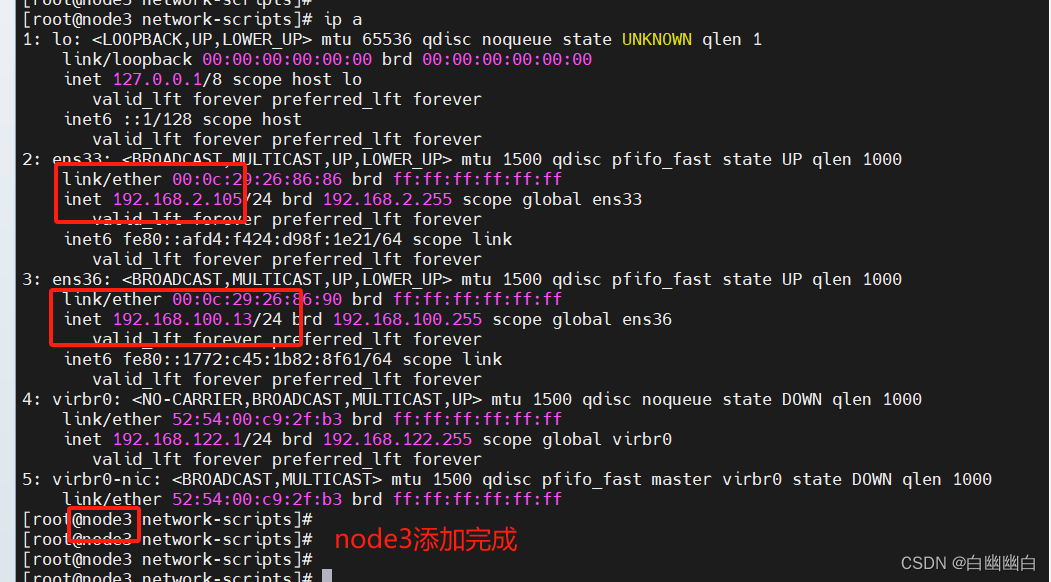

| node03 | 192.168.2.105 | 192.168.100.13 | mon、osd(/dev/sdb、/dev/sdc、/dev/sdd) |

| client | 192.168.2.106 | client |

由于是测试环境,可以让多个组件运行在同一个主机上。

业务网络:puplic network

存储网络:cluster network

4.1 环境准备

Step1 关闭 防火墙、selinux

systemctl disable --now firewalld

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

Step2 修改主机名,创建管理用户

hostnamectl set-hostname admin

hostnamectl set-hostname node01

hostnamectl set-hostname node02

hostnamectl set-hostname node03

hostnamectl set-hostname client#创建 Ceph 的管理用户

useradd cephadm

passwd cephadmvisudo

cephadm ALL=(root) NOPASSWD:ALL

Step3 修改本地hosts文件,添加域名映射

cat >> /etc/hosts << EOF

192.168.2.100 admin

192.168.2.102 node01

192.168.2.103 node02

192.168.2.105 node03

192.168.2.106 client

EOF

Step4 安装常用软件和依赖包

yum -y install epel-releaseyum -y install yum-plugin-priorities yum-utils ntpdate python-setuptools python-pip gcc gcc-c++ autoconf libjpeg libjpeg-devel libpng libpng-devel freetype freetype-devel libxml2 libxml2-devel zlib zlib-devel glibc glibc-devel glib2 glib2-devel bzip2 bzip2-devel zip unzip ncurses ncurses-devel curl curl-devel e2fsprogs e2fsprogs-devel krb5-devel libidn libidn-devel openssl openssh openssl-devel nss_ldap openldap openldap-devel openldap-clients openldap-servers libxslt-devel libevent-devel ntp libtool-ltdl bison libtool vim-enhanced python wget lsof iptraf strace lrzsz kernel-devel kernel-headers pam-devel tcl tk cmake ncurses-devel bison setuptool popt-devel net-snmp screen perl-devel pcre-devel net-snmp screen tcpdump rsync sysstat man iptables sudo libconfig git bind-utils tmux elinks numactl iftop bwm-ng net-tools expect snappy leveldb gdisk python-argparse gperftools-libs conntrack ipset jq libseccomp socat chrony sshpass

Step5 在 admin 管理节点配置 ssh 免密登录所有节点

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsasshpass -p '123123' ssh-copy-id -o StrictHostKeyChecking=no root@adminsshpass -p '123123' ssh-copy-id -o StrictHostKeyChecking=no root@node01sshpass -p '123123' ssh-copy-id -o StrictHostKeyChecking=no root@node02sshpass -p '123123' ssh-copy-id -o StrictHostKeyChecking=no root@node03

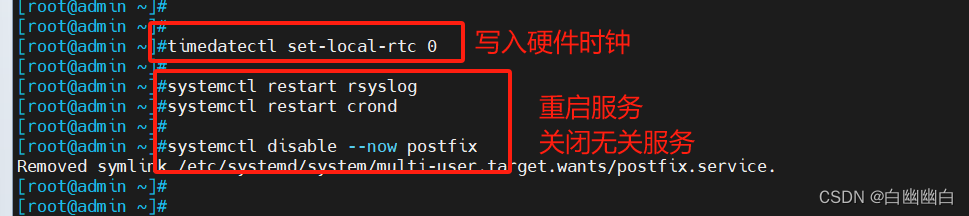

Step6 配置时间同步(一定要做)

systemctl enable --now chronydtimedatectl set-ntp true

#开启 NTP

timedatectl set-timezone Asia/Shanghai

#设置时区

chronyc -a makestep

#强制同步下系统时钟

timedatectl status

#查看时间同步状态

chronyc sources -v

#查看 ntp 源服务器信息

timedatectl set-local-rtc 0

#将当前的UTC时间写入硬件时钟#重启依赖于系统时间的服务

systemctl restart rsyslog crond

systemctl restart crond#关闭无关服务

systemctl disable --now postfix

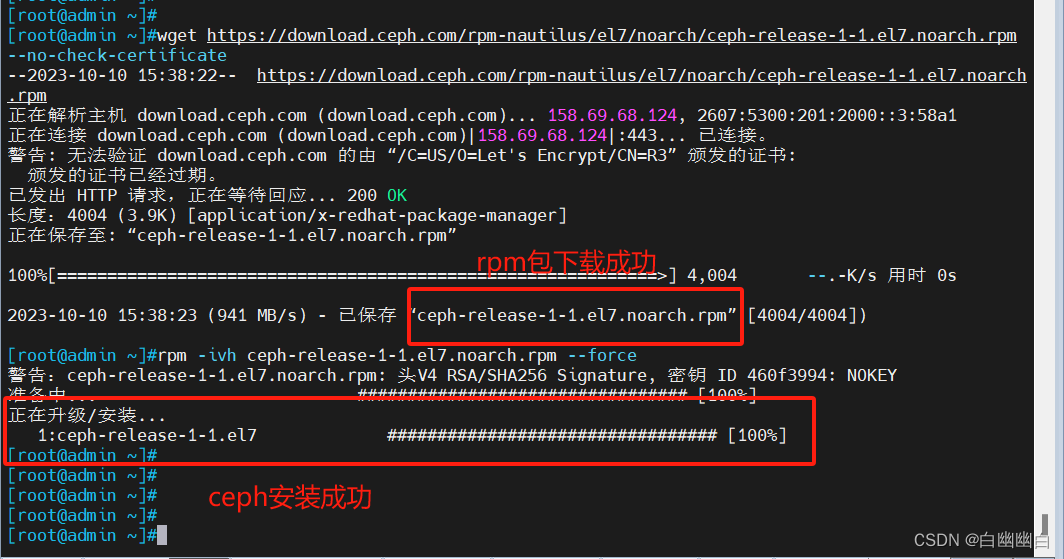

Step7 配置 Ceph yum源

#下载 Ceph 存储系统的 RPM 安装包

wget https://download.ceph.com/rpm-nautilus/el7/noarch/ceph-release-1-1.el7.noarch.rpm --no-check-certificate#rpm安装ceph存储系统

rpm -ivh ceph-release-1-1.el7.noarch.rpm --force

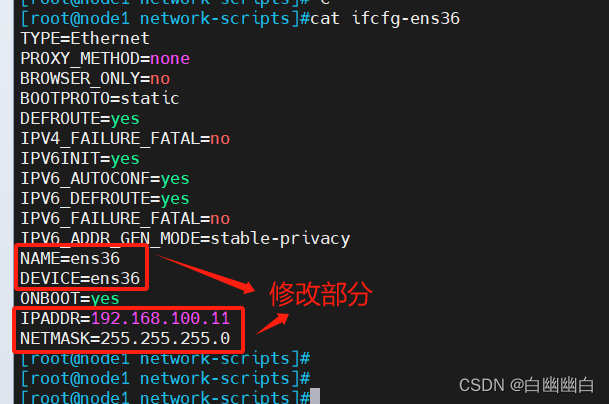

Step8 组件节点配置双网卡

#node1 node2 node3

poweoff

然后添加网卡

#添加完成后,修改新网卡的IP地址

#不需要网关和dns

##以node1为例##

cd /etc/sysconfig/network-scripts/cp ifcfg-ens33 ifcfg-ens36vim ifcfg-ens36

#修改完成后,重启服务

systemctl restart network#然后通过scp,传输配置文件,修改

scp 192.168.2.102:/etc/sysconfig/network-scripts/ifcfg-ens36 /etc/sysconfig/network-scripts/

Step9 重启所有主机(可选)

sync

reboot

4.2 部署 Ceph 集群

Step1 为所有节点创建 Ceph 工作目录

后续的工作都在该目录下进行

mkdir -p /etc/ceph

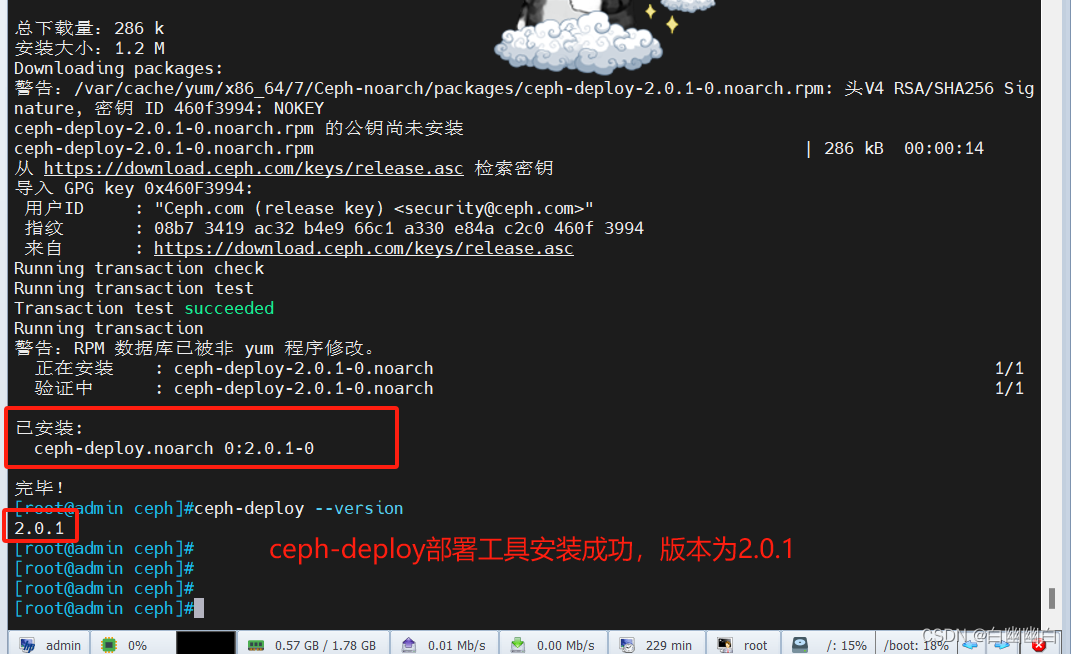

Step2 安装 ceph-deploy 部署工具

#管理节点

cd /etc/ceph#安装

yum install -y ceph-deploy

#查看版本

ceph-deploy --version

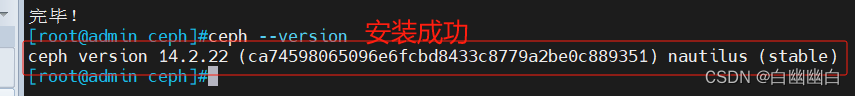

Step3 在管理节点为其它节点安装 Ceph 软件包

#ceph-deploy 2.0.1 默认部署的是 mimic 版的 Ceph,若想安装其他版本的 Ceph,可以用 --release 手动指定版本

cd /etc/ceph

ceph-deploy install --release nautilus node0{1..3} admin#ceph-deploy install 本质就是在执行下面的命令:

yum clean all

yum -y install epel-release

yum -y install yum-plugin-priorities

yum -y install ceph-release ceph ceph-radosgw#也可采用手动安装 Ceph 包方式,在其它节点上执行下面的命令将 Ceph 的安装包都部署上:

sed -i 's#download.ceph.com#mirrors.tuna.tsinghua.edu.cn/ceph#' /etc/yum.repos.d/ceph.repo

yum install -y ceph-mon ceph-radosgw ceph-mds ceph-mgr ceph-osd ceph-common ceph

Step4 生成初始配置

#在管理节点运行下述命令,告诉 ceph-deploy 哪些是 mon 监控节点

cd /etc/ceph

ceph-deploy new --public-network 192.168.2.0/24 --cluster-network 192.168.100.0/24 node01 node02 node03

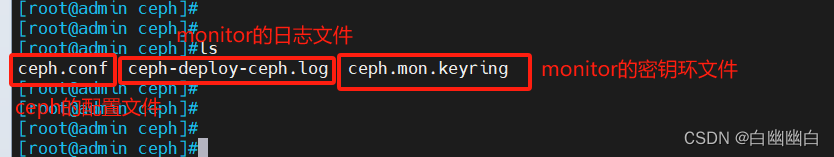

#命令执行成功后会在 /etc/ceph 下生成配置文件

ls /etc/ceph

ceph.conf #ceph的配置文件

ceph-deploy-ceph.log #monitor的日志

ceph.mon.keyring #monitor的密钥环文件

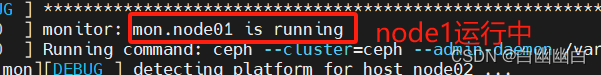

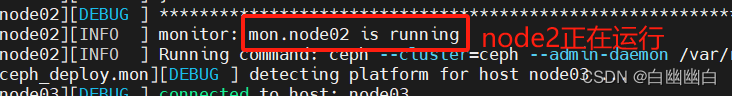

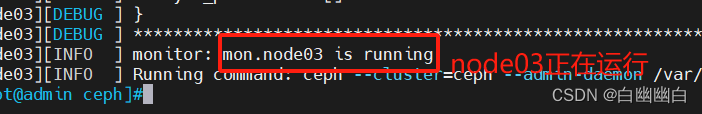

Step5 在管理节点初始化 mon 节点

cd /etc/cephceph-deploy mon create node01 node02 node03

#创建 mon 节点,由于 monitor 使用 Paxos 算法,其高可用集群节点数量要求为大于等于 3 的奇数台

ceph-deploy --overwrite-conf mon create-initial

#配置初始化 mon 节点,并向所有节点同步配置

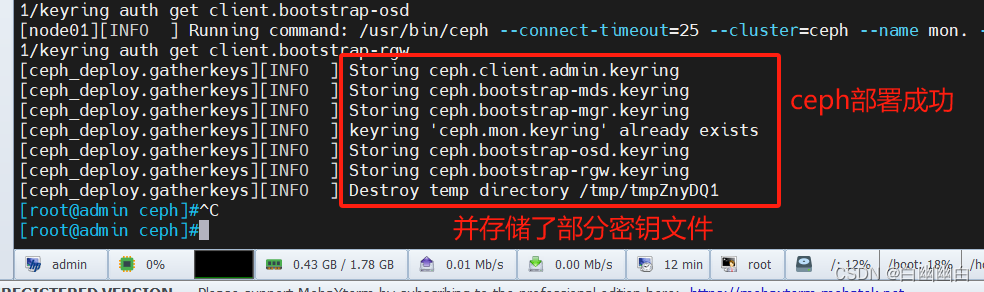

# --overwrite-conf 参数用于表示强制覆盖配置文件ceph-deploy gatherkeys node01

#可选操作,向 node01 节点收集所有密钥

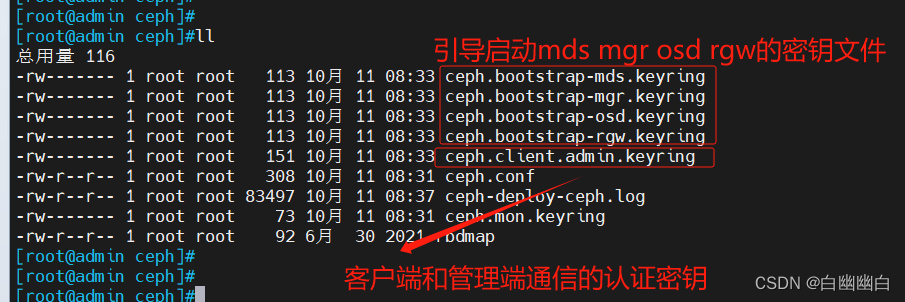

#命令执行成功后会在 /etc/ceph 下生成配置文件

ls /etc/cephceph.bootstrap-mds.keyring

#引导启动 mds 的密钥文件ceph.bootstrap-mgr.keyring

#引导启动 mgr 的密钥文件ceph.bootstrap-osd.keyring

#引导启动 osd 的密钥文件ceph.bootstrap-rgw.keyring

#引导启动 rgw 的密钥文件ceph.client.admin.keyring

#ceph客户端和管理端通信的认证密钥,拥有ceph集群的所有权限ceph.confceph-deploy-ceph.logceph.mon.keyring

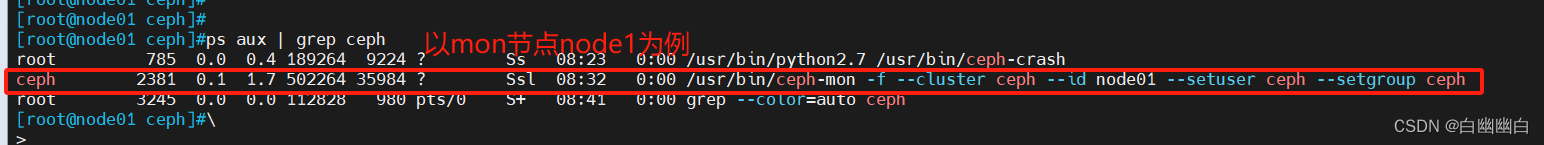

#在 mon 节点上查看自动开启的 mon 进程

ps aux | grep ceph

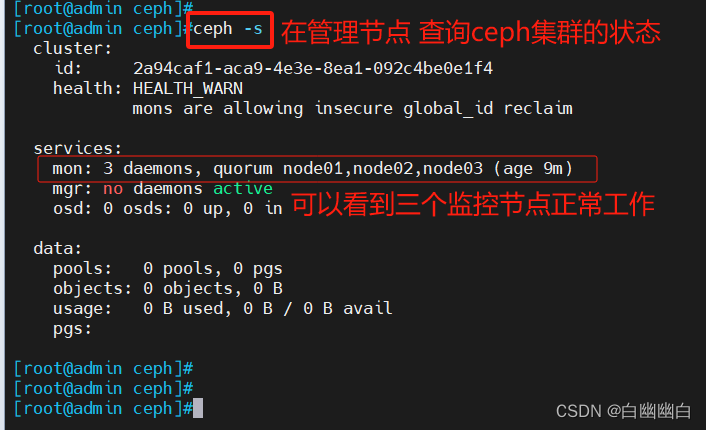

#在管理节点查看 Ceph 集群状态

cd /etc/ceph

ceph -s

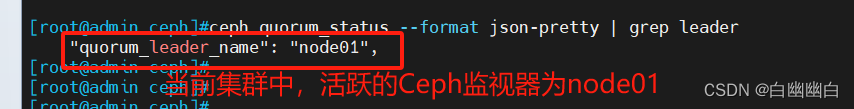

#查看 mon 集群选举的情况

ceph quorum_status --format json-pretty | grep leader

#补充知识,扩容 mon 节点

ceph-deploy mon add <节点名称>

Step6 部署能够管理 Ceph 集群的节点(可选)

#可实现在各个节点执行 ceph 命令管理集群

cd /etc/cephceph-deploy --overwrite-conf config push node01 node02 node03

#向所有 mon 节点同步配置,确保所有 mon 节点上的 ceph.conf 内容必须一致

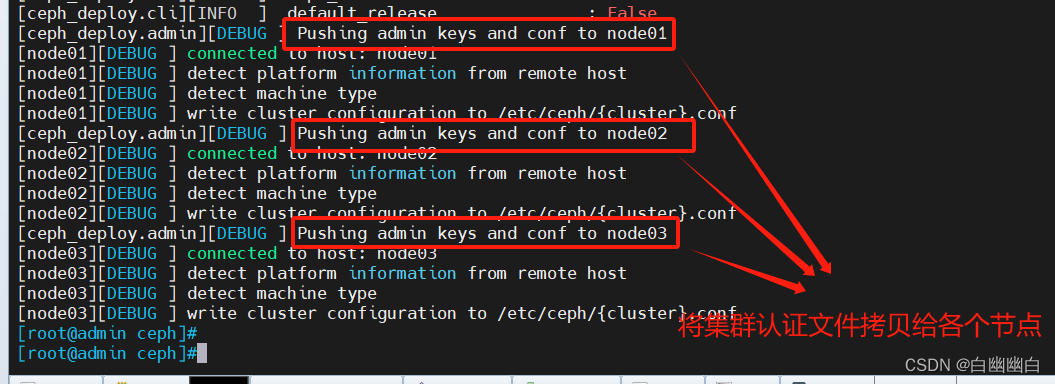

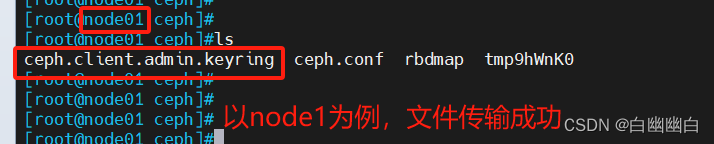

ceph-deploy admin node01 node02 node03

#本质就是把 ceph.client.admin.keyring 集群认证文件拷贝到各个节点

#在 mon 节点上查看

ls /etc/cephceph -s

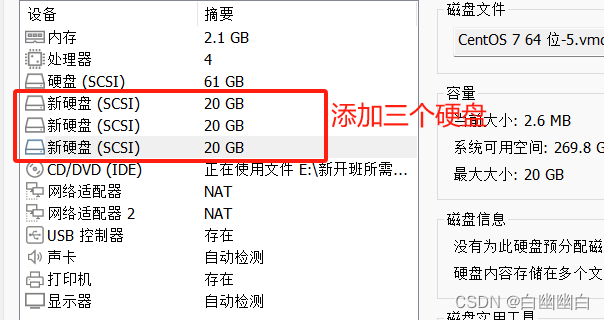

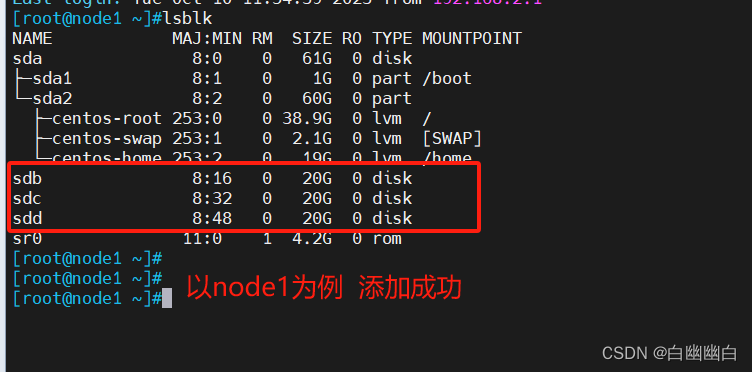

Step7 部署 osd 存储节点

node01 node02 node03 添加硬盘

#主机添加完硬盘后不要分区,直接使用

lsblk #如果是利旧的硬盘,则需要先擦净(删除分区表)磁盘(可选,无数据的新硬盘可不做)

cd /etc/ceph

ceph-deploy disk zap node01 /dev/sdb

ceph-deploy disk zap node02 /dev/sdb

ceph-deploy disk zap node03 /dev/sdb

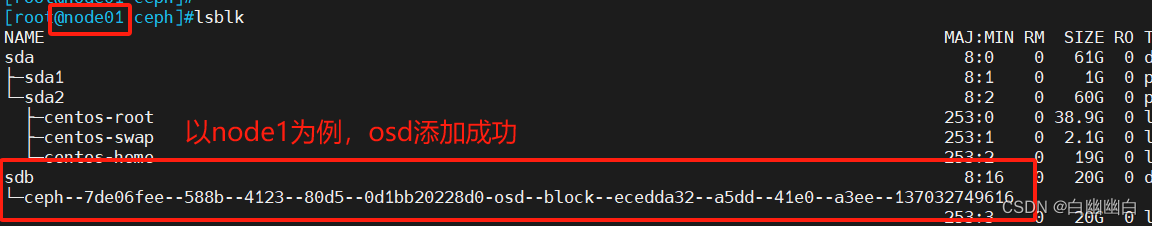

#在管理节点,为node1 2 3 添加 osd 节点

ceph-deploy --overwrite-conf osd create node01 --data /dev/sdb

ceph-deploy --overwrite-conf osd create node02 --data /dev/sdb

ceph-deploy --overwrite-conf osd create node03 --data /dev/sdb

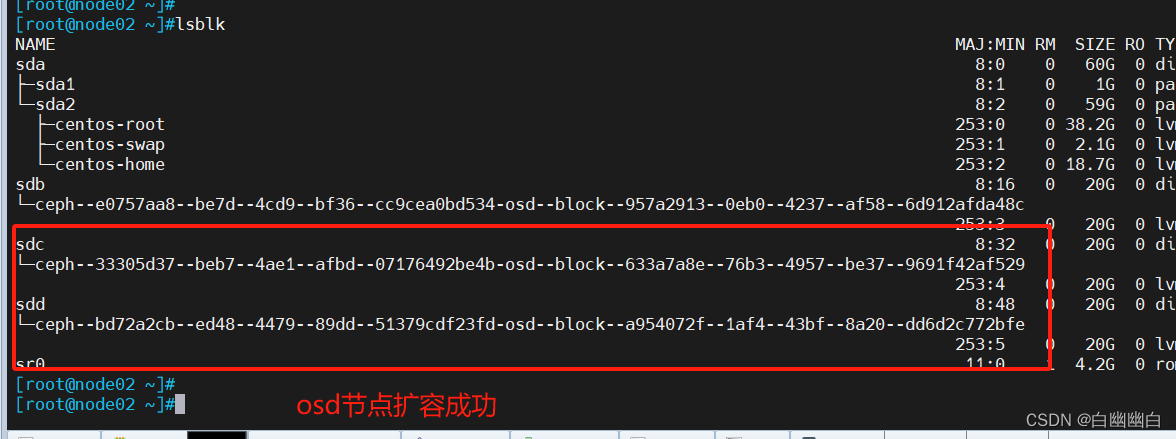

#扩容 osd 节点

cd /etc/ceph

ceph-deploy --overwrite-conf osd create node01 --data /dev/sdc

ceph-deploy --overwrite-conf osd create node02 --data /dev/sdc

ceph-deploy --overwrite-conf osd create node03 --data /dev/sdc

ceph-deploy --overwrite-conf osd create node01 --data /dev/sdd

ceph-deploy --overwrite-conf osd create node02 --data /dev/sdd

ceph-deploy --overwrite-conf osd create node03 --data /dev/sdd#添加 OSD 中会涉及到 PG 的迁移

#由于此时集群并没有数据,因此 health 的状态很快就变成 OK

#如果在生产环境中添加节点则会涉及到大量的数据的迁移。

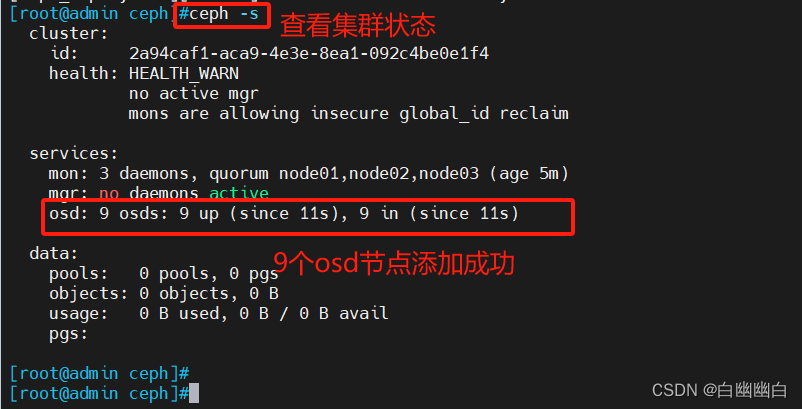

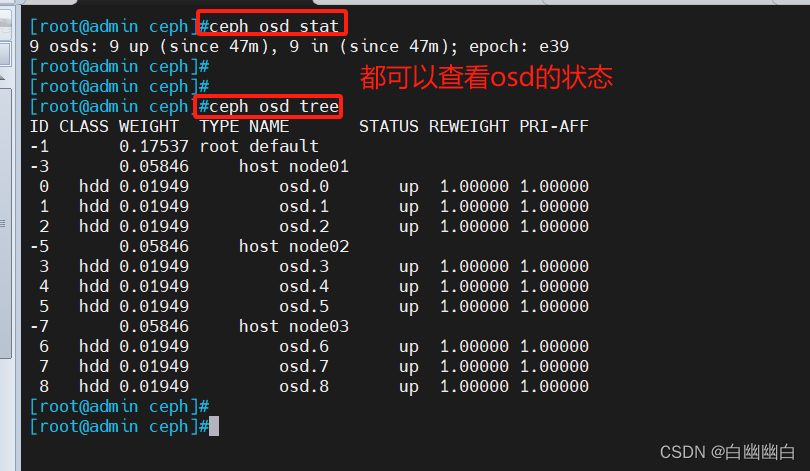

#查看 ceph 集群状态

ceph -s

#查看osd状态

ceph osd statceph osd tree

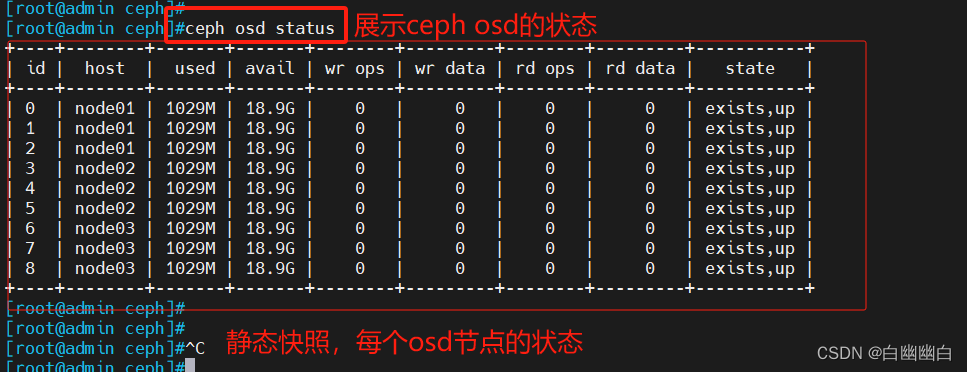

ceph osd status #查看 osd 状态,需部署 mgr 后才能执行- `id`: OSD的唯一标识符。

- `host`: OSD所在的主机名

- `used`: OSD已使用的存储容量。

- `avail`: OSD可用的存储容量。

- `wr ops`: OSD每秒写入操作的数量。

- `wr data`: OSD每秒写入数据的数量。

- `rd ops`: OSD每秒读取操作的数量。

- `rd data`: OSD每秒读取数据的数量。

- `state`: OSD的状态,"exists"表示OSD存在,"up"表示OSD正常运行。

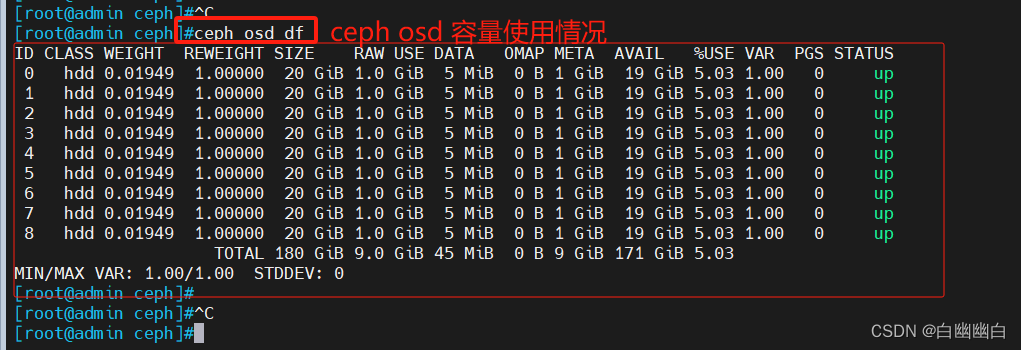

ceph osd df #查看 osd 容量,需部署 mgr 后才能执行- `ID`: OSD的唯一标识符。

- `CLASS`: OSD的存储类别。

- `WEIGHT`: OSD的权重。

- `REWEIGHT`: OSD的重新加权比例。

- `SIZE`: OSD的总存储容量。

- `RAW USE`: OSD当前使用的原始存储容量。

- `DATA`: OSD数据存储使用量。

- `OMAP`: OSD的OMAP(Object Map)数据存储使用量。

- `META`: OSD元数据存储使用量。

- `AVAIL`: OSD可用的存储容量。

- `%USE`: OSD使用率百分比。

- `VAR`: OSD使用率方差。

- `PGS`: OSD分布的PG(Placement Group)数量。

- `STATUS`: OSD的状态,"up"表示OSD正常运行。

Step8 部署 mgr 节点

管理节点上操作

#ceph-mgr守护进程以Active/Standby模式运行,可确保在Active节点或其ceph-mgr守护进程故障时,其中的一个Standby实例可以在不中断服务的情况下接管其任务。

#根据官方的架构原则,mgr至少要有两个节点来进行工作。

cd /etc/cephceph-deploy mgr create node01 node02#查看 ceph 集群状态

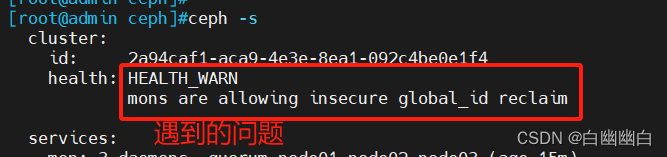

ceph -s

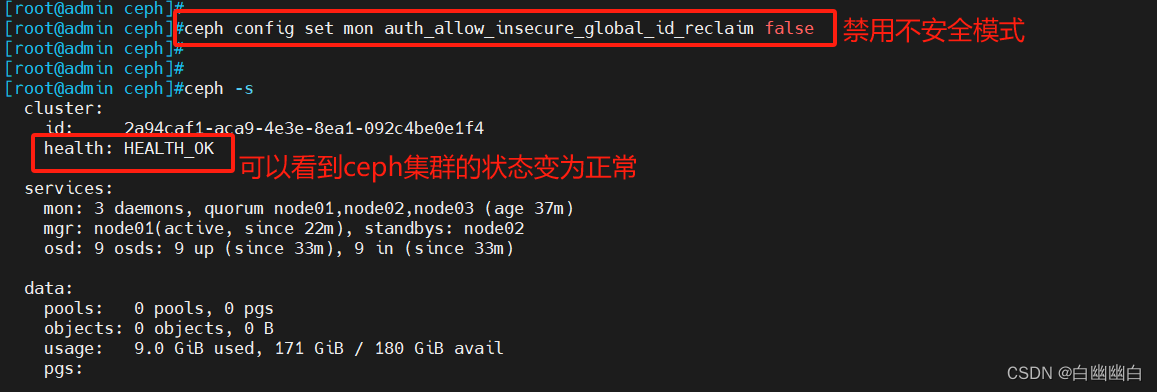

#解决 HEALTH_WARN

#问题:mons are allowing insecure global_id reclaim

#禁用不安全模式

ceph config set mon auth_allow_insecure_global_id_reclaim false

#补充知识,扩容 mgr 节点

ceph-deploy mgr create <节点名称>

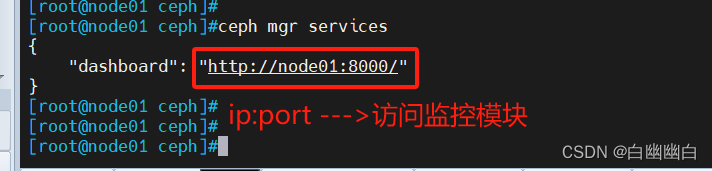

Step9 开启监控模块

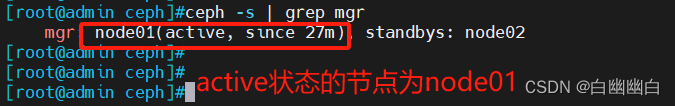

#在 ceph-mgr Active节点执行命令开启

#active状态的节点 用ceph -s查看

ceph -s | grep mgr

#在node01执行

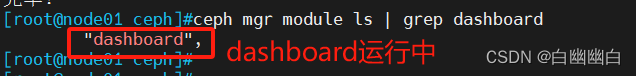

#安装监控模块

yum install -y ceph-mgr-dashboardcd /etc/cephceph mgr module ls | grep dashboard

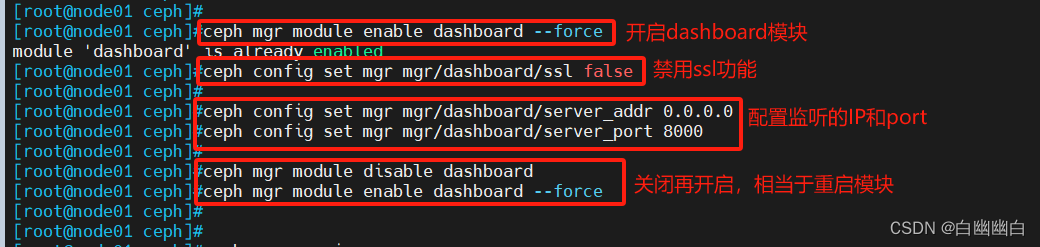

#开启 dashboard 模块

ceph mgr module enable dashboard --force#禁用 dashboard 的 ssl 功能

ceph config set mgr mgr/dashboard/ssl false#配置 dashboard 监听的地址和端口

ceph config set mgr mgr/dashboard/server_addr 0.0.0.0

ceph config set mgr mgr/dashboard/server_port 8000#重启 dashboard

ceph mgr module disable dashboard

ceph mgr module enable dashboard --force

#确认访问 dashboard 的 url

ceph mgr services

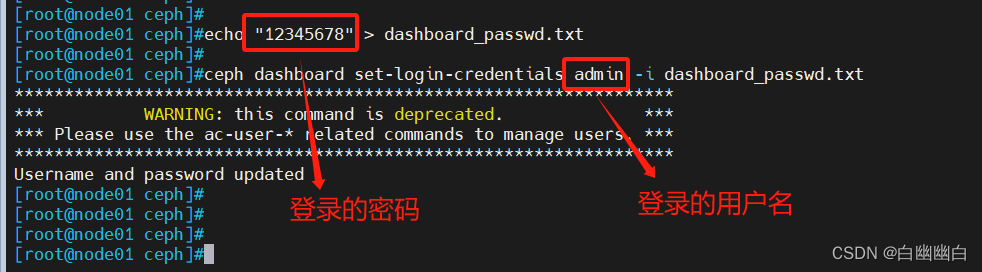

#设置 dashboard 账户以及密码

#方式一

echo "12345678" > dashboard_passwd.txt

ceph dashboard set-login-credentials admin -i dashboard_passwd.txt#方式二

ceph dashboard ac-user-create admin administrator -i dashboard_passwd.txt

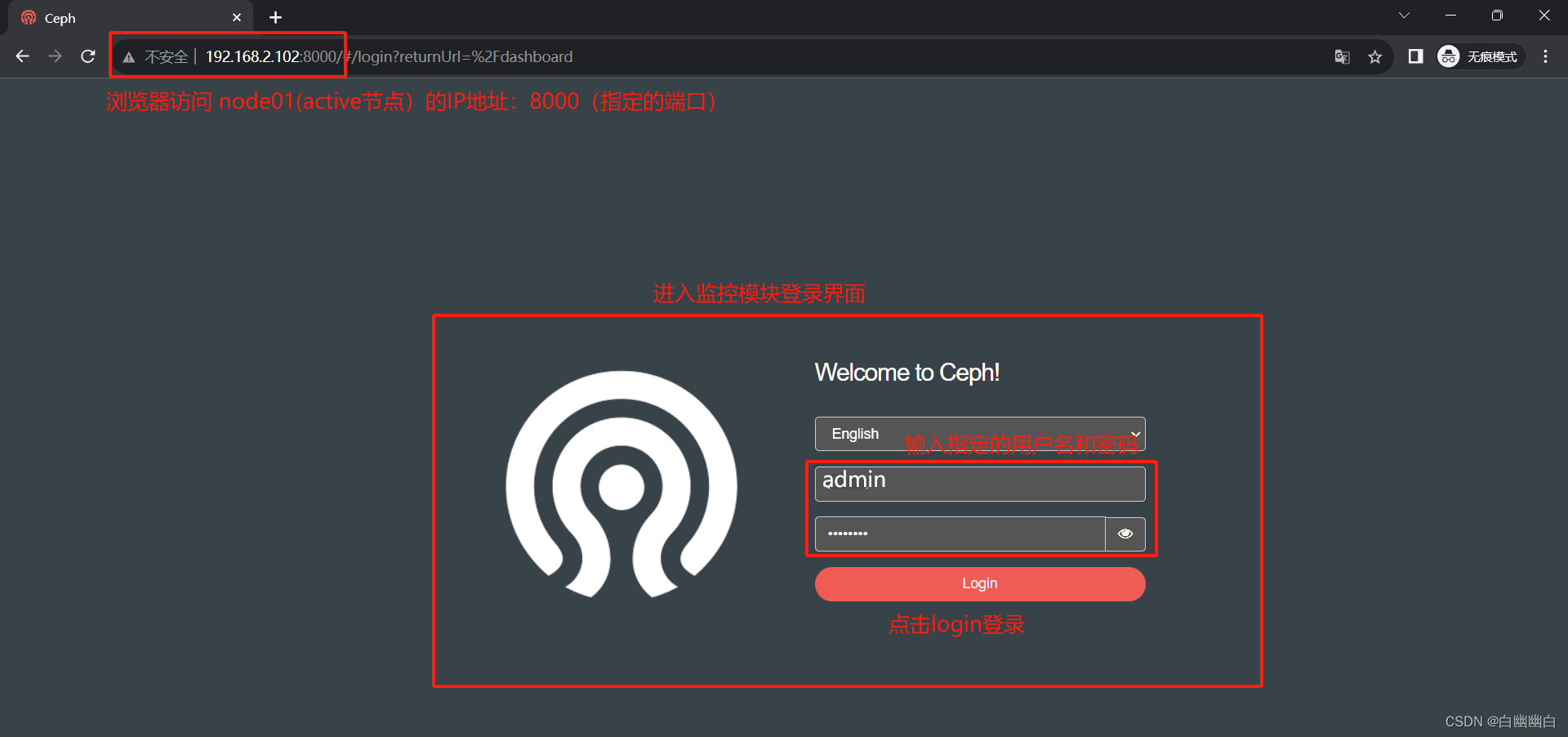

浏览器访问:http://192.168.2.102:8000

账号密码为 admin/12345678

相关文章:

基于 ceph-deploy 部署 Ceph 集群 超详细

Ceph part1 一、存储基础1.1 单机存储设备1.2 单机存储的问题1.3 单机存储问题的解决方案1.3.1 商业存储解决方案1.3.2 分布式存储(软件定义的存储 SDS) 二、分布式存储2.1 常见的分布式存储2.2 分布式存储的类型 三、Ceph概述3.1 Ceph简介3.2 Ceph 优势…...

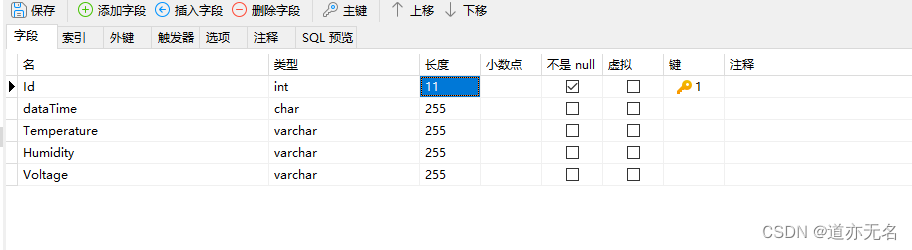

做一个物联网的后台程序与数据库设计

数据库部分 先设计一个简单的数据库。表结构如下: sql语句如下: SET NAMES utf8mb4; SET FOREIGN_KEY_CHECKS = 0;-- ---------------------------- -- Table structure for realtimedata -- ---------------------------- DROP TABLE IF EXISTS `realtimedata`...

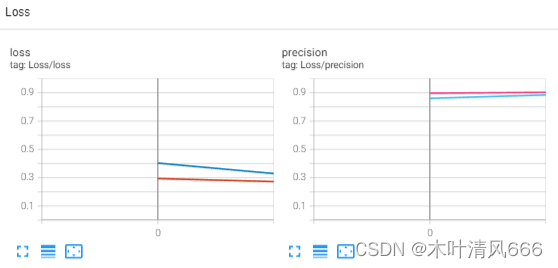

Pytorch深度学习—FashionMNIST数据集训练

文章目录 FashionMNIST数据集需求库导入、数据迭代器生成设备选择样例图片展示日志写入评估—计数器模型构建训练函数整体代码训练过程日志 FashionMNIST数据集 FashionMNIST(时尚 MNIST)是一个用于图像分类的数据集,旨在替代传统的手写数字…...

uniapp 返回上一步携带参数

1. 下一步 // 返回上一页setTimeout(() > {let pages getCurrentPages();let prevPage pages[pages.length - 2];prevPage.$vm.schoolName this.formList;uni.navigateBack({delta: 1});}, 1000) 2. 返回上一步, 携带参数 // 获取下一步返回的数据onShow() {let pages …...

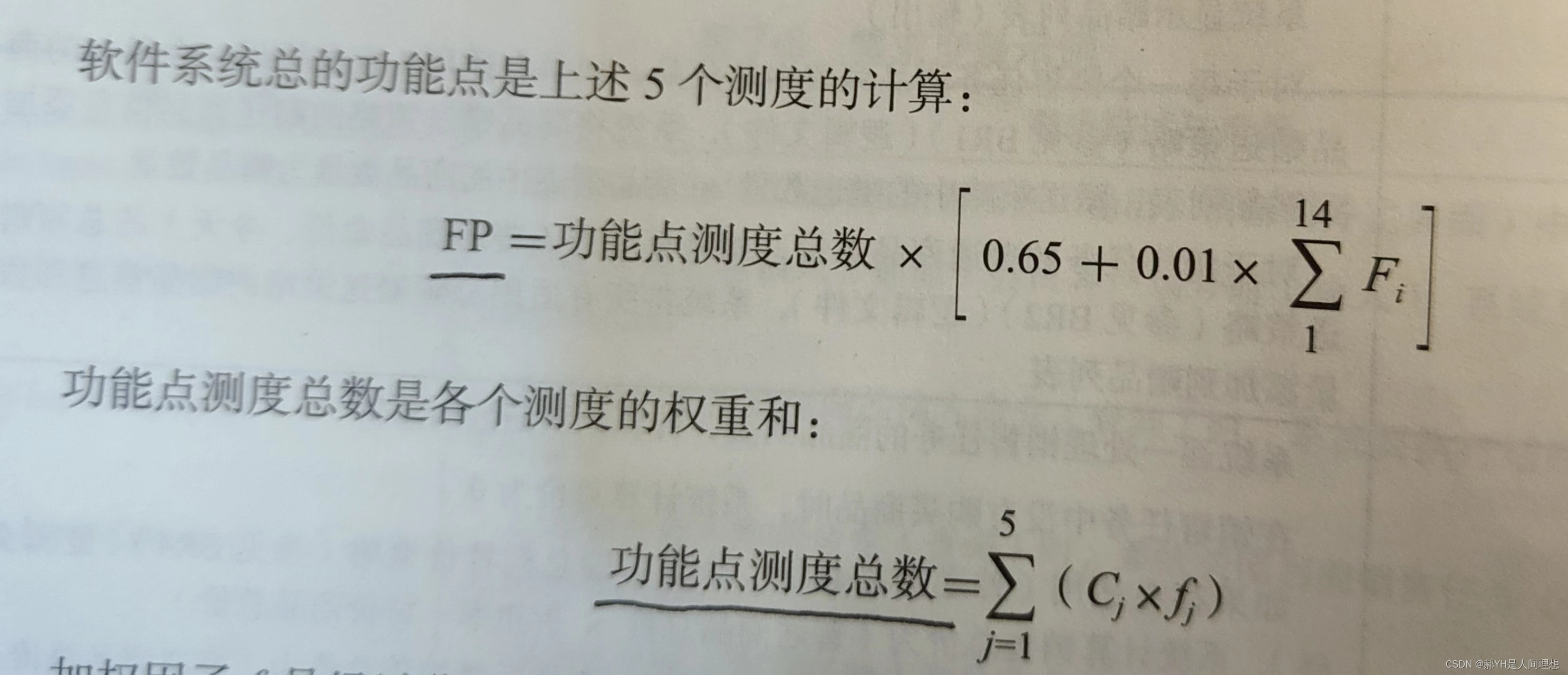

软件工程与计算总结(七)需求文档化与验证

目录 一.文档化的原因 二.需求文档基础 1.需求文档的交流对象 2.用例文档 3.软件需求规格说明文档 三.需求文档化要点 1.技术文档协作要点 2.需求书写要点 3.软件需求规格说明文档属性要点 四.评审软件需求规格说明文档 1.需求验证与确认 2.评审需求的注意事项 五…...

MySQL锁概述

数据库锁是一种机制,用于管理并发访问数据库的方式。当多个用户或事务同时访问数据库时,可能会导致数据不一致或冲突的问题。数据库锁的作用是确保数据的一致性和完整性,同时允许多个用户并发地访问数据库。 需要注意的是,加锁是消…...

【Ceph Block Device】块设备挂载使用

文章目录 前言创建pool创建user创建image列出image检索image信息调整image大小增加image大小减少image大小 删除image从pool中删除image从pool中“延迟删除”image从pool中移除“延迟删除的image” 恢复image恢复指定pool中延迟删除的image恢复并重命名image 映射块设备格式化i…...

Arbitrum Stylus 的工作原理

理解 Arbitrum 如何协调 EVM 和 WASM 的共存是至关重要的。这不仅仅是拥有两个独立的引擎;这是一种增强两者优势的协同关系。 Arbitrum 的独特架构允许 EVM 和 WASM 之间进行无缝和同步的操作,这要归功于其统一的状态、跨 VM 调用和兼容的经济模型。 用…...

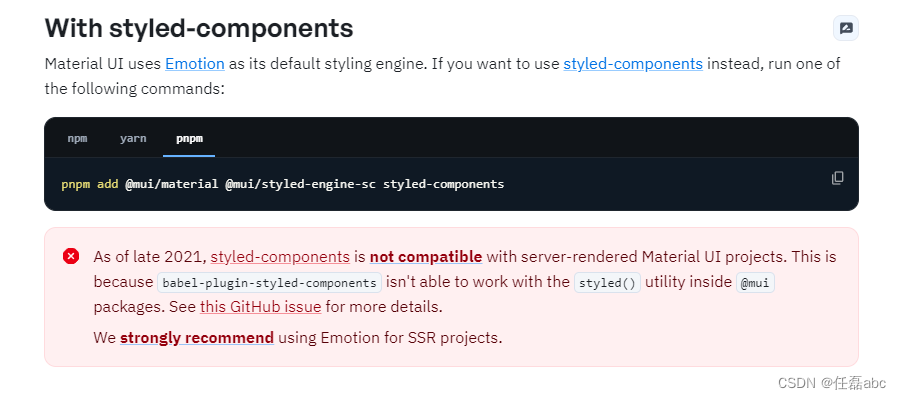

nextjs构建服务端渲染,同时使用Material UI进行项目配置

一、创建一个next项目 使用create-next-app来启动一个新的Next.js应用,它会自动为你设置好一切 运行命令: npx create-next-applatest 执行结果如下: 启动项目: pnpm dev 执行结果: 启动成功! 二、安装Mater…...

Java 使用 Easyexcel 导出大量数据

读Excel | Easy Excel 1、 我遇到的数据量超级大,使用传统的POI方式来完成导入导出很明显会内存溢出,并且效率会非常低;2、 数据量大直接使用select * from tableName肯定不行,一下子查出来300w条数据肯定会很慢;3、 …...

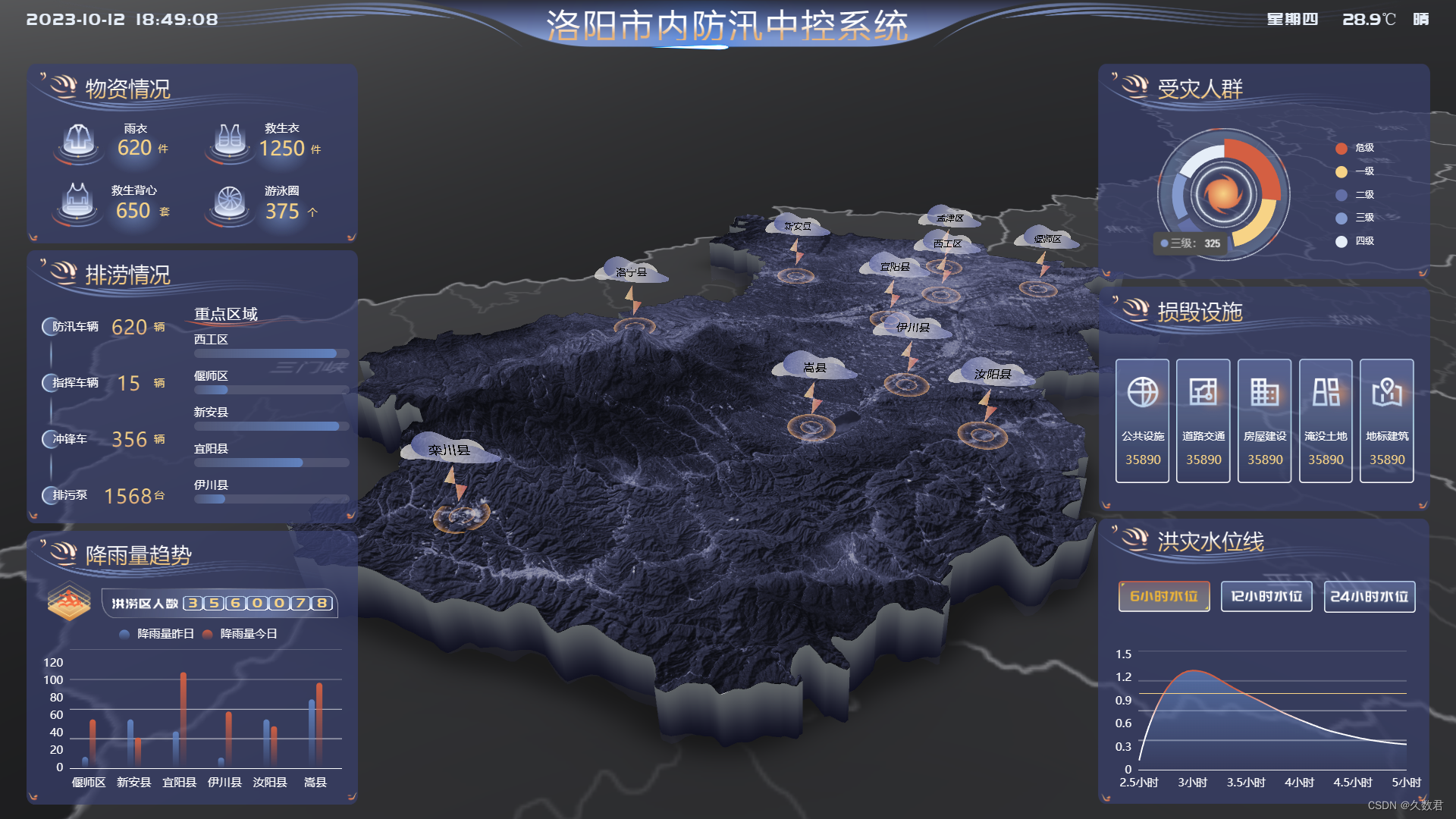

高效防汛决策:山海鲸可视化系统助力城市防洪

随着全球气候的变化,自然灾害如洪水、台风等频发,防范洪水成为城市管理者和居民们亟待解决的重要问题。 洪水的威胁 洪水是自然界的杀手之一,不仅会造成大量的财产损失,还可能危害人们的生命安全。因此,预测、监测和有…...

易点云CFO向征:CFO不能只讲故事,价值创造才是核心

作者 | 曾响铃 文 | 响铃说 在今年6月初,也是易点云上市6天后,《巴伦周刊》正式启动评价“2023港美上市中国企业CFO精英100”的活动。 时间来到9月,评价揭秘,易点云CFO向征成功入选,被评为“年度最具成长潜力CFO”…...

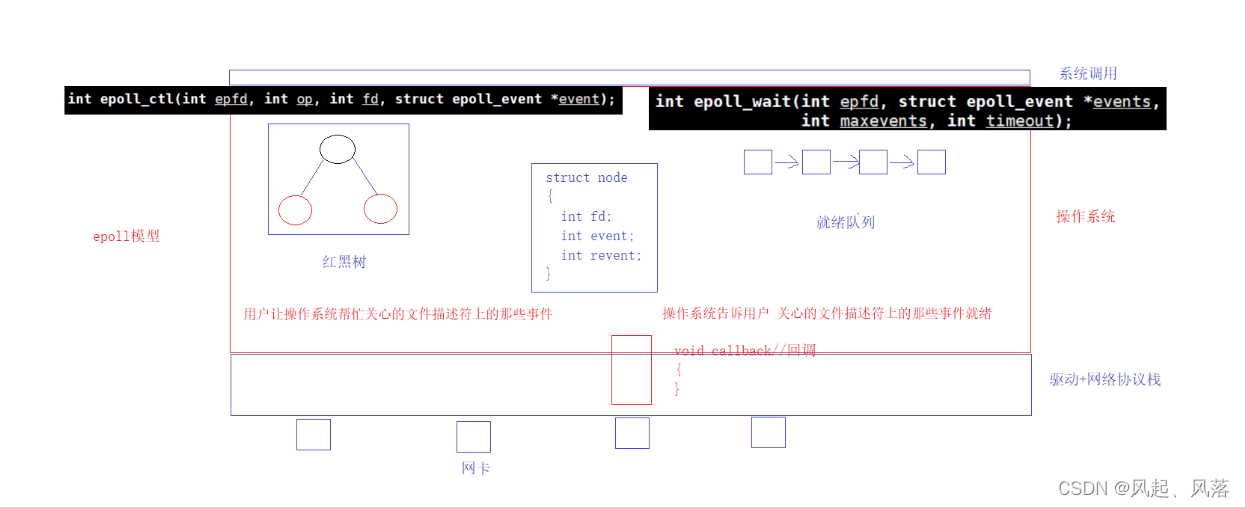

【计算机网络】poll | epoll

文章目录 1. pollpoll函数参数解析代码解析PollServer代码 poll 特点 2. epoll认识接口epoll_createepoll_ctlepoll_wait 基本原理红黑树就绪队列 1. poll poll函数参数解析 输入 man poll poll的第一个参数是文件描述符 poll的第二个参数为 等待的多个文件描述符(fd)数字层面…...

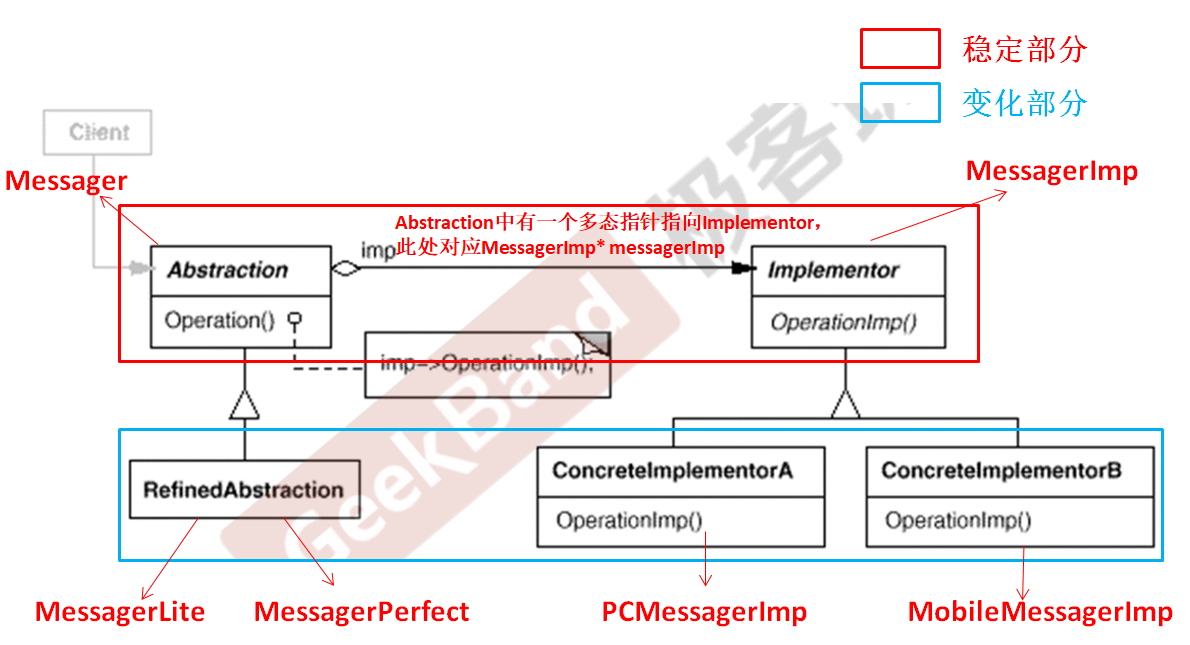

C++设计模式_07_Bridge 桥模式

文章目录 1. 动机(Motivation)2. 代码演示Bridge 桥模式2.1 基于继承的常规思维处理2.2 基于组合关系的重构优化2.3 采用Bridge 桥模式的实现 3. 模式定义4. 结构(Structure)5. 要点总结 与上篇介绍的Decorator 装饰模式一样&…...

[JAVA版本] Websocket获取B站直播弹幕——基于直播开放平台

教程 B站直播间弹幕Websocket获取 — 哔哩哔哩直播开放平台 基于B站直播开放平台开放且未上架时,只能个人使用。 代码实现 1、相关依赖 fastjson2用于解析JSON字符串,可自行替换成别的框架。 hutool-core用于解压zip数据,可自行替换成别的…...

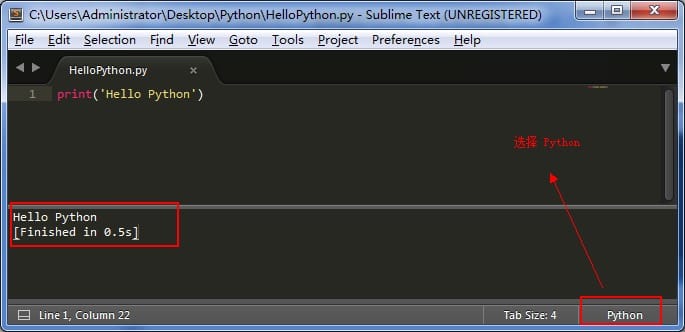

第一个 Python 程序

三、第一个 Python 程序 好了,说了那么多,现在我们可以来写一下第一个 Python 程序了。 一开始写 Python 程序,个人不太建议用专门的工具来写,不方便熟悉语法,所以这里我先用 Sublime Text 来写,后期可以…...

广告牌安全监测,保障户外广告牌的安全与稳定

随着城市的发展和现代化,广告牌已经成为城市风景的一部分。然而,随之而来的是广告牌安全问题,因为它们暴露在各种天气和环境条件下,一旦掉落,可能对人们的生命和财产造成威胁。广告牌安全监测有效的解决了这一问题&…...

分类预测 | MATLAB实现KOA-CNN-GRU开普勒算法优化卷积门控循环单元数据分类预测

分类预测 | MATLAB实现KOA-CNN-GRU开普勒算法优化卷积门控循环单元数据分类预测 目录 分类预测 | MATLAB实现KOA-CNN-GRU开普勒算法优化卷积门控循环单元数据分类预测分类效果基本描述程序设计参考资料 分类效果 基本描述 1.MATLAB实现KOA-CNN-GRU开普勒算法优化卷积门控循环单…...

进来了解实现官网搜索引擎的三种方法

做网站的目的是对自己的品牌进行推广,让越来越多的人知道自己的产品,但是如果只是做了一个网站放着,然后等着生意找上门来那是不可能的。在当今数字时代,实现官网搜索引擎对于提升用户体验和推动整体性能至关重要。搜索引擎可以帮…...

OpenCV3-Python(7)模板匹配和霍夫检测

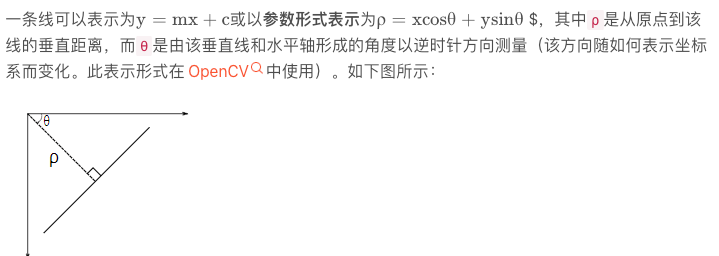

模板匹配 膜版匹配不能匹配尺度变换和视角变换的图像 图片中查找和模板相似度最高的图像 计算相似程度最高的位置 res cv.matchTemplate(img , template, method) 该方法返回一个类似灰度图的东西,如果用的相关匹配,那么亮的地方就是可能匹配上的地方 …...

idea大量爆红问题解决

问题描述 在学习和工作中,idea是程序员不可缺少的一个工具,但是突然在有些时候就会出现大量爆红的问题,发现无法跳转,无论是关机重启或者是替换root都无法解决 就是如上所展示的问题,但是程序依然可以启动。 问题解决…...

大话软工笔记—需求分析概述

需求分析,就是要对需求调研收集到的资料信息逐个地进行拆分、研究,从大量的不确定“需求”中确定出哪些需求最终要转换为确定的“功能需求”。 需求分析的作用非常重要,后续设计的依据主要来自于需求分析的成果,包括: 项目的目的…...

UDP(Echoserver)

网络命令 Ping 命令 检测网络是否连通 使用方法: ping -c 次数 网址ping -c 3 www.baidu.comnetstat 命令 netstat 是一个用来查看网络状态的重要工具. 语法:netstat [选项] 功能:查看网络状态 常用选项: n 拒绝显示别名&#…...

如何在看板中有效管理突发紧急任务

在看板中有效管理突发紧急任务需要:设立专门的紧急任务通道、重新调整任务优先级、保持适度的WIP(Work-in-Progress)弹性、优化任务处理流程、提高团队应对突发情况的敏捷性。其中,设立专门的紧急任务通道尤为重要,这能…...

Cinnamon修改面板小工具图标

Cinnamon开始菜单-CSDN博客 设置模块都是做好的,比GNOME简单得多! 在 applet.js 里增加 const Settings imports.ui.settings;this.settings new Settings.AppletSettings(this, HTYMenusonichy, instance_id); this.settings.bind(menu-icon, menu…...

CocosCreator 之 JavaScript/TypeScript和Java的相互交互

引擎版本: 3.8.1 语言: JavaScript/TypeScript、C、Java 环境:Window 参考:Java原生反射机制 您好,我是鹤九日! 回顾 在上篇文章中:CocosCreator Android项目接入UnityAds 广告SDK。 我们简单讲…...

ETLCloud可能遇到的问题有哪些?常见坑位解析

数据集成平台ETLCloud,主要用于支持数据的抽取(Extract)、转换(Transform)和加载(Load)过程。提供了一个简洁直观的界面,以便用户可以在不同的数据源之间轻松地进行数据迁移和转换。…...

【git】把本地更改提交远程新分支feature_g

创建并切换新分支 git checkout -b feature_g 添加并提交更改 git add . git commit -m “实现图片上传功能” 推送到远程 git push -u origin feature_g...

Maven 概述、安装、配置、仓库、私服详解

目录 1、Maven 概述 1.1 Maven 的定义 1.2 Maven 解决的问题 1.3 Maven 的核心特性与优势 2、Maven 安装 2.1 下载 Maven 2.2 安装配置 Maven 2.3 测试安装 2.4 修改 Maven 本地仓库的默认路径 3、Maven 配置 3.1 配置本地仓库 3.2 配置 JDK 3.3 IDEA 配置本地 Ma…...

【MATLAB代码】基于最大相关熵准则(MCC)的三维鲁棒卡尔曼滤波算法(MCC-KF),附源代码|订阅专栏后可直接查看

文章所述的代码实现了基于最大相关熵准则(MCC)的三维鲁棒卡尔曼滤波算法(MCC-KF),针对传感器观测数据中存在的脉冲型异常噪声问题,通过非线性加权机制提升滤波器的抗干扰能力。代码通过对比传统KF与MCC-KF在含异常值场景下的表现,验证了后者在状态估计鲁棒性方面的显著优…...