ubuntu下yolov6 tensorrt模型部署

- TensorRT系列教程之 Windows10下yolov8 tensorrt模型加速部署

- TensorRT系列教程之 Linux下 yolov8 tensorrt模型加速部署

- TensorRT系列教程之 Linux下 yolov7 tensorrt模型加速部署

- TensorRT系列教程之 Linux下 yolov6 tensorrt模型加速部署

- TensorRT系列教程之 Linux下 yolov5 tensorrt模型加速部署

- TensorRT系列教程之 Linux下 yolox tensorrt模型加速部署

文章目录

- ubuntu下yolov6 tensorrt模型部署

- 一、Ubuntu18.04环境配置

- 1.1 安装工具链和opencv

- 1.2 安装Nvidia相关库

- 1.2.1 安装Nvidia显卡驱动

- 1.2.2 安装 cuda11.3

- 1.2.3 安装 cudnn8.2

- 1.2.4 下载 tensorrt8.4.2.4

- 1.2.5 下载仓库TensorRT-Alpha并设置

- 二、从yolov6源码中导出onnx文件

- 三、利用tensorrt编译onnx模型

- 四、编译执行yolov6-tensorrt工程

- 五、结束语

ubuntu下yolov6 tensorrt模型部署

YOLOv6是一款由美团视觉智能部开发的目标检测框架,它包含了模型训练、推理及部署的全流程,适用于工业应用场景。以下是关于YOLOv6的多方面介绍。

-

首先,在模型结构方面,YOLOv6采用了更为精细的骨干网络设计,例如使用轻量级网络结构TinyNet,相比于传统的CNN网络,它在计算量和参数量上都得到了显著减少,同时保持了良好的性能。

-

其次,在训练策略上,YOLOv6引入了分布式训练和多卡并行训练技术,能够高效利用计算资源进行模型训练。此外,YOLOv6还采用了知识蒸馏等训练技巧,使得学生模型能够从教师模型中学习到知识,从而提高了模型性能。

-

此外,YOLOv6在算法层面也有多项改进和优化。例如,它提出了SPP-O与Generalized-LSTM-O两种创新结构,使得模型在特征提取和时空信息捕捉方面表现更加优异。此外,YOLOv6还采用了混合损失函数,将样本权重的差异考虑到损失函数中,对于样本权重的差异能够进行有效的学习。

-

最后,在应用场景方面,YOLOv6广泛应用于多种业务场景中,例如视频异常检测、工业质检等。以工业质检为例,YOLOv6能够高效准确地检测出生产线上的缺陷产品,从而提高了工业生产效率和质量。

-

总之,YOLOv6这款目标检测框架具有高效、精准、轻量化的优点,它在模型结构、训练策略、算法层面及应用场景等方面都展现出优秀的性能及创新点。

本文提供yolov6tensorrt加速方法。

有源码!有源码!有源码! 不要慌,哈哈哈。

一、Ubuntu18.04环境配置

如果您对tensorrt不是很熟悉,请务必保持下面库版本一致。

请注意: Linux系统安装以下库,务必去进入系统bios下,关闭安全启动(设置 secure boot 为 disable)

1.1 安装工具链和opencv

sudo apt-get update

sudo apt-get install build-essential

sudo apt-get install git

sudo apt-get install gdb

sudo apt-get install cmake

sudo apt-get install libopencv-dev

# pkg-config --modversion opencv

1.2 安装Nvidia相关库

注:Nvidia相关网站需要注册账号。

1.2.1 安装Nvidia显卡驱动

ubuntu-drivers devices

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt update

sudo apt install nvidia-driver-470-server # for ubuntu18.04

nvidia-smi

1.2.2 安装 cuda11.3

- 进入链接: https://developer.nvidia.com/cuda-toolkit-archive

- 选择:CUDA Toolkit 11.3.0(April 2021)

- 选择:[Linux] -> [x86_64] -> [Ubuntu] -> [18.04] -> [runfile(local)]

在网页你能看到下面安装命令,我这里已经拷贝下来:

wget https://developer.download.nvidia.com/compute/cuda/11.3.0/local_installers/cuda_11.3.0_465.19.01_linux.run

sudo sh cuda_11.3.0_465.19.01_linux.run

cuda的安装过程中,需要你在bash窗口手动作一些选择,这里选择如下:

- select:[continue] -> [accept] -> 接着按下回车键取消Driver和465.19.01这个选项,如下图(it is important!) -> [Install]

bash窗口提示如下表示安装完成

#===========

#= Summary =

#===========#Driver: Not Selected

#Toolkit: Installed in /usr/local/cuda-11.3/

#......

把cuda添加到环境变量:

vim ~/.bashrc

把下面拷贝到 .bashrc里面

# cuda v11.3

export PATH=/usr/local/cuda-11.3/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-11.3/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

export CUDA_HOME=/usr/local/cuda-11.3

刷新环境变量和验证

source ~/.bashrc

nvcc -V

bash窗口打印如下信息表示cuda11.3安装正常

nvcc: NVIDIA (R) Cuda compiler driver<br>

Copyright (c) 2005-2021 NVIDIA Corporation<br>

Built on Sun_Mar_21_19:15:46_PDT_2021<br>

Cuda compilation tools, release 11.3, V11.3.58<br>

Build cuda_11.3.r11.3/compiler.29745058_0<br>

1.2.3 安装 cudnn8.2

- 进入网站:https://developer.nvidia.com/rdp/cudnn-archive

- 选择: Download cuDNN v8.2.0 (April 23rd, 2021), for CUDA 11.x

- 选择: cuDNN Library for Linux (x86_64)

- 你将会下载这个压缩包: “cudnn-11.3-linux-x64-v8.2.0.53.tgz”

# 解压

tar -zxvf cudnn-11.3-linux-x64-v8.2.0.53.tgz

将cudnn的头文件和lib拷贝到cuda11.3的安装目录下:

sudo cp cuda/include/cudnn.h /usr/local/cuda/include/

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64/

sudo chmod a+r /usr/local/cuda/include/cudnn.h

sudo chmod a+r /usr/local/cuda/lib64/libcudnn*

1.2.4 下载 tensorrt8.4.2.4

本教程中,tensorrt只需要下载\、解压即可,不需要安装。

- 进入网站: https://developer.nvidia.cn/nvidia-tensorrt-8x-download

- 把这个打勾: I Agree To the Terms of the NVIDIA TensorRT License Agreement

- 选择: TensorRT 8.4 GA Update 1

- 选择: TensorRT 8.4 GA Update 1 for Linux x86_64 and CUDA 11.0, 11.1, 11.2, 11.3, 11.4, 11.5, 11.6 and 11.7 TAR Package

- 你将会下载这个压缩包: “TensorRT-8.4.2.4.Linux.x86_64-gnu.cuda-11.6.cudnn8.4.tar.gz”

# 解压

tar -zxvf TensorRT-8.4.2.4.Linux.x86_64-gnu.cuda-11.6.cudnn8.4.tar.gz

# 快速验证一下tensorrt+cuda+cudnn是否安装正常

cd TensorRT-8.4.2.4/samples/sampleMNIST

make

cd ../../bin/

导出tensorrt环境变量(it is important!),注:将LD_LIBRARY_PATH:后面的路径换成你自己的!后续编译onnx模型的时候也需要执行下面第一行命令

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/xxx/temp/TensorRT-8.4.2.4/lib

./sample_mnist

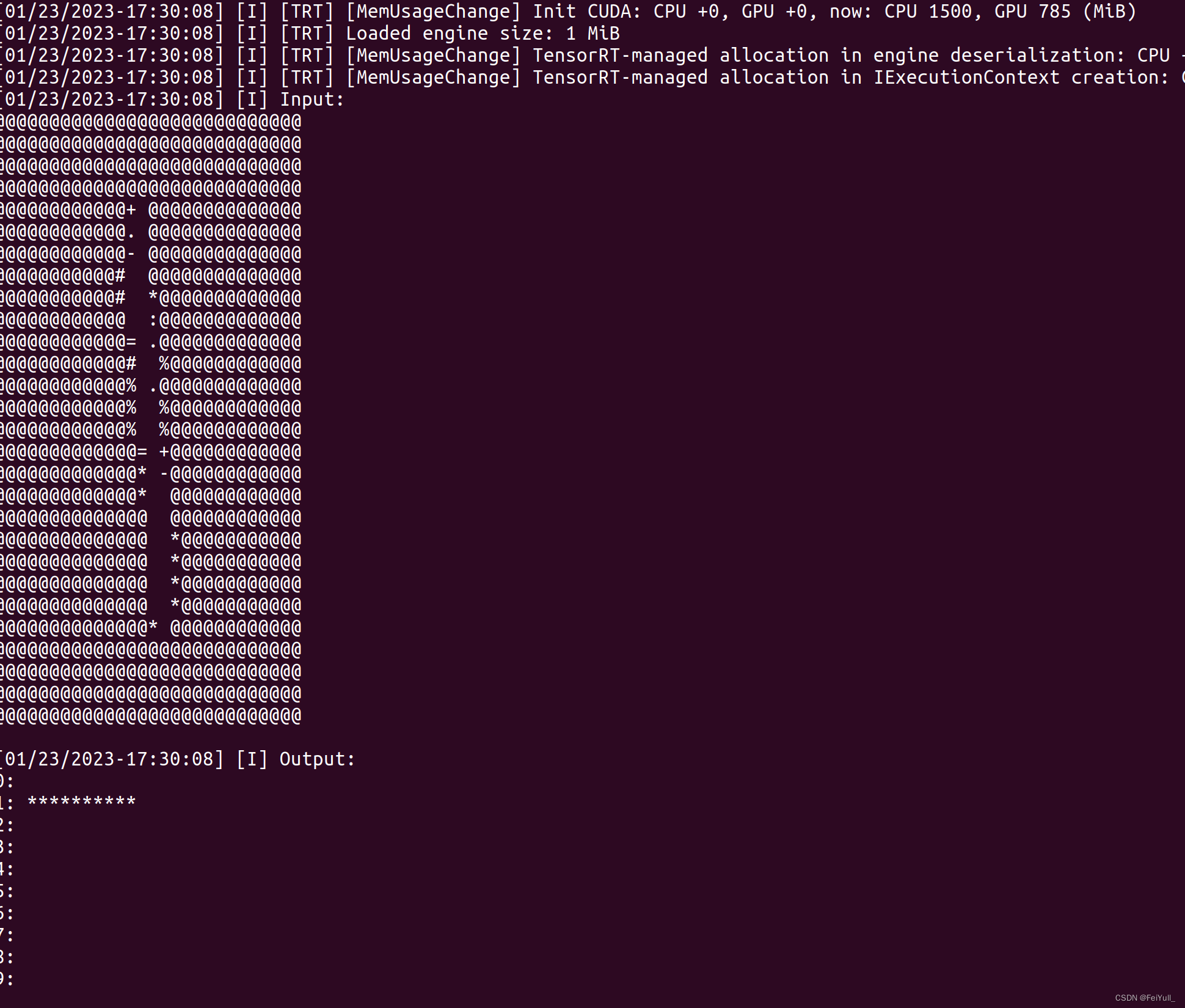

bash窗口打印类似如下图的手写数字识别表明cuda+cudnn+tensorrt安装正常

1.2.5 下载仓库TensorRT-Alpha并设置

git clone https://github.com/FeiYull/tensorrt-alpha

设置您自己TensorRT根目录:

git clone https://github.com/FeiYull/tensorrt-alpha

cd tensorrt-alpha/cmake

vim common.cmake

# 在文件common.cmake中的第20行中,设置成你自己的目录,别和我设置一样的路径eg:

# set(TensorRT_ROOT /root/TensorRT-8.4.2.4)

二、从yolov6源码中导出onnx文件

可以直接从网盘下载onnx文件[weiyun]:weiyun or google driver ,你也可以自己下载仓库,然后按照下面指令手动导出onnx文件:

# 下载yolov6源码

git clone https://github.com/meituan/YOLOv6

切换版本为6.3.0

git checkout 0.3.0

安装 yolov6环境

pip install -r requirements.txt

用以下指令导出onnx模型文件

# 640

python export.py --weights yolov7-tiny.pt --dynamic --grid

python export.py --weights yolov7.pt --dynamic --grid

python export.py --weights yolov7x.pt --dynamic --grid

# 1280

python export.py --weights yolov7-w6.pt --dynamic --grid --img-size 1280

三、利用tensorrt编译onnx模型

将你的onnx模型放到这个路径:tensorrt-alpha/data/yolov6

cd tensorrt-alpha/data/yolov6

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:~/TensorRT-8.4.2.4/lib

编译onnx模型指令,640表示模型的输入分辨率为:640X640,1280同理表示:1280X1280。注意:编译onnx格式的模型会得到例如xxxx.trt格式的文件,下文推理要用到。

# 640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6n.onnx --saveEngine=yolov6n.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6s.onnx --saveEngine=yolov6s.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6m.onnx --saveEngine=yolov6m.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6l.onnx --saveEngine=yolov6l.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

# 1280

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6n6.onnx --saveEngine=yolov6n6.trt --buildOnly --minShapes=images:1x3x1280x1280 --optShapes=images:4x3x1280x1280 --maxShapes=images:8x3x1280x1280

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6s6.onnx --saveEngine=yolov6s6.trt --buildOnly --minShapes=images:1x3x1280x1280 --optShapes=images:4x3x1280x1280 --maxShapes=images:8x3x1280x1280

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6m6.onnx --saveEngine=yolov6m6.trt --buildOnly --minShapes=images:1x3x1280x1280 --optShapes=images:4x3x1280x1280 --maxShapes=images:8x3x1280x1280

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov6l6.onnx --saveEngine=yolov6l6.trt --buildOnly --minShapes=images:1x3x1280x1280 --optShapes=images:4x3x1280x1280 --maxShapes=images:8x3x1280x1280四、编译执行yolov6-tensorrt工程

使用命令行编译下代码

git clone https://github.com/FeiYull/tensorrt-alpha

cd tensorrt-alpha/yolov6

mkdir build

cd build

cmake ..

make -j10

按照需求执行推理,支持推理一张图片、在线推理视频文件,或者在线从摄像头获取视频流并推理。

## 640

# infer image

./app_yolov6 --model=../../data/yolov6/yolov6n.trt --size=640 --batch_size=1 --img=../../data/6406401.jpg --show --savePath=../

# infer video

./app_yolov6 --model=../../data/yolov6/yolov6n.trt --size=640 --batch_size=8 --video=../../data/people.mp4 --show # infer camera

./app_yolov6 --model=../../data/yolov6/yolov6n.trt --size=640 --batch_size=4 --cam_id=0 --show## 1280

# infer video

./app_yolov6 --model=../../data/yolov6/yolov6s6.trt --size=1280 --batch_size=8 --video=../../data/people.mp4 --savePath=../例如:以下是yolov6推理视频流效果。

五、结束语

都看到这里了,觉得可以请点赞收藏,有条件的去仓库点个star,仓库:https://github.com/FeiYull/tensorrt-alpha

相关文章:

ubuntu下yolov6 tensorrt模型部署

TensorRT系列教程之 Windows10下yolov8 tensorrt模型加速部署TensorRT系列教程之 Linux下 yolov8 tensorrt模型加速部署TensorRT系列教程之 Linux下 yolov7 tensorrt模型加速部署TensorRT系列教程之 Linux下 yolov6 tensorrt模型加速部署TensorRT系列教程之 Linux下 yolov5 ten…...

k8s查看当前命名空间下所有运行的 pod 对应的镜像

1,查看镜像 kubectl -n xxx get pods | grep Running | awk {print $1} | xargs -r -I {} kubectl -n xxx get pods {} -ojsonpath{.status.containerStatuses[0].image}{"\n"} | sort 2,去重查看 kubectl -n namespace get pods -o jsonp…...

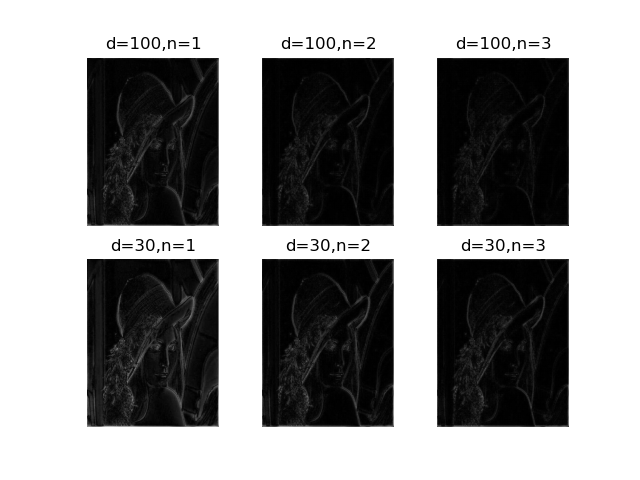

傅里叶变换和其图像处理中的应用

以下部分文字资料整合于网络,本文仅供自己学习用! 一、为什么要在频域进行图像处理? 一些在空间域表述困难的增强任务,在频率域中变得非常普通 滤波在频率域更为直观,你想想嘛,所谓滤波,就是…...

风电厂VR情景式三维模拟实训系统让教育更加贴近实际

VR虚拟仿真实训室是一种利用虚拟现实技术和仿真技术,为教学和学生实训提供虚拟环境和实践机会的设施。它通过将学生置身于虚拟场景中,让他们可以身临其境地参与到实际场景中,从而提高实际操作能力和技能水平。 在教学方面,VR虚拟仿…...

竞赛 深度学习+python+opencv实现动物识别 - 图像识别

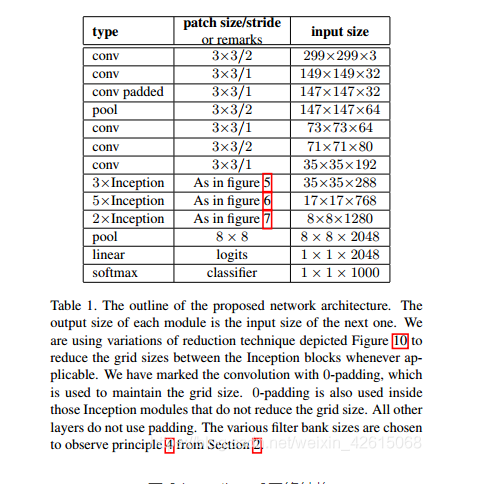

文章目录 0 前言1 课题背景2 实现效果3 卷积神经网络3.1卷积层3.2 池化层3.3 激活函数:3.4 全连接层3.5 使用tensorflow中keras模块实现卷积神经网络 4 inception_v3网络5 最后 0 前言 🔥 优质竞赛项目系列,今天要分享的是 🚩 *…...

)

LeetCode 2562. 找出数组的串联值:模拟(双指针)

【LetMeFly】2562.找出数组的串联值:模拟(双指针) 力扣题目链接:https://leetcode.cn/problems/find-the-array-concatenation-value/ 给你一个下标从 0 开始的整数数组 nums 。 现定义两个数字的 串联 是由这两个数值串联起来…...

【mac】常用命令01

1、如何像windows一样看磁盘? 不断的在上层文件夹显示,找到最上层,拖拽到左侧,方便之后找 2、Macintosh HD显示隐藏文件夹方法 终端窗口: defaults write com.apple.finder AppleShowAllFiles true killall Finder 或者…...

android 13.0 添加系统字体并且设置为默认字体

1.概述 在13.0系统定制化开发中,在产品定制中,有产品需求对于系统字体风格不太满意,所以想要更换系统的默认字体,对于系统字体的修改也是常有的功能,而系统默认也支持增加字体,所以就来添加楷体字体为系统字体,并替换为系统默认字体, 接下来就来分析下替换默认字体的方…...

平面设计师要会3D吗 优漫动游

所谓物以稀为贵,对于设计人才也一样。越是稀缺的能力,能够发挥的价值就越高。于是现在很多互联网名企在招聘的时候都加了一条:会3D设计者优先。 其实这些看起来很厉害的设计,归结起来无非就三种形式:插画、三维、合成…...

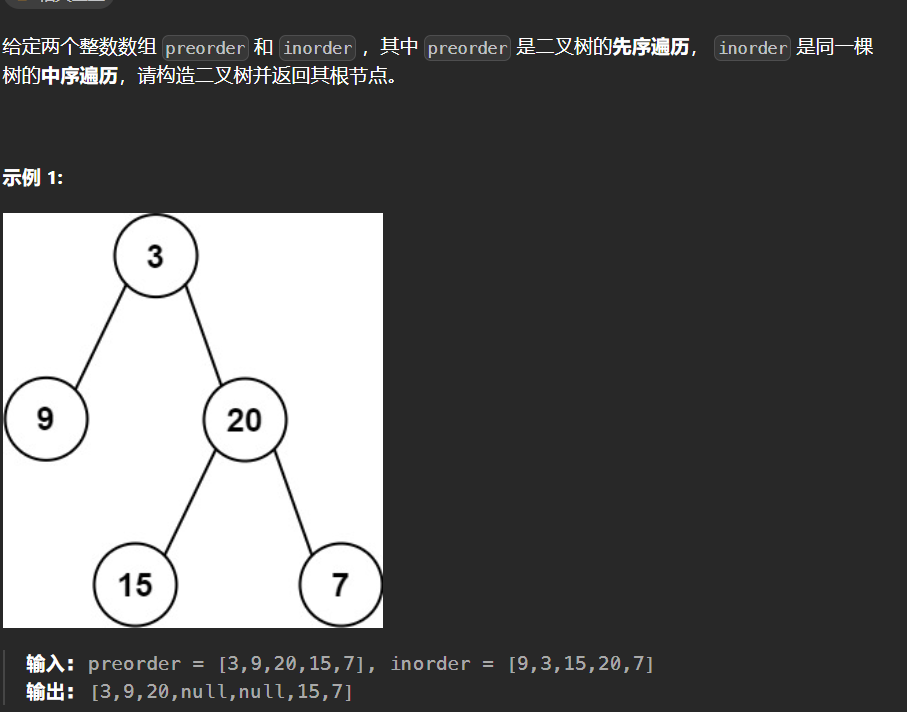

【LeetCode热题100】--105.从前序与中序遍历序列构造二叉树

105.从前序与中序遍历序列构造二叉树 二叉树前序遍历顺序:根左右 二叉树中序遍历顺序:左根右 只要我们在中序遍历中定位到根节点,那么我们就可以分别知道左子树和右子树中的节点数目。由于同一颗子树的前序遍历和中序遍历的长度显然是相同的…...

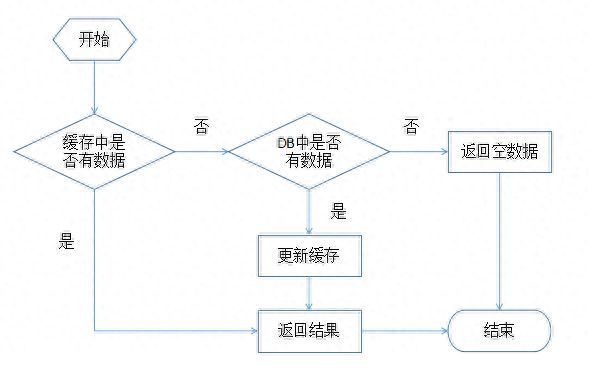

缓存设计的创新之旅:架构的灵魂之一

缓存在架构设计中占有重要地位。缓存在提升性能中也扮演重要的角色。常见的有对资源的缓存,比如数据库连接池、http连接池,还有对数据的缓存等。缓存的设计可复杂也可简单,但是需要考虑的点却很多。 缓存对象 设计缓存的时候一定要考虑的是&…...

No Human Labor)

Unnatural Instructions: Tuning Language Models with (Almost) No Human Labor

本文是LLM系列文章,针对《Unnatural Instructions: Tuning Language Models with (Almost) No Human Labor》的翻译。 TOC 摘要 指令调优使预训练的语言模型能够从推理时间的自然语言描述中执行新的任务。这些方法依赖于以众包数据集或用户交互形式进行的大量人工…...

uniapp中全局页面挂载组件(H5)

前言 我们已经学习了 uniapp中全局页面挂载组件(小程序) 有些小伙伴问在H5怎么做那让我们试一试 直接上代码 //引用组件 import dialog from ./index.vue; //我这里要把小程序的方法和h5方法写一起所以用了混入 import mixins from ./mixins.js //使用…...

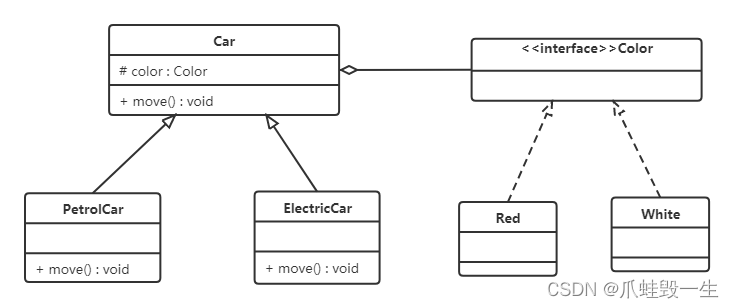

设计模式(1)-设计模式前置基础知识

1,设计模式概述 1.1 软件设计模式的产生背景 "设计模式"最初并不是出现在软件设计中,而是被用于建筑领域的设计中。 1977年美国著名建筑大师、加利福尼亚大学伯克利分校环境结构中心主任克里斯托夫亚历山大(Christopher Alexand…...

【05】基础知识:React组件实例三大核心属性 - props

一、props 了解 理解 1、每个组件对象都会有 props(properties的简写)属性 2、组件标签的所有属性都保存在 props 中 作用 通过标签属性从组件外向组件内传递变化的数据 注意 组件内部不要修改 props 数据 二、案例 需求:自定义用来…...

JOSEF约瑟 漏电继电器 JD1-200 工作电压:380V 孔径:45mm 50~500mA

JD1系列漏电继电器 系列型号 JD1-100漏电继电器 JD1-200漏电继电器 JD1-250漏电继电器 JD1系列漏电继电器原为分体式固定式安装,为适应现行安装场合需要,上海约瑟继电器厂在产品原JD1一体式漏电继电器基础上进行产品升级,开发出现在较为…...

[题] 差分矩阵 #差分

题目 差分矩阵 题解 只有一个操作: void insert(int x1, int y1, int x2, int y2, int c){b[x1][y1] c;b[x2 1][y1] - c;b[x1][y2 1] - c;b[x2 1][y2 1] c; }利用差分的思想,扩展到二维上。 insert函数作用是将矩阵之内的数全部加上c,…...

Studio One6.5最新版本新增了对Linux的支持

音乐制作人们,这是你们翘首以待的消息。数字音频工作站(DAW)已经成为音乐制作专业人士重要工具之一。 遗憾的是,对于 Linux 用户而言,选择十分有限。最受欢迎的选择通常是开源 DAW,如 Ardour、Audacity和闭…...

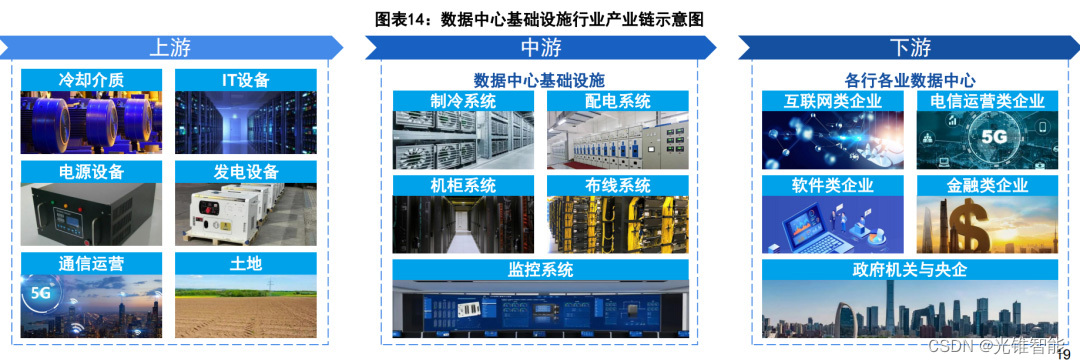

大模型引发“暴力计算”,巨头加速推进液冷“降温”

点击关注 文|姚悦 编|王一粟 一进入部署了液冷服务器的数据中心,不仅没有嘈杂的风扇声,甚至在不开空调的夏日也完全没有闷热感。 在大模型引发“暴力计算”的热潮下,数据中心的上下游,正在加紧推进液冷“…...

git log 美化配置

编辑 vim ~/.gitconfig 添加配置 [alias]lg log --graph --abbrev-commit --decorate --dateformat:%m-%d %H:%M:%S --formatformat:%C(bold blue)%h%C(reset) - %s %C(bold yellow)% d%C(reset) %n %C(dim white) (%ad) - %an%C(reset) --allgit lg 效果...

浅谈 React Hooks

React Hooks 是 React 16.8 引入的一组 API,用于在函数组件中使用 state 和其他 React 特性(例如生命周期方法、context 等)。Hooks 通过简洁的函数接口,解决了状态与 UI 的高度解耦,通过函数式编程范式实现更灵活 Rea…...

eNSP-Cloud(实现本地电脑与eNSP内设备之间通信)

说明: 想象一下,你正在用eNSP搭建一个虚拟的网络世界,里面有虚拟的路由器、交换机、电脑(PC)等等。这些设备都在你的电脑里面“运行”,它们之间可以互相通信,就像一个封闭的小王国。 但是&#…...

智慧医疗能源事业线深度画像分析(上)

引言 医疗行业作为现代社会的关键基础设施,其能源消耗与环境影响正日益受到关注。随着全球"双碳"目标的推进和可持续发展理念的深入,智慧医疗能源事业线应运而生,致力于通过创新技术与管理方案,重构医疗领域的能源使用模式。这一事业线融合了能源管理、可持续发…...

ios苹果系统,js 滑动屏幕、锚定无效

现象:window.addEventListener监听touch无效,划不动屏幕,但是代码逻辑都有执行到。 scrollIntoView也无效。 原因:这是因为 iOS 的触摸事件处理机制和 touch-action: none 的设置有关。ios有太多得交互动作,从而会影响…...

Swagger和OpenApi的前世今生

Swagger与OpenAPI的关系演进是API标准化进程中的重要篇章,二者共同塑造了现代RESTful API的开发范式。 本期就扒一扒其技术演进的关键节点与核心逻辑: 🔄 一、起源与初创期:Swagger的诞生(2010-2014) 核心…...

《C++ 模板》

目录 函数模板 类模板 非类型模板参数 模板特化 函数模板特化 类模板的特化 模板,就像一个模具,里面可以将不同类型的材料做成一个形状,其分为函数模板和类模板。 函数模板 函数模板可以简化函数重载的代码。格式:templa…...

智能AI电话机器人系统的识别能力现状与发展水平

一、引言 随着人工智能技术的飞速发展,AI电话机器人系统已经从简单的自动应答工具演变为具备复杂交互能力的智能助手。这类系统结合了语音识别、自然语言处理、情感计算和机器学习等多项前沿技术,在客户服务、营销推广、信息查询等领域发挥着越来越重要…...

:观察者模式)

JS设计模式(4):观察者模式

JS设计模式(4):观察者模式 一、引入 在开发中,我们经常会遇到这样的场景:一个对象的状态变化需要自动通知其他对象,比如: 电商平台中,商品库存变化时需要通知所有订阅该商品的用户;新闻网站中࿰…...

人工智能(大型语言模型 LLMs)对不同学科的影响以及由此产生的新学习方式

今天是关于AI如何在教学中增强学生的学习体验,我把重要信息标红了。人文学科的价值被低估了 ⬇️ 转型与必要性 人工智能正在深刻地改变教育,这并非炒作,而是已经发生的巨大变革。教育机构和教育者不能忽视它,试图简单地禁止学生使…...

【无标题】路径问题的革命性重构:基于二维拓扑收缩色动力学模型的零点隧穿理论

路径问题的革命性重构:基于二维拓扑收缩色动力学模型的零点隧穿理论 一、传统路径模型的根本缺陷 在经典正方形路径问题中(图1): mermaid graph LR A((A)) --- B((B)) B --- C((C)) C --- D((D)) D --- A A -.- C[无直接路径] B -…...