生成式AI模型量化简明教程

在不断发展的人工智能领域,生成式AI无疑已成为创新的基石。 这些先进的模型,无论是用于创作艺术、生成文本还是增强医学成像,都以产生非常逼真和创造性的输出而闻名。 然而,生成式AI的力量是有代价的—模型大小和计算要求。 随着生成式AI模型的复杂性和规模不断增长,它们需要更多的计算资源和存储空间。 这可能是一个重大障碍,特别是在边缘设备或资源受限的环境上部署这些模型时。 这就是具有模型量化功能的生成式 AI 发挥作用的地方,它提供了一种在不牺牲质量的情况下缩小这些庞大模型的方法。

在线工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器

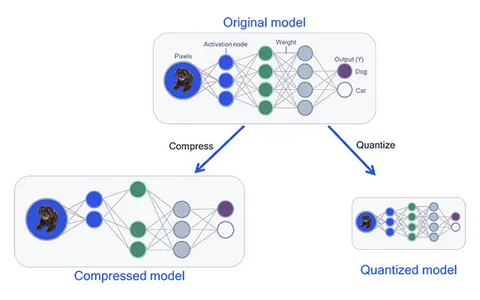

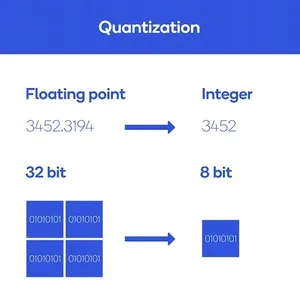

1、模型量化简介

简而言之,模型量化(Model Quantization)会降低模型参数数值的精度。 在深度学习模型中,神经网络通常采用高精度浮点值(例如 32 位或 64 位)来表示权重和激活。 模型量化将这些值转换为较低精度的表示形式(例如 8 位整数),同时保留模型的功能。

模型量化在生成式AI中的好处包括:

- 减少内存占用:模型量化最明显的好处是内存使用量的显着减少。 较小的模型尺寸使得在边缘设备、移动应用程序和内存容量有限的环境中部署生成式AI变得可行。

- 更快的推理:由于数据大小减少,量化模型运行速度更快。 这种速度的提高对于视频处理、自然语言理解或自动驾驶汽车等实时应用至关重要。

- 能源效率:缩小模型大小有助于提高能源效率,使得在电池供电设备或在能源消耗令人担忧的环境中运行生成式AI模型变得可行。

- 降低成本:较小的模型占用空间会降低存储和带宽要求,从而为开发人员和最终用户节省成本。

尽管有其优势,生成式AI中的模型量化也面临着一些挑战:

- 量化感知训练:准备量化模型通常需要重新训练。 量化感知训练旨在最大限度地减少量化过程中模型质量的损失。

- 最佳精度选择:选择正确的量化精度至关重要。 精度太低可能会导致显着的质量损失,而精度太高可能无法充分减小模型大小。

- 微调和校准:量化后,模型可能需要微调和校准以保持其性能并确保它们在新的精度约束下有效运行。

一些生成式AI模型量化的应用示例如下:

- 设备上的艺术生成:通过量化缩小生成式 AI 模型,艺术家可以创建设备上的艺术生成工具,使它们更易于访问和便携地进行创意工作。

- 边缘设备上的医疗保健成像:可以部署量化模型以进行实时医学图像增强,从而实现更快、更高效的诊断。

- 移动终端文本生成:移动应用程序可以提供文本生成服务,减少延迟和资源使用,从而增强用户体验。

2、生成式AI模型量化的代码优化

将模型量化纳入生成式 AI 可以通过 TensorFlow 和 PyTorch 等流行的深度学习框架来实现。 TensorFlow Lite 的量化感知训练(quantization-aware training)和 PyTorch 的动态量化(dynamic quantization)等工具和技术提供了在项目中实现量化的简单方法。

2.1 TensorFlow Lite 量化

TensorFlow 提供了用于模型量化的工具包,特别适合设备上部署。 以下代码片段演示了使用 TensorFlow Lite 量化 TensorFlow 模型:

import tensorflow as tf# Load your saved model

converter = tf.lite.TFLiteConverter.from_saved_model("your_model_directory")

converter.optimizations = [tf.lite.Optimize.DEFAULT]

tflite_model = converter.convert()

open("quantized_model.tflite", "wb").write(tflite_model)在此代码中,我们首先导入 TensorFlow 库, `tf.lite.TFLiteConverter `用于从模型目录加载保存的模型,将优化设置为 tf.lite.Optimize.DEFAULT 以启用默认量化,最后,我们转换模型并将其保存为量化的 TensorFlow Lite 模型。

2.2 PyTorch 动态量化

PyTorch 提供动态量化,允许你在推理过程中量化模型。 下面是 PyTorch 动态量化的代码片段:

import torch

from torch.quantization import quantize_dynamic

model = YourPyTorchModel()

model.qconfig = torch.quantization.get_default_qconfig('fbgemm')

quantized_model = quantize_dynamic(model, qconfig_spec={torch.nn.Linear}, dtype=torch.qint8)在此代码中,我们首先导入必要的库,然后通过 YourPyTorchModel()创建PyTorch 模型,将量化配置 (qconfig) 设置为适合模型的默认配置,最后使用 quantize_dynamic 来量化模型,得到量化模型 quantized_model。

3、比较数据:量化模型 vs. 非量化模型

内存占用:

- 非量化:3.2 GB 内存。

- 量化:模型大小减少 65%,内存使用量为 1.1 GB。 内存消耗减少了 66%。

推理速度和效率:

- 非量化:每次推理 38 毫秒,消耗 3.5 焦耳。

- 量化:每次推理速度加快 22 毫秒(提高 42%),能耗降低 2.2 焦耳(节能 37%)。

输出质量:

- 非量化:视觉质量(1-10 分值为 8.7)、文本连贯性(1-10 分值为 9.2)。

- 量化:视觉质量略有下降(7.9,下降 9%),同时保持文本连贯性(9.1,下降 1%)。

推理速度与模型质量:

- 非量化:25 FPS,质量得分 (Q1) 为 8.7。

- 量化:以 38 FPS 进行更快的推理(提高 52%),质量得分(第二季度)为 7.9(降低 9%)。

比较数据强调了量化的资源效率优势以及现实应用中输出质量的权衡。

4、生成式AI模型量化的最佳实践

虽然模型量化为在资源有限的环境中部署生成式 AI 模型提供了多种好处,但遵循最佳实践以确保量化工作取得成功至关重要。 以下是一些关键建议:

- 量化感知训练:从量化感知训练开始,这是一个微调模型以降低精度的过程。 这有助于最大限度地减少量化期间模型质量的损失。 在精度降低和模型性能之间保持平衡至关重要。

- 精度选择:仔细选择正确的量化精度。 评估模型尺寸减小和潜在质量损失之间的权衡。 你可能需要尝试不同的精度级别才能找到最佳折衷方案。

- 校准:量化后,进行校准,以确保量化模型在新的精度约束下有效运行。 校准有助于调整模型的行为以与所需的输出保持一致。

- 测试和验证:彻底测试和验证你的量化模型。 这包括评估其在现实世界数据上的性能、测量推理速度以及将生成的输出的质量与原始模型进行比较。

- 监控和微调:持续监控量化模型在生产中的性能。 如有必要,可以对模型进行微调,以随着时间的推移保持或提高其质量。 这个迭代过程确保量化模型保持有效。

- 文档和版本控制:记录量化过程并保留模型版本、校准数据和性能指标的详细记录。 该文档有助于跟踪量化模型的演变,并在出现问题时简化调试。

- 优化推理管道:关注整个推理管道,而不仅仅是模型本身。 优化输入预处理、后处理和其他组件,以最大限度地提高整个系统的效率。

5、结束语

在生成式AI领域,模型量化是应对模型大小、内存消耗和计算需求挑战的强大解决方案。 通过降低数值精度,同时保持模型质量,量化使生成式 AI 模型能够将其覆盖范围扩展到资源受限的环境。 随着研究人员和开发人员不断微调量化过程,我们预计生成式AI将部署在从移动设备到边缘计算等更加多样化和创新的应用程序中。 在此过程中,关键是在模型大小和模型质量之间找到适当的平衡,释放生成式AI的真正潜力。

原文链接:生成式AI模型量化 - BimAnt

相关文章:

生成式AI模型量化简明教程

在不断发展的人工智能领域,生成式AI无疑已成为创新的基石。 这些先进的模型,无论是用于创作艺术、生成文本还是增强医学成像,都以产生非常逼真和创造性的输出而闻名。 然而,生成式AI的力量是有代价的—模型大小和计算要求。 随着生…...

机器人制作开源方案 | 智能快递付件机器人

一、作品简介 作者:贺沅、聂开发、王兴文、石宇航、盛余庆 单位:黑龙江科技大学 指导老师:邵文冕、苑鹏涛 1. 项目背景 受新冠疫情的影响,大学校园内都采取封闭式管理来降低传染的风险,导致学生不能外出,…...

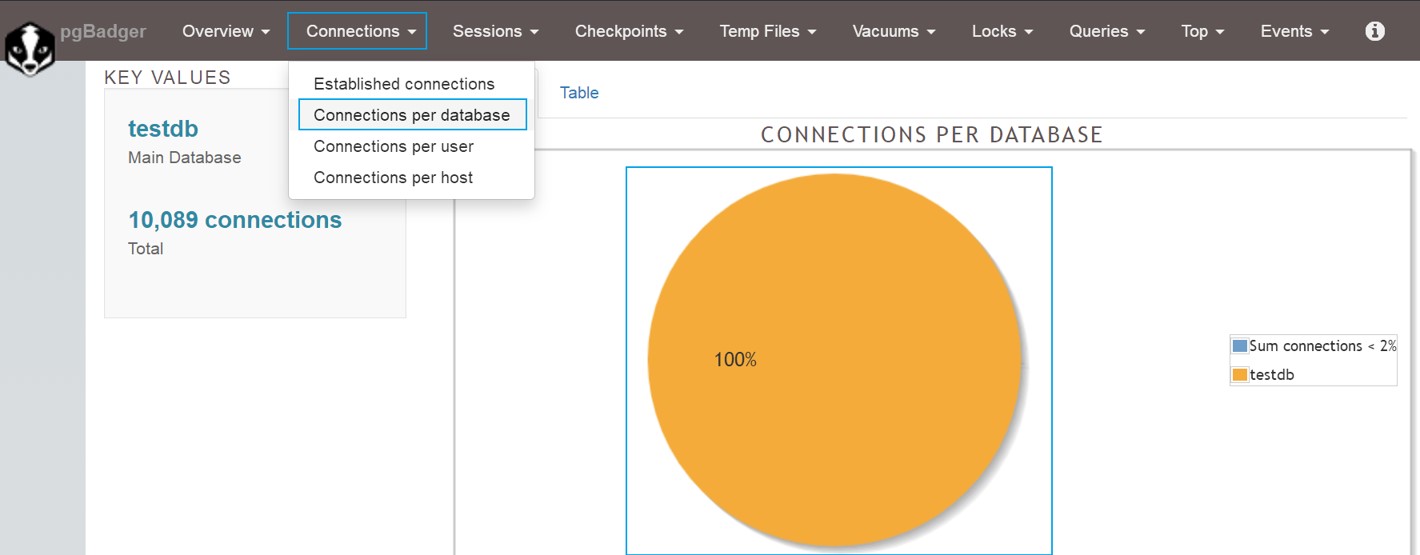

PostgreSQL技术大讲堂 - 第34讲:调优工具pgBagder部署

PostgreSQL从小白到专家,是从入门逐渐能力提升的一个系列教程,内容包括对PG基础的认知、包括安装使用、包括角色权限、包括维护管理、、等内容,希望对热爱PG、学习PG的同学们有帮助,欢迎持续关注CUUG PG技术大讲堂。 第34讲&#…...

《Python日志新宠——Loguru,轻松记录,笑对Bug!》

嘿,程序媛和程序猿们!👩💻👨💻 你们是不是也曾为日志处理这个“小事”而头疼?别着急,今天我给你们介绍一个简直比拥抱泰迪熊还要温暖的Python库——Loguru!这货不仅强…...

NET8 ORM 使用AOT SqlSugar

.NET AOT8 基本上能够免强使用了, SqlSugar ORM也支持了CRUD 能在AOT下运行了 Nuget安装 SqlSugarCore 具体代码 StaticConfig.EnableAot true;//启用AOT 程序启动执行一次就好了//用SqlSugarClient每次都new,不要用单例模式 var db new SqlSugarClient(new ConnectionC…...

CCRC认证是什么?

什么是CCRC认证? 信息安全服务资质,是信息安全服务机构提供安全服务的一种资格,包括法律地位、资源状况、管理水平、技术能力等方面的要求。 信息安全服务资质(CCRC)是依据国家法律法规、国家标准、行业标准和技术规范…...

)

linux内核面试题(2)

整理了一些网上的linux驱动岗位相关面试题,如果错误,欢迎指正。 工作队列是运行在进程上下文,还是中断上下文?它的回调函数是否允许睡眠? 工作队列是运行在进程上下文的。工作队列的回调函数是允许睡眠的,…...

YOLOV5----修改损失函数-ShuffleAttention

主要修改yolo.py、yolov5s.yaml及添加ShuffleAttention.py 一、ShuffleAttention.py import numpy as np import torch from torch import nn from torch.nn import init from torch.nn.parameter import Parameterclass ShuffleAttention(nn.Module):def...

Kafka(四)消费者消费消息

文章目录 如何确保不重复消费消息?消费者业务逻辑重试消费者提交自定义反序列化类消费者参数配置及其说明重要的参数session.time.ms和heartbeat.interval.ms和group.instance.id增加消费者的吞吐量消费者消费的超时时间和poll()方法的关系 消费者消费逻辑启动消费者…...

Python uiautomation获取微信内容!聊天记录、聊天列表、全都可获取

Python uiautomation 是一个用于自动化 GUI 测试和操作的库,它可以模拟用户操作来执行各种任务。 通过这个库,可以使用Python脚本模拟人工点击,人工操作界面。本文使用 Python uiautomation 进行微信电脑版的操作。 以下是本次实验的版本号。…...

Java通过Lettuce访问Redis主从,哨兵,集群

操作 首先需要maven导入依赖 <dependency><groupId>io.lettuce</groupId><artifactId>lettuce-core</artifactId><version>6.3.0.RELEASE</version> </dependency> 测试连接 public class LettuceDemo {public static voi…...

嵌入式数据库Sqlite

本文主要是介绍如何再Ubuntu下使用sqlite数据库,并且嵌入式QT环境下使用C语言来构建一个sqlite数据库,使用sqlite browser进行数据库的可视化。 1、安装sqlite 在ubuntu系统中的安装需要先下载一个安装包,SQLite Download Page 安装命令&a…...

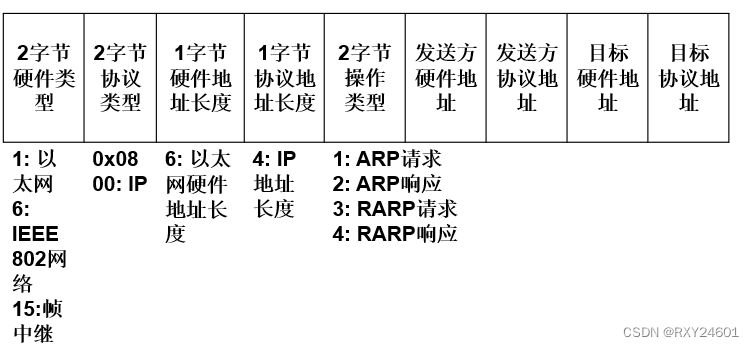

计算机网络:网络层ARP协议

在实现IP通信时使用了两个地址:IP地址(网络层地址)和MAC地址(数据链路层地址) 问题:已知一个机器(主机或路由器)的IP地址,如何找到相应的MAC地址? 为了解决…...

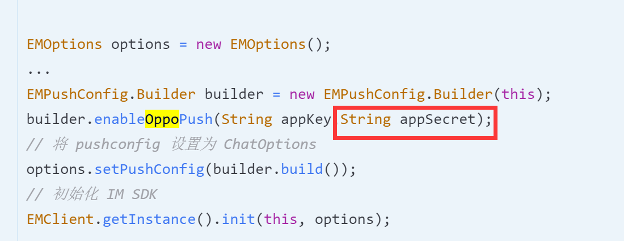

集成环信IM时常见问题及解决——包括消息、群组、推送

一、消息 环信是不支持空会话的,在插入一个会话,一定要给这个会话再插入一条消息; 发送透传消息也就是cmd消息时,value的em_开头的字段为环信内部消息字段,如果使用会出现收不到消息回调的情况; 如果发送…...

Selenium自动化测试框架

一.Selenium概述 1.1 什么是框架? 框架(framework)是一个框子——指其约束性,也是一个架子——指其支撑性。是一个基本概念上的 结构用于去解决或者处理复杂的问题。 框架是整个或部分系统的可重用设计,表现为一组抽象构件及…...

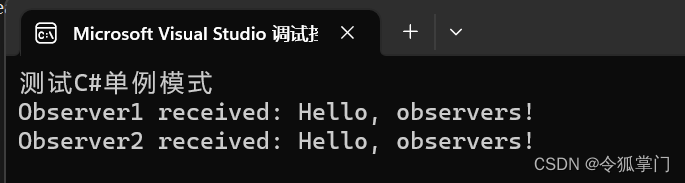

C#实现观察者模式

观察者模式是一种软件设计模式,当一个对象的状态发生变化时,其所有依赖者都会自动得到通知。 观察者模式也被称为“发布-订阅”模式,它定义了对象之间的一对多的依赖性,当一个对象状态改变时,所有依赖于它的对象都会得…...

什么是持续部署

管理软件开发和部署有 3 种常见的方法:持续集成、持续交付,然后是持续部署。尽管它们经常被混淆,但它们是明显不同的。 正如您将在本文后面看到的,它们相互融合,并补充彼此的风格。但这篇文章并不是关于他们三个。今天…...

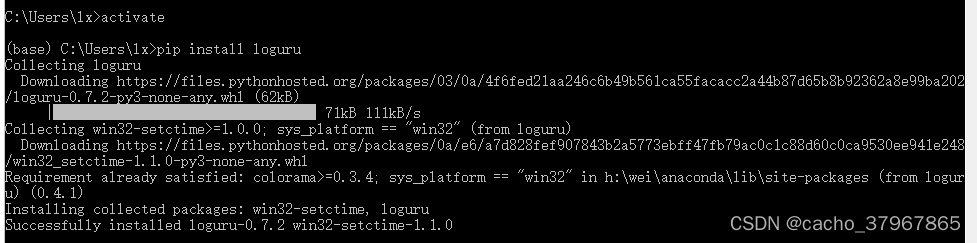

【Python】Loguru模块更简洁的日志记录库

Loguru: 更优雅的日志记录解决方案! loguru 是一个Python 简易且强大的第三方日志记录库,该库旨在通过添加一系列有用的功能来解决标准记录器的注意事项,从而减少 Python 日志记录的痛苦。 使用自带自带的 logging 模块的话,则需要…...

智慧环保:科技驱动下的环境保护新篇章

智慧环保:科技驱动下的环境保护新篇章 环境保护已经成为当今社会的重要议题,而科技的飞速发展为我们开启了智慧环保的新篇章。在这篇文章中,我们将介绍智慧环保所带来的机会和创新,以及科技在环境保护中的重要作用。 智慧环保的理…...

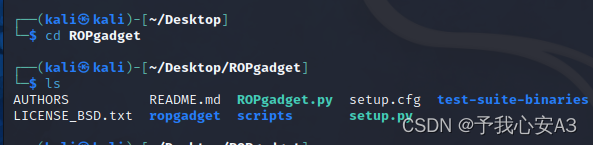

CTF-PWN环境搭建手册

工欲善其事必先利其器,作为一名CTF的pwn手,一定要有自己的专用解题环境。本文将详细记录kali下的pwn解题环境的安装过程,B站也会配备配套视频。 目录 安装前的准备工作 虚拟机环境编辑 VM版本安装教程 1. 下载Kali的VM虚拟机文件 2. 新…...

Spring Boot+Neo4j知识图谱实战:3步搭建智能关系网络!

一、引言 在数据驱动的背景下,知识图谱凭借其高效的信息组织能力,正逐步成为各行业应用的关键技术。本文聚焦 Spring Boot与Neo4j图数据库的技术结合,探讨知识图谱开发的实现细节,帮助读者掌握该技术栈在实际项目中的落地方法。 …...

Python如何给视频添加音频和字幕

在Python中,给视频添加音频和字幕可以使用电影文件处理库MoviePy和字幕处理库Subtitles。下面将详细介绍如何使用这些库来实现视频的音频和字幕添加,包括必要的代码示例和详细解释。 环境准备 在开始之前,需要安装以下Python库:…...

c#开发AI模型对话

AI模型 前面已经介绍了一般AI模型本地部署,直接调用现成的模型数据。这里主要讲述讲接口集成到我们自己的程序中使用方式。 微软提供了ML.NET来开发和使用AI模型,但是目前国内可能使用不多,至少实践例子很少看见。开发训练模型就不介绍了&am…...

重启Eureka集群中的节点,对已经注册的服务有什么影响

先看答案,如果正确地操作,重启Eureka集群中的节点,对已经注册的服务影响非常小,甚至可以做到无感知。 但如果操作不当,可能会引发短暂的服务发现问题。 下面我们从Eureka的核心工作原理来详细分析这个问题。 Eureka的…...

)

Android第十三次面试总结(四大 组件基础)

Activity生命周期和四大启动模式详解 一、Activity 生命周期 Activity 的生命周期由一系列回调方法组成,用于管理其创建、可见性、焦点和销毁过程。以下是核心方法及其调用时机: onCreate() 调用时机:Activity 首次创建时调用。…...

+ 力扣解决)

LRU 缓存机制详解与实现(Java版) + 力扣解决

📌 LRU 缓存机制详解与实现(Java版) 一、📖 问题背景 在日常开发中,我们经常会使用 缓存(Cache) 来提升性能。但由于内存有限,缓存不可能无限增长,于是需要策略决定&am…...

elementUI点击浏览table所选行数据查看文档

项目场景: table按照要求特定的数据变成按钮可以点击 解决方案: <el-table-columnprop"mlname"label"名称"align"center"width"180"><template slot-scope"scope"><el-buttonv-if&qu…...

抽象类和接口(全)

一、抽象类 1.概念:如果⼀个类中没有包含⾜够的信息来描绘⼀个具体的对象,这样的类就是抽象类。 像是没有实际⼯作的⽅法,我们可以把它设计成⼀个抽象⽅法,包含抽象⽅法的类我们称为抽象类。 2.语法 在Java中,⼀个类如果被 abs…...

【Linux手册】探秘系统世界:从用户交互到硬件底层的全链路工作之旅

目录 前言 操作系统与驱动程序 是什么,为什么 怎么做 system call 用户操作接口 总结 前言 日常生活中,我们在使用电子设备时,我们所输入执行的每一条指令最终大多都会作用到硬件上,比如下载一款软件最终会下载到硬盘上&am…...

Java求职者面试指南:Spring、Spring Boot、Spring MVC与MyBatis技术解析

Java求职者面试指南:Spring、Spring Boot、Spring MVC与MyBatis技术解析 一、第一轮基础概念问题 1. Spring框架的核心容器是什么?它的作用是什么? Spring框架的核心容器是IoC(控制反转)容器。它的主要作用是管理对…...