Flink on K8S集群搭建及StreamPark平台安装

1.环境准备

1.1 介绍

在使用 Flink&Spark 时发现从编程模型, 启动配置到运维管理都有很多可以抽象共用的地方, 目前streampark提供了一个flink一站式的流处理作业开发管理平台, 从流处理作业开发到上线全生命周期都做了支持, 是一个一站式的流出来计算平台。

未来spark开发也在规划范围内,目前还不支持

1.2 下载

StreamPark安装包下载:https://streampark.apache.org/download

StreamPark官网:https://streampark.apache.org/docs/intro

最新版为2.1.2,本次安装为2.1.2版本

1.3 已有组件及版本

| 序号 | 名称 | 配置 |

|---|---|---|

| 1 | K8S(TEK) | CPU:316,Me:361.57G,Storage:349.1G,Pods:3253,IP:3*273 (v1.26.1) |

| 2 | NFS(CFS) | 40G磁盘(目前,可扩充) |

| 3 | Harbor(容器仓库) | 未知 |

| 4 | flink | flink-(1.13.0/1.14.4/1.16.2) |

| 5 | StreamPark | 2.1.2 |

| 6 | Mysql | 5.7 |

2.挂载与权限

2.1 k8s挂载

找运维开通权限,主要是kubectl的权限

下载kubectl

权限文件:/root/.kube/config

2.2 nfs挂载

找运维要服务ip

#挂载前,请确保系统中已经安装了nfs-utils或nfs-common

sudo yum install nfs-utils

#创建待挂载目标目录

mkdir <待挂载目标目录> mkdir /localfolder/

#挂载文件系统

#挂载 CFS 根目录

#以下命令可以到 CFS 控制台-文件系统详情-挂载点详情中获取,由于部分旧版本文件系统不支持 noresvport 参数,具体挂载命令请以控制台建议命令为主。配置 norevsport 参数后,在网络重连时使用新的 TCP 端口,可以保障在网络异常到恢复期间、客户端和文件系统的连接不会中断,建议启用该参数。

#另,部分旧版本 Linux 内核需要使用 vers=4 挂载,若使用 vers=4.0 挂载有异常,可以尝试修改为 vers=4。

sudo mount -t nfs -o vers=4.0,noresvport <挂载点 IP>:/ <待挂载目录>

sudo mount -t nfs -o vers=4.0,noresvport 10.0.24.4:/ /localfolder

#挂载 CFS 子目录

#以下命令可以到 CFS 控制台-文件系统详情-挂载点详情中获取,由于部分旧版本文件系统不支持 noresvport 参数,具体挂载命令请以控制台建议命令为主。配置 norevsport 参数后,在网络重连时使用新的 TCP 端口,可以保障在网络异常到恢复期间、客户端和文件系统的连接不会中断,建议启用该参数。

#另,部分旧版本 Linux 内核需要使用 vers=4 挂载,若使用 vers=4.0 挂载有异常,可以尝试修改为 vers=4。

sudo mount -t nfs -o vers=4.0,noresvport 10.0.24.4:/subfolder /localfolder

腾讯nfs(CFS)使用文档:https://cloud.tencent.com/document/product/582/11523

2.3 Harbor

需要找运维开通权限

此处注意:项目库要公开才可以使用

3.测试Flink

在k8s为flink单独开通命名空间,并创建相应账户

kubectl create clusterrolebinding flink-role-bind --clusterrole=edit --serviceaccount=flink:flink

在有k8s操作权限的节点运行flink-session

bin/flink run \

-e kubernetes-session \

-Dkubernetes.namespace=flink \

-Dkubernetes.rest-service.exposed.type=NodePort \

-Dkubernetes.cluster-id=flink-cluster \

-c WordCount1 \

/data/package/jar/flink_test-1.0-SNAPSHOT.jar#参考配置

bin/kubernetes-session.sh \

-Dkubernetes.namespace=flink \

-Dkubernetes.jobmanager.service-account=flink \

-Dkubernetes.rest-service.exposed.type=NodePort \

-Dkubernetes.cluster-id=flink-cluster \

-Dkubernetes.jobmanager.cpu=0.2 \

-Djobmanager.memory.process.size=1024m \

-Dresourcemanager.taskmanager-timeout=3600000 \

-Dkubernetes.taskmanager.cpu=0.2 \

-Dtaskmanager.memory.process.size=1024m \

-Dtaskmanager.numberOfTaskSlots=1

4.安装StreamPark

4.1 streampark(k8s)镜像打包

#编译

./build #注意maven 镜像配置,要不找不到依赖包同时要安装npm

#测试npm是否安装

npm -v#streampark安装包添加mysql连接包

cp /data/module/streampart_2.12-2.1.2/lib/mysql-connector-java-8.0.30.jar lib/

#配置maven配置拷贝

cp /data/module/maven-3.6.3/conf/settings.xml /data/module/docker/streampark-docker/

#修改application.yml

profiles.active: mysql #[h2,pgsql,mysql]

lark-url: https://open.feishu.cn

workspace:local: /opt/streampark_workspace

#配置application-mysql.yml

tee /data/module/docker/streampark-docker/streampark-2.1.2/conf/application-mysql.yml <<-'EOF'

spring.datasource.driver-class-name: com.mysql.cj.jdbc.Driver

streampark.docker.http-client.docker-host: ${DOCKER_HOST:}

streampark.maven.settings: ${MAVEN_SETTINGS_PATH:/root/.m2/settings.xml}

streampark.workspace.local: ${WORKSPACE_PATH:/opt/streampark_workspace}

EOF# 编写Dockerfile

#需要提前准备kubectl、settings.xml 、config(kubectl的密钥)

tee docker<<-'EOF'

FROM flink:1.17.1-scala_2.12-java8

WORKDIR /opt/streampark/

ADD ./streampark-2.1.2/ /opt/streampark/

ADD ./kubectl /opt/streampark/

ADD ./settings.xml /root/.m2/

USER root

RUN sed -i -e 's/eval $NOHUP/eval/' bin/streampark.sh \&& sed -i -e 's/>> "$APP_OUT" 2>&1 "&"//' bin/streampark.sh \&& install -o root -g root -m 0755 kubectl /usr/local/bin/kubectl \&& mkdir -p ~/.kube

WORKDIR /opt/streampark/

ADD ./config /root/.kube/

RUN chown -R flink /opt/streampark/EXPOSE 10000

EOF

#构建镜像

docker build -f Dockerfile -t apache/streampark-flink:2.1.2 .

#推送镜像到仓库

docker tag apache/streampark-flink:2.1.2 storage/bigdata/streampark-flink:2.1.2

docker push storage/bigdata/streampark-flink:2.1.2docker tag apache/streampark-flink:2.1.2-rc4 storage/bigdata/streampark-flink:2.1.2-rc4

docker push storage/bigdata/streampark-flink:2.1.2-rc4

4.2部署MySQL的pod

#k8s上创建mysql的namespace

#含义:kubectl create clusterrolebinding ClusterRoleBinding名 --clusterrole=绑定的Role serviceaccount=被绑定的SA -n 命名空间

kubectl create namespace mysql

kubectl create serviceaccount mysql

kubectl create clusterrolebinding mysql-role-bind --clusterrole=edit --serviceaccount=mysql:mysql -n mysql

clusterrolebinding.rbac.authorization.k8s.io/mysql-role-bind created

#查看角色绑定

kubectl get clusterrolebinding flink-role-bind -n flink -o yaml

kubectl get clusterrolebinding mysql-role-bind -n mysql -o yaml

kubectl get clusterrolebinding mysql-role-bind -n flink -o yaml

#配置pvc和pv和nfs指定(腾讯nfs可直接使用)

apiVersion: v1

kind: PersistentVolume

metadata:name: data-mysql

spec:accessModes:- ReadWriteManycapacity:storage: 10Gicsi:driver: com.tencent.cloud.csi.cfsvolumeAttributes:host: x x xpath: /data_mysqlvers: "4"volumeHandle: cfs #此处需要每个pv都不相同,否则挂载两个pvc会报错persistentVolumeReclaimPolicy: RetainstorageClassName: data-mysqlvolumeMode: Filesystem

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:name: data-mysqlnamespace: mysql

spec:accessModes:- ReadWriteManyresources:requests:storage: 10GistorageClassName: data-mysql

#docker拉去mysql镜像并上传至镜像库

docker tag mysql:5.7 storage/bigdata/mysql:5.7

docker push storage/bigdata/mysql:5.7

#查看集群的node ip

kubectl get node

# 编写mysql的yaml文件,并做配置

sudo mkdir -p /data/module/docker/mysql/{conf,data}/

sudo tee /data/module/docker/mysql/conf/pod-db-mysql.yaml <<-'EOF'

apiVersion: v1

kind: ConfigMap

metadata:name: conf-mysqlnamespace: mysql

data:mysql.cnf: |[mysqld]#Mysql服务的唯一编号 每个mysql服务Id需唯一server-id=1# 允许访问的IP网段bind-address=0.0.0.0#设置时区default-time_zone='+8:00'#数据库默认字符集,主流字符集支持一些特殊表情符号(特殊表情符占用4个字节)character-set-server=utf8mb4#数据库字符集对应一些排序等规则,注意要和character-set-server对应collation-server=utf8mb4_general_ci#设置client连接mysql时的字符集,防止乱码init_connect='SET NAMES utf8mb4'#是否对sql语句大小写敏感,1表示不敏感lower_case_table_names=1#最大连接数max_connections=400#最大错误连接数max_connect_errors=1000#TIMESTAMP如果没有显示声明NOT NULL,允许NULL值explicit_defaults_for_timestamp=true#SQL数据包发送的大小,如果有BLOB对象建议修改成1Gmax_allowed_packet=128M#MySQL连接闲置超过一定时间后(单位:秒)将会被强行关闭#MySQL默认的wait_timeout 值为8个小时, interactive_timeout参数需要同时配置才能生效interactive_timeout=3600wait_timeout=3600

---

apiVersion: v1

kind: Pod

metadata:name: pod-db-mysqlnamespace: mysql

spec:#serviceAccount: mysqlnodeName: xxxhostNetwork: true #主机网络可见(会占用node端口)containers:- name: mysql-k8simage: storage/bigdata/mysql:5.7env:- name: TZvalue: "Asia/Shanghai"- name: LANGvalue: "zh_CN.UTF-8"- name: MYSQL_ROOT_PASSWORDvalue: "xxxx"ports:#- containerPort: 3306volumeMounts:- mountPath: /var/lib/mysqlsubPath: mysqlname: data-mysql- mountPath: /etc/mysql/conf.dname: conf-volumereadOnly: truevolumes:- name: data-mysqlpersistentVolumeClaim:claimName: data-mysql- name: conf-volumeconfigMap:name: conf-mysql

EOF#kubectl delete -f /opt/module/k3s/conf/pod-db-mysql-k3s100.yaml

#启动pod

kubectl apply -f /data/module/docker/mysql/conf/pod-db-mysql.yaml

kubectl delete -f /data/module/docker/mysql/conf/pod-db-mysql.yaml

# 稍等片刻

kubectl get pod -A -owide

kubectl describe pod pod-db-mysql

kubectl logs --tail=100 -f pod-db-mysql -n mysql

4.3 mysql 数据库初始化

# 复制数据库文件

cp -r /data/software/incubator-streampark-2.1.2-rc3/streampark-console/streampark-console-service/src/main/assembly/script/ /localnfs/data_mysql/mysql/streampark-sql/

cp -r /data/module/docker/streampark-docker/streampark-2.2.0/script/ /localnfs/data_mysql/mysql/streampark-sql/

# 创建用户及数据库

# 进入mysql容器

kubectl exec -n mysql -it pod-db-mysql -- bash

#------------------------进入mysql容器----------------------------

mysql -uroot -proot

create database if not exists `streampark` character set utf8mb4 collate utf8mb4_general_ci;

create user 'xxxx'@'%' IDENTIFIED WITH mysql_native_password by 'xxx';

grant ALL PRIVILEGES ON streampark.* to 'xxxx'@'%';

flush privileges;

-- 导入数据文件

use streampark;

source /var/lib/mysql/streampark-sql/schema/mysql-schema.sql

source /var/lib/mysql/streampark-sql/data/mysql-data.sql

-- 退出mysql

quit

#------------------------退出mysql容器------------------------

exit#查看mysql 的建表

vim /data/module/docker/streampark-docker/streampark-2.2.0/script/schema/mysql-schema.sql

vim /data/module/docker/streampark-docker/streampark-2.2.0/script/data/mysql-data.sql

4.4 创建StreamPark的pod

#k8s上创建mysql的namespace

#含义:kubectl create clusterrolebinding ClusterRoleBinding名 --clusterrole=绑定的Role serviceaccount=被绑定的SA -n 命名空间

kubectl create namespace streampark

kubectl create serviceaccount streampark

kubectl create clusterrolebinding streampark-role-bind --clusterrole=edit --serviceaccount=streampark:streampark -n streampark

clusterrolebinding.rbac.authorization.k8s.io/mysql-role-bind created#配置pvc和pv和nfs指定

vim pv-pvc-streampark.yamlapiVersion: v1

kind: PersistentVolume

metadata:name: data-streampark

spec:accessModes:- ReadWriteManycapacity:storage: 10Gicsi:driver: com.tencent.cloud.csi.cfsvolumeAttributes:host: xxxpath: /data_streamparkvers: "4"volumeHandle: cfs #此处需要每个pv都不相同,否则挂载两个pvc会报错persistentVolumeReclaimPolicy: RetainstorageClassName: data-streamparkvolumeMode: Filesystem

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:name: data-streamparknamespace: streampark

spec:accessModes:- ReadWriteManyresources:requests:storage: 10GistorageClassName: data-streampark#执行

kubectl apply -f /data/module/docker/k8s/pv-pvc-streampark.yaml

kubectl delete -f /data/module/docker/k8s/pv-pvc-streampark.yaml

# 在xxx 上执行,在指定 节点 xxx 安装StreamPark

sudo tee /data/pod-app-streampark.yaml <<-'EOF'

apiVersion: apps/v1

kind: Deployment

metadata:labels:app: pod-app-streamparkname: pod-app-streamparknamespace: streampark

spec:replicas: 1selector:matchLabels:app: pod-app-streamparktemplate:metadata:labels:app: pod-app-streamparkspec:nodeName: xxxhostNetwork: true #主机网络可见(会占用node端口)containers:- name: streamparkimage: storage/bigdata/streampark-flink:2.1.2-rc4imagePullPolicy: Alwaysenv:- name: TZvalue: "Asia/Shanghai"- name: LANGvalue: "zh_CN.UTF-8"- name: SPRING_PROFILES_ACTIVEvalue: "mysql"- name: SPRING_DATASOURCE_URLvalue: "jdbc:mysql://xxx:3306/streampark?useSSL=false&useUnicode=true&characterEncoding=UTF-8&allowPublicKeyRetrieval=false&useJDBCCompliantTimezoneShift=true&useLegacyDatetimeCode=false&serverTimezone=GMT%2B8"- name: SPRING_DATASOURCE_USERNAMEvalue: "xxxx"- name: SPRING_DATASOURCE_PASSWORDvalue: "xxxx"- name: DOCKER_HOSTvalue: "tcp://xxx:2375"- name: DEBUG_OPTS #调试端口参数value: "-agentlib:jdwp=transport=dt_socket,server=y,suspend=n,address=*:10001"ports:#- containerPort: 10000volumeMounts:- mountPath: /root/.kubesubPath: .kubename: conf-volume- mountPath: /opt/streampark_workspacesubPath: streampark_workspacename: data-volumecommand: ["sh","-c","bash bin/startup.sh debug"]volumes:- name: conf-volumehostPath:path: /roottype: DirectoryOrCreate- name: data-volumenfs:path: /data_streamparkserver: xxxEOF#kubectl delete -f /opt/module/k3s/conf/pod-app-streampark-k3s100.yaml

#启动pod

kubectl apply -f /data/pod-app-streampark.yaml

kubectl delete -f /data/pod-app-streampark.yaml

# 稍等片刻

kubectl get pod -A -o wide -n mysql

kubectl describe pod pod-app-streampark-k3s100

kubectl logs --tail=1000 -f pod-app-streampark -n mysql

# 进入mysql容器中创建用户及数据库

kubectl exec -n mysql -it pod-app-streampark -- bash

#-c streampark-k3s100# 为默认命名空间添加权限 kubectl create clusterrolebinding flink-role-binding-default --clusterrole=edit --serviceaccount=flink_dev:default

kubectl create clusterrolebinding flink-role-binding-default --clusterrole=edit --serviceaccount=default:default

相关文章:

Flink on K8S集群搭建及StreamPark平台安装

1.环境准备 1.1 介绍 在使用 Flink&Spark 时发现从编程模型, 启动配置到运维管理都有很多可以抽象共用的地方, 目前streampark提供了一个flink一站式的流处理作业开发管理平台, 从流处理作业开发到上线全生命周期都做了支持, 是一个一站式的流出来计算平台。 未来spark开…...

SpringBoot如何优雅的处理免登录接口

在项目开发过程中,会有很多API接口不需要登录就能直接访问,比如公开数据查询之类的 ~ 常规处理方法基本是 使用拦截器或过滤器,拦截需要认证的请求路径。在拦截器中判断session或token信息,如果存在则放行,否则跳转到…...

元旦档首日票房超4.69亿,“下雪场尴尬”上热搜!

哇塞,元旦假期终于来啦!🎉在这个喜庆的时刻,电影院也热闹非凡,据猫眼专业版数据显示,截至12月30日,2023年元旦档首日票房竟然超过了4.69亿!这简直是个天文数字啊!&#x…...

CentOS系统中设置IP地址的方式和存在的问题

在CentOS系统中设置IP地址通常涉及以下步骤: 打开网络接口配置文件: 使用文本编辑器(如vi、nano或emacs)打开 /etc/sysconfig/network-scripts/ifcfg-eth0 文件。这里的"eth0"是网卡的名称,如果你的系统中有…...

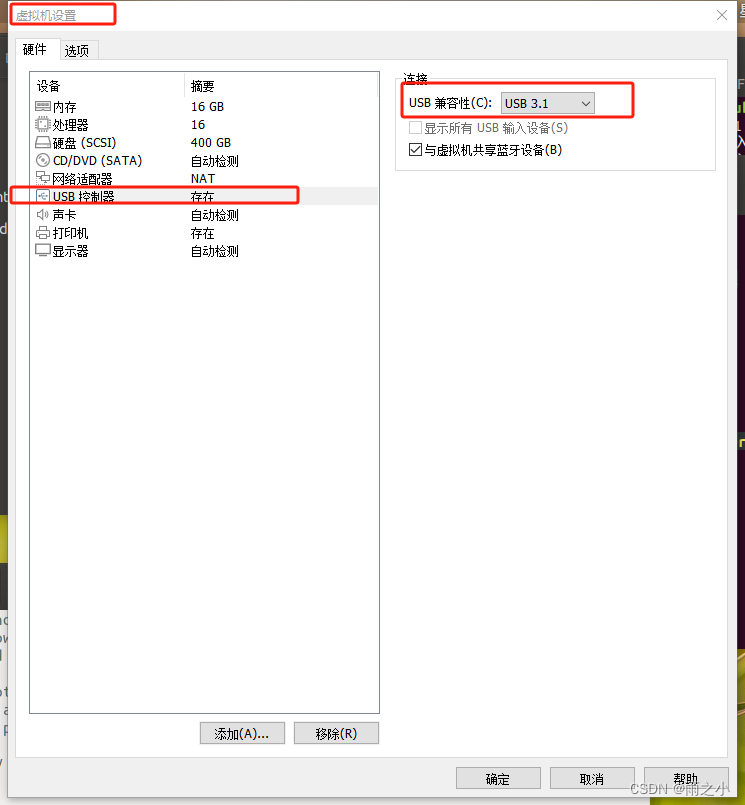

使用vmware,在ubuntu18.04中使用笔记本的摄像头

步骤1:在windows中检查相机状态 win10系统中,在左下的搜索栏,搜索“相机”,点击进入即可打开相机,并正常显示图像。 注意:如果相机连接到了虚拟机,则不能显示正常。 步骤2:在ubuntu…...

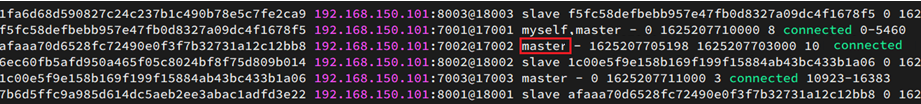

中间件系列 - Redis入门到实战(高级篇-分布式缓存)

前言 学习视频: 黑马程序员Redis入门到实战教程,深度透析redis底层原理redis分布式锁企业解决方案黑马点评实战项目 中间件系列 - Redis入门到实战 本内容仅用于个人学习笔记,如有侵扰,联系删除 学习目标 Redis持久化Redis主从…...

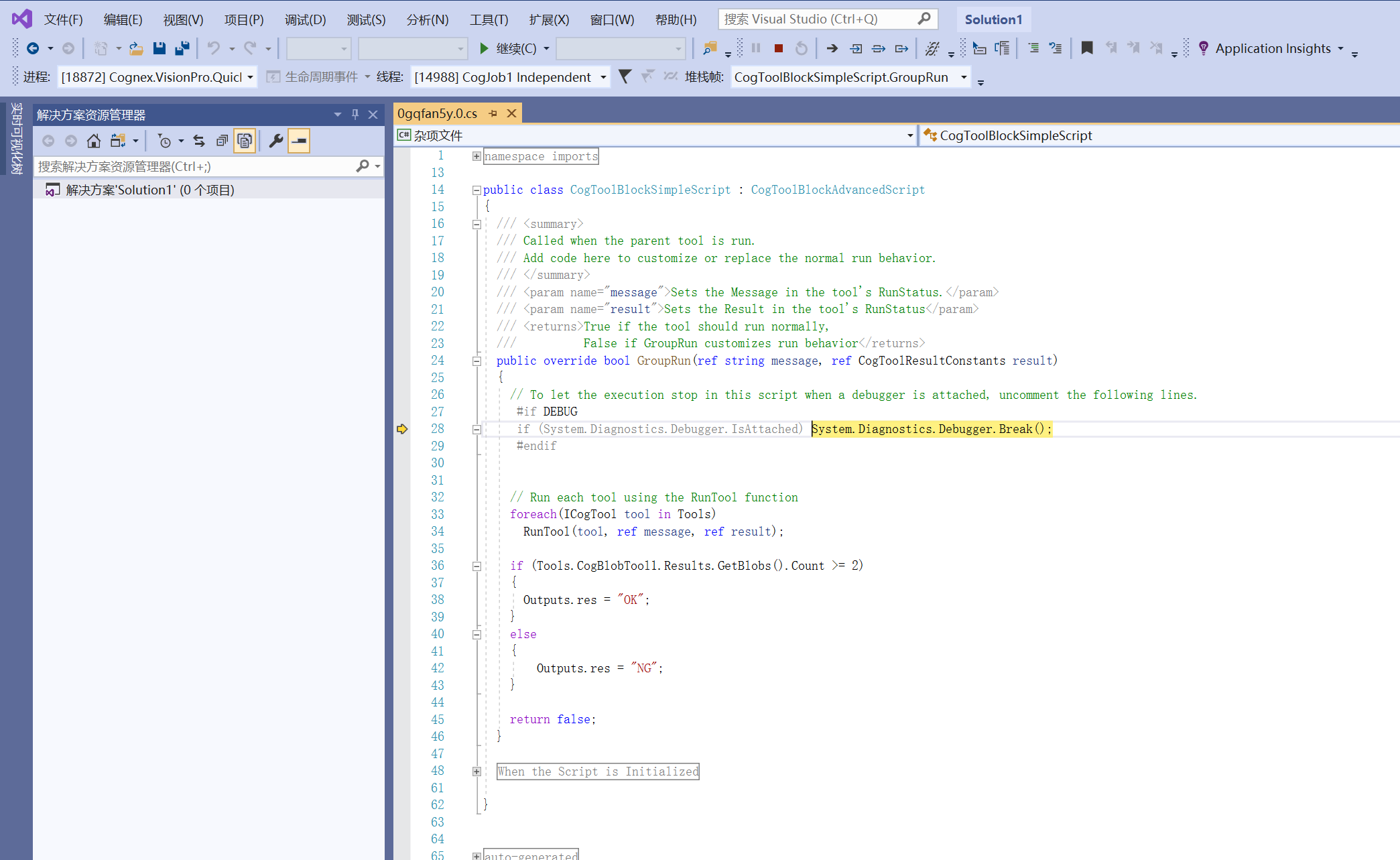

使用Visual Studio调试VisionPro脚本

使用Visual Studio调试VisionPro脚本 方法一 : 修改项目文件 csproj步骤: 方法二 : Visual Studio附加功能步骤: 方法一 : 修改项目文件 csproj 步骤: 开启VisionPro脚本调试功能 创建一个VisionPro程序…...

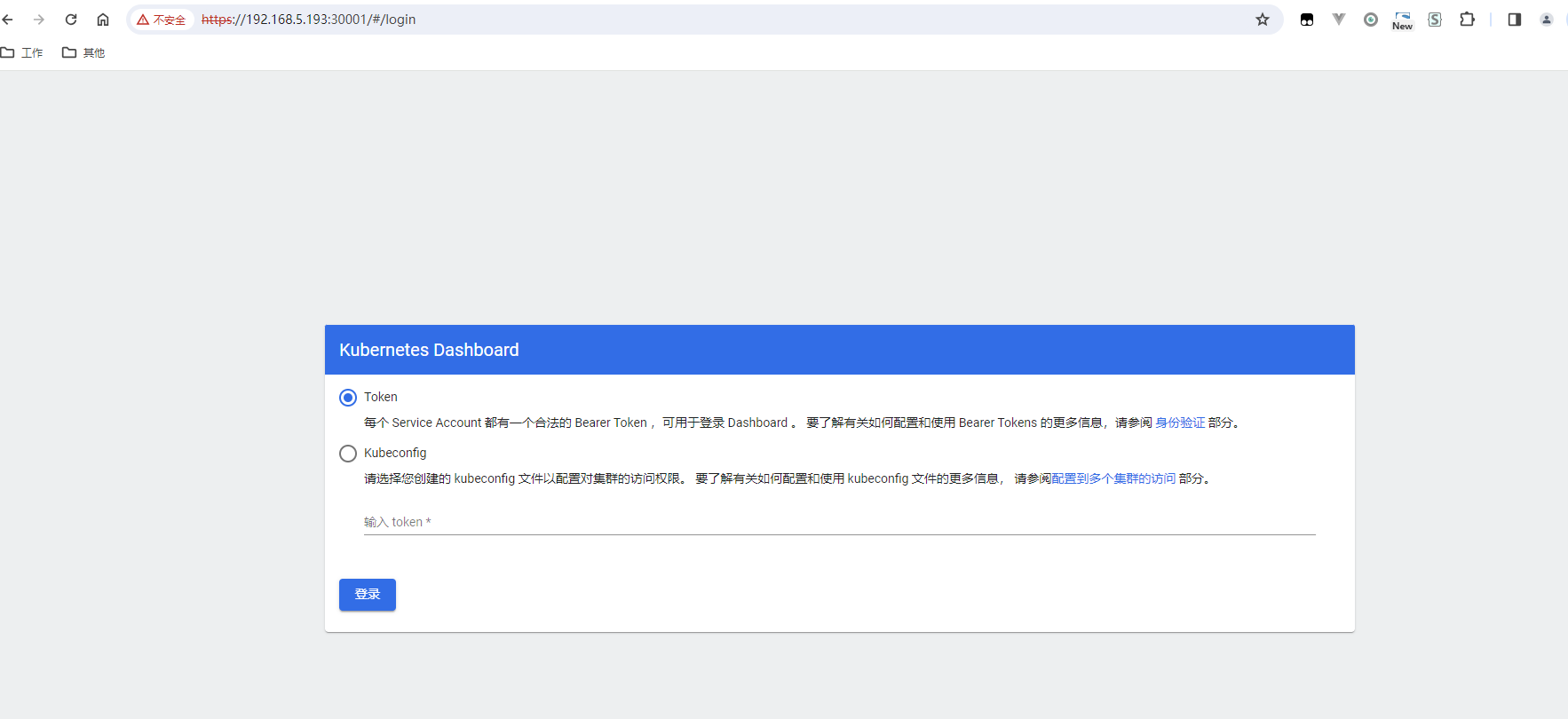

Ubuntu安装K8S的dashboard(管理页面)

原文网址:Ubuntu安装k8s的dashboard(管理页面)-CSDN博客 简介 本文介绍Ubuntu安装k8s的dashboard(管理页面)的方法。 Dashboard的作用有:便捷操作、监控、分析、概览。 相关网址 官网地址:…...

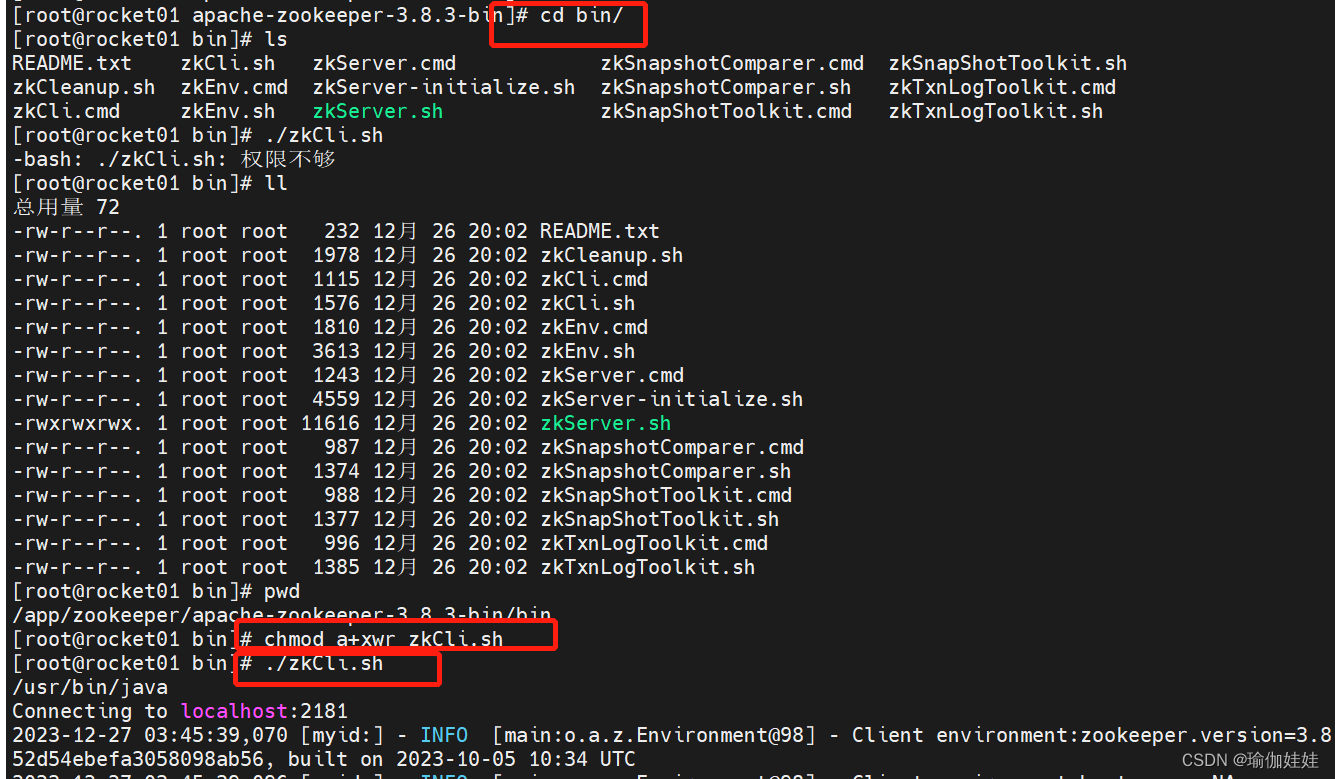

zookeeper之集群搭建

1. 集群角色 zookeeper集群下,有3种角色,分别是领导者(Leader)、跟随着(Follower)、观察者(Observer)。接下来我们分别看一下这三种角色的作用。 领导者(Leader): 事务请求(写操作)的唯一调度者和处理者,保…...

从0开始界面设计师 Qt Designer

QT程序界面的 一个个窗口、控件,就是像上面那样用相应的代码创建出来的。 但是,把你的脑海里的界面,用代码直接写出来,是有些困难的。 很多时候,运行时呈现的样子,不是我们要的。我们经常还要修改代码调整界…...

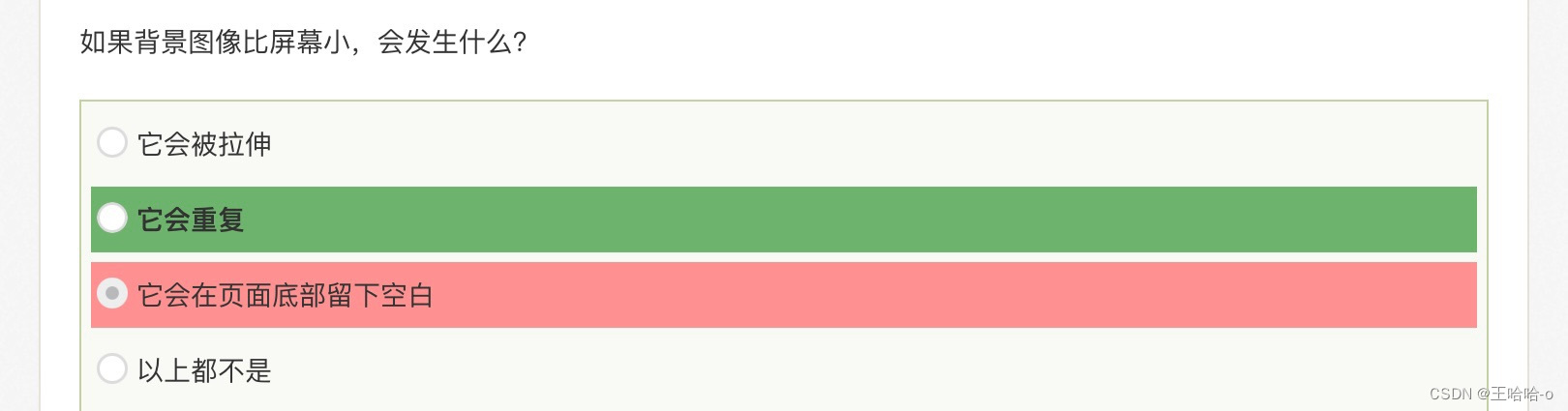

Html / CSS刷题笔记

WebKit是一个开源的浏览器引擎,它最初是由苹果公司开发的,并且被广泛用于Safari浏览器和其他基于WebKit的浏览器,比如Google Chrome的早期版本。它也是构建许多移动设备浏览器的基础。WebKit的主要功能是解析HTML和CSS,并将其渲染…...

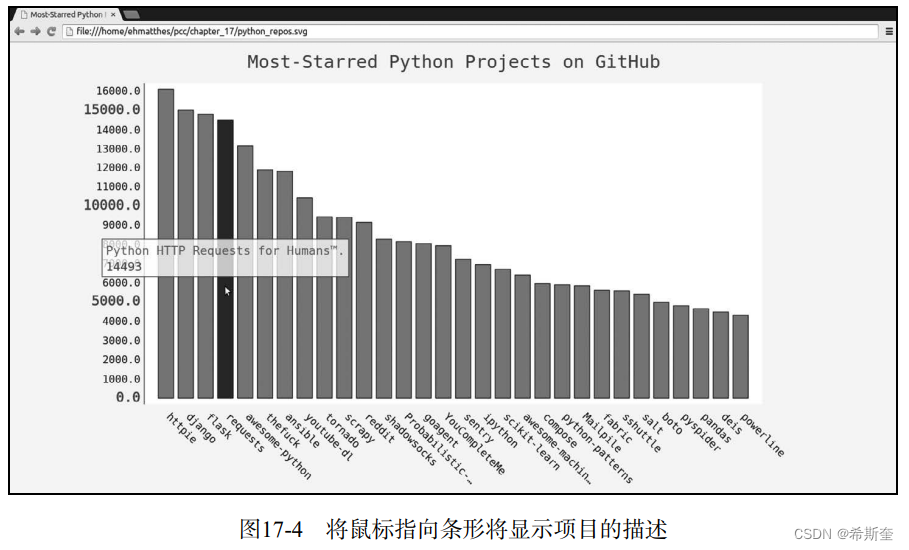

关于“Python”的核心知识点整理大全51

目录 17.2.2 添加自定义工具提示 bar_descriptions.py 17.2.3 根据数据绘图 python_repos.py 17.2.4 在图表中添加可单击的链接 python_repos.py 17.3 Hacker News API hn_submissions.py 17.4 小结 往期快速传送门👆(在文章最后)&a…...

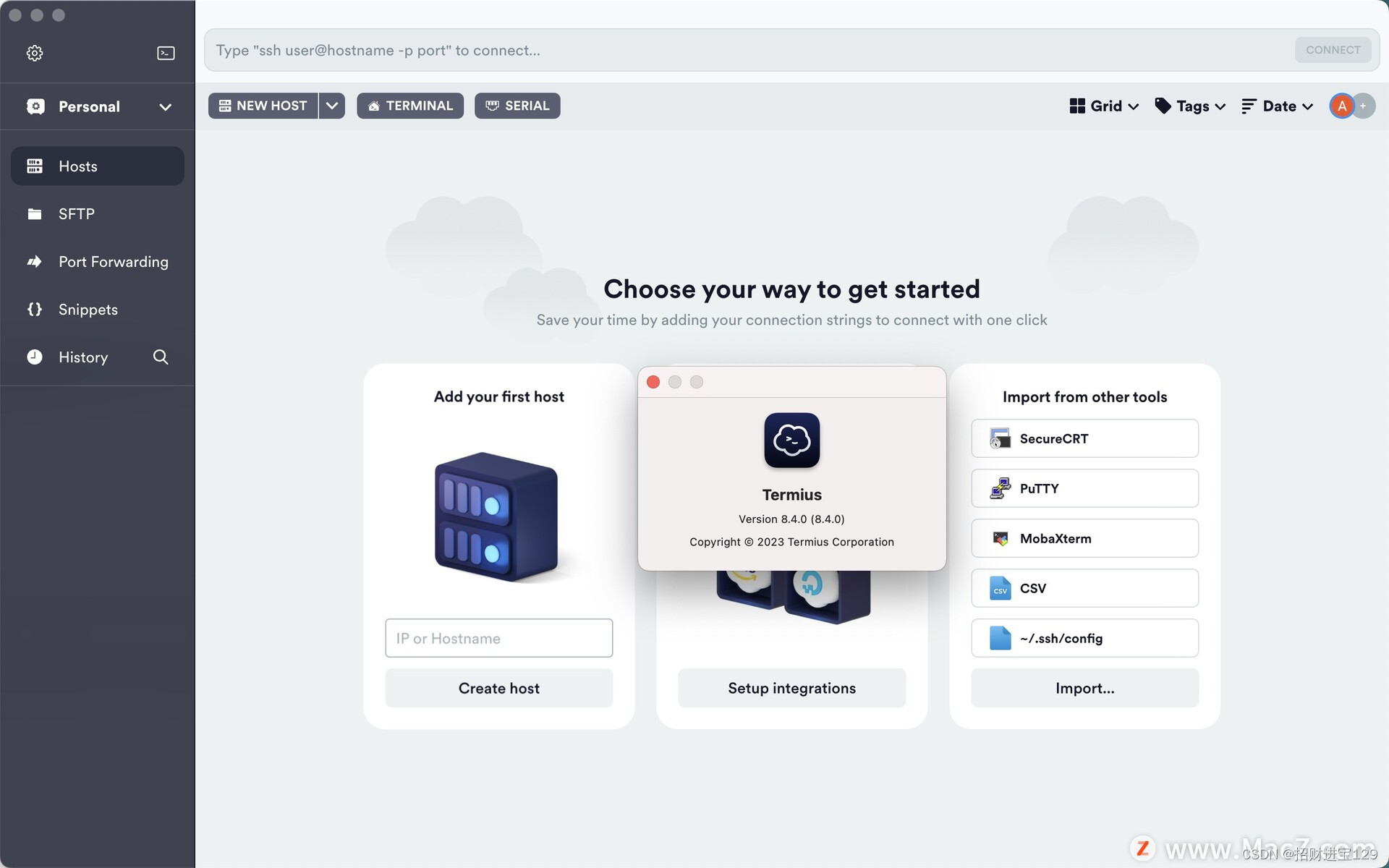

Termius for Mac/Win:一站式终端模拟器、SSH 和 SFTP 客户端软件的卓越选择

随着远程工作和云技术的普及,对于高效安全的远程访问和管理服务器变得至关重要。Termius,一款强大且易用的终端模拟器、SSH 和 SFTP 客户端软件,正是满足这一需求的理想选择。 Termius 提供了一站式的解决方案,允许用户通过单一平…...

vr体验馆用什么软件计时计费,如遇到停电软件程序如何恢复时间

vr体验馆用什么软件计时计费,如遇到停电软件程序如何恢复时间 一、软件程序问答 如下图,软件以 佳易王vr体验馆计时计费软件V17.9为例说明 1、软件如何计时间? 点击相应编号的开始计时按钮即可 2、遇到停电再打开软件时间可以恢复吗&…...

HTML---JavaScript基础

文章目录 目录 文章目录 本章目标 一.JavaScript基础 概述 特点 JavaScript 基本机构 语法 网页中引用JavaScript的方式 二. JavaScript核心语法 变量 编辑 数据类型 数组 练习 本章目标 掌握JavaScript的组成掌握JavaScript的基本语法会定义和使用函数会使用工具进行…...

2023年03月17日_微软和谷歌办公AI的感慨

2023年3月17日 最近这个科技圈的消息 有点爆炸的让人应接不暇了 各种大公司简直就是神仙打架 你从来没有见过这么密集的 这么高频的产品发布 昨天微软是发布了Office 365 Copilot 在里边提供了大量的AI的功能 然后谷歌呢也发布了这个Google Workspace AI 也是跟365 Cop…...

2023年新一代开发者工具 Vue ,正式开源!

以下文章来源于前端充电宝 ,作者CUGGZ 近日,Vue 新一代开发者工具(DevTools)正式开源!Vue DevTools 是一个旨在增强 Vue 开发人员体验的工具,它提供了一些功能来帮助开发者更好地了解 Vue 应用。下面就来看…...

springboot(ssm校园组团平台 高校组团系统 Java系统

springboot(ssm校园组团平台 高校组团系统 Java系统 开发语言:Java 框架:ssm/springboot vue JDK版本:JDK1.8(或11) 服务器:tomcat 数据库:mysql 5.7(或8.0) 数据库…...

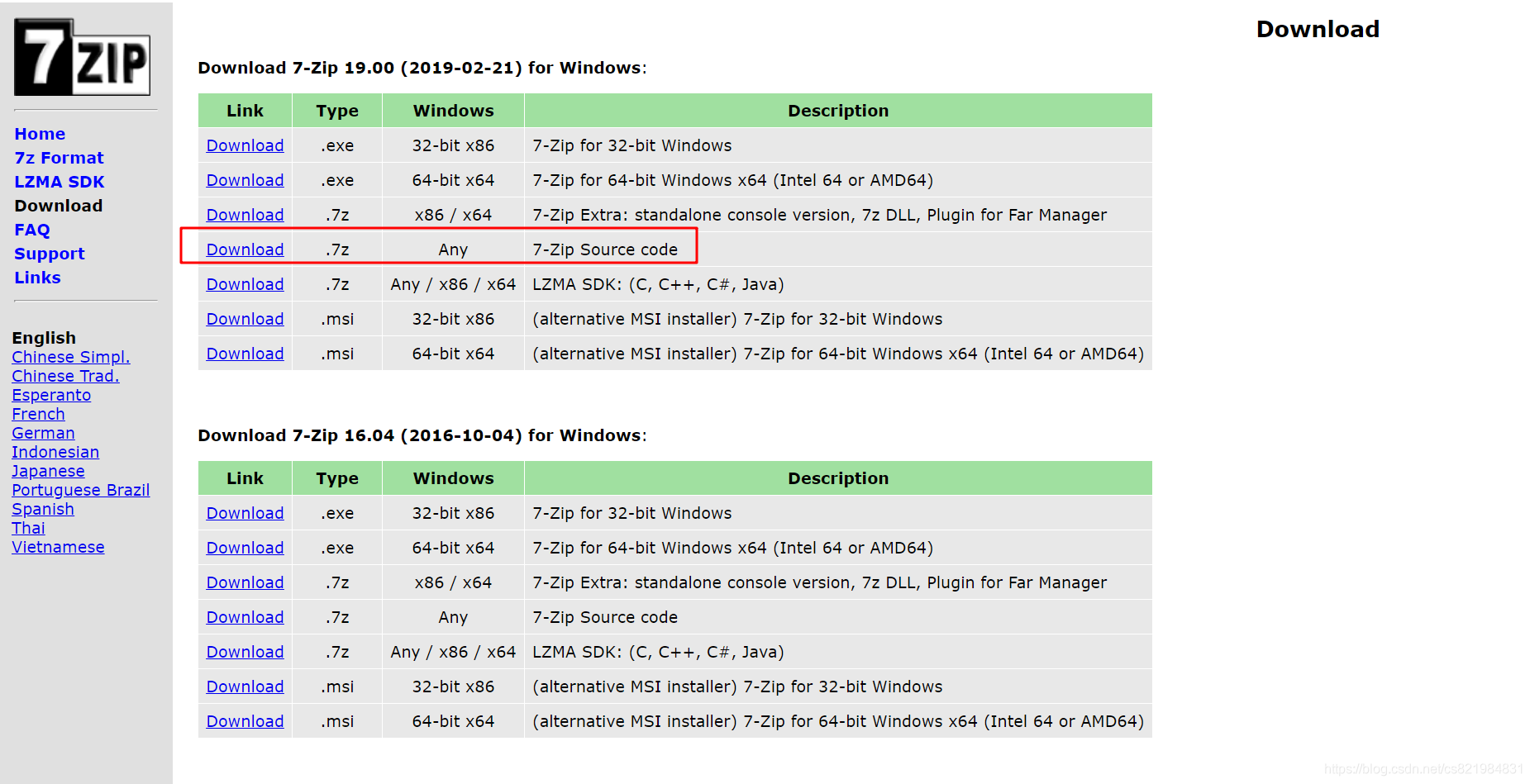

QT 利用开源7z 实现解压各种压缩包,包括进度条和文件名的显示(zip,7z,rar,iso等50多种格式)

想做一个winRAR一样的解压软件吗?很简单,利用开源的7z库就能实现。我看网上其他人说的方法不敢苟同,误人子弟。以前自己在项目中使用过7z,这次又有需要,就想记录下来。如果你研究过如何用7z的话,一定知道7z的每一个GUID都代表了一种格式,50多种GUID也就有50多个格式,最…...

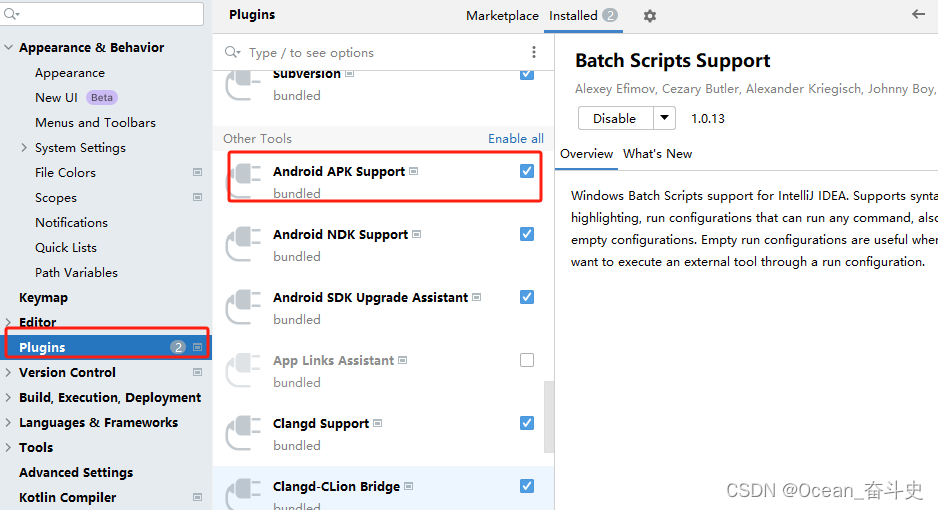

androidStudio 没有新建flutter工程的入口?

装了flutter dart 插件 执行了 flutter doctor 也执行了 flutter doctor --android-license 最后重启了 androidStudio 还是没发现在哪新建flutter项目工程 原来 plugins 下的 Android APK Support没有勾选...

conda相比python好处

Conda 作为 Python 的环境和包管理工具,相比原生 Python 生态(如 pip 虚拟环境)有许多独特优势,尤其在多项目管理、依赖处理和跨平台兼容性等方面表现更优。以下是 Conda 的核心好处: 一、一站式环境管理:…...

Linux相关概念和易错知识点(42)(TCP的连接管理、可靠性、面临复杂网络的处理)

目录 1.TCP的连接管理机制(1)三次握手①握手过程②对握手过程的理解 (2)四次挥手(3)握手和挥手的触发(4)状态切换①挥手过程中状态的切换②握手过程中状态的切换 2.TCP的可靠性&…...

ServerTrust 并非唯一

NSURLAuthenticationMethodServerTrust 只是 authenticationMethod 的冰山一角 要理解 NSURLAuthenticationMethodServerTrust, 首先要明白它只是 authenticationMethod 的选项之一, 并非唯一 1 先厘清概念 点说明authenticationMethodURLAuthenticationChallenge.protectionS…...

HTML前端开发:JavaScript 常用事件详解

作为前端开发的核心,JavaScript 事件是用户与网页交互的基础。以下是常见事件的详细说明和用法示例: 1. onclick - 点击事件 当元素被单击时触发(左键点击) button.onclick function() {alert("按钮被点击了!&…...

OpenPrompt 和直接对提示词的嵌入向量进行训练有什么区别

OpenPrompt 和直接对提示词的嵌入向量进行训练有什么区别 直接训练提示词嵌入向量的核心区别 您提到的代码: prompt_embedding = initial_embedding.clone().requires_grad_(True) optimizer = torch.optim.Adam([prompt_embedding...

SiFli 52把Imagie图片,Font字体资源放在指定位置,编译成指定img.bin和font.bin的问题

分区配置 (ptab.json) img 属性介绍: img 属性指定分区存放的 image 名称,指定的 image 名称必须是当前工程生成的 binary 。 如果 binary 有多个文件,则以 proj_name:binary_name 格式指定文件名, proj_name 为工程 名&…...

在QWebEngineView上实现鼠标、触摸等事件捕获的解决方案

这个问题我看其他博主也写了,要么要会员、要么写的乱七八糟。这里我整理一下,把问题说清楚并且给出代码,拿去用就行,照着葫芦画瓢。 问题 在继承QWebEngineView后,重写mousePressEvent或event函数无法捕获鼠标按下事…...

NXP S32K146 T-Box 携手 SD NAND(贴片式TF卡):驱动汽车智能革新的黄金组合

在汽车智能化的汹涌浪潮中,车辆不再仅仅是传统的交通工具,而是逐步演变为高度智能的移动终端。这一转变的核心支撑,来自于车内关键技术的深度融合与协同创新。车载远程信息处理盒(T-Box)方案:NXP S32K146 与…...

搭建DNS域名解析服务器(正向解析资源文件)

正向解析资源文件 1)准备工作 服务端及客户端都关闭安全软件 [rootlocalhost ~]# systemctl stop firewalld [rootlocalhost ~]# setenforce 0 2)服务端安装软件:bind 1.配置yum源 [rootlocalhost ~]# cat /etc/yum.repos.d/base.repo [Base…...

给网站添加live2d看板娘

给网站添加live2d看板娘 参考文献: stevenjoezhang/live2d-widget: 把萌萌哒的看板娘抱回家 (ノ≧∇≦)ノ | Live2D widget for web platformEikanya/Live2d-model: Live2d model collectionzenghongtu/live2d-model-assets 前言 网站环境如下,文章也主…...