kafka消费相关问题(GPT回答版本)

kafka消费相关问题(GPT回答版本)

在Java中,要避免重复消费Kafka消息,可以使用以下方法

1. 使用消费者组:

在设置Kafka消费者时,可以指定一个消费者组。一个消费者组中可以有多个消费者实例,每个实例只会消费到消息的其中一部分。当一条消息被某个消费者实例处理后,其他消费者实例就不会再消费到相同的消息。这种方式可以避免同一个消息被多个消费者重复处理。

2. 提交消费位移:

消费者在消费消息的同时,可以手动提交消费位移(offset)。消费位移表示消费者已经处理到的消息位置。通过手动提交位移,消费者可以在处理完一条消息后,立即提交位移,确保消息被成功消费。当消费者重启后,它可以根据上次提交的位移继续消费,从而避免重复消费。

3. 设置幂等性:

在订单系统中,幂等性是一个重要的概念。当同一个消息被重复消费时,保证系统行为的一致性非常重要。可以通过在订单系统中实现幂等性逻辑,来避免同一个订单被多次处理。例如,可以使用唯一订单号作为判定重复的依据,在处理订单前先检查订单号是否已经存在,如果存在则直接返回成功。

4. 使用分区键:

Kafka消息被分为多个分区,每个分区都有一个唯一的分区键。可以在生产者端设置合适的分区键,将相关的订单消息发送到同一个分区。这样,同一个订单的消息总是会被发送到同一个分区中,保证了消息的顺序性。消费者只需要消费特定的分区即可,避免重复消费。

通过以上方法,可以有效地避免重复消费Kafka消息,确保订单系统的消息处理准确性和可靠性。

对应的demo

1. 使用消费者组:

import org.apache.kafka.clients.consumer.*;

import java.util.*;public class KafkaConsumerDemo {private static final String TOPIC = "order_topic";private static final String GROUP_ID = "order_consumer_group";public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "localhost:9092");props.put("group.id", GROUP_ID);props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);consumer.subscribe(Collections.singletonList(TOPIC));while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord<String, String> record : records) {// 处理接收到的消息System.out.println("Received message: " + record.value());}}}

}

2. 提交消费位移:

import org.apache.kafka.clients.consumer.*;

import java.util.*;public class KafkaConsumerDemo {private static final String TOPIC = "order_topic";public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "localhost:9092");props.put("group.id", "order_consumer_group");props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);consumer.subscribe(Collections.singletonList(TOPIC));while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord<String, String> record : records) {// 处理接收到的消息System.out.println("Received message: " + record.value());// 手动提交位移consumer.commitSync();}}}

}

3. 设置幂等性:

import org.apache.kafka.clients.consumer.*;

import java.util.*;public class KafkaConsumerDemo {private static final String TOPIC = "order_topic";public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "localhost:9092");props.put("group.id", "order_consumer_group");props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);consumer.subscribe(Collections.singletonList(TOPIC));Set<String> processedOrders = new HashSet<>(); // 用于存储已经处理的订单号while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord<String, String> record : records) {// 处理接收到的消息String order = record.value();if (!processedOrders.contains(order)) {System.out.println("Processing order: " + order);// 在此处实现订单处理逻辑processedOrders.add(order); // 将已处理的订单号添加到集合中}}}}

}

4. 使用分区键:

import org.apache.kafka.clients.consumer.*;

import java.util.*;public class KafkaConsumerDemo {private static final String TOPIC = "order_topic";public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "localhost:9092");props.put("group.id", "order_consumer_group");props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);consumer.assign(Arrays.asList(new TopicPartition(TOPIC, 0))); // 消费指定分区while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord<String, String> record : records) {// 处理接收到的消息System.out.println("Received message from partition " + record.partition() + ": " + record.value());}}}

}

这些示例代码展示了如何在Java中使用Kafka来处理订单系统中的消息,并防止重复消费。

在订单系统中,为了避免重复消费 Kafka 消息并保持幂等性,通常需要在消费端做一些特殊的处理。以下是一个简单的 Java 示例,展示如何实现幂等性和避免重复消费:

假设订单系统中有一个主题(topic)叫做 “orders”,用于接收订单消息。在这个例子中,我们使用数据库来记录已经处理过的订单,并通过订单号来保持幂等性。

import org.apache.kafka.clients.consumer.Consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Collections;

import java.util.Properties;

import java.util.Set;

import java.util.concurrent.ConcurrentHashMap;public class OrderConsumer {// 模拟数据库,用于记录已处理的订单号private static Set<String> processedOrders = ConcurrentHashMap.newKeySet();public static void main(String[] args) {Properties props = new Properties();props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "your_kafka_bootstrap_servers");props.put(ConsumerConfig.GROUP_ID_CONFIG, "order-consumer-group");props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "false"); // 关闭自动提交props.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest");Consumer<String, String> consumer = new KafkaConsumer<>(props);consumer.subscribe(Collections.singletonList("orders"));try {while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));// 处理订单消息records.forEach(record -> {String orderId = record.key();String orderData = record.value();// 检查订单是否已经处理过if (!processedOrders.contains(orderId)) {// 在这里添加业务逻辑,处理订单消息// 记录已处理的订单号processedOrders.add(orderId);// 手动提交偏移量consumer.commitSync();} else {// 订单已处理过,可能是重复消息System.out.println("Order " + orderId + " has already been processed.");}});}} finally {consumer.close();}}

}

在这个示例中,processedOrders 是一个用于记录已处理订单号的集合。在处理每条消息之前,我们先检查订单是否已经在集合中,如果是,则认为这是一条重复消息,不再进行处理。否则,我们执行业务逻辑,并将订单号添加到已处理集合中。

请注意,这只是一个简单的示例,实际中可能需要更复杂的幂等性保证措施,具体要根据业务逻辑和系统架构来进行设计。

kafka重复发送消息

Kafka本身是一个分布式消息系统,而消息的重复发送通常是由于网络问题、生产者重试机制或者消费者处理失败引起的。以下是可能导致消息重复发送的一些情况以及相应的解决方法:

-

网络问题:

- 情况: 网络抖动、分区领导者切换等情况可能导致生产者在发送消息时出现网络错误。

- 解决方法: 在生产者端可以通过配置适当的重试机制,确保在网络问题得到解决后可以成功发送消息。此外,Kafka自身也有一些配置可以调整,例如

retries参数,控制生产者重试次数。

-

生产者确认机制问题:

- 情况: 如果生产者在发送消息后没有收到确认(acknowledgment),可能会触发重试机制,导致消息被重复发送。

- 解决方法: 配置生产者的

acks参数来调整确认机制。设置为"all"表示等待所有分区的确认,确保消息已经成功写入所有分区后才返回。

-

消费者处理失败:

- 情况: 消费者在处理消息时发生错误,可能触发消息重复消费。

- 解决方法: 在消费者端,可以通过记录已经处理过的消息的偏移量(offset)来避免重复消费。Kafka本身也提供了自动管理偏移量的功能,确保消息被消费后会更新偏移量。

-

Exactly-Once语义:

- 情况: Kafka提供的默认语义是至少一次(at-least-once)语义,这可能导致消息在发生重试时被重复发送。

- 解决方法: 如果确保消息不会被重复发送对你的应用非常关键,可以考虑使用Kafka事务或幂等性来实现Exactly-Once语义。这需要生产者和消费者的一些特殊配置和操作。

总体来说,确保Kafka集群的配置合理,生产者和消费者的配置符合业务需求,可以最大程度地避免消息重复发送和消费的问题。在设计时,也要考虑系统的幂等性,以最大程度地减少因重试而引起的问题。

下面我将为上述可能导致消息重复发送的情况分别提供一个简单的解决方案的示例:

1. 网络问题导致的消息重复发送:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;public class ProducerWithRetry {public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "your_kafka_bootstrap_servers");props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");props.put("acks", "all");props.put("retries", 3); // 设置重试次数Producer<String, String> producer = new KafkaProducer<>(props);try {// 发送消息ProducerRecord<String, String> record = new ProducerRecord<>("your_topic", "key", "value");producer.send(record);} catch (Exception e) {e.printStackTrace();// 处理发送失败的情况} finally {producer.close();}}

}

2. 生产者确认机制问题:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;public class ProducerWithAck {public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "your_kafka_bootstrap_servers");props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");props.put("acks", "all"); // 设置为"all"表示等待所有分区的确认Producer<String, String> producer = new KafkaProducer<>(props);try {// 发送消息ProducerRecord<String, String> record = new ProducerRecord<>("your_topic", "key", "value");producer.send(record);} catch (Exception e) {e.printStackTrace();// 处理发送失败的情况} finally {producer.close();}}

}

3. 消费者处理失败:

消费者的解决方案主要在于记录已经处理的消息的偏移量,并确保消费者的提交偏移量的操作在消息处理后执行。这部分通常需要在消费者的代码中实现。

4. Exactly-Once语义:

实现Exactly-Once语义通常需要涉及Kafka事务或幂等性的配置和操作,这可能会更为复杂。需要确保生产者和消费者的配置和代码逻辑符合Exactly-Once的要求。

相关文章:

)

kafka消费相关问题(GPT回答版本)

kafka消费相关问题(GPT回答版本) 在Java中,要避免重复消费Kafka消息,可以使用以下方法 1. 使用消费者组: 在设置Kafka消费者时,可以指定一个消费者组。一个消费者组中可以有多个消费者实例,每…...

【C++】string的基本使用二

我们接着上一篇的迭代器说起,迭代器不只有正向的,还有反向的,就是我们下边的这两个 它的迭代器类型也是不同的 rbegin就是末尾,rend就是开头,这样我们想遍历一个string对象的话就可以这样做 int main() {string s1(…...

MATLAB解决考研数学一题型(上)

闲来无事,情感问题和考研结束后的戒断反应比较严重,最近没有什么写博文的动力,抽空来整理一下考研初试前一直想做的工作——整理一下MATLAB解决数学一各题型的命令~ 本贴的目录遵循同济版的高数目录~ 目录 一.函数与极限 1.计算双侧极限 2…...

Vue以弹窗形式实现导入功能

目录 前言正文 前言 由于个人工作原因,偏全栈,对于前端的总结还有些初出茅庐,后续会进行规整化的总结 对应的前端框架由:【vue】avue-crud表单属性配置(表格以及列) 最终实现的表单样式如下:…...

分布式锁原理及实现

目录 一、锁的使用场景 二、如何实现控制? 三、单台服务器使用锁的场景 四、分布式锁 五、Redis 实现分布式锁及存在问题 六、Redisson 实现分布式锁 七、定时任务+锁 一、锁的使用场景 1. 控制定时任务执行 定时任务多次执行浪费资源ÿ…...

)

蓝桥杯官网填空题(海盗与金币)

题目描述 本题为填空题,只需要算出结果后,在代码中使用输出语句将所填结果输出即可。 12名海盗在一个小岛上发现了大量的金币,后统计一共有将近5万枚。 登上小岛是在夜里,天气又不好。由于各种原因,有的海盗偷拿了很…...

JavaScript 中JSON 字符串和对象之间的转换。

JSON.stringify() 方法(对象转换为 JSON 字符串) 用于将 JavaScript 对象转换为 JSON 字符串。 它接受一个 JavaScript 对象作为参数,并返回对应的 JSON 字符串表示。例如: const obj { name: John, age: 25 }; const jsonStr…...

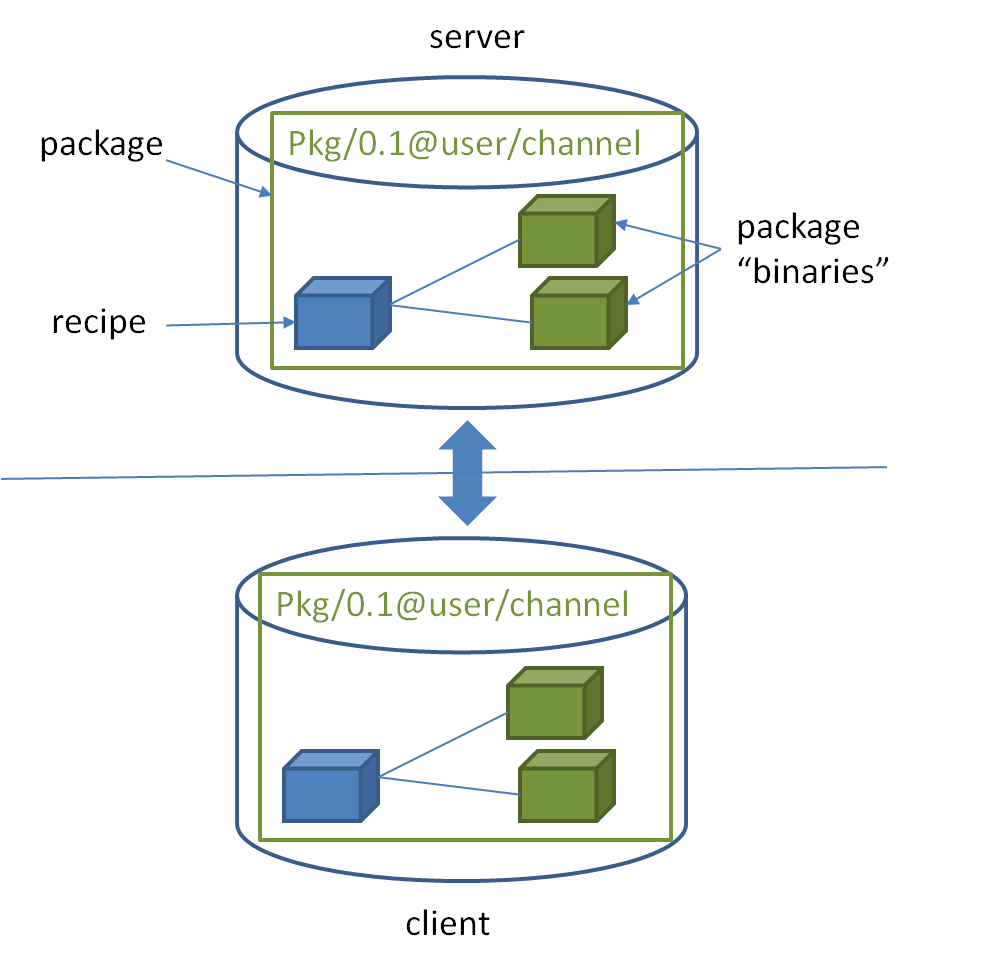

All the stories begin at installation

Before installation, there are some key points about Conan: “Conan is a dependency and package manager for C and C languages.”“With full binary management, Conan can create and reuse any number of different binaries (for different configurations like a…...

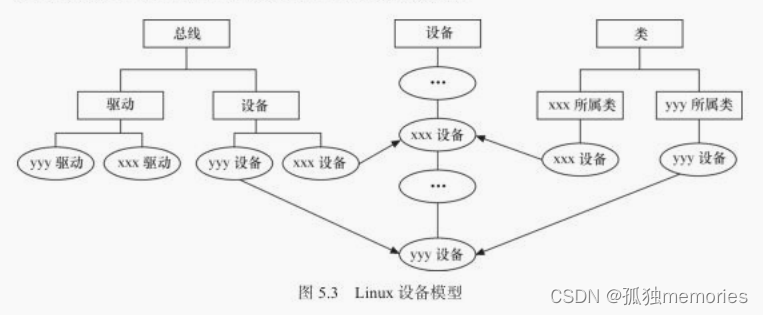

Linux文件系统与设备文件

Linux文件系统与设备文件 文章目录 Linux文件系统与设备文件Linux文件操作文件操作系统调用C库文件操作 Linux文件系统Linux文件系统目录结构Linux文件系统与设备驱动file结构体inode结构体file结构体和inode结构体的区别 devfsudev用户空间设备管理sysfs文件系统与Linux设备模…...

QT的绘图系统QPainterDevice与文件系统QIODevice

QT的绘图系统(QPainterDevice)与文件系统(QIODevice) 文章目录 1、Qt 的绘图系统1、QPainter的使用2、QPen(画笔)及QBursh(画刷)3、手动更新窗口4、绘图设备1、四种绘图设备的 区别2、 QBitmap3…...

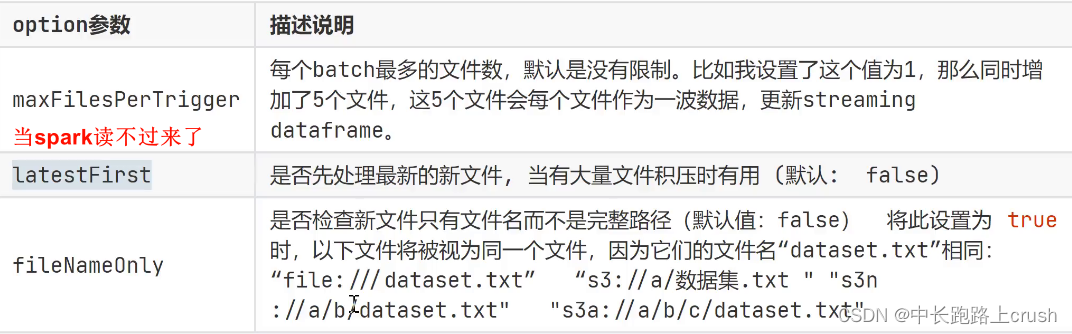

Spark流式读取文件数据

流式读取文件数据 from pyspark.sql import SparkSession ss SparkSession.builder.getOrCreate() # todo 注意1:流式读取目录下的文件 --》一定一定要是目录,不是具体的文件,# 目录下产生新文件会进行读取# todo 注意点2࿱…...

Leetcode 3011. Find if Array Can Be Sorted

Leetcode 3011. Find if Array Can Be Sorted 1. 解题思路2. 代码实现 题目链接:3011. Find if Array Can Be Sorted 1. 解题思路 这一题挺简单的,就是一个分组进行排序考察,我们将相邻且bit set相同的元素划归到同一组,然后进…...

Databend 开源周报第 129 期

Databend 是一款现代云数仓。专为弹性和高效设计,为您的大规模分析需求保驾护航。自由且开源。即刻体验云服务:https://app.databend.cn 。 Whats On In Databend 探索 Databend 本周新进展,遇到更贴近你心意的 Databend 。 支持标准流 标…...

python 正则表达式学习(1)

正则表达式是一个特殊的字符序列,它能帮助你方便的检查一个字符串是否与某种模式匹配。 1. 特殊符号 1.1 符号含义 模式描述^匹配字符串的开头$匹配字符串的末尾.匹配任意字符,除了换行符,当re.DOTALL标记被指定时,则可以匹配包…...

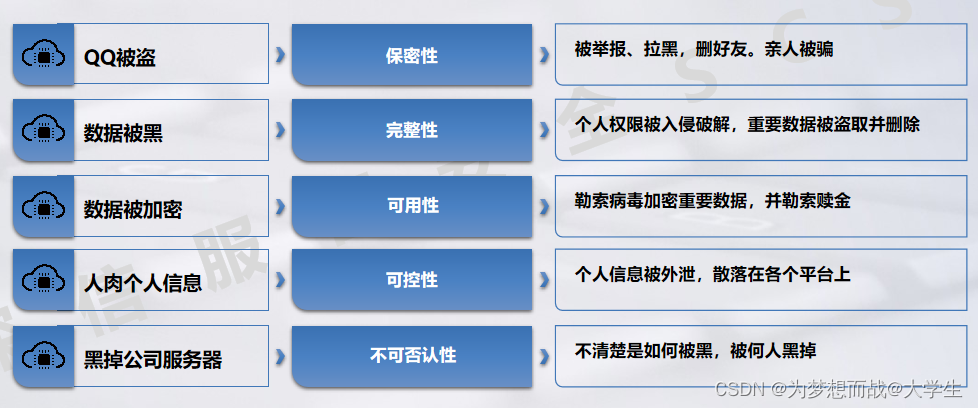

安全防御-基础认知

目录 安全风险能见度不足: 常见的网络安全术语 : 常见安全风险 网络的基本攻击模式: 病毒分类: 病毒的特征: 常见病毒: 信息安全的五要素: 信息安全的五要素案例 网络空间:…...

各省税收收入、个人和企业所得税数据,Shp、excel格式,2000-2021年

基本信息. 数据名称: 各省税收收入、个人和企业所得税数据 数据格式: Shp、excel 数据时间: 2000-2021年 数据几何类型: 面 数据坐标系: WGS84 数据来源:网络公开数据 数据字段: 序号字段名称字段说明1sssr_2021税收收入(亿元&am…...

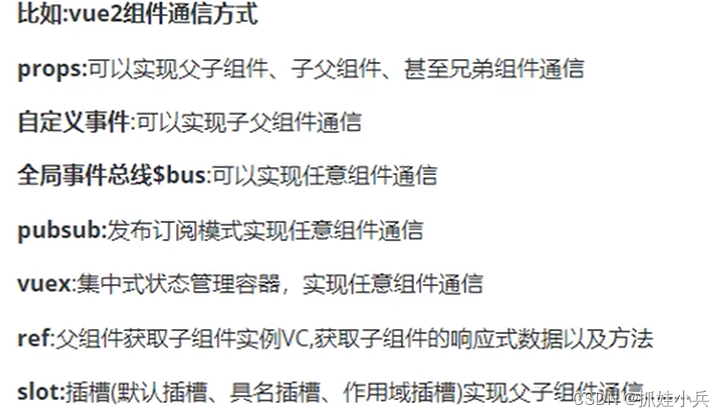

Vue记录

vue2、vue3记录,参考地址:尚硅谷Vue项目实战硅谷甄选,vue3项目TypeScript前端项目一套通关_哔哩哔哩_bilibili vue2记录 经典vue2结构 index.vue: <template><div>...</div> </template><script>…...

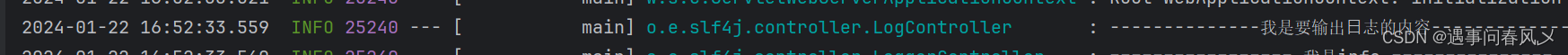

【JavaEE进阶】 Spring Boot⽇志

文章目录 🎋关于日志🚩为什么要学习⽇志🚩⽇志的⽤途🚩日志的简单使用 🎄打印⽇志🚩程序中得到⽇志对象🚩使⽤⽇志对象打印⽇志 🎍⽇志格式的说明🚩⽇志级别的作用&#…...

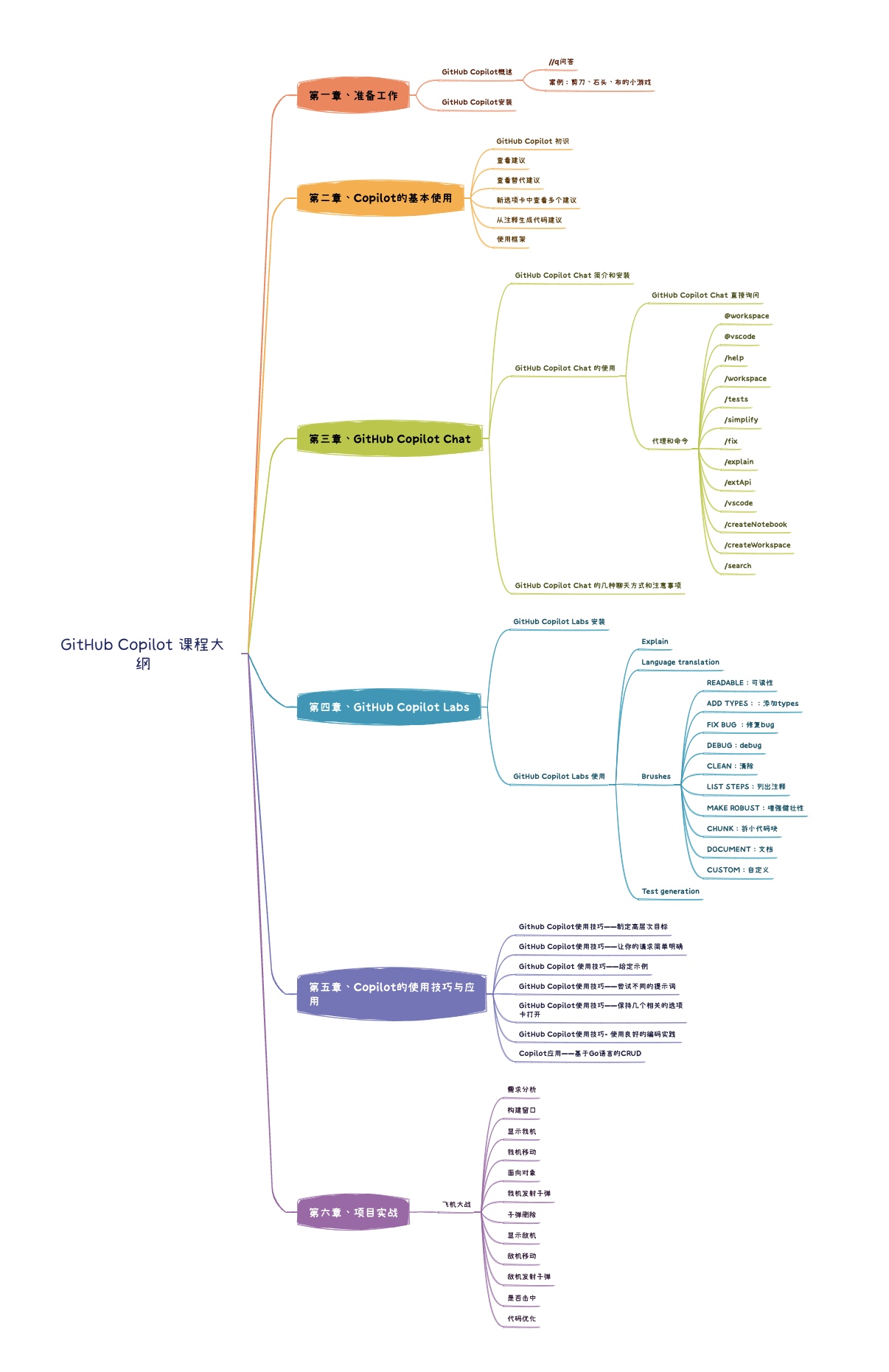

《GitHub Copilot 操作指南》课程介绍

第1节:GitHub Copilot 概述 一、什么是 GitHub Copilot 什么是 GitHub Copilot GitHub Copilot是GitHub与OpenAI合作开发的编程助手工具,利用机器学习模型生成代码建议。它集成在开发者的集成开发环境(IDE)中,可以根…...

)

结构体(C语言)

结构体 1.结构体基础知识: //结构是一些值的集合,这些值称为成员变量. // 结构的每个成员可以是不同类型的变量. 2.结构的定义 struct peo { char name[10];//姓名 char tele[12];//电话 char gender[5];//性别 int high;//身高 }; struct stu { struct…...

Xshell远程连接Kali(默认 | 私钥)Note版

前言:xshell远程连接,私钥连接和常规默认连接 任务一 开启ssh服务 service ssh status //查看ssh服务状态 service ssh start //开启ssh服务 update-rc.d ssh enable //开启自启动ssh服务 任务二 修改配置文件 vi /etc/ssh/ssh_config //第一…...

Appium+python自动化(十六)- ADB命令

简介 Android 调试桥(adb)是多种用途的工具,该工具可以帮助你你管理设备或模拟器 的状态。 adb ( Android Debug Bridge)是一个通用命令行工具,其允许您与模拟器实例或连接的 Android 设备进行通信。它可为各种设备操作提供便利,如安装和调试…...

定时器任务——若依源码分析

分析util包下面的工具类schedule utils: ScheduleUtils 是若依中用于与 Quartz 框架交互的工具类,封装了定时任务的 创建、更新、暂停、删除等核心逻辑。 createScheduleJob createScheduleJob 用于将任务注册到 Quartz,先构建任务的 JobD…...

VTK如何让部分单位不可见

最近遇到一个需求,需要让一个vtkDataSet中的部分单元不可见,查阅了一些资料大概有以下几种方式 1.通过颜色映射表来进行,是最正规的做法 vtkNew<vtkLookupTable> lut; //值为0不显示,主要是最后一个参数,透明度…...

NFT模式:数字资产确权与链游经济系统构建

NFT模式:数字资产确权与链游经济系统构建 ——从技术架构到可持续生态的范式革命 一、确权技术革新:构建可信数字资产基石 1. 区块链底层架构的进化 跨链互操作协议:基于LayerZero协议实现以太坊、Solana等公链资产互通,通过零知…...

安宝特方案丨船舶智造的“AR+AI+作业标准化管理解决方案”(装配)

船舶制造装配管理现状:装配工作依赖人工经验,装配工人凭借长期实践积累的操作技巧完成零部件组装。企业通常制定了装配作业指导书,但在实际执行中,工人对指导书的理解和遵循程度参差不齐。 船舶装配过程中的挑战与需求 挑战 (1…...

Copilot for Xcode (iOS的 AI辅助编程)

Copilot for Xcode 简介Copilot下载与安装 体验环境要求下载最新的安装包安装登录系统权限设置 AI辅助编程生成注释代码补全简单需求代码生成辅助编程行间代码生成注释联想 代码生成 总结 简介 尝试使用了Copilot,它能根据上下文补全代码,快速生成常用…...

GC1808:高性能音频ADC的卓越之选

在音频处理领域,高质量的音频模数转换器(ADC)是实现精准音频数字化的关键。GC1808,一款96kHz、24bit立体声音频ADC,以其卓越的性能和高性价比脱颖而出,成为众多音频设备制造商的理想选择。 GC1808集成了64倍…...

[KCTF]CORE CrackMe v2.0

这个Reverse比较古老,已经有20多年了,但难度确实不小。 先查壳 upx压缩壳,0.72,废弃版本,工具无法解压。 反正不用IDA进行调试,直接x32dbg中,dump内存,保存后拖入IDA。 这里说一下…...

链结构与工作量证明7️⃣:用 Go 实现比特币的核心机制

链结构与工作量证明:用 Go 实现比特币的核心机制 如果你用 Go 写过区块、算过哈希,也大致理解了非对称加密、数据序列化这些“硬核知识”,那么恭喜你,现在我们终于可以把这些拼成一条完整的“区块链”。 不过别急,这一节我们重点搞懂两件事: 区块之间是怎么连接成“链”…...