ClickHouse(22)ClickHouse集成HDFS表引擎详细解析

文章目录

- HDFS

- 用法

- 实施细节

- 配置

- 可选配置选项及其默认值的列表

- libhdfs3 支持的

- ClickHouse 额外的配置

- 限制

- Kerberos 支持

- 虚拟列

- 资料分享

- 系列文章

- clickhouse系列文章

- 知乎系列文章

HDFS

这个引擎提供了与Apache Hadoop生态系统的集成,允许通过ClickHouse管理HDFS上的数据。这个引擎提供了Hadoop的特定功能。

用法

ENGINE = HDFS(URI, format)

URI 参数是HDFS中整个文件的URI

format 参数指定一种可用的文件格式。执行SELECT查询时,格式必须支持输入,以及执行INSERT查询时,格式必须支持输出.路径部分URI可能包glob通配符。在这种情况下,表将是只读的。

clickhouse支持的format,文件格式:

| 格式 | 输入 | 输出 |

|---|---|---|

| [TabSeparated] | ✔ | ✔ |

| [TabSeparatedRaw] | ✔ | ✔ |

| [TabSeparatedWithNames] | ✔ | ✔ |

| [TabSeparatedWithNamesAndTypes] | ✔ | ✔ |

| [Template] | ✔ | ✔ |

| [TemplateIgnoreSpaces] | ✔ | ✗ |

| [CSV] | ✔ | ✔ |

| [CSVWithNames] | ✔ | ✔ |

| [CustomSeparated] | ✔ | ✔ |

| [Values] | ✔ | ✔ |

| [Vertical] | ✗ | ✔ |

| [JSON] | ✗ | ✔ |

| [JSONAsString] | ✔ | ✗ |

| [JSONStrings] | ✗ | ✔ |

| [JSONCompact] | ✗ | ✔ |

| [JSONCompactStrings] | ✗ | ✔ |

| [JSONEachRow] | ✔ | ✔ |

| [JSONEachRowWithProgress] | ✗ | ✔ |

| [JSONStringsEachRow] | ✔ | ✔ |

| [JSONStringsEachRowWithProgress] | ✗ | ✔ |

| [JSONCompactEachRow] | ✔ | ✔ |

| [JSONCompactEachRowWithNamesAndTypes] | ✔ | ✔ |

| [JSONCompactStringsEachRow] | ✔ | ✔ |

| [JSONCompactStringsEachRowWithNamesAndTypes] | ✔ | ✔ |

| [TSKV] | ✔ | ✔ |

| [Pretty] | ✗ | ✔ |

| [PrettyCompact] | ✗ | ✔ |

| [PrettyCompactMonoBlock] | ✗ | ✔ |

| [PrettyNoEscapes] | ✗ | ✔ |

| [PrettySpace] | ✗ | ✔ |

| [Protobuf] | ✔ | ✔ |

| [ProtobufSingle] | ✔ | ✔ |

| [Avro] | ✔ | ✔ |

| [AvroConfluent] | ✔ | ✗ |

| [Parquet] | ✔ | ✔ |

| [Arrow] | ✔ | ✔ |

| [ArrowStream] | ✔ | ✔ |

| [ORC] | ✔ | ✔ |

| [RowBinary] | ✔ | ✔ |

| [RowBinaryWithNamesAndTypes] | ✔ | ✔ |

| [Native] | ✔ | ✔ |

| [Null] | ✗ | ✔ |

| [XML] | ✗ | ✔ |

| [CapnProto] | ✔ | ✗ |

| [LineAsString] | ✔ | ✗ |

| [Regexp] | ✔ | ✗ |

| [RawBLOB] | ✔ | ✔ |

示例:

1. 设置 hdfs_engine_table 表:

CREATE TABLE hdfs_engine_table (name String, value UInt32) ENGINE=HDFS('hdfs://hdfs1:9000/other_storage', 'TSV')

2. 填充文件:

INSERT INTO hdfs_engine_table VALUES ('one', 1), ('two', 2), ('three', 3)

3. 查询数据:

SELECT * FROM hdfs_engine_table LIMIT 2

┌─name─┬─value─┐

│ one │ 1 │

│ two │ 2 │

└──────┴───────┘

实施细节

- 读取和写入可以并行

- 不支持:

ALTER和SELECT...SAMPLE操作。- 索引。

- 复制。

路径中的通配符

多个路径组件可以具有 globs。 对于正在处理的文件应该存在并匹配到整个路径模式。 文件列表的确定是在 SELECT 的时候进行(而不是在 CREATE 的时候)。

*— 替代任何数量的任何字符,除了/以及空字符串。?— 代替任何单个字符.{some_string,another_string,yet_another_one}— 替代任何字符串'some_string', 'another_string', 'yet_another_one'.{N..M}— 替换 N 到 M 范围内的任何数字,包括两个边界的值.

示例

- 假设我们在 HDFS 上有几个 TSV 格式的文件,文件的 URI 如下:

- ‘hdfs://hdfs1:9000/some_dir/some_file_1’

- ‘hdfs://hdfs1:9000/some_dir/some_file_2’

- ‘hdfs://hdfs1:9000/some_dir/some_file_3’

- ‘hdfs://hdfs1:9000/another_dir/some_file_1’

- ‘hdfs://hdfs1:9000/another_dir/some_file_2’

- ‘hdfs://hdfs1:9000/another_dir/some_file_3’

- 有几种方法可以创建由所有六个文件组成的表:

CREATE TABLE table_with_range (name String, value UInt32) ENGINE = HDFS('hdfs://hdfs1:9000/{some,another}_dir/some_file_{1..3}', 'TSV')

另一种方式:

CREATE TABLE table_with_question_mark (name String, value UInt32) ENGINE = HDFS('hdfs://hdfs1:9000/{some,another}_dir/some_file_?', 'TSV')

表由两个目录中的所有文件组成(所有文件都应满足query中描述的格式和模式):

CREATE TABLE table_with_asterisk (name String, value UInt32) ENGINE = HDFS('hdfs://hdfs1:9000/{some,another}_dir/*', 'TSV')

注意:

如果文件列表包含带有前导零的数字范围,请单独使用带有大括号的构造或使用 `?`.

示例

创建具有名为文件的表 file000, file001, … , file999:

CREARE TABLE big_table (name String, value UInt32) ENGINE = HDFS('hdfs://hdfs1:9000/big_dir/file{0..9}{0..9}{0..9}', 'CSV')

配置

与 GraphiteMergeTree 类似,HDFS 引擎支持使用 ClickHouse 配置文件进行扩展配置。有两个配置键可以使用:全局 (hdfs) 和用户级别 (hdfs_*)。首先全局配置生效,然后用户级别配置生效 (如果用户级别配置存在) 。

<!-- HDFS 引擎类型的全局配置选项 --><hdfs><hadoop_kerberos_keytab>/tmp/keytab/clickhouse.keytab</hadoop_kerberos_keytab><hadoop_kerberos_principal>clickuser@TEST.CLICKHOUSE.TECH</hadoop_kerberos_principal><hadoop_security_authentication>kerberos</hadoop_security_authentication></hdfs><!-- 用户 "root" 的指定配置 --><hdfs_root><hadoop_kerberos_principal>root@TEST.CLICKHOUSE.TECH</hadoop_kerberos_principal></hdfs_root>

可选配置选项及其默认值的列表

libhdfs3 支持的

| 参数 | 默认值 |

| rpc_client_connect_tcpnodelay | true |

| dfs_client_read_shortcircuit | true |

| output_replace-datanode-on-failure | true |

| input_notretry-another-node | false |

| input_localread_mappedfile | true |

| dfs_client_use_legacy_blockreader_local | false |

| rpc_client_ping_interval | 10 * 1000 |

| rpc_client_connect_timeout | 600 * 1000 |

| rpc_client_read_timeout | 3600 * 1000 |

| rpc_client_write_timeout | 3600 * 1000 |

| rpc_client_socekt_linger_timeout | -1 |

| rpc_client_connect_retry | 10 |

| rpc_client_timeout | 3600 * 1000 |

| dfs_default_replica | 3 |

| input_connect_timeout | 600 * 1000 |

| input_read_timeout | 3600 * 1000 |

| input_write_timeout | 3600 * 1000 |

| input_localread_default_buffersize | 1 * 1024 * 1024 |

| dfs_prefetchsize | 10 |

| input_read_getblockinfo_retry | 3 |

| input_localread_blockinfo_cachesize | 1000 |

| input_read_max_retry | 60 |

| output_default_chunksize | 512 |

| output_default_packetsize | 64 * 1024 |

| output_default_write_retry | 10 |

| output_connect_timeout | 600 * 1000 |

| output_read_timeout | 3600 * 1000 |

| output_write_timeout | 3600 * 1000 |

| output_close_timeout | 3600 * 1000 |

| output_packetpool_size | 1024 |

| output_heeartbeat_interval | 10 * 1000 |

| dfs_client_failover_max_attempts | 15 |

| dfs_client_read_shortcircuit_streams_cache_size | 256 |

| dfs_client_socketcache_expiryMsec | 3000 |

| dfs_client_socketcache_capacity | 16 |

| dfs_default_blocksize | 64 * 1024 * 1024 |

| dfs_default_uri | “hdfs://localhost:9000” |

| hadoop_security_authentication | “simple” |

| hadoop_security_kerberos_ticket_cache_path | “” |

| dfs_client_log_severity | “INFO” |

| dfs_domain_socket_path | “” |

HDFS 配置参考 也许会解释一些参数的含义.

ClickHouse 额外的配置

| 参数 | 默认值 |

|hadoop_kerberos_keytab | “” |

|hadoop_kerberos_principal | “” |

|hadoop_kerberos_kinit_command | kinit |

限制

- hadoop_security_kerberos_ticket_cache_path 只能在全局配置, 不能指定用户

Kerberos 支持

如果 hadoop_security_authentication 参数的值为 ‘kerberos’ ,ClickHouse 将通过 Kerberos 设施进行认证。

注意,由于 libhdfs3 的限制,只支持老式的方法。数据节点的安全通信无法由SASL保证 ( HADOOP_SECURE_DN_USER 是这种安全方法的一个可靠指标)。

如果指定了hadoop_kerberos_keytab, hadoop_kerberos_principal或者hadoop_kerberos_kinit_command,将会调用kinit工具.在此情况下,hadoop_kerberos_keytab和hadoop_kerberos_principal参数是必须配置的.kinit工具和 krb5 配置文件是必要的.

虚拟列

_path— 文件路径._file— 文件名.

资料分享

ClickHouse经典中文文档分享

系列文章

clickhouse系列文章

- ClickHouse(01)什么是ClickHouse,ClickHouse适用于什么场景

- ClickHouse(02)ClickHouse架构设计介绍概述与ClickHouse数据分片设计

- ClickHouse(03)ClickHouse怎么安装和部署

- ClickHouse(04)如何搭建ClickHouse集群

- ClickHouse(05)ClickHouse数据类型详解

- ClickHouse(06)ClickHouse建表语句DDL详细解析

- ClickHouse(07)ClickHouse数据库引擎解析

- ClickHouse(08)ClickHouse表引擎概况

- ClickHouse(09)ClickHouse合并树MergeTree家族表引擎之MergeTree详细解析

- ClickHouse(10)ClickHouse合并树MergeTree家族表引擎之ReplacingMergeTree详细解析

- ClickHouse(11)ClickHouse合并树MergeTree家族表引擎之SummingMergeTree详细解析

- ClickHouse(12)ClickHouse合并树MergeTree家族表引擎之AggregatingMergeTree详细解析

- ClickHouse(13)ClickHouse合并树MergeTree家族表引擎之CollapsingMergeTree详细解析

- ClickHouse(14)ClickHouse合并树MergeTree家族表引擎之VersionedCollapsingMergeTree详细解析

- ClickHouse(15)ClickHouse合并树MergeTree家族表引擎之GraphiteMergeTree详细解析

- ClickHouse(16)ClickHouse日志表引擎Log详细解析

- ClickHouse(17)ClickHouse集成JDBC表引擎详细解析

- ClickHouse(18)ClickHouse集成ODBC表引擎详细解析

- ClickHouse(19)ClickHouse集成Hive表引擎详细解析

- ClickHouse(20)ClickHouse集成PostgreSQL表引擎详细解析

- ClickHouse(21)ClickHouse集成Kafka表引擎详细解析

- ClickHouse(22)ClickHouse集成HDFS表引擎详细解析

知乎系列文章

- ClickHouse(01)什么是ClickHouse,ClickHouse适用于什么场景

- ClickHouse(02)ClickHouse架构设计介绍概述与ClickHouse数据分片设计

- ClickHouse(03)ClickHouse怎么安装和部署

- ClickHouse(04)如何搭建ClickHouse集群

- ClickHouse(05)ClickHouse数据类型详解

- ClickHouse(06)ClickHouse建表语句DDL详细解析

- ClickHouse(07)ClickHouse数据库引擎解析

- ClickHouse(08)ClickHouse表引擎概况

- ClickHouse(09)ClickHouse合并树MergeTree家族表引擎之MergeTree详细解析

- ClickHouse(10)ClickHouse合并树MergeTree家族表引擎之ReplacingMergeTree详细解析

- ClickHouse(11)ClickHouse合并树MergeTree家族表引擎之SummingMergeTree详细解析

- ClickHouse(12)ClickHouse合并树MergeTree家族表引擎之AggregatingMergeTree详细解析

- ClickHouse(13)ClickHouse合并树MergeTree家族表引擎之CollapsingMergeTree详细解析

- ClickHouse(14)ClickHouse合并树MergeTree家族表引擎之VersionedCollapsingMergeTree详细解析

- ClickHouse(15)ClickHouse合并树MergeTree家族表引擎之GraphiteMergeTree详细解析

- ClickHouse(16)ClickHouse日志引擎Log详细解析

- ClickHouse(17)ClickHouse集成JDBC表引擎详细解析

- ClickHouse(18)ClickHouse集成ODBC表引擎详细解析

- ClickHouse(19)ClickHouse集成Hive表引擎详细解析

- ClickHouse(21)ClickHouse集成Kafka表引擎详细解析

- ClickHouse(22)ClickHouse集成HDFS表引擎详细解析

相关文章:

ClickHouse集成HDFS表引擎详细解析)

ClickHouse(22)ClickHouse集成HDFS表引擎详细解析

文章目录 HDFS用法实施细节配置可选配置选项及其默认值的列表libhdfs3 支持的ClickHouse 额外的配置限制 Kerberos 支持虚拟列 资料分享系列文章clickhouse系列文章知乎系列文章 HDFS 这个引擎提供了与Apache Hadoop生态系统的集成,允许通过ClickHouse管理HDFS上的…...

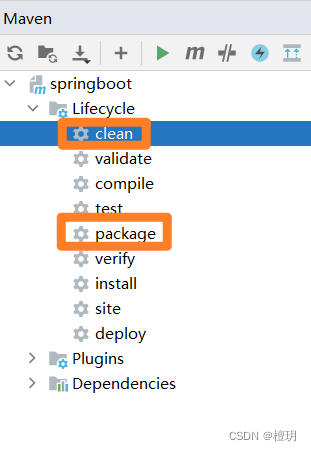

idea报错 :(java: 找不到符号)

java: 找不到符号 符号: 变量 adminService 位置: 类 com.example.controller.WebController 查到网上一个办法:因为项目是maven:先点clean在点package...

设计软件最重要的目标是可理解性?

当您设计一款软件时,设计时最重要的一点就是可理解性。安全性、性能和正确性都很重要,但它们次优于可理解性。 被误解的软件会产生Bug缺陷 如果软件的实施者和维护者对软件存在误解,那么软件最终就会出现缺陷。主要缺陷。这些缺陷有多种形式…...

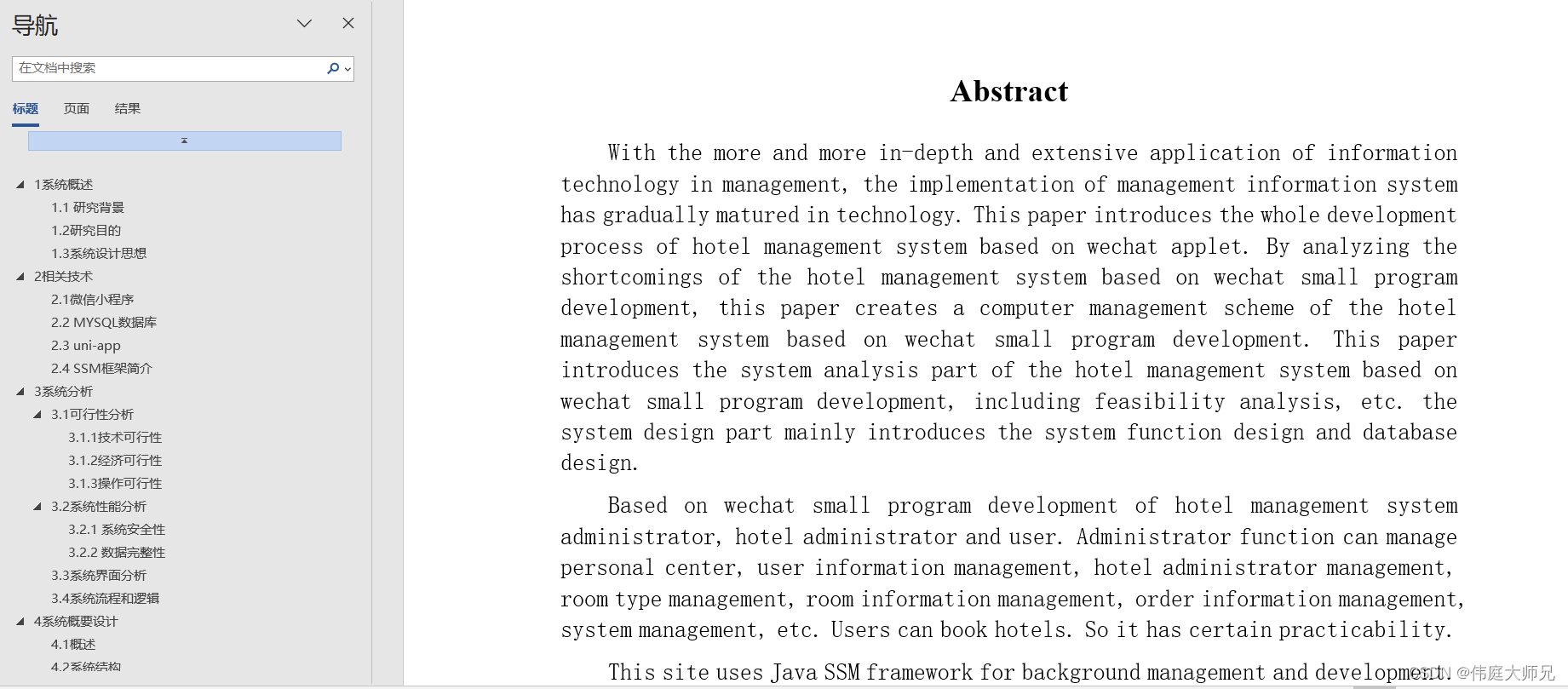

酒店|酒店管理小程序|基于微信小程序的酒店管理系统设计与实现(源码+数据库+文档)

酒店管理小程序目录 目录 基于微信小程序的酒店管理系统设计与实现 一、前言 二、系统功能设计 三、系统实现 1、管理员模块的实现 (1) 用户信息管理 (2) 酒店管理员管理 (3) 房间信息管理 2、小程序序会员模块的实现 (1)系统首页 ࿰…...

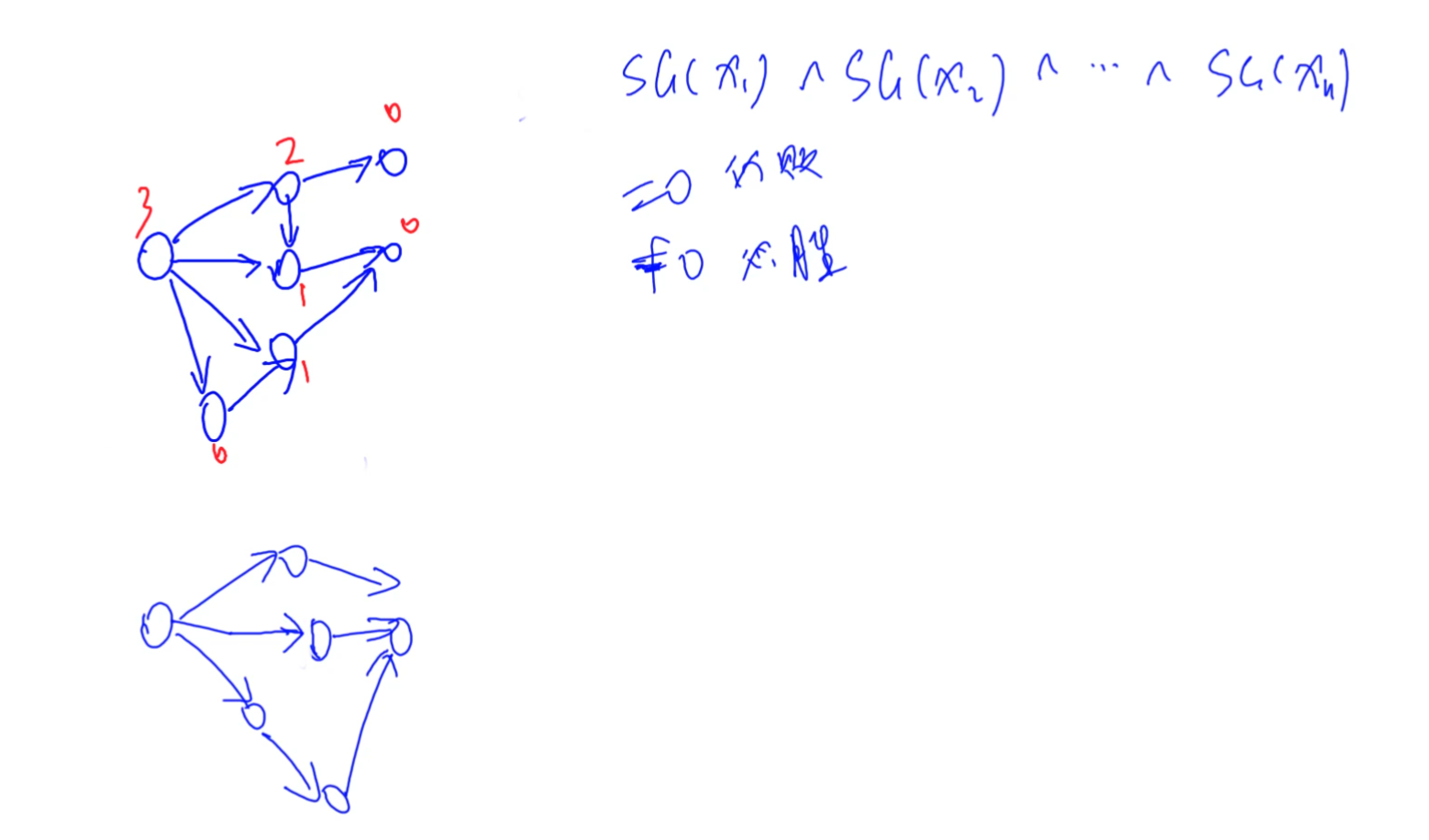

C++ 数论相关题目,博弈论,SG函数,集合-Nim游戏

给定 n 堆石子以及一个由 k 个不同正整数构成的数字集合 S 。 现在有两位玩家轮流操作,每次操作可以从任意一堆石子中拿取石子,每次拿取的石子数量必须包含于集合 S ,最后无法进行操作的人视为失败。 问如果两人都采用最优策略,…...

学者观察 | 区块链技术理论研究与实践观察——中央财经大学朱建明

导语 当下区块链研究成果质量越来越高,技术应用越来越成熟。在现阶段的研究中存在哪些短板需要弥补,如何将研究成果转化为推动数字经济高质量发展的实际应用,区块链技术与其他新技术结合发展将带来哪些新的机遇? 中央财经大学朱…...

使用Promethues+Grafana监控Elasticsearch

PromethuesGrafana监控Elasticsearch 监控选用说明指标上报流程说明实现监控的步骤搭建elasticsearch-exporter服务搭建promethues和grafana服务 监控选用说明 虽然用Kibana来监控ES,能展示一些关键指标,但ES本身收集的指标并不全面,还需要在…...

研学活动报名平台源码开发方案

一、项目背景与目标 (一)项目背景 研学活动报名平台旨在为活动组织者提供方便快捷的研学活动管理工具,同时为用户提供全面的活动搜索、报名和支付等功能。通过该系统,活动组织者能够更好地管理活动报名信息,用户也可…...

一篇文章,彻底理解数据库操作语言:DDL、DML、DCL、TCL

最近与开发和运维讨论数据库账号及赋权问题时,发现大家对DDL和DML两个概念并不了解。于是写一篇文章,系统的整理一下在数据库领域中的DDL、DML、DQL、DCL的使用及区别。 通常,数据库SQL语言共分为四大类:数据定义语言DDL…...

Linux编辑器之vim的使用

文章目录 一、vim简介二、vim的基本概念三、vim的基本操作四、vim正常模式命令集移动光标删除文字复制替换撤销上一次操作更改跳至指定的行vim末行模式命令集列出行号跳到文件中的某一行查找字符保存文件离开vim 五、进阶vim玩法打开文件批量注释代码执行shell命令指定注释窗口…...

制作OpenSSH 9.6 for openEuler 22.03 LTS的rpm升级包

OpenSSH作为操作系统底层管理平台软件,需要保持更新以免遭受安全攻击,编译生成rpm包是生产环境中批量升级的最佳途径。本文在国产openEuler 22.03 LTS系统上完成OpenSSH 9.6的编译工作。 一、编译环境 1、准备环境 基于vmware workstation发布的x86虚…...

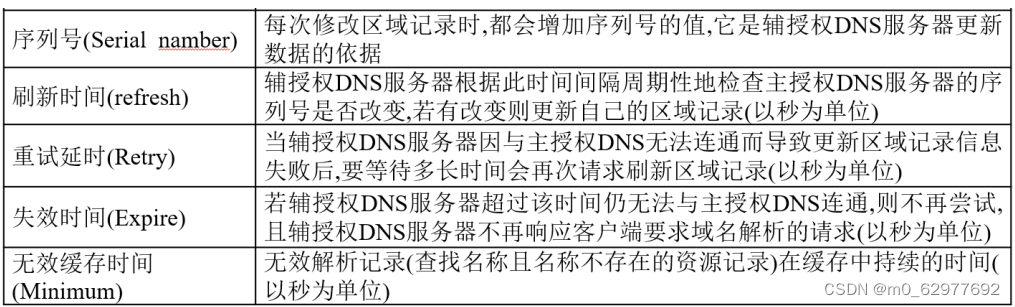

DNS配置文件讲解

1. 概述 BIND:Berkeley Internet Name Domain ,伯克利因特网域名解析服务是一种全球使用最广泛的、 最高效的、最安全的域名解析服务程序 2. 安装软件 [rootserver ~]# yum install bind -y 3. bind服务中三个关键文件 /etc/named.conf : 主配置文件…...

142:vue+leaflet 加载tomtom地图(多种形式)

第142个 点击查看专栏目录 本示例介绍如何在vue+leaflet中添加tomtom地图,这里包含了多种形式,诸如中文标记、英文标记、白天地图、晚上地图、卫星影像图,高山海拔地形图等。 直接复制下面的 vue+leaflet源代码,操作2分钟即可运行实现效果 文章目录 示例效果配置方式示例…...

Android Mac电脑更改aar中的文件再打包

一 问题 要在Mac电脑上替换AAR中的文件并重新打包。 二 解决方案 1.解压AAR文件 将AAR文件重命名为.zip,并解压缩它,得到一个文件夹。 2.替换文件 在解压后的文件夹中找到您想替换的文件,将其替换为新文件。 3.重新打包 打开终端&…...

Jmeter脚本录制:抓取IOS手机请求包!

现在移动端的项目越来越多,今天给大家介绍一下,在IOS下Jmeter如何抓包。 1、电脑连上wifi; 2、Jmeter中配置“HTTP代理服务器” 1)启动Jmeter; 2)“测试计划”中添加“线程组”; 3)“测试计划”中添加“HTTP代理服务器”&#…...

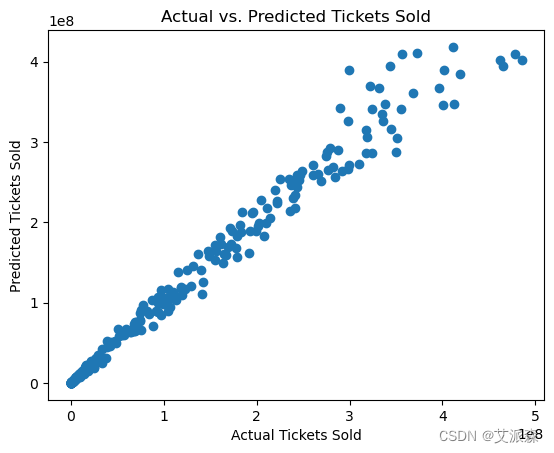

大数据分析案例-基于随机森林算法构建电影票房预测模型

🤵♂️ 个人主页:艾派森的个人主页 ✍🏻作者简介:Python学习者 🐋 希望大家多多支持,我们一起进步!😄 如果文章对你有帮助的话, 欢迎评论 💬点赞Ǵ…...

关于Gitlab用户登录提示无限重定向循环ERR_TOO_MANY_REDIRECTS

#工作笔记# 查阅了网上所有相关的记录,都没有解决gitlab登录/users/sign_up/welcome提示ERR_TOO_MANY_REDIRECTS,好在最终解决了,记录在此。 先说下起因: github哼哼不想用了,原因太多,所以内部讨论用git…...

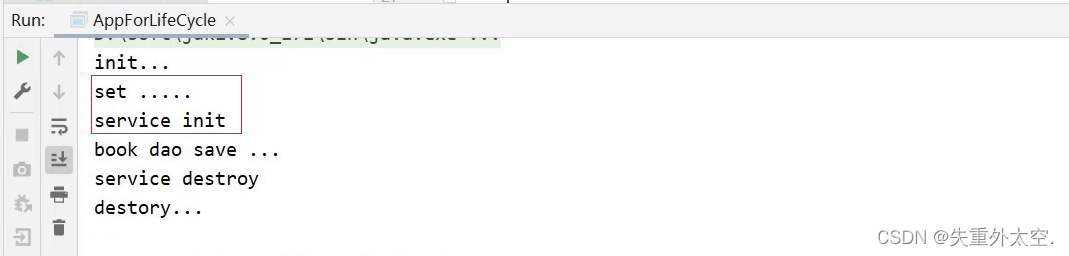

突破瓶颈,提升开发效率:Spring框架进阶与最佳实践-IOC

IOC相关内容 1.1 bean基础配置1.1.1 bean基础配置(id与class)1.1.2 bean的name属性步骤1:配置别名步骤2:根据名称容器中获取bean对象步骤3:运行程序 1.1.3 bean作用范围scope配置1.1.3.1 验证IOC容器中对象是否为单例验证思路具体实现 1.1.3.2 配置bean为非单例1.1.…...

西方网络安全人才培养的挑战及对策

文章目录 前言一、网络安全人才力量发展现状(一)注重从战略上重视网络安全人才培养和发展。(二)注重从多渠道多路径招募网络安全人才。(三)注重分层次分阶段系统规划网络安全人才培养模式。(四)注重通过实践锻炼进一步提升网络攻防实战能力。二、网络安全人才面临的形势…...

计算机网络之三次握手,四次挥手

TCP(传输控制协议)是一种面向连接的、可靠的传输层协议,用于在网络中的两个应用程序之间建立可靠的通信连接。TCP的核心特征之一是它使用“三次握手”过程来建立连接,以及“四次挥手”过程来终止连接。 三次握手(建立…...

多云管理“拦路虎”:深入解析网络互联、身份同步与成本可视化的技术复杂度

一、引言:多云环境的技术复杂性本质 企业采用多云策略已从技术选型升维至生存刚需。当业务系统分散部署在多个云平台时,基础设施的技术债呈现指数级积累。网络连接、身份认证、成本管理这三大核心挑战相互嵌套:跨云网络构建数据…...

设计模式和设计原则回顾

设计模式和设计原则回顾 23种设计模式是设计原则的完美体现,设计原则设计原则是设计模式的理论基石, 设计模式 在经典的设计模式分类中(如《设计模式:可复用面向对象软件的基础》一书中),总共有23种设计模式,分为三大类: 一、创建型模式(5种) 1. 单例模式(Sing…...

在HarmonyOS ArkTS ArkUI-X 5.0及以上版本中,手势开发全攻略:

在 HarmonyOS 应用开发中,手势交互是连接用户与设备的核心纽带。ArkTS 框架提供了丰富的手势处理能力,既支持点击、长按、拖拽等基础单一手势的精细控制,也能通过多种绑定策略解决父子组件的手势竞争问题。本文将结合官方开发文档,…...

大模型多显卡多服务器并行计算方法与实践指南

一、分布式训练概述 大规模语言模型的训练通常需要分布式计算技术,以解决单机资源不足的问题。分布式训练主要分为两种模式: 数据并行:将数据分片到不同设备,每个设备拥有完整的模型副本 模型并行:将模型分割到不同设备,每个设备处理部分模型计算 现代大模型训练通常结合…...

【学习笔记】深入理解Java虚拟机学习笔记——第4章 虚拟机性能监控,故障处理工具

第2章 虚拟机性能监控,故障处理工具 4.1 概述 略 4.2 基础故障处理工具 4.2.1 jps:虚拟机进程状况工具 命令:jps [options] [hostid] 功能:本地虚拟机进程显示进程ID(与ps相同),可同时显示主类&#x…...

关键领域软件测试的突围之路:如何破解安全与效率的平衡难题

在数字化浪潮席卷全球的今天,软件系统已成为国家关键领域的核心战斗力。不同于普通商业软件,这些承载着国家安全使命的软件系统面临着前所未有的质量挑战——如何在确保绝对安全的前提下,实现高效测试与快速迭代?这一命题正考验着…...

Mysql8 忘记密码重置,以及问题解决

1.使用免密登录 找到配置MySQL文件,我的文件路径是/etc/mysql/my.cnf,有的人的是/etc/mysql/mysql.cnf 在里最后加入 skip-grant-tables重启MySQL服务 service mysql restartShutting down MySQL… SUCCESS! Starting MySQL… SUCCESS! 重启成功 2.登…...

Redis:现代应用开发的高效内存数据存储利器

一、Redis的起源与发展 Redis最初由意大利程序员Salvatore Sanfilippo在2009年开发,其初衷是为了满足他自己的一个项目需求,即需要一个高性能的键值存储系统来解决传统数据库在高并发场景下的性能瓶颈。随着项目的开源,Redis凭借其简单易用、…...

API网关Kong的鉴权与限流:高并发场景下的核心实践

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 引言 在微服务架构中,API网关承担着流量调度、安全防护和协议转换的核心职责。作为云原生时代的代表性网关,Kong凭借其插件化架构…...

多元隐函数 偏导公式

我们来推导隐函数 z z ( x , y ) z z(x, y) zz(x,y) 的偏导公式,给定一个隐函数关系: F ( x , y , z ( x , y ) ) 0 F(x, y, z(x, y)) 0 F(x,y,z(x,y))0 🧠 目标: 求 ∂ z ∂ x \frac{\partial z}{\partial x} ∂x∂z、 …...