《Python 网络爬虫简易速速上手小册》第1章:Python 网络爬虫基础(2024 最新版)

文章目录

- 1.1 网络爬虫简介

- 1.1.1 重点基础知识讲解

- 1.1.2 重点案例:社交媒体数据分析

- 1.1.3 拓展案例1:电商网站价格监控

- 1.1.4 拓展案例2:新闻聚合服务

- 1.2 网络爬虫的工作原理

- 1.2.1 重点基础知识讲解

- 1.2.2 重点案例:股票市场数据采集

- 1.2.3 拓展案例 1:博客文章抓取

- 1.2.4 拓展案例 2:酒店价格监控

- 1.3 网络爬虫的法律与道德考量

- 1.3.1 重点基础知识讲解

- 1.3.2 重点案例:社交媒体数据抓取

- 1.3.3 拓展案例 1:网站内容聚合

- 1.3.4 拓展案例 2:在线商店价格监控

1.1 网络爬虫简介

1.1.1 重点基础知识讲解

网络爬虫,也称为网页蜘蛛或网页机器人,是一种自动化的网络程序,设计用来从万维网上下载网页,提取出有用的信息或者资源。想要精通网络爬虫,首先得了解几个基础概念:

- HTML & CSS: 网页的骨架和皮肤。HTML 定义了网页的结构,而 CSS 则负责外观。掌握它们,你才能让爬虫知道去哪儿找数据。

- JavaScript: 许多现代网站利用 JavaScript 动态加载内容。了解基础的 JavaScript 及其如何影响网页内容的加载,对爬取动态内容至关重要。

- HTTP/HTTPS 协议: 这是爬虫与网站交流的语言。理解请求(Request)和响应(Response)的基本原理,能帮你更好地设计爬虫。

- APIs: 许多网站提供 APIs 来让开发者合法地访问数据。利用 APIs 能够是一个更高效、更稳定的数据抓取方式。

接下来,让我们通过几个案例,深入探索网络爬虫在实际生产中的应用。

1.1.2 重点案例:社交媒体数据分析

假设你是一个数据分析师,需要从 Twitter 抓取关于特定话题的推文,进行情感分析。使用 Python 的 Tweepy 库,可以方便地接入Twitter API,抓取数据。这个案例不仅实用,而且非常贴近现实生产,社交媒体数据分析在市场研究、公共舆论监控等领域有广泛应用。

import tweepy# 初始化API

auth = tweepy.OAuthHandler('YOUR_CONSUMER_KEY', 'YOUR_CONSUMER_SECRET')

auth.set_access_token('YOUR_ACCESS_TOKEN', 'YOUR_ACCESS_TOKEN_SECRET')

api = tweepy.API(auth)# 抓取特定话题的推文

for tweet in tweepy.Cursor(api.search, q="#特定话题", lang="en").items(100):print(tweet.text)

1.1.3 拓展案例1:电商网站价格监控

想象你是一个电商企业的竞争情报分析师,需要监控竞争对手的产品价格。使用 Python 的 BeautifulSoup 库可以解析 HTML 页面,抓取产品价格信息。这个案例在电子商务竞争分析中非常常见。

import requests

from bs4 import BeautifulSoup# 请求网页

response = requests.get('http://example.com/product')

soup = BeautifulSoup(response.text, 'html.parser')# 解析价格信息

price = soup.find('span', class_='product-price').text

print(f"产品价格: {price}")

1.1.4 拓展案例2:新闻聚合服务

假设你正在开发一个新闻聚合服务,需要从多个新闻网站抓取最新的新闻标题和链接。使用 Python 的 Requests 库来发送HTTP请求,搭配 BeautifulSoup 进行内容解析。这个案例在信息聚合和内容提供服务中极为常见。

import requests

from bs4 import BeautifulSoup# 请求新闻网页

response = requests.get('http://news.example.com')

soup = BeautifulSoup(response.text, 'html.parser')# 抓取新闻标题和链接

for news_item in soup.find_all('div', class_='news-item'):title = news_item.find('h2').textlink = news_item.find('a')['href']print(f"标题: {title}, 链接: {link}")

通过这三个案例,我们不仅能看到 Python 在网络爬虫应用中的强大能力,还能体会到网络爬虫技术在不同行业中的广泛应用。这些案例涵盖了从社交媒体分析、价格监控到新闻聚合的多种实用场景,展示了网络爬虫技术如何帮助我们从大量网页中提取有价值的信息。

1.2 网络爬虫的工作原理

1.2.1 重点基础知识讲解

要掌握网络爬虫的工作原理,我们首先需要理解几个关键概念:

- 请求 (Request):这是网络爬虫向服务器发出的“请给我数据”的呼唤。通常分为 GET 请求(请求数据)和 POST 请求(提交数据)。

- 响应 (Response):当服务器接收到请求后,它回送的数据就是响应。响应中包含了许多有用的信息,包括请求的网页数据。

- 解析 (Parsing):获取响应后,爬虫需要从中提取有用的信息,这个过程称为解析。常用的解析工具包括 BeautifulSoup 和 lxml 。

- 数据存储 (Data Storage):爬虫从网页中提取的数据需要被存储起来,以便进一步的处理或分析。存储方式有很多种,包括但不限于数据库、文件或内存中。

接下来,我们将通过几个实际案例来深入探讨网络爬虫的工作原理。

1.2.2 重点案例:股票市场数据采集

假设你是一名金融分析师,需要实时追踪特定股票的价格变动。使用 Python 的 requests 库可以轻松地实现这一目标。通过发送 GET 请求到股票信息网站,然后解析响应数据获取股价信息。这个案例在金融分析和市场监控中非常实用。

import requests

from bs4 import BeautifulSoup# 发送 GET 请求

url = "http://example.com/stock/AAPL"

response = requests.get(url)# 解析响应内容

soup = BeautifulSoup(response.content, 'html.parser')

price = soup.find('div', class_='stock-price').text

print(f"苹果股价: {price}")

1.2.3 拓展案例 1:博客文章抓取

想象你正在构建一个个人项目,需要从你最喜欢的技术博客中抓取最新文章的标题和链接,以便快速浏览。这时,你可以使用 Python 的 requests 和 BeautifulSoup 来完成这项任务。这个案例对于内容聚合器或个人学习资源库的构建非常有帮助。

import requests

from bs4 import BeautifulSoup# 请求博客首页

response = requests.get('https://techblog.example.com')

soup = BeautifulSoup(response.text, 'html.parser')# 抓取文章标题和链接

articles = []

for article in soup.find_all('article'):title = article.find('h2').textlink = article.find('a')['href']articles.append({'title': title, 'link': link})for article in articles:print(f"标题: {article['title']}, 链接: {article['link']}")

1.2.4 拓展案例 2:酒店价格监控

假设你是一名旅行爱好者,希望监控某旅游网站上目的地酒店的价格,以便在价格最低时预订。通过 Python 的 requests 库发送请求,并利用 BeautifulSoup 解析响应内容中的酒店价格信息。这个案例对于预算有限的旅行者来说非常实用。

import requests

from bs4 import BeautifulSoup# 发送请求到酒店列表页面

response = requests.get('http://travel.example.com/hotels?destination=paris')

soup = BeautifulSoup(response.text, 'html.parser')# 解析酒店价格

hotels = []

for hotel in soup.find_all('div', class_='hotel-item'):name = hotel.find('h2').textprice = hotel.find('span', class_='price').texthotels.append({'name': name, 'price': price})for hotel in hotels:print(f"酒店: {hotel['name']}, 价格: {hotel['price']}")

通过这些案例,我们不仅理解了网络爬虫的基本工作原理,还学习了如何在实际生产中应用这些原理来解决实际问题。无论是金融市场的数据采集,个人兴趣的内容聚合,还是生活中的价格监控,网络爬虫技术都能提供强大的支持。

1.3 网络爬虫的法律与道德考量

1.3.1 重点基础知识讲解

在开发和部署网络爬虫时,法律和道德考量是不可或缺的一部分。违反这些准则可能导致法律后果,包括被禁止访问目标网站、面临诉讼甚至罚款。理解以下几个关键点是至关重要的:

- robots.txt 协议:这是网站告知网络爬虫哪些部分可被爬取、哪些部分禁止爬取的标准。遵守 robots.txt 是网络爬虫开发的基本礼仪。

- 版权法:网页上的内容,如文本、图片和视频,通常受版权法保护。未经授权擅自抓取和使用这些内容可能会侵犯版权。

- 隐私法:在处理个人数据(如社交媒体帖子、论坛评论等)时,必须遵守适用的隐私法律和规定,如 GDPR 或 CCPA。

- 访问频率和负载:过度请求网站可能会对其正常运营造成干扰,这不仅是一个道德问题,也可能引起法律问题。

1.3.2 重点案例:社交媒体数据抓取

假设你是一家营销公司的数据分析师,需要分析特定话题在社交媒体上的讨论趋势。使用 Python 来抓取 Twitter 上的相关帖子是一个常见的做法。在这个过程中,确保遵循 Twitter 的使用条款和访问频率限制至关重要。

import tweepy# 初始化 Tweepy API

auth = tweepy.OAuthHandler('YOUR_CONSUMER_KEY', 'YOUR_CONSUMER_SECRET')

auth.set_access_token('YOUR_ACCESS_TOKEN', 'YOUR_ACCESS_TOKEN_SECRET')

api = tweepy.API(auth, wait_on_rate_limit=True)# 搜索帖子

for tweet in tweepy.Cursor(api.search, q="#特定话题", lang="en", tweet_mode='extended').items(100):print(tweet.full_text)

1.3.3 拓展案例 1:网站内容聚合

你正在开发一个聚合多个新闻源内容的网站。在抓取新闻文章并展示在你的网站上之前,确保你有权使用这些内容,或者只展示文章的标题和一小段摘要,并链接回原始文章,以避免侵犯版权。

import requests

from bs4 import BeautifulSoup# 请求新闻网站

response = requests.get('https://news.example.com')

soup = BeautifulSoup(response.text, 'html.parser')# 解析并展示新闻标题和链接

for news_item in soup.select('.news-title'):title = news_item.textlink = news_item.find('a')['href']print(f"标题: {title}, 链接: {link}")

1.3.4 拓展案例 2:在线商店价格监控

你为一家价格比较网站工作,负责监控不同在线商店的产品价格。在编写爬虫抓取这些信息时,重要的是要控制请求的频率,避免因为发送过多请求而对商店的网站造成负担。

import time

import requests

from bs4 import BeautifulSoupproduct_urls = ['http://onlinestore.example.com/product1', 'http://onlinestore.example.com/product2']for url in product_urls:# 发送请求response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')# 解析产品价格price = soup.find('span', class_='price').textprint(f"产品价格: {price}")# 间隔时间,避免过快请求time.sleep(10)

通过以上案例,我们看到,在实际工作中使用网络爬虫时,遵守法律规定和道德标准是非常重要的。这不仅有助于保护你的项目免受法律风险,也是对其他网站运营者的尊重和负责任的表现。

相关文章:

《Python 网络爬虫简易速速上手小册》第1章:Python 网络爬虫基础(2024 最新版)

文章目录 1.1 网络爬虫简介1.1.1 重点基础知识讲解1.1.2 重点案例:社交媒体数据分析1.1.3 拓展案例1:电商网站价格监控1.1.4 拓展案例2:新闻聚合服务 1.2 网络爬虫的工作原理1.2.1 重点基础知识讲解1.2.2 重点案例:股票市场数据采…...

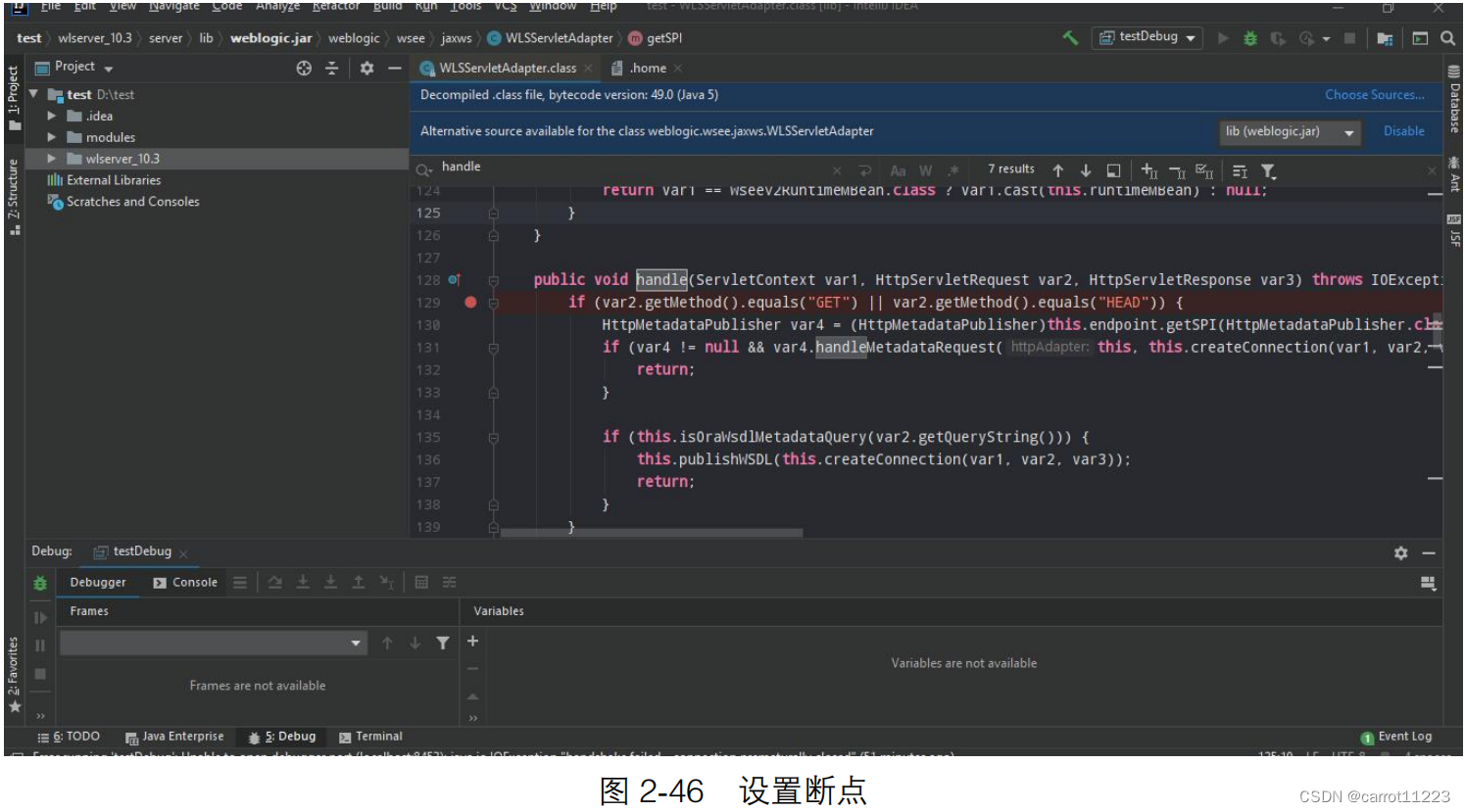

使用 IntelliJ IDEA 配合 Docker 对 Weblogic 中间件进行远程调试

使用idea对jar包远程调试: 打开一个springboot的项目进行远程调试设置: 运行: 其实我不太明白远程调试的意义,本地直接debug不好嘛。。。 点击debug的按钮,打断点测试: 跑到断点处: 远程de…...

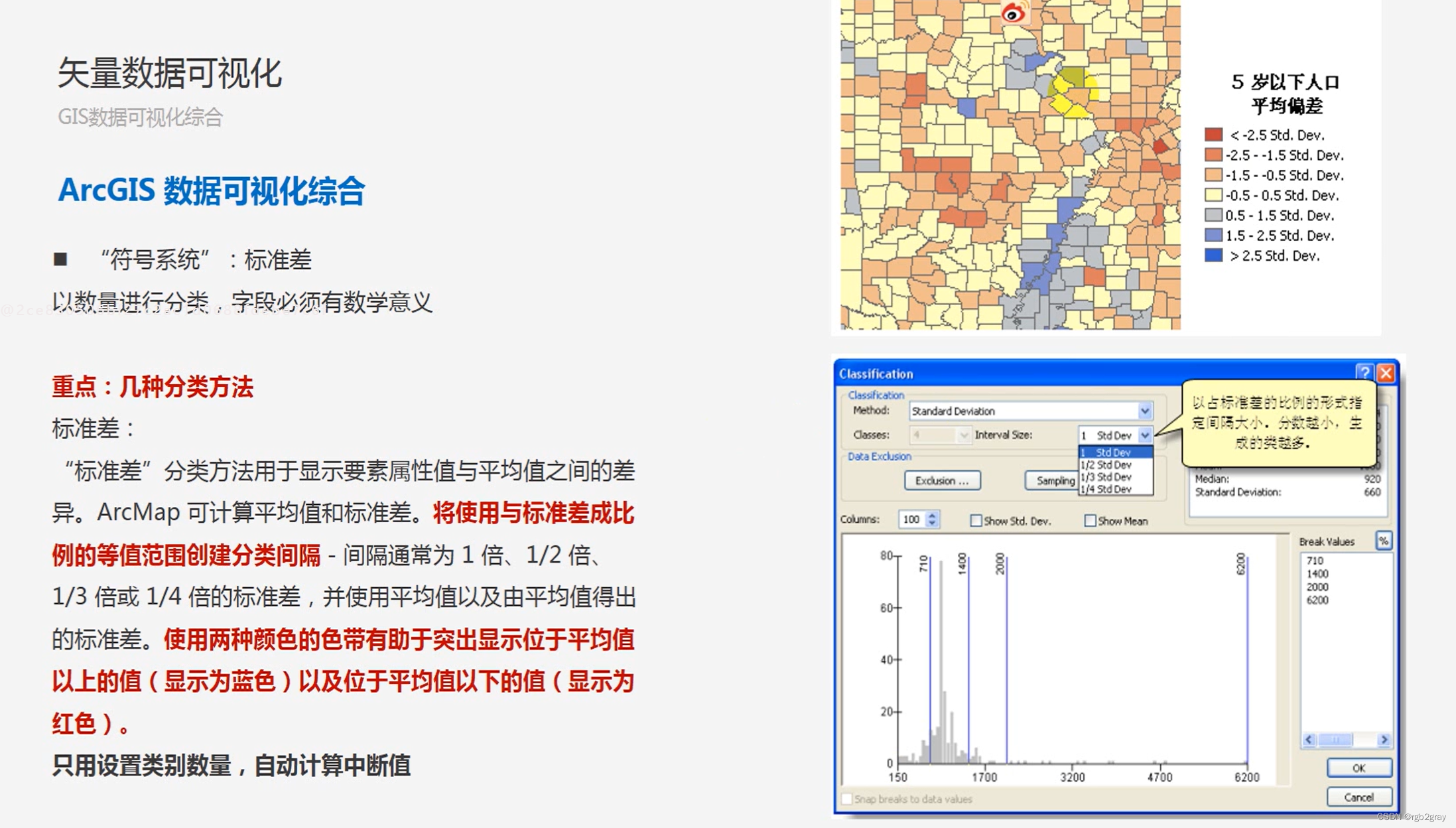

ArcGIS学习(三)数据可视化

ArcGIS学习(三)数据可视化 1.矢量数据可视化 需要提前说明的是,在ArcGIS中,所有的可视化选项设置都是在“图层属性”对话框里面的“符号系统”中实现的。 对于矢量数据的可视化,主要有四种可视化方式: 按“要素”可视化按“类别”可视化按“数量”可视化按“图表”可视…...

【使用 Python 进行 NLP】 第 2 部分 NLTK

一、说明 Python 有一些非常强大的 NLP 库,NLTK — 自然语言工具包 — NLTK 是一个强大的开源库,用于 NLP 的研究和开发。它内置了 50 多个文本语料库和词汇资源。它支持文本标记化、词性标记、词干提取、词形还原、命名实体提取、分割、分类、语义推理。…...

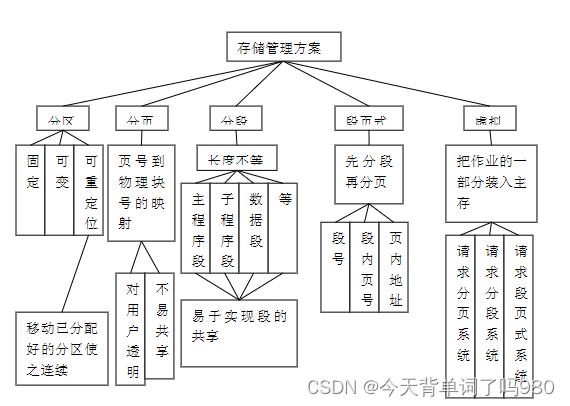

【软件设计师笔记】深入探究操作系统

【软件设计师笔记】计算机系统基础知识考点(传送门) 💖 【软件设计师笔记】程序语言设计考点(传送门) 💖 🐓 操作系统的作用 1.通过资源管理提高计算机系统的效率 2.改善人机界面向用户提供友好的工作环境 🐓 操作系统的特征 …...

python常用pandas函数nlargest / nsmallest及其手动实现

目录 pandas库 Series和DataFrame nlargest和nsmallest 用法示例 代替方法 手动实现 模拟代码 pandas库 是Python中一个非常强大的数据处理库,提供了高效的数据分析方法和数据结构。它特别适用于处理具有关系型数据或带标签数据的情况,同时在时间序列分析方面也有着出…...

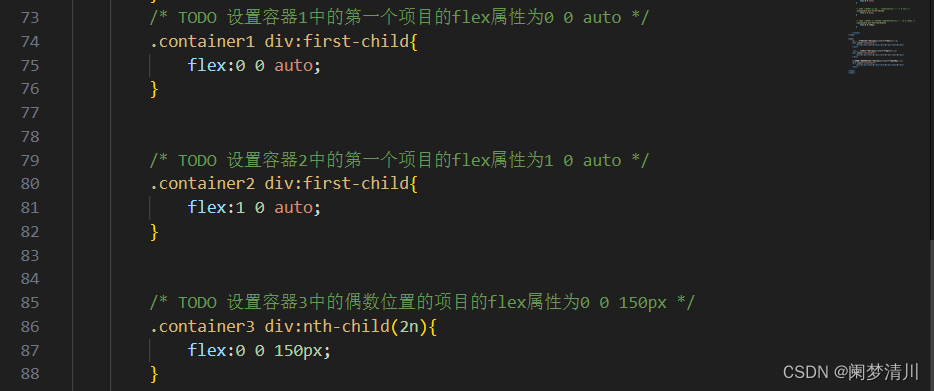

web前端-------弹性盒子(2)

上一讲我们谈的是盒子的容器实行,今天我们来聊一聊弹性盒子的项目属性; *******************(1)顺序属性 order属性,用于定义容器中项目的出现顺序。 顺序属性值,为整数,可以为负数ÿ…...

图论练习4

内容:染色划分,带权并查集,扩展并查集 Arpa’s overnight party and Mehrdad’s silent entering 题目链接 题目大意 个点围成一圈,分为对,对内两点不同染色同时,相邻3个点之间必须有两个点不同染色问构…...

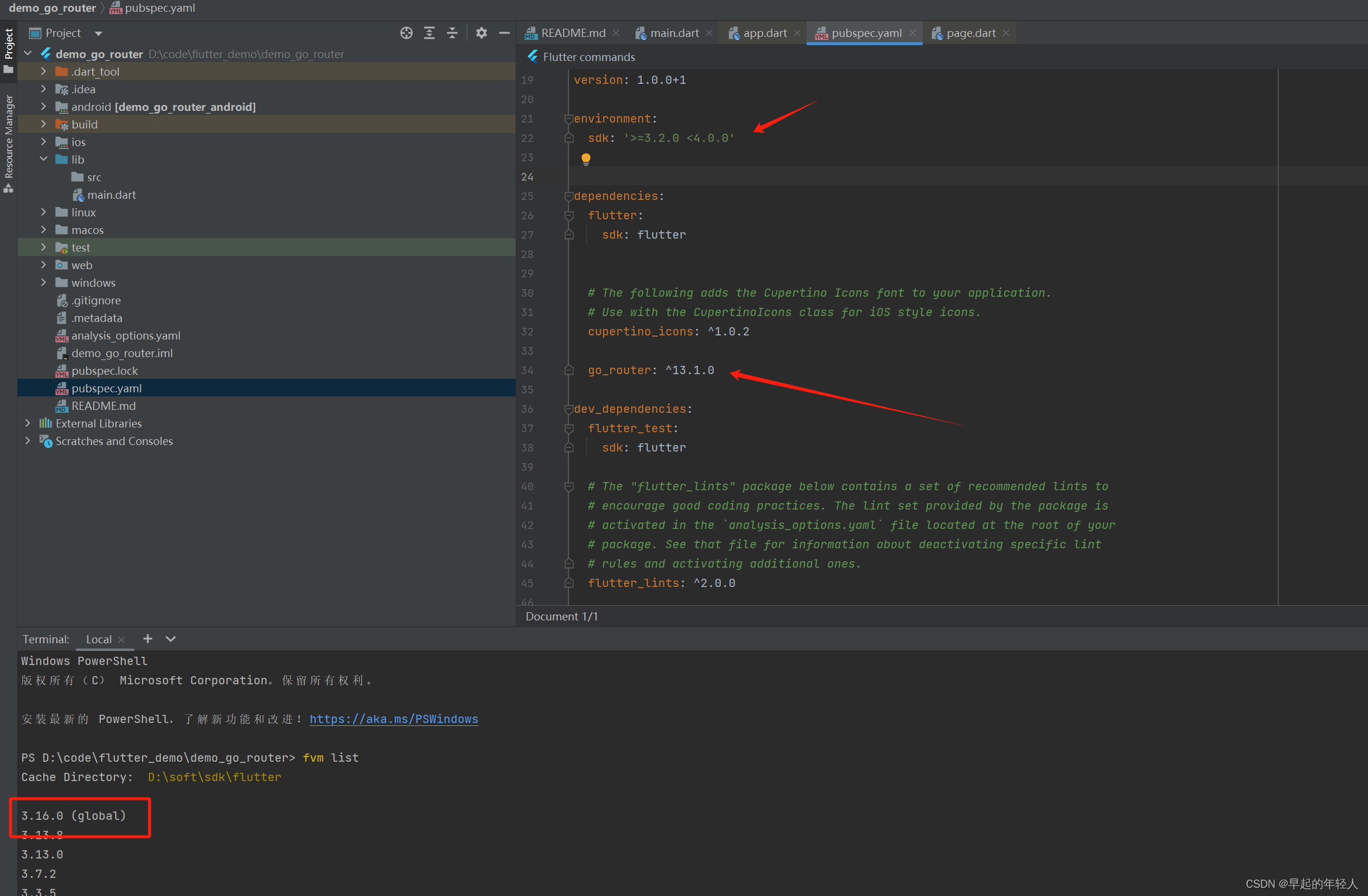

flutter go_router 官方路由(一)基本使用

1 项目中添加最新的依赖 go_router: ^13.1.0如下图所示,我当前使用的flutter版本为3.16.0 然后修改应用的入口函数如下: import package:flutter/material.dart; import package:go_router/go_router.dart;void main() {runApp(const MyApp()); }cla…...

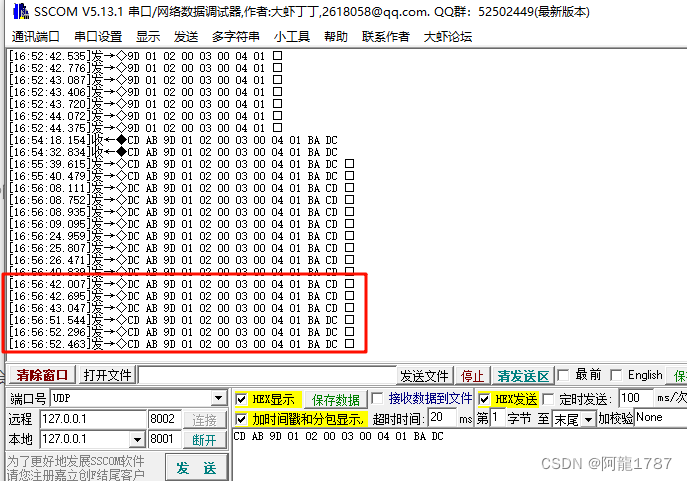

QT中,对于大小端UDP网络发送的demo,帧头帧尾

简单demo: 发送端: #include <QUdpSocket> #include <QtEndian>#pragma pack(1) struct Test {unsigned char t1:1;unsigned char t2:2;unsigned char t3:3;unsigned char t4:2;quint8 a 1;quint16 b 2;quint16 c 3;//double b …...

ip网络的三类地址及其相互关系

随着互联网的普及和发展,IP网络已成为全球范围内最重要的信息交换平台。在IP网络中,IP地址是每个设备在网络中的唯一标识,是实现网络通信的关键。虎观代理小二二将详细介绍IP网络中的三类地址,即A类、B类和C类地址,以及…...

开源计算机视觉库OpenCV详细介绍

开源计算机视觉库OpenCV详细介绍 1. OpenCV简介 OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉和机器学习软件库。它最初由Intel开发,现在由一个庞大的社区维护和更新。OpenCV旨在提供一个通用、跨平台的计算机…...

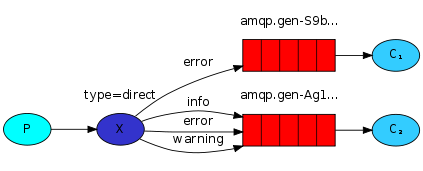

go消息队列RabbitMQ - 订阅模式-direct

1.发布订阅 在Fanout模式中,一条消息,会被所有订阅的队列都消费。但是,在某些场景下,我们希望不同的消息被不同的队列消费。这时就要用到Direct类型的Exchange。 在Direct模型下: 队列与交换机的绑定,不能…...

PyTorch 2.2 中文官方教程(十八)

开始使用完全分片数据并行(FSDP) 原文:pytorch.org/tutorials/intermediate/FSDP_tutorial.html 译者:飞龙 协议:CC BY-NC-SA 4.0 作者:Hamid Shojanazeri,Yanli Zhao,Shen Li 注意…...

jenkins部署vue项目

首次加载比较慢、需要等待很长时间 到这个页面算是初始化完成了 输入密码路径为 之前设置的路径 可以在文件中找或者 docker logs jenkins 直接安装推荐插件 正在安装中!! 安装成功后创建管理员账号(一定要记住这个也是登录账号密码) 这里实例配置直接…...

引用)

十一、C++核心编程(2)引用

一、引用的基本使用 作用: 给变量起别名语法: 数据类型 &别名 原名 #include<iostream> #include<string.h> using namespace std;int main() {//引用基本语法//数据类型 &别名 原名int a 10;//创建引用int &b a;cout << "a "…...

numpy学习总结二

单词发音: squeeze 发音:死贵子 concatenation [kɒnˌktəˈneɪʃən] 拼接;串联 threshold [θreʃhəʊld] 死re后的 quantile 拷n太哦 分位数 因果不能改 智慧不能赐 正法不可说 无缘不能度 天雨虽宽不润无根之草;佛法虽广不度无缘之人 …...

3 编辑器(Vim)

1.完成 vimtutor。备注:它在一个 80x24(80 列,24 行) 终端窗口看起来效果最好。 2.下载我们提供的 vimrc,然后把它保存到 ~/.vimrc。 通读这个注释详细的文件 (用 Vim!), 然后观察 …...

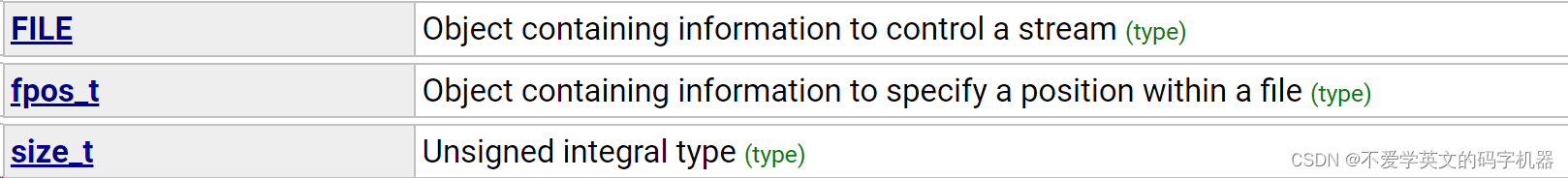

C/C++ (stdio.h)标准库详解

cstdio,在C语言中称为stdio.h。该库使用所谓的流与物理设备(如键盘、打印机、终端)或系统支持的任何其他类型的文件一起操作。 在本文将会通过介绍函数参数,举出实际的简单例子来帮助大家快速上手使用函数。 目录 一、流 二、库函数 1、F…...

深度学习介绍

对于具备完善业务逻辑的任务,大多数情况下,正常的人都可以给出一个符合业务逻辑的应用程序。但是对于一些包含超过人类所能考虑到的逻辑的任务,例如面对如下任务: 编写一个应用程序,接受地理信息、卫星图像和一些历史…...

XML Group端口详解

在XML数据映射过程中,经常需要对数据进行分组聚合操作。例如,当处理包含多个物料明细的XML文件时,可能需要将相同物料号的明细归为一组,或对相同物料号的数量进行求和计算。传统实现方式通常需要编写脚本代码,增加了开…...

装饰模式(Decorator Pattern)重构java邮件发奖系统实战

前言 现在我们有个如下的需求,设计一个邮件发奖的小系统, 需求 1.数据验证 → 2. 敏感信息加密 → 3. 日志记录 → 4. 实际发送邮件 装饰器模式(Decorator Pattern)允许向一个现有的对象添加新的功能,同时又不改变其…...

【JavaEE】-- HTTP

1. HTTP是什么? HTTP(全称为"超文本传输协议")是一种应用非常广泛的应用层协议,HTTP是基于TCP协议的一种应用层协议。 应用层协议:是计算机网络协议栈中最高层的协议,它定义了运行在不同主机上…...

Appium+python自动化(十六)- ADB命令

简介 Android 调试桥(adb)是多种用途的工具,该工具可以帮助你你管理设备或模拟器 的状态。 adb ( Android Debug Bridge)是一个通用命令行工具,其允许您与模拟器实例或连接的 Android 设备进行通信。它可为各种设备操作提供便利,如安装和调试…...

)

React Native 开发环境搭建(全平台详解)

React Native 开发环境搭建(全平台详解) 在开始使用 React Native 开发移动应用之前,正确设置开发环境是至关重要的一步。本文将为你提供一份全面的指南,涵盖 macOS 和 Windows 平台的配置步骤,如何在 Android 和 iOS…...

服务器硬防的应用场景都有哪些?

服务器硬防是指一种通过硬件设备层面的安全措施来防御服务器系统受到网络攻击的方式,避免服务器受到各种恶意攻击和网络威胁,那么,服务器硬防通常都会应用在哪些场景当中呢? 硬防服务器中一般会配备入侵检测系统和预防系统&#x…...

GC1808高性能24位立体声音频ADC芯片解析

1. 芯片概述 GC1808是一款24位立体声音频模数转换器(ADC),支持8kHz~96kHz采样率,集成Δ-Σ调制器、数字抗混叠滤波器和高通滤波器,适用于高保真音频采集场景。 2. 核心特性 高精度:24位分辨率,…...

云原生安全实战:API网关Kong的鉴权与限流详解

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 一、基础概念 1. API网关(API Gateway) API网关是微服务架构中的核心组件,负责统一管理所有API的流量入口。它像一座…...

MinIO Docker 部署:仅开放一个端口

MinIO Docker 部署:仅开放一个端口 在实际的服务器部署中,出于安全和管理的考虑,我们可能只能开放一个端口。MinIO 是一个高性能的对象存储服务,支持 Docker 部署,但默认情况下它需要两个端口:一个是 API 端口(用于存储和访问数据),另一个是控制台端口(用于管理界面…...

【SpringBoot自动化部署】

SpringBoot自动化部署方法 使用Jenkins进行持续集成与部署 Jenkins是最常用的自动化部署工具之一,能够实现代码拉取、构建、测试和部署的全流程自动化。 配置Jenkins任务时,需要添加Git仓库地址和凭证,设置构建触发器(如GitHub…...