AI推介-大语言模型LLMs论文速览(arXiv方向):2024.03.05-2024.03.10—(2)

论文目录~

- 1.Debiasing Large Visual Language Models

- 2.Harnessing Multi-Role Capabilities of Large Language Models for Open-Domain Question Answering

- 3.Towards a Psychology of Machines: Large Language Models Predict Human Memory

- 4.Can we obtain significant success in RST discourse parsing by using Large Language Models?

- 5.DiffChat: Learning to Chat with Text-to-Image Synthesis Models for Interactive Image Creation

- 6.Teaching Large Language Models to Reason with Reinforcement Learning

- 7.Wiki-TabNER:Advancing Table Interpretation Through Named Entity Recognition

- 8.GraphInstruct: Empowering Large Language Models with Graph Understanding and Reasoning Capability

- 9.Do Large Language Model Understand Multi-Intent Spoken Language ?

- 10.HaluEval-Wild: Evaluating Hallucinations of Language Models in the Wild

- 11.Proxy-RLHF: Decoupling Generation and Alignment in Large Language Model with Proxy

- 12.DEEP-ICL: Definition-Enriched Experts for Language Model In-Context Learning

- 13.Evaluation of LLMs on Syntax-Aware Code Fill-in-the-Middle Tasks

- 14.Large Language Models are In-Context Molecule Learners

- 15.Generative AI for Synthetic Data Generation: Methods, Challenges and the Future

- 16.Did Translation Models Get More Robust Without Anyone Even Noticing?

- 17.ShortGPT: Layers in Large Language Models are More Redundant Than You Expect

- 18.Evaluating the Elementary Multilingual Capabilities of Large Language Models with MultiQ

- 19.PPTC-R benchmark: Towards Evaluating the Robustness of Large Language Models for PowerPoint Task Completion

- 20.Multimodal Transformer for Comics Text-Cloze

- 21.Mixture-of-LoRAs: An Efficient Multitask Tuning for Large Language Models

- 22.Alpaca against Vicuna: Using LLMs to Uncover Memorization of LLMs

1.Debiasing Large Visual Language Models

标题:消除大型视觉语言模型的偏差

author:Yi-Fan Zhang, Weichen Yu, Qingsong Wen, Xue Wang, Zhang Zhang, Liang Wang, Rong Jin, Tieniu Tan

publish:38 pages, 17 figures

date Time:2024-03-08

paper pdf:http://arxiv.org/pdf/2403.05262v1

摘要:

在计算机视觉和自然语言处理领域,大型视觉语言模型(LVLMs)已成为不可或缺的工具,能够熟练地根据视觉输入生成文本描述。尽管它们取得了进步,但我们的研究发现,生成的内容存在值得注意的偏差,即输出主要受底层大型语言模型(LLMs)的先验影响,而不是受输入图像的影响。我们的实证实验强调了这种偏差的持续性,因为即使在没有相关图像或给定不一致的视觉输入的情况下,大型语言模型也经常提供有把握的答案。为了纠正这些偏差,并将模型的注意力重新引向视觉信息,我们引入了两种简单、无需训练的策略。首先,对于分类或多选问题解答(QA)等任务,我们提出了通过仿射变换调整输出分布的 "校准 "步骤。这种 "事后修正 "方法可确保在图像缺失时每个答案的得分一致,是一种有效的正则化技术,可减轻 LLM 先验的影响。对于更复杂的开放式生成任务,我们从对比解码方法中汲取灵感,将这种方法扩展为 “Debias 采样”。此外,我们的研究还揭示了 LVLM 在不同解码配置下的不稳定性。通过对不同设置的系统探索,我们显著提高了性能,超越了已报道的结果,并引起了人们对现有评估公平性的关注。综合实验证明了我们提出的策略在减少偏差方面的有效性。事实证明,这些策略不仅有利于最大限度地减少幻觉,还有助于生成更有用、更精确的插图。

2.Harnessing Multi-Role Capabilities of Large Language Models for Open-Domain Question Answering

标题:利用大型语言模型的多角色能力进行开放域问题解答

author:Hongda Sun, Yuxuan Liu, Chengwei Wu, Haiyu Yan, Cheng Tai, Xin Gao, Shuo Shang, Rui Yan

publish:TheWebConf 2024 (WWW 2024) oral, code repo:

https://github.com/EthanLeo-LYX/LLMQA

date Time:2024-03-08

paper pdf:http://arxiv.org/pdf/2403.05217v1

摘要:

开放域问题解答(ODQA)已成为信息系统领域一个举足轻重的研究热点。现有的方法主要遵循两种范式来收集证据:(1) \textit{retrieve-then-read}范式从外部语料库中检索相关文档;(2) \textit{generate-then-read}范式采用大型语言模型(LLM)来生成相关文档。然而,这两种方法都无法完全满足对证据的多方面要求。为此,我们提出了一个通用框架 LLMQA,它将 ODQA 流程划分为三个基本步骤:查询扩展、文档选择和答案生成,结合了基于检索和基于生成证据的优势。由于 LLM 在完成各种任务方面表现出卓越的能力,我们指示 LLM 在我们的框架中扮演生成者、重行者和评估者等多重角色,使它们在 ODQA 流程中相互协作。此外,我们还引入了一种新颖的提示优化算法来完善角色扮演提示,引导 LLM 生成更高质量的证据和答案。在广泛使用的基准(NQ、WebQ 和 TriviaQA)上进行的大量实验结果表明,LLMQA 在答案准确性和证据质量方面都达到了最佳性能,展示了其在推进 ODQA 研究和应用方面的潜力。

3.Towards a Psychology of Machines: Large Language Models Predict Human Memory

标题:迈向机器心理学:大型语言模型预测人类记忆

author:Markus Huff, Elanur Ulakçı

publish:32 pages, 3 figures, 2 tables

date Time:2024-03-08

paper pdf:http://arxiv.org/pdf/2403.05152v1

摘要:

大型语言模型(LLMs)尽管缺乏人类认知的基础,却在各种任务中展现出非凡的能力。这就提出了一个问题:这些模型除了简单地模仿人类语言模式外,还能深入探讨人类认知的内在机制吗?本研究探讨了 ChatGPT 预测人类在基于语言的记忆任务中的表现的能力。在文本理解理论的基础上,我们假设,在模棱两可的句子(如 “因为比尔喝酒,所以家里从不放酒”)前面加上与上下文相关的信息,将有助于识别这些句子。我们向人类和 ChatGPT 参与者展示了一对句子。第二个句子始终是一个设计得模棱两可的普通句子,而第一个句子要么提供了合适的上下文(如 “比尔长期酗酒”),要么提供了不合适的上下文(如 “比尔喜欢打高尔夫球”)。我们测量了人类和 ChatGPT 对句子相关性的评分、ChatGPT 对花园路径句子的可记性评分以及人类对花园路径句子的自发记忆。结果显示,ChatGPT 的评估与人类的表现惊人地一致。尽管 ChatGPT 的内部机制可能与人类认知有很大不同,但 ChatGPT 认为关联性更强、记忆性更强的句子确实被人类记忆得更好。这一发现通过使用同义词进行稳健性检查得到了证实,它强调了生成式人工智能模型准确预测人类表现的潜力。我们将讨论这些发现对于利用 LLM 发展心理学理论和深入了解人类认知的广泛意义。

4.Can we obtain significant success in RST discourse parsing by using Large Language Models?

标题:我们能否利用大型语言模型在 RST 语篇解析中取得巨大成功?

author:Aru Maekawa, Tsutomu Hirao, Hidetaka Kamigaito, Manabu Okumura

publish:Accepted in the main conference of EACL 2024

date Time:2024-03-08

paper pdf:http://arxiv.org/pdf/2403.05065v1

摘要:

最近,拥有数百亿个参数的纯解码器预训练大型语言模型(LLM)对各种自然语言处理(NLP)任务产生了重大影响。虽然纯编码器或编码器-解码器预训练语言模型已被证明在语篇解析中非常有效,但 LLMs 能在多大程度上完成这项任务仍是一个未决的研究问题。因此,本文探讨了此类 LLM 对修辞结构理论(RST)话语分析的益处。在这里,自上而下和自下而上两种基本策略的解析过程都被转换成了提示,LLMs 可以使用这些提示进行工作。我们采用 Llama 2,并用 QLoRA 对其进行微调,因为 QLoRA 可调整的参数较少。在 RST-DT、Instr-DT 和 GUM 语料库这三个基准数据集上的实验结果表明,在自下而上策略中使用 700 亿个参数的 Llama 2 获得了具有显著差异的一流(SOTA)结果。此外,在对 RST-DT 进行评估时,我们的解析器表现出了普适性,表明尽管使用 GUM 语料进行了训练,但它仍获得了与使用 RST-DT 训练的现有解析器相似的性能。

5.DiffChat: Learning to Chat with Text-to-Image Synthesis Models for Interactive Image Creation

标题:DiffChat:学习与文本到图像合成模型聊天,实现交互式图像创作

author:Jiapeng Wang, Chengyu Wang, Tingfeng Cao, Jun Huang, Lianwen Jin

date Time:2024-03-08

paper pdf:http://arxiv.org/pdf/2403.04997v1

摘要:

我们介绍的 DiffChat 是一种新颖的方法,可将大语言模型(LLM)与提示即输入的文本到图像合成(TIS)模型(如稳定扩散)进行 “聊天”,从而实现交互式图像创建。给定原始提示/图像和用户指定的指令后,DiffChat 可以有效地进行适当修改并生成目标提示,然后利用目标提示创建高质量的目标图像。为此,我们首先收集了一个名为 InstructPE 的指令跟随提示工程数据集,用于 DiffChat 的监督训练。接下来,我们提出了一个强化学习框架,该框架将美学、用户偏好和内容完整性作为图像创建的三个核心标准。它涉及一种行动空间动态修改技术,以便在非策略采样期间获得更多相关的正面样本和更难的负面样本。内容完整性也被引入到值估计函数中,以进一步改进生成的图像。根据自动和人工评估,我们的方法比基线模型和强大的竞争对手都表现出更优越的性能,这充分证明了它的有效性。

6.Teaching Large Language Models to Reason with Reinforcement Learning

标题:用强化学习教大型语言模型推理

author:Alex Havrilla, Yuqing Du, Sharath Chandra Raparthy, Christoforos Nalmpantis, Jane Dwivedi-Yu, Maksym Zhuravinskyi, Eric Hambro, Sainbayar Sukhbaatar, Roberta Raileanu

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04642v1

摘要:

从人类反馈中强化学习(Reinforcement Learning from Human Feedback,简称 RLHF)已成为使 LLM 输出与人类偏好保持一致的主要方法。受 RLHF 成功的启发,我们研究了多种从反馈中学习的算法(专家迭代、近端策略优化(PPO)、返回条件 RL)在提高 LLM 推理能力方面的表现。我们研究了启发式和通过学习奖励模型为 LLM 提供的稀疏和密集奖励。此外,我们还从多种模型大小和初始化开始,包括有监督微调(\textbf{SFT})数据和无监督微调(\textbf{SFT})数据。总体而言,我们发现所有算法的表现都相当不错,而专家迭代法在大多数情况下表现最佳。令人惊讶的是,我们发现专家迭代的样本复杂度与 PPO 相似,从一个预训练的检查点收敛最多需要 10^6$ 样本。我们研究了出现这种情况的原因,并得出结论:在 RL 训练期间,模型无法在 SFT 模型已经产生的解决方案之外再进行大量探索。此外,我们还讨论了在 SFT 训练期间,maj@1 和 pass@96 指标性能之间的权衡,以及反之,RL 训练如何同时提高这两个指标的性能。最后,我们讨论了我们的发现对 RLHF 的影响以及 RL 未来在 LLM 微调中的作用。

7.Wiki-TabNER:Advancing Table Interpretation Through Named Entity Recognition

标题:Wiki-TabNER:通过命名实体识别推进表格释义

author:Aneta Koleva, Martin Ringsquandl, Ahmed Hatem, Thomas Runkler, Volker Tresp

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04577v1

摘要:

网络表格包含大量有价值的知识,激发了旨在处理表格解释(TI)任务的表格语言模型。在本文中,我们分析了一个广泛用于评估 TI 任务的基准数据集,尤其侧重于实体链接任务。我们的分析表明,该数据集过于简化,可能会降低其全面评估的有效性,并且无法准确地表示真实世界中出现的表格。为了克服这一缺点,我们构建并注释了一个更具挑战性的新数据集。除了引入新的数据集,我们还引入了一个旨在解决实体链接任务的新问题:单元格内的命名实体识别。最后,我们提出了一个提示框架,用于评估新开发的大型语言模型(LLM)在这一新型 TI 任务上的表现。我们在不同的设置下对 LLM 进行了提示实验,我们使用随机选择和基于相似性的选择来选择呈现给模型的示例。我们的消融研究有助于我们深入了解少量示例的影响。此外,我们还进行了定性分析,以深入了解模型所遇到的挑战,并理解所提议的数据集的局限性。

8.GraphInstruct: Empowering Large Language Models with Graph Understanding and Reasoning Capability

标题:GraphInstruct:利用图形理解和推理能力增强大型语言模型的能力

author:Zihan Luo, Xiran Song, Hong Huang, Jianxun Lian, Chenhao Zhang, Jinqi Jiang, Xing Xie, Hai Jin

publish:9 pages

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04483v1

摘要:

评估和增强大型语言模型(LLM)的通用能力一直是一个重要的研究课题。图是现实世界中常见的数据结构,而理解图数据是推进通用智能的关键部分。为了评估和提高 LLM 的图理解能力,本文提出了一个名为 GraphInstruct 的基准,其中包含 21 个经典的图推理任务,提供了多样化的图生成管道和详细的推理步骤。在 GraphInstruct 的基础上,我们通过高效的指令调谐进一步构建了 GraphLM,它显示出了突出的图理解能力。为了增强 LLM 的图推理能力,我们提出了一种阶跃掩码训练策略,并构建了一个名为 GraphLM+ 的模型。作为增强 LLM 的图理解和推理能力的先驱之一,大量实验证明 GraphLM 和 GraphLM+ 优于其他 LLM。我们期待更多研究人员通过 GraphInstruct 发掘 LLM 在图数据挖掘领域的潜力。我们生成 GraphInstruct 的代码已在以下网站公开发布:https://github.com/CGCL-codes/GraphInstruct。

9.Do Large Language Model Understand Multi-Intent Spoken Language ?

标题:大型语言模型能理解多义性口语吗?

author:Shangjian Yin, Peijie Huang, Yuhong Xu, Haojing Huang, Jiatian Chen

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04481v2

摘要:

本研究利用大型语言模型(LLM)进行多意图口语理解(SLU),提出了一种在 SLU 环境中利用 LLM 生成能力的独特方法,标志着一项重大进步。我们的创新技术专门针对 LLM 在多意图 SLU 环境中的应用重新配置了实体插槽,并引入了子意图指示(SII)的概念,从而增强了对不同领域内错综复杂的多意图交流的剖析和解释能力。由此产生的数据集被称为 LM-MixATIS 和 LM-MixSNIPS,是根据已有的基准精心制作而成的。我们的研究表明,LLM 可以与当前最先进的多意图 SLU 模型相媲美,并有可能超越它们。研究还进一步探讨了 LLM 在不同意图配置和数据集比例下的功效。此外,我们还引入了两个开创性指标–实体槽准确度(ESA)和组合语义准确度(CSA),以深入分析 LLM 在这一复杂领域的能力。

10.HaluEval-Wild: Evaluating Hallucinations of Language Models in the Wild

标题:HaluEval-Wild:评估野外语言模型的幻觉

author:Zhiying Zhu, Zhiqing Sun, Yiming Yang

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04307v1

摘要:

幻觉对关键领域中大型语言模型(LLM)的可靠性提出了重大挑战。最近设计的用于评估传统 NLP 任务(如知识密集型问题解答(QA)和摘要)中 LLM 幻觉的基准,不足以捕捉动态真实世界环境中用户与 LLM 交互的复杂性。为了弥补这一不足,我们推出了HaluEval-Wild,这是首个专门用于评估野生LLM幻觉的基准。我们从包括 ShareGPT 在内的现有真实世界用户与 LLM 交互数据集中精心收集具有挑战性的用户查询(由 Alpaca 进行对抗性过滤),以评估各种 LLM 的幻觉率。分析收集到的查询后,我们将其分为五种不同的类型,从而能够对 LLM 表现出的幻觉类型进行精细分析,并利用强大的 GPT-4 模型和检索增强生成 (RAG) 合成参考答案。我们的基准提供了一种新颖的方法,可在反映真实世界互动的场景中提高我们对 LLM 可靠性的理解和改进。

11.Proxy-RLHF: Decoupling Generation and Alignment in Large Language Model with Proxy

标题:Proxy-RLHF:用代理解耦大型语言模型中的生成和配准

author:Yu Zhu, Chuxiong Sun, Wenfei Yang, Wenqiang Wei, Bo Tang, Tianzhu Zhang, Zhiyu Li, Shifeng Zhang, Feiyu Xiong, Jie Hu, Mingchuan yang

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04283v1

摘要:

从人类反馈中强化学习(RLHF)是确保大型语言模型(LLM)与人类价值观保持一致的主流方法。然而,现有的 RLHF 方法需要很高的计算成本,其中一个主要原因是 RLHF 将生成和对齐任务同时分配给 LLM。在本文中,我们介绍了 Proxy-RLHF,它将 LLM 的生成和配准过程分离开来,以更低的计算成本实现与人类价值观的配准。我们从为对齐过程设计的新型马尔可夫决策过程(MDP)入手,并采用强化学习(RL)来训练一个精简的代理模型,该模型负责监督 LLM 的标记生成,而不改变 LLM 本身。实验表明,我们的方法只需要其他方法 1% 的训练参数,就能达到相当的对齐水平。

12.DEEP-ICL: Definition-Enriched Experts for Language Model In-Context Learning

标题:DEEP-ICL:用于语言模型上下文学习的富定义专家

author:Xingwei Qu, Yiming Liang, Yucheng Wang, Tianyu Zheng, Tommy Yue, Lei Ma, Stephen W. Huang, Jiajun Zhang, Wenhu Chen, Chenghua Lin, Jie Fu, Ge Zhang

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04233v1

摘要:

长期以来,人们一直认为大型语言模型(LLMs)中的大量参数推动了上下文学习(ICL)能力的发展,通过利用特定任务的演示,可以显著提高性能。针对这一假设,我们引入了 DEEP-ICL,这是一种用于 ICL 的新颖任务定义增强 ExPert 汇编方法。DEEP-ICL 明确地从给定演示中提取任务定义,并通过学习特定任务示例生成响应。我们认为,ICL 的改进并不直接依赖于模型大小,而是从本质上源于对任务定义的理解和任务引导的学习。受此启发,DEEP-ICL 结合了两个具有不同作用的 3B 模型(一个用于总结任务定义,另一个用于学习任务演示),取得了与 LLaMA2-13B 相当的性能。此外,我们的框架克服了预训练序列长度的限制,支持无限制的演示,因此性能优于传统的 ICL。我们认为,DEEP-ICL 为实现高效的少量学习提供了一种新的选择,超越了传统的 ICL。

13.Evaluation of LLMs on Syntax-Aware Code Fill-in-the-Middle Tasks

标题:评估语法感知代码中间填充任务的 LLM

author:Linyuan Gong, Sida Wang, Mostafa Elhoushi, Alvin Cheung

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04814v1

摘要:

我们介绍了语法感知中间填充(SAFIM),它是在代码中间填充(FIM)任务中评估大型语言模型(LLM)的新基准。该基准重点关注程序结构(如代码块和条件表达式)的语法感知补全,包括来自多种编程语言的 17720 个示例,这些示例来自 2022 年 4 月之后提交的最新代码,以尽量减少数据污染。SAFIM 提供了一个稳健的框架,具有各种提示设计和新颖的语法感知后处理技术,有助于在 LLM 之间进行准确、公平的比较。我们对 15 种 LLM 进行的综合评估表明,FIM 预培训不仅能提高 FIM 熟练程度,还能改善使用 LLM 进行的从左到右(L2R)推理。我们的研究结果挑战了传统观念,表明预训练方法和数据质量比模型大小更有影响力。因此,SAFIM 可作为未来研究代码 LLMs 有效预训练策略的基础平台。评估工具包和数据集见 https://github.com/gonglinyuan/safim,排行榜见 https://safimbenchmark.com。

14.Large Language Models are In-Context Molecule Learners

标题:大型语言模型是语境中的分子学习者

author:Jiatong Li, Wei Liu, Zhihao Ding, Wenqi Fan, Yuqiang Li, Qing Li

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04197v1

摘要:

大型语言模型(LLM)在生化任务中表现出卓越的性能,尤其是分子字幕翻译任务,该任务旨在弥合分子与自然语言文本之间的差距。然而,以往将 LLMs 适应于分子标题翻译任务的方法需要额外的特定领域预训练阶段,分子空间和文本空间之间的配准能力较弱,或者对 LLMs 的规模提出了严格要求。为了解决这些难题,我们提出了 “上下文分子适应”(In-Context Molecule Adaptation,ICMA)这一新范式,允许 LLM 通过上下文分子调整(In-Context Molecule Tuning)从上下文示例中学习分子与文本的对齐。具体来说,ICMA 包含以下三个阶段:跨模态检索(Cross-modal Retrieval)、检索后重新排序(Post-retrieval Re-ranking)和上下文分子调整(In-context Molecule Tuning)。首先,跨模态检索利用 BM25 字幕检索和分子图检索来检索信息丰富的上下文示例。此外,我们还提出了利用序列反转和随机漫步进行检索后重新排序的方法,以进一步提高检索结果的质量。最后,“上下文分子调整”(In-Context Molecule Tuning)利用检索到的示例释放 LLM 的上下文分子学习能力,并为分子-字幕翻译任务调整 LLM 的参数。实验结果表明,ICMT 无需额外的训练语料和复杂的结构,就能使 LLM 达到最先进或相当的性能,这表明 LLM 本身就是上下文分子学习器。

15.Generative AI for Synthetic Data Generation: Methods, Challenges and the Future

标题:用于合成数据生成的生成式人工智能:方法、挑战与未来

author:Xu Guo, Yiqiang Chen

date Time:2024-03-07

paper pdf:http://arxiv.org/pdf/2403.04190v1

摘要:

最近,从大型语言模型(LLMs)生成合成数据的研究激增,尤其是针对数据可用性有限的情况,标志着生成式人工智能(AI)的显著转变。LLM 的性能可与真实世界的数据相媲美,因此这种方法是应对低资源挑战的一个引人注目的解决方案。本文深入探讨了利用这些巨型 LLM 生成特定任务训练数据的先进技术。我们概述了方法、评估技术和实际应用,讨论了当前的局限性,并提出了未来研究的潜在途径。

16.Did Translation Models Get More Robust Without Anyone Even Noticing?

标题:翻译模型是否在不知不觉中变得更加稳健?

author:Ben Peters, André F. T. Martins

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03923v1

摘要:

神经机器翻译(MT)模型在各种环境下都能取得很好的效果,但人们普遍认为它们对 "噪声 "输入高度敏感,如拼写错误、缩写和其他格式问题。在本文中,我们根据最近应用于机器翻译的多语言 MT 模型和大型语言模型 (LLM) 重新审视了这一观点。令人惊讶的是,我们通过对照实验表明,这些模型对多种噪声的鲁棒性远远超过以前的模型,即使它们在干净数据上的表现类似。值得注意的是,尽管 LLM 比以往的模型有更多的参数和更复杂的训练过程,但我们所考虑的开放式模型都没有使用任何专门为提高鲁棒性而设计的技术。接下来,我们将展示社交媒体翻译实验的类似趋势–LLM 对社交媒体文本的鲁棒性更高。我们还分析了在哪些情况下可以使用源校正技术来减轻噪声的影响。总之,我们表明对多种类型噪声的鲁棒性都有所提高。

17.ShortGPT: Layers in Large Language Models are More Redundant Than You Expect

标题:ShortGPT:大型语言模型中的层比你想象的更冗余

author:Xin Men, Mingyu Xu, Qingyu Zhang, Bingning Wang, Hongyu Lin, Yaojie Lu, Xianpei Han, Weipeng Chen

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03853v2

摘要:

随着大型语言模型(LLM)性能的不断提升,其规模也大幅扩大,目前的 LLM 包含数十亿甚至数万亿个参数。然而,在本研究中,我们发现 LLM 的许多层都表现出很高的相似性,有些层在网络功能中的作用微乎其微。基于这一观察结果,我们定义了一种称为 “区块影响力”(Block Influence,BI)的指标,用于衡量 LLM 中各层的重要性。然后,我们提出了一种直接的修剪方法:层删除,即根据 BI 分数直接删除 LLM 中的冗余层。实验证明,我们的方法(我们称之为 ShortGPT)在模型剪枝方面明显优于之前的最先进(SOTA)方法。此外,ShortGPT 与类似量化的方法是正交的,可以进一步减少参数和计算量。与更复杂的剪枝技术相比,通过简单的层去除就能获得更好的结果,这表明模型结构中存在高度冗余。

18.Evaluating the Elementary Multilingual Capabilities of Large Language Models with MultiQ

标题:用 MultiQ 评估大型语言模型的初级多语言能力

author:Carolin Holtermann, Paul Röttger, Timm Dill, Anne Lauscher

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03814v1

摘要:

大型语言模型(LLM)需要为所有人服务,包括全球大多数非英语使用者。然而,目前大多数 LLM,尤其是开放式 LLM,通常只用于英语(如 Llama2、Mistral)或少数高资源语言(如 Mixtral、Qwen)。最近的研究表明,尽管 LLM 的预期用途受到限制,但人们还是会用许多不同的语言提示 LLM。因此,在本文中,我们将研究最先进的开放式 LLM 在预期用途之外的基本多语言能力。为此,我们引入了 MultiQ,这是一个新的银质标准基准,用于基本开放式问题解答,包含 27.4k 个测试问题,涉及 137 种不同类型的语言。通过 MultiQ,我们评估了语言保真度(即模型是否以提示语言进行应答)和问题解答的准确性。我们测试的所有 LLM 都能忠实和/或准确地回答至少一些超出其预期用途的语言。大多数模型在忠实回答时都更准确。然而,不同模型之间的差异也很大,而且有一长段语言的模型既不准确也不忠实。我们探讨了标记化的差异,以此来解释我们的发现,并确定了值得进一步研究的可能相关性。

19.PPTC-R benchmark: Towards Evaluating the Robustness of Large Language Models for PowerPoint Task Completion

标题:PPTC-R 基准:评估用于完成 PowerPoint 任务的大型语言模型的稳健性

author:Zekai Zhang, Yiduo Guo, Yaobo Liang, Dongyan Zhao, Nan Duan

publish:LLM evaluation, Multi-turn, Multi-language, Multi-modal benchmark

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03788v1

摘要:

由于越来越依赖大语言模型(LLM)来完成用户指令,因此有必要全面了解大语言模型在实际情况下完成复杂任务的鲁棒性。为了满足这一关键需求,我们提出了 PowerPoint 任务完成鲁棒性基准(PPTC-R)来衡量 LLM 对用户 PPT 任务指令和软件版本的鲁棒性。具体来说,我们通过在句子、语义和多语言层面攻击用户指令来构建对抗性用户指令。为了评估语言模型对软件版本的鲁棒性,我们改变了所提供的应用程序接口的数量,以模拟最新版本和早期版本的设置。随后,我们使用包含这些鲁棒性设置的基准测试了 3 个闭源和 4 个开源 LLM,旨在评估偏差对 LLM 完成任务的 API 调用有何影响。我们发现,GPT-4 在我们的基准测试中表现出最高的性能和强大的鲁棒性,尤其是在版本更新和多语言设置中。但是,我们发现所有 LLM 在同时面对多个挑战(如多转弯)时都会失去鲁棒性,导致性能大幅下降。我们进一步分析了基准测试中 LLM 的鲁棒性行为和错误原因,这为研究人员了解 LLM 在完成任务时的鲁棒性以及开发更鲁棒性的 LLM 和代理提供了宝贵的见解。我们在 \url{https://github.com/ZekaiGalaxy/PPTCR} 上发布了代码和数据。

20.Multimodal Transformer for Comics Text-Cloze

标题:漫画文本-克隆的多模式转换器

author:Emanuele Vivoli, Joan Lafuente Baeza, Ernest Valveny Llobet, Dimosthenis Karatzas

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03719v1

摘要:

漫画是一种视觉和文字元素错综复杂地交织在一起的媒介,本作品探讨的是漫画中的一项封闭任务。具体来说,"文字闭合 "指的是在一个漫画板块的相邻板块中选择正确的文字。基于递归神经网络的传统方法由于 OCR 精确度有限和固有模型的局限性,在这项任务中举步维艰。我们推出了一种专为 Text-cloze 设计的新型多模态大语言模型(Multimodal-LLM)架构,其简单和困难变体均比现有的一流模型提高了 10%。我们方法的核心是基于领域适配 ResNet-50 的视觉编码器,该编码器使用 SimCLR 以自我监督的方式对漫画领域进行了微调。该编码器只需五分之一的参数,就能提供与更复杂模型相当的结果。此外,我们还为该数据集发布了新的 OCR 注释,从而提高了模型输入质量,并使结果又提高了 1%。最后,我们将任务扩展到了生成格式,建立了新的基线,拓展了漫画分析领域的研究可能性。

21.Mixture-of-LoRAs: An Efficient Multitask Tuning for Large Language Models

标题:语言模型混合物(Mixture-of-LoRAs):大型语言模型的高效多任务调整

author:Wenfeng Feng, Chuzhan Hao, Yuewei Zhang, Yu Han, Hao Wang

publish:10 pages, COLING24 Accepted

date Time:2024-03-06

paper pdf:http://arxiv.org/pdf/2403.03432v1

摘要:

指令调整有可能激发或增强大型语言模型(LLM)的特定能力。然而,实现数据的适当平衡对于防止灾难性遗忘和任务间干扰至关重要。为了解决这些局限性并提高训练的灵活性,我们提出了 Mixture-of-LoRAs(MoA)架构,这是一种新颖且参数效率高的调整方法,专为 LLM 的多任务学习而设计。在本文中,我们首先使用相应的监督语料库数据单独训练多个特定领域的 LoRA 模块。这些 LoRA 模块可以与专家混合物(MoE)中的专家设计原则保持一致。随后,我们使用明确的路由策略将多个 LoRA 组合起来,并引入领域标签以促进多任务学习,这有助于防止任务之间的干扰,最终提高每个任务的性能。此外,每个 LoRA 模型都可以迭代适应新领域,从而快速适应特定领域。在不同任务上的实验证明,LLM 具有卓越而稳健的性能,可以进一步促进特定领域 LLM 的广泛应用。

22.Alpaca against Vicuna: Using LLMs to Uncover Memorization of LLMs

标题:羊驼对抗维库纳:利用 LLMs 来揭示记忆 LLMs 的方法

author:Aly M. Kassem, Omar Mahmoud, Niloofar Mireshghallah, Hyunwoo Kim, Yulia Tsvetkov, Yejin Choi, Sherif Saad, Santu Rana

date Time:2024-03-05

paper pdf:http://arxiv.org/pdf/2403.04801v1

摘要:

在本文中,我们介绍了一种黑盒子提示优化方法,与直接用训练数据提示目标模型所揭示的内容相比,该方法利用攻击者 LLM 代理来揭示受害者代理更高水平的记忆性,而后者是量化 LLM 中记忆性的主流方法。我们使用迭代拒绝-抽样优化过程来寻找具有以下两个主要特征的基于指令的提示:(1) 与训练数据的重叠最小,以避免直接向模型展示解决方案;(2) 受害模型的输出与训练数据的重叠最大,旨在诱导受害人吐出训练数据。我们观察到,与基线前缀-后缀测量法相比,我们基于指令的提示所产生的输出与训练数据的重叠率高达 23.7%。我们的研究结果表明:(1) 经指令调整的模型可以像其基础模型一样暴露预训练数据,如果不是更多的话;(2) 除原始训练数据外的上下文也会导致泄漏;(3) 使用其他 LLM 提出的指令可以为自动攻击开辟一条新途径,我们应该进一步研究和探索。代码见 https://github.com/Alymostafa/Instruction_based_attack 。

相关文章:

:2024.03.05-2024.03.10—(2))

AI推介-大语言模型LLMs论文速览(arXiv方向):2024.03.05-2024.03.10—(2)

论文目录~ 1.Debiasing Large Visual Language Models2.Harnessing Multi-Role Capabilities of Large Language Models for Open-Domain Question Answering3.Towards a Psychology of Machines: Large Language Models Predict Human Memory4.Can we obtain significant succ…...

AI解答——DNS、DHCP、SNMP、TFTP、IKE、RIP协议

使用豆包帮助我解答计算机网络通讯问题—— 1、DHCP 服务器是什么? DHCP 服务器可是网络世界中的“慷慨房东”哦🤣 它的全称是 Dynamic Host Configuration Protocol(动态主机配置协议)服务器。 DHCP 服务器的主要任务是为网络中的…...

【TypeScript系列】声明合并

声明合并 介绍 TypeScript中有些独特的概念可以在类型层面上描述JavaScript对象的模型。 这其中尤其独特的一个例子是“声明合并”的概念。 理解了这个概念,将有助于操作现有的JavaScript代码。 同时,也会有助于理解更多高级抽象的概念。 对本文件来讲,“声明合并”是指编…...

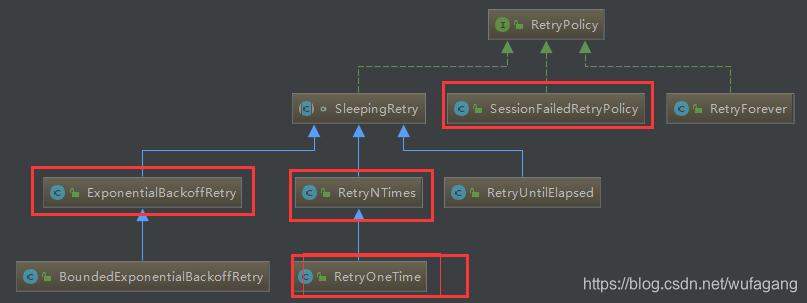

zookeeper基础学习之六: zookeeper java客户端curator

简介 Curator是Netflix公司开源的一套zookeeper客户端框架,解决了很多Zookeeper客户端非常底层的细节开发工作,包括连接重连、反复注册Watcher和NodeExistsException异常等等。Patrixck Hunt(Zookeeper)以一句“Guava is to Java…...

表查询)

MySQL数据库操作学习(2)表查询

文章目录 一、表查询1.表字段的操作①查看表结构②字段的增加③字段长度/数据类型的修改④字段名的修改⑤删除字符段⑥清空表数据⑦修改表名⑧删除表 2、表数据查询3、where 字段4、聚合函数 一、表查询 1.表字段的操作 ①查看表结构 desc 表名; # 查看表中的字段类型&#…...

Java学习

目录 treeSet StringBuilder treeSet TreeSet 是 Java 中实现了 Set 接口的一种集合类,它使用红黑树数据结构来存储元素,放到TreeSet集合中的元素: 无序不可重复,但是可以按照元素的大小顺序自动排序。 TreeSet一般会和Iterator迭代器一起使…...

C#八皇后算法:回溯法 vs 列优先法 vs 行优先法 vs 对角线优先法

目录 1.八皇后算法(Eight Queens Puzzle) 2.常见的八皇后算法解决方案 (1)列优先法(Column-First Method): (2)行优先法(Row-First Method)&a…...

springboot整合swagger,postman,接口规范

一、postman介绍 1.1概述 工具下载 Postman(发送 http 请求的工具) 官网(下载速度比较慢):Download Postman | Get Started for Free 网盘下载:百度网盘 请输入提取码 1.2Http 请求格式 请求地址请求方法状…...

029—pandas 遍历行非向量化修改数据

前言 在 pandas 中,向量化计算是指利用 pandas 对象的内置方法和函数,将操作应用到整个数据结构的每个元素,从而在单个操作中完成大量的计算。 但在一些需求中,我们无法使用向量化计算,就需要迭代操作,本例…...

相机安装位置固定后开始调试设备供电公司推荐使用方法

摄像头安装位置固定后开始调试 设备供电:无电源设备需要连接12V/2A电源并连接到摄像机的DC端口,而有电源的摄像机可以直接连接到220V电源。 连接设备:如果是有线连接,请使用网线将设备连接到电脑(建议直接连接&#…...

AI视频批量混剪系统|罐头鱼AI视频矩阵获客

AI视频批量混剪系统助您轻松管理和编辑视频素材 如今,视频营销已成为企业推广的重要方式。为了满足用户对视频管理、发布和编辑的需求,《罐头鱼AI视频批量混剪系统》应运而生。这款智能化系统集成了多种功能,助您轻松管理和发布精彩视频内容…...

线程池学习-了解,自定义线程池

什么是线程池,这个池字是什么 线程池,主要利用池化思想,线程池,字符串常量池等 为什么要有一个线程池? 正常线程的创建:1,手动创建一个线程 2.给该线程分配任务,线程执行任务 3…...

CentOS7.9 安装SIPp3.6

epel里面的SIPp版本比较旧,先不要epel yum remove -y epel-release okay有很多CentOS软件,可以这样安装: 编辑 /etc/yum.repos.d/okay.repo,内容为: [okay] nameExtra OKay Packages for Enterprise Linux - $basearc…...

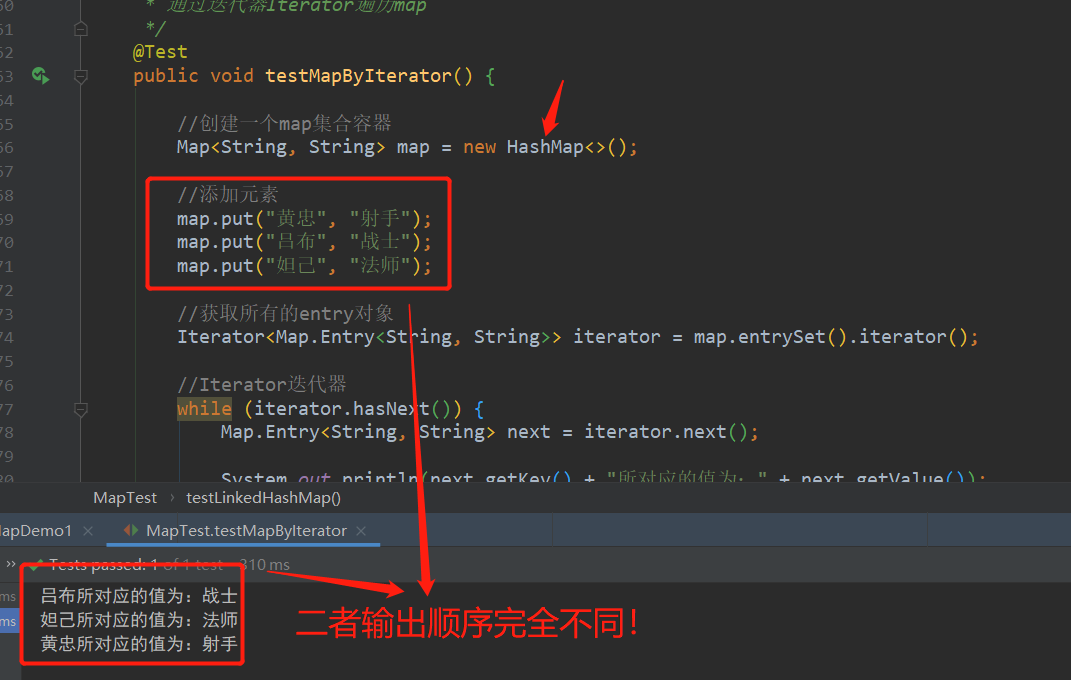

Java零基础入门-LinkedHashMap集合

一、本期教学目标 学习LinkedHashMap集合的概念及特点。学习LinkedHashMap存储结构。学习LinkedHashMap集合常用方法及示例代码演示。 二、正文 1、概述 我们学习了map接口之HashMap集合,今天我们要来学习map接口的另一个实现类-LinkedHashMap,不知道…...

LRC转SRT

最近看到一首很好的英文MTV原版,没又字幕,自己找字幕,只找到LRC,ffmpeg不支持LRC,网上在线转了SRT。 Subtitle Converter | Free tool | GoTranscript 然后用 ffmpeg 加字幕 ffmpeg -i LoveMeLikeYouDo.mp4 -vf sub…...

mybatis源码阅读系列(二)

前言 上一篇文章mybatis源码阅读系列(一)介绍了mybatis和原生jdbc的区别,并通过代码展示了两者的运行过程和结果,下面让我们继续详细了解下mybatis的执行过程; package com.wyl.mybatis.service;import com.wyl.mybat…...

【Web开发】CSS教学(超详细,满满的干货)

💓 博客主页:从零开始的-CodeNinja之路 ⏩ 收录文章:【Web开发】CSS教学(超详细,满满的干货) 🎉欢迎大家点赞👍评论📝收藏⭐文章 目录 CSS一. 什么是CSS?1.1 基本语法规范1.2 引入方式1.3 规范 二. CSS选…...

系列学习前端之第 5 章:学习 ES6 ~ ES11

1、什么是 ECMAScript ECMAScript 是由 Ecma 国际通过 ECMA-262 标准化的脚本程序设计语言。 从第 6 版开始,发生了里程碑的改动,并保持着每年迭代一个版本的习惯。 ES62015年,ES72016年,ES82017年,ES92018年&#…...

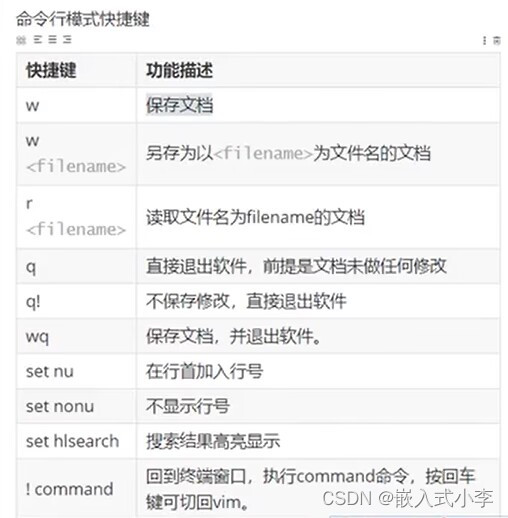

Linux学习(4)——使用编辑器

1.gedit编辑器 简单易懂,依赖图形界面。可以使用ctrlc ctrlv等快捷键,ctrls进行保存,与windows系统中相类似。 2.vi/vim编辑器 vi/vim可以直接通过控制台的终端完成文本的编辑,不依赖图形界面,使用范围更广。它的编辑…...

简单函数_短信计费

任务描述 用手机发短信,一条短信资费为0.1元,但限定一条短信的内容在70个字以内(包括70个字)。如果你一次所发送的短信超过了70个字,则会按照每70个字一条短信的限制把它分割成多条短信发送。假设已经知道你当月所发送…...

HTML 语义化

目录 HTML 语义化HTML5 新特性HTML 语义化的好处语义化标签的使用场景最佳实践 HTML 语义化 HTML5 新特性 标准答案: 语义化标签: <header>:页头<nav>:导航<main>:主要内容<article>&#x…...

springboot 百货中心供应链管理系统小程序

一、前言 随着我国经济迅速发展,人们对手机的需求越来越大,各种手机软件也都在被广泛应用,但是对于手机进行数据信息管理,对于手机的各种软件也是备受用户的喜爱,百货中心供应链管理系统被用户普遍使用,为方…...

从WWDC看苹果产品发展的规律

WWDC 是苹果公司一年一度面向全球开发者的盛会,其主题演讲展现了苹果在产品设计、技术路线、用户体验和生态系统构建上的核心理念与演进脉络。我们借助 ChatGPT Deep Research 工具,对过去十年 WWDC 主题演讲内容进行了系统化分析,形成了这份…...

在鸿蒙HarmonyOS 5中实现抖音风格的点赞功能

下面我将详细介绍如何使用HarmonyOS SDK在HarmonyOS 5中实现类似抖音的点赞功能,包括动画效果、数据同步和交互优化。 1. 基础点赞功能实现 1.1 创建数据模型 // VideoModel.ets export class VideoModel {id: string "";title: string ""…...

Redis相关知识总结(缓存雪崩,缓存穿透,缓存击穿,Redis实现分布式锁,如何保持数据库和缓存一致)

文章目录 1.什么是Redis?2.为什么要使用redis作为mysql的缓存?3.什么是缓存雪崩、缓存穿透、缓存击穿?3.1缓存雪崩3.1.1 大量缓存同时过期3.1.2 Redis宕机 3.2 缓存击穿3.3 缓存穿透3.4 总结 4. 数据库和缓存如何保持一致性5. Redis实现分布式…...

vue3+vite项目中使用.env文件环境变量方法

vue3vite项目中使用.env文件环境变量方法 .env文件作用命名规则常用的配置项示例使用方法注意事项在vite.config.js文件中读取环境变量方法 .env文件作用 .env 文件用于定义环境变量,这些变量可以在项目中通过 import.meta.env 进行访问。Vite 会自动加载这些环境变…...

Swagger和OpenApi的前世今生

Swagger与OpenAPI的关系演进是API标准化进程中的重要篇章,二者共同塑造了现代RESTful API的开发范式。 本期就扒一扒其技术演进的关键节点与核心逻辑: 🔄 一、起源与初创期:Swagger的诞生(2010-2014) 核心…...

使用 Streamlit 构建支持主流大模型与 Ollama 的轻量级统一平台

🎯 使用 Streamlit 构建支持主流大模型与 Ollama 的轻量级统一平台 📌 项目背景 随着大语言模型(LLM)的广泛应用,开发者常面临多个挑战: 各大模型(OpenAI、Claude、Gemini、Ollama)接口风格不统一;缺乏一个统一平台进行模型调用与测试;本地模型 Ollama 的集成与前…...

AI+无人机如何守护濒危物种?YOLOv8实现95%精准识别

【导读】 野生动物监测在理解和保护生态系统中发挥着至关重要的作用。然而,传统的野生动物观察方法往往耗时耗力、成本高昂且范围有限。无人机的出现为野生动物监测提供了有前景的替代方案,能够实现大范围覆盖并远程采集数据。尽管具备这些优势…...

【Android】Android 开发 ADB 常用指令

查看当前连接的设备 adb devices 连接设备 adb connect 设备IP 断开已连接的设备 adb disconnect 设备IP 安装应用 adb install 安装包的路径 卸载应用 adb uninstall 应用包名 查看已安装的应用包名 adb shell pm list packages 查看已安装的第三方应用包名 adb shell pm list…...