GPT系列模型的特点

GPT系列模型(包括GPT-1、GPT-2和GPT-3)都基于自回归机制的Transformer架构。在设计上,这些模型的核心思想是利用Transformer架构来捕捉整个序列的上下文信息,通过其独特的自回归机制逐步地整合整个序列的完整语义。GPT系列模型的设计旨在利用Transformer的强大功能高效且精准地整合整个文本序列的语义信息,并通过逐词递归预测的方式生成高质量、连贯的新文本。

-

Transformer架构:GPT模型摒弃了循环神经网络(RNN)在处理长序列时可能存在的梯度消失或梯度爆炸问题,转而采用Transformer架构。Transformer的核心是自注意力机制,该机制允许模型并行地考虑输入序列的所有位置信息,从而能够对整个上下文进行全局建模。

-

上下文信息捕获:每个Transformer层的自注意力机制可以理解为一种“关注”机制,它让模型有能力根据当前词与其他所有词之间的关联来理解词义。通过多头自注意力(Multi-Head Attention),模型可以从不同角度捕捉和融合上下文信息。

-

自回归生成:GPT模型在训练时以自回归方式工作,即预测下一个单词的概率基于之前已经生成的序列内容。具体而言,在解码过程中,模型会先看到序列的一部分,然后预测下一个最可能的单词;接着将这个预测出的单词与已有的序列拼接起来,继续预测下一个单词,如此反复,直到生成完整序列。 自回归机制是GPT系列模型设计的核心之一。在处理序列数据时(如文本),自回归模型每次预测下一个元素(例如一个词)时,都会基于它之前生成的所有元素的信息进行计算。这意味着模型通过自身的反馈循环结构,逐步地将过去生成的上下文信息整合到当前时刻的预测中。

预训练阶段:

具体来说,在预训练阶段,模型通过学习从一个词预测下一个词的过程中不断积累对上下文的理解。每一步预测时,模型会根据到目前为止生成的所有词汇构建一个上下文向量表示,这个向量融合了之前所有词的信息。Transformer中的自注意力机制允许模型在计算当前位置的输出时考虑序列中任意位置的历史输入,从而确保模型能够理解并利用全局上下文。

具体来说,在训练阶段,模型会根据输入序列的一部分来预测序列中的下一个 token,并且在预测过程中不断向右移动窗口,直到遍历完整个序列。这种预测过程使得模型能够从左至右学习到整个句子或段落的上下文依赖关系。

生成过程:

在生成过程中,GPT模型依据当前时刻已生成的部分文本(即上下文),预测下一个最可能的词。每一次预测都是在前一次预测的基础上进行更新,形成一种链式反应,因此随着每次迭代,新生成的词都会进一步影响后续预测,确保整体生成的内容与历史上下文保持一致性和连贯性。

而在生成新文本时,模型会用同样的方式运作:给定一个起始token(或者称为“prompt”),模型基于这个起始信息预测下一个最可能的token,然后将这个预测的token添加到已生成的部分,作为下一轮预测的上下文输入。如此反复迭代,直至生成满足预设条件(比如达到某个终止符号或最大长度限制)的完整文本序列。

自回归Transformer架构确保了GPT系列模型能够有效地捕捉和利用长距离的上下文依赖性,从而生成连贯、有逻辑的文本内容。所以,无论是预训练还是实际应用中的文本生成任务,GPT系列模型都能够通过其独特的自回归架构逐步地整合整个序列的完整语义。

1. 一组重要的概念

几个概念紧密相关且共同构成了Transformer架构模型的基础:

-

Token:

Token是文本序列的基本单元。当我们将一段文本输入到模型时,首先会通过分词器将其分割成一个个离散的单元,每个单元就是一个token。这可以是一个单词、子词或者字符,取决于模型的设计和预处理步骤。 -

向量表示:

为了使机器学习模型能够理解和处理文本信息,我们需要将这些token转化为数值形式。这一过程通常称为词嵌入或编码,其中每个token被映射为一个固定维度的向量。这种向量不仅包含了该token本身的语义信息,还可能包含其上下文中的相关信息。 -

上下文变量表示:

在自回归模型如GPT中,每个token的表示不仅要考虑它自身的嵌入,还要结合其在整个序列中的上下文信息。Transformer模型利用多头注意力机制,使得每个位置的token能够基于所有其他位置的token计算出一个加权求和的上下文向量表示。这个表示既包含了当前token自身的特征,也融入了整个序列的全局依赖关系。 -

注意力输出:

在Transformer结构中,注意力机制是核心组件之一,它负责计算上下文向量表示。通过自注意力机制,模型为序列中的每个位置生成一个上下文相关的输出向量,这个输出集合即为“注意力输出”。每个位置的注意力输出向量都是对其它所有位置的token进行加权组合后得到的结果,权重系数反映了不同位置之间的关联程度。

总结来说,在GPT这样的自回归模型中,每个token先经过嵌入层转换为向量表示,然后通过自注意力机制计算其在上下文中的表示,最后得出的注意力输出作为后续解码预测下一个token时的关键依据。

2.从文本数据到数学向量形式

文本数据转换为机器可理解和运算的数学向量形式通常涉及以下几种主要方法:

-

词袋模型(Bag of Words, BoW):

在词袋模型中,将文本看作一个词汇集合,忽略其语法和语序信息。每个文档通过计算其中各个单词出现的频率或TF-IDF值形成一个向量,该向量的维度与词汇表大小一致。 -

词嵌入(Word Embeddings):

词嵌入是一种将单词映射到固定长度连续向量空间的技术,例如:- FastText: 类似于Word2Vec,但考虑到词内部的子结构,尤其对于多义词和未登录词有更好的表现。

- GloVe (Global Vectors for Word Representation): 基于全局统计信息,同时考虑了共现矩阵中的局部窗口信息和全局统计信息来生成词向量。

- Word2Vec: 提供了CBOW和Skip-gram两种训练方法来学习单词的分布式表示,使得在向量空间中相似含义的词距离较近。

-

预训练语言模型产生的嵌入:

近年来流行的如BERT (Bidirectional Encoder Representations from Transformers)、**GPT (Generative Pre-training Transformer)**系列模型等,在大规模无标签文本上进行预训练后得到词嵌入,这些嵌入不仅包含词级别的信息,还包含了上下文信息,能够更好地表达词义在不同语境下的变化。 -

句子/文档级别向量化:

对于整个句子或文档,可以通过诸如平均池化、最大池化或更复杂的Transformer编码器输出层的特征向量组合等方式将其内部所有词嵌入整合成一个向量表示。

通过上述过程,文本数据就被转换成了数值型的向量表示,从而让机器学习算法能够基于数学运算理解文本内容,并应用于分类、聚类、检索等各种自然语言处理任务中。

3.预训练语言模型产生的嵌入

预训练语言模型产生的嵌入是一种先进的文本表示方法,它通过预先在大规模无标签文本语料库上进行训练,学习到每个单词、短语甚至整个句子的向量表示。这些模型不仅捕捉词汇本身的含义,还能捕获上下文信息,即一个词在不同的语境中可能具有的不同含义。

预训练语言模型的核心价值之一在于它能够通过大规模无标签文本数据集上的自监督学习过程,将自然语言中的单词、短语和句子映射到高维向量空间中。这些向量(嵌入)编码了丰富的语义和上下文信息。

例如,在BERT或GPT等模型中,每个单词在输入时都会被转换为一个固定长度的向量,而模型在训练过程中会自动学习如何根据上下文调整这个向量表示,以便于完成各种预测任务。对于整个句子,模型通常会生成一个句向量,该向量综合反映了句子的整体含义。

这种基于深度神经网络的学习方式使得模型可以捕捉到词汇的复杂关系,如同义词、反义词、多义词以及语法结构和语义依赖等。在预训练完成后,模型产生的嵌入可以作为通用的语言特征应用于下游的各种自然语言处理任务中,显著提高了对未见过的新样本的理解和处理能力。

以下是一些著名的预训练语言模型及其产生的嵌入:

-

BERT (Bidirectional Encoder Representations from Transformers):

BERT 使用Transformer架构,并通过遮蔽语言模型(Masked Language Model, MLM)和下一句预测任务(Next Sentence Prediction, NSP)来预训练模型。对于输入的每一个位置,BERT都可以生成一个上下文相关的向量表示,可以根据需要提取单个词或整个句子的向量表示。 -

GPT (Generative Pre-training Transformer) 系列:

GPT-1、GPT-2、GPT-3等模型是基于自回归Transformer结构的预训练模型,主要通过预测下一个词的方式进行预训练。这些模型可以生成高质量的连续文本,同时其内部隐藏状态可用于获取词或序列级别的嵌入。 -

ELMo (Embeddings from Language Models):

ELMo 提供了深度双向的语言模型表示,输出的是不同层级的上下文敏感的词向量,这些向量可以线性组合后用于下游任务。 -

Transformer-XL, XLNet, RoBERTa 等:

这些模型都是在BERT的基础上进行了改进,比如Transformer-XL引入了长期依赖建模机制,XLNet使用了自回归的变形Permutation Language Modeling(PLM),RoBERTa则优化了BERT的训练细节和数据处理方式,以提高性能表现。

在实际应用中,对预训练模型微调(fine-tuning)时,可以直接利用模型层的输出作为特定任务的特征向量,或者直接提取预训练得到的嵌入向量作为通用的词或句子表示,应用于多种NLP任务中,如分类、问答系统、情感分析等。

4.嵌入向量编码了丰富的语义和上下文信息

这些通过预训练生成的词向量或嵌入(embeddings)在自然语言处理中扮演着至关重要的角色。对于每个单词、短语乃至整个句子,模型会生成一个高维连续向量,其中蕴含了丰富的语义和上下文信息:

-

语义信息:相似含义的词汇在向量空间中的位置相近,例如,“大”和“巨大”的向量表示可能会有较大的重叠部分。

-

上下文敏感性:在像BERT这样的Transformer架构中,上下文相关的嵌入意味着同一个单词在不同的上下文中会有不同的向量表示,从而能够捕捉到多义性和依赖于前后文的语义变化。

-

语法结构:尽管不是所有模型都能直接编码复杂的语法结构,但深度学习模型在学习过程中也有可能捕捉到词汇间的句法关系。

-

潜在关联:向量空间中的数学操作(如加减乘除)有时能够在某种程度上反映词汇之间的逻辑关系,比如类比推理("国王" - "男性" + "女性" ≈ "女王")。

通过这种方式,预训练模型生成的嵌入可以作为非常有效的特征输入,极大地提升了后续任务(如文本分类、问答系统、机器翻译等)的表现效果。

5.GPT系列模型的内部隐藏状态

GPT-1、GPT-2和GPT-3是由OpenAI开发的一系列基于自回归Transformer架构的预训练语言模型。这些模型在无监督设置下通过大量文本数据进行训练,其核心目标是对给定上下文下的下一个词进行预测。这些模型可以生成高质量的连续文本,同时其内部隐藏状态可用于获取词或序列级别的嵌入。

具体来说:

-

在自回归的方式中,模型在训练过程中每次仅关注当前输入序列的一部分,并预测下一个最可能出现的词。随着训练的进行,模型逐渐学习到语言的概率分布规律以及词汇间的语义关联。

-

隐藏状态或内部表示层(嵌入)在处理每个词时会积累并整合之前的上下文信息(向量表示)。因此,在生成文本的过程中,每个词的嵌入不仅包含该词本身的含义,还包含了生成这个词之前的所有历史信息。

-

这些模型的输出可以用于多种下游任务,例如文本生成、问答系统、摘要生成等,而它们的内部嵌入则能够作为高质量的特征向量应用于其他自然语言处理任务,如情感分析、命名实体识别等,只需经过微调或进行简单的线性映射即可适应新任务的要求。

GPT-3相较于前代模型,在参数数量上有显著增加,从而具备了更强的泛化能力和更丰富的语言理解与生成能力,其生成的文本质量和连贯性令人印象深刻。

内部隐藏状态

在GPT系列模型中,内部隐藏状态(或称隐藏层的输出)是模型处理过程中关键的中间结果。当模型接收输入序列并经过多层Transformer结构的自注意力机制计算后,每一层都会产生对应的隐藏状态向量。这些隐藏状态不仅包含了当前词的信息,还整合了整个上下文中的相关信息。

对于词级别的嵌入,每个词的位置在自注意力机制的作用下会生成一个独特的隐藏状态向量,这个向量可以视为对该词在特定上下文下的语义表示。

具体而言,在处理一个序列时,模型首先对输入序列中的每个词进行嵌入操作,生成初始的词嵌入向量。然后,在自注意力机制的作用下,模型会根据整个序列的信息动态地调整每个词的权重,使得每个词都能够考虑到它在整个句子或段落中的上下文信息。最后,对于每一个词的位置i,其对应的隐藏状态向量能够综合反映这个词在当前语境下的含义,从而提供一种更为精确和丰富的语义表示。

因此,这样的词级别嵌入不仅包含了词本身的固有含义,还融合了其与上下文中其他词的关系,这对于自然语言处理任务(如情感分析、命名实体识别、机器翻译等)来说至关重要。

对于序列级别的嵌入,通常是指整个输入序列在模型最后一层(或特定层)的上下文相关的汇总信息。例如,在GPT模型的编码部分结束后,可以根据需要获取序列最后一个位置的隐藏状态,将其作为整个序列的“句向量”或者“段落向量”,用于捕获序列的整体含义和上下文依赖。

因此,通过GPT模型内部的隐藏状态,研究者和开发者能够提取出高质量、具有丰富上下文信息的词级别和序列级别的嵌入,进而应用于各种自然语言处理任务中。

6.GPT模型的自回归机制、嵌入表示和内部隐藏状态

GPT(Generative Pre-trained Transformer)模型的自回归机制、嵌入表示以及内部隐藏状态之间存在着密切的关系,它们共同作用以实现自然语言理解和生成任务。下面详细解释这三者之间的关系:

-

嵌入表示:

- 在GPT模型中,每个输入序列的单词首先通过一个词嵌入层转化为低维向量,这个过程将高维的离散词汇空间映射到连续的稠密向量空间。

- 词嵌入使得模型能够捕捉词汇之间的语义和语法相似性,为后续处理提供统一且丰富的初始特征表示。

-

内部隐藏状态:

- 经过词嵌入后,这些向量被送入多层Transformer结构中,每一层包含自注意力机制和前馈神经网络(也称为全连接层)。

- 每一层的自注意力机制会根据当前词及其上下文信息计算出新的隐藏状态表示,这些隐藏状态反映了单词在句子中的语境依赖关系。

- 隐藏状态在每一层中不断更新并传递给下一层,形成一种深度学习架构下的多层次抽象表示。

-

自回归机制:

- 自回归特性体现在解码阶段,即模型在生成文本时,每次只预测下一个词的概率分布。

- 在训练过程中,GPT模型基于上一时刻(或之前所有时刻)预测出的词来预测当前时刻的词,而当前时刻的预测不会看到未来时刻的信息,这样就保证了生成序列的条件独立性。

- 在实际应用时,模型会依据当前时刻的隐层状态(即考虑了历史生成信息的上下文向量)进行预测,然后用预测出的词更新隐层状态,并继续预测下一个词,如此循环直至生成完整序列。

总结来说,在GPT模型中,嵌入表示用于初始化单词的向量表示,内部隐藏状态则通过Transformer层捕获复杂的上下文依赖,而自回归机制确保模型在生成过程中按照时间顺序逐步构建输出序列,每一步都充分利用了之前生成的词所蕴含的信息。

相关文章:

GPT系列模型的特点

GPT系列模型(包括GPT-1、GPT-2和GPT-3)都基于自回归机制的Transformer架构。在设计上,这些模型的核心思想是利用Transformer架构来捕捉整个序列的上下文信息,通过其独特的自回归机制逐步地整合整个序列的完整语义。GPT系列模型的设…...

Oracle Data Guard常用命令

--查询数据库角色和保护模式 select database_role,switchover_status from v$database; --切换备库为主库(切换后,主库为mount状态) --TO PRIMARY alter database commit to switchover to primary; --SESSIONS ACTIVE alter database comm…...

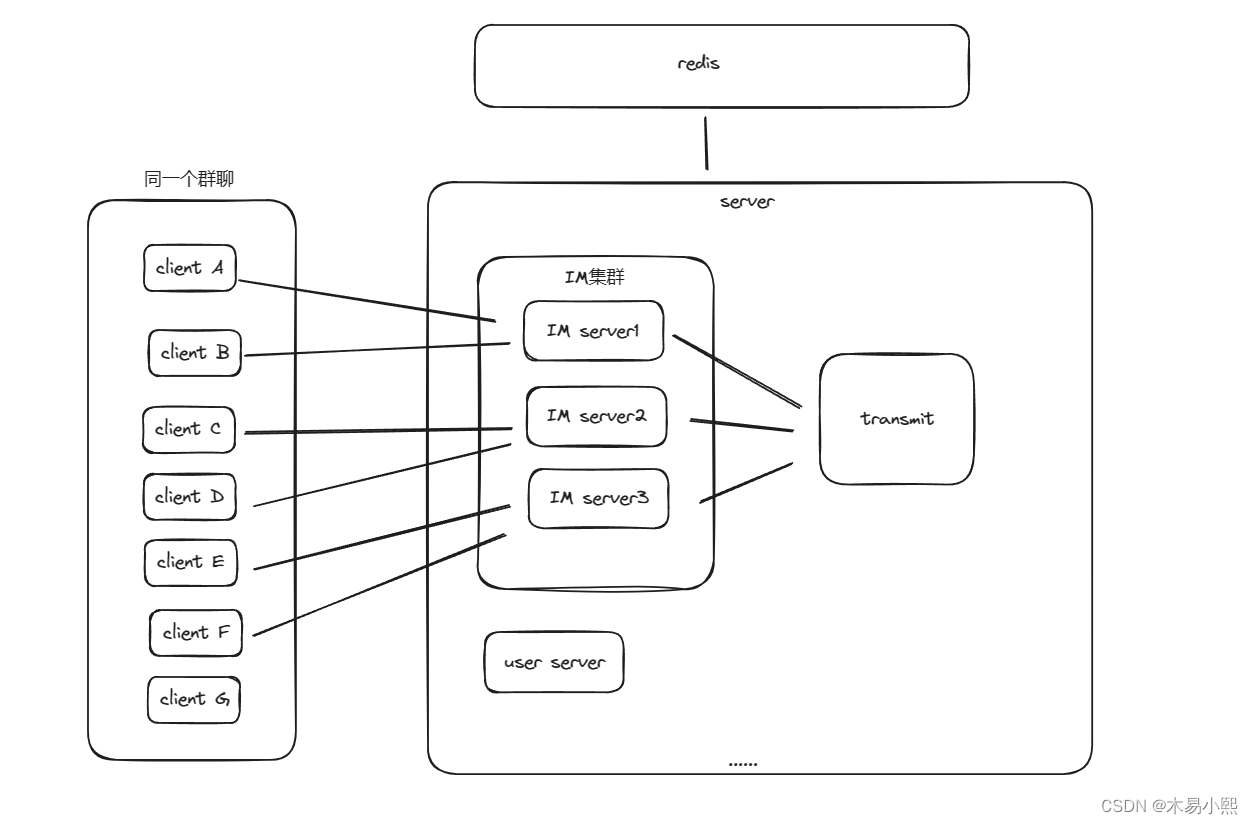

IM系统设计之websocket消息转发

Websocket消息转发 项目地址:gitgithub.com:muyixiaoxi/Link.git 上周面试被面试官问到:“在分布式IM系统中,如何实现多个websocket集群之间的通信”。 我在思考了良久后回答:“不会”。 随着我的回答,我和面试官的…...

关于vue 的生命周期的教程

Vue.js 是一款流行的前端框架,它提供了丰富的功能和便捷的开发式, 其中生命周期函数是 Vue 组件中非常重要的一部分。 本文将为您详细介绍 Vue 组件的生命周期函数及其执行顺序, 帮助您更好地理解和利用 Vue.js 框架。 什么是 Vue 生命周期 …...

STM32 CAN的工作模式

STM32 CAN的工作模式 正常模式 正常模式下就是一个正常的CAN节点,可以向总线发送数据和接收数据。 静默模式 静默模式下,它自己的输出端的逻辑0数据会直接传输到它自己的输入端,逻辑1可以被发送到总线,所以它不能向总线发送显性…...

Java中的常用类之Math类

Java中的Math类 一、Math类是什么?二、主要方法1.随机数2.绝对值3.向上取值4.向下取值5.四舍五入6.两个值中取大/小的 总结 一、Math类是什么? Math类是Java常用类的一种,主要方法针对于数学方面的运算,类中的所有方法都是static…...

Android冷启动优化

一、应用启动的三种状态 冷启动:系统不存在App进程(APP首次启动或APP被完全杀死)时启动APP,此时,APP的启动将经历两个阶段: 1、创建app进程:系统启动应用程序进程和虚拟机,创建app…...

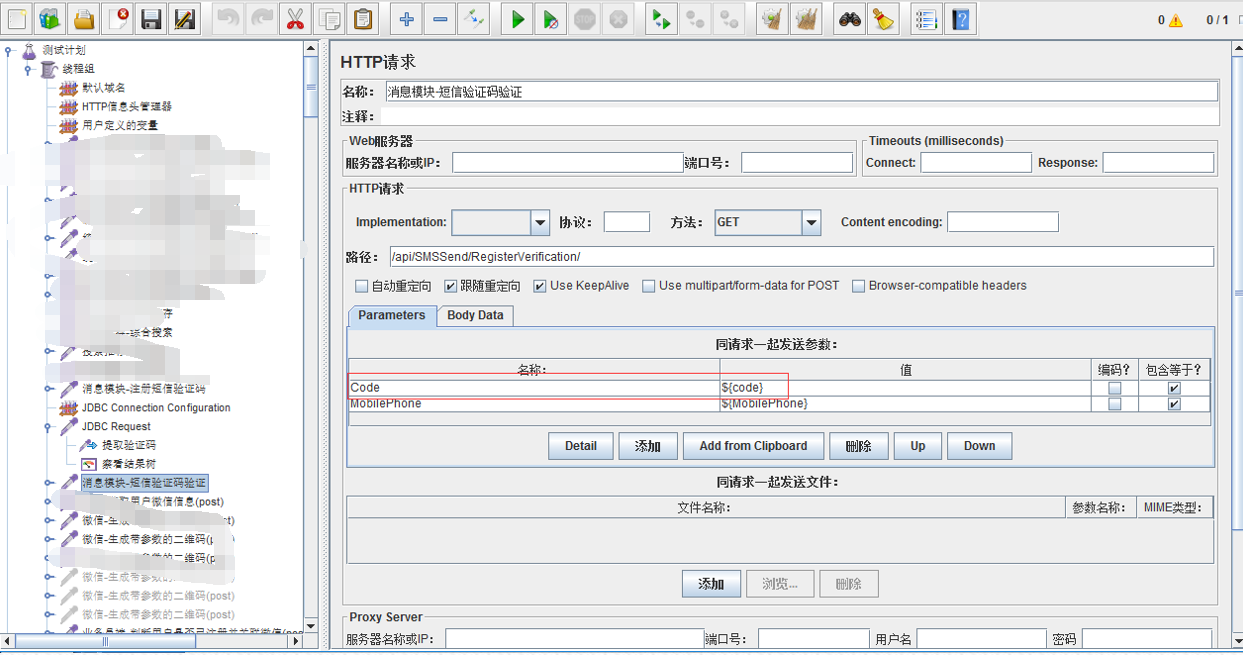

jmeter之接口功能自动化

一、接口测试简述 接口:用来连接前端,后端还有移动端的程序模块。由于不同端的工作进度不一样,需要对最开始出来的接口进行接口测试。 接口分类:POST,GET,PUT,DELETE。 POST请求的数据是放在…...

【openGL4.x手册07】几何着色器

目录 一、说明二、关于几何着色器三、原始输入/输出规范3.1 实例 四、输入五、输出5.1 分层渲染 六、输出限制 一、说明 几何着色器对于渲染管线设计是一个新生事物;目前对应于几何着色器的资料不多,并且说法不一,因此如何用几何着色器&…...

鸿蒙OpenHarmony开发实战:【MiniCanvas】

介绍 基于OpenHarmony的Cavas组件封装了一版极简操作的MiniCanvas,屏蔽了原有Canvas内部复杂的调用流程,支持一个API就可以实现相应的绘制能力,该库还在继续完善中,也欢迎PR。 使用说明 添加MiniCanvas依赖 在项目entry目录执行…...

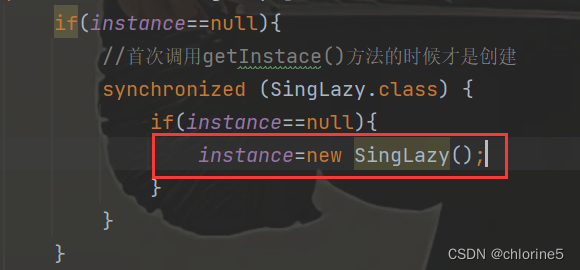

【JavaEE初阶系列】——单例模式 (“饿汉模式“和“懒汉模式“以及解决线程安全问题)

目录 🚩单例模式 🎈饿汉模式 🎈懒汉模式 ❗线程安全问题 📝加锁 📝执行效率提高 📝指令重排序 🍭总结 单例模式,非常经典的设计模式,也是一个重要的学科&#x…...

flutter-elinux的基本介绍及安装调试

搜集到两个很有用的网站: 1、flutter-elinux的基本介绍:https://juejin.cn/post/7257285697383612453 2、flutter-elinux的安装调试等:https://github.com/sony/flutter-elinux/wiki 其中,在flutter-elinux设置环境变量时&#…...

二分查找法总结

目录 1、思路讲解(LC704)2、代码思路讲解(循环不变量)(1) 左闭右闭(2)左闭右开(3)总结:左开右闭和左闭右开(4)复杂度分析 …...

Python工具-清理Unity(批量深度)清理U3D项目工程保留关键工程文件

前沿 1. Unity工程越来越多,很久不用的工程里存在了很多无用的大文件夹,极大的影响电脑容量。 2. 我电脑里面U3D工程只有17个,但容量就高达60GB,使用自己编写的工具清理后,减到了30GB多。清理了不是很重要的文件和文件…...

vue 安装脚手架报错 certificate has expired

vue 安装脚手架的时候报错,报错信息如下: 错误信息:npm ERR! request to https://registry.npm.taobao.org/vue%2fcli failed, reason: certificate has expired 翻译:npm ERR!请求到https://registry.npm.taobao.org…...

使用 Python 快速开始机器学习

🔗 快速开始 PyTorch|使用 Python 建立深度学习模型 认识 PyTorch 1.1 Torch 与 PyTorch 1.2 安装 PyTorch 1.3 验证安装并查看 PyTorch 版本PyTorch 深度学习模型的建立范式 2.1 准备数据 2.2 定义模型 2.3 训练模型 2.4 评估模型 2.5 做出预测为预测任…...

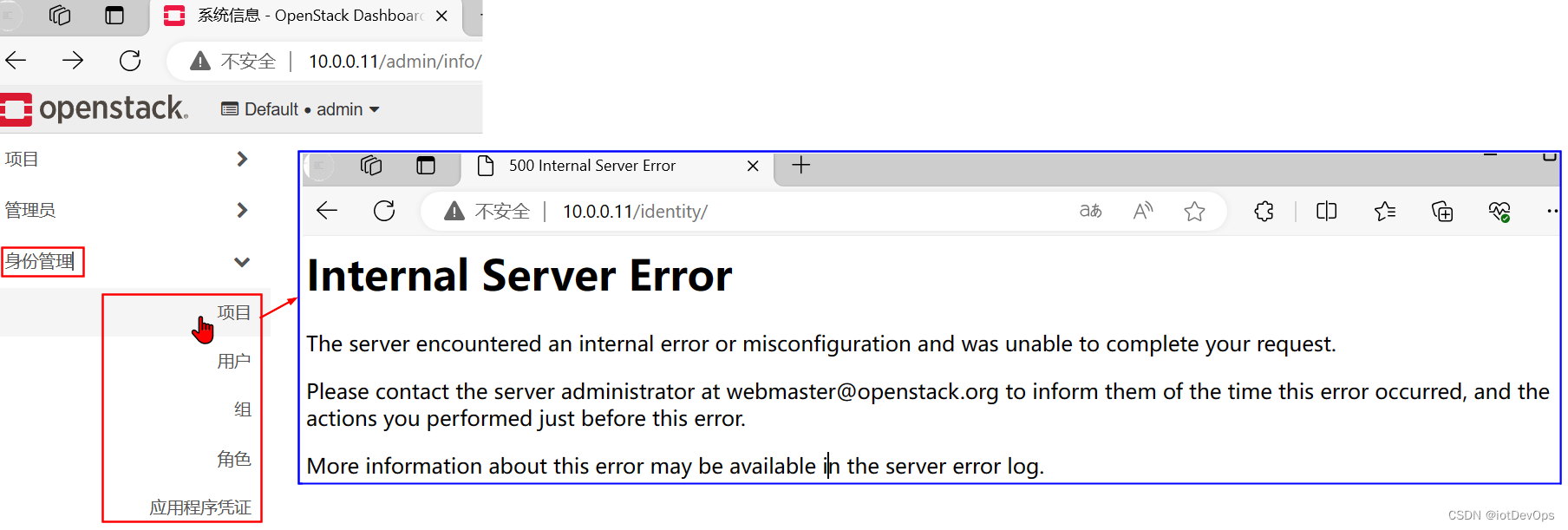

CCDP.02.OS正确部署后的Dashboard摘图说明

前言 在部署成功OpenStack后,应该可以在浏览器打开Dashboard,并对计算资源(这里主要是指VM)进行管理,也可以在Dashboard上面查看OpenStack是否存在错误,下面,已针对检查的关键点,用红…...

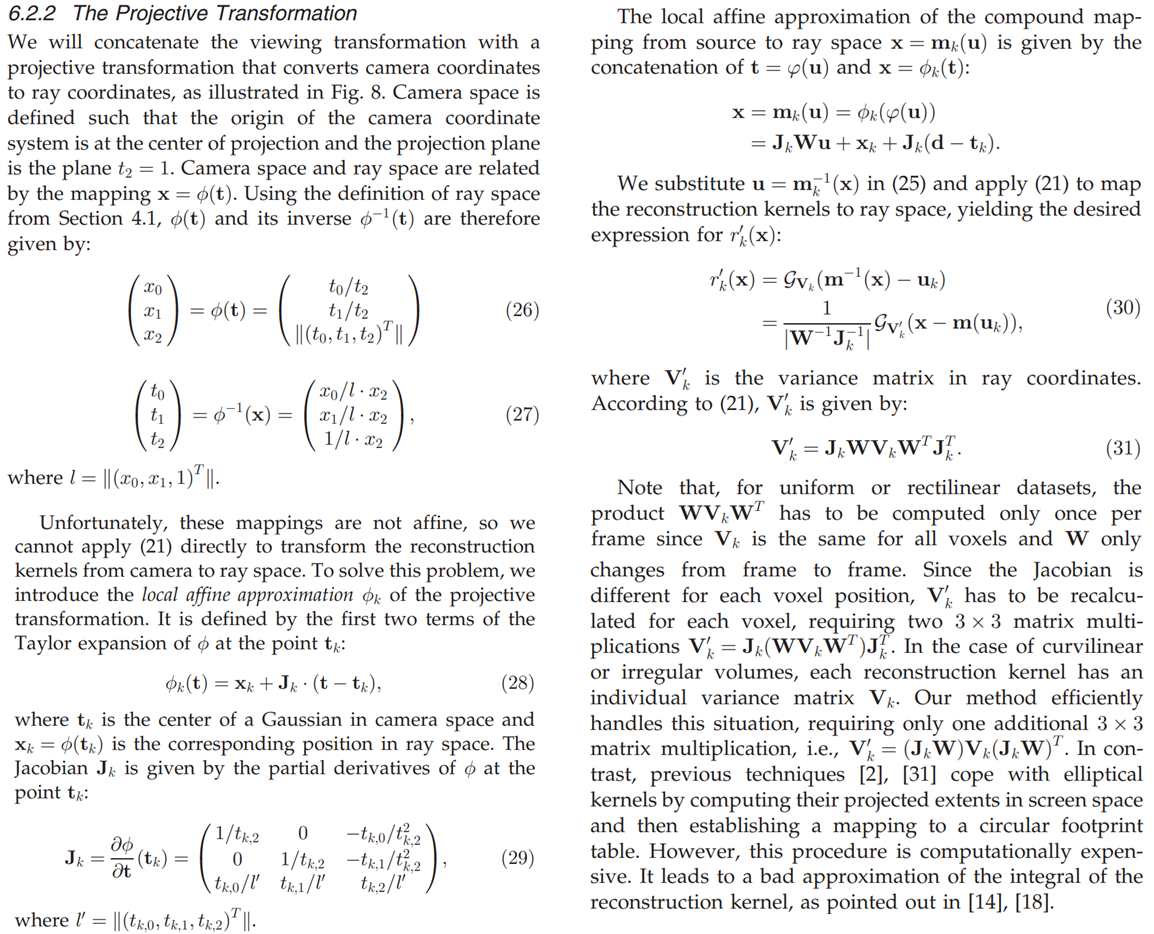

【计算机视觉】Gaussian Splatting源码解读补充(二)

第一部分 本文是对学习笔记之——3D Gaussian Splatting源码解读的补充,并订正了一些错误。 目录 三、相机相关scene/cameras.py:class Camera 四、前向传播(渲染):submodules/diff-gaussian-rasterization/cuda_rast…...

Java transient 关键字

Java字段不想序列化怎么办 在 Java 中,如果某个字段不想被序列化(即不希望被写入到序列化的数据流中),可以使用 transient 关键字进行标记。通过在字段前加上 transient 关键字,可以告诉 Java 序列化机制忽略该字段&am…...

邂逅Webpack和打包过程)

前端工程化(三)邂逅Webpack和打包过程

目录 Vue项目加载Webpack 安装Webpack的默认打包创建局部的 webpack Vue项目加载 JavaScript的打包: 将ES6转换成ES5的语法; TypeScript的处理,将其转换成JavaScript; Css的处理: CSS文件模块的加载、提取&a…...

java_网络服务相关_gateway_nacos_feign区别联系

1. spring-cloud-starter-gateway 作用:作为微服务架构的网关,统一入口,处理所有外部请求。 核心能力: 路由转发(基于路径、服务名等)过滤器(鉴权、限流、日志、Header 处理)支持负…...

shell脚本--常见案例

1、自动备份文件或目录 2、批量重命名文件 3、查找并删除指定名称的文件: 4、批量删除文件 5、查找并替换文件内容 6、批量创建文件 7、创建文件夹并移动文件 8、在文件夹中查找文件...

基于Flask实现的医疗保险欺诈识别监测模型

基于Flask实现的医疗保险欺诈识别监测模型 项目截图 项目简介 社会医疗保险是国家通过立法形式强制实施,由雇主和个人按一定比例缴纳保险费,建立社会医疗保险基金,支付雇员医疗费用的一种医疗保险制度, 它是促进社会文明和进步的…...

质量体系的重要

质量体系是为确保产品、服务或过程质量满足规定要求,由相互关联的要素构成的有机整体。其核心内容可归纳为以下五个方面: 🏛️ 一、组织架构与职责 质量体系明确组织内各部门、岗位的职责与权限,形成层级清晰的管理网络…...

Frozen-Flask :将 Flask 应用“冻结”为静态文件

Frozen-Flask 是一个用于将 Flask 应用“冻结”为静态文件的 Python 扩展。它的核心用途是:将一个 Flask Web 应用生成成纯静态 HTML 文件,从而可以部署到静态网站托管服务上,如 GitHub Pages、Netlify 或任何支持静态文件的网站服务器。 &am…...

【JavaSE】绘图与事件入门学习笔记

-Java绘图坐标体系 坐标体系-介绍 坐标原点位于左上角,以像素为单位。 在Java坐标系中,第一个是x坐标,表示当前位置为水平方向,距离坐标原点x个像素;第二个是y坐标,表示当前位置为垂直方向,距离坐标原点y个像素。 坐标体系-像素 …...

零基础在实践中学习网络安全-皮卡丘靶场(第九期-Unsafe Fileupload模块)(yakit方式)

本期内容并不是很难,相信大家会学的很愉快,当然对于有后端基础的朋友来说,本期内容更加容易了解,当然没有基础的也别担心,本期内容会详细解释有关内容 本期用到的软件:yakit(因为经过之前好多期…...

OPENCV形态学基础之二腐蚀

一.腐蚀的原理 (图1) 数学表达式:dst(x,y) erode(src(x,y)) min(x,y)src(xx,yy) 腐蚀也是图像形态学的基本功能之一,腐蚀跟膨胀属于反向操作,膨胀是把图像图像变大,而腐蚀就是把图像变小。腐蚀后的图像变小变暗淡。 腐蚀…...

Springboot社区养老保险系统小程序

一、前言 随着我国经济迅速发展,人们对手机的需求越来越大,各种手机软件也都在被广泛应用,但是对于手机进行数据信息管理,对于手机的各种软件也是备受用户的喜爱,社区养老保险系统小程序被用户普遍使用,为方…...

LeetCode - 199. 二叉树的右视图

题目 199. 二叉树的右视图 - 力扣(LeetCode) 思路 右视图是指从树的右侧看,对于每一层,只能看到该层最右边的节点。实现思路是: 使用深度优先搜索(DFS)按照"根-右-左"的顺序遍历树记录每个节点的深度对于…...