如何利用IPIDEA代理IP优化数据采集效率?

- 一、 前言

- 二、 IPIDEA介绍

- 三、体验步骤

- 四、实战训练

- 五、结语

一、 前言

在全球化与信息化交织的当代社会,数据已成为驱动商业智慧与技术革新的核心引擎。网络,作为信息汇聚与交流的枢纽,不仅是人们获取知识的窗口,更是商业活动与技术创新的广阔舞台。在这个信息繁荣的时代,Python网络爬虫成为采集、分析大数据的重要工具,但实际操作中却常遇挑战。

这里简单介绍一下,什么是网络爬虫:网络爬虫是一种自动化程序,能够遍历互联网上的不同网页,并提取其中的信息,这些信息可以是文本、图像、视频等各种形式的数据。我们可按需提取所需要的各种数据,以供后续分析和应用。

然而,网络环境复杂,信息来源丰富但分散,导致网络爬虫的效率大打折扣。即使爬虫技术本身已经相当成熟,但面对海量的信息和复杂的网络环境,仍然难以保证高效的数据采集。

代理IP技术,作为一种可行的解决方案,可以更加灵活地进行数据爬取,避免被网站识别为异常访问,从而提高数据采集的速度和稳定性,为商业决策和技术创新提供有力的数据支持。

本人也测试过很多的代理IP品牌,有一款用下来体验很不错的品牌——IPIDEA

二、 IPIDEA介绍

IPIDEA在一众提供海外代理IP的品牌中,名气还是挺大的,主要确实很好用。

IPIDEA很多优点,比如覆盖的国家多、提供真实的住宅IP、连接很稳定、支持大量并发、有专门的技术团队提供支持等。在这我就简单讲解几点,就不一一完全列举出来了。

1. 全球覆盖: IPIDEA 在全球各地部署了服务器,我们可以根据需要选择不同地区的代理 IP,实现全球范围的公开访问和爬虫需求。目前覆盖了包括美国、英国、加拿大、印度、韩国等热门国家在内的220多个国家和地区,提供超9000万IP数量。

2. 多种代理方案:IPIDEA目前为提供了5种解决方案:

动态住宅、 静态住宅、 独享数据中心、 动态长效ISP、 动态数据中心。一般网络爬虫主要使用到的是“动态住宅”,它能实现公开数据爬虫率大于99.9%。

动态住宅代理:与静态代理IP有所不同。静态代理IP在连接后一直保持不变,而动态住宅代理IP则会在一段时间内动态变化,可进行类真人的网络爬虫。

如果我一个师兄使用了IPIDEA动态住宅代理,那IP地址可能会每隔一段时间就会轮换,比如每隔几分钟、几小时或者每请求一次换一下,这可以更好地隐私保护,提高爬虫的效率。

下面代码演示如何实现动态住宅代理IP的自动轮换:

import requests

from bs4 import BeautifulSoup

import random

import time# 定义代理IP列表

proxy_list = [{'ip': 'YOUR_PROXY_IP_1', 'port': 'YOUR_PROXY_PORT_1'},{'ip': 'YOUR_PROXY_IP_2', 'port': 'YOUR_PROXY_PORT_2'},# 添加更多代理IP...

]# 定义目标网站列表

target_urls = ['https://www.amazon.com/','https://support.reddithelp.com/',# .......

]# 随机选择一个代理IP

def get_random_proxy():return random.choice(proxy_list)# 发送带代理的请求

def send_request(url, proxy):try:response = requests.get(url, proxies=proxy)if response.status_code == 200:return response.textelse:print("请求失败 状态码:", response.status_code)return Noneexcept requests.exceptions.RequestException as e:print("发生异常:", e)return None# 解析页面内容

def parse_content(html):soup = BeautifulSoup(html, 'html.parser')# 根据需要提取相关数据例如,找到页面中的链接、文本内容等return soup# 主程序

def main():for url in target_urls:# 随机选择一个代理IPproxy = get_random_proxy()proxy_url = f"http://{proxy['ip']}:{proxy['port']}"proxies = {'http': proxy_url, 'https': proxy_url}# 发送带代理的请求html_content = send_request(url, proxies)if html_content:# 解析页面内容parsed_content = parse_content(html_content)# 在这里可以根据需求处理解析后的内容print(f"从 {url} 获取到的内容:", parsed_content)#注意这里要休眠一段时间,防止对目标网站造成过大负荷time.sleep(random.randint(1, 5))if __name__ == "__main__":main()

此代码主要通过随机选择代理IP来发送请求,可以有效地提高数据采集效率和保护隐私安全。

此外还有其他优势:

3. 稳定可靠: IPIDEA 具有较高的稳定性和可用性,大家可以放心地使用代理 IP 进行数据采集等操作,减少因代理服务器不稳定而导致的中断和失败。

4. 灵活性: 大家可以根据自己的需求选择不同类型的代理服务,包括 HTTP、HTTPS、SOCKS 等不同协议的代理,以及不同地区、不同类型的代理方案,满足用户的个性化需求。

假设我一个师兄,他现在在美国,他可以根据自己的需求随意将IP定位到德国、印度、日本等国家,此外他还可以定时轮转、随机更换或者根据请求量动态更换。通过设置他自己定义的请求头信息,以真实用户身份访问,降低被识别为异常访问的风险。IPIDEA这种灵活性使用户能够访问心里所想任何地区的公开内容或服务,同时确保链接的稳定性和安全性,简直不要太爽了。

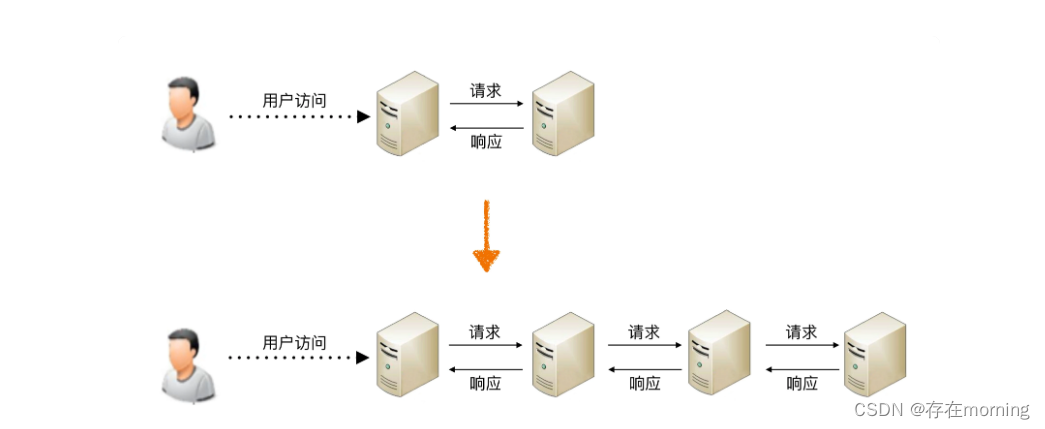

5. 提高数据采集效率: IPIDEA海外代理可以帮助分布式部署数据采集任务,实现多IP并发访问公开数据,提高网络爬虫的效率和速度,从而获取多样化的数据资源,为数据分析和挖掘提供更广泛的信息基础。

6. 保护隐私安全: 使用海外代理可以保护用户的真实IP地址,提高个人隐私安全,减少被跟踪和定位的风险。

我的师兄又来啦,假设他在日常生活中,面对一些不可抗力因素,比如自然灾害等,他能够借助IPIDEA海外代理IP,快速访问各地的新闻网站和社交媒体平台。这样,他就能及时获取到原本无法访问的内容,掌握实时的事件报道和信息,更好地了解世界动态。

再比如,我的师兄在一些流媒体平台或网站上想浏览一些东西(安全起见,懂得都懂)他又想看又不想暴露自己的真实IP地址和位置信息…额,通过使用海外代理IP,他可以保护自己的真实IP地址,避免被网站或服务追踪或识别。

– 以下是测试代理IP是否连接成功的代码示例:

import requests# 定义获取代理IP的地址

p_ip = 'YOUR_PROXY_IP'

#定义获取代理IP的端口

p_port = 'YOUR_PROXY_PORT'# 构建完整的代理地址

p_url = f'http://{p_ip}:{p_port}'# 定义访问目标网址

target_url = 'https://www.amazon.com/USA/s?k=USA&page=2'# 设置代理

proxies = {'http': p_url,'https': p_url,

}# 发送带代理的请求

try:response = requests.get(target_url, proxies=proxies)# 检查响应状态码if response.status_code == 200:print("代理IP测试成功!")else:print("代理IP测试失败,状态码:", response.status_code)except requests.exceptions.RequestException as e:print("发生异常:", e)

# 代码会发送一个带有代理的HTTP请求到target_url的网站,然后检查响应状态码以确定代理是否有效。

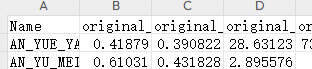

7. 响应迅速:IPIDEA代理服务器能够快速响应并转发请求,以便我们能够快速高效的获取数据。以下是我测试的结果展示:

可以看到香港地区速度很快,只有17ms延迟。延迟越低,表示请求速度越快,数据获取过程中的速度也随之提升。这显示了IPIDEA在数据获取方面的强大能力。

综上所述,上面描述的IPIDEA 代理有很多优点,它适用于各种海外代理IP需求,包括数据采集、SEO优化、市场调查等。那废话就不多说了,咱们一起体验一下吧!

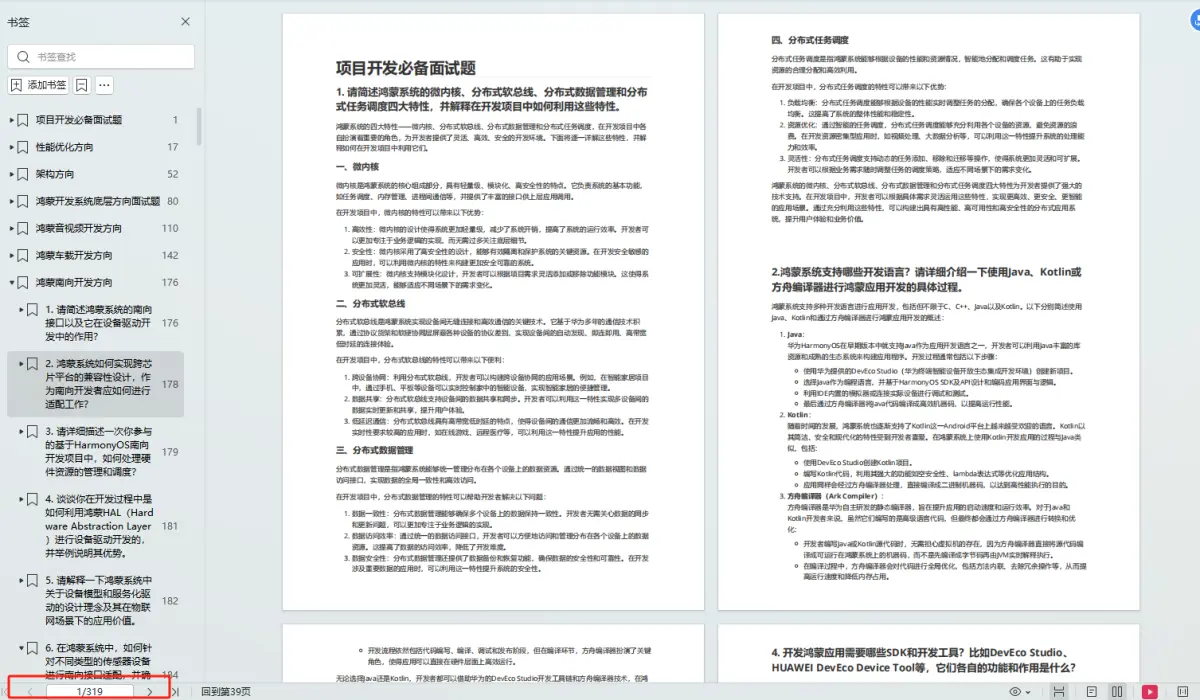

三、体验步骤

- 首先登录官网,可以看到新用户可以免费领取17.5G流量,用来测试IP质量足够了,想领取的点击此处专属链接领取哦~

- 点击–【获取代理】–【API获取】–右边绿色的【生成链接】

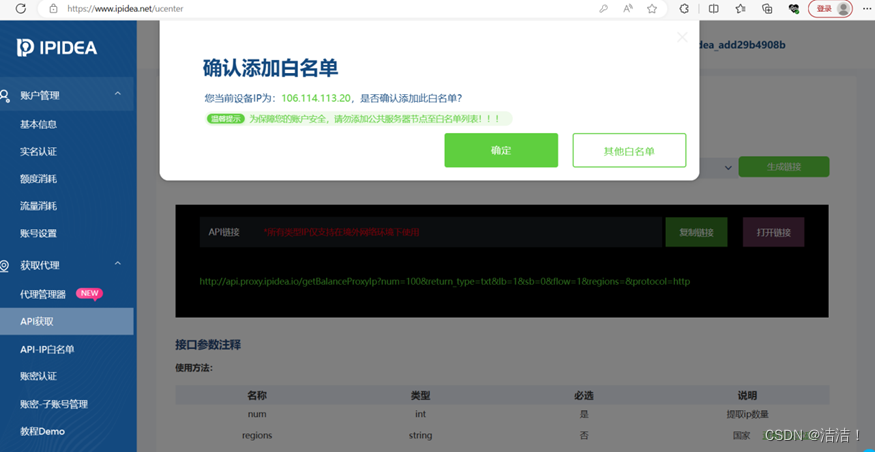

- 可以看到如下界面:

如果点击【确定】可直接将本机IP添加到白名单,如果是其他电脑使用代理IP,就点【其他白名单】进行添加(注意:这里需要把ip添加到白名单才能正常使用哦)

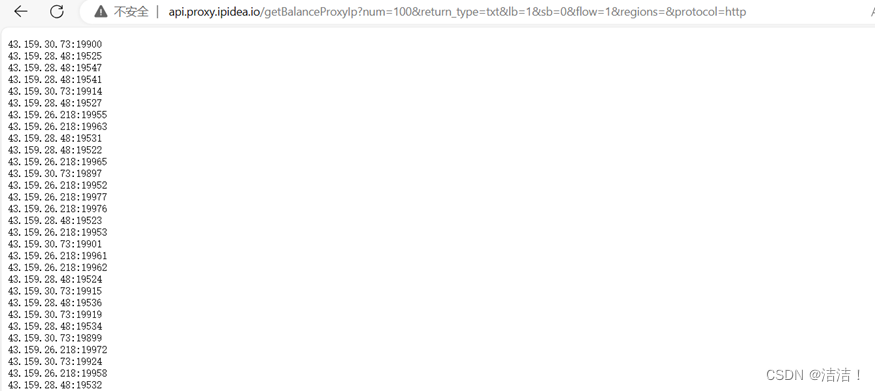

- 把IP添加到白名单之后,点击【复制链接】,然后直接到浏览器中请求,就可看到新的ip和对应的端口

- 然后我们就可以做一些Python爬虫相关的应用啦!(当然它能做的事情还有很多哟)

四、实战训练

我将运用Python爬虫技术,提取全球最大电商平台amazon上的商品信息和价格。

注意下面代码我省略了自己的账户和密码:

import requests

import json

from re import findall class IPIDEAProxy: def __init__(self): self.user_agent = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36 Edg/119.0.0.0' self.headers = { 'User-Agent': self.user_agent } self.login_url = "https://api.ipidea.net/g/api/account/accountLogin" self.get_user_info_url = "https://api.ipidea.net/g/api/user/getUserInfo" self.get_new_ips_url = "https://api.ipidea.net/g/api/tiqu/new_get_ips" self.add_white_url = "https://api.ipidea.net/g/api/white/add" # 登录IPIDEA def login(self, account, password): body = { "account": account, "password": password } response = requests.post(self.login_url, headers=self.headers, data=body) json_object = json.loads(response.text) session_id = json_object.get("ret_data", {}).get("session_id") return session_id # 获取新的IP地址 def get_new_ips(self, session_id): if not session_id: return None, None self.headers["Session-Id"] = session_id body = { "num": 1, "type": 1, "tiqu_type": "balance", "protocol": 1, "line_break": 1, } response = requests.post(self.get_new_ips_url, headers=self.headers, data=body) json_object = json.loads(response.text) links = json_object.get("ret_data", {}) for _, link in links.items(): response = requests.get(link) ip_info = response.text.split(":") if len(ip_info) == 2: proxie_ip = ip_info[0] proxie_port = ip_info[1].strip() return proxie_ip, proxie_port else: data = json.loads(response.text) if data.get("success") == "false": request_ip = data.get("request_ip") if request_ip: if self.add_white(request_ip): response = requests.get(link) ip_info = response.text.split(":") if len(ip_info) == 2: proxie_ip = ip_info[0] proxie_port = ip_info[1] return proxie_ip, proxie_port return None, None # 将IP地址添加到白名单 def add_white(self, request_ip): body = { "ip": request_ip, "remark": "Generated by script" } response = requests.post(self.add_white_url, headers=self.headers, data=body) data = json.loads(response.text) if data.get("msg") == "success": return True return False # 返回代理IP def get_proxies(self, ip, port): proxies = { 'http': f'http://{ip}:{port}', 'https': f'http://{ip}:{port}', } return proxies class Amazon: def __init__(self): self.proxy_manager = IPIDEAProxy() self.ama_url = " https://www.amazon.com/USA/s?k=USA&page=2 " self.cookies = 'your_cookie_here' # 获取amazon网站商品页面内容 def get_ama_page(self, proxies): headers = { 'User-Agent': self.proxy_manager.user_agent, 'Cookie': self.cookies } response = requests.request("GET", self. ama_url, headers=headers, proxies=proxies) return response.text # 解析amazon网站商品页面,提取商品信息和价格 def parse_ama_page(self, page_content): image_pattern = r'data-lazy-img="//(.+?)"' price_pattern = r'<span class="J_%s">(.*?)</span>' goods_names = findall(image_pattern, page_content) prices = findall(price_pattern % 'price', page_content) return goods_names, prices # 获取amazon商品信息和价格 def get_ama_goods_info(self): session_id = self.proxy_manager.login(your_account, your_passwd) proxy_ip, proxy_port = self.proxy_manager.get_new_ips(session_id) if proxy_ip and proxy_port: proxies = self.proxy_manager.get_proxies(proxy_ip, proxy_port) page_content = self.get_ama_page(proxies) goods_names, prices = self.parse_ama_page(page_content) for goods_name, price in zip(goods_names, prices): print(goods_name, price) else: print("Failed to get proxies.")

五、结语

代理IP就像网络爬虫的隐身衣,不仅能保护真实身份,避免被攻击或追踪,还能轻松获取市场公开数据。

IPIDEA作为专业的海外代理IP服务平台,为开发者提供了实现全球化数据采集和访问,解决了工作中不少棘手的麻烦问题。期待IPIDEA未来继续努力,为用户提供更全面、更优质的使用体验。

相关文章:

如何利用IPIDEA代理IP优化数据采集效率?

一、 前言二、 IPIDEA介绍三、体验步骤四、实战训练五、结语 一、 前言 在全球化与信息化交织的当代社会,数据已成为驱动商业智慧与技术革新的核心引擎。网络,作为信息汇聚与交流的枢纽,不仅是人们获取知识的窗口,更是商业活动与技…...

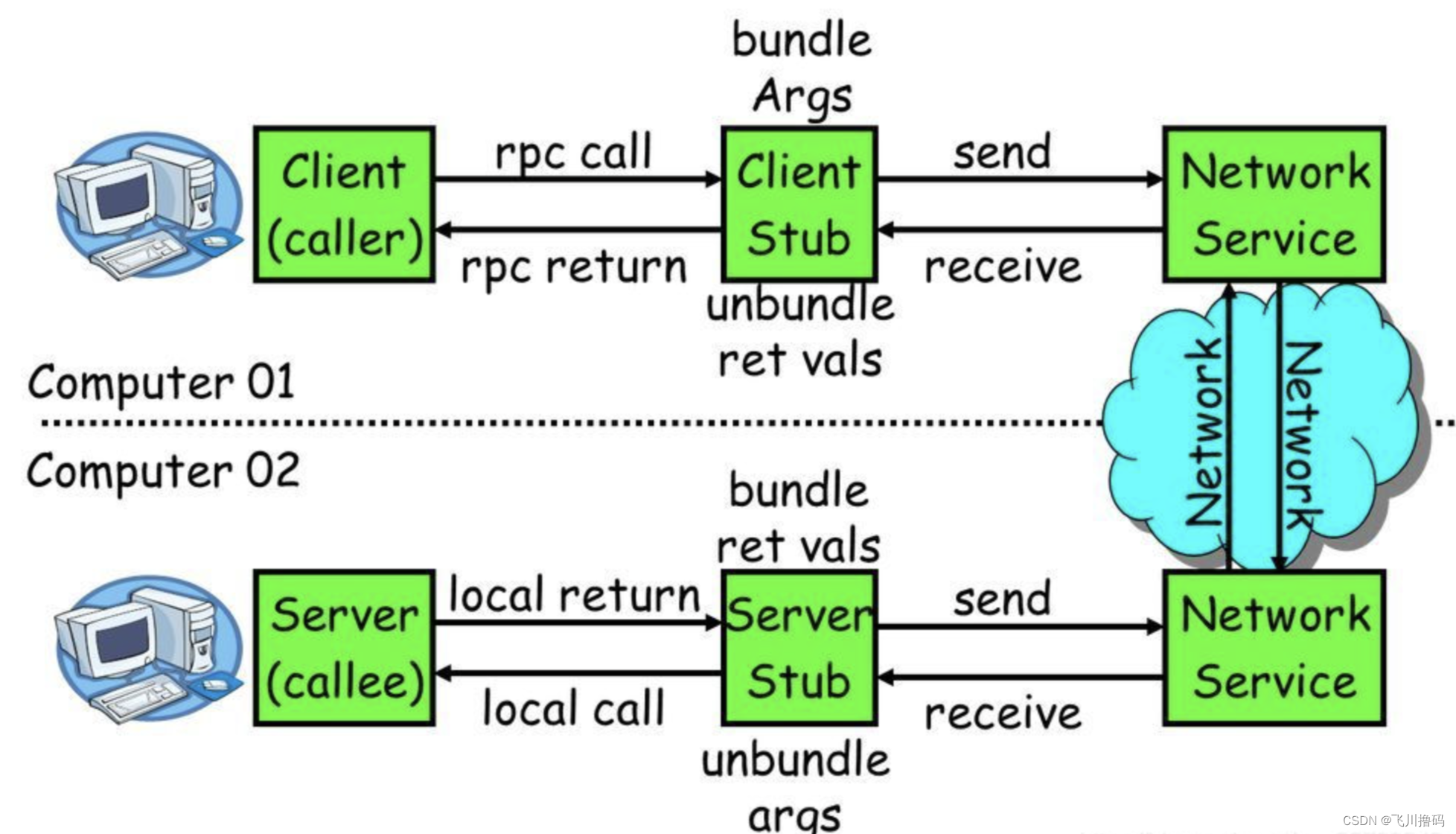

Rpcx (一):详解【介绍、基础示例 demo】

一.rpcx介绍 1.1 rpc是什么 远程过程调用的通信协议。该协议允许运行于一台计算机的程序调用另一台计算机的子程序,而程序员无需额外地为这个交互作用编程。如果涉及的软件采用面向对象编程,那么远程过程调用亦可称作远程调用或远程方法调用。简单地说就是能使应用像调用本地…...

对数据进行标准化和归一化

数据的形式:保存在CSV中,第一列为姓名,第二列之后为特征。 标准化 输入文件的路径,设置保存转化后的文件路径 import pandas as pd from sklearn.preprocessing import StandardScaler# 读取CSV文件 data pd.read_csv(rC:\User…...

【从零开始学架构 架构基础】二 架构设计的复杂度来源:高性能复杂度来源

架构设计的复杂度来源其实就是架构设计要解决的问题,主要有如下几个:高性能、高可用、可扩展、低成本、安全、规模。复杂度的关键,就是新旧技术之间不是完全的替代关系,有交叉,有各自的特点,所以才需要具体…...

OpenHarmony 实战开发——3.1 Release + Linux 原厂内核Launcher起不来问题分析报告

1、关键字 Launcher 无法启动;原厂内核;Access Token ID; 2、问题描述 芯片:rk3566;rk3399 内核版本:Linux 4.19,是 RK 芯片原厂发布的 rk356x 4.19 稳定版内核 OH 版本:OpenHa…...

小猫咪邮件在线发送系统源码,支持添加附件

一款免登录发送邮件,支持发送附件,后台可添加邮箱,前台可选择发送邮箱 网站数据采取本地保存,所以使用前请给网站修改权限,否则很多功能将无法使用 安装教程: 1.上传服务器或者主机 2.登录后台,添加发送…...

是什么?)

Django REST framework(DRF)是什么?

Django REST framework(DRF)是什么? Django REST framework(简称DRF)是一个强大且灵活的工具包,用于构建Web API。它是基于Django(一个高级Python Web框架)构建的,提供了…...

用hMailServer+roundcubemail+宝塔安装配置一个自己的邮箱服务

用hMailServerroundcubemail安装配置一个自己的邮箱服务 1、准备工具与资料: 云服务器一台 基础配置就行 2核4G。域名一个 以下用lizipro.cn示例。hMailServer安装包roundcubemail安装包异常处理插件补丁: libmysql.zip 2、hMailServer服务安装&#…...

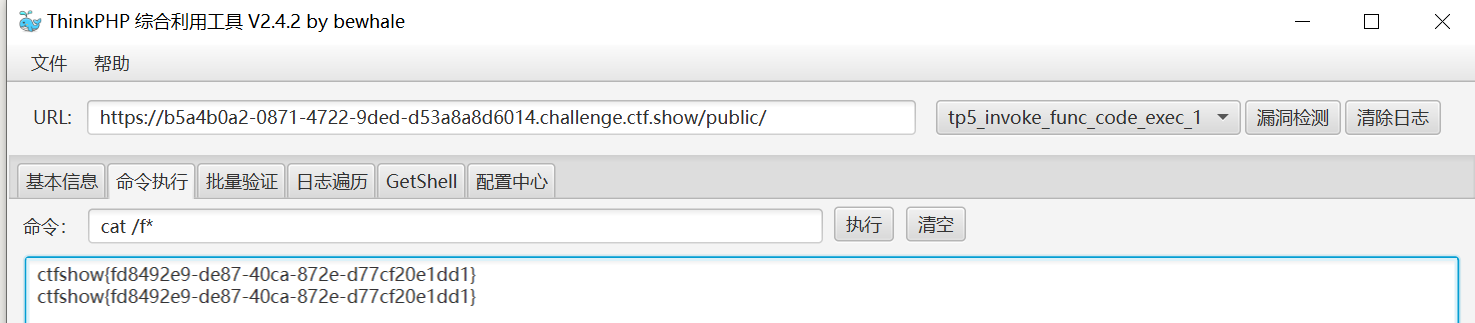

ctfshow 框架复现

文章目录 web 466web 467web 468web469web 470web 471web 472web 473web 474web 475web 476 web 466 Laravel5.4版本 ,提交数据需要base64编码 代码审计学习—Laravel5.4 - 先知社区 (aliyun.com) 用第二条链子 反序列化格式 /admin/序列化串base64<?php na…...

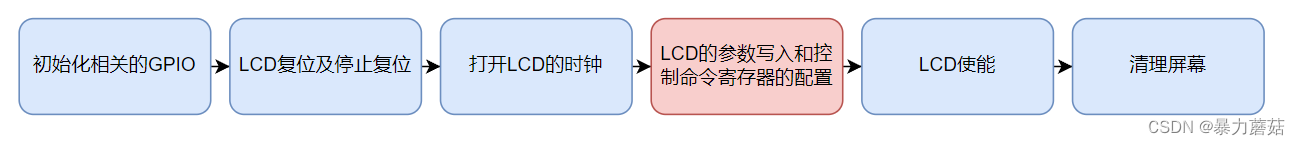

【Linux-IMX6ULL-DDR3简介测试-RGBLCD控制原理】

目录 1. DDR3 简介1.1 前要基本概念RAM & ROM 2. DDR3测试及初始化3. RGBLCD简介及控制原理3.1 RGBLCD简介3.2.1 RGB LCD时序3.2.2 像素时钟(800*400分辨率)3.2.2 显存(800*400分辨率) 3.3 RGBLCD的控制3.3.1 DOTCLK 硬件接口…...

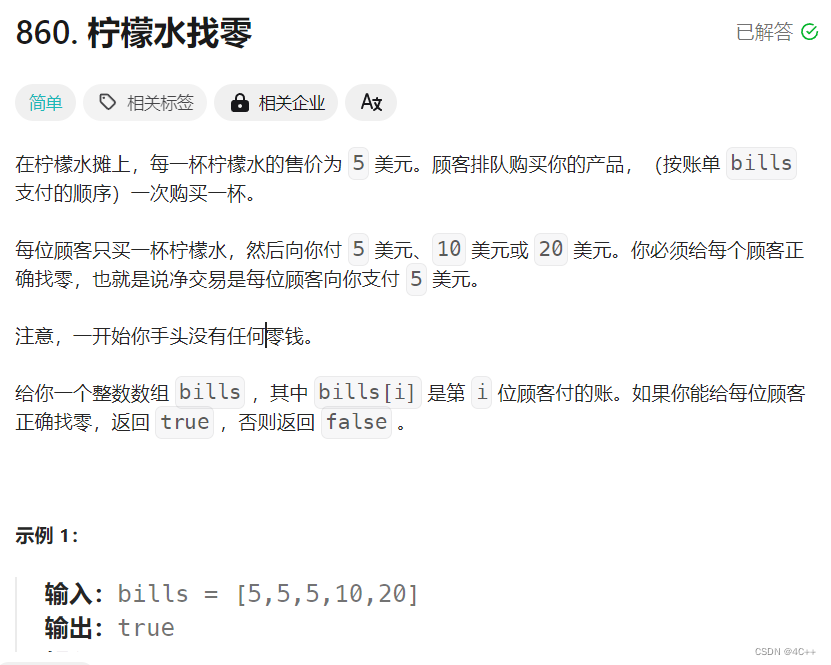

贪心算法-----柠檬水找零

今日题目:leetcode860 题目链接:点击跳转题目 分析: 顾客只会给三种面值:5、10、20,先分类讨论 当收到5美元时:不用找零,面值5张数1当收到10美元时:找零5美元,面值5张数…...

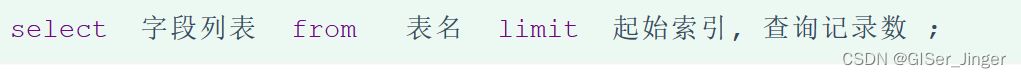

MySQL技能树学习

在MySQL中,DDL(数据定义语言)用于定义数据库对象(如表、索引、视图等),DML(数据操纵语言)用于操作数据库中的数据(如插入、更新、删除数据),DQL&a…...

java 动态代理详解

cglib 动态代理 介绍 CGLIB是一个功能强大,高性能的代码生成包。它为没有实现接口的类提供代理,为JDK的动态代理提供了很好的补充。通常可以使用Java的动态代理创建代理,但当要代理的类没有实现接口或者为了更好的性能,CGLIB 是一…...

Web路径专题

文章目录 Web路径专题什么是路径?绝对路径相对路径 如何使用路径?使用base标签 注意事项小结 Web路径专题 在Web开发中,路径是一个非常重要的概念。路径用来定位资源的位置,包括文件、目录、网页等。在本文中,我们将介…...

解决vue3项目打包后部署后某些静态资源图片不加载问题

目录 问题 原因 解决方案 问题 开发完项目打包并部署 然后访问时发现导航栏背景图片没加载 打开浏览器控制台发现这张图片报错404 原因 可能是因为在部署后的服务器环境中对中文文件名的支持不完善。服务器在解析 URL 时可能无法正确识别或编码中文字符,导致无…...

传感网应用开发教程--AT指令访问新大陆云平台(ESP8266模块+物联网云+TCP)

实现目标 1、熟悉AT指令 2、熟悉新大陆云平台新建项目 3、具体目标:(1)注册新大陆云平台;(2)新建一个联网方案为WIFI的项目;(3)ESP8266模块,通过AT指令访问…...

项目提交到空的git仓库流程

流程: # 初始化 Git 仓库 git init # 如果遇到 "detected dubious ownership" 的错误,可以添加 safe.directory 配置以解决 git config --global --add safe.directory T:/project/xxx # 将当前目录下的所有文件添加到 Git 暂存区 git add . …...

【Python】在Windows Server上部署Flask后端服务器

想要在Windows Server上部署flask应用,当然不能只下一个anaconda配完环境之后直接启动py文件,这样的话后台会有一段警告: * Serving Flask app app* Debug mode: off WARNING: This is a development server. Do not use it in a production …...

机器学习作业4——朴素贝叶斯分类器

目录 一、理论 一个例子: 二、代码 对于代码的解释: 1.fit函数: 2.predict函数: 三、实验结果 原因分析: 一、理论 朴素贝叶斯分类器基于贝叶斯定理进行分类,通过后验概率来判断将新数据归为哪一类。通过利用贝…...

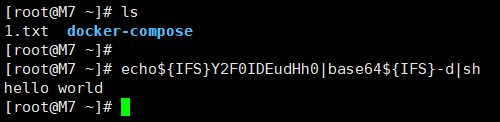

BUU-[GXYCTF2019]Ping Ping Ping

考察点 命令执行 题目 解题 简单测试 ?ip应该是一个提示,那么就测试一下?ip127.0.0.1 http://0c02a46a-5ac2-45f5-99da-3d1b0b951307.node4.buuoj.cn:81/?ip127.0.0.1发现正常回显 列出文件 那么猜测一下可能会有命令执行漏洞,测试?ip127.0.…...

Qt/C++开发监控GB28181系统/取流协议/同时支持udp/tcp被动/tcp主动

一、前言说明 在2011版本的gb28181协议中,拉取视频流只要求udp方式,从2016开始要求新增支持tcp被动和tcp主动两种方式,udp理论上会丢包的,所以实际使用过程可能会出现画面花屏的情况,而tcp肯定不丢包,起码…...

Cesium相机控制)

三维GIS开发cesium智慧地铁教程(5)Cesium相机控制

一、环境搭建 <script src"../cesium1.99/Build/Cesium/Cesium.js"></script> <link rel"stylesheet" href"../cesium1.99/Build/Cesium/Widgets/widgets.css"> 关键配置点: 路径验证:确保相对路径.…...

大数据零基础学习day1之环境准备和大数据初步理解

学习大数据会使用到多台Linux服务器。 一、环境准备 1、VMware 基于VMware构建Linux虚拟机 是大数据从业者或者IT从业者的必备技能之一也是成本低廉的方案 所以VMware虚拟机方案是必须要学习的。 (1)设置网关 打开VMware虚拟机,点击编辑…...

从深圳崛起的“机器之眼”:赴港乐动机器人的万亿赛道赶考路

进入2025年以来,尽管围绕人形机器人、具身智能等机器人赛道的质疑声不断,但全球市场热度依然高涨,入局者持续增加。 以国内市场为例,天眼查专业版数据显示,截至5月底,我国现存在业、存续状态的机器人相关企…...

ESP32 I2S音频总线学习笔记(四): INMP441采集音频并实时播放

简介 前面两期文章我们介绍了I2S的读取和写入,一个是通过INMP441麦克风模块采集音频,一个是通过PCM5102A模块播放音频,那如果我们将两者结合起来,将麦克风采集到的音频通过PCM5102A播放,是不是就可以做一个扩音器了呢…...

C# 类和继承(抽象类)

抽象类 抽象类是指设计为被继承的类。抽象类只能被用作其他类的基类。 不能创建抽象类的实例。抽象类使用abstract修饰符声明。 抽象类可以包含抽象成员或普通的非抽象成员。抽象类的成员可以是抽象成员和普通带 实现的成员的任意组合。抽象类自己可以派生自另一个抽象类。例…...

Matlab | matlab常用命令总结

常用命令 一、 基础操作与环境二、 矩阵与数组操作(核心)三、 绘图与可视化四、 编程与控制流五、 符号计算 (Symbolic Math Toolbox)六、 文件与数据 I/O七、 常用函数类别重要提示这是一份 MATLAB 常用命令和功能的总结,涵盖了基础操作、矩阵运算、绘图、编程和文件处理等…...

零基础在实践中学习网络安全-皮卡丘靶场(第九期-Unsafe Fileupload模块)(yakit方式)

本期内容并不是很难,相信大家会学的很愉快,当然对于有后端基础的朋友来说,本期内容更加容易了解,当然没有基础的也别担心,本期内容会详细解释有关内容 本期用到的软件:yakit(因为经过之前好多期…...

2025年渗透测试面试题总结-腾讯[实习]科恩实验室-安全工程师(题目+回答)

安全领域各种资源,学习文档,以及工具分享、前沿信息分享、POC、EXP分享。不定期分享各种好玩的项目及好用的工具,欢迎关注。 目录 腾讯[实习]科恩实验室-安全工程师 一、网络与协议 1. TCP三次握手 2. SYN扫描原理 3. HTTPS证书机制 二…...

计算机基础知识解析:从应用到架构的全面拆解

目录 前言 1、 计算机的应用领域:无处不在的数字助手 2、 计算机的进化史:从算盘到量子计算 3、计算机的分类:不止 “台式机和笔记本” 4、计算机的组件:硬件与软件的协同 4.1 硬件:五大核心部件 4.2 软件&#…...