DPO算法推导

DPO

-

核心思想:直接使用偏好数据进行策略优化,省去

reward模型策略优化。 -

技术背景知识:

首先给定prompt x,生成两个答案 ( y 1 , y 2 ) Π S F T ( y ∣ x ) (y_1,y_2)~\Pi^{SFT}(y|x) (y1,y2) ΠSFT(y∣x) ,并通过人工标注对比 y 1 , y 2 y_1,y_2 y1,y2 ,获得偏好结果(preference) y w ≻ y l ∣ x y_w\succ y_l|x yw≻yl∣x,其中 w w w和 l l l表示

win和lose。引入奖励模型 r r r , y 1 > y 2 y_1 > y_2 y1>y2 的概率可以表示为

p ( y 1 > y 2 ) = r ∗ ( x , y 1 ) r ∗ ( x , y 1 ) + r ∗ ( x , y 2 ) p(y_1 > y_2) = \frac{r^*(x,y_1)}{r^*(x,y_1)+ r^*(x,y_2)} p(y1>y2)=r∗(x,y1)+r∗(x,y2)r∗(x,y1)

为使得奖励函数均为正数,引入Bradley-Terry模型。-

Bradley-Terry:

p ∗ ( y w ≻ y l ∣ x ) = e x p ( r ∗ ( x , y 1 ) ) e x p ( r ∗ ( x , y 1 ) ) + e x p ( r ∗ ( x , y 2 ) ) p^{*}(y_w\succ y_l|x) = \frac{exp(r^*(x,y_1))}{exp(r^*(x,y_1))+ exp(r^*(x,y_2))} p∗(yw≻yl∣x)=exp(r∗(x,y1))+exp(r∗(x,y2))exp(r∗(x,y1))

交叉熵:令 a x = e x p ( r ∗ ( x , y 1 ) ) a_x = exp(r^*(x,y_1)) ax=exp(r∗(x,y1)), a y = e x p ( r ∗ ( x , y 2 ) ) a_y = exp(r^*(x,y_2)) ay=exp(r∗(x,y2))

L o s s = − E ( a x , a y ) ∼ D [ l n a x a x + a y ] = − E ( x , y w , y l ) ∼ D [ l n e x p ( r ∗ ( x , y w ) ) e x p ( r ∗ ( x , y w ) ) + e x p ( r ∗ ( x , y l ) ) ] = − E ( x , y w , y l ) ∼ D [ l n 1 1 + e x p ( r ∗ ( x , y l ) − r ∗ ( x , y w ) ) ] = − E ( x , y w , y l ) ∼ D [ l n σ ( r ∗ ( x , y w ) − r ∗ ( x , y l ) ) ] Loss = -E_{(a_x,a_y)\sim D}[ln\frac{a_x}{a_x+a_y}] \\ = - E_{(x,y_w,y_l)\sim D}[ln\frac{exp(r^*(x,y_w))}{exp(r^*(x,y_w))+exp(r^*(x,y_l))}] \\ = - E_{(x,y_w,y_l)\sim D}[ln\frac{1}{1+exp(r^*(x,y_l)-r^*(x,y_w))}] \\ = - E_{(x,y_w,y_l)\sim D}[ln \sigma(r^*(x,y_w) -r^*(x,y_l))] \\ Loss=−E(ax,ay)∼D[lnax+ayax]=−E(x,yw,yl)∼D[lnexp(r∗(x,yw))+exp(r∗(x,yl))exp(r∗(x,yw))]=−E(x,yw,yl)∼D[ln1+exp(r∗(x,yl)−r∗(x,yw))1]=−E(x,yw,yl)∼D[lnσ(r∗(x,yw)−r∗(x,yl))] -

KL 散度:

K L ( P ∣ ∣ Q ) = ∑ x ∈ X P ( X ) l o g ( P ( X ) Q ( X ) ) KL(P||Q) = \sum_{x\in X}P(X)log(\frac{P(X)}{Q(X)}) KL(P∣∣Q)=x∈X∑P(X)log(Q(X)P(X))

P ( x ) , Q ( x ) P(x),Q(x) P(x),Q(x) 分别是数据真实分布和模型预测分布。

-

-

DPO目标函数:获取更多的奖励,并尽可能保证与基准模型一致。

m a x π E x ∈ X , y ∈ π [ r ( x , y ) ] − β ⋅ D K L [ π ( y ∣ x ) ∣ ∣ π r e f ( y ∣ x ) ] = m a x π E x ∈ X , y ∈ π [ r ( x , y ) ] − E x ∈ X , y ∈ π [ β ⋅ l o g π ( y ∣ x ) π r e f ( y ∣ x ) ] = m a x π E x ∈ X , y ∈ π [ r ( x , y ) − β ⋅ l o g π ( y ∣ x ) π r e f ( y ∣ x ) ] = m a x π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π r e f ( y ∣ x ) − 1 β r ( x , y ) ) ] = m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π r e f ( y ∣ x ) − l o g e x p ( 1 β r ( x , y ) ) ] = m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) ] = m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) 1 Z ( x ) π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) − l o g Z ( x ) ] \underset{\pi}{max} E_{x\in X, y \in \pi}[r(x,y)] - \beta·\mathbb{D}_{KL}[\pi(y|x) || \pi_{ref}(y|x)] \\ = \underset{\pi}{max} E_{x\in X, y \in \pi}[r(x,y)] - E_{x\in X, y \in \pi}[\beta·log \frac{\pi(y|x)}{\pi_{ref}(y|x)}] \\ = \underset{\pi}{max} E_{x\in X, y \in \pi}[r(x,y) - \beta·log \frac{\pi(y|x)}{\pi_{ref}(y|x)}] \\ = \underset{\pi}{max} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi_{ref}(y|x)}- \frac{1}{\beta}r(x,y))] \\ = \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi_{ref}(y|x)}- log \ \ exp(\frac{1}{\beta}r(x,y))] \\ = \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y))} ] \\ = \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\frac{1}{Z(x)}\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y))} - log \ \ Z(x) ] \\ πmaxEx∈X,y∈π[r(x,y)]−β⋅DKL[π(y∣x)∣∣πref(y∣x)]=πmaxEx∈X,y∈π[r(x,y)]−Ex∈X,y∈π[β⋅logπref(y∣x)π(y∣x)]=πmaxEx∈X,y∈π[r(x,y)−β⋅logπref(y∣x)π(y∣x)]=πmaxEx∈X,y∈π[logπref(y∣x)π(y∣x)−β1r(x,y))]=πminEx∈X,y∈π[logπref(y∣x)π(y∣x)−log exp(β1r(x,y))]=πminEx∈X,y∈π[logπref(y∣x)⋅exp(β1r(x,y))π(y∣x)]=πminEx∈X,y∈π[logZ(x)1πref(y∣x)⋅exp(β1r(x,y))π(y∣x)−log Z(x)]

令 Z ( x ) Z(x) Z(x) 表示如下:

Z ( x ) = ∑ y π r e f ( y ∣ x ) e x p ( 1 β r ( x , y ) ) Z(x) = \underset{y}{\sum} \pi_{ref}(y|x) exp(\frac{1}{\beta}r(x,y) ) Z(x)=y∑πref(y∣x)exp(β1r(x,y))

令:

1 Z ( x ) π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) = π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) ∑ y π r e f ( y ∣ x ) e x p ( 1 β r ( x , y ) ) = π ∗ ( y ∣ x ) \frac{1}{Z(x)}\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y)) = \frac{\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y))}{\underset{y}{\sum} \pi_{ref}(y|x) exp(\frac{1}{\beta}r(x,y) )} \\ = \pi^*(y|x) Z(x)1πref(y∣x)⋅exp(β1r(x,y))=y∑πref(y∣x)exp(β1r(x,y))πref(y∣x)⋅exp(β1r(x,y))=π∗(y∣x)

接下来继续对``dpo` 目标函数进行化简:

m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) 1 Z ( x ) π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) − l o g Z ( x ) ] = m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π ∗ ( y ∣ x ) − l o g Z ( x ) ] \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\frac{1}{Z(x)}\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y))} - log \ \ Z(x) ] \\ = \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi^*(y|x)} - log \ \ Z(x) ] \\ πminEx∈X,y∈π[logZ(x)1πref(y∣x)⋅exp(β1r(x,y))π(y∣x)−log Z(x)]=πminEx∈X,y∈π[logπ∗(y∣x)π(y∣x)−log Z(x)]

由于 Z ( x ) Z(x) Z(x) 表达式与 π \pi π 不相关,优化可以直接省去。

m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π ∗ ( y ∣ x ) − l o g Z ( x ) ] = m i n π E x ∈ X , y ∈ π [ l o g π ( y ∣ x ) π ∗ ( y ∣ x ) ] = m i n π E x ∼ D [ D K L ( π ( y ∣ x ) ∣ ∣ π ∗ ( y ∣ x ) ) ] \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi^*(y|x)} - log \ \ Z(x) ] \\ = \underset{\pi}{min} E_{x\in X, y \in \pi}[log \frac{\pi(y|x)}{\pi^*(y|x)} ] \\ = \underset{\pi}{min} E_{x \sim D}[\mathbb{D}_{KL}(\pi(y|x) || \pi^*(y|x))] \\ πminEx∈X,y∈π[logπ∗(y∣x)π(y∣x)−log Z(x)]=πminEx∈X,y∈π[logπ∗(y∣x)π(y∣x)]=πminEx∼D[DKL(π(y∣x)∣∣π∗(y∣x))]

当 目标函数最小化,也就是 D K L \mathbb{D}_{KL} DKL 最小化,所满足的条件为:

π ( y ∣ x ) = π ∗ ( y ∣ x ) = 1 Z ( x ) π r e f ( y ∣ x ) ⋅ e x p ( 1 β r ( x , y ) ) \pi(y|x) = \pi^*(y|x) = \frac{1}{Z(x)}\pi_{ref}(y|x)·exp(\frac{1}{\beta}r(x,y)) π(y∣x)=π∗(y∣x)=Z(x)1πref(y∣x)⋅exp(β1r(x,y))

反解奖励函数 r ( x , y ) r(x,y) r(x,y)

r ( x , y ) = β π ( y ∣ x ) π r e f ( y ∣ x ) + β ⋅ l n Z ( x ) r(x,y) = \beta \frac{\pi(y|x)}{\pi_{ref}(y|x)} + \beta · ln \Z(x) r(x,y)=βπref(y∣x)π(y∣x)+β⋅lnZ(x)

求解奖励函数隐式表达后,带入Bradley-Terry 交叉熵函数:

L o s s = − E ( x , y w , y l ) ∼ D [ l n σ ( r ∗ ( x , y w ) − r ∗ ( x , y l ) ) ] = − E ( x , y w , y l ) ∼ D [ l n σ ( β l o g π ( y w ∣ x ) π r e f ( y w ∣ x ) − β l o g π ( y l ∣ x ) π r e f ( y l ∣ x ) ) ] Loss = - E_{(x,y_w,y_l)\sim D}[ln \sigma(r^*(x,y_w) -r^*(x,y_l))] \\ =- E_{(x,y_w,y_l)\sim D}[ln \sigma(\beta log\frac{\pi(y_w|x)}{\pi_{ref}(y_w|x)} - \beta log \frac{\pi(y_l|x)}{\pi_{ref}(y_l|x)})] Loss=−E(x,yw,yl)∼D[lnσ(r∗(x,yw)−r∗(x,yl))]=−E(x,yw,yl)∼D[lnσ(βlogπref(yw∣x)π(yw∣x)−βlogπref(yl∣x)π(yl∣x))]

到此,整个数学部分已推导完毕,不得不说句牛逼plus。

-

梯度表征:

将上述损失进行梯度求导

∇ θ L o s s ( π θ ; π r e f ) = − E ( x , y w , y l ) ∼ D [ β σ ( β l o g π ( y w ∣ x ) π r e f ( y w ∣ x ) − β l o g π ( y l ∣ x ) π r e f ( y l ∣ x ) ) [ ∇ θ l o g π ( y w ∣ x ) − ∇ θ l o g π ( y l ∣ x ) ] ] \nabla_\theta Loss(\pi_{\theta};\pi_{ref}) = - E_{(x,y_w,y_l)\sim D}[\beta \sigma(\beta log\frac{\pi(y_w|x)}{\pi_{ref}(y_w|x)} - \beta log \frac{\pi(y_l|x)}{\pi_{ref}(y_l|x)}) [\nabla_{\theta}log \pi(y_w|x) - \nabla_{\theta}log \pi(y_l|x) ]] ∇θLoss(πθ;πref)=−E(x,yw,yl)∼D[βσ(βlogπref(yw∣x)π(yw∣x)−βlogπref(yl∣x)π(yl∣x))[∇θlogπ(yw∣x)−∇θlogπ(yl∣x)]]

再令:

r ^ ( x , y ) = β π θ ( y ∣ x ) π r e f ( y ∣ x ) \hat{r}(x,y) = \beta \frac{\pi_{\theta}(y|x)}{\pi_{ref}(y|x)} r^(x,y)=βπref(y∣x)πθ(y∣x)

最终形式:

∇ θ L o s s ( π θ ; π r e f ) = − β E ( x , y w , y l ) ∼ D [ σ ( r ^ ∗ ( x , y w ) − r ^ ∗ ( x , y l ) ) ⏟ h i g h e r w e i g h t w h e n r e w a r d e s t i m a t e i s w r o n g [ ∇ θ l o g π ( y w ∣ x ) ⏟ i n c r e a s e l i k e l i h o o d o f y w − ∇ θ l o g π ( y l ∣ x ) ⏟ d e c r e a s e l i k e l i h o o d o f y l ] ] \nabla_\theta Loss(\pi_{\theta};\pi_{ref}) = -\beta E_{(x,y_w,y_l)\sim D}[\underbrace{\sigma(\hat{r}^*(x,y_w) -\hat{r}^*(x,y_l))}_{higher\ weight\ when\ reward\ estimate\ is\ wrong} [\underbrace{\nabla_{\theta}log \pi(y_w|x)}_{\ \ \ \ \ \ \ \ \ increase \ likelihood\ of\ y_w} - \underbrace{\nabla_{\theta}log \pi(y_l|x)}_{decrease \ likelihood \ of \ y_l} ]] ∇θLoss(πθ;πref)=−βE(x,yw,yl)∼D[higher weight when reward estimate is wrong σ(r^∗(x,yw)−r^∗(x,yl))[ increase likelihood of yw ∇θlogπ(yw∣x)−decrease likelihood of yl ∇θlogπ(yl∣x)]] -

改进方法ODPO

dpo缺陷主要是:采用Bradley–Terry model只给出了一个response比另一个response好的概率,而没有告诉我们好的程度。

odpo 核心思想: 把这个好的程度的差距信息引入到偏好的建模里,应该能带来收益,及在dpo损失里添加margin , 这相当于要求偏好回应的评估分数要比非偏好回应的评估分数大,且要大offset值这么多。目的是:加大对靠得比较近的数据对的惩罚力度。

L o s s o d p o = − E ( x , y w , y l ) ∼ D [ l n σ ( r ∗ ( x , y w ) − r ∗ ( x , y l ) ) − δ r ] δ r = α l o g ( r ( y w ) − r ( y l ) ) Loss^{odpo}= - E_{(x,y_w,y_l)\sim D}[ln \sigma(r^*(x,y_w) -r^*(x,y_l)) - \delta_r] \\ \delta_r = \alpha \ log(r(y_w)- r(y_l)) Lossodpo=−E(x,yw,yl)∼D[lnσ(r∗(x,yw)−r∗(x,yl))−δr]δr=α log(r(yw)−r(yl))

-

相似改进方法:

IPOKTO都是不需要奖励模型的;

相关文章:

DPO算法推导

DPO 核心思想:直接使用偏好数据进行策略优化,省去 reward 模型策略优化。 技术背景知识: 首先给定prompt x,生成两个答案 ( y 1 , y 2 ) Π S F T ( y ∣ x ) (y_1,y_2)~\Pi^{SFT}(y|x) (y1,y2) ΠSFT(y∣x) ,并通…...

Qt源码分析:窗体绘制与响应

作为一套开源跨平台的UI代码库,窗体绘制与响应自然是最为基本的功能。在前面的博文中,已就Qt中的元对象系统(反射机制)、事件循环等基础内容进行了分析,并捎带阐述了窗体响应相关的内容。因此,本文着重分析Qt中窗体绘制相关的内容…...

docker 安装 禅道

docker pull hub.zentao.net/app/zentao:20.1.1 sudo docker network create --subnet172.172.172.0/24 zentaonet 使用 8087端口号访问 使用禅道mysql 映射到3307 sudo docker run \ --name zentao2 \ -p 8087:80 \ -p 3307:3306 \ --networkzentaonet \ --ip 172.172.172.…...

【简要说说】make 增量编译的原理

make 增量编译的原理 make是一个工具,它可以根据依赖关系和时间戳来自动执行编译命令。 当您修改了源代码文件后,make会检查它们的修改时间是否比目标文件(如可执行文件或目标文件)新,如果是,就会重新编译…...

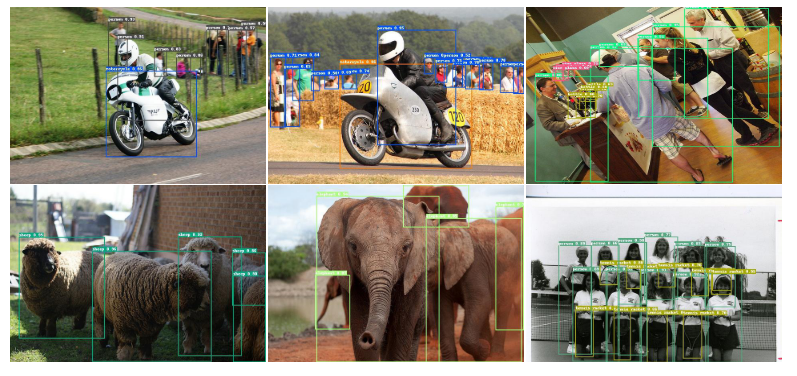

DETRs Beat YOLOs on Real-time Object Detection论文翻译

cvpr 2024 论文名称 DETRs在实时目标检测上击败YOLO 地址 https://arxiv.longhoe.net/abs/2304.08069 代码 https://github.com/lyuwenyu/RT-DETR 目录 摘要 1介绍 2.相关工作 2.1实时目标探测器 2.2.端到端物体探测器 3.检测器的端到端速度 3.1.NMS分析 3.2.端到端速度…...

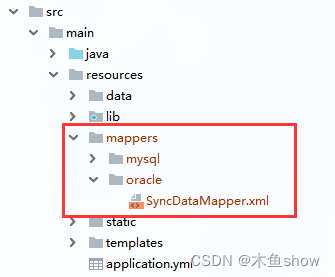

SpringBoot 多数据源配置

目录 一. 引入maven依赖包 二. 配置yml 三、创建 xml 分组文件 四、切换数据源 一. 引入maven依赖包 <dependency><groupId>com.baomidou</groupId><artifactId>dynamic-datasource-spring-boot-starter</artifactId><version>3.6.1&…...

RK3568驱动指南|第十六篇 SPI-第192章 mcp2515驱动编写:完善write和read函数

瑞芯微RK3568芯片是一款定位中高端的通用型SOC,采用22nm制程工艺,搭载一颗四核Cortex-A55处理器和Mali G52 2EE 图形处理器。RK3568 支持4K 解码和 1080P 编码,支持SATA/PCIE/USB3.0 外围接口。RK3568内置独立NPU,可用于轻量级人工…...

#BI建模与数仓建模有什么区别?指标体系由谁来搭建?

问题1: 指标体系是我们数仓来搭建还是分析师来做,如何去推动? 问题2:BI建模与数仓建模有什么区别? 指标体系要想做好,其实是分两块内容的,一块是顶层设计阶段,业务指标体系的搭建&am…...

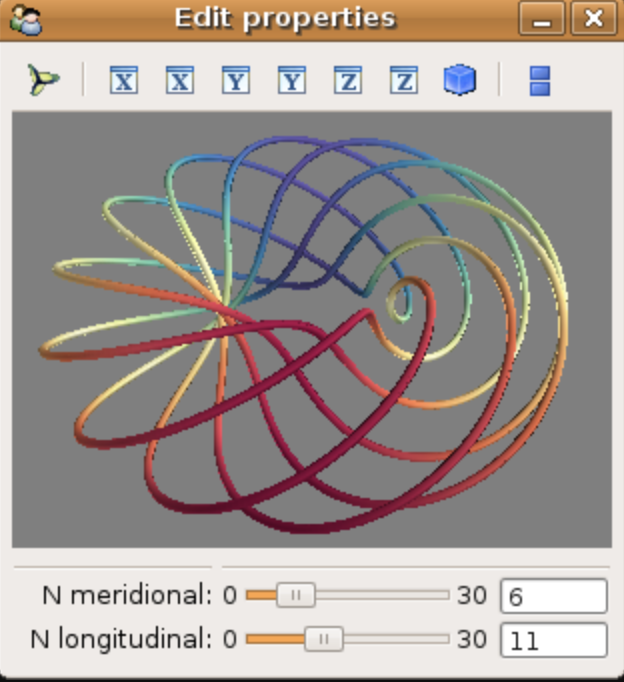

如何用Python实现三维可视化?

Python拥有很多优秀的三维图像可视化工具,主要基于图形处理库WebGL、OpenGL或者VTK。 这些工具主要用于大规模空间标量数据、向量场数据、张量场数据等等的可视化,实际运用场景主要在海洋大气建模、飞机模型设计、桥梁设计、电磁场分析等等。 本文简单…...

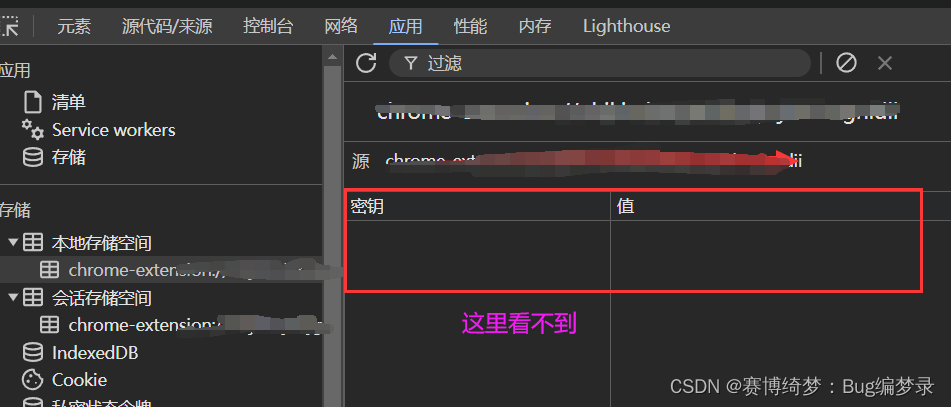

chrome.storage.local.set 未生效

之前chrome.storage.local.set 和 get 一直不起作用 使用以下代码运行成功。 chrome.storage.local.set({ pageState: "main" }).then(() > {console.log("Value is set");});chrome.storage.local.get(["pageState"]).then((result) > …...

泛微开发修炼之旅--30 linux-Ecology服务器运维脚本

文章链接:30 linux-ecology服务器运维脚本...

LeetCode 全排列

思路:这是一道暴力搜索问题,我们需要列出答案的所有可能组合。 题目给我们一个数组,我们很容易想到的做法是将数组中的元素进行排列,如何区分已选中和未选中的元素,容易想到的是建立一个标记数组,已经选中的…...

python实现支付宝异步回调验签

说明 python实现支付宝异步回调验签,示例中使用Django框架。 此方案使用了支付宝的pythonSDK,请一定装最新版本的,支付宝官网文档不知道多久没更新了,之前的版本pip安装会报一些c库不存在的错误; pip install alipay-…...

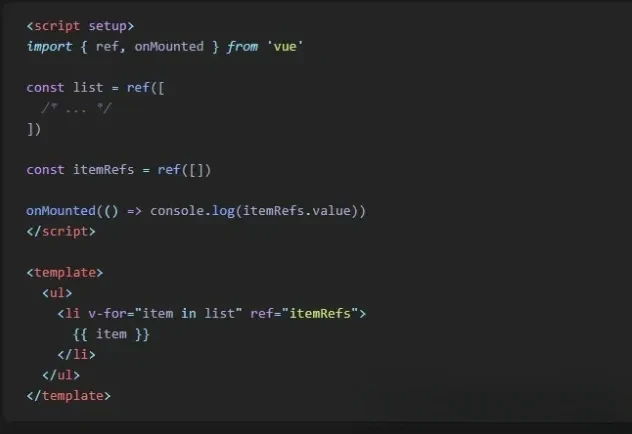

注意!Vue.js 或 Nuxt.js 中请停止使用.value

大家好,我是CodeQi! 一位热衷于技术分享的码仔。 当您在代码中使用.value时,必须每次都检查变量是否存在并且是引用。 这可能很麻烦,因为在运行时使用.value可能会导致错误。然而,有一个简单的解决方法,即使用unref()而不是.value。 unref()会检查变量是否是引用,并自…...

Java:JDK、JRE和JVM 三者关系

文章目录 一、JDK是什么二、JRE是什么三、JDK、JRE和JVM的关系 一、JDK是什么 JDK(Java Development Kit):Java开发工具包 JRE:Java运行时环境开发工具:javac(编译工具)、java(运行…...

Radio专业术语笔记

在收音机的 RDS (Radio Data System) 功能中,CT 代表 “Clock Time”。RDS 是一种数字广播标准,用于在调频广播中传输辅助数据,如电台名称、节目类型、交通信息等。CT 功能是其中的一部分,用于同步和显示广播电台发送的当前时间。…...

cocosCreator找出未用到的图片

最近整理项目的时候发现有些资源文件夹有点轮乱(一些历史原因导致的),而且有很多图片都是没用了的,但是没有被删除掉,还一直放在项目中,导致项目的资源文件夹比较大,而且还冗余。于是今天想着整理一下。 公开免费链接 找出未使用的图片 有好几种方法可以找出未使用的图片…...

一览 Anoma 上的有趣应用概念

撰文:Tia,Techub News 本文来源香港Web3媒体:Techub News Anoma 的目标是为应用提供通用的意图机器接口,这意味着使用 Anoma,开发人员可以根据意图和分布式意图机编写应用,而不是根据事务和特定状态机进行…...

Spring Boot集成fastjson2快速入门Demo

1.什么是fastjson2? fastjson2是阿里巴巴开发的一个高性能的Java JSON处理库,它支持将Java对象转换成JSON格式,同时也支持将JSON字符串解析成Java对象。本文将介绍fastjson2的常见用法,包括JSON对象、JSON数组的创建、取值、遍历…...

Three.js机器人与星系动态场景(二):强化三维空间认识

在上篇博客中介绍了如何快速利用react搭建three.js平台,并实现3D模型的可视化。本文将在上一篇的基础上强化坐标系的概念。引入AxesHelper辅助工具及文本绘制工具,带你快速理解camer、坐标系、position、可视区域。 Three.js机器人与星系动态场景&#x…...

测试微信模版消息推送

进入“开发接口管理”--“公众平台测试账号”,无需申请公众账号、可在测试账号中体验并测试微信公众平台所有高级接口。 获取access_token: 自定义模版消息: 关注测试号:扫二维码关注测试号。 发送模版消息: import requests da…...

linux arm系统烧录

1、打开瑞芯微程序 2、按住linux arm 的 recover按键 插入电源 3、当瑞芯微检测到有设备 4、松开recover按键 5、选择升级固件 6、点击固件选择本地刷机的linux arm 镜像 7、点击升级 (忘了有没有这步了 估计有) 刷机程序 和 镜像 就不提供了。要刷的时…...

【论文笔记】若干矿井粉尘检测算法概述

总的来说,传统机器学习、传统机器学习与深度学习的结合、LSTM等算法所需要的数据集来源于矿井传感器测量的粉尘浓度,通过建立回归模型来预测未来矿井的粉尘浓度。传统机器学习算法性能易受数据中极端值的影响。YOLO等计算机视觉算法所需要的数据集来源于…...

MySQL中【正则表达式】用法

MySQL 中正则表达式通过 REGEXP 或 RLIKE 操作符实现(两者等价),用于在 WHERE 子句中进行复杂的字符串模式匹配。以下是核心用法和示例: 一、基础语法 SELECT column_name FROM table_name WHERE column_name REGEXP pattern; …...

Redis数据倾斜问题解决

Redis 数据倾斜问题解析与解决方案 什么是 Redis 数据倾斜 Redis 数据倾斜指的是在 Redis 集群中,部分节点存储的数据量或访问量远高于其他节点,导致这些节点负载过高,影响整体性能。 数据倾斜的主要表现 部分节点内存使用率远高于其他节…...

【Go语言基础【13】】函数、闭包、方法

文章目录 零、概述一、函数基础1、函数基础概念2、参数传递机制3、返回值特性3.1. 多返回值3.2. 命名返回值3.3. 错误处理 二、函数类型与高阶函数1. 函数类型定义2. 高阶函数(函数作为参数、返回值) 三、匿名函数与闭包1. 匿名函数(Lambda函…...

使用LangGraph和LangSmith构建多智能体人工智能系统

现在,通过组合几个较小的子智能体来创建一个强大的人工智能智能体正成为一种趋势。但这也带来了一些挑战,比如减少幻觉、管理对话流程、在测试期间留意智能体的工作方式、允许人工介入以及评估其性能。你需要进行大量的反复试验。 在这篇博客〔原作者&a…...

【Nginx】使用 Nginx+Lua 实现基于 IP 的访问频率限制

使用 NginxLua 实现基于 IP 的访问频率限制 在高并发场景下,限制某个 IP 的访问频率是非常重要的,可以有效防止恶意攻击或错误配置导致的服务宕机。以下是一个详细的实现方案,使用 Nginx 和 Lua 脚本结合 Redis 来实现基于 IP 的访问频率限制…...

并发编程 - go版

1.并发编程基础概念 进程和线程 A. 进程是程序在操作系统中的一次执行过程,系统进行资源分配和调度的一个独立单位。B. 线程是进程的一个执行实体,是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位。C.一个进程可以创建和撤销多个线程;同一个进程中…...

android13 app的触摸问题定位分析流程

一、知识点 一般来说,触摸问题都是app层面出问题,我们可以在ViewRootImpl.java添加log的方式定位;如果是touchableRegion的计算问题,就会相对比较麻烦了,需要通过adb shell dumpsys input > input.log指令,且通过打印堆栈的方式,逐步定位问题,并找到修改方案。 问题…...