OpenAI从GPT-4V到GPT-4O,再到GPT-4OMini简介

OpenAI从GPT-4V到GPT-4O,再到GPT-4OMini简介

一、引言

在人工智能领域,OpenAI的GPT系列模型一直是自然语言处理的标杆。随着技术的不断进步,OpenAI推出了多个版本的GPT模型,包括视觉增强的GPT-4V(GPT-4 with Vision)、优化版的GPT-4O(GPT-4 Optimized)以及适用于资源受限环境的轻量级版本GPT-4OMini(GPT-4 Optimized Mini)。本文将详细介绍这些模型,并深入探讨GPT-4OMini背后的技术栈。通过公式和代码示例,我们将全面了解这些模型的构建原理和实现细节。

二、GPT-4V:视觉增强的GPT-4

1. 概述

GPT-4V是GPT-4的视觉增强版本,它能够处理和生成图像信息,进一步扩展了GPT模型的应用范围。GPT-4V在语言理解的基础上加入了视觉处理能力,使其在多模态任务中表现出色。

2. 技术细节

GPT-4V结合了Transformer模型和卷积神经网络(CNN),能够同时处理文本和图像数据。模型的架构如下图所示:

import torch

import torch.nn as nn

import torch.nn.functional as Fclass VisionEncoder(nn.Module):def __init__(self):super(VisionEncoder, self).__init__()self.conv = nn.Conv2d(in_channels=3, out_channels=64, kernel_size=3, stride=1, padding=1)self.pool = nn.MaxPool2d(kernel_size=2, stride=2)def forward(self, x):x = self.pool(F.relu(self.conv(x)))return xclass GPT4V(nn.Module):def __init__(self):super(GPT4V, self).__init__()self.vision_encoder = VisionEncoder()self.transformer = nn.Transformer(d_model=512, nhead=8, num_encoder_layers=6)def forward(self, image, text):vision_features = self.vision_encoder(image)text_features = self.transformer(text)combined_features = torch.cat((vision_features, text_features), dim=1)return combined_features

视觉处理模块

视觉处理模块使用卷积神经网络(CNN)来提取图像特征。这些特征通过一系列卷积层和池化层进行处理,最终形成图像的高层次表示。

Transformer

Transformer模块用于处理文本输入,并结合来自视觉模块的图像特征。文本和图像特征通过拼接或加权平均的方式进行融合。

3. 应用场景

GPT-4V在视觉问答、图像生成、图文配对等任务中表现出色。例如,在图像描述生成任务中,GPT-4V能够根据输入图像生成相应的描述文字。

三、GPT-4O:优化版GPT-4

1. 概述

GPT-4O是GPT-4的优化版本,旨在提高模型的计算效率和推理速度。GPT-4O在保持原有模型性能的前提下,通过优化算法和架构设计实现了更高的效率。

2. 技术细节

a. 权重共享(Weight Sharing)

权重共享是一种减少模型参数数量的方法,通过在模型的不同层之间共享参数来降低计算和存储成本。

import torch

import torch.nn as nnclass OptimizedTransformer(nn.Module):def __init__(self, d_model, nhead, num_layers):super(OptimizedTransformer, self).__init__()self.transformer = nn.Transformer(d_model, nhead, num_layers)# 使用权重共享优化self.shared_weights = nn.Parameter(torch.randn(d_model, d_model))def forward(self, src, tgt):src = src @ self.shared_weightstgt = tgt @ self.shared_weightsreturn self.transformer(src, tgt)

b. 参数剪枝(Parameter Pruning)

参数剪枝通过移除神经网络中对最终输出影响较小的权重,从而减少模型的参数数量。剪枝可以是非结构化剪枝(去除单个权重)或结构化剪枝(去除整个神经元或通道)。

import torch

import torch.nn.utils.prune as prune# 假设我们有一个简单的线性层

linear = torch.nn.Linear(10, 5)# 应用全局剪枝,保留50%的权重

prune.global_unstructured([(linear, 'weight')],pruning_method=prune.L1Unstructured,amount=0.5,

)# 检查剪枝后的权重

print(linear.weight)

c. 注意力机制优化(Attention Mechanism Optimization)

通过引入更高效的注意力计算方法,如线性注意力(Linear Attention),可以显著减少计算复杂度。

import torch

import torch.nn as nnclass LinearAttention(nn.Module):def __init__(self, d_model):super(LinearAttention, self).__init__()self.query = nn.Linear(d_model, d_model)self.key = nn.Linear(d_model, d_model)self.value = nn.Linear(d_model, d_model)def forward(self, x):Q = self.query(x)K = self.key(x)V = self.value(x)attention_weights = torch.bmm(Q, K.transpose(1, 2)) / x.size(-1)**0.5attention = torch.bmm(attention_weights, V)return attention

3. 应用场景

GPT-4O适用于需要高效推理和低延迟的场景,例如实时翻译、智能助手和大规模文本处理任务。

四、GPT-4OMini:轻量级GPT-4

1. 概述

GPT-4OMini是GPT-4O的轻量级版本,专为资源受限环境设计。它在保持高效性能的同时,大幅度减少了模型的参数数量和计算复杂度,使其适用于移动设备、嵌入式系统等场景。

2. 技术细节

a. 模型压缩技术

GPT-4OMini背后的一个关键技术是模型压缩。模型压缩技术包括以下几种方法:

参数剪枝(Parameter Pruning)同上

参数剪枝通过移除神经网络中对最终输出影响较小的权重,从而减少模型的参数数量。常见的剪枝方法有基于阈值的剪枝和结构化剪枝。

import torch

import torch.nn.utils.prune as prune# 假设我们有一个简单的线性层

linear = torch.nn.Linear(10, 5)# 应用全局剪枝,保留50%的权重

prune.global_unstructured([(linear, 'weight')],pruning_method=prune.L1Unstructured,amount=0.5,

)# 检查剪枝后的权重

print(linear.weight)

知识蒸馏(Knowledge Distillation)

知识蒸馏通过训练一个较小的学生模型去学习较大教师模型的行为,从而使小模型能够在保留大模型性能的前提下大幅度减小规模。

import torch.nn.functional as F# 定义教师模型和学生模型

teacher_model = GPT4Model()

student_model = GPT4MiniModel()# 假设我们有输入数据x和标签y

x, y = get_data()# 教师模型输出

with torch.no_grad():teacher_output = teacher_model(x)# 学生模型输出

student_output = student_model(x)# 蒸馏损失

loss = F.kl_div(F.log_softmax(student_output / temperature, dim=1),F.softmax(teacher_output / temperature, dim=1),reduction='batchmean'

)# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

量化(Quantization)

量化通过将模型的权重和激活从高精度表示(如32位浮点数)转换为低精度表示(如8位整数),从而减少模型的存储和计算需求。

import torch.quantization# 定义模型

model = GPT4Model()# 准备模型进行量化

model.qconfig = torch.quantization.default_qconfig

torch.quantization.prepare(model, inplace=True)# 校准模型

calibrate_model(model, calibration_data)# 转换模型为量化版本

torch.quantization.convert(model, inplace=True)# 检查量化后的模型

print(model)

b. 高效的模型架构设计

GPT-4OMini采用了更高效的模型架构设计,以在不显著牺牲性能的前提下减少计算量。例如,它可能会使用更少的Transformer层、更小的隐藏层尺寸和更少的注意力头。

import torch

import torch.nn as nnclass MiniTransformer(nn.Module):def __init__(self, d_model, nhead, num_layers):super(MiniTransformer, self).__init__()self.transformer = nn.Transformer(d_model, nhead, num_layers)def forward(self, src, tgt):return self.transformer(src, tgt)# 初始化一个较小的Transformer模型

model = MiniTransformer(d_model=128, nhead=4, num_layers=2)

c. 硬件加速与并行计算

GPT-4OMini还通过硬件加速和并行计算进一步提高效率。利用现代GPU、TPU等硬件加速器,以及分布式计算技术,可以显著加速模型训练和推理过程。

import torch

import torch.nn as nn

import torch.distributed as dist# 初始化分布式环境

dist.init_process_group("gloo", rank=rank, world_size=world_size)# 定义模型

model = GPT4Model().to(device)# 包装为分布式数据并行模型

model = nn.parallel.DistributedDataParallel(model)# 定义数据加载器和优化器

data_loader = get_data_loader()

optimizer = torch.optim.Adam(model.parameters())# 训练循环

for epoch in range(num_epochs):for batch in data_loader:optimizer.zero_grad()outputs = model(batch)loss = compute_loss(outputs, batch.labels)loss.backward()optimizer.step()

3. 应用场景

GPT-4OMini适用于需要轻量级、高效的自然语言处理任务的场景,如移动应用、智能家居设备和边缘计算。

五、结论

从GPT-4V到GPT-4O,再到GPT-4OMini,这些模型代表了OpenAI在自然语言处理和多模态处理方面的最新进展。通过结合先进的技术和优化方法,这些模型在不同应用场景中展示了强大的能力。GPT-4OMini特别适合资源受限的环境,具有广泛的应用前景。希望本文的详细介绍能够帮助读者更好地理解这些模型的构建原理和实现方法。

随着技术的不断发展,我们可以期待更多创新的轻量级模型出现在各类实际应用中,推动人工智能技术的普及和应用。

相关文章:

OpenAI从GPT-4V到GPT-4O,再到GPT-4OMini简介

OpenAI从GPT-4V到GPT-4O,再到GPT-4OMini简介 一、引言 在人工智能领域,OpenAI的GPT系列模型一直是自然语言处理的标杆。随着技术的不断进步,OpenAI推出了多个版本的GPT模型,包括视觉增强的GPT-4V(GPT-4 with Vision&…...

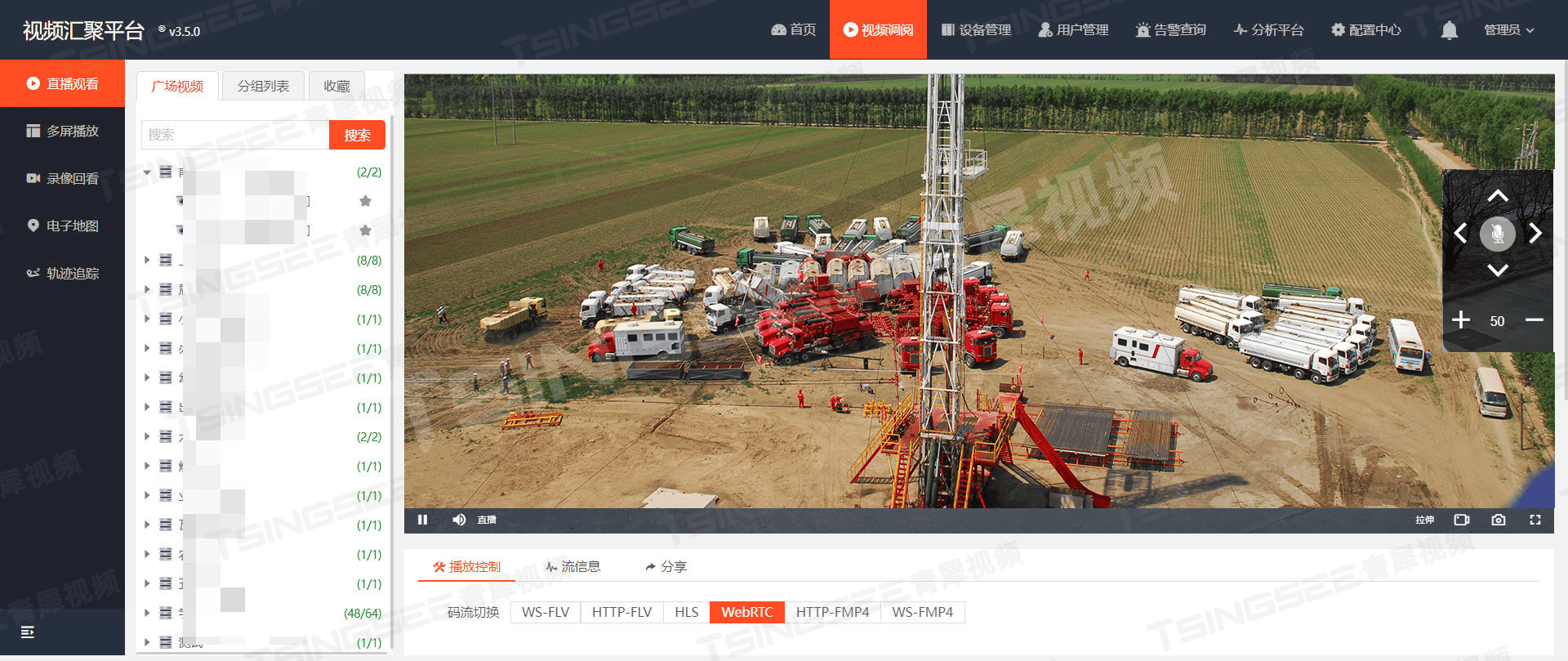

从人工巡检到智能防控:智慧油气田安全生产的新视角

一、背景需求 随着科技的飞速发展,视频监控技术已成为各行各业保障安全生产、提升管理效率的重要手段。特别是在油气田这一特殊领域,由于其工作环境复杂、安全风险高,传统的监控方式已难以满足实际需求。因此,基于视频监控AI智能…...

【黑马java基础】Lamda, 方法引用,集合{Collection(List, Set), Map},Stream流

文章目录 JDK8新特性:Lambda表达式认识Lambda表达式Lambda表达式的省略规则 JDK8新特性:方法引用静态方法的引用实例方法的引用特定类型方法的引用构造器的应用 集合➡️Collection单列集合体系Collection的常用方法Collection的遍历方法迭代器增强for循…...

Stable Diffusion 使用详解(1)---- 提示词及相关参数

目录 背景 提示词 内容提示词 人物及主体特征 场景 环境光照 画幅视角 注意事项及示例 标准化提示词 画质等级 风格与真实性 具体要求 背景处理 光线与色彩 负向提示词 小结 常用工具 另外几个相关参数 迭代步数 宽度与高度 提示词引导系数 图片数量 背景…...

- 无序数组排序后的最大相邻差)

数据结构和算法(刷题) - 无序数组排序后的最大相邻差

无序数组排序后的最大相邻差 问题:一个无序的整型数组,求出该数组排序后的任意两个相邻元素的最大差值?要求时间和空间复杂度尽可能低。 三种方法: 排序后计算比较 简介:用任意一种时间复杂度为 O ( n log n ) O…...

HOW - React 处理不紧急的更新和渲染

目录 useDeferredValueuseTransitionuseIdleCallback 在 React 中,有一些钩子函数可以帮助你处理不紧急的更新或渲染,从而优化性能和用户体验。 以下是一些常用的相关钩子及其应用场景: useDeferredValue 用途:用于处理高优先级…...

基于A律压缩的PCM脉冲编码调制通信系统simulink建模与仿真

目录 1.算法运行效果图预览 2.算法运行软件版本 3.部分核心程序 4.算法理论概述 4.1A律压缩的原理 4.2 PCM编码过程 4.3 量化噪声与信噪比 5.算法完整程序工程 1.算法运行效果图预览 (完整程序运行后无水印) 2.算法运行软件版本 matlab2022a 3.部分核心程序 &#…...

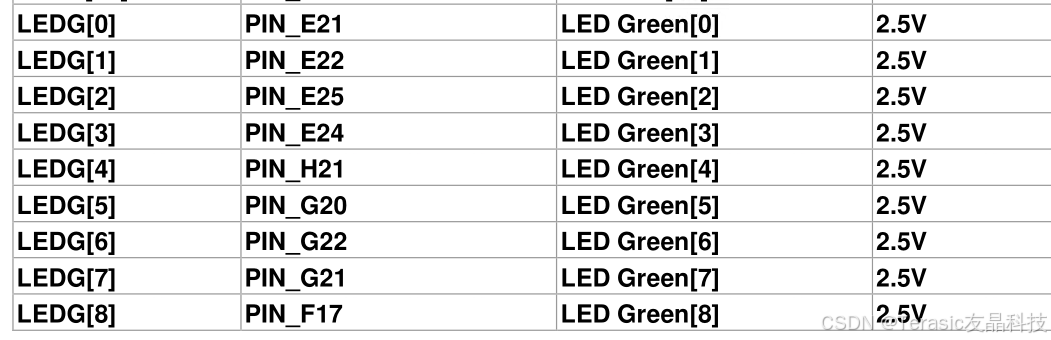

【入门教程一】基于DE2-115的My First FPGA 工程

1.1. 概述 这是一个简单的练习, 可以帮助初学者开始了解如何使用Intel Quartus 软件进行 FPGA 开发。 在本章节中,您将学习如何编译 Verilog 代码,进行引脚分配,创建时序约束,然后对 FPGA 进行编程,驱动开…...

mysql中的索引和分区

目录 1.编写目的 2.索引 2.1 创建方法 2.2 最佳适用 2.3 索引相关语句 3.分区 3.1 创建方法 3.2 最佳适用 Welcome to Code Blocks blog 本篇文章主要介绍了 [Mysql中的分区和索引] ❤博主广交技术好友,喜欢文章的可以关注一下❤ 1.编写目的 在MySQL中&…...

项目实战--C#实现图书馆信息管理系统

本项目是要开发一个图书馆管理系统,通过这个系统处理常见的图书馆业务。这个系统主要功能是:(1)有客户端(借阅者使用)和管理端(图书馆管理员和系统管理员使用)。(2&#…...

信号【Linux】

文章目录 信号处理方式(信号递达)前后台进程 终端按键产生信号kill系统调用接口向进程发信号阻塞信号sigset_tsigprocmasksigpending内核态与用户态:内核空间与用户空间内核如何实现信号的捕捉 1、信号就算没有产生,进程也必须识别…...

Kafka Producer之ACKS应答机制

文章目录 1. 应答机制2. 等级03. 等级14. 等级all5. 设置等级6. ISR 1. 应答机制 异步发送的效率高,但是不安全,同步发送安全,但是效率低。 无论哪一种,有一个关键的步骤叫做回调,也就是ACKS应答机制。 其中ACKS也分…...

【深入理解SpringCloud微服务】深入理解Eureka核心原理

深入理解Eureka核心原理 Eureka整体设计Eureka服务端启动Eureka三级缓存Eureka客户端启动 Eureka整体设计 Eureka是一个经典的注册中心,通过http接收客户端的服务发现和服务注册请求,使用内存注册表保存客户端注册上来的实例信息。 Eureka服务端接收的…...

算法——滑动窗口(day7)

904.水果成篮 904. 水果成篮 - 力扣(LeetCode) 题目解析: 根据题意我们可以看出给了我们两个篮子说明我们在开始采摘到结束的过程中只能有两种水果的种类,又要求让我们返回收集水果的最大数目,这不难让我们联想到题目…...

Django学习第一天(如何创建和运行app)

前置知识: URL组成部分详解: 一个url由以下几部分组成: scheme://host:port/path/?query-stringxxx#anchor scheme:代表的是访问的协议,一般为http或者ftp等 host:主机名,域名,…...

VScode连接虚拟机运行Python文件的方法

声明:本文使用Linux发行版本为rocky_9.4 目录 1. 在rocky_9.4最小安装的系统中,默认是没有tar工具的,因此,要先下载tar工具 2. 在安装好的vscode中下载ssh远程插件工具 3. 然后连接虚拟机 4. 查看python是否已经安装 5. 下载…...

通义千问AI模型对接飞书机器人-模型配置(2-1)

一 背景 根据业务或者使用场景搭建自定义的智能ai模型机器人,可以较少我们人工回答的沟通成本,而且可以更加便捷的了解业务需求给出大家设定的业务范围的回答,目前基于阿里云的通义千问模型研究。 二 模型研究 参考阿里云帮助文档…...

[k8s源码]6.reflector

Reflector 和 Informer 是 Kubernetes 客户端库中两个密切相关但职责不同的组件。Reflector 是一个较低级别的组件,主要负责与 Kubernetes API 服务器进行交互,执行资源的初始列表操作和持续的监视操作,将获取到的数据放入队列中。而 Informe…...

前台文本直接取数据库值doFieldSQL插入SQL

实现功能:根据选择的车间主任带出角色。 实现步骤:OA的“字段联动”功能下拉选项带不出表“hrmrolemembers”,所以采用此方法。 doFieldSQL("select roleid from HrmResource as a inner join hrmrolemembers as b on a.id b.resource…...

【06】LLaMA-Factory微调大模型——微调模型评估

上文【05】LLaMA-Factory微调大模型——初尝微调模型,对LLama-3与Qwen-2进行了指令微调,本文则介绍如何对微调后的模型进行评估分析。 一、部署微调后的LLama-3模型 激活虚拟环境,打开LLaMA-Factory的webui页面 conda activate GLM cd LLa…...

【Axure高保真原型】引导弹窗

今天和大家中分享引导弹窗的原型模板,载入页面后,会显示引导弹窗,适用于引导用户使用页面,点击完成后,会显示下一个引导弹窗,直至最后一个引导弹窗完成后进入首页。具体效果可以点击下方视频观看或打开下方…...

【kafka】Golang实现分布式Masscan任务调度系统

要求: 输出两个程序,一个命令行程序(命令行参数用flag)和一个服务端程序。 命令行程序支持通过命令行参数配置下发IP或IP段、端口、扫描带宽,然后将消息推送到kafka里面。 服务端程序: 从kafka消费者接收…...

【机器视觉】单目测距——运动结构恢复

ps:图是随便找的,为了凑个封面 前言 在前面对光流法进行进一步改进,希望将2D光流推广至3D场景流时,发现2D转3D过程中存在尺度歧义问题,需要补全摄像头拍摄图像中缺失的深度信息,否则解空间不收敛…...

蓝牙 BLE 扫描面试题大全(2):进阶面试题与实战演练

前文覆盖了 BLE 扫描的基础概念与经典问题蓝牙 BLE 扫描面试题大全(1):从基础到实战的深度解析-CSDN博客,但实际面试中,企业更关注候选人对复杂场景的应对能力(如多设备并发扫描、低功耗与高发现率的平衡)和前沿技术的…...

测试markdown--肇兴

day1: 1、去程:7:04 --11:32高铁 高铁右转上售票大厅2楼,穿过候车厅下一楼,上大巴车 ¥10/人 **2、到达:**12点多到达寨子,买门票,美团/抖音:¥78人 3、中饭&a…...

【HTML-16】深入理解HTML中的块元素与行内元素

HTML元素根据其显示特性可以分为两大类:块元素(Block-level Elements)和行内元素(Inline Elements)。理解这两者的区别对于构建良好的网页布局至关重要。本文将全面解析这两种元素的特性、区别以及实际应用场景。 1. 块元素(Block-level Elements) 1.1 基本特性 …...

Ascend NPU上适配Step-Audio模型

1 概述 1.1 简述 Step-Audio 是业界首个集语音理解与生成控制一体化的产品级开源实时语音对话系统,支持多语言对话(如 中文,英文,日语),语音情感(如 开心,悲伤)&#x…...

鸿蒙DevEco Studio HarmonyOS 5跑酷小游戏实现指南

1. 项目概述 本跑酷小游戏基于鸿蒙HarmonyOS 5开发,使用DevEco Studio作为开发工具,采用Java语言实现,包含角色控制、障碍物生成和分数计算系统。 2. 项目结构 /src/main/java/com/example/runner/├── MainAbilitySlice.java // 主界…...

Python 包管理器 uv 介绍

Python 包管理器 uv 全面介绍 uv 是由 Astral(热门工具 Ruff 的开发者)推出的下一代高性能 Python 包管理器和构建工具,用 Rust 编写。它旨在解决传统工具(如 pip、virtualenv、pip-tools)的性能瓶颈,同时…...

LeetCode - 199. 二叉树的右视图

题目 199. 二叉树的右视图 - 力扣(LeetCode) 思路 右视图是指从树的右侧看,对于每一层,只能看到该层最右边的节点。实现思路是: 使用深度优先搜索(DFS)按照"根-右-左"的顺序遍历树记录每个节点的深度对于…...