Redis 与 Scrapy:无缝集成的分布式爬虫技术

1. 分布式爬虫的概念

分布式爬虫系统通过将任务分配给多个爬虫节点,利用集群的计算能力来提高数据抓取的效率。这种方式不仅可以提高爬取速度,还可以在单个节点发生故障时,通过其他节点继续完成任务,从而提高系统的稳定性和可靠性。

2. Scrapy 简介

Scrapy 是一个用于快速抓取 web 数据的 Python 框架。它提供了一个异步处理的架构,可以轻松地处理大规模数据抓取任务。Scrapy 的主要特点包括:

- 异步处理:利用 Twisted 异步网络库,Scrapy 可以同时处理多个请求,提高数据抓取的效率。

- 强大的选择器:Scrapy 使用 lxml 或 cssselect 作为选择器,可以方便地从 HTML/XML 页面中提取数据。

- 中间件支持:Scrapy 支持下载中间件和蜘蛛中间件,允许开发者在请求和响应处理过程中插入自定义逻辑。

- 扩展性:Scrapy 可以轻松地与各种存储后端(如数据库、文件系统)集成。

3. Redis 简介

Redis 是一个开源的内存数据结构存储系统,用作数据库、缓存和消息中间件。它支持多种类型的数据结构,如字符串、哈希、列表、集合等。Redis 的主要特点包括:

- 高性能:Redis 的数据存储在内存中,读写速度快。

- 高可用性:通过主从复制和哨兵系统,Redis 可以提供高可用性。

- 数据持久化:Redis 支持 RDB 和 AOF 两种持久化方式,确保数据的安全性。

- 丰富的数据类型:Redis 支持字符串、列表、集合、有序集合、散列等多种数据类型。

4. Scrapy-Redis 架构

Scrapy-Redis 是 Scrapy 与 Redis 的集成库,它将 Scrapy 的爬虫任务和结果存储在 Redis 中。这种架构的主要优势包括:

- 分布式处理:通过 Redis,Scrapy-Redis 可以将爬虫任务分配到多个爬虫节点,实现分布式处理。

- 去重:利用 Redis 的集合数据类型,Scrapy-Redis 可以轻松实现 URL 的去重。

- 任务队列:Redis 作为任务队列,可以存储待抓取的 URL,避免重复抓取。

5. Scrapy-Redis 组件

Scrapy-Redis 架构主要由以下几个组件构成:

- Redis 服务器:作为数据存储和任务队列的后端。

- Scrapy 爬虫:执行实际的数据抓取任务。

- Scrapy-Redis 扩展:提供 Scrapy 与 Redis 之间的集成功能。

6. 实现 Scrapy-Redis 架构

以下是实现 Scrapy-Redis 架构的基本步骤和示例代码:

首先,需要安装 Scrapy 和 Scrapy-Redis。可以通过 pip 安装.

在 Scrapy 项目的 settings.py 文件中。

接下来,定义一个 Scrapy 爬虫,并使用 Redis 存储爬取结果。

import scrapy

from scrapy import Request

from scrapy.utils.project import get_project_settings

from scrapy.exceptions import NotConfigured

from twisted.internet import reactor

from twisted.internet.error import TimeoutError

from twisted.internet.defer import inlineCallbacks

from scrapy.http import HtmlResponse

from scrapy.utils.response import response_status_messagefrom scrapy_redis.spiders import RedisSpiderclass ProxyMiddleware(object):def __init__(self, proxyHost, proxyPort, proxyUser, proxyPass):self.proxyHost = proxyHostself.proxyPort = proxyPortself.proxyUser = proxyUserself.proxyPass = proxyPass@classmethoddef from_crawler(cls, crawler):settings = crawler.settingsreturn cls(proxyHost=settings.get('PROXY_HOST'),proxyPort=settings.get('PROXY_PORT'),proxyUser=settings.get('PROXY_USER'),proxyPass=settings.get('PROXY_PASS'))def process_request(self, request, spider):proxy = f"{self.proxyUser}:{self.proxyPass}@{self.proxyHost}:{self.proxyPort}"request.meta['proxy'] = proxyclass MySpider(RedisSpider):name = 'example'redis_key = 'example:start_urls'def start_requests(self):yield scrapy.Request(url=self.start_urls[0], callback=self.parse)def parse(self, response):for href in response.css('a::attr(href)').getall():yield response.follow(href, self.parse_item)def parse_item(self, response):item = {'domain_id': response.url,'domain_name': response.url,}yield item# settings.py

ITEM_PIPELINES = {'scrapy_redis.pipelines.RedisPipeline': 300,

}DUPEFILTER_CLASS = 'scrapy_redis.dupefilter.RFPDupeFilter'SCHEDULER = 'scrapy_redis.scheduler.Scheduler'SCHEDULER_QUEUE_CLASS = 'scrapy_redis.queue.SpiderQueue'

SCHEDULER_QUEUE_LIMIT = 10000REDIS_URL = 'redis://localhost:6379'DOWNLOADER_MIDDLEWARES = {'myproject.middlewares.ProxyMiddleware': 100,

}PROXY_HOST = "www.16yun.cn"

PROXY_PORT = "5445"

PROXY_USER = "16QMSOML"

PROXY_PASS = "280651"

7.结论

Scrapy-Redis 架构通过将 Scrapy 的爬虫任务和结果存储在 Redis 中,实现了高效的数据抓取。这种架构不仅提高了数据抓取的效率,还增强了系统的可扩展性和稳定性。通过合理的配置和优化,可以进一步发挥 Scrapy-Redis 架构的优势,满足大规模数据抓取的需求。

相关文章:

Redis 与 Scrapy:无缝集成的分布式爬虫技术

1. 分布式爬虫的概念 分布式爬虫系统通过将任务分配给多个爬虫节点,利用集群的计算能力来提高数据抓取的效率。这种方式不仅可以提高爬取速度,还可以在单个节点发生故障时,通过其他节点继续完成任务,从而提高系统的稳定性和可靠性…...

大厂linux面试题攻略四之Linux网络服务(一)

一、Linux网络服务-SSH服务 1.哪些设置能够提升SSH远程管理的安全等级? ssh的登录验证方式 ssh的登录端口和监听设置: 配置文件: /etc/ssh/sshd_config #Port 22 #ssh服务默认监听端口 #ListenAddress 0.0.0.0 #ssh服务…...

【Pulling fs layer】Linux使用docker-compose的时候,一直Pulling fs layer

当Docker在拉取镜像时卡在“pulling fs layer”阶段,可以通过重启Docker服务来解决。 具体步骤如下: 首先,尝试重启Docker服务。可以通过运行以下命令来重启Docker服务: systemctl restart docker 这个命令会重启Docker服务…...

最新保姆级教程使用WildCard开通Claude3升级ChatGPT4.0(2024.8)

如何使用 WildCard 服务注册 Claude3 随着 Claude3 的震撼发布,最强 AI 模型的桂冠已不再由 GPT-4 独揽。Claude3 推出了三个备受瞩目的模型:Claude 3 Haiku、Claude 3 Sonnet 以及 Claude 3 Opus,每个模型都展现了卓越的性能与特色。其中&a…...

layui 乱入前端

功能包含 本实例代码为部分傻瓜框架,插入引用layui。因为样式必须保证跟系统一致,所以大部分功能都是自定义的。代码仅供需要用layui框架,但原项目又不是layui搭建的提供解题思路。代码较为通用 自定义分页功能自定义筛选列功能行内编辑下拉、…...

中国十大顶级哲学家,全球公认的伟大思想家颜廷利:人类为何拥有臀部

人类为何拥有臀部?若众生皆无此部位,又如何能寻得一处真正属于自己的“座位”?在博大精深的中国传统文化中,汉字“座”与“坐”均蕴含“土”字元素。在易经的智慧里,作为五行之一的“土”,象征着人类社会的…...

Threejs中导入GLTF模型克隆后合并

很多场景中会需要同一个模型很多次,但是如果多次加载同一个模型会占用很高的带宽,导致加载很慢,因此就需要使用clone,也就是加载一个模型后,其他需要使用的地方使用clone的方式复制出多个同样的模型,再改变…...

今日arXiv最热大模型论文:北京大学最新综述:视觉大模型中的漏洞与攻防对抗

近年来,视觉语言大模型(LVLM)在文本转图像、视觉问答等任务中大放异彩,背后离不开海量数据、强大算力和复杂参数的支撑。 但是!大模型看似庞大的身躯背后却有一颗脆弱的“心脏”,极易受到攻击。攻击者可以…...

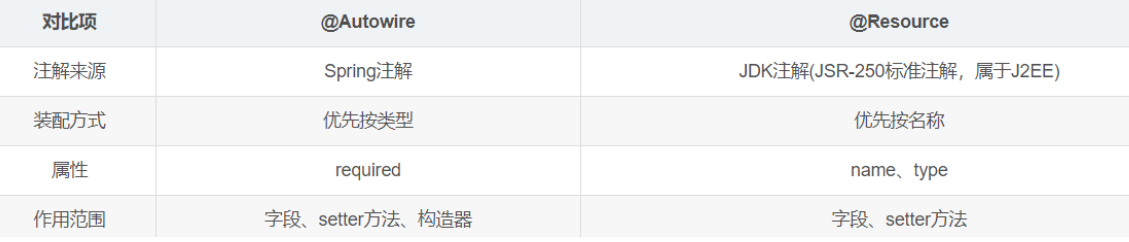

为什么IDEA中使用@Autowired会被警告

我们在使用IDEA编码时,如果用到了Autowired注解注入bean,会发现IDEA会给代码标个波连线,鼠标移动上去,会发下idea提示:不推荐使用Filed injection,这是Spring的核心DI(Dendency Injection&#…...

uniapp使用cover-view,使用@click无效

最近要做直播详情页面,用的是第三方直播链接,需要在该页面上放两个按钮,点击按钮需要弹出相关商品及优惠券。类似于抖音直播页面。 第三方链接使用的是web-view进行展示。由于该组件优先级太高,正常的前端组件无法在该页面浮现展…...

Postman 接口测试工具简易使用指南

一、Postman是什么? 我通过kimi问了这样一个问题,它给我的回答是这样的: 它的回答也算比较中规中矩,简单的说postman实际上就是一款接口测试工具,同时它还可以编写对应的测试脚本以及自动生成对应的API文档,结合我的习惯来说&am…...

Move生态:从Aptos和Sui到Starcoin的崛起

区块链技术自诞生以来,已经经历了多个发展阶段和技术迭代。近年来,随着智能合约平台的不断演进,以Move语言为核心的生态系统逐渐崭露头角。Move语言以其安全性、灵活性和高效性吸引了大量开发者和项目方的关注。在Move生态中,Apto…...

MacOS DockerDesktop配置文件daemon.json的位置

如果因为通过可视化页面修改配置错误导致客户端启动不起来,可以去找对应的配置文件通过 vim 修改后重启客户端 cd ~/.docker/...

从光速常数的可变性看宇宙大爆炸的本质

基于先前关于光速本质的讨论,让我们从函数图像看看宇宙大爆炸到底是什么。 先前已经讨论过,在量子尺度上,长度的实际对应物是频率的差异,因为只有频率差异才能在这个尺度上区分相邻时空的两点,而两点之间“差异的大小”…...

敢不敢跟我一起搭建一个Agent!不写一行代码,10分钟搞出你的智能体!纯配置也能真正掌握AI最有潜力的技术?AI圈内人必备技能

说一千道一万,不如实地转一转。学了那么久的AI Agent的概念了,是时候该落地一个Agent看看自己的掌握程度了对不对,我们都理解大脑是自动节能的,但是知识的确需要倒逼自己一把才能真的掌握,不瞒大家说,笔者对…...

vue3和vite双向加持,uni-app性能爆表,众绑是否有计划前端升级到vue3!

uni-app官方已经开始不支持vue2了,而且即将适配的鸿蒙next原生系统,也不支持vue2打包,CRMEB是否有计划跟上潮流呢,如果有会在什么时间呢,有准确的时间表吗?我们非常期待得到答案! 新版 uni-app…...

2024年最强网络安全学习路线,详细到直接上清华的教材!

关键词:网络安全入门、渗透测试学习、零基础学安全、网络安全学习路线 首先咱们聊聊,学习网络安全方向通常会有哪些问题前排提示:文末有CSDN官方认证Python入门资料包 ! 1、打基础时间太长 学基础花费很长时间,光语…...

人脸识别又进化:扫一下 我就知道你得了啥病

未来,扫下你的脸,可能就知道你得啥病了。没在瞎掰,最近的一项研究成果,还真让咱看到了一点眉目。北大的一个研究团队,搞出来一个 AI ,说是用热成像仪扫一下脸,就能检测出有没有高血压、糖尿病和…...

yolov8标注细胞、识别边缘、计算面积、灰度值计算

一、数据标注 1. 使用labelme软件标注每个细胞的边界信息,标注结果为JSON格式 2. JSON格式转yolo支持的txt格式 import json import os import glob import os.path as osp此函数用来将labelme软件标注好的数据集转换为yolov5_7.0sege中使用的数据集:param jsonfi…...

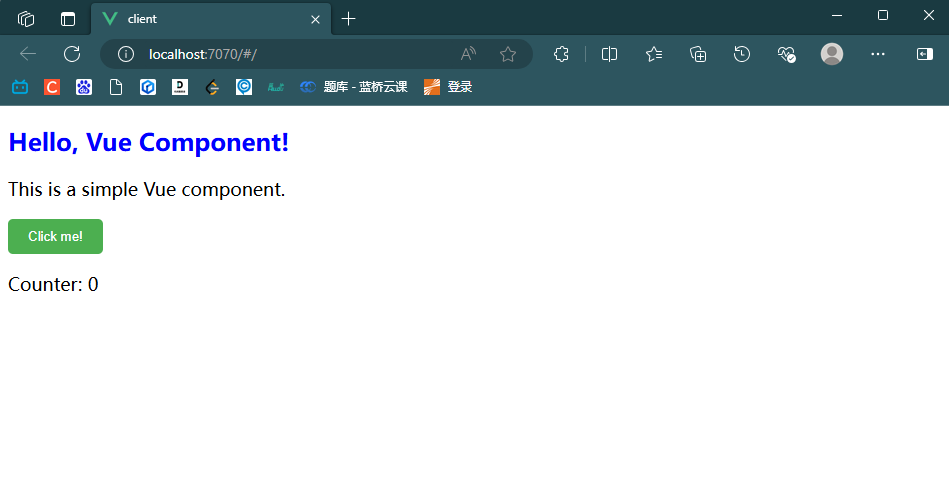

WEB前端11-Vue2基础01(项目构建/目录解析/基础案例)

Vue2基础(01) 1.Vue2项目构建 步骤一:安装前端脚手架 npm install -g vue/cli步骤二:创建项目 vue ui步骤三:运行项目 npm run serve步骤四:修改vue相关的属性 DevServer | webpack //修改端口和添加代理 const { defineCo…...

<6>-MySQL表的增删查改

目录 一,create(创建表) 二,retrieve(查询表) 1,select列 2,where条件 三,update(更新表) 四,delete(删除表…...

最新SpringBoot+SpringCloud+Nacos微服务框架分享

文章目录 前言一、服务规划二、架构核心1.cloud的pom2.gateway的异常handler3.gateway的filter4、admin的pom5、admin的登录核心 三、code-helper分享总结 前言 最近有个活蛮赶的,根据Excel列的需求预估的工时直接打骨折,不要问我为什么,主要…...

Python实现prophet 理论及参数优化

文章目录 Prophet理论及模型参数介绍Python代码完整实现prophet 添加外部数据进行模型优化 之前初步学习prophet的时候,写过一篇简单实现,后期随着对该模型的深入研究,本次记录涉及到prophet 的公式以及参数调优,从公式可以更直观…...

)

WEB3全栈开发——面试专业技能点P2智能合约开发(Solidity)

一、Solidity合约开发 下面是 Solidity 合约开发 的概念、代码示例及讲解,适合用作学习或写简历项目背景说明。 🧠 一、概念简介:Solidity 合约开发 Solidity 是一种专门为 以太坊(Ethereum)平台编写智能合约的高级编…...

【C语言练习】080. 使用C语言实现简单的数据库操作

080. 使用C语言实现简单的数据库操作 080. 使用C语言实现简单的数据库操作使用原生APIODBC接口第三方库ORM框架文件模拟1. 安装SQLite2. 示例代码:使用SQLite创建数据库、表和插入数据3. 编译和运行4. 示例运行输出:5. 注意事项6. 总结080. 使用C语言实现简单的数据库操作 在…...

select、poll、epoll 与 Reactor 模式

在高并发网络编程领域,高效处理大量连接和 I/O 事件是系统性能的关键。select、poll、epoll 作为 I/O 多路复用技术的代表,以及基于它们实现的 Reactor 模式,为开发者提供了强大的工具。本文将深入探讨这些技术的底层原理、优缺点。 一、I…...

有限自动机到正规文法转换器v1.0

1 项目简介 这是一个功能强大的有限自动机(Finite Automaton, FA)到正规文法(Regular Grammar)转换器,它配备了一个直观且完整的图形用户界面,使用户能够轻松地进行操作和观察。该程序基于编译原理中的经典…...

Mobile ALOHA全身模仿学习

一、题目 Mobile ALOHA:通过低成本全身远程操作学习双手移动操作 传统模仿学习(Imitation Learning)缺点:聚焦与桌面操作,缺乏通用任务所需的移动性和灵活性 本论文优点:(1)在ALOHA…...

Vite中定义@软链接

在webpack中可以直接通过符号表示src路径,但是vite中默认不可以。 如何实现: vite中提供了resolve.alias:通过别名在指向一个具体的路径 在vite.config.js中 import { join } from pathexport default defineConfig({plugins: [vue()],//…...

嵌入式常见 CPU 架构

架构类型架构厂商芯片厂商典型芯片特点与应用场景PICRISC (8/16 位)MicrochipMicrochipPIC16F877A、PIC18F4550简化指令集,单周期执行;低功耗、CIP 独立外设;用于家电、小电机控制、安防面板等嵌入式场景8051CISC (8 位)Intel(原始…...